Чем отличаются большие видеокарты от маленьких

Обновлено: 06.07.2024

Производительность ПК во многом зависит от видеокарты. Просмотр видео в высоком качестве, поддержка современных тяжеловесных геймов возможны при условии правильно выбранной видеокарты. В процессорах сейчас есть встроенные видеокарты, но их мощности не хватает для осуществления множества действий: поддержка изображения в формате 4К, использование технологии виртуальной реальности, 3D программ. Прежде чем купить графический адаптер, необходимо научиться разбираться в основных его параметрах.

Производители видеокарт

Есть два главных бренда, графические адаптеры которых пользуются наибольшей популярностью. Это AMD и NVIDIA. Эти компании делают лишь видеочипы для адаптеров, ведь на разработку дизайна уходит слишком много времени. Поэтому сначала для пользователей доступны референсные версии графических адаптеров. Далее другие компании вносят свою лепту в создание готовой видеокарты: меняют дизайн, разгоняют устройство, модернизируют систему охлаждения. Получившийся продукт называют кастомным графическим адаптером.

Вопрос о том, какой производитель лучше, до сих пор не решен в чью-то пользу. Продукция обеих компаний имеет свои преимущества и недостатки. У AMD видеокарты менее дорогие, при этом можно подобрать модель с хорошим уровнем производительности. Хотя очень часто наблюдаются проблемы с перегревом устройств. Компания NVIDIA производит высокотехнологичные устройства с мощными параметрами, но цены на них немного выше.

Определиться с выбором кастомных моделей ещё труднее. Компании стараются модернизировать дизайн, улучшить систему охлаждения, используют подсветку и другие фишки, чтобы выделиться среди конкурентов. Поэтому сложно определить одного производителя. Однако можно обратить внимание на ASUS, Gigabyte и MSI. Именно их продукция отличается высоким качеством.

Совместимость с блоком питания

Некоторые модели отличаются низким уровнем потребления электроэнергии, но многие современные мощные видеокарты потребляют много энергии. Поэтому устройство должно подойти по этим характеристикам к блоку питания. Производителем обязательно указываются требования к блоку питания, которые можно найти в характеристиках. Поэтому нужно заранее изучить параметры своего компьютера.

Ряд графических адаптеров имеют разъемы 6 pin и 8 pin. Для них можно купить специальные переходники, если блок питания не имеет такого коннектора.

Многие видеокарты отличаются большими размерами, особенно геймерские и оверклокерские устройства. Поэтому в процессоре должно хватать места для размещения адаптера. Стоит учитывать и размеры охлаждающей системы, если такая есть у видеокарты. Размеры ее также можно посмотреть в характеристиках, где указано длина, высота, ширина. Иногда эти параметры указываются отдельно для печатной платы и для платы уже вместе с кулером.

Основные характеристики видеопамяти

Объем видеопамяти является для многих первым критерием, по которому выбирается графический адаптер. И это неспроста, ведь именно благодаря данному параметру можно понять насколько хорошо покажет себя устройство в видеоиграх. Но на мощность видеоадаптера влияют и другие параметры, например, пиковая частота, разрядность шины памяти.

И всё же объем также влияет на удобство эксплуатации. Для реализации всех целей вполне хватает 4-8 Гб видеопамяти. Можно будет наслаждаться современными играми на высоких настройках.

Внимание стоит обратить и на тип памяти. DDR3 сейчас используется для стандартных офисных видеокарт. На игровых устройствах и топовых высокопроизводительных графических адаптерах обычно применяется тип памяти DDR5. Первый и второй вариант отличаются пропускной способностью информации, поступающей от видеоядра. Во втором случае показатель значительно выше, что положительно отражается на производительности видеокарты. Улучшенной версией DDR5 является память DDR5X, которой уже оснащены некоторые новинки. Есть тип памяти HBM, который из-за ограниченного объема не получил большого распространения.

Тактовые частоты

Каждый производитель старается максимально увеличить показатели тактовой частоты видеокарты, поскольку чем она больше, тем лучше устройство покажет себя в играх. Данный параметр больше влияет на производительность, чем перечисленные выше. В характеристиках важно обратить внимание на базовую и динамическую тактовые частоты. Среднее значение для GPU находится в пределах 900-1100 МГц. При таких показателях удается получить хорошую производительность видеокарты.

Система охлаждения и отвод тепла

Некоторые модели оснащены системой охлаждения, а некоторые требуют дополнительного оборудования для снижения температуры устройства. При перегреве GPU может быстро выйти из строя, да и на производительности это скажется не лучшим образом. Обычно устанавливаемых производителем элементов для охлаждения оказывается достаточно, что особенно касается фирм ASUS, Gigabyte и MSI. Эти компании отличаются созданием прекрасных систем охлаждения. Многие пользователи предпочитают устанавливать систему водного охлаждения, но это крайне редко бывает необходимо. Установкой таких устройств чаще всего занимаются оверклокеры.

GPU ASUS, Gigabyte и MSI оборудованы одним, двумя или тремя вентиляторами с диаметром от 90 до 120 мм. В большинстве моделей в режиме бездействия вентиляторы отключаются. Но не только хорошие кулеры должны быть на видеокарте. Конструкция ее должна быть разработана таким образом, чтобы обеспечить правильную циркуляцию воздуха. Тогда перегрев удастся избежать. Кстати, в характеристиках производители обычно указывают максимальную температуру видеокарты.

Техпроцесс и графический чип

На производительность влияет количество транзисторов, которые находятся на кристалле. Чем они меньше по размеру, тем больше их удается на нем разместить. А с увеличением числа транзисторов возрастает показатель тактовой частоты и снижается уровень энергопотребления. Техпроцесс отображает размер транзистора, то есть чем показатель меньше, тем больше их в видеокарте. Ну и число транзисторов также зависит от размеров кристалла. Раньше нормальным считался показатель технического процесса 28 нм и 20 нм. Но сейчас многие GPU имеют техпроцесс 16 нм и 14 нм.

Но этот параметр отражается не только на производительности. Техпроцесс 20 нм сильно ограничивал возможности игр с технологией виртуальной реальности, а современный техпроцесс оптимизирован под новые игры

SLI/Crossfire

В характеристиках видеокарты будет указано поддерживает ли она технологию SLI или Crossfire. Это по своей сути одинаковые технологии, которые были разработаны разными производителями. Первая - компанией Nvidia для серии GeForce, а вторая - компанией АМD для своих графических адаптеров Radeon. Цель разработки таких технологий в возможности установки от двух до четырех одинаковых моделей GPU на ПК. При их совмещении удается добиться максимальной мощности. Это идеальный вариант для игроманов, которые хотят прочувствовать всю красоту 3D игр. Но не каждая модель вышеназванных серий имеет такую возможность. Если это важный фактор, то следует обратить внимание на поддержку данной технологии.

Но кроме того, что эта технология должна быть доступна для графического адаптера, ее также должна суметь реализовать материнская плата. И кроме того у неё должно быть требуемое количество слотов PCI-Express. Вся информация об этом содержится в параметрах к материнской плате. Также важно знать, что не каждая игра поддерживает больше одного графического процессора, поэтому установка двух, трёх и более не всегда целесообразна.

Почему важен API и что это такое

API – это интерфейс прикладного программирования. Разработчики игр пишут их на определенном интерфейсе Application Programming Interface. Если графический процессор не поддерживает интерфейс, на котором разработана игра, то последняя на компьютере не запустится. Современные GPU поддерживают все основные интерфейсы АПИ. Самыми распространенными интерфейсами являются OpenGL и DirectX. В последнее время многие выпускаемые новинки поддерживают Vulcan, который часто в последнее время используется для создания игр. Vulcan отличается уменьшенной нагрузкой на ЦП. Игры с таким интерфейсом на современных GPU имеют гораздо большую производительность.

Вывод

Выбирая видеокарту нужно определиться со стоимостью, которая является оптимальной. Далее можно рассмотреть несколько моделей видеокарт разных производителей, серий, находящихся в одинаковом ценовом диапазоне. При их сравнении нужно обратить внимание на вышеперечисленные параметры. Важно не выбирать графический адаптер основываясь лишь на количестве памяти, поскольку нужно учитывать ещё и битность шины (не менее 128 бит). Нужно смотреть не на отдельные показатели, а на то, что они представляют из себя в совокупности.

В заключении можно сказать, что устройства от Nvidia отличаются лучшей производительностью и надежностью. Также это оперативно выпускаемые драйвера. AMD - это немного сниженные показатели производительности, но гораздо более приятные цены.

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Привет, Geektimes! Мы продолжаем наш цикл статей о выборе железа для компьютера. В прошлых выпусках мы затрагивали тему материнских плат, процессоров и чипсетов, систем охлаждения, жёстких дисков и блоков питания. Сегодня же говорим о том, что выводит ваш любимый ресурс на мониторы: о видеокартах.

Собственно, все видеокарты можно поделить на два больших лагеря: профессиональные и потребительские. Нет, профессиональные видеокарты нужны не профессиональным игрокам, а тем, кто работает с 3D графикой: аниматорам, мультипликаторам, моделлерам и используются они обычно при создании видеороликов, фильмов и потрясающих декораций к ним. Как правило, такие видеокарты стоят запредельно много.

Потребительские же видеокарты (о которых мы, в основном, и будем говорить) бывают двух типов: встроенные и дискретные. Отличаются они в первую очередь производительностью и ценой: если «встроенные» решения, по большей части, нужны, чтобы офис с браузером на экран выводить, и крутую трёхмерную графику тянут с трудом, то «выделенные» в отдельное устройство видеокарты, наоборот, заточены именно под игры и работу в «тяжёлых» приложениях.

Встроенная графика

Изначально, встроенные видеоадаптеры были частью т.н. «северного моста»: большой микросхемы на материнской плате, которая выступала «хабом» между CPU, оперативной памятью, видеоадаптером и «южным мостом», который отвечал за устройства ввода-вывода: жёсткие диски, USB-порты, сеть, звук и слоты расширения PCI-X и PCI-Express. Постепенный «переезд» функций северного (а сейчас и части южного) мостов непосредственно в CPU повлёк за собой и перенос графического ядра.

В продуктах Intel вы можете столкнуться со следующими графическими адаптерами:

Шестое поколение, 2011-2012

Intel HD Graphics

Intel HD Graphics 2000

Intel HD Graphics 3000

Седьмое поколение, 2012

Intel HD Graphics 2500

Intel HD Graphics 4000

Седьмое поколение, 2013

Intel HD Graphics 4200

Intel HD Graphics 4400

Intel HD Graphics 4600

Iris Graphics 5000

Iris Graphics 5100

Iris Pro Graphics 5200

Восьмое поколение, 2014+

Intel HD Graphics 5300

Intel HD Graphics 5500

Intel HD Graphics 6000

Iris Graphics 6100

Iris Pro Graphics 6200

Всё, что ниже Intel HD 4400 — достаточно старые решения. С выводом двухмерной графики у них проблем нет, с декодированием видео — тоже, но про игры можно смело забыть. Всё, что выше, впрочем, тоже особой производительностью в трёхмерных приложениях не блещет, но уже находится на куда более приятном уровне производительности.

Все эти видеочипы, в принципе, не предназначены для сложных игр: казуальные браузерки, трёхмерные игры десятилетней давности на средних настройках вполне неплохо запустятся с разрешением FullHD, но на большее расчитывать не стоит.

Компания AMD (не так давно присоединившая к себе производителя видеочипов ATI, известную своей линейкой видеокарт Radeon), также пошла по пути интеграции GPU и CPU, но несколько другим путём. AMD создали так называемое APU — Accelerated Processing Unit (ускоренное обрабатывающее устройство), по аналогии с CPU (Central Processing Unit, центральное обрабатывающее устройство). Линейка гибридных процессоров называется Fusion и работает на сокете FM (о сокетах и чипсетах мы уже рассказывали).

Производительность встроенной графики в A-серии процессоров AMD выше, чем у Intel, современные игрушки идут неплохо, но не стоит забывать, что у встроенного видеочипа нет ни выделенной высокосоростной памяти, ни качественного теплоотвода: теплопакет ограничен как площадью рассеивания крышки, так и системами охлаждения, доступными для процессора. Если вы можете себе позволить лишние 5-7 тысяч на мощное охлаждение, то их, скорее, стоит потратить на отдельную графику, чем пытаться выжать из AMD Fusion лишние кадры в секунду.

Подробнее о гибридной графики и расширении её возможностей поговорим как-нибудь в другой раз, а сейчас перейдём к самому интересному: дискретным видеокартам.

NVIDIA vs ATI-AMD

Война такая же старая, как Intel vs AMD. Обсуждать, кто лучше — всё равно, что участвовать в специальной олимпиаде.

У каждого из производителей есть более и менее удачные решения, и рассматривать их стоит исключительно с точки зрения «хотелки vs соотношение цены и производительности».

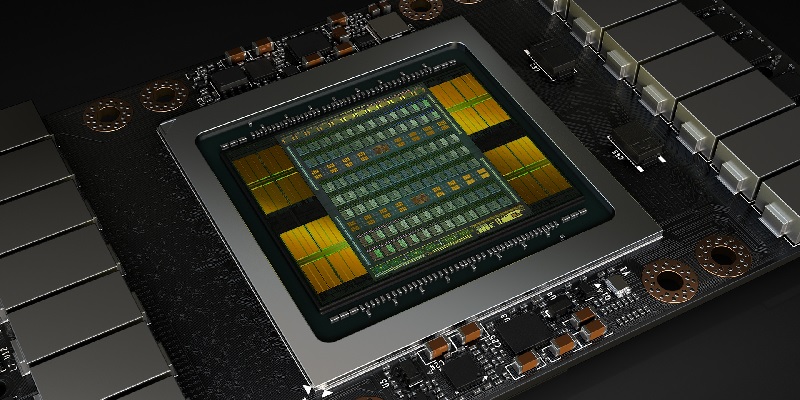

Что внутри видеокарты

Прежде чем перейти к объяснению, за что мы платим такие деньги, надо разобраться во внутреннем устройстве графического адаптера. Рассматривать legacy-архитектуру с раздельными шейдерными процессорами не будем, остановимся на ключевых моментах.

Почти вся современная трёхмерная графика (за редким исключением) состоит из набора треугольников, которые в сфере 3D-моделирования называют «полигонами». Из этих полигонов собраны трёхмерные модели, поверх которых натягиваются двухмерные текстуры. После «натягивания» текстуры в ход идут спецэффекты, из которых и формируется картинка. Вот здесь хорошо описаны превращения треугольников в готовую картинку.

Внутри видеокарты весь вывод каждого кадра делится на два больших участка: стадию построения геометрии (в которой, в основном, задействованы вычислительные мощности) и стадию отрисовки (в ней происходит основной расход памяти и потребляется вычислительный ресурс специальных аппаратных ускорителей).

Крайне подробный материал по тому, как вообще работает 3D-графика написал haqreu на Хабре:

Даже просто пробежавшись по постам по диагонали вы поймёте, какой объём вычислений производит видеокарта для расчёта всего одного кадра, а ведь ей нужно выдавать (в идеале) — больше тридцати таких картинок в секунду.

Собственно, вот параметры видеокарты, которые нас интересуют:

» Кодовое название ядра: мало за что отвечает, но пригодится при сравнении видеокарт внутри серии. Некоторые производители просто переименовывают прошлогодние видеокарты, вешают на них новое название с меньшими цифрами или программно ограничивают производительность, и готово: старенькая 9800GT превращается в NVIDIA GTX450. К счастью, в последнее время такие «финты ушами» почти прекраились.

» Техпроцесс: измеряется в нанометрах, чем он меньше — тем новее GPU и тем меньше его тепловыделение при прочих равных хараткеристиках.

» Количество потоковых процессоров: то, что раньше было «вершинными» и «пиксельными» шейдерными процессорами сейчас приведено в унифицированный вид. Драйвер видеокарты сам решает, сколько блоков будут заниматься обработкой вершин, сколько — обработкой растровых точек. Чем их больше, тем более сложные сцены сможет переварить видеоадаптер, не создавая задержек для остальных вычислительных блоков. Иными словами: больше покововых процессоров — больше спецэффектов в кадре без потери производительности.

» Частота ядра: собственно, определяет скорость работы потоковых процессоров и некоторых других модулей. Больше — лучше.

» Количество текстурных блоков: количество блоков, отвечающих за наложение двухмерных текстур на трёхмерные модели. Чем больше текстурных блоков, тем более чёткие текстуры высокого разрешения можно использовать в настройках игры.

» Количество блоков растеризации (блоков рендеринга): определяет возможности видеокарты по преобразованию готовой картинки в кадр, который будет отправлен дальше на монитор. Чем больше — тем меньше проблем с выводом картинки сверхвысокого разрешения.

» Тип и частота памяти: чем быстрее работает память — тем меньше «бутылочное горлышко» между вычислительным блоком видеокарты и хранимыми на ней данными.

» Шина памяти: второй показатель, характеризующий скорость обмена данными процессора видеокарты с микросхемами, на которых хранятся нужные блоки информации. Перемножив шину памяти на реальную частоту её работы мы получим пропускную способность: несколько лет назад, например, видеокарты Radeon имели шину памяти 256 или 128 бит, но очень высокую частоту работы памяти GDDR5. Видеокарты NVIDIA, напротив, использовали более сложную архитектуру: передавали 192, 256, 384 или 480 бит за раз, но работали с более дешёвой и менее быстрой памятью GDDR3.

Сейчас данные параметры, скорее, важны в бюджетном сегменте, где периодически встречается как недорогая память, так и сильно обрезанная (вплоть до 64 бит) шина. Флагманские же продукты перешли на широкие шины и скоростную память, и меряются, в основном, внутренней арихетктурой и оптимизацией драйверов.

» Объём памяти: как не странно, не очень сильно виляет на производительность, если вы играете на одном мониторе с разрешением 1920х1080 точек. Разницы между одинаковыми или сравнимыми между собой видеокартами с 2, 3, 4 гигабайтами в таком случае вы практически не заметите. Больший объём необходим, если вы используете многомониторную конфигурацию или являетесь энтузиастом в мире ПК: то есть работаете и играете на мониторах с разрешением 2560x1440 и 3840x2160 точек.

» Интерфейс подключения и поддерживаемые версии DirectX / OpenGL: в нынешнем году почти все видеокарты работают с поддержкой обратносовместимых PCI-E 2.0 / 3.0, а 4.0 находится на стадии стандартизации. С OpenGL и DirectX всё тоже достаточно просто: найти новую видеокарту без поддержки необходимых версий сложно, а новомодные ускорители с перспективным DirectX 12 ускореют раньше, чем значительное количество игр начнут широко использовать возможности этих библиотек. Можно не париться на эту тему.

2 ядра, 2 гига, игровая видеокарта

Все помнят этот дурацкий слоган? Из каждого утюга вещал, а плакат с соответствующим заявлением висел на каждой станции метро. Что такое игровая видеокарта? Собственно, вся дискретная графика (кроме самой-самой дешёвой, используемой только по причине того, что в компьютере не было предусмотрено встроенной графики) — так или иначе — игровая.

В классификации NVIDIA минимально-приличными «игровыми» вариантами можно назвать видеокарты, чей индекс заканчивается на 40 и выше: 540, 640, 740, 840 и так далее. Кроме того, сама компания NVIDIA относит к «игровым» карты с префиксом GTX, буквы GT обозначают «мультимедийные» модели. Игрушки на них запустятся, но ни шедевров в области графики, ни потрясающей производительности можно не ждать.

У ATI-AMD к аналогичному сегменту относятся видеоадаптеры, начинающиеся с R7 (для новой линейки) или имеющие индекс не ниже х5хх: 7530, например.

Все видеокарты, имеющие цифры «меньше»: NVIDIA GT820 или Radeon R5 230, скорее, конкуренты для встроенной в процессор графики. Вывести презентацию на проектор, фильм на большой экран, запустить «доту» на минимальных — потянут, но не более.

С точки зрения характеристик, описанных выше, игровой можно назвать ту видеокарту, чьи вычислительные мощности позволяют выводить графику современных игр на средних настройках с частотой хотя бы 20-30 кадров в секунду.

Достаточная производительность

Главный вопрос (помимо бюджета), который предстоит решить перед выбором дискретной видеокарты: что для вас означает «достаточная производительность»? Если вы играете в турнирные шутеры (типа CS:GO), то общая производительность видеосистемы здесь не очень критична. В такие игры играют с минимальной детализацией (для получения преимущества в простоте обнаружения цели), и главным вопросом встаёт разрешение вашего монитора: для «офисных» моделей 1280х1024 и 1376х768 или 1440х990 хватит сравнительно недорогих видеокарточек. FullHD потребует более мощную графику, но всё равно сильно не ударит по кошельку.

Если же вы рассчитываете наслаждаться преимуществами действительно крутой графики (а не той размазни, что нам показывают на консолях под видом NextGen’a), то здесь в ход идут действительно «крутые пушки»: флагманские и предфлагманские модели.

Однако не стоит забывать, что за графику отвечает не только видеокарта, но и создатель игры. Самый красивый бургер в игровой индустрии из Battlefield hardline соседствует со спрайтовыми хабариками и презервативами.

Разрешение и память

Влияние разрешения монитора на производительность графики не заметна, пока мы не переходим от классических разрешений к тому, что нам подарил прогресс: ретина-дисплеям, 4k2k-телевизорам и прочим прелестям в виде 3-6 мониторов для авиа- и авто-симуляторов.

Специалисты из THG сравнивали флагманскую видеокарту AMD 7970 с удвоенными микросхемами памяти, общий объём которых составил 6 Гб с такой же, но обладающей «обычным» набором — 3 Гб. Тестирование производилось на системе Eyefinity-6 (с помощью драйвера ATI шесть мониторов были объединены в одну систему с разрешением 11 520 на 1080 точек.

Как видите, именно в такой нагруженной среде лишние гигабайты дают прирост производительности: где-то — существенный (в полтора раза), где-то — не очень. С другой стороны, одна видеокарта с таким объёмом памяти не позволяет получить приемлемых показателей по количеству кадров в секунду, так что гнаться за «лишними» гигами в играх на данный момент бессмысленно: скорее, потребуется вторая видеокарта для достижения нормального фреймрейта, чем вы упрётесь по памяти в трёхгиговую версию.

Что выбрать?

Если вы сильно-сильно стеснены в средствах, а ваш компьютер вчера взорвался (этот материал вы читаете с калькулятора на перфокартах, не иначе), то оптимальным выбором для игрушек станет покупка процессора AMD A-серии со встроенной графикой.

AMD A6-5400K обладает видеоускорителем HD 7540D, он обеспечит

25-30 кадров в секунду в играх типа Dota2 или League of Legends на средних настройках с разрешением 1080p. В World of Warcraft же придётся играть на «минималках».

Если вы чуть менее стеснены в средствах, на помощь придут ускорители Radeon серии R7: 240, 250, 250X.

Их производительность примерно в полтора-два раза выше (в зависимости от версии), если сравнивать со встроенной в AMD A6 графикой.

Чуть более дорогим решением будет установка NVIDIA GTX750 / GTX750 Ti или AMD R7 260X / R7 265. Они обеспечат беспроблемное существование во всяких MOBA-играх, покажут неплохую картинку в современных гонках и шутерах и позволят не испытывать дискомфорта в online-играх. Средние настройки, FullHD разрешение — без вопросов.

Видеокарты среднего сегмента стоят несколько дороже и обладают, в принципе, сравнимой производительностью.

Вы можете ориентироваться на любую сравнительно современную видеокарту от NVIDIA (760, 960) или AMD (R9 270, 270X, 280, 280Х) — здесь вопрос, скорее, в толщине кошелька.

Залезать «выше» 70-й серии у NVIDIA и 290-й у AMD имеет смысл только в одном случае: у вас стоит монитор с разрешением 2560х1440 и выше. Впрочем, даже такие карты как NVIDIA 770 / 970 будут показывать отличные результаты на средних настройках.

О Sli и Crossfire замолвите слово

Ощутимый прирост по производительности, вы, конечно же, получите: поставив две GTX970 вместо одной 980 вы получите примерно в полтора раза больше показатели производительности и примерно такое же увеличение стоимости компьютера. Проблема заключается в том, что через пару-тройку лет вам захочется обновить видеокарту, и надо будет продавать не одну, а две старых железки, и потеряете вы и на курсе доллара, и на том, что железка подешевела втрое. Каждая. Добавьте сюда дополнительные мощности БП, за которые необходимо будет также заплатить… В общем, финансовая картинка не из самых приятных.

Вторая неприятность: драйверы и игры. Не во всех играх производительность двух видеокарт в связке будет существенно выше, чем одной, но более мощной.

Разные производители

Не смотря на то, что разрабатывают дискретные видеоускорители две компании: NVIDIA и AMD, производством и модернизацией «базового» дизайна занимаются многие вендоры: самые популярные — ASUS, MSI, Gigabyte, EVGA. Чуть менее популярные, но часто встречающиеся — Sapphire, Zotac, XFX. Остальные производители, обычно, относятся к сегменту «лоукостеров» и постоянно пытаются на чём-нибудь экономить (в основном — на питании), выбирать их варианты видеокарт стоит только если у вас нет в запасе 5-10% стоимости железки на «спать спокойно». В любом случае, у нас отличный гарантийный сервис, и если что с видеокарточкой и случится, вам её без проблем заменят или отремонтируют.

В основном производители изменяют дизайн цепей питания, увеличивают рабочие частоты, создают разной извращённости системы охлаждения и меряются длиной гарантии. Об отличиях можно почитать, загуглив конкретную модель видеокарты, например, ASUS ROG MATRIX-GTX780TI – такая карточка может выдавать на 3-5% более высокие показатели, чем какой-нибудь аналог от Gigabyte или MSI. В целом, ориентироваться надо на отзывы в магазине, обзоры и результаты бенчмарков. Панацеи и гарантированного решения в виде Z лучше, чем Y — нет.

Общие советы

Видеокарты устаревают очень и очень быстро. Если вы берёте компьютер на несколько лет вперёд — не гонитесь за флагманской моделью самого свежего поколения: она стоит неадекватных денег, и нередко через год теряет до 50% стоимости даже на полках магазинов. Присмотритесь к флагманам или пред-флагманам прошлого поколения, их производительность не будет сильно отличаться от моделей этого года, а вот цена может приятно порадовать.

Titan Z — бессмысленный и беспощадный.

Выбирайте видеокарту под своё железо и потребности. Модели из топовых сегментов стоят дорого, более того, если производительность разных видеокарт за 100 и 200 долларов могут отличаться в два-три раза, то разница между 200 и 300-долларовыми экземплярами может быть в скромные 10%: например, если вы играете в Dota-подобные игры или гоняете в «Картошку» — разницы между NVIDIA 760 и NVIDIA 980 вы не увидите, особенно если ваш процессор — старенький двухъядерный Intel Core i3. :)

Апгрейд видеокарты имеет смысл проводить, если вас совершенно не устраивает производительность: обычно прирост «синтетической» производительности между поколениями (4xx и 5xx, 5хх и 6хх и т.д. у NVIDIA) составляет около 10-15%, реальной — вдвое меньше. Менять вашу NVIDIA 560 на 660 или 760 нет смысла, а вот замена её на 960-ю (800-е поколение по непонятным причинам маркетологи пропустили) — вполне здравое решение. И прирост производительности будет ощутимый, и энергопотребление немного снизится, и памяти будет больше.

Громоздкий полноценный башенный компьютер (Full Tower) всегда является лучшим выбором, если вы хотите получить место для установки нескольких видеокарт, иметь возможность обновлять компьютер или установить в него накопители вместимостью в несколько терабайт.

- Размер корпуса

- Обращайте внимание на питание

- Низкопрофильные видеокарты

- Рекомендации по выбору карт

- Лучшая для 4K в блоке от малого до среднего: Nvidia GeForce RTX 3070 Founders Edition

- Лучшая для разрешения 1440p и 4K в полукомпактном корпусе: Nvidia GeForce RTX 3060 Ti Founders Edition

- Лучшая для бюджетных компьютеров: Zotac GeForce GTX 1650 Super Twin Fan

- Лучшая для мониторов с высокой частотой обновления на разрешении 1080p: Zotac GeForce GTX 1660 Super Twin Fan

- Лучшая для 1440p и лёгких игр в 4K: Zotac GeForce RTX 2060 Amp

- Лучшая для распространённых игр 1080p: Gigabyte GeForce GTX 1660 OC 6G

- Лучший выбор из прошлого поколения: MSI GeForce GTX 1050 Ti 4G OC

- Лучшая бюджетная при переходе от встроенной графики: Asus Radeon RX 550 4G

- Лучшая для компактных сборок со слабым питанием: Zotac GeForce GTX 1650 OC

Всё больше компьютерных энтузиастов и производителей компьютеров проявляют интерес к компактным и при этом быстрым системам. Многие производители корпусов предлагают модели довольно скромных размеров, где есть место для средних и даже полноразмерных видеокарт.

Например, модель компьютера SilverStone Sugo SG12 размером с коробку для обуви позволяет установить видеокарту длиной более 30 см. В результате можно поставить наиболее крупные из существующих мощных видеокарт, таких как Nvidia GeForce GTX 3080.

Специализированные компактные корпуса часто требуют материнских плат формата MicroATX или Mini-ITX вместо стандартных и обычно менее дорогих полноразмерных плат ATX. Их необычные размеры означают, что здесь способны поместиться большие видеокарты, но не большие материнские платы.

Можно создать игровую систему ещё меньшего размера, используя по-настоящему компактные корпуса вроде Cooler Master Elite 110 с параметрами 275 х 250 х 275 мм. Сюда могут войти процессоры Intel Core i7-9700K или i5-10600K и видеокарты вроде Zotac GeForce GTX 1650 Super Twin Fan и одна из карт на основе GeForce GTX 1660 или GTX 1660 Super. Они не самые мощные из существующих, но поддерживают игры виртуальной реальности и наиболее тяжёлые обычные игры на высоких настройках графики с разрешением 1080p.

Размер корпуса

При выборе видеокарты наиболее важным параметром является доступное для её установки место в корпусе. Часто это указывается в разделе спецификаций или в онлайн-руководстве. Желающие самостоятельно могут снять боковую панель корпуса и примерно оценить доступное пространство при помощи рулетки или линейки.

Лучшие видеокарты для майнинга криптовалют в 2021 годуВнутри корпуса нужно найти участок, где располагаются защёлки на слоте PCI Express, обычно сзади. Это место, где разъёмы видеокарты выступают через заднюю сторону системного блока. Измеряя отсюда, параллельно слоту PCI Express, куда устанавливаются видеокарты, ищите первое препятствие.

Это и будет максимальная длина карты, если на ней нет выступающих на конце разъёмов для подключения питания. Если есть, нужно сделать поправку на них. Чаще всего такие разъёмы находятся наверху современных видеокарт.

Если вы хотите установить мощную игровую видеокарту, нужно убедиться в наличии пространства для установки карты на два слота расширения. Почти все такие карты занимают именно два слота. Некоторые очень компактные компьютерные корпуса могут не обладать достаточным пространством между слотом PCI Express и ближайшей стенкой корпуса. Это может помешать установить видеокарту нужного размера.

Если вы обновляете существующий компьютер, желательно проверить хотя бы на глаз.

Расстояние между участком с крепежами и ближайшим объектом на другой стороне корпуса, вроде отсека для жёстких дисков или стенки самого корпуса, определяет, карта какой длины может поместиться. Если свободного пространства в системном блоке 262 мм или больше, можно будет установить по крайней мере некоторые современные мощные карты, в том числе на основе моделей Nvidia GeForce RTX 3070 и GeForce RTX 3080.

AMD среди таких мощных карт предлагаются Radeon RX 6800 и RX 6800 XT, референсные версии которых имеют длину как раз 262 мм. Некоторые карты сторонних производителей длиннее и намного, так что нужно проверять. Например, можно найти карты GeForce RTX 3070 длиной меньше 250 мм, а некоторые RTX 3060 Ti длиннее чем 300 мм. Смотрите спецификации.

Для небольших системных блоков, где есть место для полноразмерных видеокарт, нужна карта с воздушным охлаждением длиной 200 мм или меньше. Часто это корпуса с материнскими платами Mini-ITX, где место очень ограниченно. 200 мм может показаться минимальным значением, но по меркам игровых мощных видеокарт это немного. Однако, даже в таком случае существуют варианты.

Обращайте внимание на питание

Ещё одним фактором при сборке компактного компьютера является прокладка кабелей от блока питания. Многие карты обладают силовыми коннекторами наверху, многие компактные корпуса и Mini-ITX поддерживают подобный дизайн, но некоторые предпочитают контакты на задней стороне карты.

Если вы уже работаете в ограниченном пространстве и каждый сантиметр видеокарты на счету, нужно убедиться, что когда вы подключаете её к блоку питания, остаётся достаточно места для других компонентов.

При этом нужно знать, что многие компактные видеокарты обходятся без подключения кабеля от блока питания. Моделям вроде Zotac GeForce GTX 1650 OC хватает питания от слота PCI Express, куда они установлены.

Читайте также: