Почему видеокарта на 2 гб а используется 1 гб

Обновлено: 07.07.2024

Ну для начала давайте прочтем термин и разберемся, что такое видеопамять и о ее некоторых отличиях от ОЗУ , а также её разновидностях.

Это внутренняя оперативная память, отведённая для хранения данных, которые используются для формирования изображения на экране монитора.

При этом в видеопамяти может содержаться как непосредственно растровый образ изображения (экранный кадр), так и отдельные фрагменты как в растровой (текстуры), так и в векторной (многоугольники, в частности треугольники) формах.

Как правило, чипы оперативной памяти современной видеокарты припаяны прямо к текстолиту печатной платы, в отличие от съёмных модулей системной памяти, которые вставляются в стандартизированные разъёмы ранних видеоадаптеров.

При изготовлении видеокарт уже достаточно давно используется память GDDR3 . На смену ей пришла GDDR4 , которая имеет более высокую пропускную способность, чем GDDR3 ; однако GDDR4 не получила широкого распространения вследствие плохого соотношения «Цена-производительность» и ограниченно использовалась лишь в некоторых видеокартах верхнего ценового сегмента (например Radeon X1950XTX, HD 2900 XT, HD3870 ). Далее появилась память GDDR5 , которая по состоянию на 2012 год является наиболее массовой, GDDR3 используется в бюджетном сегменте. В 2018 году в топовых видеокартах устанавливается память типа HBM и HBM2 , GDDR5X и GDDR6 .

Также видеопамять отличается от «обычной» системной ОЗУ более жёсткими требованиями к ширине шины.

Графическая шина данных — это магистраль, связывающая графический процессор и память видеокарт.

Имеет значение соотношение количества памяти, её типа и ширины шины данных: 512 МБ DDR2 , при ширине шины данных в 128 бит , будет работать медленнее и гораздо менее эффективно, чем 256 МБ GDDR3 при ширине шины в 128 бит и т. п. По понятным причинам, 256 МБ GDDR3 с шириной шины 256 бит лучше, чем 256 МБ GDDR3 с шириной шины в 128 бит и т. п.

Также стоит учитывать, что из-за относительно невысокой стоимости видеопамяти многие производители видеокарт устанавливают избыточное количество видеопамяти ( 4, 6 и 8 Гбайт ) на слабые видеокарты с целью повышения их маркетинговой привлекательности .

GDDR5 более подробно

GDDR5 — 5-е поколение памяти DDR SDRAM, спроектированной для приложений, требующих более высокой рабочей частоты. Как и её предшественник (GDDR4), GDDR5 основана на памяти DDR3, которая имеет удвоенные, по сравнению с DDR2, DQ (Digital Quest) каналы связи, но у GDDR5 также есть буферы предварительной выборки шириной 8 битов, как у GDDR4.

Кто принял участие в разработке и как долго она длилась?

В разработке стандарта, вместе со всеми основными производителями памяти ( Hynix , Qimonda и Samsung ) и JEDEC , активно участвовала и компания AMD . Разработка этого типа памяти заняла около трёх лет от начала разработок, до окончательной спецификации, а в AMD — ещё больше.

Производство

Первые чипы, поддерживающие напряжение 1,5 В (в отличие от 2,0 В для GDDR3 ) и имеющие плотность 0.5—2 Гбит , предлагали скорость передачи до 1000*4=4,0 ГГц . В дальнейшем этот параметр увеличился до 7 ГГц .

В ноябре 2009 г. компания Elpida Memory представила микросхему памяти GDDR5 плотностью 1 Гб , обеспечивающую передачу данных со скоростью 6 Гб/с ; в июне 2010 она представила микросхему памяти GDDR5 плотностью 2 Гб , изготовленной по нормам 50 нм с применением медных внутренних соединений.

В начале 2015 г . компания Samsung Electronics объявила о начале серийного выпуска первых в мире микросхем памяти GDDR5 плотностью 8 Гб ( предназначена для графических карт , используемых в ПК и суперкомпьютерах , для игровых консолей и ноутбуков ); память выпускается по 20-нм технологии. Компания Samsung Electronics , являющаяся крупнейшим поставщиком микросхем памяти, осенью 2010 объявила о расширении инициативы « Green Memory » («Зеленая память», с пониженным энергопотреблением) и на графическую память для ПК ; теперь инициативы, наряду с памятью DRAM и твердотельными накопителями ( SSD ), распространяется также и на память Samsung LPDDR2 и GDDR5.

Частота

GDDR5 использует две тактовые частоты, CK и WCK , последняя в два раза больше первой. Команды передаются в режиме SDR (стандартная тактовая частота) на частоте CK ; адресная информация передаётся в режиме DDR на частоте CK ; а данные передаются в режиме DDR на частоте WCK . Интерфейс GDDR5 передает два информационных слова шириной 32 бита за тактовый цикл ( WCK ) через выводы микросхемы памяти. Соответствуя 8n предварительной выборке, единичный доступ для чтения или записи состоит из двух передач данных шириной 256 бит за тактовый цикл ( CK ) внутри ядра памяти и восьми с оответствующих половинных передач данных шириной 32 бита за тактовый цикл ( WCK ) на выводах микросхемы памяти.

Например, для GDDR5 со скоростью передачи данных 5 Гб/с ( Gbps ) на вывод CK подается тактовая частота 1,25 ГГц , а WCK c частотой 2,5 ГГц . Также часто употребляется эффективная частота ( QDR ), поскольку, как написано выше, данные передаются на частоте WCK в режиме DDR . В приведенном примере эта частота составляет 5 GHz .

В связи с наличием двух частот ( CK, WCK ) производители изделий использующих GDDR5 могут указывать разные частоты для памяти, хотя скорость передачи данных может не отличаться. Nvidia указывает частоту WCK , AMD — частоту CK .

Почему не GDDR3? Шина памяти

Память типа GDDR5 обеспечивает вдвое большую пропускную способность по сравнению с GDDR3 . Для повышения пропускной способности у памяти GDDR3 приходилось использовать 512 -битную шину, это приводило к тому, что увеличивается и чип , и его упаковка . Это увеличивало себестоимость , да и сами карты становились больше и сложнее, потребляя больше энергии. Переход на использование GDDR5 позволяет увеличить производительность (при 128/256 -битной шине) в 2—3 раза при даже меньших размерах чипов и меньшем потреблении энергии. Новый дизайн интерфейса памяти вызывает значительное увеличение эффективности использования полосы пропускания.

Несмотря на то, что чипы памяти GDDR5 стали дороже, чем GDDR3 , особенно в начале её широкого применения, узкая ширина шины памяти позволяет упростить дизайн ПП , что дает преимущество, так что это перспективное решение.

Перспективы, которые длятся более 10 лет для GDDR5

С момента выхода первого графического ускорителя, использующего память GDDR5 ( ATI Radeon HD 4870 , июнь 2008 ) прошло более десяти лет — больше, чем продержались другие типы графической памяти. Но расти далее уже особо и некуда — из возможностей GDDR «выжато» почти все. В стандарте GDDR5 нынешний тип памяти достиг своего предела, и хотя небольшие возможности для роста ПСП ещё есть, но они требуют слишком больших усилий и не изменят ситуацию кардинально. Но самое главное — вопрос высокого энергопотребления не решился до сих пор (при этом энергоэффективность — главный параметр для любого современного чипа) — даже текущие поколения GDDR5 -памяти уже потребляют слишком много энергии из-за сложных механизмов тактования и работы на очень высокой частоте, а любые улучшения её производительности связаны с дальнейшим повышением частоты и сложности чипов, а значит, и энергопотребления.

Также чипы GDDR5 занимают слишком много места на плате видеокарты и требуют применения нескольких каналов памяти, что усложняет сам графический процессор (особенно если говорить о топовых GPU с 384/512 -битной шиной памяти).

Для решения этих и других проблем был анонсирован (компаниями AMD и Hynix в 2011 г.) а впоследствии разработан и внедрен новый стандарт памяти — High Bandwidth Memory (HBM).

Что будет с этим типом памяти?

Вероятнее всего с конца 2020 - начала 2021 года, эта память будет использоваться только в бюджетных или возможно средних видеокартах до 4 гб, ради решений быстрого видеоадаптера, но бюджетного варианта.

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Встроенные или интегрированные (iGPU) в современные процессоры видеокарты справляются со многими компьютерными играми. Для AAA-проектов на высоких настройках они не годятся, но кое что все же могут. Рассмотрим особенности работы встроенных графических ускорителей с памятью.

Сколько памяти у встроенной видеокарты

Интегрированные видеокарты не имеют собственной памяти. Ее черпают из оперативной памяти: в зависимости от настроек BIOS/UEFI или операционной системы, Windows резервирует определённый объём оперативной памяти, которая используется встроенным видеоускорителем в качестве видеопамяти (VRAM).

Обычно графика встраивается в центральный процессор, на некоторых ноутбуках распаивается на материнской плате. Во втором случае это самостоятельное, но несъемное устройство – псевдодискретная графика.

Установленный по умолчанию объем VRAM колеблется от 32 до 2048 МБ в зависимости от модели процессора или «материнки».

Как увеличить или уменьшить объем видеопамяти

Размер выделяемой операционной системой встроенной видеокарте памяти изменяется двумя способами:

- Автоматически или динамически – система выделяет такой объём ОЗУ, который на данный момент необходим графическому процессору для выполнения поставленных задач.

- Вручную – фиксированное значение, установленное на заводе или пользователем вручную.

Зачем изменять размер видеопамяти?

Объем видеопамяти увеличивается для повышения производительности интегрированного видеоядра, запуска приложений и игр, которым недостаточно выделенного по умолчанию объёма VRAM. Уменьшается, чтобы освободить приложениям и Windows больше ОЗУ, если текущие задачи задействуют почти всю оперативку. Отображается объем задействованной памяти во вкладке «Производительность» Диспетчера задач.

При изменении размера графической памяти важен баланс. Отданная для видеокарты ОЗУ резервируется операционной системой и не может использоваться ею либо приложениями. Если на компьютере установлено мало ОЗУ – 2-4 ГБ, смысл в выделении большого объема видеопамяти в ущерб оперативной есть не всегда.

Чем шустрее используется «оперативка», тем выше производительность встроенного видеоядра. При одинаковой конфигурации компьютера ПК с DDR4-3200 выдаст больше кадров в секунду, чем с DDR3-2400. Многое зависит и от самих модулей, задач, метода тестирования.

Положительно на быстродействии графики сказывается разгон оперативки, но прирост FPS не превышает нескольких процентов.

Где посмотреть объем

Увидеть, сколько памяти выделено интегрированному графическому ядру, можно несколькими способами.

Параметры Windows 10

Или вместо этого выполните «ms-settings:easeofaccess-display» в окне Win + R.

Диспетчер задач

Первая цифра – занятая память, вторая – выделенная.

Также процент задействования VRAM отображают сторонние утилиты, например, HWiNFO.

Изменить через BIOS

Расширяется и урезается графическая память в настройках BIOS/UEFI.

Посетите BIOS Setup вашего компьютера. Чаще всего после перезагрузки ПК в момент отображения заставки нужно нажать Delete или F2 (смотрите инструкцию по эксплуатации материнской платы или ноутбука). В Windows 10 для этого отключается «Быстрый запуск».

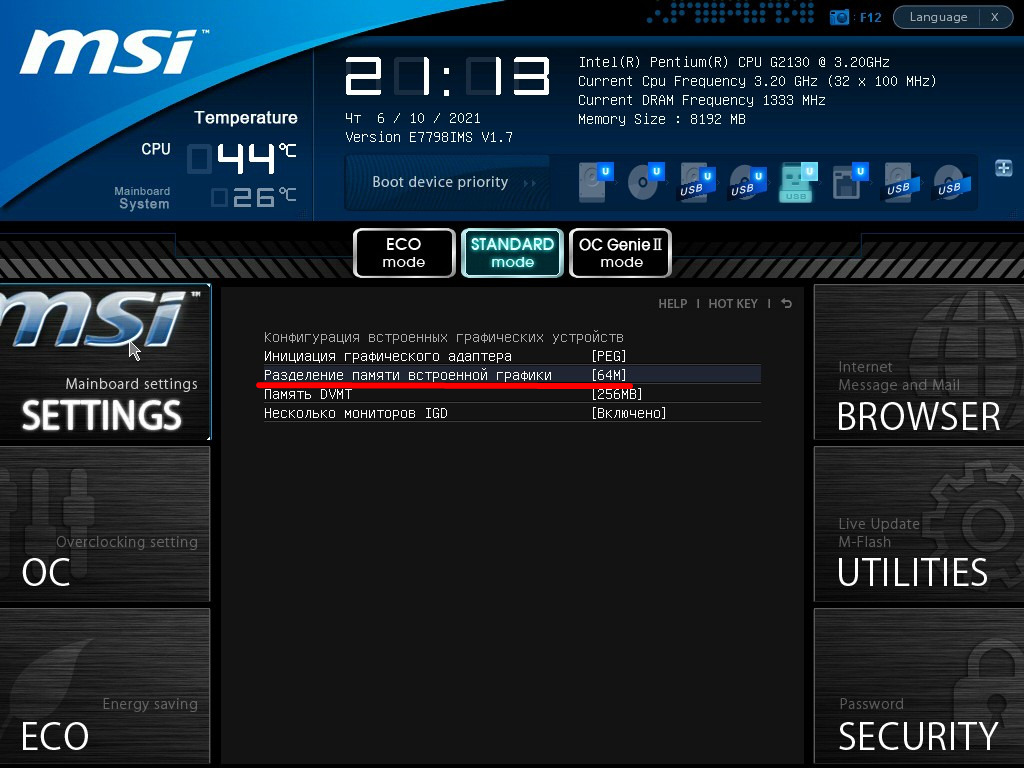

Дальнейшие действия могут отличаются для различных производителей BIOS/UEFI, но в целом они похожи. Рассмотрим на примере материнки от MSI.

В разделе «Mainboard settings» посетите подраздел «Конфигурация встроенной графики».

Откройте окно выбора параметров «Разделение памяти встроенной графики».

Укажите нужный объём, после чего нажмите F10 для выхода с сохранением настроек.

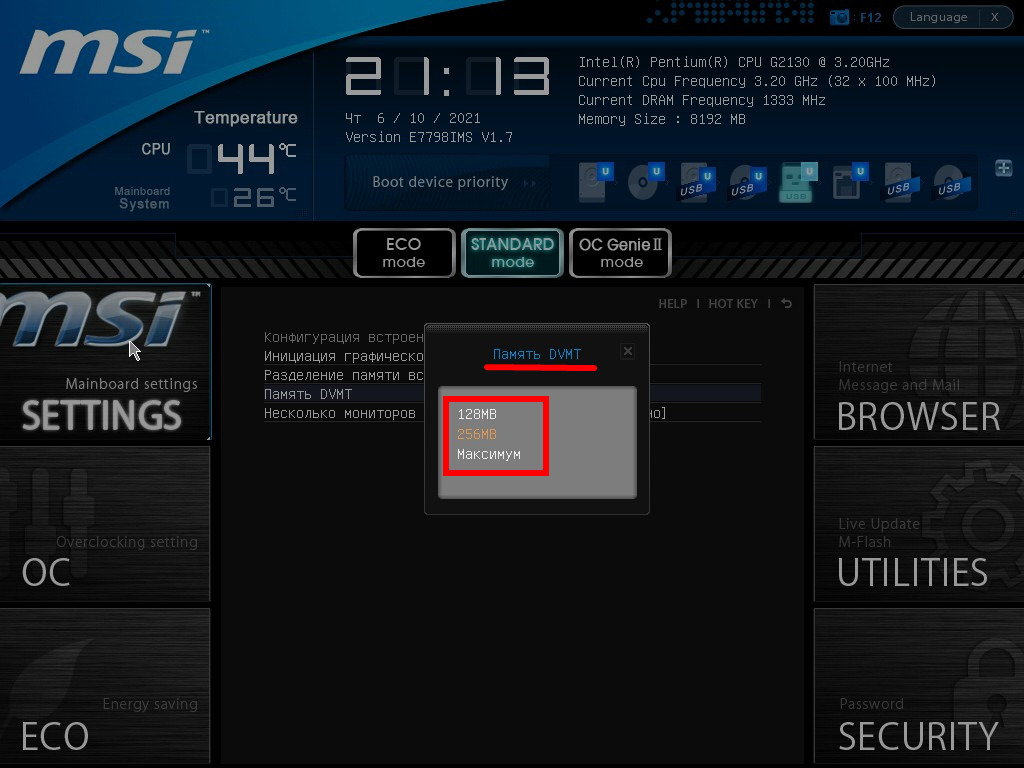

Также в списке находится параметр «Память DVMT» или Dynamic Video Memory Technology – технология динамического выделения памяти. При включении опции видеокарте выделяется столько видеопамяти, сколько она требует в зависимости от нагрузки, при отключении – весь указанный объем резервируется постоянно.

В настройках можно указать максимальный размер ОЗУ, отдаваемый под VRAM.

Параметр может называться «Graphics Adapter Size», «UMA Frame Buffer Size», «Shade Memory», «Video Memory Size» и им подобные, находиться в разделах «Chipset», «Advanced Mode», «Chipset Configuration», «Advanced».

Иногда при включении DVMT память видеокарте выделяется, но приложения её не видят и, соответственно, не запускаются. Выдают ошибку, что объём выделяемой для графики памяти меньше минимальных системных требований игры или программы.

Реестр

Изменяется значение и через реестр. Такой прием удобно использовать если игра не запускается с ошибкой о нехватки видеопамяти.

Вызовите редактор реестра: зажмите Win + R, выполните «regedit».

В ветке «HKLM\Software\Intel» создайте подраздел «GMM».

В него добавьте «Параметр «DWORD (32 бита)».

Назовите его «DedicatedSegmentSize»: через правый клик вызовите «Переименовать» и введите название.

Два раза щелкните по записи левой клавишей, переключите систему счисления на десятичную.

Введите значение, например, «1024» и жмите «ОК», после чего перезагрузите компьютер.

Сколько ставить

Рекомендуется выделять максимально возможный объём памяти для графического ускорителя при условии, что на компьютере достаточно для решения поставленных задач ОЗУ. Если ее мало, стоит активировать опцию DVMT и выставить наибольшее значение. Система автоматически будет выделять оперативку под нужды видеокарты и «забирать» ее, когда потребность во VRAM снижается.

Влияние характеристик оперативной памяти на производительность iGPU

Скорость оперативной памяти оказывает влияние на быстродействие компьютера в играх, частоту кадров. При замене планок с частотой памяти 1866 Гц на 2400 Гц стремительного роста производительности ждать не стоит. Прирост FPS будет незначительным – до нескольких кадров или процентов в секунду. Всё зависит от конфигурации оборудования и самой игры.

Стоит ли заменить оперативку на более быструю, чтобы увеличить FPS в играх?

Как правило такая замена добавляет всего несколько процентов прироста. Если можете достать память задешево можете обновить, иначе я бы не стал заморачиваться.

Доброго времени!

В последнее время снискали большую популярность интегрированные (их еще называют встроенными ) видеокарты IntelHD, Intel Iris Xe, и AMD Ryzen Vega. Последних версий уже с лихвой хватает для многих не слишком требовательных игр (что, конечно, радует — т.к. получается хорошая такая экономия на покупке внешней видеокарты)!

Однако, есть один нюанс : видеопамять для этих карт выделяется из ОЗУ (RAM). По умолчанию эта операция "выделения" происходит автоматически (без вашего участия), что не во всех случаях оптимально (например, вы можете столкнуться с ошибками во время запуска игр. ).

Разумеется, было бы не плохо вручную отрегулировать выделение памяти под интегрированную карту (в большинстве случаев стоит вопрос ее увеличения ).

И так, перейдем ближе к теме.

Как увеличить видеопамять: по шагам

ШАГ 1: зачем это нужно

Вообще, если у вас все корректно работает, нет притормаживаний, ничего не зависает и не вылетает с ошибками — то вам, скорее всего, это и не нужно.

Однако, есть ситуации, когда без этого никак:

3DMark Sky Driver (8GB Ram, dual) — производительность в зависимости от выделенной памяти для интегрированной видеокарты AMD Ryzen Vega 11 (Ryzen 5 2400G)

Примечание!

ШАГ 2: как узнать текущий объем видеопамяти

Это универсальный вариант, работающий во всех популярных версиях Windows 7/8/10.

Сначала необходимо нажать сочетание кнопок Win+R — в окне "Выполнить" ввести команду dxdiag и кликнуть по OK.

Видеопамять 1009 МБ

Нажать сочетание Win+i — откроется окно с параметрами Windows. Необходимо перейти в раздел "Система / дисплей" и открыть вкладку "Дополнительные параметры дисплея" .

Доп. параметры дисплея

В ней будет заветная ссылка — "Свойства видеоадаптера" .

Во вкладке "Адаптер" представлена строка "Используется видеопамяти" (в моем примере ниже - 1024 МБ).

Этот вариант также актуален для ОС Windows 10.

Диспетчер задач - Windows 10

ШАГ 3: как вручную установить размер выделения памяти под встроенную видеокарту

Через BIOS/UEFI

Только через настройки BIOS (в принципе) и можно изменить размер выделяемой памяти для интегрированной карты (в редких случаях можно попытаться "обмануть" игры через реестр).

Здесь универсальных инструкций со стрелками дать нельзя, т.к. у каждого производителя - "свой" BIOS. Но несколько характерных примеров я приведу (по ним можно будет сориентироваться!).

Далее нужно перейти в раздел "Configuration" (в некоторых BIOS за это отвечает раздел "Advanced" ).

Lenovo Setup Utility - главное окно

Затем нам нужно найти один из следующих параметров (прим.: в разных версиях BIOS он называется по-своему) :

- UMA Frame Buffer Size;

- iGPU Configuration;

- DVMT (Fixed Memory);

- Share Memory Size;

- Video Memory Size;

- On-Chip Frame Buffer Size.

На скриншоте ниже приведен параметр "iGPU Configuration" — необходимо отключить авто-режим!

Отключаем Auto режим

UMA Frame Buffer Size — ставим 2 GB

Кстати, в версии BIOS от American Megatrends для изменения выделяемой памяти — нужно во вкладке "Advanced" изменить параметр "DVMT" .

Advanced / настройки BIOS / American Megatrends

DVMT ставим на Maximum

Share Memory Size - выделение памяти видеосистеме

Разумеется, после выставления размера выделяемой памяти — не забудьте сохранить настройки (в большинстве версий BIOS - используется клавиша F10 / Save and Exit) и перезагрузить компьютер/ноутбук.

Через настройки реестра (опционально для IntelHD)

Этот способ поможет только "перехитрить" некоторые игры, которые могут вылетать с ошибками после запуска (т.к. у вас якобы недостаточно видеопамяти). Т.е. игра будет "считать", что размер памяти видеокарты у вас больше, чем есть на самом деле.

Причем, хочу отметить, что срабатывает он не всегда (но всё же, вдруг. ).

regedit — открыть редактор реестра

Далее в редакторе нужно создать раздел "GMM" в нижеприведенной ветке:

Создать раздел GMM

После, в разделе "GMM" создать строковый параметр с именем "DedicatedSegmentSize" (без кавычек).

Создать строковый параметр

Далее открыть его и задать значение выделяемой памяти (судя по тестам, способ актуален и работает для значений от 0 до 512).

Читайте также: