Разгон видеокарты nvidia geforce 920m на ноутбуке

Обновлено: 06.07.2024

Из статьи читатель узнает об одном из простых, но эффективных способов разгона видеокарт серии GeForce от nVidia. Для разгона не потребуется каких то особых знаний или умений. Любой обладатель такой видеокарты сможет самостоятельно сделать все необходимое, и в итоге немного увеличить производительность своего графического ускорителя.

Для разгона на компьютере необходимо установить несколько небольших бесплатных программ, ссылки на загрузку которых приведены в тексте статьи.

Разгон видеокарты и связанные с ним риски

Разгон видеокарты - это изменение некоторых штатных параметров ее работы, вследствие чего увеличивается ее производительность (в среднем на 5-20%). Во многих случаях разгон позволяет пользователю комфортно играть в компьютерные игры, которые на стандартных настройках его видеокарта не "вытягивает". Следовательно, благодаря разгону можно сэкономить денег, отложив или вообще отказавшись от приобретения более производительной видеокарты.

Но не все так просто, как кажется на первый взгляд. Есть у этого всего и обратная сторона. Дело в том, что видеокарта в разогнанном состоянии более подвержена вероятности выхода из строя. Приступая к разгону, вы должны четко осознавать, что своими действиями вы можете повредить аппаратную часть компьютера . Прибегать к разгону следует, если ради увеличения производительности видеокарты вы готовы рискнуть.

С другой стороны, если к разгону подойти с умом и не пытаться выжать из видеокарты слишком много, этот риск становится не значительным.

Необходимо учитывать, что при разгоне увеличивается мощность электроэнергии, потребляемая видеокартой. Перед разгоном желательно убедиться, что сила тока блока питания по линии +12В с запасом превышает потребности видеокарты. В противном случае блок питания может стать причиной нестабильной работы компьютера.

Об оценке соответствия блока питания требованиям компьютера читайте здесь.

В статье рассматривается один из способов разгона видеокарт серии GeForce. Чтобы сделать статью более наглядной, автор построил ее в форме описания разгона "подопытной" видеокарты GeForce GTS 450. Аналогичным образом можно разгонять любую карту от nVidia GeForce. Ниже расположены изображения с описанием всех необходимых действий.

Если у вас графический адаптер от ATI (Radeon), читать статью смысла нет.

Чтобы разогнать видеокарту пользователю нужно увеличить следующие параметры ее работы:

• частота графического ядра;

• частота шейдерных блоков.

Для обеспечения стабильности работы с новыми параметрами придется также немного повысить напряжение питания видеокарты.

Углубляться в описание указанных параметров не будем. Кому интересно - читайте о них здесь.

Разгон видеокарты GeForce

Перед началом разгона необходимо узнать показатели указанных выше параметров видеокарты в обычном состоянии. С этой целью можно использовать бесплатную утилиту GPU-Z.

После установки и запуска утилита GPU-Z покажет подробную информацию о видеокарте компьютера, в том числе и необходимые нам данные.

На изображении видно, что подопытная GeForce GTS 450 в штатном режиме имеет следующие параметры (обведены красным):

• частота графического ядра (GPU Clock) - 783 MHz;

• частота шейдерных блоков (Shader) - 1566 MHz;

• частота памяти видеокарты (Memory) - 902 MHz (1804).

Обратите также внимание на то, что с такими параметрами видеокарта GeForce GTS 450 демонстрирует следующую продуктивность (обведены зеленым):

• PixelFillrate - 6,3 GPixel/s

• TextureFillrate - 25,1 GTexel/s

• пропускная способность памяти (bandwidth) - 57,7 GB/s.

Для изменения указанных параметров будем использовать бесплатную программу nVidia Inspektor.

Программа nVidia Inspektor не требует установки. После загрузки просто запускаем ее. Откроется окно, в нижнем правом углу которого находится кнопка с названием "Show Overclocking". На нее нужно нажать мышкой и в следующем диалоговом окне подтвердить открытие дополнительных параметров (нажать кнопку "Да").

После этого откроется панель разгона видеокарты (см. изображение).

Сначала поднимем значение частоты ядра (GPU Clock) и частоты шейдерных блоков (Shader Clock). Эти параметры взаимосвязаны. Поэтому повышение частоты шейдерных блоков автоматически повлечет за собой рост частоты графического ядра. Для повышения необходимо ползунок Shader Clock передвинуть вправо. Увеличивать частоту больше чем на 15% от исходной не рекомендую.

Если для нашей GeForce GTS 450 поднять Shader Clock на 15 % от исходных (1566 MHz), получится где-то около 1800 MHz. В случаях с другими видеокартами показатели, естественно, будут другими.

Увеличив Shader Clock можно увидеть, что вслед за ней увеличится и частота графического ядра. Для GeForce GTS 450 Shader Clock был увеличен до 1800 MHz, частота графического ядра автоматически поднялась до 900 MHz (см. скриншот). Чтобы изменения вступили в силу, необходимо нажать кнопку "Apply Clock&Voltage" .

Перед тем, как переходить к повышению частоты памяти видеокарты, необходимо убедиться в стабильности ее работы с новыми параметрами ядра и шейдерных блоков. С этой целью видеокарту нужно протестировать на выполнении какой-то задачи, связанной с обработкой графических данных. Прекрасным тестом стабильности является бесплатная программа FurMark.

Для проверки видеокарты устанавливаем и запускаем FurMark. В окне программы жмем кнопку "BURN-IN test" и наблюдаем за картинкой ("вращающийся волосатый бублик", см. изображение). Если в течение продолжительного времени (не менее 10-15 мин.) на изображении не будет появляться никаких артефактов (мерцание, точки, мигание и другие признаки нестабильности), значит видеокарта с новыми параметрами работает нормально.

Кроме того, во время тестирования FurMark необходимо следить за температурой видеокарты . График температуры отображается в нижней части окна FurMark. Температура не должна превысить 90 градусов С.

Если появятся артефакты или температура станет слишком высокой, необходимо остановить тест (нажав кнопку Escape), немного снизить частоту видеоядра и шейдерных блоков (в программе nVidia Inspektor) и затем повторить тестирование.

Когда будет найдена оптимальная частота для ядра и шейдерных блоков, можно продолжить разгон видеокарты. Возвращаемся в окно программы nVidia Inspektor и таким же способом увеличиваем частоту памяти видеокарты (передвигаем вправо ползунок Memory Clock). После изменения параметров для вступления их в силу не забудьте нажать кнопку "Apply Clock&Voltage".

Стабильность работы видеокарты с разогнанной памятью также необходимо проверить при помощи теста FurMark. Если появятся артефакты, частоту памяти нужно снижать до достижения стабильности.

В случае с нашей подопытной GeForce GTS 450 частота памяти была увеличена на 15 % с 1804 MHz до 2075 MHz.

Определение максимальных рабочих частот для видеоядра, шейдерных блоков и памяти - это самый длительный и сложный этап разгона. После его завершения останется только немного поднять напряжение питания видеокарты чтобы обеспечить более высокую стабильность ее работы. С этой целью в окне программы nVidia Inspektor нужно немного (на 1 "шажок") сдвинуть вправо ползунок "Voltage". Для GeForce GTS 450 напряжение было увеличено с 1,075 V до 1,125 V. Для вступления изменений в силу не забываем нажать кнопку "Apply Clock&Voltage" (см. изображение выше).

Новые настройки видеокарты программа nVidia Inspektor позволяет сохранить в отдельный файл. В дальнейшем для того, чтобы быстро перевести видеокарту из обычного состояния в разогнанное, достаточно будет просто запустить этот файл.

Создадим такой файл для осуществленных нами настроек. Для этого в окне программы необходимо нажать кнопку "Creat Clocks Chortcut". Файл с настройками будет создан на рабочем столе компьютера.

Если вы хотите, чтобы ваша видеокарта автоматически разгонялась при включении компьютера , нужно добавить этот файл в папку с названием "Автозагрузка". Windows во время запуска открывает все файлы, находящиеся в этой папке, благодаря чему видеокарта будет автоматически разгоняться при включении компьютера.

В Windows XP, Vista, 7 папка "Автозагрузка" расположена в меню "Пуск". Нужно найти ее там, щелкнуть по ней правой кнопкой мышки и в появившемся меню выбрать "Открыть".

В Windows 8 и Windows 10 открыть папку "Автозагрузка" немного сложнее. Подробные рекомендации по этому вопросу расположены здесь.

Видеокарту также можно разогнать "навсегда" , то есть, сделать так, чтобы она постоянно работала на повышенных частотах графического ядра и видеопамяти без использования nVidia Inspektor или какой-то другой программы. С этой целью подходящие для нее повышенные частоты, которые были определены описанным выше способом, необходимо прошить в ее BIOS. Инструкция по перепрошивке BIOS видеокарты размещена здесь.

Проверка результатов разгона

Давайте сравним основные показатели разогнанной видеокарты с показателями без разгона.

До разгона подопытная GeForce GTS 450 демонстрировала следующую продуктивность (см. выше):

• PixelFillrate - 6,3 GPixel/s;

• TextureFillrate - 25,1 GTexel/s;

• пропускная способность памяти (bandwidth) - 57,7 GB/s.

После разгона были получены следующие результаты (см. скриншот):

• PixelFillrate - 7,2 GPixel/s ( прирост 14,2% );

• TextureFillrate - 28,8 GTexel/s ( прирост 14,7% )

• пропускная способность памяти (bandwidth) - 66,4 GB/s ( прирост 15,0% ).

Для проверки прироста продуктивности в условиях, приближенных к реальным, была также использована программа 3DMark11. Это один из наиболее популярных тестов производительности графических адаптеров.

В 3DMark11 без разгона GeForce GTS 450 показала результат 2272 бала , после разгона - 2573 бала.

То есть, прирост производительности видеокарты на практике составил 13,2 % (см. скриншоты).

После разгона

После разгона видеокарты

После разгона температурный режим работы видеокарты существенно изменяется в сторону повышения, что может сказаться на состоянии охлаждения остальных устройств компьютера. Кроме видеокарты в системном блоке находятся другие "греющиеся" компоненты - центральный процессор, чипсет материнской платы и др. Поэтому после разгона хотя бы на первых порах желательно тщательно отслеживать температуру всех основных устройств компьютера .

Например, можно использовать бесплатную программу SpeedFan.

Если температура какого-нибудь устройства компьютера окажется слишком высокой, необходимо позаботиться об улучшении циркуляции воздуха в корпусе системного блока, установив дополнительные кулеры (вентиляторы) на вдув и (или) выдув.

Нужно также иметь ввиду, что повышенная температура компьютера или отдельных его устройств может быть вызвана выходом из строя или засорением пылью их системы охлаждения. Порядок устранения указанных проблем описан на нашем сайте в статье о чистке и смазке кулеров.

В мире компьютерных игр в 2018 году произошло событие, которое многие эксперты отнесли к разряду революционных. Речь идет о внедрении в игры трассировки лучей.

Трассировка лучей (англ. Ray Tracing) - это технология отрисовки трехмерной графики, симулирующая физическое поведение света. Используя ее, видеокарта в точности моделирует прохождения лучей от источников освещения и их взаимодействие с объектами. При этом, учитываются свойства поверхностей объектов, на основании чего вычисляются точки начала рассеивания, особенности отражения света, возникновения теней и многое другое.

По сути, это симуляция модели человеческого зрения, которая вплотную приближает компьютерную графику к кинематографическому уровню (см. примеры).

В марте 2020 года компания Microsoft объявила о выходе новой версии графического API - DirectX 12 Ultimate (в составе крупного обновления Windows 10 20H1). Эксперты считают это значительным шагом в развитии графических технологий, способствующим массовому внедрению передовых достижений в сферу видеоигр.

Рассматривать DirectX 12 Ultimate с точки зрения разработчиков игровых приложений не будем, а попытаемся разобраться, что сулит его появление рядовому геймеру.

У каждой компьютерной игры есть определенные требования к внутренним устройствам компьютера (видеокарте, процессору объему оперативной памяти и др.). Если компьютер им не отвечает, насладиться игровым процессом вряд ли получится.

В этом каталоге можно подобрать игры с учетом как игровых предпочтений пользователя (жанр, сюжет, особенности геймплея и т.д.), так и быстродействия в них конкретного компьютерного "железа".

Онлайн-сервис сравнения характеристик видеокарт. Построен в виде сравнительной таблицы, в которую можно одновременно добавить неограниченное число графических карт, выбрав их из списка (доступно около 700 дискретных и интегрированных видеокарт nVidia, AMD и Intel).

Сервис позволяет в удобной форме сравнивать производительность видеокарт в компьютеных играх, частоту графического процессора, тип, размер и ширину шины памяти, а также другие их характеристики.

Рейтинг быстродействия и характеристики десктопных и мобильных видеокарт NVIDIA и AMD (ATI), а также графических чипов, интегрированных в процессоры и системную логику материнских плат.

Есть фильтр, позволяющий отбирать видеокарты по названию модели, разработчику, типу (мобильные, десктопные, дискретные, интегрированные), году выхода, интерфейсу подключения к материнской плате, а также требованиям к блоку питания компьютера.

DirectX - это набор библиотек, входящих в операционную систему Windows, которые используются для создания трехмерной графики. Благодаря DirectX, разработка компьютерных игр стала значительно проще. По сути, DirectX сделал Windows единоличным лидером среди операционных систем для домашних игровых компьютеров.

DirectX, как и другое программное обеспечение, постоянно усовершенствуется. Появляются все новые и новые его версии. Если какая-то компьютерная игра была создана с использованием DirectX определенной версии, для ее полноценной работы необходимо, чтобы компьютер поддерживал эту же версию DirectX или более новую.

Поддержка компьютером той или иной версии DirectX зависит от установленной на нем Windows, а также от возможностей его видеокарты.

ПОКАЗАТЬ ЕЩЕ

Модель Nvidia GeForce 920M представляет собой бюджетный вариант дискретной графической карты для ноутбуков, появившийся на рынке в 2015 году. В качестве рабочего GPU она получила ядро GK208, созданное с использованием устаревшей архитектуры Kepler. По своим возможностям видеокарта ненамного превосходила интегрированные модели и шла в комплекте к ноутбукам бюджетной и средней ценовой категории.

Технические характеристики GeForce 920M

Основные характеристики Nvidia GeForce 920M заключаются в наличии энергоэффективного графического процессора. Благодаря этому потребление энергии карты в нормальном состоянии находилось на уровне примерно 20-30 Вт.

Первые модели комплектовались всего 1 Гб видеопамяти GDDR3, более поздние версии – 2 Гб. На некоторых лэптопах типа Dell Inspiron 5758 устанавливалась четырёхгигабайтная версия этой же дискретной графики. Несмотря на это, шина памяти имела разрядность всего 64 бита, что заметно ограничивало возможности даже старшего варианта.

Все модификации GeForce 920M поддерживали работу с пакетом DirectX 11. Кроме того, производителем была предусмотрена поддержка самых современных технологий Nvidia – Optimus для оптимизации графики, PhysX для симуляции физических явлений и 3D Vision для улучшения впечатлений от игр и просмотра фильмов в стереоскопическом формате.

Поддерживаются картой и драйвера Verde Drivers, архитектура CUDA и приложения 3DTV Play, обеспечивающие подключение к внешнему телевизору и оптимизацию изображения.

Обзор видеокарты

На вид графическая карта, как и многие дискретные модели для ноутбуков, напоминает обычный центральный процессор. Благодаря этому она занимает минимум места в корпусе ноутбука и использует для подключения внешних устройств его порты. Продаётся видеоадаптер обычно в комплекте с ноутбуками, но, при желании, его можно было купить в интернет-сети. Средняя цена Nvidia GeForce 920M с 2 гигабайтами памяти находится на уровне 2000 рублей.

Видеоускоритель облегчает работу процессора при декодировании видео или запуске игры. При подключении отдельного монитора или телевизора карта поддерживает разрешение до 2К и даже 4К, но только при проигрывании фильмов. Однако по уровню производительности она сравнима со встроенной графикой Intel – например, с Iris 5100 или 5200. Из-за этого, как показывают отзывы о GeForce 920M, в играх 2012-2015 годов ноутбуки с такой видеокартой не справляются с разрешением выше FullHD (минимальным для современных игровых приложений).

Как разогнать видеокарту Nvidia Geforce 920M на ноутбуке

Производительности видеоадаптера недостаточно не только для многих современных игр, но и для майнинга. Разгон GeForce 920M не позволяет достичь с её помощью уровня даже в 10% от тех карт, которые реально могут использоваться для добычи криптовалюты. Однако разогнать такую не слишком функциональную модель можно для повышения количества fps в некоторых играх.

В результате разгона, для которого используют утилиты типа MSI Afterburner, частота кадров в приложениях повышается в пределах 5-10%. Уровень TDP карты остаётся в пределах 30 Вт. Частота процессора увеличивается на 150 МГц (с 954 до 1,1 ГГц), памяти – на 100-200 МГц (с 1,8 до 2,0 ГГц). В результате использовать видеоадаптер получается даже в достаточно динамичных шутерах типа Battlefield 4.

Какие игры пойдут на Nvidia GeForce 920M

Выполняя тест в играх GeForce 920M, можно проверить, какими игровыми приложениями стоит пользоваться на ноутбуке с этой видеокартой. Как показала проверка, модель с трудом поддерживает такие игры как Anno 2205, Fallout 4, Just Cause 3, Call of Duty: Black Ops 3 и Star Wars Battlefront. В каждой из них видеоадаптер выдает комфортное для игрока значение fps только на самых минимальных настройках.

Более или менее запускаются на ноутбуках с GeForce 920M (только на моделях с 2-4 Гб DDR3 и достаточным количеством ОЗУ – не меньше 4-6 Гб) игры BioShock Infinite, Diablo III и The Elder Scrolls V: Skyrim. В них значение fps оставалось на достаточно высоком уровне даже на средних настройках.

Желающим поиграть в игры с лучшими показателями графики (до 2К или даже UtraHD) стоит обратить внимание на FIFA 16 и Tomb Raider 2013 года.

Как обновить драйвера

Необходимость скачать драйвер Nvidia GeForce 920M для Windows 10 или других операционных систем возникает у владельцев ноутбуков с такой видеокартой нечасто. В основном, искать, скачивать и устанавливать управляющие программы приходится при переустановке платформы или нарушении работы видеоадаптера в результате действия вирусов.

Для обновления драйверов следует перейти на ресурс производителя карты и найти в списке соответствующую модель. Автоматическая установка возможна и с помощью специальной утилиты GeForce Experience, устанавливаемой с диска, который обычно идёт в комплекте с ноутбуком.

Для Windows 7, 8.1, 8 и Vista

Для Windows 10

400.00 МБ

Версия драйвера: 391.35 (WHQL) от 27.03.2018;

Язык: Русский

Операционная система: Windows 10 32/64-bit, Windows 7 32/64-bit, Windows 8.1 32/64-bit, Windows 8 32/64-bit, Windows Vista

Доброго времени.

Сегодняшняя заметка будет посвящена разгону* видеокарт от nVidia для увеличения производительности (FPS в играх). Способ, приведенный ниже, крайне простой и доступен даже начинающему пользователю.

* Примечание : под разгоном понимается увеличение штатных частот, на которых работает видеокарта. В среднем, за счет этого, удается повысить производительность на 5-10%.

Но прежде хочу сделать несколько предупреждений:

Разгон видеокарты от nVidia (по шагам)

ШАГ 1: загрузка утилиты

Вообще, для разгона видеокарты нам понадобиться увеличить частоты у ее:

- памяти (Memory Clock);

- шейдерных блоков (Shader Clock);

- графического ядра (видео-чипа / GPU Clock). Обычно, его частота указывается в описании карты (например, 954 МГц у GeForce GT 710).

Описание типовой видеокарты

ШАГ 2: настройка nVidia Inspector

После запуска утилиты nVidia Inspector пред вами предстанет окно с параметрами вашей видеокарты. Это уже неплохо, значит утилита "видит" и распознает карту и можно идти дальше.

- для начала запустите нужную вам игру и утилиту для просмотра FPS (Fraps, например). Это позволит воочию "увидеть" что даст нам разгон (в своем примере взял игру Civilization 4). После, посмотрев FPS, сверните игру (Alt+Tab) ;

- далее в правом нижнем углу окна nVidia Inspector нажмите кнопку "Show Overclocking" (стрелка-1 на скриншоте ниже) ;

- должно появиться доп. окно справа. В нем есть три заветные ползунка: GPU Clock, Memory Clock, Shader Clock (частота видеочипа, памяти, шейдеров соответственно) ;

- теперь сдвиньте ползунки Memory Clock и Shader Clock вправо на 5-10% (Memory: было 800 - стало 880 MHz; Shader: было - 1560, стало - 1700 MHz) ;

- нажмите кнопку "Apply Clock" (стрелка-4 на скрине ниже) .

NVIDIA Inspector — увеличиваем частоты

Собственно, всё! Частоты мы подняли и видеокарта теперь должна работать пошустрее. В моем тесте получилось выжать из GeForce GT 440 еще около 12% к FPS (было 107, стало 120). Разумеется, значения эти примерные, и в каждой игре производительность может сильно меняться (т.е. в одной FPS вырастет на 5%, в другой - на 25%)!

До разгона - 107 кадров (скриншот из игры Civilization IV)

После разгона 120 кадров (скриншот из игры Civilization IV)

Кстати, после перезагрузки компьютера — утилита NVIDIA Inspector запущена не будет, а значит частоты будут сброшены на дефолтные. Чтобы при каждой загрузке Windows — утилита запускалась автоматически и разгоняла видеокарту — необходимо добавить ее в автозагрузку. См. ссылку ниже.

ШАГ 3: тесты и до-настройка

Разумеется, частоты у видеокарты повышать можно не до бесконечности (в среднем 5-15%). У каждой видеокарты — своя граница (определяется экспериментально ☝) , после которой она начинает работать не стабильно: в игре могут появиться искажения в графике (артефакты), ошибки, подвисания. В общем-то, это сразу заметно!

Важно! При разгоне, обычно, требуется несколько итераций, чтобы подобрать наиболее высокие и безопасные частоты. Кстати, обратите внимание на один момент: при повышении частот — будут повышаться и температуры, и видеокарта может начать перегреваться!

Вообще, чтобы протестировать стабильность работы видеокарты — рекомендую воспользоваться утилитой FurMark. Она за 5-10 мин. хорошо нагрузит карту и позволит одновременно наблюдать и за температурой, и за FPS, и за частотами.

FurMark — стресс-тест в действии (крутится бублик)

ШАГ 4: за счет чего еще можно увеличить FPS в играх

Вообще, многие пользователи ошибочно считают, что только за счет разгона можно существенно ускорить игру и поднять FPS. На самом деле есть еще пару важных моментов (которые могут дать куда больший результат)!

От драйвера и настроек зависит очень многое. Поэтому, во-первых, порекомендовал бы проверить обновлен ли он у вас, и все ли необходимые игровые компоненты установлены в Windows (сделать это проще всего с помощью утилиты Driver Booster).

Обновить всё - игровые компоненты, звуковые и игровые устройства и пр. / Driver Booster

Во-вторых, обратите внимание, что в панели управления видеодрайвером (не только у nVidia) в параметрах 3D можно выставить приоритет для карты: на производительность или качество изображения. Если ползунок полностью выкрутить на производительность - удается добавить еще 5-15% FPS (причем, на глаз разница в качестве изображения может быть и незаметна!).

Панель управления NVIDIA

Ну и, в-третьих, есть ряд параметров, изменив которые в ручном режиме можно "снизить" качество изображения (выдаваемое видеокартой), зато выиграть еще несколько процентов. См. ссылку ниже.

Кроме настроек видеокарты обратите также внимание на параметры игры. Изменив ряд настроек — можно существенно ускорить ее. Я порекомендовал бы "поиграться" в первую очередь с:

- разрешением игры (чем меньше — тем больше FPS и плавнее картинка) ;

- качеством текстур;

- тенями, детализацией воды, тумана, дальностью горизонта;

- детализацией ландшафта;

- вертикальной синхронизацией (в некоторых играх лучше отключить) .

Настройки графики для WOW Legion

Часто бывает, что, отключив тени и изменив дальность горизонта — количество FPS удваивается (без всякого разгона!). Конечно, у каждой игры свои особенности, которые лучше искать на специализированных форумах.

Предупреждение: модификации, о которых рассказывается в этой статье, могут привести к необратимому выходу ноутбука из строя и дальнейшему дорогостоящему ремонту! Любые модификации, описанные в настоящем материале, производятся пользователями на свой страх и риск.

Если вы не уверены в своих действиях или не очень хорошо знакомы с устройствами, описанными в статье, не стоит прибегать к описанным методам разгона!

Напомним, что на нашем сайте уже публиковались материалы по экстремальному разгону ноутбука.

Рекомендуем ознакомиться также с ними.

Введение

Топовые видеокарты дорогие, прожорливые и очень горячие. Их система охлаждения часто занимает добрую четверть внутрикорпусного пространства ноутбука, если производитель подходил с умом к этому вопросу. Редко можно встретить ноутбук с диагональю меньше 17 с топовой графикой. Эти видеокарты позволяют играть почти во все современные игры на максимальном разрешении с максимальными настройками графики, но цена на укомплектованные ими ноутбуки начинается с цифры в 2000 вечнозеленых. А учитывая, что ноутбук с таким размером и весом особо не потаскаешь, да и от батареи он будет жить очень недолго, разумнее купить за те же деньги настольный ПК, который будет превосходить его в производительности в несколько раз. К тому же, нынешние топовые ускорители плохо разгоняются. Производители повышают производительность увеличивая количество ядер, а не рабочие частоты, из-за чего разгонный потенциал сильно снижается: производительность редко когда повышается больше, чем на 10%. Такие видеокарты набирают в тесте Futuremark 3Dmark 06 больше 8000 баллов.

Процесс разгона

Существует множество программ для разгона и настройки видеокарт. Для видеокарт NVIDIA самой лучшей, на мой взгляд, является RivaTuner. Эта программа, в отличие от многих других, к тому же обладает правильным мониторингом частот. Дело в том, что частоты ядра изменяются не плавно, а с определенном шагом в несколько мегагерц, однако программы для разгона дают выставить любую частоту с шагом 1МГц, а видеокарта округляет задаваемую программой частоту. Т.е. выставляем 1423, а в реальности имеем, например, 1400, если частота изменяется с шагом 50МГц. А выставив 1440, в реальности получаем 1450. RivaTuner показывает реальные частоты, а не те, что выставлены ползунком в программе.

Для видеокарт ATI RivaTuner, к сожалению, особо не применишь, разве что мониторинг будет работать, остальные функции увы не будут доступны. Однако отчаиваться не стоит, программы для разгона видеокарт были, есть и будут. Например, из известных мне: ATItool, GPU tool и другие.

Существует определённая методика разгона видеокарт, не только мобильных. Разгон видеокарты подразумевает увеличение частоты видеочипа и видеопамяти. С чего начинать разницы нет, но я рекомендую с видеочипа. Выше я уже писал, что видеочип под нагрузкой сильно греется и нагревает текстолит материнской платы вокруг себя вместе со всеми остальными элементами на нем. Почти всегда сюда попадает и видеопамять, т.к. ее ставят рядом с видеочипом. У нее, как и у видеочипа, с ростом температуры уменьшается максимальная стабильная частота. И если первой гнать память, а потом видеочип, то может так получиться, что память, подогретая разогнанным чипом, начнет сбоить на тех частотах, которые раньше держала спокойно. Поэтому начинать лучше с ядра. Впрочем, если система охлаждения у Вас производительная и чип холодный, то можно и с памяти.

Тестирование на артефакты удобно проводить мохнатым кубом в ATItool. А нагревать лучше программой FurMark либо аналогичными программами, например, встроенный тест есть в GPUtool и в OCCT GPU. Мониторить температуру и частоту с помощью RivaTuner (в случае с видеокартами NVIDIA разгонять тоже лучше ей или NVIDIA System tools, т.к. бывает, что RivaTuner не успевает за выходом новых видеокарт и некорректно меняет частоты, например в 9600М частоты 3D не выставляются вообще).

После того, как максимальные стабильные частоты найдены, можно сохранить эти настройки в профиль и поставить в автозагрузку, либо создать правило, при котором этот профиль будет автоматически загружаться, например, при запуске игры. Все современные видеокарты обычно сами сбрасывают частоты в режим экономичного 3D либо в 2D, если на них нет нагрузки, так что в простое видеокарта не будет разогнана, соответственно, не будет кушать электричество и сильно греться.

Если достигнутого Вам мало, а температура видеокарты еще не приближается к 90 градусам, то можно прибегнуть к вольтмоду, т.е. поднятию напряжения питания ядра и памяти для достижения более высоких частот.

Вольтмод видеоядра

- топовая видеокарта с большим количеством процессоров и, как следствие, плохим разгонным потенциалом. При этом обязательно наличие грамотной мощной системы охлаждения, т.к. небольшое повышение напряжения в данном случае эффекта почти не даст.

- урезанная по частотам версия видеокарты. Обычно, если кристалл по определенным причинам не вписался в TDP (тепловой пакет), отведенный для старшей версии видеокарты (к примеру GT), то в нем либо отключают некоторое количество процессоров, либо снижают рабочие частоты, либо и то и другое (и получается версия GS, GTS и т.п. например). Так вот, камень с пониженными частотами (но не с отключенными процессорами) имеет просто немного сниженные максимальные частоты работы, но такое же напряжение питания, что и у старшей версии. Если напряжение немного повысить, то младшая модель сможет работать на частотах старшей, но при этом будет немного (или много, зависит от удачности экземпляра) больше греться.

- Процессор: Intel Core 2 Duo T7300 (200*10) 4МБ кэш L2;

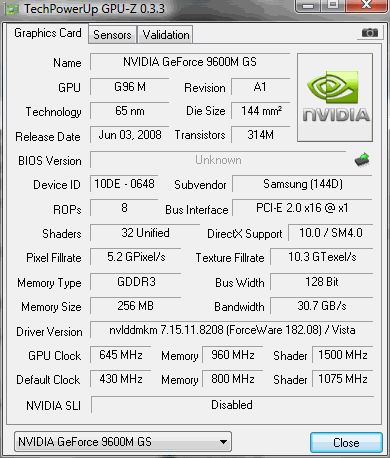

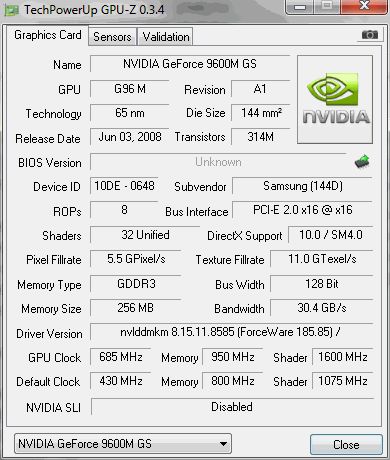

- Видеокарта: NVIDIA GeForce 9600M GS (4301075800 ядрошейдерыпамять) 256МБ (64*4) GDDR3 128 bit;

- Оперативная память: 2+1 GB DDR3 800МГц 6-6-6-15;

- Чипсет: Intel PM45 + ICH9M;

- Жёсткий диск: Samsung HM500LI 500GB 5400rpm;

Остальные устройства на производительность системы в целом не влияют, поэтому указывать их не будем.

Теория

Если кто-то ещё не понял, то следующим шагом я собираюсь поднимать напряжение на видеочипе. Существует множество материалов о вольтмоде, его видах и способах реализации. Все это добро в одну статью не уместится, поэтому кратко опишу самый распространённый вольтмод обычного стабилизатора питания, без дополнительных сложностей. Перед тем, как решиться делать что-то со своим ноутбуком, советую все же прочитать про вольтмод соответствующие статьи.

Для описываемого вольтмода стоит сказать, что каждая микросхема стабилизации питания имеет вывод обратной связи, по которому микросхема определяет уровень подаваемого напряжения. Если напряжение проседает ниже заданного уровня, то микросхема автоматически его повышает, и наоборот. Микросхема универсальная, а напряжение в каждой схеме нужно разное, поэтому для подстройки выходного напряжения вывод обратной связи заземляют через сопротивления различных номиналов. Другими словами, изменяя номинал сопротивления, можно подстраивать выходное напряжение. Только тут стоит помнить, что номиналы всех элементов, составляющих «обвязку» самой микросхемы, рассчитываются исходя из целевого напряжения. Т.е. в идеале при изменении регулировочного сопротивления нужно пересчитывать всю «обвязку», если этого не делать, то компоненты будут испытывать нагрузку, отличную от номинальной. Очевидно, что перепаивать всю обвязку мы не будем, поэтому напряжение изменять нужно в разумных пределах. В случае с ноутбуком беспокоиться об этой проблеме вряд ли придётся из-за слабой системы охлаждения, она попросту не даст сильно поднять напряжение.

Понятно, что второй вариант проще, однако не во всех случаях он реализуем, например при вольтмоде памяти подойдет только первый вариант. Вообще, то, какой вариант выбрать, зависит от самой микросхемы и схемы ее подключения.

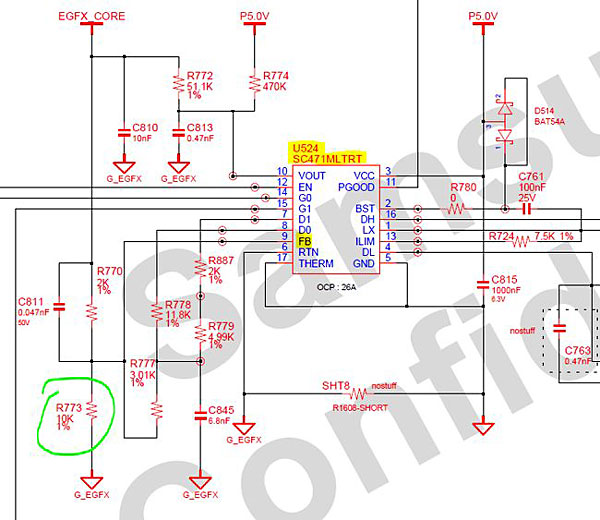

Даташит на неё на всякий случай был найден, но не пригодился, потому как все подключения указаны в мануале на ноутбук. Это оказался обычный импульсный стабилизатор без каких-либо наворотов, которые могли бы создать осложнения. И весь вольтмод заключается в уменьшении сопротивления между выводом обратной связи FB (Feedback) и землей. Есть и другие варианты, о них можно прочитать в статьях про сам вольтмод, но самым простым (хоть и не самым безопасным) является этот. На схеме в мануале видно, что нужно уменьшить сопротивление резистора R773 номиналом 10 кОм. Его-то и надо искать на плате, и затем, подпаивая к нему параллельное сопротивление, уменьшать общее сопротивление, тем самым увеличивая напряжение видеочипа.

Имея мануал на ноутбук, я уже знаю название микросхемы и её номер, т.е. мне её даже искать не надо. Если мануала на ноутбук нет, то выбрать нужный стабилизатор на плате ноутбука (если видеокарта распаяна на плате) задача не из простых, таких стабилизаторов там может оказаться не меньше десятка. Но при правильном подходе вычислить нужный можно довольно быстро. В первую очередь нужно выписать названия всех микросхем в радиусе

Практика

Хочу напомнить, что любые манипуляции со своей материнской платой и иными компонентами вы делаете на свой страх и риск. Ноутбук в результате таких манипуляций может выйти из строя. Я заранее отказываюсь от ответственности за любой вред, моральный или материальный, который может быть нанесен в результате этой статьи, все действия со своим железом вы производите на свой страх и риск.

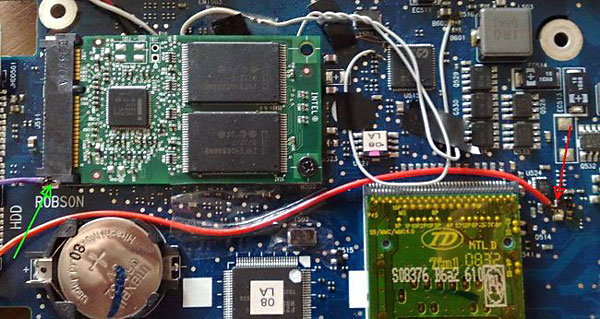

В моём случае микросхема выглядит так:

Вот увеличенный фрагмент платы:

Итак, резистор найден, сопротивление замерено и равно 1653 Ом. А получить нужно немного меньше. Под рукой оказался переменный резистор только на 20 кОм, его-то я и припаивал параллельно, т.е. одним концом на вывод микросхемы, а вторым на землю. Вообще советую использовать многооборотный подстроечный резистор для более точной настройки сопротивления, следовательно, и напряжения тоже. Номинал брать в 10-20 раз больше, чем исходное сопротивление. При 20 кОм, припаянных параллельно, результирующее сопротивление равнялось 1525 Ом, что вполне приемлемо для стартовой цифры. Уменьшая подпаянное сопротивление, уменьшаем результирующее, следовательно, напряжение растёт. Вот так это выглядит (пайку просьба не хаять, детали очень мелкие):

Тесты

Температура видеокарты и так близка к предельной, поэтому я решил, понемногу поднимая напряжение, выяснить, насколько поднимется планка разгона, и будет ли это целесообразным. Для нагрева и проверки на артефакты я использовал AtiTool 0.27b4.

В таблице видно, что поднятие напряжение до 1,268 В повысило потолок разгона при небольшом увеличении нагрева. На этом всё хорошее закончилось. Эта видеокарта позволяет изменять частоту с шагом 15 и 50 МГц для ядра и шейдеров соответственно. Поэтому дальнейшее повышение напряжения потолок разгона не поднимало, вплоть до 1,357, но при таком напряжении видеокарта перегревается. В итоге результат таков:

GPU-Z до вольтмода

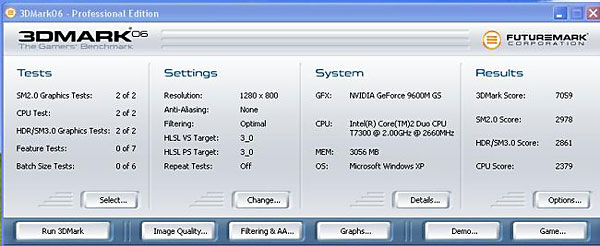

3Dmark 06 довольтмода:

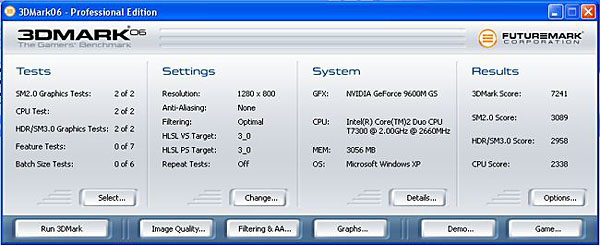

3Dmark 06 после вольтмода:

Заключение

Читайте также: