Видеокарта 2 гб или 1 гб разница

Обновлено: 04.07.2024

NVIDIA GeForce GTX660 2048 Мб и GTX650 1024 Мб, к примеру, имеют соответствующую память, что лучше выбрать? Это лишь пример, в статье мы постараемся пояснить на примере видеокарт.

Память служить хранилищем текстур. Например, вы бежите в игре по полю и каждая травинка весит по 100 Кб. Так же со всеми предметами в игре.

Но память не главное. Нужно чтобы видеокарта имела достаточную мощность, чтобы строить из этих текстур игру.

К примеру, игра Battlefield 3 на максимальной графике всего 1400 Мб.

Игрой Skyrim с огромным количеством модификаций на графику можно забить все 2048 Мб.

Остальные игры не занимают даже 1000 Мб видеопамяти.

А вот например RADEON HD7970 для стационарного компьютера с памятью 6 Гб вполне сможет использовать всю память если игра этого требует.

Производительность видеокарты зависит в большей степени не от объема видеопамяти, а от модели видеочипа, который там используется.

Для видеокарт среднего уровня, примерно GTX650Ti, 1-2 ГБ видеопамяти вполне достаточно и оптимально.

Только для самых мощных топовых видеокарт вроде GTX670 1ГБ может не хватать, поэтому только на них есть смысл ставить больший объем памяти.

Поэтому когда 2 Гб видеопамяти ставятся на бюджетную видеокарту вроде GT630, это не больше чем маркетинговый ход и выкачивание денег из ваших карманов. Такая видеокарта ничем не лучше аналогичной 1ГБ, но зато гораздо дороже.

Чем больше выделенной памяти установлено на видеокарте, тем больше данных (тех же текстур, вершин и буферов) можно хранить в ней, не используя медленный доступ к ОЗУ компьютера. Причем, больше всего места занимают текстуры и различные буферы, а вот собственно геометрические данные обычно не слишком объёмны. Рассмотрим скриншоты из старой игры с разными установками качества текстур:

Например, при выборе между топовой видеокартой с 1,5 ГБ памяти и более высокими тактовыми частотами против такой же карты но с 3 ГБ памяти со стандартными частотами и более высокой ценой на данный момент выгоднее будет первая видеокарта, так как она обеспечит даже бо́льшую производительность почти во всех режимах и условиях, кроме самых высоких разрешений. То же касается, к примеру, GeForce GTX 630 с 1 ГБ GDDR5-памяти против GTX 630 с 2 ГБ DDR3 — первый вариант точно будет быстрее. В большинстве режимов видеокарты бо́льшая частота и ширина шины играет значительно более важную роль, чем бо́льший объём видеопамяти, и только в высоких разрешениях увеличенный объем может серьёзно сказаться на скорости рендеринга.

Введение.

Многие пользователи заблуждаются рассуждая о производительности видеокарты по объему его видеопамяти. Я об этом не однократно говорил в различных статьях, форумах, но количество пользователей убежденных, что залог производительности в объеме видеопамяти не уменьшается.

Именно данное обстоятельство, позволяет многим производителям неплохо зарабатывать на доверчивых пользователях. Совсем недавно вашему вниманию была представлена видеокарта Palit Geforce GTS 250 2Gb GDDR3, производительность которой мы успели оценить в данном обзоре. На прошлой неделе мне удалось бегло протестировать в аналогичных тестах видеокарту Palit Geforce GTS 250 1Gb GDDR3. Сравнение уровней производительности данных видеокарт мне бы и хотелось представить в данном обзоре.

Комплектация.

Данная видеокарта поставляется в аналогичной коробке, как и 2 Гб версия видеокарты. Она выполнена в черно-оранжевых цветах и на ней изображена несменная "палитовская лягушка".

В коробке были обнаружены:

1. Видеокарта.

2. Инструкция.

3. Диск с драйверами.

4. Переходник питания.

5. Переходник HDMI-to-DVI.

6. Кабель SPDIF.

Внешний осмотр видеокарты.

По дизайну видеокарта полностью аналогична видеокарте с 2 Гб видеопамяти. Система охлаждения, модифицированная с увеличенным вентилятором и прозрачным кожухом черного цвета.

Видеокарта распаяна на плате красного цвета, что нехарактерно для видеокарт на чипах от NVIDIA, но более чем характерно для видеокарт на чипах от ATI (AMD).

Видеокарта имеет двухслотный дизайн. На плате распаяны следующие порты: HDMI, D-Sub, DVI. Порт HDMI можно превратить в DVI путем подключения переходника из комплекта поставки.

Видеокарта требует дополнительного питания по двум шестипиновым коннекторам дополнительного питания.

Спецификации видеокарты.

1. Тех процесс 55 нм

2. Частота ядра: 738 MHz

3. Частота шейдерного блока: 1836 MHz

4. Частота памяти: 1100 MHz / 2200 MHz

5. Общий объем памяти: 1024 Мб

6. Тип шины: 256-bit

7. Скорость памяти: 70.4 GB/s

8. Процессорных блоков: 128

9. ROP Units 16

10. Текстурных блоков: 64

11. Коннекторы: 2 x Dual-Link DVI-I

12. Форм фактор: Dual Slot

13. Коннектор питания 1 x 6-pin

14. Тепловыделение (TDP) 150 watts

15. Срабатывание защиты по температуре: 105° C - 221 ° F

Видеокарта трудится на полностью референсных частотах.

Результаты разгона.

Видеокарта разогналась до следующих частот:

1. По ядру до 792 Mhz.

2. По памяти до 2267 Mhz.

Данная версия видеокарты показала более солидный разгон, нежели видеокарта с 2 Гб видеопамяти на борту.

Температура видеокарты.

Температура видеокарты с 1 Гб видеопамяти оказалась несколько выше, чем у видеокарты с 2 Гб видеопамяти. Видимо, у обсуждаемой видеокарты более плохой контакт радиатора с ядром.

Тестовая конфигурация.

1. Core 2 Duo E8500.

2. ASUS P5QC

3. 2x2 Gb Hynix Original DDR-800.

Как видим, две видеокарты демонстрируют нам аналогичный уровень производительности. Хотел протестировать в разрешении Full HD, но игра превращалась - в слайд шоу. Вывод для данной игры дополнительные 1 Гб видеопамяти оказались бесполезными.

2. Crysis WARHEAD

Одна из популярнейших игр современности более критично отнеслась к уменьшению объема видеопамяти снижением уровня производительности на 12% в разрешении 1680x1050. Но если приглядеться, то видно, что в абсолютных цифрах - это 3 fps, что во многих случаях является статистической погрешностью и такая просадка может возникнуть практически на любой системе.

3. 3DMark Vantage

В современном синтетическом тесте мы также наблюдаем, снижение уровня производительности на 1%, что является не существенной цифрой.

Заключение.

Из результатов тестирования видно, что дополнительные 1 Гб видеопамяти не несут практически никакого увеличения производительности. Связано это с тем, что такой объем видеопамяти требуется при высоких разрешениях, а высокие разрешения не "по зубам" видеоядру и искусственное увеличение видеопамяти до 2 Гб - просто создает дисбаланс внутри самой видеокарты.

Видеокарты различаются сериями видеочипов, в каждой серии есть по три-пять графических процессоров. На базе этих процессоров выпускают десятки версий видеокарт — с разным охлаждением, количеством видеопамяти и разгоном. Поможем разобраться в этом хаосе.

AMD или Nvidia?

Принципиальной разницы между производителями нет. До конца 2020 года видеокарты Nvidia выдавали более реалистичную графику благодаря технологии трассировки лучей, но сейчас она есть и у AMD.

В продаже не найти заводские версии видеокарт от AMD и Nvidia. Вы покупаете версии от Gigabyte, MSI, Asus, Palit и других. На одном и том же видеочипе от AMD или Nvidia компании выпускают несколько модификаций, которые отличаются тактовой частотой, количеством памяти и системой охлаждения. И всё это влияет на цену.

Вот как прочитать название видеокарты.

С чего начать?

Очевидно — с бюджета. Решите, сколько денег вы готовы потратить на видеокарту. Но не спешите брать самую дорогую.

Например, Radeon RX 6800 при сравнимой производительности в середине 2021 года стоит на 30% дороже GeForce RTX 3070, ее конкурента от Nvidia. Чтобы не ошибиться с выбором, оцените производительность подходящих по цене видеокарт, мы расскажем об этом далее.

Выбираем видеочип

Мощность видеокарты зависит не только от видеочипа, но и от огромного количества других технических характеристик: частоты графического процессора, объема видеопамяти, разрядности шины, числа универсальных вычислительных процессоров и так далее. Но это то, с чего стоит начать.

Например, вашего бюджета хватит на GTX 1660 Super или RTX 2060. При беглом сравнении видно, что частота графического процессора у первой — 1530 МГц, а у второй — 1365 МГц. Получается, новая RTX менее производительная, чем GTX? Конечно нет! В ней более совершенная архитектура: больше графических CUDA-ядер, быстрее память.

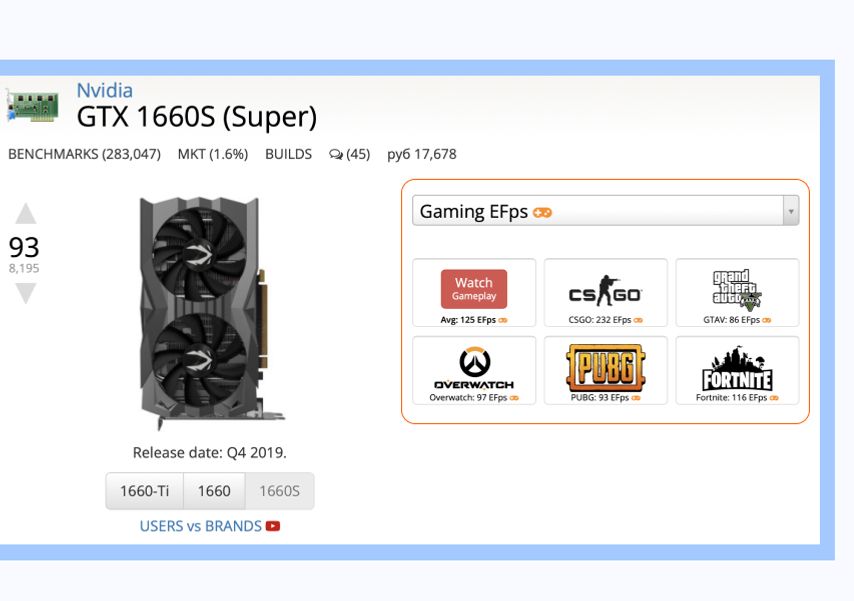

Для сравнения чипов лучше использовать сервис UserBenchmark. Введите в поиске название серии и номер видеочипа, например GTX 1660, и посмотрите на графы User rating (пользовательский рейтинг) и Avg. bench (средний результат).

В первой отражается пользовательский рейтинг, во второй — среднее значение в тестах на производительность. Чем значения выше, тем более мощная видеокарта.

Чтобы понять, каких результатов ожидать в играх, нажмите на название видеокарты и посмотрите замеры средней частоты кадров (количество FPS). Идеальной считается частота от 60 кадров в секунду и выше.

Производительность в играх зависит не только от видеокарты, но и от процессора, поэтому сравнивать видеокарты лучше в паре с ним. На том же UserBenchmark при клике на значок игры можно увидеть процессор, на котором она тестировалась.

Те же действия проделайте с RTX 2060. Как только решите, какой чип вам больше подходит, переходите к выбору модификации.

Стоит ли переплачивать за частоту видеопроцессора?

Чтобы ответить на этот вопрос, возьмем для примера две модификации Nvidia GeForce RTX 3060: Palit GeForce RTX 3060 и Asus GeForce RTX 3060 ROG-STRIX.

Версия от Palit стоит на 15 000 рублей дешевле, но и частота графического процессора у нее — 1320 МГц, а у Asus — 1882 МГц. Выбрав более разогнанную модель, в играх вы получите на 5–10% больше кадров в секунду.

Объем видеопамяти

Количество видеопамяти в разных модификациях тоже может отличаться. Например, RX 570 встречаются как с 4 ГБ, так и 8 ГБ видеопамяти. У GTX 1060 бывает 3 ГБ или 6 ГБ видеопамяти. Если разница в цене составляет 500–1000 рублей, лучше доплатить.

Если разница в цене больше, выбирайте объем, отталкиваясь от своих потребностей в игре. Вот на какие параметры стоит ориентироваться (для ААА-проектов):

- Full HD — 4 ГБ,

- 2К на высоких настройках — 4–8 ГБ,

- 4К — не менее 6 ГБ,

- 4К на высоких настройках — 12 ГБ.

Трассировка и сглаживание: нужны или нет?

Технология трассировки лучей. Создана для того, чтобы объекты в игре выглядели максимально реалистично. Чтобы лучи света, блики и тени выглядели, как в жизни. Nvidia впервые представила эту технологию вместе с линейкой видеокарт GeForce RTX, а позже выпустила драйвер и для более ранних карт.

AMD поддержку трассировки реализовали только в Radeon RX 6000-й серии, которая начала появляться в продаже в конце 2020 года. Таких видеокарт у компании меньше, чем у Nvidia.

Учтите, что трассировка лучей снижает производительность видеокарты в играх. Вы получите более реалистичную графику, но с меньшей частотой кадров (FPS). Для топовых видеокарт это не проблема, частота кадров остается приемлемой. Но с бюджетными решениями, чтобы сохранить 60 FPS, придется снижать настройки графики.

Технологии сглаживания. Позволяют улучшить качество картинки. Контуры объектов и персонажей выглядят ровными, пропадает эффект лесенки, во время движения нет ряби.

Раньше для достижения такого эффекта в видеокартах использовались технологии TXAA, FXAA и MSAA. Но они снижали производительность: частота кадров падала до 30–40 FPS.

Современные разработки — DLSS у Nvidia и FidelityFX Super Resolution у AMD — наоборот, дают прирост производительности от 5% до 20%. То есть вместо 50 FPS можно получить стабильные 60 FPS, а вместо 90 FPS — 100 FPS. Это позволяет не снижать настройки графики при повышении разрешения и играть на мониторе с частотой обновления 80, 90 или даже 120 Гц и выше.

Читайте: какой игровой монитор купить: Acer Nitro или Asus Rog Swift?

Чтобы всё сработало, разработчики игры должны предоставить Nvidia данные для анализа или встроить в свою игру часть кода от AMD. Перед покупкой проверьте, какие игры поддерживают технологии сглаживания. Посмотрите списки для видеокарт Nvidia и AMD.

Как убедиться, что видеокарта подходит ПК?

Еще один важный шаг — проверка на совместимость. Если не учесть размер и другие особенности, видеокарта может не поместиться в корпус или вовсе не заработает.

Длина и ширина

Убедитесь, что видеокарта поместится в корпус вашего ПК. В первую очередь посмотрите, какую максимальную длину видеокарты он поддерживает. Это указано в характеристиках корпуса.

Но учтите, что видеокарте могут мешать другие элементы: радиатор системы водяного охлаждения и вентиляторы. Это происходит там, где установка вентиляторов и СВО происходит во внутреннюю часть корпуса.

Например, во Fractal Design Define S допускается установка видеокарт длиной до 450 мм, а при установке спереди вентиляторов — до 425 мм. Эту информацию можно найти на сайте производителя. А если вы решите установить еще и радиатор СВО, то от 425 мм нужно будет отнять толщину радиатора.

Еще один важный параметр — ширина. Видеокарты с массивной системой охлаждения могут занимать несколько слотов расширения корпуса. Например, Palit GeForce RTX 3070 GamingPro занимает целых три слота, через которые на заднюю стенку компьютера выводятся разъемы для подключения мониторов. Широкие видеокарты часто блокируют установку Wi-Fi-плат, звуковых карт в соседние слоты PCI-Express, которые находятся выше или ниже слота видеокарты. Как проверить?

Посмотрите, как расположены слоты на плате, и измерьте расстояние между ними. Например, в Asus ROG STRIX B450-F Gaming II слоты PCI-Express далеко один от другого, так что видеокарта Palit, которую мы недавно упоминали, их не перекроет.

Обратите внимание на расположение слотов PCIe. В этой материнской плате Asus между ними большое расстояние — поместится любая современная видеокарта и не перекроет нижний слот PCIeНе забудьте про питание

В технических характеристиках видеокарты указывается минимальная мощность блока питания (БП), с которым она будет стабильно работать.

В названии блока пишут суммарную мощность для всех линий питания, куда входят жесткие диски и другое оборудование. Выделяемая процессору и видеокарте мощность может быть значительно меньше. Значение можно узнать из таблицы на корпусе БП, в графе 12 В.

Мощность, выделяемая на видеокарту и процессор, указана в графе +12 В. У этого блока — все 600 ВтКакой у вас экспресс?

Когда говорят о разъеме подключения на материнской плате, обычно упоминают версию PCI-Express (2.0, 3.0 и с недавнего времени — 4.0). Точное количество портов и их тип указаны в графе «Слоты расширения» в характеристиках материнской платы. Как правило, порт с самой последней версией предназначен для видеокарты. У видеокарт версия PCI-е указана в характеристиках в пункте «Интерфейс».

Если у вас установлена старая материнская плата, поддерживающая формат 2.0, а видеокарта поддерживает 3.0, ничего страшного. Видеокарта будет работать с пропускной способностью младшей версии PCI-Express, хотя и медленнее. В идеале стоит выбрать видеокарту с разъемом той же версии, которую поддерживает материнская плата. Или с более высокой, если собираетесь менять плату.

А что с монитором?

Видеокарты поддерживают разные разрешения экрана и разное количество мониторов. А еще от видеокарты зависит максимальная частота кадров, которую отобразит монитор за одну секунду (частота обновления, измеряется в герцах (Гц)).

Рассмотрим на примере GigabyteI GeForce RTX 2060. Максимальное разрешение, которое поддерживает видеокарта, — 7 680 x 4 320, то есть она будет работать с широкоформатным монитором или телевизором 8К.

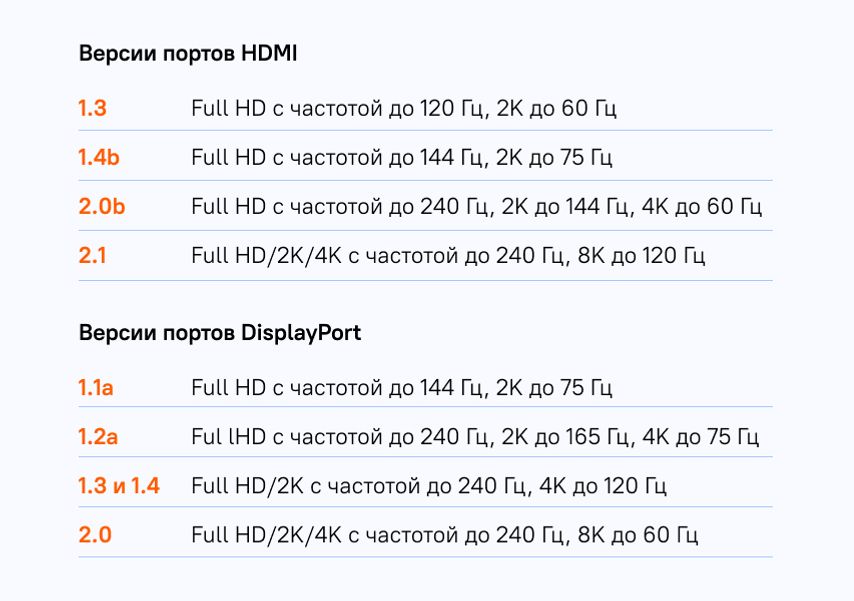

Характеристики видеокарты Gigabyte GeForce RTX 2060Также у видеокарты есть один порт HDMI версии 2.0b и три порта DisplayPort версии 1.4. То есть порт HDMI поддерживает Full HD с частотой до 240 Гц, 2K до 144 Гц, 4K до 60 Гц, а порты DisplayPort — Full HD/2K с частотой до 240 Гц и 4K с частотой до 120 Гц.

Чтобы понять, какие разъемы вам нужны, посмотрите на характеристики монитора. Если монитор Full HD с частотой обновления до 240 Гц, хватит HDMI 2.0b или DisplayPort 1.2a. Для монитора с 2К-разрешением и частотой 240 Гц понадобится HDMI 2.1 или DisplayPort 1.3.

При подключении посмотрите в инструкции к монитору, какая частота и какое разрешение поддерживаются на каждом из его портов. Бывает так, что максимальное качество доступно только на DisplayPort или одном из нескольких HDMI. Именно к ним и нужно подключить видеокарту.

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Читайте также: