Настройка дисковой полки hp

Обновлено: 07.07.2024

Алгоритм подключения системы хранения данных к хосту достаточно универсален. Безусловно, существуют нюансы настройки, которые зависят от конкретного оборудования и топологии вашей сети.

Создание SAN является сложной задачей. Если это ваш первый опыт, обратитесь к специалистам ВИСТЛАН за консультацией, помощью в проектировании системы и подборе оборудования

Подключение СХД к хосту делится на два этапа:

Физическое соединение.

Настройка.

Перед началом внимательно ознакомьтесь с документацией производителя на полку. Она подробно описывает все действия. Пример документации от Oracle .

Техническая информация

SAN состоит из нескольких HDD и контроллеров. Для равномерного распределения нагрузки и обеспечения надёжности стараются использовать два HBA (Host Bus Adapter), несколько путей ввода-вывода, как минимум два интерфейса.

Главным правилом подключения СХД к хосту является использование как минимум двух связей и путей для каждого устройства.

Свичи обеспечивают для серверов доступ только к предназначенным им ресурсам. Для этого в SAN каждому интерфейсу и каждому LUN-у присваивается World Wide Name (WWN) — подобие MAC-адреса.

LUN — Logical UNit — с точки зрения контроллера — это аналог раздела на жёстком диске. Сервер видит их как физические диски. Можно подключить все хосты к одному диску или раздать LUN-ы по серверам.

Распределение выполняется в Disk Manager конкретного сервера или с помощью утилит (LAN Mapping, SAN Mapping и т.п) хосту принудительно запрещается видеть LUN.

Не вешайте все LUN-ы на один контроллер. Разделите особо нагруженные LUN-ы по разным.

При создании SAN можно использовать разные типы HDD. Помедленнее и подешевле, типа SAS или SATA, — для ОС сервера и файловых ресурсов; FC — для скоростных приложений и баз данных.

Алгоритм подключения

В сервер установите HBA-контроллер.

Подключите СХД с помощью кабелей соответствующих интерфейсам, установленным на дисковой хранилище (FC, SAS, SCSI) по вашей схеме.

Проведите настройку сети, правильно установите типы используемых портов для оптической сети.

Скачайте с сайта производителя ПО. Однако, оно может идти в комплекте, но это не обязательно.

Установите ПО. Пройдите регистрацию, если требуется.

Включите HBA хоста и дисковую полку в одну подсеть на одном физическом коммутаторе.

Запустите утилиту сканирования SAN для определения топологии. Она покажет все устройства и их номера.

Зарегистрируйте хост на полке. Это можно сделать с помощью утилиты или вручную через веб-интерфейс полки. Автоматически — корректней.

Введите в браузере IP-адрес хоста и сделайте привязку полки. При первом подключении может понадобиться создать пароль админа.

Зайдите в систему управления дисками на хосте, убедитесь, что подключенные диски видны. Они выглядят там как обычные SCSI.

Перейдите по IP-адресу СХД в браузере. Проверьте наличие серверов, регистрация которых уже выполнена.

Найдите вкладку с инициаторами, связывающими хосты с блоками СХД. Проверьте IP-адреса. Если нужно, перенастройте их вручную.

Свяжите LUN-ы и хосты. Действия типа: Create -> Connect LUNs -> Connect Hosts.

Посмотрите наличие отметки около HBA, сигнализирующей о корректности подключения.

На этом настройка полки закончена.

Нарежьте диски на LUN-ы. Их можно сделать много. Оставьте около 1 Гб свободного места

Переведите диски в режим онлайн. Буквы не присваивайте.

Отформатируйте диски в нужный формат, например, NTFS.

Установите драйверы HBA (FC, SAS или SCSI).

Подключение завершено. Можно управлять системой с помощью специального софта или через веб-интерфейс.

Рекомендации

Если СХД только создаётся, имеет смысл использовать оборудование одного производителя, чтобы избежать проблем с совместимостью устройств.

Во избежание всяких неприятных ситуаций лучше сразу обратиться к системному интегратору, например, к нам.

Это можно не делать, если у вас в штате есть несколько опытных и толковых администраторов, у которых много свободного времени. Хотя, по деньгам вы здесь вряд ли выиграете, так как их работа оплачивается, а также нужно будет приобретать нужные комплектующие и пытаться их «подружить».

Дисковая полка конструктивно состоит из жёстких дисков и источника бесперебойного питания. Его основная функция — не питать систему в случае отключения электричества, а предоставление возможности СХД корректно завершить все операции ввода-вывода при выключении полки. Поэтому, для защиты сторейджа по питанию устанавливайте ИБП.

По FC можно подключиться к коммутатору и тем самым расширить количество используемых устройств. На SAS нельзя повесить серверов больше, чем есть портов на массиве.

Покупайте полку сразу с дисками.

Не подключайте несколько хостов к одному LUN-у, если у вас не кластер. Такое соединение создает несогласованность записи, что приведёт к повреждению данных.

Сервис — очень важная вещь в СХД. Так как стоимость и масштаб потерь велики, не скупитесь, заключите договор с интегратором на обслуживание. В результате вы сэкономите время, нервы и, как ни странно, деньги.

От того, как сконфигурированы системы хранения данных, в ряде случаев зависят их отказоустойчивость и производительность. Администраторам популярных систем хранения данных HP StorageWorks MSA2000sa важно знать ряд тонкостей создания консолидированной среды хранения на базе этих дисковых массивов.

Дисковые массивы MSA2000sa в корпусе 2U предназначены для формирования консолидированной среды хранения данных малых и средних предприятий, а также для организации дисковых хранилищ второго или третьего уровня в удаленных офисах и филиалах крупных компаний. Для систем начального и среднего уровня можно приобрести систему в базовой (минимальной) конфигурации с одним контроллером, а затем модернизировать ее, дооснастив вторым контроллером, либо сразу купить решение с двумя контроллерами. Максимальная емкость системы составляет 5,4 Тбайт при использовании дисков SAS или 12 Тбайт при оснащении дисками SATA в основном корпусе с 12 отсеками. Если же подключить три дополнительные дисковые полки по 12 отсеков в каждой, то емкость системы можно увеличить до 21,6 Тбайт в случае применения дисков SAS и до 48 Тбайт для SATA. К одной системе MSA2000sa можно подключить до четырех хост-серверов напрямую по SAS-интерфейсу.

Сколько надо контроллеров?

Для обеспечения высокой доступности данных и производительности предпочтительна конфигурация с двумя контроллерами, однако в ряде случаев вполне оправданно применение одного.

Конфигурация со сдвоенным контроллером обеспечивает более высокую доступность приложений, поскольку при отказе одного контроллера (вероятность такого события исключительно мала) его функции - управление массивами RAID и кэш-памятью дисковой подсистемы, рестарт сервисов защиты данных и назначение хост-портов — «подхватываются» резервным контроллером, а вышедший из строя узел можно заменить без отключения устройства хранения данных. Дополнительное преимущество данной конфигурации - возможность поднять производительность за счет распределения нагрузки по обработке операций ввода/вывода.

В конфигурации с двумя контроллерами применяется зеркалирование кэш-памяти. Благодаря автоматической передаче в режиме <<вещания>> (broadcast) записываемых данных на резервный кэш, снижаются нагрузки и задержки для кэш-памяти основного контроллера. При отключении питания кэшируемые данные немедленно записываются на флэш-память обоих контроллеров, что исключает риск потери данных. Реализация записи в режиме «вещания» позволяет лучше защитить данные, не жертвуя производительностью и временем отклика.

Конфигурация с одним контроллером потенциально может стать единственной точкой отказа (Single-Point-of-Failure, SPOF) -один контроллер способен обслуживать до двух хост-серверов (при прямом подключении) со скоростью доступа 3 Гбит/с, и при его отказе хост-сервер теряет доступ к системе хранения.

Конечно, один контроллер дешевле двух, и такая конфигурация оправданна для решений, где не требуется высокая степень доступности данных и допустимы кратковременные простои для восстановления доступа. Подобные конфигурации применяются и при обеспечении избыточности на уровне серверов, например в двухузловых кластерах, где каждый сервер подключается к собственному контроллеру и выход из строя последнего ведет к отказу соответствующего узла. Имеется еще вариант построения системы хранения высокой доступности с применением менеджера томов, с его помощью поддерживается зеркальная копия данных на двух независимых системах хранения, каждая из которых имеет по одному контроллеру. При выходе из строя данные восстанавливаются по резервной копии.

Прямое подключение

В схеме Direct Attach Storage (DAS) система хранения данных напрямую подключается к хост-серверу. Благодаря отсутствию коммутаторов (storage switch) такое решение экономично, как и в решении с использованием массива MSA2000fc (fibre channel), допускается коллективное использование системы хранения, но его возможности будут ограничены количеством внешних портов контроллеров. Существенное преимущество данной системы хранения - поддержка при непосредственном подключении четырех хост-серверов по одному порту или двух хост-серверов по двум портам без применения коммутатора.

При реализации решения с DAS-подключением рекомендуется применять схему подключения хост-серверов по двум портам.

Вообще производительность дисковой подсистемы напрямую зависит от числа дисков в ней задействованных. Особенно актуально для 5-го/6-го рейдов. Чем больше дисков, тем шустрее. С этой точки зрения логично собирать все диски в одну группу (опять спейр диском только одним можно будет обойтись).

С другой стороны, если у СХДшки не один, а два контроллер, то для балансировки нагрузки можно создавать две группы и луны с одной привязывать к первому контроллеру, а луны с другой - ко второму.

Зачем может понадобиться создавать более двух групп, затрудняюсь придумать. :-)

Геннадий, спасибо Вам еще раз! Хочу уточнить один момент по поводу Вашего совета по конфигурации "медленной" полки.Вы пишите, что RAID10 излишен, смысла тратить половину дисков нет. С аргументом двойных дисковых затрат я согласен. Но насколько я понимаю, RAID5 наиболее хорош в операциях ЧТЕНИЯ. А предназначение "медленной" полки - создание резервных копий и реплик, т.е. в большинстве своем - это операции ЗАПИСИ. Как я понимаю, здесь передо мной встает дилемма: либо тратить "половину дисков" на повышение производительности (т.е. жертвовать объемом в пользу производительности) либо (в случае RAID5) иметь больший объем дискового простанства, но проигрывать по скорости записи.

Для "медленной" полки в моих условиях (мне не жалко места на дисках, по крайней мере пока) лучше RAID10.

Но Вы навели меня на идею о том, что может быть "быструю" полку следует строить по схеме RAID5 или 6.

Интересно, чья производительность на чтение будет выше RAID10 из 10 дисков или RAID5 из 11 дисков? Может подскажете, толковую Benchmark-программу, которой можно будет это измерить по факту?

Хотел бы услышать Ваше мнение по поводу создания отдельной дисковой группы для целей загрузки хостов ESX (допустим, 2 диска в RAID 1 и один hot spare диск). Есть ли в этом смысл?

Теперь по поводу привязки друх дисковых групп к соответствующим двум контроллерам СХД. Ваше предложение мне нравится, но возникает вопрос. Если один из контроллеров "умирает", то диски привязанной к нему группы автоматически "отвяжутся" от него и "привяжутся" к оставшемуся работоспособному контроллеру? Rumata писал(а): Хочу уточнить один момент по поводу Вашего совета по конфигурации "медленной" полки. Может имеет смысл поговорить о нашем техсаппорте? Мы приедем, настроим, научим,

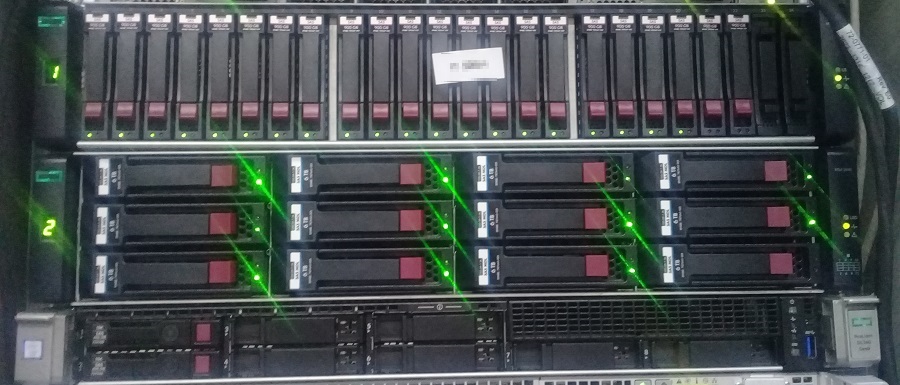

Привет, сегодня проводим эксперимент. Мы отключим полку HPE MSA 2040 ES LFF Disk Enclosure от СХД HP MSA 2040 и подключим её к серверу HPE Proliant DL360 Gen9. Эксперимент должен ответить на вопросы:

- Что нужно для такого подключения?

- Увидит ли контроллер сервера диски?

- Увидит ли контроллер сервера созданные на HPE MSA массивы RAID?

У нас есть

Имеется отдельно стоящий сервер HPE Proliant DL360 Gen9.

Имеется СХД HPE MSA 2040.

К СХД подключена полка HPE MSA 2040 ES LFF Disk Enclosure.

На полке 12 дисков и из них создан RAID5 массив.

Нужно для подключения полки к серверу

Для подключения полки к серверу понадобится дополнительное оборудование:

- PCI RAID контроллер. У меня есть в шкафу HPE H241 Smart HBA. HPE H241 Smart HBA

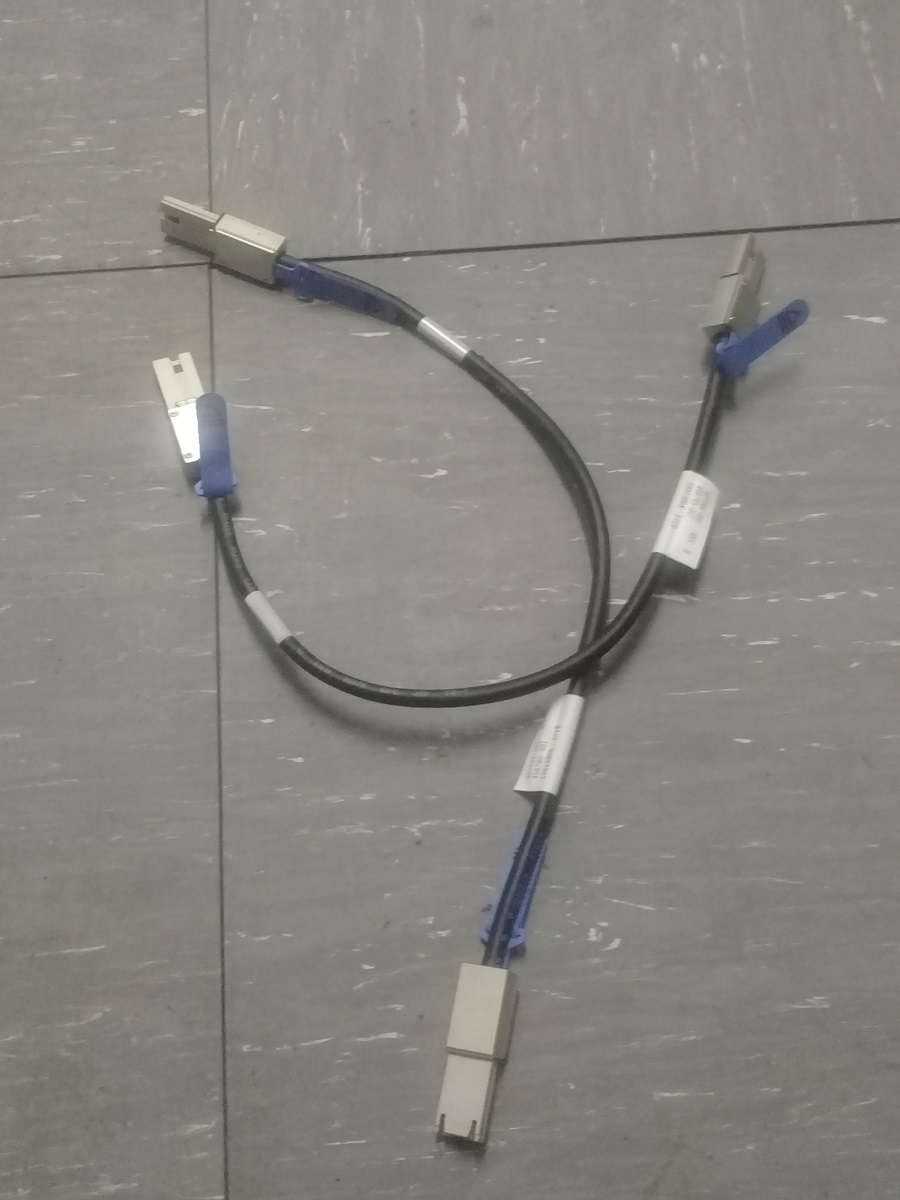

- Два кабеля Mini SAS HD to Mini SAS. И снова поможет шкаф: 716191-B21 - кабель HP 2.0m External Mini SAS HD to Mini SAS

Сборка

В сервер HPE Proliant DL360 Gen9 вставляем контроллер HPE H241 Smart HBA:

Отключаем HPE MSA 2040 ES LFF Disk Enclosure от СХД HP MSA 2040.

Берём новое кабло:

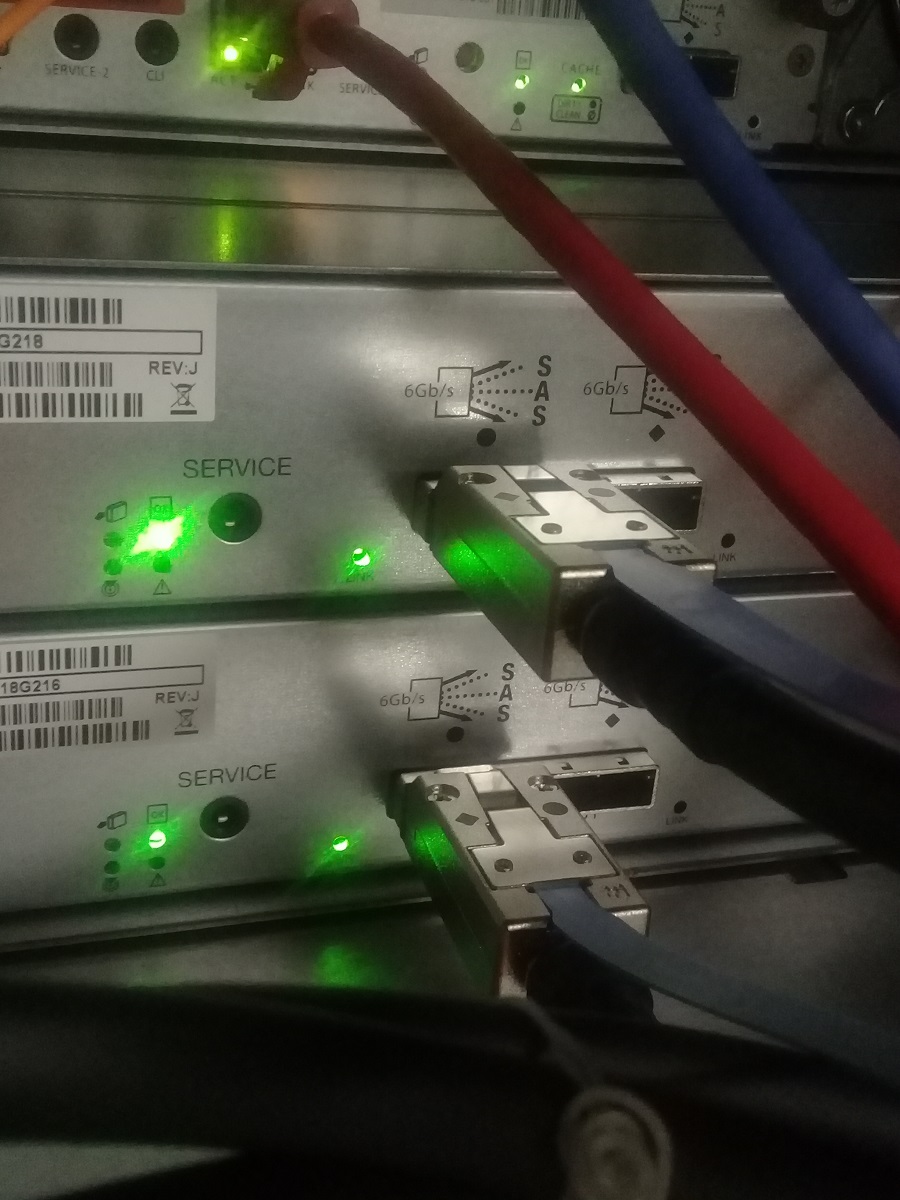

Подключаем одним концом к HPE MSA 2040 ES LFF Disk Enclosure в порт IN (слева):

Второй конец втыкаем в сервер HPE Proliant DL360 Gen9 в контроллер HPE H241 Smart HBA:

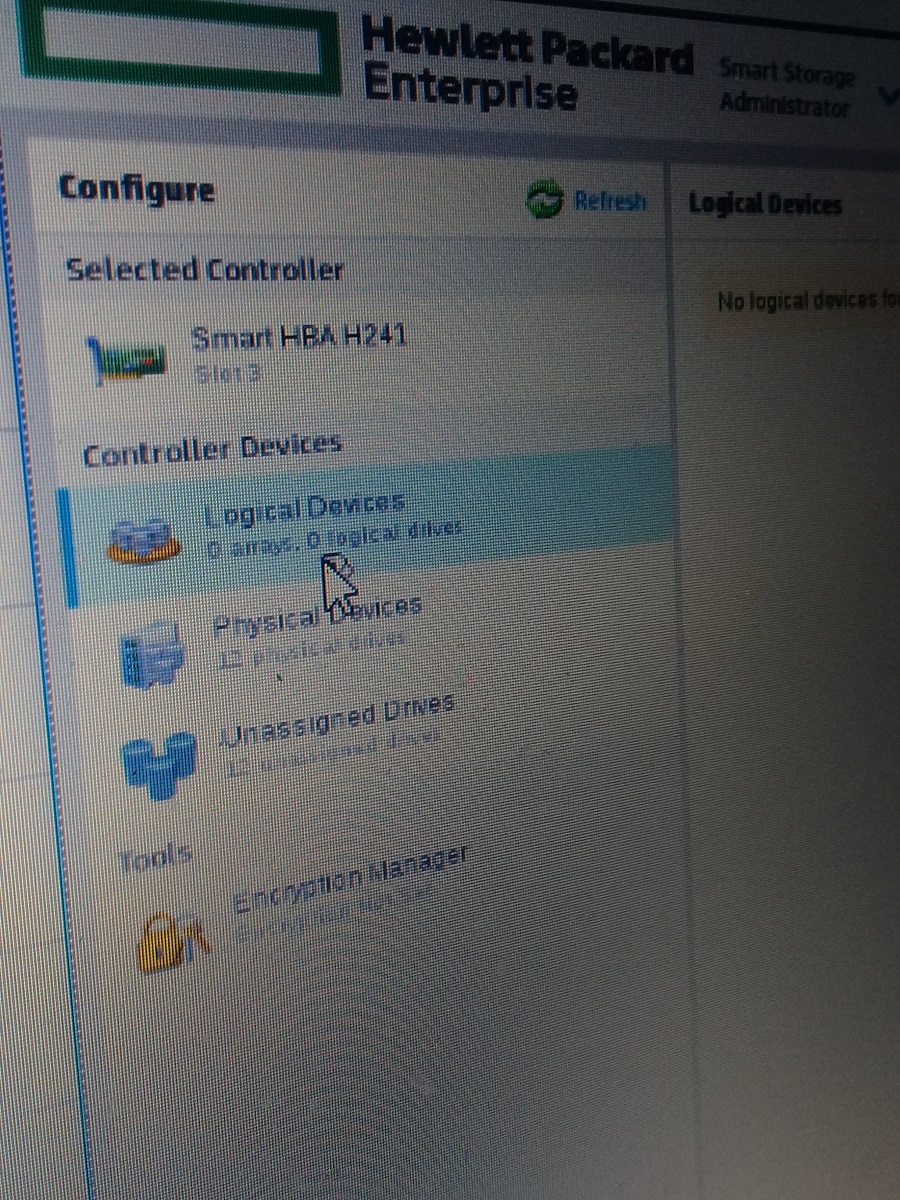

Загружаем сервер и входим в SSA - Smart Storage Administrator. Если контроллер HPE H241 Smart HBA находится в режиме HBA - переключаем его в RAID Mode и перезагружаем сервер.

Снова входим в SSA и видим такую картину:

Логических устройств - 0. Это говорит о том, что контроллер не видит массивы RAID, созданные на СХД HPE MSA 2040.

Однако, физических устройств - 12. Значит, сами диски контроллер прекрасно видит и данную полку вполне можно использовать как дополнение к серверу.

Давайте попробуем определить, что за устройство на картинке.

Правильно - по “морде” определить невозможно. Нужно смотреть на тыльную часть. И варианты могут быть разные:

А. Сервер

B. Система хранения данных (СХД)

C. Дисковая полка SAS-1 c двумя контроллерами JBOD (HP MSA2000sa AJ750A)

СХД - система хранения данных - это не полка

СХД (система хранения данных) намного сложнее полки, они дороже и имеют значительно больше нюансов.

Отличие СХД от полки это наличие “Мозга”. Контроллеры СХД это мини-серверы, со своими процессорами, памятью и операционной системой. СХД собирают из дисков RAID массивы, и передают данные по протоколам высокого уровня (iSCSI, NFS), контролируют целостность данных, позволяют создавать снапшоты и многое другое. СХД нужна если наша задача построить отказоустойчивый кластер

Однако, в случае если мы просто хотим добавить дисков в сервер, наличие “мозга” создаёт сложности: Не все СХД понимают диски объемом более 2Tb. Редкие СХД принимают от независимых производителей. Несмотря на то, что СХД полезное устройство - в этой статье мы не будем рассматривать использование СХД. Сегодня давайте разберёмся с полками.

Полка - это не СХД

Полка - достаточно простое устройство. Корпус, два блока питания, бэкплэйн и JBOD* контроллеры. Задача полки, без какой либо обработки, передать данные из накопителя в адаптер (карту RAID или HBA). Любая полка поддерживает диски любого объёма и любого производителя. Всё решает карточка в сервере. Контроллер полки - это набор микросхем с жесткой логикой.

Так выглядит подключение дисков внутри сервера

Так подключение сервер + полка.

С точки зрения схемотехники (и операционной системы), диски, установленные в полку, ничем не отличаются от дисков установленных в сервер**.

Полка имеет отдельный корпус, отдельные блоки питания, но в обоих случаях подключение производиться через RAID карточку установленную в сервер -, отличие лишь в том, что в случае с полкой, кабель подключается не по внутреннему а по внешнему разъёму.

*JBOD = Just A Bunch of Disks ( просто пачка дисков )

** Если быть совсем точным, полку можно сравнивать с сервером в котором установлен SAS экспандер - это серверы в которых количество дисков превышает 8. Для операционной системы SAS экспандер не заметен.

Вот широко распространённый RAID контроллер LSI9260-8i

8i означает 8 внутренних портов SAS/SATA

А вот его брат LSI9280-4i4e

4 внутренних и 4 внешних порта

Как называется вот этот контроллер, я думаю вы уже догадались )

Правильно - это LSI9280-8e

Все эти контроллеры собраны на одном и том же чипе LSI2108. Они обеспечивают работу по протоколам SAS/SATA со скоростью 6Gb/s и “понимают” диски объёмом более 2Tb. Попутно замечу, что на этом чипе собраны RAID контроллеры в серверах Supermicro, Intel, IBM, DELL, Fujitsu и CISCO. Многие из производителей даже не утруждают себя разработкой собственной печатной платы - меняют только прошивку. Но впрочем RAID и HBA - тема для отдельной статьи.

Вывод: если не хватает места для дисков - можно просто подключить к серверу полку. Новый сервер покупать не обязательно

Еще несколько нюансов

Полки бывают не только SAS, но других типов, например FC (скорее всего они вам не нужны).

Полки могут быть 3, 6 и 12Gb/s. Не все знают, что в одном кабеле mini-SAS четыре канала. Это значит, что для вычисления скорости обмена полка-контроллер показатель 3,6,12 нужно умножить на 4, а в случае если полка и контроллер соединяются двумя кабелями, на 8. Для примера 3-х гигабитная полка сможет отдавать в сервер 3x4 = 12 Гигабит! Что очень неплохо, особенно, если вы устанавливаете шпиндельные накопители. Для работы диска с сервером важна не скорость передачи данных а количество операций ввода-вывода IOPS. Об этом читайте в пункте 7.

Не важно Supermicro, IBM, DELL или HP. Любая SAS полка будет работать с любым SAS контроллером. Брэнд имеет значение только когда вы подключаете полку к СХД.

Полки можно собирать в гирлянду - подключая к одному контроллеру сразу несколько полок.***

*** Если вы используете SATA диски, длина подключения не должна превышать 1М.

При использовании SAS дисков (или SATA дисков с интерпозерами) можно подключать полку по двум путям, через два контроллера. Это позволяет избежать отказа в случае выхода их строя одного из контроллеров.

Полки можно добавлять по мере роста количества данных, подключая их двумя путями

“в гирлянду” вот так:

SFF* полки ( обычно бывают 2U на 24-25 дисков)

Для чего нужны SFF полки?

Типичный сервер редко перекидывает большие блоки данных - в основном он производит хаотичные запросы чтения или записи маленьких блоков из совершенно разных мест массива. Скорость по этому показателю измеряется не в Гигабитах в секунду, а в количестве операций ввода-вывода (IOPS). И именно IOPS, а не трансфер основной параметр которому следует уделять внимание. Пользователи ПК сравнивают диски по показателям 3Gb/s, 6Gb/s, 12Gb/s, но зачастую, скорость потока диск - сервер это не Гигабиты, и даже не Мегабиты, а Килобиты! Скорости 3Gb/s, которую обеспечивают даже устаревшие интерфейсы в большинстве случаев достаточно. Сильно ошибаются те, кто думают, что улучшат производительность, сменив диски 3Gb/s на 12Gb/s. Если не изменился форм-фактор и обороты диска - скорость IOPS не измениться.

На увеличение IOPS положительно влияют: увеличение оборотов, уменьшение физического размера, увеличение числа дисков в массиве.

LFF диски, (особенно низкооборотистые 7200RPM) не предназначены на работу в режиме случайного доступа - их назначение хранение ColdData (например бэкапов)

*SFF Small Form Factor - это диски 2,5” Обычно это высоко-оборотистые 10-15К SAS диски объёмом 300-1200GB. Не стоит путать их с ноутбучными дисками.

LFF Large Form Factor - это диски 3,5” Обычно низко-оборотистые 7200 диски, объёмом 2TB и более.

И наконец, если у вас уже есть СХД, добавив полку вы можете увеличить не только объём, но и существенно повысить скорость работы. Ведь показатель IOPS напрямую зависит от количества дисков.

У нас имеются полки для наиболее распространённых СХД производства NetAPP, HP, Dell, IBM.

Читайте также: