Как подключить том vmfs к windows

Обновлено: 05.07.2024

Пятница, вечер, думаешь о том, что впереди выходные, можно будет отдохнуть от тяжелой недели и все хорошо. А тут звонок:

-Алло, сервер терминалов завис!

Сервер работает на vmware esxi и перезагрузить гостевую ОС можно довольно легко, даже с мобильного телефона.

Кликаем. Ждем. Ждем.Ждем. так, что то уже не так. Отваливается консоль управления в vmcenter. Понимаю, что все плохо. Через ssh в esxitop выдает огромную нагрузку на ЦП процессом system. Принимаю решение перезагружать гипервизор, все же ESXI 6.5 не особо стабилен. Перезагружаемся. иии не хватает одного датастора, который был на свеже купленной SSD. Умер SSD!

Манипуляции с esxicli не помогают. Не хочет гипервизор видеть датастор. Конец рабочего дня. И есть 2 варианта: для лентяев-эгоистов и для КРУТЫХ: откатить вчерашний бекап и послать нафиг все наработки сотрудников за этот день, либо попробовать восстановить данные.

Мы же с тобой крутые! Поехали.

1.Монтируем диск ssd как RAW:

смотрим все диски в системе коммандой:

ls -l /vmfs/devices/disks

и подключаем его командой

vmkfstools -z /vmfs/devices/disks/ПОЛНОЕ НАЗВАНИЕ "ПУТЬ К создаваемому VMDK"

Подключаем созданный диск в виртуальную машину с windows и скачиваем программу UFS Explorer Professional Recovery.

Нажимаем просмотр файловой системы и видим:

Слева появится информация о структуре образа:

Программа хоть и имеет лимит в бесплатной версии по объему файлов для восстановления, образы создает бесплатно. Пишет в формате .img

Сохраняем образ системы.

Создаем виртуальную машину c дополнительным диском базе ubuntu и ставим gparted. Создаем раздел, открываем Disks и выбираем созданный на этапе 2 образ. (Скриншот для примера)

Дожидаемся окончания процесса. После чего имеем VMDK диск, на котором сохранены все данные. Таким образом можно бесплатно вернуть данные с убитого раздела vmfs6 и сохранить себе нервных клеток.

Всем удачи, делайте бекапы и думайте всегда, а что если все сломается!

PS у меня вернулись все данные на момент сбоя. Все довольны. Но объемы данных большие и процесс занимает много времени. Нужно терпение.

Сегодня мы разберем несколько простых способов получения доступа к данным, хранящимся на файловой системе VMFS хранилища (datastore) гипервизора ESXi (это файлы конфигурации, файлы с данными и снапшотами виртуальных машин). Статья, собственно, основана на реальной ситуации, возникшей у одного из клиентов, когда единственный продуктивный сервер с гипервизором VMware ESXi перестал загружаться.

В том случае, если не работает сам хост ESXi, но локальный диск (или диски) сервера остался работоспособными, вы всегда сможете скопировать файлы виртуальных машин (как диски с данными, так и конфигурационные файлы) с него и запустить ВМ на другом сервере (на VMware Workstation или даже Hyper-V). Основная проблема в том, что «классические» операционные системы (Windows и Linux) по умолчанию не видят раздел с файловой системой VMFS, т.к. в них отсутствует драйвер файловой системы VMFS. В этой статье мы рассмотрим, как получить доступ к файлам виртуальных машин на диске с файловой системой VMFS из разных ОС.

В моем случае проблема была в том, что резервное копирование виртуальных машин VMware настроено не было, как и не было времени на диагностику и решение проблем с загрузкой системы. Поэтому было принято решение вручную скопировать файлы критичной виртуальной машины с хранилища VMFS и запустить ее на другом компьютере на срочно поднятом для этих целей гипервизоре ESXi.

Разберем три сценария доступа к данным на файловой системе VMFS:

Монтирование VMFS раздела в Linux (Ubuntu)

В этой секции мы покажем, как смонтировать раздел с файловой системой VMFS на компьютере с установленной ОС Ubuntu (Live CD с Ubuntu в этом сценарии нам не подойдет).

В первую очередь необходимо подключить физический диск с файловой системой VMFS к компьютеру (серверу) с Ubuntu. Чтобы получить доступ к данным на VMFS томе, нам понадобиться установить специальный сторонний пакет vmfs-tools. Данный пакет позволяет получить доступ к файловой системе раздела VMFS из компьютеров под управлением Linux. Доступ к данным на таком разделе возможен в режиме только на чтение (read-only). Второе важное ограничение, разработчики vmfs-tools официально заявляли о поддержки версий файловой системе VMFS вплоть до VMFS 5.0. Возможность подключения раздела с VMFS 6 (vSphere 6.0 и 6.5.) не гарантируется.

Установим пакет следующей командой

Примечание. В репозитариях Ubuntu пока доступна только версия vmfs-tools 0.2.1, основной ее недостаток – она умеет работать только с файловой системой VMFS v4. Если вам нужно смонтировать датастор с VMFS 5, придется самостоятельно скачать и установить версию vmfs-tools не ниже 0.2.5, например, здесь:

Качаем соответствующую версию пакета так:

И устанавливаем его:

Если нужно будет удовлетворить зависимости, воспользуйтесь командой:

После установки пакета, нужно создать точку монтирования, в которую будет подключен VMFS раздел:

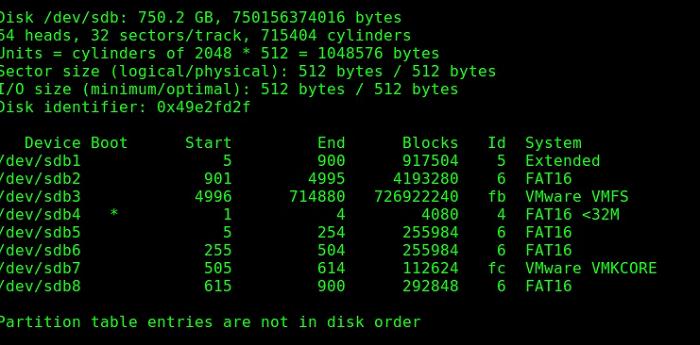

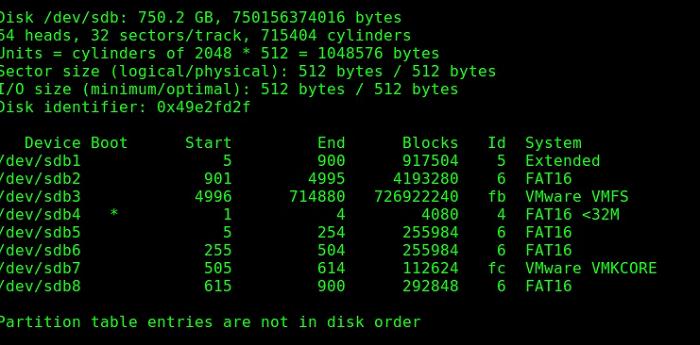

Следующий шаг – нужно разобраться с разделами на дисках. Гипервизор ESXi при установке помимо, собственно, раздела для файлов виртуальных машин (VMFS) создает множество служебных разделов. Если версия ESXi 4 или ниже, или VMFS хранилище было обновлено с версии VMFS 3 до VMFS 5, а его размер не превышает 2 Тб, выведем список дисков и разделов так:

Важно. Т.к. в ESXi 5 используется VMFS v5 с таблицей разделов GPT (таблица GUID Partition Table), которая используется вместо MBR, что позволяет создавать хранилища большего размера и пробрасывать RDM диски в режиме физической совместимости размером более 2 TB. Поэтому для просмотра таблицы разделов придется вместо fdisk использовать команду parted.

Итак, выведем информацию о разделах так:

Осталось смонтировать раздел диска с хранилищем VMFS:

Выведем содержимое смонтированного раздела:

Итак, теперь мы видим все файлы виртуальных машин на VMFS хранилище, которое доступно нам только для чтения, а это значит, что мы можем скопировать каталоги и/или отдельные файлы нужных виртуальных машин на отдельный диск и запустить их на другом гипервизоре ESXi.

Доступ к VMFS разделу из Windows

Для доступа к данным на VMFS разделе из Windows, нам понадобится специальный открытый драйвер Open Source VMFS Driver, написанный на Java. Драйвер требует версию Java не ниже 6 и также позволяет монтировать VMFS-тома в режиме только для чтения.

Примечание. При попытке подключения более новой версии VMFS появится ошибка No VMware File System detected.

- Итак, скачайте Open Source VMFS Driver (fvmfs_r95_dist.zip ) и распакуйте его в произвольный каталог (допустим C:\vmfs)

- Проверить работу java-приложения fvmfs.jar можно так:

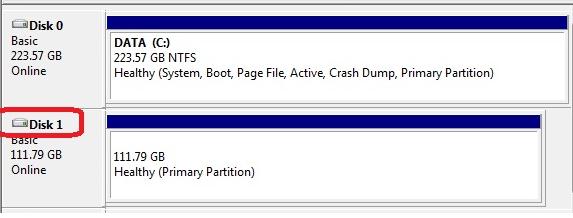

- Далее нужно определить номер диска с хранилищем VMFS, подключенный к Windows-компьютеру. Номер диска можно узнать с помощью консоли управление дисками или diskpart. (В нашем примере подключенный диск имеет индекс 1 – Disk1. Для драйвера утилиты fvmfs, этот диск будет именоваться так: \\.\PhysicalDrive1)

- Попытаемся получить информацию о диске:

Подключаем VMFS хранилище на новом ESXi хосте

Как вы видите, в обоих рассмотренных выше случаях сторонние драйверы для VMFS под Linux и Windows не позволяют работать с VMFS 6.0. Поэтому самый универсальный способ получить доступ к данным на VMFS разделе диска вышедшего из стоя сервера – подключить его на новом сервере ESXi (который, благо, устанавливается и настраивается менее чем за час). Это самый простой способ. Таким способом вы сможете переподключить как физический жёсткий диск, так и LUN с устройства хранения (через FC или iSCSI).

Новый хост ESXi должен корректно определить подключенный VMFS датастор и вы сможете получить доступ к файлам на нем.

Итак, как подключить существующее VMFS хранилище на новом ESXi хосте без его форматирования.

Сегодня мы разберем два простых способа получения доступа к данным, хранящимся на файловой системе хранилища (datastore) гипервизора ESXi (это файлы конфигурации, файлы с данными и снапшотами виртуальных машин). Статья, собственно, основана на реальной ситуации, возникшей у одного из клиентов, когда единственный продуктивный сервер с гипервизором VMware ESXi перестал загружаться.

Проблема была в том, что резервное копирование виртуальных машин VMware настроено не было, как и не было времени на диагностику и решение проблем с загрузкой системы. Поэтому было принято решение вручную скопировать файлы критичной виртуальной машины с хранилища VMFS и запустить ее на другом компьютере на срочно поднятом для этих целей гипервизоре ESXi.

Разберем два сценария доступа к данным на файловой системе VMFS:

Доступ к VMFS разделу из Ubuntu

В этой секции мы покажем, как смонтировать раздел с файловой системой VMFS на компьютере с установленной ОС Ubuntu (Live CD с Ubuntu в этом сценарии нам не подойдет).

В первую очередь необходимо подключить физический диск с VMFS к компьютеру с Ubuntu.

Чтобы получить доступ к данным на VMFS томе, нам понадобиться установить специальный пакет vmfs-tools. Данный пакет позволяет получить доступ к файловой системе раздела VMFS с не ESX/ESXi хостов. Доступ возможен в режиме только на чтение (read-only).

Установим пакет следующей командой

Примечание. В репозитариях Ubuntu пока доступна только версия vmfs-tools 0.2.1, основной ее недостаток – она умеет работать только с файловой системой VMFS v4. Если вам нужно смонтировать датастор с VMFS 5, придется самостоятельно скачать и установить версию vmfs-tools не ниже 0.2.5, например, здесь:

Качаем соответствующую версию пакета так:

И устанавливаем его:

Если нужно будет удовлетворить зависимости, воспользуемся командой:

После установки пакета, создадим каталог для точки монтирования:

Следующий шаг – нужно разобраться с разделами на дисках. Гипервизор ESXi при установке помимо, собственно, раздела для файлов виртуальных машин (VMFS) создает множество служебных разделов. Если версия ESXi 4 или ниже, или VMFS хранилище было обновлено с версии VMFS 4 до VMFS 5, а его размер не превышает 2 Тб, выведем список дисков и разделов так:

Как мы видим, раздел с файловой системой VMFS — /dev/sd3 (метка VMware VMFS)

Важно. Т.к. в ESXi 5 используется VMFS v5 с таблицей разделов GPT (таблица GUID Partition Table используется вместо MBR, что позволяет создавать хранилища большего размера и пробрасывать RDM диски в режиме физической совместимости размером более 2 TB). Поэтому для просмотра таблицы разделов придется вместо fdisk использовать команду parted.Итак, выведем информацию о разделах так:

Осталось смонтировать партицию с хранилищем VMFS:

Выведем содержимое смонтированного раздела:

Итак, теперь мы видим все файлы виртуальных машин на VMFS хранилище, которое доступно нам для чтения, а это значит, что мы можем скопировать каталоги и/или отдельные файлы нужных виртуальных машин на отдельный диск и запустить их на другом гипервизоре ESXi.

Доступ к VMFS разделу из Windows

Для доступа к данным на VMFS разделе из Windows, нам понадобится специальный открытый драйвер Open Source VMFS Driver, написанный на Java. Драйвер требует версию Java не ниже 6 и также позволяет монтировть VMFS-тома только для чтения

Всем привет! В последнее время всё чаще сталкиваюсь с тем, что многие админы используют дешёвые СХД (SOHO) для продуктивных сред… При этом редко задумываясь о доступности данных и отказоустойчивости решения… Увы, но не многие также задумываются о резервных копиях и бекапах…

Вот и сегодня ко мне «на лечение» попал интересный экземпляр:

Чудестный экземпляр EMC (ещё даже не Lenovo) iomega storcenter px4 (который дальше 25% не грузится)

О подробностях восстановления читайте под катом.

Итак, приступим.

Задачи у нас две:

1) Восстановить часть данных с дисков

2) Восстановить работоспособность СХД

Сперва нам надо понять с чем мы имеем дело и в этом нам поможет сайт производителя и документашка со спецификацией СХД — PDF дока.

Исходя из PDF-ки выше — можно понять что СХД представляет собой ничто иное как небольшой сервер на интеловом процессоре и, тут уж явно не на винде, каким-то линуксом на борту.

В самой документации нету упоминания о каком-либо RAID контроллере — потому пришлось вскрыть пациента и убедиться что аппаратная начинка не содержит сюрпризов.

Итак, что мы получили от хозяев СХД и документашки:

1) у нас есть СХД с дисками в каком-то RAID (без понимания в какой рейд заказчик собирал диски);

2) в СХД нету аппаратного RAID — так что делаем ставку на программное решение;

3) в СХД используется какой-то из линуксов (так как система не загружается — посмотреть что там не получилось);

4) Есть понимание что мы ищем на дисках (есть пара VMFS разделов которые были отданы для VM под ESXi и пара файловых шар для общего пользования).

1) ставим ОС и подключаем диски;

2) смотрим что полезного можно вытянуть из информации о дисках;

3) Собираем Raid и пытаемся смонтировать разделы;

4) монтируем VMFS разделы;

5) сливаем всю нужную информацию на другую хранилку;

6) думаем что делать с EMC.

Шаг №1

Так как «оживить» СХД не получилось (Если кто знает способы перепрошивки и может поделится утилитами — велкам в комментарии или личку) — подключаем диски к другой системе:

В моём случае под рукой был старенький сервачёк на AMD Phenom… Самое главное было найти материнку куда можно подключить минимум 4-и диска от СХД + 1 диск для установки ОС и прочих утилит.

ОС была выбрана Debian 8, так как она лучше всех дружит и с vmfs-tools и с iscsi target (ubunta ловит глюки).

Шаг №2

SDA — диск с ОС, остальные 4и — диска от СХД

Как видим на дисках есть два раздела:

20 Гб — так понимаю под ОС самого СХД

1.8 Тб — под данные пользователя

Все диски имеют идентичную разбивку — с чего можно сделать вывод что они были единым масивом в RAID.

Шаг №3

FSTYPE разделов определяется как linux_raid_member так что попробуем посмотреть что мы с них можем собрать.

При монтировании массива нам дали подсказу — filesystem type 'LVM2_member'.

Установим LVM2 и просканируем диски:

Как видим, мы нашли volume group. Логично предположить, что вторая часть может быть собрана подобным образом.

Теперь находит 2 LVM physical volumes

Из результата видно, что СХД собирала VG на LVM и дальше дробила на LV необходимых размеров.

Активируем разделы и пробуем их смонтировать:

Как видим, только часть разделов смонтировалось. А всё потому, что на других разделах — VMFS.

Шаг №4

Увы, но танцев с бубном избежать не удалось… напрямую VMFS монтировать не захотело (есть подозрение что это связано с новой версией VMFS и старыми vmfs-tools)

Перерыв кучу форумов, решение нашлось.

Создаем loop device:

Немного о kpartx можно почитать ТУТ.

Пробуем смонтировать получившийся маппер:

Смонтировалось удачно! (на ошибки можно забить так как Lun ID mismatch)

Тут мы пропустим череду неудачных попыток скопировать, из смонтированного датастора, сами виртуальные машины.

Как оказалось, файлы размером в пару сотен гигабайт — скопировать нельзя:

Шаг №5

Так как слить виртуальные машины из смонтированых датасторов не удалось… Попробуем подключить эти разделы к реальному ESXi и скопировать виртуалки через него (он то должен дружить с VMFS).

Подключим наши разделы к ESXi по средствам iSCSi (процесс опишем коротко):

1) Устанавливаем пакет iscsitarget

2) вносим необходимые параметры в /etc/iet/ietd.conf

3) Стартуем сервис service iscsitarget start

Если всё «ОК» — создаём на ESXi Software iSCSi controller и прописываем в Dynamic discovery наш сервер с примонтироваными разделами

Как видим разделы удачно подтянулись:

Так как LUN ID получившегося раздела не совпадает с тем что прописан в метаданных на самом разделе, для добавления датасторов к хосту — воспользуемся KB от VMware.

Читайте также: