Lsi управление raid linux

Обновлено: 07.07.2024

Поступил вопрос от DBA, написать о том, как разбиты диски на массивы в сервере Oracle Linux. Я, честно говоря, уже и не помню что мы там конфигурировали, воспользуемся средствами операционной системы и утилитой StorCLI.

Утилита работает и в других операционных системах на базе Linux, есть версия и для Windows, но у меня именно Oracle Linux 7.6, работаю с тем что есть.

Окружение

Раньше уже писал про то, как разбить эти диски в зеркало для ОС:

Дополнительно известно, что в сервере установлены два RAID контроллера, один обслуживает диски сервера, второй — диски полки.

Массивы в операционной системе

Посмотрим что у нас примонтировано:

У нас есть два массива md10 и md20 по 66 Тб каждый. ОС крутится на md126 .

lsblk показывает, что md10 — это RAID0, состоящий из двух дисков sda и sdb. md20 — это RAID0, состоящий из двух дисков sdc и sdc. md126 — это RAID1, состоящий из двух дисков sde и sdf.

md20 : active raid0 sdc1[0] sdd1[1]

70319335424 blocks super 1.2 512k chunks

md126 : active raid1 sde[1] sdf[0]

927881216 blocks super external:/md127/0 [2/2] [UU]

md127 : inactive sdf[1](S) sde[0](S)

10402 blocks super external:imsm

mdadm — утилита для создания массивов в linux, /proc/mdstat — статистика и состояние массивов.

Мы видим, что md126 — raid1 из двух дисков, md127 — это IMSM контейнер для md126. md10 и md20 — RAID0 массивы из двух дисков.

Ясно, что md126 — это зеркало RAID1 из двух физических задних дисков сервера. А вот sda, sdb, sdc и sdd — это некие массивы RAID контроллеров сервера, нужно разобраться, из чего они состоят.

StorCLI

Утилиту ищем в секции DOWNLOAD.

Скачиваю утилиту storcli .

Это очень мощная утилита по управлению RAID контроллером. Сегодня нам понадобится минимум функционала для определения состава массивов.

Данная команда выведет детальную информацию. Среди всего списка нам понадобится:

Ctl=Controller Index|DGs=Drive groups|VDs=Virtual drives|Fld=Failed

PDs=Physical drives|DNOpt=DG NotOptimal|VNOpt=VD NotOptimal|Opt=Optimal

Msng=Missing|Dgd=Degraded|NdAtn=Need Attention|Unkwn=Unknown

sPR=Scheduled Patrol Read|DS=DimmerSwitch|EHS=Emergency Hot Spare

Y=Yes|N=No|ASOs=Advanced Software Options|BBU=Battery backup unit

Hlth=Health|Safe=Safe-mode boot

Здесь мы увидим количество и модели контроллеров, их состояние.

Получим список виртуальных дисков для каждого контроллера:

Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|Dgrd=Degraded

Optl=Optimal|RO=Read Only|RW=Read Write|HD=Hidden|TRANS=TransportReady|B=Blocked|

Consist=Consistent|R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack|

AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled

Check Consistency

Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|Dgrd=Degraded

Optl=Optimal|RO=Read Only|RW=Read Write|HD=Hidden|TRANS=TransportReady|B=Blocked|

Consist=Consistent|R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack|

AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled

Check Consistency

Всего найдено 4 массива RAID10 по 32 Тб каждый. Это они у нас отображаются в операционной системе как sda, sdb, sdc, sdd.

Посмотрим на физические диски:

./storcli /c0 /eall /sall show

./storcli /c1 /eall /sall show

-------------------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type

-------------------------------------------------------------------------------

0:0 4 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:1 21 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:2 3 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:3 17 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:4 1 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:5 23 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:6 2 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:7 5 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:8 14 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:9 12 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:10 10 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:11 20 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:12 8 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:13 18 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:14 15 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:15 9 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:16 19 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:17 6 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:18 7 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:19 11 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:20 24 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:21 16 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:22 13 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:23 22 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

-------------------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

-------------------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type

-------------------------------------------------------------------------------

57:0 69 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:1 81 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:2 73 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:3 96 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:4 65 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:5 85 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:6 75 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:7 80 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:8 76 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:9 101 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:10 84 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:11 99 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:12 90 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:13 100 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:14 94 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:15 97 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:16 98 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:17 104 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:18 106 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:19 105 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:20 103 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:21 102 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:22 89 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:23 93 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

-------------------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

Этой информации нам достаточно, чтобы определить, что каждый RAID10 массив состоит из 12 дисков. Spare диски отсутствуют.

Результат

Далее 4 hardware RAID10 массива в операционной системе попарно объединены в RAID0 массивы средствами mdadm .

Если вам понравилась статья, то ставьте 👍🏻 каналу.

Пишите комментарии, задавайте вопросы, подписывайтесь.

Список инструментов управления для LSI/Avago

Правильно подобранная утилита, может выполнять поставленную задачу в разы удобнее и быстрее, и знание всех инструментов является прямой обязанностью любого системного администратора.

Кстати я уже делал похожие подборки по инструментам управления и настройки для серверов IBM, Supermicro и HPУтилита LSI Storage Authority

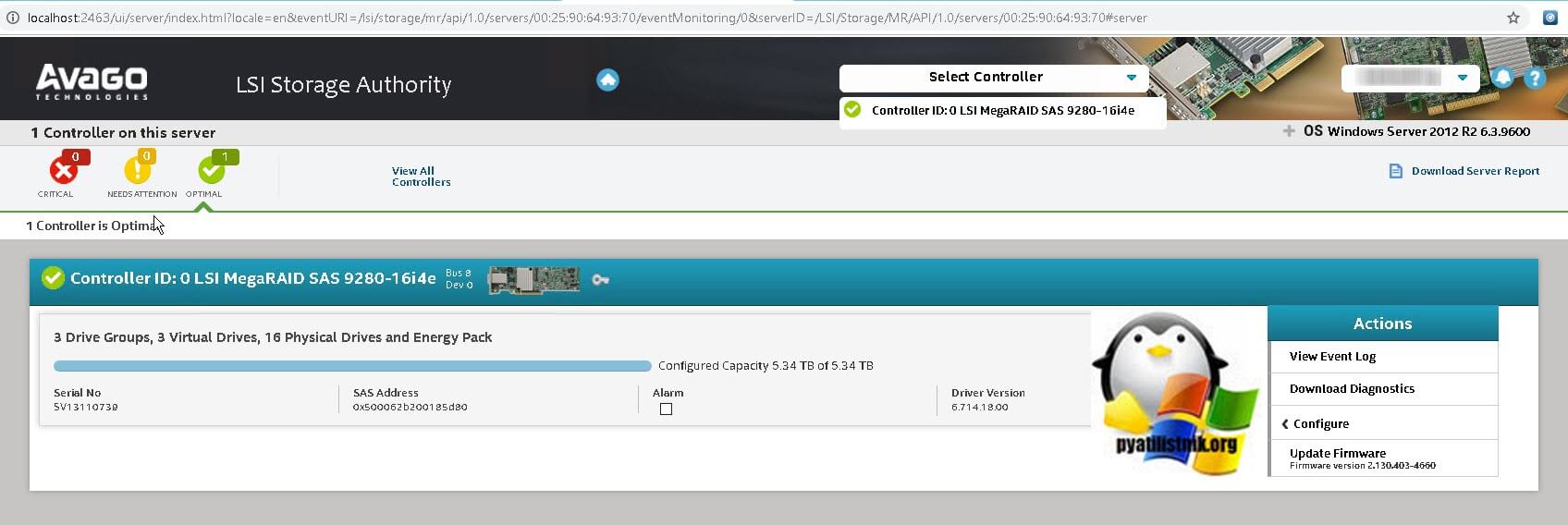

Про LSA (LSI Storage Authority) я уже делал подробнейший обзор. На текущий момент, это флагманский инструмент имеющий графический интерфейс управления, прямо из вашего браузера, что делает его кросплатфомным, убирающим привязку к операционной системе. Что хорошо, что утилита работает не на медленном Java, а на HTML5, что делает ее очень удобной.

Вот так выглядит общий дашборд управления, на нем вы увидите список ваших устройств представленных на сервере, в моем примере Controller ID: 0 LSI MegaRAID SAS 9280-16i4e.

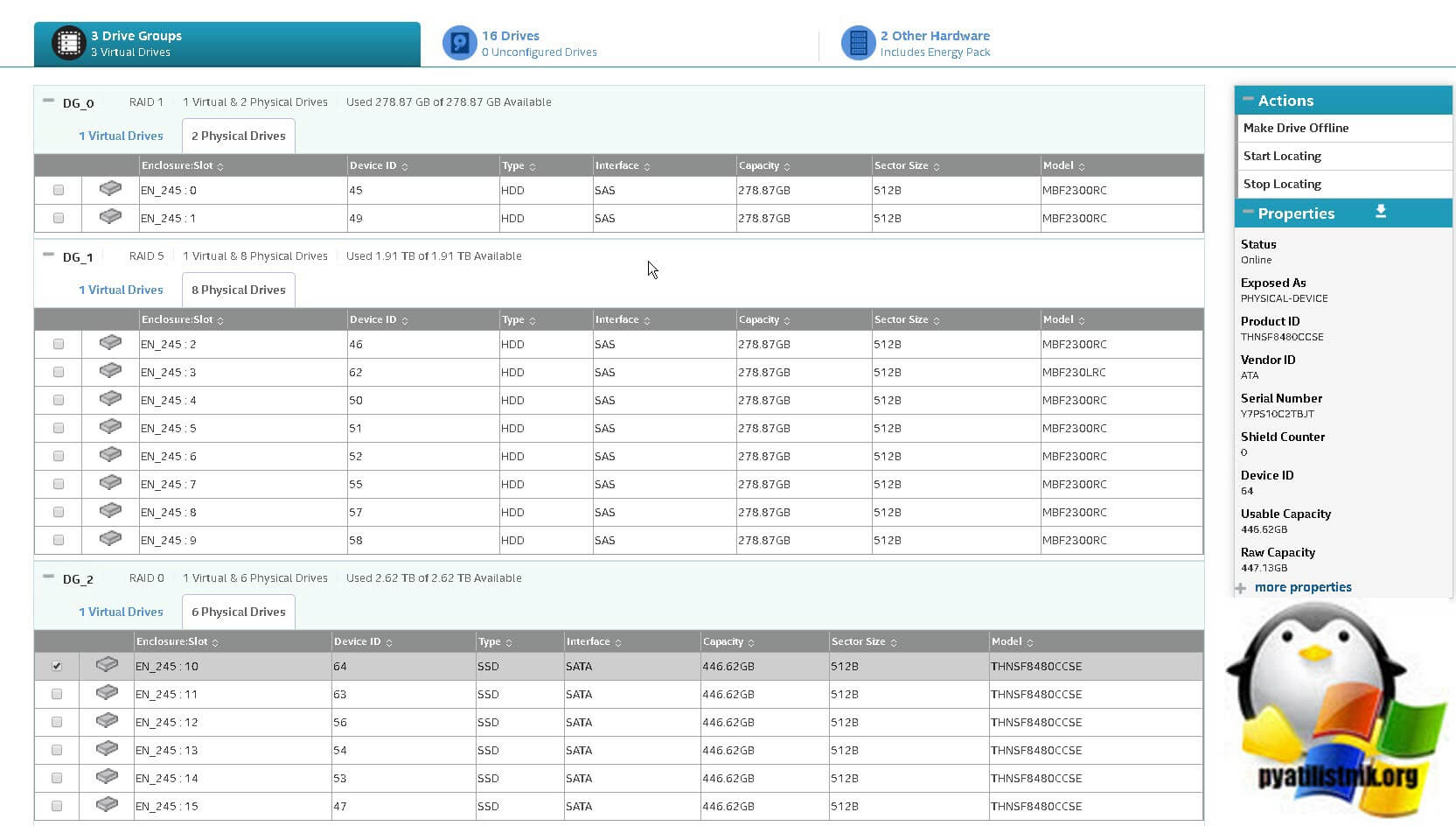

Вот так выглядит информация по вашим виртуальным и физическим дискам. Хочу отметить, что LSI Storage Authority показывает больше информации по свойствам физических дисков, тут вы легко обнаружите:

- Status - Online

- Exposed As - PHYSICAL-DEVICE

- Product ID - THNSF8480CCSE

- Vendor ID - ATA

- Serial Number - Y7PS10C2TBJT

- Shield Counter - 0

- Device ID - 64

- Usable Capacity - 446.62GB Capacity - 447.13GB

- less properties - General Properties

- SAS Address 0 - 0x500062b200185da2

- Negotiated Link Speed - 6G

- Drive Speed - 6G

- Temperature - 25C

- Revision Level - DAC9

- Power Status - On

- Native Command Queueing Capable - No

- Physical Sector Size - 512B

- SCSI UNMAP - Disabled

- Enclosure Properties

- Enclosure ID - 245

- Enclosure Model - Backplane

- Enclosure Location - Internal

- Enclosure Connector - N/A

- Drive Security Properties

- Full Disk Encryption Capable - No

- Full Disk Encryption Type - NONE

- Protection Information Properties

- Protection Information - Incapable

Утилита MegaRAID Storage Manager

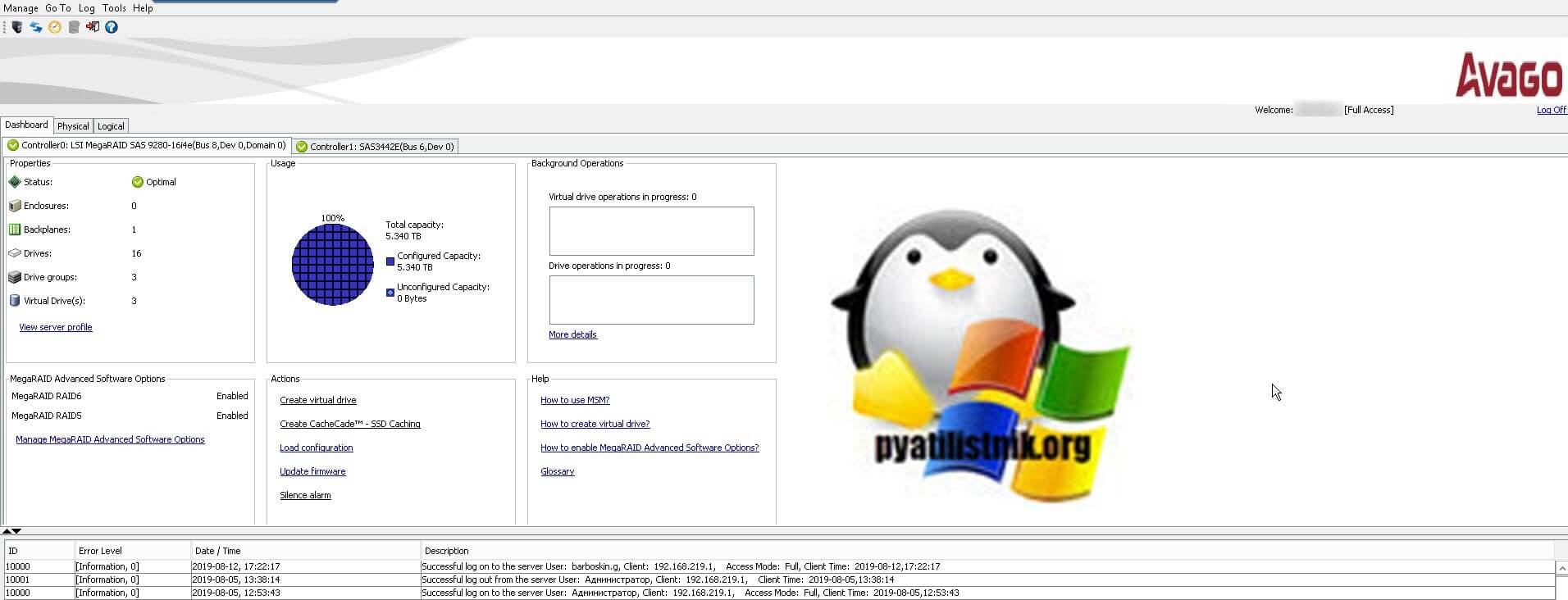

MegaRAID Storage Manager - это более старая утилита, с которой мы уже много взаимодействовали в предыдущих статьях. Например мы устанавливали MegaRAID Storage Manager на ESXI 5.5. Вот так выглядит базовый дашборд со сводной информацией, о RAID контроллерах LSI/Avago. Тут вы увидите:

- Общий объем ваших дисков, в моем примере это 5,3 ТБ

- Состояние контроллера (Status) - если все хорошо, то статус должен быть Optimal

- Drives - количество физических дисков

- Drive groups - количество датасторов

- Virtual Drives - количество виртуальных дисков

![Утилита MegaRAID Storage Manager]()

Тут же есть область "Action", позволяющая загрузить конфигурацию, обновить прошивку RAID контроллера, настроить звуковой сигнал предупреждения. Справа есть ссылки на документацию. Снизу вы увидите текущие события на вашем контроллере LSI/Avago. Вкладка "Physical" покажет ваши физические диски, выбрав любой из них вы увидите дополнительные свойства.

![Физические диски в утилите MSM]()

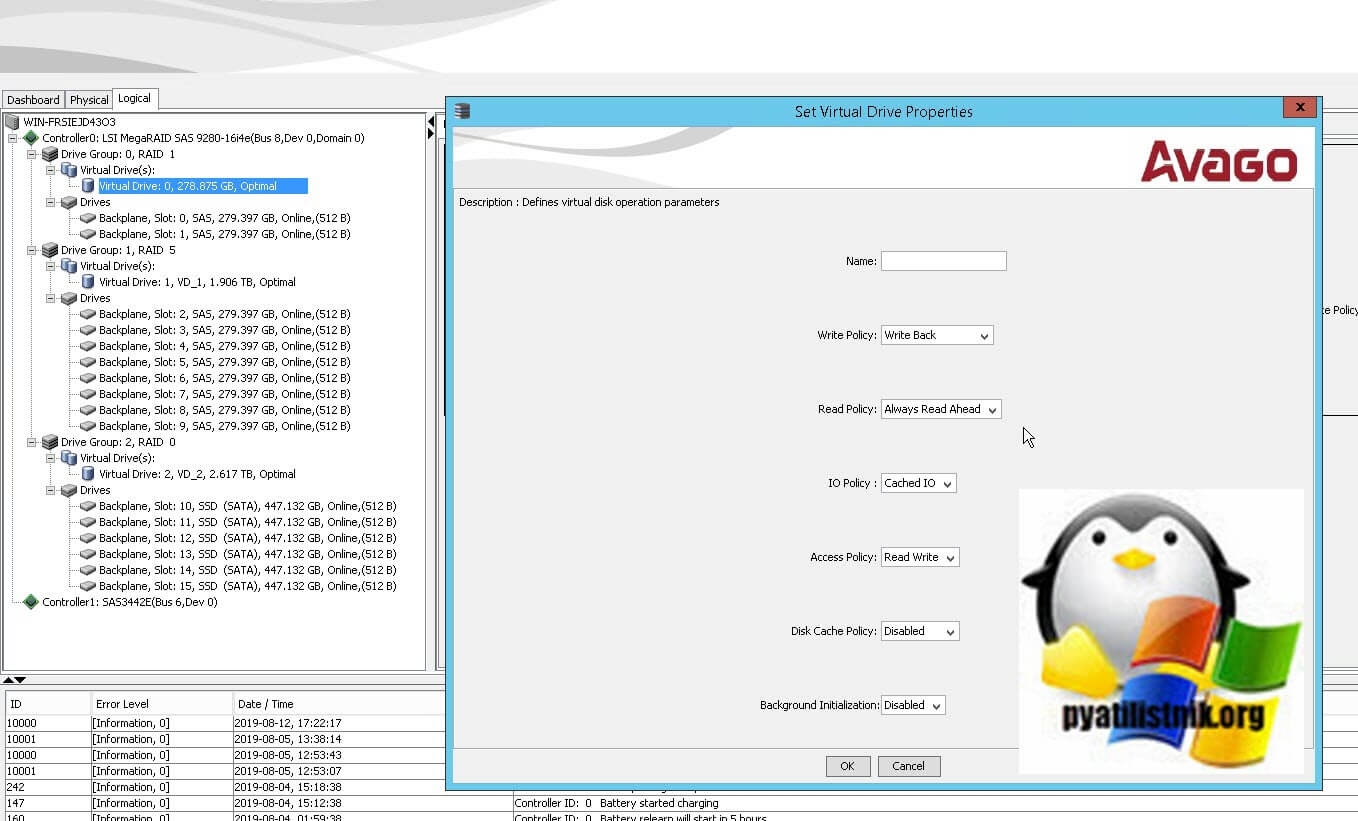

Вкладка "Logical" позволяет уже взаимодействовать с логическими сущностями. Например вы можете добавить HDD/SSD в существующий RAID массив. Вы легко можете изменить свойства любого Virtual Drive, изменить вид кэширования, включить или отключить инициализацию.

![Изменить метод кэширования на LSI контроллере]()

Методы создания различных видов RAID через MSM я подробно описывал. Чаще всего есть поддержка всех видов, но в некоторых контроллерах RAID 50 и 60 нужно разблокировать с помощью специального кода.

Утилита StorCLI

Инструмент StorCLI - это утилита командной строки, которая имеет больший функционал в отличии от графических аналогов LSA и MSM. Утилита очень простая и гораздо удобнее, по крайней мере с случае с Vmware ESXI, на которую порой установить MSM/LSA. это целая эпопея.

Разберем ситуацию, при которой нам нужно узнать состояние дискового RAID-массива, затем настроить мониторинг данного состояния сервером Zabbix. В качестве операционной системы, под управлением которой работает компьютер с LSI MegaRaid будем использовать Linux.

Установка megacli

Смотреть состояние массива RAID будем с помощью фирменной утилиты megacli.

Для начала, проверим, что на сервере используется контроллер LSI MegaRaid:

lspci -nn | grep -i lsi

02:00.0 RAID bus controller [0104]: LSI Logic / Symbios Logic MegaRAID SAS 2108 [Liberator] [1000:0079] (rev 05)

Разберем процесс установка утилиты на Linux CentOS и Ubuntu.

CentOS

Устанавливаем пакеты для распаковки архивов и загрузки файлов:

yum install unzip wget

Переходим по ссылке download.hetzner.de/tools/LSI/tools/MegaCLI — логин hetzner и пароль download. В открывшемся окне копируем ссылку на нужную версию утилиты, например:

![Копируем ссылку на утилиту для Linux]()

С помощью ссылки скачиваем утилиту на компьютер, на котором будет мониторить состояние контроллера:

* в данном примере мы загружаем MegaCLI версии 8.07.10 для Linux. Для прохождения авторизации используем логин и пароль hetzner/download.

* если система вернет ошибку при выполнении команды, устанавливаем wget командой yum install wget.Распаковываем скачанный архив:

rpm -i 8.07.10_MegaCLI_Linux/Linux\ MegaCLI\ 8.07.10/MegaCli-8.07.10-1.noarch.rpm

* напомню, в данном примере устанавливаем версию 8.07.10.

Создаем ссылку на бинарник:

ln -s /opt/MegaRAID/MegaCli/MegaCli64 /usr/bin/megacli

Проверяем, что утилита работает:

Мы должны получить версию установленного пакета.

Ubuntu

Открываем настройки репозитория:

В самый низ добавляем:

* где xenial — выпуск Ubuntu (можно посмотреть командой lsb_release -a).

Обновляем список пакетов:

И устанавливаем megacli:

apt-get install megacli

Проверяем, что утилита работает:

Мы должны получить версию установленного пакета.

Использование megacli

Для работы нам могут быть полезны следующие команды.

1. Посмотреть модели контролера и версию прошивки:

Product Name : RAID Ctrl SAS 6G 5/6 512MB (D2616)

Serial No :

FW Package Build : 12.12.0-01742. Состояние дисков:

megacli -PDList -Aall

* в данном примере отображено состояние для одного диска. Нам могут быть полезны параметры Firmware state — показывает состояние диска; Drive has flagged a S.M.A.R.T alert — состояние SMART.

Скрипты для получения состояния дисков

В нашем примере мы напишем очень простой скрипт, который будет находить неправильное состояние диска. Если хотя бы один из носителей имеет тревоги по SMART или ошибки в состоянии, скрипт будет возвращать 1. Если проблем нет — 0. Сам скрипт будет написан на bash.

У меня не получилось сделать так, чтобы команда megacli нормально отрабатывала при запуске от zabbix агента, поэтому сам скрипт будет выполняться по крону и результат записывать в отдельный файл, который и будет читать агент заббикса.

Создаем каталог, в который поместим скрипт:

Создаем файл скрипта:

count_errors=`megacli -PDList -Aall | grep -e "S.M.A.R.T alert : Yes" -e "Firmware state: Fail" | wc -l`

if [ $count_errors -gt 0 ]

then

echo 1 > /scripts/scan_result

else

echo 0 > /scripts/scan_result

fi* это простой скрипт, который получает состояние всех дисков и проверяет, нет ли среди этих состояний тревог от SMART и состояния Failed — результат записывается в переменную count_errors в виде количества найденных проблем. Если значение данной переменной больше 0 (то есть, есть хотя бы одно состояние сбоя), скрипт записывает в файл /scripts/scan_result "1", иначе — "0".

Разрешаем запуск скрипта на выполнение:

chmod +x /scripts/raid_mon_cron.sh

Создадим задание в cron:

* в данном примере мы будем запускать наш скрипт по проверке состояние дисков каждые 5 минут.

Теперь создадим скрипт, который будет запускать zabbix-agent:

* обратите внимание, что скрипт создается в каталоге zabbix-агента. Если в нашей системе его нет, необходима установка — примеры установки для CentOS и Ubuntu.

* все, что делает скрипт — выводит содержимое файла /scripts/scan_result, в котором должно быть либо 0, либо 1.

Разрешаем запуск скрипта на выполнение и зададим владельца zabbix:

chmod 770 /etc/zabbix/zabbix_agentd.d/raid_mon.sh

chown zabbix:zabbix /etc/zabbix/zabbix_agentd.d/raid_mon.sh

Пробуем выполнить скрипты:

В зависимости от ситуации они вернут 0 или 1.

UserParameter для агента Zabbix

Запуск скрипта и передача результата его работы серверу мониторинга выполняется с помощью Zabbix-агента. Для этого необходимо настроить UserParameter.

Открываем настройки агента:

В самый низ добавляем строку:

* в данном случае, мы создаем в zabbix агенте пользовательский параметр с именем raid_mon — при его вызове будет запускаться скрипт /etc/zabbix/zabbix_agentd.d/raid_mon.sh, который мы ранее создали.

systemctl restart zabbix-agent

Если используется SELinux, отключаем его:

Проверяем работу параметра. Для этого с сервера zabbix выполняем команду:

zabbix_get -s 192.168.0.15 -k raid_mon

* в данном примере мы обращаемся к серверу 192.168.0.15 и запускаем пользовательский параметр raid_mon.

В итоге, мы должны получить такой же ответ, который получили, запустив скрипт локально с компьютера, на котором его создали.

Настройка сервера Zabbix

На сервере zabbix необходимо создать шаблон для сканирования дисков с триггером для получения данных от агента на сервере и в случае 1 выводить тревогу. После необходимо добавить данный шаблон для всех узлов, на которых необходим мониторинг дисков.

Создание шаблона

Открываем веб-панель управления Zabbix. Выполним ряд шагов для достижения цели.

1. Переходим в Настройка - Шаблоны:

![Переходим в настройки шаблонов]()

Справа сверху кликаем по Создать шаблон:

![Создаем новый шаблон]()

В открывшемся окне называем шаблон, например, Template Scan RAID - добавляем его в группы, например Linux Servers и Windows Servers (нам никто не мешает также сканировать диски на серверах Windows):

![Заполняем начальные данные для шаблона]()

Кликаем по Добавить. Будет создан шаблон.

2. В списке шаблонов находим свой и кликаем для его настройки:

![Находим созданный шаблон и кликаем по нему]()

Переходим в Группы элементов данных:

![Переходим на вкладку групп элементов данных]()

Кликаем по Создать группу элементов данных:

![Кликаем по создать группу элементов данных]()

Даем название для группы, например, RAID:

![Даем название для группы элементов данных]()

. и кликаем по Добавить. Группа элементов создана.

3. Переходим на вкладку Элементы данных и кликаем по Создать элементы данных:

![Создаем элемент данных]()

В открывшемся окне даем название для элемента, например, RAID: Status Monitoring - прописываем ключ raid_mon (тот, что задали в UserParameter) - ставим интервал обновления в 5 минут (так как в кроне мы сканируем состояние каждые 5 минут, проверять чаще нет смысла) - выбираем созданную ранее группу элементов данных (RAID):

![Задаем настройки для элемента данных]()

. и кликаем по Добавить. Элемент данных добавлен.

4. Создаем триггер — для этого переходим на вкладку Триггеры - кликаем по Создать триггер:

![Создаем тригер]()

Даем название для триггера, например, RAID: Status Error - меняем значение для важности, например, на Высокая - задаем выражение =1 (триггер должен реагировать на значение равное 1):

![Параметры для создаваемого тригера]()

Нажимаем Добавить.

Шаблон готов и настроен.

Применение шаблона

Теперь можно применить наш шаблон к узлу. Переходим в Настройка - Узлы сети - выбираем узел, на котором создан скрипт для мониторинга дисков - переходим на вкладку Шаблоны и добавляем созданный нами шаблон:

![Присоединение шаблона к узлу]()

Нажимаем Обновить.

Мониторинг состояния дисков настроен. При возникновении критического состояния мы увидим проблему «RAID: Status Error».

Можно использовать MegaRAID Storage Manager™, но чтобы его поставить….

Проще использовать консольную утилиту MegaCli

Загрузиться с RIPLinuX и подключиться по SSH

Получить статус и конфигурацию всех адаптеров

Cтатус и параметры всех логических дисков

Статус и параметры физических устройств

Статус и параметры диска в 4-м слоте

Создание RAID6 массив MegaCLI

Давайте предположим, что у нас есть сервер с MegaRAID SAS

Получим список физических дисков:

Пример конфигурирования JBOD на LSI 2208 (Supermicro X9DRH-7TF)

При загрузке BIOS эти команды можно выполнить если зайти в preboot CLI по комбинации клавиш Ctrl+Y

Команды megacli и preboot CLI различаются по виду.

Например команда проверки поддержки JBOD для BIOS preboot CLI будет выглядеть так:

А для megacli это используется как набор опций и параметров:

Включить поддержку JBOB

Список доступных физических устройств:

В списке надо найти значения полей Enclosure Device ID (например 252), Slot Number и Firmware state

Нужно отметить каждое из устройств которое надо сделать JBOD, как Good в поле Firmware state .

Или сразу много устройств:

Теперь можно создавать JBOD

Создать виртуальный диск RAID

Перед настройкой массива, возможно, потребуется удалить использованную ранее конфигурацию. Для того чтобы просто удалить логические устройства используйте CfgLdDel

Для того чтобы удалить всё (в том числе политику кэша) используйте «Очистку конфигурации»

Настройка RAID-0, 1 или 5. Вместо «r0» введите соответственно «r1» или «r5» (диски находятся в Enclosure 29, на портах 0 и 1, WriteBack включен, ReadCache адаптивный, Cache также включен без BBU)

Создать RAID10

Получить список дисков

![]()

Создать массив из 6 дисков

Показать как диски были определены в RAID-массиве:

Удалить массив с >

Инициализация массива

Начать полную инициализацию для массива с >

Проверить текущий статус инициализации:

Управление CacheCade

Создать и назначить CacheCade для массива 0 (-L0) из зеркала (-r1) в режиме обратной записи (WB) на основе SSD дисков в слотах 6 и 7 (-Physdrv[252:6,252:7])

Замена неисправного диска

Обратите внимание, что это не навсегда отключает сигнализацию, а просто выключает сигнал по текущей аварии.

Просмотреть состояние диска (подставьте нужное значение [E:S]):

Пометить диск требующий замены как потерянный (если контроллер не сделал этого сам)

Получить параметры потерянного диска

Вы должны получить ответ подобный этому:

Подсветить диск который надо менять (подставьте нужное значение [E:S]):

На некоторых шасси могут быть проблемы с индикацией. Это лечится такой командой:

В этом случае для маркировки диска будет использоваться лампочка активности.

Удаляем неисправный и вставляем новый диск.

Прекращаем подсветку и проверяем состояние диска:

Может так случится, что он содержит метаданные от другого массива RAID (Foreign Configuration). Ваш контроллер не позволит использовать такой диск. Для проверки наличия Foreign Configuration

Команда удаления Foreign Configuration (если вы уверены)

Запускаем процесс замены

[32:4] - это параметры диска которым вы меняете неисправныйПроверка процесса ребилда

Использование smartctl

Получить список id

Получить данные смарт по диску с >

для диска с интерфейсом sata

пример срипта для получения данных о всех дисках

Для контроля состояния дисков с помощью демона smartd нужно закомментировать DEVICESCAN в /etc/smartd.conf и добавить:

Значения параметров типа /3/02 - /3/05 определяют время запуска тестов для заданного диска

Читайте также: