Nic teaming в windows server 2008 r2 настройка

Обновлено: 04.07.2024

Есть сервер с двумя встроенными сетевыми картами INTEL. Оба гигабитные. ОС - MS Windows Server 2008 R2. Есть ли возможность объединить обе карты и вставить их в один коммутатор, имея только один IP адрес? Может быть, мост решит мою задачу?

TeranT (31.01.2011 - 14:33) писал:

Есть сервер с двумя встроенными сетевыми картами INTEL. Оба гигабитные. ОС - MS Windows Server 2008 R2. Есть ли возможность объединить обе карты и вставить их в один коммутатор, имея только один IP адрес? Может быть, мост решит мою задачу?В настройках драйвера выставляется режим работы сетевух. У интелов - вкладка Teaming.

Точнее - в диспетчере задач - в свойствах сетевух.

Хм, спасибо большое, не думал, что это всё именно так.

А теперь, насколько я понимаю, я должен тут настроить в коммутаторе, какой порт должен быть активным, а какой пассивным?

Или я сначала создаю группу агрегации тут:

Ну и тут, как я понимаю, настройки интела:

По Intel`у - не то крутите. Похоже у вас не весь секс-набор от intel стоит, скачайте драйвер с сайта.

diz (31.01.2011 - 15:50) писал:

По Intel`у - не то крутите. Похоже у вас не весь секс-набор от intel стоит, скачайте драйвер с сайта.

Dimsoft (31.01.2011 - 15:54) писал:

какие карты intel в сервере ? (некоторые под windows не объединяются - маркетинг)Системная плата Intel S5000PAL с сетевыми Intel® 82563EB Gigabit Ethernet PHY

Так-то там такие интересные фишки оказывается есть - Adapter Fault Tolerance, Adaptive Load Balancing, Static Link Aggregation и IEEE 802.3ad Dynamic Link Aggregation. Знал бы, что такие штуки есть - настроил бы раньше по-другому, например резервный шнурок в другой коммутатор.

А, как я понимаю, ине сейчас надо указать IEEE 802.3ad Dynamic Link Aggregation, так как он использует LACP. А может, коммутатор и не надо настраивать? Всё само настроится?

добавлено 31.01.2011 в 16:48:59

Dimsoft (31.01.2011 - 16:26) писал:

с windows 2008R2 и intel есть секрет - во встроенных драйверах на старые сетевые нет тиминга - надо использовать драйвера от windows 2008 x64 скаченные с сайта intel тогда все будетАга, как тут и скачал уже: с сайта Intel

gdv1969, спасибо, уже читаю. Действительно - то, что нужно

Если вы читаете эту статью, значит хаба «Антикварное железо» у нас до сих пор еще нет.

У старого железа HP есть только один недостаток: оно работает, работает и всё никак не может сломаться. Но в HP тоже не дураки сидят и делают всё, чтобы стимулировать обновление серверного хозяйства – драйвера под новые ОС не разрабатываются, доработка фирмварей прекращается, так что приходится загонять себя пинками в рай и волей-неволей, но приходится обновляться.

Но у нас тоже есть свой интерес. Использовать старое оборудование, на тех задачах, которые ему по плечу – это наша первейшая обязанность, тем более, что есть свободные лицензии Windows 2008 R2. Попытаемся натянуть сову по имени Windows 2008 R2 на наш старый глобус DL360 G4p (P54).

Следствие ведут колобки

В списках поддерживаемых систем на странице сервера DL360G4, ОС Windows 2008 R2 уже не значится.

Т.е. BIOS для G4p (P54) (sp30408.exe), поддерживающий инсталляцию W2K8, существует, но находится «под замком» и доступен только при наличии контракта на сопровождение.

Перед началом работ следует:

1.Пройтись по серверу последним доступным для этой модели Firmware CD или подсунуть его пред тёмны очи HP Smart Update Manager и поднять последнему веки.

2.Купить контракт на сопровождение системы и законным образом получить свежую версию BIOS для G4p, скачать и поставить BIOS 2007.07.16A.

3.Проапгрейдить iLO2 до версии 1.92.

Таинственные артефакты и особая древняя магия

Если у вас сервер оснащён дисководом FDD, то перед тем как совать в него дискеты, привод надо снять и продуть сжатым воздухом от пыли. Конструкция сервера такова, что через дисковод и CD-привод вентиляторами прокачивается большой объем воздуха и вся пыль оседает внутри устройств. Если приводами пользовались крайне редко, то залежи пыли работают как хороший наждак.

Лучше разворачивать апдейты на USB-флешке, но при использовании штатных средств HP требуется флешка размером НЕ БОЛЕЕ 2ГБ!

Установку W2K8 делал мой коллега, и, с его слов, там проблем не возникло.

Скрещивание ужа с ежом или конь Тугеза

А вот с объединением адаптеров в команду (team) пришлось немного повозиться. Сервер оснащен двумя встроенными сетевыми адаптерами NC7782, собранными на чипе Broadcom BCM5704CFKB, которые интересно объединить в команду.

Традиционно team собирается при помощи HP NCU – Network Configuration Utility. NCU – это отдельный продукт, и его версия под W2k8 выложена на сайте HP и доступна к скачиванию без ограничений.

Что следует понимать как «ПО как-то инсталлировано, но как — не понятно и делать этого — точно не стоило».

А что у нас драйвера? А драйвера на сетевые карты у нас встали при инсталляции W2K8. Возникло предположение, что NCU требуются драйвера от HP.

А где взять драйвера, с учетом того, что формально их под 2008 R2 для G4p больше не делают? «Да, вот же они! Положила» не беда, что они под Windows 2003 x64.

cp006193.exe

Конечно, по традиционной схеме они не встанут. cp006193.EXE при запуске рапортует, что «гранаты у нас не той системы», и работать они тут не могут, потому что не хотят.

Но вручную ставятся. cp006193.EXE – самораспаковывающийся архив, который нормально разворачивается при помощи Winrar. Разложим его в отдельный каталог и дальше «Система / Диспетчер устройств / Сетевые карты / Драйвер / Обновить… / Установить вручную/ показываем на каталог. Драйвер меняется на лету, даже терминальная сессия не прерывается. «2003 x64 на 2008 R2»

Но и это не помогло, NCU не увидело свои собственные драйверы. Возможно, помогло бы занижение версии NCU, но было решено попробовать другое решение.

А что там у .

Другие изготовители серверов, в частности Dell и Fujitsu для объединения в team используют ПО, разработанное Broadcom, под названием BACS (Broadcom Advanced Control Suite). На настоящий момент доступна версия 4.

У HP она тоже есть. cp022114.exe

Но HP его использование видит несколько по другому – организация таргетов iSCSI и FCOE, на требуемых нам платформах. BACS для HP на G4 отказался запускаться, «Нету,- говорит –у вас для меня нужного железа». Да и не очень-то и хотелось.

Где BACS4 скачивается с сайта Broadcom я так и не нашел, ссылка на management applications ведет на страницу 404. Broadcom пишет, что пакет поставляется на CD вместе с сетевыми картами вендоров. Весь пакет выложен на сайте Fujitsu:

Или можно поискать по интернету файл FTS_BroadcomAdvancedControlSuite4BACS_14831_1064191.zip.

2011 год, но работает.

Приступаем к установке BACS4.

«HP – не HP, Абонент – не абонент»

— такими глупостями BACS4 не занимается. Ему всё равно: «Fujitsu — не Fujitsu»

Дальше всё просто «Команды / Создать». Называем Team1. Добавляем оба доступных адаптера. (Физически в момент сборки тима, во избежание проблем, к сети подключен только один кабель. После сборки тима подключаете второй кабель и всё работает как обычно)

Если драйверы ему не понравятся, BACS4 про это скажет. На HP драйверы он выругался и сказал: «Хочу NDIS6, NDIS5 – не хочу!»

На сайте Broadcom взяли свежие драйвера под BCM5704 ( Версия 17.2.0.2 от 03.07.2015 ) и поставили их на G4.

Так выглядит интерфейс BACS4

Сервер подсоединен к HP Procurve 2910, так что при установке надо указывать 802.3 ad, другой протокол портов Procurve не понимают (со стороны коммутатора на портах собран LACP).

Всё Работает, полет нормальный.

Про NIC teaming, White paper от HP. Полезное чтение.

Предположим, что вы слышали о NIC teaming (NIC: сетевой адаптер) или NIC bonding от разных поставщиков. Они связали несколько физических NICs в виртуальный NIC, который внешне предоставил видимый MAC-адрес. Их конечная цель одна и та же - для более высокой производительности и лучшей избыточности. В этом руководстве будет рассказано о Windows NIC Teaming & Linux NIC Bonding, которые имеют балансировку нагрузки и отказоустойчивость.

Близко к NIC Teaming в ОС Windows

Что такое Windows NIC Teaming?

NIC teaming, также известное в мире Microsoft как Load Balancing/Failover (LBFO), представляет собой механизм, который позволяет объединить несколько карт физических сетевых адаптеров на одном физическом хосте/сервере и объединить их в команду в форме единый логический NIC. Сетевые адаптеры, подключенные к операционной системе Windows, отображаются в виде одного или нескольких виртуальных адаптеров (также называемых групповым NICs, tNICs или групповым интерфейсом), которые имеют один и тот же IP-адрес.

Сколько режимов Windows NIC Teaming?

На рынке представлено разные сетевые адаптеры, и Intel NIC является наиболее распространенным среди основных решений. Intel NIC можно разделить на несколько режимов teaming:

Adapter Fault Tolerance (AFT) обеспечивает автоматическое резервирование для сетевых подключений сервера. Если основной адаптер выходит из строя, резервный адаптер вступает во владение.

Требования и ограничения: подходит для любого коммутатора, все члены команды должны быть подключены к одной подсети. 2-8 сетевых адаптеров на группу.

Switch Fault Tolerance (SFT) обеспечивает аварийное переключение между двумя платами сетевого адаптера, когда каждый адаптер подключен к отдельному коммутатору.

Требования и ограничения: используйте с отдельными коммутаторами, все члены команды должны быть подключены к одной подсети. Вам необходимо включить протокол Spanning Tree Protocol (STP) при создании группы SFT. 2 сетевых адаптера на команду.

Adaptive Load Balancing (ALB) обеспечивает балансировку нагрузки и отказоустойчивость адаптера. Receive Load Balancing (RLB) может быть включена и отключена в группе ALB, которая включена по умолчанию.

Требования и ограничения: работает с любыми коммутаторами.

Virtual Machine Load Balancing (VMLB) обеспечивает балансировку нагрузки при передаче и приеме трафика между виртуальными машинами (виртуальными машинами), связанными через командные интерфейсы, и отказоустойчивость в случае сбоя порта коммутатора, кабеля или сетевой карты.

Требования и ограничения: работает с любыми коммутаторами.

Fast EtherChannel/Link Aggregation (FEC) обеспечивает отказоустойчивость адаптеров балансировки нагрузки (только для протоколов маршрутизации) и помогает увеличить пропускную способность передачи и приема.

Требования и ограничения: требуются коммутаторы агрегация ссылок с возможностями FEC. 2-8 сетевых адаптеров на группу.

Gigabit EtherChannel/Link Aggregation (GEC) это гигабитное расширение FEC/Агрегации линии связи/802.3ad.

Требования и ограничения: все члены команды должны работать на гигабитной скорости.

Static Link Aggregation (SLA) заменила двух предшественников FEC и GEC.

Требования и ограничения: все сетевые адаптеры в статическом режиме должны работать с одинаковой скоростью и подключаться к коммутаторам со статическим агрегированием каналов. Если скорость сетевой карты изменится, скорость команды будет зависеть от наименьшего общего знаменателя. 2-8 сетевых адаптеров на группу.

Dynamic Link Aggregation (IEEE 802.3ad) создает одну или несколько групп, используя динамическое агрегирование каналов с сетевыми адаптерами смешанной скорости, чтобы обеспечить отказоустойчивость и улучшить пропускную способность при передаче и приеме.

Требования и ограничения: требуется коммутатор, который полностью поддерживает стандарт IEEE 802.3ad.

Multi-vendor Teaming (MVT) позволяет сетевым адаптерам разных производителей работать в команде.

Близко к NIC Bonding в Linux OS

Что такое Linux NIC Bonding?

В Linux OS объединение сетевых карт относится к процессу объединения нескольких сетевых интерфейсов в логический интерфейс привязки. То есть объедините и подключите две или более сетевых карт как одну. Обратите внимание, что одним из предварительных условий для настройки соединения является наличие сетевого коммутатора, который поддерживает EtherChannel (это верно почти для всех коммутаторов).

Сколько режимов Linux NIC Bonding?

Поведение связанного NICs зависит от типа используемого режима соединения. В общем, шаблоны могут обеспечивать отказоустойчивость и/или услуги балансировки нагрузки. В следующей таблице приведено подробное описание этих семи режимов.

| Режим | Политика | Fault Tolerance | Load Balancing | Особенности и Описани |

|---|---|---|---|---|

| mode=0 (balance-rr) | Round-robin | Y | Y | Режим по умолчанию. пакеты передаются/принимаются последовательно от первого доступного ведомого до последнего. |

| mode=1 (active-backup) | Active-backup | Y | N | ТОЛЬКО один раб активен, а другой спит. Этот резервный NIC будет действовать в случае сбоя активного NIC. При условии, что имеется N*интерфейсов, коэффициент использования ресурсов будет 1/N. |

| mode=2 (balance-xor) | XOR (Exclusive OR) | Y | Y | Передает на основе формулы XOR. Как только соединение между NIC и соответствующим устройством установлено, тот же NIC будет использоваться для передачи/приема для MAC-адреса назначения, чтобы гарантировать, что MAC-адрес остается тем же. |

| mode=3 (broadcast) | Broadcast | Y | N | Все пакеты отправляются на все подчиненные интерфейсы за счет использования ресурсов. Обычно используется для определенных целей, например, в финансовой отрасли, где требуется сверхнадежная сеть. |

| mode=4 (802.3ad) | IEEE 802.3ad Dynamic Link Aggregation | Y | Y | Создайте группы агрегации с одинаковыми настройками скорости и дуплекса. Требуется коммутатор, который поддерживает динамическое агрегирование каналов IEEE 802.3ad. |

| mode=5 (balance-tlb) | Adaptive Transmit Load Balancing (TLB) | Y | Y | Исходящий трафик распределяется в соответствии с текущей нагрузкой на каждом подчиненном интерфейсе, и входящий трафик принимается текущим ведомым. Не требует никакой специальной поддержки коммутатора. |

| mode=6 (balance-alb) | Adaptive Load Balancing (ALB) | Y | Y | Добавьте функцию балансировки нагрузки на прием по сравнению с предыдущим режимом = 5. И балансировка нагрузки приема достигается посредством согласования ARP (Address Resolution Protocol). Не требует никакой специальной поддержки коммутатора. |

| Внимание: 1. Один интерфейс bonding может указывать только один режим. 2. mode=0, mode=2, and mode=3 теоретически требует статической агрегации. 3. mode=4 нужно поддерживать 802.3ad. 4. mode=1, mode=5, and mode=6 не требуют никаких настроек на коммутаторе. 5. Выбор режима зависит от топологии сети, требований к поведению соединения и характеристик подчиненных устройств. Вообще говоря, для топологий с одним коммутатором используются следующие режимы: mode=0 (balance-rr); mode=2 (balance-xor); mode=4 (802.3ad); mode=5 (balance-tlb); mode=6 (balance-alb). And the left two modes—mode=1 (active-backup) & mode=3 (broadcast) применяются для топологии с несколькими коммутаторами. | ||||

Улучшит ли NIC teaming or bonding пропускную способность соединения между сервером и коммутатором?

Многие могут подумать, что агрегация ссылок увеличит пропускную способность. Например, каждый из трех NICs работает на скорости 1 Гбит/с, а NIC команда указывает скорость 3 Гбит/с. Означает ли это увеличение скорости в два раза? Нет. Как мы все знаем, обычно используется Ethernet 1 Гбит/с и 10 Гбит/с. Но нет определенного стандарта 3 Гбит/с. Итак, как мы реализуем 3 Гбит/с ссылки? Правда в том, что у нас на самом деле нет связи 3 Гбит/с. Вместо этого у нас есть три отдельные ссылки 1 Гбит/с.

Что еще более важно, рекомендуется учитывать агрегацию ссылок на основе отказоустойчивости сетевых каналов, а не общей доступной пропускной способности. Например, при передаче файлов с одного компьютера на другой по суммарной ссылке 2 Гбит/с общая максимальная скорость передачи может составлять только 1 Гбит/с. Однако при передаче двух файлов преимущества совокупной пропускной способности показаны. То есть агрегация ссылок увеличивает количество каналов, а не ограничения скорости.

Что принесет NIC teaming / NIC bonding пользователям?

Короче говоря, ответ - балансировка нагрузки и отказоустойчивость.

Fault tolerance—если один из базовых физических NICs отключает или отсоединяет свой кабель, хост/сервер обнаружит сбой и автоматически переместит трафик на другой NIC в соединении, что исключает ситуацию полного разрыва сетевого подключения одним точка отказа.

Рисунок 1: Load balancing & fault tolerance

Используя преимущества балансировки нагрузки и отказоустойчивости, члены команды NIC будут работать вместе, чтобы оптимизировать пропускную способность и предотвратить потерю соединения в случае сбоя сетевого адаптера.

Увеличение пропускной способности — увеличение полосы пропускания пропорционально количеству адаптеров в группе. К примеру, если объединить в NIC Teaming два сетевых адаптера со скоростью 1 Гбит/с, то общая полоса пропускания составит 2 Гбит/с;

Отказоустойчивость — при выходе из строя одного из адаптеров в группе, связь ни на секунду не прерывается и остальные сетевые адаптеры поменяют вышедший из строя.

Технология NIC Teaming не нова, но ранняя ее реализация зависела от производителей сетевого оборудования. Возможность объединять сетевые адаптеры в группу средствами ОС появилась только в редакции начиная с Windows Server 2012. Эта технология позволяет объединять в группу адаптеры разных производителей, единственное ограничение — все они должны работать на одной скорости. Ограничение по количеству объединяемых сетевых адаптеров в NIC Teaming равна 32.

Настройка

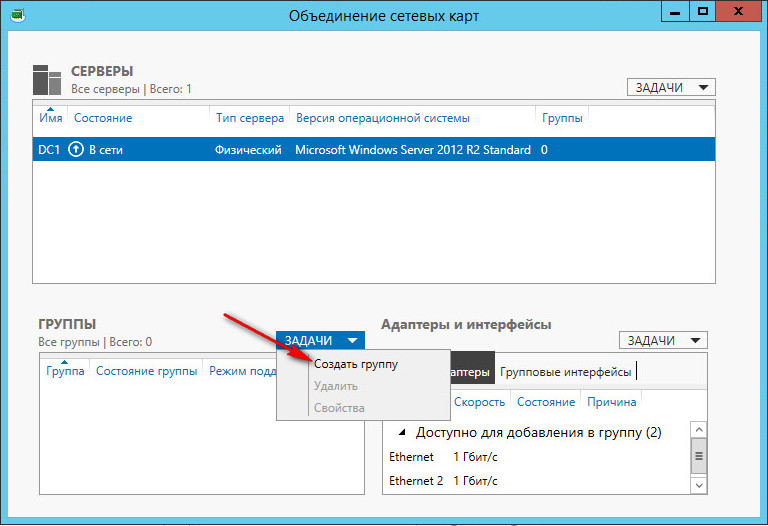

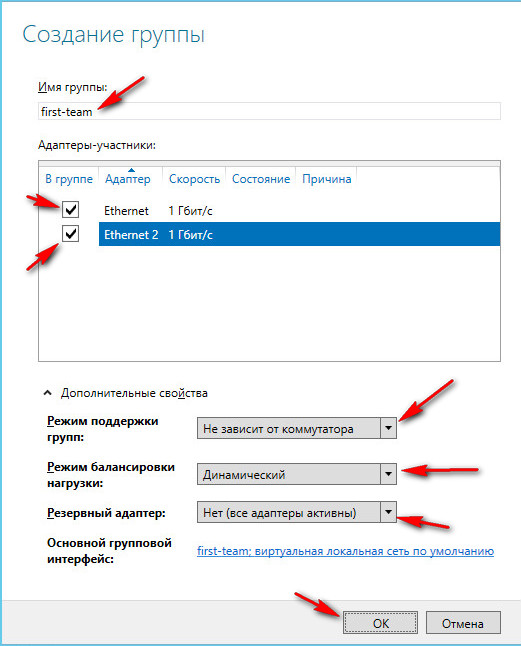

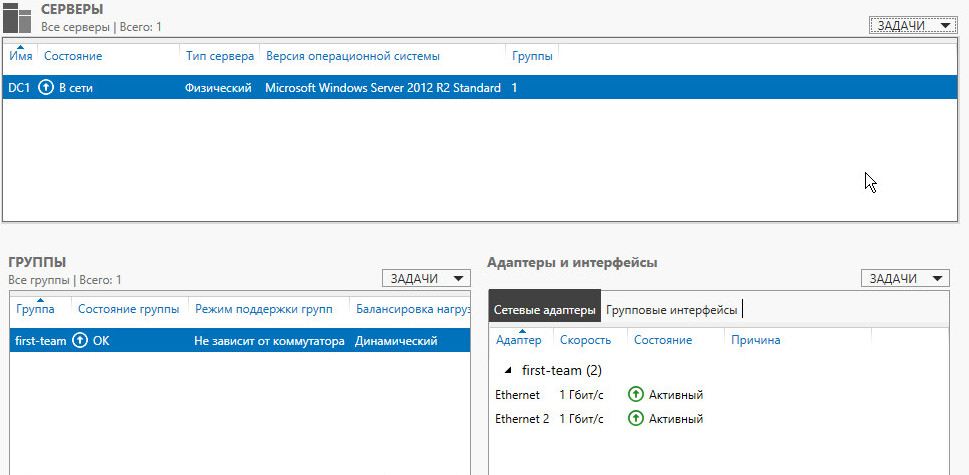

В Задачах (Tasks) выбираем пункт Создать группу (New Team).

Режим поддержки групп (Teaming mode) определяет режим взаимодействия группы с сетевым оборудованием:

Режим балансировки нагрузки (Load Balancing mode) определяет, каким образом распределять сетевой трафик между адаптерами группы:

1. Хэш адреса (Address Hash) — при передаче сетевого трафика на основании MAC или IP-адресов отправителя и получателя вычисляется хеш (некое число). Это число привязывается к определенному физическому адаптеру и в дальнейшем весь трафик от этого отправителя будет идти через этот адаптер;

2. Порт Hyper-V (Hyper-V Port) — в этом режиме осуществляется привязка адаптера teaming группы к определенному порту виртуального свича в Hyper-V. Этот режим используется в том случае, если на сервере активирована роль Hyper-V.

Резервный адаптер (Standby adapter) позволяет назначить один из адаптеров группы в качестве резервного. В нормальном состоянии резервный адаптер не используется для передачи трафика, но при выходе любого адаптера группы из строя сразу занимает его место и трафик продолжает передаваться без перерывов. Но даже без резервирования выход из строя одного адаптера в NIC Teaming не приведет к прерыванию сетевого соединения, потому что, нагрузка будет автоматически распределена по оставшимся адаптерам.

New-NetLbfoTeam -Name First-team -TeamMembers ″Ethernet″,″Ethernet 2″ ` -TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

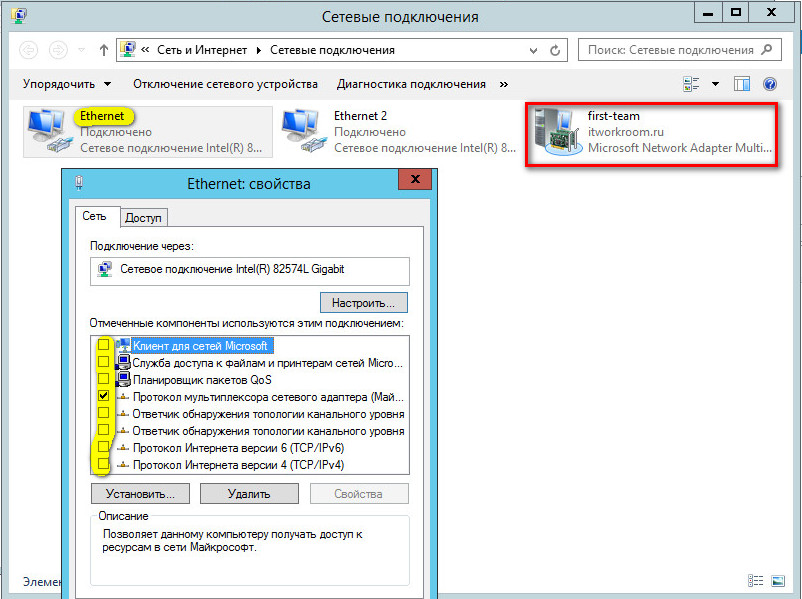

После создания группы, в окне «Сетевые подключения» появиться еще один сетевой адаптер, который как раз и является виртуальным адаптером созданной группы, при этом если посмотреть свойства физического сетевого адаптера, то мы увидим, что все компоненты кроме протокола мультиплексора сетевого адаптера отключены (выделено желтым).

Удалить группу можно также командой power shell: Remove-NetLbfoTeam -Name First-team или в графическом интерфейсе:

Читайте также: