Proxmox аналог для centos

Обновлено: 04.07.2024

Всем привет, есть машина с Proxmox. Доступ есть только на нее удаленный. К порту eno2 подключен mikrotik. Новый, не сконфигурированный. Хочу к нему подключиться из виртуалки с windows и сконфигурировать.

Пробовал настраивать сеть по разному, но winbox из виртуалки с windows, не видит Mikrotik. И не подключается по MAC. Firewall отключен. В виртуалку с windows заведены vmbr1, vmbr2, vmbr3.

загнать трафик в виртуальную машину - два провайдера, два разных шлюза 2.1/24 и 3.1/24

отфильтровать и вернуть обратно в два других сетевых интерфейса и другим виртуальным машинам на этой же ноде

есть сетевые карты 350-t2 x 2

в два порта приходит трафик, из двух портов уходит отфильтрованный дальше другим физическим серверам через коммутатор

объёдинение двух физических интерфейсов в бридж, но у нас же два гетвея?

Доброго времени суток.

- Есть proxmox 6, в нём виртуальные машины.

- Есть виртуальная машина с софт роутером (Opensense 21.7)

- И виртуальная машина с Suricata в режиме IPS

Требуется завернуть весь трафик в opsense, пропустить через виртуальную машину с IPS, и вернуть обратно виртуальным машинам на этой же ноде, но уже с двумя линками:

- первый линк обёрнут в tor (настраиваем на opnsense)

- второй линк прозрачный

- Есть proxmox 6, в нём виртуальные машины.

- Виртуальная машина с Suricata в режиме IPS

- Два провайдера, два изолированных сегмента сети, два шлюза

Требуется завернуть весь трафик в Suricata, вернуть обратно виртуальным машинам на этой же ноде и в два сетевых интерфейса (физических)

3. генту и драйвера нвидиа

- есть встройка с интелом 11го поколения

- есть видеокарта 30хх nvidia

- сам ноутбук с генту

Нужно заставить работать офф драйвера nvidia

4. Требуется консультация по ZFS и выбору оборудования исходя из задачи79206178067

- Удалённо через anydesk

- Оплата на карту любого банка

- Ценник предложите сами

- По срокам чем быстрее, тем лучше

- Если всё ок, то будут ещё задачи

- Связь удобно - почта/телеграм, контакты оставьте, пожалуйста, тут

Решено! Проблема решалась очень просто: в raid bios console во вкладке virtual drives надо выбрать нужный виртуальный диск и поставить галочку set boot drive)

Поставлена задача собрать кластер из двух нод и хранилища, возможности подключить по FС хранилища нет. По этому пытаюсь через ISCSI.Райд поднят на CXD, target знаю , ip знаю. делаю след Датацентр - Хранилище. Кликаем Добавить и выбираем тип (в нашем случае, iSCSI): после введения данных выходит ошибка

(unexpected property ‘prune-backups’ (500)

везде на форумах пишут что связано с заблокированной VM при неудачной миграции или репликации(когда то попробовал создать). Но VM и ее ID удалена.

нашел еще способ подключить ее через /etc/pve/storage.cfg ,опять же прописал все свое, она отобразилась и можно создать VM уже в хранилище СXD.

В целом вопроса два 1.Куда можно еще капнуть по этому проблеме (unexpected property ‘prune-backups’ (500) 2.На сколько правильно я второй способ задействовал. так как я только осваиваю эту стихию, палками прошу не кидаться, спасибо)

Уже давно валяется в шкафу ноутбук с не рабочим монитором. Хотел бы сделать из него небольшой домашний сервачек. Подключил к нему моник через VGA но когда пытаюсь установить Proxmox VE 7.0 он пытается расширить изображениен установщика на 2 дисплея и в итоге весь установочный диалог отображается на разбитом экране ноута, а на мониторе пустота. Гарячая клавиша Fn+F8 не работает. Попробовал вырубить физически экран внутри ноута, так же безрезультатно. Подскажите пожалуйста в какую сторону копать. Как сделать так чтоб он дублировал экраны а не расширял их? Ноутбук ASUS UL80V видео nVidia GeForce G210M.

Кластер Proxmox 7.0-11 состоял из трех нод.

Добавил в него еще одну. Всё вроде хорошо, кластер работает, но лог последней добавленной ноды забивается ошибкой:

В логах остальных нод всё нормально. Да и вообще не вижу никаких косяков. Миграция работает.pvecm status и pvecm nodes показывают, что всё хорошо

corosync.conf на всех нодах однинаковый

authkey пробывал копировать с другой ноды на последнюю и перезапускать службы, никакого эффекта.

Изучаю Proxmox VE, версия 6.4-4. Пытаюсь использовать LVM через iSCSI. В качестве хранилища использую физический сервер с контроллером Avago MegaRAID SAS 9361-8i 2GB, ОС Debian 10, собрано три массива RAID-1 из шести SAS дисков по 6TB под LVM плюс RAID-1 200GB под систему, итого 4 диска /dev/sd , установлен пакет tgt.

Target 1: iqn.2021-09.loc.truba:omv1.volume1

I_T nexus information:

В Proxmox всё делаю через web-gui, подключаю target, подключаю через него LVM раздел, всё прекрасно работает, перезагружаю proxmox и хранилище tgt, проверяю – всё работает. Проблема начинается тогда, когда в LVM раздел переносится диск виртуальной машины из local-zfs, либо когда машина сразу устанавливается в раздел LVM. В этом случае связка работает только если не перезагружать хранилище. Иначе после перезагрузки теряется LUN1, в proxmox LVM-iscsi отваливается со Status: unknown

PV VG Fmt Attr PSize PFree

/dev/sdb vgiscsi lvm2 a– <5,46t 5,26t

/dev/sdc vgiscsi lvm2 a– <5,46t <5,46t

/dev/sdd vgiscsi lvm2 a– <5,46t <5,46t

/dev/vgiscsi/volume1 VG1 lvm2 a– <200,00g <184,00g

VG1 * 1 * 1 * 0 * wz–n- * <200,00g * <184,00g

vgiscsi * 3 * 1 * 0 * wz–n- * 16,37t * <16,18t

LV * VG * Attr * LSize

vm-100-disk-0 * VG1 * -wi-a—– * 16,00g

volume1 * vgiscsi * -wi-ao—- * 200,00g

Что-то делаю не так. ?

Здравствуйте. Подскажите, возможно как то сделать эмулятор usb устройства. Установил v4l2loopback и вещаю картинку в /dev/video0. Возможно как то с эмулировать /dev/video0 как USB устройство, чтоб его прокинуть в виртуальную машину?

Довольно интересная штука, этот Proxmox.

С решением знаком совсем мало времени, отсюда довольно банальные вопросы;

Предположим имеется несколько нод в кластере, общего хранилища нет, только локальные. Необходима живая миграция. Оно работает из коробки, или нужны танцы с бубном? Рекомендации?

офтоп: Есть подозрение, что я просто обленился, или перегорел, и стоило бы отдохнуть… Голова совсем не варит.:(

Сервер под базу данных, соответственно было собрано несколько массивов, критично чтение! Ниже пойдет речь о 10 рейде 8х8 В гостевой ОС (Windows Server 2019), синтетические тесты показывают потерю производительности примерно на 40% (170т против 100т iops). Тесты к сравнению проводились на той-же Windows server 2019, но уже не в роли гостевой системы. Если отдать полностью весь ресурс сервера под гостевую ОС, то это не решает проблему. В конфиге строчка подключения диска, имеет следующий вид: scsi1: /dev/sdc,backup=0,cache=none,size=7316584,ssd=1 virtio, работает медленней. Драйвера virtio под «изобретение Miscrosoft» ставил последние.

5 рейд и 1 работают также медленно, но они не так критичны.

Буду признателен, если дадите стоящий совет, и подскажите где и что я мог упустить.

Была система с аптаймом

500 дней, не перезагружалась, но обновления устанавливались. Перед запланированной перезагрузкой накатили обновление до 7-ки.

После перезагрузки сеть не поднялась. Конфигурация в interfaces:

Шлюз 1.2.3.129 не пингуется.

Если поднять сеть на самом интерфейсе, то всё работает -

До этого на машине иногда отваливалась сеть, что в итоге было решено с с помощью

Пробовал загружаться в ядра от 5.3 до 5.11 - везде бридж не работает.

Никаких ошибок нигде не вылезает Куда смотреть - уже ума не приложу, всё перепробовал.

На домашнем сервере Proxmox система стоит на двух SSD ZFS (RAID1), хранилище на четырех HDD ZFS(raidz1). Сервер разбирал отлкючал все диски, после собрал обратно, подключил все диски. Сейчас не видится массив ZFS(raidz1). Сами диски видны в системе. Можно как то вернуть обратно ZFS(raidz1)? root@pve:

после удаления файлов и тп, образ только увеличивается в размерах

proxmox 6.x, виртуальные машины kvm, как на hdd, так и на ssd с ubuntu/gentoo/debian

диски scsi, образа в qcow

есть мысль добавить опцию discard, а так же делать fstrim -av по крону в раз в неделю

ПыСы все данные на одном разделе

Доступ к гипервизору только через L2TP-туннель

На этом дедике крутится много разной ботвы.

Задача:поднять на нём еще одну виртуалку с белым статическим IP от провайдера и доступом в Сеть.

Вешаем на карту IP, gateway и остальное, что выдал провайдер создаём vmbr1 в него втыкаем нашу карту и готово.

Альтернативы для Proxmox Virtual Environment

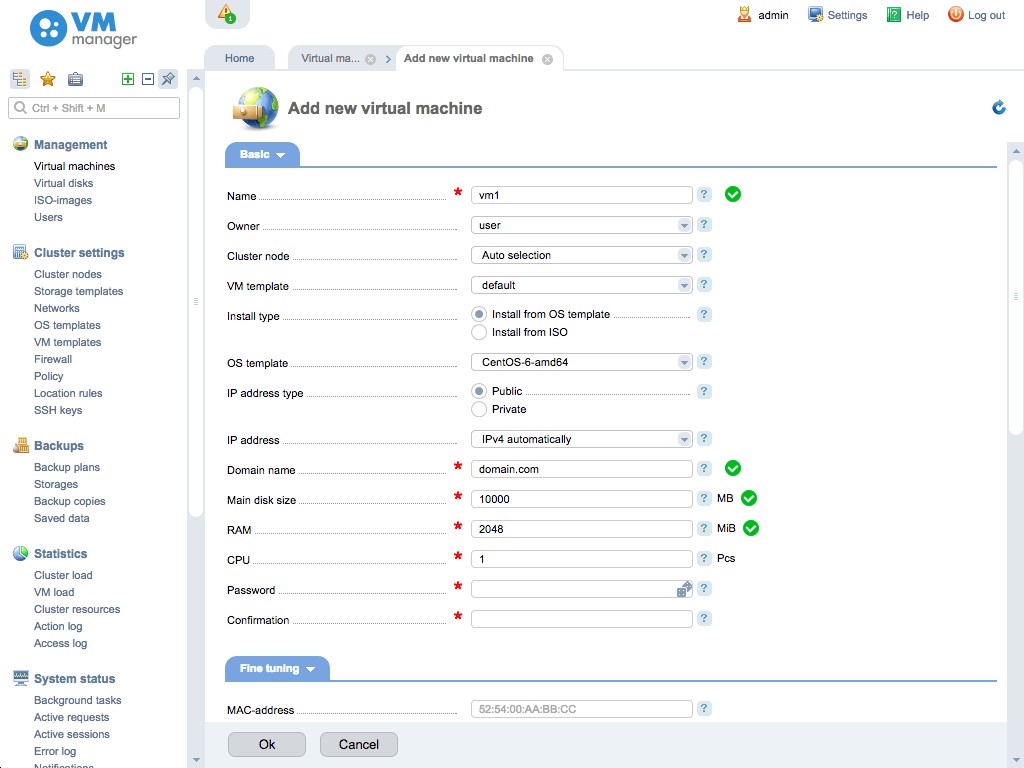

66Веб-панель управления VPS на основе Linux.

Коммерческая панель управления VPS на основе Linux с полной поддержкой виртуализаций KVM и OpenVZ. В нем представлены отличные инструменты для создания виртуальных машин, предоставления услуг VPS-хостинга и построения облачной инфраструктуры.

36OpenStack OpenStack - это глобальная платформа облачных вычислений с открытым исходным кодом для публичных и частных облаков.

OpenStack OpenStack - это результат глобального сотрудничества разработчиков и технологов облачных вычислений, представляющий собой всеобщую платформу облачных вычислений с открытым исходным кодом для публичных и частных облаков.

18Citrix Hypervisor - это комплексная платформа виртуализации серверов со встроенными функциями корпоративного класса, позволяющая легко обрабатывать различные типы рабочих нагрузок, смешанные операционные системы и конфигурации хранения или сети.

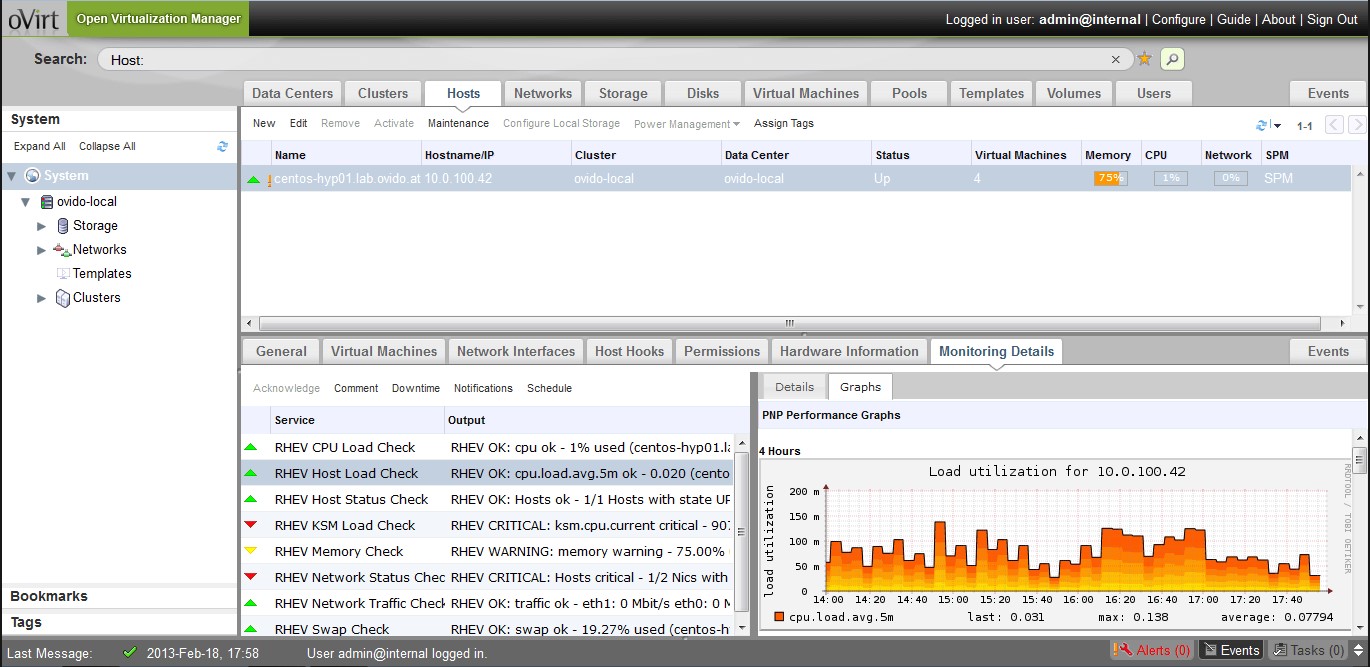

15oVirt - это приложение для управления виртуализацией.

oVirt - это приложение для управления виртуализацией. Это означает, что вы можете использовать интерфейс oVirt (механизм oVirt) для управления техническими сетевыми узлами, хранилищами и сетевыми ресурсами, а также для развертывания и мониторинга виртуальных машин, работающих в вашем центре обработки данных.

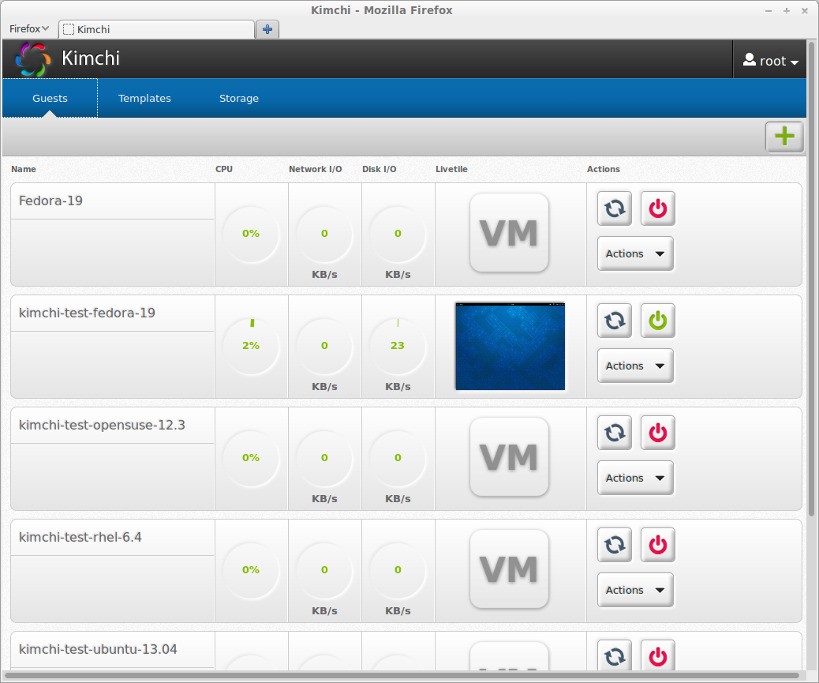

5Kimchi - это инструмент управления для KVM на основе HTML5.

Kimchi сделан для того, чтобы как можно проще начать работу с KVM и создать своего первого гостя.

4Веб-клиент vSphere позволяет подключаться к системе vCenter Server для управления хостом ESXi.

VMware виртуализирует вычисления, от центра обработки данных до облака и мобильных устройств, чтобы помочь нашим клиентам быть более гибкими, отзывчивыми и прибыльными.

Что в этом списке?

В списке находится программы которые можно использовать для замены Proxmox Virtual Environment.

Это аналоги похожие по функционалу на Proxmox Virtual Environment, которые заменяют программу частично или полностью. Этот список содержит 6 замен.

С помощью пользователей мы собираем каталог похожих друг на друга программ, чтобы вы могли подобрать альтернативу и скачать их. На сайте можно скачать популярные программы для Windows, Mac Os, Android и iPhone

Proxmox Virtual Environment — это система виртуализации с открытым исходным кодом, основанная на Debian GNU/Linux.

Основные нововведения в данном релизе:

- Debian 7.0 Wheezy как базовая система; ;

- pve-kernel-2.6.32 2.6.32-100;

- ceph обновлён до 0.61.2;

- pve-cluster 3.0-4;

- pve-manager 3.0-20;

- pve-qemu-kvm 1.4-12;

- qemu-server 3.0-15.

Неплохо!

Посмотреть бы сравнение с rhev.

Как система виртуализации может быть основана на ОС?

Debian GNU/Linux - это дистрибутив. Ваш К.О.

Ок, мистер К.О., тогда объясните на каком дистрибутиве основана VirtualBox раз Вы такой умный?

Windows Же. Придурок ПроксМокс это КВМ+Еще что(Open хз что там), то + Панели управления и т.п. Или читай сначала о теме или не бзди.

КВМ+ОпенВЗ+класетризация и бекапы из коробки + нормальный гуй на extjs

Внезапно! Proxmox VE и VirtualBox - это совсем разный класс ПО.

Где взять RHEV? Написал бы хорошее сравнение.

Так это тот же RHEV, только с другой веб-мордой и своим костылем под названием pmxcfs

Когда я им страдал там небыло экст жс. Но всеравно из того, что я видел он лучшее. А ананимус моя утка.

смешно, только что скачал, еще удивлялся, почему в гугле только статейки/отзывы о старой версии :-D а я оказывается на гребне волны! )))

Вроде контора серьезная, а favicon от joomla.

Neskolko mesiacev/mozhet dazhe uzhe s let nazad kogda eshe pro oVirt neslyshal edinstvenniy Hyperviser s webmordoi i avtobackapami out of the box, plus eshe i online migration, nashel tolko Proxmox. Togda on vrode pojavilsia. Nu i kak nachavschii lichno interesovaca Linuxom s vyhoda Ubunty i bolee vsego polozhitelno otnosiaschiysia k Debianu. Ja sochel Proxmox the best. No sovremenem ja poznakomilsia i uchilsia u odnogo prodvinutogo Linuxoida. Tochnee ja u nego uchilsia eshe do togo kak nachal porabatyvat s Linuxom. No prosto lichniy opyt s Ubuntu byl do nego. Koroche. Cherez dolgovremennoe obschenie s Linux guru etim. Vsetaki oznakomilsia ja bolee i bolee s RedHat side of the world. Nu i vobshem stal k etomu vsemu prosche otnositsia. A tak kak on sam lubitel CentOS konechnowhe u nego prosto KVM. Tak vot dlia nachala u menia slazhilos vmechatlenie. A slushai kak zhe eto iz sebia budet vygliadet upgrade procedura edakogo podelija kak Proxmox. Etozh chacha kakajato custom bildennaja. Ne to chto chistenkiy Debian ili CentOS s KVM. Nu tak v dobavok eshe nedavno kakto razochem nemnozhko my v troem boltali s CentOS project leaderom. Nu i konechno my s etim Guru nedavno oVirt kovyriali. Chto vygliadit dostatochno interesno. No poslednee chto ja slyshal. Etot guru znachit po sovetu CentOS lidera pokovyrial OpenNebula. Skazal chto oochen dovolen. Ja dumaju dlia menia by eshe aktualen byl by faktor nalichija godnoi dokumentacii, opyta i soveta. Tu sistemu by ja i stavil togda. Have fun. :) Ja tebe eshe mylo kinu shas. S dokumentikom. :D

В данной инструкции мы сначала соберем кластер Proxmox для управления всеми хостами виртуализации из единой консоли, а затем — кластер высокой доступности (HA или отказоустойчивый). В нашем примере мы будем работать с 3 серверами — pve1, pve2 и pve3.

Мы не станем уделять внимание процессу установки Proxmox VE, а также настройки сети и других функций данного гипервизора — все это можно прочитать в пошаговой инструкции Установка и настройка Proxmox VE.

Подготовка нод кластера

Серверы должны иметь возможность обращения друг к другу по их серверным именам. В продуктивной среде лучше всего для этого создать соответствующие записи в DNS. В тестовой можно отредактировать файлы hosts. В Proxmox это можно сделать в консоли управления — устанавливаем курсор на сервере - переходим в Система - Hosts - добавляем все серверы, которые будут включены в состав кластера:

* в данном примере у нас в hosts занесены наши два сервера Proxmox, из которых мы будем собирать кластер.

Настройка кластера

Построение кластерной системы выполняется в 2 этапа — сначала мы создаем кластер на любой из нод, затем присоединяем к данному кластеру остальные узлы.

Создание кластера

Переходим в панель управления Proxmox на любой их нод кластера. Устанавливаем курсов на Датацентр - кликаем по Кластер - Создать кластер:

Для создания кластера нам нужно задать его имя и, желательно, выбрать IP-адрес интерфейса, на котором узел кластера будет работать:

. кликаем Создать — процесс не должен занять много времени. В итоге, мы должны увидеть «TASK OK»:

Присоединение ноды к кластеру

На первой ноде, где создали кластер, в том же окне станет активна кнопка Данные присоединения — кликаем по ней:

В открывшемся окне копируем данные присоединения:

Теперь переходим в панель управления нодой, которую хотим присоединить к кластеру. Переходим в Датацентр - Кластер - кликаем по Присоединить к кластеру:

В поле «Данные» вставляем данные присоединения, которые мы скопировали с первой ноды — поля «Адрес сервера» и «Отпечаток заполняться автоматически». Заполняем пароль пользователя root первой ноды и кликаем Присоединение:

Присоединение также не должно занять много времени. Ждем несколько минут для завершения репликации всех настроек. Кластер готов к работе — при подключении к любой из нод мы будем подключаться к кластеру:

Готово. Данный кластер можно использовать для централизованного управления хостами Proxmox.

Посмотреть статус работы кластера можно командой в SSH:

Отказоустойчивый кластер

Настроим автоматический перезапуск виртуальных машин на рабочих нодах, если выйдет из строя сервер.

Для настройки отказоустойчивости (High Availability или HA) нам нужно:

- Минимум 3 ноды в кластере. Сам кластер может состоять из двух нод и более, но для точного определения живых/не живых узлов нужно большинство голосов (кворумов), то есть на стороне рабочих нод должно быть больше одного голоса. Это необходимо для того, чтобы избежать ситуации 2-я активными узлами, когда связь между серверами прерывается и каждый из них считает себя единственным рабочим и начинает запускать у себя все виртуальные машины. Именно по этой причине HA требует 3 узла и выше.

- Общее хранилище для виртуальных машин. Все ноды кластера должны быть подключены к общей системе хранения данных — это может быть СХД, подключенная по FC или iSCSI, NFS или распределенное хранилище Ceph или GlusterFS.

1. Подготовка кластера

Процесс добавления 3-о узла аналогичен процессу, описанному выше — на одной из нод, уже работающей в кластере, мы копируем данные присоединения; в панели управления третьего сервера переходим к настройке кластера и присоединяем узел.

2. Добавление хранилища

Подробное описание процесса настройки самого хранилища выходит за рамки данной инструкции. В данном примере мы разберем пример и использованием СХД, подключенное по iSCSI.

Если наша СХД настроена на проверку инициаторов, на каждой ноде смотрим командой:

. IQN инициаторов. Пример ответа:

После настройки СХД, в панели управления Proxmox переходим в Датацентр - Хранилище. Кликаем Добавить и выбираем тип (в нашем случае, iSCSI):

В открывшемся окне указываем настройки для подключения к хранилке:

* где ID — произвольный идентификатор для удобства; Portal — адрес, по которому iSCSI отдает диски; Target — идентификатор таргета, по которому СХД отдает нужный нам LUN.

Нажимаем добавить, немного ждем — на всех хостах кластера должно появиться хранилище с указанным идентификатором. Чтобы использовать его для хранения виртуальных машин, еще раз добавляем хранилище, только выбираем LVM:

Задаем настройки для тома LVM:

* где было настроено:

- ID — произвольный идентификатор. Будет служить как имя хранилища.

- Основное хранилище — выбираем добавленное устройство iSCSI.

- Основное том — выбираем LUN, который анонсируется таргетом.

- Группа томов — указываем название для группы томов. В данном примере указано таким же, как ID.

- Общедоступно — ставим галочку, чтобы устройство было доступно для всех нод нашего кластера.

Нажимаем Добавить — мы должны увидеть новое устройство для хранения виртуальных машин.

Для продолжения настройки отказоустойчивого кластера создаем виртуальную машину на общем хранилище.

3. Настройка отказоустойчивости

Создание группы

Для начала, определяется с необходимостью групп. Они нужны в случае, если у нас в кластере много серверов, но мы хотим перемещать виртуальную машину между определенными нодами. Если нам нужны группы, переходим в Датацентр - HA - Группы. Кликаем по кнопке Создать:

Вносим настройки для группы и выбираем галочками участников группы:

- ID — название для группы.

- restricted — определяет жесткое требование перемещения виртуальной машины внутри группы. Если в составе группы не окажется рабочих серверов, то виртуальная машина будет выключена.

- nofailback — в случае восстановления ноды, виртуальная машина не будет на нее возвращена, если галочка установлена.

Также мы можем задать приоритеты для серверов, если отдаем каким-то из них предпочтение.

Нажимаем OK — группа должна появиться в общем списке.

Настраиваем отказоустойчивость для виртуальной машины

Переходим в Датацентр - HA. Кликаем по кнопке Добавить:

В открывшемся окне выбираем виртуальную машину и группу:

. и нажимаем Добавить.

4. Проверка отказоустойчивости

После выполнения всех действий, необходимо проверить, что наша отказоустойчивость работает. Для чистоты эксперимента, можно выключиться сервер, на котором создана виртуальная машина, добавленная в HA.

Важно учесть, что перезагрузка ноды не приведет к перемещению виртуальной машины. В данном случае кластер отправляет сигнал, что он скоро будет доступен, а ресурсы, добавленные в HA останутся на своих местах.

Для выключения ноды можно ввести команду:

Виртуальная машина должна переместиться в течение 1 - 2 минут.

Ручное перемещение виртуальной машины

Представим ситуацию, что у нас произошел сбой одного из узлов кластера, но при этом виртуальная машина не переехала на рабочую ноду. Например, если сервер был отправлен в перезагрузку, но не смог корректно загрузиться. В консоли управления нет возможности мигрировать виртуалку с неработающего сервера. Поэтому нам понадобиться командная строка.

И так, открываем SSH-консоль сервера, на любой работающем сервере Proxmox. Переходим в каталог qemu-server той ноды, которая не работает:

* мы предполагаем, что у нас вышел из строя сервер pve1.

Смотрим содержимое каталога:

Мы должны увидеть конфигурационные файлы запущенных виртуальных машин, например:

* в нашем примере у нас запущена только одна виртуальная машина с идентификатором 100.

mv 100.conf ../../pve2/qemu-server/

* где pve2 — имя второй ноды, на которой мы запустим виртуальный сервер.

. проверяем, что виртуальная машина появилась в системе. В противном случае, перезапускаем службы:

systemctl restart pvestatd

systemctl restart pvedaemon

systemctl restart pve-cluster

Сбрасываем состояние для HA:

ha-manager set vm:100 --state disabled

ha-manager set vm:100 --state started

* в данном примере мы сбросили состояние для виртуальной машины с идентификатором 100. Если это не сделать, то при запуске виртуалки ничего не будет происходить.

После виртуальную машину можно запустить:

Репликация виртуальных машин

Если у нас нет общего дискового хранилища, мы можем настроить репликацию виртуальных машин между нодами. В таком случае мы получим, относительно, отказоустойчивую среду — в случае сбоя, у нас будет второй сервер, на котором есть аналогичный набор виртуальных машин.

Настройка ZFS

Репликация может выполняться только на тома ZFS. Подробная работа с данной файловой системой выходит за рамки данной инструкции, однако, мы разберем основные команды, с помощью которых можно создать необходимы том.

Пул ZFS необходимо создавать из командной строки, например:

zpool create -f zpool1 /dev/sdc

* в данном примере мы создадим пул с названием zpool1 из диска /dev/sdc.

Теперь открываем панель управления Proxmox. Переходим в Датацентр - Хранилище - ZFS:

Задаем настройки для создания хранилища из созданного ранее пула ZFS:

* в данном примере мы создаем хранилище из пула zpool1; название для хранилище задаем zfs-pool, также ставим галочку Дисковое резервирование. Остальные настройки оставляем по умолчанию.

После этого мы должны либо перенести виртуальную машину на хранилище ZFS, либо создать в нем новую машину.

Настройка репликации

Переходим к хосту, где находится виртуальная машина, для которой мы хотим настроить клонирование (она должна также находится на хранилище ZFS) - Репликация:

Задаем настройки для репликации виртуальной машины:

* в данном примере мы указываем системе проверять и реплицировать изменения каждые 15 минут для виртуальной машины с идентификатором 100. Репликация должна проводиться на сервер pve2.

Нажимаем Создать — теперь ждем репликации по расписанию или форсируем событие, кликнув по Запустить сейчас:

Удаление ноды из кластера

Удаление узла из рабочего кластера выполняется из командной строки. Список всех нод можно увидеть командой:

Мы увидим, примерно, следующее:

Membership information

----------------------

Nodeid Votes Name

1 1 pve1 (local)

2 1 pve2

3 1 pve3

* где pve1, pve2, pve3 — узлы кластера; local указываем на ноду, с которой мы выполняем команду pvecm.

Для удаления узла, например, pve2 вводим:

pvecm delnode pve2

Ждем немного времени, пока не пройдет репликация. В консоли управления Proxmox удаленный сервер должен пропасть

Удаление кластера

Рассмотрим процесс удаления нод из кластера и самого кластера. Данные действия не могут быть выполнены из веб-консоли — все операции делаем в командной строке.

Подключаемся по SSH к одной из нод кластера. Смотрим все узлы, которые присоединены к нему:

Мы получим список нод — удалим все, кроме локальной, например:

pvecm delnode pve2

pvecm delnode pve3

* в данном примере мы удалили ноды pve2 и pve3.

Необходимо подождать, минут 5, чтобы прошла репликация между нодами. После останавливаем следующие службы:

systemctl stop pvestatd pvedaemon pve-cluster corosync

Подключаемся к базе sqlite для кластера PVE:

Удаляем из таблицы tree все записи, поле name в которых равно corosync.conf:

Отключаемся от базы:

Удаляем файл блокировки:

rm -f /var/lib/pve-cluster/.pmxcfs.lockfile

Удаляем файлы, имеющие отношение к настройке кластера:

Запускаем ранее погашенные службы:

systemctl start pvestatd pvedaemon pve-cluster corosync

Как настроить кластер гипервизоров Proxmox Virtual Enviroment

Читайте также: