Avago megaraid sas 9361 4i создание raid

Обновлено: 06.07.2024

Добрый день!

Посоветуйте, как правильно настроить рейд-контроллер.

Контроллер: LSI AVAGO MegaRAID SAS 9361-8i с комплектом защиты LSI MegaRAID CacheVault < LSI00418 LSICVM02 > CVPM02.

Будут следующие массивы:

Диск С, Винда - 2 ССД в зеркало.

Диск Д, файл транзакций *.LDF - 2 SAS в зеркало

Диск Е, база данных SQL *.MDF - 4 SAS в Рэйд 10

Создал пробные зеркала, увидел, что если щелкнуть в утилите MegaRaid Storage Manager на дисковой группе, то параметр Data Protection - Disabled.

Есть такое подозрение, что при наличии батарейки должно быть Enabled. как перенастроить?

Подскажите, какие выбрать остальные параметры:

Write Policy

Read Policy

IO Policy

Access Policy

Disk Cache Policy

Будут ли настройки зависеть от того, что будет на массиве (винда, бд, файл транзакций).

Установлен server 2016 R2.

Заранее благодарен!

Войдите в меню контроллера при включении питания. Такие параметры настраиваются там.

Sponge Bob писал(а): Добрый день.

Войдите в меню контроллера при включении питания. Такие параметры настраиваются там.

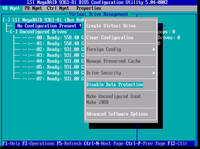

Да, есть такое. Только я запутался. Если зайти в настройку контроллера при включении сервера, там в меню будет опция "Disable Data Protection", вот скрин:

При этом (опция=Disable Data Protection, как на скрине), в винде видим что защита на уровне контроллера включена:

а на уровне Drive Group выключена. почему и как ее включить?

mcmurphy94 писал(а): Добрый день!

Создал пробные зеркала, увидел, что если щелкнуть в утилите MegaRaid Storage Manager на дисковой группе, то параметр Data Protection - Disabled.

Есть такое подозрение, что при наличии батарейки должно быть Enabled. как перенастроить?

Среди меня есть мнение, что пар-р "Data Protection" не имеет отношения к BBU/CV-защите кеша контроллера.

Имхуется мне, что при наличии исправного BBU/CV никаких отдельных настроек для защиты кеша контроллера не нужно - он будет подпитываться от BBU или сбрасываться на флеш в случае CV по-любому, для любого LUN`а (VD) без специального указания.

А Data Protection, мнится мне, имеет отношение к опции PI контроллера - защита информации на уровне физического носителя по стандарту Т10/DIF, для работы с "нестандартными" физ.секторами (например, 520b вместо 512b и т.д) с избыточной информацией (КС/КЧ) .

Ок, спасибо!

А как правильно сделать - после создания массива запустить инициализацию (если не была выбрана опция инициализировать сразу после создания)? Это актуально и для SAS и для SSD?

Утилита от LSI MSM не пишет, был ли проинициализирован массив. Если запустить инициализацию, предупреждает, что данные будут потеряны. Это действительно так, если есть файлы, то их затрет?

К сравнению, интеловский рейд на С600 и утилита Intel Rapid позволяет запускать инициализацию на массиве с файлами и ничего не затирается. У них разные подходы?

И еще - когда надо провести проверку консистентности - уже после заполенения массива файлами, или нет?

mcmurphy94 писал(а): Ок, спасибо!А как правильно сделать - после создания массива запустить инициализацию (если не была выбрана опция инициализировать сразу после создания)? Это актуально и для SAS и для SSD?

Не уверен, что понял, как второй вопрос из вышеотквоченного сочетается/связан со первым.

Мои семантические фильтры сбоят?

Актуальна ли инициализация массива как для HDD, так и для SSD.

Или актуальна ли инициализация массива как для SAS, так и для SATA носителей?

И по запуску тоже как-то коряво спрошено.

Даже если Вы не включите фоновую инициализацию и откажетесь инициализировать массив после его создания (если БИОС контроллера допускает такое вольнодумство ), то у Вас остаётся возможность "подстраховаться" впоследствии, задействовать механизмы PR или СС (см.ниже).

Это вопросы к создателям утилиты MSM (хотя я бы их - за одну лишь тормозную явовскую морду и вечный косяк с multicast/unicast-коннектами к сетевым агентам - просто распнул бы. не смертельным, но очччень обидным образом).

Надеюсь, что про потерю данных они так "шутят"-перестраховываются. Т.к. инициализация массива может проводиться контроллером в т.ч. и в фоновом режиме прямо в процессе работы контроллера с данными на носителях.

Если это ТА ЖЕ инициализация, то нафига так пугать народ?

А если это "какая-то другая" инициализация, то. какая?

Вообще же из более-менее детальной проработки документации у меня по некоторым признакам сложилось впечатление, что пресловутая "инициализация массива" - неважно, фоновая она, или "фронт-эндная" - использует тот же механизм/алгоритм, что и так называемое "патрульное чтение" (Patrol Reading), проверяя абсолютно все блоки носителей на читабельность (и при нужде - на писабельность), с соответствующими выводами (аналог ремапа битых физ.секторов, проводимого внутри hdd или ssd их собственными фирмварями).

По итогам инициализации в метаданные массива записывается помимо прочего ещё и инфа о состоянии носителей (указание на имеющиеся "ремапы", пометки в Bad Strip Table, etc.).

И да - и инициализация, и Patrol Reading абсолютно недеструктивны для данных на массиве (конечно, при штатном развитии событий, что является нормой для исправного контроллера).

Повторюсь - LSI (как и остальные вендоры) реализовал точно такой же механизм инициализации, по сути стандарт.

Почему MSM пугает уничтожением данных - "вопрос не по окладу"(с).

mcmurphy94 писал(а): И еще - когда надо провести проверку консистентности - уже после заполенения массива файлами, или нет?

Если Вы имеете в виду СС - Check Consistency - то она, в отличие от Patrol Reading, работает только на блоках с данными (PP проверяет все блоки без исключения).

Соответственно, запускать СС на пустом массиве бесполезно.

В данной статье мы расскажем про разные способы организации RAID-массивов, а также покажем один из первых аппаратных RAID-контроллеров с поддержкой NVMe.

Все разнообразие применений технологии RAID встречается в серверном сегменте. В клиентском сегменте чаще всего используется исключительно программный RAID0 или RAID1 на два диска.

В этой статье будет краткий обзор технологии RAID, небольшая инструкция по созданию RAID-массивов с помощью трех разных инструментов и сравнение производительности виртуальных дисков при использовании каждого из способов.

Что такое RAID?

RAID (англ. Redundant Array of Independent Disks — избыточный массив независимых (самостоятельных) дисков) — технология виртуализации данных для объединения нескольких физических дисковых устройств в логический модуль для повышения отказоустойчивости и производительности.

Конфигурация дисковых массивов и используемые при этом технологии зависят от выбранного уровня RAID (RAID level). Уровни RAID стандартизированы в спецификации Common RAID Disk Data Format. Она описывает множество уровней RAID, однако самыми распространенными принято считать RAID0, RAID1, RAID5 и RAID6.

RAID0, или Stripes, — это уровень RAID, который объединяет два или более физических диска в один логический. Объем логического диска при этом равен сумме объемов физических дисков, входящих в массив. На этом уровне RAID отсутствует избыточность, а выход из строя одного диска может привести к потере всех данных в виртуальном диске.

Уровень RAID1, или Mirror, создает идентичные копии данных на двух и более дисках. Объем виртуального диска при этом не превышает объема минимального из физических дисков. Данные на виртуальном диске RAID1 будут доступны, пока хотя бы один физический диск из массива работает. Использование RAID1 добавляет избыточности, но является достаточно дорогим решением, так как в массивах из двух и более дисков доступен объем только одного.

Уровень RAID5 решает проблему дороговизны. Для создания массива с уровнем RAID5 необходимо как минимум 3 диска, при этом массив устойчив к выходу из строя одного диска. Данные в RAID5 хранятся блоками с контрольными суммами. Нет строгого деления на диски с данными и диски с контрольными суммами. Контрольные суммы в RAID5 — это результат операции XOR, примененной к N-1 блокам, каждый из которых взят со своего диска.

Хотя RAID-массивы повышают избыточность и предоставляют резервирование, они не подходят для хранения резервных копий.

После краткого экскурса по видам RAID-массивов можно переходить к устройствам и программам, которые позволяют собирать и использовать дисковые массивы.

Виды RAID-контроллеров

Существует два способа создать и использовать RAID-массивы: аппаратный и программный. Мы рассмотрим следующие решения:

- Linux Software RAID.

- Intel® Virtual RAID On CPU.

- LSI MegaRAID 9460-8i.

Linux Software RAID

Программные RAID-массивы в семействе ОС Linux — достаточно распространенное решение как в клиентском сегменте, так и в серверном. Все, что нужно для создания массива, — утилита mdadm и несколько блочных устройств. Единственное требование, которое предъявляет Linux Software RAID к используемым накопителям, — быть блочным устройством, доступным системе.

Отсутствие затрат на оборудование и программное обеспечение — очевидное преимущество данного способа. Linux Software RAID организует дисковые массивы ценой процессорного времени. Список поддерживаемых уровней RAID и состояние текущих дисковых массивов можно посмотреть в файле mdstat, который находится в корне procfs:

Поддержка уровней RAID добавляется подключением соответствующего модуля ядра, например:

Все операции с дисковыми массивами производятся через утилиту командной строки mdadm. Сборка дискового массива производится в одну команду:

После выполнения этой команды в системе появится блочное устройство /dev/md0, которое представляет из тебя виртуальный диск.

Intel® Virtual RAID On CPU

Intel® VROC Standard Hardware Key

Intel® Virtual RAID On CPU (VROC) — это программно-аппаратная технология для создания RAID-массивов на базе чипсетов Intel®. Данная технология доступна в основном для материнских плат с поддержкой процессоров Intel® Xeon® Scalable. По умолчанию VROC недоступен. Для его активации необходимо установить аппаратный лицензионный ключ VROC.

Стандартная лицензия VROC позволяет создавать дисковые массивы с 0, 1 и 10 уровнями RAID. Премиальная версия расширяет этот список поддержкой RAID5.

Технология Intel® VROC в современных материнских платах работает совместно с Intel® Volume Management Device (VMD), которая обеспечивает возможность горячей замены для накопителей с интерфейсом NVMe.

Intel® VROC со стандартной лицензией Настройка массивов производится через Setup Utility при загрузке сервера. На вкладке Advanced появляется пункт Intel® Virtual RAID on CPU, в котором можно настроить дисковые массивы.

Создание массива RAID1 на двух накопителях

Технология Intel® VROC имеет свои «козыри в рукаве». Дисковые массивы, собранные с помощью VROC, совместимы с Linux Software RAID. Это означает, что состояние массивов можно отслеживать в /proc/mdstat, а администрировать — через mdadm. Эта «особенность» официально поддерживается Intel. После сборки RAID1 в Setup Utility можно наблюдать синхронизацию накопителей в ОС:

Отметим, что через mdadm нельзя собирать массивы на VROC (собранные массивы будут Linux SW RAID), но можно менять в них диски и разбирать массивы.

LSI MegaRAID 9460-8i

Внешний вид контроллера LSI MegaRAID 9460-8i

RAID-контроллер является самостоятельным аппаратным решением. Контроллер работает только с накопителями, подключенными непосредственно к нему. Данный RAID-контроллер поддерживает до 24 накопителей с интерфейсом NVMe. Именно поддержка NVMe выделяет этот контроллер из множества других.

Главное меню аппаратного контроллера

При использовании режима UEFI настройки контроллера интегрируются в Setup Utility. В сравнении с VROC меню аппаратного контроллера выглядит значительно сложнее.

Создание RAID1 на двух дисках

Объяснение настройки дисковых массивов на аппаратном контроллере является достаточно тонкой темой и может стать поводом для полноценной статьи. Здесь же мы просто ограничимся созданием RAID0 и RAID1 с настройками по умолчанию.

Диски, подключенные в аппаратный контроллер, не видны операционной системе. Вместо этого контроллер «маскирует» все RAID-массивы под SAS-накопители. Накопители, подключенные в контроллер, но не входящие в состав дискового массива, не будут доступны ОС.

Несмотря на маскировку под SAS-накопители, массивы с NVMe будут работать на скорости PCIe. Однако такая особенность позволяет загружаться с NVMe в Legacy.

Тестовый стенд

Каждый из способов организации дисковых массивов имеет свои физические плюсы и минусы. Но есть ли разница в производительности при работе с дисковыми массивами?

Для достижения максимальной справедливости все тесты будут проведены на одном и том же сервере. Его конфигурация:

- 2x Intel® Xeon® 6240;

- 12x DDR4-2666 16 GB;

- LSI MegaRAID 9460-8i;

- Intel® VROC Standard Hardware Key;

- 4x Intel® SSD DC P4510 U.2 2TB;

- 1x Samsung 970 EVO Plus M.2 500GB.

Тестирование

В первую очередь проверим задержки при работе с диском. Тест выполняется в один поток, размер блока 4 КБ. Каждый тест длится 5 минут. Перед началом для соответствующего блочного устройства выставляется none в качестве планировщика I/O. Команда fio выглядит следующим образом:

Из результатов fio мы берем clat 99.00%. Результаты приведены в таблице ниже.

| Случайное чтение, мкс | Случайная запись, мкс | |

|---|---|---|

| Диск | 112 | 78 |

| Linux SW RAID, RAID0 | 113 | 45 |

| VROC, RAID0 | 112 | 46 |

| LSI, RAID0 | 122 | 63 |

| Linux SW RAID, RAID1 | 113 | 48 |

| VROC, RAID1 | 113 | 45 |

| LSI, RAID1 | 128 | 89 |

Помимо задержек при обращении к данным, хочется увидеть производительность виртуальных накопителей и сравнить с производительностью физического диска. Команда для запуска fio:

Производительность измеряется в количестве операций ввода-вывода. Результаты представлены в таблице ниже.

| Случайное чтение 1 поток, IOPS | Случайная запись 1 поток, IOPS | Случайное чтение 128 потоков, IOPS | Случайная запись 128 потоков, IOPS | |

|---|---|---|---|---|

| Диск | 11300 | 40700 | 453000 | 105000 |

| Linux SW RAID, RAID0 | 11200 | 52000 | 429000 | 232000 |

| VROC, RAID0 | 11200 | 52300 | 441000 | 162000 |

| LSI, RAID0 | 10900 | 44200 | 311000 | 160000 |

| Linux SW RAID, RAID1 | 10000 | 48600 | 395000 | 147000 |

| VROC, RAID1 | 10000 | 54400 | 378000 | 244000 |

| LSI, RAID1 | 11000 | 34300 | 229000 | 248000 |

Легко заметить, что использование аппаратного контроллера дает увеличение задержек и просадку по производительности в сравнении с программными решениями.

Заключение

Использование аппаратных решений для создания дисковых массивов из двух дисков выглядит нерационально. Тем не менее, существуют задачи, где использование RAID-контроллеров оправдано. С появлением контроллеров с поддержкой интерфейса NVMe у пользователей появляется возможность использовать более быстрые SSD в своих проектах.

MegaRAID Storage Manager мне нужен для того, чтобы воткнуть в свой комп RAID контроллер и прошить его перед установкой в сервер. Прикрепляю к статье интерактивное руководство. MegaRAID Storage Manager есть под разные операционные системы. Будем устанавливать версию для Windows.

Ссылки

Интерактивное руководство В хроме подглючивает, открываете через Firefox.

Установка MegaRAID Storage Manager

Качаем MegaRAID Storage Manager.

Я скачал версию 7.05.00.02.

Данная версия поддерживает контроллеры:

- RAID

- MegaRAID SAS 9362-4i

- MegaRAID SAS 9362-8i

- MegaRAID SAS 9361-4i

- MegaRAID SAS 9361-8i

- MegaRAID SAS 9363-4i

- MegaRAID SAS 9380-8e

- MegaRAID SAS 9381-4i4e

- MegaRAID SAS 9361-8iCC

- MegaRAID SAS 9380-8eCC

- MegaRAID SAS 9364-8i

- MegaRAID SAS 9340-8i

- MegaRAID SAS 9341-8i

- MegaRAID SAS 9341-4i

- MegaRAID SAS 9270-8i

- MegaRAID SAS 9271-4i

- MegaRAID SAS 9271-8i

- MegaRAID SAS 9271-8iCC

- MegaRAID SAS 9286-8e

- MegaRAID SAS 9286CV-8e

- MegaRAID SAS 9286CV-8eCC

- MegaRAID SAS 9265-8i

- MegaRAID SAS 9285-8e

- MegaRAID SAS 9240-4i

- MegaRAID SAS 9240-8i

- MegaRAID SAS 9260-4i

- MegaRAID SAS 9260CV-4i

- MegaRAID SAS 9260-8i

- MegaRAID SAS 9260CV-8i

- MegaRAID SAS 9260DE-8i

- MegaRAID SAS 9261-8i

- MegaRAID SAS 9280-4i4e

- MegaRAID SAS 9280-8e

- MegaRAID SAS 9280DE-8e

- MegaRAID SAS 9280-24i4e

- MegaRAID SAS 9280-16i4e

- MegaRAID SAS 9260-16i

- MegaRAID SAS 9266-4i

- MegaRAID SAS 9266-8i

- MegaRAID SAS 9285CV-8e

- MegaRAID SAS 8704ELP

- MegaRAID SAS 8704EM2

- MegaRAID SAS 8708ELP

- MegaRAID SAS 8708EM2

- MegaRAID SAS 8880EM2

- MegaRAID SAS 8888ELP

- MegaRAID SAS 8308ELP*

- MegaRAID SAS 8344ELP*

- MegaRAID SAS 84016E*

- MegaRAID SAS 8408E*

- MegaRAID SAS 8480E*

- MegaRAID SATA 300-8ELP*

- LSI SAS 9211

- LSI SAS 9212

- LSI SAS3041E-R

- LSI SAS3041X-R

- LSI SAS3080X-R,

- LSI SAS3081E-R

- LSI SAS3442E-R

- LSI SAS3442X-R

- LSI WarpDrive SLP-300

- 9212 4i4e-R spec

- 9211-8i/4i-R spec

- LSI Nytro WarpDrive WLP4-200

- LSI Nytro WarpDrive WLP4-400

- LSI Nytro WarpDrive BLP4-400

- LSI Nytro WarpDrive BLP4-800

- LSI Nytro WarpDrive BLP4-1600

- LSI Nytro XD BLP4-400

- LSI Nytro XD BLP4-800

- LSI SAS 9207-4i4e

- LSI SAS 9217-4i4e

- LSI SAS 9207-8i

- LSI SAS 9217-8i

- LSI SAS 9207-8e

- LSI SAS 9201-16e

- LSI SAS 9200-8e

* Контроллеры предыдущих версий должны работать, но не тестировались.

Работает в ОС 32 и 64 бит:

- Windows* 2000

- Windows* 2003

- Windows* XP

- Windows* Vista

- Windows* 2008

- Windows* 7

- Windows* 8

![MegaRAID]()

![MegaRAID]()

![MegaRAID]()

Install. Требуется C++ пакет.

![MegaRAID]()

Условия установки соблюдены. Открывается окно мастера установки.

![MegaRAID]()

![MegaRAID]()

Принимаем лицензионное соглашение. Next.

![MegaRAID]()

Я выбираю установку для всех пользователей. Next.

![MegaRAID]()

Можно сменить папку установки. Next.

![MegaRAID]()

Выбираю обычную установку. Next.

![MegaRAID]()

Предлагают настроить LDAP, забиваю. Next.

![MegaRAID]()

Указываем размер ключа. Поскольку я на своей же машине буду шить контроллер, то эта опция — по барабану. Next.

![MegaRAID]()

Вот тут я подвис и оставил значение по умолчанию. Это настройка диапазона времени, за которое выводить уведомления. Мне оно не нужно. Next.

![MegaRAID]()

Эта страница предназначена только для того, чтобы нажать кнопку Install или не нажать. Идиотизм.

![MegaRAID]()

![MegaRAID]()

Установка завершена. Finish.

![MegaRAID]()

На рабочем столе появляется иконка MegaRAID Storage Manager. Для работу нужна java.

Можно использовать MegaRAID Storage Manager™, но чтобы его поставить….

Проще использовать консольную утилиту MegaCli

Загрузиться с RIPLinuX и подключиться по SSH

Получить статус и конфигурацию всех адаптеров

Cтатус и параметры всех логических дисков

Статус и параметры физических устройств

Статус и параметры диска в 4-м слоте

Создание RAID6 массив MegaCLI

Давайте предположим, что у нас есть сервер с MegaRAID SAS

Получим список физических дисков:

Пример конфигурирования JBOD на LSI 2208 (Supermicro X9DRH-7TF)

При загрузке BIOS эти команды можно выполнить если зайти в preboot CLI по комбинации клавиш Ctrl+Y

Команды megacli и preboot CLI различаются по виду.

Например команда проверки поддержки JBOD для BIOS preboot CLI будет выглядеть так:

А для megacli это используется как набор опций и параметров:

Включить поддержку JBOB

Список доступных физических устройств:

В списке надо найти значения полей Enclosure Device ID (например 252), Slot Number и Firmware state

Нужно отметить каждое из устройств которое надо сделать JBOD, как Good в поле Firmware state .

Или сразу много устройств:

Теперь можно создавать JBOD

Создать виртуальный диск RAID

Перед настройкой массива, возможно, потребуется удалить использованную ранее конфигурацию. Для того чтобы просто удалить логические устройства используйте CfgLdDel

Для того чтобы удалить всё (в том числе политику кэша) используйте «Очистку конфигурации»

Настройка RAID-0, 1 или 5. Вместо «r0» введите соответственно «r1» или «r5» (диски находятся в Enclosure 29, на портах 0 и 1, WriteBack включен, ReadCache адаптивный, Cache также включен без BBU)

Создать RAID10

Получить список дисков

![]()

Создать массив из 6 дисков

Показать как диски были определены в RAID-массиве:

Удалить массив с >

Инициализация массива

Начать полную инициализацию для массива с >

Проверить текущий статус инициализации:

Управление CacheCade

Создать и назначить CacheCade для массива 0 (-L0) из зеркала (-r1) в режиме обратной записи (WB) на основе SSD дисков в слотах 6 и 7 (-Physdrv[252:6,252:7])

Замена неисправного диска

Обратите внимание, что это не навсегда отключает сигнализацию, а просто выключает сигнал по текущей аварии.

Просмотреть состояние диска (подставьте нужное значение [E:S]):

Пометить диск требующий замены как потерянный (если контроллер не сделал этого сам)

Получить параметры потерянного диска

Вы должны получить ответ подобный этому:

Подсветить диск который надо менять (подставьте нужное значение [E:S]):

На некоторых шасси могут быть проблемы с индикацией. Это лечится такой командой:

В этом случае для маркировки диска будет использоваться лампочка активности.

Удаляем неисправный и вставляем новый диск.

Прекращаем подсветку и проверяем состояние диска:

Может так случится, что он содержит метаданные от другого массива RAID (Foreign Configuration). Ваш контроллер не позволит использовать такой диск. Для проверки наличия Foreign Configuration

Команда удаления Foreign Configuration (если вы уверены)

Запускаем процесс замены

[32:4] - это параметры диска которым вы меняете неисправныйПроверка процесса ребилда

Использование smartctl

Получить список id

Получить данные смарт по диску с >

для диска с интерфейсом sata

пример срипта для получения данных о всех дисках

Для контроля состояния дисков с помощью демона smartd нужно закомментировать DEVICESCAN в /etc/smartd.conf и добавить:

Значения параметров типа /3/02 - /3/05 определяют время запуска тестов для заданного диска

Читайте также: