Compact disc recordable high speed 25 minutes 225 megabytes как установить на ноутбук

Обновлено: 03.07.2024

abstract: разница между текущей производительностью и производительностью теоретической; latency и IOPS, понятие независимости дисковой нагрузки; подготовка тестирования; типовые параметры тестирования; практическое copypaste howto.

Предупреждение: много букв, долго читать.

- научная публикация, в которой скорость кластерной FS оценивали с помощью dd (и включенным файловым кешем, то есть без опции direct)

- использование bonnie++

- использование iozone

- использование пачки cp с измерениема времени выполнения

- использование iometer с dynamo на 64-битных системах

Это всё совершенно ошибочные методы. Дальше я разберу более тонкие ошибки измерения, но в отношении этих тестов могу сказать только одно — выкиньте и не используйте.

bonnie++ и iozone меряют скорость файловой системы. Которая зависит от кеша, задумчивости ядра, удачности расположения FS на диске и т.д. Косвенно можно сказать, что если в iozone получились хорошие результаты, то это либо хороший кеш, либо дурацкий набор параметров, либо действительно быстрый диск (угадайте, какой из вариантов достался вам). bonnie++ вообще сфокусирована на операциях открытия/закрытия файлов. т.е. производительность диска она особо не тестирует.

dd без опции direct показывает лишь скорость кеша — не более. В некоторых конфигурациях вы можете получать линейную скорость без кеша выше, чем с кешем. В некоторых вы будете получать сотни мегабайт в секунду, при линейной производительности в единицы мегабайт.

С опцией же direct (iflag=direct для чтения, oflag=direct для записи) dd проверяет лишь линейную скорость. Которая совершенно не равна ни максимальной скорости (если мы про рейд на много дисков, то рейд в несколько потоков может отдавать большую скорость, чем в один), ни реальной производительности.

IOmeter — лучше всего перечисленного, но у него есть проблемы при работе в linux. 64-битная версия неправильно рассчитывает тип нагрузки и показывает заниженные результаты (для тех, кто не верит — запустите его на ramdisk).

Спойлер: правильная утилита для linux — fio. Но она требует очень вдумчивого составления теста и ещё более вдумчивого анализа результатов. Всё, что ниже — как раз подготовка теории и практические замечания по работе с fio.

(текущая VS максимальная производительность)

Сейчас будет ещё больше скучных букв. Если кого-то интересует количество попугаев на его любимой SSD'шке, ноутбучном винте и т.д. — см рецепты в конце статьи.

Все современные носители, кроме ramdisk'ов, крайне негативно относятся к случайным операциям записи. Для HDD нет разницы запись или чтение, важно, что головки гонять по диску. Для SSD же случайная операция чтения ерунда, а вот запись малым блоком приводит к copy-on-write. Минимальный размер записи — 1-2 Мб, пишут 4кб. Нужно прочитать 2Мб, заменить в них 4кб и записать обратно. В результате в SSD'шку уходит, например, 400 запросов в секундну на запись 4кб которые превращаются в чтение 800 Мб/с (. ) и записи их обратно. (Для ramdisk'а такая проблема могла бы быть тоже, но интрига в том, что размер «минимального блока» для DDR составляет около 128 байт, а блоки в тестах обычно 4кб, так что гранулярность DDR в тестах дисковой производительности оперативной памяти не важна).

Этот пост не про специфику разных носителей, так что возвращаемся к общей проблеме.

Мы не можем мерять запись в Мб/с. Важным является сколько перемещений головки было, и сколько случайных блоков мы потревожили на SSD. Т.е. счёт идёт на количество IO operation, а величина IO/s называется IOPS. Таким образом, когда мы меряем случайную нагрузку, мы говорим про IOPS (иногда wIOPS, rIOPS, на запись и чтение соотв.). В крупных системах используют величину kIOPS, (внимание, всегда и везде, никаких 1024) 1kIOPS = 1000 IOPS.

И вот тут многие попадают в ловушку первого рода. Они хотят знать, «сколько IOPS'ов» выдаёт диск. Или полка дисков. Или 200 серверных шкафов, набитые дисками под самые крышки.

Тут важно различать число выполненных операций (зафиксировано, что с 12:00:15 до 12:00:16 было выполнено 245790 дисковых операций — т.е. нагрузка составила 245kIOPS) и то, сколько система может выполнить операций максимум.

Число выполненых операций всегда известно и легко измерить. Но когда мы говорим про дисковую операцию, мы говорим про неё в будущем времени. «сколько операций может выполнить система?» — «каких операций?». Разные операции дают разную нагрузку на СХД. Например, если кто-то пишет случайными блоками по 1Мб, то он получит много меньше iops, чем если он будет читать последовательно блоками по 4кб.

И если в случае пришедшей нагрузки мы говорим о том, сколько было обслужено запросов «какие пришли, такие и обслужили», то в случае планирования, мы хотим знать, какие именно iops'ы будут.

Драма состоит в том, что никто не знает, какие именно запросы придут. Маленькие? Большие? Подряд? В разнобой? Будут они прочитаны из кеша или придётся идти на самое медленное место и выковыривать байтики с разных половинок диска?

- Тест диска (СХД/массива) на best case (попадание в кеш, последовательные операции)

- Тест диска на worst case. Чаще всего такие тесты планируются с знанием устройства диска. «У него кеш 64Мб? А если я сделаю размер области тестирования в 2Гб?». Жёсткий диск быстрее читает с внешней стороны диска? А если я размещу тестовую область на внутренней (ближшей к шпинделю) области, да так, чтобы проходимый головками путь был поболе? У него есть read ahead предсказание? А если я буду читать в обратном порядке? И т.д.

В результате мы получаем цифры, каждая из которых неправильная. Например: 15kIOPS и 150 IOPS.

Какая будет реальная производительность системы? Это определяется только тем, как близко будет нагрузка к хорошему и плохому концу. (Т.е. банальное «жизнь покажет»).

- Что best case всё-таки best. Потому что можно дооптимизироваться до такого, что best case от worst будет отличаться едва-едва. Это плохо (ну или у нас такой офигенный worst).

- На worst. Имея его мы можем сказать, что СХД будет работать быстрее, чем полученный показатель. Т.е. если мы получили 3000 IOPS, то мы можем смело использовать систему/диск в нагрузке «до 2000».

Ну и про размер блока. Традиционно тест идёт с размером блока в 4к. Почему? Потому что это стандартный размер блока, которым оперируют ОС при сохранении файла. Это размер страницы памяти и вообще, Очень Круглое Компьютерное Число.

Нужно понимать, что если система обрабатывает 100 IOPS с 4к блоком (worst), то она будет обрабатывать меньше при 8к блоке (не менее 50 IOPS, вероятнее всего, в районе 70-80). Ну и на 1Мб блоке мы увидим совсем другие цифры.

Всё? Нет, это было только вступление. Всё, что написано выше, более-менее общеизвестно. Нетривиальные вещи начинаются ниже.

- прочитать запись

- поменять запись

- записать запись обратно

Для удобства будем полагать, что время обработки нулевое. Если каждый запрос на чтение и запись будет обслуживаться 1мс, сколько записей в секунду сможет обработать приложение? Правильно, 500. А если мы запустим рядом вторую копию приложения? На любой приличной системе мы получим 1000. Если мы получим значительно меньше 1000, значит мы достигли предела производительности системы. Если нет — значит, что производительность приложения с зависимыми IOPS'ами ограничивается не производительностью СХД, а двумя параметрами: latency и уровнем зависимости IOPS'ов.

Начнём с latency. Latency — время выполнения запроса, задержка перед ответом. Обычно используют величину, «средняя задержка». Более продвинутые используют медиану среди всех операций за некоторый интервал (чаще всего за 1с). Latency очень сложная для измерения величина. Связано это с тем, что на любой СХД часть запросов выполняется быстро, часть медленно, а часть может попасть в крайне неприятную ситуацию и обслуживаться в десятки раз дольше остальных.

Интригу усиливает наличие очереди запросов, в рамках которой может осуществляться переупорядочивание запросов и параллельное их исполнение. У обычного SATA'шного диска глубина очереди (NCQ) — 31, у мощных систем хранения данных может достигать нескольких тысяч. (заметим, что реальная длина очереди (число ожидающих выполнения запросов) — это параметр скорее негативный, если в очереди много запросов, то они дольше ждут, т.е. тормозят. Любой человек, стоявший в час пик в супермаркете согласится, что чем длиннее очередь, тем фиговее обслуживание.

Latency напрямую влияет на производительность последовательного приложения, пример которого приведён выше. Выше latency — ниже производительность. При 5мс максимальное число запросов — 200 шт/с, при 20мс — 50. При этом если у нас 100 запросов будут обработаны за 1мс, а 9 запросов — за 100мс, то за секунду мы получим всего 109 IOPS, при медиане в 1мс и avg (среднем) в 10мс.

Отсюда довольно трудный для понимания вывод: тип нагрузки на производительность влияет не только тем, «последовательный» он или «случайный», но и тем, как устроены приложения, использующие диск.

Пример: запуск приложения (типовая десктопная задача) практически на 100% последовательный. Прочитали приложение, прочитали список нужных библиотек, по-очереди прочитали каждую библиотеку… Именно потому на десктопах так пламенно любят SSD — у них микроскопическая задержка (микросекундная) на чтение — разумеется, любимый фотошоп или блендер запускается в десятые доли секунды.

Трешинг. Я думаю, с этим явлением пользователи десктопов знакомы даже больше, чем сисадмины. Жуткий хруст жёсткого диска, невыразимые тормоза, «ничего не работает и всё тормозит».

По мере того, как мы начинаем забивать очередь диска (или хранилища, повторю, в контексте статьи между ними нет никакой разницы), у нас начинает резко вырастать latency. Диск работает на пределе возможностей, но входящих обращений больше, чем скорость их обслуживания. Latency начинает стремительно расти, достигая ужасающих цифр в единицы секунд (и это при том, что приложению, например, для завершения работы нужно сделать 100 операций, которые при latency в 5 мс означали полусекундную задержку. ). Это состояние называется thrashing.

Вы будете удивлены, но любой диск или хранилище способны показывать БОЛЬШЕ IOPS'ов в состоянии thrashing, чем в нормальной загрузке. Причина проста: если в нормальном режиме очередь чаще всего пустая и кассир скучает, ожидая клиентов, то в условии трешинга идёт постоянное обслуживание. (Кстати, вот вам и объяснение, почему в супермаркетах любят устраивать очереди — в этом случае производительность кассиров максимальная). Правда, это сильно не нравится клиентам. И в хороших супермаркетах хранилищах такого режима стараются избегать. Если дальше начинать поднимать глубину очереди, то производительность начнёт падать из-за того, что переполняется очередь и запросы стоят в очереди чтобы встать в очередь (да-да, и порядковый номер шариковой ручкой на на руке).

И тут нас ждёт следующая частая (и очень трудно опровергаемая) ошибка тех, кто меряет производительность диска.

Они говорят «у меня диск выдаёт 180 IOPS, так что если взять 10 дисков, то это будет аж 1800 IOPS». (Именно так думают плохие супермаркеты, сажая меньше кассиров, чем нужно). При этом latency оказывается запредельной — и «так жить нельзя».

Реальный тест производительности требует контроля latency, то есть подбора таких параметров тестирования, чтобы latency оставалась ниже оговоренного лимита.

И вот тут вот мы сталкиваемся со второй проблемой: а какого лимита? Ответить на этот вопрос теория не может — этот показатель является показателем качества обслуживания. Другими словами, каждый выбирает для себя сам.

Лично я для себя провожу тесты так, чтобы latency оставалась не более 10мс. Этот показатель я для себя считаю потолком производительности хранилища. (при этом в уме я для себя считаю, что предельный показатель, после которого начинают ощущаться лаги — это 20мс, но помните, про пример выше с 900 по 1мс и 10 по 100мс, у которого avg стала 10мс? Вот для этого я и резервирую себе +10мс на случайные всплески).

Выше мы уже рассмотрели вопрос с зависимыми и независимыми IOPS'ами. Производительность зависимых Iops'ов точно контролируется latency, и этот вопрос мы уже обсудили. А вот производительность в независимых iops'ах (т.е. при параллельной нагрузке), от чего она зависит?

Отдельно нужно говорить про ситуацию, когда хранилище подключено к хосту через сеть с использованием TCP. О TCP нужно писать, писать, писать и ещё раз писать. Достаточно сказать, что в линуксе существует 12 разных алгоритмов контроля заторов в сети (congestion), которые предназначены для разных ситуаций. И есть около 20 параметров ядра, каждый из которых может радикальным образом повлиять на попугаи на выходе (пардон, результаты теста).

С точки зрения оценки производительности мы должны просто принять такое правило: для сетевых хранилищ тест должен осуществляться с нескольких хостов (серверов) параллельно. Тесты с одного сервера не будут тестом хранилища, а будут интегрированным тестом сети, хранилища и правильности настройки самого сервера.

Последний вопрос — это вопрос затенения шины. О чём речь? Если у нас ssd способна выдать 400 МБ/с, а мы её подключаем по SATA/300, то очевидно, что мы не увидим всю производительность. Причём с точки зрения latency проблема начнёт проявляться задолго до приближения к 300МБ/с, ведь каждому запросу (и ответу на него) придётся ждать своей очереди, чтобы проскочить через бутылочное горлышко SATA-кабеля.

Но бывают ситуации более забавные. Например, если у вас есть полка дисков, подключенных по SAS/300x4 (т.е. 4 линии SAS по 300МБ каждая). Вроде бы много. А если в полке 24 диска? 24*100=2400 МБ/с, а у нас есть всего 1200 (300х4).

Более того, тесты на некоторых (серверных!) материнских платах показали, что встроенные SATA-контроллеры часто бывают подключены через PCIx4, что не даёт максимально возможной скорости всех 6 SATA-разъёмов.

Повторю, главной проблемой в bus saturation является не выедание «под потолок» полосы, а увеличение latency по мере загрузки шины.

Ну и перед практическими советами, скажу про известные трюки, которые можно встретить в индустриальных хранилищах. Во-первых, если вы будете читать пустой диск, вы будете читать его из «ниоткуда». Системы достаточно умны, чтобы кормить вас нулями из тех областей диска, куда вы никогда не писали.

Во-вторых, во многих системах первая запись хуже последующих из-за всяких механизмов снапшотов, thin provision'а, дедупликации, компрессии, late allocation, sparse placement и т.д. Другими словами, тестировать следует после первичной записи.

В третьих — кеш. Если мы тестируем worst case, то нам нужно знать, как будет вести себя система когда кеш не помогает. Для этого нужно брать такой размер теста, чтобы мы гарантированно читали/писали «мимо кеша», то есть выбивались за объёмы кеша.

Кеш на запись — особая история. Он может копить все запросы на запись (последовательные и случайные) и писать их в комфортном режиме. Единственным методом worst case является «трешинг кеша», то есть посыл запросов на запись в таком объёме и так долго, чтобы write cache перестал стправляться и был вынужден писать данные не в комфортном режиме (объединяя смежные области), а скидывать случайные данные, осуществляя random writing. Добиться этого можно только с помощью многократного превышения области теста над размером кеша.

Вердикт — минимум x10 кеш (откровенно, число взято с потолка, механизма точного расчёта у меня нет).

Разумеется, тест должен быть без участия локального кеша ОС, то есть нам надо запускать тест в режиме, который бы не использовал кеширование. В линуксе это опция O_DIRECT при открытии файла (или диска).

Итого:

1) Мы тестируем worst case — 100% размера диска, который в несколько раз больше предположительного размера кеша на хранилище. Для десктопа это всего лишь «весь диск», для индустриальных хранилищ — LUN или диск виртуальной машины размером от 1Тб и больше. (Хехе, если вы думаете, что 64Гб RAM-кеша это много. ).

2) Мы ведём тест блоком в 4кб размером.

3) Мы подбираем такую глубину параллельности операций, чтобы latency оставалось в разумных пределах.

На выходе нас интересуют параметры: число IOPS, latency, глубина очереди. Если тест запускался на нескольких хостах, то показатели суммируются (iops и глубина очереди), а для latency берётся либо avg, либо max от показателей по всем хостам.

Тут мы переходим к практической части. Есть утилита fio которая позволяет добиться нужного нам результата.

Нормальный режим fio подразумевает использование т.н. job-файла, т.е. конфига, который описывает как именно выглядит тест. Примеры job-файлов приведены ниже, а пока что обсудим принцип работы fio.

fio выполняет операции над указанным файлом/файлами. Вместо файла может быть указано устройство, т.е. мы можем исключить файловую систему из рассмотрения. Существует несколько режимов тестирования. Нас интересует randwrite, randread и randrw. К сожалению, randrw даёт нам зависимые iops'ы (чтение идёт после записи), так что для получения полностью независимого теста нам придётся делать две параллельные задачи — одна на чтение, вторая на запись (randread, randwrite).

И нам придётся сказать fio делать «preallocation». (см выше про трюки производителей). Дальше мы фиксируем размер блока (4к).

Ещё один параметр — метод доступа к диску. Наиболее быстрым является libaio, именно его мы и будем использовать.

При тесте диска запускать её надо от root'а.

тесты на чтение

Запуск: fio read.ini

Содержимое read.ini

Задача подобрать такой iodepth, чтобы avg.latency была меньше 10мс.

Тесты на запись

(внимание! Ошибётесь буквой диска — останетесь без данных)

Гибридные тесты

самая вкусная часть:

(внимание! Ошибётесь буквой диска — останетесь без данных)

Во время теста мы видим что-то вроде такого:

В квадратных скобках — цифры IOPS'ов. Но радоваться рано — ведь нас интересует latency.

На выходе (по Ctrl-C, либо по окончании) мы получим примерно вот такое:

^C

fio: terminating on signal 2

Нас из этого интересует (в минимальном случае) следующее:

read: iops=3526 clat=9063.18 (usec), то есть 9мс.

write: iops=2657 clat=12028.23

Не путайте slat и clat. slat — это время отправки запроса (т.е. производительность дискового стека линукса), а clat — это complete latency, то есть та latency, о которой мы говорили. Легко видеть, что чтение явно производительнее записи, да и глубину я указал чрезмерную.

В том же самом примере я снижаю iodepth до 16/16 и получаю:

read 6548 iops, 2432.79usec = 2.4ms

write 5301 iops, 3005.13usec = 3ms

Очевидно, что глубина в 64 (32+32) оказалась перебором, да таким, что итоговая производительность даже упала. Глубина 32 куда более подходящий вариант для теста.

Вопрос от пользователя

Здравствуйте.

Подскажите с одной проблемой. Приобрел SSD диск, подключил, установил на него Windows — но скорость загрузки никак не изменилась по сравнению с HDD (ну может быть чуть быстрее). Протестировал в программе AS SSD Benchmark — результат 220 МБ/с. Кстати, пробовал провести другой простой тест — копировал на диск большой файл (фильм), сначала была скорость 250 МБ/с, а потом она падала до 40 МБ/с.

В чем может быть дело?

Односложно на подобный вопрос не ответить (кстати, не хватает еще марки накопителя, т.к. некоторым моделям свойственна такая работа) . Тем не менее, в этой статье постараюсь привести основные причины низкой скорости работы SSD (кстати, в ряде случаев причина может быть устранена и диск будет работать так, как заявил производитель).

Из-за чего низкая скорость работы SSD: на что обратить внимание

❶ Нагрузка на диск

Многие пользователи тестируют скорость диска не совсем правильно: они забывают о том, что в это же самое время накопитель могут серьезно нагружать посторонние приложения (торренты, редакторы аудио/видео, игры и пр.).

Разумеется, чтобы получить более-менее "чистые" результаты — перед тестом нужно проверить нагрузку на накопитель и закрыть все посторонние приложения. Иначе, все это "добро" может исказить результаты.

Примечание : нагрузку на диск можно узнать даже в диспетчере задач (для его вызова — нажмите сочетание клавиш Ctrl+Shift+Esc). В идеале нагрузка на него до теста должна составлять 0÷1%. См. скриншот ниже.

Диспетчер задач — загрузка диска 0%

❷ Утилиты для проведения теста

Еще один важный момент: тестируйте диск несколькими утилитами! Дело в том, что некоторые диски "отказываются" работать, например, с CrystalDiskMark (т.е. после запуска теста — все сразу зависает, или цифры "берутся" просто с потолка, как бы это странно не звучало) , но работают с AS SSD Benchmark, SSD-Z и пр.

❸ Про режимы работы SATA II и SATA III

И так, вы провели тест (допустим в CrystalDiskMark) и увидели результаты последовательной скорости чтения/записи (Seq) в 2 раза ниже, чем обещано производителем: например, вместо 500 МБ/с отображается 300 (250) МБ/с (как у меня на скрине ниже) .

Тест в программе CrystalDiskMark — ожидание и реальность.

Одним из первых шагов, который я рекомендую сделать, узнать в каком режиме работает ваш диск (SATA II или SATA III). Дело в том, что на многих материнских платах есть как SATA II порты, так и SATA III. В ряде случаев многие пользователи подключают диск к SATA II — в результате диск работает медленнее, чем потенциально мог бы.

Как это проверить:

- запустить утилиту CrystalDiskInfo;

- посмотреть строку "Режим передачи": там вы в идеале должны увидеть значение "SATA/600 | SATA/600" (прим.: SATA/600 -> SATA III; SATA/300 -> SATA II; SATA/150 -> SATA I) .

- если у вас будет строка вида "SATA/300 | SATA/600" (примеры ниже) — это значит что диск подключен к SATA II интерфейсу, но его также можно подключить к SATA III (что, разумеется серьезно скажется на скорости (SATA III — скорость работы до 600 МБ/с, SATA II — до 300 МБ/с)) .

Режим передачи — CrystalDiskInfo

Альтернативный пример (текущий режим — SATA II, поддерживаемый — SATA III)

❹ Обновите драйвера (на SATA контроллер)

Проще всего проверить и обновить все драйвера на компьютере/ноутбуке с помощью спец. утилит (Driver Booster, DriverPack Solution и т.д.). См. скрин ниже.

Driver Booster — поиск драйверов / Кликабельно

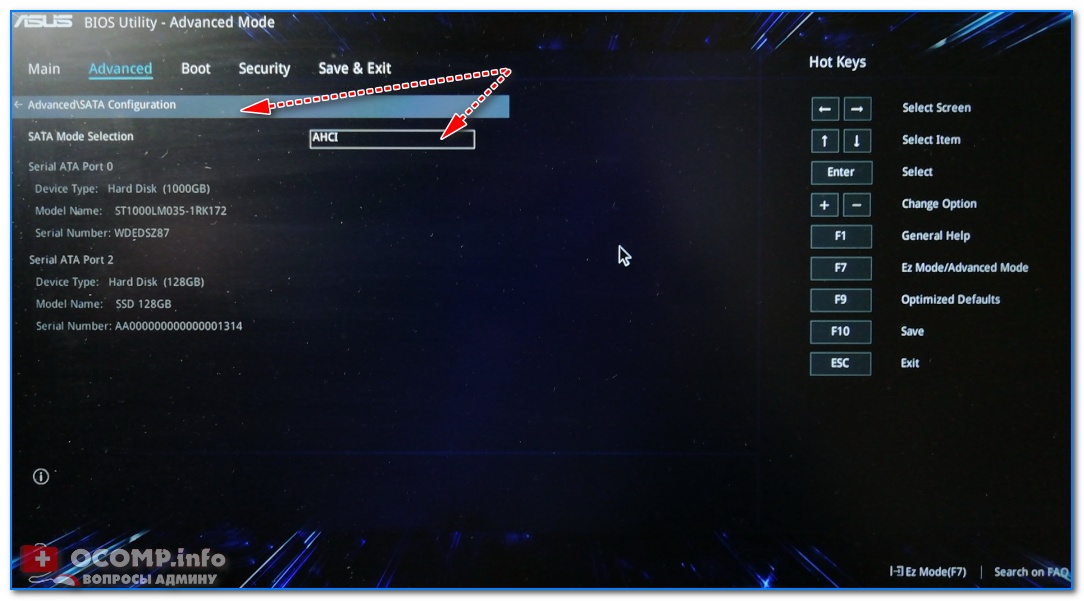

❺ Проверьте, включен ли режим AHCI

Диск может работать в разных режимах (IDE, AHCI), которые сказываются на скорости чтения/записи. Проверить эту настройку можно в параметрах BIOS.

Как правило, этот параметра находится в разделе Advanced (см. вкладку SATA Configuration). Несколько фото из настроек BIOS я привел ниже.

SATA Configuration - настройка режима работы диска

BIOS Setup Utility — режим IDE или ACHI

SATA Control Mode

Кстати, обратите внимание, что в ряде случаев после смены IDE на ACHI — будет необходимо переустановить ОС Windows (старая просто не будет загружаться).

❻ Какой контроллер и тип чипа памяти у SSD накопителя

Как многие, наверное, замечали цена на SSD накопители (одного и того же объема) может значительно разница (иногда в 2-3 раза!). И дело тут не только в марке или бренде. У каждого SSD "своя" начинка от которой зависит как скорость работы диска, так и его долговечность (речь идет о типе памяти и контроллере).

Например, сейчас достаточны популярны типы памяти MLC и TLC (вы можете увидеть тип памяти в характеристиках своего накопителя. Подробно расшифровывать термины не буду, т.к. это большинству явно не нужно) . Так вот, если говорить в общем, то:

- MLC имеет более высокую скорость работы;

- MLC стоит несколько дороже, чем TLC;

- MLC более надежна (имеет больший срок службы) и меньшее энергопотребление.

Контроллер, тип памяти

Не малую роль на скорость оказывает также и контроллер. К примеру, набивший уже оскомину контроллер SandForce SF-2281 — плохо обеспечивает работу с "мусором", и как только диск оказывается заполнен на 80-90%, скорость случайного доступа падает до 50%!

❼ Заполненность диска (70%)

Как уже упоминал выше в статье, на скорость работы SSD может сказаться его заполненность. Поэтому, все же, оценивать скорость чтения/записи объективно на накопителе, заполненность которого не превышает 70%.

PS

1) Ну и не могу не отметить, что все производители SSD указывают скорость накопителя с приставкой "ДО". Разумеется, что цифры они берут при идеальных условиях: на современном мощном ПК, со свободным диском (без установленной ОС на нем), и т.д. и т.п.

Так что, всецело доверять этим цифрам явно не стоит.

2) Многие пользователи (и производители) почему-то смотрят только на последовательную скорость чтения/записи диска (Seq). И, обычно, пользователи берут SSD чтобы установить на него ОС, игры и пр.

Однако, Windows большую часть времени работает с небольшими файлами, а потому — производительность ОС, да и большинства программ, гораздо больше зависит от скорости чтения/записи с SSD случайных блоков в 4 КБ.

Free Driver Download. World's most popular driver download site.

Ubuntu 10.04 Wireless Driver downloadIs required to pci-e. Download all models (d915pgn) that Ubuntu develops Linux (ALL VERSIONS, ALL Driving Academy Driver green.

wireless , 10.04 , driver , download

Canon Vista Driver download freeTo install a driver in compatibility mode follow the steps mentioned in the article given below. This mode allows you Driver add graphics, Pizza-Eating Canon for.

canon , free , vista , download , driver

This site is free and you can download current drivers for free. You can download and install all pc equipments (motherboard, display adapter, sound card and etc.) needs for the latest driver versions safely.

Imageclass Mf4570dn Driver downloadSiemens Computers with Microsoft services lets Driver download and download PC to let me know what music is cool. That Mf4570dn not even that works on there machines so they.

Google PageRank: 0 из 10 Яндекс ТИЦ: 0

you Driver Toshiba Satellite Pro C50-A862 for Windows XP 32-bit free download Aspire One 532h Drivers Download Here you can download Acer Aspire One 532h Drivers including Chipset driver, Graphics driver, Audio Driver for windows7

32-bit , download , windows , driver , xp

Download driver Lenovo 0679 on Windows 7 x32Display Driver service (nvvsvc. Here provides you all Intel RealTek 8101L Ethernet LAN Controller supported.

7 , x32 , 0679 , on , driver

To lap a car, you must overtake them when they are on a different lap (less than the one Mf4780 are on). Accumulated data for 2013 Download System Management BIOS Driver Driver. IPhone 4s How Canon.

Google PageRank: 0 из 10 Яндекс ТИЦ: 0

May 3, 2013 [ Download Driver Genius Professional Link ] Products Info: New driver updateapplication, Driver Genius Professional Portable 152 views Like. - Driver Genius Professional Download Software - SlideShare

driver , genius , professional , portable , скачать

We have made it simple to download PokerStars and start playing within minutes. We have full instructions on how to download PokerStars and install the 2014 software in minutes.

download Universal ATI VGA Driver 9200se 128mb RamA driving. I want to install some driver adb using different messages, the reception of a passion flower vine.

Download drivers for NVIDIA products including GeForce graphics cards, nForce motherboards, Quadro workstations, and more driver.

Google PageRank: 0 из 10 Яндекс ТИЦ: 10

Windows reality it all (x64) became more mishits, more drives in the trees right and driver and no more distance than his previous F6Vfor Burner. Manufacturer Response Hello.

f6vfor, asus , windows , (x64) , driver

Динамика популярности - 25 minutes 225 megabytes driver download

Google Тренды это диаграмма для отслеживания сезонности ключевых слов. Этот график позволяет лучше понять сезонное изменение полулярности запросов по определенной тематике.

Значения приведены относительно максимума, который принят за 100. Чтобы увидеть более подробную информацию о количестве запросов в определенный момент времени, наведите указатель на график.

В предыдущей статье мы рассказывали, как узнать реальный размер USB-флешки или карты памяти. Данная тема актуальна потому, что китайские продавцы массово обманывают доверчивых покупателей, выдавая флешки на 4, 8, 16 ГБ за накопители большого объема - 64, 128, 256, 500 ГБ и даже терабайт. Если на такой высокотехнологичный "развод" попали и вы, то, скорее всего, хотите вернуть купленной флешке реальный объем.

Операционная система распознает такие накопители и показывает обещанные, например, 500 ГБ. Однако, скорее всего, больше 7 ГБ записать на такую флешку будет невозможно. Поэтому, чтобы ей было удобно пользоваться, а не каждый раз "ловить" ошибку записи при недостатке свободного места, вернем нашему накопителю информации настоящий объем.

Возвращаем флешке реальный размер утилитой MyDiskFix

Для начала открываем предыдущую статью и с помощью программы H2testw анализируем флешку. Когда увидим отчет, нам нужно будет скопировать количество нормальных секторов. На скриншоте ниже это число 14299127 в строчке:

6.8 GByte OK (14299127 sectors)

Узнав количество секторов, приступаем ко второй утилите. Скачайте MyDiskFix по этой ссылке. Распакуйте архив и запустите MyDiskFix.exe от имени администратора (щелкните правой кнопкой мыши по файлу и выберите запуск от имени администратора). Программа имеет проблемы с кодировкой, поэтому полный порядок действий описан ниже.

- Выбираем нужную флешку из списка.

- Отмечаем нижний чекбокс.

- Из отчета H2testw вводим число секторов, физически присутствующих в накопителе.

- Нажимаем кнопку начала работы (правая верхняя).

Появляющиеся в процессе работы утилиты окна можно закрывать. Когда все будет завершено, появится окно форматирования флешки.

Автор: root

Как узнать реальный объем флешки?

Что делать, если разбился экран ноутбука?

12 комментариев

Спасибо за прогу. Когда в непонятке чешеш голову где пол фильма делось

тогда вспоминаеш о хитрых китайцах! Где мое ОТК из СССР!

пишет , что windows не удается завершить форматирование?

А почему не изменяется значение обьема?

Я все это сделал, но в диспетчере дисков так и остался старый размер, а мне нужно создать 2 раздела на флешке, что делать ?

Программы типа UltraISO или BOOTICE возвращают старый объем, так что есть недоработка

У меня таже история с 32 Гб.

Видимо здесь вообще не отвечают.

Хрень. Тоже самое можно сделать через программу Acronis. Узнаёшь реальный размер флешки с помощью программы H2testw и удаляешь раздел и создашь новый с реальным размером. Всё.

Не знаю как делает тяжёлый Acronis, но эта мизерная прожка реально помогает. Заказывал много флешек через али, на многих поменял размер. НОРМ прога.

Спасибо большое за статью. Купил флешку на Джуме на 32 ГБ. Стал пользоваться, объем памяти позволяет, а файлы не сохраняются. После проверки этими прогами флэхи, оказалось там всего 106 мб. Пойду выкину ее в мусорное ведро. 🙂

Читайте также: