Depo storage 6212 sas подключение

Обновлено: 04.07.2024

| DEPO Storage 4712G2 | NetApp E2812 |

| DEPO Storage 4724G2 | NetApp E2824 |

| DEPO Storage 4760G2 | NetApp E2860 |

| DEPO Storage 4924G2 | NetApp E5724 |

| DEPO Storage 4960G2 | NetApp E5760 |

| DEPO Storage 4724F | NetApp EF280 |

| DEPO Storage 4924F | NetApp EF570 |

| DEPO Storage 5112 | NetApp FAS2720 |

| DEPO Storage 5124 | NetApp FAS2750 |

| DEPO Storage 5124F | NetApp AFF A220 |

| DEPO Storage 5820 | NetApp FAS8200 |

| DEPO Storage 5900 | NetApp FAS9000 |

- Техническая поддержка общается с заказчиками на русском языке, работает в комфортном для России режиме с 8:00 до 20:00 по Мск, 7 дней в неделю (включая субботу и воскресенье), что позволяет осуществить поддержку всех без исключения регионов нашей Родины;

- При окончании гарантии мы продолжаем осуществлять консультации клиентов, которые приобрели наши СХД;

- Для определённых гарантийных планов запасается ЗИП, что позволяет более оперативно принимать решения о замене з/ч;

- Мы обладаем самой крупной сетью авторизованных центров в стране по обслуживанию серверного оборудования (более 180)

- Мы имеем оборудование NetApp для проведения стендирования проблем заказчиков;

- В связи с тем, что у нас множество клиентов, приобретающих ОЕМ продукцию, мы являемся крупным заказчиком для NetApp, что помогает обращать на наши тикеты больше внимания, нежели на отдельные проекты, отдельных заказчиков; (дополнение от меня: здесь идёт речь о привлечении саппорта NetApp в случае возникновения проблем, с которыми не сможет справится поддержка DEPO)

Aquarius

Компания Aquarius предлагает своим потребителям OEM системы DellEMC DataDomain и различные системы компании HPE.

| Aquarius Array FB40 D2200 | Dell EMC DD2200 |

| Aquarius Array FB40 D6300 | Dell EMC DD6300 |

| Aquarius Array FB40 D6800 | Dell EMC DD6800 |

| Aquarius Array FB40 D9300 | Dell EMC DD9300 |

| HT StoreServ 8000 | HPE 3PAR StoreServ 8000 |

| HT StoreServ 20000 | HPE 3PAR StoreServ 20000 |

| НТ Array 2050 | HPE MSA 2050 |

| НТ Array 2052 | HPE MSA 2052 |

| VirtualArray 4330 | HPE StoreVirtual 4330 |

| HT Flash Array | HPE Nimble Storage |

| HT Intelligence Array 600 | HPE Primera 600 |

SITONICA

Компания SITONICA на Российском рынке предлагает системы IBM Storwize и FlashSystem

| SITONICA ST30 | IBM Storwize V3700 |

| SITONICA ST50 | IBM Storwize V5030 |

| SITONICA ST51 | IBM Storwize V5100 |

| SITONICA ST70 / ST71 | IBM Storwize V7000 |

| SITONICA ST90 | IBM FlashSystem 900 |

| SITONICA ST91 | IBM Storwize V5100F |

| SITONICA STSV | IBM SVC |

| SITONICA STV90 | IBM FlashSystem A9000 |

Булат

А вот компания Булат заявила, что производит только свои собственные системы. Нет, может быть дело конечно в администраторе сайта, который вовремя не убрал оттуда модели Huawei и IBM, но кажется всё-таки зрение меня пока ещё не подводит и это именно они.

К сожалению, с сопоставлением моделей всё оказалось в данном случае очень сложно. Во-первых, для некоторых моделей очень плохо указаны характеристики, где-то указаны очень подробно и распознать модель не составляет труда, где-то указаны только общие параметры типа размера, веса, поддерживаемых протоколов и кол-ва дисков, а где-то вообще упор сделан на описание программного обеспечения. Да и судя по характеристикам некоторых моделей, там не то что актуальная линейка V5 (хотя уже нельзя назвать V5 актуальной линейкой, в России уже доступны системы V6, хотя на сайте Huawei российском пока ещё висят модели V5), а V3 прослеживается. В любом случае, если кто то может помочь в более точном определении моделей, прошу написать мне на почту или в комменты, буду очень благодарен за помощь.

Сила

Компания Сила предлагает своим потребителям OEM системы DellEMC.

| СИЛА CX4-1127-00 | Dell EMC Data Domain DD9800 |

| СИЛА CX3-1043 | Dell EMC SCv3000 |

| СИЛА СХ3-1045 | Dell EMC SC5020 |

| СИЛА СХ2-1033 | Dell EMC Unity 300 |

| СИЛА СХ2-1035 | Dell EMC Unity 500 |

| СИЛА СХ2-1124 | Dell EMC Data Domain DD6300 |

| СИЛА СХ2-1133 | Dell EMC Unity 350F |

| СИЛА CX2-1036 | Dell EMC Unity 600 |

| OKA SC20v | Dell SCv2000 |

| OKA SC32 | Dell EMC SCv3000 |

| ОКА SC72 | Dell EMC SC7020 |

| ОКА FS86 | Dell Compellent FS8600 |

| OS55 | Huawei OceanStor 2600 V3 |

Цифра

Цифра предлагает своим потребителям OEM системы Huawei.

| Si30 | Huawei OceanStor Dorado 3000 V6 |

| Si50 | Huawei OceanStor Dorado 5000 V6 |

| Si60 | Huawei OceanStor Dorado 6000 V6 |

| Si80 | Huawei OceanStor Dorado 8000 V6 |

| Si180 | Huawei OceanStor Dorado 18000 V6 |

| Cr53 | Huawei OceanStor 5300 V5 |

| Cr55 | Huawei OceanStor 5500 V5 |

| Cr56 | Huawei OceanStor 5600 V5 |

| Cr58 | Huawei OceanStor 5800 V5 |

| Cr68 | Huawei OceanStor 6800 V5 |

Если вы знаете, какого-либо ещё ОЕМ производителя, также приглашаю в комментарии, дабы можно было пополнить эту статью.

Небольшие компании как правило сталкиваются с одной и той же проблемой: желание развивать ИТ-инфраструктуру упирается в ограниченный бюджет. В итоге из всего желаемого набора — отказоустойчивый кластер серверов, система хранения данных и т.п. — приходится выбирать что-то одно, со временем внедряя другие компоненты. Впрочем, как говорят, даже если вас съели, у вас есть два выхода.

В этой статье описан процесс создания фермы виртуализации на базе кластера Hyper-V, разворачиваемого на модульном сервере Depo Storm 5306M. Сервер хорош тем, что сочетает в себе всю необходимую инфраструктуру: вычислительные модули, СХД, сетевой коммутатор — эдакий data-center-in-a-box. А в качестве операционной системы будет использоваться бесплатный Hyper-V Server 2008 R2.

Начнем с конфигурации СХД. По умолчанию веб-интерфейс шасси находится по адресу 192.168.150.150

Чтобы один LUN можно было назначать нескольким серверам, необходимо активировать ‘Intel Shared LUN’.

Далее в разделе System\Storage (кнопка ‘Create Storage Pool’) создаем storage pool’ы. В окне выбора дисков, участвующих в пуле, выбираем необходимые носители, задаем имя и жмем кнопку ‘Create’.

Первый пул — System — для дисков, на которые будет ставиться ОС. Второй пул – Cluster — для кворума и общего хранилища кластера.

Сначала создаем виртуальные диски для системы. Выбираем нужный пул и в правом меню нажимаем ‘Create Virtual Drive’. В открывшемся окне указываем имя диска, уровень рейда, размер диска (максимальный размер автоматически пересчитывается в зависимости от выбранного уровня рейда), обязательно ставим галочку ‘Initialize Boot Sector’. Назначаем диск нужному серверу и выбираем номер диска 0 (boot device). В итоге должно получиться примерно следующее:

Создаем и назначаем диски для всех серверов. Пул Cluster пока что оставляем неразмеченным — создавать и подключать диски будем после установки ОС на все серверы, к чему и приступим.

Подключаем USB-дисковод к передней панели сервера (можно, конечно, подключиться и к модулю управления сзади шасси, это избавит от необходимости включать дисковод в каждое лезвие, но по личным ощущениям через передний USB-разъем Windows ставится немного быстрее).

Заходим в раздел ‘Servers’ и запускаем сервер кнопкой ‘Power On’.

Когда сервер включился, нажимаем кнопку ‘Remote KVM & CD’ и открываем консоль сервера (для этого на компьютере должно быть установлено Java Runtime Environment 6 или новее). В открывшемся окошке нажимаем кнопку ‘Apply’.

Появится примерно такое окно:

Далее все как с обычным компьютером: заходим в boot-меню, выбираем загрузку с подключенного дисковода, устанавливаем ОС Hyper-V Server 2008 R2.

После установки откроется консоль ‘sconfig’ (в платных редакциях консоль запускается командой ‘sconfig’):

Сначала выбираем пункт ‘8) Network Settings’:

Первому адаптеру назначаем адрес из сети, в которой будет работать кластер (не забываем про DNS), второй настраиваем для heartbeat.

Далее в разделе ‘1) Domain/Workgroup’ вводим компьютер в домен и переименовываем его.

Перезагружаемся, входим в систему под аккаунтом администратора домена и вводим команду ‘netsh advfirewall set allprofiles state off’ (внимание, эта команда отключает все профили фаервола).

Снова заходим в sconfig и выбираем ‘4) Configure Remote Management’:

Активируем пункты 1, 2, 3 и опять перезагружаемся.

Активируем опцию ‘11) Failover Clustering Feature’. Переходим к настройке общего хранилища в веб-интерфейсе шасси. В пуле Cluster создаем 2 диска: Quorum (2 Гб) и Data. Ставим галочку ‘Assign to multiple servers’ и назначаем серверs, для которых диск будет общим.

Приступим к инициализации дисков на узлах кластера. Для этого нам понадобится находящийся в домене компьютер с установленным полноценным Windows server 2008r2 или Windows 7 с RSAT. Подключаемся к серверам через консоль MMC, добавляем оснастку Disk Management.

Переводим все диски в режим online, инициализируем их и форматируем (New Simple Volume) в NTFS. Переводим диски в режим offline. Повторяем процедуру на всех узлах кластера (уже без форматирования).

Теперь запускаем на сервере управления оснастку ‘Failover Cluster Manager’ (если ее нет, то устанавливаем через Server Manager или командой ‘start /w ocsetup FailoverCluster-FullServer’). Нажимаем кнопку ‘Validate a Configuration…’, чтобы проверить кластер на работоспособность.

Указываем участников кластера и выбираем ‘Run All Tests (recommended)’. Изучаем результаты и если ничего серьезного не обнаружено, нажимаем ‘Create a Cluster…’. Вводим узлы и назначаем имя и IP-адрес кластера.

Далее Next, Next и смотрим результат.

Включаем опцию ‘Enable Cluster Shared Volumes…’

… и добавляем туда общий диск, он у нас должен остаться один. 2Гб-раздел автоматически назначается кластером для кворума.

В результате должно получиться что-то похожее:

Вот так легко и непринужденно можно развернуть многофункциональное отказоустойчивое серверное решение.

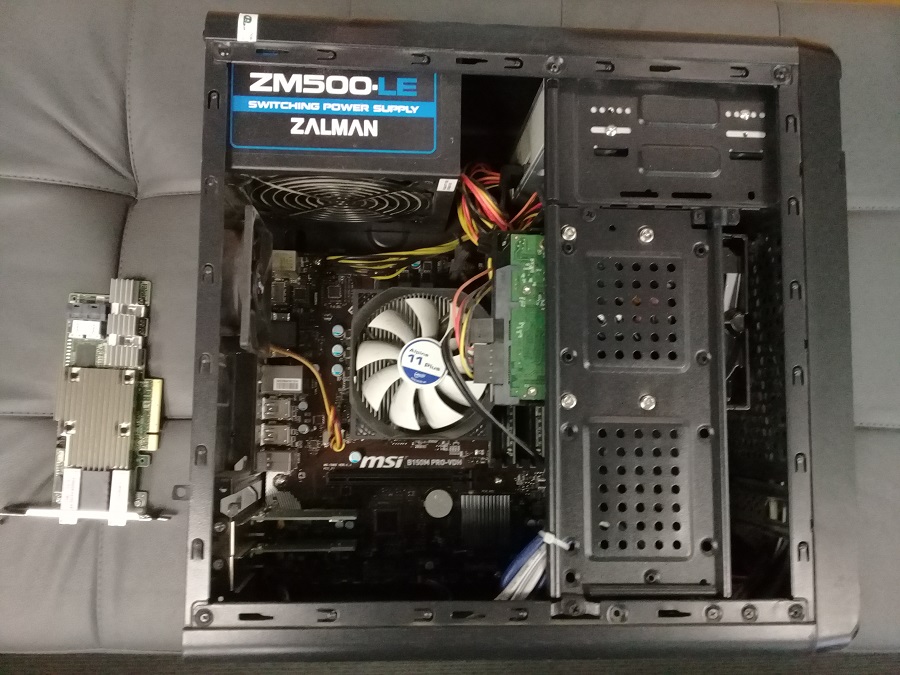

Всем привет, сегодня у нас маленький эксперимент по подключению SAS дисков к обычному персональному компьютеру. Обычно в компьютер можно установить только SATA диски, так как на материнской плате есть встроенный SATA контроллер. А SAS диски в обычный ПК не вставишь.

Дело в том, что SATA контроллер поддерживает только SATA диски. А SAS контроллер может поддерживать и SAS диски и SATA диски. SAS обратно совместим с интерфейсом SATA: устройства 3 Гбит/с и 6 Гбит/с SATA могут быть подключены к контроллеру SAS, но не наоборот.

SATA (Serial ATA) — последовательный компьютерный интерфейс обмена данными с накопителями информации. Предназначен для настольных ПК.

- SATA Revision 1.0 — до 1,5 Гбит/с

- SATA Revision 2.0 — до 3 Гбит/с

- SATA Revision 3.0 — до 6 Гбит/с

SAS (Serial Attached SCSI) — последовательный компьютерный интерфейс, разработанный для подключения различных устройств хранения данных, например, жёстких дисков и ленточных накопителей. Последняя реализация SAS обеспечивает передачу данных со скоростью до 12 Гбит/с на одну линию. Предназначен для серверов.

SAS не предназначен для настольных ПК, но иногда очень надо. Мне, например, по работе требуется иногда работать с SAS дисками. Подключаем SAS диск к ПК.

Что нужно для подключения SAS диска к ПК

Потребуется обычный ПК. Поскольку SAS контроллера на обычном ПК нет, то нам потребуется такой контроллер. Я попробую два варианта:

-

— это полноценный RAID контроллер, позволяющий объединять диски в RAID массивы. — это простой адаптер HBA, он не умеет объединять диски в RAID массивы. Вернее умеет, но со специальной прошивкой и не так хорошо как нормальный RAID контроллер.

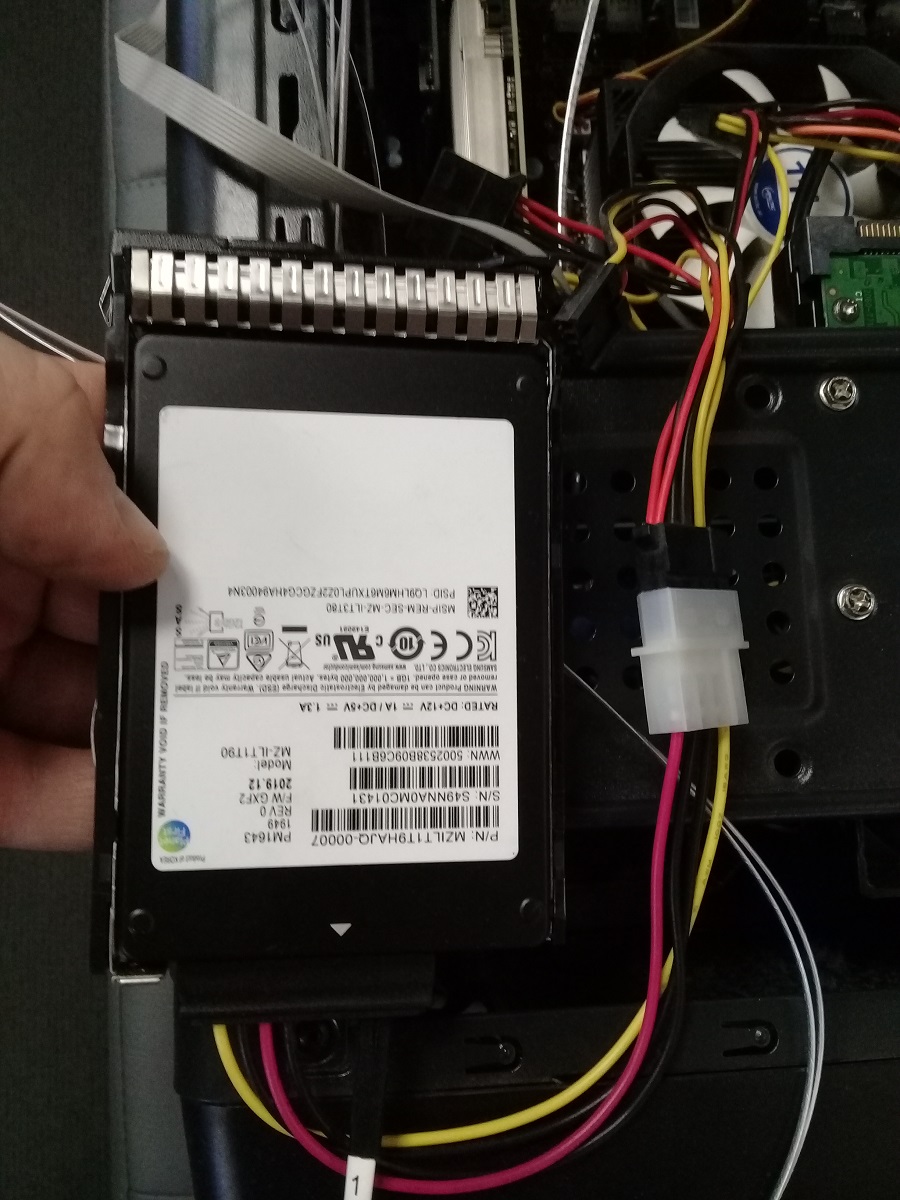

Для подключения дисков к контроллеру без использования корзины потребуется кабель переходник. Купил такой:

Переходник позволяет подключить 4 HDD с интерфейсом SAS или SATA к контроллеру с разъемом SFF-8643. Питание подаётся на каждый диск через 4-pin Molex.

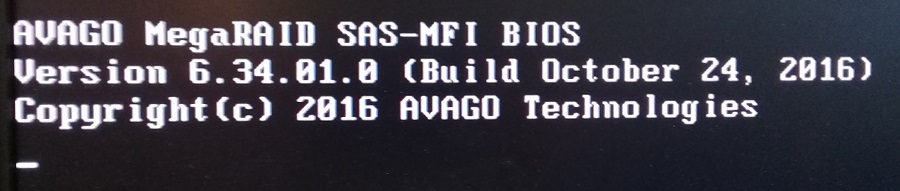

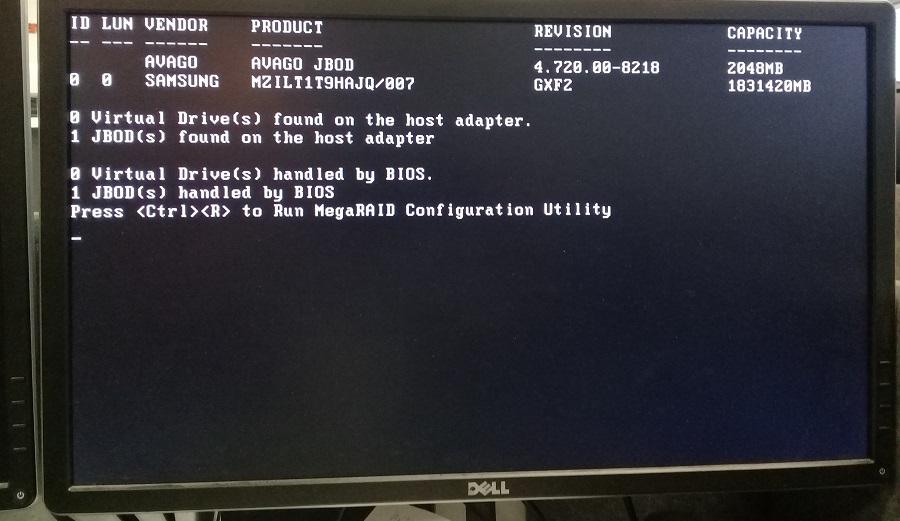

Подключение SAS диска через RAID контроллер Avago MegaRAID SAS 9380-8i8e

Готовим корпус ПК.

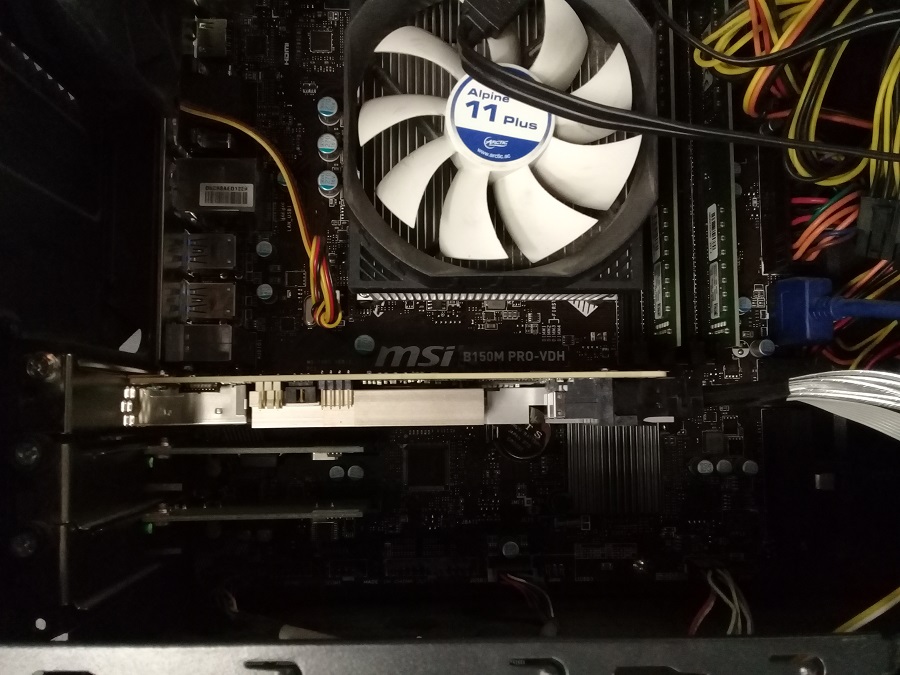

Устанавливаем контроллер в PCIe слот.

Подключаем диск через переходник.

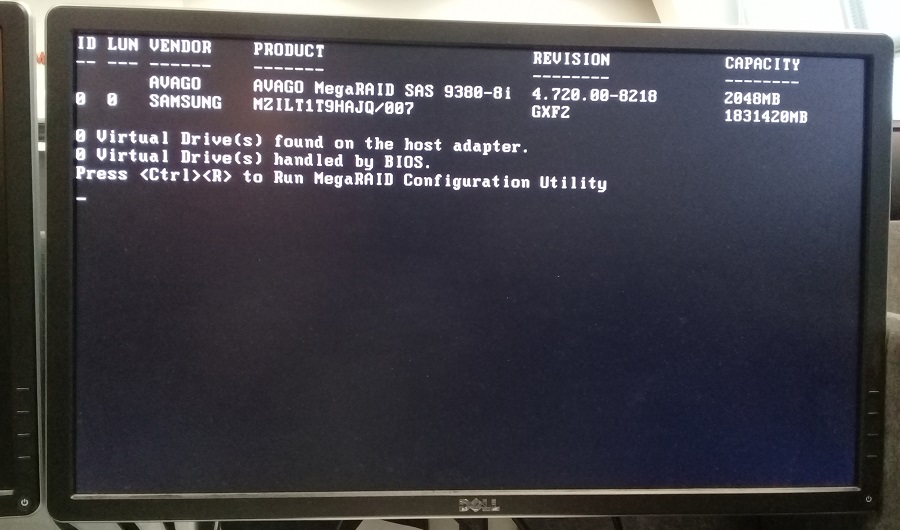

RAID контроллер определился. Видим, что диск SAMSUNG тоже определился.

Для доступа в конфигурационную утилиту MegaRAID Configuration Utility нажимаем Ctrl+R.

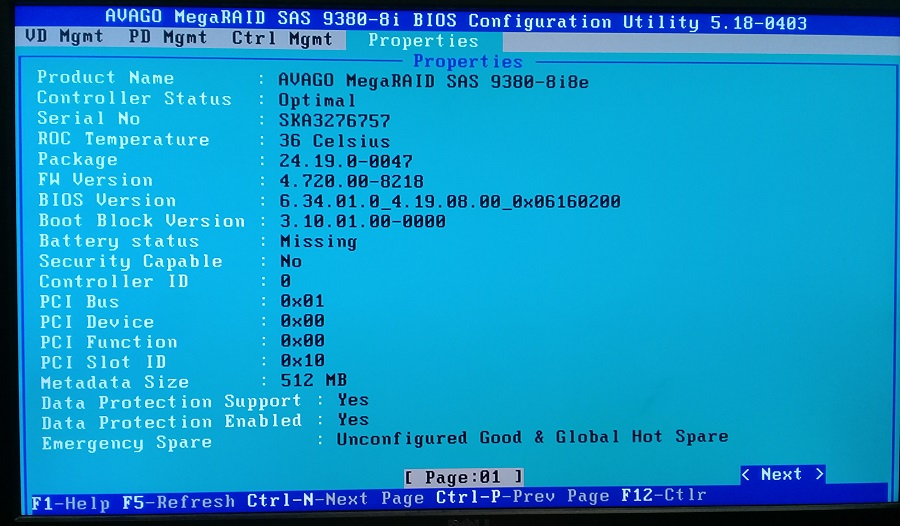

Можем посмотреть настройки контроллера.

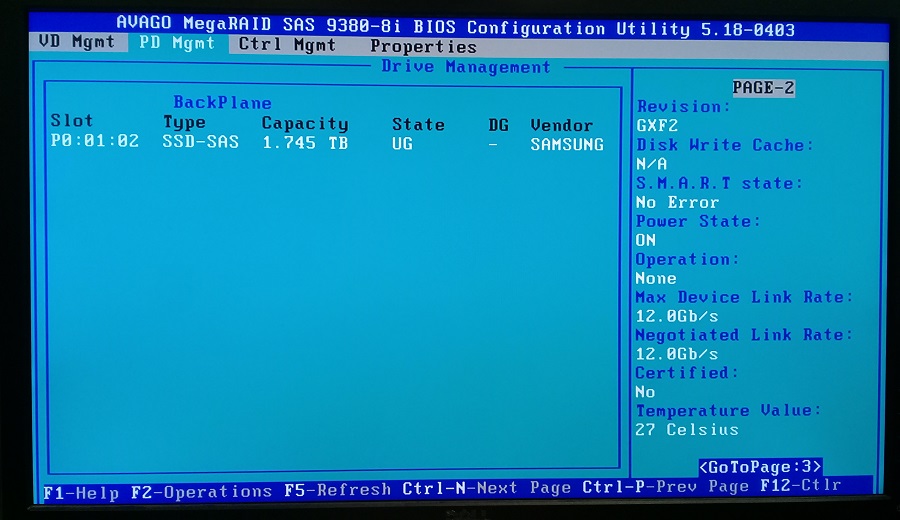

Можем посмотреть физические диски. Я подключал только один диск, он определился. Обратите внимание, что состояние диска UG — Unconfigured Good.

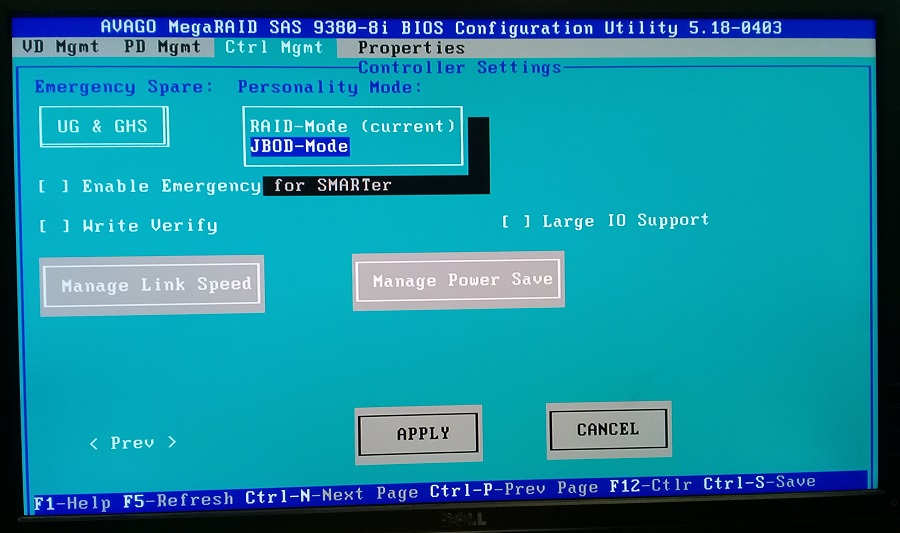

RAID контроллер по умолчанию показывает операционной системе не физические диски а RAID массивы. Я же хочу просто пробросить диск. Для этого необходимо RAID контроллер переключить в режим HBA.

В настройках контроллера меняем режим на JBOD-Mode. Применяем изменения и перезагружаем компьютер.

При загрузке уже 1 JBOD найден и handled by BIOS, это уже хорошо. Для проверки снова зайдем в настройки контроллера.

Алгоритм подключения системы хранения данных к хосту достаточно универсален. Безусловно, существуют нюансы настройки, которые зависят от конкретного оборудования и топологии вашей сети.

Создание SAN является сложной задачей. Если это ваш первый опыт, обратитесь к специалистам ВИСТЛАН за консультацией, помощью в проектировании системы и подборе оборудования

Подключение СХД к хосту делится на два этапа:

Физическое соединение.

Настройка.

Перед началом внимательно ознакомьтесь с документацией производителя на полку. Она подробно описывает все действия. Пример документации от Oracle .

Техническая информация

SAN состоит из нескольких HDD и контроллеров. Для равномерного распределения нагрузки и обеспечения надёжности стараются использовать два HBA (Host Bus Adapter), несколько путей ввода-вывода, как минимум два интерфейса.

Главным правилом подключения СХД к хосту является использование как минимум двух связей и путей для каждого устройства.

Свичи обеспечивают для серверов доступ только к предназначенным им ресурсам. Для этого в SAN каждому интерфейсу и каждому LUN-у присваивается World Wide Name (WWN) — подобие MAC-адреса.

LUN — Logical UNit — с точки зрения контроллера — это аналог раздела на жёстком диске. Сервер видит их как физические диски. Можно подключить все хосты к одному диску или раздать LUN-ы по серверам.

Распределение выполняется в Disk Manager конкретного сервера или с помощью утилит (LAN Mapping, SAN Mapping и т.п) хосту принудительно запрещается видеть LUN.

Не вешайте все LUN-ы на один контроллер. Разделите особо нагруженные LUN-ы по разным.

При создании SAN можно использовать разные типы HDD. Помедленнее и подешевле, типа SAS или SATA, — для ОС сервера и файловых ресурсов; FC — для скоростных приложений и баз данных.

Алгоритм подключения

В сервер установите HBA-контроллер.

Подключите СХД с помощью кабелей соответствующих интерфейсам, установленным на дисковой хранилище (FC, SAS, SCSI) по вашей схеме.

Проведите настройку сети, правильно установите типы используемых портов для оптической сети.

Скачайте с сайта производителя ПО. Однако, оно может идти в комплекте, но это не обязательно.

Установите ПО. Пройдите регистрацию, если требуется.

Включите HBA хоста и дисковую полку в одну подсеть на одном физическом коммутаторе.

Запустите утилиту сканирования SAN для определения топологии. Она покажет все устройства и их номера.

Зарегистрируйте хост на полке. Это можно сделать с помощью утилиты или вручную через веб-интерфейс полки. Автоматически — корректней.

Введите в браузере IP-адрес хоста и сделайте привязку полки. При первом подключении может понадобиться создать пароль админа.

Зайдите в систему управления дисками на хосте, убедитесь, что подключенные диски видны. Они выглядят там как обычные SCSI.

Перейдите по IP-адресу СХД в браузере. Проверьте наличие серверов, регистрация которых уже выполнена.

Найдите вкладку с инициаторами, связывающими хосты с блоками СХД. Проверьте IP-адреса. Если нужно, перенастройте их вручную.

Свяжите LUN-ы и хосты. Действия типа: Create -> Connect LUNs -> Connect Hosts.

Посмотрите наличие отметки около HBA, сигнализирующей о корректности подключения.

На этом настройка полки закончена.

Нарежьте диски на LUN-ы. Их можно сделать много. Оставьте около 1 Гб свободного места

Переведите диски в режим онлайн. Буквы не присваивайте.

Отформатируйте диски в нужный формат, например, NTFS.

Установите драйверы HBA (FC, SAS или SCSI).

Подключение завершено. Можно управлять системой с помощью специального софта или через веб-интерфейс.

Рекомендации

Если СХД только создаётся, имеет смысл использовать оборудование одного производителя, чтобы избежать проблем с совместимостью устройств.

Во избежание всяких неприятных ситуаций лучше сразу обратиться к системному интегратору, например, к нам.

Это можно не делать, если у вас в штате есть несколько опытных и толковых администраторов, у которых много свободного времени. Хотя, по деньгам вы здесь вряд ли выиграете, так как их работа оплачивается, а также нужно будет приобретать нужные комплектующие и пытаться их «подружить».

Дисковая полка конструктивно состоит из жёстких дисков и источника бесперебойного питания. Его основная функция — не питать систему в случае отключения электричества, а предоставление возможности СХД корректно завершить все операции ввода-вывода при выключении полки. Поэтому, для защиты сторейджа по питанию устанавливайте ИБП.

По FC можно подключиться к коммутатору и тем самым расширить количество используемых устройств. На SAS нельзя повесить серверов больше, чем есть портов на массиве.

Покупайте полку сразу с дисками.

Не подключайте несколько хостов к одному LUN-у, если у вас не кластер. Такое соединение создает несогласованность записи, что приведёт к повреждению данных.

Сервис — очень важная вещь в СХД. Так как стоимость и масштаб потерь велики, не скупитесь, заключите договор с интегратором на обслуживание. В результате вы сэкономите время, нервы и, как ни странно, деньги.

Читайте также: