Есть ли пределы развития и миниатюризации компьютеров

Обновлено: 04.07.2024

Рано или поздно рост производительности компьютеров остановиться по чисто физическим причинам. Сейчас рост производительности достигается за счёт все большей миниатюризации — уменьшения размеров транзисторов, что позволяет разместить в одном кубическом сантиметре больше количество логических элементов.

Однако миниатюризация не может продолжаться бесконечно. Уже в 2021-м году ожидается появление процессоров сделанных по 3-х нанометровому технологическому процессу, т.е. минимальный размер элемента составляет 3 нанометра. Для сравнения размер атома кремния, повсеместно используемого при изготовлении процессоров составляет 0.21 нанометра. Очень скоро мы упрёмся в ограничения связанные с атомарной структурой вещества.

Миниатюризация электроники приближается к своему пределу Миниатюризация электроники приближается к своему пределуВ связи с этим квантовые компьютеры многие рассматривают как возможную в будущем замену традиционным электронным компьютерам.

Что такое квантовый компьютер?

Если очень коротко: квантовый компьютер, это вычислительное устройство, использующее некоторые эффекты квантовой механики , такие как суперпозиция и квантовая запутанность для хранения информации и вычислений.

В квантовых компьютерах информация хранится в квантовых битах – кубитах (QuBit - quantum bit).

Если обычный бит может принимать два строго определённых состояния: 0 и 1, то квантовый бит является вероятностным: он находится в суперпозиции двух возможных состояний: α|0⟩+β|1⟩ где α и β соответственно являются вероятностями обнаружить кубит в состоянии |0⟩ или |1⟩ соответственно.

В теории это может позволить обрабатывать одновременно все возможные состояния объекта и позволит получить большое преимущество над классическими компьютерами при решении некоторых классов задач.

Что по быстродействию?

Существует распространённое заблуждение, что квантовые компьютеры обладают намного большим быстродействием, чем традиционные.

Это не так. На самом деле все современные квантовые компьютеры в тысячи и десятки тысяч раз медленнее обычных электронных компьютеров.

Нет, это не люстра. Это квантовый компьютер разработки IBM Нет, это не люстра. Это квантовый компьютер разработки IBMОднако существует отдельный класс задач, с которыми квантовые компьютеры благодаря особенностям своего устройства справляются быстрее, а иногда даже намного быстрее .

Классическим примером такой задачи является факторизация целых чисел (в особенности очень больших чисел), т.е. разложение их на простые множители. Эта задача особенно важна в современной криптографии, так как многие алгоритмы шифрования основаны на том, что факторизация очень больших чисел является непосильной задачей для современных цифровых компьютеров.

Развитие квантовых вычислений может быть опасно например для держателей криптовалют, так как появление быстрых способов разложения больших целых чисел на множители скомпрометирует все основные алгоритмы шифрования. Развитие квантовых вычислений может быть опасно например для держателей криптовалют, так как появление быстрых способов разложения больших целых чисел на множители скомпрометирует все основные алгоритмы шифрования.Поэтому квантовые компьютеры представляют угрозу для практически всех существующих на данный момент алгоритмов шифрования и систем электронной безопасности.

Какие перспективы?

Критическим моментом в развитии квантовых вычислений является их помехоустойчивость. Информация хранящаяся в кубитах (квантовых битах) подвержена компрометации из-за декогеренции несущих информацию частиц в результате взаимодействия с другими частицами.

Основные надежды связаны с так называемой квантовой пороговой теоремой (Quantum Threshold Theorem), которая гласит, что если удастся создать квантовую схему с достаточно высоким уровнем точности, то с помощью неё можно будет смоделировать квантовый компьютер точность которого будет 100%.

Насчёт принципиальной разрешимости этой задачи есть разные мнения. Многие специалисты считают, что это всего-лишь вопрос времени. Другие смотрят на это довольно скептически.

IBM Q System One – первый коммерческий квантовый компьютер IBM Q System One – первый коммерческий квантовый компьютерОднако даже если пороговая точность квантовых микросхем будет достигнута и мы получим способ создавать надёжные квантовые компьютеры, всё равно я не ожидаю, что они полностью заменят обычные цифровые компьютеры.

Дело в том, что квантовые и цифровые компьютеры имеют разные области применения. Квантовые компьютеры не имеют никаких преимуществ перед цифровыми в решении задач, для которых существуют эффективные вычислительные алгоритмы.

Наиболее вероятным вариантом развития событий мне видится появление гибридных, квантово-цифровых компьютеров, в которых в дополнение к обычному центральному процессору будет использоваться квантовый сопроцессор, которому основной процессор будет делегировать сложные задачи, как например уже упоминавшаяся выше задача факторизации больших целых чисел.

Информационные технологии за последнее десятилетие в своем развитии сделали такой гигантский скачок вперед, что предсказать, каким будет, например, персональный компьютер лет через пять, мало кто решится.

Содержание

Введение. с.3

Глава 1 . История развития и перспективы молекулярной электроники

1.1 “Прошлое” молекулярной схемотехники. с.5

1.2 Существующие научные разработки молекулярных компьютеров. c.6

3. Абстракционное “конструирование” молекулярного компьютера. с.7

1.4 Есть ли у молекулярных компьютеров будущее. с.10

Глава 2 . Квантовые компьютеры – миф или грядущая реальность ?

2.1 История развития теории квантовых вычислительных устройств. с.12

2. Производство квантовых компьютеров:технологические трудности и перспективы. с.14 a. a) Предел первый быстродействие. с.15 b) Предел второй : память. с.16 b. c) Перспективы развития квантовых

ЭВМ. с.17

Заключение. с.19

Библиография. с.21

Работа состоит из 1 файл

про компьютеры.docx

Законы квантовой механики составляют фундамент изучения строения вещества. Они позволили выяснить строение атомов, установить природу химической связи, объяснить периодическую систему элементов, понять строение атомных ядер, изучать свойства элементарных частиц.

Ряд крупнейших технических достижений 20 в. основан на специфических законах квантовой механики, которая, в частности, создала фундамент для такой бурно развивающейся области физики как квантовая электроника и заложила основы для формирования теории квантовых вычислений.

В 1960-е годы американский физик Р.Ландауэр, работавший в корпорации IBM, пытался обратить внимание научного мира на то, что вычисления – это всегда некоторый физический процесс, а значит, невозможно понять пределы наших вычислительных возможностей, не уточнив, какой физической реализации они соответствуют [2].

К сожалению, в то время среди ученых господствовал взгляд на вычисление как на некую абстрактную логическую процедуру, изучать которую следует математикам, а не физикам.

По мере распространения компьютеров ученые, занимавшиеся квантовыми объектами, пришли в выводу о практической невозможности напрямую рассчитать состояние эволюционирующей системы, состоящей всего лишь из нескольких десятков взаимодействующих частиц, например молекулы метана (CH4). Объясняется это тем, что для полного описания сложной системы необходимо держать в памяти компьютера экспоненциально большое (по числу частиц) количество переменных, так называемых квантовых амплитуд. Возникла парадоксальная ситуация : зная уравнение эволюции, зная с достаточной точностью все потенциалы взаимодействия частиц друг с другом и начальное состояние системы, практически невозможно вычислить ее будущее, даже если система состоит из 30 электронов в потенциальной яме, а в распоряжении имеется суперкомпьютер с оперативной памятью, число битов которой равно числу атомов в видимой области Вселенной (!). И в то же время для исследования динамики такой системы можно просто поставить эксперимент с 30 электронами, поместив их в заданный потенциал и начальное состояние. На это, в частности, обратил внимание русский математик

Ю.И.Манин, указавший в 1980 году на необходимость разработки теории квантовых вычислительных устройств.[1] В 1980-е годы эту же проблему изучал американский физик П.Бенев, явно показавший, что квантовая система может производить вычисления, а также английский ученый

Д.Дойч, теоретически разработавший универсальный квантовый компьютер, превосходящий классический аналог. [1]

Большое внимание к проблеме разработки квантовых компьютеров привлек лауреат Нобелевской премии по физике Р.Фейнман. Благодаря его авторитетному призыву число специалистов, обративших внимание на квантовые вычисления, увеличилось во много раз.

В 1996 году коллега Шора по работе в Lucent Technologies

Л.Гровер предложил квантовый алгоритм быстрого поиска в неупорядоченной базе данных. (Пример такой базы данных – телефонная книга, в которой фамилии абонентов расположены не по алфавиту, а произвольным образом.) Задача поиска, выбора оптимального элемента среди многочисленных вариантов очень часто встречается в экономических, военных, инженерных задачах, в компьютерных играх.

Алгоритм Гровера позволяет не только ускорить процесс поиска, но и увеличить примерно в два раза число параметров, учитываемых при выборе оптимума. Реальному созданию квантовых компьютеров препятствовала, по существу, единственная серьезная проблема – ошибки, или помехи. Дело в том, что один и тот же уровень помех гораздо интенсивнее портит процесс квантовых вычислений, чем классических. Пути решения этой проблемы наметил в 1995 году П.Шор, разработав схему кодирования квантовых состояний и коррекций в них ошибок.

2.2 Производство квантовых компьютеров : технологические трудности и перспективы

Прототипы квантовых компьютеров существуют уже сегодня. Правда, пока что экспериментально удается собирать лишь небольшие регистры, состоящие всего из нескольких квантовых битов. Так, недавно группа, возглавляемая американским физиком И. Чангом (IBM), объявила о сборке

5-битового квантового компьютера. [4] Несомненно, это большой успех. К сожалению, существующие квантовые системы еще не способны обеспечить надежные вычисления, так как они либо недостаточно управляемы, либо очень подвержены влиянию шумов. Однако физических запретов на построение эффективного квантового компьютера нет, необходимо лишь преодолеть технологические трудности.

К таким трудностям (мы будем называть их пределами) можно отнести следующие :

a) Предел первый : быстродействие

Все логические операции, осуществляемые компьютером, основаны на переключении битов между условными значениями “0” и “1”, которым отвечают два устойчивых физических состояния. Во всех случаях скорость переключения битов и, следовательно, быстродействие вычислительного устройства определяются тем, насколько быстро протекает соответствующий физический процесс. Например, время переключения транзистора тем меньше, чем больше подвижность электронов в полупроводнике, скорость перехода молекулы из одной формы в другую определяется вероятностью этого события и т.д. Времена процессов переключения, как правило, очень малы (от 1 до 10-15 секунды). И все же они конечны.

С точки зрения квантовой механики, утверждает физик из

Массачусетского технологического института (США) Сет Ллойд, скорость вычисления ограничена полной доступной энергией [7]. В 1998 году это положение было теоретически доказано математиками из Массачусетского технологического университета (США) Норманом Марголусом и Львом

Левитиным. Им удалось показать, что минимальное время преключения бита равно одной четверти постоянной Планка, деленной на полную энергию:

Таким образом, чем больше энергия компьютера, используемая им для вычислений, тем быстрее он считает. По мнению Ллойда, “предельный” компьютер – это такой компьютер, вся энергия которого будет расходоваться только на вычислительный процесс.

Исходя из приведенного соотношения, оценим, к примеру, быстродействие некоторого гипотетического компьютера массой 1 килограмм, состоящего всего из одного бита. Как известно, полная энергия тела задается фундаментальным соотношением E=mc2, где m- масса объекта, с – скорость света в вакууме. Итого имеем 1017 Дж. Если бы всю эту энергию , “погребенную” в массе нашего компьютера, можно было бы использовать в вычислительном процессе, время переключения бита достигло бы фантастически малых величин порядка 10-51 секунды!

Полученное значение существенно больше “планковского промежутка времени”, (10-44 секунды) – минимального временного интервала, который, с точки зрения квантовой гравитации, требуется для протекания любого физического события.

Однако мы рассмотрели однобитный компьютер, в то время как на практике любой ЭВМ требуется не один, а множество битов. Если энергию нашего гипотетического компьютера распределить между миллиардами битов, время переключения уже каждого из них будет уже меньше планковского. Важно, что при этом общее число переключений всех битов за секунду останется прежним – 1051.

По сравнению с предельным компьютером Ллойда нынешние ЭВМ – просто черепахи : при тактовой частоте порядка 500 мегагерц типичный современный компьютер выполняет лишь 1012 операций в секунду.

Предельный компьютер работает в 1039 раз быстрее!. А если он будет весить не килограмм, а тонну, быстродействие возрастет еще в 1000 раз.

В чем причина медлительности современных ЭВМ? Все дело в том, считает Ллойд, что полезную работу в них совершают лишь электроны, перемещающиеся внутри транзисторов. Что касается основной массы компьютера, то она не только не используется как источник энергии, но, напротив, препятствует свободному движению носителей зарядов.

Единственная ее функция – поддерживать ЭВМ в стабильном состоянии.

Как избавиться от бесполезной массы? Надо превратить ее в кванты электромагнитного излучения - фотоны, которые, как известно, не имеют массы покоя (считается, что она равна 0). Тогда вся энергия, запасенная в массе, перейдет в энергию излучения, и компьютер из неподвижного серого ящика превратится в светящийся огненный шар! Как ни странно,но именно так может выглядеть предельный компьютер,считает

Ллойд. Его вычислительная мощность будет огромна: менее чем за одну наносекунду он сможет решать задачи, на которые у современных ЭВМ ушло бы время, равное жизни вселенной!

Однако, остается еще проблема ввода-вывода информации. Как бы мы не совершенствовали процесс ввода-вывода, описанная модель

“предельного” компьютера имеет один принципиальный недочет. Допустим, максимальный размер (например,диаметр) нашего компьютера равен 10 сантиметрам. Поскольку фотоны движутся со скоростью света, то все 1031 битов информации, хранящейся в нашем компьютере, не могут быть

“скачаны” из него быстрее, чем за время, требующееся свету для прохождения расстояния в 10 сантиметров – то есть за 3-10 секунды.Значит, максимальная скорость обмена информацией компьютера с внешним миром равна 1041 бит в секунду. А предельная скорость обработки информации, как мы уже выяснили раньше, составляет 1051 бит в секунду, что в десять миллиардов раз быстрее. Таким образом, необходимость связи компьютера с внешним миром, а также отдельных его частей друг с другом может приводить к существенным потерям в скорости вычислений. “Отчасти решить эту проблему можно, заставив куски копьютера работать независимо друг от друга, в параллели”,-отмечает

Есть ли способ повысить скорость ввода-вывода? ”Да,-говорит

Ллойд,-надо уменьшать размера компьютера.” Тогда обмен информацией будет происходить быстрее, а объем памяти станет меньше. При этом доля последовательных операций в компьютере может возрасти, а доля параллельных – уменьшиться.

Заметим, что до сих пор все наши рассуждения касались только быстродействия предельного компьютера, но мы забыли о такой важной его характеристике, как память. Существует ли предел запоминающей способности вычислительных систем?

b) Предел второй : память

Память компьютера ограничена его энтропией, утверждает Сет

Ллойд, то есть степенью беспорядка, случайности в системе. [5] В теории информации понятие энтропии – аналог понятия количества информации. Чем более однородна и упорядочена система, тем меньше информации она в себе содержит.

Величина энтропии S пропорциональна натуральному логарифму числа различимых состояний системы (W): S =k*ln(W), где k – постоянная Больцмана. Смысл этого соотношения очевиден: чем больший объем информации вы хотите сохранить, тем больше различимых состояний вам потребуется. Например, для записи одного бита информации необходимо два состояния: включено и выключено. Чтобы записать два бита, потребуется уже 4 различных состояния, 3 бита - 8, n битов –

Таким образом, чем больше различных состояний в системе, тем выше ее запоминающая способность.

Чему равна энтропия “предельного” квантового компьютера?

Во-первых, она зависит от объема компьютера: чем он больше, тем большее число возможных положений в пространстве могут занимать его частицы. Во-вторых, необходимо знать распределение частиц по энергиям.

Для этого можно воспользоваться готовым расчетом, выполненным еще сто лет назад Максом Планком при решении задачи о так называемом черном теле. Что же мы получим? Оказывается, литр квантов света может хранить около 1031 битов информации – это в 1020 раз больше, чем можно записать на современный 10-гигабайтный жесткий диск! Откуда такая огромная разница? По мнению Ллойда ,все дело в том, что способ, которым в современных компьютерах записывается и хранится информация, чрезвычайно неэкономен и избыточен. За хранение одного бита отвечает целый “магнитный домен” – а ведь это миллионы атомов . Таким образом, вновь встает вопрос об уменьшении размеров ЭВМ.

А. ШИШЛОВА. По материалам зарубежной печати (“New Scientist”, Annals of the New York Academy of Sciences).

Стремительный прогресс в развитии компьютерной техники за последние десятилетия невольно заставляет задуматься о будущем компьютеров. Останутся ли они прежними или изменятся до неузнаваемо сти? Сегодня много говорят о том, что традиционные полупроводниковые ЭВМ скоро себя исчерпают. Ожидается, что уже через пять—десять лет их потеснят более мощные молекулярные (см. “Наука и жизнь” № 12, 2000 г.), квантовые (см. “Наука и жизнь” № 1, 2001 г.), биологические и другие, весьма экзотические, вычислительные устройства. Сет Ллойд, физик из Массачусетского технологического института (США), идет в своих прогнозах дальше всех. Он считает, что компьютер будущего не будет иметь ничего общего ни с одной из ныне существующих или только еще разрабатываемых вычислительных машин. Скорее, он превратится в нечто вроде огненного шара или даже черной дыры. Изображение черной дыры, полученное космическим телескопом Хаббла. Графики, иллюстрирующие развитие вычислительной техники за последние десятилетия. Компактность и быстродействие уже существующих и гипотетических вычислительных устройств.Что за чепуха, — скажете вы, — развеможно поместить на рабочий стол раскаленный шар или черную дыру, да и как они могут производить вычисления?!

Прежде чем прийти к столь экстравагант ным выводам, Ллойд задал себе вопрос: до каких пор будут уменьшаться размеры вычислительных устройств и возрастать их быстродействие? Уже более тридцати лет развитие компьютеров подчиняется эмпирическому закону, сформулирован ному Гордоном Муром в 1965 году, согласно которому плотность транзисторов на микросхеме удваивается за 18 месяцев. С каждым годом следовать “закону Мура” становится все труднее, поэтому его близкий конец предсказывался уже неоднократно. Однако человечес кий гений и изобретательность находят все новые оригинальные выходы из технологических и производственных сложностей, встающих на пути безудержной “компьютерной гонки”. И все же, считает Ллойд, прогресс вычислительной техники не может продолжаться вечно, рано или поздно мы наткнемся на предел, обусловленный законами природы.

Каков же будет самый последний, самый мощный, “предельный” компьютер? Вряд ли сегодня можно предугадать, как именно он будет устроен. Но для нас это не принципиально, говорит Ллойд, технологические детали — задача инженеров будущего. Важно понимать, что любое вычисление — это прежде всего некий физический процесс. Поэтому задачу “о предельном компьютере” следует решать путем рассмотрения основных физических принципов и величин — таких как энергия, температура, объем.

Предел первый: быстродействие

Все логические операции, осуществляемые компьютером, основаны на переключении битов между условными значениями “0” и “1”, которым отвечают два устойчивых физических состояния. Это могут быть, к примеру, большее или меньшее сопротивление проводящего канала в транзисторе (обычный, или полупроводниковый, компьютер), та или иная структура молекулы (молекулярный компьютер), значения спина атома (квантовый компьютер) и т.д. Во всех случаях скорость переключения битов и, следовательно, быстродействие вычислительного устройства определяются тем, насколько быстро протекает соответству траекториях гамма-фотонов и обрабатывалась за счет их столкновений друг с другом, а также больше подвижность электронов в полупроводнике, скорость перехода молекулы из одной формы в другую определяется вероятностью этого события и т. д. Времена процессов переключения, как правило, очень малы (от 1 до 10 -15 секунды). И все же они конечны.

С точки зрения квантовой механики, утверждает Сет Ллойд, скорость вычислений ограничена полной доступной энергией. В 1998 году это положение было теоретически доказано физиками из Массачусетского технологического университета (США) Норманом Марголусом и Львом Левитиным. Им удалось показать, что минимальное время переключения бита равно одной четверти постоянной Планка, деленной на полную энергию:

Таким образом, чем больше энергия компьютера, используемая им для вычислений, тем быстрее он считает. По мнению Ллойда, “предельный компьютер” — это такой компьютер, вся энергия которого будет расходоваться только на вычислительный процесс.

Исходя из приведенного соотношения, оценим, к примеру, быстродействие некоего гипотетического компьютера массой один килограмм, состоящего всего из одного бита. Как известно, полная энергия тела задается фундаментальным соотношением E=mc 2 , где m — масса, с — скорость света в вакууме. Итого, имеем 10 17 Джоулей. Если бы всю эту энергию, “погребенную” в массе нашего компьютера, можно было бы использовать в вычислительном процессе, время переключения бита достигло бы фантастически малых величин порядка 10 -51 секунды! Полученное значение существенно меньше

называемого “планковского промежутка времени” (10 -44 секунды) — минимального временного интервала, который, с точки зрения квантовой теории гравитации, требуется для протекания любого физического события. “Это довольно-таки странно”, — говорит Ллойд…

Однако мы рассмотрели однобитный компьютер, в то время как на практике любой ЭВМ требуется не один, а множество битов. Если энергию нашего гипотетического компьютера распределить между миллиардом битов, время переключения каждого из них будет уже меньше планковского. “Важно, что при этом общее число переключений всех битов за секунду останется прежним — 10 51 ”, — отмечает Ллойд.

По сравнению с “предельным” компьютером Ллойда нынешние ЭВМ — просто черепахи: при тактовой частоте порядка 500 мегагерц типичный современный компьютер выполняет лишь 10 12 операций в секунду. “Предельный” компьютер работает в 10 39 раз быстрее! А если он будет весить не килограмм, а тонну, быстродействие возрастет еще в 1000 раз.

В чем причина медлительности современных ЭВМ? Все дело в том, — считает Ллойд, — что полезную работу в них совершают лишь электроны, перемещающиеся внутри транзисторов. Что касается основной массы компьютера, то она не только не используется как источник энергии, но, напротив, препятствует свободному движению носителей заряда. Единствен ная ее функция — поддерживать ЭВМ в стабильном состоянии.

Как избавиться от “бесполезной” массы? Надо превратить ее в кванты электромагнитного излучения — фотоны, которые, как известно, не имеют массы покоя (считается, что она равна нулю). Тогда вся энергия, запасенная в массе, перейдет в энергию излучения, и компьютер из неподвижного серого ящика превратится в светящийся огненный шар! Как ни странно, но именно так может выглядеть “предельный” компьютер, утверждает Ллойд. Его вычислительная мощность будет огромна: менее чем за одну наносекунду он сможет решать задачи, на которые у современных ЭВМ ушло бы время, равное жизни Вселенной!

Заметим, что до сих пор все наши рассуждения касались только быстродействия “предельного” компьютера, но мы забыли о такой важной его характеристике, как память. Существует ли предел запоминающей способности вычислительных устройств?

Предел второй: память

Память компьютера ограничена его энтропией , утверждает Сет Ллойд, то есть степенью беспорядка, случайности в системе. В теории информации понятие энтропии — аналог понятия количества информации . Чем более однородна и упорядо

ющий физический процесс. Например, время переключения транзистора тем меньше, чем так чена система, тем меньше информации она в себе содержит.

Величина энтропии ( S ) пропорциональна натуральному логарифму числа различимых состояний системы ( W ): S = k . ln W , где k — постоянная Больцмана. Смысл этого соотношения очевиден: чем больший объем информации вы хотите сохранить, тем больше различимых состояний вам потребуется. Например, для записи одного бита информации необходимо два состояния: “включено” и “выключено”, или “1” и “0”. Чтобы записать 2 бита, потребуется уже 4 различных состояния, 3 бита — 8, n битов — 2 n состояний. Таким образом, чем больше различимых состояний в системе, тем выше ее запоминающая способность.

Чему равна энтропия “предельного” компьютера Ллойда?

Во-первых, она зависит от объема компьютера: чем он больше, тем большее число возможных положений в пространстве могут занимать его частицы. Допустим, объем нашего компьютера равен одному литру. Во-вторых, необходимо знать распределение частиц по энергиям. Поскольку речь идет о светящемся шаре, можно воспользоваться готовым расчетом, выполненным еще лет сто назад Максом Планком при решении задачи о так называемом абсолютно черном теле. Что же мы получим? Оказывается, литр квантов света может хранить около 10 31 битов информации — это в 10 20 раз больше, чем можно записать на современный 10-гигабайтный жесткий диск! Откуда такая огромная разница? “Все дело в том, — говорит Ллойд, — что способ, которым в современных компьютерах записывается и хранится информация, чрезвычайно неэкономен и избыточен. За хранение одного бита отвечает целый “магнитный домен” — а ведь это миллионы атомов”.

От раскаленного шара — к черной дыре

Итак, подведем итоги. Пытаясь выяснить пределы быстродействия и запоминающей способности вычислительного устройства, мы сначала избавились от лишней массы (1 килограмм), переведя ее в энергию квантов света, а затем каким-то образом запихнули все это в объем, равный 1 литру. В этих условиях температура огненного шара должна достигать миллиарда градусов (!), а излучать он будет гамма-кванты. Что ни говори, наш “предельный” компьютер получился довольно-таки странным… “Как управлять такой огромной энергией — вот в чем проблема”, — справедливо замечает Ллойд.

Но, допустим, каким-то образом нам все же удалось обуздать раскаленный “супчик” из гамма-квантов, заперев его в неком “ящике”. Тогда работа “предельного” компьютера могла бы выглядеть следующим образом. Информация хранилась бы в положениях и с небольшим количеством образующихся при столкновениях электронов и позитронов. Считывать информацию было бы совсем несложно. “Достаточно просто открыть “окошко” в стенке “ящика” и выпустить фотоны, — говорит Ллойд. — Вылетев наружу со скоростью света, они тут же попадут в детектор гамма-излучения, где и будет считано их состояние”. Для ввода информации потребуется управляемый генератор гамма-излучения. Конечно, все эти устройства ввода-вывода неизбежно привнесут с собой и “лишнюю” массу, от которой мы так хотели избавиться. Но Ллойд полагает, что в будущем, возможно, удастся сделать эти приборы очень маленькими и легкими.

Однако, как бы мы ни совершенствовали процесс ввода-вывода, описанная модель “предельного” компьютера имеет один принципиальный недочет. Допустим, максимальный размер (например, диаметр) нашего компьютера равен 10 сантиметрам. Поскольку фотоны движутся со скоростью света, то все 10 31 битов информации, хранящейся в нашем компьютере, не могут быть “скачаны” из него быстрее, чем за время, требующееся свету для прохождения расстояния в 10 сантиметров — то есть за 3 . 10 -10 секунды. Значит, максимальная скорость обмена информацией компьютера с внешним миром равна 10 41 бит в секунду. А предельная скорость обработки информации, как мы уже выяснили раньше, составляет 10 51 бит в секунду, что в десять миллиардов раз быстрее. Таким образом, необходимость связи компьютера с внешним миром, а также отдельных его частей друг с другом будет приводить к существенным потерям в скорости вычислений. “Отчасти решить эту проблему можно, заставив куски компьютера работать независимо друг от друга, в параллели”, — отмечает Ллойд.

Слишком медленный ввод-вывод информации затрудняет коррекцию ошибок в процессе вычислений. В нашей модели “предельного” компьютера для устранения ошибки придется извлечь наружу соответствующие биты, а вместо них поместить туда новые. Мы сможем проделывать эту операцию не чаще 10 41 раз в секунду, тогда как за это же время компьютер обработает 10 51 битов. Таким образом, лишь одна десятимиллиардная часть информации будет проверять ся на наличие ошибок. Придется либо слепо доверять точности расчетов, либо снижать скорость вычислений.

Есть ли способ повысить скорость ввода-вывода? “Да, — говорит Ллойд, — надо уменьшать размеры компьютера”. Тогда обмен информацией будет происходить быстрее, а объем памяти станет меньше. При этом доля последовательных операций в компьютере может возрасти, а доля параллельных — уменьшить ся.

Что произойдет, если мы начнем сжимать “сгусток” гамма-квантов, температура которого равна миллиарду градусов, а объем одному литру? По мере сжатия температура станет еще выше, в результате чего в объеме компьютера начнут рождаться новые, еще более экзотические частицы. “Компьютеры будущего могут превратиться в релятивистские устройства высокой энергии наподобие ускорителей элементарных частиц”, — полагают Вальтер Симмонс и его коллеги Сандип Пакваса и Ксерксес Тата из университета Гавайи, исследующие возможность компьютерных вычислений на уровне элементарных частиц. “По мере роста температуры в компьютере наши знания о том, что происходит у него внутри, становятся все более и более шаткими”, — говорит Ллойд.

Но, к счастью, наступит момент, когда все опять станет “просто”. Сжатый до некоторого предельного значения “компьютер” превратится… в черную дыру. Один килограмм первоначального вещества “схлопнется” в объем менее чем 10 -27 метров в поперечнике! Ну это уж чересчур, — скажете вы, — о каком еще компьютере можно после этого говорить?! Оказывается, можно…

Как известно, черная дыра — это область чрезвычайно сильного гравитационного поля, “всасывающая” в себя всю окружающую материю. Оказавшись вблизи так называемого горизонта событий черной дыры, ни одно тело, даже свет, уже не может ее покинуть (см. “Наука и жизнь” № 8, 2000 г.). Однако это не совсем так. В 1970 году Стефан Хокинг из Кембриджс кого университета теоретически показал, что черные дыры должны испаряться — испускать кванты света и элементарные частицы за горизонт событий . Если черные дыры все же излучают, то, согласно законам термодинамики, они имеют энтропию, а значит, могут запасать в себе информацию. Энтропия черной дыры была вычислена в 1972 году Яковом Бекенштейном. Согласно его расчетам, черная дыра массой один килограмм может хранить примерно 10 16 бит.

Но с тех самых пор, как информация попадает в черную дыру, она становится недоступной для остальной части Вселенной. Значит, использовать черную дыру для каких-либо вычислений в принципе невозможно — мы все равно не сможем извлечь из нее полученный результат. Однако, с точки зрения теории струн (см. “Наука и жизнь” № 4, 1998 г.), не все так безнадежно. Гордон Кейн, физик-теоретик из университета штата Мичиган (США), полагает, что информацию о том, как формировалась черная дыра все же можно добыть. Сет Ллойд считает, что она остается записанной на горизонте событий в форме сжатых струн, “наподобие сплющенных спагетти”.

Если это действительно так, то черная дыра — и есть “предельный” компьютер, причем благодаря его ничтожно малым размерам скорость вычислений и скорость обмена информацией достигнут одного и того же, максимального, значения. Тем самым проблема ввода-вывода будет решена. “Черная дыра — самый мощный последовательный компьютер”, — считает Ллойд.

Представить себе, как может работать “чернодырный” компьютер еще сложнее, чем в случае раскаленного шара из гамма-квантов. По всей видимости, на вход его будет подаваться материя в неком исходном состоянии, программа задаст точный сценарий ее коллапса в черную дыру, а результатом станет анализ излучения вспышки черной дыры, взрывающейся в результате испарения. “Предельный” компьютер — хоть и мощное, но одноразовое устройство: решив задачу, он исчезнет.

Лишь после того, как компьютер превратится в пылающий огненный шар либо в микроскопическую черную дыру, — утверждает Ллойд, — прогресс вычислительной техники прекратится. Фантастика? Нет, “еще одно свидетельство тесной связи физики и теории информации”. Конечно, сегодня мы даже не можем себе представить, как достичь этих невероятных пределов. Однако не стоит отчаиваться — доверьтесь человеческому гению. Если развитие ЭВМ будет идти теми же темпами, все описанное станет реальностью через каких-нибудь две сотни лет.

В первые годы развития авиации было очевидно, что скорости самолетов будут только расти. Так, собственно, и произошло: от смешных 50 километров в час для самолета братьев Райт в 1903 году мы пришли к 800-900 км/ч для различных Boeing и Туполевых в середине 1960-ых. И с тех пор рост скорости коммерческих самолетов застопорился: да, были попытки создания сверхзвуковых пассажирских самолетов, и Конкорды вместе с Ту-144 даже летали около двух десятилетий. Но из-за не самой высокой безопасности, а главное неэффективности с точки зрения траты энергии при столь высоких скоростях, мы на данный момент тратим на путешествия по воздуху столько же времени, сколько и наши родители 50 лет назад.

Современные компьютеры подошли очень близко к той же проблеме. На протяжении десятилетий наша способность миниатюризировать компоненты приводила к тому, что мы удваивали количество транзисторов на кремниевом чипе каждые два года или около того. Это явление, известное как закон Мура (названный в честь соучредителя Intel Гордона Мура), позволяло создавать все более дешевые и мощные процессоры на протяжении десятилетий. Но сейчас мы почти достигли пределов миниатюризации, и поэтому производительность вычислений скоро начнет стагнировать.

Да, на бумаге все хорошо: от 40-нанометровых процессоров в конце нулевых мы перешли к 7-нанометровым решениям, а в конце этого года нам обещают уже 5 нм. Однако стоит понимать, что эти нанометры — мнимые, и достигаются они благодаря трехмерному расположению транзисторов и прочим хитростям. На деле ключевые части транзисторов, такие как затвор, за последние 10 лет уменьшились лишь на несколько десятков процентов. И именно поэтому современные 14-нанометровые процессоры от Intel выступают не особо хуже 7-нанометровых решений AMD, хотя на деле разница должна быть близка к двукратной.

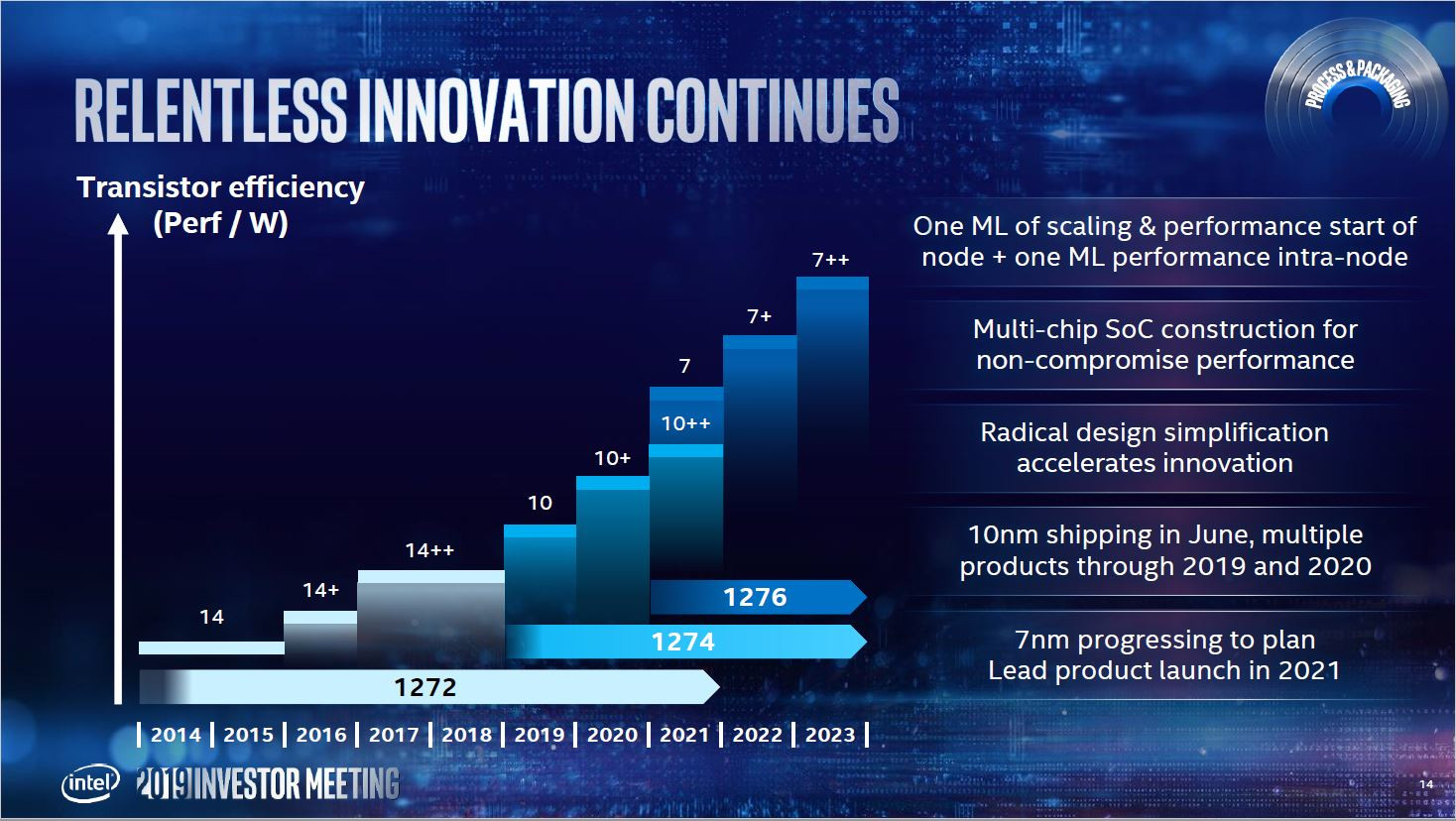

Красивая табличка, демонстрирующая рост эффективности процессоров при переходе на более тонкие техпроцессы. Увы, она уже не выполняется.

В последние годы исследователи ломают голову над тем, что делать дальше. Разумеется, есть надежда, что ответ — это новые технологии, такие как квантовые вычисления, углеродные нанотрубки или фотонные вычисления. Проблема тут лишь в том, что это пока очень размытые технологии, которые в лучшем случае работают в лабораториях, и до полок в магазине доберутся они еще очень нескоро. Поэтому не стоит надеяться на быстрое и полное переосмысление компьютерных чипов — имеет смысл серьезно изменить подход к написанию программного обеспечения для текущих.

Чарльз Лейзерсон, профессор компьютерных наук и инженерии в MIT, отметил в своей последней статье на Science, что в течение многих лет программистам не приходилось беспокоиться о том, чтобы заставить код работать быстрее, потому что закон Мура делал это для них. Поэтому они выбрали простой путь, отдавая приоритет своей способности быстро писать код над способностью компьютеров выполнять этот код как можно быстрее.

Хорошо заметно, что последние годы рост замедлился.

Хорошая новость заключается в том, что этот подход помогает вам писать код быстрее. Плохая же новость в том, что иногда это приводит к ошеломляющей неэффективности, которая может очень быстро усугубиться. Если в вашей программе одна такая редукция, то ее влияние на общую производительность может быть и незаметно. Но если вы пишете программу с двадцатью уровнями редукции, код может быть в сотню раз менее эффективным, чем мог быть, если бы вы писали «честно».

И это не просто мысленный эксперимент. Возможность добиться дальнейшего прогресса в таких областях, как машинное обучение, робототехника и виртуальная реальность потребует огромных вычислительных мощностей. Если мы хотим использовать весь потенциал этих технологий, то должны внести значительные изменения в принципы работы с кодом. Наилучшим способом является создание новых, заточенных под определенные задачи инструкций процессоров и соответствующих программных алгоритмов, однако это дорого и в конечном счете может привести к тем же редукциям с теми же последствиями. Поэтому для большинства компаний наиболее практичным способом повышения производительности вычислений является повышение эффективности уже имеющегося программного обеспечения.

Современные процессоры имеют огромное количество инструкций, но далеко не весь софт ими пользуется.

Одна из стратегий повышения производительности заключается в распараллеливании кода. Достаточное количество существующих программ были разработаны с использованием алгоритмов десятилетней давности и нередко не используют современные инструкции типа AVX. Более того, если ПО в целом уже научилось работать с многоядерными CPU, то части программ все еще могут быть «одноядерными», причем это касается даже таких известных утилит, как Photoshop. Поэтому распараллеливание и использование современных инструкций может позволить ускорить выполнение некоторых сложных задач в десятки и даже сотню раз, или же можно пойти другим путем и делать все с той же скоростью, но гораздо энергоэффективнее.

Однако на этом благом пути по оптимизации производительности будут встречаться и чисто земные проблемы. Во-первых, никто не отменял «индусский код», в котором исправление одной проблемы тянет за собой ворох новых, и в итоге зачастую проще, но отнюдь не дешевле, переписать программу с нуля. А заниматься этим в случае с тяжелым современным софтом хотят и могут далеко не все компании. Во-вторых, существует понятие институциональной инерцией, когда программисты (и не только) продолжают делать все так, как привыкли, неохотно переходя к более новым вещам.

Классический пример индусского кода, для понимания которого не нужно быть программистом.

Развитые технологические гиганты, такие как Google и Amazon, уже поняли цену оптимизаций. Огромный масштаб их центров обработки данных означает, что даже небольшие улучшения в производительности программного обеспечения могут принести большую финансовую отдачу. И, по-хорошему, по этому же пути должен пойти остальной мир — разработчики приложений больше не должны игнорировать эффективность при развертывании новых функций.

«Инженерия производительности» будет более рискованной, чем даже разработка новых кремниевых чипов. Компании изначально не могут предсказать величину ускорения своего софта, пока программисты не потратят время на оптимизацию кода. Причем где-то эффект будет значительным и оправданным, а где-то прирост производительности будет всего несколько процентов. Но по мере того, как мы достигаем физических пределов микропроцессоров, сосредоточение внимания на улучшении программного обеспечения окажется для большинства программистов лучшим вариантом получения большей отдачи от существующих компьютеров.

Читайте также: