Geforce 6600 gt radeon x1300 сколько мб памяти

Обновлено: 05.07.2024

Успех видеокарт на базе графических процессоров NVIDIA GeForce 6600/6600 GT с интерфейсом передачи данных AGP уже не вызывает ни у кого и тени сомнения. Карты с графическим процессором GeForce 6600 GT – это просто идеальное решение класса Hi Middle на сегодняшний день, которому просто нет достойных конкурентов среди чипов ATI с поддержкой интерфейса AGP. А видеокарты на базе GeForce 6600 и вовсе стали выбором оверклокера номер 1 из-за прекрасной возможности разгона графического процессора NV43.

Да, на подходе уже чипы ATI серии X700 с переходным мостом Rialto, который, аналогично мосту HSI у NVIDIA, будет отвечать за поддержку интерфейса AGP. Как видим, в ATI прекрасно осознали все преимущества переходного моста у NVIDIA и поняли, что если не сделать свой собственный переходный мост – аналог HSI, то “схватку” за пока ещё огромный рынок AGP-совместимых систем можно легко проиграть. Держать на конвейере по 2 разных варианта одного и того же чипа (для PCI-Express и для AGP) – слишком большое расточительство. Что же касается результатов тестов PCI-Express-вариантов чипов X700, то новинки от ATI должны будут составить более чем достойную конкуренцию серии NVIDIA GeForce 6600. Однако на данный момент этих карт нет в рознице, и, судя по новостям о сроках начала поставок новых видеокарт, пока совсем не ясно, когда же новые чипы от ATI смогут начать новый виток конкурентной борьбы с чипами NVIDIA в наиболее “вкусном” для производителей GPU секторе Middle-End.

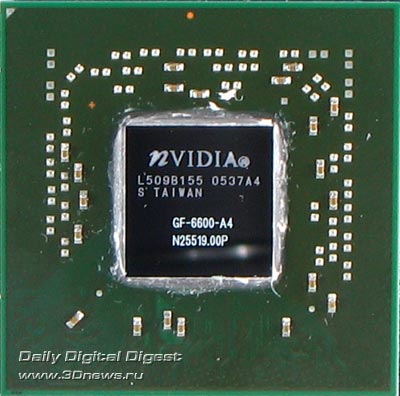

Графический чип NVIDIA GeForce 6600 GT

Наша таблица спецификаций не претерпела больших изменений, поскольку ничего нового на рынок за время тестирования выпущено не было, а значит и рассматривать, по большому счёту, нам придётся старые решения.

В основе платы Sparkle GeForce 6600 GT лежит всё тот же чип NV43, обладающий 8 конвейерами рендеринга с одним текстурным модулем на каждом, 3 вершинными процессорами и стандартными для NVIDIA GeForce 6600 GT частотами.

Особенности графического процессора GeForce 6600 GT мы уже рассматривали в нашем материале, посвящённом данному GPU, поэтому мы не будем заострять внимание наших читателей на данном вопросе, а сразу перейдём к описанию платы.

Плата Sparkle GeForce 6600 GT

| Технические характеристики карты | |

| Производитель карты | Sparkle |

| Графический процессор | NV43 |

| Частота чипа, МГц | 500 |

| Память | GDDR III, 128 Мбайт |

| Частота памяти, МГц | 450 (900) |

| Ширина шины памяти, бит | 128 |

| Интерфейс | AGP 8x (мост HSI) |

| RAMDAC | 2x400 МГц |

| Количество вершинных конвейеров | 3 |

| Количество пиксельных конвейеров | 8 |

| API | DirectX 9.0c, OpenGL 1.5 |

| Контроль системы охлаждения | Есть |

| Дополнительное питание | Требуется |

| Разъёмы подключения мониторов | D-Sub и DVI |

| Наличие TV-Out | Да |

| Наличие TV-IN | Нет |

| Цена, $ | 190 |

Дизайн и компоновка платы

Карта попала к нам на тестирование в OEM-комплектации, следовательно, рассказ о ретейле мы опускаем. Вообще, как мы уже отмечали в наших предыдущих обзорах, для российских покупателей, по хорошо понятным всем причинам, вопрос ретейла не такой щепетильный, как для западных покупателей, если речь идёт о программном обеспечении. Таким образом, мы незамедлительно переходим к описанию непосредственно самой видеокарты.

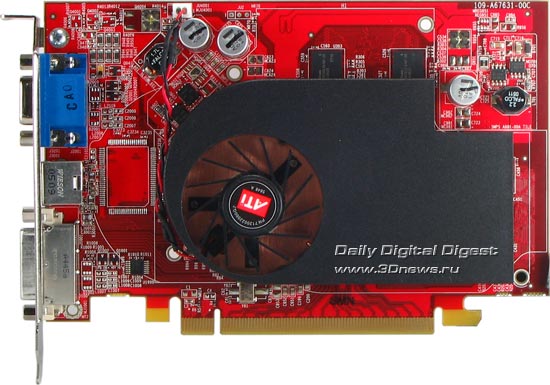

Sparkle GeForce 6600 GT

Переходный чип HSI, который отвечает за преобразование сигнала на магистрали GPU – шина передачи данных, размещён под углом 45 градусов относительно графического процессора.

Sparkle GeForce 6600 GT

(1280x815, 182 Кбайт)

(1280x815, 182 Кбайт)

Sparkle GeForce 6600 GT

(1280x832, 242 Кбайт)

(1280x832, 242 Кбайт)

Sparkle GeForce 6600 GT

(1280x791, 240 Кбайт)

(1280x791, 240 Кбайт)

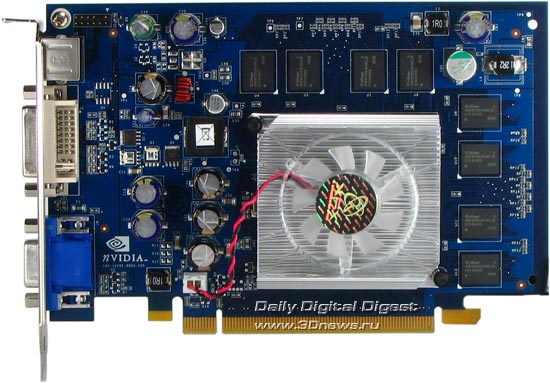

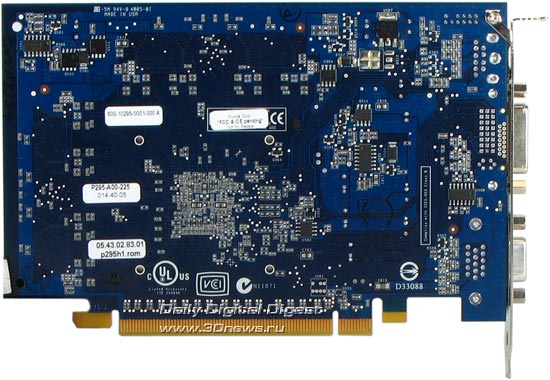

Похоже на то, что дизайн референс-платы от NVIDIA лёг в основу изделия Sparkle. В отличие от ещё одного бренда среднего звена, компании Palit, Sparkle идет по пути наименьшего сопротивления и в своих изделиях пользуется референсными PCB.

Впрочем, всё остальное также достаточно стандартно: синий цвет PCB (характерен для Sparkle), 128 Mбайт DDR III памяти с шиной передачи данных в 128 бит, интерфейс передачи данных AGP 4x/8x (посредством моста HSI) и стандартный набор выходов: 1 DVI-I, 1 аналоговый и 1 TV-OUT.

Sparkle GeForce 6600 GT - разъем питания

Дополнительное питание на карте присутствует, что вполне закономерно, учитывая тот факт, что энергопотребление карты на базе графического процессора NVIDIA GeForce 6600 GT с интерфейсом передачи данных AGP заметно выше, нежели у карты с интерфейсом передачи данных PCI-Express. Для плат на базе GPU GeForce 6600 дополнительное питание уже не требуется, однако для GT-модификации чипа GeForce 6600, работающей на более высоких, нежели GeForce 6600, частотах, дополнительное питание обязательно.

Sparkle GeForce 6600 GT

Чип NV43, как видно на фотографии, изготовлен на 50-й неделе 2004 года и имеет ревизию A4.

Sparkle GeForce 6600 GT

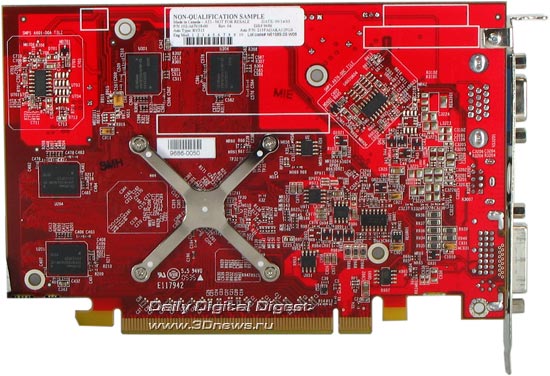

В отличие от уже рассмотренной нами платы Palit на базе графического процессора NVIDIA GeForce 6600 GT, изделие от Sparkle имеет место на PCB для установки VIVO чипа от Phillips, однако на нашем образце он установлен не был.

Sparkle GeForce 6600 GT

На плате Sparkle GeForce 6600 GT установлены микросхемы памяти производства Samsung (K4J55323QF-GC20), для которых предусмотрена BGA-упаковка. Время выборки чипов памяти – 2,0 нс., что соответствует частоте работы 500 МГц (1000 МГц DDR), однако память функционирует на положенной по спецификации частоте 450 МГц (900 МГц). То есть установив более быструю, нежели положено по спецификациям NVIDIA, память, производитель всё равно выставил стандартные частоты. Однако, быстрая памяти сыграет свою положительную роль при разгоне данной видеокарты, что мы обязательно рассмотрим в соответствующем разделе статьи. Частота работы GPU составляет положенные по спецификации 500 МГц.

Sparkle GeForce 6600 GT

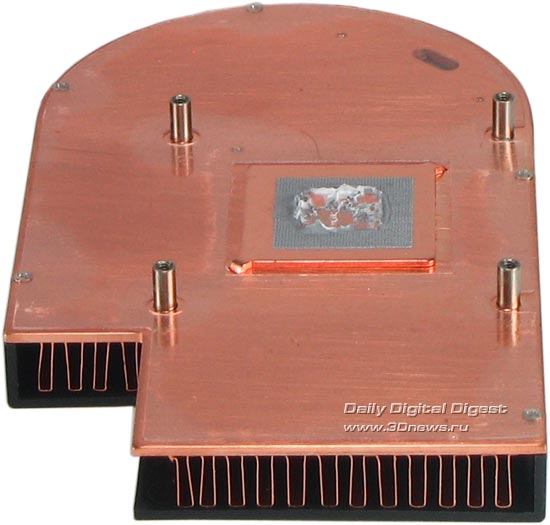

Система охлаждения на плате не представляет собой ничего выдающегося.

Sparkle GeForce 6600 GT

Если быть более подробным, то это точная копия референса от NVIDIA, но с фирменной наклейкой Sparkle.

Sparkle GeForce 6600 GT

Наклейка разместилась на небольшом блоке, который отвечает за охлаждение графического чипа.

Sparkle GeForce 6600 GT

Вентилятор, размещённый сбоку от графического процессора, обдувает радиаторы, которыми прикрыт GPU. Для чипов памяти никакого охлаждения не предусмотрено, в отличие от чипа HSI, который прикрыт небольшим радиатором.

Тестирование

Качество 2D

Перед тем как оценить качество изображения, выдаваемого видеокартой Sparkle GeForce 6600 GT AGP, которая приняла участие в нашем сегодняшнем тестировании, повторимся, что на сегодняшний день нельзя дать более или менее объективную оценку данного параметра для серии видеокарт, так как качество 2D сильно зависит от конкретного экземпляра, а проверить все карты по понятным причинам невозможно. Качество 2D также зависит от монитора и соединительного кабеля, что, в свою очередь, привносит солидную долю субъективизма в методику оценки данного параметра.

Качество 2D, показываемое платой в разрешениях 1024x768x100 Гц, 1280х1024х85Гц и 1600х1200х60 Гц, можно охарактеризовать как отменное. Заметных отклонений в качестве картинки не было замечено ни у одного из протестированных экземпляров.

Разгон

Итак, видеокарту Sparkle GeForce 6600 GT AGP со стандартных для этого акселератора 500 МГц/900 МГц удалось разогнать до следующих частот:

| Карта | Ядро/память Max |

| Sparkle GeForce 6600 GT AGP | 530 МГц / 1115 МГц |

Разгон графического процессора получился не самым хорошим (всего лишь + 30 МГц к номиналу), а вот память со стандартных 900 МГц смогла разогнаться до 1115 МГц. Даже учитывая то, что данная память является 2.0 нс. памятью от Samsung – это просто прекрасный результат.

Тестовый стенд:

•Материнская плата: MicroStar K7N2 Delta (nForce 2 Ultra 400);

• Процессор: AMD Athlon XP 3200+ Barton (200x11 = 2200 МГц);

• Память: 2x512МБ DDR PC 3200 Kingston (двухканальный режим, тайминги 5 3 3 2);

• Винчестер: Maxtor Diamond 9 Plus 120 ГБ (8 МБ Cashe).

Операционная система, тестовые программы, драйверы и настройки

Система:

• Microsoft Windows XP SP1 ENG

• DirectX 9.0b

• Драйвер для видеокарт NVIDIA – ForceWare 71.82 WHQL;

• Драйвер для видеокарт ATI – Catalyst 5.2 WHQL.

Драйверы NVIDIA: оптимизации триллинейной фильтрации включены, анизотропной также включены по умолчанию.

Драйверы ATI – оптимизации триллинейной фильтрации включены по умолчанию.

Все излишества и «красивости» в операционной системе убирались, система настраивалась на максимальное быстродействие.

Vsync принудительно отключался через драйверы как в OpenGL, так и в Direct3D-приложениях. Технология сжатия текстур S3TC также отключалась.

Тестовые программы:

• FutureMark 3DMark2003 v340 (комплексный полусинтетический DirectX 9.0 тест, Vertex Shaders 1.1/1.4/2.0, Pixel Shaders 1.1/1.4/2.0);

• FutureMark 3DMark2005 (комплексный полусинтетический DirectX 9.0c тест, Vertex Shaders 2.0/3.0, Pixel Shaders 2.0/3.0);

• Massive Development AquaMark 3 (комплексный полусинтетический DirectX 9.0 тест, Vertex Shaders 1.1/1.4/2.0, Pixel Shaders 1.1/1.4/2.0, Hardware T&L);

• Digital Extreme/Epic Games Unreal Tournament 2004 (Direct3D, Hardware T&L, Dot3, cube texturing);

• Legend Ent./Epic Games Unreal II: The Awakening v1403 (Direct3D, Hardware T&L, Dot3, cube texturing);

• Activision/Infinity Ward Call of Duty 1.4 (OpenGL, мультитекстурирование);

• Egosoft X2: The Threat (Direct3D, мультитекстурирование, Dot3, стенсильные тени);

• GodGames/Croteam Serious Sam: The Second Encounter 1.07 (OpenGL, мультитекстурирование);

• People Can Fly/DreamCatcher Interactive Painkiller v 1.31 (Direct3D, пиксельные и вершинные шейдеры версии 1.1, проецируемые текстуры, динамическое попиксельное затенение, DOT3 bump mapping);

• Ion Storm/Eidos Interactive Thief 3: Deadly Shadows (Direct3D, пиксельные и вершинные шейдеры 1.1);

• IO Int./Eidos Entaractive Hitman: Contracts ((Direct3D, пиксельные и вершинные шейдеры 1.1);

• Crytek/UbiSoft FarCry 1.3 (DirectX 9.0, пиксельные и вершинные шейдеры версии 2.0, мультитекстурирование);

• Core Design/Eidos Entaractive Tomb Raider: Angel of Darkness v49 (DirectX 9.0, пиксельные и вершинные шейдеры версии 2.0, качество по умолчанию);

• Microsoft HALO: Combat Evolved 1.3 (DirectX 9.0, Vertex Shaders 1.1/1.4/2.0, Pixel Shaders 1.1/1.4/2.0, Hardware T&L);

• Activision/id Software Doom 3 (OpenGL, мультитекстурирование).

Результаты тестирования

Полусинтетические тесты

3DMark 2003 v340

Открывает наше тестирование старожил всех тестирований – тестовый пакет от Futuremark.

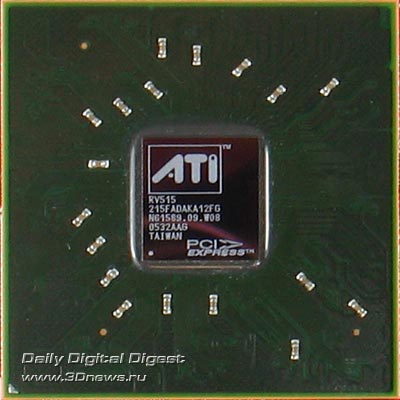

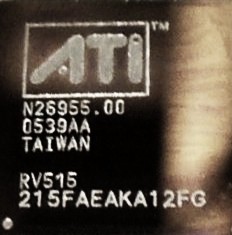

ATI, наконец, выпустила на рынок новое поколение видеокарт. Новое семейство содержит три новых видеочипа: R520, RV530 и RV515. Нетрудно догадаться, что R520 - топовый продукт, а чипы RV - это его урезанные версии. Самая «обделённая» из них - это RV515, на базе которого и построена видеокарта X1300, которая участвует в этом тесте.

Официальные спецификации RADEON X1300

- Кодовое имя чипа RV515

- Технология 90 нм

- 105 миллионов транзисторов FС корпус (flip-chip, перевернутый чип без металлической крышки)

- 128 бит интерфейс памяти

- До 256 мегабайт DDR1/2 или GDDR-3 памяти

- Поддержка технологии HyperMemory

- PCI Express 16х шинный интерфейс

- 4 пиксельных процессора (один квад)

- 4 текстурных блока

- Вычисление, блендинг и запись до 4 полных (цвет, глубина, буфер шаблонов) пикселей за такт

- 3 вершинных процессора

- Сквозная точность вычислений - FP32 (и вершины и пиксели)

- Полная поддержка SM 3.0 (шейдеры версии 3.0), включая динамические ветвления в пиксельных и вершинных процессорах, выбор значений текстур из вершинных процессоров и т.д.

- Эффективная реализация переходов и ветвлений

- Поддержка FP16 формата: полностью поддерживается вывод в буфер кадра в плавающем формате FP16 (включая любые операции блендинга и даже MSAA). Сжатие FP16 текстур, включая 3Dc.

- Новый RGBA (10:10:10:2) целочисленный тип данных в буфере кадра для более качественного рендеринга без привлечения FP16.

- Новый качественный алгоритм анизотропной фильтрации (пользователю доступен выбор между более быстрой и более качественной реализацией анизотропии), улучшена трилинейная фильтрация

- Поддержка «двустороннего» буфера шаблонов

- MRT (Multiple Render Targets - рендеринг в несколько буферов)

- Контроллер памяти с 4-х канальным кроссбаром 4*32 бита (4 канала памяти, программируемый арбитраж). Эффективное кэширование и новая более эффективная реализация HyperZ

- 2xRAMDAC 400 МГц

- 2xDVI интерфейса c поддержкой HDCP

- TV-Out и TV-In интерфейс, HDTV-Out

- Аппаратный видеопроцессор (для задач компрессии, декомпрессии и постобработки видео), новое поколение, способное ускорять работу с H.264, - новым алгоритмом компрессии видео, используемым в HD-DVD и Blu-Ray видеодисках.

- 2D ускоритель с поддержкой всех функций GDI+

Из спецификаций видно, что RV515 содержит всего 4 пиксельных процессора и столько же текстурных блоков (раньше можно было бы сказать: «4 пиксельных процессора с 1 текстурным блоком на каждом*», но новая архитектура от ATI сломала устоявшиеся принципы строения микроархитектур видеочипов - теперь пиксельные процессоры и текстурные блоки друг от друга не зависят. Управляет пересылкой данных между ними «Ultra Threading Dispatch Processor», который при помощи хитрых алгоритмов распределяет данные между текстурниками и пиксельными конвейерами, следя за тем, чтобы все были заняты работой и свободные блоки не простаивали без дела.)

Если не учитывать, что новая архитектура может иметь более высокий КПД, то можно предположить, что соперниками видеокарт на этом чипе будут карточки 6600LE (4 конвейера, 4 TMU, 3 три вершинных процессора) и 6600(8 конвейеров, 4 TMU, 3 три вершинных процессора).

Именно с этими видеокартами будет сравниваться поступившая на тестирование X1300 256Mb. Надо заметить, что есть также версия X1300Pro, которая отличается от X1300 повышенными частотами чипа и памяти. Во время проведения тестов будет осуществлена попытка сделать X1300Pro из тестируемой карточки путём разгона.

Теперь, собственно, о самой карточке.

Частоты (чип/физическая по памяти (эффективная по памяти): 425/250 (500) MHz.

Ширина шины обмена с памятью: 128bit

Число вершинных конвейеров: 3

Число пиксельных конвейеров: 4

Размеры: 180x100x15mm (последняя величина - максимальная толщина видеокарты).

Цвет текстолита: темно-синий.

Выходные гнезда: DVI, D-Sub, S-Video.

VIVO: нет.

Микросхемы памяти Infineon. Время выборки у микросхем памяти 2.8ns, что соответствует частоте работы 357 (714) МГц. Память же работает на частоте 250 (500) МГц.

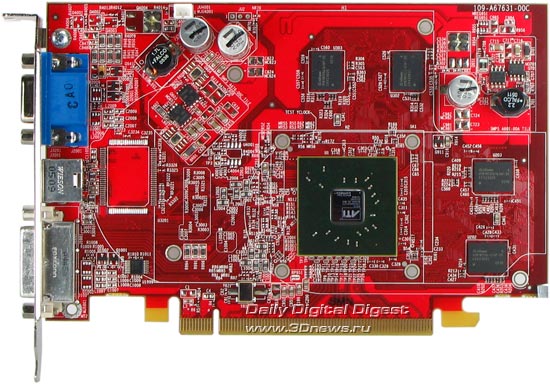

Дизайн платы стандартный, он соответствует дизайну платы от самой ATI. Видно, что и на эталонной карте, и на тестируемой есть посадочное место под ATI RAGE Theater, но ни на одной из карт его нет. Также можно заметить некоторую разницу в используемых элементах, по всей видимости, стабилизатора питания, который находится в правом верхнем углу платы, если смотреть на неё спереди. На эталонной плате (X1300Pro) использовался один набор деталей, а часть посадочных мест пустовала, тогда как на тестируемой карте (X1300) детали распаяны иначе. Та же картина и на задней стороне карты в том же самом месте.

Теперь пару о слов о системе охлаждения.

Она представляет собой примитивный алюминиевый радиатор с игольчатым оребрением, покрывающий почти всю лицевую сторону карты.

Микросхемы памяти на лицевой стороне прижимаются к этому радиатору через термопрокладки (стоит заметить, что на представленном образце термопрокладки были установлены не совсем аккуратно, и часть чипов памяти прилегала к этим прокладкам не полностью - на фото выше можно увидеть, что след от микросхемы уходит за край прокладки). На оборотной стороне карты микросхемы памяти охлаждения лишены, хотя память даже на стандартных частотах нагревается довольно ощутимо. При сильной загрузке видеокарты палец не продержишь более 5 секунд. Да и радиатор без активного охлаждения тоже раскаляется, особенно в области видеочипа.

Теперь посмотрим, что же скрывается под радиатором.

X1800XT - RV515 изготовлен в конце сентября - начале октября этого года.

В коробке можно найти руководство пользователя, диск с драйверами, PowerDVD 5, диск "Sapphire select", переходник DVI-to-D-Sub, переходник для вывода компонентного сигнала, переходник для вывода S-Video, переходник для вывода композитного видеосигнала. Довольно неплохой комплект.

Установка и драйверы

Конфигурация тестового стенда:

- Компьютер на базе Athlon 64 (939Socket)

- процессор AMD Athlon 3500+ (2250MHz) (L2=512K);

- системная плата ASUS A8N-E Deluxe на чипсете NVIDIA nForce4 Ultra;

- оперативная память 1 GB DDR SDRAM 400MHz (CAS (tCL)=2.5; RAS to CAS delay (tRCD)=3; Row Precharge (tRP)=4 tRAS=8);

- жесткий диск Maxtor DiamondMax10 6B200S0 200GB SATAII.

Синтетические тесты я не проводил, т.к. опыта проведения их у меня не было, да и время тестирования на них всё равно не хватало (карта была предоставлена на 2 недели, но мне, как студенту, ещё надо было учиться когда-то :) ). Поэтому сразу перейдём к игровым тестам.

Производительность в игровых тестах

При тестировании были использованы две видеокарты: Radeon X1300 (RV515) и GeForce 6600LE (NV43). Т.к. NV43 мне попался удачный, то оказалось легко разблокировать «спрятанные» 4 конвеера и сделать из неё уже GeForce 6600.

Более того, я решил сравнить приблизительные КПД чипов при одинаковых частотах по памяти и чипу и одинаковом числе конвееров. Т.е., не включая дополнительные конвейеры, разогнать GeForce 6600LE до 425/500. И сравнить полученные скорости, чтобы понять, насколько отличается КПД прежней архитектуры от КПД новой, воплощенной ATI в серии X1000. Хотя бы приблизительно.

Итого одна видеокарта GeForce 6600LE будет присутствовать в тестах в трёх ролях: в роли, собственно GeForce 6600LE (4@300/500), в роли GeForce 6600LE (4@425/500), одинаковой по параметрам с X1300 (4@425/500), и в роли GeForce 6600 (8@300/500).

К слову, этот чудесный экземпляр позволял, кроме включения конвееров, ещё и очень сильно разогнать себя - до 560/650 (чип/память), но т.к. с разгоном X1300 не сложилось (чуть дальше частот X1300 Pro - и карта теряла стабильность), то сравнивать GeForce 6600 (8@560/650) было бы не с кем.

X1300 удалось разогнать только до частот X1300Pro, но использовать её в таком режиме без дополнительного охлаждения я бы не советовал. Для облегчения теплового режима работы разогнанной X1300 был установлен внешний обдув.

![]()

Результаты тестов: сравнение производительности

В качестве инструментария я использовал:

- Half-Life2 (Valve/Sierra) - DirectX 9.0, demo (ixbt01, ixbt02, ixbt03 Тестирование проводилось при максимальном качестве).

- DOOM III (id Software/Activision) - OpenGL, мультитекстурирование, настройки тестирования - Ultra High Quality, demo ixbt1 (33MB!).

- 3DMark05 1.0.0 (FutureMark) - DirectX 9.0, мультитекстурирование.

- F.E.A.R. (Monolith/Sierra) - DirectX 9.0, мультитекстурирование, настройки тестирования - maximum, Soft shadows.

Видеокарты, участвующие в этом тестировании относятся к Middle-End и, даже, к Low-End, что позволяет получать более-менее играбельные fps только в «легких» режимах 1024x768 и 1280x1024 (1280x960). При включении AA и AF скорости падали катастрофически, поэтому больший вес в сравнении карт имели тесты в «лёгких» режимах. Тестировать в разрешениях экрана выше 1280x1024 смысла никакого не было, т.к. видеокарты не топовые, поэтому даже на «лёгких» режимах вряд ли можно было ожидать упирания в процессор.

Игровые тесты, сильно нагружающие блоки вершинных шейдеров, блоки пиксельных шейдеров 2.0, активное мультитекстурирование.

![]()

В лёгком режиме X1300 опередил GeForce 6600LE и идёт почти наравне с своим «клоном по параметрам» от nVidia (разогнанный 6600LE), немного опережая последнего. До 6600 уже не дотянуться, хотя X1300 стоит дороже, чем 6600 (на момент написания статьи). Тут 4 «современных» конвеера не могут догнать 8 «старого образца».

X1300Pro в 1024x768 опережает 6600, а в 1280x960 всё сводится к паритету.

В тяжёлом режиме X1300 стабильно, но быстрее чем 6600LE и даже чем 6600LE на частотах 425/500 в 1280x960. X1300Pro держит примерный паритет с 6600, опережая обе версии 6600LE (что не удивительно при его цене, но могло быть и лучше).

Half-Life2: ixbt01 demo

![]()

X1300 выступил очень неплохо для своих технических возможностей (что не удивительно, если учесть, под какие карточки эта игра делалась), но оказался в проигрыше по ценам. Он вполне спокойно обошёл 6600LE в лёгком режиме и даже его разогнанную версию («новые» конвейеры оказались эффективнее). С 6600 держит шаткий паритет.

Впрочем, те же 4 «новых», но разогнанных, конвейера в лице X1300Pro вполне могут потягаться с 6600. И тут цена вполне адекватна. За X1300Pro выигрыш.

Half-Life2: ixbt02 demo

![]()

Почти всё то же самое, только при лёгких настройках X1300 уже опустился до паритета с разогнанной до 425/500 6600LE (но преимущество над нормальным 6600LE осталось) и проиграл 6600. X1300Pro всё ещё не на много опережает 6600.

А вот при AA и AF и X1300Pro, и даже простая X1300 смогла вырвать победу у всех видеокарт соперника (из того же ценового диапазона, разумеется). X1300 с очень внушительным отрывом ушёл от 6600, а уж 6600LE тем более уже оказался в проигрыше. Может быть, дело в объёме памяти на видеокартах: на 6600LE/6600 было установлено 128Мб, тогда как на X1300/X1300Pro - 256Мб.

Но вот цена новинок слишком высока для их производительности. Если цена на X1300 опустится до 90 у.е., а на X1300Pro до 100 у.е. тогда эти видеокарты будут хорошим выбором.

Half-Life2: ixbt03 demo

![]()

Этот тест ознаменовался очень хорошим выступлением видеокарт на канадских видеочипах. X1300 даже сравнялся с 6600, а уж 6600LE проиграл ей намного больше (60% в режиме 1024x768 без AA и AF). Даже 6600LE разогнанная до частот X1300 не смогла ничего сделать. «Новые» конвейеры показали свою мощь. X1300Pro вообще ушёл очень далеко вперёд, вполне оправдывая свою цену.

В режиме с AA и AF всё то же самое, только проценты преимущества немного уменьшились. Но победа осталась за X1300 и X1300Pro.

Игровые тесты, сильно нагружающие пиксельный конвейер текстурированием, активная работа стенсиль-буфера, блоков шейдеров.

DOOM III Ultra High mode

![]()

Появившиеся вроде надежды на оптимизацию обработки теней, связанные с улучшенным быстродействием новой архитектуры от ATI в других тестах, быстро развеялись после первых же результатов тестов. Всё-таки очень хорошо «точили» Doom3 под калифорнийские карточки.

Без AA/AF: полный провал новинок от ATI. Даже X1300Pro не смогла достать 6600LE с более низкими частотами и «старой» архитектурой.

С AA/AF: лишь X1300Pro смогла как-то соревноваться с 6600LE (в том числе и разогнанной) и 6600. X1300 полностью проиграла бой.

Синтетические тесты, сильно нагружающие шейдерные блоки.

3DMark05: MARKS

![]()

Здесь всё очень радужно для видеокарт на чипах ATI.

Без AA/AF: X1300 почти догнал 6600, опередив 6600LE (даже в разогнанном варианте - возможно, в этом заслуга новой архитектуры… надо бы сравнить с предыдущей архитектурой ATI, но у меня в распоряжении не было таких карт). X1300Pro уверенно лидирует.

С AA/AF: X1300 особо не церемонясь спокойно обошёл 6600 (не говоря уж про 6600LE). Новая архитектура или отполированные до блеска драйвера? Хороший вопрос… Про X1300Pro уже всё сказано: свою цену по результатам этого теста она отрабатывает.

Хочу заметить, насколько на X1300 быстрее первый Game-тест проходил по сравнению с 6600. В сцене, где огромный бронированный робот расстреливает солдат у двери 6600 удавалось максимум показать 10 кадров/сек. X1300Pro же не напрягаясь выдавала все 17-18. И во втором тесте (по лесу летает зелёный огонёк) также соотношение в пользу X1300Pro: 5 и 8 кадров соответственно. Правда, при этом были отмечены проблемы с качеством картинки в первом тесте, о чём ниже.

Вопросы качества.

Во время тестирования были замечены две проблемы с качеством картинки.

Дым от упавшей цистерны на X1300 как будто терял цветовую разрядность и окрашивался в инородные цвета, тогда как на 6600 артефактов замечено не было.

Тоже проблемы с прорисовкой дыма. (Правда, в этой игре у всех видеокарт от ATI есть проблемы. Например, на предыдущих поколениях все тени при установке максимальной графики имели резкие, рваные края. На X1300 такого дефекта не было, хотя совсем гладкими тени не стали; на видеокартах GeForce (даже предыдущих поколений) тени отображаются плавными и без артефактов.) На GeForce 6600 дым вполне адекватный, в то время как на X1300 он имеет какую-то рваную структуру, идёт полосами.

Такие странности с отрисовкой в этой игре тем более странны, т.к. эта же игра вышла на X-Box 360, где как раз используется чип от ATI.

Выводы по производительности

ATI Radeon X1300Pro - уже намного интереснее. Она чаще всего наравне соперничает с 6600, нередко выходит вперёд (HL2, 3Dmark05), но иногда и откатывается назад (Doom3). Если цена опустится хотя бы долларов на 20-30 то уже вполне можно подумывать о покупке данной карты, если выбирать из сектора Low-End. Пока же цена говорит не в пользу X1300Pro, хотя она и бывает быстрее, чем 6600.

Остаётся ждать полноценного выхода новинок на прилавки и постепенного понижения цен до приемлемых, при которых покупка этих карт становится оправданной.

Наконец мы добрались до тестирования и видеокарт низшего ценового диапазона. Огромное разнообразие всевозможных сочетаний используемых видеопроцессоров, типов памяти, частот и количества установленной видеопамяти недавно пополнилось свежими представителями бюджетного сегмента.

В нашем сегодняшнем тестировании мы рассмотрим две видеокарты из противоборствующих лагерей - ATI и NVIDIA. Если говорить кратко, то типичными представителями недорогих решений от ATI являлись видеокарты на основе Radeon 9550/9600 и X700, который относится скорее к верхней границе рассматриваемого сегмента. Бюджетные решения от NVIDIA базируются в основном на чипах 6200/6600 с различными вариациями частот и разрядности шины памяти.

Как вы знаете, новая "тысячная" серия от ATI, анонсированная этой осенью, включает в себя и бюджетных представителей по имени X1300 и X1300Pro. От старожилов бюджетного сегмента, данные новички отличаются новой архитектурой, включающей в себя существенно переработанный контроллер памяти RingBus, оптимизацию выполнения сложных шейдеров, расширенные функции обработки видеопотоков AVIVO.

В отличие от ATI, компания NVIDIA не стала "придумывать велосипед" и выпустила всего лишь обновленную версию 6600. "Новинка" теперь комплектуется памятью типа DDR2, что, безусловно, должно положительно сказаться на повышении производительности. Частоты чипа тоже несколько повышены, поскольку тех. процесс тонкий, хорошо отлажен и запас есть.

Мы решили в этом обзоре протестировать две данные видеокарты вместе не потому, что они являются прямыми конкурентами, а потому, что они обе являются лишь новыми игроками бюджетного сегмента. Остальные бюджетные видеокарты нам уже довольно хорошо знакомы, и можно без труда подобрать подходящих друг другу соперников. Цены на видеокарты, рекомендованные производителями, и цены непосредственно на прилавках магазинах могут заметно отличаться, а для бюджетного сегмента даже 10 уе разницы, бывает, выглядят существенно, особенно в процентном отношении. Поэтому - оставим право выбора за покупателем, а вся информация, приведенная здесь, надеюсь, поможет сделать этот выбор осознанным.

Radeon X1300Pro

К нам в лабораторию попал пока только инженерный образец Radeon X1300Pro, поэтому вопрос оформления коробки и комплектации придется оставить в стороне. Сама же видеокарта является типичным представителем данного семейства, следовательно, можно ожидать, что продемонстрированные ей результаты будут в той или иной степени справедливы и для всех серийных видеокарт X1300Pro.

![X1300Pro vs 6600 DDR2]()

Как видите, видеокарта довольно небольших размеров, система охлаждения закрывает только видеопроцессор и не касается чипов видеопамяти. На данной видеокарте не установлен чип видеозахвата, хотя место для него на PCB присутствует.

![X1300Pro vs 6600 DDR2]()

На оборотной стороне PCB установлены 4 микросхемы видеопамяти. В остальном больше ничего примечательного там нет, кроме разве что наклейки, из которой мы узнаем, что данный инженерный образец датирован 14-м сентября 2005 года.

![X1300Pro vs 6600 DDR2]()

Сняв радиатор видим, что на лицевой стороне видеокарты расположены еще 4 микросхемы видеопамяти.

![X1300Pro vs 6600 DDR2]()

Видеопамять производства Infineon, время выборки 2,5 нс, что соответствует рабочей частоте 800 МГц DDR. Собственно, но этой частоте видеопамять и работает. 8 микросхем в сумме дают 256 Мб установленной видеопамяти.

![X1300Pro vs 6600 DDR2]()

Размер кристалла видеопроцессора поражает, таких малюток мы еще не видели. Сам чип сделан в августе 2005 года. Давненько, однако.

![X1300Pro vs 6600 DDR2]()

"Система охлаждения" тоже довольно проста - медное основание с напаянной "гармошкой", образующей ребра. Прямолопастная турбина всегда крутится на максимальных оборотах, а они немаленькие. К сожалению, такой шум долго выносить довольно трудно, впрочем, в серийных изделиях мы наверняка увидим решение этой проблемы.

Особо рассматривать в инженерном образце X1300Pro больше нечего. Перейдем к другому "новому" представителю бюджетного сегмента. 6600 DDR2.

XFX 6600 DDR2

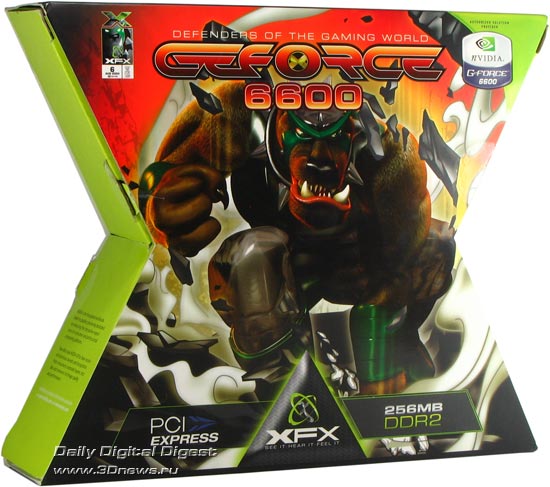

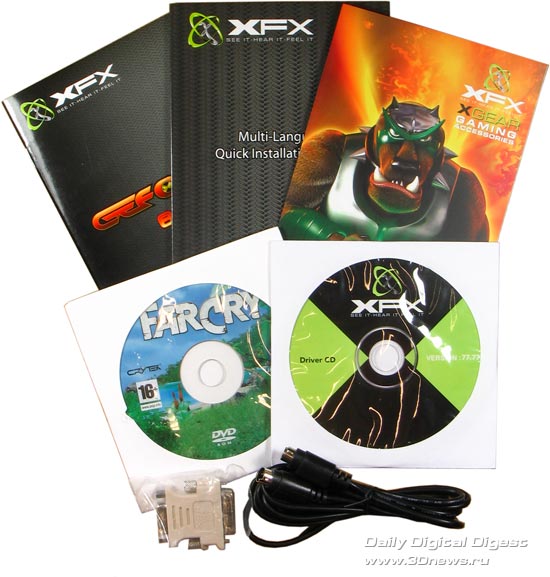

В качестве обновленной 6600 с установленной памятью DDR2 сегодня выступает экземпляр от компании XFX.

![6600DDR2 vs 6600 DDR2]()

К оформлению своего продукта сотрудники компании подошли творчески. Коробка выполнена в виде стилизованной буквы "Х", что, по всей видимости, символизирует первую букву в названии компании. В отличие от привычных прямоугольных коробок, такую точно ни с чем не спутаешь.

![6600DDR2 vs 6600 DDR2]()

На обратной стороне коробки перечислены все используемые в видеокарте технологии, присутствует круглая эмблема, заявляющая об экстремальном разгоне, быстрой памяти и суперсистеме охлаждения. Впрочем, вглядываясь в прозрачное окно, за которым видна видеокарта, насчет суперсистемы охлаждения закрадываются определенные сомнения.

![6600DDR2 vs 6600 DDR2]()

Внутри внешней коробки, оказывается, скрывается коробка поменьше. Компания XFX картона не пожалела. Хочется надеяться, что это оригами не отразится на кошельке нас, покупателей.

![6600DDR2 vs 6600 DDR2]()

В этой маленькой коробочке, в свою очередь, как раз и находится видеокарта с аксессуарами. Набор особым богатством не блещет, да это и понятно, как никак бюджетное решение. Так ли необходима в комплекте игра FarCry, вопрос спорный. Впрочем, почему нет, лишь бы на цене не сказывалось.

![6600DDR2 vs 6600 DDR2]()

Дизайн видеокарты вполне обычен для бюджетных решений. Разве что все 8 микросхем памяти расположены на лицевой стороне. Систему охлаждения "системой" назвать трудно. Это просто квадратный алюминиевый радиатор с кулером. Однако этого вполне достаточно для нормального охлаждения видеопроцессора, при этом кулер практически не слышно.

![6600DDR2 vs 6600 DDR2]()

На обратной стороне видеокарты ничего примечательного не находится. Да и с чего ему там взяться.

![6600DDR2 vs 6600 DDR2]()

Видеопроцессор - проверенный временем 6600. Выпущен на 37-й неделе 2005 года. Рекомендуемая компанией NVIDIA частота GPU составляет 350 МГц, однако на плате от XFX GPU работает на частоте в 400 МГц.

![6600DDR2 vs 6600 DDR2]()

Переходим к тестированию.

Характеристики видеокарт

В данной таблице собраны основные характеристики рассматриваемых сегодня видеокарт. Характеристики "классической" GeForce 6600 приведены в качестве "отправной точки". Как видно из таблицы, GeForce 6600 DDR2 отличается лишь типом используемой памяти и несколько повышенными частотами. Radeon X1300Pro отличает прежде всего большая рабочая частота GPU. Количество пиксельных конвейеров и текстурных модулей хотя и в два раза меньше, чем у GeForce 6600, но новая архитектура, высокоэффективный контроллер памяти и оптимизация выполнения сложных шейдеров еще себя проявят.

Разгон

Сравнительный анализ видеокарт ATI Radeon X1300 и NVIDIA GeForce 6600 GT по всем известным характеристикам в категориях: Общая информация, Технические характеристики, Видеовыходы и порты, Совместимость, размеры, требования, Поддержка API, Память. Анализ производительности видеокарт по бенчмаркам: PassMark - G3D Mark, PassMark - G2D Mark.

ATI Radeon X1300![ATI Radeon X1300]()

NVIDIA GeForce 6600 GT![NVIDIA GeForce 6600 GT]()

Преимущества

Причины выбрать ATI Radeon X1300

- Видеокарта новее, разница в датах выпуска 1 year(s) 1 month(s)

- Более новый технологический процесс производства видеокарты позволяет её сделать более мощной, но с меньшим энергопотреблением: 80 nm vs 110 nm

- Производительность в бенчмарке PassMark - G2D Mark в 2.2 раз(а) больше: 237 vs 108

Характеристики Дата выпуска 5 October 2005 vs 12 August 2004 Технологический процесс 80 nm vs 110 nm Бенчмарки PassMark - G2D Mark 237 vs 108 Причины выбрать NVIDIA GeForce 6600 GT

- Частота ядра примерно на 11% больше: 500 MHz vs 450 MHz

- Скорость текстурирования в 2.2 раз(а) больше: 4 GTexel / s vs 1.8 GTexel / s

- Максимальный размер памяти больше в 2 раз(а): 256 MB vs 128 MB

- Частота памяти в 2 раз(а) больше: 1000 MHz vs 500 MHz

- Производительность в бенчмарке PassMark - G3D Mark примерно на 91% больше: 111 vs 58

Характеристики Частота ядра 500 MHz vs 450 MHz Скорость текстурирования 4 GTexel / s vs 1.8 GTexel / s Максимальный размер памяти 256 MB vs 128 MB Частота памяти 1000 MHz vs 500 MHz Бенчмарки PassMark - G3D Mark 111 vs 58 Сравнение бенчмарков

GPU 1: ATI Radeon X1300

GPU 2: NVIDIA GeForce 6600 GTЧитайте также:

- Не устанавливается vlc на андроид

- Файл имеет расширение отличное от txt и sls

- Низкоуровневое форматирование hdd seagate

- Как узнать ip адрес ps3

- Как создать img файл