Как делать фэкт файл

Обновлено: 02.07.2024

Статья будет интересная прежде всего изучающим программирование на C/C++ в UNIX-подобных системах от самых корней, без использования IDE.

Компилировать проект ручками — занятие весьма утомительное, особенно когда исходных файлов становится больше одного, и для каждого из них надо каждый раз набивать команды компиляции и линковки. Но не все так плохо. Сейчас мы будем учиться создавать и использовать Мейкфайлы. Makefile — это набор инструкций для программы make, которая помогает собирать программный проект буквально в одно касание.

Для практики понадобится создать микроскопический проект а-ля Hello World из четырех файлов в одном каталоге:

Все скопом можно скачать отсюда

Автор использовал язык C++, знать который совсем не обязательно, и компилятор g++ из gcc. Любой другой компилятор скорее всего тоже подойдет. Файлы слегка подправлены, чтобы собирались gcc 4.7.1

Программа make

Если запустить

make

то программа попытается найти файл с именем по умолчание Makefile в текущем каталоге и выполнить инструкции из него. Если в текущем каталоге есть несколько мейкфайлов, то можно указать на нужный вот таким образом:

make -f MyMakefile

Есть еще множество других параметров, нам пока не нужных. О них можно узнать в ман-странице.

Процесс сборки

Компилятор берет файлы с исходным кодом и получает из них объектные файлы. Затем линковщик берет объектные файлы и получает из них исполняемый файл. Сборка = компиляция + линковка.

Компиляция руками

Самый простой способ собрать программу:

g++ main.cpp hello.cpp factorial.cpp -o hello

Каждый раз набирать такое неудобно, поэтому будем автоматизировать.

Самый простой Мейкфайл

В нем должны быть такие части:

Для нашего примера мейкфайл будет выглядеть так:

Обратите внимание, что строка с командой должна начинаться с табуляции! Сохраните это под именем Makefile-1 в каталоге с проектом и запустите сборку командой make -f Makefile-1

В первом примере цель называется all . Это цель по умолчанию для мейкфайла, которая будет выполняться, если никакая другая цель не указана явно. Также у этой цели в этом примере нет никаких зависимостей, так что make сразу приступает к выполнению нужной команды. А команда в свою очередь запускает компилятор.

Использование зависимостей

Использовать несколько целей в одном мейкфайле полезно для больших проектов. Это связано с тем, что при изменении одного файла не понадобится пересобирать весь проект, а можно будет обойтись пересборкой только измененной части. Пример:

Это надо сохранить под именем Makefile-2 все в том же каталоге

Теперь у цели all есть только зависимость, но нет команды. В этом случае make при вызове последовательно выполнит все указанные в файле зависимости этой цели.

Еще добавилась новая цель clean . Она традиционно используется для быстрой очистки всех результатов сборки проекта. Очистка запускается так: make -f Makefile-2 clean

Использование переменных и комментариев

Переменные широко используются в мейкфайлах. Например, это удобный способ учесть возможность того, что проект будут собирать другим компилятором или с другими опциями.

Это Makefile-3

Переменные — очень удобная штука. Для их использования надо просто присвоить им значение до момента их использования. После этого можно подставлять их значение в нужное место вот таким способом: $(VAR)

Что делать дальше

После этого краткого инструктажа уже можно пробовать создавать простые мейкфайлы самостоятельно. Дальше надо читать серьезные учебники и руководства. Как финальный аккорд можно попробовать самостоятельно разобрать и осознать такой универсальный мейкфайл, который можно в два касания адаптировать под практически любой проект:

Приложение CapCut позволяет бесплатно редактировать видео и создавать отличные видеоролики без особых усилий. Оно позволяет сокращать объем, изменять скорость кадров, приближать кадры, вставлять текст, менять фон и имеет много других очень нужных при монтаже видео функций.

Как сделать видео в CapCut

CapCut предназначен для использования на всех моделях мобильных устройств, есть возможность менять скорость и накладывать рисунок пользователя поверх изображения. Чтобы сделать видео в CapCut, сначала необходимо его снять и загрузить в приложение.

Как делать эдиты в CapCut

Эдитами называют клипы, которые смонтированы из нарезок видео, нескольких фотографий или коллажей. Видеоряд в данном случае идет в такт музыкальному сопровождению. Чтобы сделать эдит в CapCut нужно открыть сервис, выбрать кнопку «Новый проект», далее выбрать те изображения, из которых вы будете делать эдит, укоротить его с помощью сжатия. Для сжатия надо навести ножницы на изображение. Сжатие надо проделать со всеми картинками, затем можно выбрать эффект анимации.

Для этого жмем на Edit, выбираем combo и далее выбираем интересную анимацию. С помощью «Audio» выбираем мелодию.

Как делать эффекты в CapCut

C помощью Effects можно выбрать любой эффект под любую ситуацию. Также в CapCut можно делать фото, вспышки, приближение, размещать текст на фоне видео или фото.

Переходы в CapCut делаются с помощью белого прямоугольничка с черной полоской внутри. Если нажать на него, можно выбрать переход в разных вариантах – от медленных до быстрых.

Регулировать скорость, замедление или убыстрение кадров можно с помощью специальной кнопки «Скорость».

Как делать футаж в CapCut

Футаж представляет собой короткий видеоролик, который создается специально для видеомонтажа. Например, он может быть в виде шаблона с текстом, анимированного фона и так далее. Приложение CapCut позволяет довольно быстро сделать футаж, используя различные кнопки вроде Effects или Text.

Как делать 3d в CapCut

Для обеспечения эффекта 3d надо выбрать инструмент «Изменить» (иконка в виде ножниц), перейти к функции «Стиль» - иконка в виде куба, после чего выбрать эффект, нажав на надпись «3D-увеличение».

В этой статье рассмотрено 6 способов как сделать zip архив в Windows 10. Если хотите сделать ZIP-файл на Windows 10 а не знаете как, тогда вот самые простые способы создания архивных папок.

Вы хотите создать ZIP-архив на своем компьютере с Windows? Существуют различные причины, по которым вы хотели бы сделать это. Может быть, вы хотите объединить несколько файлов в один архив? Или, может быть, вы хотите уменьшить размер ваших файлов, сжимая их в ZIP-архиве?Независимо от причины, существуют встроенные и сторонние опции создания ZIP-файла в Windows. Вот шесть простых способов создания ZIP архива в Windows 10 .

1. Создайте ZIP архив с помощью контекстного меню Windows

Один из самых простых способов создать ZIP файл на вашем ПК. Это использовать контекстное меню. В этом меню есть опция, которая позволяет добавлять выбранные файлы в ZIP-архив.

Для этого не нужно устанавливать какие-либо расширения или приложения. Эта функция доступна сразу после установки Windows 10.

Вы можете использовать эту опцию для добавления одного файла, нескольких файлов и даже папок в новый ZIP-архив. Вот как вы его используете:

Этот новый ZIP-архив помещается в ту же папку, что и ваши исходные файлы.

2. Используйте проводник для создания ZIP-файлов в Windows

Еще один встроенный способ создания ZIP-файла в Windows — это использование проводника файлов. Этот способ работает почти так же, как и пункт контекстного меню. И вы можете использовать его для добавления файлов и папок в новый ZIP-архив.

Используйте проводник для создания ZIP-файлов в Windows Используйте проводник для создания ZIP-файлов в WindowsВот как можно найти и воспользоваться этой функцией архивации:

3. Используйте командную строку Windows для создания ZIP-файлов

Если вы являетесь фанатом командной строки. Тогда этот способ точно для вас. Так как он полностью описывает метод создания Zip архива через командную строку.

Хочу заметить, что эта команда работает только в Windows 10.

В Windows 10 есть команда tar , которая помогает создавать или извлекать архивы на вашем компьютере. Вы можете использовать эту команду для добавления существующих файлов в ZIP-архив.

- Откройте окно командной строки на вашем компьютере.

- Используйте команду cd , чтобы перейти в папку, в которой находятся ваши файлы.

- Введите следующую команду в окне командной строки и нажмите Enter .

tar.exe -a -c -f output.zip myfile.txtЗаменить output.zip на любове другое имя, которое вы хотите дать своему ZIP-файлу.

myfile.txt файл который вы хотите добавить в ZIP-файл. - Командная строка создаст и сохранит ZIP-архив в текущем рабочем каталоге.

4. Программы для создания ZIP-файла в Windows

Windows 10 позволяет создавать ZIP-архивы без каких-либо приложений. Но эти возможности довольно ограничены и не совсем удобны. Если вам нужны дополнительные опции, такие как возможность выбрать уровень сжатия и разделить архив на несколько частей. Тогда вам потребуется скачать и установить дополнительные программы. Например:

7-Zip (free) это сторонний инструмент архивирования. Который вы можете использовать для создания, а также извлечения разных типов архивов на вашем компьютере. Эта программа предлагает такие опции, как разбитие архивов и добавление к ним защиты паролем. А так же многое другое.

Если вам интересны все функции 7-zip, напишите в комментарии,а я сделаю для вас подробный обзор с подробным описанием.

Краткая инструкция для создания ZIP-файла через команду 7-zip:

5. Добавьте файлы в существующий ZIP-файл в Windows

Если вы вдруг забыли добавить некоторые файлы при создании ZIP-архива. Не беспокойтесь, вы можете добавить файлы в существующий архив без каких-либо хлопот. Вам даже не нужна дополнительная программа. Вот что нужно сделать чтоб изменить существующий ZIP-архив:

- Откройте папку, в которой находится ваш ZIP-архив.

- В другом окне откройте папку с файлами которые вы забыли заархивировать.

- Теперь просто перетащите файлы в ZIP-архив.

- Теперь ваши файлы будут добавлены в ваш архив.

6. Как распаковать ZIP-файлы в Windows

В ОС Windows 10 можно извлечь файлы как через командную строку так и с помощью контекстного меню.

Сейчас термин стал общеупотребительным для обозначения алгоритмов и технологий картографирования лиц и изменения видео. Под DeepFake мы понимаем:

- смену лица;

- синтез лица, т.е. объединение разных образцов для создания нового композитного лица;

- манипуляции с атрибутом/выражением лица, вроде имитации улыбки или подмигивания.

Хотя манипуляции с видео далеко не новое явление, за последние годы произошло два больших изменения:

- методы стали более продвинутыми за счет использования алгоритмов машинного обучения, в то время как старые технологии требовали утомительного ручного редактирования видео;

- стало намного проще создавать собственные поддельные видео с помощью коммерческих приложений или программ с открытым исходным кодом.

Для создания DeepFake чаще всего используется две технологии, которые стоит рассмотреть немного подробнее.

Генеративные состязательные сети, или сокращенно GAN , представляют собой подход к генеративному моделированию с использованием методов глубокого обучения.

Генеративное моделирование – это задача обучения без учителя в машинном обучении, которая включает автоматическое обнаружение и изучение закономерностей во входных данных таким образом, чтобы модель можно было использовать для создания или вывода новых примеров, взятых из исходного набора данных.При использовании GAN совместно обучаются две конкурирующие нейронные сети: «Дискриминатор» и «Генератор». Затем модель генератора создает искусственные изображения с использованием случайного шума, а дискриминатор обучается различать настоящие образцы и подделки. Если вы выровняете GAN с достаточно большим набором обучающих данных (человеческих лиц), он научится генерировать довольно реалистичные подделки.

Принцип работы GAN

Автоэнкодеры

Другой популярный подход – использование автоэнкодеров.

Автоэнкодер состоит из компонента кодировщика и декодера, где роль автоэнкодера состоит в том, чтобы научиться кодировать входное изображение в представление более низкой размерности. Роль декодера – восстановить это представление обратно в исходное изображение. Закодированное представление содержит связанные с лицевыми характеристиками исходного изображения детали узора, вроде выражения лица.

Если не вдаваться в подробности, основная идея метода заключается в том, что если у вас есть пара обучающихся отдельно (но с общим кодировщиком) автокодировщиков, два автокодера будут изучать лица как цели, так и источника. Декодер для цели затем можно комбинировать с общим кодировщиком. Если в кодер поступает исходное видео, но он подключен к декодеру для целевого, это генерирует синтетический выходной сигнал с подобием источников и характеристиками цели.

Мобильные приложения

Теперь мы последовательно разберем создание DeepFake на примере трех коммерческих мобильных приложений и сравним результаты.

Reface

Reface , ранее известный как Doublicat – одно из многих коммерческих мобильных приложений, позволяющих создавать собственные видео/изображения для обмена лиц без программирования.

На веб-сайте Reface говорится, что программа реализует «прорывную технологию AI/ML с использованием Generative Adversarial Networks», но никакой конкретики не приводится.

Приложение позволяет подставлять лица в одно из множества видео или выбрать собственное видео из интернета. Можно также обрабатывать и сохранять несколько лиц – это дает возможность повторно использовать их без импорта. Поскольку Reface распознает все лица в видео, можно установить отдельное лицо для каждого персонажа.

Большинство функций приложения доступно бесплатно, но чтобы избавиться от водяных знаков, придется оплатить подписку Pro.

Impressions

Приложение накладывает лица известных людей на записанные пользователем видео. Выбрав знаменитость, загрузите ролик, а программа создаст дипфейк-версию.

Impressions также включает каталог аудиозаписей из популярных фильмов и телесериалов, которые можно синхронизировать по губам. Приложение загружает и обрабатывает видео на своих серверах, поэтому для работы требуется подключение к Интернету.

Пока Impressions доступен только на iPhone или iPad, но компания-разработчик утверждает, что скоро появится версия и для Android. Приложение бесплатно при условии, что на клипах остается водяной знак.

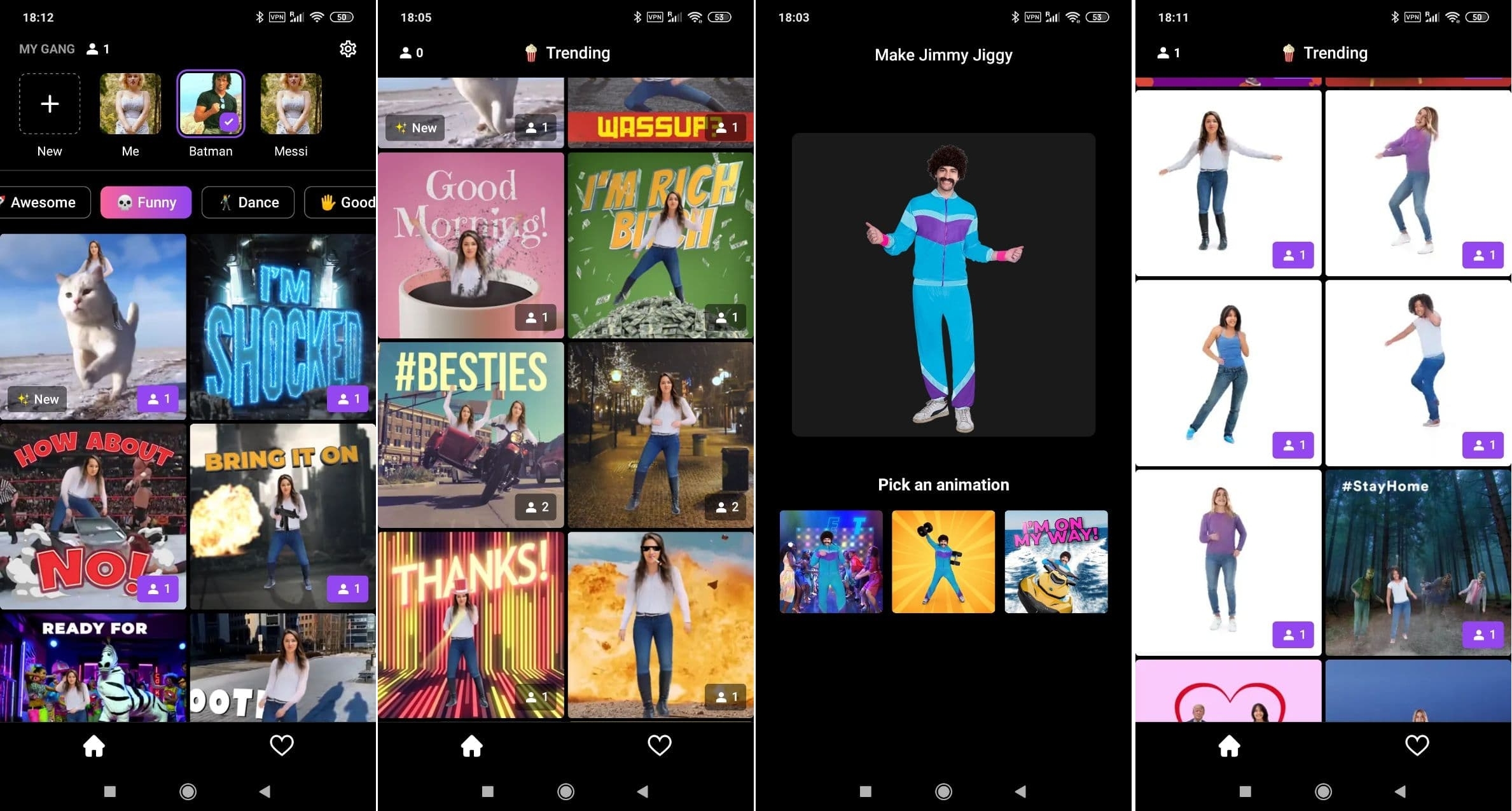

Jiggy

Jiggy позволяет воспользоваться технологией создания дипфейков для развлечения. Приложение предлагает десятки танцевальных видео, в которые можно втиснуть свое или чужое лицо, загрузив фотографию. Jiggy также сканирует верхнюю часть тела, чтобы наложить ее на танцующего персонажа.

Как и Reface, Jiggy оживляет выражение и движения лица.

Приложения вроде Reface, Impressions и Jiggy позволяют легко попробовать модную технологию, не прибегая к программированию и вообще не вникая в технологические нюансы. Мы на этом не остановимся и далее рассмотрим более полное руководство по созданию DeepFake на коленке.

Делаем DeepFake при помощи модели движения первого порядка за 5 минут

Методология и подход

Новый способ анимации исходного изображения на основе видеоролика не требует дополнительной информации или аннотаций к объекту. Модель использует обученную для восстановления видео из неподвижного изображения нейронную сеть, а также движения на видео, которое изучается во время обучения. По исходному изображению и движущемуся видео можно предсказать, как изображенный объект перемещается в соответствии с движением на этих кадрах.Модель отслеживает движения головы, разговоры, слежение за глазами и даже движения тела.

Исходный код модели находится на GitHub . Там же можно найти все необходимые пояснения, чтобы установить ее на свою машину, при необходимости переучить и протестировать, но мы пойдем еще более простым путем, который вообще не потребует разбираться с кодом.

Пошаговое руководство

Чтобы сделать собственный DeepFake, мы используем бесплатный облачный сервис Google Colab . Он основан на Jupyter Notebook и предоставляет всё необходимое для машинного обучения прямо в браузере. Вам понадобится только аккаунт Google.

Шаг 1. Откройте в браузере файл ipynb и скопируйте его на свой Google Диск. Это заранее подготовленный алгоритм машинного обучения.

Шаг 2. Запустите первый процесс, чтобы скачать ресурсы и настроить параметры модели.

Шаг 3. Дождитесь вывода надписи CONFIGURE DONE . Чтобы проверить, промотайте страницу вниз.

Шаг 4. При помощи второго скрипта можно протестировать алгоритм, используя заранее заготовленную коллекцию видео и фото. Выберите исходное изображение, запустите run и дождитесь результатов.

Шаг 5. Чтобы сделать собственное видео, вам потребуется перетащить в папку проекта изображение и исходное видео для анимации.

Шаг 6. После этого скопируйте путь к ним, пропишите его в соответствующих полях третьего сценария и нажмите запуск.

Вуаля, Сталлоне уже требует от вас одежду, ботинки и мотоцикл:

Подводные камни

Представленный способ не универсален и может иногда выдавать неожиданные результаты. Учитывая личный опыт, приведем несколько рекомендаций:

- чтобы сократить время обработки, стоит использовать небольшие видеоролики (до 30 секунда и до 5 МБ) – это ускорит обработку и предотвратит зависание процесса;

- для достижения наилучшего результата используйте изображение и видео с одинаковым соотношением сторон и обрезанным лицом – на видео не должно быть других предметов кроме лица, иначе результат может оказаться неожиданным;

- Постарайтесь обеспечить одинаковую пропорцию головы и фона на целевом изображении и во всем видео

DeepFaceLab

Говоря о дипфейках, нельзя забывать про DeepFaceLab. Подробный пошаговый туториал по этой нейросетевой библиотеке уже публиковался на нашем сайте. Этот инструмент требует мощного железа и/или больших затрат времени и не входит в категорию создания DeepFake на коленке, но если вы хотите глубже погрузиться в тему, начать стоит с него.Для ознакомления с технологией создания DeepFakes или для развлечения вполне можно попробовать Reface или Impressions. Этих мобильных приложений хватит, чтобы подшутить над друзьями или сделать забавное видео. Если вы хотите чуть глубже разобраться в технологии, но без дорогого железа и многих часов рендера, стоит попробовать модель движения первого порядка для анимации изображений в Google Colab: алгоритм позволит поэкспериментировать с разными исходниками и параметрами, но также не требователен к ресурсам вашего компьютера. Для более серьезных манипуляций присмотритесь к возможностям DeepFaceLab. Удачи!

Эта небольшая заметка не про комплектующие или их разгон, а про первичное знакомство с ПО, которое помогает "утилизировать" мощь наших ПК для создания видео, получивших название DeepFake (и чем они мощнее - тем более качественный фейк мы сможем сделать за более короткое время). Это мой первый опыт написания "статьи", надеюсь блин выйдет не слишком уж большим комом. :)

DeepFake, DeepNude, Deep. - всё чаще слова с данным корнем звучат с экранов ТВ или пестрят в заголовках статей и блогов, заманивая сочной провокационной картинкой на обложке. Нейросети всё лучше учатся распознавать или изменять наши лица, тела, голоса. Всё труднее становится заметить эти подделки даже профессионалам. Источник скандалов и дискредитации известных персон, удел мошенников или просто обычное хобби и весёлый досуг? Всё зависит от чистоты помыслов людей, в чьих руках (особенно если прямых) оказывается подобное ПО. Моё внимание к данного рода программам привлекли видео, где Сталлоне остался "Один дома" и был вместо Арнольда в "Терминатор 2". Захотелось попробовать и узнать - насколько реально освоить это ремесло человеку, не обладающему знаниями в этой области, а также и не имеющему особых навыков использования фото- и видеоредакторов?! Попробуем разобраться вместе!

MSI RTX 3070 сливают дешевле любой другой, это за копейки Дешевая 3070 Gigabyte Gaming - успей пока не началось

Скачав данный пакет программ (DeepFaceLab) около недели назад, я был несколько ошарашен, ибо перед моим взором предстала следующая картина:

Однако постепенно, шаг за шагом изучая обучающие видео и pdf файл обучения, пробуя что-то с этим всем добром сделать, я понял, что это - большой труд, который проделал автор данного ПО, чтобы облегчить наше бремя создания видеофейков. Сильно глубоко вдаваться в сам процесс создания DeepFake (далее DF) не буду: для этого есть, уже упомянутые выше - видео на ютуб от автора, других умельцев и мануал (или писать отдельную статью). Но некоторые пояснения, которые возможно смогут помочь людям, решившим бросить вызов коварным нейросетям, я, с вашего позволения, попробую сообщить.

1. Про железо, куда же без него родного! Кроме очевидного (конец первого абзаца), тут есть некоторые нюансы: т.к. лимитирующим по времени этапом создания DF является тренировка нейросети (далее ИИ), которое происходит на видеокарте (CUDA предпочтительнее, но можно даже на встройке!), то именно её параметры будут нам важнее, чем CPU. Мощь ядра и большой объём VRAM - ускоряют процесс и позволяют использовать более "тяжёлые" настройки, влияющие как на скорость некоторых операций, так и качество итогового видеоматериала. Автор пакета выставил следующие требования к комплектующим:

Минимальные системные требования: Windows 7 и выше, процессор с поддержкой SSE инструкций, 2Gb ОЗУ с подкачкой, OpenCL-совместимая видеокарта (NVIDIA, AMD, Intel HD Graphics)

Рекомендуемые системные требования: Windows 7 и выше, процессор с поддержкой AVX инструкций, 8Gb ОЗУ, NVIDIA видеокарта 6GB видео памяти.

реклама

var firedYa28 = false; window.addEventListener('load', () => < if(navigator.userAgent.indexOf("Chrome-Lighthouse") < window.yaContextCb.push(()=>< Ya.Context.AdvManager.render(< renderTo: 'yandex_rtb_R-A-630193-28', blockId: 'R-A-630193-28' >) >) >, 3000); > > >);Из чего можно сделать вывод, что лучше использовать карты уровня GeForce GTX 1060 (и более поздние аналоги) для nVidia или AMD Radeon 470 и выше. Мой конфиг: Ryzen 7 1800X @ 4.0 GHz, GeForce GTX 1080 Ti.

2. Отбор видеоматериала источника лица и видео, из которого делают DF - огромное, если не решающее, влияние на итоговый результат. Лучше использовать FHD исходники, ну или уж хотя бы честный HD. Выбор персонажей для источника лица и под замену - второй кит, на котором держится успешность нашего фейка. Если вы заменяете, например, блондинку с прямыми волосами на брюнетку с пышными - есть не иллюзорный шанс получить плохую узнаваемость героя DF. Худых моделей легче "вписать" в толстых, что наверное логично. Есть конечно исключения - вдруг вы, наоборот, хотите довести фэйк до абсурда и вписываете специально какие-то нелепые соотношения моделей (старика в ребёнка и т.д.). Такой подход тоже вполне имеет право на жизнь! Последний этап "пробоподготовки" - тщательно проверить: какие лица выделил детектор лиц, а он выделяет ВСЮ массовку! И приходится переназначать такие кадры вручную. Тренироваться лучше начинать на простых сценах, где 1 человек, и он более менее статичен: пресс-конференции, монологи и всё в таком духе. По мере увеличения способностей, повышать сложность сцены. Ещё очень важный момент при отборе лиц: SRC - это лицо, которые мы хотим вставить. DST - лицо, заменяемое в нашем фэйке. SRC лицо - нужно очень серьёзно "просеивать": удалять кадры, где чем-то закрывается лицо, размытые, смазанные и т.д. Оставлять только чёткие! А DST наоборот - нам нужны абсолютно все кадры с данным лицом, а иначе потом будут пропуски кадров, и настоящий герой видео будет возвращаться в фэйк.

3. Тренировка ИИ. Сложный процесс, имеющий кучи, непонятных не только новичку, но и чуть более опытным пользователям, настроек (в продвинутых моделях), поэтому лучше начинать либо с H64 или с DF (в данном случае это название модели для тренировки), т.к. они проще. Хотя можно запускать и более сложные модели, такие как SAE и SAE HD, в режиме "по умолчанию", главное чтобы хватило VRAM, иногда надо снижать некоторые параметры. Тренировать ИИ рекомендуют ОТ одного дня. Но на картах уровня 1080ti и выше, на мой взгляд, это время можно сократить, но исходя из результата, который выводится на экран в процессе тренировки. Пример:

реклама

Выложу свой стандартный алгоритм создания DF, который поможет в самостоятельном освоении:

- 2) extract images from video data_src (источники лиц - им заменяют)

- 3.2) extract images from video data_dst FULL FPS (лицо, которое будет заменено)

- 4) data_src extract faces S3FD all GPU (детектирование лиц источника)

- [4.1) data_src check result] (удаляем всех левых персонажей, ошибочные кадры - крупные массивы фото, остальное отсеем позже)

- 4.2.2) data_src sort by similar histogram

- 4.1) data_src check result

- 4.2.1) data_src sort by blur

- 4.1) data_src check result (удалить мутные)

- 4.2.6) data_src sort by best (автоматика сама отбирает лучшие лица и удаляет ненужные, можно сразу использовать только этот пункт и потом вручную проверить, не осталось ли там "неликвида")

- 5) data_dst extract faces S3FD all GPU (детектирование лица "под замену")

- [5.1) data_dst check results]

- 5.2) data_dst sort by similar histogram

- 5.1) data_dst check results

- 5.3) data_dst sort by blur (Ручная проверка и удаление кадров, где несколько лиц или не совсем корректно определены контуры нужного лица в папке DeepFaceLab\workspace\data_dst\aligned_debug).

- 5) data_dst extract faces MANUAL RE-EXTRACT DELETED

RESULTS DEBUG (восстановление удалённого и последующая ручная разметка маски лица) - 6) train SAE HD (тренировка модели, можно брать другую использовав соответвующий *.bat файл)

- 7) convert SAE HD (замена dst лица на src, используя натренированную ранее модель)

- 8) converted to mp4 ("склеивание" стоп-кадров в видео)

Здесь "2) extract images from video data_src" - это "батник" "2) extract images from video data_src.bat" из папки "DeepFaceLab" и т.д. Эх, наверное сумбур уже пошёл, и я тут чутка перегрузил терминами, которые сложно воспринимать без подробного описания, а писать полную статью с подробным описанием всех действий - я в данный момент не потяну. При просмотре самых вводных видео от автора ПО - многое встанет на свои места. Если не хотите пока забивать голову, можно бегло пробежать по видео ниже, чтобы понять приблизительный уровень DF у человека, который неделю (плотно) пытался разбираться в этом вопросе. И сделать какие-то выводы о дальнейшей целесообразности самостоятельных попыток создания DeepFake видео.

Вывод: за неделю ознакомиться с данным пакетом можно, но получить реально хороший уровень фэйков - тяжело (если конечно вы не гений :)), потому что многие параметры моделей можно подбирать только эмпирическим путём или общаясь с более опытными фэйкерами, например, на рутрекере.

Привожу варианты своих "работ", чтобы вы могли оценить приблизительный уровень и некий прогресс в динамике обучения. Если она вообще имеется конечно. Все видео приводить не буду, можно поглядеть на моём канале. Только основные вехи.

Самое первое видео, его исходники идут в комплекте DeepFaceLab, т.е. и предназначены для первых тренировок (файлы data_dst.mp4 и data_src.mp4 в папке "DeepFaceLab\workspace", свои видеофайлы вы в дальнейшем должны называть также, чтобы программа их подхватывала и использовала).

Тут особо и комментировать нечего, ляп на ляпе. По сути, я в тот момент просто жал почти везде "Enter" и всё было в режиме "по умолчанию", т.к. я ещё мало что понимал и не умел менять настройки (модели масок, цветовые и почти все прочие). Это делается уже почти в конце, на этапе "7) convert SAE HD" из алгоритма выше. Время тренировки модели - около 3-4 часов.

Далее пошёл этап набивания шишек (я многие из них уже озвучил ранее): когда наше видео по качеству хуже чем источник - получается, что очень сильно заметны грани заменённого лица. Один раз я не заметил, что детектор не взял некоторые лица, и они потом исчезли в видео. Выбор слишком сложных динамических сцен, совершенно разное освещение SRC и DST лиц - тоже получается слишком "топорная" вставка.

Пример ошибки со вставкой Поклонской в Шурыгину - она довольно тяжело узнаётся из-за совсем разных причёсок и цвета волос:

Тут на миг пропадает лицо Греты (замена на неизвестную широкой общественности журналистку):

Ну и в самом конце, самый последний фэйк, который закончил только сегодня - тренировал 16 часов, личный рекорд пока что. Само обращение очень сочное, хорошего качества, а мой источник лица немного не дотягивает до такого уровня детализации и цветопередачи, возможно если продолжить тренировку модели с некоторыми другими настройками - его качество ещё можно поднять:

Если кого-то заинтересовала данная тема - скачивайте DeepFaceLab, устанавливайте и вперёд! Какие-то моменты могу попробовать подсказать, но в Интернете достаточно подробных рукописных и видеогайдов.

Читайте также: