Не создается dag файл

Обновлено: 05.07.2024

В феврале мы писали о том, что Antminer E3 перестал майнить Ethereum Classic. Проблема заключалась в DAG-файле, размер которого постоянно увеличивается. В этот раз в зоне риска оказались видеокарты на 4 ГБ. Накануне некоторые их владельцы не смогли майнить Ethereum и Ethereum Classic из-за того же DAG-файла. Рассказываем, как обойти ограничение для разного программного обеспечения и ферм.

Что такое DAG-файл?

Для понимания проблемы нужно окунуться в теорию. DAG — это большой файл, который необходим для майнинга Эфириума, Ethereum Classic и других монет на алгоритме Ethash. Он загружается в память видеокарт при каждом запуске майнера. Если у вас много GPU, все они делают это. В общем, без DAG майнинг на алгоритме Ethash работать не будет — это базовый принцип.

Размер DAG-файла постоянно увеличивается. Видеокарты с 2 ГБ памяти перестали справляться с майнингом Эфириума в конце 2016 года. Устройства на 3 ГБ сделали то же самое в конце 2018 года. И сейчас — в 2020 — с подобным начинают сталкиваться 4-гигабайтные видеокарты. Но не стоит переживать, из ситуации можно выйти.

Настройки для Phoenix Miner

Phoenix Miner — один из самых надёжных и простых решений для майнинга Ethash-монет. Он в том числе включён в архив для быстрого старта майнинга. Пароль — 2miners.

У Phoenix Miner есть специальный параметр -rvram. Он устанавливает объём зарезервированной памяти, которая не может использоваться для майнинга. По умолчанию он составляет 384 МБ для Windows и всего 128 МБ для Linux. Здесь всё просто: чтобы продолжить майнить Ethereum на видеокартах с 4 ГБ, необходимо отключить это разделение памяти. Для этого устанавливаем -rvram на 1.

Добавление параметра rvram

Майнеры из чата майнинг-пула 2Miners также рекомендуют для видеокарт AMD на Windows поставить драйвер 20.4.2 и установить утилиту AMD-Compute-Switcher. При такой конфигурации майнинг идет без потери скорости.

Итог: добавьте -rvram 1 в ваш .bat-файл, для Windows установите драйвер 20.4.2 и AMD-Compute-Switcher.

Настройки для Claymore’s Miner

Ещё один популярный майнер для добычи Ethash-монет на видеокартах AMD и Nvidia — Claymore’s. У Claymore’s есть так называемый параметр -eres. Он заранее выделяет память видеокарты для определённого количества эпох.

Напомним, эпоха обозначает рост объёма DAG-файла. Увеличение показателя в Ethash-монетах происходит каждые 30 тысяч блоков, а сама процедура известна как “смена эпохи”.

Если eres установлен на 2, программное обеспечение выделит память видеокарты, достаточную для майнинга в нынешней и следующих двух эпохах. После этого нужно будет снова перераспределить память. Увы, для каждой процедуры выделения памяти требуется время. Поэтому видеокарты с большим объёмом памяти могут использовать высокие значения eres, чтобы его сэкономить. А вот для карт с небольшим объёмом памяти схема обратная: нужно устанавливать eres на 0, чтобы GPU не выделяла под майнинг больше памяти, чем необходимо в данный момент.

К сожалению, размер DAG-файла вырос настолько, что нам не удалось запустить Claymore’s майнер на Windows на 4GB картах ни при каких условиях, увы. Используйте только Linux и параметр -eres 0.

Итог: Claymore’s майнер на Windows для 4GB больше нельзя использовать, даже если применять хитрые настройки.

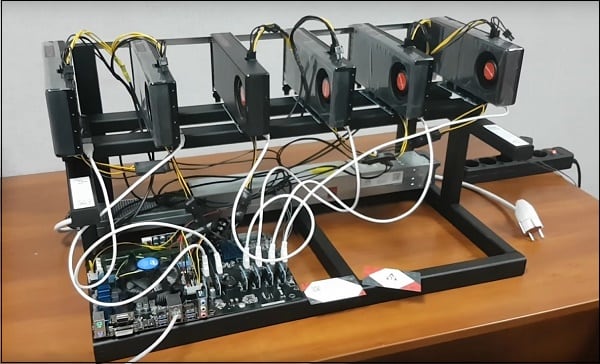

Измените конфигурацию майнинг-фермы

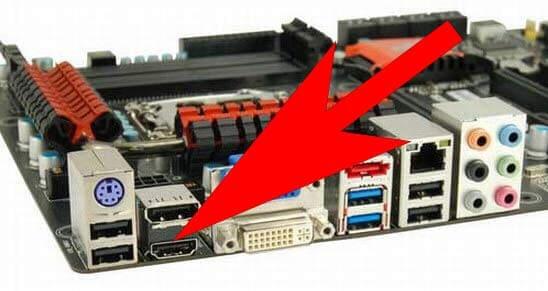

Если ваша майнинг-ферма состоит из разных видеокарт, у некоторых из них наверняка больше памяти, чем у остальных. Так вот, поместите эти более продвинутые карты с большим объёмом памяти в первый x16 PCIe слот — также известный как нулевой слот.

Например, если у вас шесть видеокарт с 4 ГБ памяти и две с 8 ГБ, пусть одна из “восьмёрок” будет GPU0, то есть поместить её в нулевой слот. Ниже — изображение материнской платы ASUS Z270-P.

Итог: установите в нулевой слот видеокарту на 8 или 16 ГБ.

Перейдите с Windows на Linux

Windows требует больше памяти видеокарт, чем Linux — это факт. Если вы хотите и дальше использовать GPU на 4 ГБ, выбор операционной системы будет предельно важен. К слову, Phoenix и Claymore’s доступны для Linux.

Мы рекомендуем использовать один из специальных дистрибутивов Linux по типу HiveOS или SimpleMining OS. У них простой в использовании интерфейс для майнинга. Вдобавок у HiveOS есть предварительно настроенные файлы для всех пулов 2Miners, также известные как “полётные листы”. С ним процесс подготовки к майнингу будет ещё проще.

Итог: используйте Linux.

Когда мои видеокарты на 4 ГБ перестанут майнить Эфириум?

Даже если применить все перечисленные рекомендации, ваши видеокарты рано или поздно перестанут справляться с майнингом Ethereum и Ethereum Classic. Когда это произойдёт?

Мы предполагаем, что видеокарты на 4 ГБ перестанут майнить Ethash-монеты приблизительно на эпохе под номером 375. Естественно, с учётом конкретного оборудования и программного обеспечения это число может немного отличаться.

Для смены эпохи нужно 30 тысяч блоков, то есть эпоха 375 начнётся на блоке 11 250 000. Следить за нынешним номером блока можно на специальной странице. Вот ссылка для Эфириума, а вот — для ETC.

Нынешний блок в сети Эфириума

Сейчас сеть Эфириума на блоке 9 871 779.

11 250 000 - 9 781 779 = 1 378 221 (оставшихся блоков)

1 378 221 * 13 секунд = 17 916 873 секунды (среднее время блока в сети равно 13 секундам)

17 916 873 / 60 / 60 / 24 = 207 дней.

Если проделать те же вычисления для Ethereum Classic, который сейчас находится на высоте блока 10 187 286, получим 160 оставшихся дней на майнинг ETC на видеокартах с 4 ГБ.

Итог: видеокарты на 4 ГБ перестанут майнить Эфириум в январе 2021 года, а Ethereum Classic — в сентябре 2020 года.

Моя видеокарта больше не майнит Эфириум, что делать?

Если ваша видеокарта перестала справляться с майнингом Эфириума, выход всё равно есть. У других Ethash- монет — по типу CLO, ETP, PIRL и EXP — куда более ранняя эпоха, то есть их DAG-файл значительно меньше. Так что майнить эти монеты получится даже после того, как GPU не смогут майнить ETH и ETC.

Если у вас видеокарта Nvidia, вам будет немного легче, чем владельцам AMD-карт. Видеокарты от Nvidia обычно более гибкие и могут справляться с разными алгоритмами, а не только с Ethash. Хотя и устройства AMD с последней версией lolMiner выдают отличные результаты.

Еще материалы по теме

PXF, Greenplum и оптимизация SQL-запросов к разным источникам данных

На заметку разработчику Spark-приложений: 3 ошибки PySpark и тонкости Outer…

Комбо Apache Airflow и NiFi для запланированного запуска ETL-конвейеров: практическая…

Новое на сайте

Отзывы на Google

Курсы от инженеров и для инженеров. Всё чётко, по делу. Тренеры глубоко знают продукты, о которых читают лекции. read more

Принимал участие в обучении по курсу "KAFKA: Администрирование кластера Kafka". В целом понравилось, но хотелось бы более качественной организации работы с лабгайдами. Когда лектор выполняет лабораторную работу, не совсем удобно выполнять её параллельно - где-то отстаешь, где-то убегаешь вперед. Может будет лучше разделить на более мелкие модули. read more

Прошел Курс Администрирование кластера Hadoop. Подача материала хорошая, размеренная. Преподаватель отвечает на все вопросы, и пытается как можно прозрачней приподнести материал. read more

Обучался на программе HADM. Подача материала доступная. Порадовало соотношение теории и практики 50/50. Отзывчивый преподаватель. Однозначно рекомендую. read more

Заканчиваю прохождения курса "ADH: Администрирование кластера Arenadata Hadoop". Хочу сказать, что выстроен грамотный план обучения, где отслеживается отличное соотношение практики и теории. Преподаватель, Комисаренко Николай, обладает отличным чувством юмора, что позволило не скучать на серьезных темах, и обладает отличным навыком объяснять сложные вещи простыми словами. На курс приходил с большим числом вопросов, на все из которых получил грамотные ответы, после чего все разложилось по полочкам. read more

В декабре 2020 прошел курс "Администрирование кластера Kafka". Курс проводился удаленно. В части организации обучения придраться не к чему. Необходимую информацию прислали заранее, лабораторный стенд и портал обучения работали стабильно. Немного разочаровали лабораторные работы. На месте BigDataSchool я бы их переделал. В документах с лабами нужно сделать нормальное форматирование и нумерацию пунктов. Все пункты, необходимые для выполнения, нужно сделать в виде текста. В лабах много работ по созданию «обвязки» kafka (создание самоподписных сертификатов, развертывание MIT и т.п), которые можно сделать заранее. Это позволит студентам уделять больше времени изучению самой kafka. BigDataSchool идет навстречу и позволяет пользоваться лабораторным стендом гораздо дольше установленных часов обучения. Это очень к стати, если в течении дня Вы вынуждены отвлекаться от обучения. В целом, курс дает хорошую базу по kafka. Преподаватель хорошо подает материал, делает акценты в нужных местах, подробно отвечает на вопросы. read more

С 30 ноября по 4 декабря прошел курс "Администрирование кластера Hadoop". Учитывая, что я обладал довольно поверхностной информацией в данной теме (я CIO) - ушел с курсов просветленным. Многое стало понятным, в процессе обучения наложил знания на существующую инфраструктуру компании, в которой работаю. Рекомендую коллегам руководителям в ИТ - прокачаться на данном курсе, вы поймете куда двигаться в ближайшие 2-3 года. Админам, работающим или стремящимся в BigData- обязательно! Рекомендация - настойчиво, для тех кто "думает, что знает": перед курсом уделите время работе с командной строкой Linux! Total recall - обязательное условие. Много практической работы, и если есть затык в Linux - будете безнадежно отставать при выполнении лабораторных работ. read more

В октябре прошел курс Анализ данных с Apache Spark, это был второй раз, когда я обучался в этом месте. В целом, все хорошо, думаю что не последний. Не могу не подчеркнуть профессионализм преподавателя Королева Михаила, отвечал на поставленные вопросы, делился своим опытом. В общем, рекомендую! read more

Прошел тут курс "NIFI: Кластер Apache NiFi", вёл Комисаренко Николай. Живое и понятное обучение. Преподаватель отвечал на все вопросы от самых глупых, до самых умных и это было приятно. Так же порадовало, что преподаватель не идёт по заранее проложенным рельсам, а проходит весь путь вместе с вами, стараясь привнести, что-то новое. read more

Спасибо за обучение!

Очень крутое место, много практики, понятное объяснение заданной темы. Еще вернусь :) read more

Обучался на курсе HADM администрирование кластера Arenadata Hadoop. Интересный курс, хорошая подача. read more

Обучался на курсе по администрированию Apache Kafka. Хорошая подача материала, интересные практические задачи. Возникающие вопросы доходчиво и ясно объясняют. Остался очень доволен. read more

Был на курсе "Администрирование кластера Hadoop". Отличная подача материала. Очень много практики и технических подробностей. Подробный обзор стека технологий, платформы и инструментов. Рекомендую! read more

Учился на курсе Администрирование Hadoop. Курс вёл Николай Комиссаренко. Отлично подготовленная, продуманная, системная программа курса. Практические занятия организованы так, что у студентов есть возможность познакомиться с реальными особенностями изучаемого продукта. Отключил голову и прощёлкал лабы по книжке - здесь не работает. Преподаватель легко и развёрнуто отвечает на возникающие вопросы не только по теме предмета, но и по смежным. read more

Прошёл курс по администрированию Apache Kafka. Очень понравилась как подача материала, так и структура курса. Только вот времени маловато оказалось. не всё успел доделать, но это уже не к курсу претензии :). Практики было довольно много, и это хорошо read more

Прошёл курс "Hadoop для инженеров данных" у Николая Комиссаренко. Информация очень актуальна и полезна, заставляет задуматься о текущих методах работы с большими данными в нашей компании и, возможно, что-то поменять. Занятия с большим количеством практики, поэтому материал хорошо усваивается. Отдельное спасибо Николаю за то, что некоторые вещи объяснял простым языком, понятным даже для "чайников" в области Hadoop. read more

I did not find any disadvantages in the course. Pluses: + A lot of practice (50% of the time). + The teacher can explain difficult topics easy way. + Announced topics were considered. Besides additional materials were studied. read more

Посетил курс администрирование Hadoop. На курсе устанавливали кластер с нуля на виртуалках в облаке Amazon. Настраивали Kerberos, тестировали выполнение задач на кластере, управление ресурсами кластера. Т.к. кластер развернут в облаке, после завершения занятий можно самостоятельно работать с кластером из дома. Лекции вел Николай Комиссаренко, после обучения предоставил все материалы. На занятиях отвечал на дополнительные вопросы, рассмотрели как решить пару живых задач от студентов. Хороший курс для начала изучения BigData. Update Дополнительно прошел обучения по Airflow и NiFi. Курсы двух дневные упор на занятиях делался на использовании продуктов, администрированию уделялось меньше времени. Т.к. курсы короткие, то перед занятиями желательно почитать обзорные статьи по продуктам, чтобы не терять время на базовое погружение и задавать более предметные вопросы. Перед началом занятий желательно связаться с школой и запросить что больше интересуется на обучении. Может быть предложить свои кейсы, чтобы на лабораторных отработать не только общий функционал. read more

Был на основах хадупа, все материалы описаны доступным языком. В частности хочу отметить преподавателя Николая Комисаренко, как очень квалифицированного преподавателя и специалиста. read more

Отличные курсы по "Администрированию Hadoop" и отличная организация проведения занятий, все по делу и понятно. Очень понравилось, знания получены основательные. Материал подаётся основательно. Постараюсь ещё попасть на другие курсы. read more

Курс по Isilon у Николая Комиссаренко мне тоже понравился. Грамотный и отзывчивый. Возникали вопросы по курсу он отвечал на все вопросы. Спасибо. Успехов ему read more

Посетил курс администрирование Hadoop. На курсе устанавливали кластер с нуля на виртуалках в облаке Amazon. Настраивали Kerberos, тестировали выполнение задач на кластере, управление ресурсами кластера. Т.к. кластер развернут в облаке, после завершения занятий можно самостоятельно работать с кластером из дома. Лекции вел Николай Комиссаренко, после обучения предоставил все материалы. На занятиях отвечал на дополнительные вопросы, рассмотрели как решить пару живых задач от студентов. Хороший курс для начала изучения BigData. read more

Эффективный практический курс. Прошел курс Администрирование Hadoop в октябре 2018. Хорошо наполненный материал, оптимальная длительность курса и все делалось своими руками. Местами было непросто, но преодолимо. Оправдал все ожидания, после курса появилось целостное понимание создания и работы кластера. Николай, большое спасибо read more

Прошёл курс по администрированию Hadoop Cloudera. Отличная "живая" подача материала на "простом" языке. Как плюс работа с кластером построена на платформе AWS. На курсах не скучно, рекомендую! read more

Я узнал много нового посетив курс уважаемого Николая Комиссаренко по айзелону. Очень грамотный специалист обучение было очень полезным и грамотным. Спасибо вам большое read more

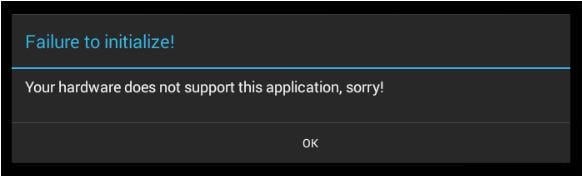

Перевод и причины проблемы

Такой объём памяти должен быть достаточно вместительным для того, чтобы в нём поместился упомянутый в тексте ошибки DAG-файл – блок данных размером более 1 Гб, задействованный для поиска решений блока в сети блокчейн с помощью алгоритма «Dagger Hashimoto». В процессе майнинга размер DAG-файла постоянно увеличивается, и со временем начинает превышать объёмы памяти стандартных видеокарт (2-3 гигабайта). При запуске майнинга, при попытке загрузить такой DAG-файл в видеопамять, система обнаруживает, что объём данного файла слишком велик, после чего пользователь получает ошибку CUDA error 11.

Данная проблема может возникнуть как при первом запуске майнера, так и уже после длительной его работы. Наблюдается она примерно с середины 2016 года, когда стандартного размера видеопамяти в 2 гигабайта стало не хватать для обслуживания DAG-файлов, а с апреля 2018 года перестанет хватать и 3 гигабайт.

- Установите размер файла подкачки до 32 гигабайт и более. Нажмите Win+R, там введите sysdm.cpl и нажмите ввод. В открывшемся окне свойств системы перейдите на вкладку «Дополнительно», найдите там опцию «Быстродействие», и щёлкните на кнопке «Параметры» рядом с ней. Вновь перейдите на вкладку «Дополнительно», нажмите на кнопку «Изменить», здесь активируйте опцию «Указать размер», и установите размер файла подкачки в 32 гигабайт;

- Откажитесь от системных визуальных эффектов, нагружающих видеокарту и замедляющих её быстродействие. Вновь перейдите по указанному чуть выше пути, в опции «Быстродействие» вновь нажмите на «Параметры», и здесь активируйте опцию «Обеспечить наилучшее быстродействие». Нажмите на «Ок» для сохранения произведённых вами изменений. Также рекомендуется закрыть все ненужные программы, включая и ваш браузер;

- Впишите атрибут –eres 0 в ваш Claymore bat-файл. Это позволит системе создавать буфер DAG с меньшей интенсивностью, тем самым способствуя стабильности расчётов. Данный способ – один из самых действенных, позволяющий решить ошибку CUDA error 11 на вашем компьютере;

- Установите свежие драйвера для вашей видеокарты с сайта её производителя (или используйте программы уровня «Драйвер Пак Солюшн» для полуавтоматического обновления драйверов). Для этого сначала рекомендуется удалить старые драйвера с помощью «

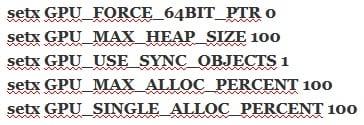

- Добавьте следующие строчки в ваш Claymore bat-файл:

- Убедитесь, что на вашем винчестере имеется достаточное количество свободного места. При необходимости, увеличьте его размеры;

- Установите видеокарту с большим объёмом видеопамяти. Увеличение требование к аппаратной начинке систем для майнинга требует для сегодняшних систем размер памяти видеокарты 4 и более гигабайт.

Заключение

У видеокарт с 4 ГБ видеопамяти проблема в том, что размер DAG-файла уже становится слишком большим.

Операционная система Windows 10 занимает около 0,5 ГБ видеопамяти, а DAG-эпоха уже слишком велика, и программы начинают забирать память из системной памяти, поэтому скорость замедляется с 27-28 до 19-20 Mh/s.

Как уменьшить зарезервированный объем VRAM Windows 10

Существует обходной путь для борьбы с веским DAG-файлом.

Если вы активируете iGPU (внутренний gpu в вашем процессоре) и используете hdmi на материнской плате, то Windows не выделит эту память из ваших 4 ГБ видеокарт.

Если у вас нет внутренней графики на вашем процессоре, обходной путь сработает, если вы установите в качестве главной видеокарты с памятью более 4 ГБ ( или дополнительную карточку, которую вы используете только для заглушки, для отрисовки Windows, а не для майнинга ).

Вставьте HDMI в материнскую плату, а не в видеокарту

Вариант с картой - заглушкой:

Подойдет любая, самая дешевая карта

Второй вариант – указать эпохи вручную

Для управления DAG-файлом и его эпохами в программах PhoenixMiner и Claymore Dual Miner существуют следующие команды:

-eres - установить количество DAG эпох, для которых программа будет резервировать буфер.

Значения: 0 - если у видеокарт мало видеопамяти (4 ГБ);

1; 2 (по умолчанию)

Имитировать эпоху можно с помощью параметра -benchmark 353 в Claymore, где 353 - номер эпохи

-lidag (значение) - замедлить генерацию DAG, чтобы избежать сбоев при переключении DAG эпох (0-3, по умолчанию:0 - быстро, 3 - медленно).

Можно указать для отдельных карт. В настоящее время опция работает только на картах AMD

-gser - инициализировать создание DAG на нескольких видеокартах (0 - Нет инициализации, все видеокарты генерируют DAG одновременно (по умолчанию);

1-частичное перекрытие генерации DAG на каждой карте;

2 - отсутствие перекрытия (каждая карта ждет, пока предыдущая закончит генерацию DAG);

3-10 - от 1 до 8 секунд задержки после каждого построения DAG перед следующим)

Не забудьте выставить файл подкачки на максимум. В некоторых случаях это тоже помогает.

Следующие команды только для PhoenixMiner:

-rvram - установить минимально зарезервированную VRAM, которую нельзя использовать для майнинга. Значения по умолчанию - 384 МБ в Windows и 128 МБ в Linux.

Вы также можете установить -rvram -1 , если хотите отключить защиту от использования слишком большого количества VRAM.

-dagrestart (значение) перезапустить майнер при выделении буфера для новой DAG эпохи. Возможные значения: 0 - никогда, 1 - всегда, 2 - автоматически (майнер принимает решение в зависимости от версии драйвера). Это относится к картам AMD на 4 ГБ, у которых могут быть проблемы с новыми DAG эпохами после эпохи 350.

Третий вариант – обновить софт

Разные версии программ потребляют разный объем видеопамяти. К примеру:На Windows 10 4 ГБ видеокарты в данный момент еще работают. И должны работать до конца лета, если не обновятся программы.

hive os, MinerBabe и т. д.) резервируют меньше видеопамяти, чем системы на Windows (порядка 22 МБ или 128 МБ против 384 МБ). Хотя они и платные, однако это тоже может быть кратковременным решением проблемы.

Пятый вариант – добывать другие монеты

Ни единым ETH и ETC жив майнинг. И хотя Ethereum и Ethereum Classic – это лучшее, что есть на Ethash алгоритме, лучше поискать другие альткоины, чем фермы будут простаивать.

-

- 2,1 Гб - 1.13 GB - 1.24 GB - 1.41 GB - 1.42 GB - 1.45 GB - 1.57 GB - 1.68 GB - 1.75 GB

- Mix Blockchain - 1.85 GB - 2.02 GB - 2,59 Гб

Важно сразу продавать эти монеты потому, что в отличии от ETH они могут в любой момент соскамитсья!

Шестой вариант – продать карты заранее и перезайти с 8 ГБ картами

Наиболее разумный вариант. Пока рынок оживает в преддверии халвинга BTC и рынок видеокарт не перенасыщен предложением, имеет смысл продать старые 4 ГБ карты и купить вместо них 8 ГБ.

Обо всем этом и о многих других важных вещах мы говорили на нашем канале. Подписывайтесь, кто еще не подписался!

Читайте также: