Проблема с удалением файлов расчет времени

Обновлено: 02.07.2024

Как вы удаляете временные файлы? Вручную запускаете CCleaner или аналогичную программу, либо настроили ее запуск по расписанию? Я обхожусь встроенными средствами Windows, причем все сводится буквально к одной команде. Я хочу поделиться с вами двумя скриптами, которые давно служат мне верой и правдой для удаления ненужных файлов.

В Windows есть утилита для очистки диска, которую можно настроить для удаления заданных категорий файлов по расписанию. Она легко справится с очисткой временных файлов из расположений, известных системе, но не позволит удалять ненужные файлы из заданной вами папки. С помощью скриптов можно очищать не только временные файлы, но и любую папку. Например, я удаляю файлы из папок Test и Temp, которые служат для экспериментов и временного хранения файлов как в загрузках, так и документах.

В отличие от программных чистильщиков, скрипты можно гибко настроить, а регулярность выполнения очистки легко реализовать с помощью планировщика заданий Windows.

В статье вы найдете примеры скриптов и рассказ о том, как настроить задачу в планировщике одной командой. Вы также сможете скачать готовые файлы и создать задание для очистки папок за пару минут.

Скрипты

Вы можете воспользоваться на выбор скриптами CMD, VBS и PowerShell.

Можно использовать утилиту командной строки forfiles.exe, входящую в состав Windows 7 и новее (когда-то она входила в Windows 2000 Resource Kit). Одной командой удаляются все файлы из указанной папки и вложенных в нее.

Команда для выполнения

- Вместо %temp% (временной папки в профиле) подставьте свою папку (параметр /p)

- Возраст файлов по умолчанию 14 дней (параметр /d), но вы можете задать любое значение

- Можно удалять файлы определенного расширения по маске (например, /m *.log)

- За рекурсивное удаление (во вложенных папках) отвечает параметр /s

Конечно, в скрипте вы можете использовать несколько команд, каждая из которых будет удалять заданную папку. Справка по использованию утилиты вызывается командой forfiles /?.

Приведенный ниже скрипт VBS удаляет все файлы и папки, включая защищенные, с выводом списка удаленных файлов.

Команда для выполнения

Скрипт можно запускать из командного файла (CMD).

- Вместо %windir%\temp подставьте свою папку (в этом примере удаляются файлы из временной папки в системном каталоге)

- Возраст файлов по умолчанию 14 дней, но вы можете задать любое значение

- Список удаленных файлов будет по умолчанию сохранен в файле %windir%\system32\MyCleanupScript.Log, хотя можно указать любой путь и имя файла

Как и в случае с утилитой forefiles.exe, можно реализовать очистку различных папок, указав каждую в отдельной команде.

PowerShell

Скрипт на PowerShell был в блоге Сергея Мариничева в рамках урока об операциях с файлами, но теперь страница доступна только в архиве интернета. Я скопировал ключевое содержимое для вас:

Выполнение очистки по расписанию

Для выполнения очистки папки по расписанию нужно создать скрипт с именем cleanup.cmd, содержащий команду для запуска, и скопировать его в любую папку из PATH (например, %windir%\system32). Поместите туда же скрипт VBS или PowerShell, если вы решили использовать его, а не утилиту forfiles.ехе.

Задание в планировщике создается одной командой:

Задание с именем CleanUp будет выполняться:

- с наивысшими правами (параметр /RL)

- раз в неделю (параметр /SC)

- по воскресеньям (параметр /D)

- в 14:00 (параметр /ST)

Откройте Пуск – Поиск – Планировщик заданий и вы увидите в библиотеке планировщика задание CleanUp.

Можете проверить работу задания в планировщике. Для этого щелкните правой кнопкой мыши по заданию и выберите Выполнить.

Готовые файлы

Загрузите архив и распакуйте в любую папку. В архиве варианты forfiles и VBS.

- Задайте путь к папке и возраст файлов в скрипте CleanUp.cmd в одной из папок (каждая соответствует одному из описанных выше способов), после чего скопируйте все содержимое папки в %windir%\system32.

- Щелкните правой кнопкой мыши на файле schedule.cmd и выберите Запуск от имени администратора, чтобы создать задание.

Благодарности

Авторами скриптов, которые я когда-то почерпнул из этой темы конференции OSZone, являются Keeper2006 и amel27 соответственно. В этой же теме вы найдете другие интересные варианты решения данной задачи, и туда же следует направлять вопросы по доработке скриптов под свои нужды.

А как вы избавляетесь от ненужных файлов – программой или скриптом? Настроена ли у вас очистка по расписанию?

Вадим - владелец этого блога, и почти все записи здесь вышли из-под его пера. Подробности о блоге и авторе здесь. Поддержать автора вы можете тут.

Вас также может заинтересовать:

Подпишитесь на канал и читайте интересные записи чаще! Есть вопросы? Задайте их в чате.

комментариев 75

Великолепно! Взял на вооружение. Сам чищу по расписанию планировщика заданий следующим скриптом:

Ваша оценка: 0 Ваша оценка: +1equinox, я рад, что вам понравился скрипт. Как вижу, вы использовали похожий метод, но удаляли все целиком. Поскольку я часто открываю файлы без сохранения, они оседают во временных папках. И я предпочитаю иметь двухнедельную подушку, на случай, если они понадобятся.

Мне очень приятно, что вы узнаете много нового из моего блога :) Что же касается обычных пользователей, то мой блог не для них. Он для необычных людей, которые стремятся узнать что-то новое о Windows и расширить свой кругозор :)

Годится! Согласны? +8Интересный вариант очистки, я пользовался CMD

На который в групповых политиках запланировано выполнение при выходе из системы. Ваш скрипт заинтересовал расширенными возможностями. Спасибо.

Ваша оценка: +3Спасибо. Давно ищу метод очистки дисков от временных файлов на ПК в домене. Этот вопрос пока не гуглил, а можно ли создавать задания в планировщике через GPO? Тогда можно использовать один из этих скриптов или ccleaner с ключом /auto.

Ваша оценка: 0IWS, это то же самое, что у equinox, просто код слегка другой.

А зачем? Поставьте в качестве логон/логофф скрипта и все.

Ваша оценка: +2Доброго дня, всем!

после чего скопируйте все содержимое папки в %windir%\system32.

, по-моему здесь было бы правильно написать копируем папку CleanUp ,так как в Schdule.cmd указан путь: %WINDIR%\system32\cleanup

А в целом все такие же интересные и познавательные материалы, как и раньше, так держать!

В schedule.cmd действительно написано

Но там нет слэша в конце, а это значит, что будет выполнен исполняемый файл с именем cleanup вне зависимости от его расширения.

Проверьте сами. Положите в System32 файл cleanup.bat

и выполните в командной строке

Ваша оценка: +3 Ваша оценка: 0Возможно, они младше двух недель, ибо этот параметр задан в скрипте.

Спасибо за теплые пожелания! :)

Ваша оценка: +2осталось только добавить что в пакете sysinternals есть маленькая утилита sdelete помогающая безвозвратно удалять файлы.

Ваша оценка: +2SERG, для очистки временных файлов sdelete не нужна. Это, скорее, для укрепления конфиденциальности, что в домашних условиях не особо востребовано.

Ваша оценка: 0Спасибо, взял на вооружение.

Хотелось бы узнать как можно настроить планировщик, что бы задание выполнялось при выключении или выходе из системы пользователя.

Спасибо!

взял на вооружение. Но только добавил не в планировщик, а сделал ярлычок в Total CMD, поместив рядом с VBS для создания папки с именем даты и новым текстовиком)

Не подскажете, как можно сделать еще файлик для чистки дисков, скажем, убирать файлы .bak? Порой процедура очень нужная :)

Очень рад, что зайдя на OSZONE, я увидел ссылку сюда. Хороший блог, хоть многое и знакомо, но нравится как вы объясняете. Спасибо за труд!

Ваша оценка: +1Что касается вашего вопроса про bak-файлы, то:

1. Определите список папок, в которых они создаются

2. Выполняйте для каждой папки команду forefiles.exe с ключом /m *.bak

Практически уже ничего не чищу. Поскольку всё временное находится в стандартных расположениях, раз в полгода захожу во встроенную очистку диска (за это время успевает скопиться 2,5-4GB мусора), удаляю.

Почему не чищу с фанатизмом? Всё предельно просто. HDD распределялся таким образом, чтобы на системном разделе оставался приличный запас свободного места. 4GB мусора никак на скорость работы не влияют.

Morpheus, прямой зависимости между скоростью работы и наличием временных файлов нет. Но есть другие факторы, по которым я не считаю нужным держать на диске по 2-4 Гб мусора на протяжении полугода.

Для оптимальной производительности HDD нужно дефрагментировать, и чем больше мусора, тем дольше проходит этот процесс. Да, в Windows 7 он выполняется в фоне, поэтому незаметен. Однако дефрагментация этих файлов создает ненужную нагрузку на HDD, что теоретически сокращает его срок службы.

Да и вообще, зачем гонять мусор по диску, если его можно удалить :)

Ваша оценка: +1 Ваша оценка: 0Подскажите, как удалять файлы из директории с исключением?

Пример:

Надо удалить все файлы и папки кроме одной папки.

Ну вы блин даётё

ППц.

Это не решение проблемы.

Во первых скрипт это фаил а значит он должен гдето лежать куда пользователь должен иметь доступ.

Во вторых в папку windir\temp орбычный юзер даже доступ может не имеет, ибо у него есть свой темп который лежит в %temp%.

В 3 папку %temp% планировщиком не очистить ибо планировщик выполняет задачи от имени, а не для текущего пользователя(вы же понимаете что у каждого юзера папка %temp% своя), тоесть запускать скрипт нуно во время Логона(ЛогОффа).

Вот раборчий вариант.

Просто добавить в групповые политики в пункт User Configuration\Police\Windows Settings\Scripts\LogOn

Рабаотет для XP и 7(для всех NT5 и NT6)

Какой проблемы? Скрипт полностью справляется с задачей, отраженной в заголовке и содержании статьи.

То же самое можно сказать и про ваш скрипт :)

В статье не было ничего сказано про %WinDir%\Temp, но при запуске из планировщика с максимальными правами все будет работать, если пользователь обладает правами админа.

Годится! Согласны? +6%AllUsersProfile%\Application Data\Microsoft\Dr Watson

%Windir%\minidump

%SystemRoot%\Memory.dmp

1.Удалить только те %Windir%/$NtUninstallКБ Номер$-папки, созданные более месяца назад, как создать резервную копию файлы обновлений Windows. Не следует удалять те, которые были созданы за последние 30 дней.

2.Чтобы удалить кэш загрузки обновлений Windows, удалите все папки в папке %Windir%\SoftwareDistribution\download, которые были создано более 10 дней назад.

3.Удалите следующие файлы журнала в папке % Windir %:

KB*.log

Setup*.log

Setup*.old

SetupLog.txt

файле Winnt32.log

SET*.tmp

1.Удалите папку %Windir%\$NtServicePackUninstall$ на Удалите папки резервного копирования для пакетов обновления для Windows XP.

2.Удалить папку % windir%\ServicePackFiles для удаления установочные файлы и папки кэша для службы Windows XP пакеты обновления.

Нашёл вас через oszone

А так же, как удалить всё из папки профиля пользователей, работающих за 1 пк файлы по маске и старше n дней из заданной папки или удалить папку по маске и старше n дней, пример: удалить всё для пользователь1 и пользователь2 из C:\Documents and Settings\пользователь1\del\*.* и C:\Documents and Settings\пользователь2\del\*.* или саму папку del (маска), если она старше n дней, выполять надо в не зависимости от того, какой пользователь работает с пк?

В конце записи есть ссылка на тему в форуме по скриптам, обратитесь туда, плиз.

Ваша оценка: 0Вадим, а можно в этом запросе

сделать так чтобы оставалась 1 (последняя) копия не зависимо от даты. Это мне нужно, на случай сбоя резервного копирования т.к. этой командой я удаляю старые резервные копии.

Ваша оценка: 0 Ваша оценка: +1 Ваша оценка: 0Андрей, я понятия не имею, как в VBS обрабатываются пути с кириллицей. Спросите в указанной теме форума.

Но ничто не мешает вам использовать forfiles, сохранив скрипт в кодировке OEM.

Ваша оценка: 0Это все понятно, а вот можно изменит скриптом адрес который находится по умолчанию в %TEMP% например на D:\temp

Ваша оценка: 0 Ваша оценка: 0А можно в данный скрипт внести изменении чтобы не удалялись пара каталогов с данными из этой папки?

Ваша оценка: 0 Ваша оценка: 0Спасибо. Не обратил внимания.

Ваша оценка: 0Подскажите как автоматизировать очистку папки AppData/Temp в профиле пользователя, чтобы удалялось из папки всё . У меня ничего не получается.

Ваша оценка: 0Сергей, а что конкретно вы сделали, что у вас ничего не получается?

Ваша оценка: 0 Ваша оценка: 0Сергей, слэши в путях неправильные. C:\users\ надо.

Ваша оценка: 0Скажите нет ли способа чистить папку tmp на хостинге , после установки плагинов и тп. она засоряется а в ручную долго это делать?

Ваша оценка: 0Вячеслав, очевидно, надо запускать какой-то скрипт на сервере, на котором крутится ваш сайт :)

Ваша оценка: 0это понятно , думал вы можете скрипт посоветовать , ну даладно.

Ваша оценка: 0Вячеслав, как я могу советовать скрипт, если я даже не знаю ОС, под управлением которой работает сервер? :) Для Windows вы скрипт уже знаете, гуд лак!

Ваша оценка: 0 Ваша оценка: 0 Ваша оценка: 0 Ваша оценка: 0Антон, даже если вы не владеете CMD, можно погуглить

Ваша оценка: 0Использую скрипт VBS для очистки от временных файлов; но вот что раздражает так это то, что при выполнении файлика CleanUp.cmd с двумя командами запуска скриптов для чистки пользовательского и системного TEMP каталогов на доли секунд появляется и исчезает черное окно интерпретатора команд. Можно каким либо способом сделать чтобы это окно не появлялось ?

Ваша оценка: 0Можно запуск скрипта предварять start /min …

Ваша оценка: 0Использую данную команду для автоматического удаления файлов внутри своей временной папки. Удаляет хорошо, однако после работы основной программы остается не только файл temp но и log. Расширения нет и данный скрипт на нем спотыкается. Как обойти?

Заранее спасибо.

Вадим, речь идет об команде:

Ваша оценка: 0Сергей, речь о том, что запросы на изменение скрипта нужно направлять в форум.

ОС Windows долгое время попрекали за медлительность её файловых операций и медленное создание процессов. А почему бы не попробовать сделать их ещё более медленными? Эта статья покажет способы замедления файловых операций в Windows примерно в 10 раз от их нормальной скорости (или даже больше), причём способы эти практически не поддаются отслеживанию обычным пользователем.

А ещё, конечно же, мы научимся подобные ситуации обнаруживать и исправлять. Весь текст написан на основе проблемы, с которой я столкнулся пару месяцев назад, так что всё, написанное ниже, полностью реально.

Что-то пошло не так

Иногда наиболее ценной информацией, которая у вас есть при попытке что-то ускорить, есть само знание того, что это точно можно ускорить. Ну, знаете, как в школе — задача решается потому, что это задача, а значит у неё точно должно быть решение.

Когда дело касается кода, который находится полностью под вашим контролем — здесь проще. Можно сравнить быстродействие различных версий, покопаться, поговорить с его авторами, с какого-то этапа также начинает работать ведомая опытом интуиция.

Когда же речь идёт о «чёрном ящике», каким, например, является реализация файловой системы NTFS от Microsoft, становится сложнее. Но и здесь можно найти кое-какие подсказки:

- Вы замечаете, что некоторые файловые операции, которые раньше работали быстро, вдруг стали работать медленно. Вероятно, их можно снова заставить работать быстро.

- Одни и те же файловые операции иногда работают быстро, а иногда — медленно. Возможно, их можно заставить работать быстро всегда.

- При профилировании своего приложения вы видите хорошую производительность файловых операций в большинстве случаев, кроме нескольких «горячих» мест, где всё почему-то работает значительно хуже среднего. Возможно, вы можете изменить свой код так, чтобы избежать данной проблемы.

Медленное удаление файлов

Снова и снова собирая из исходников Chromium, я заметил, что очистка директории с результатами сборки стала занимать несколько минут — это довольно значительная часть цикла сборки. Я был уверен, что это должно происходить быстрее. Я также заметил, что данной проблемы не случается, если в момент удаления данных файлов не запущена Visual Studio.

Профилирование с помощью ETW не показало явного виновника происходящего, но дало несколько подсказок, которые привели меня к мысли, что дело может быть в VsChromium — расширении для Visual Studio, которое делает работу над проектом Chromium в Visual Studio несколько удобнее. Одной из важных его фич является загрузка всего исходного кода проекта в оперативную память (для дальнейшего быстрого поиска). В случае Chromium это несколько гигабайт RAM, но зато поиск работает за милисекунды. Мне это расширение очень помогает в работе, но десятикратное замедление файловых операций — не та цена, которую я готов за это платить.

Воспроизведение проблемы

Для написания данной статьи я сэмулировал проблему, написав скрипт на Python, который создаёт и удаляет тысячи файлов в папке, которая находится под наблюдением VsChromium. Запустив данный скрипт, я собрал трейс событий с помощью ETW. Вот график использования процессора в WPA (Windows Performance Analyzer) и таблица с временем (в милисекундах). Всего скрипт работал около 5 секунд:

Кажется обоснованным, что процесс python.exe, который выполняет мой скрипт, использует значительную часть ресурсов CPU. Также понятно, что процесс System тоже будет занят кое-какой работой, поскольку мы занимаемся добавлением и удалением файлов. Кроме того, мы видим в таблице работу расширения VsChromium, поскольку оно наблюдает за той самой папкой, в которой мы создаём и удаляем файлы, а значит должно реагировать на это (добавлять и удалять файлы из индекса). Ну и, наконец, SearchIndexer.exe использует немного ресурсов для индексации новых файлов. Вроде бы всё выглядит неплохо. И всё же — мы знаем, что код работает слишком медленно.

Вот, для контраста, график использования процессора в случае создания и удаления файлов в директории, которая не находится под наблюдением VsChromium. Производительность поднялась почти в 10 раз! Понятное дело, что загрузка от VsChromium.Server.exe и devenv.exe исчезла полностью, но на этом всё не заканчивается. Сам python, выполняющий мой скрипт, также стал работать намного быстрее (время выполнения скрипта упало с 4888 мс до 561 мс). Процесс System вообще ускорился с 2604 мс до 42 мс. Что же здесь происходит?

График CPU Usage (Precise), который основывается на информации о переключении контекстов, даёт хорошую возможность сказать, сколько именно процессорных ресурсов использует тот или иной процесс. Но чтобы понять, на что именно процесс тратит время, нужно воспользоваться графиком CPU Usage (Sampled). Он основан на «снимках» стека вызовов функций (по-умолчанию, сделанным с частотой 1000 раз в секунду).

Этот вид представления данных группирует данные по процессам, затем по потокам, затем по модулям и, наконец, по функциям. В данном случае для процесса python.exe мы видим, что в 4637 снимках из 4904 какая-то работа происходила в модуле ntoskrnl.exe. Это намного больше, чем время выполнения кода в python27.dll (им вообще можно пренебречь).

Углубляясь в исследование того, что делал ntoskrnl.exe, мы видим какие именно функции в нём вызывались:

Чаще всего вызывалась функция выделения памяти MiAllocatePagedPoolPages и функции очистки памяти memset, MiCompletePrivateZeroFault, а также ассоциированные с ними отказы страниц. Кажется немного странным, что в тесте работы файловой системы больше всего ресурсов занимают задачи выделения и очистки памяти, правда? Но подождите, это ещё не всё. Вторым по занятости в системе является процесс System, и занят он (чем бы вы думали?) обнулением только что освобождённых страниц памяти. Что же, всё-таки, происходит?

Вернувшись к анализу снимков колстека процесса python.exe, я поискал функцию memset и нашел её где-то на 70 уровней ниже по колстеку (не удивительно, что раньше я её пропустил). Правый клик на ней, выбираем View Callers-> By Function и видим, что общие затраты на её вызов (включая время выполнения «дочерних функций») составляют примерно половину всей загрузки процессора — 2971 снимок из 4904 сделанных.

Вызывающей функцией практически всегда была FsRtlNotifyFilterReportChangeLiteEx. Правый клик на ней, View Callees-> By Function. Это показало мне, что данная функция выделяла память, вызывала memset для неё и потребляла около 83% процессорного времени в процессе python.exe.

В поисках проблемы

В этом месте моего исследования у меня было несколько, как позже оказалось, неверных догадок. Одна из них касалась частых вызовов wcifs.sys!WcGenerateFileName — я подумал, что генерация имён файлов в формате «8.3» работает слишком медленно, но её отключение ничего не изменило. В конце-концов я остановил свои попытки постичь непостижимые колстеки и вместо этого задумался о том, как работает расширение VsChromium. При загрузке оно просто должно прочесть и загрузить в память всё содержимое файлов в контролируемой папке. Но после этого ему нужно всего лишь отслеживать изменения и я предположил, что оно имеет что-то типа монитора изменений файловой системы. Я знал, что расширение недавно получило обновление и в нём автор увеличил буфер, в котором хранились нотификации об изменениях файлов, с 16 KB до 2 MiB. И почему-то операционной системе это очень не понравилось. Я попробовал откатиться к предыдущей версии расширения (с меньшим буфером) — и это действительно исправило проблему.

Данный буфер выделялся с помощью функции ExAllocatePoolWithTag, а затем заполнялся информацией об изменениях в файловой системе. Для избежания утечки данных из ядра ОС, вся неиспользуемая часть буфера обнулялась. Если буфер достаточно большой, а объём пересылаемой информации относительно мал — обнуление будет занимать большую часть времени. Я добавил провайдер данных ALL_FAULTS (который я нашел, просматривая результат вызова “xperf -providers k”) к моей ETW-сессии чтобы увидеть как часто случались отказы страниц. И это было впечатляюще! Случилось 2,544,578 отказов страниц при попытках обнуления данных, что соответствует 9.7 GiB данных или около 4970 раз по буферу в 2 MiB. Это 4.97 буфера на каждую тысячу созданных и удалённых файлов. Мне подсказали, что VsChromium должен создавать около 5 событий на каждый созданный и удалённый файл, а значит большинство буферов с нотификациями будут содержать лишь одну запись. Вот отказы страниц по процессам и типам:

Зачем такой большой буфер?

Документация для FileSystemWatcher рекомендует не использовать большой буфер, но не вдаётся в подробности о том, чем это грозит. На машинах разработчиков Chrome достаточно много оперативной памяти, так что когда однажды очень частые файловые операции (баг в ядре Windows, о котором я писал ранее) привели к переполнению ранее использованного буфера в 16 КВ, его просто значительно увеличили. И это, на первый взгляд, помогло. По крайней мере тогда, для решения той проблемы. Хотя и замедлило файловые операции во много раз.

Когда автор расширения VsChromium узнал о проблеме, он решил уменьшить буфер обратно и обрабатывать ошибки его переполнения более изящно (временно приостанавливая мониторинг).

Ирония данной ситуации состоит в том, что большинство затрат ресурсов здесь (вызовы memset, отказы страниц, обнуление) случаются потому, что две разных части ядра ОС не достаточно хорошо общаются друг с другом. Система нотификаций запрашивает память, получает её (уже обнулённую) и снова пытается её обнулить. Если бы она знала, что память уже обнулена — то не пыталась бы сделать это во второй раз, и не было бы лишних отказов страниц, и жизнь была бы куда лучше. Эй, Microsoft, у меня есть классная идея о том, как сделать систему нотификаций об изменениях файловой системы лучше!

Вооружимся этим знанием

ETW-трейсы позволяют достаточно просто понять, что буферы для нотификаций являются проблемой — каждый процесс, выполняющий какие-то файловые операции будет показывать крайне много времени, потраченного в ntoskrnl.exe!FsRtlNotifyFilterReportChangeLiteEx. Это показывает, что кто-то использует очень большой буфер для нотификаций, но как нам найти процесса-виновника? Очень просто — поскольку память в нашем случае выделялась с помощью ntoskrnl.exe!ExAllocatePoolWithTag, то освобождаться она будет с помощью ntoskrnl.exe!ExFreePoolWithTag. Мы можем поискать вызовы этой функции в имеющихся у нас коллстеках и найти тот, где их много.

Другие полезные ссылки

Увеличение размера буфера в VsChromium случилось вот в этом коммите, который вошел в билд 0.9.26. Обратное уменьшение случилось вот в этом комите, который вошел в версию 0.9.27.

Я рекомендую всем пользователям VsChromium обновиться до последней версии.

ETW-трейсы и упомянутый в статье скрипт на Python можно скачать вот здесь. Он создаёт и удаляет файлы дважды, один раз в директории под наблюдением VsChromium, и второй раз в ненаблюдаемой директории, с полусекундной паузой. Для воспроизведения эксперимента из статьи вам, конечно, понадобиться соответствующая версия VsChromium, настроенная на мониторинг нужной папки.

А в следующей статье я расскажу о том, как Microsoft позволяет вам иногда случайно создать N процессов за O(N^2) времени.

Иногда надо сделать удаление файлов старше n дней. Например Backup’ ы. Можно делать это вручную, отсортировать их по дате и удалить, а можно воспользоваться скриптом. В данном примере мы рассмотрим скрипт для удаления файлов старше n дней и добавим задание в планировщик Windows Server 2012R2.

Иногда надо сделать удаление файлов старше n дней. Например Backup’ ы. Можно делать это вручную, отсортировать их по дате и удалить, а можно воспользоваться скриптом. В данном примере мы рассмотрим скрипт для удаления файлов старше n дней и добавим задание в планировщик Windows Server 2012R2.

Содержание:

1. Скрипт удаления файлов старше n-дней

2. Создание задания в планировщике задач

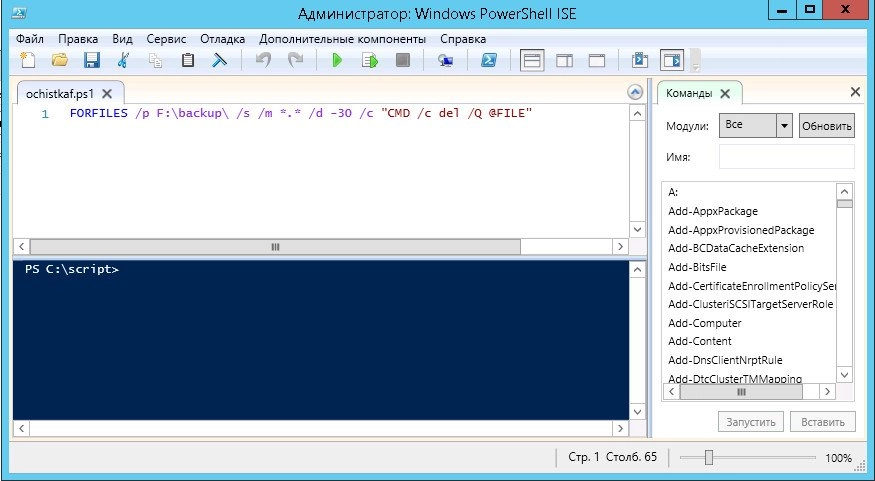

Скрипт на самом деле очень простой, создается в PowerShell и выглядит он следующим образом:

Где:

F:\backup\ - путь, в какой папке мы будем с вами искать файлы для удаления *.* - имя (маска) файлов /d -30 - старше скольки дней нам необходимо удалить файлы.

Вот так это выглядит в PowerShell:

Осталось только его выполнить и все.

Все хорошо, у нас есть скрипт. Мы можем выполнять его вручную, когда необходимо очистить наши бекапы. Но зачем выполнять это вручную? Мы поручим планировщику запускать наш скрипт и избавимся сами от рутинной работы.

Итак, что нам для этого надо?

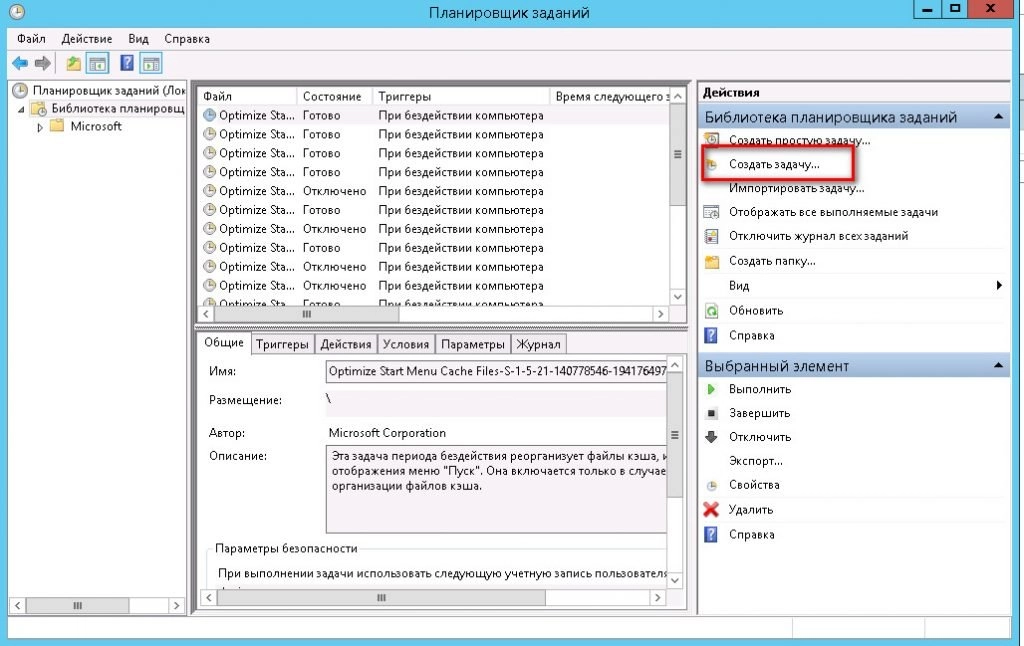

Для начала идем в "Пуск -> панель управления -> Администрирование" и запускаем там "Планировщик заданий".

Выбираем пункт "Создать задачу":

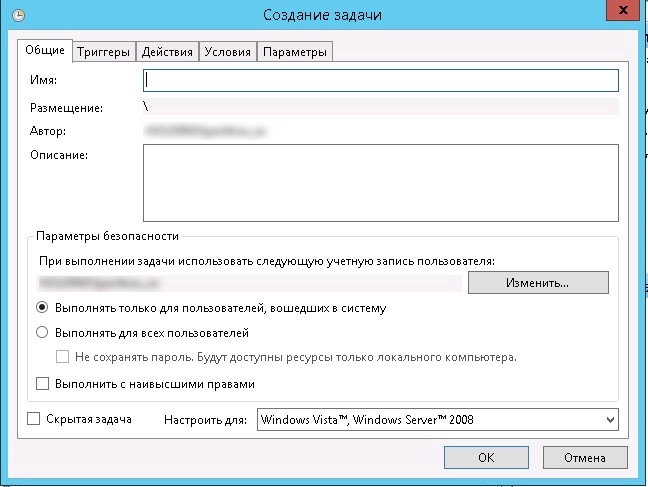

На вкладке "Общие" задаем имя задания, его описание и пользователя, от которого оно будет выполняться. По умолчанию там будет пользователь, под которым вы вошли в данный момент в систему.

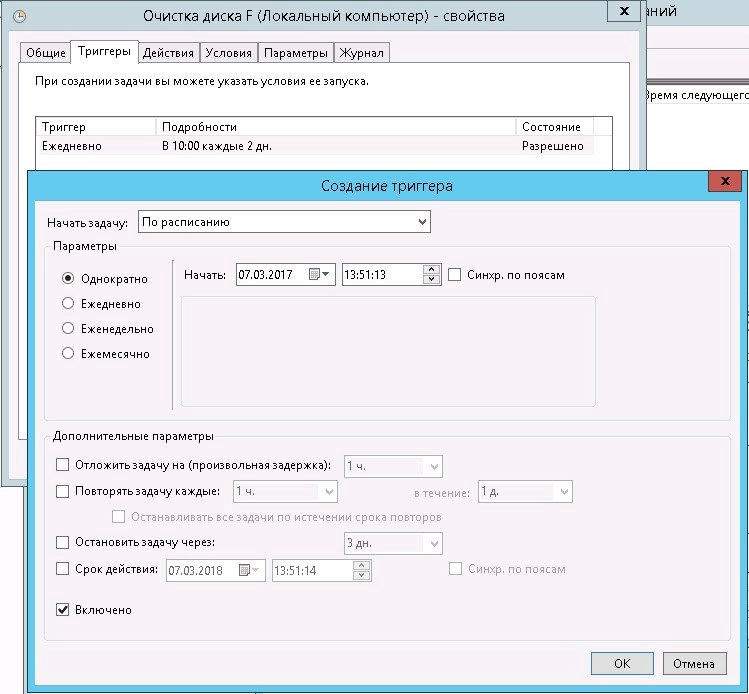

Далее переходим на вкладку "Триггеры" и создаем расписание, когда мы будем запускать наше задания. У меня настроено в 10:00 каждые 2 дня.

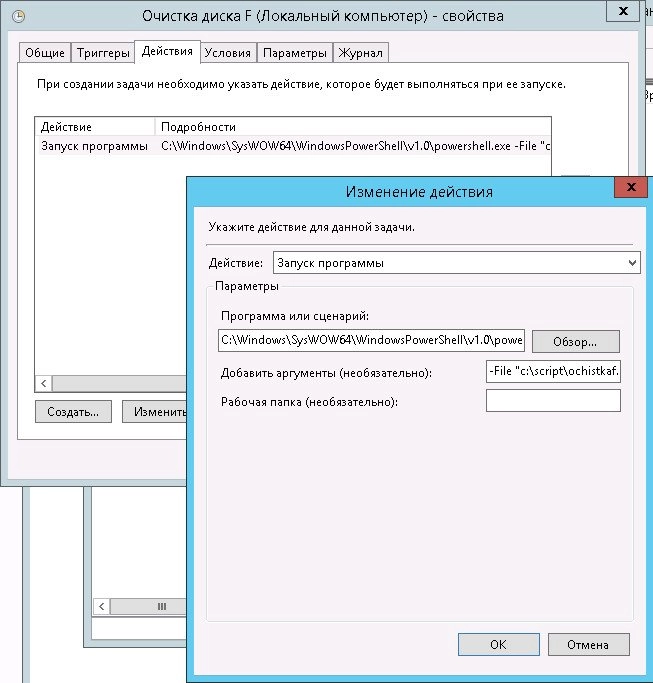

Далее идем на вкладку "Действия" и задаем действие, которое будет выполняться. Выбираем "Запуск программы"

программу или сценарий

и указываем путь до PowerShell:

А аргументе указываем путь до нашего скрипта, который мы создали ранее:

Нажимаем "Ок" и еще раз "Ок"

Все, на этом наше задание создано. Осталось дождаться, когда будет выполнено наше действие по расписанию и проверить, все ли правильно было настроено.

Друзья всем привет, в своей статье я хочу поведать вам о некоторых важных моментах, которые стоит учитывать пред тем как приступить к восстановлению утерянных данных.

Рассмотрим четыре основных причины по которым чаще всего мы теряем свои файлы:

6. Рекомендуемые программы для восстановления файлов.

1. Что происходит с файлами после обычного удаления:

При обычном удалении файла стирается только его идентификатор, по которому система определяет, в каком секторе этот файл начинается и где заканчивается. Без идентификатора система считает, что носитель отчищен от информации, которую вы удалили.

В действительности же, удаленный файл остается целым и невредимым в занятых секторах и хранится он будет там до тех пор, пока на этот участок носителя с верху не будет записана другая информация. Новые файлы будут записаны поверх старых когда начнет заканчиваться место на диске и вот тогда уже старые данные восстановить не получится.

Поэтому важно понимать, чем меньше вы будите юзать свой накопитель, с момента удаления нужной информации, тем выше шанс восстановить все 100% удаленных файлов. Так же при обычном удалении файла сохраняется его оглавление, поэтому высока вероятность, что восстановить такие данные получится под своими оригинальными именами и в папках в которых они хранились.

2. Что происходит с данными при форматировании:

После форматирования диска с файлами происходит почти тоже самое, что и при обычном удалении, только затирается еще и оглавление. После чего, все так же без проблем можно восстановить утерянные данные, причем любые (фото, видео, текстовые документы, архивы и т.д.) в общем все, что хранилось на вашем носителе. Но опять же важно не тянуть с этим делом и как можно быстрее приступить к восстановлению.

3. Как повлияет удаление раздела на целостность файлов:

В этом случае происходит все тоже самое, что и при обычном удалении файлов. После удаления раздела жесткого диска или флешки, не страдает даже оглавление файлов, поэтому информацию, все так же без проблем можно восстановить с папками и именами.

4. Что делает низкоуровневое форматирование:

Сразу хочу сказать, что после низкоуровневого форматирования восстановить данные уже нельзя, а если даже и возможно, то мне такие способы не известны.

В процессе глубокого форматирования с верху старых данных записываются пустые файлы, другими словами происходит обнуление секторов. Таким образом вся информация на диске полностью затирается и не подлежит восстановлению.

Хотя некоторые пользователи утверждают, что в лабораторных условиях часть таких файлов все еще можно вытянуть. К стати друзья можете ознакомится со статьей, где обсуждаем и ищем рабочие решения по восстановлению данных после глубокого форматирования .

5. Почему система не уничтожает файлы сразу:

На самом деле все очень просто, обычное удаление занимает мало времени и происходит почти мгновенно. А вот полное уничтожение файлов требует перезаписи секторов, что занимает гораздо больше времени. Например файл размером 5 гигабайт удалится молниеносно, а на полное затирание нужно потратить несколько минут.

6. Рекомендуемые программы для восстановления файлов:

Hetman Partition Recovery восстанавливает все типы файлов с идентификаторами и оглавлениями. Это одна из лучших программ, но она платная.

Для бесплатного восстановления рекомендую использовать Recuva . Данная программа так же восстанавливает все типы файлов, с идентификаторами и оглавлениями, но в отличии от первого варианта, она восстанавливает файлы без папок. Поэтому если удаленной информации много, то придется повозится с повторным ее сортированием.

Читайте также: