Qemu где хранятся файлы xml

Обновлено: 06.07.2024

KVM - это технология полной виртуализации для Linux на x86 (включая 64-bit) оборудование, содержащее расширения виртуализации (Intel VT или AMD-V). Сам KVM состоит из загружаемого модуля ядра, kvm.ko, который обеспечивает базовую инфраструктуру виртуализации и специфичный для процессора модуль, kvm-intel.ko или kvm-amd.ko.

В Debian, Xen и VirtualBox являются альтернативами KVM.

Установим пакеты qemu-kvm с помощью команды apt-get или aptitude, например, будем использовать следующую команду:

Демон libvirt будет запускаться автоматически во время загрузки и загружать соответствующие kvm модули, kvm-amd или kvm-intel, которые поставляются вместе с Linux ядром пакета Debian. Если вы намерены создавать виртуальные машины из командной строки, то установите virtinst.

Для того, чтобы иметь возможность управлять виртуальными машинами (ВМ) от обычного пользователя, вы должны добавить этого пользователя в группы kvm и libvirt:

Теперь вы можете получить список всех своих доменов:

libvirt defaults to qemu:///session for non-root. So from <youruser> you'll need to do:

You can use LIBVIRT_DEFAULT_URI to change this.

Самый простой способ для создания и управления гостевыми ВМ это использовать графическое приложение Virtual Machine Manager virt-manager.

Также, вы можете создать гостевую ВМ в командной строке. Ниже приведен пример для создания гостевой ВМ Debian Squeeze с именем squeeze-amd64:

Since the guest has no network connection yet, you will need to use the GUI virt-viewer to complete the install.

You can avoid pulling the ISO by using the --location option. To obtain text console for the installation you can also provide --extra-args "console=ttyS0":

Для полностью автоматизированной установке смотрите preseed или debootstrap.

Between VM guests

By default, QEMU uses macvtap in VEPA mode to provide NAT internet access or bridged access with other guest. Unfortunately, this setup could not let the host to communicate with any guests.

Between VM host and guests

To let communications between VM host and VM guests, you may setup a macvlan bridge on top of a dummy interface similar as below. After the configuration, you can set using interface dummy0 (macvtap) in bridged mode as the network configuration in VM guests configuration.

Between VM host, guests and the world

In order to let communications between host, guests and outside world, you may set up a bridge and as described at QEMU page.

For example, you may modify network configuration file /etc/network/interfaces for setup ethernet interface eth0 to a bridge interface br0 similar as below. After the configuration, you can set using Bridge Interface br0 as the network connection in VM guests configuration.

You can then use the virsh(1) command to start and stop virtual machines. VMs can be generated using virtinst. For more details see the libvirt page. Virtual machines can also be controlled using the kvm command in a similar fashion to QEMU. Below are some frequently used commands:

Start a configured VM guest "VMGUEST":

Notify the VM guest "VMGUEST" to graceful shutdown:

Force the VM guest "VMGUEST" to shutdown in case it is hanged, i.e. graceful shutdown not work:

On the other hand, if you want to use a graphical UI to manage the VMs, you can use the Virtual Machine Manager virt-manager.

Guest behavior on host shutdown/startup is configured in /etc/default/libvirt-guests.

This file specifies whether guests should be shutdown or suspended, if they should be restarted on host startup, etc.

First parameter defines where to find running guests. For instance:

Below are some options which can improve performance of VM guests.

-

Assign virtual CPU core to dedicated physical CPU core

- Native driver for Windows VM guests

- Create new VM guest with below configuration:

- IDE storage for Windows OS container, assume with filename WINDOWS.qcow2

- IDE CDROM, attach Windows OS ISO to CDROM

- Remove IDE storage for Windows OS, DO NOT delete WINDOWS.qcow2

- Remove VirtIO storage for dummy storage, you can delete DUMMY.qcow2

- Remove IDE storage for CD ROM

- Add a new VirtIO / VirtIO SCSI storage and attach WINDOWS.qcow2 to it

- Select VirtIO / VirtIO SCSI storage for the storage containers

- Restart the VM guest

- VirtIO SCSI storage provides richer features than VirtIO storage when the VM guest is attached with multiple storage. The performance are the same if the VM guest was only attached with a single storage.

- Select "None" for disk cache mode

- Edit the VM guest configuration, assume the VM guest name is "VMGUEST"

Network I/O

-

Native driver for Windows VM guests

- Select VirtIO for the network adapter

- Restart the VM guest

- процессор Atlon X2 245

- оперативная память 4 гигабайта

- жесткий диск 500 гигабайт

- материнская плата ASUS M4N68T-M LE.

- Microsoft hyper-v не подходит — платная. Компания, в которой я работаю использует только лицензионное программное обеспечение. Следовательно никто не выделит для моих целей лицензию на сервер.

- VMWARE ESXi не знает контролера SATA, расположенного на материнской плате (поскольку разрабатывалась для серверных систем).

- Qemu-kvm — свободно разрабатываемый гипервизор, поддерживает аппаратную виртуализацию. Его можно установить в любой современный дистрибутив Linux. Это по мне, его и берем.

- можно подмонтировать жесткий диск в директорию и указать его в качестве хранилища

- можно просто устройство выбрать хранилищем.

- отключаю поддержку звука (это сервер, а не рабочая станция);

- не использую протокол IPv6 (в моей сети он не используется);

- отключаю поддержку сетевых карт wifi, wmax и все что сними связанно.

- comp1 – имя виртуального компьютера, к которому подключаем диск.

- /dev/sdc – путь к устройству на физическом компьютере.

- Vdv — куда подключаем на виртуальной машине.

- --type – тип диска.

- компьютер, на котором работала виртуальная машина, сгорел (процессор Atlon X2 245).

- раз в неделю виртуальная машина выключается и делается резервная копия файла конфигурации и образа диска.

-

Select VirtIO for the network adapter

Memory

-

Huge Page Memory support

-

Calculate the huge page counts required. Each huge page is 2MB size, as a result we can use below formula for the calculation. e.g. 4 VM guests, each VM guest using 1024MB, then huge page counts = 4 x 1024 / 2 = 2048. Note that the system may be hang if the acquired memory is more than that of the system available.

Миграция гостя из RHEL/CentOS 5.x

Иными словами, соответствующие разделы должны выглядеть примерно так:

Если у вас был настроен сетевой мост на хосте CentOS, то обратитесь к данной статье Wiki, в которой описано, как настроить его в Debian.

Не работает сетевой мост

virt-manager использует виртульную сеть для гостевых машин, по умолччанию это маршрут в 192.168.122.0/24 и вы можете посмотреть его набрав ip route как root.

Если этого маршрута нет в таблице маршрутизации ядра, то гостевые машины не смогут подключтся к сети и вы не сможете завершить создание гостевых машин.

cannot create bridge 'virbr0': File exists:

Чтобы решить эту проблему вы можете удалить virbr0, запустив:

Откройте virt-manager и пройдите на вкладку "Edit" -> "Host details" -> "Virtual networks" запустите сеть по умолчанию.

Во можете проверить сетевой статус (netstatus).

При необходимости, можно использовать сетевой мост BridgeNetworkConnections

Можно ли при таком запуске каким-то образом создать дамп фаил конфигурации для virsh (xml-ный файл)?

Можно воспользоваться virt-manager и не городить скрипты запуска ВМ напряму через qemu-system-x86_64.

У меня virt-manager создаёт бредовый конфигурационный фаил. Неправильно определяет тип хостового процессора, не даёт выбрать q35. При ручной правке созданного конфига - машина полностью пропадает из окна выбора virt-manager. Причём virsh define не видет ошибок.

Неправильно определяет тип хостового процессора

Что за железо у тебя?

q35 не обязательно для проброса видео, можно юзать стандартный 440fx.

amd athlon 760k и материнка asrock на 85 чипсете

пукать во время секса - норма. а это фигня какая-то

Успешно прокинул карту в ВМ с конфигом из топика?

BIOS на втором мониторе загорелся, загрузилось начало установки. До конца систему ставить не стал. Кстати, как через qemu привязать беспроводную клаву с мышкой, если на хосте другой комплект с темже vendor id? В virt-manager правил xml и цеплял по шине и номеру устройства usb.

ты, это, того, короче геморой запускать нельзя.

деб* для квм не фонтан, у тебя либо либвирт/кему/виртманагер старые, либо кривые, либо ты настроил коряво, либо конфиг правишь левой пяткой. Из всех граблей ты, похоже выбрал. все.в вирт манагере добавляешь usb-хост девайс и все, нафиг руками мучаться, два одинаковых устройства будут глючить/рандомно цепляться.

Вот и не знаю с какой стороны хвататься. Ну главное понял, что проброс с vfio и vga none у меня работает. В virt-manager (для определения моего процессора) в xml'e писать

Обычно достаточно. И кончай курить, в virt-manager'e нет ручной правки xml.

Вот xml от вирт-менеджера, таким образом у меня работает проброс. Проброшено видео и usb-мышка.

King_Carlo★★★★★ ( 05.11.14 14:00:11 )

Последнее исправление: King_Carlo 05.11.14 14:01:26 (всего исправлений: 1)Сейчас буду пытаться. /etc/libvirt/qemu/блаблабла.xml сюда virt-manager кидает фаил конфигурации. А потом его virsh или текстовиком каким.

Во перых не кидает, а там его и хранит/пользует. Во вторых

Меня смущает вот эти строки

Если у меня AMD - повлияет ли это на производительность гостя? И что значит model и require? У тебя всё стоит require, это значит что эти инструкции задействованы?Если исправил вручную gedit, а потом сделал virsh define, то там всё прекрасно сохраняется и эти параметры передаются в виртуальную машину. Но ясно что лучше так не делать, это уже я эксперементировал с определениями моего процессора и его инструкций.

Пробрось сами usb порты с матери.

Дефайн, вообще-то эти файлы и создает.

делаю vfio-bind в qemu дописываю

Я в курсе. Использовал gedit из-за привычкы мышко-тыкальства. Так мне по тексту проще перемещаться.

Скажите, а куда в virt-manager забить параметр аналогичный в qemu -vga none . Чето немогу догнать, как заставить сразу грузить окно с bios на проброшенную видеокарту.

тот твой топик для меня стал вдохновением :)

![]()

А я не пользуюсь ни наркоманским virt-manager'ом, ни libvirt, virsh и прочие наркоподелия. То то нельзя выбрать, то этого нет, короче гониво.

где взял парамтры проброса usb?

Если у меня AMD - повлияет ли это на производительность гостя?

Впиши свой процессор. Я тебе свой конфиг для примера кинул, у меня intel i7-4790k.

Только я использую pci-assign, а не vfio.

У тебя гость повторно запускается, хост не вешает?

![]()

Определил нужные мне порты по lsusb -t .

![]()

У тебя гость повторно запускается, хост не вешает?

может повесить, а может просто не запуститься, у меня через vfio не получается просто, приходится вот так. Скрипты в госте отключения лень городить.

Ну и редко когда запускаю гостя чаще, чем раз в несколько суток.

Запустил и пусть себе работает.

Мне нужно пробросить Bus 06 (это usb 3.0. в него вставил свисток беспроводной мыши и клавы) В запускалку qemu добавляю такие строчки (сомневаюсь в правильности)

![]()

Я использую -machine pc-i440fx-2.0 , который лучше для проброса нежели q35, возможно причина в этом (т.к. в q35 встроенный usb-контроллер, а я для i440fx указываю свой), я показал полную комманду запуска.

Кстати, а чего ты хочешь добиться предоставляя гостю использовать 6 ядер, но фактически отдавая только 4? Если я не ошибаюсь, вот так правильнее будет:

![]()

Кстати, уже в установленной системе всяко удобнее использовать Synergy и юзать хостовую клавиатуру, а не использовать/пробрасывать вторую.

Есть несколько способов управлять виртуальными машинами, запущенными в гипервизоре KVM, например с помощью популярного графического фронтенда virt-manager. Однако, если вы хотите использовать KVM на сервере, графические решения вряд ли будут хорошим выбором. В этом случае удобным инструментом будет virsh - утилита командной строки для управления гостевыми виртуальными машинами. Она работает со службой libvirtd, которая может управлять несколькими различными гипервизорами, включая KVM, Xen, QEMU, LXC и OpenVZ.

Интерфейс командной строки virsh также полезен в случае, если вы хотите автоматизировать инициализацию и управление виртуальными машинами. Кроме того, способность virsh работать с различными гипервизорами обеспечивает единый интерфейс для управления виртуальными машинами различных типов.

В этом руководстве я продемонстрирую вам, как запускать KVM из командной строки с использованием virsh в Debian или Ubuntu.

Этап 1: проверка аппаратной поддержки виртуализации

В качестве первого этапа проверьте, поддерживает ли ваш процессор аппаратную виртуализацию (то есть Intel VT или AMD-V), которая требуется для KVM. Это можно сделать с помощью команды:

Если в выводе нет флага vmx или svm, это значит, что процессор не поддерживает аппаратную виртуализацию, поэтому вы не сможете использовать KVM на этом хосте. После проверки самое время установить KVM.

Этап 2: Установка KVM

Установите KVM и соответствующие пользовательские утилиты с помощью apt-get:

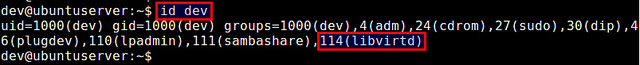

Во время инсталляции будет создана группа libvirtd, и ваш userID будет автоматически добавлен в группу. Это позволит вам управлять виртуальными машинами от имени обычного пользователя. Вы можете проверить это с помощью команды id, которая выводит ваш group ID.

![добавление userID]()

Если по каким-либо причинам в списке вашего groupID нет libvirtd, вы можете вручную добавить себя в эту группу.

Перезагрузите обновленную информацию о группе, как показано ниже. Когда появится запрос, введите свой пользовательский пароль.

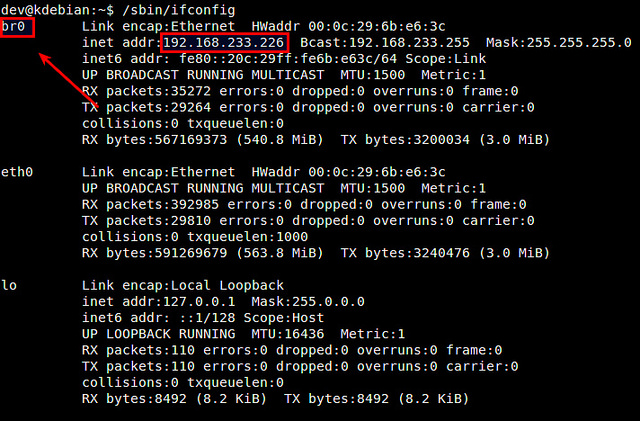

Этап 3: Настройка сетевого моста

Один из способов получения доступа из виртуальной машины к внешним сетям - мост, встроенный в ваш хост Linux. Это называется сетевой мост. Ниже описано, как создать и настроить сетевой мост Linux br0 для мостового соединения с KVM.

Сначала установим необходимый для создания сетевого моста пакет.

Далее необходимо настроить сетевой мост в файле /etc/network/interfaces, чтобы он активировался при загрузке системы. Для использования файла /etc/network/interfaces необходимо отключить Network Manager (если он у вас используется). Как это сделать, описано здесь .

После отключения Network Manager настраиваем сетевой мост br0 в /etc/network/interfaces, как показано ниже.

Здесь предполагается, что главным сетевым интерфейсом, который имеет доступ к внешним сетям, является eth0. Кроме того, предполагается, что eth0 получает IP-адреса посредством DHCP. Обратите внимание, что в /etc/network/interface нет настроек для eth0, так как он подключается к сетевому мосту br0.

Перезагрузите сетевые службы и убедитесь, что сетевой мост настроен успешно. В этом случае br0 должен присвоить сетевой адрес интерфейса eth0, в свою очередь интерфейсу eth0 не должно быть присвоено сетевого адреса.

![настройка сетевого моста]()

Этап 4: создание виртуальной машины из командной строки

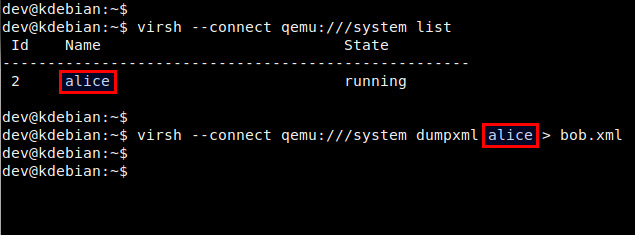

В KVM настройки виртуальной машины хранятся в XML-файле домена. Поэтому сначала необходимо подготовить этот файл.

Ниже пример простого XML-файла для виртуальной машины. Вы можете использовать его, откорректировав в соответствии со своими потребностями.Этот XML-файл определяет следующую виртуальную машину:

1 Гб оперативной памяти, один CPU и один жесткий диск.

Образ диска: /home/dev/images/alice.img.

Загрузка с CD: (/home/dev/iso/ubuntu-13.10-server-amd64.iso).

Сеть: сетевой мост br0.Строка UUID между тегами <uuid></uuid> может быть сгенерирована случайным образом. Для этого используется утилита командной строки uuid.

Доменный XML-файл можно также создать, сделав дамп информации о домене существующей виртуальной машины:

![дамп информации о домене существующей виртуальной машины]()

Этап 5: запуск виртуальной машины из командной строки.

Перед запуском виртуальной машины необходимо создать образ диска для нее. Для этого можно воспользоваться командой qemu-img, входящей в пакет qemu-kvm.

Преимущество опции qcow2 в том, что создаваемый при ее использовании образ диска не резервирует сразу весь свой свой объем (5 Гб), а динамически увеличивается при наполнении в процессе работы виртуальной машины.

Теперь вы готовы к запуску виртуальной машины с использованием созданного ранее доменного XML-файла. Это делается с помощью приведенной ниже команды:Проверьте, что домен создан успешно.

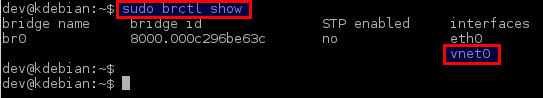

Кроме того, проверьте, что виртуальный сетевой интерфейс для виртуальной машины (то есть vnet0) успешно добавлен в созданный ранее сетевой мост br0.

![проверка виртуального сетевого интерфейса]()

Этап 6. Удаленный доступ к виртуальной машине.

Для удаленного доступа к консоли виртуальной машины вы можете использовать любой VNC-клиент.

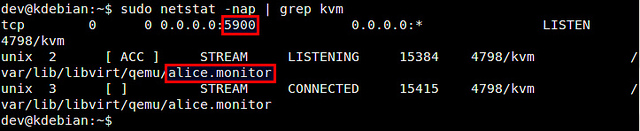

Сначала определите номер порта VNC для виртуальной машины:![определение номера порта VNC]()

В этом примере номер порта для виртуальной машины alice 5900.

Затем запустите VNC-клиент и подключитесь к VNC-серверу, работающему по адресу KVM-host-IP:5900.

Управление виртуальной машиной с помощью virsh

Ниже список наиболее часто употребляемых команд virsh.

Для создания нового гостевого домена и запуска виртуальной машины:

Для остановки виртуальной машины и уничтожения гостевого домена:

Для выключения виртуальной машины (без уничтожения домена):

Для приостановки виртуальной машины:

Для возобновления работы виртуальной машины:

Для автозапуска виртуальной машины после загрузки хоста:

Для получения информации о домене виртуальной машины:

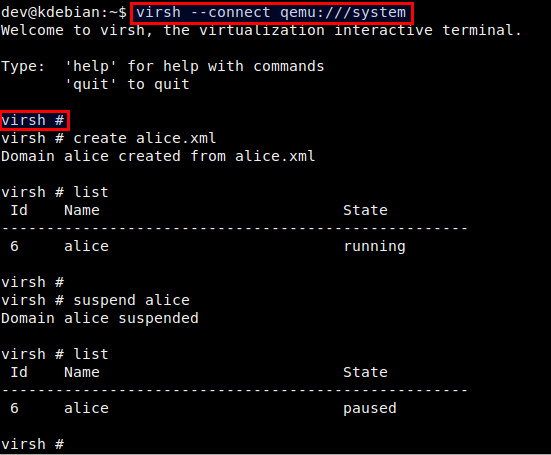

Вы можете также управлять виртуальными машинами из сессии virsh. Для создания новой сессии virsh и входа в нее, просто введите:

В командной строке вы можете использовать любые команды virsh.

![командная строка virsh]()

Решение проблем

1. Я получил ошибку, когда попытался создать виртуальную машину:

Вы получите эту ошибку, если ваш процессор не поддерживает аппаратную виртуализацию (то есть Intel VT или AMD-V), которая требуется для работы KVM. Если же вы получили эту ошибку с процессором, поддерживающим Intel VT или AMD-V, возможные решения этой проблемы:

Во-первых, проверьте, загружены ли требуемые модули ядра.

Если модуль kvm не загружен, вам необходимо загрузить его:

Второе решение - добавление аргумента "--connect qemu:///system" к команде virsh, как показано ниже. Этот аргумент может потребоваться, если вы используете более одного гипервизора (то есть VMware, VirtualBox) на сервере.

2. Я получил ошибку, когда пытался запустить консоль своей виртуальной машины:

Эта ошибка возникает потому, что вы не определили устройство консоли в XML-файле виртуальной машины. Добавьте приведенные ниже строки в раздел "device" XML-файла.

Данная статья — это обобщение информации, накопленной за время использования гипервизора Qemu-KVM. Я хочу поделиться теми знаниями опытом, которыми обладаю на данный момент. Надеюсь, что моя статья пойдет на пользу тем, кто только собирается использовать гипервизор Qemu-KVM или уже использует. И еще: статья не для новичков linux (элементарные вещи здесь рассматриваться не будут).

Про данную систему виртуализации в сети написано много. Но когда действительно начинаешь с ней работать — сталкиваешься с нехваткой информации и практических примеров применения. Итак приступим.

Переходим к делу. Установку операционной среды описывать я не буду. Оговорюсь лишь, что во время установки операционной среды жесткий диск большего размера не трогал. Его время еще придет. Как установить гипервизор на Debian очень хорошо описано здесь. Лично я ставлю qemu-kvm libvirt-bin.

Гипервизор поставили, теперь немного о внутренней структуре. Есть два каталога, в которые стоит заглянуть:

/etc/libvirt/ — здесь в основном хранятся конфигурационные файлы

/var/lib/libvirt/ — здесь будут хранится образы жестких дисков, мгновенные снимки системы и многое другое.

Наш гипервизор установлен.Далее сохраняем файл и перезагружаем компьютер.

О, чудо! Гипервизор установлен!

Дальше возникает вопрос: как управлять сервером? Управлять Qemu-kvm можно двумя программами: virt-manager и virtinst.Virt-manager.

Эта программа рассчитана на графический интерфейс. Она поддерживает как удаленное управление виртуальными машинами, так и локальное. Но у нее есть огромный минус — аналогов для windows попросту нет.

Как лично я вышел из положения. Установил графическую оболочку LXDE и сервер xrdp, благодаря такому нехитрому набору программ мне не пришлось физически ходить к компьютеру (больно много ему чести). Я просто подключался через стандартный RDP клиент который, есть в windows. Но это дополнительная трата ресурсов компьютера.

Если вы установили virt-manager, он автоматически создает:

хранилище для образов виртуальных машин по пути /var/lib/libvirt/images

виртуальный сетевой интерфейс default.

Следовательно подмонтировать жесткий диск с большим объемом нужно в директорию /var/lib/libvirt/images.Если не создавать хранилище для образов дисков виртуальных машин, то для того, чтобы диски лежали в одном месте, нужно будет указывать полный путь к образу при его создании(много писать), а так образ создастся в указанном пуле или если он у вас единственный, то его имя указывать не обязательно. Конфигурационный файл пула будет лежать в директории /etc/libvirt/storage/ это .xml файлик. Выходим из virsh введя команду exit.

В принципе наш гипервизор установился и его можно использовать. Но есть еще маленькая мелочь, о которой хотелось бы упомянуть. А именно о том, как работает Qemu-kvm.

Запущенная на нем виртуальная машина шлет команды физическому процессору напрямую через загружаемый модуль (kvm-amd или kvm-intel). Это должен быть один из модулей, который соответствует производителю процессора (Intel или AMD).

В сборке собственного ядра мне помогли вот эти статьи первая и вторая.

Забегу немного вперед. Многие люди в интернете жаловались на то, что модель сетевой карты virtio некорректно работает. Этому есть объяснение, и достаточно простое. Драйвера для этого устройства находятся в стадии экспериментальных. Зато virtio storage работают отлично.

Теперь начинаем работать с виртуальными машинами. Создаем нашу первую виртуальную машину:

virt-install --connect qemu:///system \

--name comp1 \

--ram 512 \

--vcpus=1 \

--disk pool=storage,cache=none,size=20, format= qcow2\

--disk /home/firsachi/Winxp.iso,device=cdrom \

--bridge=br0,model=e1000 \

--os-type=windows

--os-variant=winxp \

--graphics vnc,port=5901,listen=0.0.0.0Некоторые детали хочу пояснить:

pool=storage указываем пул, в котором нужно создать диск;

cache=none это означает, что отключено кэширование записи на диск. В моем случае это образ img. При включенном кэшировании записи вдвое увеличивается время обращения к диску виртуальной машины;

size=20 размер диска в гигабайтах;

format= qcow2 это формат образа диска. Как я понял, только он поддерживает снимки системы;

model=e1000 модель сетевой гигабитной карты Intel (по умолчанию идет стомегабитный rtl8139);

port=5901 порт, на который можно обратиться с помощью Ultra VNC Viewer;

listen=0.0.0.0 разрешение подключиться со всех IP (по умолчанию слушает только localhost).

Установку можно произвести непосредственно и на устройство. Выглядеть будет так:

virt-install --connect qemu:///system \

--name comp1 \

--ram 512 \

--vcpus=1 \

--disk /dev/sdb, format= qcow2\

--disk /home/firsachi/Winxp.iso,device=cdrom \

--bridge=br0,model=e1000 \

--os-type=windows

--os-variant=winxp \

--graphics vnc,port=5901,listen=0.0.0.0

Где sdb должен быть заменен на ваше устройство.Если все прошло успешно, то для подключения к консоли нашей виртуальной машины нужно установить Ultra VNC Viewer к себе на компьютер. В подключении нужно указать IP адрес сервера и порт, или доменное имя сервера и порт.

Как происходит установка Windows, надеюсь, знают все.Теперь о драйверах виртуальных машин. Для установки драйверов нужны следующие образы дисков: virtio-win-0.1-30.iso и viostor-0.1-30-floppy.img

Последний диск не обязателен, он нужен только в том случае, если вы собираетесь установить windows xp или windows 2003 server на virtio storage (кстати, если так сделать, то операционная система работает быстрее).Во многом поможет и вот эта статья. Рекомендую также заглядывать вот сюда.

Установил на нем Qemu-KVM, переместил на него файл конфигурации виртуальной машины и образ диска. В файле конфигурации отредактировал путь к диску виртуальной машины, перезагрузил ноутбук. И, о чудо! Гипервизор не только увидел мою виртуальную машину, но и запустил ее.

Вот так теперь и живем: гипервизор Qemu-KVM, виртуальный контролер домена, и довольный проделанной работой я.

Спасибо всем, кто дочитал до конца. Надеюсь, мои мысли оказались полезными.Читайте также:

- Create new VM guest with below configuration:

-

Edit the VM guest configuration, assume the VM guest name is "VMGUEST" having 4 virtual CPU core

Disk I/O

Disk I/O is usually the bottleneck of performance due to its characteristics. Unlike CPU and RAM, VM host may not allocate a dedicated storage hardware for a VM. Worse, disk is the slowest component between them. There is two types of disk bottleneck, throughput and access time. A modern harddisk can perform 100MB/s throughput which is sufficient for most of the systems. While a modern harddisk can only provides around 60 transactions per seconds (tps).

For VM Host, you can benchmark different disk I/O parameters to get the best tps for your disk. Below is an example of disk tuning and benchmarking using fio: