В какие игры компьютер не обыграл человека

Обновлено: 03.07.2024

"Искусственный интеллект (ИИ) научился…" – такие заголовки каждый раз провоцируют очередную серию дебатов на тему скорой победы машины над человеком.

Хотя в новостях нередко преувеличивают достижения и притягивают факты за уши, с каждым годом становится все больше задач, где ИИ – пусть и с оговорками – обходит человека.

Игры – та область, в которой совсем недавно человек считал себя непобедимым, благодаря нестандартному мышлению и огромному, трудно просчитываемому числу вариантов. Но сейчас здесь безраздельно властвуют машины, а полученный при создании игровых ИИ-систем опыт открывает огромные возможности для переноса подходов к их обучению на более серьезные задачи.

Сегодня ИИ – это в первую очередь сложные самообучающиеся алгоритмы-нейросети, полученные путем "глубокого обучения" (deep learning) на огромных массивах данных. Победы в играх, как правило, основаны на технике reinforced learning ("обучение с подкреплением"): компьютер ничего не знает о правилах игры, но учится, играя невероятное количество матчей сам с собой. Люди при этом лишь настраивают сложную схему поощрений за "правильные" действия.

В каких играх человек уже уступил ИИ? Есть ли ограничения? И какие перспективы? Настоящее Время предлагает подборку избранных игровых ИИ-достижений последних лет.

Май 1997. Шахматы

Суперкомпьютер IBM Deep Blue вошел в историю как первая машина, сумевшая победить в шахматах гроссмейстера-человека. Чемпион мира Гарри Каспаров сумел выиграть в одной из партий, другая закончилась вничью, но Deep Blue выиграл дважды и стал победителем поединка.

Строго говоря, Deep Blue не был ИИ в современном понимании: он просто умел быстро искать среди миллионов вариантов лучшие ходы по определенным правилам, установленным людьми.

Через 20 лет Google представил мощную ИИ-систему DeepMind AlphaZero: она научилась шахматам, японским шахматам и го с нуля, причем в каждой дисциплине AlphaZero сумела победить лучшего компьютерного игрока. А компьютеры, по крайней мере – в шахматах, не оставляли людям шансов примерно со времен матча между чемпионом мира Владимиром Крамником и Deep Fritz в 2006 году (2-4).

Март 2016. Го

До мая 2017-го, когда прошел исторический матч между ИИ AlphaGo (Google DeepMind) и чемпионом мира по го Ли Седолем. AlphaGo выиграл со счетом 4-1. Позже этот успех развил "универсальный" игровой ИИ AlphaZero.

Июль 2018. Quake III

Казалось бы, в чем смысл тренировать ИИ-систему, которая хорошо бы играла в легендарный шутер? Исследователи из DeepMind называют это сложной исследовательской задачей: как научить компьютер с нуля ориентироваться в трехмерном игровом пространстве с неидеальной информацией (неизвестно, где спрятался враг).

Ученые также решили не упрощать задачу и не описывать пространство известными параметрами ("расстояние до красного_игрока_1 = 55"), а просто показывать ИИ игровой экран.

Эта задача уже непростая. А для ее усложнения в DeepMind решили проверить еще и способы обучения разных ИИ-игроков командному взаимодействию, поэтому режимом игры был выбран "захват флага" – группе игроков нужно действовать скоординированно, чтобы утащить флаг с вражеской базы, не потеряв при этом свой.

Результат? Вероятность победы команд под управлением ИИ достигала 74%. У сильных людей-игроков – всего 52%.

Январь 2019. Starcraft II

В этом году искусственному интеллекту покорилась одна из самых популярных стратегий реального времени ХХI века – игра Starcraft II. В начале года нейросеть Deepmind AlphaStar (Google) легко победила (счет 5-1 или 5-0, смотря как считать) одного из лучших в мире игроков в Starcraft II, поляка Грегоржа MaNa Коминча.

Игра требует не только молниеносной реакции и четкого управления сотнями боевых единиц, но и долгосрочного стратегического планирования на больших картах. К тому же Starcraft II не раскрывает игрокам всей важной информации о состоянии игрового поля: в отличие от, скажем, шахмат, игровая карта не открыта все время, неизвестны запасы ресурсов врага, размер и положение его армии и т.п. То есть, научить ИИ всем премудростям и хитростям игры непросто. Каждая из версий AlphaStar тренировалась на ИИ-коллегах, отыграв примерно по 200 человеческих лет.

Несмотря на эффектную победу, игра была ограничена одной расой (из трех) и первое время полным обзором карты для AlphaStar – человеку постоянно надо переключать позицию, показываемую на экране, а ИИ сначала словно смотрел на огромный монитор, умещавший всю карту сразу. Все ограничения, похоже, можно было бы снять, просто увеличив время тренировки модели.

Апрель 2019. Dota 2

ИИ Open AI Five победил команду OG, прошлогодних чемпионов крупнейшего турнира по игре Dota 2. Правда, команды были ограничены всего 17 героями в режиме Captain’s Draft, не работали внутриигровые функции создания иллюзорных копий и вызова существ-помощников.

Создатели, как и в случае со Starcraft, не объясняли Five сложные правила Dota 2, а "научили учиться": с нуля система сама разобралась в правилах, играя сама с собой –45000 часов за десять месяцев.

Июль 2019. Покер

Успех в популярной карточной игре немалым образом зависит от умения покериста блефовать и вычислять блефующих соперников.

В 2017-м вышли ИИ-система DeepStack (университет Альберты), легко обыгрывающая профессионалов, а также проект Libratus от специалистов из университета Карнеги Меллон, который в 20-дневном марафоне выиграл виртуальные $1,7 млн у четырех профессиональных покеристов в матчах один на один.

Тот же Карнеги Меллон и Facebook в июле 2019 показали самую совершенную ИИ-систему для покера – Pluribus (pdf). Она умеет успешно играть (в том числе с использованием блефа) сразу с пятью оппонентами. Система работает на достаточно недорогом компьютере, а вычислительные ресурсы для обучения Pluribus обошлись всего в $150: чтобы стать непобедимым, боту понадобилось разыграть триллионы покерных раздач с пятью своими клонами.

Поиграли, и что дальше?

Искусственный интеллект – одно из ключевых направлений развития науки во всем мире. Область его применения, разумеется, не ограничивается играми – скорее, это отправная точка для новых способов применения ИИ в реальной жизни.

Компании-лидеры, в основном из США и Китая (Google, Facebook, Amazon, Microsoft, Tencent, Alibaba), инвестируют миллиарды в развитие ИИ. И каждый год приносит что-то впечатляющее: генерацию правдоподобных видео, создание текстов, картин, музыки. С каждым годом становятся все автономнее автомобили.

В последнее время все чаще говорят об этике использования ИИ и потенциальных больших проблемах: среди очевидных вещей вроде потери многих рабочих мест (и появления новых), специалисты обеспокоены предвзятостью ИИ-решений во многих задачах, а также рисками использования ИИ в военных системах.

При этом до главного Золотого Грааля ИИ, "общего искусственного интеллекта" (AGI, Artificial Generalized Intelligence), человечеству еще далеко. AGI – это реализация искусственного интеллекта из фантастических книг и фильмов, система, которая сможет решать любую задачу на уровне человека или лучше. Все современные ИИ строго специализированы и не могут легко переключаться между различными направлениями: скажем, нейросеть, умеющая распознавать символы на фото, не сможет генерировать тексты, и наоборот.

Кто-то считает, что AGI в принципе недостижим, но опрошенные в 2015 году ИИ-эксперты сошлись на том (pdf), что c 50%-ной вероятностью общий ИИ появится в ближайшие 45 лет. При этом ученые из Азии в среднем были оптимистичнее, чем американцы.

По результатам другого неформального опроса, AGI изобретут к 2099.

А вот известный ученый-футуролог Рэй Курцвайль из Google считает, что это произойдет еще до 2029 года.

Даже до появления общего ИИ развитие компьютеров и робототехники приведет к глобальным изменениям на мировом рынке труда. Исследователи считают (pdf), что искусственный интеллект превзойдет людей в качестве перевода (к 2024) и по уровню школьных сочинений (2026); ИИ сможет лучше человека водить грузовики (2027) и работать в торговле (2031), писать книги (2049) и даже превзойдет людей-хирургов (2053).

В те времена люди без особого труда одерживали победу над исскуственным интеллектом. Но сегодня мощные программы, способные просчитывать миллионы ходов, обыгрывают людей, не оставляя им шансов.

Впрочем, на практике нет никакого смысла обыгрывать компьютерные программы. Попытки предпринимаются, конечно, только ради забавы. А тем, насколько стремительно совершенствуются компьютерные программы, мы, люди, создающие их, можем только гордиться.

Приведём пример 7-ми игр с самым мощным ИИ, для которого человек не соперник.

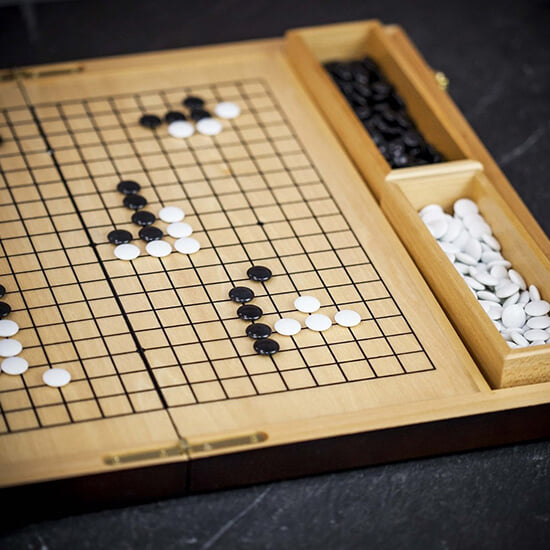

Го – ещё более сложная игра, чем хорошо всем знакомые шахматы. Здесь есть более 350 способов начать матч, тогда как в шахматах их всего 20. А уже после 1-го хода появляется почти 130 тыс. разных комбинаций. В шахматах же после начального хода может быть одна из 400 позиций.

Если хочется на личном опыте убедиться, что современный ИИ невозможно обыграть в Го, то можно сразиться с AlphaGo. Так называется алгоритм, разработанный компанией Google. Самая современная версия – Zero бесконечно тренировалась, проводя игру сама с собой и всего за несколько дней стала лучше всех своих предшественников.

2. Jeopardy

Jeopardy – это телевикторина, аналогом которой на нашем телевидении является «Своя игра». Лучший игрок – БрэдРаттер однажды сразился с компьютером Watson и… проиграл.

Примечательно, что робот не был подключён к Интернету и находил ответы даже на те вопросы, которые были поставлены неоднозначно. В итоге он получил 80 тыс. долларов, и эти деньги, конечно же, пошли на благотворительные цели.

3. Кубик Рубика

Среднестатистический человек может собирать кубик Рубика несколько часов. И хорошо, если удастся собрать хотя бы одну грань. Но если постоянно тренироваться, можно сократить время сбора до нескольких минут или даже секунд. Мировой рекорд среди представителей нашего биологического вида – 4,69 сек. Но робот с ИИ, появившийся пару лет назад, собирает кубик в 12 раз быстрее. Ему на это требуется меньше половины секунды.

4. Покер

В покере невозможно увидеть карты играющего, пока он их сам не покажет, и поэтому задача программистов, поставивших цель создать ИИ, способный обыгрывать человека, существенно усложняется. Однако нейросеть DeepStack, имеющая нечто похожее на интуицию, смогла добиться больших успехов, ежедневно играя и анализируя проведённые игры.

5. Dota 2

Лучшим искусственным игроком в Dota 2 является OpenAlFive. Лучшие результаты система показывает в матчах «один на один». Боты становятся всё более совершенными, учась на своих же ошибках. Но их слабая сторона – стратегия. Они реагируют лишь на те события, которые происходят в данный момент и способны планировать свои действия не более чем на 15 мин. вперёд.

6. Pac-Man

Pac-Man – одна из самых старых и хорошо всем знакомых компьютерных игр. Существует огромное количество её вариаций. Немалую популярность в своё время имела версия Ms. Pac-Man, выпущенная для консоли Atari 2600. Враги здесь ведут себя совершенно непредсказуемо, из-за чего прохождение уровней существенно усложняется. Даже человек после долгих тренировок смог набрать не многим более 250 000 очков.

Но недавно компания Maluuba, принадлежащая корпорации Microsoft, разработала программу, которая смогла набрать максимально возможные 999 999 очков.

7. StarCraft 2

Программа AlphaStar, разработанная компанией DeepMind, успешно обыгрывает профессиональных геймеров в StarCraft 2 «в сухую» – со счётом 10:0. Правда, у ИИ было одно преимущество, которое не совсем честное. Дело в том, что он всегда может видеть полную карту, тогда как геймерам приходится для этого прокручивать экран.

👇 Первое правило любой игры: играй с соперником, который сильнее тебя. Подписывайтесь на канал, оценивайте публикацию . 👇

Люди проигрывают искусственному интеллекту на собственной территории — компьютеры уже выигрывают у нас в шахматы, го, покер и даже Dota 2. Мы составили краткий обзор таких противостояний и попробовали разобраться, какие прикладные задачи могут решать игровые алгоритмы в будущем.

В 1914 году испанский инженер и математик Леонардо Торрес-и-Кеведо, который изобрел одну из первых систем радиоуправления, представил шахматный автомат. Он был достаточно примитивным и умел разыгрывать только эндшпиль — финальную стадию партии — но ни один из мастеров того времени не смог выиграть у автомата Торреса.

Начавшаяся в том же году Первая, а вскоре после нее и Вторая мировые войны остановили дальнейшие разработки. Следующий важный этап для искусственного интеллекта наступил только в 1955 году — тогда и появился сам термин «искусственный интеллект». Его придумал американский ученый Джон Маккарти, а через три года он создал язык программирования Lisp, который стал основным в работе с ИИ.

В 1956 году другой инженер Артур Сэмюэл создает первый в мире самообучающийся компьютер, который играет в шашки. Сэмюэл выбрал именно шашки из-за элементарных правил, которые при этом требуют определенной стратегии. Компьютер обучался на простых гидах по игре, которые можно было купить в магазине. В них описывались сотни партий с хорошими и плохими ходами. Через три года Сэмюэл ввел понятие машинного обучения.

Артур Сэмюэл играет в шашки с компьютером IBM 701, 1959 годИнтересный факт: в 1966 году Джозеф Вейценбаум представил Элизу, первого в истории чат-бота. Элиза могла говорить на английском на любые темы. Вейценбаум разработал ее, чтобы сымитировать прием у психотерапевта. Он специально выбрал сложную ситуацию, в которой многое опирается на умение слушать и распознавать главное в репликах собеседника — компьютер того времени этого не мог. Разработчик таким образом хотел показать, насколько ненатуральным будет общение человека и компьютера, но при тестах оказалось, что люди испытывали в разговоре с Элизой чувства и эмоции, как с полноценным собеседником.

В 1985 году университет Карнеги-Меллон начал разработку ChipTest, компьютера для игры в шахматы. В 1988 к проекту присоединилась IBM и прототип переименовали в Deep Thought. Через год его решили проверить в деле и пригласили Гарри Каспарова, который без труда победил в обеих играх.

В 1995 IBM представила Deep Thought II, который позже назвали Deep Blue, сделав отсылку к прозвищу компании, Big Blue. Через год состоялся первый матч Каспарова и улучшенного компьютера. Человек снова выиграл: в шести партиях Каспаров три раза победил и один раз проиграл, два матча закончились вничью.

Еще через год, в мае 1997, сильно улучшенный Deep Blue одержал в ответном матче две победы, один раз проиграл и трижды сыграл вничью, став первым компьютером, выигравшим у действующего чемпиона мира по шахматам.

Уже в начале 2000-х компьютеры стабильно выигрывали у мировых чемпионов, и шахматы стали первой игрой, в которой люди уступили компьютерам.

Разработчики искусственного интеллекта начали искать новый вызов в более сложных и непредсказуемых играх, для которых нужны более комплексные алгоритмы. После победы Deep Blue астрофизик из университета Принстона заявил, что «пройдет 100 лет перед тем, как компьютер сможет обыграть человека в го — может, даже больше». Ученые приняли вызов и начали разрабатывать машины для этой игры с простыми правилами, в которой тем не менее очень сложно стать мастером.

Первые компьютеры, которые действительно могли составить конкуренцию человеку, появились только в этом десятилетии. В 2014 году Google DeepMind представила алгоритм AlphaGo, который два года соревновался с людьми на равных, но одержал первую значимую победу только в октябре 2015, одолев чемпиона Европы.

Через год на популярном азиатском сервере Tygem, где играют и мировые чемпионы, появился пользователь под ником Master. За несколько дней он провел 60 матчей и ни разу не потерпел поражения, чем вызвал возмущения и подозрения в нечестной игре. 4 января 2017 года Google раскрыла, что все это время под ником скрывалась улучшенная версия AlphaGo.

В мае 2017 AlphaGo — все тот же, который прославился в сети под ником Master — сразился с Кэ Цзе, первым игроком го в мировом рейтинге, и победил в трех матчах из трех, а уже в октябре Google DeepMind выпустила версию, которая была мощнее Master. AlphaGo Zero самообучался вообще без участия человека, просто бесконечно играя сам с собой. Через 21 день он достиг уровня Master, а через 40 уже был лучше всех предыдущих версий.

В декабре 2017 вышел AlphaZero, еще более мощный вариант AlphaGo Zero. Он смог стать лучше предшественника за 8 часов, одновременно достигнув уровня гроссмейстера в шахматах. Так го стала второй игрой, в которой люди больше не могут выиграть.

Го и шахматы подчиняются строгим правилам, и тренировка искусственного интеллекта в них — дело времени. Но есть игры, в которых человеческий фактор выходит на первый план. Например, покер — во многом психологическая игра, построенная на эмоциях, неверабальной коммуникации, умении блефовать и распознавать блеф.

В 2017 году, после более чем 10 лет попыток и неудач, две команды независимо друг от друга разработали свои модели ИИ, способные обыграть профессионалов в покер. Университет Альберты представил DeepStack, нейросеть, обладающую искусственной формой интуиции, а исследователи уже знакомого университета Карнеги-Меллон показали Libratus AI. Нейросеть за 20 дней провела 120 тысяч игр против профессионалов, которые собирались каждый вечер, чтобы обсудить возможные лазейки и недоработки в Libratus. Каждый игровой день анализировала и нейросеть, совершенствуясь по его итогам.

Меньше чем за месяц Libratus выиграла у профессионалов $1,7 млн (пока что виртуальных), а один из участников эксперимента так описал свои впечатления: «Это как играть с кем-то, кто видит все твои карты. Я не обвиняю нейросеть в нечестной игре, просто она действительно настолько хороша».

В 2015 году Илон Маск и Сэм Альтман, президент Y Combinator, основали компанию OpenAI, чтобы создать открытый и дружественный искусственный интеллект.

В 2017 году в рамках эксперимента команда разработчиков решила натренировать свою нейросеть в Dota 2 — игре, в которой две команды по пять человек сражаются друг с другом, используя множество комбинаций более сотни героев. У каждого из них есть свой набор навыков, а игроки могут собирать предметы для усиления персонажа. Это крупнейшая игра в современном киберспорте.

За две недели нейросеть смогла обучиться и победить нескольких лучших игроков мира в режиме один на один, и сейчас ее создатели готовятся выпустить версию для основного режима, пять на пять.

В начале 2018 алгоритмы от Alibaba и Microsoft превзошли человека в тесте на понимание прочитанного текста.

В марте 2018 года небольшой робот собрал кубик Рубика за 0,38 секунды. Рекорд среди людей — 4,69 секунды.

В мае 2018 искусственный интеллект стал лучше людей распознавать рак кожи.

По данным опроса более чем 350 экспертов в области искусственного интеллекта, скоро алгоритмы смогут победить нас в любой игре, через 10 лет научатся водить лучше нас, а к 2050 году будут проводить операции точнее нас.

Сами же исследователи, создав нейросети, которые за несколько дней достигают сверхчеловеческих способностей в играх, теперь пытаются найти им применение в реальной жизни. Google DeepMind использует AlphaGo Zero для исследования сворачивания белка, пытаясь найти лекарство от болезней Альцгеймера и Паркинсона.

«Наша конечная цель — использовать прорывы вроде AlphaGo для решения всех видов насущных проблем в реальном мире», — говорит Демис Хассабис, СЕО компании. «Если такие алгоритмы можно применить и в других ситуациях, как, например, изучение сворачивания белка, снижение уровня потребляемой энергии, или создание новых революционных материалов, то это сильно продвинет вперед все человечество и положительно скажется на наших жизнях».

Искусственный интеллект активно идет и в бизнес — не только в лабораториях Google, но и в российских компаниях: «Тинькофф» использует искусственный интеллект для одобрения кредитов, а «Газпромбанк» распознает улыбки клиентов с помощью компьютерного зрения.

На прошлой неделе южнокорейский мастер игры в го и один из самых титулованных игроков в мире Ли Седоль объявил о завершении карьеры и сделал драматичное заявление: «После того, как искусственный интеллект начал играть в го, я понял, что не стану лучшим, даже если возглавлю рейтинг за счет безумных усилий. Теперь есть сущность, которую не одолеть».

Ли говорил о компьютере AlphaGo – разработке компании DeepMind, которую пять лет назад за 650 миллионов долларов купил Google. Машине кореец проиграл еще в 2016-м, но с тех пор искусственный интеллект стал только сильнее. А вообще победу компьютера над человеком в го считают настоящим прорывом, который потенциально может привести к масштабным изменения в мире.

Го долго не давалась компьютерам: все ходы не просчитать, нужны интуиция и абстрактное мышление

Программисты уже давно проверяют мощь искусственного интеллекта в сложных играх с лучшими из людей. Разработанный IBM компьютер Deep Blue обыграл Гарри Каспарова в шахматы еще в 1997 году. Перед матчем Каспаров думал: «Это просто машина. Машины глупые». Но после поражения признавался: «Я чувствовал – чуял, – что за столом был новый тип разума».

Чтобы победить Каспарова, Deep Blue использовал грубую вычислительную силу: после каждого хода программа просчитывала все возможные варианты развития событий и принимала решение на основе этих данных.

Но с го такой подход не работает из-за объема данных, которые нужно обрабатывать. В го игроки по очереди ставят черные и белые камни на доску 19 на 19. Задача игры – занять как можно больше территории, при этом запирая камни противника, не давая ему получить преимущество. В целом го похожа на знакомую многим по школе игру в точки – только сложнее.

Из-за размера доски уже для первого хода, который делают черные камни, возможен 361 вариант (в шахматах – всего 20). Соответственно, с каждым ходом древо потенциальных расстановок только разрастается. После первых двух ходов в шахматах существует 400 возможных развитий событий, в го – 129 960. В блоге Google, разработавшего AlphaGo, писали, что в целом количество возможных комбинаций больше, чем атомов во вселенной. Математик Джон Тромп подсчитал, что это будет 171-значное число.

Поэтому от людей в игре в го требуется не только интеллект и способность к расчетам, но и мощное абстрактное мышление, сильная интуиция – качества, которые слабо развиты у компьютеров. Один из разработчиков AlphaGo Демис Хассабис рассказывал: «Это очень интуитивная игра. Мастера го часто говорят, что сделали тот или иной ход, потому что он казался правильным». По его словам, у мастеров развивается особое эстетическое чувство, и хорошая позиция просто выглядит красиво.

Несмотря на то, что процессоры с каждым годом становятся все мощнее и быстрее, поиск ходов на древе возможностей помог искусственному интеллекту достичь в го только уровня сильного любителя. Компьютеры обыгрывали людей, но только получив фору в несколько камней.

В 2014-м Дэвид Фотланд, один из первопроходцев го для компьютеров, рассказывал, что программы сталкиваются с той же проблемой, что и люди: «Многие игроки достигают определенного любительского пика и не могут стать сильнее. Чтобы преодолеть это плато, нужно сделать какой-то ментальный скачок, и у программ возникают те же проблемы. Нужно смотреть на всю доску, а не только на локальные битвы».

Чтобы преодолеть этот интеллектуальный барьер и симулировать интуицию и эстетическое чувство профессионалов, разработчики AlphaGo подключили нейросети (сети процессоров и софта, симулирующие работу нейронов человеческого мозга) и алгоритмы глубинного обучения.

Сначала в нейросети AlphaGo скормили базу данных человеческих игр, в которую входило примерно 30 миллионов ходов. После этого он научился правильно предсказывать ход человека в 57% случаев, хотя предыдущий рекорд ИИ составлял 44%. Затем разработчики научили AlphaGo играть против самого себя – так компьютер научился еще лучше выделять максимально выгодные ходы и разрабатывать новые стратегии.

Все это помогло рационализировать процессы, на которых работал обыгравший Каспарова Deep Blue. Теперь система не просто разыгрывает все возможные комбинации, а умеет сосредотачиваться на наиболее перспективных вариантах развития событий. Кроме того, она ориентируется даже в ситуациях, с которыми еще никогда не сталкивалась. А такие из-за масштабности го оставались. За счет нового механизма AlphaGo обыграл всех ранее созданных компьютерных игроков (при этом давая им фору в четыре камня) и начал побеждать людей-профессионалов.

В октябре 2015-го AlphaGo разгромил двукратного чемпиона Европы француза Фань Хуэя. Они сыграли пять партий, никто не получал фору, и компьютер выиграл все пять. Это был первый случай, когда машина победила профессионального человека. После матча Хуэй рассказывал, что многому научился, и эти знания помогли ему прибавить и подняться в международном рейтинге.

А в 2016-м AlphaGo играл с Ли Седолем и победил 4:1. Этот матч, который только в Китае смотрели 60 миллионов человек, получился историческим по ряду причин.

Компьютер научился играть творчески, но креативность человека сбила алгоритм

Во-первых, как и Каспаров, Ли оказался не готов к тому, как хорошо играет компьютер. По его собственному признанию, первую партию он проиграл из-за этого.

Во-вторых, во второй партии компьютер продемонстрировал приобретенную креативность. В историю го этот момент вошел, как «Ход 37». Многим комментаторам он показался ошибкой – казалось, что ход машины никак не был связан со всем, что она делала раньше.

Но эксперты оценили. Фань Хуэй, работавший судьей на матче, потом рассказывал: «Это не человеческий ход. Я никогда не видел такой ход в исполнении человека. Так красиво». Обратите внимание на эстетический эпитет.

Ли после матча наоборот утверждал, что это был не компьютерный ход: «Я думал, что меня ждет очень эффективная машина, которая будет из сохраненных данных высчитывать лучший ход для каждой конкретной ситуации. Но некоторые ходы мне показались очень творческими. Они показывали красоту го, которую способны создавать только люди».

Этот ход подчеркнул проделанный искусственным интеллектом путь от простого перебора возможностей к мышлению. AlphaGo заточен на довольно консервативную игру, и если вероятность победы с небольшим преимущество составит 95%, а вероятность разгрома – 80%, компьютер выбирает первый путь.

Но Ход 37 не был консервативным. Разработчики AlphaGo позже посмотрели логи, чтобы понять, почему машина его выполнила. Оказалось, она понимала: вероятность того, что человек так поставит свой камень, составляла 1 к 10 000. Но AlphaGo принял такое решение, потому что посчитал его оптимальным для решения поставленной задачи. А еще потому, что оно поставило Ли в тупик – он на 15 минут отошел от стола и долго думал над ответом.

В целом кореец потом рассказывал, что по ходу второй партии у него никогда не было ощущения, что он ведет игру.

В итоге машина не смогла к этому адаптироваться, допустила несколько ошибок, и за следующие 10 ходов вероятность ее победы, по ее собственным расчетам, упала с 70% до меньше 50% и выше этой отметки уже не поднималась. Комментаторы назвали действия Ли божественными.

Разработчики AlphaGo учли поражение и Ход 78, продолжили работу над алгоритмом и в 2017-м отправили обновленную систему играть с мастерами го онлайн. Результат? 60 побед, ноль поражений и одна ничья, которая случилась, потому что человек отключился от интернета. Своего предшественника модернизированный AlphaGo вынес в 100 партиях из 100, используя при этом куда меньше оборудования и вычислительных мощностей.

До искусственного разума еще далеко, хотя победа в го и прорыв

Не у всех победы компьютера вызывают такую же драматичную реакцию, как у Ли. Многие, наоборот, видят в них возможность для сотрудничества, которое в итоге принесет пользу человеку. Например, один из сильнейших игроков в мире Не Вэйпин, проиграв AlphaGo в интернете, сказал: «Го – не такая простая игра, как нам казалось. Людям еще многое в ней нужно исследовать. И бог го прислал эту машину, чтобы она помогла людям это сделать».

Другой китайский гроссмейстер Кэ Цзе тоже указывал на возможные прорывы: «Я полтора года изучал программы, теорию и применял все это на практике. Люди тысячелетиями развивались в игре, но теперь компьютеры говорят, что люди ничего не понимают. Думаю, вообще никто даже близко не приблизился к пониманию основ го».

Сейчас этот компьютер считается лучшим игроком в го в мире и, возможно, когда-нибудь приблизится к пониманию основ игры. Но у разработчиков другие цели. Команда DeepMind подчеркивает, что их искусственный интеллект не заточен только под го, а в будущем сможет решать совершенно не связанные с игрой задачи.

В целом специалисты указывают, что потенциально искусственный интеллект может привести к прорывам в робототехнике, научных исследованиях (вплоть до лекарства от рака), а в повседневной жизни могут появиться, например, не допускающие ошибок финансовые советники на основе ИИ и доступные всем беспилотные машины. А еще обещают, что нейросети будут писать музыку и книги не хуже людей.

С другой стороны, обещанные прорывы пока не наступают. Люди по-прежнему сами сидят за рулем, а американские политики обвиняют Россию в информационных диверсиях – хотя Марк Цукерберг больше года назад обещал Конгрессу, что искусственный интеллект решит проблему фэйковых новостей.

В целом консенсус такой: искусственный интеллект пока очень далек от того, что было показано в «Терминаторе», а мир все же в разы сложнее игры в го. До создания человекоподобных роботов еще очень далеко, потому что компьютеры сейчас даже не могут вести осознанный разговор и решать многие задачи, которые без проблем даются детям.

Но карьеру Ли Седоля компьютер уже завершил. Правда, не совсем. Кореец все еще консультирует разработчиков AlphaGo, а в декабре сыграет с корейским компьютером HanDol. Но в свою победу Ли не верит: «Даже с форой в два камня мне кажется, что я проиграю. Сейчас я даже не слежу за новостями го».

Читайте также: