Vmware esxi совместимость raid

Обновлено: 03.07.2024

Модели Dell PowerEdge DX150, DX151, DX290, DX291 и DX141 сертифицированы и совместимы со всеми версиями, начиная с 5.0. DX152 и DX292 совместимы, начиная с 6.5.

Все остальные модели не сертифицированы VMware, но в большинстве случаев они могут работать с VMware vSphere / ESXi.

Совместимость

(Вся информация может быть изменена)

ЗАМЕТКИ:

конфигурация сети

- Для связи между несколькими серверами ESXi в одной подсети необходимы маршруты хоста через шлюз из-за ограничений сетевой безопасности.

Единые IP-адреса

- IP-адреса по умолчанию статически сопоставляются с MAC-адресом хоста. Однако можно получить отдельные MAC-адреса для дополнительных одиночных IP-адресов через Robot. Затем их можно настроить для виртуальных машин. Чтобы назначить эти MAC-адреса, войдите в Robot, выберите «Сервер» в меню слева, выберите желаемый сервер и затем щелкните вкладку «IP-адреса». Здесь вы можете щелкнуть значок рядом с отдельным IP-адресом, чтобы получить MAC-адрес.

Подсети

- Чтобы использовать подсеть (IPv4, а также IPv6) в ESXi, требуется как минимум один дополнительный IP-адрес в качестве виртуальной машины маршрутизатора, поскольку сам ESXi не может маршрутизировать. При заказе подсети обязательно обратите внимание на то, что она требуется для ESXi и должна маршрутизироваться на дополнительный одиночный IP-адрес.

ВАЖНО Поскольку подсети IPv6 маршрутизируются на локальные адреса канала (на основе MAC), IPv6 можно использовать только ограниченным образом (т. Е. В одной виртуальной машине).

Письмо с подтверждением подсети содержит (например) следующую информацию:

Вы НЕ получаете отдельный MAC-адрес для каждого IP-адреса из подсети.

Все серверы имеют подсеть IPv6 / 64. Чтобы узнать, какая подсеть IPv6 есть у вашего сервера, проверьте вкладку IP-адресов сервера в Robot .

Если вы заказали сервер до февраля 2013 г., эту подсеть можно заказать (бесплатно) через Robot, и она будет автоматически активирована.

Подсеть IPv6 направляется на локальный адрес канала по умолчанию (полученный из MAC-адреса) основного IP. С помощью робота маршрутизация подсети IPv6 может быть переключена на локальный адрес канала виртуального MAC (другими словами, на дополнительный одиночный IP-адрес). Это можно сделать в Robot , используя тот же символ, который находится рядом с дополнительными одиночными IP-адресами для запроса виртуальных MAC-адресов. Хост-система, как и сам ESXi, не получает адреса IPv6. Это не является ни необходимым, ни возможным, потому что ESXi не может работать со шлюзом fe80 :: 1.

Чтобы использовать эти IP-адреса в виртуальных машинах, необходима виртуальная машина маршрутизатора, дополненная дополнительной виртуальной сетевой картой из новой подсети. Для самой подсети требуется новый vSwitch в ESXi, к которому будут подключены все виртуальные машины в подсети.

Заметки

После обновления до VMware ESXi 5 эта проблема может появиться снова. Вы можете решить эту проблему, отключив большую разгрузку приема (LRO) на хосте ESXi:

- Войдите на хост ESXi с помощью клиента vSphere.

- Выберите хост -> Конфигурация -> Программное обеспечение: Расширенные настройки.

- Выберите Сеть и прокрутите вниз чуть больше половины.

- Установите следующие параметры от 1 до 0:

Перезагрузите хост ESXi, чтобы активировать эти изменения.

Если у вас возникают проблемы с подключением в системах с сетевыми картами Realtek, то при определенных обстоятельствах отключение разгрузки и активация опроса могут решить эту проблему. Однако это также снижает производительность.

- разгрузка контрольной суммы: деактивировано

- разгрузка сегментации: деактивировано

- большая разгрузка приема: деактивировано

- опрос устройства: включен

Подготовка в клиенте vSphere

Обзор сети должен показать следующее:

Конфигурация виртуальной машины маршрутизатора

- Пример /etc/network/interfaces виртуальной машины на маршрутизаторе

- Пример /etc/network/interfaces виртуальной машины Linux в подсети

Виртуальная машина маршрутизатора теперь подключена к обеим сетям и может использоваться в качестве шлюза для виртуальных машин в подсети. Не забудьте активировать IP-переадресацию в ядре:

Чтобы сделать это постоянным при перезагрузках, добавьте следующую строку в /etc/sysctl.conf

Теперь виртуальные машины должны быть доступны (например, через SSH) через назначенные им IP-адреса.

Инструкция по установке

- Выберите Rescue System в качестве ОС для заказанного вами сервера.

- Если вам нужен RAID, вы можете добавить 4-портовый RAID-контроллер, поскольку ESXi не поддерживает программный RAID.

- Как только сервер будет в сети (вы получите электронное письмо от нас, информирующее вас об этом), вы можете заказать консоль KVM и использовать ее для виртуального монтирования ISO-файла той версии ESXi, которую вы хотите установить. Дополнительную информацию о заказе консоли KVM и ее использовании для установки ОС можно найти на странице консоли KVM .

После этого должен отобразиться следующий экран:

- После перезагрузки войдите, используя пароль, который вы ввели во время установки. Это пароль root для SSH, а также пароль для клиента VMware vSphere (требуется Windows). Затем его можно будет загрузить отдельно через браузер.

- После успешной установки вы можете заказать до трех дополнительных одиночных IP-адресов через Robot. Вы можете получить MAC-адрес для своего дополнительного IP- адреса через Robot на вкладке IP-адресов . Вы увидите небольшую кнопку рядом с IP-адресом. Нажатие на эту кнопку даст IP-адресу виртуальный MAC.

- Настройте MAC-адреса виртуальных серверов с соответствующими IP-адресами через vSphere. Как только это будет сделано, даже DHCP будет работать через сеть Hetzner!

Для получения дополнительной информации о ESXi и его использовании посетите официальный сайт.

Ручная установка обновлений

Установку обновлений в бесплатной версии можно произвести только через консоль или через VMware Go. Обновление может занимать несколько сотен мегабайт, что может занять много времени при стандартном DSL-соединении, поэтому следующее руководство может помочь. Вы делаете это на свой страх и риск. Нет никаких гарантий на правильность!

Обязательным условием является доступ с активацией SSH и нахождение системы в режиме обслуживания. Это можно активировать с помощью:

Обновление vSphere 5.0 до 5.1

Прежде всего, VMware-ESXi-5.1.0-799733-depot.zip необходимо загрузить обновление со страницы обновлений VMWare и сохранить на хосте ESXi.

После того, как все виртуальные машины были выключены и система перешла в режим обслуживания vim-cmd hostsvc/maintenance_mode_enter , обновление можно установить двумя способами. Следующая команда обновляет систему и удаляет все пакеты, не включенные в обновление. Это эквивалентно новой установке.

В качестве альтернативы только пакеты, содержащиеся в обновлении, могут быть обновлены до их новых версий, а все остальные пакеты останутся нетронутыми.

Установка патчей

После того, как патчи были перенесены в систему, их можно устанавливать. Важно ввести полное имя пути, например:

После перезагрузки необходимо выйти из режима обслуживания:

Мониторинг RAID-контроллера

Контроллер 3ware

Для контроллера 3ware существует как поставщик CIM, так и интерфейс командной строки. 64-разрядный интерфейс командной строки для Linux можно использовать, начиная с версии 9.5.2.

Примечание. Контроллеры 3ware поддерживаются ESXi 5.0 только через внешний драйвер.

Контроллер Adaptec

Для контроллеров Adaptec поставщик CIM и интерфейс командной строки (arcconf) должны быть установлены вручную. Требуется актуальная версия драйвера. Руководство по установке можно найти на сайте Adaptec (PDF)

Мониторинг может быть достигнут путем установки удаленного ARCCONF через систему Windows / Linux.

$ arcconf GETCONFIG 1 AD

Контроллер LSI

LSI предоставляет так называемого поставщика CIM / SMIS. После установки на странице мониторинга оборудования в клиенте vSphere отображается состояние RAID. Однако активный сигнал тревоги возможен только в платной версии и при запуске vCenter.

В качестве альтернативы можно установить инструмент командной строки MegaCLI , который также используется для управления контроллером RAID. Сценарий может использоваться для автоматизации отображения информации о состоянии. Этот сценарий и уведомления должны запускаться с другого сервера.

Параллельная работа встроенного контроллера / аппаратного RAID

Во время установки ESXi видит только один тип хранилища, то есть либо встроенный контроллер SATA, либо дополнительный контроллер RAID. Если диски подключены к обоим, то приоритет отдается аппаратному контроллеру, а диски, подключенные к встроенному контроллеру, невидимы. Эти диски все еще можно использовать, загружая соответствующий модуль ядра вручную.

Чтобы этот модуль загружался автоматически во время запуска, необходимо добавить строку выше к /etc/rc.local и /sbin/auto-backup.sh .

Замена оборудования

Изменить MAC-адрес

esxcfg-advcfg -s 1 /Net/FollowHardwareMac

Либо выполните эту команду до смены платформы, либо, если изменение уже произошло, есть два варианта:

- Закажите консоль KVM Console и включите оболочку ESXi, затем нажмите, Alt + F1 чтобы переключиться на консоль и введите команду. После нажатия Alt + F2 вы вернетесь в графический интерфейс.

- Временно обучите коммутатор новому MAC-адресу, загрузившись в Rescue System, а затем снова в хост ESXi. В результате хост ESXi теперь снова доступен через основной IP-адрес, но только в течение ограниченного периода времени. Продолжительность этого времени зависит от того, сколько времени потребуется коммутатору для удаления записи кэша ARP для этого MAC-адреса. Обычно достаточно времени для входа в систему через SSH и выполнения команды при условии, что доступ SSH включен. Однако даже это можно настроить, так как подключение через клиент ESXi снова станет возможным.

В любом случае после этого требуется перезагрузка. Это можно запустить через консоль:

После перезапуска MAC-адрес должен быть установлен правильно, и это можно проверить в оболочке ESXi с помощью следующей команды:

Я создаю виртуальную среду для малого бизнеса. Он основан на одном хосте ESXi 5.1, на котором будет размещено около полудюжины виртуальных машин. Однако у меня есть некоторые сомнения относительно того, как реализовать хранилище. Я, естественно, хочу, чтобы хранилище данных было отказоустойчивым, но я не могу получить средства на отдельный накопитель или дорогостоящие аппаратные RAID-решения, поэтому я бы хотел использовать некоторый программный RAID (lvm /mdadm, скорее всего). Как это можно реализовать? Моя единственная идея до сих пор заключалась бы в создании виртуальной машины с адаптером хранения как сквозной, помещает некоторый программный RAID поверх дисков, а затем представляет результирующие тома «назад» на хост ESXi, который затем создает хранилище данных, из которого другие виртуальные машины получить их хранение.

Это вроде бы круто, у меня есть лучшие варианты? Из моих исследований, транзит, похоже, имеет немало недостатков, таких как отсутствие приостановки /возобновления и т. Д.

ESXi не является ОС общего назначения и не должен считаться полностью привязанным к списку совместимости оборудования и, следовательно, использовать проверенный и одобренный аппаратный RAID-адаптер. Выберите, чтобы сделать что-нибудь еще, и вы присоединитесь к другим людям, которые срезали углы и вернулись сюда, жалуясь на то, что их системы не работают или они потеряли данные - мы получаем много из них.

Кажется, это круто, у меня есть лучшие варианты?

Ваша общая идея - спот-он. Я лично предложил бы использовать ZFS с Solaris или FreeBSD, но mdadm также может работать. Может быть, хотя у вас нет всех преимуществ, о которых я пишу в этом посте, так что возьми это как отказ от ответственности. Этот пост будет довольно длинным, я заранее извиняюсь за стену текста.

Из моих исследований, сквозной проход, похоже, имеет немало недостатков, таких как отсутствие приостановки /возобновления и т. д.

Есть некоторые, в частности:

- Работает только с поддержкой vt-d (или AMD IOMMU) на процессоре (Intel) или плате ЦП + (AMD): нет проблем, сегодня без него невозможно получить сервер, так как каждый процессор Intel за исключением того, что Atoms имеют его (даже в базовых системах от HP, Dell и других).

- VMware-снимки всех виртуальных машин с переданными элементами не могут быть созданы: в теории проблема, но это затрагивает только вашу виртуальную машину хранения, которая имеет минимальную настройку конфигурации и не используется ни для чего другого. Вы можете делать снимки на уровне хранилища, где они быстрее, дешевле и не замедляют работу системы. Кроме того, вы можете без проблем сфотографировать все другие виртуальные машины на хосте (и даже объединить их с моментальными снимками файловой системы для мощных параметров восстановления и долговременного архивирования состояний).

- В некоторых областях ваша внутренняя сложность увеличивается. На первый взгляд это правда - вы добавляете дополнительный слой, и вам нужно управлять большим количеством вещей, например, вашей новой внутренней SAN (настройка сети /VLAN в VMware) или самой виртуальной памяти вашего хранилища (обновления и т. д.). Но, с другой стороны, у вас также есть простота и гибкость:

- Согласованные резервные копии запущенных виртуальных машин могут создаваться автоматически с помощью нескольких простых скриптов и полностью бесплатны. Они также могут быть сохранены на другой машине, диске или облаке (зашифрованы), без каких-либо дополнительных дорогостоящих программных решений.

- Если ваш сервер умирает, просто купите новую замену, установите ESXi, включите сквозной проход, настройте свою сеть, добавьте диски и загрузите виртуальную машину хранилища. После того, как он встал, выполните повторное сканирование вашего хранилища, и это похоже на простое сбой питания, все ваши данные безопасны, и вы это знаете (вместо этого с HW RAID вы надеетесь, что это так).

- Особые требования могут быть выполнены с минимальными изменениями по мере необходимости. У бизнеса есть устаревшее приложение, для которого требуются локальные диски для резервного копирования? Просто настройте iSCSI и прозрачно представляйте свое хранилище. Они испытывают рост и нуждаются в большем объеме хранения? Просто увеличьте пул с большим количеством дисков и представите их либо непосредственно через iSCSI, либо через VMware (NFS или iSCSI с vmdk сверху). Они хотят использовать базу данных на гибком отдельном сервере? Просто откройте свою NFS на другой LAN /VLAN и поставьте ее на новый сервер как «реальную» SAN.

- Простой графический процессор работает только для дорогих карт Nvidia и всех карт AMD: В настоящее время это правда, но для виртуальной машины хранения в любом случае не требуется выделенный графический процессор.

Существуют также общие досады, не связанные с прохождением:

- Чтобы перезагрузить виртуальную машину хранения, все остальные виртуальные машины, которые зависят от нее, должны быть сначала отключены: Эта очевидная проблема редко упоминается, но в моих глазах наиболее раздражает. Конечно, обновления для ESXi также требуют полной перезагрузки, но поскольку у вас теперь есть две системы, время может не синхронизироваться отлично. Я рекомендую стабильную операционную систему и выравнивание некритических обновлений между обеими системами. Кроме того, вы должны ограничить VM хранилища своей собственной внутренней виртуальной локальной сетью, что еще больше уменьшит необходимость применения исправлений сразу после их выпуска. Обратите внимание, что это также относится к случайным перезагрузкам виртуальной машины хранения из графического интерфейса пользователя.

- Ошибки в базовом стеке делают вашу машину неработоспособной: Этот риск увеличивается по сравнению с ESXi, потому что теперь у вас есть две системы и два сетевых стека между ними. С яркой стороны как ваша виртуальная память, так иESXi обычно должен быть стабильным, а ошибок должно быть немного. Тем не менее, я советую запланировать обновления несколько дней /недель после выпуска, чтобы вы могли увидеть, есть ли у других проблемы. Не меняя конфигурацию, с другой стороны, это очень стабильно, что является плюсом для SME (требуется меньше поддержки).

- Решение не известно стороннему персоналу службы поддержки: Это довольно редкая настройка, поэтому вероятность того, что ваша случайная замена может понять ее без вашей документации с самого начала, - это может быть проблема или преимущество, в зависимости от ваших бизнес-целей. Это можно смягчить с помощью некоторой базовой документации, объясняющей структуру установки (используйте рисунки /диаграммы!), Сравнение с традиционной настройкой RAID и что делать в общих случаях (резервное копирование, восстановление, замена диска, обновления, сетевые изменения, аппаратное расширение).

Технические проблемы в стороне, вы должны думать о своих целях и способах их достижения. Это определяет практичность выбранного вами решения, а также его недостатки и недостатки, а также общий результат (успех или неудачу). Это то, что во многом зависит от потребностей самого бизнеса. Некоторые соображения относительно или против предлагаемого решения с точки зрения бизнеса:

В любом случае вы должны учитывать эти моменты. Ваше решение может быть успешным только в том случае, если вы достигнете поставленных целей, неважно, каков выбор большинства, только то, что технически возможно реализовать, b) в рамках бюджета, c) достижение целей бизнеса. Если все эти точки выполнены, и вам еще нужно решить, выберите более простое /менее сложное решение (KISS). Если они одинаково легки, решайте за то, что приносит вам больше денег и /или счастья.

Я бы уволил тебя, если бы я был маленьким бизнесом, и ты развернул что-то вроде этого . Это обычная тема. VMware имеет четко определенный список совместимости оборудования . Однако при использовании в качестве автономного сервера вы используете аппаратный RAID NEED . Не-RAID-диски будут работать, но это не то, что вы хотите. Итак, мои вопросы:

- Недостаточно средств для хранения? Что это за серверное оборудование? Вы можете позволить себе диски, но не RAID-контроллер? Совместимый RAID-контроллер не стоит дорого.

- Разве это не случай управления ожиданиями клиентов? Очевидно, что отдельное хранилище будет более дорогостоящим, чем аппаратный RAID.

- Пока решения для хранения «все-в-одном» , они лучше подходят для конкретных технических требований, а не для сокращения затрат.

Это случай злоупотребления VMware. Программный RAID не поддерживается. Я бы вернулся к клиенту и пересмотрел сборку /требования.

«Сколько стоят ваши данные?»

Это означает, что предупреждения об использовании стандартного оборудования действительны. ESXi довольно придирчив.

«Я, естественно, хочу, чтобы хранилище данных было отказоустойчивым, но я не могу получить средства для отдельной накопительной машины или дорогостоящий аппаратный RAID решений, поэтому я хотел бы использовать некоторый программный RAID (lvm /mdadm, most скорее всего). Как это можно реализовать?

esxi не будет работать без RAID-массива REAL HW для хранилища данных . Не будет работать даже программный рейд на базе BIOS.

Получил мой контроллер рейда Adaptec 6405e за 100 $ на Ebay!

НО в отношении следующей части

Моя единственная идея до сих пор заключалась в том, чтобы создайте виртуальную машину с адаптером хранения как сквозную, добавьте некоторые программный RAID поверх дисков, а затем представляет тома «назад» на хост ESXi, который затем создает хранилище данных из которые другие виртуальные машины получают в своем хранилище ».

Мой «FileServer» состоит из 4x5TB HD передается непосредственно на VM . Затем я построил mdadm Raid 5 в общей сложности около 14 ТБ и экспортировал его по NFS ко всем моим виртуальным машинам. Около 15/20 в любое время, с 10/20 dev VM, которые отключены, если не используются. Это хорошо сработало для меня, но это не с большой группой пользователей. Infact Я действительно единственный локальный пользователь, но у меня есть веб-сайты, которые генерируют некоторый трафик, но опять же, они статичны в основном.

Хороший вопрос, который нужно задать в этом сценарии, если вы подумываете об использовании этой идеи, для чего нужен FileServer?

В моем случае 90% моих виртуальных машин, если не все, размещают все необходимые данные внутри виртуальной машины (linux) и имеют размер менее 20 ГБ. Я использую FileServer в качестве центрального репо для резервных копий, также любые мультимедийные приложения, такие как Plex, будут считывать с FileServer, а мой P2P сохраняет непосредственно на FileServer, но не на моих хостах есть база данных или все, что находится на FileServer. Тем не менее, они делают все свои резервные копии на FileServer. Мой файловый сервер - это моя единственная виртуальная машина, на которой размещаются 2 службы, и это NFS для виртуальных машин, а также SMB для доступа к Windows через графический интерфейс. Это чудесно сработало для меня. Я также установил FileServer через NFS в качестве хранилища данных, и я смогу подключить ISO к новым виртуальным машинам из хранилища данных. Я также резервирую OVA snapshopts поверх SMB в окнах непосредственно на FileServer. Запуск виртуальных машин на экспортированном программном рейде NFS будет сумасшедшим, но экспорт большого хранилища данных NFS обратно на хост esXi имеет много преимуществ.

Я большой поклонник программных RAID (Linux), потому что они гибкие, экономичные, простые в управлении и полностью предсказуемые. В реальных сценариях они всегда выигрывают аппаратные RAID-контроллеры среднего класса для скорости. Единственная проблема - получить надежный RDM или контроллер диска через VM, который запускает NAS. Большинство недорогих контроллеров LSI в режиме ИТ делают трюк. Я получаю потрясающую скорость и стабильность с помощью программного обеспечения RAID10 на виртуальном NAS на базе Openmediavault (адаптер Vmxnet3, Paravirtual disk controller), который экспортирует хранилище данных для других виртуальных машин на том же хосте через NFS (внутренняя ссылка 10 Гбит).

Это только вопрос бюджета. Если ваш бюджет неограничен - переходите к RAID-адаптерам верхнего уровня из белого списка. Если вы хотите сэкономить деньги, и вы знакомы с ESXi и внутренними сетями NAS - идите с программными рейдами.

Другим преимуществом такой установки будет то, что mdadm хорошо документирован, легко восстановить соединение с другим сервером в случае сбоя сервера.

Однако вы должны учитывать, что обычная настройка ESXi не ожидает, что хранилище данных будет на одном сервере с ESXi. В вашем случае, если жесткий диск с ESXi и /или «виртуальной машиной, у которой адаптер для хранения данных в виде сквозной прогонки» терпит неудачу (и, конечно, не в RAID), ваш хранилище данных больше не будет доступно. Если вы разделили хранилище данных, вам понадобится меньше шагов для восстановления настроек в случае сбоя. Поэтому я считаю, что вам следует попробовать снова найти средства для отдельного компьютера хранилища данных. Это может быть используемый ПК с процессором 1-2 ГГц и контроллером SATA, где вы можете настроить ОС Linux с помощью mdadm.

P.S. Не забудьте настроить мониторинг (например, уведомления по электронной почте) о состоянии вашего RAID-массива mdadm.

Поддержка программного RAID-массива существует в ESXi для динамического интеллектуального контроллера массива HPE. Я использую его на DL20 g9 с зеркальными SSD-накопителями Enterprise, и он отлично работает.

Тем не менее, я просто взял Smart Array 440 от eBay за 200 долларов США, что является аппаратным RAID без каких-либо причин, кроме тех случаев, когда этот выбор предоставляется, всегда идите на оборудование.

Мне понравился ESXi, когда я впервые его использовал, мне все еще нравится, но больше не люблю его, и тестирует proxmox в качестве альтернативы.

Что я узнаю, так это то, что VMWARE, конечно же, хотят зарабатывать деньги, и они, вероятно, согласятся с поставщиками аппаратного обеспечения, чтобы поддерживать только аппаратное обеспечение класса high-end, что повышает их продажи в обмен на откаты от этих поставщиков, я знаю, что другое правдоподобное объяснение для управления их накладными расходами на поддержку, но я думаю, что это больше связано с «поощрением» людей к аппаратным средствам на сервере.

Я использовал программный рейд в различных ситуациях, и считаю его таким же надежным, если не более надежным, чем аппаратный рейд, я думаю, что единственным надежным аппаратным рейдом является резервное копирование батареи, что позволяет записывать записи на сбои питания .

Однако мои домашние системы подключены к устройствам ИБП, а мои бизнес-системы в центрах обработки данных имеют ИБП, поставляемый центром обработки данных. Я считаю, что такие вещи, как программный zfs-рейд, намного безопаснее, чем что-то вроде HP smartarray, а также защита от битов, а также прямой доступ к состоянию SMART на диске.

Сказав, что это не означает, что я никогда не использую аппаратный рейд, если клиент напрямую его запрашивает или у них есть красивый бюджет, который будет платить за него, тогда я его развожу, но у меня нет отношения, если, если у меня есть плохой клиент, я начинаю рассказывать им, что им нужно переосмыслить, потому что ничего, кроме аппаратного рейда, является самоубийством, это просто глупо.

Я вижу все негативные комментарии, и я понимаю, что эти люди не знают, как работает VSAN. пожара кого-то , только потому, что они используют технологию, которую VMware поддерживает в своем собственном продукте? Честно говоря, это говорит о недостатке менеджера в поиске и принятии советов или о постоянном обучении.

Прочитайте проект старого SAN (PMS), в котором два хоста с пересылкой на дисковых устройствах Glusterfs тома и обслуживают результирующее хранилище блоков через iSCSi обратно в тот же кластер. Это был гений.

VMware vSphere – широко используемая популярная платформа виртуализации, и сегодня темой нашего разговора станет инсталляция и разворот ее последней актуальной – 7.0 версии.

Требования

Для начала, огласим ряд минимальных требований к аппаратному оборудованию для успешной установки VMware vSphere 7.0.

Требования для ESXi 7.0:

CPU. Двухъядерный x86_64 CPU на компьютере, на котором будет работать ESXi хост. Функции Intel-VT-x или AMD-v (RVI) следует включить в UEFI/BIOS.

RAM. Для запуска ESXi понадобится не менее 4 ГБ RAM, а для запуска виртуальных машин на хосте – от 8 ГБ и выше. Больше памяти – большее количество ВМ будет бегать.

Хранилище. ESXi 7.0 требует не менее 8 ГБ дискового пространства для установки и загрузки. Устанавливать можно на отдельный SSD/HDD, RAID и даже держать на SD-карте или флешке.

Важно! В случае SD-карты или флешки не предусмотрено постоянного или временного раздела для хранения журналов.

На загрузочном девайсе рекомендуется выделить более 32ГБ под ESXi, и он не должен совместно использоваться с прочими хостами ESXi. Оптимальными для хранения виртуальных машин являются SCSI (SAS) диски.

Сеть. Понадобится минимум один сетевой контроллер Gigabit Ethernet. Должна быть совместимость сетевого адаптера с ESXi 7.0. Хорошо иметь несколько сетевых адаптеров на сервере ESXi – тогда можно пользоваться утилитой агрегирования каналов NIC Teaming (настраивается отдельно). Это полезно, если есть нужда в функциях кластеризации. Для всех компонентов vSphere (хостов ESXi, серверов vCenter и т.п.) рекомендовано применять статическую IP-конфигурацию.

Естественно, если в vSphere планируется развернуть дополнительные компоненты, например, Kubernetes или NSX, минимальные требования растут. Перед расчетом спецификации оборудования под инсталляцию ESXi обязательно проверьте его совместимость в VMware Compatibility Guide.

Важно! Для полноценной поддержки оборудования серверов Hewlett Packard , DELL и других рекомендуются специальные установочные образы. Например, для HP и DELL:

VMware_ESXi_7.0.0_15843807_HPE_700.0.0.10.5.0.108_April2020.iso

VMware-VMvisor-Installer-7.0.0-15843807.x86_64-DellEMC_Customized-A00.iso.

Требования для vCenter 7:

Для централизованного управления хостами ESXi традиционно используется vCenter Server. Его можно развернуть исключительно как работающую на хосте ESXi виртуальную машину (VCSA). Контроллер сервиса платформы (PSC) интегрирован в саму VCSA.

Важно! В vSphere 7.0 нельзя инсталлировать PSC отдельно или поставить vCenter на машину под управлением Windows – отличие от версии 6.7.

CPU. Минимально (среда до 10 хостов и до сотни ВМ) потребуется два виртуальных процессора.

RAM. 12 ГБ ОЗУ необходимо для обслуживания максимум 10 хостов и 100 виртуальных машин.

Рост количества машин и хостов эквивалентен росту параметров CPU и RAM. Кроме того, обратите внимание, с этим увеличением следует выбирать и соответствующий режим установки (Tiny, Small, Medium, Large, X-Large).

Хранилище. vCenter Server Appliance 7.0 нуждается в 415-3665 ГБ, исходя из количества виртуальных машин. В реальности используется меньше, так как часть зарезервирована под обновления Lifecicle Manager. Часто используется тонкий диск.

Схема развертывания

Для примера возьмем инсталляцию двух серверов ESXi и разворот vCenter Server Appliance на первом из них. Второй отдадим под запуск других виртуальных машин. Назначим:

Далее рассмотрим подключение ESXi-хостов и виртуальных машин к одной сети, но при желании можно создавать отдельные сети для каждой ВМ или их группы. Последнее особенно актуально, когда разворачивается очень большое количество машин, и тогда с помощью VLAN можно заизолировать их друг от друга на втором уровне модели OSI.

Важно! VLAN должен поддерживаться имеющимся маршрутизатором для внешних соединений.

Если используется кластеризация, следует настроить отдельные сети для vMotion и SAN.

Развертывание хостов ESXi. Инсталляция ESXi на серверах

ESXi представляет собой гипервизор первого типа (инструмент запуска виртуальных машин на физическом оборудовании при помощи аппаратной эмуляции). Перед его установкой следует подготовить компьютеры/серверы, проверив соответствие указанным выше требованиям, обеспечив доступ в сеть и назначив всю адресацию.

Инсталляция первого хоста ESXi

Для установки первого хоста ESXi (192.168.11.30) загружаемся с подготовленного носителя, на котором уже записан VMware-VMvisor-Installer-7.0.0-15843807.x86_64.iso. Жмем Enter после приветствия и подтверждаем лицензионное соглашение в следующем окне:

Вводим пароль root и подтверждаем желание инициировать процесс установки, нажав F11:

Базовая конфигурация ESXi-хоста

Первое, что мы увидим при запуске новоустановленного ESXi-хоста, будет его прямая консоль DCUI с версией гипервизора, номером сборки, данными по CPU, памяти и IP-адресации, кроме того там содержится ссылка на браузерное управление ESXi-хостом:

Для настройки системы жмем F2.

Удовлетворяем запрос на аутентификацию (пароль root, который использовался в процессе установки):

Для продолжения жмем Enter.

После этого перед нами появится меню настройки системы. Правая часть интерфейса содержит IP-адрес, назначенный через DHCP. Давайте поменяем настройки сети и присвоим статический IP этому ESXi-хосту, выбрав «Configure Management Network»:

В появившемся окне выбираем «IPv4 Configuration» и подтверждаем решение:

Далее выбираем «Set static IPv4 address and network configuration» и жмем пробел, после чего заходим в следующие настройки IPv4:

Pv4 Address: 192.168.11.30

Subnet Mask: 255.255.255.0

Default Gateway: 192.168.11.2

Чтобы сохранить настройки жмем Enter. Если этот сетевой протокол не используется, можно отключить IPv6.

Затем переходим в DNS Configuration. Выбираем «Use the following DNS server address and hostname» и нажимаем пробел. У нас используется такая конфигурация DNS:

Primary DNS Server: 192.168.11.2

Alternative DNS Server: 192.168.11.1

Для сохранения настроек жмем Enter.

После нажатия Escape выходим из меню «Configure Management Network». Чтобы применить все прописанные изменения, жмем Y (перезапустится демон сети). Перезагрузка потребуется, если мы выключили/включили IPv6:

Теперь переходим к «Troubleshooting options» в меню «System Customization»:

Здесь включаем при необходимости ESXi Shell и SSH-доступ к нашему ESXi-хосту путем выбора соответствующих строк и жмем Enter:

Создание хранилища данных

Для хранения файлов виртуальных машин можно создать специальное хранилище данных. Для этого подключаем диск (или несколько) к серверу ESXi.

Важно! Для производственных сред рекомендуется использовать RAID 1 или RAID 10. Это поможет создать достаточный запас места и снизить вероятность потерять данные при повреждении диска. Но, применение RAID не является заменой организации резервного копирования.

Теперь будем использовать VMware Host Client для управления ESXi-хостом. Если выберем пункт «Host» в навигации, сможем просмотреть всю информацию о нем (версия, имя, CPU, память и состояние хранилища):

Перейдем непосредственно к созданию стораджа. В навигации в разделе «Virtual Machines» выбираем «Storage» и кликаем на кнопку «New datastore»:

Здесь проходим следующие шаги:

- Выбираем параметры разбивки. Пока пусть будет все по умолчанию (полный диск);

- Для завершения создания нового хранилища данных нажимаем кнопку «Finish» в пункте «Ready to complete», после чего появится предупреждение: «The entire contents of this disk are about to be erased and replaced with the specified configuration, are you sure?».

- Подтверждаем. После этого новый сторадж появится в списке хранилищ на соответствующей вкладке.

Проделав все эти операции, мы полностью подготовили наш первый хост ESXi (192.168.11.30) к созданию виртуальных машин.

Развертывание других ESXi-хостов

По аналогии с предыдущим разворачиваем второй хост ESXi (192.168.11.27), который планируем применять для запуска виртуальных машин.

Развертывание vCenter Server

Мастер-установщик vCenter Server проходит два этапа.

Stage 1

Introduction. Здесь нам подробно показывают, как будет устанавливаться наш vCenter. Кнопочкой «Next» проходим до конца:

End user license agreement. Здесь лицензионное соглашение, которое следует принять.

vCenter Server deployment target. На этом этапе следует указать параметры первого хоста ESXi, где будет развернут в итоге vCenter:

ESXi host or vCenter Server name: 192.168.11.30

Set up vCenter Server VM. Здесь вводится имя vCenter VM и устанавливается пароль администратора для vCenter Server Appliance:

Select datastore. В этом разделе выбирается место хранения этого vCenter Server, достаточное для развертывания виртуальной машины. У нас он уже готов – это «datastore100». Включаем режим тонкого диска («Enable Thin Disk Mode»):

Configure network settings. Сетевые настройки в нашем случае будут следующими:

Network: VM Network

IP version: IPv4

IP assignment: static

IP address: 192.168.11.31

Subnet mask of prefix length: 255.255.255.0

Default gateway: 192.168.11.2

DNS servers: 192.168.11.2

Ready to complete stage 1. Проверяем все настройки и соглашаемся с завершением первого этапа установки:

Какое-то время на экране будет прогресс-бар разворота vCenter 7.0.

Stage 2

Introduction. Нам аналогично сообщают, что будет происходить на данном этапе. Чтобы продолжить, нажимаем «Next».

vCenter Server configuration. Выбираем настройки синхронизации времени и включаем доступ к SSH:

Time synchronization mode: Synchronize with the ESXi host

SSH access: Enabled

SSO configuration. Выбираем опцию «Create a new SSO domain»:

Single Sign-On domain name: vsphere.local

Single Sign-On user name: administrator

Single Sign-On password: Enter a password and confirm the password

Configure CEIP. Убираем галочку, если не хотим отправлять статистику в VMware и идем далее:

Ready to complete. Проверяем все, что задали, и жмем «Finish».

Важно! Ни в коем случае не прерывайте процесс установки vCenter. Иначе придется все начинать сначала.

Снова видим прогресс-бар установки. По завершению автоматически запустится vCenter Server Appliance. Если этого не случилось, нужно подключиться к хосту ESXi с VCSA и запустить в VMware Host Client виртуальную машину вручную:

К vCenter VM можно подключиться через консоль VCSA напрямую. Для этого в клиенте щелкаем на предварительный просмотр ВМ, после чего перейдем в автономное приложение VMware Remote Console или же в VMware Workstation, чтобы открыть управление клавиатурой и мышью. Здесь будут отображены все данные vCenter: версия, конфигурация ЦП, памяти, IP-адрес, а также ссылки для управления VCSA. Нажимаем F2 и вводим назначенные в процессе установки vCenter данные – точно так же, как редактировались настройки для ESXi:

Перейдем в раздел «Administration» и в «Edit» поменяем срок действия пароля. Можно отключить эту функцию вообще, чтобы не отслеживать его истекание в дальнейшем.

Настройка среды vSphere 7.0

После создания и конфигурирования ESXi, инсталляции и настройки vCenter, можно приступать к созданию виртуальных машин и применению разнообразных функций vSphere.

Важно! Веб-клиент на Flash для этой версии vSphere является устаревшим – доступен только HTML5 vSphere Client.

Создание дата-центра

Дата-центр представляет собой логический контейнер, используемый для организации ESXi-хостов, кластеров и виртуальных машин. Правой кнопкой мыши кликаем на vCenter server (у нас 192.168.11.31) и выбираем в открывшемся меню «New Datacenter»:

В появившемся окне вбиваем его имя.

Добавление хостов ESXi

Теперь, когда у нас есть новый дата-центр, необходимо добавить в него ESXi-хосты. Кликаем правой кнопкой мыши на его имя и в открывшемся меню выбираем «Add Host»:

Откроется окошко мастера добавления хоста, где, двигаясь по пунктам меню при помощи кнопки «Next», мы обозначим все его параметры:

Name and location. Задание имени/IP-адреса хоста ESXi (192.168.11.30 у нас):

Connection settings. Вводим имя пользователя и пароль.

Host summary. Проверяем сводку по хосту.

Assign license. Вводим серийный номер vSphere 7.0. Либо же останется режим Evaluation:

Lockdown mode. Рекомендуется выключать этот режим для сохранения возможности подключаться к ESXi-хосту напрямую, в обход vCenter. То есть даже если машина vCenter не работает:

VM location. Здесь надо выбрать дата-центр для размещения ВМ (в нашем случае Datacenter1):

Ready to complete. Проверяем все выбранные нами параметры хоста и, если все хорошо, жмем «Finish».

Итак, один хост нам удалось добавить в окружение vCenter. У нас, к примеру, vCenter VM работает на 192.168.11.30. Аналогичным образом добавляем и второй хост ESXi (192.168.11.27):

В развороте большого количества машин очень полезны рекомендованные вендором шаблоны, а также VMware vApps для апробированных конфигураций. Но, это уже тема для отдельного подробного разговора.

Intel VROC — программный чипсетный RAID для накопителей NVMe и SATA. Ранее программный RAID для SATA называется RSTe (Intel Rapid Storage Technology Enterprise), в прошлом году обе технологии решено было объединить под общим названием 5 . В этой статье речь пойдёт именно о массивах из накопителей NVMe на платформе Intel Purley (чипсеты Intel C62x и процессоры Intel Xeon Scalable).

Для начала стоит разобраться с терминологией:

Домен VMD и контроллер VMD. VMD расшифровывается как Volume Management Device, «устройство управления томами». Контроллер PCIe, встроенный в процессоры Intel Xeon Scalable, разделён на три домена по 16 линий PCIe — итого 48 линий.

Наличие VMD не является обязательным условием для работы VROC. Если у вас есть сервер на базе одной из предыдущих платформ без VMD (например, Grantley, Mehlow, Tatlow), то использовать VROC для NVMe накопителей можно, причём без покупки каких либо дополнительных ключей. Не будет поддержки загрузочных массивов, горячего подключения/отключения и управления индикацией. Поддерживаются только накопители производства Intel 5 .

VROC write hole. RAID-5 и RAID-6 в традиционной реализации 1 подвержены проблеме так называемого write hole. При записи неполного страйпа в такие массивы необходимы дополнительные дисковые операции, с пересчётом и записью новых страйпов с контрольными суммами. Сбой накопителей или аварийное отключение питания в этот момент может привести к нарушению целостности данных, если не будет обновлён страйп с контрольной суммой или один из страйпов с данными.

Одним из решений этой проблемы является предварительная запись в энергонезависимую память. Но в случае программных RAID без дополнительного оборудования остаётся полагаться на другие способы. Intel упоминает о том, что в прежних релизах VROC использовалось журналирование страйпов с данными и чётностью, но в последних релизах используется другой алгоритм, суть которого не раскрывается:

The previous Intel VROC mechanisms implemented to address the RAID Write Hole condition encompassed a combination of Dirty Stripe Journaling and Partial Parity Logging. This implementation only partially closed the RAID Write Hole. With the Intel VROC VC product family, the RWH solution included will completely close this condition (when RWH is enabled). When RWH is disabled, the old implementation (using Dirty Stripe Journaling and Partial Parity Logging) is used.

Поддержка VROC операционными системами

Отдельные документы Intel по настройке VROC в Windows и Linux находятся здесь.

Помимо VROC GUI и CLI в Windows, а также mdadm в Linux для управления VROC у Intel есть Accelerated Storage Manager (ASM) — web-интерфейс и RESTful API с очень подробной документацией.

Windows

VROC прозрачен для Intel SSD Datacenter Tool, утилиты для просмотра статуса и обновления прошивок накопителей Intel. У накопителей меняется лишь Device Path:

Для Windows понадобится свежий драйвер вместе с утилитой управления — их можно скачать с Intel Download Center. Для владельцев SSD производства Intel мы советуем заодно скачать свежую версию Intel SSD Datacenter Tool, чтобы обновить прошивку.

Установка драйвера и GUI ничем не отличается от привычного RSTe. Обратите внимание, что все массивы, кроме RAID-0 требуют инициализации. Запустить её можно, выбрав соответствующий пункт в свойствах тома.

Под Windows можно воспользоваться триальным периодом продолжительностью 90 дней. Для этого нужно просто установить VROC GUI и создать массив. Функционал будет соответствовать Premium-ключу. Управление томами будет доступно только через GUI, в интерфейсе EFI HII вы их не увидите. Это означает, во-первых, что в триальном режиме с VROC-томов нельзя будет загрузиться, во-вторых — не стоит размещать на таких томах критичные данные, так как можно пропустить окончание триального периода и потерять доступ к томам.

Linux

- Возможность создавать массивы можно из UEFI HII и UEFI shell, то есть без участия операционной системы. Это не столь важный функционал, так как для автоматизации развёртывания можно использовать скрипты в live-образе Linux.

- Управление через AST. Это действительно удобно.

- Загрузочные массивы. На самом деле, Linux можно заставить грузиться с обычного программного массива любого уровня, но это требует дополнительных действий (например, при установке на RAID-5 или 6 раздел boot обычно помещают на отдельное зеркало на той же дисковой группе). С VROC благодаря поддержке в BIOS процесс установки ОС на RAID осуществляется гораздо проще.

- Поддержка. Intel уделаяет большое внимание тестированию различных серверных накопителей на платформе Purley и даже обещает предоставлять патчи в случае появления каких-либо проблем у конкретного пользователя (при использовании поддерживаемых накопителей и поддерживаемых дистрибутивов).

Рекомендуется использовать ядро версии 4.15 и новее 3 .

В целом работа VROC в Linux ничем не отличается от обычного mdraid с форматом метаданных imsm (в честь Intel Matrix Storage Manager), обеспечивающий совместимость массивов с Windows в связке с RSTe/VROC. Для управления используется тот же mdadm, для мониторинга — mdmon. Есть лишь несколько специфических команд. Например, mdadm --detail-platform позволяет узнать подробности о VROC: версия, поддерживаемые размеры страйпов, максимальное количество дисков и томов.

За работу светодиодов отвечает пакет ledmon, поставляемый Intel.

Драйвер для ESXi

Мы упоминали о том, что VROC не поддерживается в ESXi. Тем не менее, на сайте Intel присутствует документ под названием Intel VMD-enabled NVMe Driver for VMware ESXi User Guide. Действительно, RAID-массивы через VROC в ESXi не поддерживаются (ESXi вообще не поддерживает программный RAID), но VMD в платформах для Intel Xeon Scalable можно и нужно задействовать для корректной работы индикации и горячей замены NVMe-накопителей, для чего требуется специальный драйвер, установка которого описана в этом документе.

Ограничения

Intel периодически обновляет документ под названием Supported Configuration Guide («Руководство по поддерживаемым конфигурациям»). Последняя версия на момент публикации этой статьи — 6.2. Заглянем внутрь.

Поддерживаемые накопители

В начале документа вы найдёте таблицу с поддерживаемыми моделями SSD, как Intel, так и других производителей, с некоторыми интересными примечаниями. Обратите внимание, что для «составных» моделей SSD Intel, которые фактически представляют собой два накопителя на одной плате (P3608, P4608, P4618) поддерживается только RAID-0. Как и в случае со списками совместимости для SAS-контроллеров — если вашего накопителя нет в списке, то это не обязательно означает, что он не будет работать в составе VROC. Просто эту модель ещё не тестировали в Intel. Стоит ли идти на риск, зависит от конкретного проекта. Если речь идёт о хранении временных файлов на рабочей станции в RAID-0, то есть стабильность работы и целостность данных стоят на втором месте, то установку официально не поддерживаемых накопителей можно считать оправданной.

Поддерживаемые ОС

Из Linux официально поддерживаются последние RHEL и SLES. Но мы уже упоминали о том, что поддержка VROC в Linux реализована в рамках mdraid, так что VROC должен работать на любых современных дистрибутивах. Для Windows указаны все актуальные серверные версии (2012R2 и новее) и Windows 10. Поддержка Windows 7 закончилась с версией VROC 5.6.

Поддерживаемые аппаратные конфигурации

- 4 SSD с прямым подключением на каждый VMD-домен (см. выше определение домена VMD) или 24 SSD на VMD-контроллер при подключении через PCIe-коммутаторы.

- Максимум 48 SSD на платформу.

- Поддерживается каскадное подключение коммутаторов PCIe — максимум 2 уровня.

- Максимум два RAID-тома на массив.

- Том может находится на SSD, подключенных к разным доменам VMD и процессорам.

- Официально не поддерживается загрузка с томов из SSD, подключенных к разным контроллерам VMD.

- RAID-0 и RAID-5: до 24 SSD

- RAID-10: 4 SSD

- RAID-1: 2 SSD

Горячее подключение поддерживается, но Intel рекомендует вставлять накопители по одному, дожидаясь инициализации перед добавлением следующего накопителя 2 .

Производительность

- Windows: 1 млн. IOPS. В своей документации Intel сообщает о причинах этого ограничения и даёт рекомендации по тюнингу параметров драйвера 6, 7 .

- Linux: 2,5 млн. IOPS. Производительность существенно лучше масштабируется в сравнении с Windows. Особенное это заметно при использовании высокопроизводительных накопителей Intel Optane 8 .

Стоит напомнить, что при том уровне производительности, который обеспечивают современные твердотельные накопители, следует учитывать нагрузку на процессор и топологию подключения накопителей. То есть, под систему с несколькими накопителями NVMe стоит выбирать процессоры из расчета не менее 8 ядер с частотой от 2,2 ГГц на каждый 1 млн. IOPS. При тестировании или настройке реальных приложений необходимо учитывать топологию соответствия слотов PCIe и процессоров — обращение к накопителю через контроллер PCIe другого процессора приводит к существенному росту задержек 9 .

VROC на платах Supermicro

Как использовать VROC на материнских платах Supermicro? Для начала необходимо убедиться, что полноценный VROC поддерживается материнской платой. Если это платформа Purley, то есть 1- или 2-процессорная плата под процессоры Intel Xeon Scalable с чипсетом C62x. Бывают и исключения. Например, плата Supermicro X11SRA на базе C422. VROC поддерживается и тоже требует установки ключа, но только для накопителей M.2, а из массивов — RAID-0 и RAID-1. Если у вас есть плата без VMD, то VROC без возможности загрузки и с некоторыми другими ограничениями всё равно можно будет использовать — см. VROC non-VMD NVMe RAID.

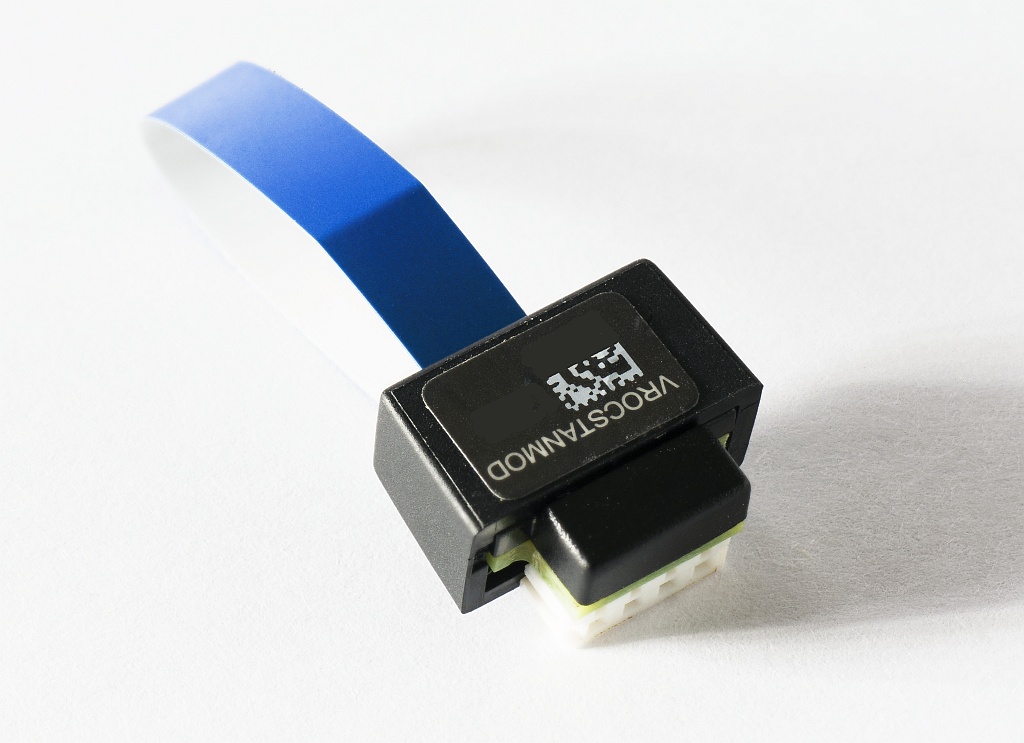

Затем необходимо приобрести один из трёх аппаратных ключей 4 :

- AOC-VROCINTMOD. Ключ для использования исключительно с накопителями производства Intel. Стоит дешевле остальных.

- AOC-VROCSTNMOD. Ключ VROC Standard. Обеспечивает RAID 0/1/10 для любых накопителей (настоятельно рекомендуем следовать списку совместимости).

- AOC-VROCPREMOD. Ключ VROC Premium. То же, что Standard, с добавлением RAID-5.

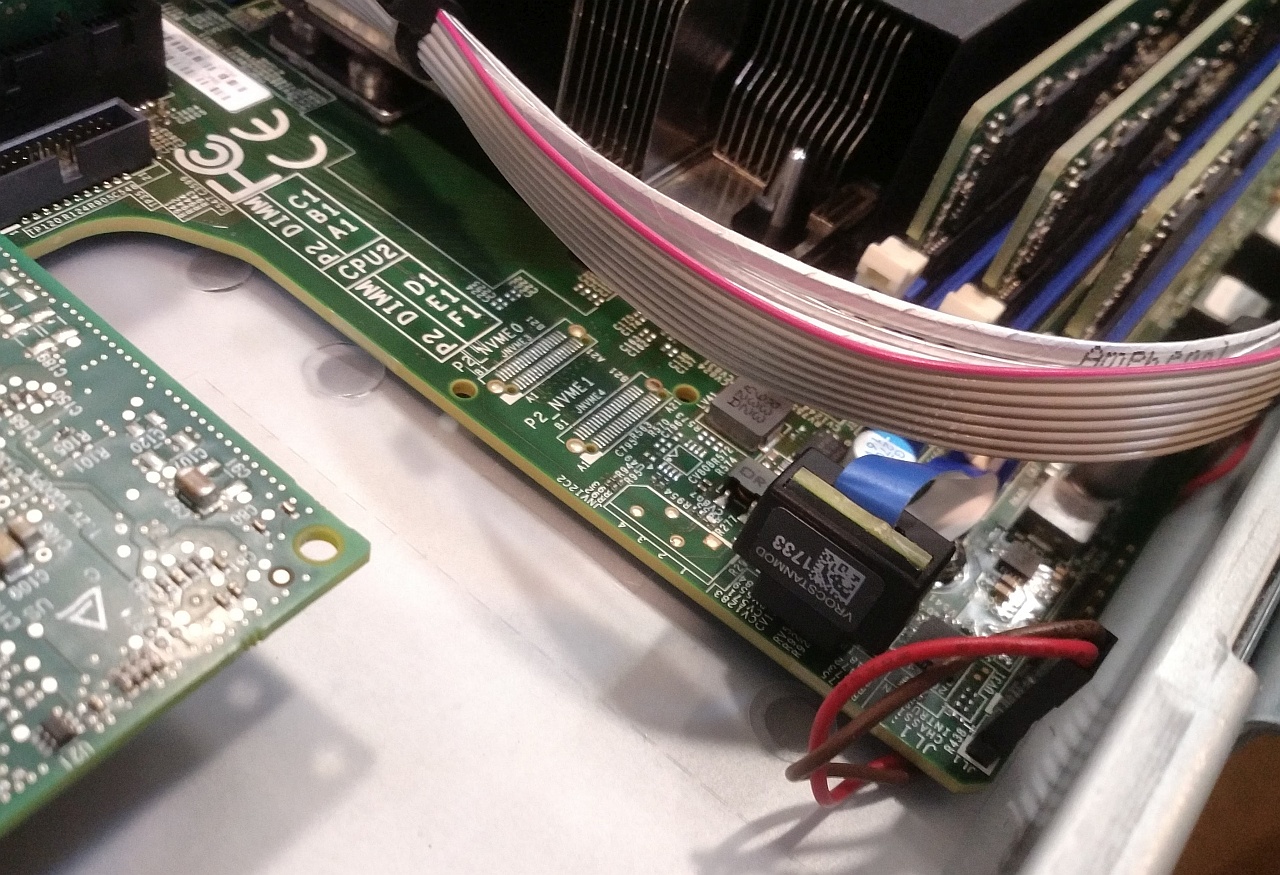

Устанавливается этот ключ в небольшой белый 4-контактный разъём на материнской плате. На всех поддерживающих VROC платах Supermicro этот разъём имеет маркировку JRK1. Например, на плате X11DDW-L он расположен в левом углу, рядом с угловым вырезом:

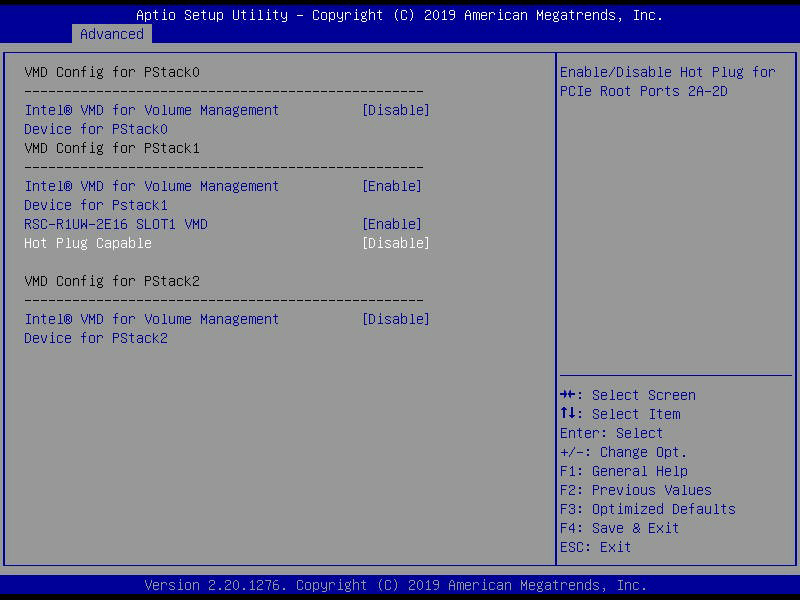

Далее необходимо включить VMD для нужных слотов. Загляните в инструкцию к плате — там приведена схема с топологией подключения слотов. Затем в BIOS, в разделе Advanced включите VMD для тех слотов или портов, если PCIe выведен на разъёмы OCuLink, к которым подключены накопители.

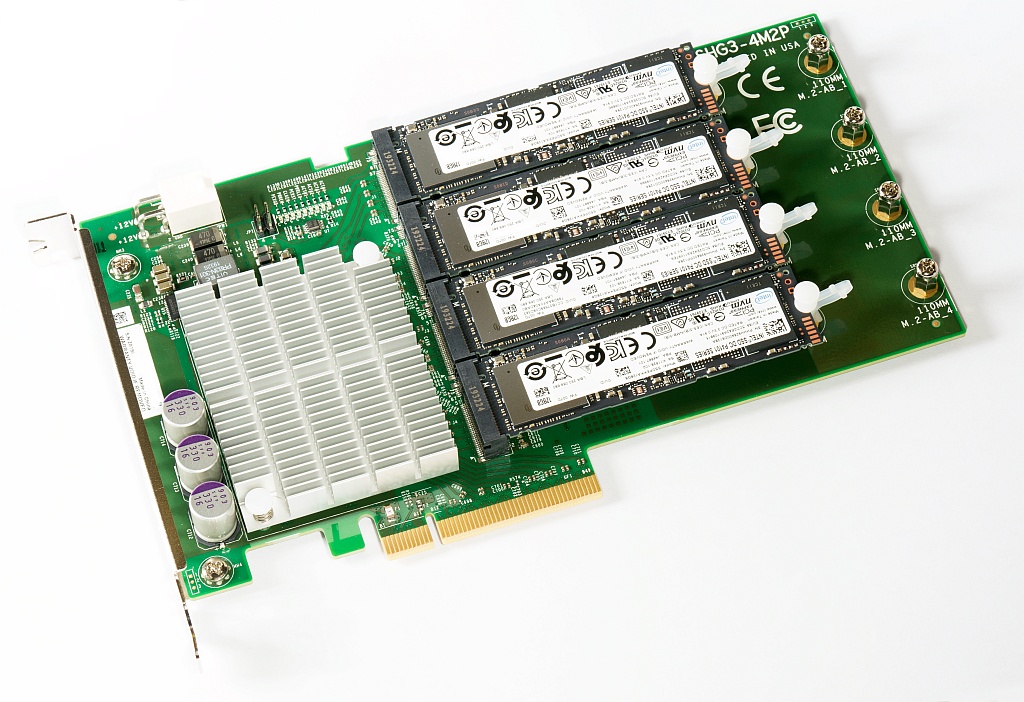

В данном случае использовалась плата Supermicro AOC-SHG3-4M2P, позволяющая подключить четыре накопителя M.2 в один слот PCIe x8. Плата была установлена в верхний слот x16 платформы Supermicro 1029P-WTR.

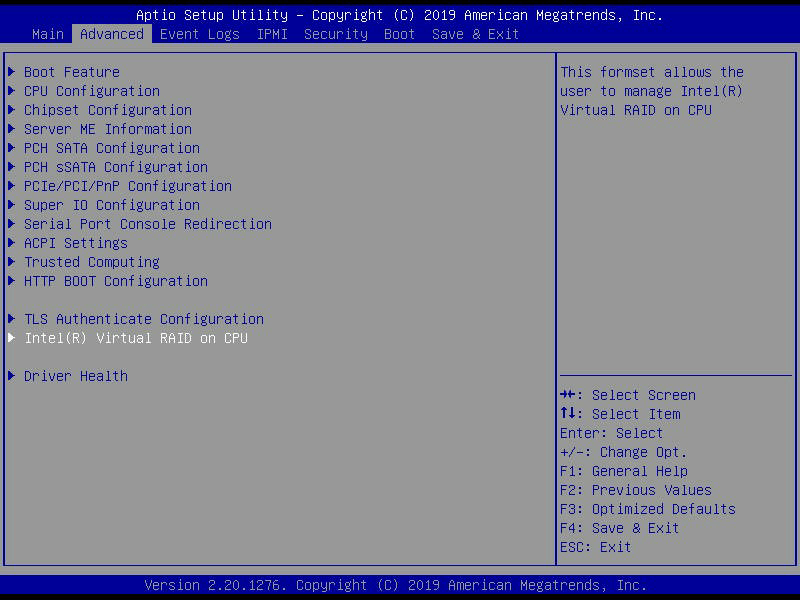

После перезагрузки в разделе Advanced появится пункт Intel Virtual RAID on CPU. Кстати, режимы инициализации всех слотов и режим загрузки необходимо переключить в UEFI вместо Legacy.

UEFI HII для VROC не отличается от такового для RSTe. Создаём массивы, выбираем накопители.

Читайте также: