X11dpi nt raid настройка

Обновлено: 06.07.2024

Ранее мы уже рассматривали утилиты для управления серверами HP, и я подумал сделать, нечто подобное для каждого из вендоров.

История Supermicro

Super Micro Computer Inc, известная как Supermicro, является компанией в сфере информационных технологий, базирующейся в Сан-Хосе, штат Калифорния. Штаб-квартира Supermicro расположена в Силиконовой долине, с производственными площадями в Нидерландах и Научно-техническим парком на Тайване.

Основатель Чарльз Лян, Уолли Liaw и Sara Liu 1 ноября 1993 года, Supermicro специализируется на серверах, хранения, лезвиях, стоечных решениях, сетевых устройствах, программном обеспечении для управления серверами и высокого класса рабочих станций для центров обработки данных, облачных вычислений, корпоративных IT решение, Big Data, высокопроизводительных вычислений (HPC).

В сентябре 2014 года Supermicro переместила свою корпоративную штаб-квартиру в бывшую штаб-квартиру Mercury News в Северном Сан-Хосе, штат Калифорния, вдоль межштатной автомагистрали 880, назвав кампус Supermicro Green Computing Park. В 2017 году компания завершила строительство нового производственного здания площадью 182 000 квадратных футов в кампусе. Главное здание было спроектировано Уорреном Б. Хейдом в стиле модерн, которое было характерно для коммерческих зданий в 1960-х годах, и построено компанией Карла Н. Свенсона.

Supermicro - это золотая середина между ценой и качеством. В подавляющем большинстве, вы обнаружите данные сервера у большинства российских компаний. Очень часты решения, что за за одни и те же деньги вы можете приобрести больше серверных мощностей Supermicro, нежели у IBM, HP или Dell. Качество Supermicro уже не такое плохое, как было в 2014 году, компания постоянно повышает качество, я ее могу сравнить с Microtik, который за счет свой стоимости так же получил хорошую часть рынка сетевого оборудования, при незначительном отличии качества от лидеров. Лично я за здоровую конкуренцию, так как для клиента это хорошо.

Зачастую начинающие системные администраторы в виду своей неопытности или отсутствия знаний и квалификации, не умеют настраивать и управлять сервера, у них нет понятия, о специализированном софте для этих задач. Я не виню их, так как все были в начале пути, данной статьей я хотел бы поверхностно рассказать, что и для чего используется.

Список инструментов управления серверами SuperMicro

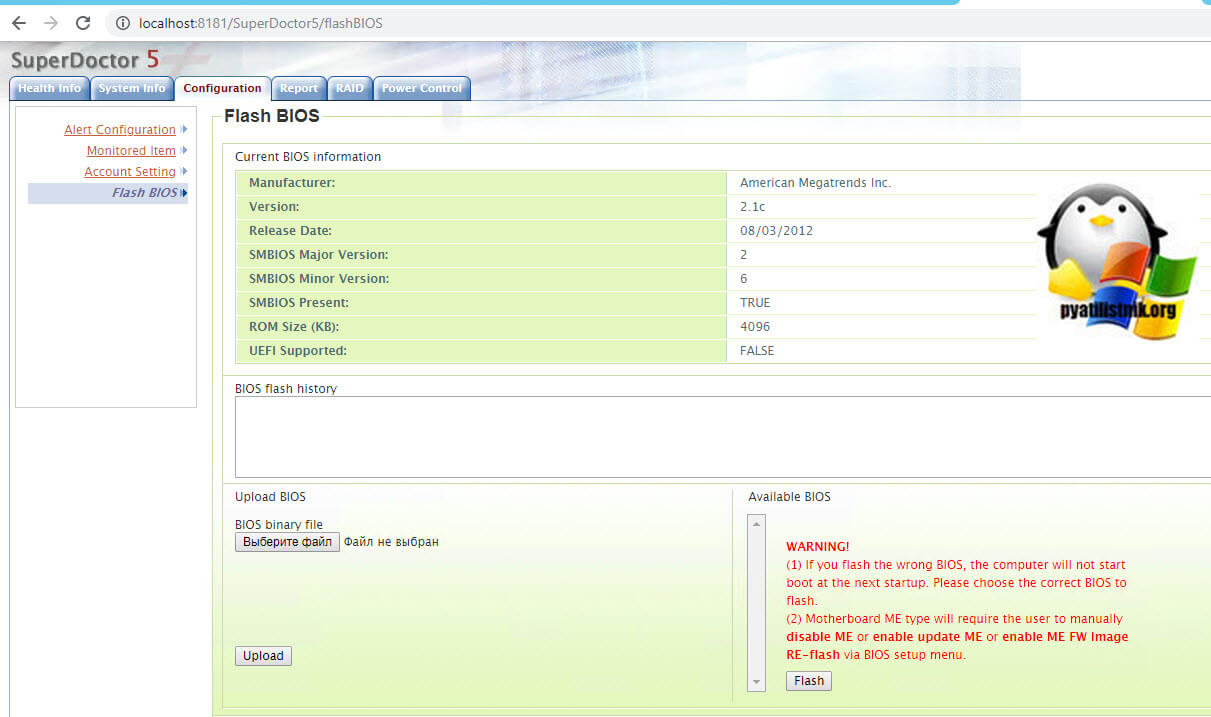

Утилита SuperDoctor

На текущий момент, это самая главная утилита, которая позволит вам управлять вашим сервером Supermicro в полной мере. Как устанавливать SuperDoctor 5, я уже подробно рассказывал, кому интересно советую ознакомиться. Когда вы откроете веб-интерфейс данной утилиты, то на первом экране вы увидите дашборд с различными показателями состояния физических компонентов сервера.

- Поддерживает функции мониторинга, контроля и управления - Мониторинг оборудования: скорость вентилятора, температура, напряжение, вторжение в корпус, сбой избыточного питания, энергопотребление, работоспособность дисков, рейд и память, 20 типов системной информации: BIOS, материнская плата, шасси, компьютерная система, дисководы, память, сеть, принтер, процессор, системный слот, IPMI, источник питания, учетная запись, операционная система, процесс, сервис, общий ресурс, часовой пояс, OEM Строки и параметры Cfg системы.

- Предоставляет расширения SNMP для системы управления сетью.

- Простой в использовании веб-интерфейс и интерфейс командной строки.

- Уведомления отправляются по электронной почте и SNMP-ловушкам.

- Простота настройки:- Подключаемые модули аппаратного и программного обеспечения для мониторинга. Совместимо с плагинами Nagios.

- Поддерживает платформы Windows и Linux.

- Тут же вы можете обновить BIOS на SuperMicro, если в этом есть необходимость

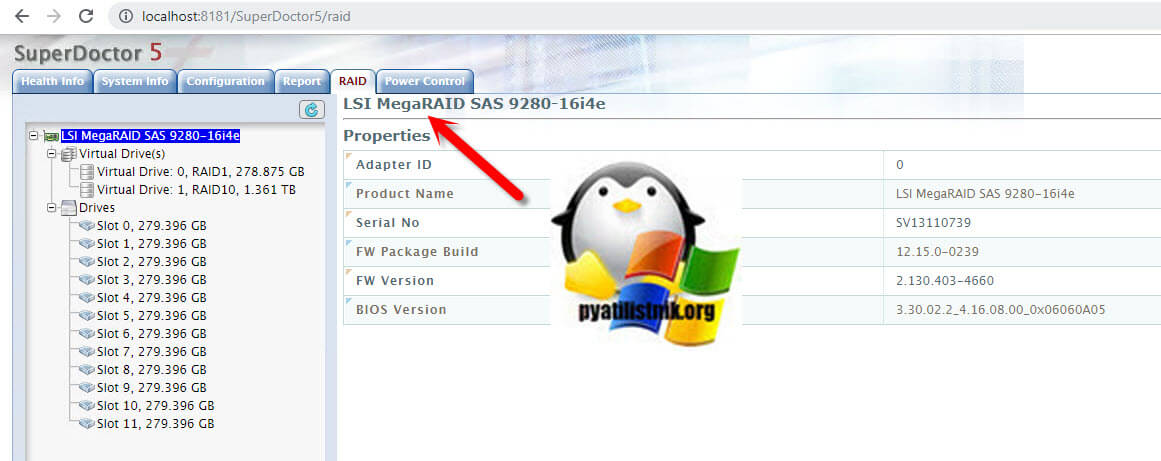

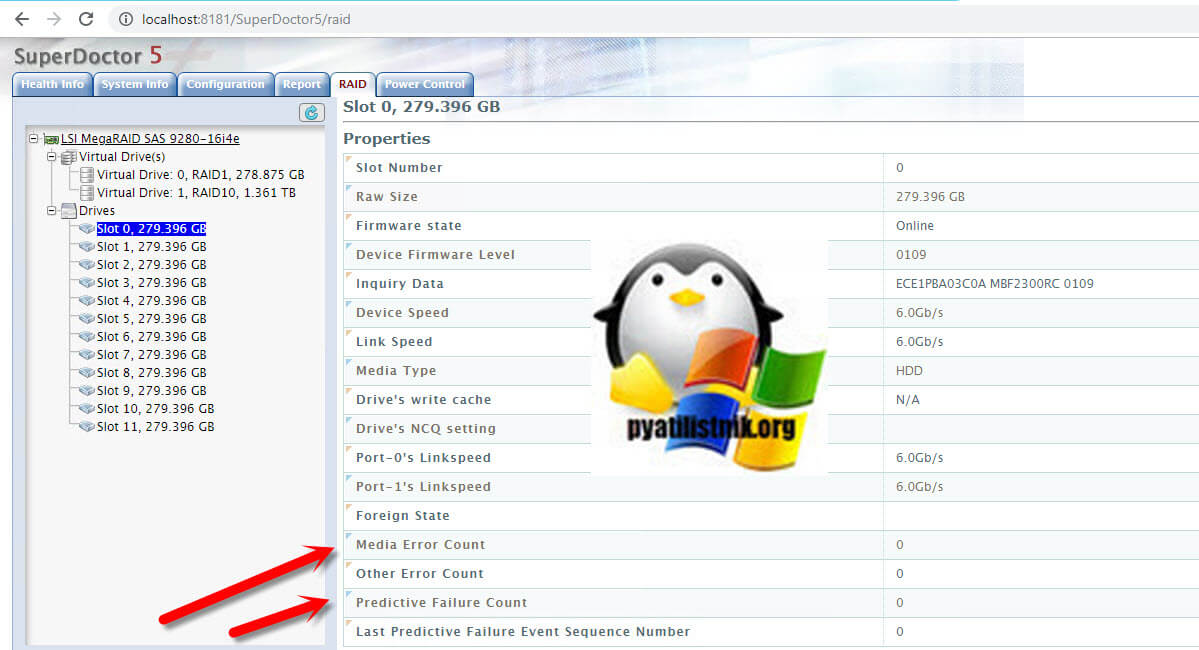

- Так же вы можете тут посмотреть всю информацию по жестким дискам и RAID контроллеру. В моем примере, это LSI MegaRAID SAS 9280-16i4e.

- У каждого из жестких дисков вы можете посмотреть его физическое состояние (S.M.A.R.T.), тут есть счетчики, например, как у LSI "Predictive Failure Count"

Утилита ipmicfg

ipmicfg - утилита командной строки, может выполняться в DOS, Windows и Linux. Она предоставляет как стандартные IPMI, так и собственные OEM-команды Supermicro для конфигурации BMC или Filed Replaceable Unit (FRU). С помощью этого инструмента вы можете выполнять следующие действия:

- Настройте IPMI IP-адрес

- Настройте управление пользователями IPMI

- Настроить IPMI FRU

- Управление системным журналом событий (SEL)

Утилита Supermicro IPMI Configuration Utility

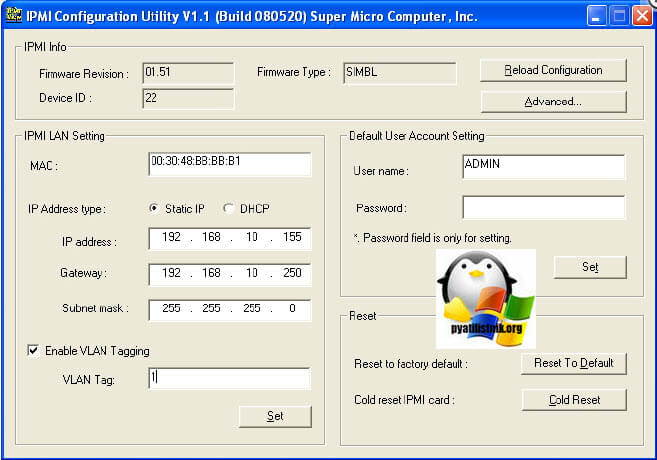

Supermicro IPMI Configuration Utility - это старенькая утилита, в задачи которой входило:

- Определение прошивки сервера

- Сброс пароля на доступ к IPMI

- Настройка IP-адреса IPMI, можно было выбрать статический или DHCP

- Настройка VLAN

- Сброс настроек на заводские

- Сброс IPMI карты

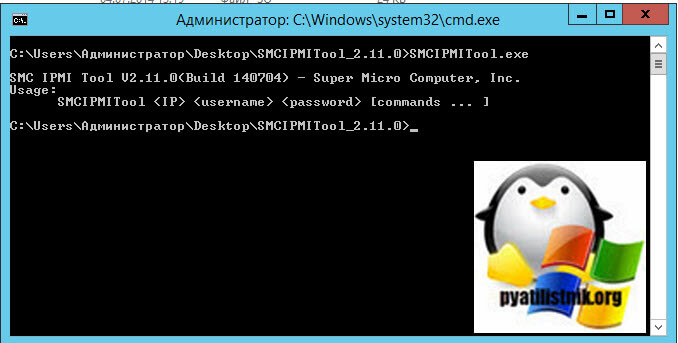

Утилита Supermicro SMCIPMITool

SMCIPMITool - это утилита Supermicro, которая позволяет пользователю взаимодействовать с системами SuperBlade и устройствами IPMI через CLI (интерфейс командной строки). Эта утилита обеспечивала два пользовательских режима: режим командной строки ОС и режим оболочки. Эта утилита может быть легко интегрирована с существующей инфраструктурой для связи с контроллерами управления материнской платой сервера Supermicro.

Ключевые особенности SMCIPMITool:

- Удаленное управление системой

- SuperBlade Management

- Управление MicroBlade

- Система управления питанием

- Управление HDD и NVMe

- FRU Management

- Диагностика системы (без супер диагностики)

- NM (Node Manager) Управление

- Управление Группой

- IPv6 поддерживается

- Последовательный по локальной сети

- Boot Override

- Обновление прошивки

- Датчики и журнал событий

- Мониторинг питания и BBP

- Информация о системе MultiNode

- Управление виртуальным носителем (требуется ключ продукта узла)

- Удаленный захват экрана (требуется ключ продукта узла)

![SMCIPMITool]()

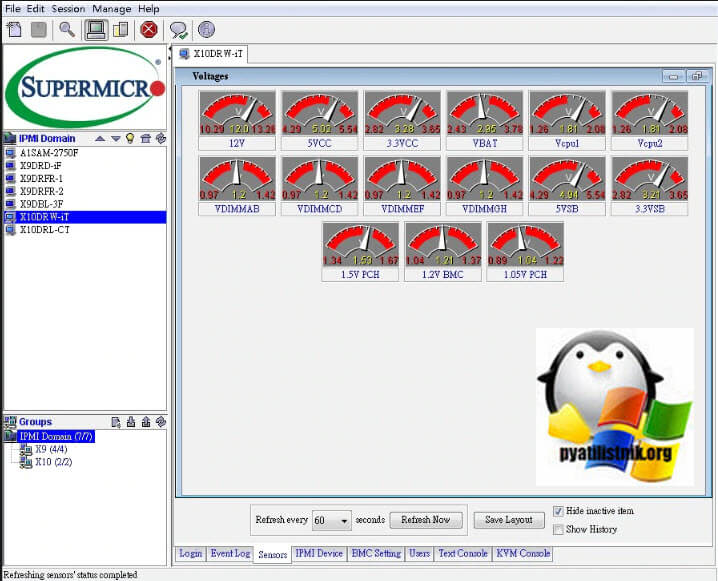

Утилита Supermicro IPMIView

IPMIView - это приложение на основе графического интерфейса, которое позволяет администраторам управлять несколькими целевыми системами через BMC. IPMIView V2.0 поддерживает BMC Supermicro, соответствующие IPMI v1.5 или v2.0.

IPMIView отслеживает и сообщает о состоянии системы SuperBlade, включая блейд-сервера, блоки питания, коммутаторах, модули InfiniBand и CMM. IPMIView также поддерживает удаленный KVM и Virtual Media.

Ключевые особенности IPMIView:

- Управление системой IPMI

- Перенаправление консоли KVM

- Перенаправление текстовой консоли

- Управление виртуальными медиа

IPMI Управление пользователями/группами - Приемник ловушек

- Мобильное приложение (Android, iOS)

Вот так выглядит интерфейс IPMIView, в который добавлено несколько серверов

![IPMIView]()

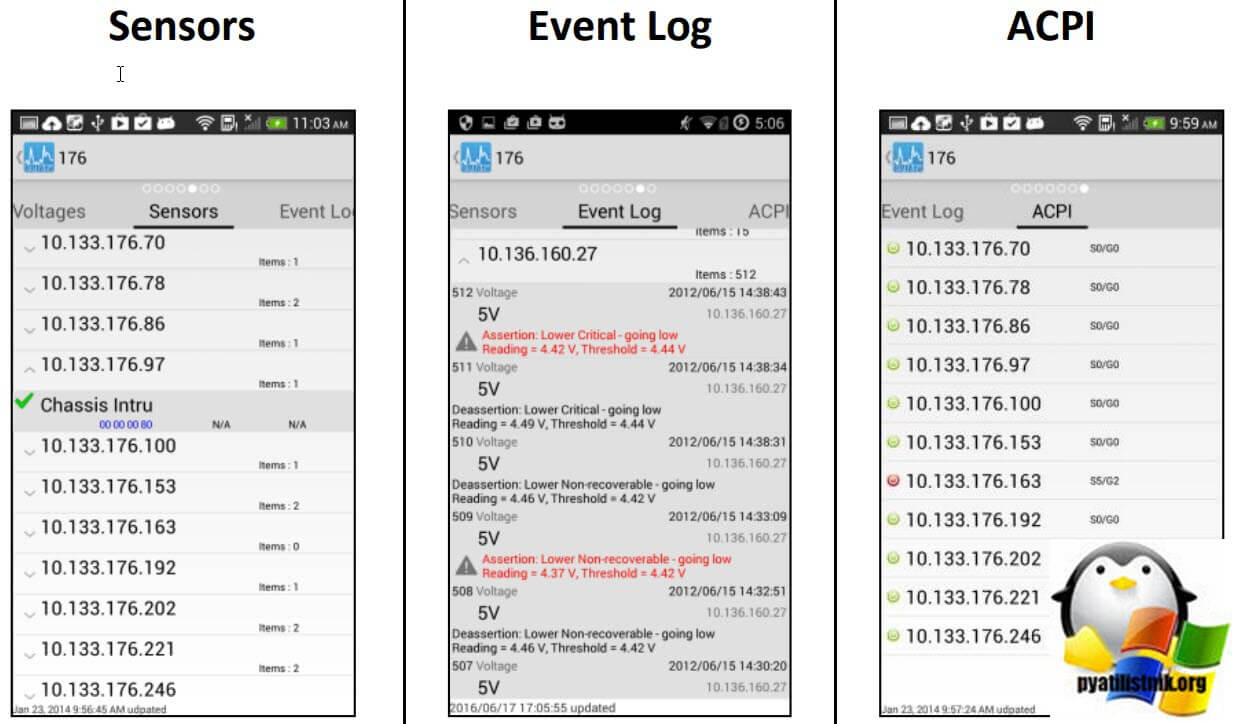

А вот так выглядит версия для Android, где вы можете видеть суммарную информацию, вентиляторы, температуру, вольтаж

![IPMIView android]()

Различные сенсоры, события генерируемые серверами SuperMicro, ACPI![IPMIView android]()

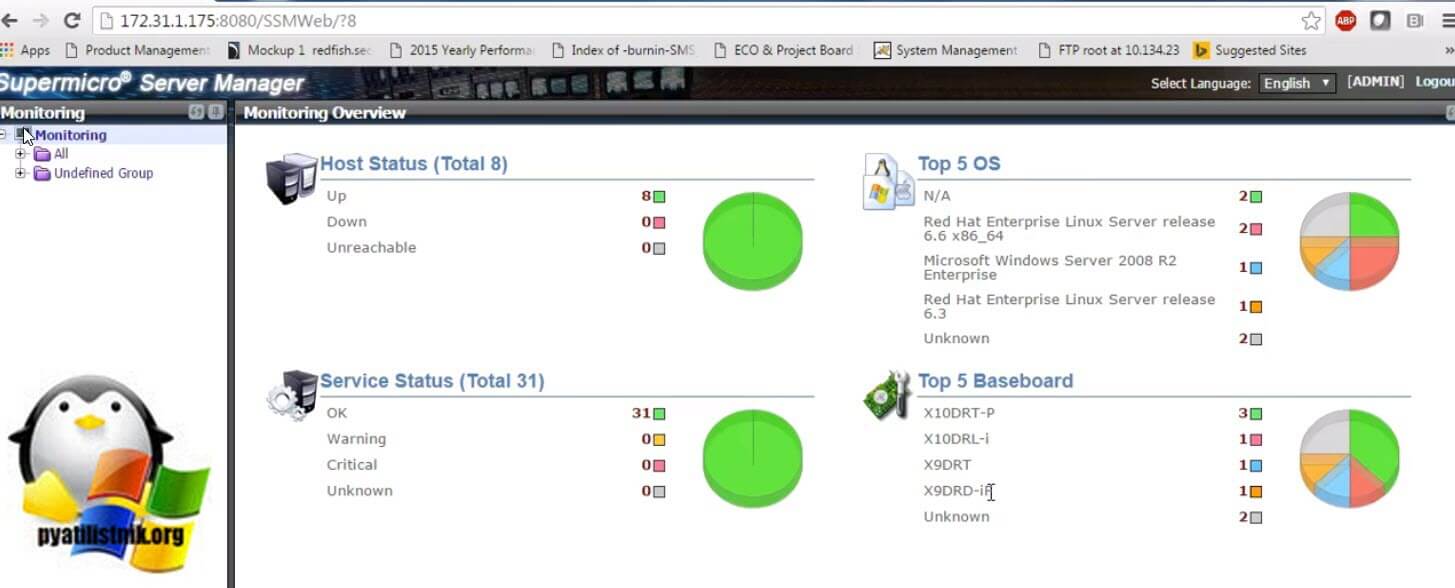

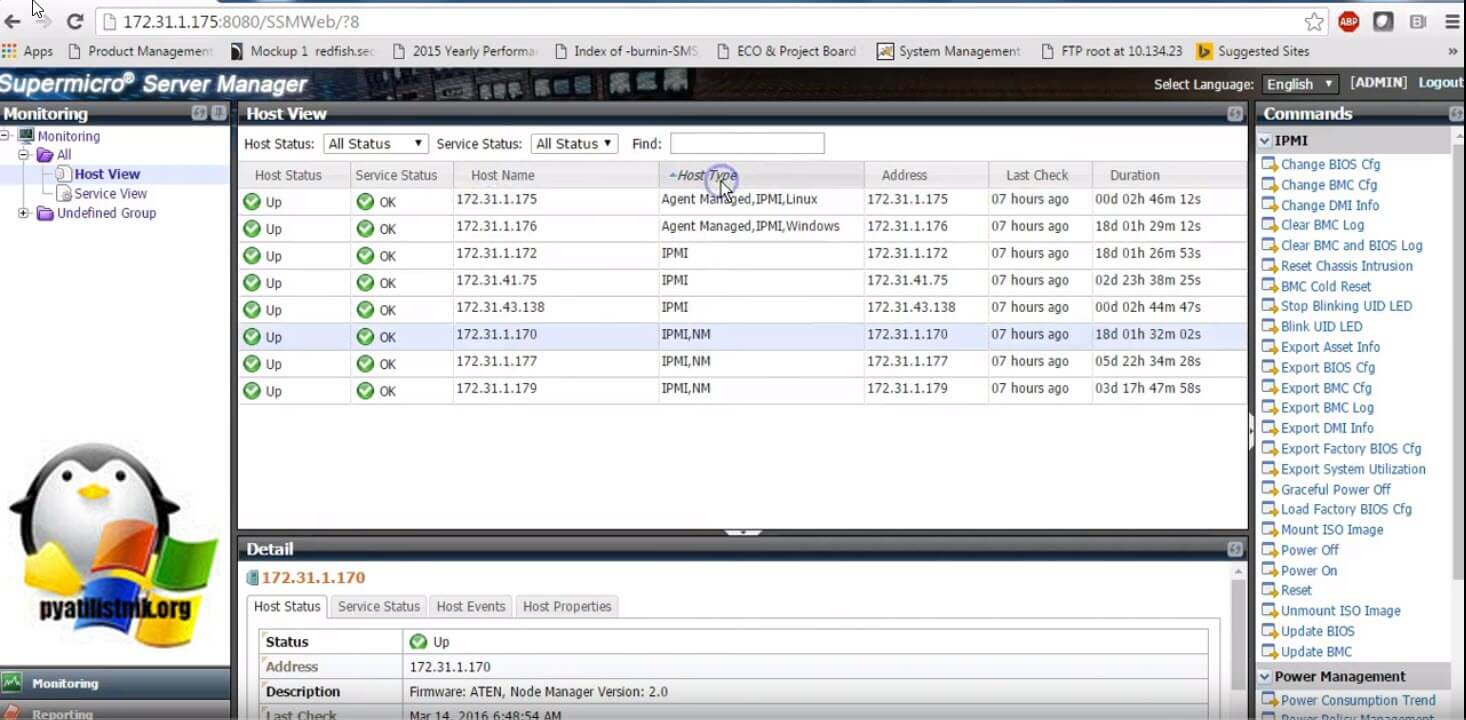

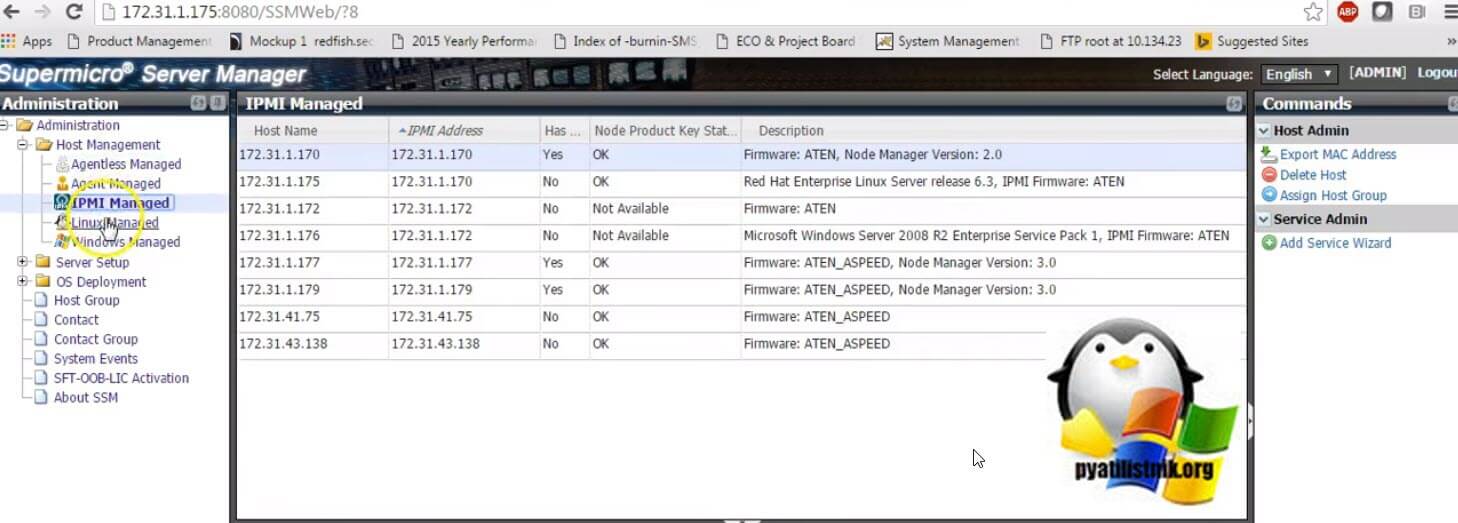

Модули Supermicro SSMSupermicro Server Manager (SSM) - это комплексное решение для управления и мониторинга серверов Supermicro в датацентре из единой консоли. SSM поддерживает REST API, WebUI и CLI. Лицензирование: SFT-DCMS-Single требуется для каждого целевого узла.

Управление

- Управляет системой через BMC/IPMI или SuperDoctor 5 (агент ОС)

- Обновляет BIOS и встроенное ПО и конфигурации BMC/IPMI

- Редактирует информацию DMI (SMBIOS)

- Вызывает развертывание ОС без участия человека (RHEL, CentOS, SLES, Ubuntu, VMware ESXi)

- Монтирует загрузочные ISO-образы для обслуживания и установки образов

- Экспортирует и очищает журналы системных событий

- Удаленное включение/выключение/сброс целевых систем

- Управляет политиками электропитания отдельных узлов

- Интегрируется с аутентификациями LDAPv3 и Active Directory

![Supermicro SSM]()

Мониторинг

- Активно следит за состоянием серверного оборудования и услуг

- Проверяет информацию об активах на системных компонентах

- Проверяет использование системы (требуется агент TAS и доступно только в X10 и последующих поколениях)

- Оповещения по электронной почте и SNMP-ловушкам

- Журналы и отчеты о доступности управляемых узлов

- Мониторинг энергопотребления для серверов

- Инициирует удаленную консоль, чтобы подключаться через VNC

- Автоматическая генерация обращений к Supermicro Global Service Team (требуется соглашение об обслуживании Supermicro)

- Многоуровневые сервисные уведомления о вызовах

- Отслеживает заранее определенные критические сбои оборудования

![Supermicro SSM]()

Лицензирование: Дополнительные лицензии SFT-DCMS-SVC-KEY на каждом целевом узле для функции Call-Home

![Supermicro SSM]()

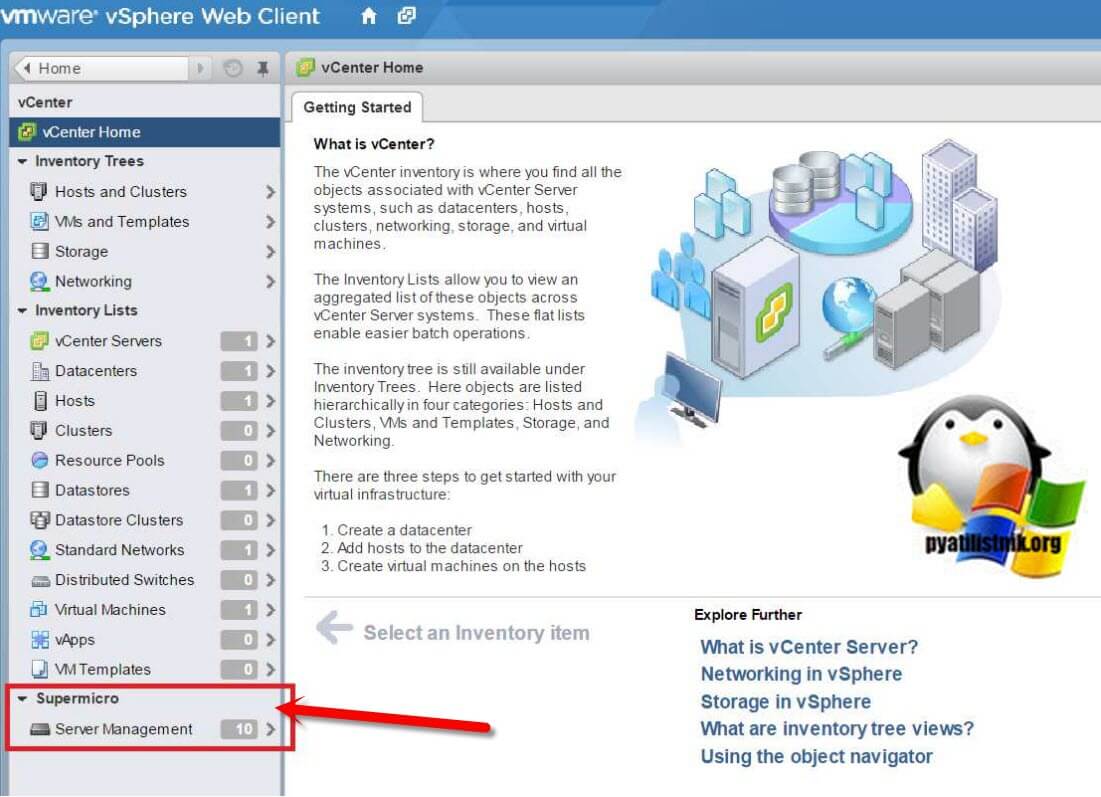

Плагины Supermicro SSM

Supermicro предлагает плагины, которые интегрируют SSM в существующую облачную инфраструктуру заказчика. Воспользуйтесь преимуществами OEM-функций Supermicro через удобный для вас интерфейс.

-

- Подключаемый модуль SSM SCOM позволяет видеть все хост-системы Supermicro с помощью Microsoft Operations Manager.

![upermicro SSM Microsoft SCOM]()

- VMware vCenter - Подключаемый модуль SSM vCenter - это многофункциональный и простой в использовании инструмент, который позволяет одновременно управлять хостами SSM и хостами vSphere ESXi. Плагин установлен в веб-клиенте vSphere.

У вас на вкладке "Home" появится два значка Supermicro server management и Supermicro SSM REST API Settings.

![Supermicro server management]()

В отдельной вкладке "Supermicro" вы можете посмотреть все ваши сервера, в моем примере их 10.

![Supermicro server management-02]()

Вкладка "Summary" покажет всю сводную информацию о сервере.![Supermicro server management]()

Тут же вы можете обновить BMC и BIOS.

![kak nastroit]()

3. Нажимаем F10, сохраняем параметры и перезагружаем сервер

4. После перезагрузки во время приглашения «Press CTRL+I to configure…» для конфигурации встроенного контроллера нужно нажать сочетание клавиш CTRL+I.

5. В появившемся меню выбрать пункт Create Volume

6. Выставить параметры

b. Select Disks – в подменю выбрать три или четыре физических диска

Нажать Enter для создания раздела

![Создание раздела]()

7. Проверяем правильность создания раздела:

a. RAID5

Если все правильно, то Exit и Y для подтверждения

![Создание раздела]()

8. Начнется загрузка образа операционной системы Windows Server 2008

![Загрузка системы]()

![Полная установка]()

10. Созданный массив система видит как один диск, что и требовалось![Созданный массив]()

11. Создаем новую партицию, размером во весь виртуальный диск

![патриции]()

12. После создания диска получается следующее – созданы две служебные и одна основная партиция

![Установка системы]()

13. Установка системы на основную партицию

После установки ОС – доступен и работоспособен логический диск на основной партиции на виртуальном диске на массиве RAID5.На днях столкнулся с совсем неочевидной проблемой. Хотя что могло быть сложнее поставить Windows 2019 на новый сервер.

Материнская плата Supermicro X11DPL-i, биос обновлен до последней версии 3.3 на 20.11.2020.

Диски 2х SSDSC2KG48

Режим загрузки Legacy (UEFI глобально ничего бы не изменил).

Задача: собрать softraid на встроенном контроллере в чипсет и установить Windows Server 2019.

Почему не внешний контроллер: единственный доступный в 1U корпусе слот оказался занят сетевой картой, поэтому даже при желании его было не поставить.

надо было ставить Linux и вообще ceph и все в шоколадеДействие первое:

1.1 Подключаем 1 диск для проверки.

1.2 Включаем PCH SATA Configuration - Configure SATA as RAID , перезагружаемся.

![Supermicro X11 Intel VROC (RST) + Windows Server 201x Installer Длиннопост, Установка, Intel, Драйвер, Костыли, Windows]()

1.2.1 Обращаю внимание, что на плате есть еще второй sSATA контроллер (Second SATA), который по умолчанию включен.

![Supermicro X11 Intel VROC (RST) + Windows Server 201x Installer Длиннопост, Установка, Intel, Драйвер, Костыли, Windows]()

1.3 Ждем, где клацать Ctrl-I и не видим. Не загружается утилита конфигурации виртуального контроллера. После инициализации OpROM сетевых карт начинает грузиться с них же.

1.4 Возвращаемся в биос, проверяем, что все нормально, перезагружаемся - не работает.

1.5 Гуглим решение: оказывается нужно как минимум 2 диска, чтобы загрузилась.

1.6 Подключаем второй диск, все начинает работать.

Вот казалось бы, вроде логично, что массив собирается только из 2 и более дисков, но почему утилита грузится с теми же требованиями?

P.S. забегая наперед, если один из дисков умрет или его отключить и массив развалится, то утилита загрузится и покажет, что массив degraded, поэтому можно спать спокойно.

Действие второе:

2.1 Массив собрали, массив в boot menu появляется, вставляем флешку/грузим по сети/подключаем через IPMI (подчеркните сами нужное) с образом Windows Server 2019 (md5 B2626D444A641604F325B145AB0C86F1), включаем сервер

2.2 Загружается установщик, клацаем далее, встречаем пустое окно при выборе дисков.

В смысле, как так? Нету драйверов под стандартный intel raid? Такого быть не может.

2.3 ОК, лезем на сайт Supermicro к нашей модели материнки, скачиваем "Intel PCH Driver(SATA)", перепаковываем в ISO, подключаем через IPMI, пробуем скармливать . и не кушает.

![Supermicro X11 Intel VROC (RST) + Windows Server 201x Installer Длиннопост, Установка, Intel, Драйвер, Костыли, Windows]()

2.4 ОКК, лезем на сайт Intel, ищем драйвер Intel SoftRaid/VROC, получаем пакет VROC_7.0.0.2291_F6.

2.5 Перепаковываем в iso, подключаем . и опять не работает. Да как так то?

2.6 Идем в биос, лазим по нему в поисках слов "raid", "intel vroc", "boot volume". В итоге понимаем, что нигде ничего нет, да и вообще, все должно работать. Лезем в Ctrl+I, у него все круто, проблем никаких, рейд собран, помечен как Bootable.

Бросаем это затею и идем гуглить.

"Supermicro X11 server 2019" "Intel VROC server 2019" "X11 softraid windows server installer"

Единственное похожее упоминание о проблеме есть тут в ветке комментариев:

![Supermicro X11 Intel VROC (RST) + Windows Server 201x Installer Длиннопост, Установка, Intel, Драйвер, Костыли, Windows]()

Тут есть упоминание о sSATA, но к нему у нас не подключены диски, так что в итоге он был отключен вообще.

Итак, действие третье:

3.1 Вспоминаем, что у нас есть WinPE на базе Win10 (у меня это StrelecPE), пробуем загрузиться в него.

3.2 Открываем диспетчер устройств, обнаруживаем кучу неопознанных устройств, как обычно, но среди которых нету RAID-контроллера.

3.3 Значит драйвер для него установлен. да, так и есть драйвер "Intel Embedded Server RAID Technology II" установлен, успешно запустился и работает. Но в оснастке управления дисков (он же diskpart) массива так и нет.

3.3.1 ID устройства PCI\VEN_8086&DEV_2826&CC_0104

![Supermicro X11 Intel VROC (RST) + Windows Server 201x Installer Длиннопост, Установка, Intel, Драйвер, Костыли, Windows]()

3.4 ОК, подключаем еще раз новые драйвера с сайта Intel, пытаемся скормить драйвер и вуаля, шайтан машина таки жива, диск мгновенно появляется. (Момент скрина был позже событий, поэтому система уже установлена. Изначально диск конечно же был пустой)

![Supermicro X11 Intel VROC (RST) + Windows Server 201x Installer Длиннопост, Установка, Intel, Драйвер, Костыли, Windows]()

3.3.1 На этом моменте все умные уже предполагают, о чем будет следующее действие.

3.5 Монтируем ISO с установщиком ОС, запускаем setup.exe, диск успешно видится, система начала копировать файлы.

3.5.1 Да, можно было распаковать и через другие утилиты установки из-под WinPE, можно было через cmd распаковать сразу на диск, потом доделать загрузчик, но зачем? Если можно просто нажать далее и он сделает все сам.

3.6 setup.exe радостно сообщает, что файлы все скопировал и надо перезагрузиться.

Вроде все? Но нет.

После перезагрузки сразу получаем BSOD Inaccessible Boot Device, который как бы намекает.

Не то чтобы намекает, он напрямую говорит, что загрузчик запустил ядро, но ядро не нашло загрузочного диска. А почему?

Потому что в образе системы предустановлен тот самый драйвер, который загружается без ошибок для данного устройства, но по факту не работает.

Действие четвертое, заключительное:

4.1 Грузим опять WinPE.

4.2 Устанавливаем рабочий драйвер в WinPE.

4.3 Открываем Dism++, открываем сессию на установленную систему на дисках, импортируем туда рабочий драйвер

4.4 Перезагружаемся. Вуаля, система продолжает ставится без каких-либо проблем.

Это можно было бы сделать сразу в действии третьем (3.3.1), но так как setup.exe не предлагает не перезагружаться, в моем случае это было недоступно, да и я сам хотел проверить, заработает оно или нет без этого.

Что произошло:

Как я предполагаю, в Intel что-то поменяли в прошивке виртуального raid-контроллера (версия Sata Option ROM 6.2.0.1034), оставив старый DeviceID. Скорее всего хотели не сломать совместимость с уже интегрированными драйверами в образах Windows Server 2012R2, 2016 и 2019. Установочные образы 2012R2, 2016 ведут себя аналогично 2019. Так и получилось, драйвер ставится, загружается, но где-то что-то идет не так и он не работает.

Я склоняюсь к этой версии, так как точно помню, что в основном Windows без проблем встают на Intel SoftRaid, без дополнительных драйверов.

В любом случае, драйвер был загружен, но диски в систему не передавал, а результатом стала вроде и простая, но неочевидная ситуация, которую разрулить стандартными средствами невозможно. Установщик отказывается ставить драйвер для контроллера дисков, если у него уже есть драйвера, даже если нерабочие.

Так как эта платформа была в единственном экземпляре, то такой порядок действии вполне нормальный, но если таких было бы несколько, то хорошим решением было бы пересобрать дистрибутив с интегрированными рабочими драйверами. Насколько такое решение является "стандартным средством" решать вам.

![]()

Лига Сисадминов

659 постов 12.4K подписчиков

Правила сообщества

В последнее время ставлю или VMware Esx или proxmox - а винду уже тудаСупермикро, как бы это сказать, не очень)). 6 (!) раз переустанавливали сервер 2012рэ2 (да, давно было), он стабильно бсодил при загрузке с непонятной дженерал еррор, хотя ставился на рэйд только так. Бубен не помогал. Махнули местами процы - поехал сука.

Один вопрос: а чем софтовый рейд не угодил ?

У меня уже 6 лет моторесурса дисков в зеркале, рейд пережил три-четыре раз переустановку винды, при чём начиная с 8.1 на нынешнюю 10.

Зачем тебе рэйд-режим работы контроллера если рэйд нужен софтовый?

1. можешь прислать ссылку на прямо вот точные драйвера которые тебе в итоге подошли

2. с Dism++ не понял, загрузился в режиме PE, запустил DISM, нашлась установленная система 2016, примонтировал, открыл сессию, добавил драйвера, закрыл сессию, перезагрузился - проблема осталась. Как правильно в Dism++ эту операцию делать?

Здравствуйте, подскажите вот такую вещь, подогнали материнку X11SSH-F, как у нее попасть в BIOS?

Чёт я малость запутался - ты в середине пишешь, что интегрировал драйвера в исо, но это не помогло. А в конце пишешь, что надо бы по хорошему интегрировать драйвера в инсталлятор и тогда всё должно быть ништяк. В чём отличие?

И дополнение - на работе есть два сервера с матерями супермикро, год назад решал на одной из них проблему, хоть убей, не помню уже какую, но которая вылезла на ровном месте и какой на любой другой матери не было и быть не должно. Так толком и не решил, обошёл. И с тех пор я к ним ниочинь.

Если уж использовать программный рейд, то какой смысл это делать на intel, а не средствами ОС?

Заморочился нашёл способ поставить ОСЬ:

Слил исошку с дровами с оф сайта супермикро, распаковал, и в процеесе установки винды с диска (через usb dvd), просто подкинул дрова и все установилось без проблем на софт рейд 10

1. ISO Стрельца с WINPEВообще не понятно зачем все это. Собрал этих платформ чертову тучу. Драйвера подбрасываются прямо из инсталятора.

1. Качаешь драйвера с сайта Супермикро - по моему называются Intel SATA или Intel PCH

2. Названия не очевидные какой подкидывать. Перваый раз просто выбирал сверху вниз, заняло около получаса попробовать перебором. И на этом все. проблем нет.

3. Если собрал рейд на sSATA - то в драйверах с сайта Супермикро где-то рядом фалик.

4. Конечно HPE или DELL будут проще настраиваться, да и с гарантией получше "чуток", Но при этом деньги совсем другие, особенно если массив большой.

Нафиг эти все танцы - драйвера в ISO встраивать. Хотя это круто, что автор умеет это делать.

5 лет как свалил с on-premise, а костыли там всё те же.

На сервере использовать SSD 3D NAND TLC ? Серьёзно?оо

А raid не зеркало из них случаем? Ну чтобы умирали одновременно.твоя ошибка в первой же строчке раздела Дано.

не надо брать эту хуергу, супермайкро ебучее.

ни разу не было таких проблем с серверами крупных брендов.

![]()

Windows спустя месяц

![Windows спустя месяц]()

Лучше не приходи.

Вроде хорошее предложение, но как-то сомнительно.

Даже если и недалеко, не приходи.

А с другой стороны, этой фотографии как минимум лет 10, и кто знает,может бывший эникейщик сейчас развертывает на предприятиях RedHat и ставит домохозяйкам Gentoo?![Лучше не приходи. Windows, Установка, Эникейщик]()

![]()

Раритет

Сегодня полез смотреть проверять доступность Windows 10 October 2020 Update в параметрах системы. Действительно, появилось в необязательных, но речь уже не об этом, так как заметил, что для обновления доступны ещё два драйвера.

![Раритет Intel, Windows 10, Драйвер, Длиннопост]()

Последний меня заинтересовал и я полез в диспетчер устройств смотреть дату выпуска текущего драйвера со схожими признаками (PCIe, 1901), а там.

![Раритет Intel, Windows 10, Драйвер, Длиннопост]()

Оказалось, что у меня на компе один из первый драйверов, написанных Intel аж в день своего основания.

![Раритет Intel, Windows 10, Драйвер, Длиннопост]()

Такой раритет я, пожалуй, оставлю без обновления. ))

Пожелание сотрудницы

![Пожелание сотрудницы Ведьмак, Windows, Установка, Офис, Сотрудники]()

Видимо очень хорошая сотрудница

Intel «похоронит» базу данных драйверов для старых ПК

![Intel «похоронит» базу данных драйверов для старых ПК Bios, Intel, Драйвер, Программное обеспечение]()

В эту пятницу, 22 ноября, Intel удалит со своих серверов все драйверы и BIOS для чипсетов, процессоров, видеокарт и других устройств, которые были выпущены более десяти лет назад. Сейчас при попытке загрузки такого ПО в верхней части страницы появляется соответствующее предупреждение. Дополнительно компания избавится от подобных файлов, предназначенных для работы под управлением операционных систем Windows 98, ME, XP и Windows Server, которые больше не поддерживаются Microsoft.

Владельцы устаревшего оборудования по-прежнему смогут загружать необходимые драйверы из сторонних источников, но делать это им придётся на свой страх и риск.

![]()

Разработчики Linux и Windows работают над закрытием огромной уязвимости в процессорах

Фундаментальная ошибка проектирования всех современных процессоров Intel, выпущенных за последние 10 лет, заставила разработчиков Linux и Windows в срочном порядке переписывать значительные куски кода ядер для того, чтобы закрыть недавно открытую в них уязвимость. Архитектура ARM64 также подвержена уязвимости.

Детали уязвимости находятся под эмбарго до тех пор, пока не будут выпущены исправления, которое намечается на середину января 2018 года, когда выйдет новое ядро Linux и ежемесячное обновление безопасности для Windows. Проблема возможно уже исправлена в ядре 4.14.11, учитывая огромный размер инкрементного патча (229 KiB).

По известным сейчас данным, обход этой аппаратной проблемы может привести к падению производительности приложений на процессорах Intel от 5 до 30% и даже до 63% на некоторых задачах. Более новые чипы от Intel имеют в своём арсенале возможности (PCID / ASID), позволяющие сократить провал в производительности при применении исправления.

Суть уязвимости, скорее всего, заключается в том, что процессоры Intel при спекулятивном выполнении кода не выполняют проверки на безопасность инструкций, которые позволяют читать сегменты памяти, что позволяет любому пользовательскому приложению получить доступ к памяти ядра, тем самым позволяя прочитать закрытые данные, такие как ключи шифрования и пароли. Большую опасность проблема также представляет для систем виртуализации, так как позволяет получить доступ к памяти вне гостевой системы.

Для решения проблемы разработчикам ядер пришлось полностью разделить память ядра и память пользовательских приложений, однако такое решение приводит к серьёзному падению производительности из-за постоянной необходимости замены указателей на память. Разработчики ядра Linux в шутку предлагали следующие аббревиатуры для новой модели разделения памяти ядра и пользовательских процессов: User Address Separation (*_uass) и Forcefully Unmap Complete Kernel With Interrupt Trampolines (fuckwit_*), однако остановились на Kernel Page Table Isolation (kpti_*).

Разработчики из GRSecurity протестировали патчи и увидели огромное падение производительности. Разработчики PostgreSQL отметили падение производительности в тесте pgbench на 23% (при использовании процессоров с PCID - 17%). Из-за сильного влияния на производительность разработчики патча предусмотрели опцию для отключения KPTI, которая активируется через передачу параметра "nopti" при загрузке ядра.

Компания AMD утверждает, что её процессоры уязвимости не подвержены. Работа над исправлением уязвимости в других операционных системах также активно ведётся

![]()

Организация единого дискового пространства — задача, легко решаемая с помощью аппаратного RAID-контроллера. Однако следует вначале ознакомиться с особенностями использования и управления таким контроллером. Об этом сегодня расскажем в нашей статье.

Надежность и скорость работы дисковых накопителей — вопрос, волнующий каждого системного администратора. Несмотря на заверения производителей о качестве собственных устройств — HDD и SSD продолжают выходить из строя в самое неподходящее время, теряя драгоценные данные. Технология S.M.A.R.T. в большинстве случаев дает возможность оценить «здоровье» накопителя, но это не гарантирует того, что диск будет продолжать беспроблемно работать.

Предсказать выход диска из строя со 100%-ой точностью невозможно, поэтому следует предусмотреть вариант, при котором это не станет проблемой или причиной остановки сервисов. Использование RAID-массивов решает эту задачу. Рассмотрим три основных подхода, применяющихся для этой задачи:- Программный RAID — наименее затратный вариант, но и наименее производительный. Массив создается средствами операционной системы, вся нагрузка по обработке данных «ложится на плечи» центрального процессора.

- Интегрированный аппаратный RAID (еще его часто называют Fake-RAID) — микрочип, установленный на материнскую плату, который берет на себя часть функционала аппаратного RAID-контроллера, работая в паре с центральным процессором. Этот подход работает чуть быстрее, чем программный RAID, но надежность у такого массива оставляет желать лучшего.

- Аппаратный RAID — это отдельный контроллер с собственным процессором и кэширующей памятью, полностью забирающий на себя выполнение всех дисковых операций. Наиболее затратный, однако, самый производительный и надежный вариант для использования.

Внешний вид

Мы выбрали решения Adaptec от компании Microsemi. Это RAID-контроллеры, зарекомендовавшие себя удобством использования и высокой производительностью. Их мы устанавливаем, если наш клиент решил заказать сервер произвольной или фиксированной конфигурации.

![]()

Для подключения дисков используются специальные интерфейсные кабели. Со стороны контроллера используются разъемы SFF8643. Каждый кабель позволяет подключить до 4-х дисков SAS или SATA (в зависимости от модели). Помимо этого интерфейсный кабель еще имеет восьмипиновый разъем SFF-8485 для шины SGPIO, о назначении которой поговорим чуть позже.

Помимо самого RAID-контроллера существует еще два дополнительных устройства, позволяющих увеличить надежность:

-

BBU (Battery Backup Unit) — модуль расширения с литий-ионной батареей, позволяющий поддерживать напряжение на энергозависимой микросхеме кэша. В случае внезапного обесточивания сервера его использование позволяет временно сохранить содержимое кэша, которое еще не было записано на диски.

Это особенно важно, когда включен режим отложенной записи кэша (Writeback). При пропадании электропитания содержимое кэша не будет сброшено на диски, что приведет к потере данных и, как следствие, штатная работа дискового массива будет нарушена.

Технические характеристики

Температура

Вначале хотелось бы затронуть такую важную вещь, как температурный режим аппаратных RAID-контроллеров Adaptec. Все они оснащены небольшими пассивными радиаторами, что может вызвать ложное представление о небольшом тепловыделении.

Производитель контроллера приводит в качестве рекомендуемого значения воздушного потока — 200 LFM (linear feet per minute), что соответствует показателю 8,24 литра в секунду (или 1,02 метра в секунду). Рассчитаны такие контроллеры исключительно на установку в rackmount-корпусы, где такой воздушный поток создается скоростными штатными кулерами.

От 0°C до 40-55°C — рабочая температура большинства RAID-контроллеров Adaptec (в зависимости от наличия установленных модулей), рекомендованная производителем. Максимальная рабочая температура чипа составляет 100°C. Функционирование контроллера при повышенной температуре (более 85°C) может вывести его из строя. Удобства ради приводим под спойлером табличку рекомендуемых температур для разных серий контроллеров Adaptec.

Series 2 (2405, 2045, 2805) and 2405Q 55°C без модулей Series 5 (5405, 5445, 5085, 5805, 51245, 51645, 52445) 55°C без батарейного модуля, 40°C с батарейным модулем ABM-800 Series 5Z (5405Z, 5445Z, 5805Z, 5805ZQ) 50°C с модулем ZMCP Series 5Q (5805Q) 55°C без батарейного модуля, 40°C с батарейным модулем ABM-800 Series 6E (6405E, 6805E) 55°C без модулей Series 6/6T (6405, 6445, 6805, 6405T, 6805T) 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-600 Series 6Q (6805Q, 6805TQ) 50°C с ZMCP модулем AFM-600 Series 7E (71605E) 55°C без модулей Series 7 (7805, 71605, 71685, 78165, 72405) 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-700 Series 7Q (7805Q, 71605Q) 50°C с ZMCP модулем AFM-700 Series 8E (8405E, 8805E) 55°C без модулей Series 8 (8405, 8805, 8885) 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-700 Series 8Q (8885Q, 81605Z, 81605ZQ) 50°C с ZMCP модулем AFM-700 Нашим клиентам не приходится беспокоиться о перегреве контроллеров, поскольку в наших дата-центрах поддерживается постоянный температурный режим, а сборка серверов произвольной конфигурации происходит с учетом особенностей таких комплектующих (о чем мы упоминали в нашей предыдущей статье).

Скорость работы

Для того чтобы продемонстрировать, как наличие аппаратного RAID-контроллера способствует увеличению скорости работы сервера, мы решили собрать тестовый стенд со следующей конфигурацией:

- CPU Intel Xeon E3-1230v5;

- RAM 16 Gb DDR4 2133 ECC;

- 4 HDD емкостью по 1 ТБ.

Затем в этот же стенд поставим RAID-контроллер Adaptec ASR 7805 с модулем защиты кэша AFM-700, подключим к нему эти же жесткие диски и выполним точно такое же тестирование.

С программным RAID

Несомненное преимущество программного RAID — простота использования. Массив в ОС Linux создается с помощью штатной утилиты mdadm. При установке операционной системы чаще всего создание массива предусмотрено непосредственно из установщика. В случае, когда такой возможности установщик не предоставляет, достаточно всего лишь перейти в соседнюю консоль с помощью сочетания клавиш Ctrl+Alt+F2 (где номер функциональной клавиши — это номер вызываемой tty).

Создать массив очень просто. Командой fdisk -l смотрим, какие диски присутствуют в системе. В нашем случае это 4 диска:

Проверяем, чтобы на дисках не было метаданных, например, от предыдущего массива:

В случае, если на одном или нескольких дисках будут метаданные, удалить их можно следующим образом (где sdX — требуемый диск):

Создадим на каждом диске разделы для будущего массива c помощью fdisk. В качестве типа раздела следует указать fd (Linux RAID autodetect).

Собираем массив RAID 10 из созданных разделов с помощью команды:

Сразу после этого будет создан массив /dev/md0 и будет запущен процесс перестроения данных на дисках. Для отслеживания текущего статуса процесса введите:![]()

Пока процесс перестроения данных не будет завершен, скорость работы дискового массива будет снижена.

После установки операционной системы и Bitrix24 на созданный массив мы запустили стандартный тест и получили следующие результаты:

![]()

С аппаратным RAID

Прежде чем сервер сможет использовать единое дисковое пространство RAID-массива, необходимо выполнить базовую настройку контроллера и логических дисков. Сделать это можно двумя способами:

- при помощи внутренней утилиты контроллера,

- утилитой из операционной системы.

![]()

Утилита позволяет не только управлять настройками контроллера, но и логическими устройствами. Инициализируем физические диски (вся информация на дисках при инициализации будет уничтожена) и создадим массив RAID-10 с помощью раздела Create Array. При создании система запросит желаемый размер страйпа, то есть размер блока данных за одну I/O-операцию:

- больший размер страйпа идеален для работы с файлами большого размера;

- меньший размер страйпа подойдет для обработки большого количества файлов небольшого размера.

Важно — размер страйпа задается только один раз (при создании массива) и это значение в дальнейшем изменить нельзя.

![]()

Сразу после того, как контроллеру отдана команда создания массива, также, как и с программным RAID, начинается процесс перестроения данных на дисках. Этот процесс работает в фоновом режиме, при этом логический диск становится сразу доступен для BIOS. Производительность дисковой подсистемы будет также снижена до завершения процесса. В случае, если было создано несколько массивов, то необходимо определить загрузочный массив с помощью сочетания клавиш Ctrl + B.

После того как статус массива изменился на Optimal, мы установили Bitrix24 и провели точно такой же тест. Результат теста:

![]()

Сразу становится понятно, что аппаратный RAID-контроллер ускоряет операции чтения и записи на дисковый носитель за счет использования кэша, что позволяет быстрее обрабатывать массовые обращения пользователей.

Управление контроллером

Непосредственно из операционной системы управление контроллером производится с помощью программного обеспечения, доступного для скачивания с сайта производителя. Доступны варианты для большинства операционных систем и гипервизоров:

- Debian,

- Ubuntu,

- Red Hat Linux,

- Fedora,

- SuSE Linux,

- FreeBSD,

- Solaris,

- Microsoft Windows,

- Citrix XenServer,

- VMware ESXi.

С помощью указанных утилит можно, не прерывая работу сервера, легко управлять логическими и физическими дисками. Также можно задействовать такой полезный функционал, как «подсветка диска». Мы уже упоминали про пятый кабель для подключения SGPIO — этот кабель подключается напрямую в бэкплейн (от англ. backplane — соединительная плата для накопителей сервера) и позволяет RAID-контроллеру полностью управлять световой индикацей каждого диска.

Следует помнить, что бэкплэйны поддерживают не только SGPIO, но и I2C. Переключение между этими режимами осуществляется чаще всего с помощью джамперов на самом бэкплэйне.

Каждому устройству, подключенному к аппаратному RAID-контроллеру Adaptec, присваивается идентификатор, состоящий из номера канала и номера физического диска. Номера каналов соответствуют номерам портов на контроллере.

Замена диска — штатная операция, впрочем, требующая однозначной идентификации. Если допустить ошибку при этой операции, можно потерять данные и прервать работу сервера. С аппаратным RAID-контроллером такая ошибка является редкостью.

Делается это очень просто:

-

Запрашивается список подключенных дисков к контроллеру:

Например, на платформах Supermicro штатная работа диска — зеленый или синий цвет, а «подсвеченный» диск будет моргать красным. Перепутать диски в этом случае невозможно, что позволит избежать ошибки из-за человеческого фактора.

![]()

Настройка кэширования

Теперь пару слов о вариантах работы кэша на запись. Вариант Write Through означает, что контроллер сообщает операционной системе об успешном выполнении операции записи только после того, как данные будут фактически записаны на диски. Это повышает надежность сохранности данных, но никак не увеличивает производительность.

Чтобы достичь максимальной скорости работы, необходимо использовать вариант Write Back. При такой схеме работы контроллер будет сообщать операционной системе об успешной IO-операции сразу после того, как данные поступят в кэш.

Важно — при использовании Write Back настоятельно рекомендуется использовать BBU или ZMCP-модуль, поскольку без него при внезапном отключении электричества часть данных может быть утеряна.

Настройка мониторинга

Вопрос мониторинга статуса работы оборудования и возможности оповещения стоит достаточно остро для любого системного администратора. Для того чтобы настроить «связку» из Zabbix и RAID-контроллера Adaptec рекомендуем воспользоваться перечисленными решениями.

Зачастую требуется отслеживать состояние контроллера напрямую из гипервизора, например, VMware ESXi. Задача решается с помощью установки CIM-провайдера с помощью инструкции Microsemi.

Прошивка

Необходимость прошивки RAID-контроллера возникает чаще всего для исправления выявленных производителем проблем с работой устройства. Несмотря на то, что прошивки доступны для самостоятельного обновления, к этой операции следует подойти очень ответственно, особенно если процедура выполняется на «боевой» системе.

Если нашему клиенту требуется сменить версию прошивки контроллера, то ему достаточно создать тикет в нашей панели управления. Системные инженеры выполнят перепрошивку RAID-контроллера до требуемой версии в указанное время и сделают это максимально корректно.

Важно — не следует выполнять перепрошивку самостоятельно, поскольку любая ошибка может привести к потере данных!

Заключение

Использование аппаратного RAID-контроллера оправдано в большинстве случаев, когда требуется высокая скорость и надежность работы дисковой подсистемы.

Системные инженеры Selectel бесплатно выполнят базовую настройку дискового массива на аппаратном RAID-контроллере при заказе сервера произвольной конфигурации. В случае, если потребуется дополнительная помощь с настройкой, мы будем рады помочь в рамках нашей услуги администрирования. Также мы подготовили для наших читателей небольшую памятку по командам утилиты arcconf.

Читайте также: