Efi network timeout vmware что делать

Обновлено: 07.07.2024

esxcli network nic ring current set –n vmnic0 –r <value> -t <value> The settings above apply to the pNIC. Equally, or even more, important are the ring buffer values in the guest OS. A pre-requisite of tuning the in-guest buffer values is the usage of the VMXNET3 virtual network adapter. Looking at the Windows OS, the values are not present by default but are changeable using the pre-defined values.

DRSS array of int Number of RSS Queues to create on the Default Queue RSS pool. [Default: 4, Max: 16]

RSS array of int Number of RSS queues to create in netqueue RSS pool. [Default: 4, Max: 16]

debug uint Debug msglevel: Default is 0 for Release builds

disable_dcb bool Disable the DCB support. 0: enable DCB support, 1: disable DCB support. [Default: 1]

disable_fwdmp bool For debug purposes, disable firmware dump feature when set to value of 1. [Default: 0]

disable_geneve_filter bool For debug purposes, disable Geneve filter support feature when set to value of 1. [Default: 0]

disable_geneve_oam_support bool For debug purposes, disable Geneve OAM frame support feature when set to value of 1. [Default: 1]

disable_q_feat_pair bool For debug purposes, disable queue pairing feature when set to value of 1. [Default: 0]

disable_q_feat_preempt bool For debug purposes, disable FEAT_PREEMPTIBLE when set to value of 1. [Default: 0]

disable_roce bool Disable the RoCE support. 0: Enable RoCE support, 1: Disable RoCE support. [Default: 1]

disable_shared_rings bool Disable sharing of Tx and Rx rings support. 0: Enable sharing, 1: Disable sharing. [Default: 0]

disable_tpa bool Disable the TPA(LRO) feature. 0: enable TPA, 1: disable TPA. [Default: 0]

disable_vxlan_filter bool For debug purposes, disable VXLAN filter support feature when set to value of 1. [Default: 0]

enable_default_queue_filters int Allow filters on the default queue. -1: auto, 0: disallow, 1: allow. [Default: -1, which enables the feature when NPAR mode and/or VFs are enabled, and disables if otherwise]

enable_dr_asserts bool For debug purposes, set to 1 to enable driver assert on failure paths, set to 0 to disable driver asserts. [Default: 0]

enable_geneve_ofld bool Enable Geneve TSO/CSO offload support. 0: disable Geneve offload, 1: enable Geneve offload. [Default: 1]

enable_host_dcbd bool Enable host DCBX agent. 0: disable host DCBX agent, 1: enable host DCBX agent. [Default: 0]

enable_r_writes bool For debug purposes, set to 1 to enable r writes, set to 0 to disable r writes. [Default: 0]

enable_vxlan_ofld bool Enable VXLAN TSO/CSO offload support. 0: disable, 1: enable. [Default: 1]

force_hwq array of int Max number of hardware queues: -1: auto-configured, 1: single queue, 2..N: enable this many hardware queues. [Default: -1]

max_vfs array of int Number of Virtual Functions: 0: disable, N: enable this many VFs. [Default: 0]

multi_rx_filters int Define the number of RX filters per NetQueue: -1: use the default number of RX filters, 0,1: disable use of multiple RX filters, so single filter per queue, 2..N: force the number of RX filters to use for a NetQueue. [Default: -1]

psod_on_tx_tmo bool For debug purposes, set to 1 to force PSOD on tx timeout, set to 0 to disable PSOD on tx timeout. [Default: 0]

[root@vm-hostgen10-1:/tmp] esxcfg-module -s "enable_vxlan_ofld=0" bnxtnet

esxcli system settings advanced set -o /Net/Vmxnet3SwLRO -i 0

esxcli system settings advanced set -o /Net/Vmxnet3HwLRO -i 0

esxcli software vib install -d /tmp/VMW-ESX-6.7.0-bnxtnet-216.0.42.4-of fline_bundle-15092352.zip

Официальная полноценная поддержка виртуальных машин с интерфейсом Unified Extensible Firmware Interface (UEFI) в VMware Workstation появилась начиная с версии 10. Однако и в VMware Workstation 8.x or 9.x существовала (официально не поддерживаемая) возможность запуска виртуальной машины на базе UEFI .

В этой статье мы покажем, как в VMware Workstation создать виртуальную машину с интерфейсом UEFI и как установить на нее ОС (на примере Windows 8.1 x64).

Несмотря на то, что VMware Workstation 10 заявлена как платформа с полноценной поддержкой UEFI, графического интерфейса для переключения между BIOS и UEFI нет (как и в предыдущих версиях).

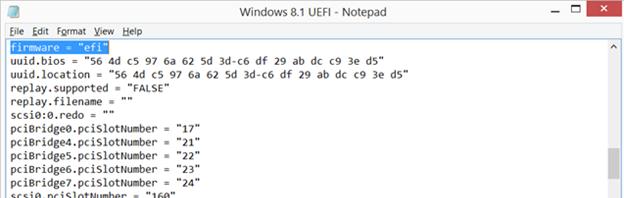

Создайте мастером новую чистую виртуальную машину (не включайте ее!). Итак, чтобы виртуальная машина вместо BIOS работала на UEFI среде, необходимо открыть конфигурационный файл виртуальной машины (файл с расширением *.vmx) и добавить строку:

Совет. Значения ключа должно быть в нижнем регистре, в противном случае виртуальная машина автоматически переключится в BIOS-режим.

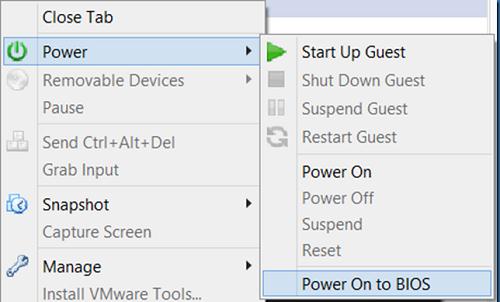

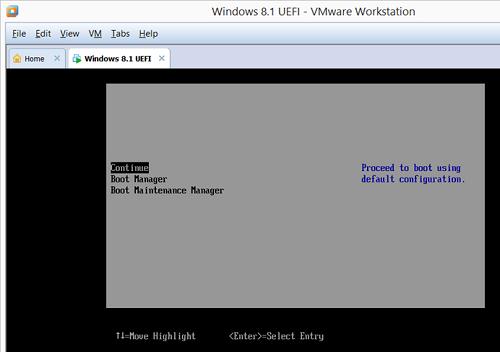

После этого включаем виртуальную машину со входом в BIOS (Power -> Power On to BIOS).

Для установки Windows 8.1 на виртуальной машине VMWare с UEFI понадобится оригинальный iso образ или специально подготовленный загрузочный образ (как создать установочную флешку с Windows 8 для установки в режиме UEFI).

Совет. Установочный диск с Windows 7 для установки на UEFI можно создать так.Выполните стандартную процедуру установки Windows 8.1.

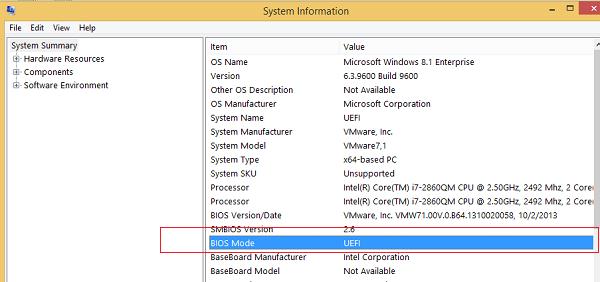

Примечание. Установщик автоматически сконвертируем диск в стиль GPT и создаст необходимые разделы: системный раздел EFI (EF00) с загрузчиком (100 мб с ФС FAT32), Recovery, MSR и раздел под данные. Подробнее про разделы здесь.После окончания установки Windows 8.1 (x64), выполните команду msinfo32.exe (Сведения о системе) и убедитесь, что тип BIOS (BIOS Mode) – UEFI.

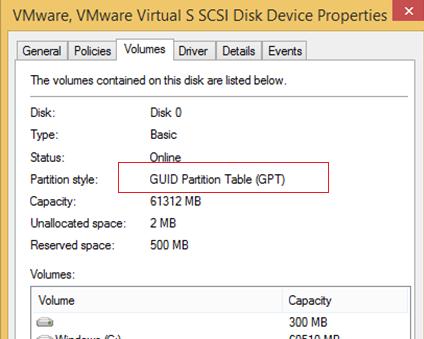

В свойствах же виртуального диска будет указано, что используется таблица разделов GUID Partition Table (GPT), т.к. MBR на UEFI в наивном режиме не поддерживается (только в режиме совместимости).

Итак, мы показали, как включить поддержку UEFI на виртуальной машине VMware, и установить на нее 64-битную версию Windows 8.1.

- VMware Technology Network

- :

- Global

- :

- Russian

- :

- Russian Discussions

- :

- Отказ сети внутри виртуальной машины.

- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

Столкнулся со следующей проблемой – на ESX-узле (4.0.0, build 208167) у гостевых операционных систем Windows 2003/2008 периодически пропадает сеть, т.е. IP-адрес и сетевая карта в системе есть и нормально внутри машины отображаются, но пинги на другие хосты с этих виртуальных машин не идут, так же не идут пинги и на них извне. В Security настройках виртуального свича опции MAC Address Changes и Forged Transmits установлены в положение Accept. Сами виртуальные машины и ESX-узел не перезагружались. Сеть плоская, все находится в одной подсети, никаких VLAN не применяется. Помогает в данной ситуации удаление сетевого адаптера и потом создание его заново. Надеюсь на вашу помощь в решении данной проблемой.

VTsukanov- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

на хосте агрегация линков используется? Если да то как настроено (со сотороны свича и со стороны хоста)?

Какой тип сетевого адаптера внутри vm используется?

vmtools стоят и актуальной версии?

Denor- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

На ESX-ноде в настройках свича стоит "Route based on the originating virtual port ID". В виртуальной машине используется один стандартный сетевой адаптер E1000, т.е. никакой особой настройки агрегации портов нет. Tools стоят актуальной версии.

VTsukanov- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

т.е. никакой особой настройки агрегации портов

агрегация портов подразумевалась на хосте. Сколько физических адаптеров у этого виртуального свича?

. на проблемной ESX-ноде есть предупреждение.

Похоже на железки . У вас эта проблемная нода в HCL[/url] попадает?

На что то более конкретное хост в логах ругается?

Denor- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

Тоже думал на железо, но вроде все совместимое - Blade ProLiant BL460c G6, сторадж HP MSA 2312sa. Агрегация портов как на рисунке ware01.jpg. Поскольку система хитрая-бэйдовая, как таковых физических nic-ов нет, а так можно сказать что в сервер подключено две 2-х портовых сетевых карты. Логи снять не удается - генерится ошибка. Предпринял попытку перезагрузить сервис командой "service mgmt-vmware restart", как итог сервер вылетел из Inventory, правда машины на этом ESX работают. Думаю, выключить виртуалки и перезагрузить ESX.

VTsukanov- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

Внешне HCL отпадает. C вашими железками не работал, но из общих соображений проапгрейдил бы и firmware, и сам ESX (зрительно помню что дрова на bnx2x в апдейтах проскакивали).

Я так понимаю что вы 802.3ad группу из ваших адаптеров не делали ни на стороне свича ни на стороне хоста (приблизительно так[/url])?

А в Prod2 ситуация с исчезновениями таже?

Denor- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

Не знаю как будет работать дальше, но вечером проделал следующее - выключил все виртуальные машины на проблемном ESX, далее перезагрузил саму ESX-ноду. После перезагрузки смог подключиться к перезагруженному ESX и стал внимательно изучать настройки. Оказалось, что мой предшественник включал "MAC Address Changes" в установку "Reject" не только в настройках vSwitch, но и у VM Network, VMkernel, Service Console. Исправил все на "Accept", завел обратно в кластер, заработало, пока мониторю. А так, вроде firmware свежее, агрегацию группы портов по 802.3ad не настраивал. Сеть Prod2 служит исключительно для резервирования Service Console. Что касается Upgrade ESX, то хочется сразу обновиться до версии 4.1, кстати, в связи с этим вопрос - переход будет бесплатным? У меня лицензии "vCenter Server 4 Foundation" и "vSphere 4 Advanced". И почему получил ошибку "ESX Configuration Issues. Cannot synchronize host. Operation timeout."?

Так же появился еще один вопрос - при подключении iSCSI (хранилище MSA2312i) возникает таккой баг - первый LUN видится, но из GUI не фоматируется пишет "Failed to get disk partition information", последующие LUN подключаются нормально. Помогает в данной ситуации подключение из командной строки. Хотелось бы знать - это ошибка ESX или проблемы с MSA2312i?

VTsukanov- Mark as New

- Bookmark

- Subscribe

- Mute

- Email to a Friend

Не знаю, до нее еще не близко, кто то из лиц более ближних к vmware может ответить.

И почему получил ошибку "ESX Configuration Issues. Cannot synchronize host. Operation timeout."?

Потому что VC не смог договориться с менаджмент агентом (могла быть и в сетке проблема)

> Хотелось бы знать - это ошибка ESX или проблемы с MSA2312i?

Такое бывает (что приходится ручками форматировать) кто виноват не разбирался, дальше LUN живет нормально?

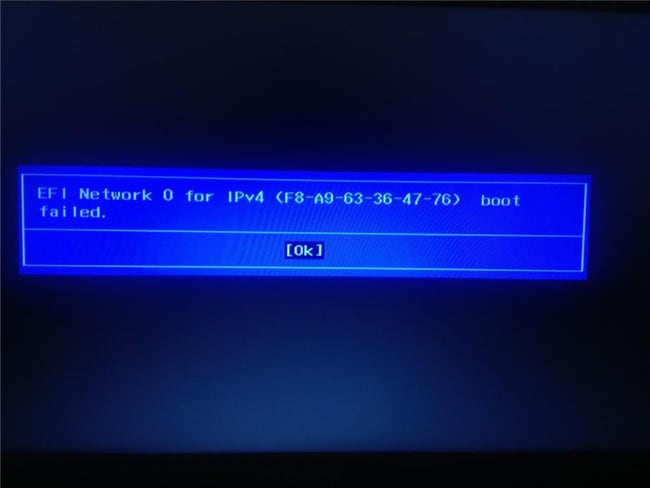

Когда возникают ошибки в операционной системе, их в большинстве случаев относительно легко решить. В крайнем случае, всегда можно переустановить дистрибутив, что приведет к полному исцелению компьютера (если проблема программная). Другое дело, когда пользователь сталкивается с проблемами на аппаратном уровне и с программами, которые обеспечивают работу и взаимодействие между собой оборудования. К одной из таковых, например, относится ошибка EFI Network 0 for IPv4 boot failed, что делать с ней не никто не сможет разобраться без обращения к соответствующим информационным источникам.

Что это за ошибка EFI Network 0 for IPv4 boot failed на ноутбуках Lenovo

Ошибка EFI Network 0 for IPv4 boot failed на ноутбуках Lenovo

Ошибка при загрузке ноутбука Lenovo

Соответствующая ошибка может появиться в виду многих причин, например, в результате перепрошивки BIOS или неаккуратной работы самого пользователя в соответствующем «инженерном меню».

Стартовый экран загрузки ноутбуков Lenovo

Здесь есть несколько вариантов. Вначале владельцам ноутбуков Lenovo следует попробовать сбросить настройки BIOS по умолчанию. Делается это так:

- Включить ноутбук;

- Дождаться стартового экрана загрузки (не ОС, а именно компьютера (обычно, на нем изображен логотип Lenovo);

- На секунду зажать клавиши Fn+F2.

На ряде ноутбуков Lenovo одновременное нажатие этих двух клавиш приводит к сбросу настроек BIOS. Если это произошло, то после очередной перезагрузки начнет загружаться операционная система.

BOIS ноутбуков Lenovo

Если соответствующие действия не привели к нужному результату, следует выполнить следующее:

- Включить ноутбук;

- На стартовом экране загрузки нажать на F2 или Del (зависит от модели ноутбука);

- В открывшемся «инженерном меню» перейти на вкладку «Boot»;

- Выбрать пункт «Boot Mode» и нажать Enter;

- В отобразившемся списке выбрать «Legacy»;

- Перейти на вкладку «Exit»;

- Выбрать «Save and reboot».

После того, как ноутбук перезагрузится, должна начать загружаться операционная система, а ошибка «EFI: Network 0 for IPv4 boot failed» больше не должна беспокоить.

Если и эти действия не привели к нужному результату, тогда в BIOS потребуется еще и найти пункт «1 st boot device», который потребуется развернуть и в нем выбрать HDD + (название жесткого диска). Таким образом, будет сообщено компьютера то, с какого устройства ему следует загружаться в первую очередь. Поэтому он перестанет пытаться загрузиться из сети, в которой у пользователя, по понятным причинам, отсутствуют загрузчик и система.

Следует заметить, что пункты и вкладки в BIOS могут иметь другие названия (это зависит от модели компьютера).

Сегодняшняя статья будет посвящена владельцам ноутбуков Lenovo. Хотя, полезного в статье будет много и для тех у кого нет ноутбука Lenovo…

.jpg)

Однако производители BIOS зашили в своих микропрограммах разного рода функции, которые собственно не понятно как использовать.

Ошибка вида EFI Network 0 For IPv4 Boot Failed возникает как правило в результате неопытного использования BIOS, когда определенные атрибуты, отвечающие за загрузку компьютера были изменены, причем на неправильные значения. Также, подобное значение могло возникнуть в результате перепрошивки BIOS на более свежую версию…

Для того чтобы устранить ошибку EFI Network 0 For IPv4 Boot Failed, необходимо выключить компьютер. Далее мы снимаем боковую крышку системного блока и находим на материнской плате небольшую круглую батарейку. Вытаскиваем ее, аккуратно поддевая чем-нибудь плоским.

Подождите десять секунд и вставляйте батарейку обратно.

Включайте компьютер и заходите в BIOS. В разделе отвечающим за загрузку, который называется Boot. находим параметр который отвечает за последовательность загрузки устройств. Вам необходимо выставить правильную очередь загрузки устройств.

Первым у нас должен стартовать жесткий диск (винчестер), а за ним должен идти привод. Собственно все. Другие устройства выставлять не надобности и пустые строки можно заменить на значение Отключено.

Наша "тестовая лаборатория" включает в себя:

- Маршрутизатор Mikrotik 951G-2HnD с RouterOS v6.39 (stable)

- Сетевое хранилище Western Digital My Cloud EX2

Некоторых файлов, например kolibri.iso (образ Kolibri OS) в архиве не будет, т.к. их можно без труда найти и скачать в интернете, также в архиве не будет содержимого папки winpe (т.к. все эти файлы есть на любом установочном диске с Windows и включать их в состав архива я не вижу смысла). А вот на остальных мы остановимся подробнее.

Для чего они? После загрузки PXELinux на устройство начинается поиск дополнительных файлов и библиотек, т.е. устройство пытается подключиться к TFTP серверу, указанному в опциях отдаваемых DHCP сервером и запросить у него, например, файл ldlinux.c32, так вот TFTP сервер должен знать о реальном местоположении файла, чтобы отдать его, например в нашем случае он лежит в disk1/tftpboot/ldlinux.c32. Честно говоря я не экспериментировал, можно ли задать соответствие не отдельным файлам, а папкам или файлам по маскам, поэтому на всякий случай сделал правила для всех файлов на TFTP сервере. После того как мы прописали правила необходимо настроить наш DHCP сервер.

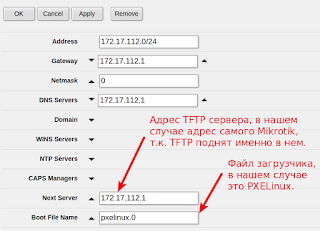

Переходим на закладку IP -> DHCP Server -> Networks в Mikrotik, выбираем нашу подсеть и делаем там следующие настройки:

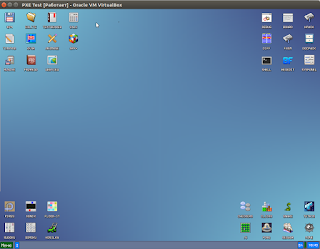

На этом приготовления к первому запуску закончены. Можно брать любой ПК и пробовать загрузиться по сети. Для меня наиболее простым решением было создание отдельной виртуальной машины в VirtualBox и настройка ее на загрузку по сети. В результате, если все сделано правильно, вы увидите вот такую вот симпатичную менюшку PXELinux:

Сама конфигурация этого меню находится в файле disk1/tftpboot/ubuntu-installer/amd64/boot-screens/menu.cfg . Если мы попробуем загрузиться в Kolibri OS для примера, то заметим что передача казалось бы маленького (всего 66.5 Mb) образа kolibri.iso через TFTP даже по гигабитной сети займет довольно продолжительное время:

Посмотрите как реализована в конфигурации (menu.cfg) загрузка того же Ubuntu LiveCD:

Здесь ядро vmlinuz.efi и рамдиск initrd.lz у нас грузятся по TFTP, а вот содержимое rootfs уже берется с NFS ресурса (благо Ubuntu так умеет). Порядок создания папки ubuntu16.04_live_amd64 на NFS ресурсе описан тут.

Ну или если вкратце, то я создал отдельную папку на WDMyCloud EX2, разрешил доступ к ней по NFS:

/nfs и просто скопировал необходимые файлы с LiveCD с Ubuntu в нее:

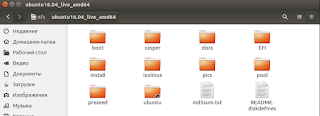

В результате содержимое папки ubuntu16.04_live_amd64 у нас полностью идентично корню LiveCD с Ubuntu:

Просто? Просто. Теперь пробуем загрузиться по PXE выбрав в меню LiveCD:

Кстати, в меню iPXE SuperBoot от bradgillap есть пункт External Linux Installs. Фактически это внешнее (т.е. находящееся в интернет) загрузочное меню, которое позволяет вам установить некоторые Linux-based ОС, а также загрузить некоторые варианты LiveCD онлайн. Т.е. для того чтобы установить тот же Ubuntu, фактически достаточно только соответствующим образом сконфигурировать DHCP . Все остальное, даже на этапе загрузочного меню может быть взято из сети.

Читайте также: