Что значит super в видеокартах nvidia

Обновлено: 04.07.2024

Транскодирование видео — очень ресурсоемкая задача. Иногда выполнять её за счет ЦП довольно дорого, и, чтобы сэкономить ресурсы, используют графические ускорители. Особенно это актуально в ОТТ вещании, когда на один канал приходится множество профилей.

В этой статье мы рассмотрим основные преимущества и недостатки этих решений на примере технологии QuickSync от Intel и NVENC от Nvidia. Интересно, что формально являясь конкурентами в сфере кодирования, обе компании развиваются параллельно и даже сотрудничают в производстве новых чипов.

Для начала определимся с графикой, которую будем сравнивать. Рассматривать будем только стабильные решения для работы 24/7: в телевещании иначе нельзя. У Intel все просто: возьмем последнее поколение Xeon процессоров Coffee Lake со встроенной графикой Intel® UHD Graphics P630, процессор Intel® Xeon® E-2246G. У Nvidia же с выбором видеокарты для транскодирования все немного сложнее. Мы выбрали Quadro RTX 4000 (8GB) — это серверный аналог GeForce RTX 2070 Super (8GB). В отличие от RTX, она не имеет официальных ограничений в одновременной обработке больше 3 потоков. Это ограничение можно снять, установив созданный умельцами патч, но, как мы уже отметили, будем рассматривать только проверенные и официальные решения. Более ранние версии видеокарт отмели сразу: они проигрывают при работе с HEVC, так как не имеют возможности кодирования B-кадров.

Теперь подберем платформы с выбранными графическими решениями.

Итак, перейдем к цифрам. Проведем нагрузочный тест на максимально возможное количество транскодируемых каналов (режим fastest) на одном сервере.

В этом сравнении Nvidia в два раза производительнее Intel при AVC транскодировании и практически не уступает в кодировании HEVC.

Теперь мы знаем максимально возможное количество каналов FHD (1920*1080) разрешения на один сервер со встроенной графикой Intel и видеокартой Nvidia, а значит, сможем вычислить цену за 1 канал FHD.

Получается, что для AVC по цене разницы нет. В случае c HEVC Nvidia гораздо дороже по цене за канал на платформу, если рассчитывать максимальное количество каналов (то есть использовать самые быстрые алгоритмы кодирования, жертвуя качеством).

На этом моменте прервем вычисления и перейдем к вопросу о качестве, так как гораздо честнее будет сравнить одинаково приемлемое качество, а не получаемое в быстрых режимах.

Рассмотрим еще один немаловажный вопрос — качество сжатия видео. Ведь нет никакого смысла в количестве каналов, если их невозможно смотреть.

Ниже представлен график сравнения качества по метрике PSNR: Intel AVC с исходным потоком (синяя линия) / Nvidia AVC с исходным потоком (красная линия).

Исходя из графика видим, что качество получаемых потоков близкое по значению PSNR. Давайте сравним с помощью VMAF метрики.

В следующем графике рассмотрим сравнение Intel HEVC с исходным потоком (синяя линия) / Nvidia HEVC с исходным потоком (красная линия).

По графику видим, что наше сравнение было не совсем корректным, так как максимальное количество кодируемых каналов Nvidia =14, и их качество почти на 2 dB выше чем, 13 каналов на Intel.

Поэтому мы провели еще несколько изменений, и при максимально возможном качестве на Nvidia и на Intel в режиме GAcc (GPU Accelerated — когда кодирование происходит не только на графике, но подключается и ЦП) получили следующий результат. Intel HEVC GAcc с исходным потоком (синяя линия) / Nvidia HEVC с исходным потоком (красная линия):

Качество кодирования практически совпало, но производительность обеих систем упала в разы. Теперь Nvidia кодировала всего 4 канала FHD HEVC, а Intel всего 2.

Пересчитаем цену за канал исходя из новых данных:

- 1500/2=750 за один транскодируемый HEVC канал на Intel;

- 3000/4=750 за один транскодируемый HEVC канал на Nvidia.

И, собственно, мы получили то же соотношение по цене за канал, что и в ситуации с AVC.

Рассмотрим еще один важный момент при обслуживании рабочей системы: это потребляемая мощность платформы. Из наших тестов при максимальной нагрузке платформ транскодированием мы получили следующие значения.

Получается, что при равно выполняемой работе платформа с Nvidia потребляет на 50 Вт больше.

При больших объемах транскодируемых каналов, часто возникает вопрос размещения серверов.

Для Intel предусмотрены специальные платформы blade-сервер, где в одном 3U сервере умещается от 8 до 14 лезвий (полноценных серверов, измененного форм-фактора). В одной 3U платформе можно транскодировать до 168 FHD AVC каналов. Если же использовать не blade-сервер, а обычный rack-сервер, то на такое количество каналов понадобится высота в 14U.

Для Nvidia в этом плане немного сложнее: сами карты занимают дополнительное место в платформе. Можно размещать по 1 карте в 1U сервер, тогда занимаемое место на 168 FHD AVC каналов будет составлять 7U. Можно на одной платформе разместить несколько видеокарт, что позволяет сэкономить на цене за платформы, но выиграть место вряд ли получится: чтобы разместить 2–3 карты, потребуется платформа 3, а то и 4U.

Помимо транскодирования видео, существуют такие задачи, как декодирование видео для визуального мониторинга и кодирование с карты захвата SDI/NDI. В таких случаях решение Intel подходит лучше: эти задачи зачастую не объемные, а значит и использовать все ресурсы Nvidia не получится. Даже если нужно кодировать SDI, то скорее всего это будет несколько каналов — сложно найти проект, где требуется кодировать до 24 сигналов. Кроме того, в 1U платформу довольно сложно уместить SDI карту захвата PCI и видео карту PCI, нужно либо выбирать платформу с другой высотой, либо подбирать платформу с достаточным местом для двух карт, что встречается довольно редко.

Имеется и техническое ограничение. Процесс декодирования менее затратный, чем транскодирование, и в теории на Nvidia можно визуально мониторить больше 24 каналов FHD AVC. На самом деле, количество каналов ограничено до 8, так как невозможно передать больший объем декодированного (несжатого) видео через PCI шину. С Intel же такой проблемы нет, так как графика встроена в процессор.

Справедливости ради стоит отметить, что Nvidia более привлекательна для решения транскодирования контента высокого разрешения UHD, поскольку на одной карте можно развернуть многопрофильное транскодирование. Intel же не может транскодировать UHD контент в несколько профилей на одном графическом ядре, и приходится включать систему распределения потока между серверами — такое решение называется распределенным транскодированием.

После сравнения частного кейса можно выделить основные преимущества обоих решений.

Дисклеймер: данный автор не считает себя убежденным профессионалом и является профаном во многих темах. Не стоит слепо прислушиваться к мнению автора! Все, что будет здесь рассказано, основано на отобранной информации и личном опыте.

Категорически приветствую!

Недавно Nvidia выпустила "рефреш" видеокарт поколения Turing , которые отличаются от первых ревизий улучшенными чипами, повышенными тактовыми частотами, увеличенным числом CUDA , тензорных и RT-ядер , а также более быстрыми чипами памяти. Карты получили новое имя - RTX Super .

Наверное для многих "Super" означает что-то крутое и мощное или даже что-то очень навороченное. И в нашем случае так можно назвать, к примеру, самую мощную видеокарту. Но маркетологи Nvidia посчитали нужным закрепить данную приставку для всей обновленной линейки RTX, чтобы как-то положительно повлиять на продажи. Довольно смело, учитывая, что продажи первой линейки RTX не самые успешные для компании. В этом возможная причина отказа от приписки "Ti".

Чем могут похвастаться?

По заверению производителя, обновленная линейка теперь гарантированно лучше флагманов прошлого поколения (Pascal) и быстрее первой ревизии в среднем на 15% за аналогичную цену. Ну хоть цены оставили прежними.

На деле все вышло довольно интересно.

Позитивные впечатления могут вызвать RTX 2060S и RTX 2070S . Первый получил дополнительные 2Гб видеобуфера и в среднем на 10% быстрее своего предшественника. Однако рекомендуемая цена повысилась на $50 (теперь стоит около $400).

RTX 2070S получил самый высокий прирост производительности среди обновленной линейки — в среднем около 20%. Цена сохранилась около $500.

А вот RTX 2080S разочаровал многих обзорщиков. Прирост производительности оказался самым мизерным по сравнению с другими новинками — около 5% в среднем. К тому же скорость чипов памяти у данной карты была немного замедленна (15.5 Гбит/с вместо 16 Гбит/с).

Если сравнивать с младшими решениями, то RTX 2080S и RTX 2080 больше не выгодны по цена/производительность, не говоря о том, что RTX 2080S будет трудно конкурировать по текущей цене даже с прошлым RTX 2080.

Вообще, довольно странная ситуация получается с RTX 2080S. Если младшие видеокарты по производительности весьма близки к старшим моделям первой ревизии, то последний даже и близко не подходит к производительности RTX 2080 TI . Оно и логично. Производитель не собирался выпускать конкурента главному потребительскому флагману, но сделать рефреш все-таки было необходимо. Поэтому, на мой взгляд, карта получилась не на столько производительной как предполагалось изначально.

Есть также теория, что производитель выпустил обновленную линейку для конкуренции с видеокартами RX 5000 , за неимением возможности выпустить что-то новое в ближайшее время. Учитывая, что RX 5700 и RX 5700 XT (с использованием адекватного охлаждения) вполне успешно могут конкурировать с RTX 2060S и RTX 2070S, то против будущих флагманов от Radeon, выпуск RTX 2080S очень сомнителен.

Но пока этого не случилось, "зеленые" вполне могут снимать сливки, пока на рынке комплектующих флагман только один, свой.

Если говорить на эмоциях, то Nvidia плюнули в лицо абсолютно всем. Сначала продавая новые видеокарты по "заоблачным" ценам, а меньше чем через год выпустить рефреши, которые по производительности быстрее. Особенно обидно за владельцев RTX 2060, которые имеют только 6гб видеопамяти, чего в будущих играх вряд ли будет хватать.

Некоторые считают, что новые карты по идее должны были быть изначально такими. Но без конкуренции со стороны Radeon мы бы вряд ли узнали наверняка.

Из всех новинок, на мой взгляд, выделяется только RTX 2070S, который получил самый высокий прирост производительности и выглядит самым привлекательным, чем остальные решения.

Компания NVIDIA, как и ожидалось, сегодня официально представила несколько обновлённых версий своих видеокарт семейства Turing, которые получили к своим названиям приставку «Super». Всего было представлено три новые видеокарты: GeForce RTX 2080 Super, GeForce RTX 2070 Super и GeForce RTX 2060 Super, и нацелены они на конкуренцию с готовящимися видеокартами AMD поколения Navi.

Все три новинки отличаются от «стандартных» версий, представленных в прошлом году, более мощными графическими процессорами, а также некоторыми изменениями в подсистеме памяти. За счёт этого, по словам NVIDIA, получилось добиться довольно большого прироста производительности: вплоть до 24 % в отдельных случаях по сравнению с прошлогодними моделями. В среднем же прирост составляет около 15 %, что для «рефреша» довольно внушительно.

Видеокарта GeForce RTX 2060 Super построена на графическом процессоре Turing TU106-410 с 2176 ядрами CUDA, 272 тензорными ядрами и 34 RT-ядрами. Тактовые частоты графического процессора составляют 1470/1650 МГц, а уровень тепловыделения повысился до 175 Вт. Однако куда важнее, что новая версия GeForce RTX 2060 получила 8 Гбайт памяти GDDR6 вместо 6 Гбайт. Вместе с объёмом увеличилась и ширина шины памяти — со 192 до 256 бит. Эффективная частота памяти осталась прежней — 14 ГГц, а общая пропускная способность подсистемы памяти выросла до 448 Гбайт/с.

Видеокарта NVIDIA GeForce RTX 2070 Super будет построена на графическом процессоре Turing TU104-410, который обладает 2560 ядрами CUDA, 320 тензорными ядрами и 40 RT-ядрами. Тактовые частоты чипа составят 1605/1770 МГц. Новая видеокарта как и её предшественница получит 8 Гбайт памяти GDDR6 с эффективной частотой 14 ГГц и пропускной способностью 448 Гбайт/с.

В свою очередь GeForce RTX 2080 Super получила графический процессор TU104-450 с 3072 ядрами CUDA, 384 тензорными ядрами и 48 RT-ядрами. Его частоты равны 1650/1815 Мгц. Дополняют данный чип 8 Гбайт памяти GDDR6 с эффективной частотой 15,5 ГГц (было 14 ГГц). В результате с прежней 256-битной шиной пропускная способность памяти составила ровно 500 Гбайт/с.

Что касается производительности, то NVIDIA предпочитает сравнивать новинки с представителями прошлого поколения своих видеокарт. Так, старшая GeForce RTX 2080 Super, по словам компании, будет быстрее чем Titan Xp, средняя GeForce RTX 2070 Super опережает GeForce GTX 1080 Ti и до 24 % обходит RTX 2070, а младшая GeForce RTX 2060 Super опережает GeForce GTX 1080 и оказывается до 22 % быстрее обычной RTX 2060. Теоретический уровень производительности новинок составляет 7, 9 и 11 Тфлопс соответственно, причём как в операциях на целых числах, так и с плавающей запятой (INT32 и FP32).

С выходом видеокарт GeForce RTX 2080 Super и RTX 2070 Super компания NVIDIA прекратит выпуск их предшественников в лице GeForce RTX 2080 и RTX 2070 соответственно. В свою очередь обычная GeForce RTX 2060 в ассортименте компании останется как самая доступная видеокарта с поддержкой аппаратного ускорения трассировки лучей. Её рекомендованная цена, напомним, составляет $349.

Рекомендованная стоимость новой GeForce RTX 2060 Super в России составит 32 990 рублей и $399 в США, а в продажу она поступит 9 июля. В тот же день начнутся продажи и GeForce RTX 2070 Super по цене 39 990 рублей ($499 в США). Наконец, 23 июля выйдет видеокарта GeForce RTX 2080 Super за 56 990 рублей на отечественном рынке и за $699 в США.

Видеокарты различаются сериями видеочипов, в каждой серии есть по три-пять графических процессоров. На базе этих процессоров выпускают десятки версий видеокарт — с разным охлаждением, количеством видеопамяти и разгоном. Поможем разобраться в этом хаосе.

AMD или Nvidia?

Принципиальной разницы между производителями нет. До конца 2020 года видеокарты Nvidia выдавали более реалистичную графику благодаря технологии трассировки лучей, но сейчас она есть и у AMD.

В продаже не найти заводские версии видеокарт от AMD и Nvidia. Вы покупаете версии от Gigabyte, MSI, Asus, Palit и других. На одном и том же видеочипе от AMD или Nvidia компании выпускают несколько модификаций, которые отличаются тактовой частотой, количеством памяти и системой охлаждения. И всё это влияет на цену.

Вот как прочитать название видеокарты.

С чего начать?

Очевидно — с бюджета. Решите, сколько денег вы готовы потратить на видеокарту. Но не спешите брать самую дорогую.

Например, Radeon RX 6800 при сравнимой производительности в середине 2021 года стоит на 30% дороже GeForce RTX 3070, ее конкурента от Nvidia. Чтобы не ошибиться с выбором, оцените производительность подходящих по цене видеокарт, мы расскажем об этом далее.

Выбираем видеочип

Мощность видеокарты зависит не только от видеочипа, но и от огромного количества других технических характеристик: частоты графического процессора, объема видеопамяти, разрядности шины, числа универсальных вычислительных процессоров и так далее. Но это то, с чего стоит начать.

Например, вашего бюджета хватит на GTX 1660 Super или RTX 2060. При беглом сравнении видно, что частота графического процессора у первой — 1530 МГц, а у второй — 1365 МГц. Получается, новая RTX менее производительная, чем GTX? Конечно нет! В ней более совершенная архитектура: больше графических CUDA-ядер, быстрее память.

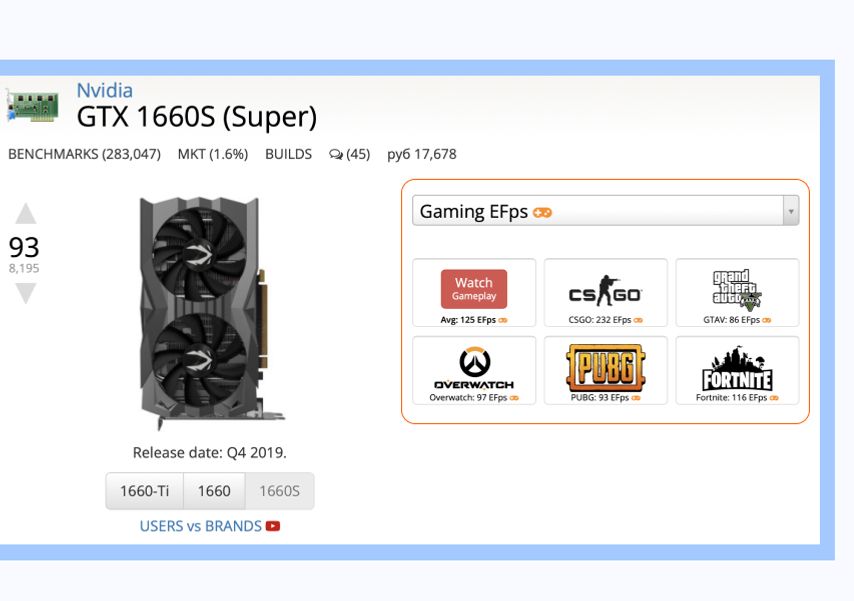

Для сравнения чипов лучше использовать сервис UserBenchmark. Введите в поиске название серии и номер видеочипа, например GTX 1660, и посмотрите на графы User rating (пользовательский рейтинг) и Avg. bench (средний результат).

В первой отражается пользовательский рейтинг, во второй — среднее значение в тестах на производительность. Чем значения выше, тем более мощная видеокарта.

Чтобы понять, каких результатов ожидать в играх, нажмите на название видеокарты и посмотрите замеры средней частоты кадров (количество FPS). Идеальной считается частота от 60 кадров в секунду и выше.

Производительность в играх зависит не только от видеокарты, но и от процессора, поэтому сравнивать видеокарты лучше в паре с ним. На том же UserBenchmark при клике на значок игры можно увидеть процессор, на котором она тестировалась.

Те же действия проделайте с RTX 2060. Как только решите, какой чип вам больше подходит, переходите к выбору модификации.

Стоит ли переплачивать за частоту видеопроцессора?

Чтобы ответить на этот вопрос, возьмем для примера две модификации Nvidia GeForce RTX 3060: Palit GeForce RTX 3060 и Asus GeForce RTX 3060 ROG-STRIX.

Версия от Palit стоит на 15 000 рублей дешевле, но и частота графического процессора у нее — 1320 МГц, а у Asus — 1882 МГц. Выбрав более разогнанную модель, в играх вы получите на 5–10% больше кадров в секунду.

Объем видеопамяти

Количество видеопамяти в разных модификациях тоже может отличаться. Например, RX 570 встречаются как с 4 ГБ, так и 8 ГБ видеопамяти. У GTX 1060 бывает 3 ГБ или 6 ГБ видеопамяти. Если разница в цене составляет 500–1000 рублей, лучше доплатить.

Если разница в цене больше, выбирайте объем, отталкиваясь от своих потребностей в игре. Вот на какие параметры стоит ориентироваться (для ААА-проектов):

- Full HD — 4 ГБ,

- 2К на высоких настройках — 4–8 ГБ,

- 4К — не менее 6 ГБ,

- 4К на высоких настройках — 12 ГБ.

Трассировка и сглаживание: нужны или нет?

Технология трассировки лучей. Создана для того, чтобы объекты в игре выглядели максимально реалистично. Чтобы лучи света, блики и тени выглядели, как в жизни. Nvidia впервые представила эту технологию вместе с линейкой видеокарт GeForce RTX, а позже выпустила драйвер и для более ранних карт.

AMD поддержку трассировки реализовали только в Radeon RX 6000-й серии, которая начала появляться в продаже в конце 2020 года. Таких видеокарт у компании меньше, чем у Nvidia.

Учтите, что трассировка лучей снижает производительность видеокарты в играх. Вы получите более реалистичную графику, но с меньшей частотой кадров (FPS). Для топовых видеокарт это не проблема, частота кадров остается приемлемой. Но с бюджетными решениями, чтобы сохранить 60 FPS, придется снижать настройки графики.

Технологии сглаживания. Позволяют улучшить качество картинки. Контуры объектов и персонажей выглядят ровными, пропадает эффект лесенки, во время движения нет ряби.

Раньше для достижения такого эффекта в видеокартах использовались технологии TXAA, FXAA и MSAA. Но они снижали производительность: частота кадров падала до 30–40 FPS.

Современные разработки — DLSS у Nvidia и FidelityFX Super Resolution у AMD — наоборот, дают прирост производительности от 5% до 20%. То есть вместо 50 FPS можно получить стабильные 60 FPS, а вместо 90 FPS — 100 FPS. Это позволяет не снижать настройки графики при повышении разрешения и играть на мониторе с частотой обновления 80, 90 или даже 120 Гц и выше.

Читайте: какой игровой монитор купить: Acer Nitro или Asus Rog Swift?

Чтобы всё сработало, разработчики игры должны предоставить Nvidia данные для анализа или встроить в свою игру часть кода от AMD. Перед покупкой проверьте, какие игры поддерживают технологии сглаживания. Посмотрите списки для видеокарт Nvidia и AMD.

Как убедиться, что видеокарта подходит ПК?

Еще один важный шаг — проверка на совместимость. Если не учесть размер и другие особенности, видеокарта может не поместиться в корпус или вовсе не заработает.

Длина и ширина

Убедитесь, что видеокарта поместится в корпус вашего ПК. В первую очередь посмотрите, какую максимальную длину видеокарты он поддерживает. Это указано в характеристиках корпуса.

Но учтите, что видеокарте могут мешать другие элементы: радиатор системы водяного охлаждения и вентиляторы. Это происходит там, где установка вентиляторов и СВО происходит во внутреннюю часть корпуса.

Например, во Fractal Design Define S допускается установка видеокарт длиной до 450 мм, а при установке спереди вентиляторов — до 425 мм. Эту информацию можно найти на сайте производителя. А если вы решите установить еще и радиатор СВО, то от 425 мм нужно будет отнять толщину радиатора.

Еще один важный параметр — ширина. Видеокарты с массивной системой охлаждения могут занимать несколько слотов расширения корпуса. Например, Palit GeForce RTX 3070 GamingPro занимает целых три слота, через которые на заднюю стенку компьютера выводятся разъемы для подключения мониторов. Широкие видеокарты часто блокируют установку Wi-Fi-плат, звуковых карт в соседние слоты PCI-Express, которые находятся выше или ниже слота видеокарты. Как проверить?

Посмотрите, как расположены слоты на плате, и измерьте расстояние между ними. Например, в Asus ROG STRIX B450-F Gaming II слоты PCI-Express далеко один от другого, так что видеокарта Palit, которую мы недавно упоминали, их не перекроет.

Обратите внимание на расположение слотов PCIe. В этой материнской плате Asus между ними большое расстояние — поместится любая современная видеокарта и не перекроет нижний слот PCIeНе забудьте про питание

В технических характеристиках видеокарты указывается минимальная мощность блока питания (БП), с которым она будет стабильно работать.

В названии блока пишут суммарную мощность для всех линий питания, куда входят жесткие диски и другое оборудование. Выделяемая процессору и видеокарте мощность может быть значительно меньше. Значение можно узнать из таблицы на корпусе БП, в графе 12 В.

Мощность, выделяемая на видеокарту и процессор, указана в графе +12 В. У этого блока — все 600 ВтКакой у вас экспресс?

Когда говорят о разъеме подключения на материнской плате, обычно упоминают версию PCI-Express (2.0, 3.0 и с недавнего времени — 4.0). Точное количество портов и их тип указаны в графе «Слоты расширения» в характеристиках материнской платы. Как правило, порт с самой последней версией предназначен для видеокарты. У видеокарт версия PCI-е указана в характеристиках в пункте «Интерфейс».

Если у вас установлена старая материнская плата, поддерживающая формат 2.0, а видеокарта поддерживает 3.0, ничего страшного. Видеокарта будет работать с пропускной способностью младшей версии PCI-Express, хотя и медленнее. В идеале стоит выбрать видеокарту с разъемом той же версии, которую поддерживает материнская плата. Или с более высокой, если собираетесь менять плату.

А что с монитором?

Видеокарты поддерживают разные разрешения экрана и разное количество мониторов. А еще от видеокарты зависит максимальная частота кадров, которую отобразит монитор за одну секунду (частота обновления, измеряется в герцах (Гц)).

Рассмотрим на примере GigabyteI GeForce RTX 2060. Максимальное разрешение, которое поддерживает видеокарта, — 7 680 x 4 320, то есть она будет работать с широкоформатным монитором или телевизором 8К.

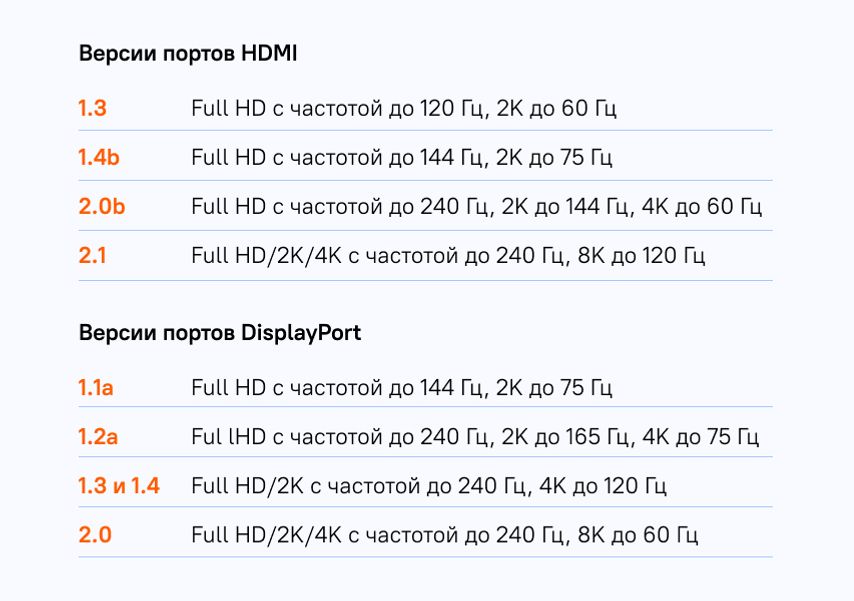

Характеристики видеокарты Gigabyte GeForce RTX 2060Также у видеокарты есть один порт HDMI версии 2.0b и три порта DisplayPort версии 1.4. То есть порт HDMI поддерживает Full HD с частотой до 240 Гц, 2K до 144 Гц, 4K до 60 Гц, а порты DisplayPort — Full HD/2K с частотой до 240 Гц и 4K с частотой до 120 Гц.

Чтобы понять, какие разъемы вам нужны, посмотрите на характеристики монитора. Если монитор Full HD с частотой обновления до 240 Гц, хватит HDMI 2.0b или DisplayPort 1.2a. Для монитора с 2К-разрешением и частотой 240 Гц понадобится HDMI 2.1 или DisplayPort 1.3.

При подключении посмотрите в инструкции к монитору, какая частота и какое разрешение поддерживаются на каждом из его портов. Бывает так, что максимальное качество доступно только на DisplayPort или одном из нескольких HDMI. Именно к ним и нужно подключить видеокарту.

Читайте также: