Хватит ли видеокарты на 1 гб

Обновлено: 07.07.2024

Видеопамять (или VRAM) — это такое же хранилище данных, как и оперативная память (DRAM) вашего компьютера. Много ли ее надо?

Вы могли заметить, что при настройке графики в играх интерфейс показывает, сколько видеопамяти потребуется при включении той и иной опции. Так вот, для комфортной игры с максимальным качеством отображения нам необходимо выяснить, сколько видеопамяти потребуется. Этим и займемся.

Что важно знать

- Видеопамять встроена в видеокарту и хранит графические данные, например игровые текстуры;

- Видеопамять нельзя менять так же просто, как оперативную память: если нужно больше VRAM — придется обновить видеокарту;

- Самое большое преимущество VRAM над обычной DRAM — скорость доступа. Поскольку чипы видеопамяти встроены прямо в видеокарту, графический процессор получает доступ к хранимой в ней информации быстрее, чем к SSD или жесткому диску.

Что произойдет, если видеопамяти все-таки не хватит?

Страшного — ничего, но впечатление от игры может быть подпорчено, особенно если вы решите поиграть в долгожданную и требовательную новинку. Ждите также проблем с производительностью и текстурами.

Что это значит?

Недостаточная емкость видеопамяти почти всегда означает проблемы с производительностью в играх. При серьезной нехватке VRAM начинает задействоваться более медленная DRAM (оперативная память ПК). В частности, это приводит к более низкой частоте кадров и незначительному притормаживанию.

Проблемы с текстурами — это, например, искажение изображения, задержки и разрывы кадров. Если у вас мало VRAM, вам придется выставлять в настройках игр более низкую детализацию текстур, чтобы при быстром перемещении по игровой карте вы не попадали в ситуацию, когда текстуры на определенном участке не успели полностью прогрузиться. В таких случаях вы вместо, допустим, домов будете видеть белые блоки, а вместо травы — пустое поле.

Сколько VRAM мне нужно для комфортной игры?

В 2021 году для комфортных игр в современные тайтлы нужно минимум 6 Гб видеопамяти. Но лучше всего рассматривать решения с 8 Гб, особенно если вы планируете играть на мониторе с разрешением 2K (1440p) или 4K (2160p). Так что когда вы задаете себе вопрос «Сколько VRAM мне вообще нужно?» — учитывайте следующие факторы:

1. Разрешение, в котором вы запускаете игры

Чем выше разрешение в игре, тем больше видеопамяти вам потребуется. Более высокое разрешение означает дополнительные пиксели, которые увеличивают размер текстуры и требуют больше памяти для ее хранения. Исходя из разрешения, требуемую емкость VRAM можно рассчитать:

- 2 Гб для разрешения 720p;

- 3 Гб для разрешения 900p;

- 4 Гб для разрешения 1080p;

- 6–8 Гб для разрешения 1440p;

- 8–12 Гб для разрешения 2160p.

Но не только разрешение изображения влияет на емкость памяти.

2. Сами игры, которые вы предпочитаете

Некоторые игры не только поддерживают высокие разрешения в 4K, но и в целом требуют больше видеопамяти. Как правило, это AAA-игры (в духе Call of Duty: Black Ops — Cold War) и игры с плохой оптимизацией (такое часто встречается при выходе новых игр, вспомним, к примеру, PUBG версии 2017 года).

Более качественная графика и количество отображаемых объектов на игровой карте также определяют, сколько памяти она использует. Например, игры с тяжелой графикой, такие как «Ведьмак 3»: Control и Shadow of the Tomb Raider требуют намного больше памяти, чем простые игры, не особо ориентированные на графику, такие как League of Legends и Counter-Strike: Global Offensive.

3. Использование графических модификаций

Иногда использование сторонних модов или графических надстроек может привести к увеличению использования видеопамяти до гораздо больших объемов, чем обычно. Это связано с тем, что некоторые моды добавляют в игры текстуры высокого разрешения (например, в The Elder Scrolls V: Skyrim или Fallout 76). Если использование модов — ваш предпочтительный способ игры, то вам, вероятно, следует рассматривать видеокарты с 6 Гб VRAM и более.

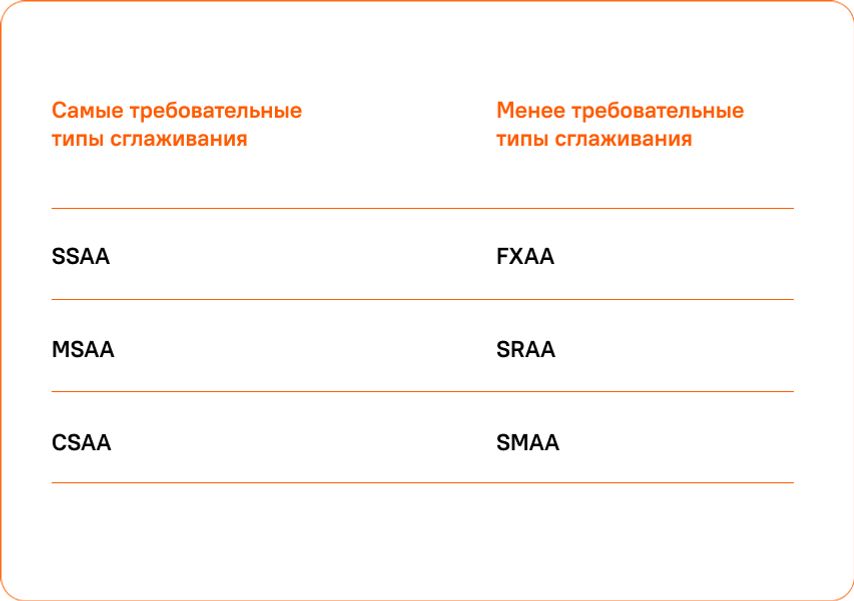

4. Сглаживание очертаний и контуров

Для сглаживания краев объектов и устранения эффекта лесенки в играх используется функция Anti-Aliasing. Чем сильнее сглаживание, тем приятнее получается картинка, однако для этого требуется отрисовать больше пикселей. Поэтому когда этот параметр включен, потребление видеопамяти также увеличивается. Степень его усиления будет зависеть от используемого метода Anti-Aliasing. К наиболее распространенным из них относятся:

- SSAA — сглаживание всей сцены;

- FXAA — быстрое сглаживание;

- MSAA — сглаживание краев объектов;

- TXAA — метод сглаживания с применением blur-эффекта;

- CSAA — сглаживание по краям с учетом соседних пикселей.

5. Настройки параметров игры

Чем выше настройки вашей игры, тем больше данных требуется обработать вашему графическому процессору — и тем больше памяти он потребляет в результате. Поскольку верно и обратное, вы можете понизить настройки игры, чтобы уменьшить использование памяти.

Компромисс или новая видеокарта?

Многим игрокам с видеокартами пятилетней давности, мечтающим о новых играх, приходится снижать настройки графики таким образом, чтобы их игры работали плавно. Помните, что такие настройки, как сглаживание, уровень детализации и качество текстур, больше всего влияют на потребление VRAM (о чем мы и говорили выше).

Если подобные компромиссы вас не устраивают — воспользуйтесь нашим гайдом. В самом начале мы привели приблизительный расчет по части емкости видеопамяти, которая требуется для запуска современных игр с максимальным качеством графики, так что вы без труда определитесь с параметрами VRAM.

Дальше останется лишь выбрать на сайте «Ситилинка» модели видеокарт, удовлетворяющие вашим требованиям, и подобрать оптимальный по цене вариант.

Я уже много раз писал, что для счастья геймеру вполне достаточно игр до 2010 года выпуска и сейчас в полной мере пробую это на своем примере. И знаете что хочу сказать — сейчас мне вполне достаточно видеокарты AMD Radeon HD 4870, я прохожу игру Dead space, пропущенную в свое время, а если поборю желание каждый час проверять курс криптовалют и цены на видеокарты на вторичном рынке, вполне продержусь в таком режиме еще пару месяцев.

реклама

Ну а пока меня очень впечатлили возможности Windows 10 в плане запуска старых игр, и даже создается ощущение, что в этом плане она лучше, чем Windows 7. Но остается открытым вопрос производительности в играх, ведь у этих ОС заметно различаются версии Windows Display Driver Model (WDDM), потребности в GPU-ускорении и потребление видеопамяти. Я решил сравнить, какая ОС покажет себя лучше в плане производительности в старых играх, которые еще по плечу старушке Radeon HD 4870.

реклама

var firedYa28 = false; window.addEventListener('load', () => < if(navigator.userAgent.indexOf("Chrome-Lighthouse") < window.yaContextCb.push(()=>< Ya.Context.AdvManager.render(< renderTo: 'yandex_rtb_R-A-630193-28', blockId: 'R-A-630193-28' >) >) >, 3000); > > >);Radeon HD 4870 — не самая лучшая видеокарта "затычка", ведь ее потребление достигает 160 ватт, а отсутствие поддержки DirectX 11 отсекает возможность запуска многих игр. Но за счет 800 унифицированных шейдерных процессоров и видеопамяти GDDR5, работающей на шине шириной 256 бит, у видеокарты достаточно "грубой силы" для запуска старых игр, и сегодня она гораздо предпочтительнее, чем, к примеру, GeForce GTS 250.

реклама

Для тестирования я выбрал популярные игры с встроенными бенчмарками периода 2007-2010 годов, в которые мерились производительностью в свое время обладатели Radeon HD 4870, а так же 3DMark Vantage, рассчитанный на тестирование видеокарт с поддержкой DirectX 10. В обеих тестовых ОС я исключил софт, задействующий GPU-ускорение: браузеры, мессенджеры и т. д. А видеокарта будет работать на заводских настройках.

Far Cry 2

Начать я решил с игры с открытым миром Far Cry 2, вышедшей в 2008 году. Игроки встретили Far Cry 2 довольно прохладно, по сравнению с третьей частью, но у игры были отлично проработанные геймплейные нюансы, которые впоследствии серия растеряла. Например, реалистичный износ оружия с соответствующими анимациями, физически более правдоподобное пламя и горение растений и разрушаемое окружение.

Настройки бенчмарка вы видите на скриншоте.

реклама

А результаты тестирования здесь и далее по тексту будут представлены в виде склеенных скриншотов, первый результат на которых будет принадлежать Windows 10, а второй — Windows 7.

Windows 7 выдала чуть более высокий максимальный FPS, но среднее значение практически идентично.

S.T.A.L.K.E.R - Call Of Pripyat

И опять мы получаем идентичные результаты, с разницей в пределах погрешности.

Mafia II

А вот производительность Radeon HD 4870 в следующей игре, Mafia II, 2010 года выпуска, откровенно разочаровала. Даже учитывая, что использовались низкие настройки.

Бенчмарк показал "кинематографичный" средний FPS, равный 24. Довольно неприятно, что топовая видеокарта 2008 года не справляется с игрой 2010 года выпуска. Игра, кстати, неправильно определила Windows 10, посчитав ее Windows 7 6.2 Build 9200.

World in Conflict

Следующая игра - очень требовательная к ресурсам железа стратегия World in Conflict, вышедшая в 2007 году. Во встроенном бенчмарке будут использоваться максимальные настройки и разрешение 1920х1080.

И результат опять практически одинаковый, только у Windows 7 произошел одномоментный всплеск максимальной кадровой частоты аж на 100 кадров, не отразившейся на среднем результате. По результатам видно, что Radeon HD 4870 не тянет на максималках стратегию 2007 года и это довольно печально.

3DMark Vantage

И завершающий тест - 3DMark Vantage в режиме Perfomance.

И здесь видно небольшое лидирование Windows 10 по очкам, но если посмотреть на FPS тестов, то видно, что результаты обеих ОС очень близки.

Выводы

Итак, из тестов следует вывод, что при наличии достаточного объема ОЗУ и SSD-накопителя, даже при использовании очень слабой видеокарты нет никаких причин пользоваться устаревшей операционной системой. Windows 10 отлично работает со старой видеокартой и отлично показывает себя при запуске старых игр.

А вот производительность Radeon HD 4870 разочаровала, даже в старых играх она не позволяет выставить максимальные настройки. Но ситуация на рынке видеокарт в 2021 году настолько печальна, что примерный аналог Radeon HD 4870 по производительности, GeForce GT 730, имеющий, конечно, больше памяти и поддержку DirectX 12, стоит уже дороже 6000 рублей.

Доброго всем дня, фаны и фанатки, подписчики подписчицы, случайные зрители зрительницы, на связи Live Games!

В этом ролике речь пойдёт, вы не поверите, о видеопамяти. Прошёл 2020 год, и когда казалось бы, хуже уже быть не может, полным цветом зацвёл майнинг, биток вновь взлетел, а новые видеокарты оказались в дефиците, ну или лежат в магазинах за двойной ценник. Даже старые видеокарты сильно подорожали, что совсем уже опечаливает.

Тем, кто успел урвать какую-нибудь видеокарту, теперь можно только позавидовать, ведь теперь возможность купить видеокарточку по адекватному ценнику, представится, возможно, только к следующим новогодним праздникам.

С свете всех этих событий у нас назрел вопрос – сколько видеопамяти потребуется для игр в 2021 году? И на какие настройки и фреймрейт можно рассчитывать? Как сильно зависит жор от настроек графики и разрешения рендера? Сильна ли разница в качестве картинки? Ответы на эти вопросы вы найдёте в этой статье.

Игр будет не много, но все они показательны – либо требовательны к железу, либо совсем свежие и вышли на некст-ген консоли , либо популярные в геймерских кругах.

Тестировали игры мы в трёх разрешениях – 1080р, 1440р и 2160р. Это позволит наглядно проследить потребление видеопамяти при повышении разрешения.

Настройки затронем все, от минималок до экстрим, если они есть. Не оставим в стороне и новомодные RTX и DLSS технологии.

Ну и в конце, систематизируем полученные результаты в простой и понятный вывод, и дадим краткие рекомендации. Так что, смотрим до конца, запасаемся чаем и сладкой булочкой!

Для начала, наш тестовый стенд:

i7 8700k 4.8ghz

Кулер DeepCool GT

Корпус Nzxt

Матплата Gigabyte Z370 HD3P

Память G.Skill 32 gb 3600 mhz

БП Corsair rm850x

SSD - Kingston Hyperx 480gb Sata3 MLC.

Жесткие диски Wd gold 2tb и wd blue 1tb.

И самое главное, на какой видеокарте проводились тесты. Гулять, так на все деньги – в замерах нам помогла RTX 3090 , с внушительным видеобуфером в 24Гб. То есть, по объёму памяти у нас ничто никуда не упрётся.

И последний нюанс перед самими тестами – для удобства восприятия цифры потребления памяти будем округлять. Но если нужны точные цифры, они на футажах, а их много будет в нашем ролике. Начинаем!

* Apex Legends . Популярный фритуплей баттлрояль от создателей Titanfall. Так как игра рассчитана на массового игрока, то бегает она на хорошо оптимизированном движке, положительно показавшем себя ещё в Titanfall 2.

Итак:

1080р , минималочки. Игре потребовалось ни много ни мало, 3,7Гб видеобуфера. Графон соответсвенно, не очень.

1440р . Рост аппетита незначительный – игре понадобилось без малого 4Гб памяти.

2160р . И вот тут то Легендарный Орех растерял всю свою скромность, и малу помалу сожрал практически 5Гб! Хотя если подсчитать, при двухкратном росте разрешения с 1080р до 4К, рост потребления памяти увеличился всего на 1,3Гб.

Теперь всё тоже самое но ультра настройках.

1080р , ультры. Несмотяр на увещевания игры что ей для ультра текстур нужно 8Гб, оверлей показал более призимлённые и реальные 5-6Гб. Таким же чудачеством тешил игрока и Titanfall 2, уверяя что для ультра текстур ему тоже кровь из носу надо 8Гб, но при этом бодро бегал в 1080р на GTX 1060 6гб (где-то всплакнул один котодмен о своей почившей джифорсине, кто знает тот поймёт).

1440р . Рост потребления памяти заметен, но не критичен – 5,4Гб. При долгой игре, впрочем, игра может отьесть примерно 6,5Гб. Всё стандартно как и в случае с минималками.

2160р . Высокое разрешение требует больше памяти – 6,4Гб вынь да положь на алтарь игрового движка. Во время каток задействованный объём доходит вплоть до 9,5Гб! Как нам кажется, это не столько требования игры, сколько следствие того что у видеокарты много свободного места в видеобуфере. И информация продолжает записываться в память видеокарты. В своё время, например, Watch Dogs 1 на ультрах умудрялся кушать 11Гб на Титане Х.

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Читайте также: