Как посмотреть температуру памяти видеокарты rtx 3070

Обновлено: 07.07.2024

Одной из самых проблемных сторон использования новейших графических процессоров серии Nvidia GeForce RTX 30 для майнинга Ethereum является тот факт, что их видеопамять сильно нагревается, и до недавнего времени просто не было инструмента, чтобы дать вам представление о том, насколько она горячая.

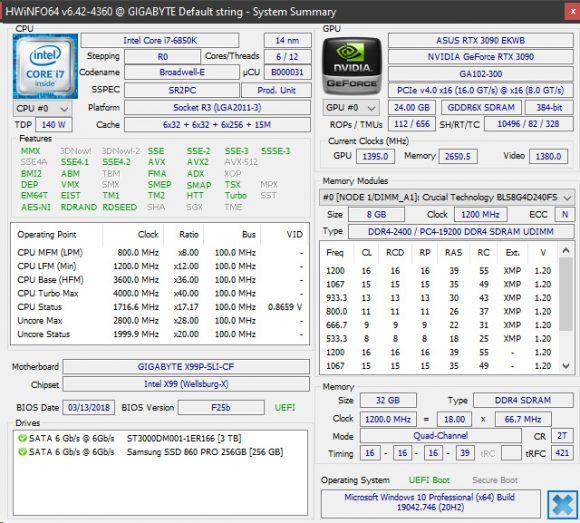

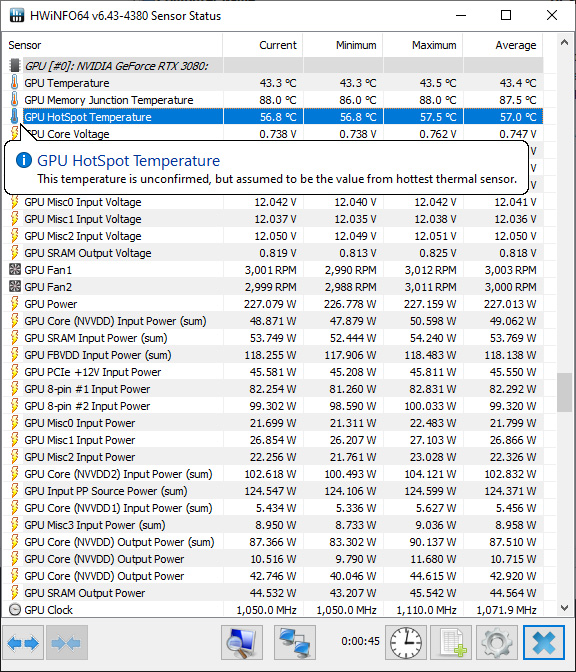

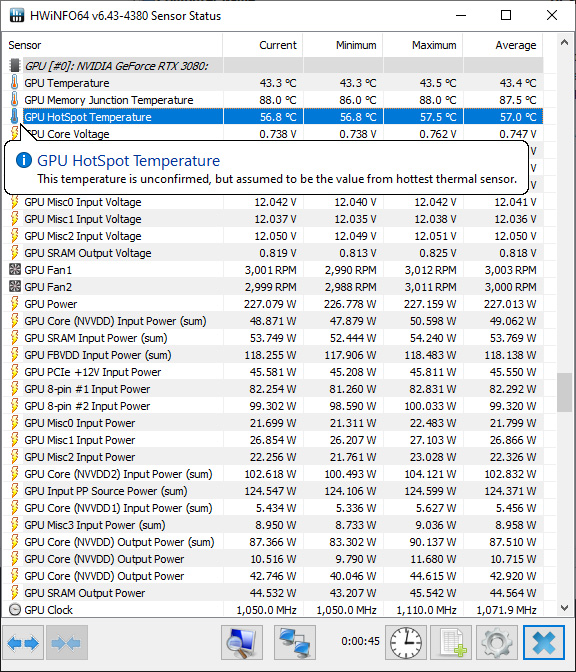

Благодаря последней версии HWiNFO 6.42 теперь вы можете контролировать рабочие температуры видеопамяти GDDR6X ваших графических процессоров RTX 3060 Ti, RTX 3070, RTX 3080 и RTX 3090 и принимать соответствующие меры, чтобы поддерживать охлаждение для обеспечения максимальной производительности и отсутствия проблем. операция на длительный срок. Имейте в виду, что вы можете быть очень удивлены, когда увидите, что реальные цифры действительно высоки, но этого следовало ожидать, учитывая тот факт, что даже поверхность задней панели видеокарты сильно нагревается, когда мы касаемся ее или измеряем ее. .

Просто скачайте и запустите последнюю версию HWiNFO, вы даже можете использовать портативную версию, перейдите в Мониторинг и запустите состояние датчика, а затем прокрутите вниз до данных графического процессора и посмотрите, что вы получите в виде данных о температуре перехода памяти графического процессора (прямо под температурой графического процессора) .

Мы получаем температуру холостого хода 36 градусов, но при майнинге она поднимается до 92 градусов по Цельсию, и это графический процессор с водяным охлаждением, температура графического процессора под нагрузкой приближается к 50C.

Примечание относительно новой температуры перехода памяти GDDR6X:

Как и в случае с Navi, это не внешняя (корпусная) температура, а температура внутреннего перехода, измеренная внутри кремния.

Так что не бойтесь увидеть более высокие значения, чем другие распространенные температуры, это ожидаемо. Также установлены соответственно более высокие пределы (дросселирование начинается около 110 C).

РЕДАКТИРОВАТЬ: добавляем, что сообщаемое значение должно быть текущей максимальной температурой среди всех микросхем памяти.

Проверка задней панели RTX 3090 с водяным охлаждением с помощью тепловизора FLIR показала, что при стандартных настройках при майнинге вы получаете около 72,8 C (самая горячая точка), а с разогнанной памятью самая горячая точка на задней панели, где находятся микросхемы памяти, составляет 75,8 C. Неудивительно, что мы получили такие высокие температуры, учитывая, что реальная рабочая температура памяти под задней панелью составляет 92 градуса.

Таким образом, добавление дополнительных охлаждающих вентиляторов поверх задней панели определенно необходимо, если вы планируете использовать RTX 3090 для майнинга Ethereum. То же самое касается RTX 3080 при использовании для майнинга, хотя с RTX 3070 и 3060 Ti ситуация может быть лучше из-за более низкого энергопотребления, которое они имеют, особенно при оптимизации для майнинга. Нам нужно дополнительно изучить температуру памяти с этими двумя, тем временем, если вы проверите, какие температуры вы получаете с HWiNFO на своих графических процессорах, не стесняйтесь делиться результатами в комментариях ниже.

Реальная температура GPU на видеокартах GeForce RTX 3000 в наиболее горячих областях чипа может на 11-14 градусов превышать то значение, которое показывают имеющиеся программы мониторинга. Но вскоре доступ к значению истинной максимальной температуры предоставит программа HWiNFO, как пишет авторитетный ресурс Igor’s Lab.

Температурные датчики GPU Radeon VII

К сожалению, средства мониторинга температуры современных видеокарт не могут полностью удовлетворить энтузиастов и оверклокеров. Поэтому продвинутым пользователям приходится прибегать к дополнительным программным средствам. Например, недавно популярная утилита HWiNFO научилась измерять температуры чипов памяти, после чего выяснилось, что память GDDR6X на флагманских видеокартах NVIDIA зачастую работает с нагревом свыше 100 градусов. Теперь разработчик HWiNFO готовится добавить ещё одно важное значение температуры для GeForce RTX 3000 — температуру самой горячей точки GPU.

На каждом кристалле GPU, как правило, установлено несколько десятков термических датчиков, каждый из которых считывает показатель температуры в своей области. Однако на практике температура GPU выводится программами мониторинга как некое усреднённое значение (Junction Temp). Между тем, температура в разных областях чипа может значительно различаться. Это зависит от вычислительной нагрузки на ту или иную область кристалла, ровности поверхности кристалла, эффективности используемой системы охлаждения и даже правильности нанесённой термопасты на чип. Таким образом усреднённый показатель температуры далеко не всегда отображает реальную картину.

Программа мониторинга HWiNFO уже может считывать показатели температуры самой горячей точки (HotSpot) графических процессоров видеокарт серии Radeon RX 6000, поскольку AMD в этом плане оказалась более прозрачной. В NVIDIA же, видимо, посчитали, что для пользователя данная информация не будет полезной. В действительности оказывается, что та температура, на которую предлагает ориентироваться NVIDIA, реального положения дел с нагревом не описывает.

Например, средняя температура GPU видеокарты MSI Radeon RX 6800 XT Gaming X (на графике ниже отображена как Edge и выделена зелёным) составляет под нагрузкой порядка 65 градусов по Цельсию. Между тем температура самой горячей точки (HotSpot), может отличаться на 12–20 градусов в большую сторону и достигать значения 90 градусов по Цельсию.

Аналогичные замеры для видеокарт NVIDIA сможет делать грядущая новая версия программы HWiNFO. Ресурс Igor’s Lab уже провёл её тестирование и выяснил, что разница между значением среднего показателя температуры GPU видеокарты GeForce RTX 3090 Founders Edition, который обычно видят пользователи, может отличаться от показателя температуры самой горячей точки в среднем на 11–14 градусов по Цельсию.

Для большинства пользователей, использующих видеокарты по прямому назначению, то есть для работы и игр, данная информация действительно не имеет почти никакого практического значения. Однако для энтузиастов компьютерного разгона эти сведения могут оказаться весьма полезными, поскольку они прямо или косвенно указывают на эффективность той или иной системы охлаждения. На примере тех же замеров для GeForce RTX 3090 Founders Edition можно отметить, что СО видеокарты справляется с охлаждением GPU значительно лучше, чем система охлаждения MSI RX 6800 XT Gaming X, даже несмотря на разницу в уровне энергопотребления видеокарт. У первой он заявлен на отметке 350 Вт, а у второй — на 300 Вт. В то же время на флагманской карте NVIDIA значительно хуже охлаждаются чипы памяти, поскольку эта видеокарта использует два набора модулей, расположенных с обеих сторон платы. К счастью, для памяти стандарта GDDR6X такая рабочая температура является вполне обычной.

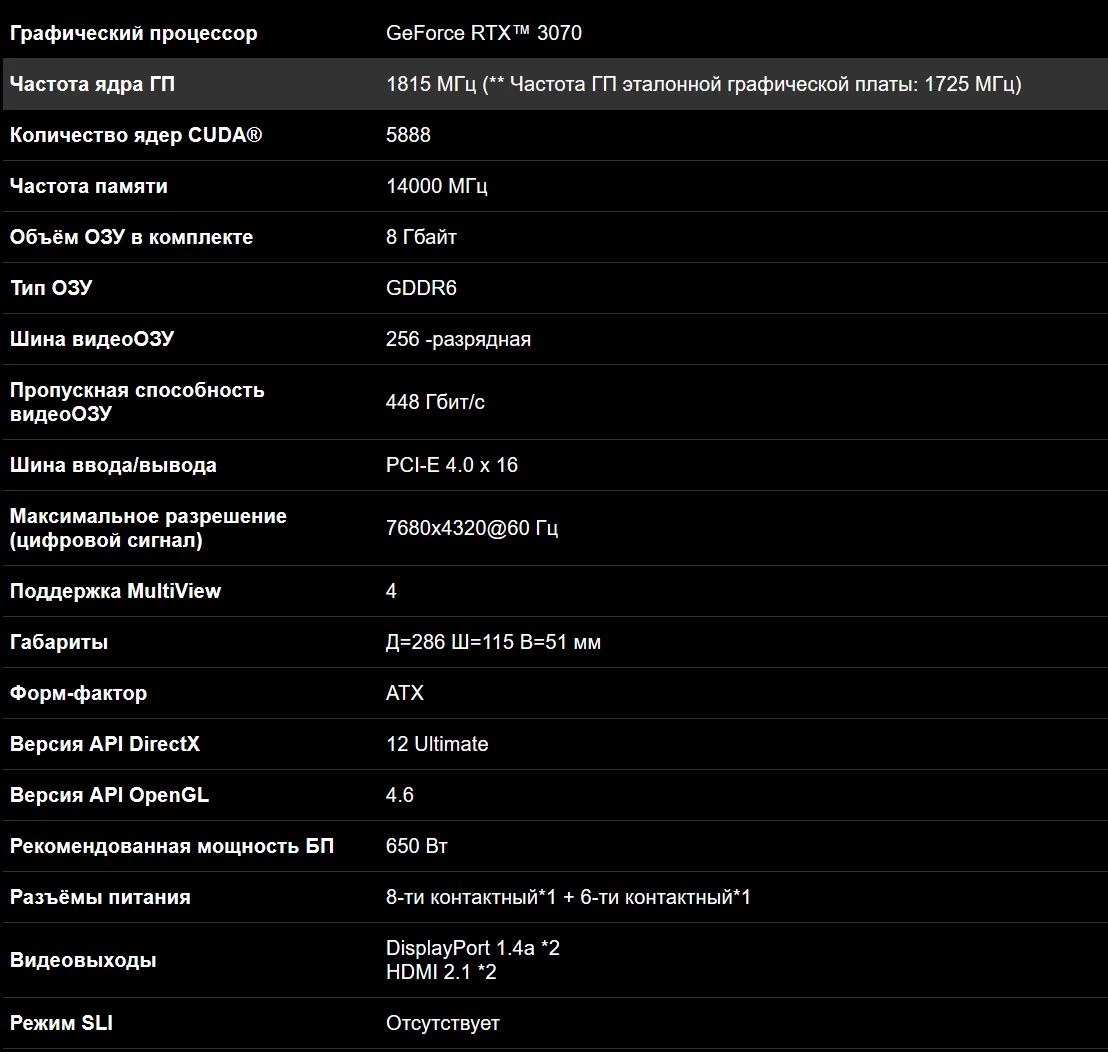

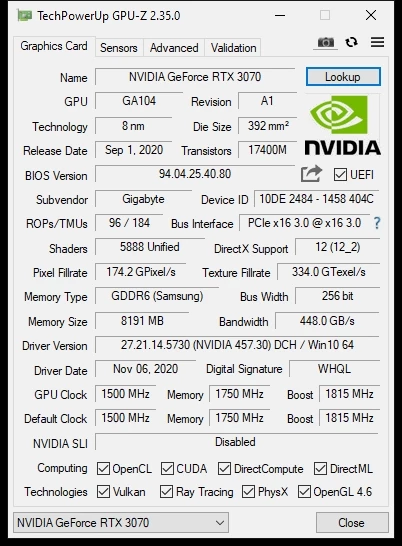

На референсную модель видеокарты RTX 3070 мы уже посмотрели, настало взглянуть, что придумали партнеры. Привычные ожидания - заводской разгон, немного выше производительность и зачастую лучшее охлаждение - как со стороны производимого шума, так и со стороны температур. Первой на очереди у нас видеокарта GIGABYTE GeForce RTX 3070 GAMING OC 8G, которую мы проведем через привычные тесты и посмотрим на производительность в играх и ее разгонный потенциал.

Основными отличиями GIGABYTE GeForce RTX 3070 GAMING OC 8G от референсной модели являются увеличенный Power Limit до

260-270 Ватт и заводской разгон ядра до 1815 МГц (1725 МГц у Founders Edition). Как это отразится на производительности видеокарты, рабочих температурах и производимом уровне шума мы увидим позднее, а пока сконцентрируемся на внешнем виде видеокарты и особенностях дизайна системы охлаждения.

Внешний вид

Внешний вид упаковки привычный для серии видеокарт GAMING от GIGABYTE, как и комплект поставки - видеокарта GIGABYTE GeForce RTX 3070 GAMING OC 8G, диск с драйверами, а также записка с напоминанием зарегистрировать продукт на официальном сайте, чтобы получить дополнительный год гарантии, увеличивая гарантийный период до 4 лет. Недурно!

Визуально, дизайн видеокарты GIGABYTE GeForce RTX 3070 GAMING OC 8G не сильно отличается от представителей серии GAMING прошлых поколений, однако при ближайшем рассмотрении отличий можно найти немало. С лицевой стороны видеокарта почти не изменилась - грани стали более мягкие, да в цветовой палитре добавилось больше серого цвета. Сбоку изменения не только визуальные - коннекторы дополнительного питания получили небольшой декоративный щит, который приятно смотрится и надежнее фиксирует коннекторы на месте. RGB логотип компании по-прежнему присутствует и по ощущениям горит ярче, чем у предыдущих моделей видеокарт GIGABYTE, которые попадали мне на тестирование. А может, я просто это выдумываю.

Задняя поверхность видеокарты получила вырез, позволяющей правому вентилятору продувать радиатор насквозь, выдувая горячий воздух вверх. Давно пора приносить новшества в дизайн видеокарт! Особенно с растущим тепловыделением и энергопотреблением. Очень приятно видеть, что все больше и больше производителей выпускают дизайны видеокарт, использующих подход с продуваемым насквозь радиатором. Надеюсь, приживется.

GIGABYTE GeForce RTX 3070 GAMING OC 8G - трехвентиляторная, 2.5-слотовая модель видеокарты с фирменным охлаждением WINDFORCE 3X, алюминиевым радиатором и прямым контактом тепловых трубок с видеочипом. Несмотря на энергопотребление в

260-270 Ватт, видеокарта удивительно небольшая: 286 мм в длину, 115 мм в ширину и 51 мм в высоту, или 2.5 слота расширения PCIe. Вес видеокарты составляет

950 грамм, почти на 100 грамм легче Founders Edition. По сравнению с монструозными RTX 3080 и RTX 3090, видеокарта GIGABYTE GeForce RTX 3070 GAMING OC 8G выглядит миниатюрно. Для питания используются 8pin+6pin коннекторы с официальной рекомендацией использовать блоки питания мощностью от 650 Вт. Интерфейсы подключения включают х2 DisplayPort 1.4a с поддержкой DSC 1.2a (Display Stream Compression) и x2 HDMI 2.1, тоже поддерживающие DSC 1.2a. Карта использует двойной BIOS - бесшумный и производительный, переключатель которого можно найти посередине карты.

Конфигурация системы

- Процессор: Intel Core i7 10700K OC 5GHz

- Оперативная память: 16Gb Crucial Ballistix Sport LT @ 3866 MHz CL16

- Материнская плата: ASUS ROG STRIX Z490-A GAMING

- Системный SSD: Samsung EVO 860 500Gb

- SSD с играми: Kingston KC2500 1TB

- Охлаждение CPU: Arctic Liquid Freezer II 280 mm (Rev. 2)

- Блок питания: XFX XTR Black Edition 750W Gold

- Корпус: Phanteks P500A

- Операционная система: Windows 10, 2004

- Версия драйвера: NVIDIA 457.30 Game Ready Driver

- Видеокарта: GIGABYTE GeForce RTX™ 3070 GAMING OC 8G

Шум, энергопотребление

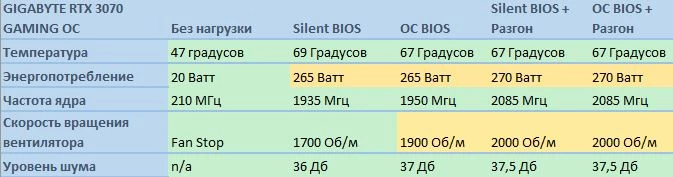

Тесты проводились в закрытом корпусе, в повседневных условиях использования видеокарты. Для тестирования температуры видеокарты использовался стресс-тест синтетического бенчмарка Superposition в пресете 1080p Extreme. По истечении 10 минут с начала теста измерялись показания температуры в программе HwInfo и скорость вращения вентиляторов. Для измерения энергопотребления использовалась HwInfo, уровень шума измерялся при помощи шумомера, расположенного на расстоянии 1 метра от корпуса.

Как NVIDIA вычисляет значения частоты ядра мне неизвестно - наверное, в условиях заросшего паутиной корпуса без вентиляторов. Реальная частота буста всегда сильно отличается, и GIGABYTE GeForce RTX 3070 GAMING OC 8G - не исключение. В бенчмарке Superposition средняя частота ядра при использовании OC биоса составила 1950 МГц, а в случае использования Silent биоса - 1935 МГц. Эталонная видеокарта от NVIDIA в этих же условиях удерживала среднюю частоту ядра на отметке 1875 МГц.

Видеокарта использует двойной BIOS, который можно переключать между двумя режимами работы - OC и SILENT - при помощи небольшого переключателя сбоку видеокарты. Для применения профиля работы следует перезагрузить компьютер. Оба биоса обладают одинаковым лимитом энергопотребления в

260-270 Ватт по информации со встроенных датчиков. В случае OC биоса видеокарта начинает сбрасывать частоты только по достижении отметки в 70 градусов, которая является основным таргетом температуры. По достижении этой отметки вентиляторы начинаются разгоняться, а карта - немного сбрасывать частоты, чтобы удержать эту температуру. Приоритетом работы Silent BIOS является производимый уровень шума. В более горячих условиях температура видеокарты может доходить до 75 градусов, а скорость вращения вентиляторов не будет превышать отметки в 1900 Об/м. В этом профиле видеокарта агрессивнее сбрасывает частоты для контроля температуры и уровня шума.

В обоих случаях видеокарта практически бесшумна в обычных условиях работы. В случае использования OC биоса и корпуса с худшей продуваемостью, чем мой Phanteks P500A, работу видеокарты можно будет услышать, однако примерно до отметки в 2300 Об/м весь производимый шум - это звук движения воздуха. Сами вентиляторы совсем не слышно. В случае моего экземпляра видеокарты шум дросселей был различим во время экранов загрузки некоторых игр, когда игра выдавала больше 300 FPS. Но как часто бывает, этот параметр варьируется от карты к карте.

То ли NVIDIA проделали замечательную работу с дизайном архитектуры видеокарт AMPERE, то ли GIGABYTE такие молодцы, а может, и те и другие. При солидном энергопотреблении видеокарта остается тихой и холодной. Даже в разгоне, который показывает ощутимый частотный прирост, видеокарта остается бесшумной, а ее температура даже не доходит до отметки в 70 градусов. Для сравнения, моя личная VEGA 64 NITRO+ от Sapphire, которая считается самой самой лучшей картой серии с воздушным охлаждением, при таком же температурном таргете и схожем уровне энергопотребления звучит значительно громче. Так что бояться высокого энергопотребления видеокарт NVIDIA Ampere не стоит - производители держат под контролем и шум, и охлаждение видеокарт.

Тесты в играх

Тестирование проводилось в двух разрешениях - 2560x1440 и 3840x2160. Основные тесты мы уже провели в обзоре эталонной видеокарты RTX 3070. Поэтому здесь предлагаю сконцентрироваться на различиях между двумя моделями. Заводской разгон видеокарты GIGABYTE GeForce RTX 3070 GAMING OC 8G практически соответствует ручному разгону Founders Edition, посему посмотрим как это проявляется в играх. Тестирование проводилось c ОС биосом.

В 1440p разница небольшая, но в 4К заводской разгон ядра ярче себя проявляет. Судя по всему, основным боттлнеком в разрешении 2560x1440 является пропускная способность памяти.

Разгон

Увеличенный лимит энергопотребления обещает более высокий разгонный потенциал видеокарты относительно Founders Edition, что очень и очень радует. Founders Edition показала ощутимый прирост производительности относительно стоковых показателей работы. Будет ли видеокарта GIGABYTE GeForce RTX 3070 GAMING OC 8G так же хорошо скалироваться на частотах выше 2000 МГц?

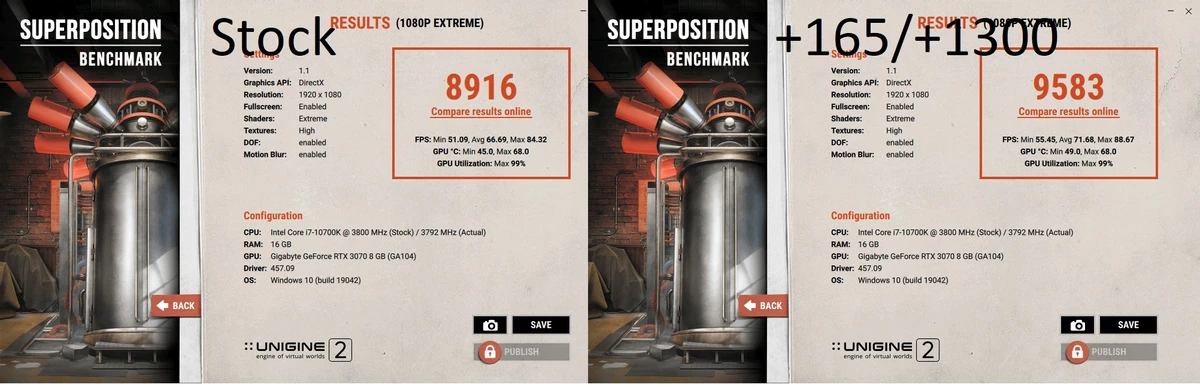

Начнем с бенчмарка Superposition, который, на мой взгляд, является лучшим синтетическом бенчмарком производительности видеокарт на сегодняшний день. Минимальная нагрузка на процессор, никакого предпочтения видеокартам NVIDIA или AMD, видимое увеличение результата от разгона как ядра, так и памяти. Superposition также помогает отлавливать очевидный переразгон памяти, который выражается в видимых артефактах изображения, однако подтверждать стабильность разгона нужно в играх.

Сходу видеокарта оказывается стабильна на показателях +160 по ядру и +1300 по памяти. Круто! Отражается это и на результата бенчмарка Superposition:

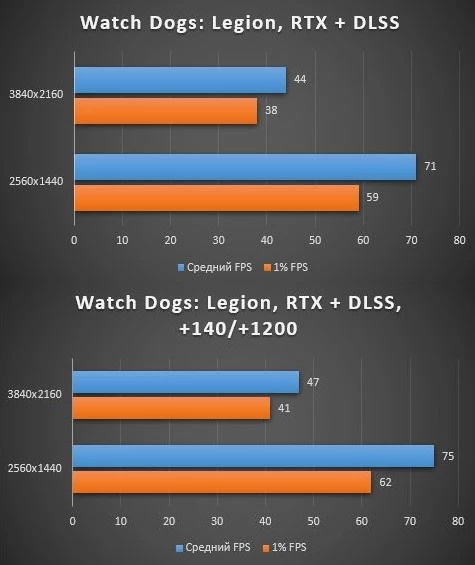

В некоторых играх, однако, этот разгон оказывается нестабилен, посему опускаемся до более консервативных +140 по ядру и +1200 по памяти. Samsung отлично подтянули производственный процесс GDDR6 модулей - первое поколение модулей Samsung практически не гналось:

Как я и подозревал, в 1440p разница незначительна, а вот в 4К дополнительные 65 Мгц по ядру выливаются в видимый прирост производительности. В 1440p ботлнеком является пропускная способность памяти, отчего разгон памяти дает более ощутимое преимущество, нежели разгон ядра, но в 4К картина меняется.

RTX игры тоже получают буст производительности, как это видно из бенчмарков Watch Dogs: Legion с использованием технологий RTX и DLSS:

Разница между RTX+DLSS Off/On значительна, при небольшой разнице в производительности:

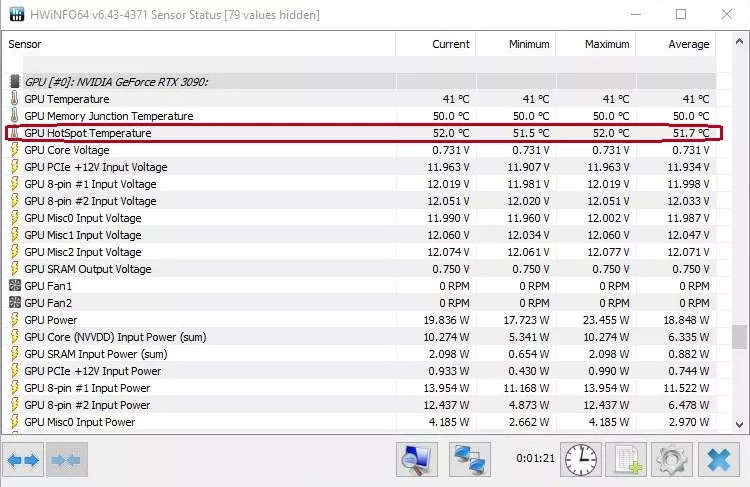

В последней бета-версии утилиты HWiNFO v6.43-4380 теперь доступен ряд улучшений и несколько нововведений. Наиболее интересной новой фишкой программы стала возможность мониторинга температуры HotSpot GPU для видеокарт от NVidia. Не так давно эта бесплатная утилита дала возможность владельцам видеокарт Nvidia 3000-й серии (RTX 3080 и RTX 3090) мониторить рабочую температуру чипов памяти GDDR6X (Обычно именно эта часть видеокарт 3000-й серии является самой горячей при майнинге Ethereum). Чипы памяти GDDR6X начинают троттлить при температуре около 110 градусов по Цельсию. Новая же функция предназначена не для памяти, а для мониторинга GPU (точнее самой горячей точки на многочисленных датчиках температуры интегрированных в сам GPU)

Список изменений в новой версии HWiNFO v6.43-4380 Beta:

- Улучшенный мониторинг датчиков на материнских платах серии MSI H510.

- Исправлен мониторинг +12В на некоторых материнских платах серии ASUS Z590.

- Улучшена поддержка памяти LPDDR4, LPDDR4, LPDDR4X.

- Исправлена возможная ошибка WHEA / сбой системы во время длительного мониторинга графических процессоров AMD RX 6000 серии.

- Улучшен мониторинг датчиков на AsRock Z590 Taichi и Z590 PG Velocita.

- Консолидированный мониторинг AMD NAVI, добавлены эффективная частота и мощность TGP для NAVI21.

- Добавлены всплывающие подсказки по датчикам для предоставления более подробной информации по ним.

- Улучшена отзывчивость интерфейса программы.

- Улучшена обработка скрытия и показа датчиков в индивидуальном порядке.

- Исправлено возможное зависание при логировании датчиков с большим набором отключенных элементов.

- Добавлен мониторинг температуры GPU HotSpot для NVIDIA GPU.

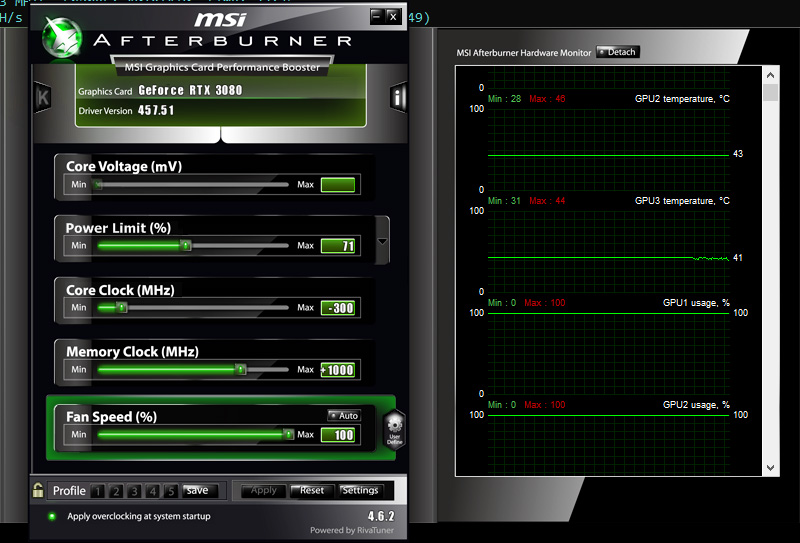

Такие инструменты, как MSI Afterburner показывают рабочую температуру графического процессора исходя из среднего значения от нескольких датчиков, находящихся в GPU. Графический процессор представляет собой большой кристалл с множеством транзисторов внутри, и разные его части могут находиться под разной нагрузкой, а некоторые части могут вообще простаивать время от времени. Это все приводит к разнице температур между разными участками кристалла. Так же внутри GPU находятся несколько термо-датчиков, которые отслеживают температуры в определенных местах кристалла, а специальный алгоритм усредняет эти значения в одно число, которое вы видите как "реальную" рабочую температуру графического процессора.

Измерение же температуры HotSpot, которое теперь сообщает HWiNFO последней бета-версии, показывает самую горячую точку, измеренную датчиками на графическом процессоре, и это значение однозначно выше, чем обычная cредняя температура, которую вы можете увидеть в других программах мониторинга, таких как например MSI Afreburner. Обратите внимание, что наличие большой разницы (10-15 градусов) между HotSpot и обычной средней температурой является обычным явлением, однако это может быть полезно для обнаружения потенциальных проблем с GPU или кулером видеокарты во время работы. Если вы видите разницу температур более 15 градусов и ваш GPU работает при этом не стабильно, стоит обратить на это внимание. Возможно имеется проблема с вентиляторами, термопастой или какие-то другие, связанные с неравномерным охлаждением GPU.

Читайте также: