Как разделить ресурсы видеокарты

Обновлено: 08.07.2024

Всем привет, дорогие друзья. Рад вас видеть! В недавней статье по "технологиям из прошлого" я затронул тему SLI. Раньше было нормой, когда в игровом компьютере стояло несколько видеокарт, которые трудились над одной картинкой.

Что примечательно, даже сегодня некоторые люди рассматривают покупку пары видеокарт в свой компьютер, вместо одной мощной. Почему так делать не стоит?

Технология SLI.

. Позволяет объединить несколько видеокарт в одной системе. Работает это так: изображение делится, после чего одна видеокарта обрабатывает одну часть, а вторая - другую. Изначально экран попросту делился "надвое", и одна видеокарта обрабатывала, к примеру, верхнюю часть, а вторая - нижнюю. Такой способ был практически самым первым и показал себя с худшей стороны.

Для объединения видеокарт в SLI нужен специальный мостик Для объединения видеокарт в SLI нужен специальный мостикПозже изображение научились делить самыми разными способами. Вообще работа этой технологии заслуживает отдельной статьи с описанием, поэтому просто примите в голову, что технология SLI - технология, которая позволяет объединить несколько видеокарт для обработки одной картинки.

Теоретически.

. Данная технология в идеальных условиях будет работать точно так. как ей полагается, а именно - мы получим производительность, кратную числу видеокарт. Правда, достижимо это только в теории, иначе этой статьи бы не было.

Почему нет?

Прежде чем мы разберемся с тем, почему все-таки твердо "нет", давайте вспомним, сколько современных проектов поддерживает SLI? Не буду вас томить, ибо таких проектов меньше половины. Это означает, что как минимум в половине проектов прироста от SLI не будет практически никакого.

Иными словами, движок игры, рассчитанный на работу с одной видеокартой, просто не будет давать указаний для работы второй видеокарты (это очень упрощенно), так что вот, теперь перейдем непосредственно к недостаткам:

Нет и еще раз нет

Сразу обозначу пару вещей, которые понятны абсолютно каждому: две видеокарты вдвое дороже, чем одна, они потребляют больше энергии, а значит им нужен более мощный ее источник, и сильнее греются, что значит - экономить на корпусе - совсем не наш вариант.

Реальный прирост производительности в SLI в игре, которая оптимизирована под работу с двумя видеокартами. Однако оптимизация играет роль: обратите внимание на 1 и 0.1%. За тесты спасибо ребятам из PRO Hi-TECH Реальный прирост производительности в SLI в игре, которая оптимизирована под работу с двумя видеокартами. Однако оптимизация играет роль: обратите внимание на 1 и 0.1%. За тесты спасибо ребятам из PRO Hi-TECHКроме того, производители видеокарт что AMD с их Crossfire, что Nvidia с их SLI, что производители игр - все они как-то обходят стороной тему оптимизации и тестирования работы пары видеокарт. Это значит, что разные неприятные ошибки вроде артефактов, будут встречаться гораздо чаще, чем хотелось бы.

А вот что будет, если оптимизации в игре нет. Одна видеокарта показывает производительность лучшую, чем две видеокарты. И если разницу среднего ФПС можно списать на погрешность, то с 1 и 0.1% - уже как-то все очень плохо. За фото все также благодарите ребят из PRO Hi-TECH А вот что будет, если оптимизации в игре нет. Одна видеокарта показывает производительность лучшую, чем две видеокарты. И если разницу среднего ФПС можно списать на погрешность, то с 1 и 0.1% - уже как-то все очень плохо. За фото все также благодарите ребят из PRO Hi-TECHПрибавьте к этому и то, что даже если все работает хорошо, то прирост от пары видеокарт не будет двукратным, а в лучшем (очень оптимистичном) случае - процентов 35-40. Ну и надо оно вам?

Технология SLI почти мертва

В 30-й линейке поддержку NVLink (подросший SLI), получила только одна видеокарта - RTX 3090, которая вроде как вообще является наследницей RTX Titan, то есть - профессиональной видеокартой.

Единственная видеокарта в 30-й линейке (если не брать в расчет профессиональные), способная работать в тандеме. Единственная видеокарта в 30-й линейке (если не брать в расчет профессиональные), способная работать в тандеме.Для игр, действительно, брать пару видеокарт смысла не имеет, однако в рабочих задачах вроде 3D моделирования, мощность лишней не бывает. Те программы, как правило, могут загрузить абсолютно все железо, которое имеется на компьютере. Такие дела, господа.

Если статья понравилась - не забудь поставить лайк, подписаться на канал (и исторический тоже ), а также на нашу группу ВК . До скорого!

Функция искусственного разделения ресурсов видеокарты на несколько виртуальных задач в настоящее время ограничена Grid/Tesla и рабочими станциями графических процессорах Quadro. Эта функция недоступна для игровой серии GeForce. По крайней мере, такой возможности не былодо сих пор. Благодаря довольно простому модулю под названием «vgpu_unlock» эта функция теперь может быть включена в потребительских графических картах.

реклама

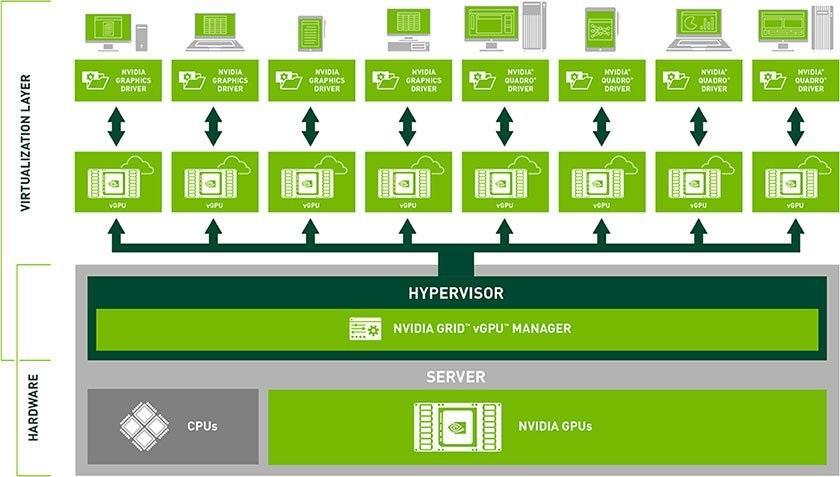

Виртуализация графического процессора - это способ виртуального распределения аппаратных ресурсов видеокарты между несколькими различными задачами. Это позволяет нескольким конечным пользователям использовать одну видеокарту для множества задач, таких как 3D-моделирование или научная работа. Многие пользователи пользуются подобной технологией, сами об этом не подозревая. Например, популярная игровая платформа GeForce Now работает по такому принципу. В ней компания NVIDIA использует графические процессоры GRID для виртуализации нескольких игровых сред для геймеров.

Теоретически теперь должна быть возможность включить одну видеокарту GeForce RTX 3090 для работы нескольких виртуальных машин и использовать ее для игр. Это было бы интересным решением проблемы нехватки графических карт. Особенно такая возможность может быть полезна в различных интернет-кафе и компьютерных клубах, которые могут использовать один графический процессор для работы нескольких компьютеров.

Мод на самом деле довольно прост, он обманом заставляет драйвер считывать другой идентификатор устройства PCI. Карты на архитектурах Pascal, Turing и Ampere интерпретируются драйвером, как карты Quadro или Tesla. Мод работает с программным обеспечением виртуальных машин Linux и KVM. Хотя хост-компьютер не может работать на операционной системе Microsoft Windows, виртуальные машины, которые будут подключены к основной системе, имеют такую возможность.

Таким образо, чтобы определить, поддерживает ли конкретный графический процессор функциональность vGPU, драйвер смотрит на идентификатор устройства PCI. Этот идентификатор вместе с идентификатором поставщика PCI уникален для каждого типа устройства. Чтобы включить поддержку vGPU, нужно сообщить драйверу, что идентификатор устройства PCI установленного графического процессора является одним из идентификаторов устройств, используемых графическим процессором с поддержкой vGPU.

Список всех поддерживаемых на данный момент видеокарт довольно обширен. Ознакомиться с ним можно, взглянув на изображение ниже.

Доброго времени!

В последнее время снискали большую популярность интегрированные (их еще называют встроенными ) видеокарты IntelHD, Intel Iris Xe, и AMD Ryzen Vega. Последних версий уже с лихвой хватает для многих не слишком требовательных игр (что, конечно, радует — т.к. получается хорошая такая экономия на покупке внешней видеокарты)!

Однако, есть один нюанс : видеопамять для этих карт выделяется из ОЗУ (RAM). По умолчанию эта операция "выделения" происходит автоматически (без вашего участия), что не во всех случаях оптимально (например, вы можете столкнуться с ошибками во время запуска игр. ).

Разумеется, было бы не плохо вручную отрегулировать выделение памяти под интегрированную карту (в большинстве случаев стоит вопрос ее увеличения ).

И так, перейдем ближе к теме.

Как увеличить видеопамять: по шагам

ШАГ 1: зачем это нужно

Вообще, если у вас все корректно работает, нет притормаживаний, ничего не зависает и не вылетает с ошибками — то вам, скорее всего, это и не нужно.

Однако, есть ситуации, когда без этого никак:

3DMark Sky Driver (8GB Ram, dual) — производительность в зависимости от выделенной памяти для интегрированной видеокарты AMD Ryzen Vega 11 (Ryzen 5 2400G)

Примечание!

ШАГ 2: как узнать текущий объем видеопамяти

Это универсальный вариант, работающий во всех популярных версиях Windows 7/8/10.

Сначала необходимо нажать сочетание кнопок Win+R — в окне "Выполнить" ввести команду dxdiag и кликнуть по OK.

Видеопамять 1009 МБ

Нажать сочетание Win+i — откроется окно с параметрами Windows. Необходимо перейти в раздел "Система / дисплей" и открыть вкладку "Дополнительные параметры дисплея" .

Доп. параметры дисплея

В ней будет заветная ссылка — "Свойства видеоадаптера" .

Во вкладке "Адаптер" представлена строка "Используется видеопамяти" (в моем примере ниже - 1024 МБ).

Этот вариант также актуален для ОС Windows 10.

Диспетчер задач - Windows 10

ШАГ 3: как вручную установить размер выделения памяти под встроенную видеокарту

Через BIOS/UEFI

Только через настройки BIOS (в принципе) и можно изменить размер выделяемой памяти для интегрированной карты (в редких случаях можно попытаться "обмануть" игры через реестр).

Здесь универсальных инструкций со стрелками дать нельзя, т.к. у каждого производителя - "свой" BIOS. Но несколько характерных примеров я приведу (по ним можно будет сориентироваться!).

Далее нужно перейти в раздел "Configuration" (в некоторых BIOS за это отвечает раздел "Advanced" ).

Lenovo Setup Utility - главное окно

Затем нам нужно найти один из следующих параметров (прим.: в разных версиях BIOS он называется по-своему) :

- UMA Frame Buffer Size;

- iGPU Configuration;

- DVMT (Fixed Memory);

- Share Memory Size;

- Video Memory Size;

- On-Chip Frame Buffer Size.

На скриншоте ниже приведен параметр "iGPU Configuration" — необходимо отключить авто-режим!

Отключаем Auto режим

UMA Frame Buffer Size — ставим 2 GB

Кстати, в версии BIOS от American Megatrends для изменения выделяемой памяти — нужно во вкладке "Advanced" изменить параметр "DVMT" .

Advanced / настройки BIOS / American Megatrends

DVMT ставим на Maximum

Share Memory Size - выделение памяти видеосистеме

Разумеется, после выставления размера выделяемой памяти — не забудьте сохранить настройки (в большинстве версий BIOS - используется клавиша F10 / Save and Exit) и перезагрузить компьютер/ноутбук.

Через настройки реестра (опционально для IntelHD)

Этот способ поможет только "перехитрить" некоторые игры, которые могут вылетать с ошибками после запуска (т.к. у вас якобы недостаточно видеопамяти). Т.е. игра будет "считать", что размер памяти видеокарты у вас больше, чем есть на самом деле.

Причем, хочу отметить, что срабатывает он не всегда (но всё же, вдруг. ).

regedit — открыть редактор реестра

Далее в редакторе нужно создать раздел "GMM" в нижеприведенной ветке:

Создать раздел GMM

После, в разделе "GMM" создать строковый параметр с именем "DedicatedSegmentSize" (без кавычек).

Создать строковый параметр

Далее открыть его и задать значение выделяемой памяти (судя по тестам, способ актуален и работает для значений от 0 до 512).

Группа энтузиастов сумела найти способ и включить данную функцию на пользовательских видеокартах GeForce.

Изначально GPU-виртуализация была доступна графическими процессорам линейки Quadro Grid и Tesla. Для её разблокировки на пользовательских картах, потребовалось задействовать простенькую модификацию — vgpu_unlock. И вуаля.

Специальная модификация заставляет драйвер считывать другой идентификатор устройства PCI, попутно маскируя условную геймерскую видеокарту под профессиональное решение на базе Quadro Grid и Tesla.

Виртуализация графического процессора позволяет распределять аппаратные ресуры видеокарты между несколькими устройствами. Пользователи могут использовать карту для множества задач, таких как 3D-моделирование или научная работа.

Однако большинству из нас она запомнилась, как облачная платформа GeForce Now, где ресурсы графических ускорителей разделены между несколькими пользователями.

Потенциально можно использовать флагманский ускоритель GeForce RTX 3090, для «питания» нескольких виртуальных машин и использовать её для игр. В нынешние времена, это может быть актуальным решением для владельцев интернет-кафе.

Список графических ускорителей, поддерживающий данную модификацию:

Как раз был видос на эту тему у Этот компьютер)

Всё же довольно нишевая штука. Для широкого потребителя это реально лишний функционал.

Впринципе ДА

Но для вот этой ниши, это писец как полезно

Ведь ненадо покупать ТочноТакую же видеокарту, просто с включенной парой программных технолгий, за Х10 цену

но вот только ради этого и производят карты с х10 наценкой. Загугли канал Этот комьютер в ютабе, там последний видос хорошо разжевал как и почему

Понятно, что это к этому видосу отсылка и есть. Да, его уже все видели. Все кидают.

Получишь только половину производительности своей карты в виртуалке и на хосте, эта технология полноценно только в A100 поддерживается

Позволит делать РЕНДЕР ФЕРМЫ на игровых картах

Что позволит сократить расходы на создание фермы того же качества в . раз 5 примерно или во сколько "профессиональные карты" дешевле игровых

Кхм, ну только если в облаке, но это нарушает правила NVIDIA, которые любой принимает, устанавливая их драйвер.

Для дома или офиса проще получать полный доступ к карте целиком и делать очередь, чем дробить виртуалки.

С каких это пор карты НВИДИА теперь распространяются по модели телефонов Эпл?

Насколько помню с 2017 года, но многие втихаря ставят консьюмерские карты.

А разницы между игровой и профессиональной сейчас у карт нет - кроме объема оперативки и драйверов которые разграничивают режимы работы чипа. Сам чип один и тот же внутри :)

Кто ж спорит, что большая часть разницы в софте. Это итак понятно. Чем меньше аппаратной разницы, тем меньше нужно усилий для разработки и производства карт.

Возможно в следующем поколении теперь выставят аппаратные ограничения. Продавать геймерские карты по четверной цене каждое поколение не получится, иначе геймеры потихоньку перейдут на консоли. А деньги нужны и от условно «нищих»геймеров и от профессионалов, готовых к многократным переплатам. ред.

Соглы, но иметь в наличии такую функцию, лишним не будет. Всё же приятно видеть, когда есть какие-то плюшки, фишки итд . Хоть вы этим и не воспользуетесь. (=

Можно крутить память из хоста в виртуальной машине как хочешь и это невозможно задетектить, читерами используется уже давно, а за любое сопротивление от античита на их стороне армия линуксоидов.

Комментарий удален по просьбе пользователя

Пусть, он довольно хорошо пишет

Комментарий удален по просьбе пользователя

Уже отказывался же

И правильно сделал. Не нужно потакать эксплуататорству московских мажориков с бритой попкой. 30к в месяц минус налоги за свой счет. Все равно, что расписаться в своей терпильности и быть готовым сдохнуть от истощения, чтобы написали, какой ты был хороший и нашли нового голодного хиккаря из провинции.

Всё очень просто, купите Aster. 20 Баксов спасшие меня от покупки второго компа. Думаю как нибудь написать гайд длинопост(ой), но мне пиздец как лень

Спасибо за решение. Посмотрел некоторые статьи. Всё же в этой программе есть недостатки. Например, некоторые программы не работают одновременно. Также, всё выполняется в рамках одной ОС, тогда как иногда требуются разные.

Ломать ноутбук об колено, или делить один экран на двоих не придется. Почти десять лет назад я…хз, за два года работы в фотошопе, видеомонтажке, 3д пакетах проблем не было, с двух рабочих мест параллельной работы. Плюс многие статьи по нему устарели очень сильно. установка не слишком сложная, главное внимательно читать инструкции програмы и документацию. Плюс имеет смысл оставить бекап, но астер при установке может сделать самостоятельно.

Единственное, что скажу, астер работал через жопу когда была амд 5700хт, но всё прекрасно заработало когда свапнулся на 2080. Более того паралльно можно играть в сетевые игры или синглы почти без напрягов. А вообще астер чудесная программа ибо в рабочих задачах комп не нагружен на 100%. Единственные неудобства которые я могу создать человеку который работает со мной - запустить рендер, так как видяха у нас одна.

И если тебе надо чтобы работал монитор с одного профиля, и ещё два с другого, увы, здесь нужна вторая видеокарта.

Либо сидишь с одного монитора на один профиль, и если надо как мне переключится на экраный графический планшет, чтож, немножко гемороя прийдётся потерпеть. кста ты меня на вёл на мысль, чтобы не перубаться с графического монитора и держать перед глазами рефы, сделаю ещё третий профиль если позволит лицензия. ред.

Помимо игры в Battlefield 1 и развлечений с VR-очками, установка отдельной видеокарты в сервер полезна при работе с графикой в виртуальной среде или для математических вычислений.

Использование GPU в серверной среде связано с некоторыми особенностями в каждом конкретном сценарии, поэтому разберем их подробнее.

Математика — царица наук

С появлением криптовалют и майнинга оказалось, что рассчитывать ключи шифрования на видеокартах получается быстрее, чем на обычных CPU.

Тому есть несколько причин:

У видеокарты больше арифметическо-логических модулей, чем в центральном процессоре, что позволяет выполнять большее число параллельных задач;

GPU обслуживается более производительной оперативной памятью;

Логика работы GPU проще, что снижает издержки каждой операции.

Например, Intel Xeon v4 с поддержкой AVX 2.0 способен выполнять 16 32-битных инструкций на ядре за такт, в то время как одна видеокарта NVIDIA GeForce GTX 1080 отрабатывает 8 228 аналогичных инструкций.

Сейчас математический обсчет на видеокартах используются не только для майнинга. Например, в корпоративном секторе есть более общие задачи:

Обсчет некоторых бизнес-приложений (анализ Big Data);

Графические задачи. Для массового создания изображений по 3D моделям удобнее использовать специальный сервер или рендер-ферму вместо компьютера дизайнера;

Ресурсоемкие задачи из сферы информационной безопасности. Брутфорс паролей на видеокартах — хорошее подспорье при тестировании на проникновение.

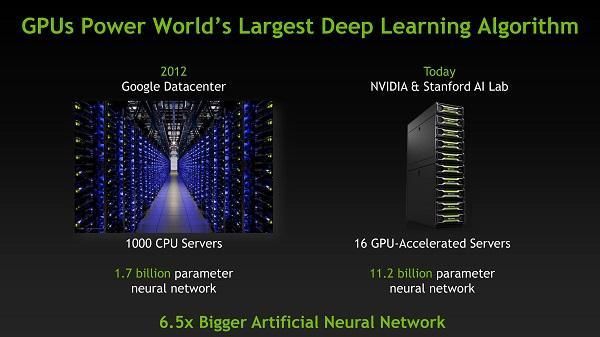

В последние годы видеокарты все больше используют для обучения нейронных сетей, как подвариант работы с Big Data. Популярный фреймворк Caffe работает на инстансах Амазона с GPU на порядок быстрее CPU.

Не так давно ко мне обратилась организация, поймавшая шифровальщика. По счастью, вирус был старый и файлы были зашифрованы PSK-ключом, а не сертификатом. Понадобилось два дня брутфорса при помощи Hashcat на нескольких игровых компьютерах коллег — и десятизначный ключ нашелся.

При переносе работы с процессора на GPU сложность в том, что нельзя просто сказать операционной системе «считай-ка, дорогуша, на видеокарте». Для работы напрямую с математическим модулем видеокарты нужна поддержка в конкретном приложении. Сам принцип такой работы называется GPGPU (General-purpose computing for graphics processing units), поэтому стоит искать поддержку чего-то подобного в описании возможностей ПО.

/>

Для работы приложений с математическим модулем видеокарты используются две технологии — CUDA и OpenCL:

CUDA. Программно-аппаратная технология от NVIDIA. SDK предоставляет возможность разработки на диалекте языка C. NVIDIA выпускает как обычные видеокарты с интерфейсом PCI-E, так и серверную линейку Tesla. Есть и оптимизированные для блейд-серверов видеокарты с интерфейсом MXM;

OpenCL. Открытый фреймворк, изначально разработанный группой компаний Khronos Compute. Поддерживается как в видеокартах NVIDIA, так и в моделях от AMD.

Экспериментальных сравнений производительности двух технологий можно найти немало. При работе с видеокартами AMD и NVIDIA примерно одного уровня, от использования OpenCL выигрывает AMD. Но если приложение разрабатывалось с поддержкой CUDA — лидирует уже NVIDIA. Поэтому выбор конкретной видеокарты обусловлен той архитектурой, которая была заложена в приложение.

Кроме обработки сложных математических задач видеокарту можно использовать и более профильно — для работы с «тяжелыми» графическими приложениями.

Виртуализируй это

Терминальные серверы и тонкие клиенты давно ценятся за удобство обслуживания и независимость от клиентских машин. Последние годы набирает популярность инфраструктура виртуальных рабочих столов (VDI), предлагающая каждому пользователю собственную виртуальную машину в дата-центре.

Если пересадить обычного офисного сотрудника на тонкий клиент не представляет особого труда и практически не сказывается на качестве работы, то отдельная категория стабильно вызывает головную боль — это дизайнеры, архитекторы и другие специалисты, использующие серьезные графические программы.

Решением проблемы может стать перевод требовательных пользователей на VDI вместо простого терминала. Потребуется гипервизор с поддержкой аппаратного ускорения графики. В 2016 году это умеют большинство гипервизоров, даже бесплатных.

Для проброса видеокарты нужно проверить соответствие системы ряду требований.

Если пользователей, желающих оценить плюсы отдельной графики, много, то можно приобрести специальные видеокарты с поддержкой разделения ресурсов.

Умеющие делить ресурсы модели есть у NVIDIA и AMD:

| NVIDIA | AMD | |||||

|---|---|---|---|---|---|---|

| Название технологии | GRID 2.0 | Multi User GPU (MxGPU) | ||||

| Наименование | Tesla M10 | Tesla M60 | Tesla M6 | FirePro S7150 | FirePro S7150 x2 | FirePro S7100X |

| Интерфейс | PCI-E | PCI-E | MXM | PCI-E | PCI-E | MXM |

| Количество пользователей GPU | 16 | 32 | 16 | 16 | 32 | 16 |

| Поддержка VMware | да | да | ||||

| Поддержка Citrix Xen | да | в разработке | ||||

| Поддержка MS Hyper-V | да, начиная с 2016 | в разработке | ||||

| Поддержка NICE | да | нет | ||||

| Технология работы | через специальный драйвер | аппаратная |

Еще у VMware в ассортименте присутствуют видеокарты GRID K и GRID К2, не попавшие в таблицу, так как морально устарели.

Поддержки карт с разделяемыми ресурсами пока что нет в бесплатных системах виртуализации. Если раньше XenServer всех редакций поддерживал работу «многопользовательской» карты, то теперь необходима редакция Enterprise. Для VMware понадобится редакция Enterprise Plus и выше.

Помимо виртуализации рабочих столов существует и виртуализация приложений (VMware Horizon, Citrix XenApp). Не обязательно выдавать дизайнеру полноценную рабочую станцию, можно виртуализировать, например, только Photoshop.

При разработке виртуальной среды с ускорением графики стоит обратить внимание не только на поддержку в гипервизоре, но и на совместимость с определенной моделью сервера. Совместимость видеокарт NVIDIA GRID с конкретными моделями серверов можно проверить на сайте NVIDIA. В частности, из серверов HPE сертифицирован для работы современной Tesla M60 только ProLiant DL380 Gen9. Эта же модель одобрена AMD.

Для блейд-серверов у AMD и NVIDIA есть решение с интерфейсом MXM, которое характеристиками схоже с картами для обычных серверов.

Основным минусом технологии ускорения графики в виртуальной среде является цена. Одна видеокарта стоит около $3 000 долларов, что сравнимо со стоимостью целого сервера. Кроме того, для нового проекта потребуется лицензия на гипервизор и, скорее всего, сервер определенной модели (помним про совместимость). Кроме того, при выборе карт NVIDIA нужна еще и лицензия на драйвер.

NVIDIA GRID позволяет использовать разделяемую видеокарту тремя способами:

| Виртуальное приложение | Виртуальный ПК | Виртуальная рабочая станция | |

|---|---|---|---|

| Удаленный рабочий стол | |||

| Удаленное приложение | |||

| Гостевая OS Windows | |||

| Гостевая OS Linux | |||

| Макс. количество мониторов | зависит от приложения | 2 | 4 |

| Макс. разрешение | зависит от приложения | 2560х1600 | 4096х2160 |

| Поддержка CUDA и OpenCL | |||

| Размер видеопамяти, на клиента | 1 Гб, 2 Гб, 4 Гб, 8 Гб | 512 Мб, 1 Гб | 512 Мб, 1 Гб, 2 Гб, 4 Гб, 8 Гб |

| Цена в год, за лицензию + SUMS* | $10 | $50 | $250 |

| Вечная лицензия** | $20 | $100 | $450 |

| SUMS1 | $5 | $25 | $100 |

*SUMS (Support, Update and Maintenance Subscriptions) — поддержка и обновления от NVIDIA.

**Для приобретения вечной лицензии необходимо приобрести SUMS хотя бы на первый год.

Ценник на лицензии сам по себе не большой, но суммарно внедрение всего программно-аппаратного решения обойдется довольно дорого. Тем не менее, если в компании большая часть сотрудников работает с громоздкими графическими приложениями, внедрение VDI может быть дешевле, чем поддержка парка мощных компьютеров.

Помимо математических расчетов и инфраструктуры мощных виртуальных машин с поддержкой графических приложений, можно использовать видеокарты и для игр. Например, создать облачный сервис для прохождения третьего ведьмака на высоких настройках на любом устройстве.

Читайте также: