Mgpu что это в видеокарте

Обновлено: 07.07.2024

Многие из вас слышали или читали об iGPU или dGPU, когда речь идет о графических картах . И очень важно знать, в чем различия между одним типом и другим. Один из этих типов может оказаться хуже другого или данный тип не нужен вам для вашей повседневной работы. Давайте разберем различия, если на вашем компьютере будет установлен iGPU или dGPU в качестве видеокарты.

iGPU

IGPU - акроним расшифровывается как «интегрированный графический процессор» . Т.е.- это встроенная видеокарта, или другими словами, это процессор, к которому был присоединен ряд вычислительных блоков, которые выполняют функции обычной видеокарты.

К примеру, сюда можно отнести все процессоры Intel Core с момента второго поколения. Дело в том, что ядро расчета и графическое ядро, связаны на одной плате. По крайней мере, в настоящее время. А первые iGPU были интегрированы в чипсет материнской платы.

Преимущество iGPU - Благодаря встроенному графическому адаптеру в процессор, вы сразу можете использовать графику без сторонней видеокарты. Именно поэтому они всегда использовались в дешевых системах, которые не требуют большой производительности в играх. Обычно такие ПК покупают для офисов. Они имеют малое энергопотребление в отличие от dGPU.

dGPU

DGPU - расшифровывается как «выделенный графический процессор» или выделенная видеокарта . Топовые производители таких видеокарт - это Gforce и AMD. Т.е. Вам нужно покупать отдельно видеокарту и подключать её к материнской плате настольного ПК через порт PCI, AGP или PCIe.

Для ноутбуков для ноутбуков такие видеокарты идут в формате MX.

Преимуществ DGPU - это производительность. Именно этот тип берут для игр. В отличие от iGPU, вам не нужно делить оперативную память с самим процессором, поскольку они имеют свою собственную выделенную VRAM . Энергопотребление dGPU может превосходить в 10 раз от iGPU.

Вывод : Хотите играть в игры ? Берите dGPU . Вам нужен ПК для офиса , чтобы ковыряться в офисе или работать в фотошопе? Берите iGPU .

Последние дни были горячими, но мы все же смогли заставить работать Radeon RX Vega 64 в конфигурации CrossFire, подобрав нужную конфигурацию аппаратного и программного обеспечения. В нашу тестовую лабораторию поступила видеокарта ASUS ROG Strix Radeon Vega 64 OC Edition, а AMD выпустила драйвер Radeon Software Crimson ReLive Edition 17.9.2, который открывает режим mGPU или CrossFire. Как показал тест видеокарты ASUS, партнеры AMD могут выделиться, прежде всего, системой охлаждения. Будет интересно посмотреть, как две видеокарты Radeon RX Vega 64 покажут себя в режиме совместной работы.

Перед тем, как мы приступим к тестам, позвольте сказать пару слов о Radeon RX Vega: Видеокарты Radeon RX Vega 64 и Vega 56 ждали очень долго, ожидания пользователей были весьма велики. Мы опубликовали тест эталонной версии, где также разобрали архитектуру Vega. Также мы провели дополнительные тесты High Bandwidth Memory Controller, майнинга криптовалют и разгона. Наконец, тест с пониженным напряжением дал весьма интересные результаты.

О сборке системы mGPU говорить особо нечего. Следует добавить в систему вторую видеокарту, после первой перезагрузки драйвер для второй видеокарты будет автоматически установлен. Если этого не произошло, следует установить самый свежий драйвер вручную. Затем режим mGPU будет автоматически активирован. Опять же, если этого не произошло, достаточно активировать опцию "mGPU" в настройках драйвера "Игры" - "Глобальные настройки".

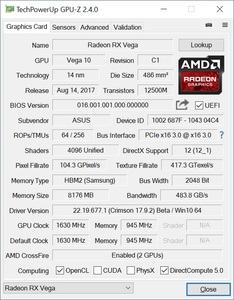

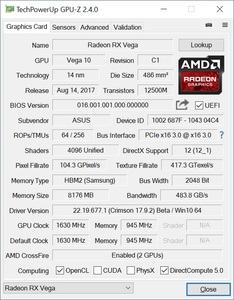

Активацию технологии mGPU можно проверить, например, в утилите GPU-Z.

Еще один способ проверки активации mGPU заключается в проверке LED на "тахометре" GPU у эталонной видеокарты. Впрочем, в зависимости от игры, технология mGPU работала не всегда. Но перейдем к результатам тестов.

В наше время редко можно встретить пользователей, имеющих две и более видеокарты в своем системном блоке. По большей части это объясняется дороговизной приобретения двух видеокарт или мизерным приростом производительности и куда выгоднее приобретать одну видеокарту, но дорогую и производительную, нежели две, но дешевле и слабее.

Несмотря на практически смерть технологий AMD CrossFire и NVIDIA SLI, API DirectX 12 поддерживает работу нескольких видеокарт через mGPU. Ресурс TweakTown решил заняться этим вопросом и протестировал две видеокарты AMD Radeon RX 6800 XT в режиме mGPU. В тестировании принимали участие разные модели видеокарт: референсная и от компании XFX.

Они тестировались в четырех проектах, которые поддерживают API DirectX 12, mGPU и оптимизированы под комплектующие AMD. Для теста были выбраны следующие игры: Deus Ex Mankind Divided, Rise of the Tomb Raider, Sniper Elite 4 и Strange Brigade. Все игры запускались в разрешениях 1080p, 1440p и 2160p.

Как показало тестирование, увеличение производительности сильно зависит от используемого разрешения: если в 1080p производительность увеличивается на 1-56%, в 1440p – на 39-93%, а может и упасть на 5%, то в 2160p она увеличилась на 57-93%. Объясняется это тем, что чем больше разрешение, тем сильнее задействуется видеокарта.

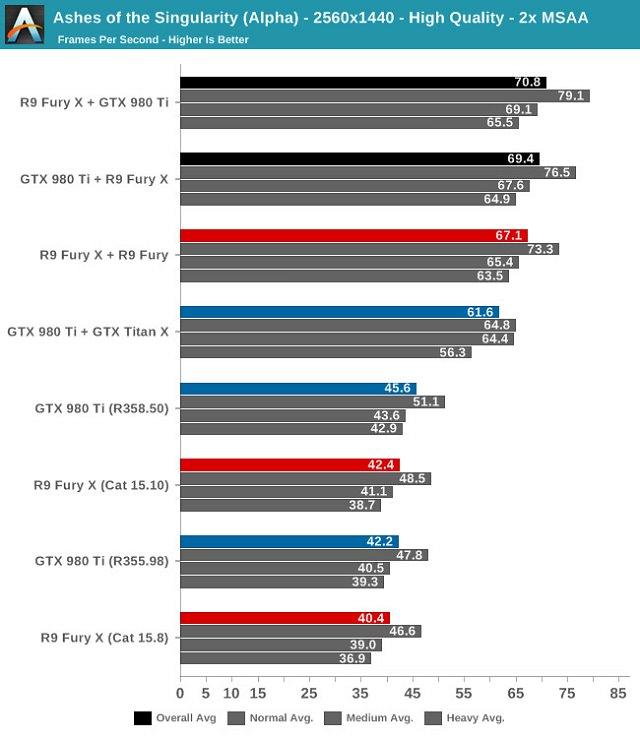

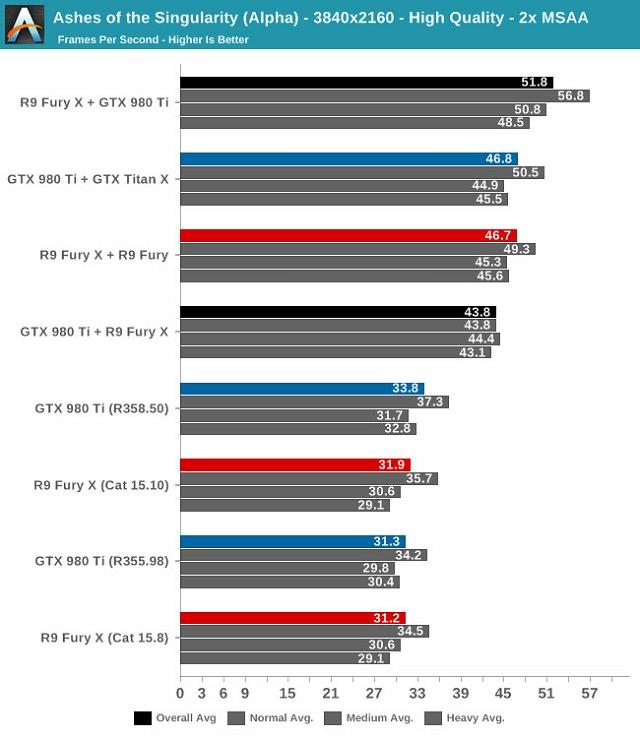

Одно из самых важных нововведений в DirectX 12 – это так называемый «asymmetric multi-GPU», функция, позволяющая соединять и запускать вместе видеопроцессоры от разных брендов, при условии поддержки определенного общего уровня технологий (в случае Ashes of Singularity – это Direct3D 12_0). Для работы этой функции недостаточно иметь две видеокарты с поддержкой DirectX 12, нужно также использовать их на приложениях, которые поддерживают DirectX 12. Проще говоря, если вы думаете, что прошлогодние игры на DirectX 11 заработают быстрее с этой функцией – ну, в общем, вы думаете неправильно. Команда Anandtech решила проверить заявления Microsoft о работоспособности этой функции и собрала систему с несколькими видеочипами, используя карты Radeon R9 Fury X и GeForce GTX 980 Ti. Выводы получились интересные.

Для начала, действительно, самый распространенный метод работы с несколькими картами – AFR, когда каждая карта обрабатывает только определенную часть кадров – работает. При его включении появился больше чем 50-процентный прирост производительности, но, увы, далеко не такой большой, как если бы использовались карты одного бренда в связке CrossFire или SLI. Во-вторых, на производительность влияло то, какая из видеокарт выбрана как основная. В Anandtech обнаружили, что конфигурация, в которой основной была R9 Fury X (то есть, к ней был подключен монитор), а GTX 980 Ti была вторичной, работала немного быстрее, чем при обратном варианте. Также через Multi-GPU работает запуск разных видеопроцессоров одного производителя (к примеру, GTX 980 Ti и GTX TITAN X). В чем же главный и неоспоримый плюс этой функции? В том, что система с R9 Fury X и GTX 980 Ti во всех тестах вела себя абсолютно стабильно.

Остается только гадать, сколько продлится это идиллическое состояние индустриальных стандартов, и сколько пройдет времени, прежде чем (может быть) производители видеочипов обнаружат, что это не идет на пользу их коммерческой выгоде. Судя по всему, и AMD, и NVIDIA потратили на мультичиповую оптимизацию довольно много ресурсов. И также только в несколько отдаленном будущем мы точно узнаем, какую часть этих ресурсов они предпочтут пустить на обеспечение мультичиповой производительности в унифицированной системе, а сколько – на собственные разработки SLI и CrossFire.

Интересующимся подробностями и хорошо читающим по-английски мы предлагаем ссылку на полный отчет Anandtech о проведенных тестах.

Читайте также: