Можно ли подключить видеокарту в pci e x4

Обновлено: 01.07.2024

Слоты PCI-Express 4-го поколения неоднозначная новинка в мире компьютерных комплектующих и далеко не всегда он нужен. Преимущества больших скоростей взаимодействия видеокарты с другими элементами ПК не имеет значительного смысла в средних и дорогих системах, а в бюджетных, слот PCI-E 4.0 ещё долго не появится. Но тогда в чём смысл? Нужно ли его брать и кому новый PCI будет полезен?

Начнём с того, что PCI-E 4.0 полностью совместим с 3-им поколением, что имеет свои плюсы. Прежде всего, нынешние видеокарты от Nvidia можно будет поставить даже в флагманские платы с чипсетами AMD. Но не только этим едины… Будущий чипсет B550 так же обзаведётся PCI-E 4.0 для SSD NVM-e и слотов PCI x16 для видеокарт.

Простыми словами, в новые платы можно будет поставить хоть GT730 не потеряв функционал.

Уверен, у некоторых пользователей могли возникнуть вопросы – почему это PCI-E 4.0 важен для бюджетных систем? В первую очередь, именно бюджетным видеокартам может не хватать собственной оперативной памяти в тяжёлых играх и здесь на помощь приходит ОЗУ. Именно в таком случае крайне важна скорость обмена информацией между графическим ускорителем и ОЗУ.

Для средних и дорогих систем эта проблема не столь критична, так как видеокарты имеют больше оперативной памяти и как следствие не нуждаются в помощи от плашек на материнской плате.

Для кого же PCI-E 4.0 будет полезен? В первую очередь для пользователей с бюджетными профессиональными системами для монтажа и рендеринга. Причина аналогична с бюджетными видеокартами в тяжёлых играх – нехватка собственно памяти. Разумеется, всё зависит от сложности проекта, но стандартные решения от Nvidia или AMD не всегда справляются собственными силами при объёме оперативной памяти в 6-8 Гб.

Для большинстве случаев PCI-E 4.0 пока не нужен из-за отсутствия необходимости. Наибольшее значение для рядового пользователя – скорость работы видеокарты с ОЗУ. Но как правило, видеокартам хватает и собственной памяти, а единственная из продающихся, только RX5500 на 4Гб способная реализовать потенциал PCI-Express 4.0 и воспользоваться им.

И всё же, новый PCI будет востребован в профессиональных задачах и бюджетных решениях от Nvidia, которые выйдут в этом году.

Спецификация PCI Express 4.0

Организация PCI-SIG, занимающаяся развитием и стандартизацией шины PCI Express (PCIe), в октябре 2017 года утвердила спецификацию стандарта PCI Express 4.0.

Стандарт PCI Express 3.0 был утвержден около семи лет назад, в ноябре 2010 года.

В стандарте PCI Express 4.0 определена передача данных со скоростью 16 млрд передач в секунду (GT/s), гибкое конфигурирование линий и скорости.

В спецификации PCI Express 3.0 закреплена максимальная скорость 8 GT/s.

PCIe 4.0 обеспечивает удвоение скорости в расчете на линию — до 16 GT/s.

Учитывая то, насколько широко стандарт распространился, PCI-SIG решила улучшить гибкость и масштабируемость подключений.

Так, разработчики получат доступ к большему числу линий, различным конфигурациям и скоростям, необходимым для маломощных систем.

Другие изменения включают снижение задержек, улучшенную масштабируемость дополнительных линий и лучшее разграничение.

PCI Express 4.0 работает со скоростью 4 GT/s (гигатранзакций в секунду), что эквивалентно 1.969 Мбайт/с для одной линии.

Если карта расширения будет подключена по полным 16 линиям, пропускная способность увеличится с 15,75 Гбайт/с до 31,51 Гбайт/с.

А для M.2 SSD с четырьмя линиями — с 3,94 до 7,87 Гбайт/с.

Ограничение мощности из слота в PCIe 4.0 останется на уровне PCIe 3.0 — 75 Вт.

PCI Express 4.0 сохраняет полную обратную совместимость с PCIe 3.0 от программного обеспечения от синхронизации архитектуры до механических интерфейсов.

То есть карты PCIe 1.x, 2.x и 3.x будут легко подключаться к слотам PCIe 4.0 и будут работать на самых высоких уровнях производительности этих карт.

Аналогично, все карты PCIe 4.0 подключаются к PCIe 1.x-, PCIe 2.x- и PCIe 3.x-слотам и работают на уровнях производительности, поддерживаемых этими слотами.

Каждый раз при смене поколений интерфейса PCI-express, возникает множество споров о том, что видеокарты, которые используют новую версию не заведутся на старых материнских платах, либо будут работать гораздо медленнее. В распоряжении автора снова оказалась GeForce RTX 3080 версии Gigabyte Gaming. Она, как и все представители RTX 3000, поддерживает актуальную версию интерфейса PCI-e 4.0, а благодаря своей производительности и сохранинию стабильных частот ГПУ под нагрузкой, может послужить хорошим маркером для тестирования интерфейсов PCI-e 3.0 и PCI-e 4.0.

Давайте посмотрим, сколько кадров в секунду мы потеряем, если будем использовать карту на интерфейсе PCI-e 3.0.

Вариант статьи для тех, кому лень читать

Конечно, в нынешней ситуации с дефицитом видеокарт количество таких историй тоже стало гораздо меньше: но интернет помнит, как в более сытые годы сплошь и рядом раздавались авторитетные советы менять платформу на новую для установки GeForce GTX 750 Ti. «Поставите карту на материнку с PCI-e 2.0 – она будет работать на 20-25% медленнее!» - сокрушались тогда разного рода эксперты.

Ранее разница между двумя актуальными версиями интерфейса PCI-e уже рассматривалась на примере Radeon RX 5500 XT в вариантах с 8 и 4 гб памяти на борту. Но с тех самых пор автора донимало любопытство: а что будет, если взять гораздо более производительную видеокарту? Проявится ли разница в более ощутимых величинах, будет ли она в действительности двукратной или хотя бы близкой к этому?

Тестовый стенд и методика тестирования

Конфигурация тестового стенда уже знакома постоянным читателям.

- Центральный процессор: AMD Ryzen 9 3900X;

- Система охлаждения процессора: ID-Cooling SE-207;

- Термоинтерфейс: Arctic MX-2;

- Материнская плата: Gigabyte X570 Aorus Master (биос F33F);

- Оперативная память: Kingston HX437C19FB3K2/32, 2x16gb;

- Дисковая подсистема: SSD Gigabyte GP-ASM2NE6200TTTD + HDD Western Digital WD10EZRX-00A8LB0;

- Корпус: Corsair Carbide 270R;

- Блок питания: Cougar GX-F 750.

Частота процессора Ryzen 9 3900X на время тестов фиксировалась на отметке в 4200 МГц. Оперативная память разгонялась до частоты в 3800 МГц с таймингами, которые по-прежнему можно найти в ее обзоре. Видеокарта работала в штатном режиме, никаких модификаций над ней не производилось.

На время тестов отключались все фоновые программы, за исключением, разумеется, лаунчеров, необходимых для запуска игр.

Переключение между PCI-e 4.0 и PCI-e 3.0

В прошлый раз выбор платформы AM4 вызвал буйный восторг у комментаторов: «УУУУ, тесты на X570, все тут понятно!».

Но в реальном мире тестовая платформа позволяет вручную устанавливать режим работы разъемов PCI-e. Причём - отдельно для слотов x16 и остальных разъёмов под карты расширения.

И это отнюдь не фикция. Установив третью генерацию интерфейса для слотов с 16-ю линиям, при помощи той же GPU-Z можно увидеть, что видеокарта под нагрузкой использует именно интерфейс версии 3.0, хотя и она сама, и тестовая плата по-прежнему поддерживают PCI-e 4.0.

В режиме простоя, как и у всех современных видеокарт, версия интерфейса будет снижаться до 1.1, но под нагрузкой – не будет выше той, что была назначена вручную.

Синтетические тесты

Разумеется, различия заключаются не только в показаниях одной графы в GPU-Z.

Так, если запустить соответствующий тест из пакета 3Dmark, то можно заметить, что пропускная способность интерфейса версии 3.0 для GeForce RTX 3080 составляет всего 13.07 гигабайта в секунду, да и количество фпс в тестовой сцене лишь немногим отличается.

А если переключиться на версию 4.0 – пиковая пропускная способность возрастет до 26.29 гигабайта, да и кадров в секунду станет заметно больше.

То есть – теоретическая разница в пропускной способности интерфейса для RTX 3080 является буквально двукратной – как, впрочем, было и с RX 5500 XT годом ранее.

Но, как и в случае с RX 5500 XT, следует помнить, что это – именно разница в пиковой пропускной способности, которая имеет умозрительное значение.

А реальное значение, когда мы говорим о видеокартах, имеет уже производительность самих устройств в синтетике и реальных играх.

Так какой будет эта разница?

На третьей версии интерфейса в 3Dmark Fire Strike тестовая система выбивает 30 526 итоговых баллов, и 42 268 баллов за графику. Переключимся на четвёетую версию интерфейса – и получим 30 696 общих баллов в 3Dmark и 42 719 баллов за графику в этом же тесте.

Результат в Unigine Superposotion на PCI-e 3.0 – 21 894 балла. Если же вернуться к актуальной версии интерфейса - результат в этом тесте возрастет до 21 969 баллов.

Разница есть и наблюдается в каждом из трех показателей – то есть нельзя сказать, что дело в погрешности измерений, пропускная способность интерфейса свой вклад тоже вносит.

Однако, почему-то, эта разница не только не является двукратной, но даже на меметичные 20-25% никак не тянет.

Но, может быть, эти самые «20 процентов» покажут игры? Особенно если выставить максимальные или близкие к ним настройки графики, и провести замеры не только в FullHD, но и в QuadHD?

Тесты в играх

Assassin’s Creed: Valhalla

Cyberpunk 2077

DOOM Eternal

Mafia: Definitive Edition

Metro: Exodus

Project CARS 3

Red Dead Redemption 2

The Outer Worlds

Total War: Three Kingdoms

Заключение

Споры о якобы существующей несовместимости или потере существенной части производительности видеокарт при их установке в платформу с более ранней версией интерфейса PCI-e – это уже неотъемлемая часть истории.

Так было при переходе с первой версии на вторую, со второй на третью, с третьей на четвертую. Будьте уверены: при появлении материнских плат и видеокарт, использующих PCI-e 5.0, во вселенной комментариев абсолютно ничего не изменится.

Нет, никто здесь не собирается спорить с тем, что теоретическая пропускная способность интерфейса PCI-e возрастает с каждым поколением. Попросту глупо это отрицать, учитывая, что это четко указано в паспортных характеристиках интерфейса и подтверждается на практике, как минимум синтетическими тестами.

Но надо иметь ввиду, что это – разница именно в максимальной пропускной способности, то есть в объеме данных, который в принципе можно передать по этому интерфейсу за единицу времени.

А вот будет ли эта характеристика реально влиять на производительность видеокарты – зависит от того, какими объемами данных она реально оперирует.

В этом материале вы могли видеть пример GeForce RTX 3080. Карта эта уже далеко не топовая, но по-прежнему очень быстрая и большинство других моделей, поддерживающих PCI-e 4.0, однозначно уступят ей в производительности.

И тем не менее – даже для RTX 3080 реальная разница между двумя интерфейсами – не только не двукратная, но и не составляет даже 20%, и даже редко где наберет 5%. А во многих случаях и вовсе составит 1-2 кадра. Что, при общем уровне производительности, больше походит на погрешность измерений, чем на влияние пропускной способности интерфейса.

Поэтому главный вопрос, который стоит задать себе в данном контексте: если для столь мощной карты разница настолько незначительна, то почему для менее производительных моделей она должна быть больше?

А ответ прост: больше она не будет.

Конечно, все это не относится к тем случаям, когда на платформе со старой версией интерфейса установлен также более медленный процессор и оперативная память. Например, если речь идет о платформе Intel LGA 1150, где интерфейс PCI-e 3.0 соседствует с четырехъядерными процессорами и памятью стандарта DDR3.

Или, если угодно – при сравнении систем на платформе Socket AM4, одна из которых поддерживает одновременно процессоры Ryzen 5000 и PCI-e 4.0, а вторая вынуждена ограничиваться моделями семейства Ryzen 3000 и PCI-e 3.0.

В этих случаях, разумеется, разница будет гораздо заметнее.

Только вызвана она будет уже не версией интерфейса PCI-e, а гораздо более очевидными причинами. И говорить в таком случае придётся уже не о разнице, обусловленной стандартом PCI-e, а о разнице в общей производительности системы.

Инструкция по видеокартам

Что такое видеокарта

Видеокарта является основным элементом видеоподсистемы любого более или менее производительного компьютера (за исключением самых дешёвых офисных систем с интегрированным в чипсет видео). К основным компонентам видеокарты относятся: графический процессор (с легкой руки nVidia, именуемый GPU - Graphic Processing Unit), от возможностей которого во многом зависит производительность всей видеоподсистемы, и видеопамять (служащая для хранения различных элементов выводимого изображения, включая графические примитивы, текстуры и прочее).

Производители видеокарт

На рынке по производству дискретных графических процессоров всего две компании – nVidia и ATI/AMD. А их партнеры, такие как ASUS, Gigabyte, Sapphire, MSI и др., занимаются продажей видеокарт на базе GPU или от nVidia, или от ATI/AMD. У каждого из таких производителей есть как свои плюсы, так и минусы. В прошлом разработкой и выпуском видеоплат занимались сами производители и не всегда их разработки были безупречными. За ошибки в производстве приходилось расплачиваться покупателям, пользователи получали проблемы с качеством изображения, перегревом и стабильностью.

Поэтому, чтобы решить эти проблемы, было решено выпускать видеокарты на базе референсного дизайна, т.е. дизайн платы уже разрабатывают сами производители графических процессоров nVidia и AMD. Хотя описанные проблемы все еще встречаются в бюджетных видеокартах.

Хотя особых отличий у видеокарт разных производителей не так много (именно у тех кто выпускает по референсному дизайну), стоит покупать видеокарты у лидеров рынка, таких как:

ASUS, Sapphire, Gigabyte, MSI

Менее популярные фирмы-производители, но с достаточно качественными видеокартами :

Zotac, PowerColor, Palit

Хотя рекомендовать определенного производителя довольно сложно, все зависит от конкретной модели и ее ценового класса.

Нужно понимать, что дорогие видеокарты mid-end или high-end класса, выпускаются на одном заводе. Производители видеокарт клеят на них наклейки со своим логотип, меняют стандартное охлаждение на более эффективно и менее шумное. Так что кроме цены, упаковки и охлаждения разницы между ними нет, ну и возможно гарантийным сроком.

Чтобы привлечь покупателя к своей продукции, производители слегка «разгоняют» видеокарты. Такие видеокарты маркируются аббревиатурой OC (overcloced), но не всегда. Производительность разогнанных видеокарт зачастую не превышает 10 процентов и проделанная работа будет входить в стоимость видеокарт. После разгона видеокарты начинают сильнее греться и производители ставят свои системы охлаждения на замену стандартных. Конечно, они решили проблему с перегревом, но пользователь получит повышенную шумность, хотя если будет установленная качественная система охлаждения, то она может работать тише стандартной. В подробных характеристиках на сайтах производителя можно узнать шумность видеокарты.

Влияние процессоров на производительность видеокарт

Если качество 3D-игр имеет для вас большое значение, то имейте в виду, что установка высокопроизводительной видеокарты в компьютер, оснащённый слабым центральным процессором (CPU), не обеспечит вам той мощности графики, на которую вы рассчитываете. Это объясняется тем, что одной из функций центрального процессора является обеспечение видеокарты информацией, необходимой для её работы. Игры с высоким разрешением изображения требуют не только быстрой видеокарты, но и быстрого центрального процессора. Существуют и такие игры, которые не станут сильно загружать ваш не очень производительный процессор и будут довольствоваться лишь высокой мощностью видеокарты, но это как правило не очень "навороченные" 3D-игры. Большинство игр с усовершенствованной 3D-графикой требуют строгого соответствия между скоростью процессора и скоростью видеокарты. Однако увеличить разрешение экрана и активировать функцию, отвечающую за качество изображения (например, устранение контурных неровностей), мощная видеокарта позволит вам и вне зависимости от производительности центрального процессора. Но стоит вам запустить игру с насыщенной 3D-графикой, как ваш низкопроизводительный процессор начнёт заметно "тормозить" и видеокарте придётся потратить немало времени в ожидании того момента, когда CPU разберётся со всеми поставленными перед ним задачами. Разумеется, появление технологии DirectX10 значительно улучшило технические возможности видеокарт и позволило снизить объём данных, поступающих в видеокарту из центрального процессора, что в свою очередь способствовало уменьшению зависимости производительности видеокарты от мощности CPU. Однако, зависимость всё же осталась, поэтому при покупке видеокарты вам стоит подумать и о производительности процессора.

Что такое reference и non-reference видеокарты

Референс - это видеокарта сделанная по дизайну самого производителя (nVidia, ATi) то-есть - печатная плата, питание, охлаждение - всё сделано по рекомендованной ATi или nVidia конструкции. Часто референсные системы охлаждения малоэффективны и "запас прочности" в них практически отсутствует. Часто видеокарты от сторонних производителей (Palit,XFX,Sapphire,ASUS и др.) отличаются всего лишь только наклейкой , это тоже референс.

Нереференс - это видеокарта которая разработана по дизайну стороннего производителя (Palit,XFX,Sapphire,ASUS и др.) , чаще всего модифицированное охлаждение (либо вообще пассивное охлаждение), зачастую усиленные цепи питания и более качественные элементы.

PCI-E 1.0/2.0/3.0

Интерфейс PCI-Express (PCI-E) – это средство взаимодействия, в данном контексте, состоящее из контролера шины и соответствующего слота

на материнской плате (если обобщить).

Данный высокопроизводительный протокол используется, как уже было отмечено выше, для подключения видеокарты в систему. Соответственно, на материнской плате присутствует соответствующий слот PCI-Express, куда и устанавливается видеоадаптер. Ранее, видеокарты, подключались по интерфейсу AGP, но когда данного интерфейса, попросту говоря: "перестало хватать", на помощь пришёл PCI-E.

Несмотря на то, что названия PCI и PCI-Express очень похожи, принципы соединения (взаимодействия) у них кардинально отличаются. В случае PCI-Express используется линия – двунаправленное последовательное соединение, типа "точка-точка", данных линий может быть несколько. В случае с видеокартами и материнскими платами (не учитываем Cross Fire и SLI), которые поддерживают PCI-Express x16 (то есть большинство), можно запросто догадаться, что таких линий 16

довольно часто на материнских платах с PCI-E 1.0, можно было наблюдать второй слот x8, для работы в режиме SLI или Cross Fire.

Ну, а в PCI, устройство подключается к общей 32- х разрядной параллельной шине.

Для интерфейса PCI-Express 1.0 пропускная способность составляет 2,5 Гбит/c. Эти данные нужны нам, чтобы отслеживать изменения этого параметра в различных версиях PCI-E.

Далее, версия 1.0 эволюционировала в PCI-E 2.0. В результате данного преображения, мы получили в два раза большую пропускную способность, то есть 5 Гбит/c, но хотелось бы отметить, что в производительности графические адаптеры, особо не выиграли, так как это просто версия интерфейса. Большая часть производительности зависит от самой видеокарты, версия интерфейса может только незначительно улучшать или тормозить передачу данных (в данном случае "торможения" нет, и присутствует неплохой запас).

Точно так же в 2010 году, с запасом, был разработан интерфейс PCI-E 3.0, на данный момент он используется во всех новых системах, но если у Вас все ещё 1.0 или 2.0, то не горюйте – ниже мы поговорим о относительно обратной совместимости различных версий.

В версии PCI-E 3.0, пропускная способность была увеличена в два раза по сравнению с версией 2.0. Также там было произведено немало технических изменений.

К 2015 году ожидается появление на свет PCI-E 4.0, что для динамической IT-индустрии абсолютно неудивительно.

Довольствуясь системой с материнской платой, которая поддерживает PCI-Express 1.0, возникают сомнения, будет ли корректно работать видеокарта с PCI-Express 2.0 или 3.0? Да, будет, по крайней мере так обещают разработчики, которые обеспечили эту самую совместимость. Единственное то, что видеокарта, не сможет полностью раскрыться во всей красе, но потери производительности, в большинстве случаев, будут незначительны.

С точностью наоборот, можно преспокойно устанавливать видеокарты с интерфейсом PCI-E 1.0, в материнские платы, которые поддерживают PCI-E 3.0 или 2.0, тут вообще ничего не ограничивается, так что будьте спокойны по поводу совместимости. Если, конечно же, с другими факторами все в порядке, к таковым можно отнести недостаточно мощный блок питания и т.д.

Энергопотребление

Видеокарты без дополнительного питания - до 75 W

С дополнительным питанием (один 6-pin) - до 150 W

C дополнительным питанием (два 6-pin) - до 225 W

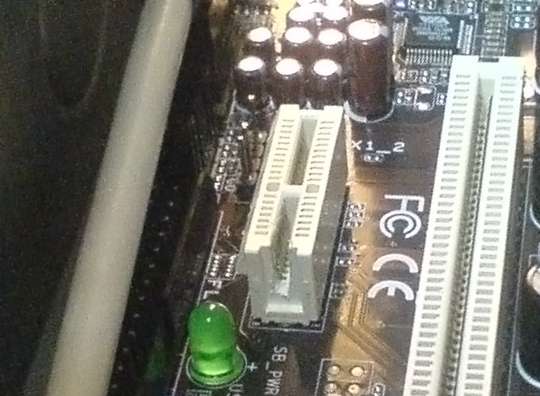

Если в компьютере имеются 2 видеовыхода и захотелось подключить 3 монитора, то с некоторой вероятностью сделать это просто добавлением второй видеокарты не удастся — не все материнские платы имеют 2 разъёма PCI Express X16, а в многочисленные разъёмы PCI Express X1 видеокарты обычного размера не встанут из-за несовместимости по разъёму. Не все знают, что на самом деле установка длинного разъёма X16 в короткий слот возможна, поэтому не обязательно для 3-го монитора покупать другую и более дорогую материнскую плату. Способам расширения потенциальных возможностей компьютера посвящена эта статья, а также она развеивает сомнения и опасения о том, что что-то при доработке платы напильником не получится. Час работы — и 3-й монитор к Вашей системе будет подключен.

Проблема установки 2 видеокарт существует из-за того, что большинство слотов PCI-Express x1 имеют пластмассовый бортик на конце, дальнем от стенки корпуса компьютера, а видеокарты не имеют прорези для совместимости с бортиком. Как показывается ниже, проблема решается простым прорезанием этого бортика.

Для чего это может понадобиться?

1) Для установки 3-го монитора в систему.

Все способы предполагают материальные затраты и более ограниченный выбор вариантов конфигурации. Если уже имеется плата со свободным слотом PCI-Express x1 и видеокарта с разъёмом PCI-Express x16, проще поступить так, как описано ниже.

Способ 1.6) Сделать прорезь на любом разъёме PCIe X1, удобном для установки видеокарты.

(рис. 6)

2) Для подключения видеокарт в режиме Crossfire.

Строго говоря, для этого режима предусмотрены специальные материнские платы. Но, возможно, решение будет работать и с любой парой разъёмов PCIe (не проверялось).

Процесс доработки разъёма.

Перед работой убедитесь, что на материнской плате действительно будет свободное место для установки свободно висящего «хвоста» разъёма PCI-Express x16. Могут быть детали (конденсаторы, другие разъёмы), которые, в лучшем случае, удастся перепаять, разместив в другом положении.

Прорезание стенки достаточно просто, но требует соблюдения нескольких технических моментов в плане аккуратности операции.

1) материнскую плату лучше вынуть из корпуса, так как неосторожным движением можно повредить целостность разъёма или окружающих деталей;

2) прорезание выполнять так, чтобы не треснула пластмасса разъёма в основании. Поэтому, не использовать кусачки, резать острым скальпелем или лезвием для строительного ножа, соскабливая мелкими кусками или дремелем (машинкой для боров с установленной циркулярной пилой или наждачным диском), но осторожно, чтобы не повредить контакты. Нарушение целостности пластмассы тоже может привести к раздвиганию контактов, ненадёжному соединению.

3) срезая кусочки пластмассы острым ножом, следует быть очень осторожным, чтобы не срезать пружинящие контакты, которые находятся буквально в миллиметре от места операции. Если резать неострым ножом, на процедуру уходит времени 25-30 минут, а контакты, вероятнее, оказываются более защищены тем, что неострое лезвие их не перережет. На практике, у меня один контакт отогнулся вовнутрь, в пространство для текстолита карты, но затем его удалось подогнуть обратно.

4) пластмассу срезать до уровня дна разъёма; на фото показан процесс последовательного выскабливания стенки разъёма до нужной глубины:

(рис. 7)

5) перед установкой видеокарты внимательно проверить, что контакты не загнуты вовнутрь и видеокарта их не повредит.

6) при установке видеокарты — проверить, не прикоснётся ли оголённый разъём видеокарты проводящих поверхностей (радиаторы, детали). Если есть такая опасность, изолировать разъём или поверхности хотя бы скотчем или толстой бумагой, прикреплённой к карте.

(рис. 8)

7) После установки 2-й видеокарты — закрепить её за корпус, так как точка крепления за один маленький разъём PCIe довольно опасна для целостности самого разъёма.

На практике, я игнорировал рекомендацию (1), потому что места для работ внутри корпуса хватало и пользовался неострым б/у-лезвием. Стружки изнутри разъёма выдувал через трубку от шариковой ручки (использование офисных инструментов).

(рис. 9)

Столь незначительный набор инструментов (лезвие, трубка, возможно — скотч) и около часа времени на установку — небольшая плата за возможность подключения 3-го монитора. Может быть, он окажется лишним, но проверить удобство работы с ним и без него лишним не будет.

(рис. 10)

Установка 3-го монитора в системе (Windows XP)

При включении компьютера на вторую карту видеосигнал сначала не подаётся, дисплей сообщает о неподключённом кабеле. Операционная система без проблем обнаруживает видеокарту и подключает драйвер, если это карта того же производителя, что и первая, ранее установленная. WinXP просит перезапустить себя после автоустановки драйвера без каких-либо специальных действий для этого. После перезапуска система стала видеть монитор на второй видеокарте, а монитор обнаружил подключение кабеля.

(рис. 12)

(Интересно, что 2-й монитор на 1-й видеокарте пронумеровался в системе третьим.)

После активации монитора в свойствах дисплея (возможно, потребуется запуск мастера подключения мониторов, зависит от драйвера) на нём появляется фон рабочего стола.

(рис. 13)

Остаётся настроить разрешение и частоту подключения. При установке монитора ЭЛТ не забываем установить частоту развёртки не менее 70 Гц, чтобы не пользоваться 60 Гц по умолчанию. Для LCD-мониторов такое действие не нужно.

(рис. 14)

Если производители чипов (NVidia, ATI, Matrox) разные, нужно установить второй драйвер — обычно, по отзывам из других статей, они уживаются вместе (UPD: по подсказке Jeditobe и подтверждению guessss_who, Windows Vista не поддерживает одновременно драйверы разных производителей видеокарт. XP и Win7 этим не страдают.). В настройках дисплея из системы подключается нужное количество дополнительных мониторов. Результат:

(рис. 15)

В других статьях были неоднократные измерения производительности видеокарт на разъёме PCI-Express x1, в которых показано, что все видеокарты уровня ниже ATI 3850 / GF 9800 в любых режимах и играх ведут себя практически одинаково по сравнению с разъёмом PCI-Express x16 — им хватает предельного потока данных через 1 канал PCI-Express, равного 250 Мбайт/с в одну сторону (500 Мбайт/с в обе).

Если для видеокарты не стоят игровые задачи или она маломощная, то решение на PCIе x1 почти не будет уступать другим решениям с более дорогой материнской платой (кроме некоторых очень требовательных приложений наподобие Microsoft Flight Simulator, Crysis, Call Of Duty 4).

Читайте также: