Пиковая производительность процессора это

Обновлено: 03.07.2024

В вычислении , операции с плавающей точкой в секунду ( FLOPS , флоп или флоп / с ) является мера производительности компьютера , полезной в области научных вычислений , которые требуют с плавающей точкой вычислений. Для таких случаев это более точная мера, чем измерение инструкций в секунду .

СОДЕРЖАНИЕ

Арифметика с плавающей точкой

Арифметика с плавающей запятой необходима для очень больших или очень маленьких действительных чисел или вычислений, требующих большого динамического диапазона. Представление с плавающей точкой похоже на научную нотацию, за исключением того, что все выполняется по основанию два, а не десять. Схема кодирования хранит знак, показатель степени (в базе два для Cray и VAX , в базе два или десять для форматов с плавающей запятой IEEE и в базе 16 для архитектуры IBM с плавающей запятой ) и значащее выражение (число после точки счисления ). Хотя используется несколько похожих форматов, наиболее распространенным является ANSI / IEEE Std. 754–1985 . Этот стандарт определяет формат для 32-битных чисел, называемых одинарной точностью , а также для 64-битных чисел, называемых двойной точностью, и более длинных чисел, называемых расширенной точностью (используется для промежуточных результатов). Представления с плавающей запятой могут поддерживать гораздо более широкий диапазон значений, чем с фиксированной запятой, с возможностью представлять очень маленькие числа и очень большие числа.

Динамический диапазон и точность

Возведение в степень, присущее вычислениям с плавающей запятой, обеспечивает гораздо больший динамический диапазон - наибольшие и наименьшие числа, которые могут быть представлены, - что особенно важно при обработке наборов данных, где некоторые из данных могут иметь чрезвычайно большой диапазон числовых значений или где диапазон может быть непредсказуемым. Таким образом, процессоры с плавающей запятой идеально подходят для приложений с интенсивными вычислениями.

Вычислительная производительность

FLOPS и MIPS - это единицы измерения производительности вычислительных машин компьютера. Операции с плавающей запятой обычно используются в таких областях, как научные вычислительные исследования. Единица MIPS измеряет целочисленную производительность компьютера. Примеры целочисленных операций включают перемещение данных (от A к B) или проверку значений (если A = B, то C). MIPS в качестве эталона производительности подходит, когда компьютер используется для запросов к базе данных, обработки текстов, электронных таблиц или для запуска нескольких виртуальных операционных систем. Фрэнк Х. МакМахон из Ливерморской национальной лаборатории Лоуренса изобрел термины FLOPS и MFLOPS (мегафлопы), чтобы он мог сравнивать суперкомпьютеры того времени по количеству вычислений с плавающей запятой, которые они выполняли в секунду. Это было намного лучше, чем использование распространенного MIPS для сравнения компьютеров, поскольку эта статистика обычно мало влияла на арифметические возможности машины.

FLOPS в системе HPC можно рассчитать с помощью этого уравнения:

Это можно упростить до наиболее распространенного случая: компьютер с ровно 1 процессором:

FLOPS может быть записан с различными показателями точности, например, в списке суперкомпьютеров TOP500 компьютеры ранжируются по 64-битным ( формат с плавающей запятой двойной точности ) операциям в секунду, сокращенно FP64 . Аналогичные меры доступны для 32-битных ( FP32 ) и 16-битных ( FP16 ) операций.

Количество FLOP на цикл на ядро для различных процессоров

| Микроархитектура | ЭТО | FP64 | FP32 | FP16 |

|---|---|---|---|---|

| Процессор Intel | ||||

| Intel 80486 | x87 (32-бит) | ? | 0,128 | ? |

| Intel P5 Pentium Intel P6 Pentium Pro | x87 (32-бит) | ? | 0,5 | ? |

| Intel P5 Pentium MMX Intel P6 Pentium II | MMX (64-бит) | ? | 1 | ? |

| Intel P6 Pentium III | SSE (64-бит) | ? | 2 | ? |

| Intel Netburst Pentium 4 (Willamette, Northwood) | SSE2 (64-бит) | 2 | 4 | ? |

| Intel P6 Pentium M | SSE2 (64-бит) | 1 | 2 | ? |

| Intel Netburst Pentium 4 (Prescott, Cedar Mill) Intel Netburst Pentium D (Smithfield, Presler) Intel P6 Core ( Yonah ) | SSE3 (64-бит) | 2 | 4 | ? |

| Intel Core ( Мером , Пенрин ) Intel Nehalem ( Нехалем , Вестмер ) | SSSE3 (128 бит) SSE4 (128 бит) | 4 | 8 | ? |

| Intel Atom ( Bonnell , Saltwell , Silvermont и Goldmont ) | SSE3 (128 бит) | 2 | 4 | ? |

| Intel Sandy Bridge ( Sandy Bridge , Ivy Bridge ) | AVX (256 бит) | 8 | 16 | 0 |

| Intel Haswell ( Haswell , Devil's Canyon , Broadwell ) Intel Skylake ( Skylake , Kaby Lake , Coffee Lake , Comet Lake , Whisky Lake , Amber Lake ) | AVX2 и FMA (256 бит) | 16 | 32 | 0 |

| Intel Xeon Phi ( Уголок рыцарей ) | SSE и FMA (256 бит) | 16 | 32 | 0 |

| Intel Skylake-X Intel Xeon Phi ( Knights Landing , Knights Mill ) | ||||

AVX2 (128 бит) Экскаватор

(ANSI 77 с векторными расширениями)

Рекорды производительности

Записи на одном компьютере

В июне 1997 года Intel «s ASCI Red был первым в мире компьютер для достижения одного терафлопс и за ее пределами. Директор Sandia Билл Кэмп сказал, что ASCI Red обладает лучшей надежностью среди всех когда-либо построенных суперкомпьютеров и «является высшей точкой для суперкомпьютеров по долговечности, цене и производительности».

NEC «S SX-9 суперкомпьютер был первым в мире векторного процессора превысит 100 гигафлопса за одно ядро.

К 2007 году корпорация Intel представила экспериментальный многоядерный чип POLARIS , обеспечивающий производительность в 1 терафлопс на частоте 3,13 ГГц. 80-ядерный чип может повысить этот результат до 2 терафлопс на частоте 6,26 ГГц, хотя тепловыделение на этой частоте превышает 190 Вт.

26 июня 2007 года IBM анонсировала второе поколение своего топового суперкомпьютера, получившего название Blue Gene / P и разработанного для непрерывной работы на скоростях, превышающих один петафлопс, быстрее, чем Blue Gene / L. При такой настройке он может развивать скорость более трех петафлопс.

25 октября 2007 года японская корпорация NEC выпустила пресс-релиз, в котором объявляла о своей модели SX-9 серии SX , утверждая, что это самый быстрый векторный суперкомпьютер в мире. SX-9 показывает первый процессор , способный пиковая производительность вектора 102,4 гигафлопса на одном ядра.

4 февраля 2008 года NSF и Техасский университет в Остине начали полномасштабные исследования на суперкомпьютере AMD , Sun под названием Ranger , самой мощной в мире суперкомпьютерной системе для открытых научных исследований, работающей с постоянной скоростью 0,5 петафлопс. .

25 мая 2008 года американский суперкомпьютер « Roadrunner », построенный IBM , достиг вычислительного рубежа в один петафлопс. Он возглавил список TOP500 самых мощных суперкомпьютеров (без учета grid-компьютеров ) за июнь 2008 г. и ноябрь 2008 г. Компьютер находится в Лос-Аламосской национальной лаборатории в Нью-Мексико. Название компьютера относится к птице штата Нью-Мексико , большой дорожной бегуне ( Geococcyx californianus ).

В июне 2008 года AMD выпустила серию ATI Radeon HD 4800, которые, как сообщается, станут первыми графическими процессорами, достигающими одного терафлопс. 12 августа 2008 года AMD выпустила видеокарту ATI Radeon HD 4870X2 с двумя графическими процессорами Radeon R770 общим объемом 2,4 терафлопс.

В ноябре 2008 года модернизация суперкомпьютера Cray Jaguar в Национальной лаборатории Окриджа (ORNL) Министерства энергетики (DOE) подняла вычислительную мощность системы до пика 1,64 петафлопс, что сделало Jaguar первой в мире системой с петафлопс, предназначенной для открытых исследований . В начале 2009 года суперкомпьютер был назван в честь мифического существа Кракен . Kraken был объявлен самым быстрым суперкомпьютером в мире, управляемым университетом, и шестым в рейтинге TOP500 2009 года. В 2010 году Kraken был модернизирован и теперь может работать быстрее и мощнее.

В 2009 году Cray Jaguar показал 1,75 петафлопс, обойдя IBM Roadrunner и заняв первое место в списке TOP500 .

В октябре 2010 года Китай представил Tianhe-1 , суперкомпьютер, работающий с максимальной вычислительной скоростью 2,5 петафлопс.

По состоянию на 2010 год самый быстрый процессор ПК достиг 109 гигафлопс ( Intel Core i7 980 XE ) в вычислениях с двойной точностью. Графические процессоры значительно мощнее. Например, вычислительные процессоры Nvidia Tesla C2050 GPU выполняют около 515 гигафлопс в вычислениях с двойной точностью, а AMD FireStream 9270 достигает максимальной скорости 240 гигафлопс.

В ноябре 2011 года было объявлено , что Япония достигла 10,51 петафлопс с К компьютеру . Он имеет 88,128 SPARC64 VIIIfx процессоры в 864 стойках, с теоретической производительностью 11,28 петафлопс. Он назван в честь японского слова « кей », которое означает 10 квадриллионов , что соответствует целевой скорости 10 петафлопс.

15 ноября 2011 года Intel продемонстрировала единственный процессор на базе x86 под кодовым названием Knights Corner, выдерживающий более терафлопс в широком диапазоне операций DGEMM . Intel подчеркнула во время демонстрации, что это был устойчивый терафлопс (а не «сырой терафлопс», используемый другими для получения более высоких, но менее значимых чисел), и что это был первый процессор общего назначения, который когда-либо преодолевал терафлопс.

18 июня 2012 года суперкомпьютерная система IBM Sequoia , базирующаяся в Ливерморской национальной лаборатории США (LLNL), достигла 16 петафлопс, установив мировой рекорд и заняв первое место в последнем списке TOP500.

12 ноября 2012 года рейтинг TOP500 подтвердил Titan как самый быстрый суперкомпьютер в мире согласно тесту LINPACK со скоростью 17,59 петафлопс. Он был разработан Cray Inc. в Национальной лаборатории Ок-Ридж и сочетает в себе процессоры AMD Opteron с технологиями графического процессора (GPU) NVIDIA Tesla «Kepler».

10 июня 2013 года китайский Tianhe-2 был признан самым быстрым в мире с показателем 33,86 петафлопс.

20 июня 2016 года китайский Sunway TaihuLight был признан самым быстрым в мире с 93 петафлопс в тесте LINPACK (из 125 петафлопс). Система, которая почти полностью основана на технологии, разработанной в Китае, установлена в Национальном суперкомпьютерном центре в Уси и обеспечивает более высокую производительность, чем следующие пять самых мощных систем в списке TOP500 вместе взятые.

В июне 2019 года Summit , суперкомпьютер IBM, который сейчас работает в Национальной лаборатории Ок-Ридж (ORNL) Министерства энергетики США, занял первое место с производительностью 148,6 петафлопс в тесте High Performance Linpack (HPL). используется для ранжирования списка TOP500. Summit имеет 4356 узлов, каждый из которых оснащен двумя 22-ядерными процессорами Power9 и шестью графическими процессорами NVIDIA Tesla V100.

Записи распределенных вычислений

Распределенные вычисления используют Интернет, чтобы связать персональные компьютеры для достижения большего количества FLOPS:

- По состоянию на апрель 2020 года общая вычислительная мощность сети Folding @ home превышает 2,3 экзафлопса. Это самая мощная распределенная компьютерная сеть, которая впервые в истории превысила 1 экзафлопс общей вычислительной мощности. Такой уровень производительности в первую очередь достигается за счет совокупных усилий огромного количества мощных графическихпроцессоров и процессоров .

- По состоянию на декабрь 2020 года вся сеть BOINC в среднем составляет около 31 петафлопса.

- По состоянию на июнь 2018 года производительность SETI @ Home , использующая программную платформу BOINC , составляет в среднем 896 терафлопс.

- По состоянию на июнь 2018 года проект Einstein @ Home , использующий сеть BOINC , работает со скоростью 3 петафлопса.

- По состоянию на июнь 2018 года MilkyWay @ Home , использующий инфраструктуру BOINC , вычисляет 847 терафлопс.

- По состоянию на июнь 2020 года GIMPS , ищущий простые числа Мерсенна , выдерживает 1354 терафлопс.

Стоимость вычислений

Затраты на оборудование

| Дата | Приблизительно доллар США за гигафлопс | Платформа, обеспечивающая самую низкую стоимость GFLOPS | Комментарии | |

|---|---|---|---|---|

| Не скорректировано | 2020 г. | |||

| 1945 г. | 129,49 трлн долларов | $ 1881,79 трлн. | ENIAC : 487000 долларов в 1945 году и 7195000 долларов в 2019 году. | 487000 долл. США / 0,0000000385 GFLOPS |

| 1961 г. | 18,7 млрд долларов | 161,9 млрд долларов | Базовая установка IBM 7030 Stretch стоила в то время 7,78 млн долларов США каждая. | IBM 7030 Натяжные выполняет одну с плавающей точкой умножить каждые 2,4 микросекунды. |

| 1984 г. | 18 750 000 долл. США | 46 710 000 долл. США | Крей X-MP / 48 | 15 000 000 долл. США / 0,8 GFLOPS |

| 1997 г. | 30 000 долл. США | 48 000 долл. США | Два 16-процессорных кластера Beowulf с микропроцессорами Pentium Pro | |

| Апрель 2000 г. | 1000 долларов США | 1 530 долл. США | Кластер Бунип Беовульф | Bunyip была первой вычислительной технологией стоимостью менее 1 доллара США за мегафлопс. В 2000 году он получил премию Гордона Белла. |

| Май 2000 г. | 640 долл. США | 975 долл. США | KLAT2 | KLAT2 была первой вычислительной технологией, которая масштабировалась для крупных приложений, оставаясь при этом менее 1 доллара США за MFLOPS. |

| Август 2003 г. | 82 доллара США | 115 долларов США | KASY0 | KASY0 была первой вычислительной технологией стоимостью менее 100 долларов США за гигафлопс. |

| Август 2007 г. | 48 долларов США | 60 долларов США | Микровульф | По состоянию на август 2007 г., этот «персональный» кластер Beowulf со скоростью 26,25 GFLOPS может быть построен за 1256 долларов. |

| Март 2011 г. | 1,80 доллара США | 2,09 $ | HPU4Science | Этот кластер стоимостью 30 000 долл. США был построен с использованием только имеющегося в продаже оборудования «игрового» уровня. |

| Август 2012 г. | 0,75 доллара США | 0,85 долл. США | Система Quad AMD Radeon 7970 ГГц | Четырехъядерный настольный компьютер AMD Radeon 7970, обеспечивающий производительность вычислений одинарной точности 16 терафлопс и 4 терафлопс двойной точности. Общая стоимость системы составила 3000 долларов США; построен с использованием только имеющегося в продаже оборудования. |

| июнь 2013 | 0,22 доллара США | 0,24 доллара США | Sony PlayStation 4 | Пиковая производительность Sony PlayStation 4 составляет 1,84 терафлопс по цене 400 долларов. |

| Ноябрь 2013 | 0,16 доллара США | 0,18 доллара США | Система AMD Sempron 145 и GeForce GTX 760 | Система, построенная с использованием имеющихся в продаже компонентов, с использованием одного AMD Sempron 145 и трех Nvidia GeForce GTX 760 достигает в общей сложности 6,771 терафлопс при общей стоимости 1090,66 долларов США. |

| Декабрь 2013 | 0,12 доллара США | 0,13 доллара США | Система Pentium G550 и Radeon R9 290 | Построен с использованием имеющихся в продаже запчастей. Intel Pentium G550 и AMD Radeon R9 290 имеют максимальную производительность в 4,848 терафлопс, что составляет 681,84 доллара США. |

| Январь 2015 | 0,08 доллара США | 0,09 доллара США | Система Celeron G1830 и Radeon R9 295X2 | Построен с использованием имеющихся в продаже запчастей. Intel Celeron G1830 и AMD Radeon R9 295X2 превысили 11,5 терафлопс при общей сумме 902,57 долларов США. |

| Июнь 2017 г. | 0,06 доллара США | 0,06 доллара США | AMD Ryzen 7 1700 и AMD Radeon Vega Frontier Edition | Построен с использованием имеющихся в продаже запчастей. Процессор AMD Ryzen 7 1700 в сочетании с картами AMD Radeon Vega FE в CrossFire достигает максимальной производительности более 50 TFLOPS при цене чуть менее 3000 долларов США за всю систему. |

| Октябрь 2017 г. | 0,03 доллара США | 0,03 доллара США | Intel Celeron G3930 и AMD RX Vega 64 | Построен с использованием имеющихся в продаже запчастей. Три видеокарты AMD RX Vega 64 обеспечивают половинную точность чуть более 75 TFLOPS (38 TFLOPS SP или 2,6 TFLOPS DP в сочетании с ЦП) при цене |

3 × NVIDIA RTX 3080 @ 29770 Гфлопс каждый и 699,99 долларов США

Общий объем GFLOPS = 89,794 / TFLOPS = 89,2794

Общая стоимость системы, вкл. реалистичные, но недорогие детали; соответствует другому примеру = 2839 долларов США

В данной части учебного пособия излагаются основы организации и функционирования компьютеров. Рассматриваются показатели производительности компьютеров и процессоров, приведена структура компьютера, описаны её основные компоненты. Подробно рассмотрен центральный процессор, включая его структуру, особенности системы команд, принцип конвейерной обработки команд, основные режимы работы, особенности построения и функционирования современных микропроцессоров. Рассмотрены основные характеристики и разновидности устройств памяти, принципы их построения и функционирования. Проиллюстрировано функционирование компьютера при выполнении команд. Настоящее учебное пособие предназначено для студентов, обучающихся по направлению 09.03.02 «Информационные системы и технологии», а также может быть полезно студентам, обучающихся по другим направлениям, связанным с применением компьютеров в различных прикладных областях.

Оглавление

- Введение

- 1. Основные понятия

- 2. Производительность компьютеров и её оценка

Приведённый ознакомительный фрагмент книги Организация ЭВМ и периферийные устройства предоставлен нашим книжным партнёром — компанией ЛитРес.

2. Производительность компьютеров и её оценка

Производительность компьютера является объективной мерой эффективности его функционирования и используется в качестве одного из основных его технических параметров. Производительность определяется архитектурой и рабочей частотой процессора, пропускной способностью системной шины, типом и объёмом оперативной и кэш-памяти и другими особенностями конфигурации. Кроме того, она зависит от типа используемой ОС, применённых для получения программы трансляторов с языков программирования, конкретных приложений и др.

Таким образом, понятие производительности компьютера является весьма многоплановым, в связи с чем для её оценки используется целый ряд различных показателей.

2.1. Показатели производительности

Различают следующие показатели производительности:

1. Пиковая — максимально достижимая производительность процессорной подсистемы компьютера, включающей процессор, кэш — и оперативную память.

2. Номинальная — средняя производительность процессорной подсистемы компьютера.

3. Системная — средняя производительность всей аппаратно-программной системы ПК в целом, т.е. с учётом обмена данными с жёстким диском, видеосистемой, и другими внешними устройствами, взаимодействия с ОС.

4. Эксплуатационная — производительность компьютера на реальной рабочей нагрузке, с учётом конкретных используемых приложений, например текстовых процессоров, систем автоматизации проектирования, компиляторов и др.

Очевидно, что для обычного пользователя наибольший интерес представляет именно эксплуатационная производительность компьютера на наиболее часто используемых приложениях. Если же набор таких приложений не определён, то используются значения системной, номинальной и пиковой производительности.

2.2. Методы определения показателей производительности

2.2.1. Пиковая производительность

Пиковая производительность — производительность процессорной подсистемы компьютера при выполнении коротких команд, т.е. команд, не выполняющих обращений к оперативной и кэш-памяти. Такие команды обычно связаны с выполнением различных регистровых операций (например, инкремент регистра INC AX, пересылка данных MOV AX, BX) и могут выполняться за один цикл работы процессора.

Таким образом, пиковая производительность — число команд типа «регистр — регистр», выполняемых процессорной подсистемой в единицу времени без учета статистического веса таких команд в реальных программах. Обычно пиковая производительность оценивается для команды типа «Нет операции» (NOP — No OPeration) 2 .

Пиковая производительность зависит как от тактовой частоты процессора, так и от его архитектуры и микроархитектуры. Для выявления эффективности архитектуры и микроархитектуры целесообразно проводить сравнение пиковой производительности процессоров при одинаковой частоте.

2.2.2. Номинальная производительность

Номинальная производительность — среднее число команд, включая команды обмена с оперативной памятью, выполняемых в единицу времени процессорной подсистемой. Используемые при этом наборы команд подбирают с учетом их статистического веса (частоты использования) в популярных приложениях и имитируют реальную нагрузку на процессорную подсистему.

Номинальная производительность измеряется при помощи как абсолютных (количество операций в секунду), так и относительных единиц (программные тесты).

В качестве абсолютных используются следующие единицы:

• количество миллионов инструкций (команд) в секунду, MIPS (Million Instructions Per Second);

• количество операций в секунду над числами с плавающей точкой, FLOPS (FLoating-point Operations Per Second), а также производные единицы MFLOPS, GFLOPS, TFLOPS, PFLOPS и др.

Для оценки номинальной производительности широко используется тестовый пакет SPEC CPU от фирмы SPEC (Standard Performance Evaluation Corporation) 3 . Пакет вычисляет две оценки — SPECint и SPECfp, представляющие целочисленные вычисления и вычисления над числами с плавающей точкой соответственно.

Тест SPECint использует универсальные наборы команд над числами с фиксированной точкой и сбалансирован по типам операций, глобальных и локальных переменных и констант в результате статистического исследования и усреднения по большому числу реальных программ (архивация, компиляция с С, комбинаторная оптимизация, искусственный интеллект, игра в шахматы, сжатие видео). Таким образом, тест фактически оценивает производительность процессорной подсистемы без учёта математического сопроцессора.

Тест SPECfp использует базовые арифметические команды над числами с фиксированной и плавающей точками одинарной и двойной точности с равновероятным распределением команд, операции вычисления тригонометрических функций, логарифмов и др. (распознавание речи, уравнение Максвелла, вычисление 3-мерных моделей в гидравлике, моделирование биомолекулярных систем, имитация отжига, симплес-метод).

Результат измерения выдается в виде коэффициента соотношения производительности тестируемой системы к производительности эталонной системы. В качестве эталонной системы корпорация SPEC выбрала систему Sun «Ultra Enterprise 2» на базе процессора Sun UltraSPARC II с частотой 296 МГц (1997 г.), но с увеличенным объемом кэша и оперативной памяти.

2.2.3. Системная производительность

Результаты оценки системной производительности некоторого компьютера обычно приводятся относительно базового компьютера стандартной конфигурации либо относительно некоторого набора компьютеров. Результаты оформляются в виде сравнительных таблиц, двухмерных и трёхмерных графиков и диаграмм.

Одним из известных тестов системной производительности является Business Winstone 4 . Тест Winstone измеряет среднюю производительность компьютера при выполнении популярных офисных Windows — приложений с учётом величины занимаемого этими приложениями сектора рынка (текстовые процессоры, электронные таблицы, системы управления базами данных, программы деловой графики, издательские системы и т.д.). Результаты теста Winstone представляются в виде индекса производительности относительно базового ПК.

Сектор рынка, занимаемый некоторым приложением, косвенно определяет удельный вес общего компьютерного времени, используемого данным приложением.

Популярным тестом системной производительности является также пакет SYSmark. Он широко используется специалистами по информационным технологиям, производителями компьютерного оборудования, аналитиками и журналистами. Тесты SYSmark SE разделены на два сценария: создание интернет-контента и офисная производительность. В тесте создания интернет-контента можно выделить три тестовые группы: 3D-графика, 2D-графика и web-публикация. Сценарий офисной производительности также разделён на три тестовые группы: связь (электронная почта, календарь и просмотр web-страниц), создание документов и анализ данных. Приложения запускаются не последовательно, одно за другим (как в предыдущих версиях), а одновременно, и в процессе прохождения теста осуществляется переключение между ними, что точнее соответствует реальным условиям типичной офисной работы.

2.2.4. Эксплуатационная производительность

Эксплуатационная производительность — производительность компьютера (либо его компонента или подсистемы) при выполнении конкретных приложений. Так, например, если компьютер предполагается использовать преимущественно для решения задач автоматизации проектирования, то целесообразно протестировать его тестами AutoCAD, которые интегрально оценивают производительность ПК на этой нагрузке. Соответственно оценивается производительность тестами С Сomplier (тест компиляции с языка Си), Adobe Photoshop (тест фотоэффектов программы PhotoShop), текстовых процессоров (загрузка, прокрутка, печать документов, поиск/замена фрагментов текста), Quake (игровой тест) и т.д.

В случае систематического использования на компьютере нескольких приложений для оценки эксплуатационной производительности может быть сформирован интегральный показатель на основе определения весовых коэффициентов отдельных приложений.

2.3. Производительность процессоров

Достаточно продолжительное время основной мерой производительности процессоров и компьютеров в целом служила их тактовая частота. Однако по мере усложнения внутренней организации микропроцессоров (кэш-память, конвейерная обработка, суперскалярность, многоядерность и т.д.) этот параметр утратил своё определяющее значение. В настоящее время для оценки производительности процессоров используется ряд специальных единиц.

Для измерения производительности своих 32-разрядных процессоров фирма Intel в 1992 г. предложила следующую единицу: индекс относительной производительности микропроцессоров Intel, называемый iCOMP Index (Intel COmparative Microprocessor Performance Index).

В 1996 г. была введена новая единица — iCOMP Index 2.0, ориентированная на Pentium (MMX) — процессоры. При вычислении этого индекса полностью исключены 16-битные операции и добавлен мультимедийный тест (≈20 %).

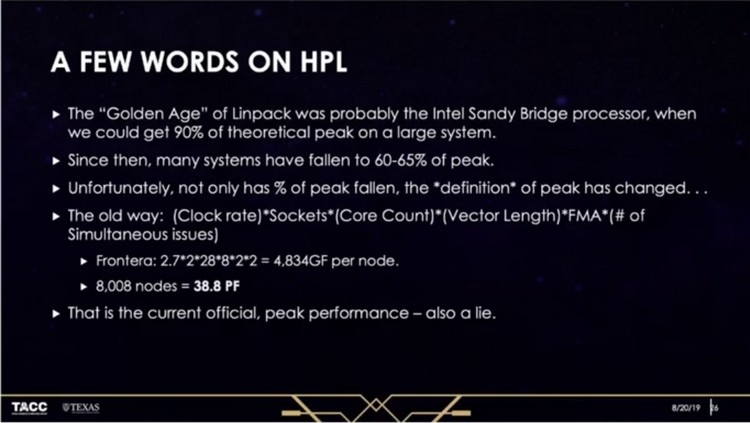

Данный термин просто потерял свою актуальность для современных компьютеров и особенно высокопроизводительных систем. Если раньше реальная производительность составляла примерно 90 % от максимальной, то сейчас это значение может падать и до 60–65 %. И, собственно, все об этом знают, но продолжают его использовать…

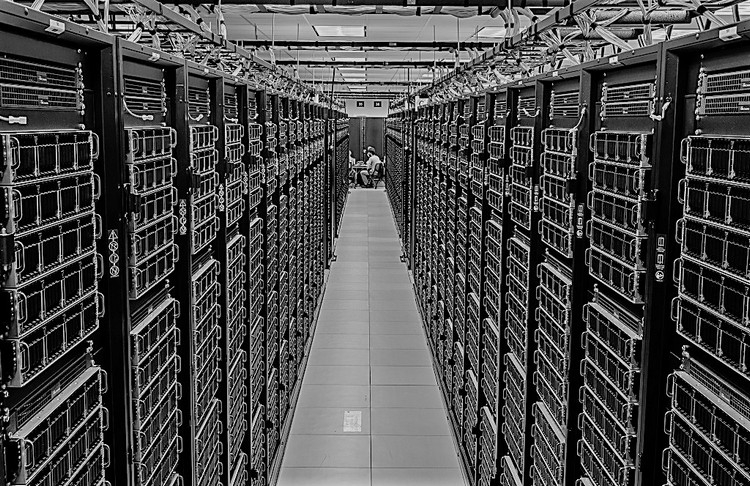

Максимальная производительность суперкомпьютеров является величиной теоретической, рассчитываемой лишь на основе технических характеристик системы. Однако такие расчёты редко отражают реальное положение вещей, на что и указывает Ден Станционе (Dan Stanzione), директор Центра передовых вычислений Университета Техаса (TACC).

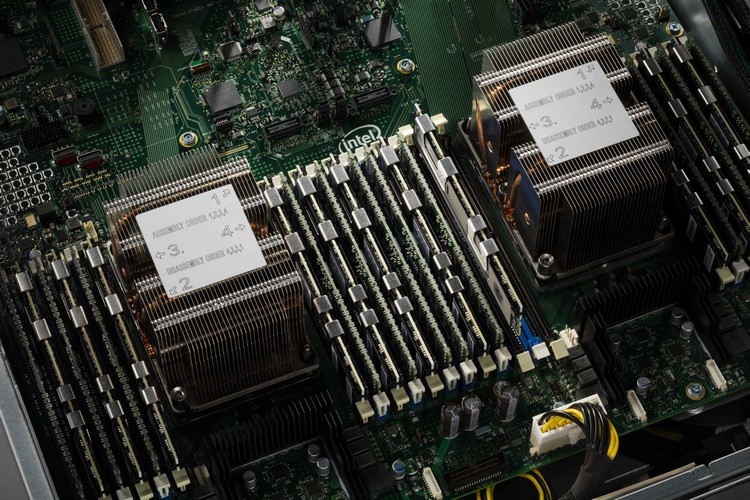

В качестве примера в своём докладе Ден Стенционе приводит суперкомпьютер Frontera, расположенный как раз в вычислительном центре Техасского университета. Особенностью данного компьютера является то, что для расчётов в нём используются, в частности, новые центральные процессоры Xeon Platinum 8280. Максимальная теоретическая производительность этой системы равна 38,7 петафлопс, тогда как тест производительности Linpack (HPL) оценивает производительность в 23,5 петафлопс. Это самый производительный публичный академический суперкомпьютер в мире.

Пиковая, или максимально возможная производительность системы рассчитывается теоретически: перемножаются количество ядер процессора, количество самих процессоров, ширина вектора, число операций FMA за такт и тактовая частота. Однако полученное значение не будет справедливо для разных задач и инструкций.

Например, при использовании инструкций AVX-512 процессоры Intel работают с более низкими тактовыми частотами из-за повышения температуры. Если базовая частота тех же Xeon Platinum 8280 составляет 2,7 ГГц, то при работе с AVX-512 она опускается, согласно данным TACC, в среднем до 1,8 ГГц. С такой частотой пиковая производительность Frontera составляет уже 25,8 петафлопс, что намного ближе к результату, полученному в Linpack.

Основная проблема при оценке производительности в настоящее время как раз и заключается в том, что тактовая частота динамически регулируется в зависимости от энергопотребления и температурных показателей процессора. Частота меняется непрерывно, и поэтому в каждый момент времени пиковая производительность будет разной.

Также стоит отметить, что есть способы повысить производительность. Например, использовать более эффективное охлаждение — в Frontera с помощью СЖО CoolIT удалось добиться устоявшейся частоты 2,0 ГГц при расчётах с AVX-512. И конечно, всё ещё зависит от программного обеспечения: одни приложения способны использовать ресурсы процессора более эффективно, нежели другие.

Да и тот же LINPACK уже давно критикуют за необъективность, так как он не учитывает другие важные факторы — эффективность работы с памятью и шинами, например. В качестве альтернативы разработан более современный бенчмарк HPCG.

Также эксперт отметил, что путаница с пиковой производительностью присуща всем современным процессорам, так как все они динамически меняют частоты. Например, по словам AMD, у её новых процессоров EPYC Rome при работе с инструкциями AVX2 частота не опускается ниже базовой. Однако boost-частоты могут быть ниже обычных значений. Дополнительную путаницу в расчёты может внести и настраиваемый уровень TDP.

В общем, для каждого конкретного случая производительность будет разной, и сравнивать их сейчас напрямую довольно трудно. Впрочем, вычисления всё равно становятся «дешевле» — некогда «горячие» инструкции со временем становятся такими же обыденными и «холодными».

Поскольку современные компьютеры обладают высоким уровнем производительности, более распространены производные величины от FLOPS, образуемые путём использования кратных приставок системы СИ.

Содержание

Флопс как мера производительности

Как и большинство других показателей производительности, данная величина определяется путём запуска на испытуемом компьютере тестовой программы, которая решает задачу с известным количеством операций и подсчитывает время, за которое она была решена. Наиболее популярным тестом производительности на сегодняшний день является программа Linpack, используемая, в том числе, при составлении рейтинга суперкомпьютеров TOP500.

Одним из важнейших достоинств показателя флопс является то, что он до некоторых пределов может быть истолкован как абсолютная величина и вычислен теоретически, в то время как большинство других популярных мер являются относительными и позволяют оценить испытуемую систему лишь в сравнении с рядом других. Эта особенность даёт возможность использовать для оценки результаты работы различных алгоритмов, а также оценить производительность вычислительных систем, которые ещё не существуют или находятся в разработке.

Границы применимости

Несмотря на кажущуюся однозначность, в реальности флопс является достаточно плохой мерой производительности, поскольку неоднозначным является уже само его определение. Под «операцией с плавающей запятой» может скрываться масса разных понятий, не говоря уже о том, что существенную роль в данных вычислениях играет разрядность операндов, которая также нигде не оговаривается. Кроме того, величина флопс подвержена влиянию очень многих факторов, напрямую не связанных с производительностью вычислительного модуля, таких как: пропускная способность каналов связи с окружением процессора, производительность основной памяти и синхронность работы кэш-памяти разных уровней.

Всё это, в конечном итоге, приводит к тому, что результаты, полученные на одном и том же компьютере при помощи разных программ, могут существенным образом отличаться, более того, с каждым новым испытанием разные результаты можно получить при использовании одного алгоритма. Отчасти эта проблема решается соглашением об использовании единообразных тестовых программ (той же LINPACK) с усреднением результатов, но со временем возможности компьютеров «перерастают» рамки принятого теста и он начинает давать искусственно заниженные результаты, поскольку не задействует новейшие возможности вычислительных устройств. А к некоторым системам общепринятые тесты вообще не могут быть применены, в результате чего вопрос об их производительности остаётся открытым.

Так, например, 24 июня 2006 года общественности был представлен суперкомпьютер MDGrape-3, разработанный в японском исследовательском институте RIKEN (Йокогама), с рекордной теоретической производительностью в 1 Пфлопс. Однако данный компьютер не является компьютером общего назначения и приспособлен для решения узкого спектра конкретных задач, в то время как стандартный тест LINPACK на нём выполнить невозможно в силу особенностей его архитектуры.

Также высокую производительность на специфичных задачах показывают графические процессоры современных видеокарт и игровые приставки. К примеру, заявленная производительность игровой приставки Xbox 360 составляет 1 Тфлопс, а приставки PlayStation 3 и вовсе 2 Тфлопс, что ставит их в один ряд с суперкомпьютерами начального уровня. Столь высокие показатели объясняются тем, что указана производительность над числами 32-битного формата [1] [2] , тогда как для суперкомпьютеров обычно указывают производительность на 64-разрядных данных [3] [4] . Кроме того, данные приставки и видео-процессоры рассчитаны на операции с трёхмерной графикой, хорошо поддающиеся распараллеливанию, однако эти процессоры не в состоянии выполнять многие задачи общего назначения, и их производительность сложно оценить классическим тестом LINPACK [5] и тяжело сравнить с другими системами.

Причины широкого распространения

Несмотря на большое число существенных недостатков, показатель флопс продолжает с успехом использоваться для оценки производительности, базируясь на результатах теста LINPACK. Причины такой популярности обусловлены, во-первых, тем, что флопс, как говорилось выше, является абсолютной величиной. А во-вторых, очень многие задачи инженерной и научной практики в конечном итоге сводятся к решению систем линейных алгебраических уравнений, а тест LINPACK как раз и базируется на измерении скорости решения таких систем. Кроме того, подавляющее большинство компьютеров (включая суперкомпьютеры) построены по классической архитектуре с использованием стандартных процессоров, что позволяет использовать общепринятые тесты с большой достоверностью.

Обзор производительности реальных систем

Из-за высокого разброса результатов теста LINPACK, приведены примерные величины, полученные путём усреднения показателей на основе информации из разных источников. Производительность игровых приставок и распределённых систем (имеющих узкую специализацию и не поддерживающих тест LINPACK) приведена в справочных целях в соответствии с числами, заявленными их разработчиками. Более точные результаты с указанием параметров конкретных систем можно получить, например, на сайте The Performance Database Server.

Суперкомпьютеры

Процессоры персональных компьютеров

Карманные компьютеры

Распределённые системы

Данные приведены по состоянию на 26 июля 2011 года

Игровые приставки

Указаны операции с плавающей точкой над 32-разрядными данными

GPU-процессоры

Теоретическая производительность (FMA; гигафлопсы):

Человек и калькулятор

Калькулятор не случайно попал в одну категорию вместе с человеком, поскольку хотя он и является электронным устройством, содержащим процессор, память и устройства ввода/вывода, режим его работы кардинально отличается от режима работы компьютера. Калькулятор выполняет одну операцию за другой с той скоростью, с какой их запрашивает человек-оператор. Время, проходящее между операциями, определяется возможностями человека и существенно превышает время, которое затрачивается непосредственно на вычисления. Можно сказать, что в среднем производительность обычного карманного калькулятора составляет 10 флопс.

Человек, пользуясь лишь ручкой и бумагой, выполняет операции с плавающей запятой очень медленно и часто с большой ошибкой. Говоря о производительности нашего вычислительного аппарата, придётся использовать такие единицы как миллифлопс и даже микрофлопс.

Sony и Microsoft представили точные спецификации новых консолей, и можно начать дискуссию о том, что нас ждёт в нашей любимой индустрии в ближайшие 5 лет. Производительность Xbox Series X – 12 терафлопс, а PlayStation 5 может похвастать «всего лишь» 10,28 терафлопсами. И это значит, что в следующем поколении японцы в теории слабее американцев на 14%.

Триллионы

Так что же это за терафлопс? Термин FLOPS - это сокращение от «floating point operations per second». То есть, количество операций с плавающей запятой, которые машина может обработать за одну секунду. Эта мера чрезвычайно важна для компьютеров и суперкомпьютеров. Благодаря последним проводятся сложнейшие вычисления, которые двигают науку вперёд. На данный момент самое быстрое в мире устройство имеет производительность в 148,6 петафлопс, то есть, 148,6 тысячи терафлопс, и это около 148 квадриллионов операций в секунду.

Терафлопс - это меньшая единица, чем петафлопс, и означает 1 триллион операций в секунду. PS5 сможет выполнять 10,28 триллиона таких вычислений, а Xbox Series X - до 12 триллионов. Разница в производительности обеих консолей составляет около 1,72 терафлопс, то есть в 1,72 миллиарда операций. Это значит, что консоль от Microsoft следующего поколения сможет показать, к примеру, более сложные объекты, больше спецэффектов или разместит на арене нескольких дополнительных противников.

Лирическое отступление и наблюдение. Разница между PS4 Pro производительностью в 4,2 терафлопса и Xbox One X с 6 терафлопсами практически такая же, как и в новых консолях.

Больше – значит лучше?

Теперь мы должны ответить на один очень и очень важный вопрос. Будет ли для нас иметь какое-то значение, если персонаж PS5 будет состоять, например, из 150 000 полигонов, а Xbox Series X - из 170 000 полигонов? Или тот факт, что на PS5 будет на 10 фейерверков меньше, чем на Xbox Series X? Или, к примеру, разница в 70 и 80 кадров в секунду? Или, возможно, малозаметная на глаз разница в разрешении? Это зависит от множества факторов: чего мы ждём от игры, жанр игры, какой у вас телевизор и так далее. Но если главное требование - лучшее качество, то вы в любом случае выберете PC.

Здесь уместным будет вспомнить слова двух руководителей Microsoft в недавнем прошлом.

В 2013 году топ-менеджер Microsoft Фил Харрисон (сейчас руководит проектом Google Stadia) уверял, что, если у одной платформы больше гигафлопс или терафлопс – это не имеет большого значения, так как важны «лучшие игры». Xbox One не удалось стать доминирующей платформой, в том числе и из-за меньшего количества терафлопс на старте. Однако это лишь одна из переменных.

Глава Xbox Фил Спенсер в июне 2017 года говорил в интервью журналисту GameCentral:

«Зачем вам 60 кадров в секунду? Единственное, что влияет на игровой процесс – это игры. Не все понимают, что означает 60 к/с против 30 к/c. Не все технически подкованы».

В случае с консолями вся дилемма выбора зависит от одного главного фактора – какие из игр будут работать лучше, более стабильно и без существенных просадок частоты кадров. И это зависит не только от количества терафлопс, но и от архитектуры консоли.

Многие люди жаловались, что для обычного человека презентация Sony была скучной и неинформативной. Потребителю всё равно, как быстро смогут передаваться данные между GPU, CPU, RAM, SRAM и другими компонентами. Мы хотим игр! Того, чего Марк Церни нам не показал. Но следует помнить, что это выступление должно было состояться на конференции GDC для разработчиков. Именно они будут создавать игры для PS5 в будущем.

Что происходит сейчас, или пара слов о SSD

Почему люди с богатым опытом в индустрии как мантру повторяют, что SSD изменит облик видеоигр?

Данный тип носителей существовал на рынке уже нескольких лет, и владельцы PC активно его используют, чтобы быстрей загружать систему, программы и игры. Однако, к сожалению, выдающегося развлекательного проекта, который использовал бы все возможности SSD на 100% мы так и не получили. Разработчики могут рекомендовать игрокам использовать SSD в системных требованиях, но не пишут, что он является необходимостью. С большой долей вероятности ситуация изменится, когда SSD-диски по умолчанию будут стоять в каждой новой консоли. Большинство разработчиков, в том числе и ведущих, при создании игры в первую очередь думают о консольном варианте.

В прессе появлялись заявления, восхваляющие новое поколение и защищающие более слабую спецификацию PS5. В основном, от сотрудников Naughty Dog, Ready At Dawn, а также от бывшего программиста Crytek Мэтта Филлипса. Последний написал следующие слова:

«Как программист с 15-летним опытом и 24 изданными ААА-играми на всех возможных платформах от Nintendo, Microsoft и PlayStation, ни я, ни мои друзья никогда не использовали терафлопс в качестве единицы измерения для чего-либо. Просто перестаньте использовать это слово, оно не имеет значения. Что важно для качества наших игр на новых устройствах: хорошие девкиты, новейший C++, компилятор шейдеров, отличный пакет инструментов профилирования CPU и GPU, быстрое время отклика и никаких лишних трюков».

Получается, что с точки зрения программиста ключом к комфортной работе с консолью является набор инструментов и языков, благодаря которым из неё можно извлечь гораздо больше, чем может показаться на первый взгляд.

Другие разработчики отмечали, что твердотельные накопители SSD оценят лишь через год, и их реализация позволит создать новый подход к игровому дизайну. В особенности, эксклюзивов.

Ранее все игры разрабатывались так, чтобы мы не видели, каким образом формируется мир, так как пропускная способность не позволяла плавно переходить из одной большой локации в другую. Приходилось показывать полосу загрузки, либо создавать узкий длинный коридор, лифт или прибегать к другим уловкам.

Церни говорил об этом на презентации, потому что это было одной из самых больших проблем современной разработки игр. У нас есть огромные вычислительные мощности, но мы не можем использовать их на 100% так, как хочется. Что же изменится в ближайшие несколько лет?

Больше, больше, больше!

Может получиться так, что разработчики начнут создавать полные контента миры и игроки будут прыгать из одного гигантского города в другой без экрана загрузки и ожиданий. В играх про полёты мы сможем эффектным образом попадать в новый большой регион. В файтингах вроде Dragon Ball или Naruto персонаж после удара будет мгновенно улетать в другой город, а локации сражений будут быстрей сменяться и увеличатся. Мировой Змей в последнем God of War без подвисаний совершит путешествие по девяти мирам скандинавской мифологии. Уровень масштаба увеличится не только в ААА-играх. До сих пор всё это было невозможно или не использовалось.

Игроку неважно, какая консоль победит в новой войне. Каждый для себя сделает правильный выбор: Xbox Series X, PlayStation 5, останется на старых консолях или соберёт дорогой PC. А может это будет Nintendo Switch с массой эксклюзивов c оценками выше 90% на Metacritic и производительностью всего в 1 терафлопс?

Количество терафлопс имеет значение. Но самым важным для игрока всё равно останутся убеждения, предпочтения, выбор друзей и, естественно, игры, которые предложат гиганты.

Читайте также: