Сколько лет работает видеокарта

Обновлено: 04.07.2024

Компания Nvidia часто обвиняется в том, что понижает производительность видеокарт с помощью драйверов. Иногда этому удается найти доказательства, но чаще всего при перепроверке они оказываются несостоятельными. Здесь я попытаюсь объяснить, каким образом на самом деле замедляют драйвера.

Как эталон, возьмем GTX 1080Ti с теоретической производительностью в 11.3 терафлопс. В конкуренты поставим RTX 2080 с 10 терафлопс. Как мы видим, их производительность практически аналогична и даже с небольшим выигрышем у GTX 1080Ti, что подтверждается независимыми результатами:

В момент выхода RTX 2080 осенью 2018, видеокарта выдавала равное количество кадров в секунду/FPS в сравнении с референсом GTX 1080Ti практически во всех играх:

К началу года спроса на новые Turing нет, старые Pascal уже давно распроданы майнерам. Выручка падает, инвесторы недовольны, капитализация снижается. Нужно что-то делать.

Химичить с производительностью в старых играх опасно и контрпродуктивно - активные граждане могут это заметить, что приведет к различным репутационным потерям, судебным искам от обществ по защите прав потребителей и все недовольные просто откатятся к старым версиям дров.

Но тут выходит наиболее ожидаемая игра года на ПК - Red Dead Redemption 2. Все, что остается сделать - это скрутить потенциал прямых конкурентов текущей линейки Turing, то есть GTX 1060, 1070, 1080 и т.д. Каким образом это достигается? Все просто, грузим в новой игре RTX 2080 на 100%, а GTX 1080Ti на 70-80%. Также делаем и с остальными. Смотрим результат:

Все видеокарты Nvidia прошлого поколения показывают отвратительные результаты. Но почему GTX 1080Ti оказалась даже хуже RTX 2070 Super? Потому что Nvidia выпустила промо, где прямо заявила, что 2070S лучше 1080Ti, которое изучал журналист издания Forbes.

A super-fast, replacement for the RTX 2070 that beats the GTX 1080 Ti in many testsНо ведь пользователи не дураки, плохую оптимизацию дров можно легко заметить через программу MSI Afterburner по уровню загрузки GPU ниже 99%. Однако, нужно знать небольшой нюанс - чем сильнее загружена видеокарта, тем больше электричества она потребляет, тем больше ее температура из-за энергопотребления.

Если в игре 2017 года с ультра настройками графики Total War: Warhammer 2 GTX 1080Ti грелась до 68С при 50% оборотах вентилятора и 99% загрузки чипа:

То уже в игре Quake 2 RTX 2019 года, призванную продемонстрировать всю мощь трассировки лучей, GTX 1080Ti грелась лишь до 64℃ при 35% оборотах вентилятора и выдавала всего 40FPS при разрешении 800x600(фото iPhone X):

Симулировать плохую оптимизацию на самом деле весьма сложно, ведь нужно будет писать лишний код, а это может привести к различным багам и вылетам. Гораздо легче сымитировать 100% загрузку при фактических 70-80%. А от недозагруженной видеокарты уже можно ожидать и невысокое энергопотребление, как и температуру.

Сотрудники Nvidia не раз заявляли, что видеокарты предыдущих линеек оптимизируются хуже, нежели текущая архитектура. Это объясняется простым желанием сократить расходы. Как например, в этом интервью:

Но у графического подразделения AMD бюджет в несколько раз ниже бюджета Nvidia. Тем не менее, с каждым годом некогда паритет между RX 580 и GTX 1060 развеивается все сильнее в пользу красных. И таких случаев действительно множество, что породило мем про карету из Золушки у зеленых, которая превращается в тыкву и гадкого утенка AMD, который вырастает и становится прекрасным лебедем.

Я глубоко сомневаюсь, что качество драйверов красных в течение нескольких лет после выхода видеокарты улучшается. Наоборот, оно даже падает из-за смены приоритетов, но по сравнению с намеренным подлогом Nvidia, результат оказывается просто колоссальным:

Что в таком случае остается делать обычным пользователям? При покупке видеокарт нужно осознавать, что вы покупаете текущую производительность лишь в среднем на два года, до выхода новой линейки. И хотя, официально заявляется, что поддержка видеокарт закачивается через 5-8 лет, как это было с видеокартами архитектуры Fermi, на самом деле видеокарта подвергается запланированному устареванию(planned obsolscence) намного раньше.

И если Apple обосновывала замедление айфонов постепенной деградацией батареи, то Nvidia обвинить невозможно, т.к. в отличие от AMD, она не открывает драйвера даже для устаревших видеокарт, чтобы те могли поддерживаться и изучаться сообществом.

P.S.: Объяснение. Драйвера старых игр остаются без изменений. Драйвера для новых игр умышленно делают такими, чтобы они не использовали видеокарты прошлых линеек на всю мощь. Иначе говоря - вы купили новую Tesla, в первый год вам дают ездить на 300км/час, второй год 280км, третий 250 и т.д.

Короче как обычно - тонна воды и ни одного конкретного теста или подтверждения тому, что нвидиа скручивает производительность паскалям. А то, что новые игры оптимизируются в первую очередь под новый Тьюринг - это как бы ожидаемо. У АМД нет такой возможности, так как 580 у них по сути самое новое предложение в ее сегменте. Вот и оптимизируют под неё до сих пор. ред.

Самое смешное, что чувак взял видосы с канала (PRO Hi-Tech) на котором производили тесты видеокарт на разных драйверах, и не нашли подкруток, а даже наоборот, увидели повышение производительности на более новых драйверах.

Парень, понимаешь им нельзя зан жать производительность, но они ее просто увеличивают на 0,01% мощности, но на новых картах можно увидеть прирост до 10%, а у амд все карты получают норм прирост

при чем здесь амд? тема про якобы снижение производительности у нвидеа

При том, что прирост или снижение на фоне карт амд. Мне казалось, что это не сложно понять из данной статьи.

Точнее про выделение игровому движку заниженного лимита нагрузки карты от имеющихся у неё 100%.

Точнее про выделение игровому движку заниженного лимита нагрузки карты от имеющихся у неё 100%.

Точно подметил!) А то что на нвидиа карточках изображение намного лучше, это ни кого не беспокоит? Есть rx5700xt, так вот в играх постоянно какие то лаги и прочая фигня, уже сто раз пожалел что взял этот амудэ.

Пруф в студию, что у амд изображение хуже. Столько раз видел обратную ситуацию. У амд более реалистичное изображение и плавное, нежели у нвидиа.

Про новые карты ничего сказать не могу, но был опыт довольно близкого сравнения gtx660 и r9 290 ,ну и немного встройки хасвела с 4670к - что зеленая карта, что встройка на 60гц мониторе выдавала явно тусклую картинку с иногда заметными ступеньками в переходе между оттенками, как на 16 бит гамме (при 75 гц почему-то цвета становились насыщеннее без какой-либо калибровки). r9 290 при казалось-бы более чем вдвое мощнее по железу (по цифрам там считай две 660, смотанных изолентой) выдавала прирост производительности порядка 50-60%, но при этом качество ,выводимого на экран изображения, было стабильным при любой частоте одновления начиная с 60гц и до 144гц при этом лучше зеленых и встройки у интелла. я прекрасно знаю, что реф охлаждение, это демоверсия боинга и годиться только для майнинга, но на ватере она до сих пор трудиться уже во втором конфиге. Уже заказал себе 5700xt надеюсь новая архитекиура не сильно сказалась на качестве итоговой картинки (на это можно надеяться, если верить в закономерно более высокое тепловыделение на каждый фпс).

чево? как по-вашему одинаковые рендеры могут выглядеть по-разному?

Может вылечат драйверами со временем? Архитектура новая. Ну и почему бы не пожаловаться в гарантию?

Автор вчера зарегистрировался и сразу же выдал жирную говностатью, которая составлена так, что бы хомячок в неё поверил. Первая же фраза про терафлопсы - хомячок свято бы поверил, ибо для него это марка производительности, в то время как разбирающийся в железе человек после сравнения карт с разной архитектурой по флопсам сразу же статью промотает до конца, вмажет минус и закроет вкладку

Короче, это тупорылая заказуха, не иначе

А меня позабавила фраза, которая с самого начала статьи вгоняет в ступор: "теоретические терафлопсы". Дальше с серьезными щами читать уже увы не получилось.

AMD и не нужно оптимизировать под каждую новую серию отдельно (кроме Navi), т.к. архитектура GCN в основе своей практически и не изменилась с момента своего появления, поэтому все оптимизации автоматически распространяются в той или иной степени на старые видеокарты. Nvidia же многое постоянно правит у каждой новой архитектуры, поэтому и оптимизировать нужно более индивидуально.

Значит, брать AMD на порядок выгоднее?

Увы нет. У них своих проблем хватает.

Возьмёшь АМД, и будешь долбаться с драйверами и проблемами куда чаще.

С драйверами сейчас примерно одинаковая беда у обоих производителей, но у nvidia кодировщик видео работает хорошо ещё с 9хх серии, и в целом до сих пор существующее количественное превосходство dx11 игр их выручает. Ну а с rtx и в низкоуровневых api они стали работать лучше предыдущего поколения. Кстати, по моим наблюдениям у navi относительно polaris и vega с этим стало похуже. ред.

А типо у нвидии что то реально менялось в архитектуре? Она просто любит всё обзывать по новому и втюхивать хомякам.

Почитайте разбор архитектуры 2000 серии, там много изменений. А вот супер просто чипов брак и разгон.

Речь в статье не об этом. Фиктивная догрузка карт - не миф. Денуву, кстати, как официальный пример "балластной загрузки" - в ту же копилку. Пользы от неё игроку - ровно столько же.

Какой тебе тест? Сидел я с 2012 года на i5 -3470+ gtx750gaming и прошел на старых дровах ведьмака 3 с добротными настройками. Выходить вульфенштейн и требует обновить дрова так как с картинкой в 8бит играть нереально. После установки все отлично, но ведьмак 3 уже начал подлагивать и система не справилась с предыдущими установками. Пришлось ответить дрова.

Ну как тебе сказать. Вобщем я провел свои тесты на 1060 и сравнил 2 драйвера. Подбирал специально по датам. Первый - июльский драйвер нвидии от 2018 года, в августе была представлена первая карта RTX поэтому рассчет был на то что в конце каррентгена карты еще не будут резать. Второй драйвер - один из новых на момент тестов 432 драйвер который вышел уже с RTX и для RTX карт. В ксго фпс заметно просел на тех же настройках. Падение было 20-30% примерно. Также просел фпс и в Watch Dogs 2 (было 50-60 стало 35-45) и в GTA 5 и даже в Assasins Creed Odyssey - казалось бы игра вышла после RTX поколения и уж в ней то новый драйвер должен растоптать старый, показать оптимизацию и преимущество. Нет, опять же та же петрушка с падением до 30% фпс. Так что правда в том что падение есть и в этом легко убедиться когда мы возьмем например 2 видоса с любого канала по игровым тестам и сравним в одной какой-нибудь игре данные по видеокарте на текущий момент и на момент 3-4 лет назад. На старом обзоре за который занесли денег 1060 прям таки идеальна для Full HD и лучшая покупка. На новых, где хвалить надо уже скажем 3070 то мы тут же показываем какая карта стала немощная в той же игре. И дело тут не в обновлениях игр, а в том что реального прогресса кот наплакал. Получается как с i7-6700 и i7-2600K когда пользователи 2600К разогнав его до частот 6700 с удивлением обнаружили что однако прирост на равной частоте у 6700 не такой значительный. А ведь прошло 5 лет. Именно поэтому карты старые режут так как иначе маркетологи не смогут врать про 200% прироста относительно прошлой линейки.

Камикадзе перешел на видеокарты?

Даунгрейд это когда в конкретной игре были одни результаты, а стали другие.

Показали бы чтоли наглядные графики, в какой игре сколько фпс и какая нагрузка, а то сплошные доводы.

это точно, перегрев, самая большая проблема видеокарт. просто надо следить за температурой. начинает подозрительно и неоправданно греться, бегом в СЦ или самому если руки из плеч. а так да, не трудно разработать определенную термопасту, у которой будет срок годности, по истечению которого она будет высыхать, независимо от того, как сильно её владелец нагревал играми. это если согласится в существование технологического заговора. хотя я в это не сильно верю.

Абсолютно согласен с человеком.

Нуууу. честно сказать, очень похоже на заманивание клиентов в контору, о которой весь экран залеплен водяными знаками. Первое, что хочу сказать. Ни в коем случае не лезьте в карточку, до окончания гарантии. 780 вышла из строя через два с лишним года. Вернул в магазин, поменял на 1070 с доплатой. PROFIT! Второе, по поводу шума. Тут уж сам покупатель решает, брать ему подороже с офигенной системой охлаждения или поспешить и взять на что денег хватает. Стоит MSI 1070 Gaming X, Шум? Да даже на 100% - она нифига не воет и никуда не взлетает. Когда ПК работает на полную, она нисколько не выделяется из общего шумового фона. Кулер на ЦП, БП и ЖД, куда более шумные. Старые мои 580, 780 - они заметно Грооомче и потребляли в 1,5 раза больше энергии. Те кто не сидит по 5-10 лет на одной карточке меня поймут.

callmegod да да, согласен. карту разбирать не стоит до окончания срока гарантии. у меня за всё время было очень много карт, и обычно, неисправную карту, видно практически в самом начале использования. тем более сейчас в основном гарантия 2 года, а на некоторые модели дают дополнительный год, если её зарегистрировать на сайте производителя, например asus strix 10хх. что же касается температуры, она на современных картах не сильно высокая, просто надо знать предел карты, и не нагружать её сверх ультра настройками выжимая 30 фпс. Лучше всего оставлять такие настройки графики, какие подставляет сама игра. если беречь вещь - то и прослужит она долго пс. а доля маркетинга в ролике всё-таки есть ;))

устрашение юзеров и впаривание левых услуг какое нафиг ежегодное обслуживаие!? не гнать видюху фанатично и пыль прогонять 1-2 раза в год будет работать долго-долго а таких спецов как в видосе - лесом слать нужно. деревья протирать, чтобы мох не рос

Да все сейчас нормально с охлаждением видеокарт. У меня в комбастере на макс настройках, видюха выдает макс. 66гр. при 900 об. винтов,что является примерно 35% от максимальных оборотов винтов, при этом карту вообще не слышно.

Все верно говорит, особенно в точку про систему охлаждения, производители вшивали и вшивают в биос карты какие то низкие % оборотов вентилятора при высокой температуре.

570 gtx c 2011-го ниразу не влезал! Играл и играю во всё что хочу, ( настройки по возможности), НО термопасту не менял ни разу) Хошь верь, а хошь не верь)

Не сильно греются? Скажите это моей печке MSI R9 390, которая на ультах может разогреваться до 80+ :-) а если серьезно, Может у кого то занижены обороты куллера. Но что мешает тебе настроить? Есть свой софт как правило, как вариант- Afterburner. Про строение системы охлаждения системного блока не забываем, где элементарно из-за одного куллера, разница температур может быть 5-10 градусов. Ухаживая за своим ПК, соблюдая чистоту как внутри, так и снаружи системника. Его чистка. Не занимаясь извратом, пытаясь разогнать свою видеокарту, при этом не имея знаний и т.д. - Все будет работать долго и стабильно. И не надо будет думать о том, что ты не поменял пасту, и все это сломается. P.s. если человек хоть немного следит за температурами, можно заметить, когда температура стала выше. Поэтому в принципе, можно заметить когда у тебя пересохла паста.

Game Project Вот Моя старушка как раз из этих горячих девочек))) R9 390 карта старая уже. Жрет как сивый мерен -до 275вт в пике При хорошей нагрузке, ее рабочая температура 80-85. Для нее это норма. Куллеры в штатке крутятся даже не в половину мощности))) Я конечно штатную установка на вращение куллеров повысил. Стараюсь выше 90 не подниматься. Но ноги то припекает))

Chamelot В свое время была MSI 290x, которая работала не на штатных 1080 / 1250, а 1420 / 1650 и выше 70 не поднималась. Так что все упирается в выбор правильной карты, а точнее ее охлаждения. Но многие экономят пару штук и получают 80-90 градусов) Так сейчас 1080Ti при частотах 2100 / 12400 не превышает 64 градусов вообще.

Game Project Так не поверишь, у меня тоже MSI ))) А я даже больше скажу что 290, что 390 по сути одно и тоже, только 390 переобули, пашаманили и продавали на 100$ больше) Но это старый поколения карт, у которых энергопотребление больше. У той же 1080 ti оно меньше, чем у 390. TDP- R9 290- 275 TDP- R9 290X -290 TDP- R9 390-275 TDP- GTX 1080 ti- 250

Есть ASUS 7870 direct CU-II и есть халявная Gigabyte 1050 без доппитания. Видеокарты довольно близкие по производительности, обе с 2Gb памяти. И на них на обеих, не смотря на разных производителей и системы охлаждения одинаковая фигня: алгоритм работы вентиляторов неприемлем. Они почти стоят градусов до пятидесяти, что банально глупо. Подправил у обеих алгоритмы, на 7870 вообще вшил в биос, заменил пасту на MX-4. Благодаря нормальной пасте упала температура и измененный график работы карлсонов не повлиял на шумовые характеристики почти никак. 7870 вообще удалось освободить от кулера не трогая пломбу, там всё оч грамотно сделано и у процессора есть защитная рамка, чтобы массивным охладом с тремя толстыми трубками не сколоть чип. На ней же прилепил на термосопли масенький радиатор на VRM, стала гнаться получше. Оставил родные частоты, т.к. пирометр мне сказал, что датчик в digi+ либо стоит ради смеха, либо занижает циферки умышленно. Пайки я не боюсь случай чего - но я боюсь не найти этот vrm, т.к. нужен именно от такой же видюхи (он с прошивкой). PS Но вообще, работая в сервисе, я чаще встречал две проблемы: сдох ГПУ от разгона (часто с вольтмодом) - это когда по чесноку поговоришь с человеком. Либо же дохнут ключи вернего плеча питания ГПУ - часто по той же причине. Еще летит vrm - но это вообще норма, т.к. оч много карточек максимум просто дуют на него. Там критическая температура для многих микрух сто градусов по даташиту, поэтому производителям и пофигу. Но удачный экземплярчик среднего класса работать может годами. Топовые - они почти все говно, их приходится менять по тем или иным причинам. И они не оптимальны по соотношению цена/производительность.

Не надо разгонять и насиловать карту, заводские настройки это гарант стабильной работы, конечно с заводскими настройками карта выдает примерно 80% от полной мощности, но видеокарты как и любая вещь быстро выйдет из строя если всегда будет работать на пределе своих возможностей. К примеру лампочка на 3,5 вольта будет светить немного ярче если к ней подключить 5 вольт, но она перегорит намного быстрее. Даже в машинах есть ограничитель педали газа, если его убрать и надавить газ на нейтральной передаче до упора на пару минут, двигатель все горшки выплюнет.

Интресно мужик говорит. Всё вполне очивидные вещи. Правильно он сказал, ктото за год на ЦП раза 3-4 меняет термпасту а на видюху забивают.

моей 580 уже много лет, лет семь наверно или уже восемь, ну когда там пятисотая серия вышла, почти столько и работает, прошлой зимой заглючило конкретно, артефакты, минимальное разрешение, драйвера не ставятся, чистка и смена вполне на вид "не деревянной" термопасты, конечно, ничего не дали, пожарил в духовке, работает уже год и не чирикает; а знакомец один на производстве с термопастами дело имел, не компы, а агрегаты там какие-то, но суть та же, градусы под сто, а уж рабочий режим вообще постоянный, так вот чушь, говорит, это всё, и за десять лет абсолютно ничего с ней, с термопастой, не делается, это, мол, что лично видел и щупал, а так и дольше боги её знают на сколько.. другое дело, что можно производителей заподозрить в использовании некачественной пасты и температурку всегда надо контролировать полюбому, лично у меня всё чётко, стоит нагреться больше девяноста - тут же кулеры врубаются по полной и ревут так, будто их насилуют противоестественными способами, так что я всегда в курсе, ежели что не так..

Жидкий металл в помощь всем

ай пацаны всему свое время и всему приходит время. а в целом. дело случая екараный бабай .

Теория с глобальным заговором мне нравилась больше! Писи: 660 2Гб (5 лет). Всё современное идёт на НDK, на высоких (40-60 фпс) Профилактика всего компУтера раз в 3-4 мес.

а что видеокарты ремонтируют? какой смысл через 3 года и более? я беру среднего сегмента и ниже . у меня до сих пор как раз 650 gtx и ремонтировать ни за что не буду))

LORDLEXXSpbRUS А как она 650, норм играется?, на али вчера тож её заказал), на второй комп.

SkEwReK да ничё при своей цене что платил не жалею. батла 3и 4 на средних настройках в HD вполне идёт. первая уже нет, тормозит жутко. и колды последние 2 тоже не пашут. свои деньги отработала уже на ура.

В данной статье, мы поговорим о видеокартах, сроках их службы и различных нюансах. Я всегда сравнивал видеокарту с полноценным компьютером. Видеокарта это и процесор, и оперативная память, и в какой-то степени материнская плата, не хватает лишь жесткого диска. Устройство сложное и есть масса причин из-за которых, оно может выйти из строя.

О громное энергопотребление современных видеокарт, при максимальных нагрузках, может потреблять больше электроэнергии, чем все остальные детали компьютера вместе взятые. Рабочие температуры видеочипа и силовых элементов, приближенны к технологическому максимуму.

Т ем не менее, при всех сложностях, основная поломка у современных видеокарт, это неисправность самого видеопроцессора минимум 90% видеокарт выходит из строя из-за неисправности GPU(Процессора видеокарты), остальные 10% занимают проблемы с памятью, проблемы по питанию и другие поломки.

О бычно я не люблю говорить о том, что раньше было лучше, но как ни крути- раньше видеокарты жили дольше. Возможно причина кроется именно в большой мощности современных видеокарт, а может и плановое досрочное устаревание, о котором все больше говорят, дает о себе знать.

В идеокарт в ремонты приходит очень много, и вот некоторые особенности из личной статистики некоторых сервисных центров: Очень часто приносять на ремонт видеокарты у которых совсем недавно закончился срок гарантии, или буквально за несколько месяцев до его окончания.

То есть, это от 1-до 3 лет службы, в зависимости от производителя видеокарты. Если отбросить в стороны теории заговоров производителей видеокарт, и все подытожить, выходит что видеокарты отрабатывают свой гарантийный срок и умирают, по крайней мере 60% точно, лишь не большая часть держится гораздо дольше.

Интересный момент в том, что во время действия гарантии, пользователь видеокарты не обслуживает ее, что бы не повредить пломбу и не лишиться гарантии, максимум с нее сдувают пыль, чистят радиатор, термопасту же никто не меняет.

Хотя обычно, на всех видеокартах у которых вышел из строя процесор, полностью пересохшая термопаста . Выходит, что на центральном процессоре, некоторые пользователи за год меняют по 2 раза термопасту, а на видеокарте не делают ничего.

Кто-то скажет, что термоинтерфейс видеокарты рассчитан на такой срок работы и ничего менять не нужно. Возможно, а возможно именно в этом и кроется проблема. Все рассчитано на гарантийный срок, а именно 1-2 или 3 года, то есть в притык .

Р асскажу на примере одной конкретной модели. Примерно 3-4 года назад, средне бюджетная модель видеокарт, Nvidia GTX660 была очень популярной,все игры летали, а цена не так сильно кусалась, как у старших моделей. Было куплено очень много данных карточек, от разных производителей и вот спустя 2-3 года, видеокарты масово стали приносить в ремонт. Эта видеокарта взята как пример,

данная ситуация сейчас со всеми мощными видеокартами от любого производителя. Когда карточка разбирается в сервисном центре, там как правило обнаруживается, что термопаста похожа на камень .

И сходя из этого, напрашивается вывод, что видеокарта требует работ по обслуживанию, еще за долго до окончания гарантийного срока. То есть стоит выбор, лишиться гарантии, либо рисковать лишиться видеокарты незадолго до, или после окончания гарантийного срока. Дання проблема будет волновать скорее тех, кто не в состоянии менять видеокарты раз в году, когда выходят новые модели, а таких людей довольно много.

Получается, что ресурс видеокарты ограничен из-за отсутствия обслуживания, по крайней мере, этот фактор дает большой процент поломок.

Т акже бытует мнение: (чтобы показать якобы какие тихие делают видеокарты)- обороты кулеров, намеренно делают заниженными до минимума, несмотря на то, что безопасней для устройства снизить температуру.

В озможно всем стоит задуматься выполнить профилактические работы, спустя максимум 2 года работы, а лучше даже ранее. Надеюсь данная информация была для вас полезной и интересной. Вы естественно можете с ней не согласиться, и мы будем рады прочитать ваше мнение по этим вопросам.

Ваша заказ успешно отправлен

Сколько живут видеокарты в майнинге?

Любой графический ускоритель, независимо от его производительности, стоимости и возможностей, базируется на печатной плате изготавливаемой из текстолита. Из этого же материала делаются практически все остальные комплектующие компьютера: материнские платы, блоки питания, SSD-накопители и так далее.

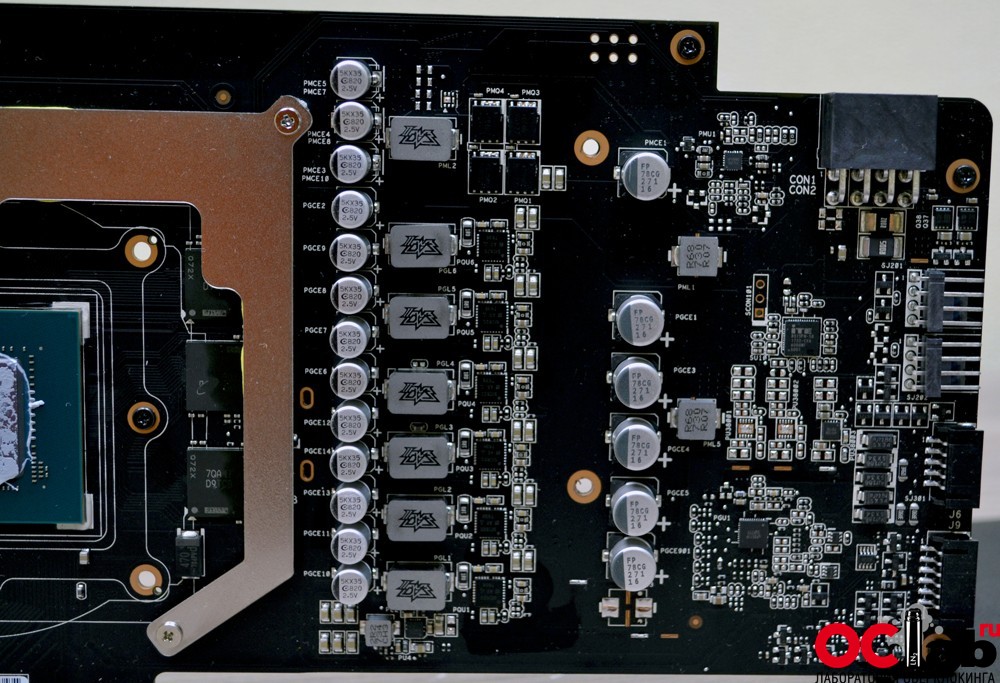

Обычно при производстве видеокарт производители используют печатные платы с количеством слоев от 5 до 10 штук. Хорошим показателем принято считать, если в pcb (печатной плате) видеокарты насчитывается более шести слоев. В таком случае разводка электрических дорожек наиболее оптимальна, и позволяет распаивать большее количество электрических компонентов, в частности, элементов в системы питания.

Не менее важным в данном вопросе принято считать и качество самой пайки. Хоть сейчас все компоненты для видеокарт производится на автоматизированных линиях, не всё оборудование может обеспечить приемлемое качество. Это очень хорошо заметно на видеокартах бюджетных брендов, у которых допускается небольшие перекосы при посадке компонентов печатной платы. Поэтому для майнинга лучше всего выбирать видеокарты, с хорошим качеством пайки BGA-компонентов. Примером таких ускорителей можно считать видеокарты от компании Asus, принадлежащие к игровой линейке ROG Strix. Asus открыто заявляет об использовании фирменной технологии Auto-Extreme Technology, которая доводит качество изготовления плат практически до идеала.

В противном случае, после длительной эксплуатации видеокарт с рабочими температурами выше 80 градусов, пользователи могут столкнуться с тем, что криво посаженные BGA-компоненты могут отпаиваться и приводить к выходу из строя видеокарты.

Графический процессор видеокарты является одним из самых главных компонентов, и при этом одним из самых уязвимых. Несмотря на то, что производство GPU уже многократно отточено и их качество очень высоко, графические процессоры все равно очень часто выходят из строя. Точнее из строя выходит не сам ГПУ, кристалл чипа действительно повредить очень трудно, а его крепление к печатной плате. Все графические процессоры распаивается на печатной плате при помощи небольших оловянных шариков, соединяющих PCB видеокарты и подложку GPU. Этот тип пайки называется BGA. Повреждения в этом месте, а точнее в соединении, обычно возникают при частых серьезных колебаниях рабочих температур GPU.

Например, средняя рабочая температура GPU при майнинге может достигать 80, а то и 90 градусов. Но в этом нет ничего страшного, так как GPU рассчитаны на работу при температурах до 100-105 градусов. Однако, мы рекомендуем настраивать работу видеокарт, а точнее их системы охлаждения так, чтобы рабочая температура GPU находилась в пределах 70-75 градусов.

К повреждениям соединения GPU и печатной платы приводят резкие скачки температура. Например, ваша видеокарта майнила при рабочей температуре в районе 80 градусов. Затем из-за ошибки процесс майнинга остановился, и видеокарта резко остыла до 35-40 градусов. Именно в этот момент GPU может деформироваться из-за неравномерного остывания. Соответственно? если такие перепады будут происходить по нескольку раз в день, на протяжении года и более, чип может «отвалиться». Это значит, что контакт между GPU и печатной платой будет нарушен и видеокарта выйдет из строя. Для того чтобы этого не происходило необходимо минимизировать такие резкие перепады температур. Один из самых простых способов этого избежать, это уменьшить количество отключений и рестартов фермы. Добиться этого можно подбиранием стабильных рабочих частот для графических ускорителей, а также поддержанием одного уровня температуры в помещении, скажем 21-22 градуса.

В-первом случае, если вы разгоняете видеокарты и видете, что они раз в день или два отключаются, лучше снизить частоты или убрать разгон вовсе. Да, вы потеряете несколько центов дохода в день, но при этом многократно продлите жизнь своим видеокартам.

Во втором случае, поддержание постоянной температуры в помещении защитит вас от выключений из-за перегрева в летний период.

Микросхемы видеопамяти, используемые в графических ускорителях, также являются одним из главных компонентов. При этом они являются самыми надежными компонентами видеокарты, так как выходят из строя только в самых крайних случаях. При пренебрежительном и халатном эксплуатировании видеокарты. Повреждение микросхем может быть вызвано только их перегревом и дальнейшим выгоранием. Происходит это очень редко, и в основном на видеокартах очень бюджетного сектора, когда чипы памяти ничем не охлаждаются, а порой и дополнительно подогреваются близко расположенными горячими компонентами.

В процессе самого майнинга микросхемы памяти могут выйти из строя только при ручном разгоне с увеличением рабочего напряжения.

Других способов убить микросхемы не существует.

Система охлаждения, или в простонародье кулер, является одним из самых надежных, простых и наименее ломающихся частей виеокарты. Единственная неприятность, которая может постичь кулер видеокарты, это выход из строя вентиляторов. Но, как правило, даже если это происходит, то только через несколько лет активной эксплуатации. А при должном техническом обслуживании, то есть чистки кулера от пыли, вентиляторы могут и не сломаться вовсе.

Система охлаждения видеокарты должна всегда оставаться в чистоте. Именно это залог долгой и бесперебойной работы графического ускорителя. Так как половина из вышеописанных проблем происходит именно из-за перегрева.

Что ж, рассмотрев каждый конкретный компонент видеокарты в отдельности, мы смогли понять как, и на что влияет длительный период майнинга на видеокартах. На поставленный в начале статьи вопрос, умирают ли видеокарты от майнинга, мы ответим так.

При выборе видеокарт с качественными компонентами и хорошей системой охлаждения, а также их грамотной эксплуатации, майнинг не наносит вреда графическим ускорителям даже после нескольких лет эксплуатации. Отличным примером этого могут служить видеокарты AMD Radeon HD 7970, которые используется майнерами уже на протяжении 7 лет. Причём количество видеокарт, вышедших из строя, крайне мало. Это отлично подтверждает приведенные нами доводы.

Далее для сравнения приводим статистику продолжительности жизни видеокарт в майнинге. Данную информацию мы получили от одного из профессиональных майнеров, занимающихся самостоятельной сборкой ферм на продажу. Что же значат все эти цифры?

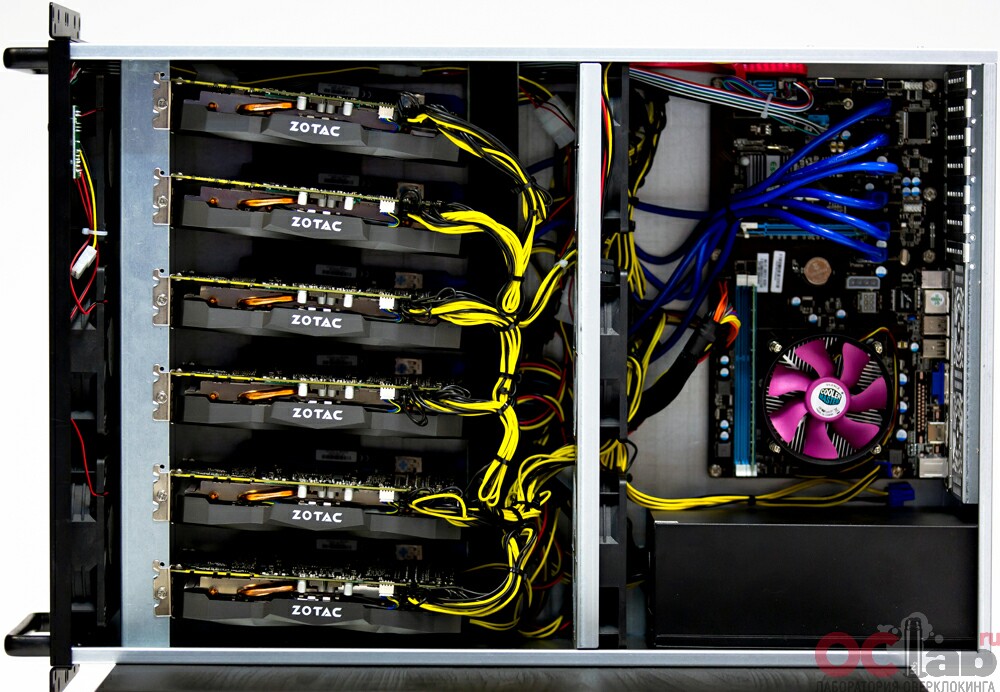

Как видим, любое оборудование любит уход и качественную сборку. Данного мнения об эксплуатации и сборке ферм для майнинга придерживается не только наша редакция, но и специалисты российской компании-дистрибьютора 3Logic. Так как при разработке и сборке своей продукции, а именно майнинговых ферм, инженеры компании уделили огромное внимание качественному охлаждению и грамотному подбору видеокарт. Впрочем, как и прочих основных компонентов фермы. Познакомиться с продукцией компании 3logic вы можете перейдя по ссылке. В ассортименте производителя имеется несколько моделей майнинговых ферм подназванием ACD crypto Compact и ACD Crypto rack 19. Они рассчитанны на использование с разным количеством и типом видеокарт. Также вы можете ознакомиться с обзорами данных ферм, перейдя в соответствующий раздел «майнинг» на нашем сайте.

Читайте также: