Storcli замена диска в raid

Обновлено: 04.07.2024

Допустим, у сервера 2 диска: /dev/sda и /dev/sdb . Эти диски собраны в софтверный RAID1 с помощью утилиты mdadm --assemble .

Один из дисков вышел из строя, например, это /dev/sdb . Повержденный диск нужно заменить.

Примечание: перед заменой диска желательно убрать диск из массива.

Удаление диска из массива

Проверьте, как размечен диск в массиве:

В данном случае массив собран так, что md0 состоит из sda2 и sdb2 , md1 — из sda3 и sdb3 .

На этом сервере md0 — это /boot , а md1 — своп и корень.

Удалите sdb из всех устройств:

Если разделы из массива не удаляются, то mdadm не считает диск неисправным и использует его, поэтому при удалении будет выведена ошибка, что устройство используется.

В этом случае перед удалением пометьте диск как сбойный:

Снова выполните команды по удалению разделов из массива.

После удаления сбойного диска из массива запросите замену диска, создав тикет с указанием s/n сбойного диска. Наличие downtime зависит от конфигурации сервера.

Определение таблицы разделов (GPT или MBR) и ее перенос на новый диск

После замены поврежденного диска нужно добавить новый диск в массив. Для этого надо определить тип таблицы разделов: GPT или MBR. Для этого используется gdisk .

Где /dev/sda — исправный диск, находящийся в RAID.

Для MBR в выводе будет примерно следующее:

Для GPT примерно следующее:

Перед добавлением диска в массив на нем нужно создать разделы в точности такие же, как и на sda . В зависимости от разметки диска это делается по-разному.

Копирование разметки для GPT

Для копирования разметки GPT:

Обратите внимание! Здесь первым пишется диск, на который копируется разметка, а вторым — с которого копируется (то есть с sda на sdb ). Если перепутать их местами, то разметка на изначально исправном диске будет уничтожена.

Второй способ копирования разметки:

После копирования присвойте диску новый случайный UUID:

Копирование разметки для MBR

Для копирования разметки MBR:

Обратите внимание! Здесь первым пишется диск, с которого копируется разметка, а вторым — на который копируется.

Если разделы не видны в системе, то можно перечитать таблицу разделов командой:

Добавление диска в массив

Если на /dev/sdb созданы разделы, то можно добавить диск в массив:

После добавления диска в массив должна начаться синхронизация. Скорость зависит от размера и типа диска (ssd/hdd):

Установка загрузчика

После добавления диска в массив нужно установить на него загрузчик.

Если сервер загружен в нормальном режиме или в infiltrate-root , то это делается одной командой:

Если сервер загружен в Recovery или Rescue-режиме (т.е. с live cd), то для установки загрузчика:

Смонтируйте корневую файловую систему в /mnt :

Смонтируйте /dev , /proc и /sys :

Выполните chroot в примонтированную систему:

Установите grub на sdb :

Затем попробуйте загрузиться в нормальный режим.

Как заменить диск, если он сбойный

Диск в массиве можно условно сделать сбойным с помощью ключа --fail (-f) :

Сбойный диск можно удалить с помощью ключа --remove (-r) :

Добавить новый диск в массив можно с помощью ключей --add (-a) и --re-add :

Поступил вопрос от DBA, написать о том, как разбиты диски на массивы в сервере Oracle Linux. Я, честно говоря, уже и не помню что мы там конфигурировали, воспользуемся средствами операционной системы и утилитой StorCLI.

Утилита работает и в других операционных системах на базе Linux, есть версия и для Windows, но у меня именно Oracle Linux 7.6, работаю с тем что есть.

Окружение

Раньше уже писал про то, как разбить эти диски в зеркало для ОС:

Дополнительно известно, что в сервере установлены два RAID контроллера, один обслуживает диски сервера, второй — диски полки.

Массивы в операционной системе

Посмотрим что у нас примонтировано:

У нас есть два массива md10 и md20 по 66 Тб каждый. ОС крутится на md126 .

lsblk показывает, что md10 — это RAID0, состоящий из двух дисков sda и sdb. md20 — это RAID0, состоящий из двух дисков sdc и sdc. md126 — это RAID1, состоящий из двух дисков sde и sdf.

md20 : active raid0 sdc1[0] sdd1[1]

70319335424 blocks super 1.2 512k chunks

md126 : active raid1 sde[1] sdf[0]

927881216 blocks super external:/md127/0 [2/2] [UU]

md127 : inactive sdf[1](S) sde[0](S)

10402 blocks super external:imsm

mdadm — утилита для создания массивов в linux, /proc/mdstat — статистика и состояние массивов.

Мы видим, что md126 — raid1 из двух дисков, md127 — это IMSM контейнер для md126. md10 и md20 — RAID0 массивы из двух дисков.

Ясно, что md126 — это зеркало RAID1 из двух физических задних дисков сервера. А вот sda, sdb, sdc и sdd — это некие массивы RAID контроллеров сервера, нужно разобраться, из чего они состоят.

StorCLI

Утилиту ищем в секции DOWNLOAD.

Скачиваю утилиту storcli .

Это очень мощная утилита по управлению RAID контроллером. Сегодня нам понадобится минимум функционала для определения состава массивов.

Данная команда выведет детальную информацию. Среди всего списка нам понадобится:

Ctl=Controller Index|DGs=Drive groups|VDs=Virtual drives|Fld=Failed

PDs=Physical drives|DNOpt=DG NotOptimal|VNOpt=VD NotOptimal|Opt=Optimal

Msng=Missing|Dgd=Degraded|NdAtn=Need Attention|Unkwn=Unknown

sPR=Scheduled Patrol Read|DS=DimmerSwitch|EHS=Emergency Hot Spare

Y=Yes|N=No|ASOs=Advanced Software Options|BBU=Battery backup unit

Hlth=Health|Safe=Safe-mode boot

Здесь мы увидим количество и модели контроллеров, их состояние.

Получим список виртуальных дисков для каждого контроллера:

Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|Dgrd=Degraded

Optl=Optimal|RO=Read Only|RW=Read Write|HD=Hidden|TRANS=TransportReady|B=Blocked|

Consist=Consistent|R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack|

AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled

Check Consistency

Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|Dgrd=Degraded

Optl=Optimal|RO=Read Only|RW=Read Write|HD=Hidden|TRANS=TransportReady|B=Blocked|

Consist=Consistent|R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack|

AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled

Check Consistency

Всего найдено 4 массива RAID10 по 32 Тб каждый. Это они у нас отображаются в операционной системе как sda, sdb, sdc, sdd.

Посмотрим на физические диски:

./storcli /c0 /eall /sall show

./storcli /c1 /eall /sall show

-------------------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type

-------------------------------------------------------------------------------

0:0 4 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:1 21 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:2 3 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:3 17 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:4 1 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:5 23 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:6 2 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:7 5 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:8 14 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:9 12 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:10 10 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:11 20 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:12 8 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:13 18 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:14 15 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:15 9 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:16 19 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:17 6 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:18 7 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:19 11 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:20 24 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:21 16 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:22 13 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

0:23 22 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

-------------------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

-------------------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type

-------------------------------------------------------------------------------

57:0 69 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:1 81 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:2 73 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:3 96 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:4 65 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:5 85 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:6 75 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:7 80 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:8 76 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:9 101 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:10 84 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:11 99 Onln 0 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:12 90 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:13 100 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:14 94 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:15 97 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:16 98 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:17 104 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:18 106 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:19 105 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:20 103 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:21 102 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:22 89 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

57:23 93 Onln 1 5.457 TB SATA HDD N N 512B TOSHIBA MG04ACA600E U -

-------------------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

Этой информации нам достаточно, чтобы определить, что каждый RAID10 массив состоит из 12 дисков. Spare диски отсутствуют.

Результат

Далее 4 hardware RAID10 массива в операционной системе попарно объединены в RAID0 массивы средствами mdadm .

Если вам понравилась статья, то ставьте 👍🏻 каналу.

Пишите комментарии, задавайте вопросы, подписывайтесь.

storcli64 и smartctl определяют местонахождение информации о сбое жесткого диска

Способ определения положения жесткого диска и буквы дискаSection One : Introduction

strocli - это обновленная версия megacli, которая perccli для серверов Dell, использование точно такое же

Smartctl может просматривать интеллектуальную информацию о главном чипе управления диска

lsscsi может просматривать информацию о системе scsi, источником данных является / proc / scsi / scsi, этот документ здесь не представлен

Эти инструменты являются общими инструментами для просмотра информации, связанной с диском, и полезны для устранения неполадок, связанных с состоянием диска и проблемами с картами-рейдами

Section Two : Install package

Установите storcli или perccli и программно подключите команду к каталогу / usr / bin / для удобного использования команды:

ln -s /opt/MegaRAID/storcli/storcli64 /usr/bin/

ln -s /opt/MegaRAID/perccli/percclie64 /usr/bin/

Section Three : Step

perccli64 / c0 / eall / sall покажет, что диск имеет

img-/c0/eall/sallНа рисунке четыре раздела jbod. Как показывает опыт, буква диска системы разделов jbod обычно находится перед разделом raid, что означает, что раздел jbod будет из / dev / sda> / dev / sdd, а раздел raid из / запускается dev / sde;

DG обозначает группу дисков и представляет собой порядок, в котором raid сконфигурирован для группировки. 32: 4 и 32: 5 показаны на рисунке как группа томов.

perccli64 / c0 / vall покажите, что соответствующие отношения между DG и VD этого диска таковы

img-/c0/vallИз рисунка видно, DG / В.Д. является группы томов RAID и система для того, соответствующие отношения между группами томов, как правило, только если группа сервера тома RAID в случае, операционная система VD0 из / DEV / SDA, и так далее; Однако, если сервер включает группу томов jbod, группа томов raid сортируется после jbod. В этом примере VD0 = / dev / sde. Если вы хотите найти / dev / sdf, VD = 1, что соответствует DG = 1

Возвращаясь к img- / c0 / eall / sall, когда DG равен 1, DID = 6, DID - это идентификатор устройства, эта концепция будет полезна позже, а слот №7 будет седьмым на сервере, что соответствует slt = 6. (От 0 до 6), в это время физическое расположение диска находится в / dev / sdf.

И наоборот, если вы видите индикатор сбоя жесткого диска на сервере, вы можете поменять местами соответствующую букву диска системного раздела.

Note:

Если на сервере нет группы томов jbod, все рейды, то в это время / c0 / vall может найти соответствующее отношение, чтобы найти отношение ассоциации

В реальной работе вы также можете выключить подсветку диска с помощью perccli64 / c0 / e32 / s6 locate, чтобы определить правильность расположения

Section Four : storcli/perccli Usage

Просмотр информации о контроллере

perccli64 show ctrlcount Посмотрите, сколько контроллеров - это несколько карт рейдов

perccli64 показать информацию о рейд-картах

Вы можете видеть, что есть только одна карта рейда, ctrl 0 также / c0

storcli64 /c0 show

Посмотрите на идентификатор устройства, номер слота и DriveGroup диска

Просмотр информации об указанном жестком диске

Note:

При просмотре информации об одной группе томов была обнаружена ошибка носителя, указывающая на неисправность жесткого диска.

Просмотр соответствия между дисками и разделами системного диска

Note:

VD: обычно считается порядком устройства жесткого диска в системе. Обычно, если в системе есть только raid-раздел, тогда VD = 0 - это / dev / sda, VD = 1 - это / dev / sdb и т. Д., Но если есть jbod Раздел, сначала расположите раздел jbod, например, если jbod достигает / dev / sdc, VD0 - это / dev / sdd и т. Д .;

DG: порядок, в котором группы томов настроены в карте рейда;

Команды, связанные с сбором журналов рейд-карт

storcli64 /c0 show time Показать время рейда

storcli64 /c0 show alilog logfile=node-x.alilog Получить alilog, все журналы включены

storcli64 /c0 show all logfile=node-x.all.log информация о рейд-карте

storcli64 /c0 show badblocks Информация о плохих секторах на диске

perccli64 /c0 show events filter=fatal Показывает уровень события как фатальный, вы можете получить информацию обо всех разрушительных событиях, найти сбой диска или сбой карты рейда

perccli64 /c0 show cc Проверка согласованности данных. Необходимо проверить согласованность данных нескольких дисков выше raid1, но raid0 на одном диске может не потребоваться, и неясно, повлияет ли это на производительность

Section Five : Smartctl Get Error info of Disks

Common Commands Usage Description

--scan Scan for devices

--scan-open Scan for devices and try to open each device

-x, --xall Show all information for device

-a, --all Show all SMART information for device

-i, --info Show identity information for device

-d TYPE, --device=TYPE Specify device type to one of: ata, scsi, nvme[,NSID], sat[,auto][,N][+TYPE], usbcypress[,X], usbjmicron[,p][,x][,N], usbprolific, usbsunplus, marvell, areca,N/E, 3ware,N, hpt,L/M/N, megaraid,N, aacraid,H,L,ID, cciss,N, auto, test

-s VALUE, --smart=VALUE Enable/disable SMART on device (on/off)

-o VALUE, --offlineauto=VALUE(ATA) Enable/disable automatic offline testing on device (on/off)

-S VALUE, --saveauto=VALUE(ATA) Enable/disable Attribute autosave on device (on/off)

-H, --health Show device SMART health status

-c, --capabilities(ATA,NVMe) Show device SMART capabilities

-A, --attributes Show device SMART vendor-specific Attributes and values

-l TYPE, --log=TYPE Show device log. TYPE: error, selftest, selective, directory[,g|s],

xerror[,N][,error], xselftest[,N][,selftest],

background, sasphy[,reset], sataphy[,reset],

scttemp[sts,hist], scttempint,N[,p],

scterc[,N,M], devstat[,N], ssd,

gplog,N[,RANGE], smartlog,N[,RANGE],

nvmelog,N,SIZE-t TEST, --test=TEST Run test. TEST: offline, short, long, conveyance, force, vendor,N,

select,M-N, pending,N, afterselect,[on|off]-X, --abort Abort any non-captive test on device

Get info for /dev/sdf

Посмотреть список всех устройств

Note:

В предыдущей главе мы нашли DID диска / dev / sdf в perccli, то есть device_id равен 6, то есть / dev / bus / 0 -d megaraid, 6

Просмотр информации о диске

Просмотр информации об атрибутах диска

Просмотр состояния диска

Note:

Что касается следующих результатов теста, это указывает, что результат теста PASSED, то есть диск все еще может использоваться, но список аварийного обнаружения WORST <THRESH, TYPE - Pre-fail, а WHEN_FAILED - In_the_past, что указывает на то, что диск предсказан как плохой.

Хочу рассказать поучительную историю, которая случилась со мной на днях. На одном из серверов в ЦОД вышел из строя диск в составе рейда mdadm. Ситуация типовая, с которой регулярно сталкиваюсь. Оставил заявку в техподдержку на замену диска с указанием диска, который надо поменять. В цоде заменили рабочий диск и оставили сбойный. Дальше история, как я решал возникшую проблему.

Если у вас есть желание научиться строить и поддерживать высокодоступные и надежные системы, рекомендую познакомиться с онлайн-курсом «DevOps практики и инструменты» в OTUS. Курс не для новичков, для поступления нужно пройти .Цели статьи

- Рассказать поучительную историю о том, какие могут быть проблемы при аренде серверов в ЦОД.

- Показать на примере, как надо действовать при выходе из строя диска в рейде mdadm.

- Простыми словами объяснить, в чем разница между программным и аппаратным рейдом.

Введение

Когда первый раз сталкиваешься с рукожопством сотрудников техподдержки дата центра, впадаешь в ступор и думаешь, ну как так то? Сейчас я спокойно отношусь к таким ситуациям и действую исходя из самых худших ожиданий. На днях я столкнулся с ситуацией, когда мне заменили не тот диск в сервере с RAID1. Вместо сбойного диска вынули рабочий и заменили чистым. К счастью все закончилось хорошо, но обо всем по порядку.

Не скажу, что у меня прям большой опыт аренды серверов, но он есть. Я регулярно обслуживаю 10-15 серверов, расположенных в разных дата центрах, как российских, так и европейских. Первый негативный опыт я получил именно в Европе и был очень сильно удивлен и озадачен. Я, как и многие, был под влиянием либеральной пропаганды на тему того, что у нас все плохо, а вот Европа образец надежности, стабильности и сервиса. Как же я ошибался. Сейчас отдам предпочтение нашим дата центрам. По моему мнению и опыту, у нас тех поддержка и сервис в целом лучше, чем там, без привязки к стоимости. В Европе дешевле схожие услуги, так как там масштабы сервисов в разы больше.

Приведу несколько примеров косяков саппорта, с которыми сталкивался.

Было много всяких инцидентов помельче, нет смысла описывать. Хотя нет, один все же опишу. Устанавливал свой сервер в ЦОД. Решил пойти в маш зал и проконтролировать монтаж. Если есть такая возможность, крайне рекомендую ей воспользоваться. Местный рукожоп неправильно прикрепил салазки и сервер во время монтажа стал падать. Я его поймал, тем спас его и сервера других клиентов. В итоге помог с монтажом. Сам бы он просто не справился. Я не представляю, что было, если бы я не пошел в машзал. К чести руководства, я написал претензию, где подробно описал данный случай и попросил бесплатно месячную аренду. Мне ее предоставили. Советую всем так поступать. Зачастую, руководство может быть не в курсе того, что происходит в реальности. Надо давать обратную связь.

Уровень моего доверия к тех поддержке дата центров и хостингов вы примерно представляете :) Ну и вот случилось очередное ЧП. Подробнее остановлюсь на этой ситуации, так как она случилась вчера, свежи воспоминания.

Замена диска в рейде mdadm

Речь пойдет о дешевых дедиках от selectel. Я их много где использую и в целом готов рекомендовать. Это обычные десктопные системники за скромные деньги. Свое мнение об этих серверах, а так же сравнение с полноценными серверами сделаю в конце, в отдельном разделе.

На сервере была установлена система Debian из стандартного шаблона Selectel. Вот особенности дисковой подсистемы этих серверов и шаблона.

- 2 ssd диска, объединенные в mdadm

- /boot раздел на /dev/md0 размером 1G

- корень / на /dev/md1 и поверх lvm на весь массив

В целом, хорошая и надежная разбивка, чему будет подтверждение дальше. На сервере был установлен proxmox, настроен мониторинг mdadm. Мониторинг дисков не сделал. В какой-то момент получил уведомление в zabbix, что mdadm развалился. Сервер при этом продолжал работать. Ситуация штатная. Пошел в консоль сервера, чтобы все проверить. Посмотрел состояние рейда.

Убедился, что один диск выпал из массива. В системном логе увидел следующее.

Попробовал посмотреть информацию о выпавшем диске.

Информации не было, утилита показывала ошибку обращения к диску. Получилось посмотреть модель и серийный номер только работающего диска.

Я не стал разбираться, что там к чему с диском. Если вижу проблемы, сразу меняю. Предупредил заказчика, что с диском проблемы, нужно планировать замену. Так как железо десктопное, "сервер" надо выключать. Согласовали время после 22 часов. Я в это время уже сплю, поэтому написал тикет в тех поддержку, где указал время и серийный номер диска, который нужно было оставить. Я сделал на этом акцент, объяснил, что сбойный диск не отвечает, поэтому его серийник посмотреть не могу. Расписал все очень подробно, чтобы не оставить почвы для недопонимания или двойного толкования. Я в этом уже спец, но все равно не помогло.

Я спокойно согласился на эту операцию, потому что часто делаются бэкапы и они гарантированно рабочие. Настроен мониторинг бэкапов и делается регулярное полуручное восстановление из них. Договоренность была такая, что хостер после замены дожидается появления окна логина, а заказчик проверяет, что сайт работает. Все так и получилось - сервер загрузился, виртуалки поднялись, сайт заработал. На том завершили работы.

Утром я встал и увидел, что весь системный лог в ошибках диска, рабочего диска в системе нет, а есть один глючный и один новый. Сразу же запустил на всякий случай ребилд массива и он вроде как даже прошел без ошибок. Перезагрузка временно оживила сбойный диск. В принципе, на этом можно было бы остановиться, заменить таки сбойный диск и успокоиться. Но смысл в том, что этот сбойный диск почти сутки не был в работе и данные на нем старые. Это не устраивало. Потом пришлось бы как-то склеивать эти данные с данными из бэкапов. В случае с базой данных это не тривиальная процедура. Созвонился с заказчиком и решили откатываться на рабочий диск, который вытащили накануне ночью.

Я создал тикет и попросил вернуть рабочий диск на место. К счастью, он сохранился. К нему добавить еще один полностью чистый. Хостер оперативно все сделал и извинился. В завершении прислал скриншот экрана сервера.

И самоустранился. Дальше решать проблему загрузки он предложил загрузившись в режиме rescue. Этот режим доступен через панель управления сервером в админке, даже если сервер не имеет ipmi консоли. Как я понял, по сети загружается какой-то live cd для восстановления. Я в нем загрузился, убедился, что данные на месте, но понять причину ошибки не смог. Может быть и смог бы, если бы дольше покопался, но это очень неудобно делать, не видя реальной консоли сервера. Я попросил подключить к серверу kvm over ip, чтобы я мог подключиться к консоли. Тех поддержка без лишних вопросов оперативно это сделала.

К слову, мне известны случаи, когда техподдержка selectel потом сама чинила загрузку и возвращала mdadm в рабочее состояние. Видел такие переписки в тикетах у своих клиентов до того, как они обращались ко мне. Но я не стал настаивать на таком решении проблемы, так как боялся, что будет хуже. К тому же это было утро воскресенья и специалистов, способных это сделать, могло просто не быть. Плюс, я не думаю, что они обладали бы большими компетенциями, чем я. Я бы за их зарплату не пошел работать в ЦОД.

После того, как я подключился к консоли сервера, восстановление загрузки было делом техники.

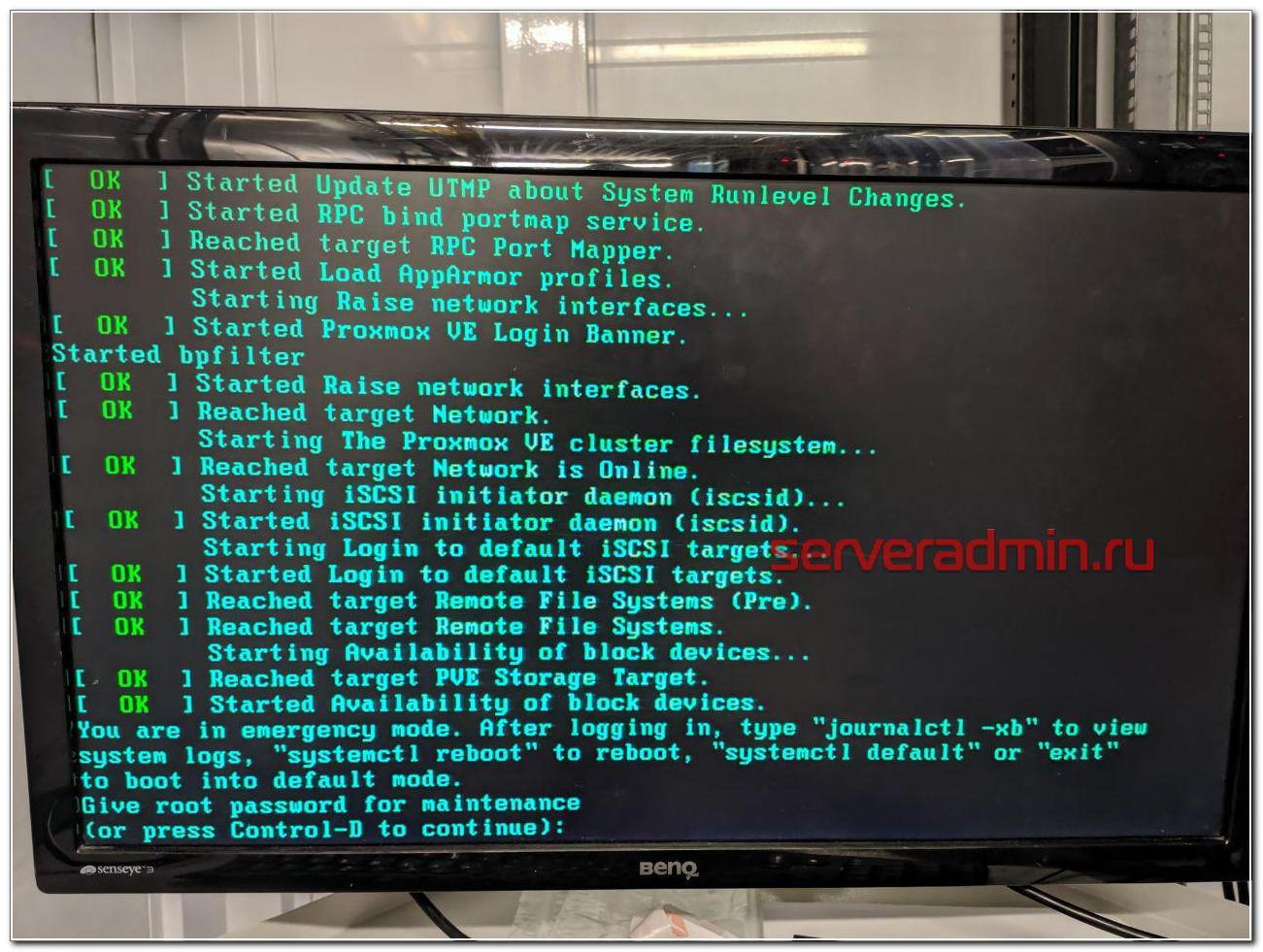

You are in emergency mode

У меня много примеров того, как я восстанавливал загрузку сломавшихся linux дистрибутивов.

В данной ситуации с mdadm я был уверен, что все получится, так как сам массив с системой жив, данные доступны. Надо только разобраться, почему система не загружается. Напомню, что ошибка загрузки была следующая.

Дальше нужно ввести пароль root и вы окажетесь в системной консоли. Первым делом я проверил состояние массива mdadm.

Состояние массива md0, на котором располагается раздел /boot - inactive. Вот, собственно, и причина того, почему сервер не загружается. Судя по всему, когда был подключен сбойный диск, mdadm отключил массив, чтобы предотвратить повреждение данных. Не понятно, почему именно на разделе /boot, но по факту было именно это. Из-за того, что массив остановлен, загрузиться с него не получалось. Я остановил массив и запустил снова.

После этого массив вышел из режима inactive и стал доступен для дальнейшей работы с ним. Я перезагрузил сервер и убедился, что он нормально загружается. Сервер фактически был в рабочем состоянии, просто с развалившимся массивом mdadm, без одного диска.

Если вам это не поможет, предлагаю еще несколько советов, что можно предпринять, чтобы починить загрузку. Первым делом проверьте файл /etc/fstab и посмотрите, какие разделы и как там монтируются. Вот мой пример этого файла.

Вам нужно убедиться, что указанные lvm разделы /dev/mapper/vg0-root и /dev/mapper/vg0-swap_1 действительно существуют. Для этого используйте команду:

Подробно об этой команде, о работе с lvm и вообще с дисками я рассказываю в отдельной статье - настройка диска в debian. Если с lvm разделами все нормально, проверьте /boot. У меня он монтируется по uuid. Посмотреть список uuid всех разделов можно командой.

Как вы видите, у меня uuid раздела для загрузки полностью совпадает с тем, что указано в fstab. Если по какой-то причине uuid изменился (разобрали и собрали новый массив), отредактируйте fstab.

Все дальнейшие действия я делал уже по ssh. Скопировал таблицу разделов с рабочего диска sda на чистый sdb.

Проверил таблицы разделов и убедился, что они идентичные.

Скопировал раздел BIOS boot partition с рабочего диска на новый.

Потом добавил разделы диска sdb2 и sdb3 в рейд массив.

Дождался окончания ребилда и убедился, что он прошел. Проверил состояние массива.

В завершении устанавливаем загрузчик на оба диска.

После этого я перезагрузился и убедился, что все работает нормально. По хорошему, теперь надо было бы поменять загрузочный диск с первого на второй и убедиться, что со второго тоже нормально грузится. Я не стал этого делать, и так простой и так был велик. Главное, чтобы массив был на месте, а починить загрузку, если что, дело техники.

Вот и все по замене диска в массиве mdadm. После доступа к консоли сервера, мне потребовалось минут 10, чтобы вернуть сервер в рабочее состояние.

В чем отличия программного и аппаратного рейда

Сейчас расскажу, чем принципиально отличается программный рейд контроллер (mdadm) от аппаратного, для тех, кто этого до конца не понимает. Если бы у меня вышел из строя диск на аппаратном рейд контроллере, установленном в полноценный сервер, проблема по замене сбойного диска в RAID решалась бы в следующей последовательности:

- Рейд контроллер оповещает о том, что с диском проблемы и выводит его из работы. В случае с софтовым рейдом система может зависнуть в случае проблем с диском, прежде чем пометит его как проблемный и перестанет к нему обращаться.

- Я оставляю тикет в тех поддержку, где прошу заменить сбойный диск. Информацию о нем я посмотрю в панели управления рейд контроллером.

- Сотрудник тех поддержки видит сбойный диск, так как индикация на нем, скорее всего, будет мигать красной лампочкой. Это не гарантия того, что рукожоп все сделает правильно, но тем не менее, шансов, что он ошибется, меньше. Я сталкивался с ситуацией, когда и в этом случае диск меняли не тот.

- При появлении нового диска raid контроллер автоматически начинает ребил массива.

Если же у вас в сервере уже установлен запасной диск на случай выхода из строя диска в составе raid массива, то все еще проще:

- При выходе из строя диска, контроллер помечает его как сбойный, вводит в работу запасной диск и начинает ребилд.

- Вы получаете оповещение о том, что вышел из строя диск и оставляете тикет в тех поддержку на замену запасного диска.

И это все. В обоих случаях у вас вообще нет простоя. Вот принципиальная разница между mdadm и железным raid контроллером. Стоимость полноценного сервера с контроллером и постоянным ipmi доступом к консоли в среднем в 3 раза выше, чем у сервера на десткопном железе с софтовым рейдом при схожей производительности. Это все при условии, что вам достаточно одного процессора и 64G памяти. Это потолок для десктопных конфигураций. Дальше считайте сами, что вам выгоднее. Если возможен простой в несколько часов на замену диска или других комплектующих, то смело можно использовать десктопное железо. Mdadm обеспечивает сопоставимую гарантию сохранности данных в сравнении с железным контроллером. Вопрос лишь в простое и производительности. Ну и своевременные бэкапы добавляют уверенности в том, что вы переживете неполадки с железом.

При использовании железного рейда на hdd дисках, есть возможно получить очень значительный прирост скорости за счет кэша контроллера. Для ssd дисков я особо не замечал разницы. Но это все на глазок, никаких замеров и сравнений я не делал. Нужно еще понимать, что десктопное железо в целом менее надежное. К примеру, в том же селектеле на дешевых серверах я ловил перегрев или очень высокую температуру дисков. Прыгала в районе 55-65 градусов. Все, что ниже 60-ти, тех поддержка футболила, говоря, что это допустимая температура, судя по документации к дискам. Это так и есть, но мы же понимаем, что диск, постоянно работающий на 59 градусах с бОльшей долей вероятности выйдет из строя.

Вот еще пример разницы в железе. Если у вас в нормальном сервере выйдет из строя планка памяти, сервер просто пометит ее как сбойную и выведет из работы. Информацию об этом вы увидите в консоли управления - ilo, idrac и т.д. В десктопном железе у вас просто будет постоянно виснуть сервер и вам придется долго выяснять, в чем же проблема, так как доступа к железу у вас нет, чтобы проще было запланировать тестирование сервера. А если вы закажете это у тех поддержки, то есть ненулевая вероятность, что станет хуже - сервер уронят, перепутают провода подключения дисков и т.д. В общем, это всегда риск. Проще сразу съезжать с такой железки на другую.

Заключение

Надеюсь, моя статья была интересной. Для тех, кто никогда не работал с ЦОДами будет полезно узнать, чего можно от них ожидать. Я скучаю по временам, когда все сервера, которые я администрировал, были в серверной, куда никому не было доступа и куда я мог в любой момент попасть и проверить их. Сейчас все стало не так. И твои сервера уже не твои. Их может сломать, уронить, что-то перепутать сотрудник тех поддержки дата центра.

Сейчас большой тренд на переход в облака. Я смотрю на эти облака и не понимаю, как с ними можно нормально взаимодействовать. Заявленная производительность не гарантированная, нагрузка плавает в течении суток. Упасть может в любой момент и ты не будешь понимать вообще в чем проблема. Твои виртуалки могут быть по ошибке удалены и кроме извинений и компенсации в 3 копейки ты ничего не получить. Каждое обращение в ТП как лотерея. Думаешь, что сломают в этот раз. Если сервера железные, то когда пишу тикет на доступ к железу, я морально и технически всегда готов к тому, что этот сервер сейчас отключится и я больше не смогу к нему подключиться.

В целом, опыт работы с облаками у меня негативный. Несколько раз пробовал для сайтов и все время съезжал. Нет гарантированного времени отклика. А это сейчас фактор ранжирования. Для очень быстрого сайта остается только один вариант - свое железо, а дальше уже кому какое по карману. Зависит от надежности и допустимого времени простоя.

Я про облака заговорил, потому что тенденции к тому, что от железных серверов надо отказываться и все переносить в облака. С одной стороны удобно должно быть. Как минимум, не будет указанных выше в статье проблем. А с другой стороны добавляется куча других проблем. Я пока сижу на железяках разного качества и стоимости. А у вас как?

Читайте также: