Что не относится к инструментам хранения и обработки больших данных excel

Обновлено: 03.07.2024

Десять лет назад данные по всему миру начали активно расти, открывая возможности по улучшению клиентского опыта. На текущий момент понятие Big Data уже прочно вошло в обиход по всему миру. Львиная доля этих данных собирается через Интернет, а остальная часть с помощью устройств с возможностью выхода в сеть. Также еще один важный фактор роста — это растущее число виртуальных online офисов.

Компании заинтересованы как в найме экспертов Big Data, так и людей хорошо разбирающихся в инструментах аналитики. Руководители команд ищут сотрудников, обладающих компетентными навыками и демонстрирующих талант и когнитивные способности, которые стали бы ценным активом для выполнения нишевых обязанностей компании. Много из того, что было ценным раньше утратило свою ценность и наоборот. В любом случае, давай подробнее разберем что такое Big Data.

Мы без остановки производим гигантское количество данных через социальные сети, общественный транспорт и интернет покупки. Их объемы завораживают дух. Ежедневно мы загружаем 95 миллионов изображений и видео, 340 миллионов твитов и 1 миллиард документов. Всего мы производим 2,5 квинтиллиона байт в день, кто-то из вас помнит сколько это нулей? Вот поэтому их и называют Big Data.

Хотя данные проникли почти во все ниши и служат одной из главных движущих сил успеха современных компаний, но термин Big Data используется не так давно. К слову, Google Trends демонстрирует интерес пользователей к этому словосочетанию с 2011 года. Сегодня этот термин находится в активной ротации, являясь одним из наиболее часто используемых в корпоративной среде. У этого термина нет четких границ и определения, кто-то считает что Big Data начинается со 100 Гб (500 Гб, 1 Тб, что угодно), кто-то с данных которые невозможно обработать в Excel или с данных которые невозможно обработать на одном компьютере, а кто-то причисляет к ним любые данные. Поэтому существует и альтернативное мнение, что Big Data не существует, это вымышленный персонаж, который маркетологи используют, чтобы заставить компании тратить деньги.

Sportmaster Lab , Санкт-Петербург, Москва, Липецк , От 100 000 до 150 000 ₽

Так что же это за концепция? По сути, Big Data — это серия подходов, инструментов и методов, используемых для обработки структурированных и неструктурированных данных огромных объемов и значительного разнообразия для получения результатов, воспринимаемых людьми, которые доказывают свою эффективность в условиях непрерывного роста. Большие данные служат альтернативой традиционным системам управления базами данных и решениям в рамках Business Intelligence.

Таким образом, большие данные не относятся к определенному количеству данных или даже к самим данным. Вместо этого термин означает методы обработки данных, которые позволяют распределенную обработку информации. Эти методы могут применяться как к огромным наборам данных (например, содержание всех страниц в Интернете), так и к небольшим (например, к содержанию этой статьи).

Большие данные имеют важное значение для глобального бизнеса, поскольку большее количество данных приводит к более точному анализу, который, в свою очередь, обеспечивает более эффективное принятие решений, повышение операционной эффективности и сокращению затрат.

Три больших кита Big Data

Когда мы говорим о больших данных, мы не можем не упомянуть три ключевых свойства: объем, скорость и разнообразие. Эти три вектора позволяют нам понять, чем большие данные выгодно отличаются от управления данными старой школы.

Объем

Количество данных должно быть достаточно. Вам придется обрабатывать огромные объемы неструктурированных данных с низкой плотностью. И размер данных является наиболее важным показателем при определении возможной извлекаемой ценности, так как чем больше данных, тем точнее можно получить результат на них. Клики-потоки, системные журналы и системы потоковой обработки обычно генерируют достаточные по объему данные.

Разнообразие

Давно прошли те времена, когда данные собирались из одного места и возвращались в едином формате. Сегодня данные бывают всех форм и размеров, включая видео, текст, звук, графику и даже выкалывание на бумаге. Таким образом, большие данные предоставляют возможности для использования новых и существующих данных и разработки новых способов сбора данных в будущем.

Скорость

Под скоростью обычное подразумевается, как быстро данные попадают к нам из различных систем для дальнейшего с ними взаимодействия. Некоторые данные могут появляться в режиме реального времени, а некоторые поступают пачками. Поскольку большинство платформ обрабатывают входящие данные с разной скоростью, важно не ускорять процесс принятия решения, не имея всей необходимой информации.

Лучшие инструменты для работы с Big Data

Программное обеспечение Big Data Analytics широко применяется для эффективной обработки данных и достижения конкурентного преимущества на рынке. Эти программные аналитические инструменты помогают отслеживать текущие рыночные изменения, потребности клиентов и другую различную ценную информацию. Давайте рассмотрим самые популярные инструменты аналитики 2021 году.

Apache Hadoop

Apache Hadoop занимает первое место в нашем списке. Большие данные будет сложно обрабатывать без Hadoop, и специалисты по данным хорошо это знают. Hadoop — это не только полностью открытая и бесплатная система хранения больших данных, но и сопутствующий набор утилит, библиотек, фреймворков, дистрибутивов для разработки.

Эта основополагающая технология хранения и обработки больших данных является проектом верхнего уровня Apache Software Foundation.

Hadoop состоит из четырех частей:

- HDFS — это распределенная файловая система, предназначенная для работы на стандартном оборудовании.

- MapReduce — модель распределённых вычислений, представленная компанией Google, используемая для параллельных вычислений.

- YARN— технология, предназначенная для управления кластерами.

- Библиотеки — для работы остальных модулей с HDFS

X-plenty

Эта облачная масштабируемая платформа входит в число лидеров в своей нише, предлагая решения ETL и инструменты конвейера данных. X-plenty обрабатывает как структурированные, так и неструктурированные данные и объединяется с различными источниками, включая Amazon Redshift, хранилища данных SQL, базы данных NoSQL и облачные службы хранения. Основные преимущества:

- легкое преобразование данных;

- REST API;

- гибкость в использовании;

- превосходная безопасность;

- различные источники данных;

- клиентоориентированный подход.

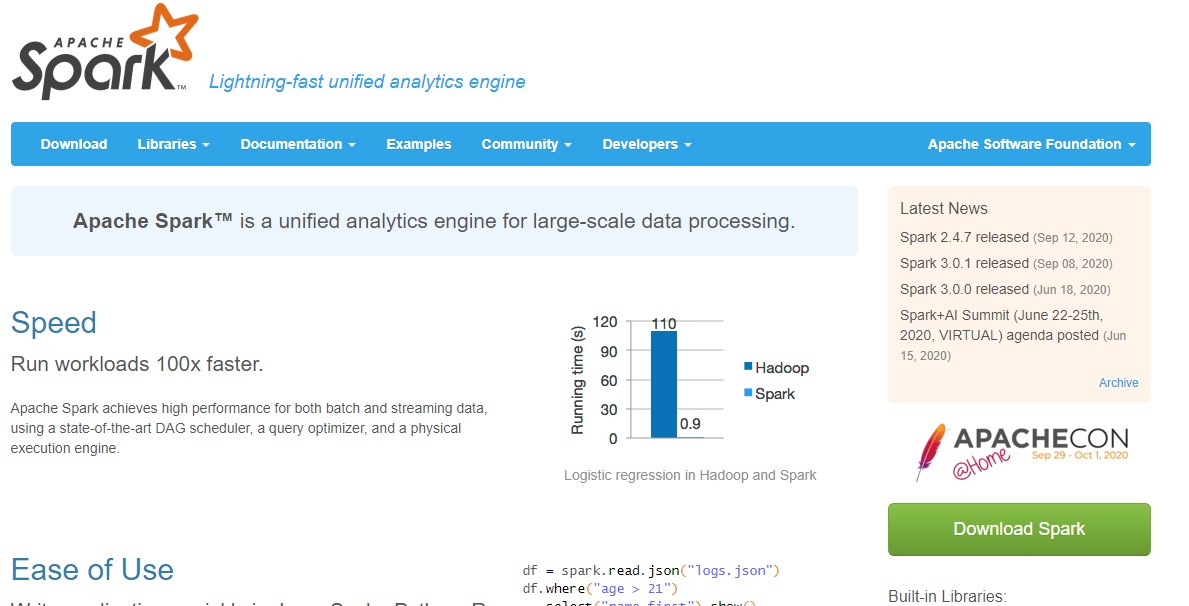

Spark

Сегодня этот мощный инструмент аналитики с открытым исходным кодом является одним из основных в арсенале компаний, включая Amazon, eBay и Yahoo. Apache Spark — это технология для работы с большими данными посредством распределенных вычислений в оперативной памяти, что увеличивает скорость обработки. Он основан на Hadoop и является по сути эволюцией концепции MapReduce, используя другие типы вычислений, включая интерактивные запросы и потоковую обработку.

Spark создан для широкого спектра рабочих задач, таких как пакетные приложения, итерационные алгоритмы, интерактивные запросы и потоковая передача. Это делает его идеальным вариантом как для любительского использования, так и для профессиональной обработки больших объемов данных.

Cassandra

Если вы знакомы с базами данных NoSQL, вы наверняка сталкивались с Cassandra. Это бесплатная база данных NoSQL с открытым исходным кодом, и она хранит значения в виде пар ключ-значение. Этот инструмент — идеальный выбор, когда вам требуется масштабируемость и высокая доступность без ущерба для производительности.

Благодаря своим архитектурным особенностям Apache Cassandra имеет следующие преимущества:

- масштабируемость и надежность за счет отсутствия центрального сервера;

- гибкая схема данных;

- высокая пропускная способность, особенно для операций записи;

- собственный SQL-подобный язык запросов;

- настраиваемая согласованность и поддержка репликации;

- автоматическое разрешение конфликтов.

Talend

Talend — это аналитическая программа, а точнее бесплатный инструмент ETL с открытым исходным кодом, которая упрощает и оптимизирует интеграцию больших данных. ETL упрощает преобразование необработанных данных в информацию, которую можно использовать для практической бизнес-аналитики (BI). Программное обеспечение Talend может похвастаться такими функциями, как облако, большие данные, интеграция корпоративных приложений, качество данных и управление основными данными. Он также содержит единый репозиторий для хранения и повторного использования метаданных и проверки качества данных.

- более быстрая разработка и развертывание;

- меньше расходов и бесплатная загрузка;

- современное решение;

- единая платформа;

- огромное преданное сообщество.

Существует широкий спектр инструментов для работы с большими данными, которые помогают хранить, анализировать, составлять отчеты и делать с данными намного больше. Это программное обеспечение превращает скудные биты данных в мощное топливо, которое стимулирует глобальные бизнес-процессы и способствует принятию решений, основанных на знаниях.

Итоги

Когда-то использование больших данных произвело революцию в области информационных технологий. Сегодня компании используют ценные данные и внедряют инструменты больших данных, чтобы превзойти своих конкурентов. На конкурентном рынке как устоявшиеся компании, так и новички применяют стратегии, опираясь на обработанные данные, чтобы зафиксировать сигнал, отследить пожар и получить прибыль.

Большие данные позволяют организациям определять новые возможности и создавать новые типы компаний, которые могут комбинировать и анализировать отраслевые данные. Таким образом, чистые, актуальные и наглядные данные предоставляют полезную информацию о продуктах, оптимизируют бизнес-операции и влекут за собой значительные экономические преимущества.

Собранные компанией данные являются фундаментальным источником информации для любого бизнеса. Извлечь искомое своими силами из огромного массива не так-то просто и здесь на помощь приходит специальный софт.

Перевод публикуется с сокращениями, автор оригинальной статьи Edwin Lisowski.

Apache Hadoop – самый популярный инструмент для BigData . П озволяющий обрабатывать огромные объемы данных фреймворк с открытым исходным кодом (бесплатный по лицензии Apache) работает на мощном оборудовании в дата-центре.

- облачная инфраструктура;

- поддерживающие другие модели работы фреймворка библиотеки;

- универсальная модель для обработки – MapReduce;

- распределенная ФС – HDFS, позволяющая хранить любые типы данных;

- высокая масштабируемость;

- эффективная и гибкая обработка данных.

Распределенный фреймворк реального времени, поддерживающий любой ЯП. Он написан на Java и Clojure и является полностью бесплатным. Apache Storm может обрабатывать и преобразовывать потоки данных из различных источников.

RapidMiner – это кросс-платформенный инструмент для обработки BigData с открытым исходным кодом. Он объединяет data science, прогнозную аналитику и технологию машинного обучения, а также предлагает широкий спектр продуктов, позволяющих создавать новые процессы интеллектуального анализа данных.

Платформа доступна под различными лицензиями: бесплатная позволяет пользователям использовать 1 логический процессор и до 10 000 строк данных; стоимость коммерческой версии Rapidminer начинается с $2.500 в год.

- хорошо развитая облачная интеграция;

- интерактивные информационные панели, которые легко расшарить;

- интеграция с клиентскими базами данных;

- создание и валидация прогнозных моделей;

- разнообразие методов управления данными;

- прогнозная аналитика на основе BigData;

- поддержка клиент-серверной модели.

Основываясь на вашей деятельности, автономная BigData -платформа Qubole изучит, оптимизирует и сможет управлять данными. Это положительно скажется на сосредоточенности инженеров исключительно на обработке данных вместо управления фреймворком.

Стоимость инструмента от $199 в месяц, но есть вариант подписки, предназначенный для предприятий с несколькими пользователями.

- облачная оптимизация;

- гибкость и простота в использовании;

- движок с открытым исходным кодом;

- автоматическое использование процедур, для минимизации повторения ручных действий;

- встроенные оповещения и рекомендации, оптимизирующие надежность, производительность и затраты на обслуживание.

Tableau – инструмент визуализации для бизнес-аналитики и анализа данных. Программное обеспечение содержит три основных продукта: d esktop, s erver, o nline предназначенные для аналитики, предприятия и использования в облаке соответственно.

Проект прост в использовании, может обрабатывать все размеры данных, а также умеет визуализировать данные в реальном времени через web-коннектор.

- совместная работа онлайн;

- создание любых типов визуализации;

- no-code запросы;

- простое расшаривание данных для мобильных устройств;

- удобная настройка.

Распределенная опенсорсная БД Cassandra , предназначена для управления большими объемами данных, раскиданных по серверам. Распространяется бесплатно.

- быстрая обработка огромных объемов данных;

- линейная масштабируемость;

- доступ из облака;

- отсутствие единой точки отказа;

- автоматическая репликация;

- распределение данных между дата-центрами.

Apache Spark – это уникальное решение с открытым исходным кодом, способное обрабатывать как данные реального времени, пакетные данные, так и данные в памяти, что обеспечивает быстрые результаты. Инструмент может работать в локальной системе, что облегчает тестирование и разработку. Стоимость завязана на лицензии Apache, но есть и бесплатная пробная версия.

- производительная потоковая обработка;

- интеллектуальная система обработки графов;

- автономный кластерный режим;

- стек доступных тематических библиотек;

- DataFrame API;

- развертывание в облаке.

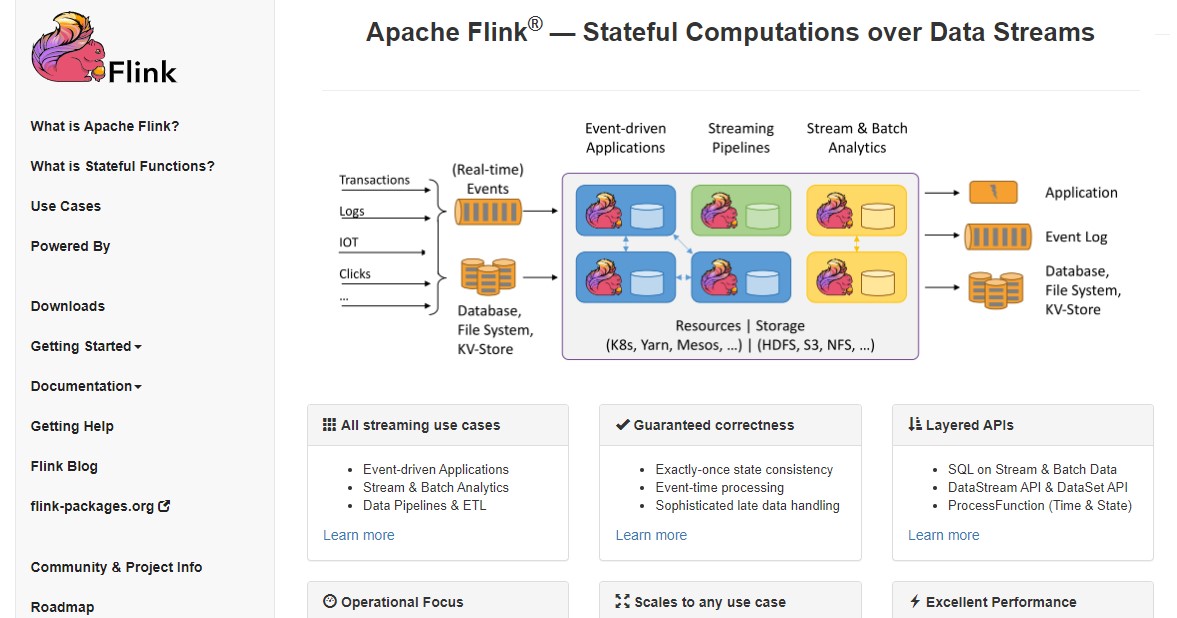

Фреймворк с открытым исходным кодом для потоковой обработки больших данных. Она может быть как ограниченной, так и неограниченной. Flink работает во всех известных кластерных средах и способен продуктивно выполнять задачи любого масштаба.

- точные результаты;

- отказоустойчивость и авто-восстановление после сбоя;

- поддержка различных адаптеров для связи со сторонними системами и источниками данных;

- гибкость «оконного» управления.

При наличии множества инструментов для работы с BigData , важно четко определить свои потребности, прежде чем выбрать подходящий под структуру вашего бизнеса.

Поскольку большинство платформ предлагают пробную версию, рекомендуется уделить время тщательной проверке, чтобы они полностью соответствовали вашим требованиям.

Разнообразие продуктов велико, выберите свой для повышения производительности, точности результатов и уменьшения скучной рутины. Если вы используете в проектах другой софт – напишите в комментариях, какой именно и ваше мнение о нем.

Возможность поиска и очистки больших данных имеет важное значение в 21 веке. Правильные инструменты являются обязательным условием для конкуренции с конкурентами и добавления преимуществ для вашего бизнеса. Я делаю список из 30 лучших инструментов для больших данных для вас.

Часть 1. Инструменты извлечения данных

Parsehub es un rastreador basado en web (web-based crawler). Puede extraer datos que manejan sitios web dinámicos con AJax, JavaScripts y detrás del inicio de sesión. Tiene una ventana de prueba gratuita de una semana para que los usuarios experimenten sus funcionalidades.

Import.io - это веб-инструмент для извлечения данных. Впервые он был запущен в Лондоне. Теперь import.io меняет свою бизнес-модель с B2C на B2B. В 2019 году Import.io приобрел Connotate и стал платформой для интеграции веб-данных . Import.io - это отличный выбор для бизнес-анализа.

Mozenda - это программное обеспечение для просмотра веб-страниц, которое также предоставляет сервис очистки для извлечения данных на уровне предприятия . Вы можете извлекать обновляемые данные из облачного программного обеспечения и локального программного обеспечения.

Часть 2: Инструменты с открытым исходным кодом

KNIME Analytics Platform - аналитическая платформа. Это может помочь вам обнаружить бизнес-идеи и весь потенциал на рынках. Он предоставляет платформу Eclipse вместе с другими внешними расширениями для интеллектуального анализа данных и машинного обучения. Он предлагает более 2 тысяч модулей для профессионалов-аналитиков, готовых к внедрению.

OpenRefine (ранее Google Refine) - это мощный инструмент для работы с грязными данными : очистки, преобразования и связывания наборов данных. С его групповыми функциями вы можете нормализовать данные, как вам нравится.

Это бесплатное программное обеспечение языка программирования и графики и статистического расчета программного обеспечения. Язык R популярен среди майнеров данных для разработки статистического программного обеспечения и анализа данных. Заработайте кредиты и популярность в последние годы благодаря простоте использования и обширной функциональности.

Помимо интеллектуального анализа данных, он также предоставляет статистические и графические методы, линейное и нелинейное моделирование, классические статистические тесты, анализ временных рядов, классификацию, группирование и многое другое.

Как и KNIME, RapidMiner работает через визуальное программирование и способен манипулировать, анализировать и моделировать . Повышение производительности работы с данными с помощью платформы с открытым исходным кодом, машинного обучения и развертывания моделей. Унифицированная платформа для обработки данных ускоряет аналитические процессы от подготовки данных к внедрению. Значительно повышает эффективность.

Это отличное программное обеспечение для бизнес-аналитики, которое помогает компаниям принимать решения на основе данных. Как и большинству компаний, трудно получить ценность из данных. Платформа объединяет источники данных , включая локальную базу данных, Hadoop и NoSQL. В результате вы можете легко анализировать данные и управлять ими.

Это программное обеспечение с открытым исходным кодом, предназначенное для преобразования данных в информацию. Он предоставляет различные услуги и программное обеспечение, включая облачное хранилище, интеграцию бизнес-приложений, управление данными и т. Д. При поддержке обширного сообщества он позволяет всем пользователям и членам Talend обмениваться информацией, опытом, вопросами из любого места.

Weka - это набор алгоритмов машинного обучения для задач интеллектуального анализа данных . Алгоритмы могут быть применены непосредственно к набору данных или вызваны из его собственного кода JAVA. Он также подходит для разработки новых схем машинного обучения. С помощью графического интерфейса вы можете привлечь профессионалов, которым не хватает навыков программирования, в мир наук о данных.

Это программный пакет с открытым исходным кодом для Microsoft Excel. В качестве дополнительного расширения у него нет сервисов и функций интеграции данных. Основное внимание уделяется анализу социальных сетей. Интуитивно понятные сети и описательные отношения облегчают анализ социальных сетей. Являясь одним из лучших статистических инструментов для анализа данных, он включает в себя расширенные сетевые метрики, доступ к импортерам данных из социальных сетей и автоматизацию.

Gephi также представляет собой пакет программного обеспечения с открытым исходным кодом для визуализации и анализа сети, написанный на Java на платформе NetBeans . Подумайте об огромной сети отношений, которые вы видите, которые представляют соединения LinkedIn или Facebook. Gephi идет дальше, предоставляя точные расчеты.

Microsoft PowerBI предоставляет локальные и облачные сервисы. Впервые он был представлен как надстройка Excel. Вскоре PowerBI набирает популярность благодаря своим мощным функциям. На данный момент вы воспринимаетесь как лидер в аналитике. Он обеспечивает визуализацию данных и возможности бизнес-аналитики, которые позволяют пользователям творчески и инновационно создавать отчеты и информационные панели с минимальными затратами.

Solver специализируется на программном обеспечении корпоративного управления эффективностью (CPM). Его программное обеспечение BI360 доступно для локального и облачного развертывания, которое сосредоточено на четырех ключевых аналитических областях, включая финансовую отчетность, бюджетирование и информационные панели, а также хранилище данных.

Qlik - это инструмент для визуализации и анализа данных самообслуживания . Визуализированные информационные панели, которые помогают компании с легкостью «понять» эффективность бизнеса.

Tableau - это интерактивный инструмент визуализации данных. «В отличие от» большинства инструментов визуализации, которые требуют сценариев. Tableau помогает новичкам «преодолеть» трудности практической работы. Функции перетаскивания упрощают анализ данных. У них также есть «стартовый комплект» и богатый источник обучения, чтобы помочь пользователям создавать инновационные отчеты.

Fusion Table - это платформа управления данными, предоставляемая Google . Вы можете использовать его для сбора, просмотра и обмена данными. Это похоже на электронную таблицу, но гораздо более мощный и профессиональный. Вы можете сотрудничать с университетами, добавив их CSV, KML и набор данных электронных таблиц. Вы также можете опубликовать свою работу с данными и встроить ее в другие веб-ресурсы.

Infogram предоставляет более 35 интерактивных диаграмм и более 500 карт, которые помогут вам визуализировать данные. В дополнение к различным диаграммам (включая гистограммы, гистограммы, круговые диаграммы или облака слов) существуют инновационные форматы инфографики.

Он имеет инструмент обратной связи с клиентами, который собирает отзывы и мнения клиентов. Затем они анализируют языки, используя НЛП, чтобы прояснить положительные и отрицательные намерения. Просмотр результатов с графиками и таблицами на панелях. Также вы можете подключить HubSpot ServiceHub к системе CRM. В результате вы можете связать результаты опроса с конкретным контактом. Таким образом, вы можете выявлять недовольных клиентов и своевременно предоставлять качественные услуги, чтобы увеличить удержание клиентов.

Часть 5. Databases

Нет сомнений в том, что Oracle является чемпионом среди баз данных с открытым исходным кодом. Благодаря многочисленным функциям, это лучший вариант для компании . Он также поддерживает интеграцию различных платформ. Простота настройки в AWS делает его надежным выбором для реляционной базы данных. Высокий уровень безопасности для интеграции личных данных, таких как кредитные карты, делает их незаменимыми.

Он превосходит Oracle, MySQL, Microsoft SQL Server и становится четвертой по популярности базой данных. Обладая высокой стабильностью, он может обрабатывать большие объемы данных.

Это облачное программное обеспечение для баз данных, которое имеет широкие возможности таблиц данных для сбора и отображения информации. Он также имеет электронную таблицу и встроенный календарь, чтобы легко отслеживать задачи. Работать с вашими начальными шаблонами легко с помощью Lead Management, Bug Tracking и Lead Tracking.

Это бесплатная база данных с открытым исходным кодом для хранения, вставки, изменения и восстановления данных. Кроме того, Мария поддерживает сильное сообщество с активными членами для обмена информацией и знаниями.

Главная Надстройки Статьи Формулы Обработка больших объемов данных. Часть 1. ФормулыОбработка больших объемов данных. Часть 1. Формулы

| nwdata_sums.xls | [Обработка данных (формат 97-2003)] | 2725 kB |

| nwdata_sums.xlsx | [Обработка данных (формат 2007)] | 732 kB |

Одним из самых популярных методов использования электронных таблиц является обработка данных, полученных из учетных систем. Современные базы данных, используемые учетными системами в качестве хранилища информации, способны накапливать и обрабатывать в собственных структурах десятки, а иногда сотни тысяч информационных записей в день. Средства анализа в системах управления базами данных реализуются либо на программном уровне, либо через специальные интерфейсы и языки запросов. Электронные таблицы позволяют эффективно обработать данные без знания языков программирования и других технических средств.

Методы переноса данных в Excel могут быть различны:

- Копирование-вставка результатов запросов

- Использование стандартных процедур импорта (например, Microsoft Query) для формирования данных на рабочих листах

- Использование программных средств для доступа к базам данных с последующим переносом информации в диапазоны ячеек

- Непосредственный доступ к данным без копирования информации на рабочие листы

- Подключение к OLAP-кубам

Данные, полученные из учетных систем, обычно характеризуются большим объемом – количество строк может составлять десятки тысяч, количество столбцов при этом часто невелико, так как языки запросов к базам данным сами имеют ограничение на одновременно выводимое количество полей.

Обработка этих данных в Excel может вестись различными методами. Выделим основные способы работы:

- Обработка данных стандартными средствами интерфейса Excel

- Анализ данных при помощи сводных таблиц и диаграмм

- Консолидация данных при помощи формул рабочего листа

- Выборка данных и заполнение шаблонов для получения отчета

- Программная обработка данных

Правильность выбора способа работы с данными зависит от конкретной задачи. У каждого метода есть свои преимущества и недостатки.

В данной статье будут рассмотрены способы консолидации и выборки данных при помощи стандартных формул Excel.

Описание примеров

Примеры к статье построены на основе демонстрационной базы данных, которую можно скачать с сайта Microsoft

Выгруженный из этой базы данных набор записей сформирован при помощи Microsoft Query.

Данные не несут специальной смысловой нагрузки и используются только в качества произвольного набора записей, имеющих несколько ключевых полей.

Файл nwdata_sums.xls используется для версий Excel 2000-2003

Файл nwdata_sums.xlsx имеет некоторые отличия и используется для версий Excel 2007-2010.

Первый лист data содержит исходные данные, остальные – примеры различных формул для обработки информации.

Ячейки, окрашенные в серый цвет, содержат служебные формулы. Ячейки желтого цвета содержат ключевые значения, которые могут быть изменены.

Применение метода

Очевидно, самым простым и удобным методом обработки больших объемов данных с точки зрения пользователя являются сводные таблицы. Этот интерфейс специально создавался для подобного рода задач, способен работать с различными источниками данных, поддерживает интерфейсные методы фильтрации, группировки, сортировки, а также автоматической агрегации данных различными способами.

Проблема при консолидации данных при помощи сводных таблиц появляются, если предполагается дальнейшая работа с этими агрегированными данными. Например, сравнить или дополнить данные из двух разных сводных таблиц (как вариант: объемы продаж и прайс листы). В таком случае обычно прибегают к методу копирования значений из сводных таблиц в промежуточные диапазоны с дальнейшим применением формул поиска (VLOOKUP/HLOOKUP). Очевидно, что проблема возникает при обновлении исходных данных (например, при добавлении новых строк) – требуется заново копировать результаты консолидации из сводной таблицы. Другим, с нашей точки зрения, не совсем корректным методом решения является применение функций поиска непосредственно к диапазонам, которые занимают сводные таблицы. Это может привести к неверному поиску при обновлении не только данных, но и внешнего вида сводной таблицы.

Еще один классический пример непригодности применения сводной таблицы – это требование формирования отчета в заранее предопределенном виде («начальство требует в такой форме и никак иначе»). Возможностей настройки сводной таблицы зачастую недостаточно для предоставления произвольной формы. В данном случае пользователи также обычно используют копирование результатов агрегирования в качестве значений.

Самым правильным методом обработки данных в приведенных случаях, с нашей точки зрения, является применение функций рабочего листа для консолидации данных. Этот метод требует иногда больших затрат времени на создание формул, но зато в дальнейшем при изменении исходных данных отчеты будут обновляться автоматически. Файлы примеров показывают различные варианты применения функция рабочего листа для обработки данных.

Суммирование по одному ключевому полю

Таблицы с формулами на листе SUM показывают вариант решения задачи консолидации данных по одному ключевому значению.

Две верхние таблицы на листе демонстрируют возможности стандартной функции SUMIF, которая как раз и предназначена для суммирования с проверкой одного критерия.

Нижние таблицы показывают возможности другой редко используемой функции DSUM

Первый параметр определяет рабочий диапазон данных. Причем верхняя строка диапазона должна содержать заголовки полей. Второй параметр указывает наименование поля (столбца) для суммирования. Третий параметр ссылается на диапазон условий суммирования. Этот диапазон должен состоять как минимум из двух строк, верхняя строка – поле критерия, вторая и последующие - условия.

В другом варианте указания условий именем поля в этом диапазоне можно пренебречь, задав его прямо в тексте условия:

Здесь data!Z2 означает ссылку на текущую строку данных, а не на конкретную ячейку, так как используется относительная ссылка. К сожалению, нельзя указать в третьем параметры ссылку на одну ячейку – строка заголовка полей все равно требуется, хотя и может быть пустой.

В принципе, функции типа DSUM являются устаревшим методом работы с данными, в подавляющем большинстве случаев лучше использовать SUMIF, SUMPRODUCT или формулы обработки массивов. Но иногда их применение может дать хороший результат, например, при совместном использовании с интерфейсной возможностью «расширенный фильтр» – в обоих случаях используется одинаковое описание условий через дополнительные диапазоны.

Суммирование по нескольким критериям

Таблицы с формулами на листе SUM2 показывают вариант суммирования по нескольким критериям.

Первый вариант решения использует дополнительно подготовленный столбец обработанных исходных данных. В реальных задачах логичнее добавлять такой столбец с формулами непосредственно на лист данных.

Операция «&» используется для соединения строк. Можно также вместо этого оператора использовать функцию CONCATENATE. Промежуточный символ «;» (или любой другой служебный символ) необходим для обеспечения уникальности сцепленных строковых значений.

Пример: Есть, если два поля с перечнем слов. Пары слов «СТОЛ»-«ОСЬ» и «СТО»-«ЛОСЬ» дают одинаковый ключ «СТОЛОСЬ». Что соответственно даст неверный результат при консолидации данных. При использовании служебного символа комбинации ключей будут уникальны «СТОЛ;ОСЬ» и «СТО;ЛОСЬ», что обеспечит корректность вычислений.

Использовать подобную методику создания уникального ключа можно не только для строковых, но и для числовых целочисленных полей.

Второй пример – это популярный вариант использования функции SUMPRODUCT с проверкой условий в виде логического выражения:

Обрабатываются все ячейки диапазона (data!$M$2:$M$3000), но для тех ячеек, где условия не выполняются, в суммирование попадает нулевое значение (логическая константа FALSE приводится к числу «0»). Такое использование этой функции близко по смыслу к формулам обработки массива, но не требует ввода через Ctrl+Shift+Enter.

Третий пример аналогичен, описанному использованию функций DSUM для листа SUM, но в нем для диапазона условий использовано несколько полей.

Четвертый пример – это использование функций обработки массивов.

Обработка массивов является самым гибким вариантом проверки условий. Но имеет очень сложную запись, трудно воспринимается пользователем и работает медленнее стандартных функций.

Пятый пример содержится только в файле формата Excel 2007 (xlsx). Он показывает возможности новой стандартной функции

Поиск по одному критерию

Таблицы с формулами на листе SEARCH предназначены для поиска по ключевому полю с выборкой другого поля в качестве результата.

Первый вариант – это использование популярной функции VLOOKUP.

Во втором вариант использовать VLOOKUP нельзя, так как результирующее поле находится слева от искомого. В данном случае используется сочетание функций MATCH+OFFSET.

Первая функция ищет нужную строку, вторая возвращает нужное значение через вычисляемую адресацию.

Поиск по нескольким критериям

Таблицы с формулами на листе SEARCH2 предназначены для поиска по нескольким ключевым полям.

В первом варианте используется техника использования служебного столбца, описанная в примере к листу SUM2:

Второй вариант работы сложнее. Используется обработка массива, который образуется при помощи функций вычисляемой адресации:

Четвертый и пятый параметр в функции OFFSET используется для образования массива и определяет его размерность в строках и столбцах.

Выборка по одному критерию

Таблица на листе SELECT показывает вариант фильтрации данных через формулы.

Предварительно определяется количество строк в выборке:

Служебный столбец содержит формулы для определения номеров строк для фильтра. Первая строка ищется через простую функцию:

Вторая и последующие строки ищутся в вычисляемом диапазоне с отступом от предыдущей найденной строки:

Результат выдается через функцию вычисляемой адресации:

Вместо функции проверки наличия ошибки ISNA можно сравнивать текущую строку с максимальным количеством, так как это сделано в столбце A.

Для организации выборок при помощи формул необходимо знать максимально возможное количество строк в фильтре, чтобы создать в них формулы.

Выборка вариантов

Самый сложный вариант выборки по ключевому полю представлен на листе SELECT2. Формулы сами определяют все доступные ключевые значения второго критерия.

Первый служебный столбец содержит сцепленные строки ключевых полей. Второй столбец проверяет соответствие первому ключу и оставляет значение второго ключевого поля:

Третий служебный столбец проверяет значение второго ключа на уникальность:

Результирующий столбец второго ключа ProductName ищет уникальные значения в служебном столбце C:

Столбец Quantity просто суммирует данные по двум критериям, используя технику, описанную на листе SUM2.

Заключение

Использование функций рабочего листа для консолидации и выборки данных является эффективным методом построения отчетов с обновляемым источником исходных данных. Недостатками этого метода являются повышенные требования к пользователю в части создания сложных формул, а также низкая производительность в сравнении, например, со сводными таблицами. Последний недостаток зависит от объема исходных данных, сложности формул консолидации и технических возможностей компьютера. В критических случаях рекомендуется использовать ручной режим пересчета формул рабочей книги Excel.

Читайте также: