Mpio windows server 2019 настройка

Обновлено: 04.07.2024

Мы продолжаем цикл публикаций из серии How To для пользователей СХД Qsan. В данной статье пойдет речь о подключении СХД к серверам на базе Windows Server, в том числе при использовании функционала виртуализации Hyper-V.

В статье мы будем рассматривать подключения СХД Qsan с использованием блочных протоколов доступа iSCSI и Fibre Channel. Сам процесс подключения можно разделить на несколько основных этапов:

- Физическая и логическая коммутация

- Действия на стороне СХД

- Действия на стороне хоста(ов)

В статье приведены скриншоты настройки операционной системы Windows Server 2016/2019 с нелокализованным интерфейсом. Часть описания, не относящаяся напрямую к ОС, взята из нашего предыдущего обзора по настройке ESXi.

Физическая и логическая коммутация

Совокупность оборудования и линий связи между СХД и серверами образуют так называемую SAN сеть. Отказоустойчивое подключение участников SAN сети подразумевает постоянное наличие хотя бы одного пути между инициатором (хост) и таргетом (СХД). Т.к. СХД сейчас практически поголовно имеют минимум два контроллера, каждый сервер должен иметь связь с каждым из них. В простейшем варианте серверы подключаются к СХД напрямую. Такой режим работы называют Direct Attach. СХД Qsan поддерживают такой режим работы. В этом случае каждый сервер должен иметь двухпортовую HBA для соединения с каждым контроллером СХД. Т.е. между сервером и СХД будет 2 пути. При наличии максимального количества опциональных портов в таком режиме к СХД можно подключить до 10 серверов через iSCSI или до 8 серверов через Fibre Channel.

В большинстве случаев серверы соединяются с СХД через коммутаторы. Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

- Фабрики между собой не соединяются для изоляции в случае возникновения ошибок в сети;

- Если протокол iSCSI делит использование коммутаторов с другими сервисами, то весь трафик iSCSI должен быть помещен в изолированный VLAN;

- Для протокола Fibre Channel необходимо настроить в коммутаторах зонирование по принципу «один инициатор – один или несколько таргетов» для исключения влияния серверов друг на друга;

- Для iSCSI соединений со скоростью 10G и выше рекомендуется включить поддержку кадров большого размера (MTU=9000) с целью увеличения производительности. Важно помнить, что необходимо изменить MTU у всех участников сети: порты контроллера СХД, физические коммутаторы, физические и виртуальные порты сетевых карт серверов.

Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

В Windows Server параметр MTU меняется в настройках драйвера адаптера:

Control Panel\Network and Internet\Network Connections → Свойства конкретного адаптера → Configure → Advanced → Jumbo Packet (у некоторых адаптеров этот пункт может называться что-то типа Large Packets)

Для получения инструкций по изменению MTU у физических коммутаторов рекомендуем обратиться к документации конкретного производителя.

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

- Необходимо выбрать тип пула: thick (место выделяется сразу) или thin (место выделяется по мере заполнения). Отметим, что thick пулы являются более производительными.

- Выбрать конкретные диски

- Уровень RAID

- Указать параметры физических накопителей, влияющие на их производительность.

Рекомендуется использовать установки по умолчанию для максимальной скорости:- Enable Disk Write Cache

- Enable Disk Read-ahead

- Enable Disk Command Queuing

- Disable Disk Standby

![]()

![]()

![]()

![]()

Помимо обычных пулов Qsan поддерживает создание AutoTiering пулов при условии активации соответствующей лицензии. С принципом работы таких пулов можно ознакомиться в отдельной статье.

После создания пула(ов) необходимо создать тома (volume): Volumes → Create volumes. Также запустится пошаговый мастер создания тома.

![]()

![]()

Необходимо задать требуемый размер тома, тип тома выбирается как RAID volume. Рассмотрим их более подробно.

- Block Size – размер блока, который будет эмулироваться для хоста. Для Windows Server рекомендуется задать значение 4КБ как наиболее оптимальное.

- Background I/O Priority – приоритет фоновых задач (расширение, миграция и пр.)

- Erase Volume Data – необходимость зануления создаваемого тома. Значение Fast Erase соответствует записи нулей в первый гигабайт пространства, может быть полезно при повторном использовании дисков с целью удалить остатки предыдущих данных (стереть таблицы размещения). Full Erase – запись нулей по всему объему, полезно для достижения максимальной производительности в случае использования RAID 1/10.

- Enable Cache Mode (Write-back Cache) – включение кэша СХД. Очень сильно влияет на производительность.

- Enable Video Editing Mode – снижение производительности ради более стабильных результатов. Если не предполагается использование тома в системах видеонаблюдения, лучше выключить данный параметр.

- Enable Read-ahead – включение упреждающего чтения. Положительно влияет на производительность.

- Enable Fast RAID Rebuild – при активации данной настройки система будет вести трекинг всех записываемых блоков, чтобы понимать, сколько реальных данных записано на том. В случае выхода из строя диска в составе RAID группы во время ребилда не будут копироваться пустые блоки, что может ускорить данный процесс. Однако стоит помнить, что использование Fast Rebuild снижает производительность при случайном доступе.

Заключительным этапом в настройке СХД является публикация томов для доступа к ним со стороны хостов через функционал LUN mapping → Map LUN.

![]()

![]()

- Необходимо выбрать протокол доступа: FCP (Fibre Channel) или iSCSI. Доступ к одному и тому же тому может быть только через один протокол.

- Allowed Host – список хостов, которым разрешен доступ к тому. По умолчанию разрешено всем (*). Однако рекомендуется всегда явно указывать разрешения для исключения конфликтов доступа и, соответственно, повреждения файловой системы. Для Fibre Channel указываются WWPN хостов (с возможностью выбора из всех доступных в SAN сети). Для iSCSI указываются IQN хостов. В случае нескольких хостов они добавляются по кнопке Add Host. Со стороны Windows значения WWPN и IQN можно узнать через консольную (PowerShell) команду Get-InitiatorPort

![]()

- LUN – ID с которым том будет виден хостам. Также по этому идентификатору легко опознать том со стороны сервера. В случае использования Windows Cluster для корректной работы LUN ID должен быть одинаковым для одного и того же тома для всех узлов кластера.

Действия на стороне хоста

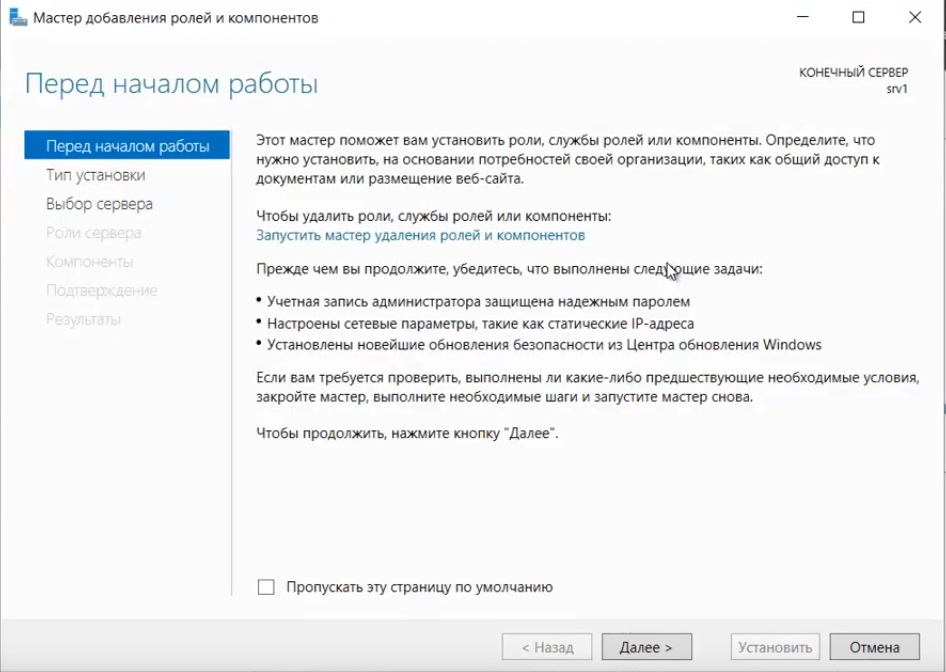

Первоначально необходимо один раз установить на сервере компонент Multipath IO, который обеспечивает работу многопутевого ввода/вывода. Данное действие производится через стандартный диалог Add Roles and Features

![]()

При использовании протокола iSCSI необходимо выполнить:

- В свойствах Software iSCSI Initiator необходимо указать адреса таргетов, т.е. СХД на вкладке Discovery должны быть введены все используемые IP адреса контроллеров СХД

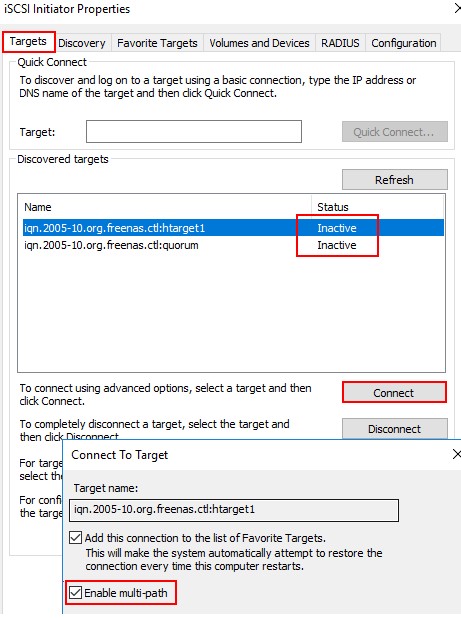

- После обнаружение таргетов к ним необходимо подключиться при помощи кнопки Connect. Отметим важные детали:

- Необходимо добавить подключаемые таргеты в список Избранных, чтобы в случае разрыва соединения происходило автоматическое переподключение

- Необходимо включить поддержку MPIO

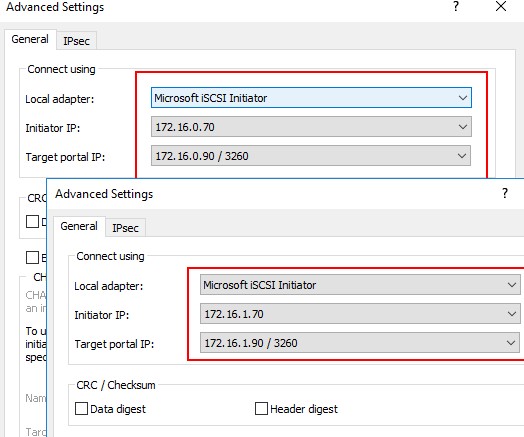

- Хотя автоматическое определение маршрутизации в большинстве случаев работает корректно, мы все же рекомендуем не пренебрегать явным указанием с какого сетевого интерфейса сервера необходимо подключаться к конкретному таргету (Advanced Settings)

- Если через один и тот же сетевой интерфейс сервера производится работа с нескольким портами СХД, то подключение через Connect нужно проделать для каждого пути

![]()

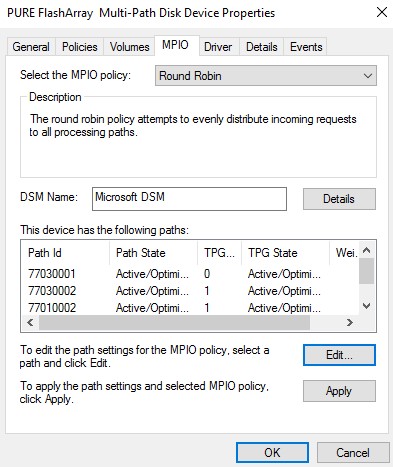

- После любого изменения параметров СХД и SAN сети необходимо выполнить Rescan в стандартной оснастке управления дисками или в Device Manager. Итогом будет появление (т.к. мы добавляем новый том) нового устройства, доступного в нашем конкретном примере по 4 путям (согласно топологии подключения через два коммутатора в Discovery указано 4 IP адреса портов СХД) с LUN как мы и задавали при публикации на СХД. Также следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

![]()

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN доступный по 4 путям. Как и в случае с iSCSI следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

![]()

Важное замечание касательно конфигурирования MPIO. По умолчанию Windows видит дисковые устройства по отдельности, т.е. каждый путь к устройству – это отдельный диск.

![]()

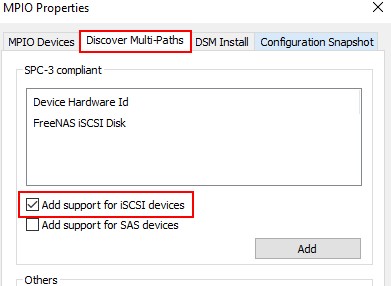

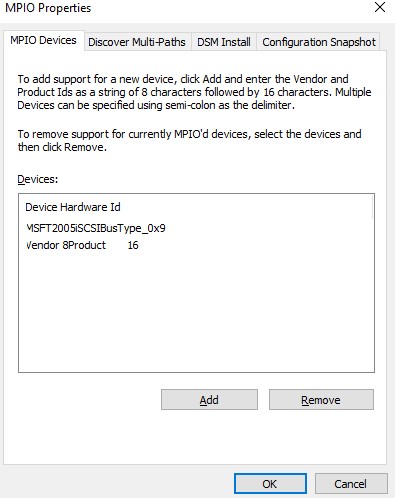

Чтобы ОС «склеила» все одинаковые диски в единое устройство, необходимо в стандартной оснастке MPIO добавить новое устройство как многопутевое. Для iSCSI устройств устанавливается отдельное разрешение. По окончании настройки потребуется перезагрузить сервер. Данную настройку необходимо произвести однократно для каждой СХД. После чего все вновь презентованные диски будут опознаваться ОС как многопутевые.

![]()

В случае использования кластера из нескольких хостов Windows Server, действия, описанные выше, необходимо повторить на каждом из хостов. После чего диски, появившиеся в системе, можно добавлять в дисковые ресурсы кластера.

22.10.2021![date]()

Windows Server 2012 R2, Windows Server 2016![directory]()

комментариев 5 Если сервер может получить доступ к логическому диску (LUN) через несколько адаптеров инициатора iSCSI или несколько портов Fibre Channel, то в диспетчере устройств/дисков на системе без установленного MPIO модуля будет присутствовать большее количество LUN, чем презентовано на самом деле ( = количество путей к LUN * количество презентованных LUN).![comments]()

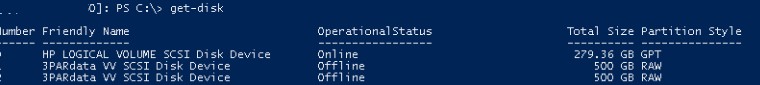

На следующем скриншоте видно (список подключенных дисков можно вывести с помощью get-disk), что Windows видит без MPIO видит 2 диска по разным путям, которые по факту являются одним LUN:

![windows server видит дубли LUN дисков при подключении без mpio]()

Если ОС поддерживает MPIO, она будет видеть каждый из презентованных ей дисков в одном экземпляре. При включенном MPIO сервер может обращаться к данным на СХД по нескольким путям, что увеличивает скорость доступа к подключенному LUN и позволяет задействовать для доступа несколько сетевых или HBA-адаптеров.

Совет. Если ОС не поддерживает MPIO, то для предотвращения потери данных нужно уменьшить количество путей к LUN до 1. На сервере нужно оставить включенным только один порт Fiber Channel или адаптер iSCSI инициатора. Также нужно отключить дополнительные пути для данного LUN на уровне СХД и коммутаторов.

MPIO может задействовать альтернативный логический путь при выходе из строя одного/нескольких компонентов, заставив операционную систему использовать для доступа к логическому диску (LUN) резервный маршрут, сохраняя непрерывность доступа к данным. Таким образом MPIO является важным компонентом при реализации отказоустойчивой системы доступа к данным, кроме того входящие в состав MPIO модули позволяют распределять нагрузку между различными путями к одному и тому же LUN-у.Установка MPIO в Windows Server 2016/2012R2

Windows Server поддерживает многопутевой ввод-вывода MPIO начиная с версии Windows Server 2008 R2. Технология Microsoft MPIO позволяет обеспечить высокую доступность и балансировку нагрузки посредством возможности организации нескольких подключений к СХД, не зависит от протоколов и поддерживает подключение дисковых массивов и хранилищ по iSCSI, Fiber Channel и хранилищ SAS.

MPIO-модуль в Windows Server по умолчанию не включен. Установить его в Windows Server 2016 можно двумя способами:

- Из графического интерфейса с использованием консоли Server Manager

- Из командной строки Powershell

Установка MPIO с помощью консоли Server Manager

Установка MPIO с помощью Powershell

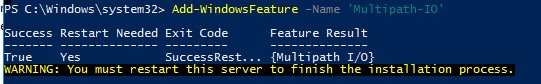

Запустите консоль PowerShell с правами администратора и для установки компонента выполните команду:

Add-WindowsFeature -Name 'Multipath-IO'

![Add-WindowsFeature Multipath-IO powershell]()

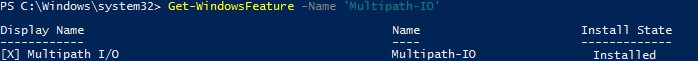

Чтобы убедиться, что модуль MPIO установлен в вашем Windows Server, выполните:

Get-WindowsFeature -Name 'Multipath-IO'

![powershell проверить наличие модуля Multipath-IO]()

Remove-WindowsFeature -Name 'Multipath-IO'

Настройка MPIO в Windows Server 2016

После установки MPIO модуля, необходимо активировать его для LUN, которые доступны по нескольким путям. По умолчанию ОС видит каждое подключение к диску как разные логические диски (LUN).

Совет. Одним из компонентов MPIO является специальный модуль MSDSM (Microsoft Device Service Module), позволяющий управлять политиками балансировки нагрузки. По умолчанию MPIO устанавливается со стандартным Microsoft DSM, однако в большинстве случаев стоит установить DSM модуль, предоставляемый производителем СХД (IBM DSM, HP DSM MPIO и т.д.). Обычно скорость работы и функционал нативного DSM модуля выше, чем у стандартного DSM-модуля Microsoft (производитель пишет свои DSM модули с учетом специфики работы и особенностей своего железа)/Разрешите модулю DSM от Microsoft (MSDSM) автоматически объединять SAN диски в зависимости от типа подключений. MSDSM автоматически определяет наличие LUN, имеющих несколько путей к СХД и поддерживает большинство популярных систем хранения.

Сделать это можно из командной строки:

- Для SAS дисков: Enable-MSDSMAutomaticClaim -BusType SAS

- Для iSCSI дисков: Enable-MSDSMAutomaticClaim -BusType iSCSI

mpclaim.exe -r -i -a ""

Также вы можете включить DSM через графический интерфейс. Откройте консоль управления Server Manager и в меню Tools выберите пункт MPIO (или выполните команду mpiocpl).

![mpio windows server - включить поддержку iscsi]()

После перезагрузки откройте диспетчер устройств или диспетчер дисков и убедитесь, что количество подключенных дисков (LUN), доступных серверу уменьшилось в 2 раза (при наличии подключений к СХД по двум путям).

Вы можете управлять списком устройств, для которых включена поддержка MPIO на вкладке MPIO Devices (или командой Get-MSDSMSupportedHw ).

![доступные mpio устройства]()

Вы можете добавить новые MPIO устройства, нажав кнопку Add или из PowerShell:

New-MSDSMSupportedHw -VendorId <vend> -ProductId <product>

При настройке кластера конфигурацию MPIO необходимо выполнить на всех узлах.![включить поддержку mpio для iscsi LUN в Windows Server]()

Затем нажмите на кнопку Advanced и привяжите разные IP адреса инициатора к разным IP адресами target.

![привязка IP адресов iscsi target к iniciator]()

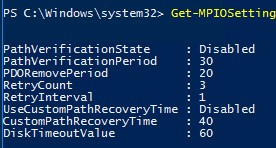

С помощью PowerShell можно получить текущие настройки MPIO:

![Get-MPIOSetting]()

Можно изменить настройки MPIO таймеров так (например, установим рекомендованные настройки для flash массива):

Set-MPIOSetting -NewPathRecoveryInterval 20 -CustomPathRecovery Enabled -NewPDORemovePeriod 30 -NewDiskTimeout 60 -NewPathVerificationState Enabled

Доступны следующие политики балансировки MPIO:

Чтобы задать политику балансировки (например, Round Robin):

Set-MSDSMGlobalLoadBalancePolicy -Policy RR

Также политику балансировки можно изменить в свойствах подключенного LUN на вкладке MPIO. В этом примере для массива выбрана политика Round Robin.

![настройка mpio балансировки для lun в свойствах диска]()

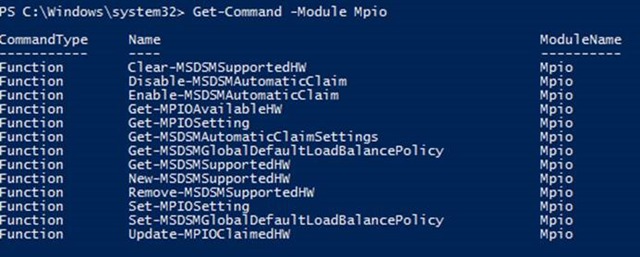

Чтобы увидеть полный список PowerShell команд, доступных в модуле MPIO, выполните команду:

Get-Command –Module Mpio

![Список posh команд для mpio модуля]()

SAN Policy

В Windows имеется специальная политика дисков (SAN Policy), которая определяет, нужно ли автоматически монтировать диски при их подключении к хосту.

Текущую настройку SAN Policy можно получить с помощью diskpart. По умолчанию используется SAN политика Offline Shared.

Именно из-за этой политики SAN внешние диски, подключенные с СХД, могут при перезагрузке находиться в offline режиме. См. статью “Диск отключен в соответствии с установленной администратором политикой”.Чтобы автоматически монтировать диски, нужно изменить значение SAN Policy на OnlineAll.

После установки Windows Server 2019 и перед сдачей сервера клиенту вы, как хороший системный администратор, должны выполнить первоначальную настройку сервера. Во-первых, это избавит вас от возможных претензий и при этом не займёт много времени. Во-вторых, покажет вас с лучшей стороны. В третьих, другой сисадмин, который будет настраивать сервер после вас, не будет ругаться и стонать.

Итак, ОС установлена, что дальше?

Настройка сети и Интернет

Сначала настраиваем сеть. Убедитесь что драйвера сетевой карты корректно настроены. Если драйвера не настроены, то нужно их установить.

Например, при установке Windows Server 2019 на виртуальную машину VMware с сетевой картой VMXNET3, драйвера устанавливаются вместе с VMware Tools.

![win]()

VMware Tools устанавливаются просто, подробно останавливаться на этом не будем.

![win]()

Если в сети доступен DHCP сервер и есть доступ к интернету, то сеть автоматически заработает и появится Интернет, это видно по значку.

![win]()

По умолчанию сеть настроена на получение IP адреса по DHCP. Обычно принято назначать серверам статические IP адреса. Выясните у клиента настройки для сети сервера и настройте IPv4 в свойствах сетевого адаптера.

![win]()

Если в компании нет DNS сервера и провайдер не указал свои адреса, то можно использовать публичные DNS сервера, такие как:

Если в компании явно не требуется протокол IPv6, то лучше его отключить.

![win]()

Сеть настроена, Интернет есть. Можно для уверенности выполнить ping любого сайта в Интернет.

![win]()

Настройка драйверов

Диспетчер устройств покажет вам, есть ли неизвестные устройства.

![win]()

При установке на виртуальную машину обычно проблем с драйверами не много, но если вы устанавливаете Windows Server 2019 на железный сервер, то картина может быть такой:

![win]()

В этом случае драйвера можно найти на сайтах производителей серверов. Например, драйвера для серверов HPE можно установить из Service Pack for ProLiant:

В крайнем случае можно найти в Интернете сборник драйверов и воспользоваться им, но я таким обычно не занимаюсь.

Установка обновлений

Устанавливать обновления нужно. Если вы скачали самый свежий образ Windows Server 2019, то и в этом случае найдётся парочка обновлений.

![win]()

Процесс обновления может затянуться, иногда я оставляю эту операцию на ночь.

![win]()

Активация Windows

Активируйте Windows, если у вас есть ключ. Даже если у вас ознакомительная версия и Windows активируется сам, то проверьте доступность Интернет. В ином случае без активации через 10 дней сервер начнёт выключаться каждые 30 минут.

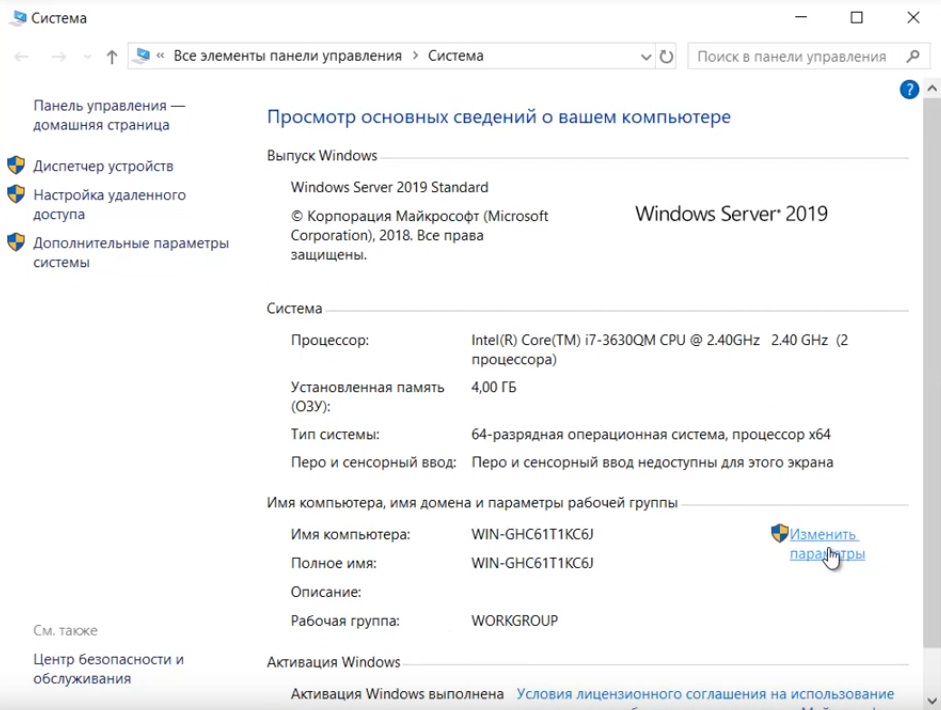

Имя сервера

Укажите имя сервера (узнайте у клиента), при необходимости введите сервер в домен, для этого потребуются права администратора домена.

![win]()

После смены имени сервера может потребоваться перезагрузка.

![win]()

Региональные настройки, время и временная зона

Настройте язык, временную зону и время. Временную зону уточните у клиента. В Windows Server 2019 эти настройки можно сделать с помощью панели управления. Единственное, теперь регион вынесен в настройки интерфейса метро: Settings > Region.

![win]()

Роль сервера и софт

В зависимости от требований установите роли сервера и необходимый софт.

![win]()

Удалённый доступ

В зависимости от необходимости настройте удалённый доступ к серверу. Это может быть RDP, VNC, виртуальная или KVM консоль.

Заключение

Драйвера установлены, сеть настроена, регион проверен, обновления есть, активация выполнена, имя задано, роли и софт присутствует, доступ есть. Сервер можно отдавать заказчику.

В этой статье мы рассмотрим базовые настройки Windows Server 2019, это AD, DNS, DHCP и лицензирование терминального сервера. Данные настройки актуальны на большинстве серверов и являются самыми необходимыми.

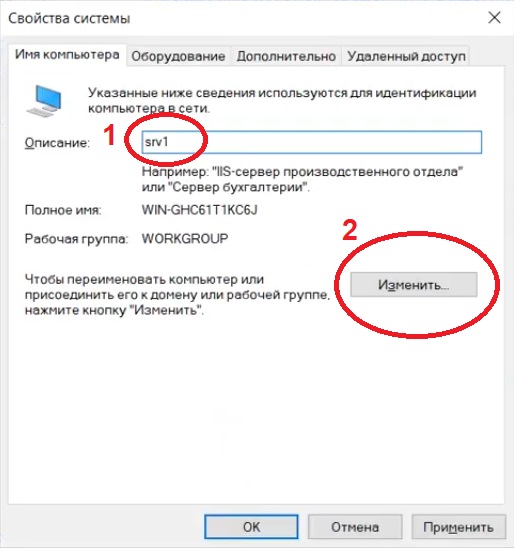

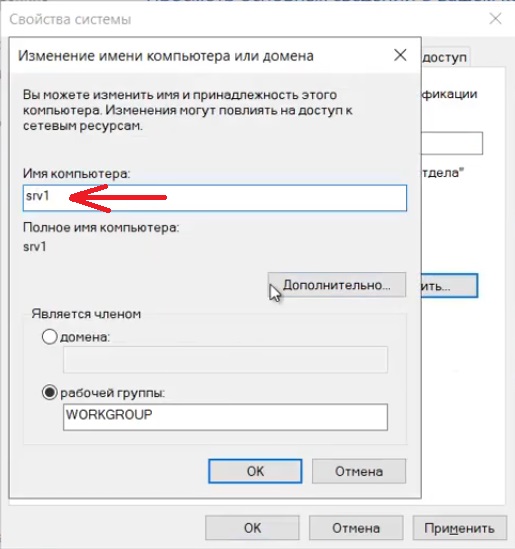

Как установить Windows Server и произвести первичные настройки по активации можете ознакомиться в нашей прошлой статье по этой ссылке.1) Меняем имя сервера и его описание (если нужно). Переходим в свойства системы => изменить параметры => изменить. Задаем «Имя компьютера», и если нужно, то имя рабочей группы. После изменения параметров нужно перезагрузиться.

![]()

![]()

![]()

![]()

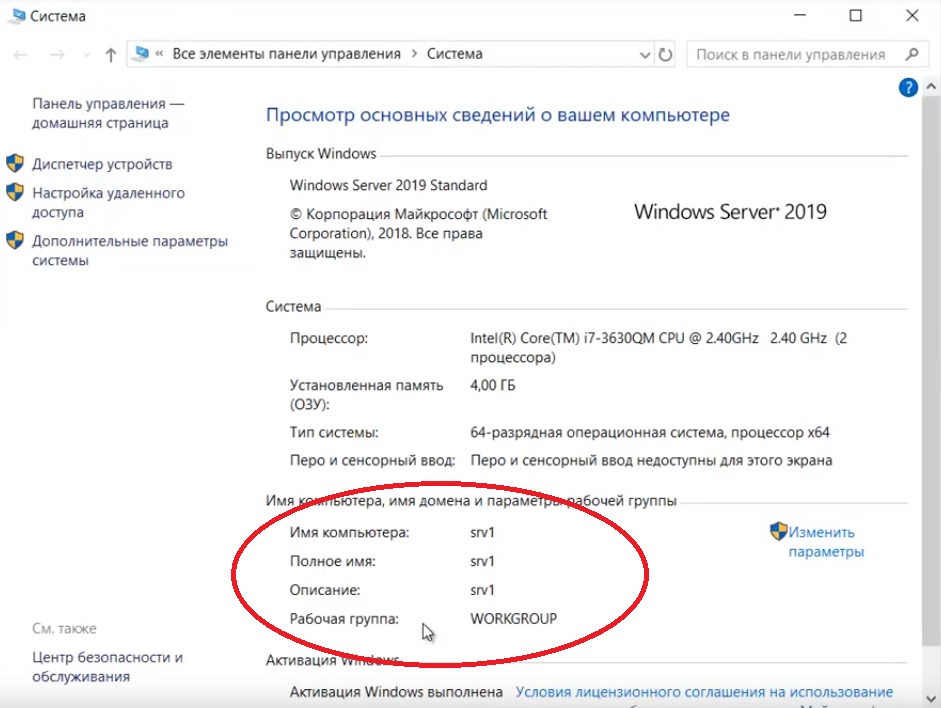

После перезагрузки можете проверить, все ли у вас прошло успешно с изменением имени.

![]()

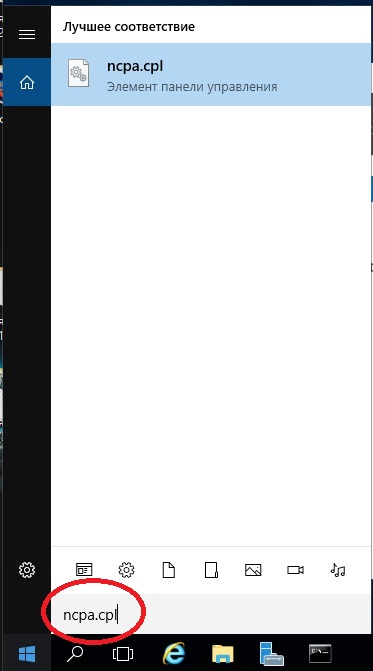

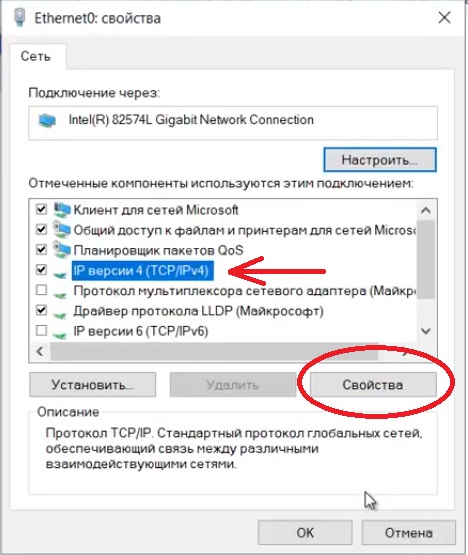

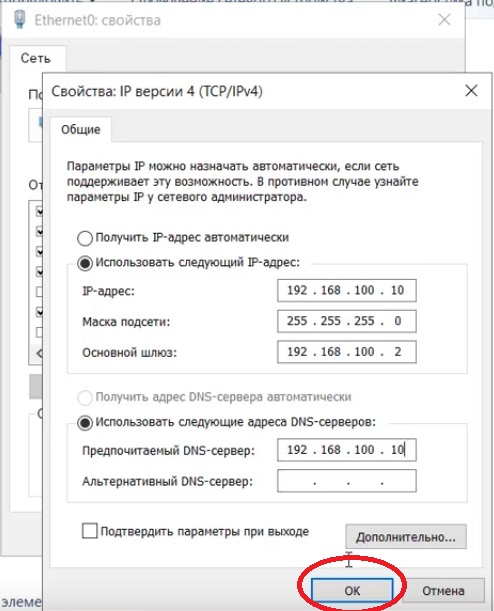

2) Далее меняем сетевые настройки, IP, маску и шлюз ставите обязательно статичными, настройки производятся в зависимости от Вашей сети.

![]()

Переходим в свойства сетевой карты.

![]()

И далее в свойства IPv4

![]()

![]()

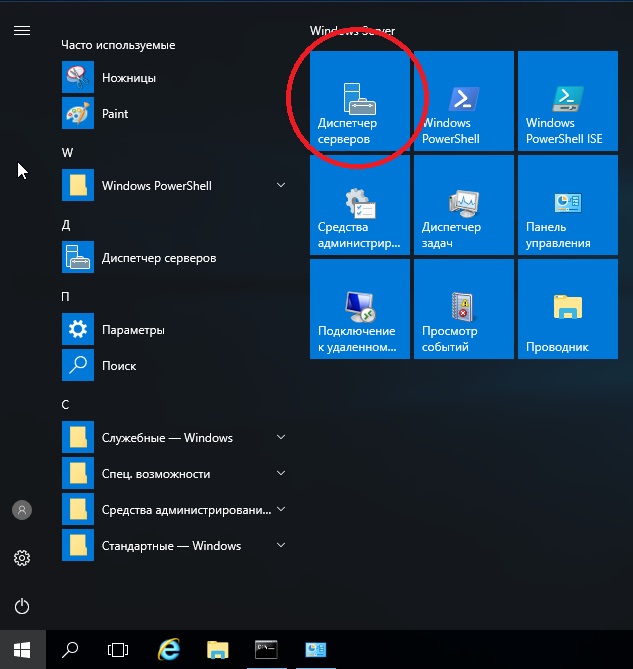

3) Следующим пунктом настраиваем Active Directory. Добавляем роли и компоненты. Для этого переходим меню «Пуск» => Диспетчер серверов.

![]()

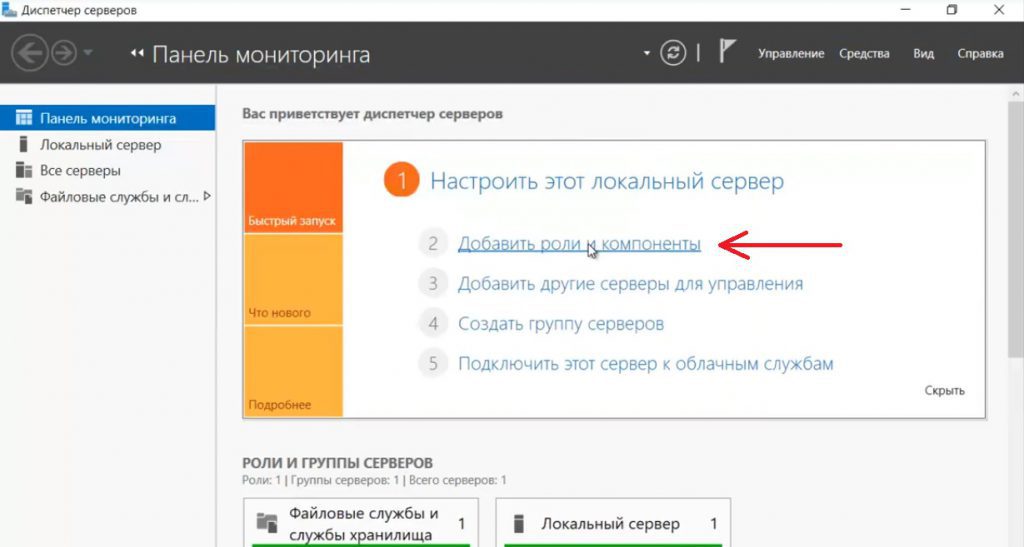

![]()

![]()

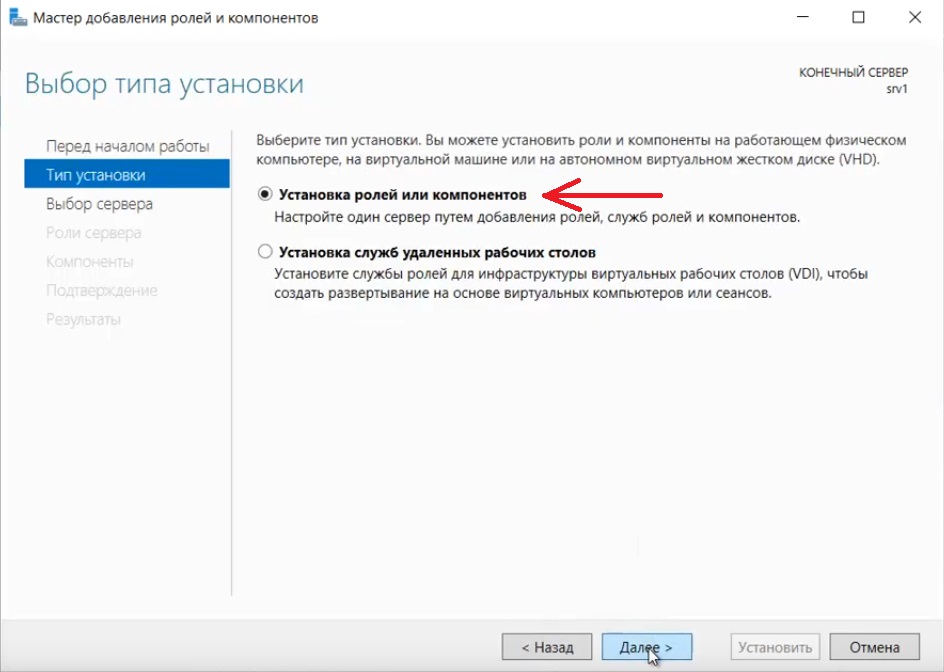

Установка "Ролей и компонентов".

![]()

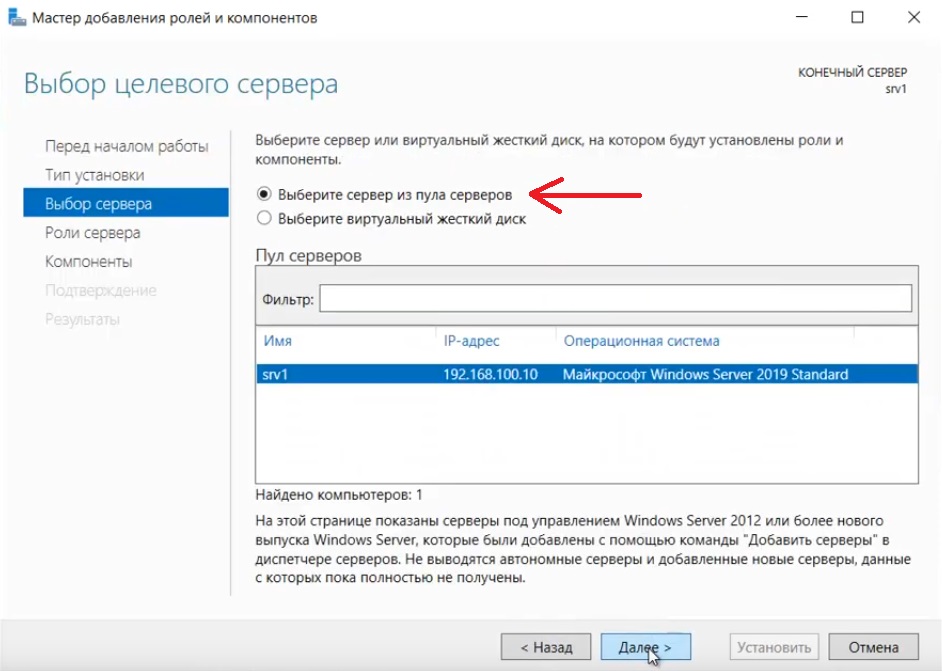

Соответственно выбираем нужный нам пул сервера.

![]()

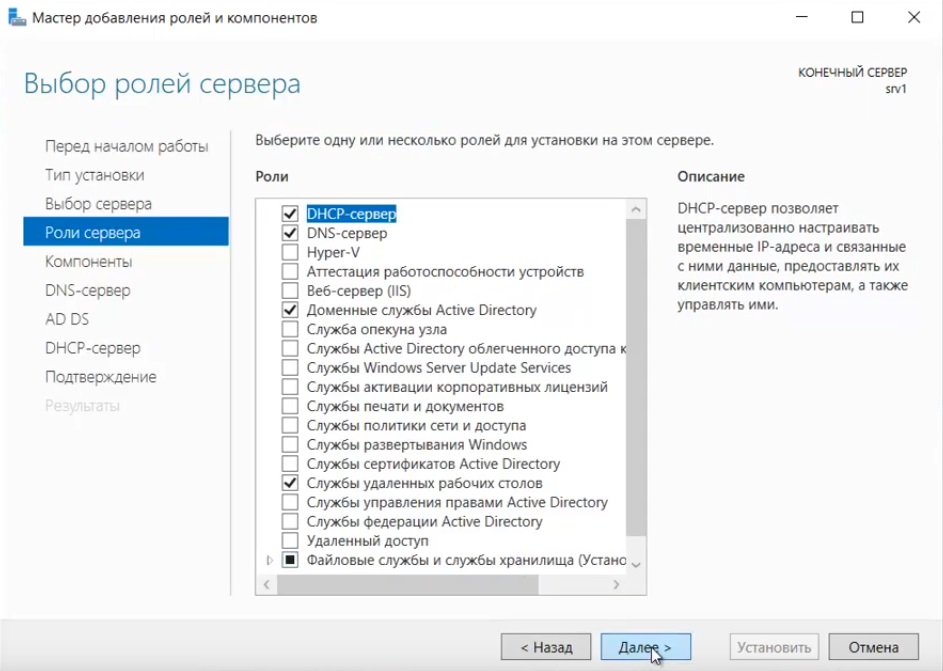

В "Роли сервера" для всех наших настроек выберем "DHCP-сервер", "DNS-сервер", "Доменные службы Active Directory" и "Службы удаленных рабочих столов".

![]()

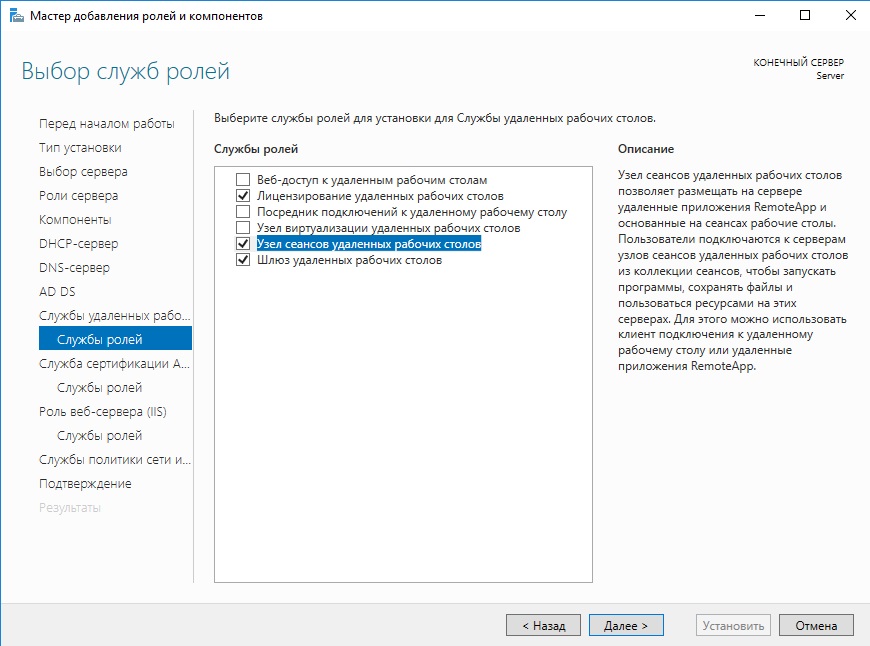

Идем далее до "Службы ролей" и выбираем пункты как на скриншоте ниже.

![]()

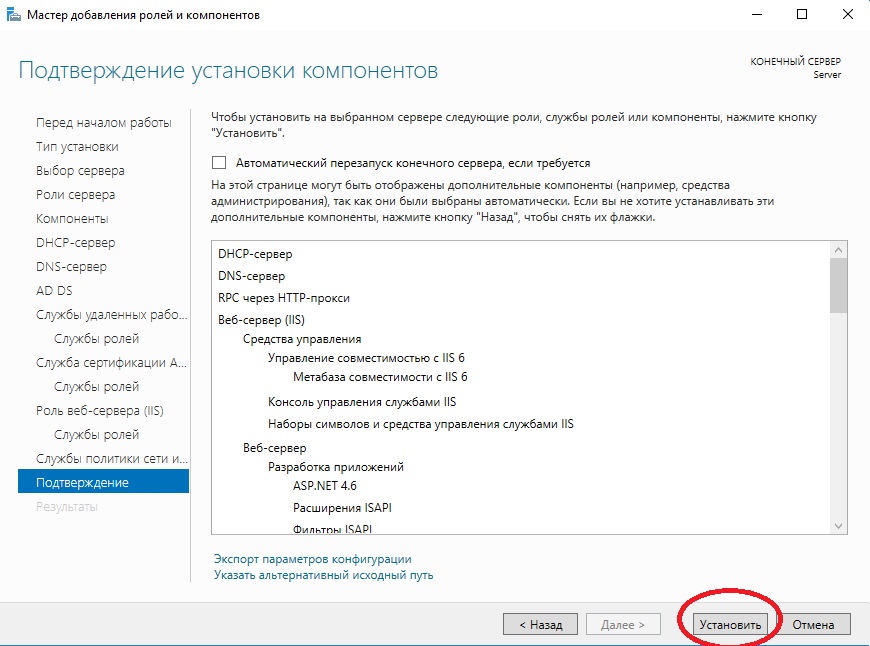

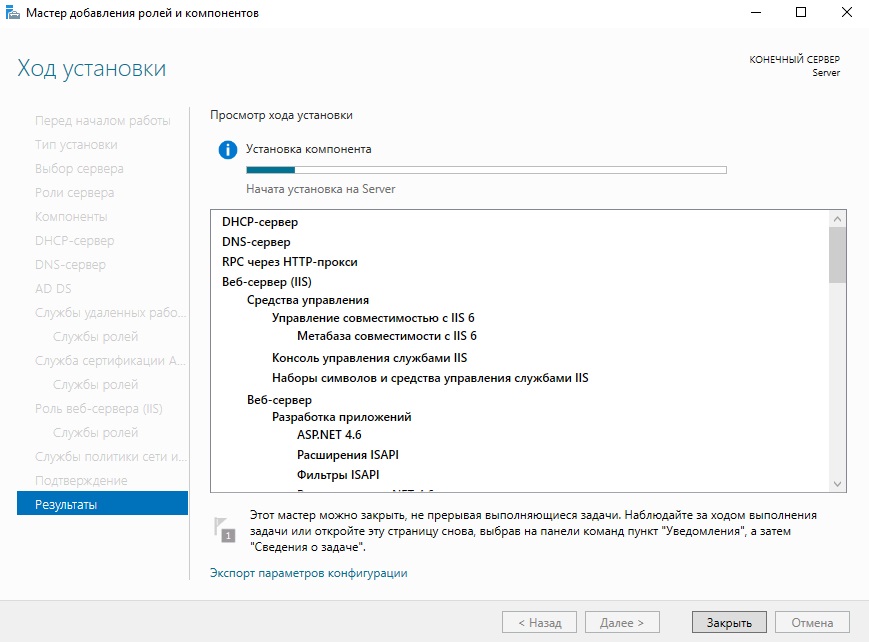

После так же идем "Далее" до пункта "Подтверждение" и устанавливаем все, что мы выбрали.

![]()

![]()

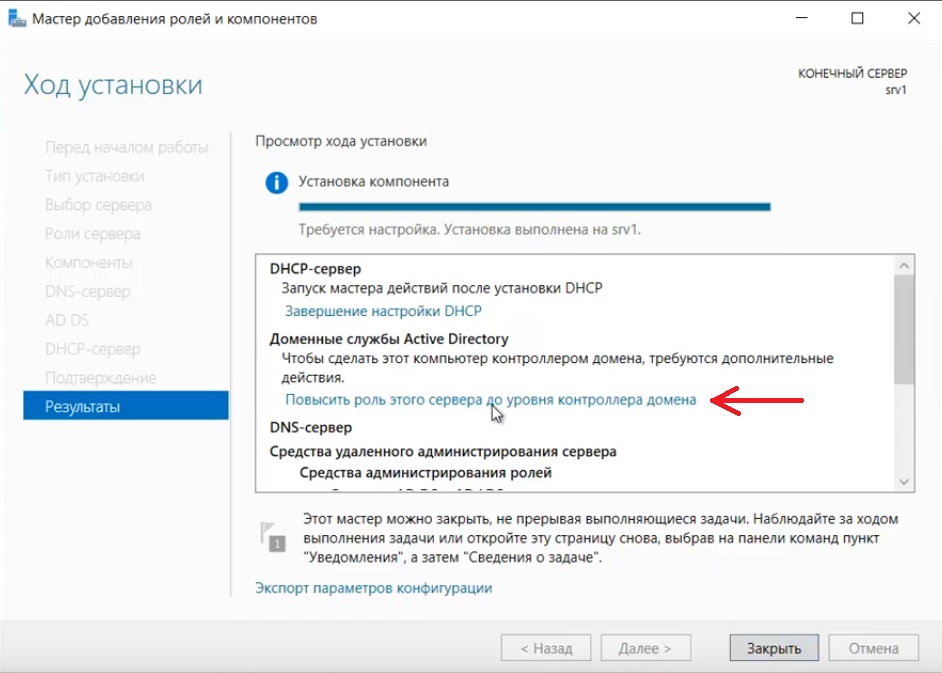

После установки в "Результатах" выбираем пункт "Повысить роль этого сервера до уровня контроллера домена".

![]()

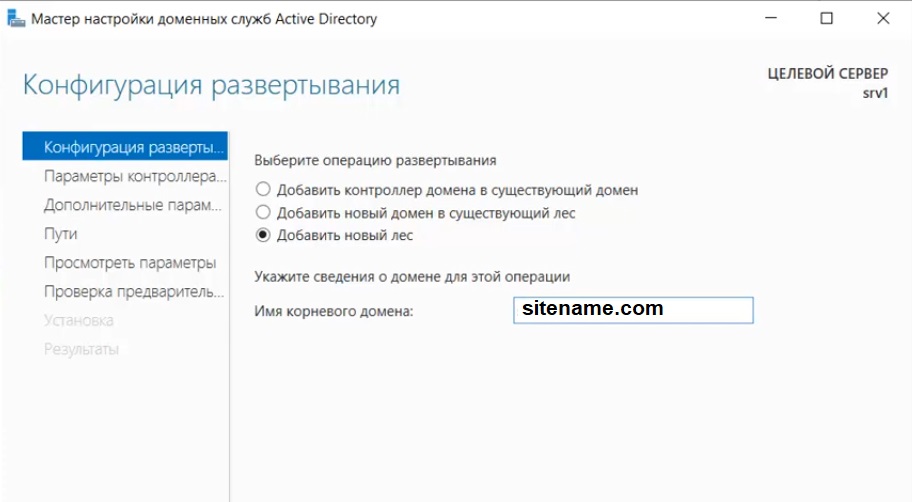

В мастере настроек доменных служб выбираем "Добавить лес" и вводим имя корневого домена, это может быть любое имя, к примеру домен вашего сайта.

![]()

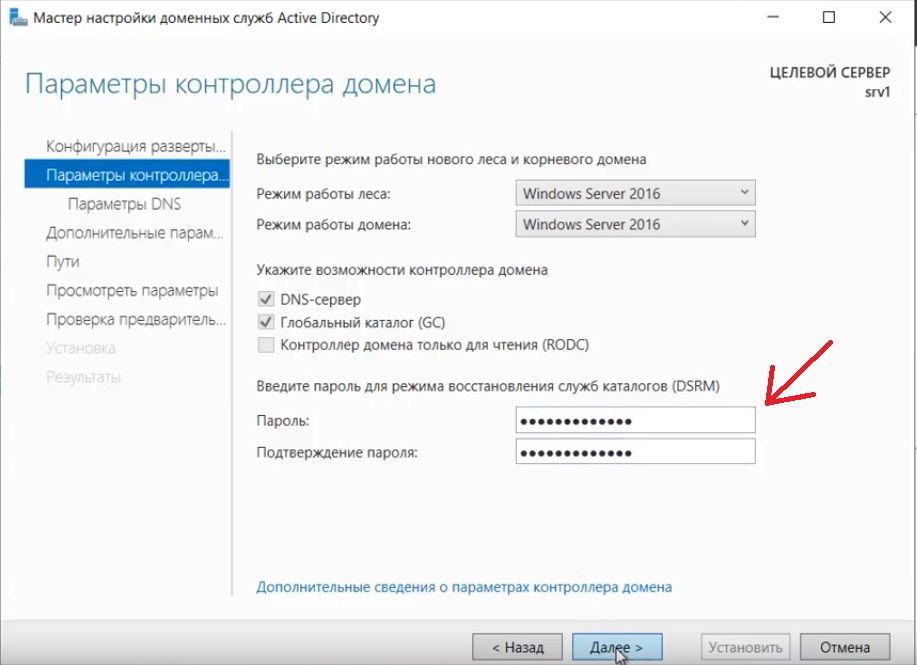

В параметрах контроллера нужно придумать пароль.

![]()

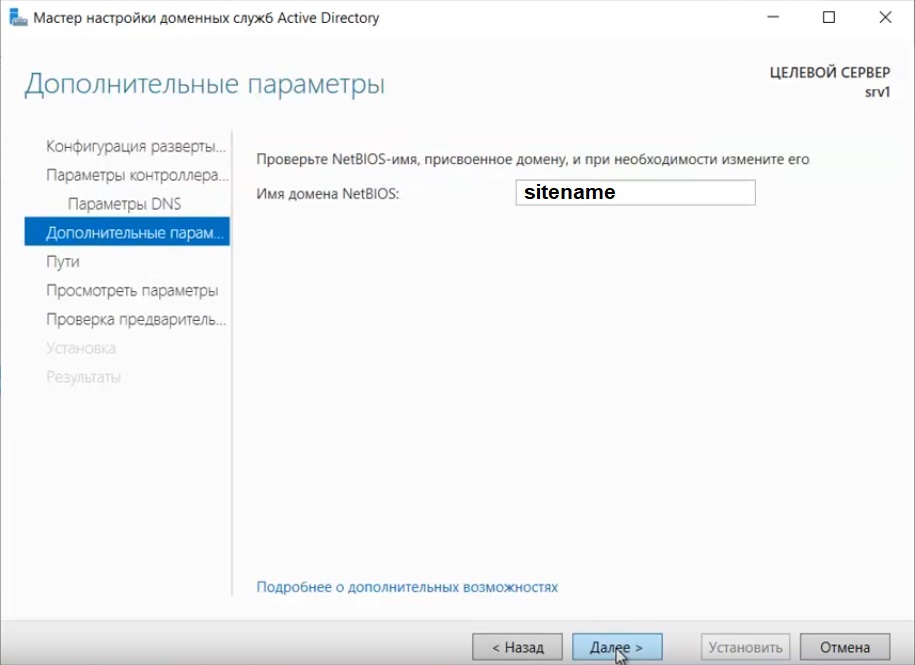

По каталогу настроек идем дальше, до дополнительных параметров, там нужно указать имя домена NetBIOS, если он у вас там уже стоит, то можете оставить как есть, либо поменять по своему желанию.

![]()

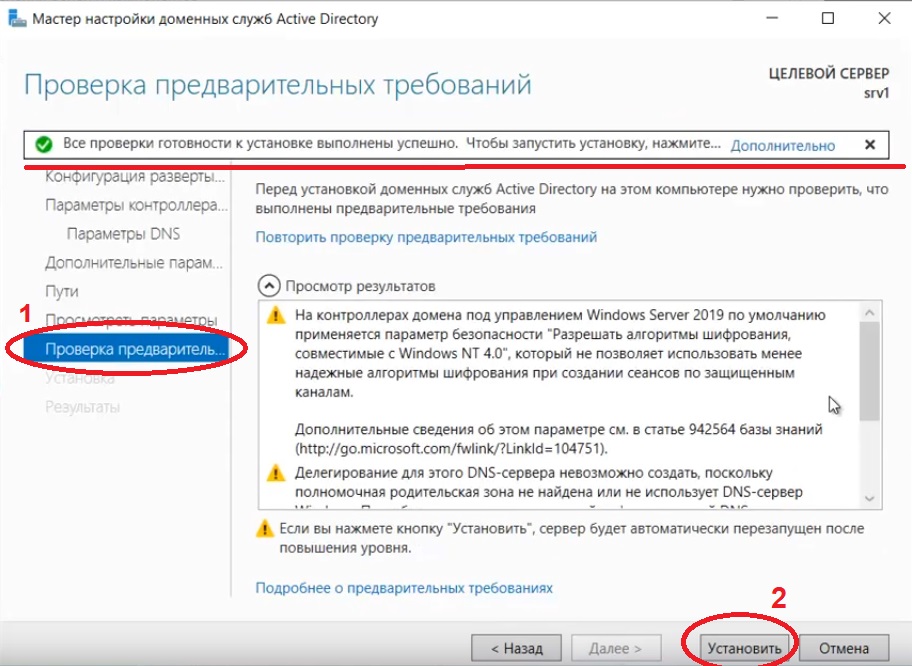

Далее идем до "Проверки предварительных требований", если проверка прошла успешно, то устанавливаем примененные настройки.

![]()

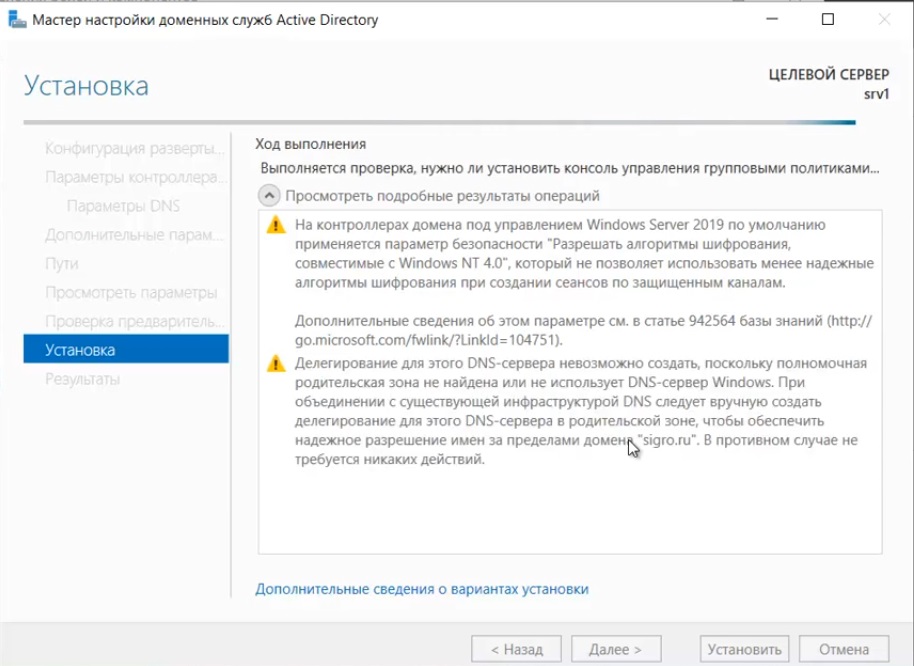

![]()

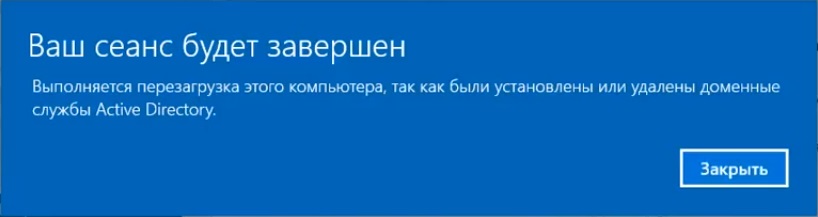

После полной установки необходимо перезагрузиться.

![]()

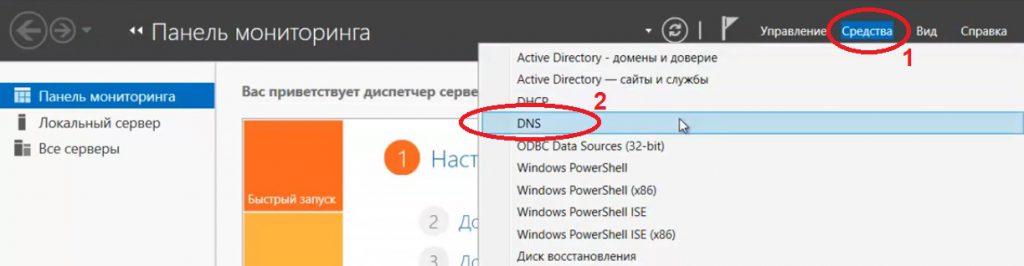

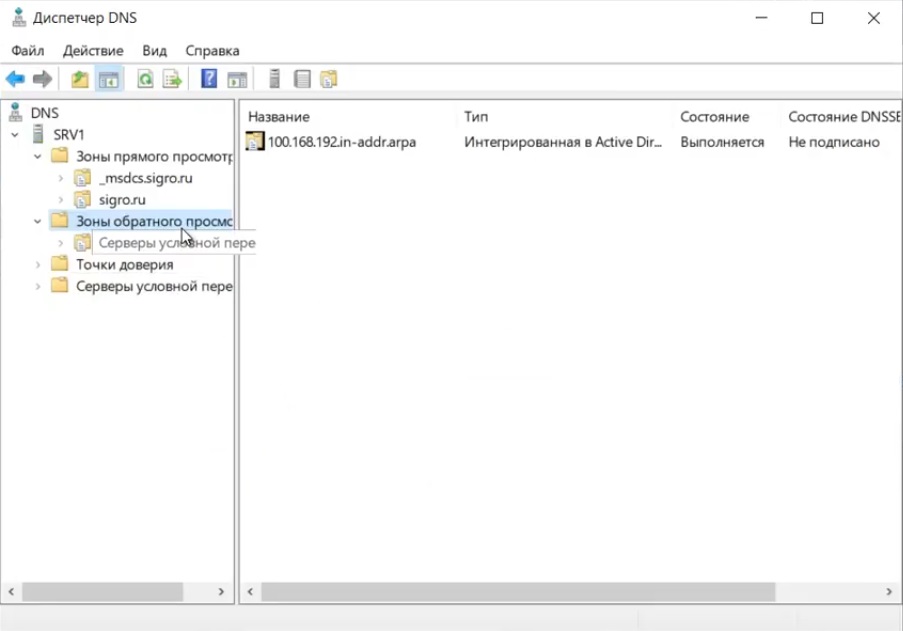

4) Производим настройку "Зона обратного просмотра".

![]()

На пункте "Зона обратного просмотра" => Создать новую зону.

![]()

Выбираем "Основную зону".

![]()

Для всех DNS-серверов, работающих на контроллерах домена в этом домене:

![]()

Зона обратного просмотра IPv4

![]()

Ну и соответственно выводим индефикатор сети.

![]()

![]()

Проверяем, что все установилось.

![]()

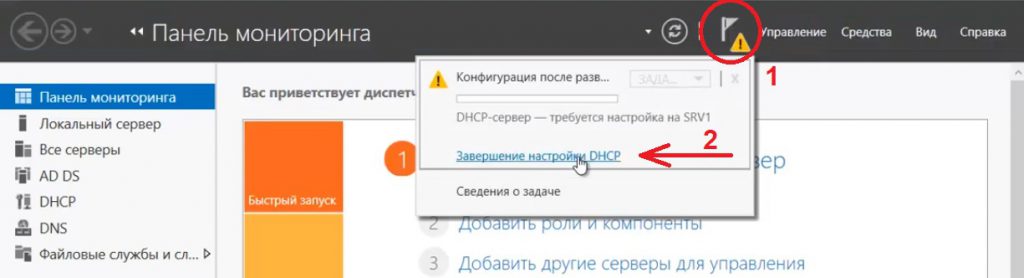

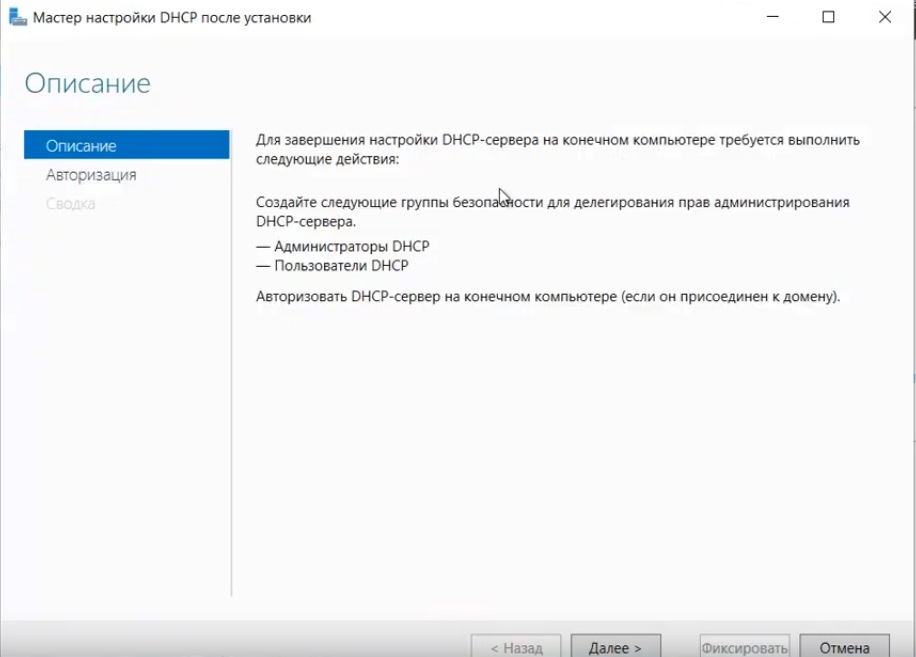

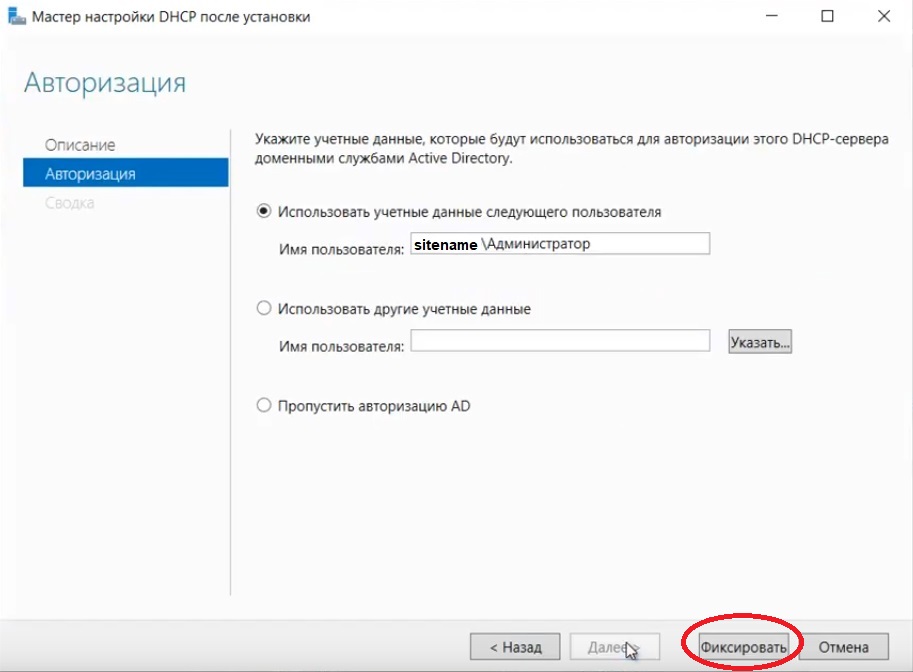

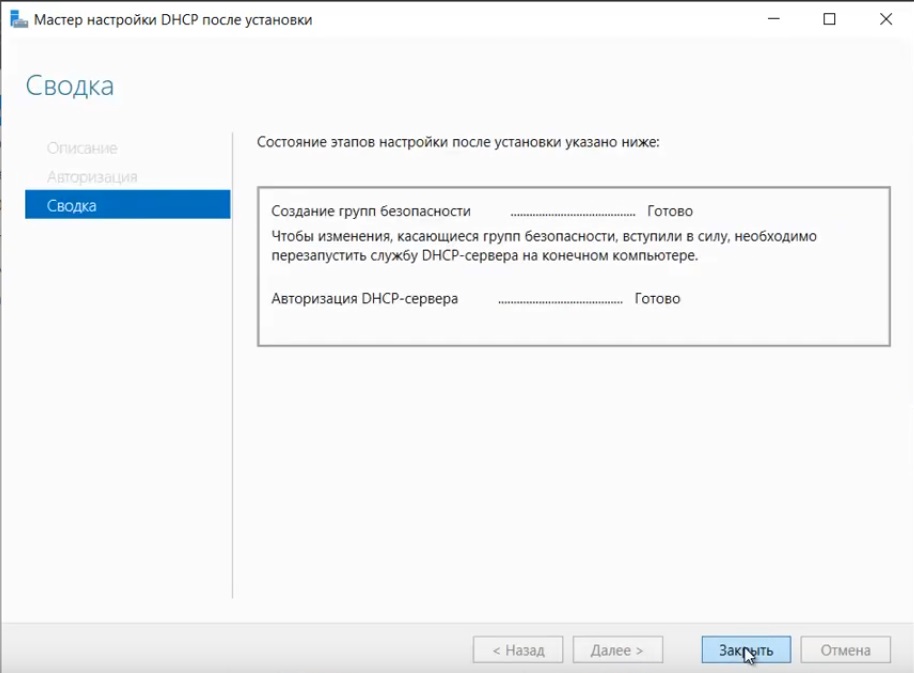

5) Переходим к настройке DHCP. Переходим в мастер установки.

![]()

![]()

![]()

![]()

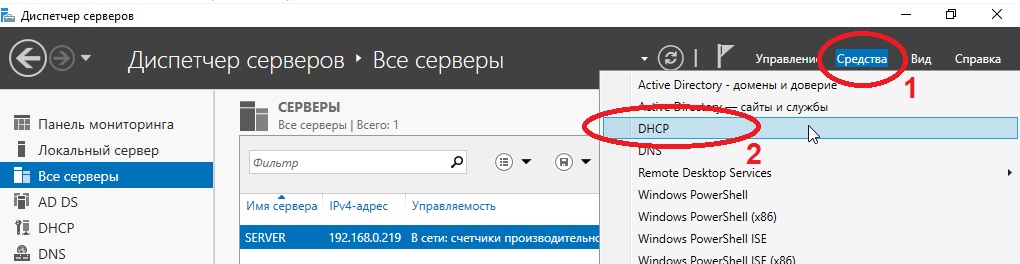

После завершения установки => Диспетчер => Средства => DHCP

![]()

На DHCP => Имя вашего сервера => IPv4 - правой кнопкой мыши => Создать область.

![]()

Задаем любое имя области DHCP.

![]()

В диапазоне адресов задаем начальный и конечный интервал области IP адресов, который будет раздавать сервер.

![]()

![]()

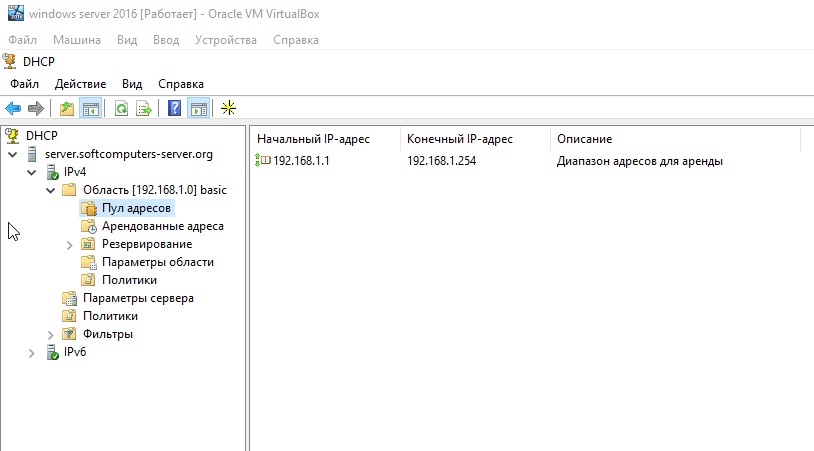

Далее в дереве каталогов DHCP => Имя сервера => Область => Пул адресов. В списке должен быть указан начальный и конечный диапазон, который Вы указывали в настройках.

![]()

6) Теперь по настройкам лицензирования удаленных рабочих столов (терминального сервера). Пошаговую инструкцию как лицензировать терминальный сервер можете прочитать в нашей ранней статье на следующей странице.

Читайте также: