Настройка lacp windows server 2019

Обновлено: 07.07.2024

- В диспетчере сервера нажмите « локальный сервер».

- В области «Свойства» перейдите на вкладку «объединение сетевых адаптеров», а затем нажмите на ссылкуНевозможносправа. Откроется диалоговое окно «Объединение сетевых адаптеров».

Нажмите « ОК».

Инструкция PowerShell *

| Примечание | Мы рекомендуем использовать Microsoft Teaming в операционных системах 2012 и выше. |

Создание команды сети с помощью PowerShell

Ознакомьтесь с статьей Microsoft TechNet , в которой описаны командлеты для объединения сетевых адаптеров (нетлбфо) в Windows PowerShell *.

- Откройте командную строку PowerShell с повышенными привилегиями. В поле поиска на панели задач Windows® 10 введите PowerShell. Нажмите клавиши W и S , чтобы открыть компонент « Поиск».

- Теперь вы должны видеть результатыWindows PowerShellв верхней области. Щелкните правой кнопкой мышиWindows PowerShellи выбратьЗапуск от имени администратора.

Предположим, что вы слышали о NIC teaming (NIC: сетевой адаптер) или NIC bonding от разных поставщиков. Они связали несколько физических NICs в виртуальный NIC, который внешне предоставил видимый MAC-адрес. Их конечная цель одна и та же - для более высокой производительности и лучшей избыточности. В этом руководстве будет рассказано о Windows NIC Teaming & Linux NIC Bonding, которые имеют балансировку нагрузки и отказоустойчивость.

Близко к NIC Teaming в ОС Windows

Что такое Windows NIC Teaming?

NIC teaming, также известное в мире Microsoft как Load Balancing/Failover (LBFO), представляет собой механизм, который позволяет объединить несколько карт физических сетевых адаптеров на одном физическом хосте/сервере и объединить их в команду в форме единый логический NIC. Сетевые адаптеры, подключенные к операционной системе Windows, отображаются в виде одного или нескольких виртуальных адаптеров (также называемых групповым NICs, tNICs или групповым интерфейсом), которые имеют один и тот же IP-адрес.

Сколько режимов Windows NIC Teaming?

На рынке представлено разные сетевые адаптеры, и Intel NIC является наиболее распространенным среди основных решений. Intel NIC можно разделить на несколько режимов teaming:

Adapter Fault Tolerance (AFT) обеспечивает автоматическое резервирование для сетевых подключений сервера. Если основной адаптер выходит из строя, резервный адаптер вступает во владение.

Требования и ограничения: подходит для любого коммутатора, все члены команды должны быть подключены к одной подсети. 2-8 сетевых адаптеров на группу.

Switch Fault Tolerance (SFT) обеспечивает аварийное переключение между двумя платами сетевого адаптера, когда каждый адаптер подключен к отдельному коммутатору.

Требования и ограничения: используйте с отдельными коммутаторами, все члены команды должны быть подключены к одной подсети. Вам необходимо включить протокол Spanning Tree Protocol (STP) при создании группы SFT. 2 сетевых адаптера на команду.

Adaptive Load Balancing (ALB) обеспечивает балансировку нагрузки и отказоустойчивость адаптера. Receive Load Balancing (RLB) может быть включена и отключена в группе ALB, которая включена по умолчанию.

Требования и ограничения: работает с любыми коммутаторами.

Virtual Machine Load Balancing (VMLB) обеспечивает балансировку нагрузки при передаче и приеме трафика между виртуальными машинами (виртуальными машинами), связанными через командные интерфейсы, и отказоустойчивость в случае сбоя порта коммутатора, кабеля или сетевой карты.

Требования и ограничения: работает с любыми коммутаторами.

Fast EtherChannel/Link Aggregation (FEC) обеспечивает отказоустойчивость адаптеров балансировки нагрузки (только для протоколов маршрутизации) и помогает увеличить пропускную способность передачи и приема.

Требования и ограничения: требуются коммутаторы агрегация ссылок с возможностями FEC. 2-8 сетевых адаптеров на группу.

Gigabit EtherChannel/Link Aggregation (GEC) это гигабитное расширение FEC/Агрегации линии связи/802.3ad.

Требования и ограничения: все члены команды должны работать на гигабитной скорости.

Static Link Aggregation (SLA) заменила двух предшественников FEC и GEC.

Требования и ограничения: все сетевые адаптеры в статическом режиме должны работать с одинаковой скоростью и подключаться к коммутаторам со статическим агрегированием каналов. Если скорость сетевой карты изменится, скорость команды будет зависеть от наименьшего общего знаменателя. 2-8 сетевых адаптеров на группу.

Dynamic Link Aggregation (IEEE 802.3ad) создает одну или несколько групп, используя динамическое агрегирование каналов с сетевыми адаптерами смешанной скорости, чтобы обеспечить отказоустойчивость и улучшить пропускную способность при передаче и приеме.

Требования и ограничения: требуется коммутатор, который полностью поддерживает стандарт IEEE 802.3ad.

Multi-vendor Teaming (MVT) позволяет сетевым адаптерам разных производителей работать в команде.

Близко к NIC Bonding в Linux OS

Что такое Linux NIC Bonding?

В Linux OS объединение сетевых карт относится к процессу объединения нескольких сетевых интерфейсов в логический интерфейс привязки. То есть объедините и подключите две или более сетевых карт как одну. Обратите внимание, что одним из предварительных условий для настройки соединения является наличие сетевого коммутатора, который поддерживает EtherChannel (это верно почти для всех коммутаторов).

Сколько режимов Linux NIC Bonding?

Поведение связанного NICs зависит от типа используемого режима соединения. В общем, шаблоны могут обеспечивать отказоустойчивость и/или услуги балансировки нагрузки. В следующей таблице приведено подробное описание этих семи режимов.

| Режим | Политика | Fault Tolerance | Load Balancing | Особенности и Описани |

|---|---|---|---|---|

| mode=0 (balance-rr) | Round-robin | Y | Y | Режим по умолчанию. пакеты передаются/принимаются последовательно от первого доступного ведомого до последнего. |

| mode=1 (active-backup) | Active-backup | Y | N | ТОЛЬКО один раб активен, а другой спит. Этот резервный NIC будет действовать в случае сбоя активного NIC. При условии, что имеется N*интерфейсов, коэффициент использования ресурсов будет 1/N. |

| mode=2 (balance-xor) | XOR (Exclusive OR) | Y | Y | Передает на основе формулы XOR. Как только соединение между NIC и соответствующим устройством установлено, тот же NIC будет использоваться для передачи/приема для MAC-адреса назначения, чтобы гарантировать, что MAC-адрес остается тем же. |

| mode=3 (broadcast) | Broadcast | Y | N | Все пакеты отправляются на все подчиненные интерфейсы за счет использования ресурсов. Обычно используется для определенных целей, например, в финансовой отрасли, где требуется сверхнадежная сеть. |

| mode=4 (802.3ad) | IEEE 802.3ad Dynamic Link Aggregation | Y | Y | Создайте группы агрегации с одинаковыми настройками скорости и дуплекса. Требуется коммутатор, который поддерживает динамическое агрегирование каналов IEEE 802.3ad. |

| mode=5 (balance-tlb) | Adaptive Transmit Load Balancing (TLB) | Y | Y | Исходящий трафик распределяется в соответствии с текущей нагрузкой на каждом подчиненном интерфейсе, и входящий трафик принимается текущим ведомым. Не требует никакой специальной поддержки коммутатора. |

| mode=6 (balance-alb) | Adaptive Load Balancing (ALB) | Y | Y | Добавьте функцию балансировки нагрузки на прием по сравнению с предыдущим режимом = 5. И балансировка нагрузки приема достигается посредством согласования ARP (Address Resolution Protocol). Не требует никакой специальной поддержки коммутатора. |

| Внимание: 1. Один интерфейс bonding может указывать только один режим. 2. mode=0, mode=2, and mode=3 теоретически требует статической агрегации. 3. mode=4 нужно поддерживать 802.3ad. 4. mode=1, mode=5, and mode=6 не требуют никаких настроек на коммутаторе. 5. Выбор режима зависит от топологии сети, требований к поведению соединения и характеристик подчиненных устройств. Вообще говоря, для топологий с одним коммутатором используются следующие режимы: mode=0 (balance-rr); mode=2 (balance-xor); mode=4 (802.3ad); mode=5 (balance-tlb); mode=6 (balance-alb). And the left two modes—mode=1 (active-backup) & mode=3 (broadcast) применяются для топологии с несколькими коммутаторами. | ||||

Улучшит ли NIC teaming or bonding пропускную способность соединения между сервером и коммутатором?

Многие могут подумать, что агрегация ссылок увеличит пропускную способность. Например, каждый из трех NICs работает на скорости 1 Гбит/с, а NIC команда указывает скорость 3 Гбит/с. Означает ли это увеличение скорости в два раза? Нет. Как мы все знаем, обычно используется Ethernet 1 Гбит/с и 10 Гбит/с. Но нет определенного стандарта 3 Гбит/с. Итак, как мы реализуем 3 Гбит/с ссылки? Правда в том, что у нас на самом деле нет связи 3 Гбит/с. Вместо этого у нас есть три отдельные ссылки 1 Гбит/с.

Что еще более важно, рекомендуется учитывать агрегацию ссылок на основе отказоустойчивости сетевых каналов, а не общей доступной пропускной способности. Например, при передаче файлов с одного компьютера на другой по суммарной ссылке 2 Гбит/с общая максимальная скорость передачи может составлять только 1 Гбит/с. Однако при передаче двух файлов преимущества совокупной пропускной способности показаны. То есть агрегация ссылок увеличивает количество каналов, а не ограничения скорости.

Что принесет NIC teaming / NIC bonding пользователям?

Короче говоря, ответ - балансировка нагрузки и отказоустойчивость.

Fault tolerance—если один из базовых физических NICs отключает или отсоединяет свой кабель, хост/сервер обнаружит сбой и автоматически переместит трафик на другой NIC в соединении, что исключает ситуацию полного разрыва сетевого подключения одним точка отказа.

Рисунок 1: Load balancing & fault tolerance

Используя преимущества балансировки нагрузки и отказоустойчивости, члены команды NIC будут работать вместе, чтобы оптимизировать пропускную способность и предотвратить потерю соединения в случае сбоя сетевого адаптера.

Сегодня опишу процесс построения отказоустойчивого кластера из двух серверов на основе Microsoft Hyper-V Server 2019 и с общим блочным хранилищем.

Упрощённое описание инфраструктуры кластера:

Sconfig выглядит так, доступен на локальной консоли:

Конфигурирование серверов буду производить в Windows Admin Center.

Все операции выполняются от имени учётной записи пользователя домена (Domain User), имеющей права администратора на обоих серверах.

Так же у этой учётной записи должны быть права Create Computer в том OU или контейнере, в котором находятся серверы, из которых будем собирать кластер.

Чаще всего данные операции выполняются пользователем с правами Domain Admin.

Получаем список сетевых адаптеров:

Первым делом объединяем интерфейсы QLogic в агрегированный канал, тип объединения будет LACP.

Теперь, если снова написать Get-NetAdapter, увидим новый сетевой интерфейс с именем LACP_LAN

Чтобы два раза не ходить, сразу на этот интерфейс повесим виртуальный коммутатор для клиентского доступа

Список сетевых интерфейсов теперь такой:

Интерфейсы 10Gb от Intel подключены в разные коммутаторы, на случай, если один из коммутаторов откажет. На их основе настроим агрегированный канал с несколькими виртуальными сетями для доступа к блочному дисковому хранилищу по протоколу iSCSI и для работы кластера.

В результате получается такой список интерфейсов и остаётся настроить IP-адреса.

Т.к. интерфейсов уже довольно много, удобнее будет отсортировать вывод, к примеру, в алфавитном порядке:

Выполняем командлет присвоения IP-адреса, внимательно подставляя свои адреса и номера интерфейсов:

Ставим роли и службы:

Install-WindowsFeature failover-clustering, rsat-clustering, rsat-role-tools, rsat-hyper-v-tools, hyper-v-powershell

Сначала необходимо перевести сервис iSCSI-инициатора в режим автоматического запуска и запустить его:

Для работы с дисковыми устройствами по протоколу iSCSI необходимо настроить так называемый iSCSI target portal:

Подключаем доступные iSCSI-таргеты:

Либо можно вызвать обычную графическую консоль командой

Всё то же самое необходимо выполнить и на втором сервере.

Можно начинать работать с дисками.

Начнём работу с диска номер 4, объёмом 1GB:

По необходимости то же самое делаем с остальными дисками. В результате получается такая картина:

Перезагружаем оба сервера.

Всё, основные вещи на серверах сделаны, можно приступать к сборке кластера.

Кластер будем собирать используя Failover Cluster Manager.

Запускаем мастер проверки конфигурации, указываем наши серверы, в следующем пункте оставляем отметку Run all tests, жмём пару раз Next и ждём завершения тестов.

Нажимаем далее и подтверждаем создание.

Теперь кластер необходимо настроить: добавить кластерные хранилища, разграничить сети и, собственно, добавить роли,которые будут исполняться на нашем кластере.

Начинаем с сетей кластера. Раскрываем древовидное представление в менеджере и выбираем Networks:

Теперь нужно настроить дисковые массивы и диск-свидетель кворума.

Теперь необходимо добавить общее хранилище (Cluster Shared Volume, CSV).

В разделе Disks выбираем диск, из которого хотим сделать CSV и жмём Add to Cluster Shared Volume.

Технология объединения сетевых адаптеров NIC Teaming заключается в том, что несколько физических адаптеров (NIC) объединяются в группу, в результате чего получается один единственный логический адаптер. Процесс объединения называют teaming. NIC Teaming решает две основные задачи:

Включение и настройка

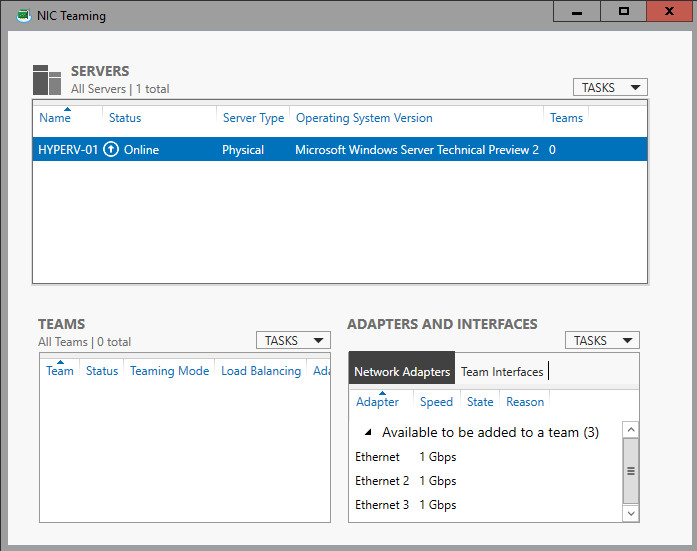

По умолчанию режим NIC Teaming отключен. Чтобы его активировать открываем Server Manager, заходим в свойства сервера и нажимаем ссылку Объединение сетевых карт (NIC Teaming).

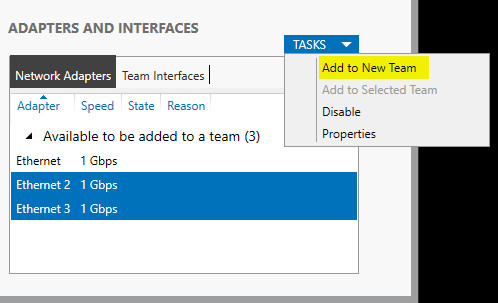

В открывшемся окне жмем на кнопку Задачи (Tasks) и выбираем пункт Создать группу (New Team).

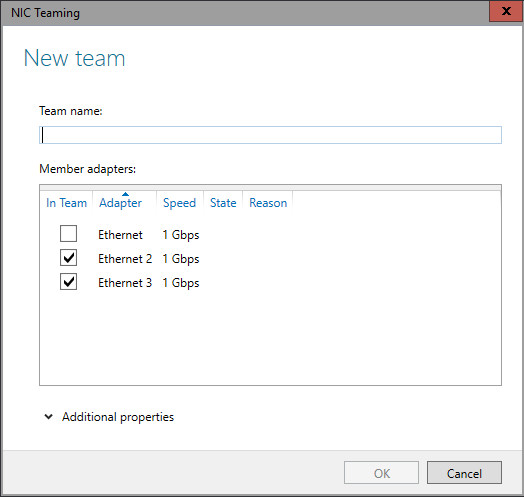

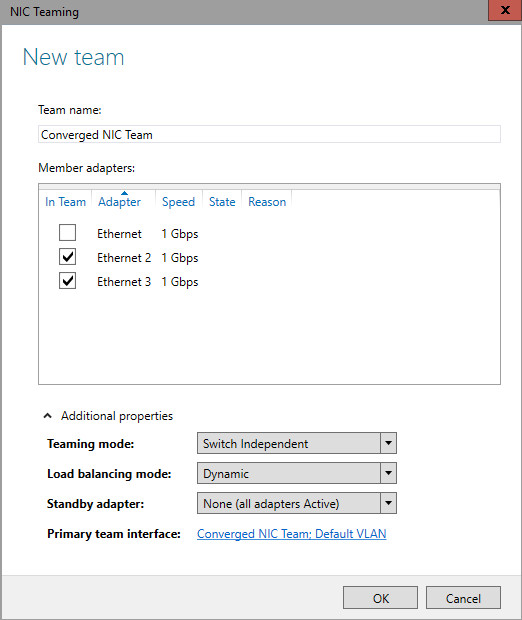

Даем группе название и выбираем добавляемые адаптеры.

Затем настраиваем дополнительные свойства группы. Поскольку от этих параметров зависит эффективность работы NIC Teaming, стоит рассмотреть их поподробнее.

Режим поддержки групп (Teaming mode) определяет режим взаимодействия группы с сетевым оборудованием:

Режим балансировки нагрузки (Load Balancing mode) определяет, каким образом распределять сетевой трафик между адаптерами группы:

Резервный адаптер (Standby adapter) позволяет назначить один из адаптеров группы в качестве резервного. В нормальном состоянии резервный адаптер не используется для передачи трафика, но при выходе любого адаптера группы из строя сразу занимает его место и трафик продолжает передаваться без перерывов. Впрочем, даже без резервирования выход из строя одного адаптера в NIC Teaming не приведет к прерыванию сетевых операций, т.к. нагрузка будет автоматически распределена по оставшимся адаптерам.

Настроив свойства группы, жмем ОК. Все, группа создана. Теперь в окне «Сетевые подключения» появился еще один сетевой адаптер, который как раз и является виртуальным адаптером группы.

Если посмотреть свойства физических сетевых адаптеров, то мы увидим, что все компоненты кроме протокола мультиплексора сетевого адаптера отключены

А все настройки теперь производятся в свойствах виртуального адаптера.

Включить и управлять NIC Teaming можно и с помощью PowerShell. Для этого в PS есть целый модуль по имени NetLbfo.

К примеру, следующая команда создает группу Team1 из адаптеров Ethernet и Ethernet 2, включает режим Switch Independent и задает балансировку нагрузки по хешу адреса:

New-NetLbfoTeam -Name Team1 -TeamMembers ″Ethernet″,″Ethernet 2″ `

-TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

Отключение NIC Teaming

Отключение NIC Teaming произойдет, если удалить тиминговую группу. Сделать это можно в Server Manager, в окне NIC Teaming.

Также удалить группу можно через PowerShell командой Remove-NetLbfoTeam -Name Team1

Кстати, при удалении группы восстанавливаются предыдущие настройки сетевых адаптеров.

Заключение

Реализация технологии NIC Teaming в Windows Server 2012 откровенно порадовала. Она проста в настройке, не предъявляет специальных требований к оборудованию и может работать работает практически с любыми сетевыми адаптерами. В общем я за ее использование, однозначно.

Читайте также: