Avago 3108 megaraid настройка raid 1

Обновлено: 29.06.2024

Как настроить RAID 1 массив и установить на него Windows 7, 8.1, 10

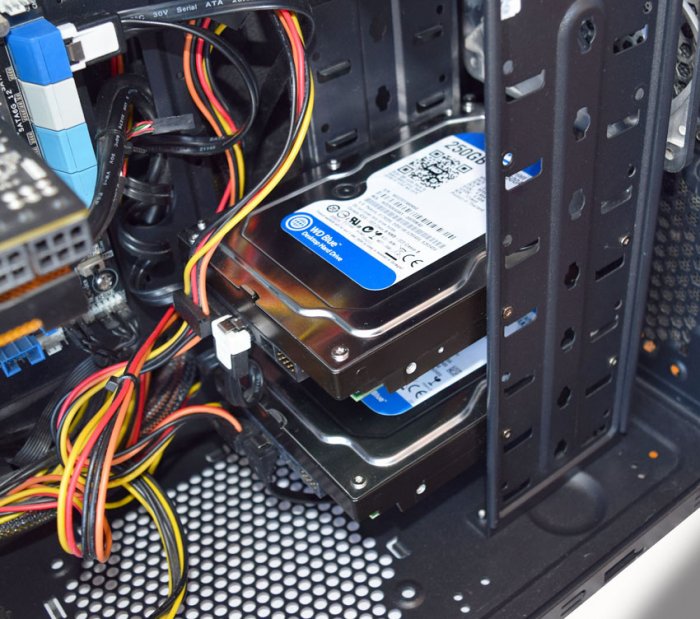

После прочтения предыдущих статей о создании программного RAID 1 массива средствами операционной системы вы конечно зададите вопрос: «А как установить саму систему на RAID 1 массив или может существует возможность переноса уже готовой и настроенной Windows с программами на рейд массив. Ведь неожиданно сломаться может и винчестер с установленной операционкой, а не только второстепенный жёсткий диск с файлами?» Потеря операционной системы со всеми установленными приложениями, при отсутствии резервной копии, может вывести из работы на несколько дней любую организацию, поэтому я считаю обязательным создание RAID 1 массива на рабочем месте и установки на него Windows.- Примечание : Друзья, кроме RAID 1 массива, ещё существует RAID 0 массив, способный увеличить быстродействие Вашей операционной системы в два раза .

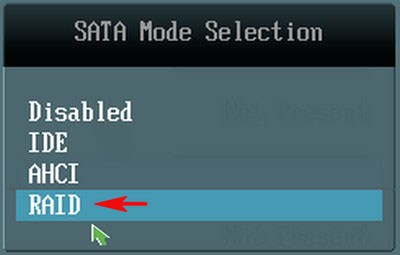

SATA Mode Selection выставляем в положение RAID.

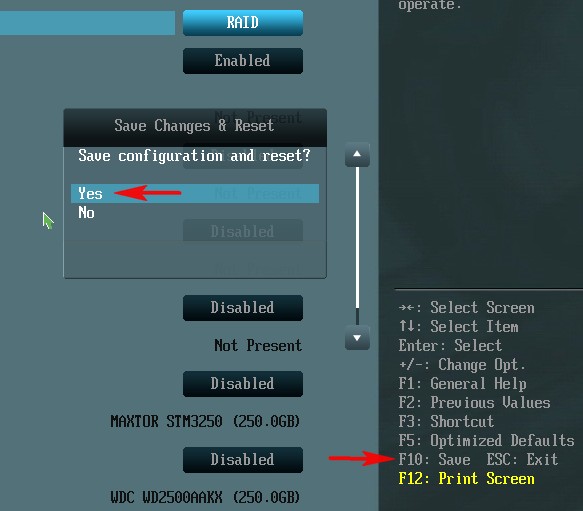

HotPlug — (горячее подключение) выставляем в Enabled для жёстких дисков объединяемых в массив.

Для сохранения внесённых изменений жмём F10 и выбираем Yes. Происходит перезагрузка.

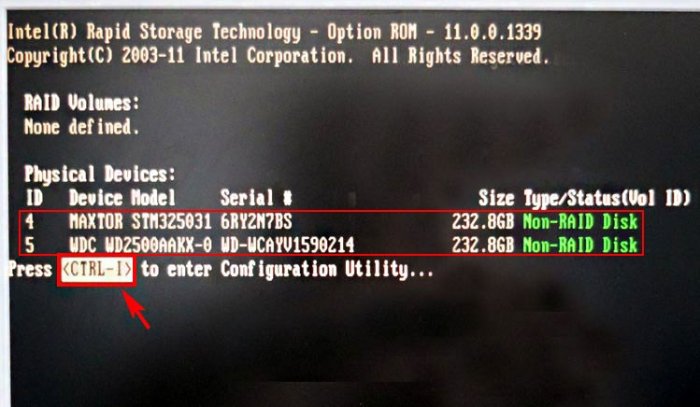

После включения в БИОС технологии RAID, на экране монитора при загрузке на несколько секунд возникнет предложение нажать клавиатурное сочетание ( CTRL-I ), чтобы войти в настройки конфигурации RAID.

Также видно два подключенных к портам 4 и 5 жёстких диска SATA: Maxtor и WD, находящихся пока не в RAID-массиве ( Non-RAID Disk ). Нажимаем CTRL-I.

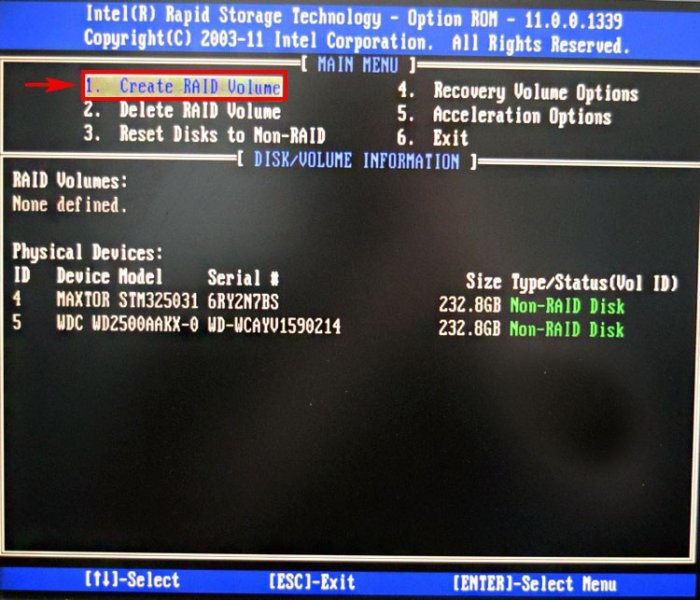

В начальном окне настроек выбираем с помощью стрелок на клавиатуре Create a RAID Volume (Создать том RAID) и жмём Enter.

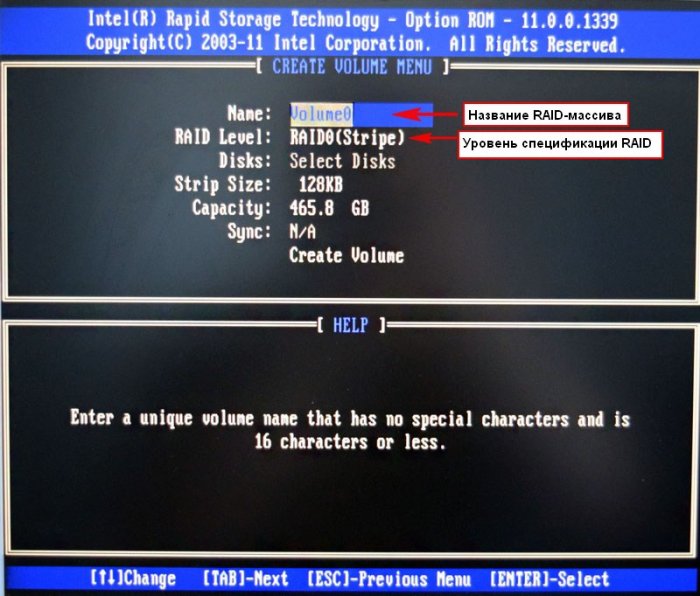

В данном окне производим основные настройки RAID-массива.

Name (название RAID-массива). Жмём на клавишу "пробел" и вводим наименование,

например " RAID 1 new" и жмём Enter. Передвигаемся ниже с помощью клавиши Tab.

RAID Level: (Уровень RAID). Мы будем создавать RAID1(Mirror) -"зеркалирование" - при отказе одного из дисков, точная копия данных останется на другом диске и контроллер сразу переключиться на использование дублирующего диска. Выбираем этот уровень с помощью стрелок на клавиатуре.

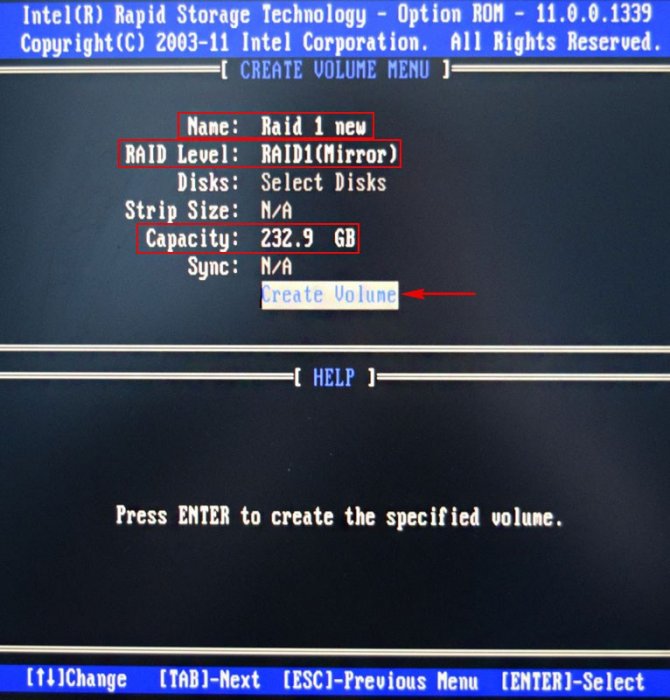

Capacity (объём) выставляется автоматически. Объём двух наших дисков 500 ГБ превращаются в 250 ГБ, так как мы используем уровень RAID1(Mirror) и два наших винчестера работают как один.

Больше ничего не меняем и передвигаемся к последнему пункту Create Volume и жмём Enter.

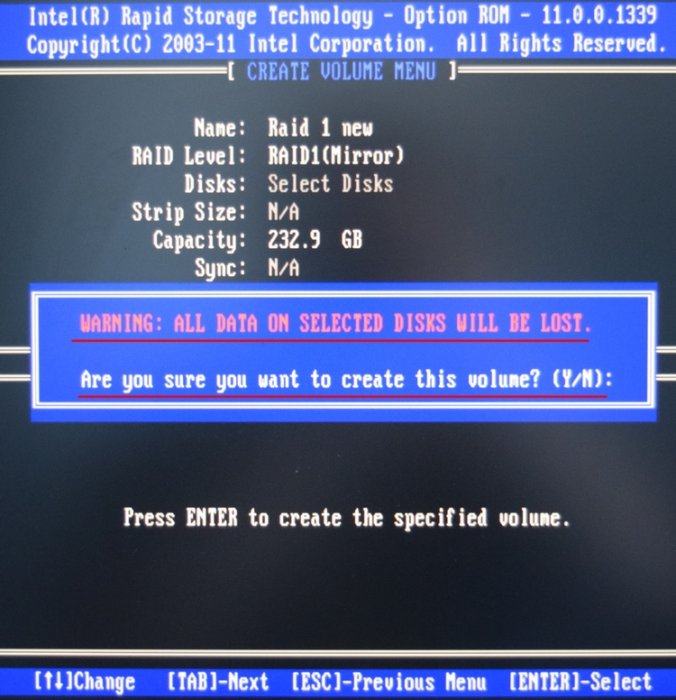

WARNING: ALL DATA ON SELECTED DISKS WILL BE LOST.

Are you sure you want to create this volume? (Y/N):

ВНИМАНИЕ: ВСЕ ДАННЫЕ на выбранных дисках будут потеряны.

Вы уверены, что хотите создать этот объем ? (Y / N):

Жмём Y (Да) на клавиатуре.

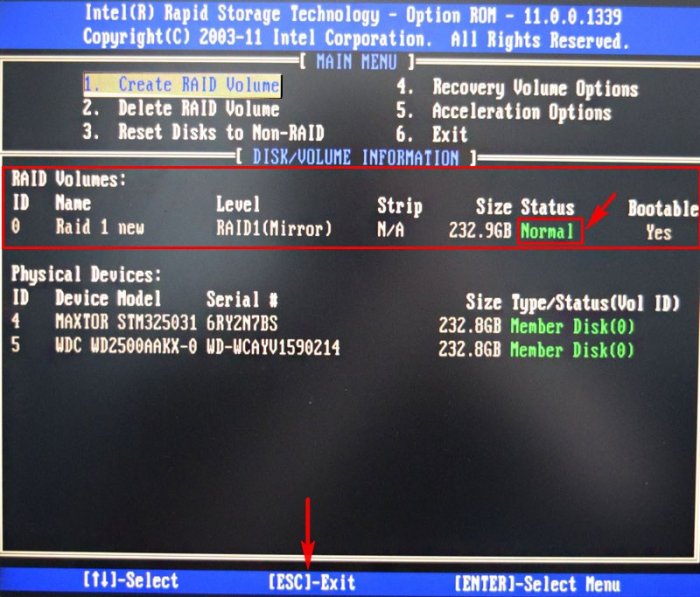

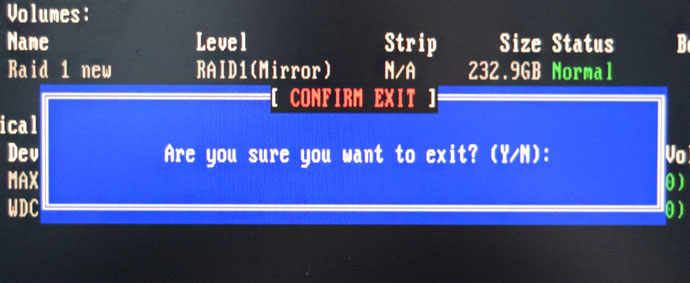

RAID 1 создан и находится со статусом Normal (нормальный). Для выхода жмём на клавиатуре клавишу Esc

Are you sure you want to exit (Вы уверены что хотите выйти? Нажимаем Y (Да).

Как видим, только что созданный нами RAID 1 массив с названием " RAID 1 new" тоже находится в загрузочном меню.

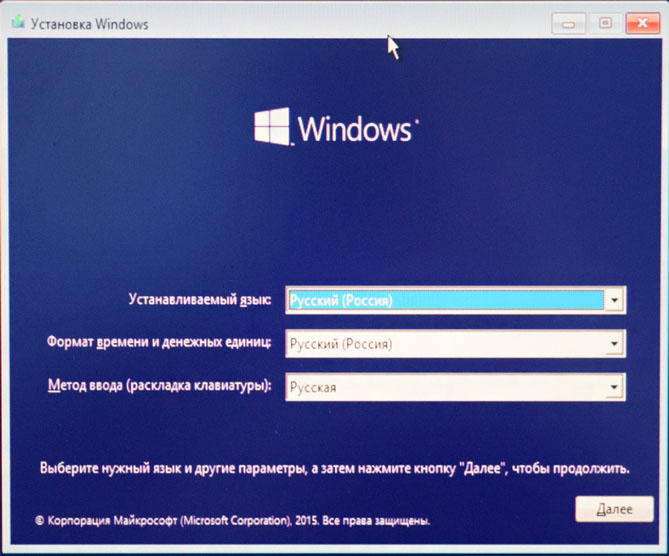

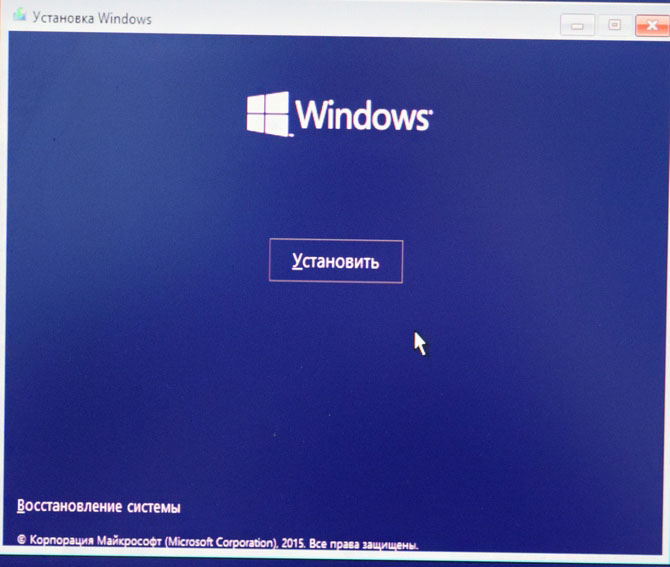

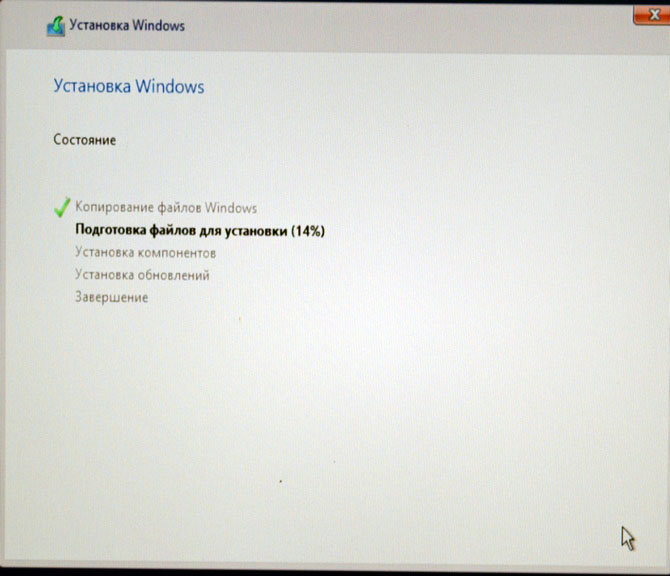

Загружаемся с флешки в программу установки Windows 10. Далее действуем как при обычной установке операционной системы.

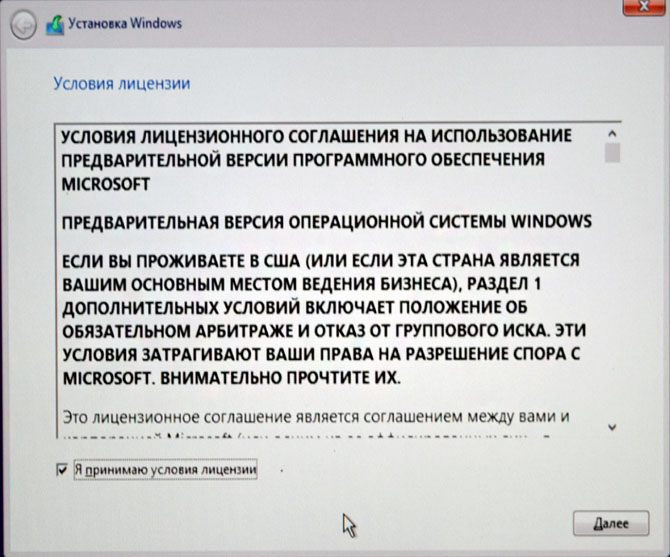

Принимаем лицензионное соглашение

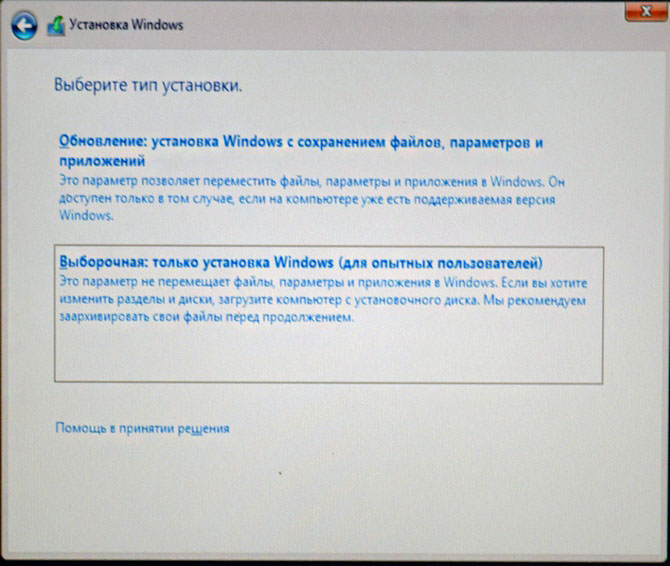

Выборочная: Только установка Windows

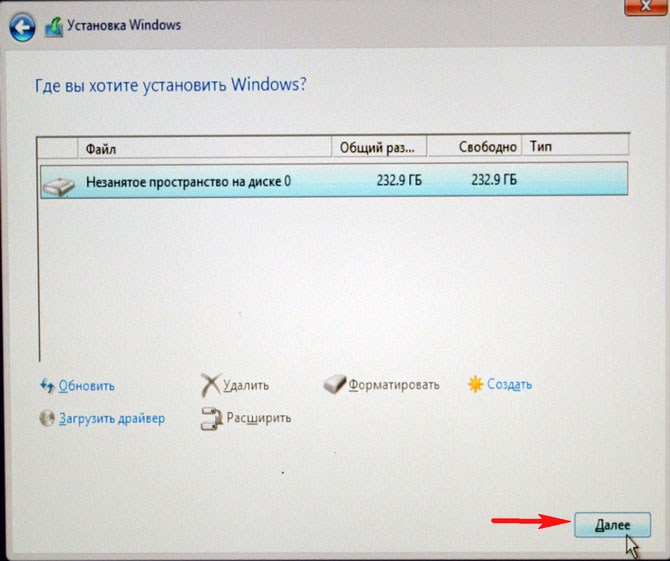

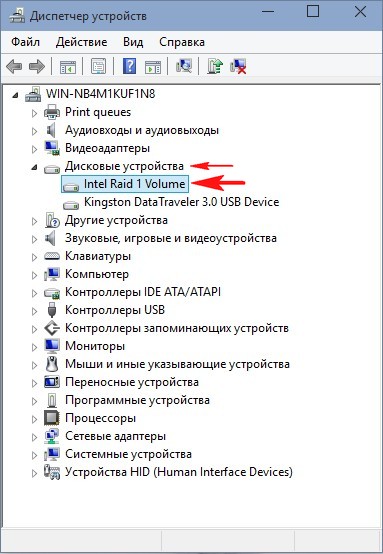

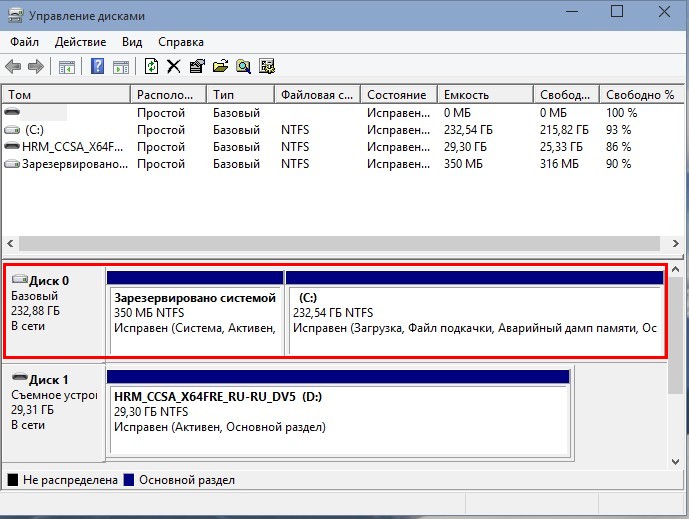

Два жёстких диска объединённых в RAID-массив установщик Win 10 видит как один.

Если хотите, можете создать разделы. Далее

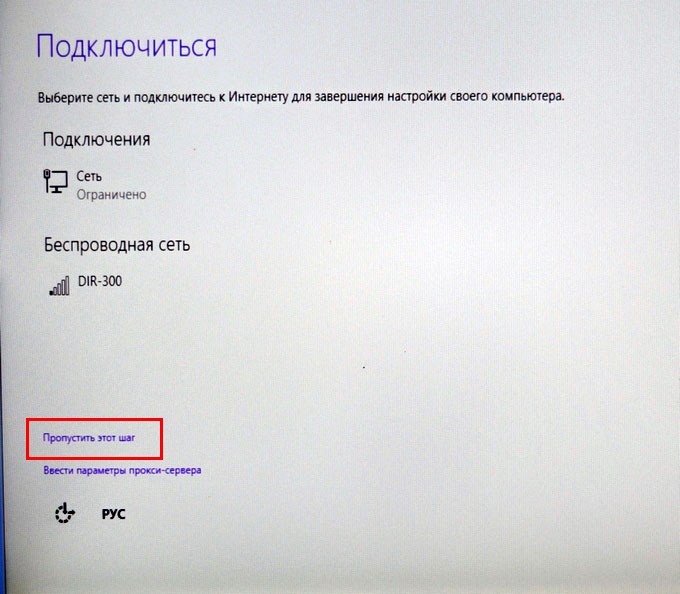

Пропустить этот шаг

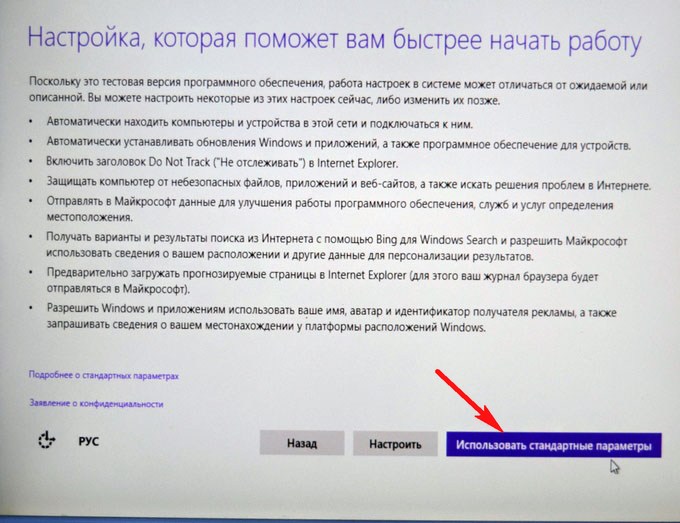

Использовать стандартные параметры

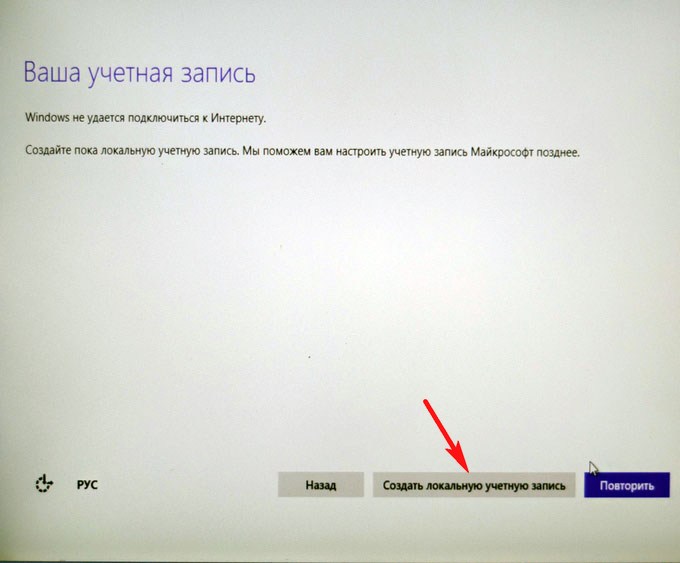

Создать локальную учётную запись

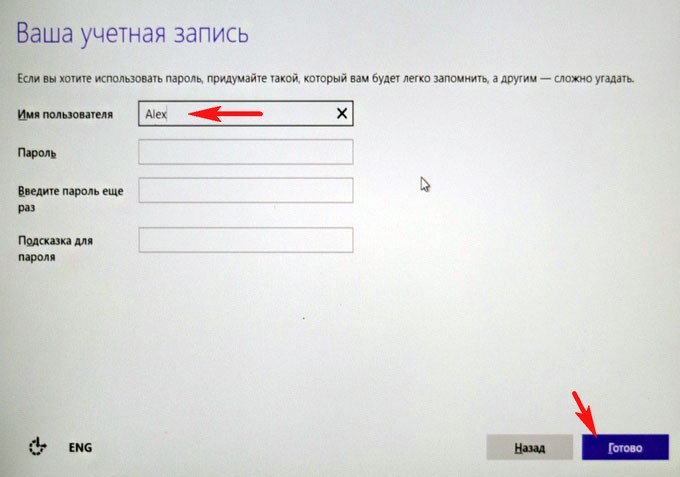

Вводим имя учётной записи и жмём Готово.

Windows 10 установлена на RAID 1 массив.

RAID 1 массив и флешка с Windows 10.

Друзья, если один жёсткий диск в независимом массиве вышел из строя, то операционная система загрузится со второго исправного винчестера, то есть с вашими данными ничего не случится, а вот как воссоздать RAID - массив, об этом поговорим в следующей статье.

Список инструментов управления для LSI/Avago

Правильно подобранная утилита, может выполнять поставленную задачу в разы удобнее и быстрее, и знание всех инструментов является прямой обязанностью любого системного администратора.

Кстати я уже делал похожие подборки по инструментам управления и настройки для серверов IBM, Supermicro и HPУтилита LSI Storage Authority

Про LSA (LSI Storage Authority) я уже делал подробнейший обзор. На текущий момент, это флагманский инструмент имеющий графический интерфейс управления, прямо из вашего браузера, что делает его кросплатфомным, убирающим привязку к операционной системе. Что хорошо, что утилита работает не на медленном Java, а на HTML5, что делает ее очень удобной.

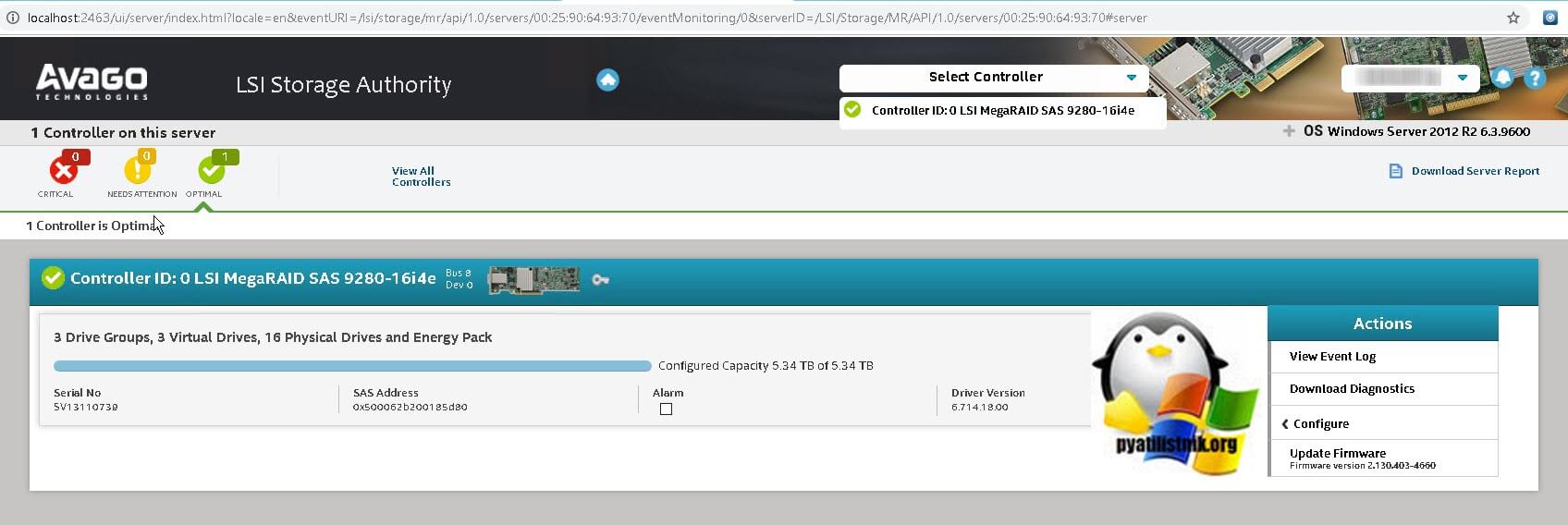

Вот так выглядит общий дашборд управления, на нем вы увидите список ваших устройств представленных на сервере, в моем примере Controller ID: 0 LSI MegaRAID SAS 9280-16i4e.

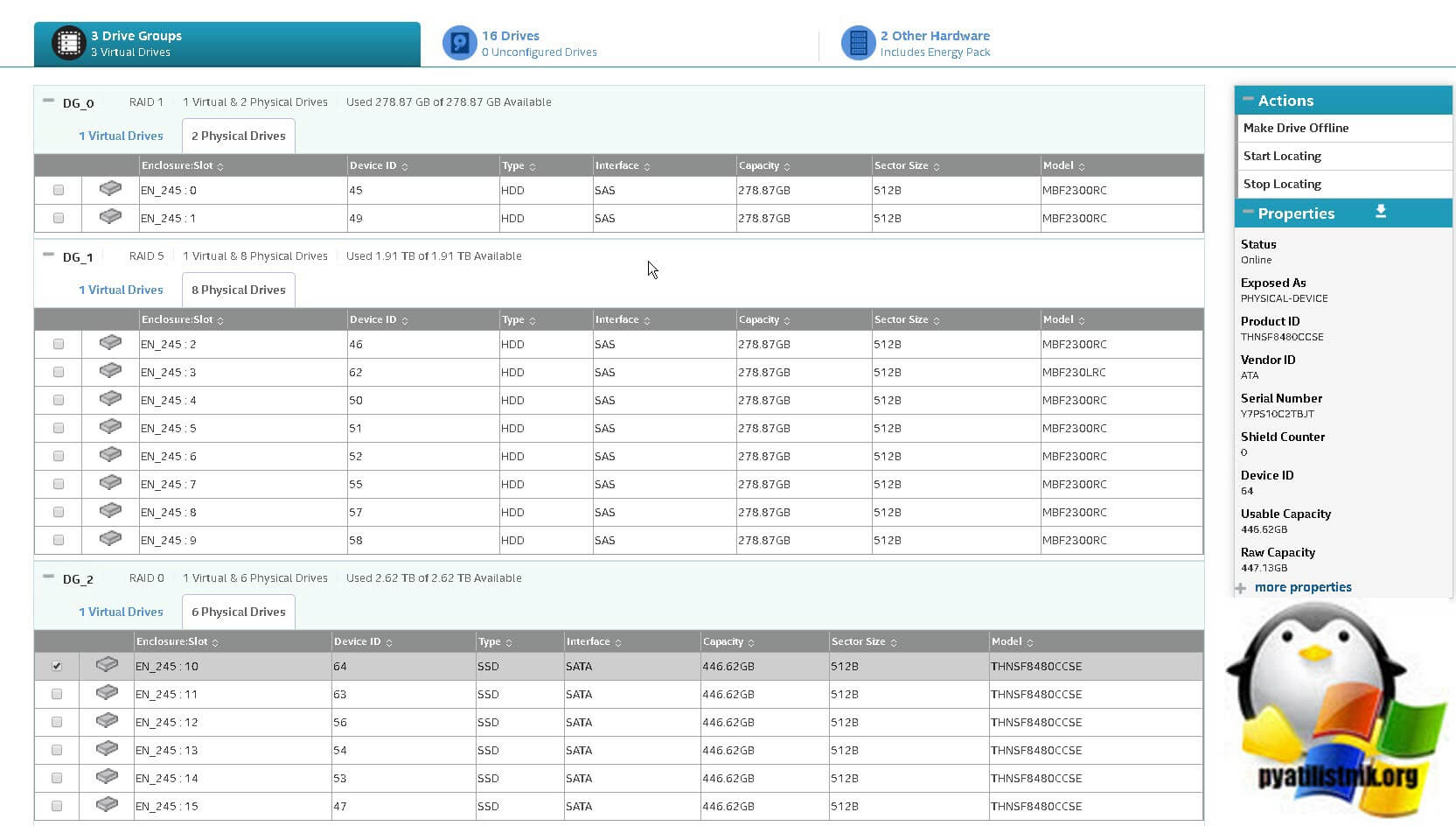

Вот так выглядит информация по вашим виртуальным и физическим дискам. Хочу отметить, что LSI Storage Authority показывает больше информации по свойствам физических дисков, тут вы легко обнаружите:

- Status - Online

- Exposed As - PHYSICAL-DEVICE

- Product ID - THNSF8480CCSE

- Vendor ID - ATA

- Serial Number - Y7PS10C2TBJT

- Shield Counter - 0

- Device ID - 64

- Usable Capacity - 446.62GB Capacity - 447.13GB

- less properties - General Properties

- SAS Address 0 - 0x500062b200185da2

- Negotiated Link Speed - 6G

- Drive Speed - 6G

- Temperature - 25C

- Revision Level - DAC9

- Power Status - On

- Native Command Queueing Capable - No

- Physical Sector Size - 512B

- SCSI UNMAP - Disabled

- Enclosure Properties

- Enclosure ID - 245

- Enclosure Model - Backplane

- Enclosure Location - Internal

- Enclosure Connector - N/A

- Drive Security Properties

- Full Disk Encryption Capable - No

- Full Disk Encryption Type - NONE

- Protection Information Properties

- Protection Information - Incapable

Утилита MegaRAID Storage Manager

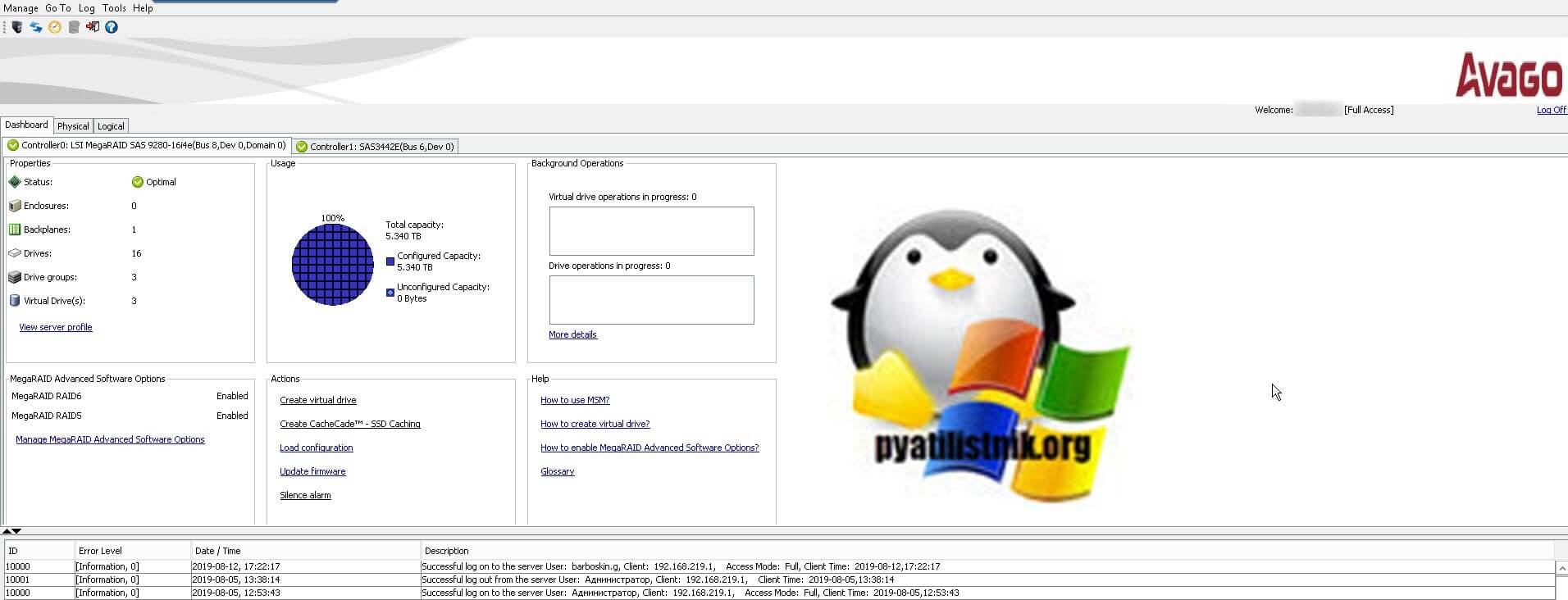

MegaRAID Storage Manager - это более старая утилита, с которой мы уже много взаимодействовали в предыдущих статьях. Например мы устанавливали MegaRAID Storage Manager на ESXI 5.5. Вот так выглядит базовый дашборд со сводной информацией, о RAID контроллерах LSI/Avago. Тут вы увидите:

- Общий объем ваших дисков, в моем примере это 5,3 ТБ

- Состояние контроллера (Status) - если все хорошо, то статус должен быть Optimal

- Drives - количество физических дисков

- Drive groups - количество датасторов

- Virtual Drives - количество виртуальных дисков

![Утилита MegaRAID Storage Manager]()

Тут же есть область "Action", позволяющая загрузить конфигурацию, обновить прошивку RAID контроллера, настроить звуковой сигнал предупреждения. Справа есть ссылки на документацию. Снизу вы увидите текущие события на вашем контроллере LSI/Avago. Вкладка "Physical" покажет ваши физические диски, выбрав любой из них вы увидите дополнительные свойства.

![Физические диски в утилите MSM]()

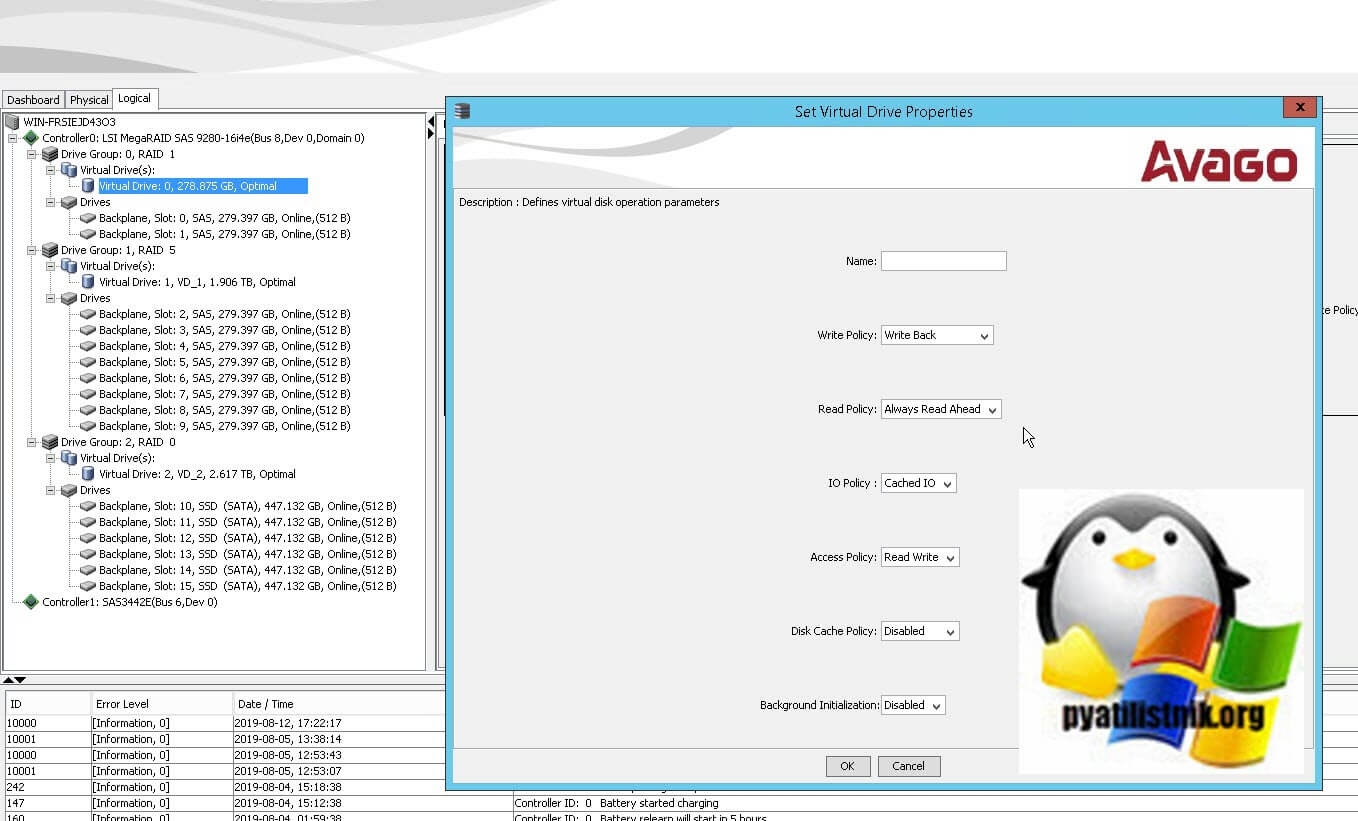

Вкладка "Logical" позволяет уже взаимодействовать с логическими сущностями. Например вы можете добавить HDD/SSD в существующий RAID массив. Вы легко можете изменить свойства любого Virtual Drive, изменить вид кэширования, включить или отключить инициализацию.

![Изменить метод кэширования на LSI контроллере]()

Методы создания различных видов RAID через MSM я подробно описывал. Чаще всего есть поддержка всех видов, но в некоторых контроллерах RAID 50 и 60 нужно разблокировать с помощью специального кода.

Утилита StorCLI

Инструмент StorCLI - это утилита командной строки, которая имеет больший функционал в отличии от графических аналогов LSA и MSM. Утилита очень простая и гораздо удобнее, по крайней мере с случае с Vmware ESXI, на которую порой установить MSM/LSA. это целая эпопея.

Добрый день!

Посоветуйте, как правильно настроить рейд-контроллер.

Контроллер: LSI AVAGO MegaRAID SAS 9361-8i с комплектом защиты LSI MegaRAID CacheVault < LSI00418 LSICVM02 > CVPM02.

Будут следующие массивы:

Диск С, Винда - 2 ССД в зеркало.

Диск Д, файл транзакций *.LDF - 2 SAS в зеркало

Диск Е, база данных SQL *.MDF - 4 SAS в Рэйд 10Создал пробные зеркала, увидел, что если щелкнуть в утилите MegaRaid Storage Manager на дисковой группе, то параметр Data Protection - Disabled.

Есть такое подозрение, что при наличии батарейки должно быть Enabled. как перенастроить?

Подскажите, какие выбрать остальные параметры:

Write Policy

Read Policy

IO Policy

Access Policy

Disk Cache Policy

Будут ли настройки зависеть от того, что будет на массиве (винда, бд, файл транзакций).Установлен server 2016 R2.

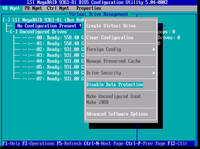

Заранее благодарен!Войдите в меню контроллера при включении питания. Такие параметры настраиваются там.

Sponge Bob писал(а): Добрый день.

Войдите в меню контроллера при включении питания. Такие параметры настраиваются там.

![Изображение]()

Да, есть такое. Только я запутался. Если зайти в настройку контроллера при включении сервера, там в меню будет опция "Disable Data Protection", вот скрин:

![Изображение]()

При этом (опция=Disable Data Protection, как на скрине), в винде видим что защита на уровне контроллера включена:

![Изображение]()

а на уровне Drive Group выключена. почему и как ее включить?

Нет ли у вас документа Avago 6Gb/s SAS and 12Gb/s SAS Performance Tuning Guide, был бы очень признателен. в интернете есть ссылки, но все мертвые.mcmurphy94 писал(а): Добрый день!

Создал пробные зеркала, увидел, что если щелкнуть в утилите MegaRaid Storage Manager на дисковой группе, то параметр Data Protection - Disabled.

Есть такое подозрение, что при наличии батарейки должно быть Enabled. как перенастроить?Среди меня есть мнение, что пар-р "Data Protection" не имеет отношения к BBU/CV-защите кеша контроллера.

Имхуется мне, что при наличии исправного BBU/CV никаких отдельных настроек для защиты кеша контроллера не нужно - он будет подпитываться от BBU или сбрасываться на флеш в случае CV по-любому, для любого LUN`а (VD) без специального указания.

А Data Protection, мнится мне, имеет отношение к опции PI контроллера - защита информации на уровне физического носителя по стандарту Т10/DIF, для работы с "нестандартными" физ.секторами (например, 520b вместо 512b и т.д) с избыточной информацией (КС/КЧ) .

Ок, спасибо!

А как правильно сделать - после создания массива запустить инициализацию (если не была выбрана опция инициализировать сразу после создания)? Это актуально и для SAS и для SSD?

Утилита от LSI MSM не пишет, был ли проинициализирован массив. Если запустить инициализацию, предупреждает, что данные будут потеряны. Это действительно так, если есть файлы, то их затрет?К сравнению, интеловский рейд на С600 и утилита Intel Rapid позволяет запускать инициализацию на массиве с файлами и ничего не затирается. У них разные подходы?

И еще - когда надо провести проверку консистентности - уже после заполенения массива файлами, или нет?

mcmurphy94 писал(а): Ок, спасибо!

А как правильно сделать - после создания массива запустить инициализацию (если не была выбрана опция инициализировать сразу после создания)? Это актуально и для SAS и для SSD?Не уверен, что понял, как второй вопрос из вышеотквоченного сочетается/связан со первым.

Мои семантические фильтры сбоят?Актуальна ли инициализация массива как для HDD, так и для SSD.

Или актуальна ли инициализация массива как для SAS, так и для SATA носителей?И по запуску тоже как-то коряво спрошено.

Даже если Вы не включите фоновую инициализацию и откажетесь инициализировать массив после его создания (если БИОС контроллера допускает такое вольнодумство ), то у Вас остаётся возможность "подстраховаться" впоследствии, задействовать механизмы PR или СС (см.ниже).

mcmurphy94 писал(а): Утилита от LSI MSM не пишет, был ли проинициализирован массив. Если запустить инициализацию, предупреждает, что данные будут потеряны. Это действительно так, если есть файлы, то их затрет?Это вопросы к создателям утилиты MSM (хотя я бы их - за одну лишь тормозную явовскую морду и вечный косяк с multicast/unicast-коннектами к сетевым агентам - просто распнул бы. не смертельным, но очччень обидным образом).

Надеюсь, что про потерю данных они так "шутят"-перестраховываются. Т.к. инициализация массива может проводиться контроллером в т.ч. и в фоновом режиме прямо в процессе работы контроллера с данными на носителях.

Если это ТА ЖЕ инициализация, то нафига так пугать народ?

А если это "какая-то другая" инициализация, то. какая?Вообще же из более-менее детальной проработки документации у меня по некоторым признакам сложилось впечатление, что пресловутая "инициализация массива" - неважно, фоновая она, или "фронт-эндная" - использует тот же механизм/алгоритм, что и так называемое "патрульное чтение" (Patrol Reading), проверяя абсолютно все блоки носителей на читабельность (и при нужде - на писабельность), с соответствующими выводами (аналог ремапа битых физ.секторов, проводимого внутри hdd или ssd их собственными фирмварями).

mcmurphy94 писал(а): К сравнению, интеловский рейд на С600 и утилита Intel Rapid позволяет запускать инициализацию на массиве с файлами и ничего не затирается. У них разные подходы? Если у этого "чипсетного недорейда" ничего не затирается, значит его создатели пошли по стандартному пути (см.вышеописанный алгоритм).

По итогам инициализации в метаданные массива записывается помимо прочего ещё и инфа о состоянии носителей (указание на имеющиеся "ремапы", пометки в Bad Strip Table, etc.).

И да - и инициализация, и Patrol Reading абсолютно недеструктивны для данных на массиве (конечно, при штатном развитии событий, что является нормой для исправного контроллера).

Повторюсь - LSI (как и остальные вендоры) реализовал точно такой же механизм инициализации, по сути стандарт.

Почему MSM пугает уничтожением данных - "вопрос не по окладу"(с).

mcmurphy94 писал(а): И еще - когда надо провести проверку консистентности - уже после заполенения массива файлами, или нет?Если Вы имеете в виду СС - Check Consistency - то она, в отличие от Patrol Reading, работает только на блоках с данными (PP проверяет все блоки без исключения).

Соответственно, запускать СС на пустом массиве бесполезно.![]()

В данной статье мы расскажем про разные способы организации RAID-массивов, а также покажем один из первых аппаратных RAID-контроллеров с поддержкой NVMe.

Все разнообразие применений технологии RAID встречается в серверном сегменте. В клиентском сегменте чаще всего используется исключительно программный RAID0 или RAID1 на два диска.

В этой статье будет краткий обзор технологии RAID, небольшая инструкция по созданию RAID-массивов с помощью трех разных инструментов и сравнение производительности виртуальных дисков при использовании каждого из способов.

Что такое RAID?

RAID (англ. Redundant Array of Independent Disks — избыточный массив независимых (самостоятельных) дисков) — технология виртуализации данных для объединения нескольких физических дисковых устройств в логический модуль для повышения отказоустойчивости и производительности.

Конфигурация дисковых массивов и используемые при этом технологии зависят от выбранного уровня RAID (RAID level). Уровни RAID стандартизированы в спецификации Common RAID Disk Data Format. Она описывает множество уровней RAID, однако самыми распространенными принято считать RAID0, RAID1, RAID5 и RAID6.

RAID0, или Stripes, — это уровень RAID, который объединяет два или более физических диска в один логический. Объем логического диска при этом равен сумме объемов физических дисков, входящих в массив. На этом уровне RAID отсутствует избыточность, а выход из строя одного диска может привести к потере всех данных в виртуальном диске.

Уровень RAID1, или Mirror, создает идентичные копии данных на двух и более дисках. Объем виртуального диска при этом не превышает объема минимального из физических дисков. Данные на виртуальном диске RAID1 будут доступны, пока хотя бы один физический диск из массива работает. Использование RAID1 добавляет избыточности, но является достаточно дорогим решением, так как в массивах из двух и более дисков доступен объем только одного.

Уровень RAID5 решает проблему дороговизны. Для создания массива с уровнем RAID5 необходимо как минимум 3 диска, при этом массив устойчив к выходу из строя одного диска. Данные в RAID5 хранятся блоками с контрольными суммами. Нет строгого деления на диски с данными и диски с контрольными суммами. Контрольные суммы в RAID5 — это результат операции XOR, примененной к N-1 блокам, каждый из которых взят со своего диска.

Хотя RAID-массивы повышают избыточность и предоставляют резервирование, они не подходят для хранения резервных копий.

После краткого экскурса по видам RAID-массивов можно переходить к устройствам и программам, которые позволяют собирать и использовать дисковые массивы.

Виды RAID-контроллеров

Существует два способа создать и использовать RAID-массивы: аппаратный и программный. Мы рассмотрим следующие решения:

- Linux Software RAID.

- Intel® Virtual RAID On CPU.

- LSI MegaRAID 9460-8i.

Linux Software RAID

Программные RAID-массивы в семействе ОС Linux — достаточно распространенное решение как в клиентском сегменте, так и в серверном. Все, что нужно для создания массива, — утилита mdadm и несколько блочных устройств. Единственное требование, которое предъявляет Linux Software RAID к используемым накопителям, — быть блочным устройством, доступным системе.

Отсутствие затрат на оборудование и программное обеспечение — очевидное преимущество данного способа. Linux Software RAID организует дисковые массивы ценой процессорного времени. Список поддерживаемых уровней RAID и состояние текущих дисковых массивов можно посмотреть в файле mdstat, который находится в корне procfs:

Поддержка уровней RAID добавляется подключением соответствующего модуля ядра, например:

Все операции с дисковыми массивами производятся через утилиту командной строки mdadm. Сборка дискового массива производится в одну команду:

После выполнения этой команды в системе появится блочное устройство /dev/md0, которое представляет из тебя виртуальный диск.Intel® Virtual RAID On CPU

![]()

Intel® VROC Standard Hardware Key

Intel® Virtual RAID On CPU (VROC) — это программно-аппаратная технология для создания RAID-массивов на базе чипсетов Intel®. Данная технология доступна в основном для материнских плат с поддержкой процессоров Intel® Xeon® Scalable. По умолчанию VROC недоступен. Для его активации необходимо установить аппаратный лицензионный ключ VROC.Стандартная лицензия VROC позволяет создавать дисковые массивы с 0, 1 и 10 уровнями RAID. Премиальная версия расширяет этот список поддержкой RAID5.

Технология Intel® VROC в современных материнских платах работает совместно с Intel® Volume Management Device (VMD), которая обеспечивает возможность горячей замены для накопителей с интерфейсом NVMe.

![]()

Intel® VROC со стандартной лицензией Настройка массивов производится через Setup Utility при загрузке сервера. На вкладке Advanced появляется пункт Intel® Virtual RAID on CPU, в котором можно настроить дисковые массивы.

![]()

Создание массива RAID1 на двух накопителях

Технология Intel® VROC имеет свои «козыри в рукаве». Дисковые массивы, собранные с помощью VROC, совместимы с Linux Software RAID. Это означает, что состояние массивов можно отслеживать в /proc/mdstat, а администрировать — через mdadm. Эта «особенность» официально поддерживается Intel. После сборки RAID1 в Setup Utility можно наблюдать синхронизацию накопителей в ОС:Отметим, что через mdadm нельзя собирать массивы на VROC (собранные массивы будут Linux SW RAID), но можно менять в них диски и разбирать массивы.

LSI MegaRAID 9460-8i

![]()

Внешний вид контроллера LSI MegaRAID 9460-8i

RAID-контроллер является самостоятельным аппаратным решением. Контроллер работает только с накопителями, подключенными непосредственно к нему. Данный RAID-контроллер поддерживает до 24 накопителей с интерфейсом NVMe. Именно поддержка NVMe выделяет этот контроллер из множества других.![]()

Главное меню аппаратного контроллера

При использовании режима UEFI настройки контроллера интегрируются в Setup Utility. В сравнении с VROC меню аппаратного контроллера выглядит значительно сложнее.![]()

Создание RAID1 на двух дисках

Объяснение настройки дисковых массивов на аппаратном контроллере является достаточно тонкой темой и может стать поводом для полноценной статьи. Здесь же мы просто ограничимся созданием RAID0 и RAID1 с настройками по умолчанию.Диски, подключенные в аппаратный контроллер, не видны операционной системе. Вместо этого контроллер «маскирует» все RAID-массивы под SAS-накопители. Накопители, подключенные в контроллер, но не входящие в состав дискового массива, не будут доступны ОС.

Несмотря на маскировку под SAS-накопители, массивы с NVMe будут работать на скорости PCIe. Однако такая особенность позволяет загружаться с NVMe в Legacy.Тестовый стенд

Каждый из способов организации дисковых массивов имеет свои физические плюсы и минусы. Но есть ли разница в производительности при работе с дисковыми массивами?

Для достижения максимальной справедливости все тесты будут проведены на одном и том же сервере. Его конфигурация:

- 2x Intel® Xeon® 6240;

- 12x DDR4-2666 16 GB;

- LSI MegaRAID 9460-8i;

- Intel® VROC Standard Hardware Key;

- 4x Intel® SSD DC P4510 U.2 2TB;

- 1x Samsung 970 EVO Plus M.2 500GB.

Тестирование

В первую очередь проверим задержки при работе с диском. Тест выполняется в один поток, размер блока 4 КБ. Каждый тест длится 5 минут. Перед началом для соответствующего блочного устройства выставляется none в качестве планировщика I/O. Команда fio выглядит следующим образом:

Из результатов fio мы берем clat 99.00%. Результаты приведены в таблице ниже.Случайное чтение, мкс Случайная запись, мкс Диск 112 78 Linux SW RAID, RAID0 113 45 VROC, RAID0 112 46 LSI, RAID0 122 63 Linux SW RAID, RAID1 113 48 VROC, RAID1 113 45 LSI, RAID1 128 89 Помимо задержек при обращении к данным, хочется увидеть производительность виртуальных накопителей и сравнить с производительностью физического диска. Команда для запуска fio:

Производительность измеряется в количестве операций ввода-вывода. Результаты представлены в таблице ниже.Случайное чтение 1 поток, IOPS Случайная запись 1 поток, IOPS Случайное чтение 128 потоков, IOPS Случайная запись 128 потоков, IOPS Диск 11300 40700 453000 105000 Linux SW RAID, RAID0 11200 52000 429000 232000 VROC, RAID0 11200 52300 441000 162000 LSI, RAID0 10900 44200 311000 160000 Linux SW RAID, RAID1 10000 48600 395000 147000 VROC, RAID1 10000 54400 378000 244000 LSI, RAID1 11000 34300 229000 248000 Легко заметить, что использование аппаратного контроллера дает увеличение задержек и просадку по производительности в сравнении с программными решениями.

Заключение

Использование аппаратных решений для создания дисковых массивов из двух дисков выглядит нерационально. Тем не менее, существуют задачи, где использование RAID-контроллеров оправдано. С появлением контроллеров с поддержкой интерфейса NVMe у пользователей появляется возможность использовать более быстрые SSD в своих проектах.

Читайте также: