Background initialization raid что это

Обновлено: 07.07.2024

В утилите Intel® RAID Web Console нет возможности инициализации тома RAID, созданного с Intel® RAID-контроллерами с использованием встроенного ПО Integrated RAID (IR), такого как:

- Intel® RAID Controller RS3UC080

- Intel® RAID Controller RS3FC044

- Intel® RAID Controller RS25FB044

- Интегрированный RAID®-модуль Intel® RMS3JC080

- Интегрированный RAID®-модуль Intel® RMS25JB040

- Интегрированный RAID®-модуль Intel® RMS25JB080

- Интегрированный RAID®-модуль Intel® RMS25KB040

- Интегрированный RAID®-модуль Intel® RMS25KB080

- Intel® Integrated Server RAID Module AXXRMS2LL080

ИК-контроллер — это контроллер начального Intel® RAID Controller с поддержкой уровней RAID 0, 1, 10, 1E.

Нет необходимости запускать инициализацию вручную. Intel RAID Controller микропрограммного обеспечения IR автоматически запускается инициализация фона после создания тома RAID.

После создания тома RAID дождись некоторого времени и обновите Intel RAID Web Console. Затем в фоновом процессе должна быть запущена инициализация.

| Связанная тема |

| Руководство пользователя для Intel RAID/систем хранения |

Другие продукты

Эта статья относится к 4 продукция.

Продукция, выпуск которой прекращен

Вам нужна дополнительная помощь?

Оставьте отзыв

Содержание данной страницы представляет собой сочетание выполненного человеком и компьютерного перевода оригинального содержания на английском языке. Данная информация предоставляется для вашего удобства и в ознакомительных целях и не должна расцениваться как исключительная, либо безошибочная. При обнаружении каких-либо противоречий между версией данной страницы на английском языке и переводом, версия на английском языке будет иметь приоритет и контроль. Посмотреть английскую версию этой страницы.

Для работы технологий Intel может потребоваться специальное оборудование, ПО или активация услуг. // Ни один продукт или компонент не может обеспечить абсолютную защиту. // Ваши расходы и результаты могут отличаться. // Производительность зависит от вида использования, конфигурации и других факторов. // См. наши юридические уведомления и отказ от ответственности. // Корпорация Intel выступает за соблюдение прав человека и избегает причастности к их нарушению. См. Глобальные принципы защиты прав человека в корпорации Intel. Продукция и программное обеспечение Intel предназначены только для использования в приложениях, которые не приводят или не способствуют нарушению всемирно признанных прав человека.

Организация единого дискового пространства — задача, легко решаемая с помощью аппаратного RAID-контроллера. Однако следует вначале ознакомиться с особенностями использования и управления таким контроллером. Об этом сегодня расскажем в нашей статье.

Надежность и скорость работы дисковых накопителей — вопрос, волнующий каждого системного администратора. Несмотря на заверения производителей о качестве собственных устройств — HDD и SSD продолжают выходить из строя в самое неподходящее время, теряя драгоценные данные. Технология S.M.A.R.T. в большинстве случаев дает возможность оценить «здоровье» накопителя, но это не гарантирует того, что диск будет продолжать беспроблемно работать.

Предсказать выход диска из строя со 100%-ой точностью невозможно, поэтому следует предусмотреть вариант, при котором это не станет проблемой или причиной остановки сервисов. Использование RAID-массивов решает эту задачу. Рассмотрим три основных подхода, применяющихся для этой задачи:

- Программный RAID — наименее затратный вариант, но и наименее производительный. Массив создается средствами операционной системы, вся нагрузка по обработке данных «ложится на плечи» центрального процессора.

- Интегрированный аппаратный RAID (еще его часто называют Fake-RAID) — микрочип, установленный на материнскую плату, который берет на себя часть функционала аппаратного RAID-контроллера, работая в паре с центральным процессором. Этот подход работает чуть быстрее, чем программный RAID, но надежность у такого массива оставляет желать лучшего.

- Аппаратный RAID — это отдельный контроллер с собственным процессором и кэширующей памятью, полностью забирающий на себя выполнение всех дисковых операций. Наиболее затратный, однако, самый производительный и надежный вариант для использования.

Внешний вид

Мы выбрали решения Adaptec от компании Microsemi. Это RAID-контроллеры, зарекомендовавшие себя удобством использования и высокой производительностью. Их мы устанавливаем, если наш клиент решил заказать сервер произвольной или фиксированной конфигурации.

Для подключения дисков используются специальные интерфейсные кабели. Со стороны контроллера используются разъемы SFF8643. Каждый кабель позволяет подключить до 4-х дисков SAS или SATA (в зависимости от модели). Помимо этого интерфейсный кабель еще имеет восьмипиновый разъем SFF-8485 для шины SGPIO, о назначении которой поговорим чуть позже.

Помимо самого RAID-контроллера существует еще два дополнительных устройства, позволяющих увеличить надежность:

-

BBU (Battery Backup Unit) — модуль расширения с литий-ионной батареей, позволяющий поддерживать напряжение на энергозависимой микросхеме кэша. В случае внезапного обесточивания сервера его использование позволяет временно сохранить содержимое кэша, которое еще не было записано на диски.

Это особенно важно, когда включен режим отложенной записи кэша (Writeback). При пропадании электропитания содержимое кэша не будет сброшено на диски, что приведет к потере данных и, как следствие, штатная работа дискового массива будет нарушена.

Технические характеристики

Температура

Вначале хотелось бы затронуть такую важную вещь, как температурный режим аппаратных RAID-контроллеров Adaptec. Все они оснащены небольшими пассивными радиаторами, что может вызвать ложное представление о небольшом тепловыделении.

Производитель контроллера приводит в качестве рекомендуемого значения воздушного потока — 200 LFM (linear feet per minute), что соответствует показателю 8,24 литра в секунду (или 1,02 метра в секунду). Рассчитаны такие контроллеры исключительно на установку в rackmount-корпусы, где такой воздушный поток создается скоростными штатными кулерами.

От 0°C до 40-55°C — рабочая температура большинства RAID-контроллеров Adaptec (в зависимости от наличия установленных модулей), рекомендованная производителем. Максимальная рабочая температура чипа составляет 100°C. Функционирование контроллера при повышенной температуре (более 85°C) может вывести его из строя. Удобства ради приводим под спойлером табличку рекомендуемых температур для разных серий контроллеров Adaptec.

| Series 2 (2405, 2045, 2805) and 2405Q | 55°C без модулей |

| Series 5 (5405, 5445, 5085, 5805, 51245, 51645, 52445) | 55°C без батарейного модуля, 40°C с батарейным модулем ABM-800 |

| Series 5Z (5405Z, 5445Z, 5805Z, 5805ZQ) | 50°C с модулем ZMCP |

| Series 5Q (5805Q) | 55°C без батарейного модуля, 40°C с батарейным модулем ABM-800 |

| Series 6E (6405E, 6805E) | 55°C без модулей |

| Series 6/6T (6405, 6445, 6805, 6405T, 6805T) | 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-600 |

| Series 6Q (6805Q, 6805TQ) | 50°C с ZMCP модулем AFM-600 |

| Series 7E (71605E) | 55°C без модулей |

| Series 7 (7805, 71605, 71685, 78165, 72405) | 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-700 |

| Series 7Q (7805Q, 71605Q) | 50°C с ZMCP модулем AFM-700 |

| Series 8E (8405E, 8805E) | 55°C без модулей |

| Series 8 (8405, 8805, 8885) | 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-700 |

| Series 8Q (8885Q, 81605Z, 81605ZQ) | 50°C с ZMCP модулем AFM-700 |

Нашим клиентам не приходится беспокоиться о перегреве контроллеров, поскольку в наших дата-центрах поддерживается постоянный температурный режим, а сборка серверов произвольной конфигурации происходит с учетом особенностей таких комплектующих (о чем мы упоминали в нашей предыдущей статье).

Скорость работы

Для того чтобы продемонстрировать, как наличие аппаратного RAID-контроллера способствует увеличению скорости работы сервера, мы решили собрать тестовый стенд со следующей конфигурацией:

- CPU Intel Xeon E3-1230v5;

- RAM 16 Gb DDR4 2133 ECC;

- 4 HDD емкостью по 1 ТБ.

Затем в этот же стенд поставим RAID-контроллер Adaptec ASR 7805 с модулем защиты кэша AFM-700, подключим к нему эти же жесткие диски и выполним точно такое же тестирование.

С программным RAID

Несомненное преимущество программного RAID — простота использования. Массив в ОС Linux создается с помощью штатной утилиты mdadm. При установке операционной системы чаще всего создание массива предусмотрено непосредственно из установщика. В случае, когда такой возможности установщик не предоставляет, достаточно всего лишь перейти в соседнюю консоль с помощью сочетания клавиш Ctrl+Alt+F2 (где номер функциональной клавиши — это номер вызываемой tty).

Создать массив очень просто. Командой fdisk -l смотрим, какие диски присутствуют в системе. В нашем случае это 4 диска:

Проверяем, чтобы на дисках не было метаданных, например, от предыдущего массива:

В случае, если на одном или нескольких дисках будут метаданные, удалить их можно следующим образом (где sdX — требуемый диск):

Создадим на каждом диске разделы для будущего массива c помощью fdisk. В качестве типа раздела следует указать fd (Linux RAID autodetect).

Собираем массив RAID 10 из созданных разделов с помощью команды:

Сразу после этого будет создан массив /dev/md0 и будет запущен процесс перестроения данных на дисках. Для отслеживания текущего статуса процесса введите:

Пока процесс перестроения данных не будет завершен, скорость работы дискового массива будет снижена.

После установки операционной системы и Bitrix24 на созданный массив мы запустили стандартный тест и получили следующие результаты:

С аппаратным RAID

Прежде чем сервер сможет использовать единое дисковое пространство RAID-массива, необходимо выполнить базовую настройку контроллера и логических дисков. Сделать это можно двумя способами:

- при помощи внутренней утилиты контроллера,

- утилитой из операционной системы.

Утилита позволяет не только управлять настройками контроллера, но и логическими устройствами. Инициализируем физические диски (вся информация на дисках при инициализации будет уничтожена) и создадим массив RAID-10 с помощью раздела Create Array. При создании система запросит желаемый размер страйпа, то есть размер блока данных за одну I/O-операцию:

- больший размер страйпа идеален для работы с файлами большого размера;

- меньший размер страйпа подойдет для обработки большого количества файлов небольшого размера.

Важно — размер страйпа задается только один раз (при создании массива) и это значение в дальнейшем изменить нельзя.

Сразу после того, как контроллеру отдана команда создания массива, также, как и с программным RAID, начинается процесс перестроения данных на дисках. Этот процесс работает в фоновом режиме, при этом логический диск становится сразу доступен для BIOS. Производительность дисковой подсистемы будет также снижена до завершения процесса. В случае, если было создано несколько массивов, то необходимо определить загрузочный массив с помощью сочетания клавиш Ctrl + B.

После того как статус массива изменился на Optimal, мы установили Bitrix24 и провели точно такой же тест. Результат теста:

Сразу становится понятно, что аппаратный RAID-контроллер ускоряет операции чтения и записи на дисковый носитель за счет использования кэша, что позволяет быстрее обрабатывать массовые обращения пользователей.

Управление контроллером

Непосредственно из операционной системы управление контроллером производится с помощью программного обеспечения, доступного для скачивания с сайта производителя. Доступны варианты для большинства операционных систем и гипервизоров:

- Debian,

- Ubuntu,

- Red Hat Linux,

- Fedora,

- SuSE Linux,

- FreeBSD,

- Solaris,

- Microsoft Windows,

- Citrix XenServer,

- VMware ESXi.

С помощью указанных утилит можно, не прерывая работу сервера, легко управлять логическими и физическими дисками. Также можно задействовать такой полезный функционал, как «подсветка диска». Мы уже упоминали про пятый кабель для подключения SGPIO — этот кабель подключается напрямую в бэкплейн (от англ. backplane — соединительная плата для накопителей сервера) и позволяет RAID-контроллеру полностью управлять световой индикацей каждого диска.

Следует помнить, что бэкплэйны поддерживают не только SGPIO, но и I2C. Переключение между этими режимами осуществляется чаще всего с помощью джамперов на самом бэкплэйне.

Каждому устройству, подключенному к аппаратному RAID-контроллеру Adaptec, присваивается идентификатор, состоящий из номера канала и номера физического диска. Номера каналов соответствуют номерам портов на контроллере.

Замена диска — штатная операция, впрочем, требующая однозначной идентификации. Если допустить ошибку при этой операции, можно потерять данные и прервать работу сервера. С аппаратным RAID-контроллером такая ошибка является редкостью.

Делается это очень просто:

-

Запрашивается список подключенных дисков к контроллеру:

Например, на платформах Supermicro штатная работа диска — зеленый или синий цвет, а «подсвеченный» диск будет моргать красным. Перепутать диски в этом случае невозможно, что позволит избежать ошибки из-за человеческого фактора.

Настройка кэширования

Теперь пару слов о вариантах работы кэша на запись. Вариант Write Through означает, что контроллер сообщает операционной системе об успешном выполнении операции записи только после того, как данные будут фактически записаны на диски. Это повышает надежность сохранности данных, но никак не увеличивает производительность.

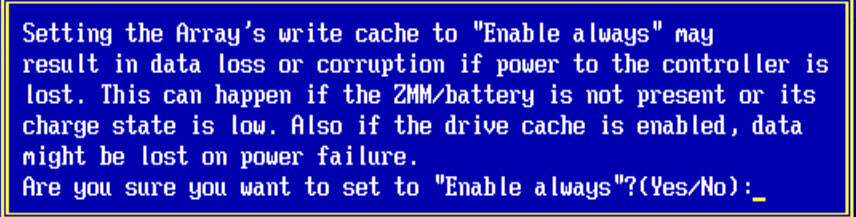

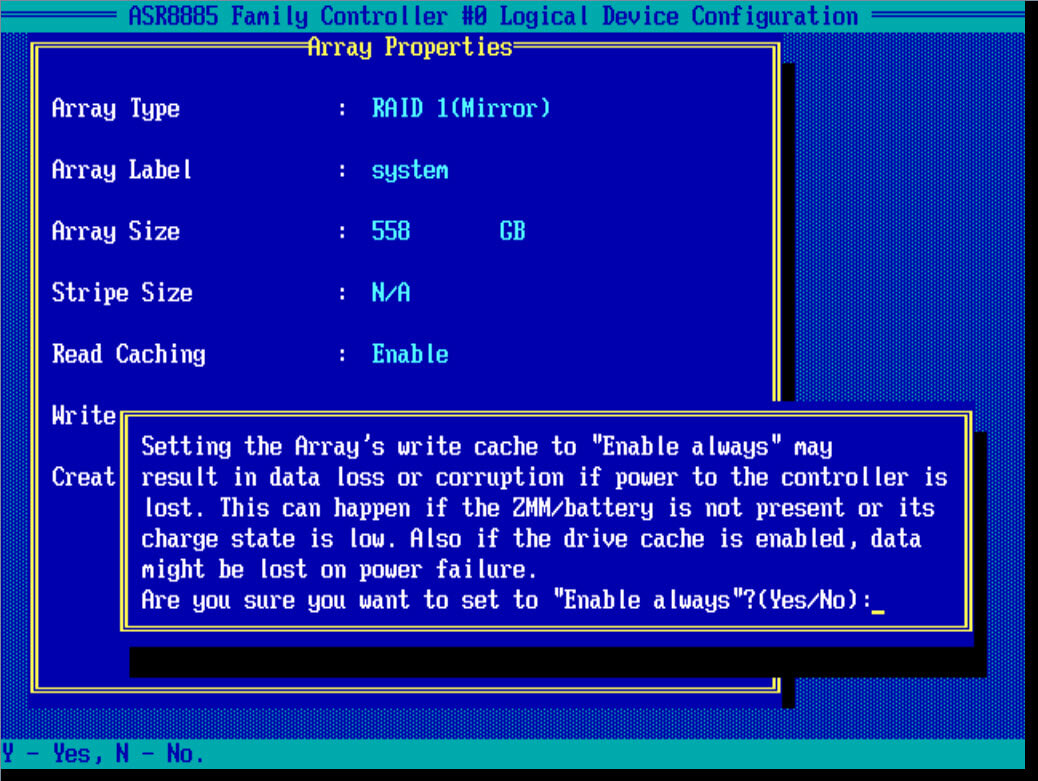

Чтобы достичь максимальной скорости работы, необходимо использовать вариант Write Back. При такой схеме работы контроллер будет сообщать операционной системе об успешной IO-операции сразу после того, как данные поступят в кэш.

Важно — при использовании Write Back настоятельно рекомендуется использовать BBU или ZMCP-модуль, поскольку без него при внезапном отключении электричества часть данных может быть утеряна.

Настройка мониторинга

Вопрос мониторинга статуса работы оборудования и возможности оповещения стоит достаточно остро для любого системного администратора. Для того чтобы настроить «связку» из Zabbix и RAID-контроллера Adaptec рекомендуем воспользоваться перечисленными решениями.

Зачастую требуется отслеживать состояние контроллера напрямую из гипервизора, например, VMware ESXi. Задача решается с помощью установки CIM-провайдера с помощью инструкции Microsemi.

Прошивка

Необходимость прошивки RAID-контроллера возникает чаще всего для исправления выявленных производителем проблем с работой устройства. Несмотря на то, что прошивки доступны для самостоятельного обновления, к этой операции следует подойти очень ответственно, особенно если процедура выполняется на «боевой» системе.

Если нашему клиенту требуется сменить версию прошивки контроллера, то ему достаточно создать тикет в нашей панели управления. Системные инженеры выполнят перепрошивку RAID-контроллера до требуемой версии в указанное время и сделают это максимально корректно.

Важно — не следует выполнять перепрошивку самостоятельно, поскольку любая ошибка может привести к потере данных!

Заключение

Использование аппаратного RAID-контроллера оправдано в большинстве случаев, когда требуется высокая скорость и надежность работы дисковой подсистемы.

Системные инженеры Selectel бесплатно выполнят базовую настройку дискового массива на аппаратном RAID-контроллере при заказе сервера произвольной конфигурации. В случае, если потребуется дополнительная помощь с настройкой, мы будем рады помочь в рамках нашей услуги администрирования. Также мы подготовили для наших читателей небольшую памятку по командам утилиты arcconf.

Хранение объемных данных — занятие хлопотное. Совет вроде «купи Netapp (Dell/EMC, HPE) — и нет проблем» плох тем, что подменяет повестку в головах администраторов систем хранения: разбор трафика данных и угроз их сохранности — на сравнение готовых решений и условий сервисных контрактов при них.

Данные неравноценны. Их согласованное хранение на разноскоростных носителях лежит в основе иерархических систем сопровождения жизненного цикла информации.

Самые ожесточенные технологические сражения идут за «горячие» данные: критичные транзакции перемещаются все ближе к обрабатывающим процессорам. Именно там обыгрываются сценарии хранения с низкими задержками обращения (RAM, Optane, NAND).

К сожалению, общую массу данных на SSD-накопители не перенесешь, и она стремительно растет в объеме: прибывает новый контент, вовлекаются в активный оборот архивные отложения (операционная деятельность, аналитика, big data). Динамическое извлечение «горячего» ядра из общей массы становится отдельным искусством в пределах специфических отраслевых решений, но основное тело данных как лежало, так и лежит на типовых массивах HDD. И оно не такое уж «холодное», это тело.

Отвязав задачу производительного брутто-хранения (bulk storage) на емких механических дисках от программных ускорителей с использованием флэш-памяти и RAM, освежим в памяти базовые принципы обустройства дисковых массивов.

1. Уровни RAID

Изначально RAID был аппаратной технологией. Современные программные реализации RAID в составе ОС хранения опираются на вычислительную мощность процессоров, не так привязаны к оборудованию и богаче функционально. Какими быть серверам хранения — на аппаратных контроллерах или программно-определяемыми, зависит от роли серверов, приложений окружения, бюджета.

При нынешней емкости HDD изжил себя RAID 5 с одной четностью и его производные. Потеря диска переводит массив RAID 5 в деградированное состояние на несколько суток. При повторном отказе во время долгой реконструкции пользователь рискует остаться без данных. Компромисс между производительностью, надежностью и ценой хранения дают RAID 6, RAID DP (NetApp), RAID Z2 (ZFS). Они могут восстановить информацию при отказе двух дисков в одной группе.

Это ненадолго. Пропорционально емкости дисков растет вероятность ошибок чтения (Unrecoverable read error, URE), подрывая будущие перспективы и RAID 6 тоже:

Разработчики ОС для СХД идут дальше, предлагая массивы с тройным распределением четности RAID 7.3 (RAIDIX) и RAID Z3 (ZFS), способные пережить потерю трех дисков. Есть реализации массивов RAID N+M с произвольным распределением четности, когда пользователь сам определяет количество дисков, выделяемых под хранение контрольных сумм.

2. Размер дисковой группы

Слово NetApp: «Настройка оптимального размера группы RAID требует компромисса факторов. Вы должны решить, что именно: скорость восстановления RAID, гарантия от потери данных из-за сбоя диска, оптимизация производительности ввода-вывода или увеличение пространства для хранения данных для вас важнее.

Создавая большие группы RAID, вы максимизируете пространство, доступное для хранения данных, при постоянном объеме хранилища под четности («налог на четность»). С другой стороны, когда выходит из строя диск в более крупной группе RAID, увеличивается время восстановления — что влияет на производительность в долгосрочной перспективе. Кроме того, чем больше дисков в группе RAID — тем выше вероятность сбоя нескольких дисков группы».

В общем случае, чем больше дисков — тем выше производительность, но и вычислительная нагрузка на контроллер или CPU/RAM выше.

NetApp рекомендует создавать группы RAID-DP из 20…28 HDD. Adaptec говорит о максимум 32 дисках в RAID 6.

3. Емкость дисков

Чем больше объем диска в RAID-группе — тем выше «налог на четность» (RAID 6 тратит под контрольные суммы емкость двух дисков) и дольше восстановление. Чем короче дисковая группа — тем ниже производительность. Оптимальный баланс размера дисковых групп и емкости дисков приходится выбирать самому пользователю. Например, общую емкость 96TB можно получить несколькими способами: 24 x 4TB, 16 x 8TB или 8 x 12TB:

| Дисковая группа RAID6 | Эффективная емкость | Производительность | Среднее время реконструкции |

| 24 х 4 TB | 88 TB (96 TB – 2 x 4 TB) | Высокая | Сутки |

| 16 х 8 TB | 80 TB (96 TB – 2 x 8 TB) | Средняя | Двое суток |

| 8 х 12 TB | 72 TB (96 TB – 2 x 12 TB) | Ниже среднего | Трое суток |

4. Заполнение массива данными

Слово Oracle: «В файловой системе Oracle Solaris ZFS запись перенаправляется на свободные блоки, поэтому для записи новых данных требуется некоторое пространство. Общая рекомендация: не заполнять пулы хранения ZFS больше, чем на 90% — во избежание потерь производительности. На практике, это значение плавающее и привязано к рабочим нагрузкам:

- Если данные в основном добавляются (разовая запись, без удаления), пустые блоки найти легко — за ориентир можно взять, скажем, 95%;

- Аналогичным правилом можно руководствоваться, если данные добавляются большими файлами/блоками 128K-1M и удаляются скопом;

- С другой стороны, если большая доля данных (свыше 50%) адресуется с размером блока данных 8К (файлы DB, iSCSI LUNs, много маленьких файлов) с постоянной перезаписью (динамические данные), тогда правилу 90% надо следовать строго:

- Если 100% данных — динамические, с малым размером блока, то пулы надо тщательно мониторить, возможно, начиная с 80% заполнения».

ZFS создавалась с использований идей, лежащих в основе WAFL — файловой системы ОС Data ONTAP систем хранения данных NetApp, в том числе COW (Сopy On Write — записи на свободное место). Рекомендации NetApp (WAFL + RAID-DP) по заполнению пулов данными примерно такие же, как у Oracle.

RAIDIX относится к классическому типу хранилищ ROW (с перезаписью по месту), ориентирован на потоковые операции, но и там разработчики советуют внимательно следить за остатком свободного места на дисках.

5. Скорость реконструкции массива

На производительность штатных операций ввода-вывода влияет изменение статуса логических томов в процессе работы. Массив, перешедший в деградированное состояние после отказа диска, работает медленнее — реконструкция данных отнимает ресурсы процессора ввода-вывода.

Например, в RAID-контроллерах Adaptec можно расставить приоритеты, изменяя параметры Transformation Priority и Rebuild Priority в меню Modify Controller Settings:

При нынешних емкостях дисков восстановление массивов идет сутками, в разных моделях управления данными по-разному. Администратор обязан оценивать урон от нештатных ситуаций.

Некоторые ОС для СХД позволяют восстанавливать локальные области, а не массив целиком — тем самым сокращая общее время реконструкции. Пространство массива разбивается на части, по которым отслеживаются изменения. Восстановление данных происходит только в тех зонах, где было зафиксировано изменение блоков данных.

6. «Тихие» ошибки

У всех дисков в списке характеристик есть статистический параметр Unrecoverable Read Errors (URE) — вероятность ошибок чтения данных с поверхности дисков — из-за ее повреждений, старения, космических лучей, расположения звезд. Для Enterprise SATA/NL SAS допускается один непрочитанный бит на 10 15 , или один сектор из примерно 244 миллионов. Наткнуться на битый сектор при штатной работе RAID маловероятно, но восстановление RAID после аварии подразумевает большое количество операций чтения. Попадись URE, данные соответствующего блока не будут восстановлены, что приведет к несостоятельности данных.

Калькуляторы расчета вероятности ошибок, с привязкой к емкости дисков и сроку эксплуатации дают высокие шансы получить однажды тыкву вместо кареты. Не случайно в файловую систему ZFS, рассчитанную под емкие хранилища, создатели встроили контроль целостности данных. RAIDIX тоже обнаруживает и исправляет скрытые ошибки во время выполнения обычных дисковых операций путем анализа RAID-метаданных. Сканирование и исправление выполняется в фоновом режиме в периоды низкой активности СХД.

7. Контроль отклика дисков

Контроль отклика дисков (задержек обращения к ним) нужен для поддержания стабильной производительности и профилактики урона от старения дисков: их своевременная замена упредит разрушение массива и фатальную потерю данных.

Выросшая латентность даже одного из дисков тянет вниз производительность всего RAID массива. Режим упреждающей реконструкции RAIDIX Advanced Reconstruction подчеркивает целевое позиционирование этой ОС для СХД под видеопроизводство: для стабильно высокой скорости передачи потоков важны ровные характеристики отклика по всей дисковой группе. Исключив диски с худшим, чем у остальных, откликом, и перестроив массив загодя, можно оптимизировать скорость чтения.

Разработчики RAID позволяют проверять отклик дисков автоматически или вручную. Дополнительная нагрузка на процессор ввода-вывода может снижать производительность массива. Когда диски новые, проверки можно и отключить, если же хранилище возрастное — лучше обезопасить себя от неожиданностей и диагностику не выключать.

8. Инициализация массива

Инициализация — это процесс преобразования исходного массива физических дисков в состоятельные логические тома (с целостными, внутренне непротиворечивыми данными). Выполняется для повышения производительности и надежности хранения. У разработчиков аппаратных и программных RAID свои алгоритмы инициализации, быстрой или полной — с проверками целостности данных.

Прирост производительности достигается за счет обновления метаданных на физических дисках, в том числе, освобождением места под будущие операции записи. Надежности способствует:

- очистка всего объема дисков от «недружелюбных» метаданных — если они присутствовали на дисках;

- обнаружение скрытого повреждения данных (Silent Data Corruption») — при полной инициализации;

- контроль согласованности данных (проверяется четность или зеркальная копия данных) — при полной инициализации;

- проверками целостности данных.

Построение RAID-массива без инициализации или с быстрой инициализацией (например, затиранием нулями данных), экономит время на старте, но чревато ошибками в будущем. Многие аппаратные контроллеры не позволяют создавать массивы без инициализации.

Рекомендована полная инициализация, хотя на нее может уйти несколько суток. Она может быть фоновой (background initialization), с изменяемым приоритетом исполнения массивом основных задач над инициализацией. При нулевом приоритете инициализация выполняется в паузах активности.

9. Настройка уведомлений

При изменении состояния массива все аппаратные RAID-контроллеры и программные реализации могут в автоматическом режиме включать звуковую и визуальную сигнализацию ( подсвечивать карман с диском ), присылать уведомления и логи на почту. Администраторы, оставляющие массивы без удаленного контроля, преступно небрежны. Надо ли потом удивляться потерям данных в результате последовательного отказа нескольких дисков?

Настройка уведомлений выглядит у всех примерно одинаково:

Заполняются поля: от кого, кому, на какие порты будут приходить уведомления, их тип. При необходимости, прикрепляются журналы событий, критических ошибок, предупреждений.

10. Профилактика

Жесткие диск, как механическое устройство хранения информации — потенциальная точка отказа. Обычно это происходит из-за износа магнитной поверхности пластин. Внезапные отказы редки, если не пренебрегать диагностикой, их можно упреждать. Предусмотрительность снижает издержки: реконструкции массива или восстановления информации с развалившейся структуры RAID.

Для анализа запоминающий свойств носителей информации выполняются диагностические процедуры и вычитываются S.M.A.R.T. атрибуты дисков:

В данном примере тестировались диски «из коробки» — потому для всех 11127 операций чтения значение латентности не превышает 25…40 ms. Смещение отклика по конкретному диску в правые зоны — сигнал к его замене. Накопитель будет тормозить весь массив, и это потенциальный «cмертник».

Всем привет, рад, что вы решили посмотреть вторую часть статьи по настройке и созданию raid массивов на контроллере adaptec raid 8885. Сегодня мы будем рассматривать, самые распространенные виды RAID, со всеми нюансами и рекомендациями, которые предписывают производители железа, но в любом случая, я вас призываю не верить на слово и производить свое тестирование со всеми настройками.

И так общие настройки для контроллера посмотрите в первой части настройки adaptec raid 8885.

Инициализация дисков

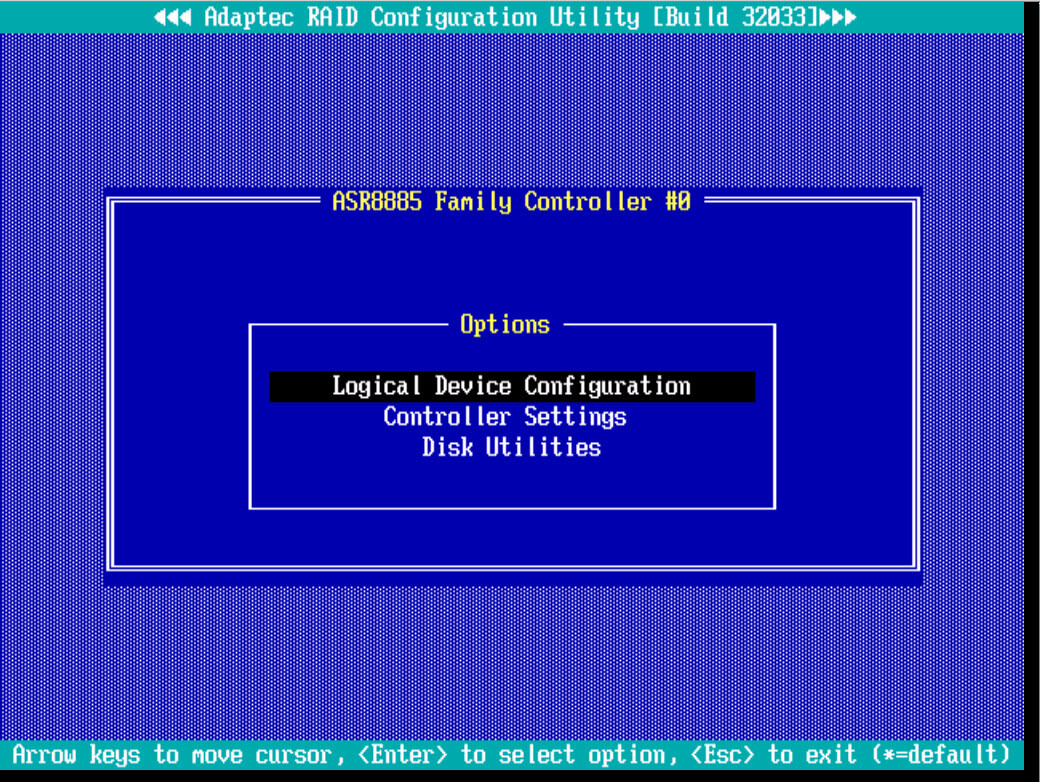

Выбираем в главном меню пункт Logical Device Configuration

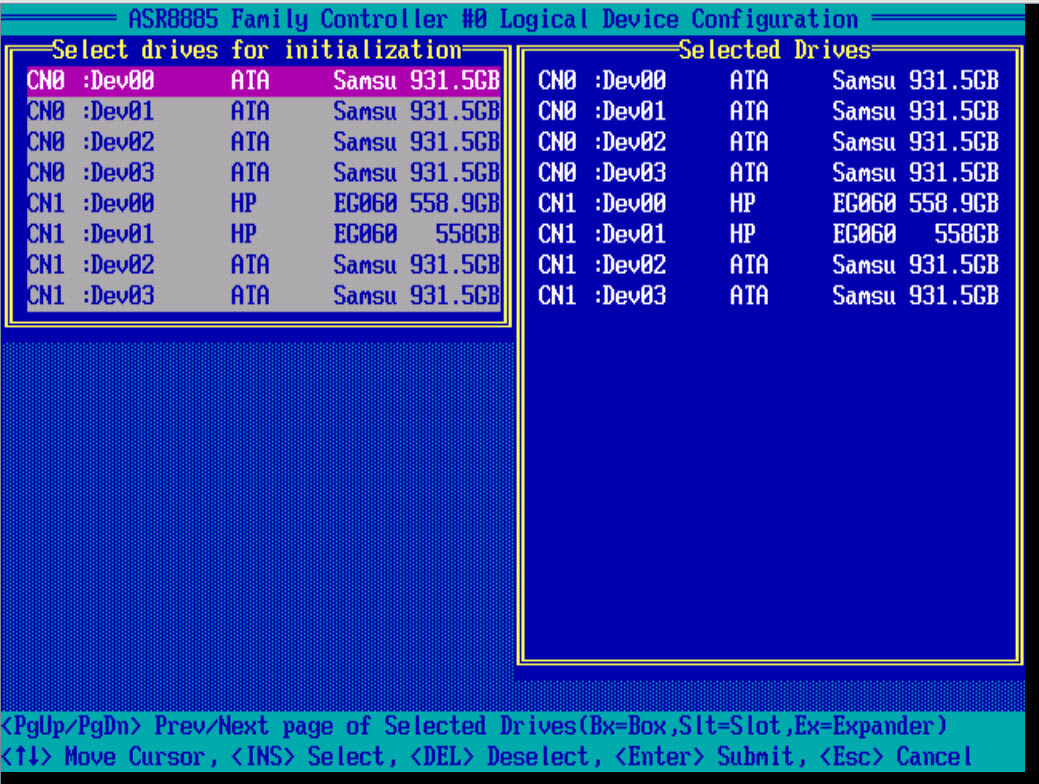

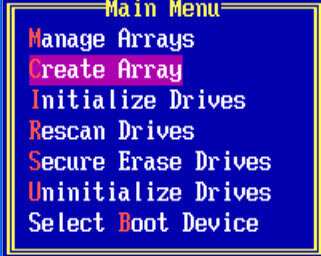

Первым делом, что бы вы могли создать создать raid массив, вам нужно проинициализировать ваши диски, для этого выбираем initialize Drives.

Пробелом выбираем нужный диск, он сразу будет у вас отображаться в правой части окна. Для подтверждения выбора жмем Enter.

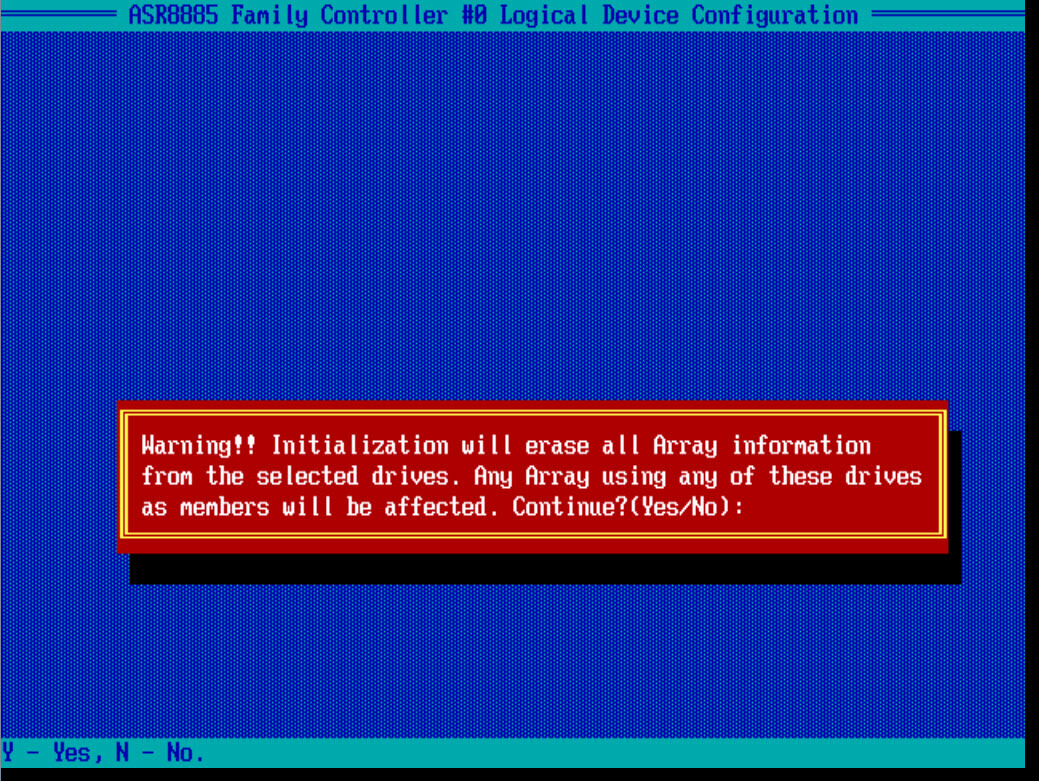

Вас предупредят, что вся информация с дисков будет удалена, жмем Y и соглашаемся

Как создать raid

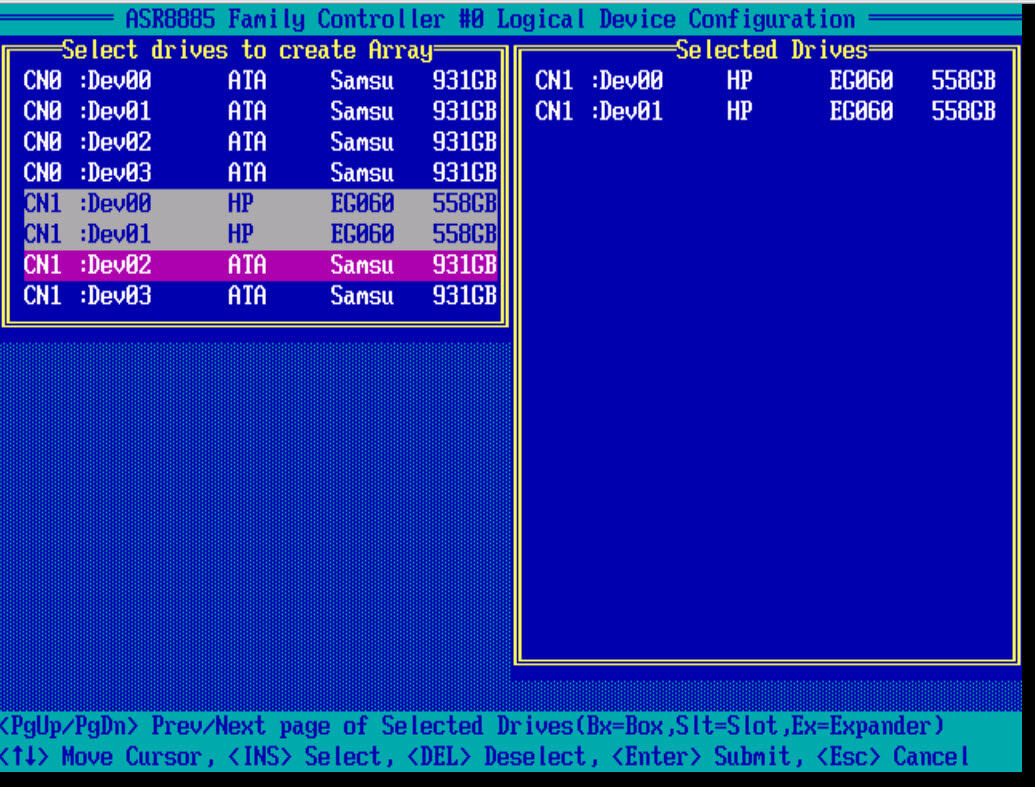

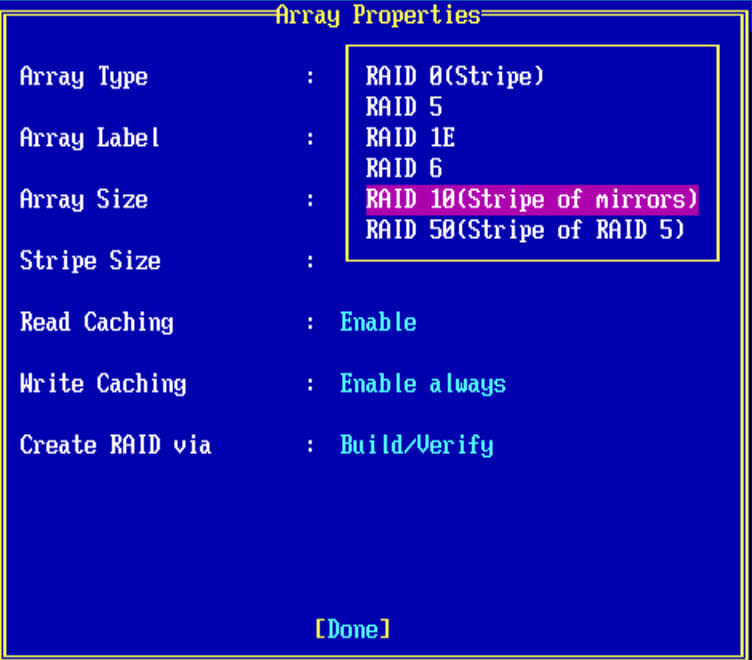

И так давайте рассмотрим как создать raid на данном контроллере adaptec. После инициализации рассмотрим создание RAID 0 и RAID 1 под систему, почитать по виды RAID можно по ссылке слева. Выбираем Create Array.

Создаем RAID 0

Создать raid массив 0, можно из любого количества дисков или твердотельных SSD. Я выбираю пробелом два HP SAS диска по 600 гб.

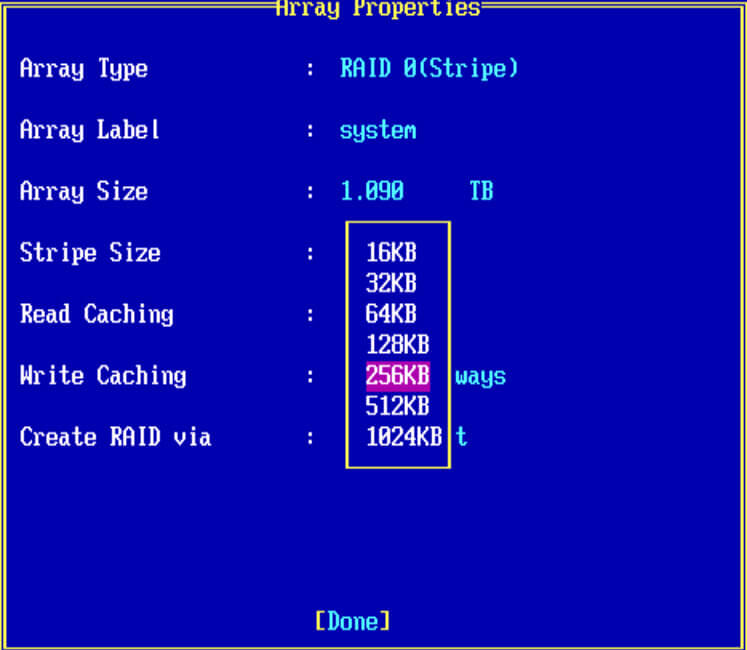

- Выбираем RAID 0

- в Array Label можно написать предназначение массива

- Array Size > указываете нужный вам размер

- Stripe Size > размер блока, может принимать разные значения от 16-1024 кб, все зависит от задачи

- Read Cachin > кэш на чтение

- Write Caching > кэш на запись, про оба кэша в конце статьи.

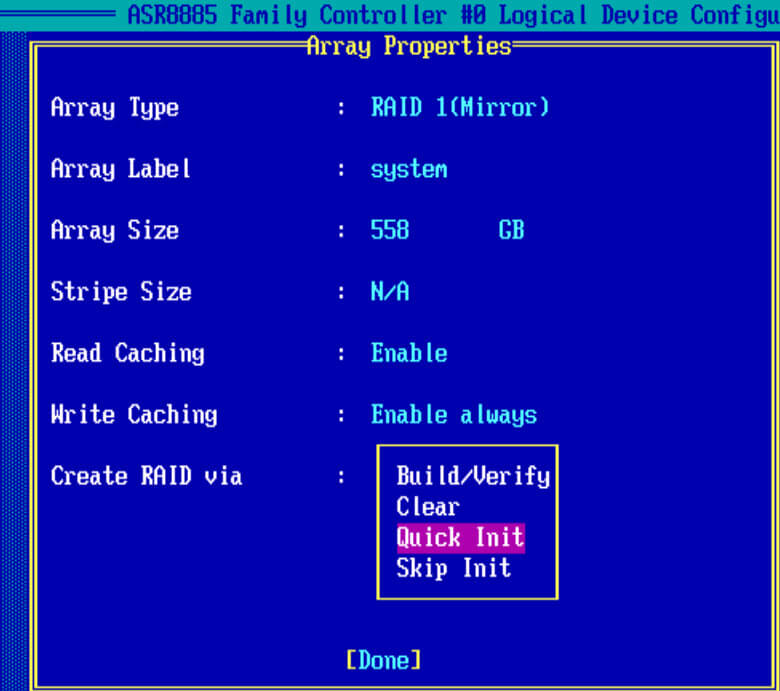

- Criate RAID via > инициализация массива.

Жмем enter, вас предупредят, что все данные у вас будут уничтожены.

Я настоятельно рекомендую использовать данный вид рейд, только в тестовых целях, так как отказоустойчивость у него нулевая, выше я дал ссылку на виды рейд, почитайте их принципы

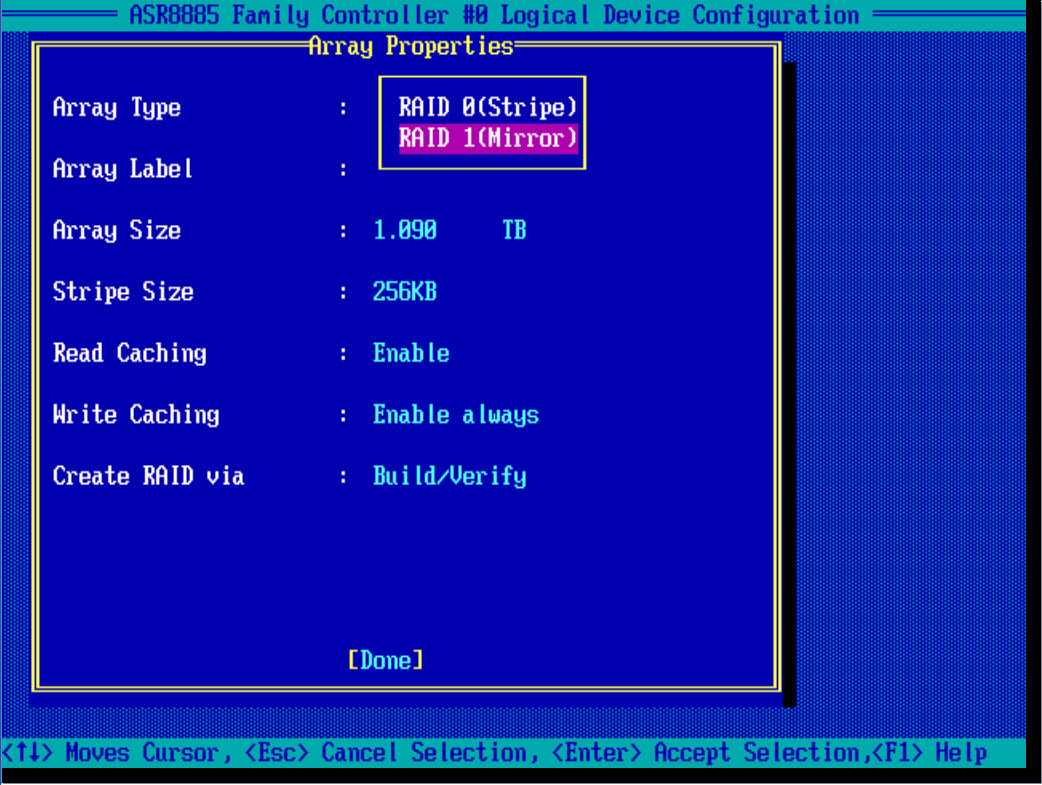

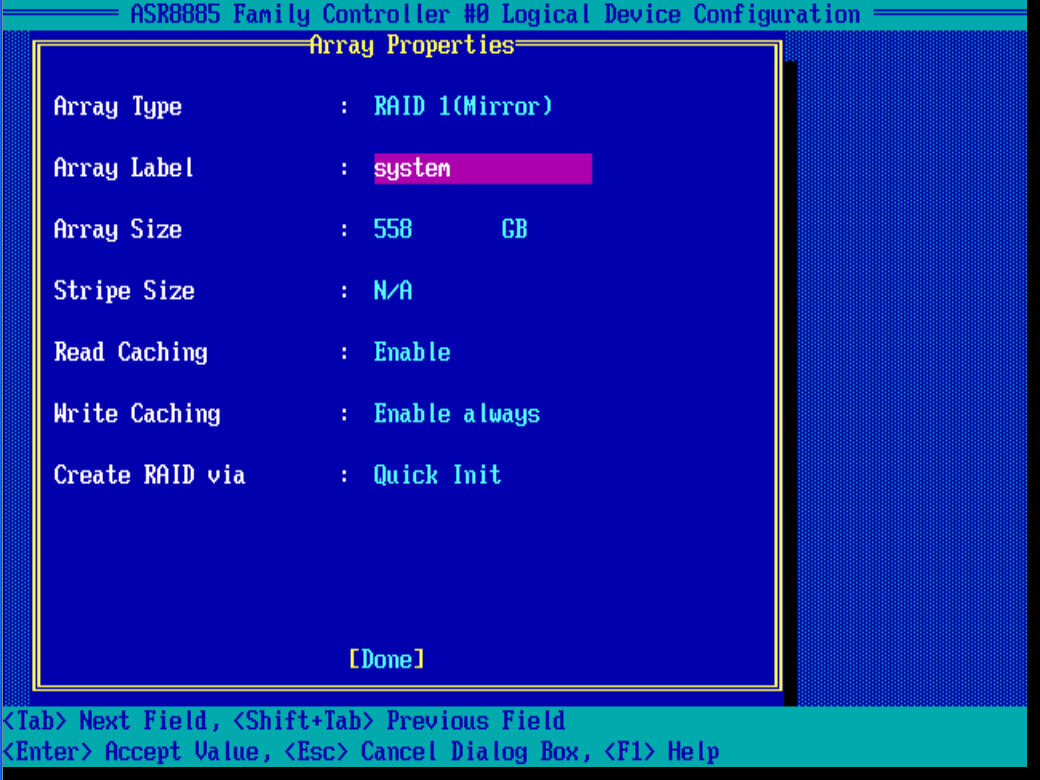

Создаем RAID 1

И так, так же как и с 0 рейдом, создадим на контроллере adaptec, зеркальный массив под установку системы. В Array Type выбираем RAID 1 (Mirror), для его создания нужно четное число дисков.

Также задаем описание, у меня это system. Stripe к сожалению задать не удается, режимы кэширования оставим по умолчанию

В пункте Create RAID via выбираем Quick init, быстрое формтирование массива.

Подтверждаем инициализацию рейд дисков

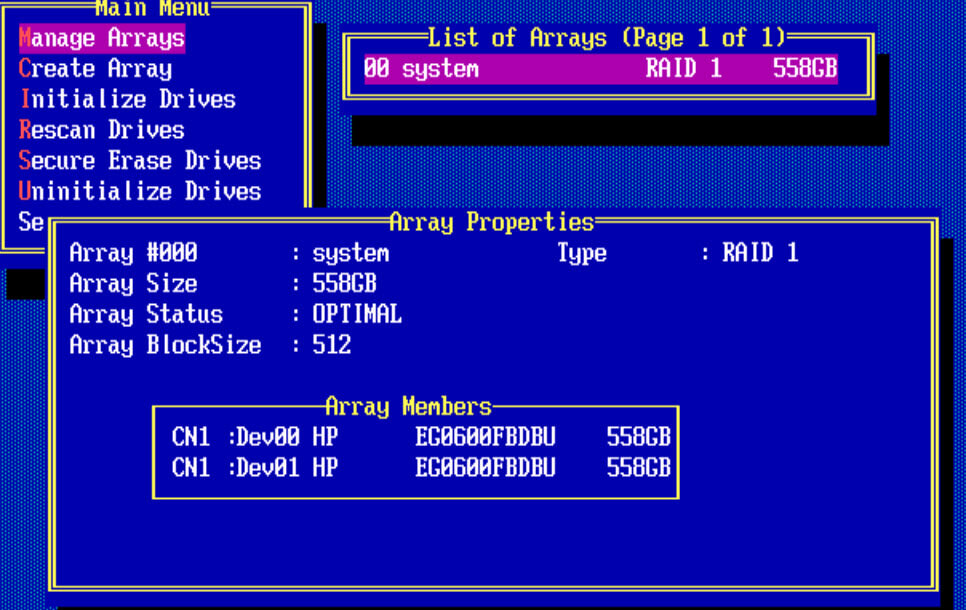

Для того чтобы, потом изменить настройки созданного рейд массива, следует выйти в меню Main Menu и выбрать пункт manage Arrays. У вас будет отображен список lun в List of Arrays. Как видите у меня есть RAID 1 и он состоит из двух дисков.

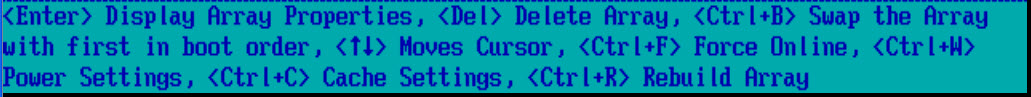

Снизу есть комбинации клавиш с помощью которых можно выполнять редактирование у созданных lunов.

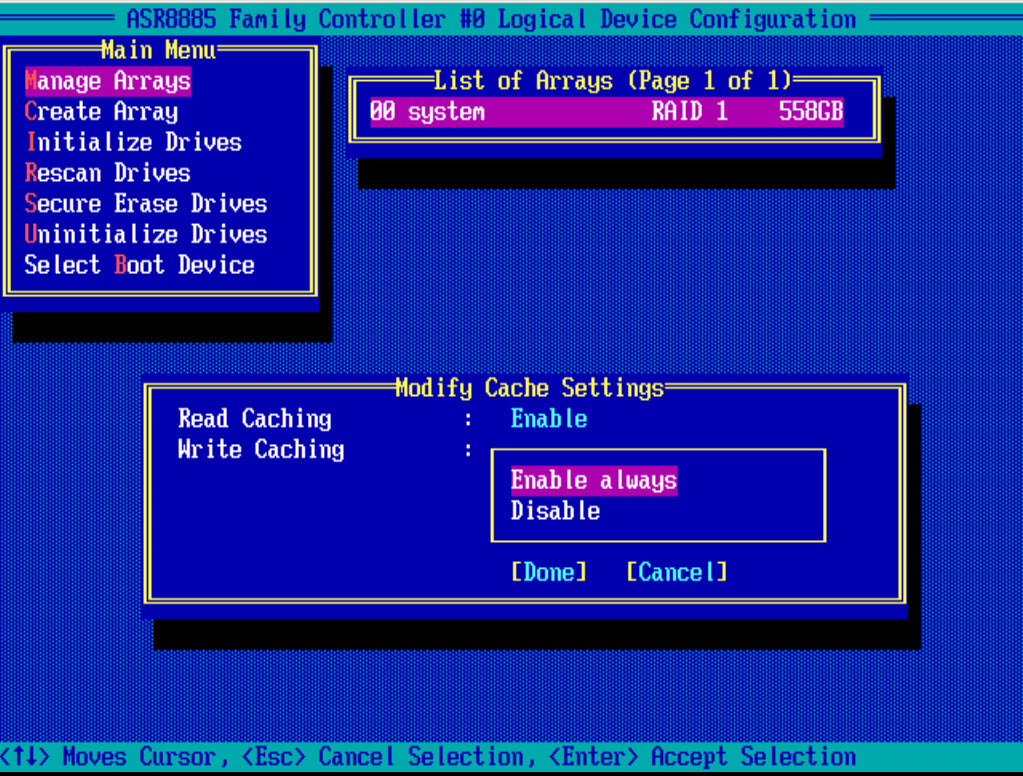

Нажимаем CTRL+R и попадаем в пункт редактирования настроек кэширования. Выбираем значения Tab.

Создаем RAID 5

Самый противоречивый вид, с одной стороны может долго восстанавливаться, а с другой экономит место. Если у вас как и у меня будут ssd твердотельные диски, для тестирования, то советую попробовать пятерку. Для создания рейд 5 требуется минимум 3 диска, формула n-1, где n общее число дисков. В моем случае из 4 ssd и в системе увижу объем трех, четвертый будет скрыт под контрольные суммы.

Выбираем из списка RAID-5

Вот какие настройки у меня получились.

Жмем done. Так как у меня 4 ssd диска, то контроллер предложил, для увеличения производительности отключить на ssd дисках кэш на чтение и на запись.

При желании потом можно включить cache.

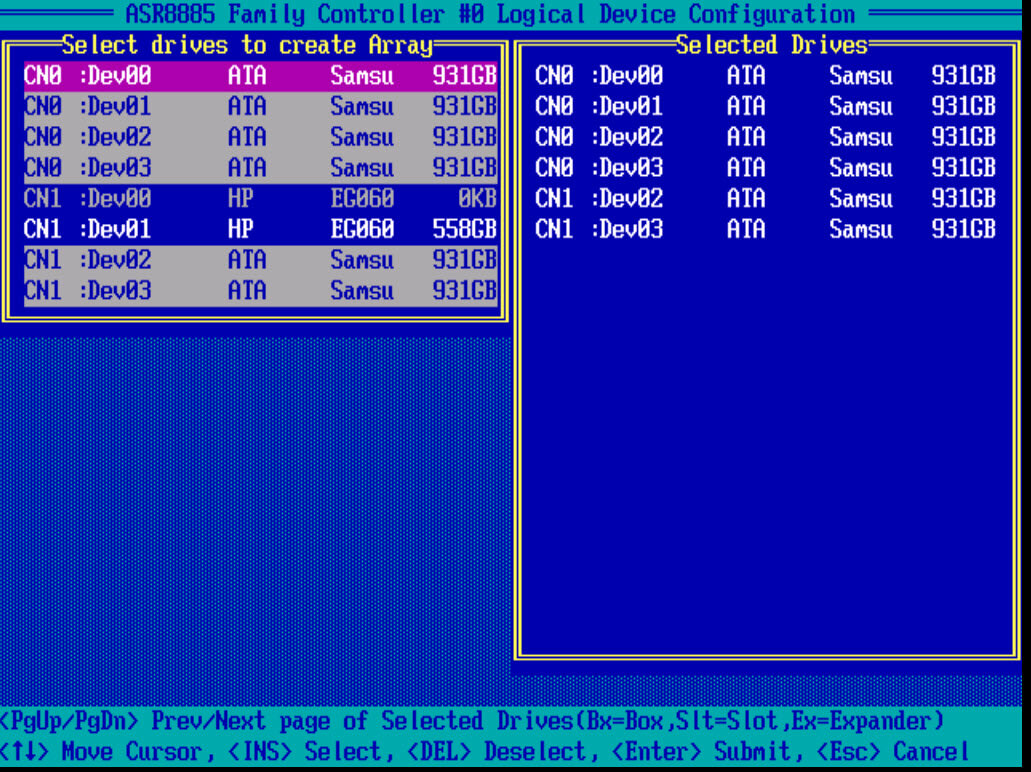

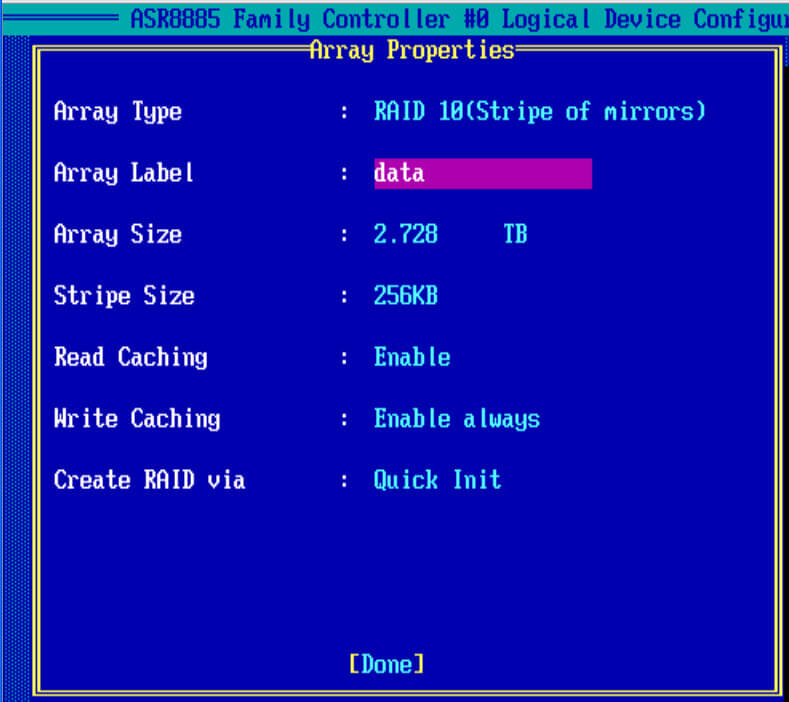

Создаем RAID 10

И так, чтобы настроить raid массив 10, нам потребуется четное количество дисков. В моем случае это 6 ssd samsung evo 850. Выбираем диски пробелом и жмем Enter.

В Array Type выбираем нужное значение.

заполняем остальные значения, у меня вышло вот так и жмем done, так же контроллер вам порекомендует отключить для ssd кэширование, советую подтвердить на данном этапе, а потом сравнить во время тестирования с ним и без него.

Описание кэширования LUN

- Read Caching > Данная настройка, по дефолту включена, это позволяет adaptec 8885 контроллеру сохранять данные в кэш на диске. Со включенным кэшом контроллер мониторит процесс чтений данных с пула дисков. Опция Enable MaxCache, аналогична Cache Cade у LSI, и смысл технологии в том, что если у вас есть обычные hdd и есть один или более ssd дисков, то их можно использовать для кэширования hdd массивов, что в десятки раз увеличивает количество операций ввода/вывода (iops)

- Write Caching > так же настройка включена по дефолту. Данный параметр означает. что включен режим write-back, в котором рейд контроллер отсылает ОС подтверждение о том что данные записались, только тогда когда они появились на дисках. При его работе производительность лучше, но данные могут потеряться если у вас будут проблемы с питанием, но если у вас подключена батарейка или флэш-модуль, то кэш сохранится еще на 72 часа, в течении которых вы должны устранить проблему с питанием. Если вы не восстановите электропитание, то контроллер не сможет перенести данные из кэша DRAM, на диски.

Далее можно приступать к установке операционной системы на созданные lun, в моем случае я буду ставить VMware ESXi 5.5.

Читайте также: