Какая архитектура используется в современных компьютерах гарвардская или фон неймана

Обновлено: 03.07.2024

Гарвард и фон Нейман, начиная с глобальных константных переменных STM32

От школы до последующей стажировки, честно говоря, меня не особо заботила структура фон Неймана и гарвардская структура процессора, я знал только, что это связано с памятью данных и памятью программ. Чтобы

Вчера в программе STM32, когда глобальная переменная была определена как атрибут const, было обнаружено, что ее местоположение было во встроенной FLASH STM32, а не во встроенной SRAM. Внезапно я чувствую себя очень странно, разве все программы не должны работать в ОЗУ? Разве его нельзя поместить в SRAM даже в статической постоянной области? Чтобы

причина? Это должно начинаться с архитектуры процессора фон Неймана и Гарварда.

1. Гарвардская структура и структура фон Неймана.

Гарвардская структура относится к физическому разделению памяти данных и памяти программ. Если взять в качестве примера однокристальный микрокомпьютер 51, память данных представляет собой RAM однокристального микрокомпьютера, а программная память - это ROM однокристального микрокомпьютера. Запрещается хранить инструкции в памяти данных, равно как и данные в памяти команд. Чтобы

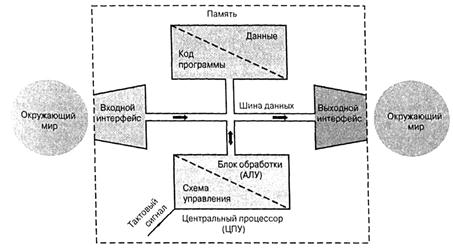

На рисунке показана структура Гарварда в Интернете. Память данных и память программ используют две независимые шины. Блок управления может одновременно связываться с памятью программ и памятью данных для реализации функций системы программного обеспечения. ARM использует гарвардскую структуру. (Строго говоря, многие усовершенствованные чипы ARM приняли комбинацию структуры Гарварда и структуры фон Неймана)

Структура фон Неймана, это структура, принятая в компьютерах общего назначения, при этом данные и память программ не разделены:

Видно, что фон Нейман помещает в память как память данных, так и память программ. Для структуры фон Неймана инструкции и данные должны загружаться в рабочую память при выполнении программы. Чтобы

Эти две структуры должны иметь разные реализации в области защищенного кода. Гарвардская структура различает код и данные на аппаратном уровне, и, конечно, должно быть программное обеспечение, в то время как структура фон Неймана должна различаться только на программном уровне.

2. Адрес глобальной переменной STM32 const

Порядок действий следующий:

Результат работы программы:

По карте памяти STM32 (вФайл запуска STM32Этот рисунок приведен в одной статье), можно сделать вывод, что адрес globalConstDat находится во Flash-памяти (0x0800 0000

0x0801 ffff), а адреса остальных переменных находятся в SRAM. Почему такая ситуация? Первое зависит от компилятора, а второе связано с тем, что ARM - это гарвардская структура. Встроенная FLASH и встроенная SRAM эквивалентны ROM и RAM однокристального микрокомпьютера 51. SRAM используется для хранения данных, а FLASH - для хранения инструкций. . Когда программа запущена, блок управления может одновременно взаимодействовать с RAM и FLASH, что означает, что CPU может напрямую выполнять программу во FLASH. Обратите внимание, что некоторые FLASH-файлы нельзя запускать непосредственно на нем, и их необходимо загружать в RAM, например NandFlash, потому что скорость чтения NandFlah очень низкая, но есть также некоторые FLASH-файлы, такие как NorFlah. Встроенная флэш-память STM32 - это флэш-память, аналогичная атрибуту NorFlash. Глобальная статическая константа находится в области текстовых констант. Она статична и не может быть изменена. Она размещается в области памяти программы компилятором, что означает, что она компилируется в "инструкцию" 。

Если он находится в процессоре фон Неймана, в этом случае у компилятора будет другой набор мер.

Разница между фон Нейманом и гарвардской архитектурой: архитектура фон Неймана была разработана известным физиком и математиком Джоном фон Нейманом в конце 1940-х годов, а архитектура Гарварда была основана на оригинальном релейном компьютере Harvard Mark I.

Оригинальная гарвардская архитектура использовалась для хранения инструкций на перфоленте и данных в электромеханических счетчиках. Архитектура фон Неймана составляет основу современных вычислений и проще в реализации. В этой статье рассматриваются две компьютерные архитектуры в отдельности и объясняется разница между ними.

Архитектура фон Неймана

Архитектура фон Неймана это не что иное, как искусство хранения электронного компьютера. Это совсем не новая концепция, она существует уже давно, и мы следуем принципу этой архитектуры фон Неймана. Если мы вернемся в историю, совершенно очевидно, что архитектура фон Неймана была впервые опубликована в отчете Джона фон Неймана 30 июня 1945 года, и с тех пор тот же принцип применяется для хранения электронных компьютеров.

Применение и функции

Архитектура фон Неймана нашла широкое применение в повседневной жизни. Имея в виду широкое применение, архитектура фон Неймана была введена в качестве предмета в образовательной степени. Начиная с третьего семестра студенты инженерных специальностей будут изучать этот предмет в своей учебной программе. Архитектура фон Неймана состоит из некоторых важных функций, и здесь мы подробно остановимся на них.

Память: Все мы знаем, что фон Нейман - это не что иное, как компьютер с функцией хранения данных. В архитектуре фон Неймана память играет жизненно важную роль и считается одной из важных особенностей. В основном это отвечает как за хранение, так и за запуск данных и данных программирования. В наши дни это было заменено ОЗУ, и теперь мы используем ОЗУ для этой цели.

Устройство управления: Это подразделение в основном отвечает за аспект управления. Все данные хранятся в памяти и во время обработки данных блок управления играет роль и управляет потоком данных. Фактически, если быть более типичным, это «По одному». Блок управления следует принципу One At A Time и, соответственно, обрабатывает все данные.

Ввод, вывод: Как и все электронные устройства, архитектура фон Неймана также имеет архитектуру ввода / вывода. Это основная функция та же, и ничего особенно не было разработано для архитектуры ввода и вывода. С помощью устройства ввода и вывода человек может общаться с устройством.

ALU: ALU или арифметическая логическая единица имеет большое значение в архитектуре фон Неймана. Этот ALU будет выполнять любое сложение, вычитание, умножение и деление данных. В дополнение к этому, ALU будет выполнять любые другие алгоритмические функции и действия. Это основной аспект архитектуры фон Неймана, о котором вы должны знать.

Гарвард Архитектура

Гарвардская архитектура не что иное, как своего рода хранилище данных. Когда дело доходит до физического хранения данных, Гарвардская архитектура всегда стояла на первом месте. Хотя эта концепция не нова, архитектура Гарварда получила огромную признательность от всех. Релейный компьютер Harvard Mark I - это термин, из которого впервые возникла концепция архитектуры Гарварда, а затем произошли значительные изменения в этой архитектуре. Основная функция этой архитектуры - разделить физическое хранение данных и предоставить пути прохождения сигналов для инструкций и данных.

Применение и функции

Он нашел широкое применение в продуктах для обработки аудио и видео, и с каждым инструментом обработки аудио и видео вы заметите присутствие архитектуры Havard. Процессоры Blackfin от Analog Devices, Inc. - это конкретное устройство, в котором они получили самое широкое применение. В других продуктах на основе электронных чипов также широко используется архитектура Havard.

Состояние памяти

В предыдущей архитектуре мы наблюдали наличие двух воспоминаний. Однако в случае Гарвардский архитектуры, вы не найдете двух памяти и будет одна память. Имеющаяся память сможет выполнять все функции. Да, будет только постоянная память, и эта память будет использоваться для чтения, кодирования, декодирования и хранения данных.

Аспект скорости

Много говорилось о Гарвардский архитектура, но без скорости никакая архитектура не может быть принята. Но в случае архитектуры Havard производители разработали архитектуру таким образом, чтобы она могла обрабатывать данные с гораздо более высокой скоростью. Да, все внимание было уделено тому, чтобы архитектура могла обрабатывать данные с высокой скоростью.

Реализуя ту же формулу, современные ЦП производятся так, чтобы новый ЦП мог работать с гораздо более высокой скоростью, а также мог эффективно обрабатывать данные. Концепция кеш-памяти ЦП также реализуется при разработке архитектуры Гарварда.

Особенности архитектуры фон Неймана

- Архитектура фон Неймана - это теоретический проект, основанный на концепции компьютера с хранимой программой.

- Архитектура фон Неймана имеет только одну шину, которая используется как для извлечения инструкций, так и для передачи данных. Что еще более важно, операции должны быть запланированы, потому что они не могут быть выполнены одновременно.

- В архитектуре фон Неймана процессору потребовалось бы два тактовых цикла для выполнения инструкции.

- Архитектура фон Неймана обычно используется буквально на всех машинах, от настольных компьютеров, ноутбуков, высокопроизводительных компьютеров до рабочих станций.

Особенности Гарвардской Архитектуры

- Гарвардская архитектура - это современная компьютерная архитектура, основанная на компьютерной модели ретранслятора Harvard Mark I.

- Гарвардская архитектура имеет отдельное пространство памяти для инструкций и данных, которое физически разделяет сигналы и код хранения и память данных, что, в свою очередь, позволяет получить доступ к каждой из систем памяти одновременно.

- В гарвардской архитектуре процессор может выполнить инструкцию за один цикл, если были установлены соответствующие планы конвейерной обработки.

- Гарвардская архитектура - это новая концепция, используемая специально в микроконтроллерах и цифровой обработке сигналов (DSP).

- Гарвардская архитектура - сложный вид архитектуры, поскольку в ней используются две шины для команд и данных, что делает разработку блока управления сравнительно более дорогой.

Разница между фон Нейман и Гарвардской архитектуры

| Точка сравнения | Гарвард Архитектура | Архитектура фон Неймана |

| Соглашение | В гарвардской архитектуре ЦП связан как с памятью данных (RAM), так и с памятью программ (ROM), отдельно. | В архитектуре фон Неймана нет отдельной памяти данных и программ. Вместо этого, одно соединение памяти предоставляется ЦПУ. |

| требования к оборудованию | Для этого требуется больше оборудования, поскольку для каждой памяти потребуются отдельные данные и адресная шина. | В отличие от архитектуры Гарварда, для этого требуется меньше оборудования, так как требуется только общая память. |

| требования к свободному пространству | Это требует больше места. | Архитектура фон Неймана требует меньше места. |

| Скорость исполнения | Скорость выполнения выше, потому что процессор извлекает данные и инструкции одновременно. | Скорость выполнения ниже, поскольку он не может одновременно получать данные и инструкции. |

| Использование пространства | Это приводит к неэффективной трате пространства, поскольку, если в памяти данных остается пространство, память инструкций не может использовать пространство памяти данных, и наоборот. | Пространство не тратится впустую, потому что пространство памяти данных может использоваться памятью инструкций и наоборот. |

Если вам понравилась эта статья, подпишитесь на вашу электронную почту для связанных материалов. Благодарю.

CSN Team.

=> ПОСЛЕДУЮЩИЕ США НА INSTAGRAM | FACEBOOK & TWITTER ПОСЛЕДНИЕ ОБНОВЛЕНИЯ

Различают Принстонскую и Гарвардскую архитектуру вычислительных машин. Эти архитектурные варианты были предложены в конце 40-х годов специалистами, соответственно, Принстонского и Гарвардского университетов США для разрабатываемых ими моделей компьютеров.

Принстонская архитектура

Принстонская архитектура , которая часто называется архитектурой фон Неймана , характеризуется использованием общей оперативной памяти для хранения программ, данных, а также для организации стека. Для обращения к этой памяти используется общая системная шина, по которой в процессор поступают и команды, и данные.

Архитектура современных персональных компьютеров основана на

магистрально-модульном принципе .

Любую вычислительную машину образуют три основные компонента:

- процессор,

- память,

- устройства ввода-вывода (УВВ).

Информационная связь между устройствами компьютера осуществляется через системную шину (системную магистраль).

Шина – это кабель, состоящий из множества проводников. Количество проводников, входящих в состав шины, является

максимальной разрядностью шины .

Системная шина, в свою очередь, представляет собой совокупность

- шины данных, служащей для переноса информации;

- шины адреса, которая определяет, куда переносить информацию;

- шины управления, которая определяет правила для передачи информации;

- шины питания, подводящей электропитание ко всем узлам вычислительной машины.

Системная шина характеризуется тактовой частотой и разрядностью. Количество одновременно передаваемых по шине бит называется

разрядностью шины .

Тактовая частота характеризует число элементарных операций по передаче данных в 1 секунду. Разрядность шины измеряется в битах, тактовая частота – в мегагерцах.

Устройство управления (УУ) формирует адрес команды, которая должна быть выполнена в данном цикле, и выдает управляющий сигнал на чтение содержимого соответствующей ячейки запоминающего устройства (ЗУ). Считанная команда передается в УУ. По информации, содержащейся в адресных полях команды, УУ формирует адреса операндов и управляющие сигналы для их чтения из ЗУ и передачи в арифметико-логическое устройство (АЛУ). После считывания операндов устройство управления по коду операции, содержащемуся в команде, выдает в АЛУ сигналы на выполнение операции. Полученный результат записывается в ЗУ по адресу приемника результата под управлением сигналов записи. Признаки результата (знак, наличие переполнения, признак нуля и так далее) поступают в устройство управления, где записываются в специальный регистр признаков. Эта информация может использоваться при выполнении следующих команд программы, например команд условного перехода.

Устройство ввода позволяет ввести программу решения задачи и исходные данные в ЭВМ и поместить их в оперативную память. В зависимости от типа устройства ввода исходные данные для решения задачи вводятся непосредственно с клавиатуры, либо они должны быть предварительно помещены на какой-либо носитель (дисковый накопитель).

Устройство вывода служит для вывода из ЭВМ результатов обработки исходной информации. Чаще всего это символьная информация, которая выводится с помощью печатающих устройств или на экран дисплея.

Запоминающее устройство или память – это совокупность ячеек, предназначенных для хранения некоторого кода. Каждой из ячеек присвоен свой номер, называемый адресом . Информацией, записанной в ячейке, могут быть как команды в машинном виде, так и данные.

Обработка данных и команд осуществляется посредством арифметико-логического устройства (АЛУ), предназначенного для непосредственного выполнения машинных команд под действием устройства управления. АЛУ и УУ совместно образуют центральное процессорное устройство (ЦПУ). Результаты обработки передаются в память.

Основные принципы построения вычислительных машин с архитектурой фон Неймана

- Принцип двоичности. Для представления данных и команд используется двоичная система счисления.

- Принцип программного управления. Программа состоит из набора команд, которые выполняются процессором друг за другом в определённой последовательности.

- Принцип однородности памяти. Как программы (команды), так и данные хранятся в одной и той же памяти (и кодируются в одной и той же системе счисления, чаще всего – двоичной). Над командами можно выполнять такие же действия, как и над данными.

- Принцип адресуемости памяти. Структурно основная память состоит из пронумерованных ячеек, процессору в произвольный момент времени доступна любая ячейка.

- Принцип последовательного программного управления. Все команды располагаются в памяти и выполняются последовательно, одна после завершения другой.

- Принцип условного перехода. Команды из программы не всегда выполняются одна за другой. Возможно присутствие в программе команд условного перехода (а также команд вызова функций и обработки прерываний), которые изменяют последовательность выполнения команд в зависимости от значений данных. Этот принцип был сформулирован задолго до фон Неймана Адой Лавлейс и Чарльзом Бэббиджем, однако был логически включен в указанный набор как дополняющий предыдущий принцип.

Архитектура фон Неймана имеет ряд важных достоинств.

- Наличие общей памяти позволяет оперативно перераспределять ее объем для хранения отдельных массивов команд, данных и реализации стека в зависимости от решаемых задач. Таким образом, обеспечивается возможность более эффективного использования имеющегося объема оперативной памяти в каждом конкретном случае применения.

- Использование общей шины для передачи команд и данных значительно упрощает отладку, тестирование и текущий контроль функционирования системы, повышает ее надежность.

Поэтому Принстонская архитектура в течение долгого времени доминировала в вычислительной технике.

Однако ей присущи и существенные недостатки. Основным из них является необходимость последовательной выборки команд и обрабатываемых данных по общей системной шине. При этом общая шина становится «узким местом» (bottleneck – «бутылочное горло»), которое ограничивает производительность цифровой системы.

Гарвардская архитектура

Гарвардская архитектура была разработана Говардом Эйкеном в конце 1930-х годов в Гарвардском университете с целью увеличить скорость выполнения вычислительных операций и оптимизировать работу памяти. Она характеризуется физическим разделением памяти команд (программ) и памяти данных. В ее оригинальном варианте использовался также отдельный стек для хранения содержимого программного счетчика, который обеспечивал возможности выполнения вложенных подпрограмм. Каждая память соединяется с процессором отдельной шиной, что позволяет одновременно с чтением-записью данных при выполнении текущей команды производить выборку и декодирование следующей команды. Благодаря такому разделению потоков команд и данных и совмещению операций их выборки реализуется более высокая производительность, чем при использовании Принстонской архитектуры.

Недостатки Гарвардской архитектуры связаны с необходимостью проведения большего числа шин, а также с фиксированным объемом памяти, выделенной для команд и данных, назначение которой не может оперативно перераспределяться в соответствии с требованиями решаемой задачи. Поэтому приходится использовать память большего объема, коэффициент использования которой при решении разнообразных задач оказывается более низким, чем в системах с Принстонской архитектурой. Однако развитие микроэлектронной технологии позволило в значительной степени преодолеть указанные недостатки, поэтому Гарвардская архитектура широко применяется во внутренней структуре современных высокопроизводительных микропроцессоров, где используется отдельная кэш-память для хранения команд и данных. В то же время во внешней структуре большинства микропроцессорных систем реализуются принципы Принстонской архитектуры.

Архитектура микропроцессора. Основные понятия

Под архитектурой МП понимают принцип его внутренней организации: общую структуру, логическую структуру отдельных устройств, совокупность команд и принципы взаимодействия аппаратной части и программы обработки информации.

Иначе: архитектура – математическая модель МП, образованная программно- доступными элементами МП. Архитектура МП отражает возможности прикладного использования МП и содержит описание программной модели МП. Под программной моделью микропроцессора понимается совокупность программно-доступных регистров, объединенных в систему укрупненными связями и дополнительными элементами, обеспечивающими функциональную законченность модели.

Полностью понятие архитектура МП включает:

- структурную схему МП,

- программную модель МП,

- описание организации памяти,

- описание организации процедур ввода/вывода.

Различают два основных типа архитектуры МП – фон Неймановскую (принстонскую) и гарвардскую.

| Фоннеймановская архитектура | Гарвардская архитектура |

Фон Неймановская (принстонская) архитектура (предложена Джо фон Нейманом в 1945 г.) предполагает, что программа и данные находятся в общей памяти, доступ к которой производится по одной шине данных и команд. Основным достижением группы инженеров, работавших с Джоном фон Нейманом, было осознание того факта, что программа может храниться в памяти вместе с данными. Основным преимуществом такого подхода является его гибкость, так как для изменения программы достаточно просто загрузить новый код в соответствующую область памяти. По существу, фон-неймановская архитектура, показанная на рис., состоит из центрального процессора (ЦПУ), памяти и общей шины (магистрали), по которой в обоих направлениях пересылаются данные. ЦПУ также должен взаимодействовать и с окружающим миром. При этом данные к/от соответствующих интерфейсных портов передаются по одной общей шине данных.

Огромным преимуществом фон-неймановской архитектуры является ее простота, поэтому данная концепция легла в основу большинства компьютеров общего назначения. Однако использование общей шины означает, что в любой момент времени может выполняться только одна операция. Соответственно, пересылка данных между ЦПУ и памятью данных не может осуществляться одновременно с выборкой команды . Эта особенность называется фон-неймановским узким местом.

| Рис. – Элементарная фон-неймановская машина (шина адреса не показана) |

Гарвардская архитектура (реализована в 1944 г. в ЭВМ Гарвардского университета) соответствует структуре с разделенными устройствами памяти команд и данных и отдельными шинами команд и данных.

В первое послевоенное десятилетие в Гарвардском университете было создано несколько компьютеров семейства "Марк", в которых память программ была полностью отделена от памяти данных (программа считывалась с бумажной перфоленты). Такая концепция была более эффективной, чем фон-неймановская (принстонская) архитектура, поскольку код программы мог считываться из памяти программ одновременно с обменом между ЦПУ и памятью данных или с операциями ввода/вывода. Однако такие машины были намного сложнее и дороже в изготовлении. А с учетом уровня технического развития 40 - 50-х годов, высоких экономических затрат, они не получили широкого распространения. Однако с развитием больших интегральных схем и технологии гарвардская архитектура снова оказалась в центре внимания.

За последние тридцать лет компьютеры настолько стали популярны, что успели изменить многие процессы в жизни человека и соответственно общества. С каждым годом, согласно закону Мура, они приобретают все больше вычислительных способностей, что позволяет им решать все более сложные задачи. Уже сегодня компьютеры столкнулись с рядом ограничений, которые не позволяют нам решать задачи из фильмов про будущее. Так ли будет и дальше, есть ли предел у современной архитектуры и что нам делать, если такой стремительный рост в дальнейшем невозможен?

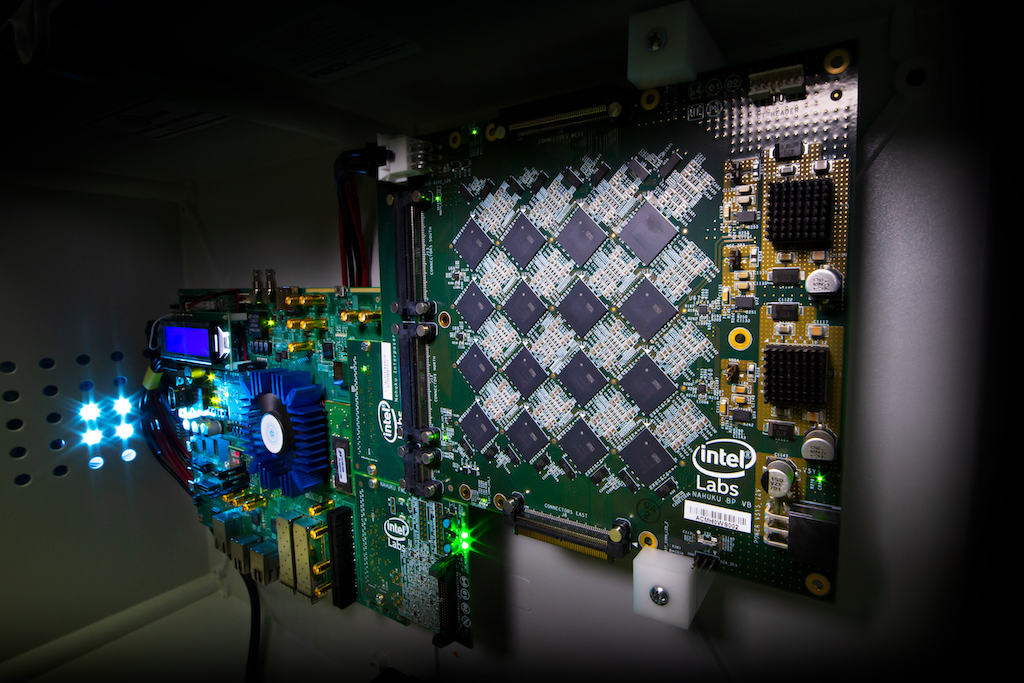

На изображении отладочная плата с расположенными чипами Loihi.

Компьютер фон Неймана все так же будет обрабатывать задачи, связанные с реляционными базами данных (про BigData не уверен), численными методами, интернетом и тд. В общем он так и будет заниматься всем тем, для чего он был создан, но уже не будет такого быстрого прироста вычислительных способностей, а для решения задач обработки сигналов “реального мира” будет использоваться другой архитектурный подход. Оба архитектурных подхода будут использоваться на одной печатной плате, а со временем и в одном чипе.Эта статья является вступлением для статьи Neuromorphic inspired computing и описывает проблематику вопроса, решения предлагаются во второй статье.

Классическая архитектура фон Неймана

“Бутылочное горлышко” архитектуры фон Неймана.

Все классические компьютеры обладают так называемой архитектурой фон Неймана.

Рис. 1. The decline of von Neumanns architecture

Недостатком такой архитектуры является тот факт, что данные из области памяти цикл за циклом должны передаваться в область вычислительного юнита и обратно. Интерфейс, связывающий вычислительный юнит и память компьютера, ограничен в своей пропускной способности. Даже тот факт, что современные процессоры имеют несколько уровней кэша непосредственно в вычислительном юните, не решает проблему. Данный подход усугубляется необходимостью аккумулировать и структурировать данные для полного заполнения буфера вычисляемых операций. Можно привести метафору с поездом: пока все пассажиры не займут именно свои места в поезде, поезд никуда не поедет.

Физические ограничения материалов

Согласно закону Мура, количество транзисторов удваивается примерно каждые два года при уменьшении стоимости их производства. Реализуется этот факт посредством уменьшения размера транзистора. Уменьшение размеров транзистора приводит нас к еще одному ограничению: их размеры обусловлены физическими свойствами материалов из которых они производятся.

Реалии представляются таким образом, что этот закон начинает испытывать давление со стороны “законов физики микромира”.

Рис. 2. Уменьшение размеров транзистора приводит к ошибкам в его производстве

Тут мы сталкиваемся сразу с несколькими сложностями:

- Во-первых, при уменьшении размеров электрический разряд начинает “пробивать” затвор и затвор перестает выполнять свою роль.

- Во-вторых, усложняется задача отведения тепла от такого транзистора.

- В-третьих, при уменьшении размера транзистора брак при их производстве возрастает, так как меньшее количество вещества на молекулярном уровне формирует сам транзистор.

Отказоустойчивость и брак в производстве

Задумывались ли вы, как производят младшие модели процессоров и чипов для видеокарт? Вы наверное подумаете, что есть специально выделенные команды, которые разрабатывают каждый год новый упрощенный чип. На самом деле процесс выглядит по-другому. Компания разрабатывает один максимально мощный чип. Его устройство выглядит, как некая повторяющаяся архитектура. Обратите внимание на то, что практически все элементы дублируются, как и в авиации.

Рис. 3. Блок схема процессора Xeon

Подход хороший, но он требует отключения очень больших блоков: в случае отказа нескольких транзисторов, которых в одном ядре может быть семьсот миллионов. То есть отказ 0.000000001% транзисторов приводит к потере 10% и более производительности устройства.

Если предположить, что мы можем создавать блоки, основанные на ста транзисторах при количестве этих самых блоков более миллиона мы бы получили значительный прирост отказоустойчивости в чипе. Это значит, что при выходе из строя небольшого количества транзисторов мы бы теряли очень маленький процент блоков от их общего числа. Этот подход сильно бы удешевил стоимость производства, и топовый чип стоил бы уже не, как малолитражный автомобиль, а как хорошая рубашка.

Потребление электроэнергии и размер суперкомпьютеров

В современном мире, когда мобильный телефон обладает вычислительными способностями компьютера пятилетней давности и при этом работает от аккумулятора, нам кажется, что мы почти достигли предела в уменьшении потребления энергии компьютерами. Но, если мы сравним вычислительные способности суперкомпьютера IBM Summit, его размеры и потребляемые им объемы энергии с мозгом мыши, окажется, что он неимоверно большой и очень неэффективный.

Рис 4. IBM Power System AC922, IBM POWER9 22C 3.07GHz, NVIDIA Volta GV100, Dual-rail Mellanox

EDR InfiniBand, 2.41 million cores, 148.6 petaflops

Пиковая потребляемая мощность: 13 000 000 W

Размеры: 4,608 nodes * 0.2 m^3 = 920 m^3

Мозг мыши способен обрабатывать куда более сложные задачи при потреблении всего 1-5 ватт.

Online learning and continuous-flow

Тут хочется сказать больше об алгоритмах, нежели об архитектуре, хотя в данном контексте алгоритмы продиктованы архитектурой. Современный компьютер хорошо справляется с дискретными данными, когда есть, пускай и большое количество, но все же порционных, конечных, желательно целочисленных данных, тут он может себя проявить очень хорошо. Но вот, когда речь заходит о последовательностях, непрерывности, бесконечно малых или бесконечно больших значениях, тут мы пытаемся найти некое приближение. В результате мы интерпретируем наши данные в последовательность дискретных кадров, дробим, разделяем и обрабатываем каждый фрейм как нечто статическое и конечное.

Да, сейчас существуют различные подходы bi-directional soft attention (см. BERT) для того, чтобы связывать эти самые кадры в работе с языковыми моделями. Также современные подходы машинного обучения лишены возможности обучаться непосредственно в процессе решения поставленной задачи. Это все еще две различные задачи.

Параллелизм и масштабируемость

Возвращаясь к архитектуре фон Неймана, мы видим, что весь поток данных проходит через некий вычислительный центр, то есть по сути еще одно узкое горлышко. Количество ядер в современных чипах растет, но вслед за этим возникает и новая проблема: сперва данные нужно распараллелить, а после синхронизировать результаты. То есть, если у вас множество независимых входных сигналов и они не связаны между собой ни во времени, ни в контексте, множество ядер процессоров и ядер видеокарт хорошо справляются с этой задачей. Но в том случае, если у вас большой входной сигнал, то задача параллелизма вычислений, синхронизации результатов может занять большую часть этих самых вычислений.

Оригинал статьи

В следующей статье я рассказываю как решают все перечисленные сложности по средствам Neuromorphic архитектуры.

Читайте также: