Настройка vdi autocad vmware

Обновлено: 03.07.2024

Анастасия Калимулина — компания «АйДиТи», специалист по направлению «Архитектура и строительство», авторизованный инструктор Autodesk

Игорь Мамедов — компания «АйДиТи», технический директор

В непростых условиях современного рынка все большую актуальность приобретают усилия по оптимизации производственных процессов с целью уменьшения затрат. Значимо снизить себестоимость проектно-конструкторских работ — вот задача, над реализацией которой работают руководители и специалисты компаний, на деле стремящихся получить ощутимые конкурентные преимущества.

В многочисленных публикациях сотрудников компании «АйДиТи» в журнале «САПР и графика» постоянно обсуждается проблема, как с наибольшей пользой и выгодой использовать все внутренние возможности современных решений САПР и ГИС, включая технологию информационного моделирования (BIM). В настоящем же материале мы начнем рассказ о не совсем еще привычных, а возможно, кому-то и не очень знакомых внешних инструментах и способах работы с системами автоматизированного проектирования.

В качестве наглядного примера рассмотрим организацию работы в программном комплексе Autodesk Building Design Suite Ultimate на виртуальных рабочих столах с применением инновационных технологий NVIDIA GRID и Citrix VDI. В скобках заметим, что продукция NVIDIA и Citrix сертифицирована для работы с программными продуктами Autodesk.

Сравнение версий программного комплекса Autodesk Building Design Suite

Standard

Premium

Ultimate

AutoCAD Raster Design

Autodesk 3ds Max

Autodesk Navisworks Simulate

Autodesk Navisworks Manage

Autodesk Robot Structural Analysis Professional

Autodesk, Inc. — мировой лидер в области решений для 3Dдизайна, проектирования и создания виртуальной реальности. Все компании из списка Fortune 100 применяют инструменты Autodesk, чтобы проектировать, моделировать и визуализировать свои идеи для экономии времени и денег, улучшения качества продукции и скорейшего внедрения инноваций.

Начиная с выпуска AutoCAD в 1982 году компания разработала широчайший спектр инновационных программ, позволяющих инженерам, архитекторам и конструкторам испытывать свои идеи еще до их реализации.

Autodesk Building Design Suite — гибкий, экономически эффективный программный комплекс, в котором объединены архитектурностроительные САПР и решения на базе технологии BIM, благодаря чему архитекторы, инженеры и специалисты строительных организаций получили возможность готовить наглядные визуальные представления проектов.

Материальная часть

Autodesk Building Design Suite Ultimate — комплекс программных продуктов компании Autodesk, в том числе таких популярных, как AutoCAD, 3Ds Max и Revit. Другими словами — это профессиональный набор самых современных инструментов проектировщика. Не секрет, что программные продукты, входящие в Autodesk Building Design Suite Ultimate, предъявляют высокие требования к аппаратному обеспечению. Так, например, сбалансированными условиями для Revit можно считать: четырехъядерный процессор с максимальной частотой 2,2 ГГц, ОЗУ 8 Гбайт и видеокарту NVIDIA Quadro K600. А для выполнения крупных моделей или таких «тяжелых» задач, как рендеринг, потребуется, как минимум, 16ядерный процессор с минимальной частотой 3,7 ГГц, ОЗУ 16 Гбайт, видеокарта NVIDIA Quadro K4200 (4 Гбайт).

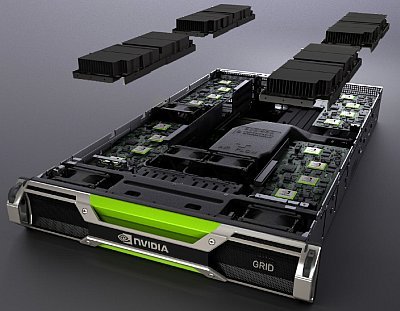

Технология NVIDIA GRID активно набирает популярность среди любителей компьютерных игр с повышенными требованиями к ресурсам ПК. Однако эта же технология вполне применима и для выполнения ежедневных рабочих задач по 3Dмоделированию или информационному моделированию (BIM) в профессиональных трехмерных графических приложениях. По существу, NVIDIA GRID является необходимой аппаратной составляющей для реализации технологии удаленных рабочих столов. Графические ускорители виртуальных рабочих столов NVIDIA GRID предназначены для решения различных задач: K1 позволяет организовать виртуальные рабочие столы с обычными офисными приложениями и несложной графикой для 32 пользователей (по два дисплея на пользователя), а K2 поддерживает профессиональные приложения с мощной графикой при организации виртуальных рабочих столов для 16 пользователей (по два дисплея на пользователя).

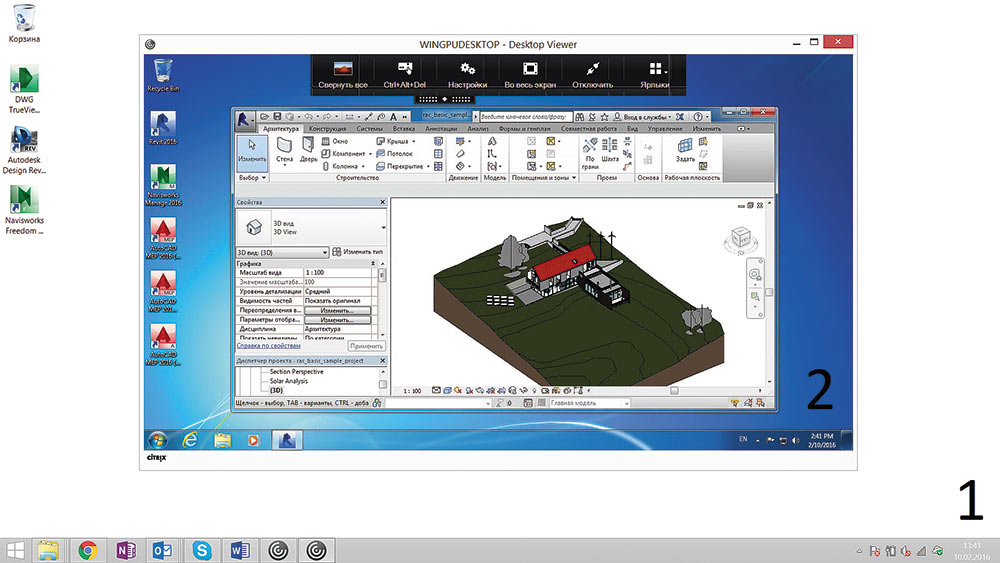

Citrix VDI (Virtual Desktop Infrastructure) — инфраструктура виртуальных рабочих столов, или, иначе, — комплекс программных решений, который позволяет осуществлять удаленный доступ к другому ПК, что схематически представлено на рисунке: 1 — рабочий стол стационарного ПК; 2 — виртуальный рабочий стол (открыто приложение Autodesk Revit). На персональное устройство пользователя устанавливается специальное кроссплатформенное приложение Citrix Receiver, предназначенное для осуществления связи с виртуальным рабочим столом. Серверная же часть может быть представлена следующими приложениями:

- Citrix XenDesktop — система виртуальных рабочих столов;

- Citrix XenApp — система виртуализации приложений;

- Citrix XenServer — платформа для управления облачными, серверными и десктопными виртуальными инфраструктурами;

- Citrix NetScaler — система балансировки нагрузки и безопасного доступа.

Для реализации виртуального доступа необходимо подключение к локальной сети или к Интернету. Удаленное подключение можно осуществить с любого устройства: с рабочей станции дома или в офисе, с ноутбука, планшета или смартфона.

Суть виртуального подключения состоит в том, что пользователю централизованно предоставляется возможность совершенно полноценной работы с его профессиональными приложениями и данными. Правда, на своей рабочей станции он имеет дело всего лишь с поступающими на нее изображениями и звуками. Сами же приложения, данные, вычисления обслуживаются удаленной серверной инфраструктурой, элементами которой являются системы хранения данных и серверы. Это высокопроизводительное и надежное оборудование можно модифицировать и развивать в зависимости от возникающих практических задач.

Заметим, что такая организация работы никоим образом не ограничивает профессиональные возможности пользователя, и отнюдь не снижает, а даже повышает производительность его труда. В то же время, она обеспечивает удобное и надежное централизованное управление инфраструктурой, имеющей при этом единый вид.

NVIDIA — лидер в области визуальных вычислений, разработчик и производитель графических карт для игр на ПК, а также графических процессоров для выполнения профессиональной визуализации, начиная с механического и промышленного проектирования и заканчивая медицинской визуализацией, создания цифрового контента и фильмов.

Информационное моделирование зданий (BIM) — это основанная на интеллектуальной компьютерной модели технология, снижающая затраты времени и средств на выполнение проектов зданий и обеспечивающая при этом минимальное воздействие таких проектов на окружающую среду.

Кому и когда это выгодно

Рассмотрим сценарии для проектных организаций, где использование технологии VDI с установленными на них графическими приложениями (например, Autodesk Building Design Suite) окажется рациональнее, чем организация работы с теми же графическими приложениями традиционным способом на настольных ПК.

Мобильная альтернатива высокопроизводительной рабочей станции

Например, руководителю (ГИП, ГАП и т.п.) необходимо иметь для работы мобильную рабочую станцию. Основное время он занят не процессом моделирования и оформления чертежей, а работой в традиционных офисных приложениях. Однако изредка ему необходимо просматривать результаты деятельности своих подчиненных, готовясь к внутренним совещаниям или встречам с заказчиками, причем открывать чертежи и модели необходимо в исходном формате (например, в приложении Revit). Так вот, чтобы лишний раз не возлагать на проектировщиков или BIMменеджера дополнительные обязанности по экспорту чертежей в формат программыпросмотрщика, нужно использовать технологию виртуального рабочего стола.

VDI поможет просматривать актуальные результаты работы подчиненных без использования в качестве настольного ПК профессиональной графической станции. В этом случае при наличии всего необходимого программного и аппаратного обеспечения для реализации технологии VDI требуется выполнение двух условий: первое — стабильное подключение к локальной сети или Интернету, второе — хранение рабочих файлов проектов на внешнем ресурсе. А серверное приложение Revit Server поможет реализовать хранение файлов проектов для работы в приложении Revit при подключении через Интернет.

В рамках подобного сценария можно рассматривать и такие случаи, когда рядовой сотрудникпроектировщик по различным причинам не имеет возможности стабильно присутствовать на рабочем месте, но должен иметь постоянный доступ к проектным данным и графическим приложениям. Или существует потребность в демонстрации «тяжелой» модели на выездной презентации. Или нужно организовать процесс обучения пользователей работе с сапровскими приложениями.

Программные комплексы (Suite) Autodesk — комбинации программных продуктов Autodesk, обеспечивающие всестороннее решение задач в той или иной отрасли.

В комплексах семейства Autodesk Design Suite поддерживается сквозной рабочий процесс, охватывающий стадии проектирования, дизайна и визуализации. Выбор продукта, в котором ведется работа в конкретный момент времени, обусловлен потребностями пользователя и выполняемыми операциями.

Компания «АйДиТи» — один из ведущих отечественных поставщиков лицензионного программного и аппаратного обеспечения, системный интегратор в области САПР и ГИС.

Компания «АйДиТи» осуществляет:

- поставки, как корпоративные, так и розничные, лицензионного программного обеспечения и оборудования для рабочих мест, офисов и центров обработки данных (САПР и ГИС для всех отраслевых направлений; системное, офисное, антивирусное и иное прикладное ПО; системы хранения и обработки данных; серверное и сетевое оборудование; рабочие станции и периферия);

- консалтинг и внедрение САПР и ГИС, технологии информационного моделирования (BIM);

- управление активами ПО (Software Asset Management, SAM);

- разработку и реализацию проектов ИTинфраструктуры;

- техническую поддержку и обучение.

Компания обладает высшими партнерскими статусами крупнейших мировых разработчиков, таких как Autodesk, Microsoft, Adobe, Corel, Kaspersky Lab, VMware, и сотрудничает со всеми ведущими производителями программного и аппаратного обеспечения.

Заказчики «АйДиТи» — это тысячи государственных и коммерческих структур, а также частных пользователей, работающих в различных отраслях.

Система менеджмента качества «АйДиТи» сертифицирована и соответствует ГОСТ Р ИСО 90012008.

«АйДиТи» ведет свою деятельность по всей территории России через свои представительства:

«АйДиТи — Центральный офис»

«АйДиТи — Северный Кавказ»

Кроссплатформенные возможности

Существует возможность использования профессиональных графических приложений на устройствах и операционных системах (iMAC или MacBook от Applе и их OS X), не поддерживающих установку и использование этих приложений. Не секрет, что Mac OS X поддерживает применение весьма ограниченного набора программных продуктов Autodesk. Среди них из входящих в состав Building Design Suite Ultimate — только AutoCAD. Поэтому использовать Revit и 3Ds MAX с таким устройством возможно лишь при подключении к виртуальной рабочей машине с операционной системой Microsoft Windows.

Citrix Systems, Inc. — лидер в области перехода к программно определяемым рабочим местам, объединяющей виртуализации, управлению мобильностью, сетевым технологиям и решениям по предоставлению программного обеспечения как услуги. Решения Citrix помогают организовать мобильность бизнеса, используя защищенные рабочие места, обеспечивающие сотрудникам непрерывный доступ к приложениям, десктопам, данным и коммуникациям с любого устройства, через любые сети и облака.

Ресурсоемкие задачи

Технология виртуальных рабочих столов позволяет также существенно упростить и облегчить реализацию задач, требующих максимального задействования ресурсов компьютера. Среди таких задач: рендеринг (для архитекторов и дизайнеров) и выполнение конструкторских расчетов (для специалистов по несущим конструкциям здания). Не секрет, что эти процессы занимают в среднем до нескольких часов. Применение же компьютера для других задач в это время не представляется возможным, так как активность процессора достигает 100%. Виртуальный рабочий стол в этом случае можно использовать подобно инструментам облачного рендеринга, но с применением профессиональных гибко настраиваемых инструментов, в отличие от ограниченного выбора настроек A360 Cloud Rendering. Так, например, в организации для подобных задач может использоваться один (или несколько — в зависимости от масштабов организации) виртуальный рабочий стол. Причем пользователи могут оставаться на своих рабочих местах, настраивая и следя за процессом расчета, и параллельно выполнять другие задачи на своем ПК.

Защита интеллектуальной собственности

Не исключены ситуации, когда проектная организация должна предоставить конфиденциальную информацию контрагентам или сотрудникам. В этом случае инфраструктура виртуальных рабочих столов поможет обеспечить сохранность данных (путем включения настройки запрета копирования данных через буфер обмена, запрета выхода в Интернет с виртуальной рабочей станции), а также ограничить время доступа к виртуальному рабочему столу.

Варианты приобретения

Существуют две возможности внедрения технологии виртуальных рабочих столов.

Первая: приобретение сервера виртуализации рабочих столов, — в этом случае, если сервер и рабочие станции находятся в одной локальной сети, подключение к Интернету не понадобится.

Вторая: приобретение услуг по аренде инфраструктуры виртуальных рабочих столов через подключение к Интернету.

Выбор способа должен зависеть от планируемой загрузки мощностей виртуальной станции. Если потребность в таких ресурсах возникает не часто и не регулярно, можно ограничиться услугами по аренде, если же планируется постоянное использование виртуальных машин, рациональнее будет приобрести сервер в собственность.

Преимущества и недостатки

К преимуществам использования инфраструктуры виртуальных рабочих столов в процессе выполнения проектных задач можно смело отнести следующее:

- уникальные возможности быстрого удаленного доступа к приложениям и данным при наличии весьма удобного интерфейса. Можно использовать любые локальные устройства, оснащенные специализированным клиентом и каналом передачи данных, связанные с сетевой структурой серверов. При этом обеспечивается доступ к ресурсоемким данным с менее мощных, но мобильных устройств, причем из любой точки планеты посредством подключения к Интернету;

- снижение издержек и гибкое администрирование, включая возможности масштабируемости системы, а также инструменты контроля, мониторинга и технической поддержки пользователей. Можно разместить все приложения и данные в едином комплексе. Можно гибко распределять мощности в зависимости от ресурсоемкости возникающих и меняющихся задач пользователей, не внося какиелибо изменения в существующие аппаратные средства. Можно четко и надежно разграничить доступ к корпоративной информации и оптимально организовать инфраструктуру доставки приложений и данных на основе унифицированных рабочих мест;

- снижение общих затрат на ИТинфраструктуру. Можно приобретать меньшее количество лицензий программного обеспечения, но использовать их в существенно большем объеме и гораздо рациональнее. Можно сократить штат необходимых технических специалистов. Можно сократить эксплуатационные расходы за счет экономии на площадях, занимаемых рабочими местами пользователей;

- высочайшая степень надежности и сохранности информации, основанная на отказоустойчивости аппаратных средств и особенностях организации виртуальной инфраструктуры;

- исключительная информационная безопасность, практически полностью изолирующая виртуальную машину от вредоносных атак;

- энергосбережение при большом количестве локальных рабочих мест — совокупное энергопотребление серверной части и тонких клиентов окажется в этом случае существенно ниже такового у рабочих станций.

Недостатки же у технологии виртуальных рабочих столов весьма условны и в большинстве своем вполне разрешимы. Значительную их часть, связанную с аппаратной мощностью и скоростью работы, можно попросту и не заметить, если научиться грамотно распределять ресурсы виртуальных машин на основе экономного и разумного разделения задач. Некоторые затруднения могут возникнуть лишь в тех случаях, когда отдельные аппаратные средства или интерфейсы не поддерживаются платформой виртуализации.

Итак, мы видим, что применение технологии виртуальных рабочих столов объективно сулит изрядные бонусы. Высокопрофессиональные специалисты могут работать где, когда и на чем им вздумается, выполняя проекты быстрее и с меньшими издержками. Осталось лишь на практике убедиться, что производительность действительно высокая, а качество при этом не страдает.

С этой целью во второй части публикации мы приведем и проанализируем результаты тестирования производительности при выполнении различных задач моделирования и рендеринга на различных комбинациях настольного и виртуального ПК с разным качеством передачи данных по сети Интернет и по локальной сети.

Централизация рабочих столов и клиентских ПК в центре обработки данных сегодня все чаще становится предметом обсуждения в IT-сообществе, особенно интересен такой подход для крупных организаций. Одной из наиболее «горячих» технологий в этом отношении является VDI. VDI позволяет централизовать обслуживание клиентских окружений, упростить развертывание приложений, их настройку и конфигурирование, а также обновление и контроль соответствия требованиям безопасности.

VDI «отвязывает» рабочий стол пользователя от аппаратного обеспечения. Развертывать можно как постоянный виртуальный рабочий стол, так и (наиболее частый вариант) гибкую виртуальную машину. Виртуальные машины включают индивидуальный набор приложений и настроек, который разворачивается в базовой ОС при авторизации пользователя. После выхода из системы, ОС возвращается в «чистое» состояние, убирая любые изменения и вредоносные программы.

Для системного администратора это очень удобно — управляемость, безопасность, надежность на высоте, обновлять приложения можно в едином центре, а не на каждом ПК. Офисные пакеты, интерфейсы к базам данных, интернет-браузеры и прочие нетребовательные к графике приложения могут работать на любом сервере (всем известные терминальные клиенты 1С).

Но что делать, если хочется виртуализовать более серьезную графическую станцию?

Тут не обойтись без виртуализации графической подсистемы.

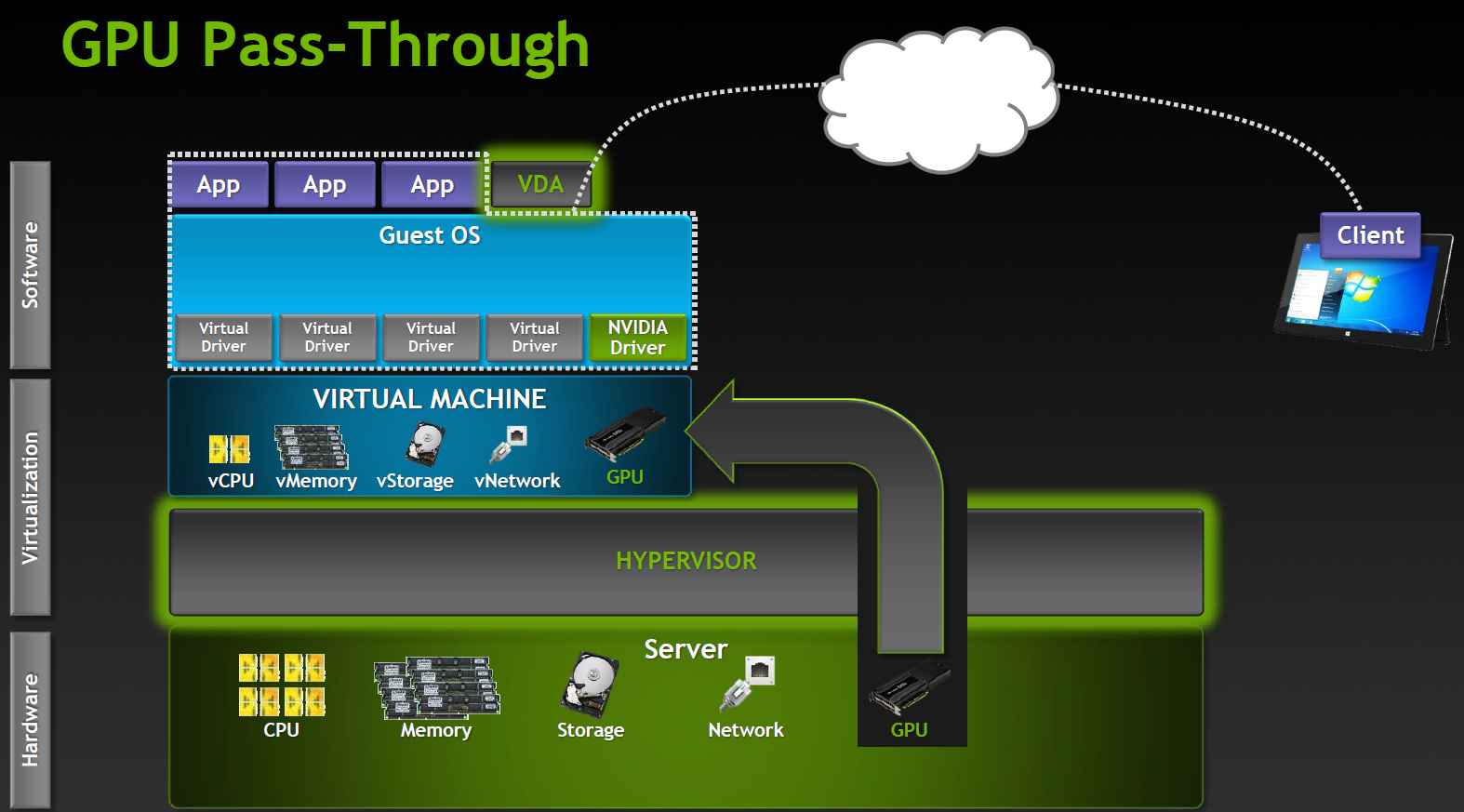

- GPU pass-through: 1:1 выделенный GPU на ВМ

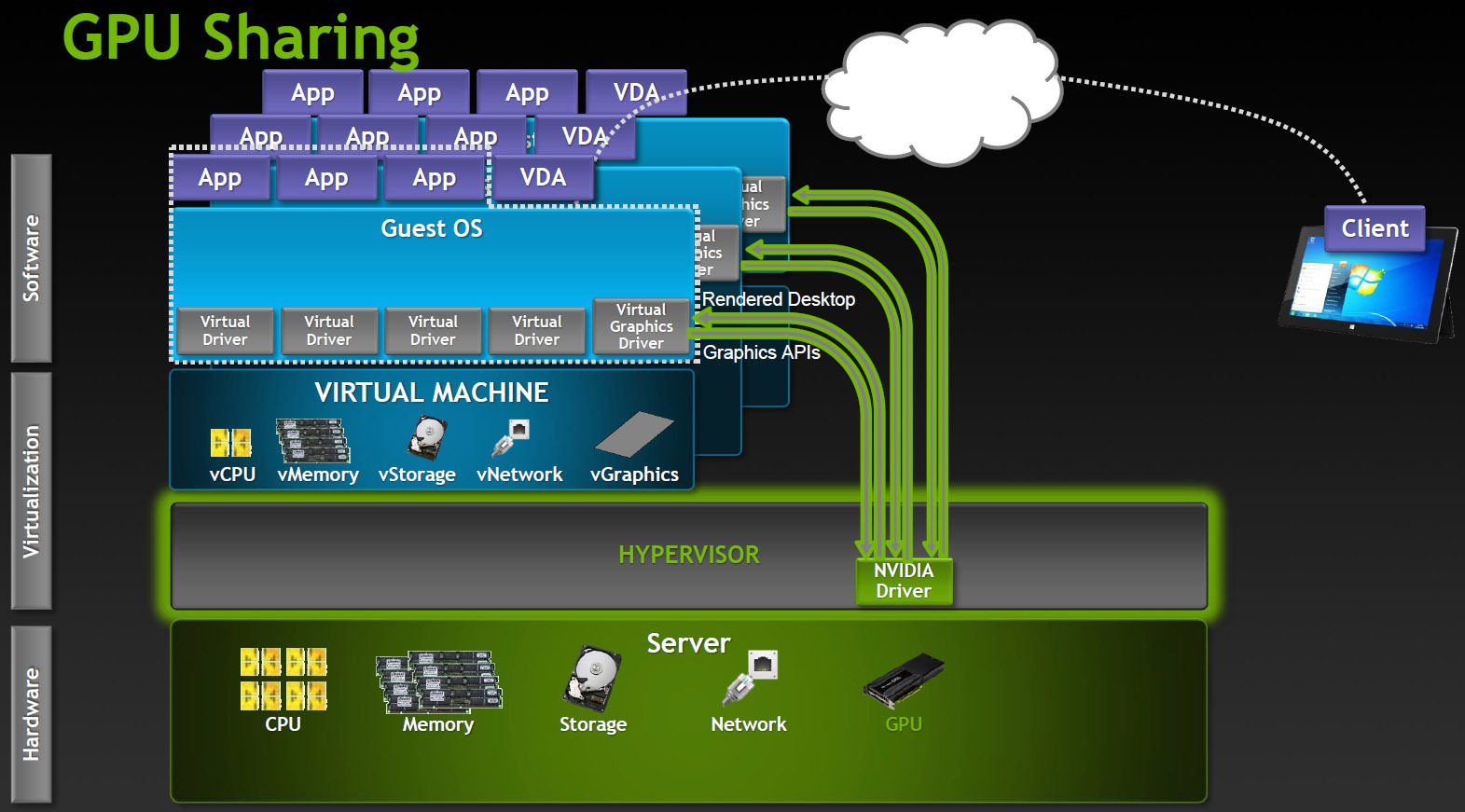

- Shared GPU: Программная виртуализация GPU

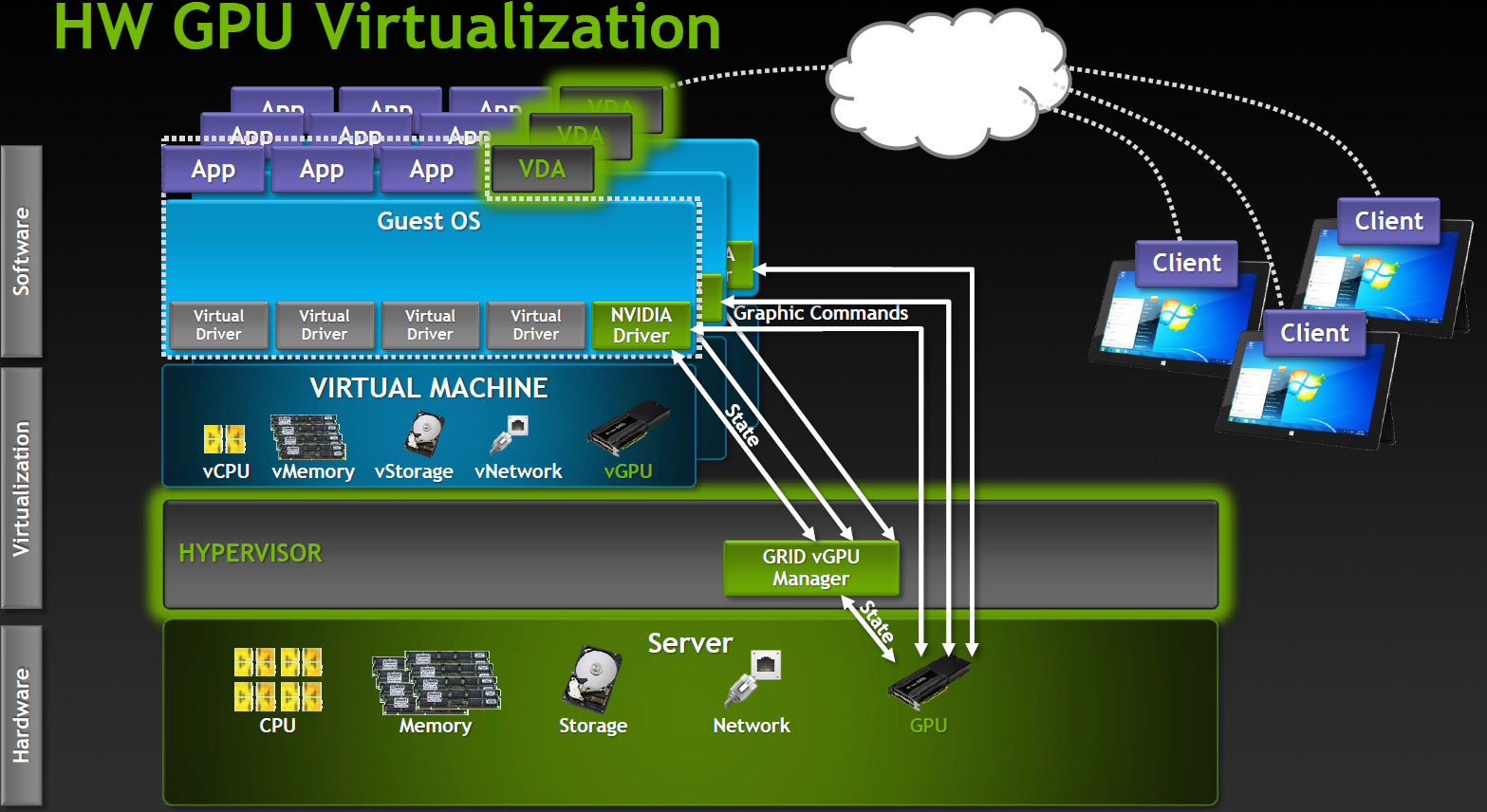

- Virtual GPU: Аппаратная витруализация (HW&SW)

Рассмотрим подробнее

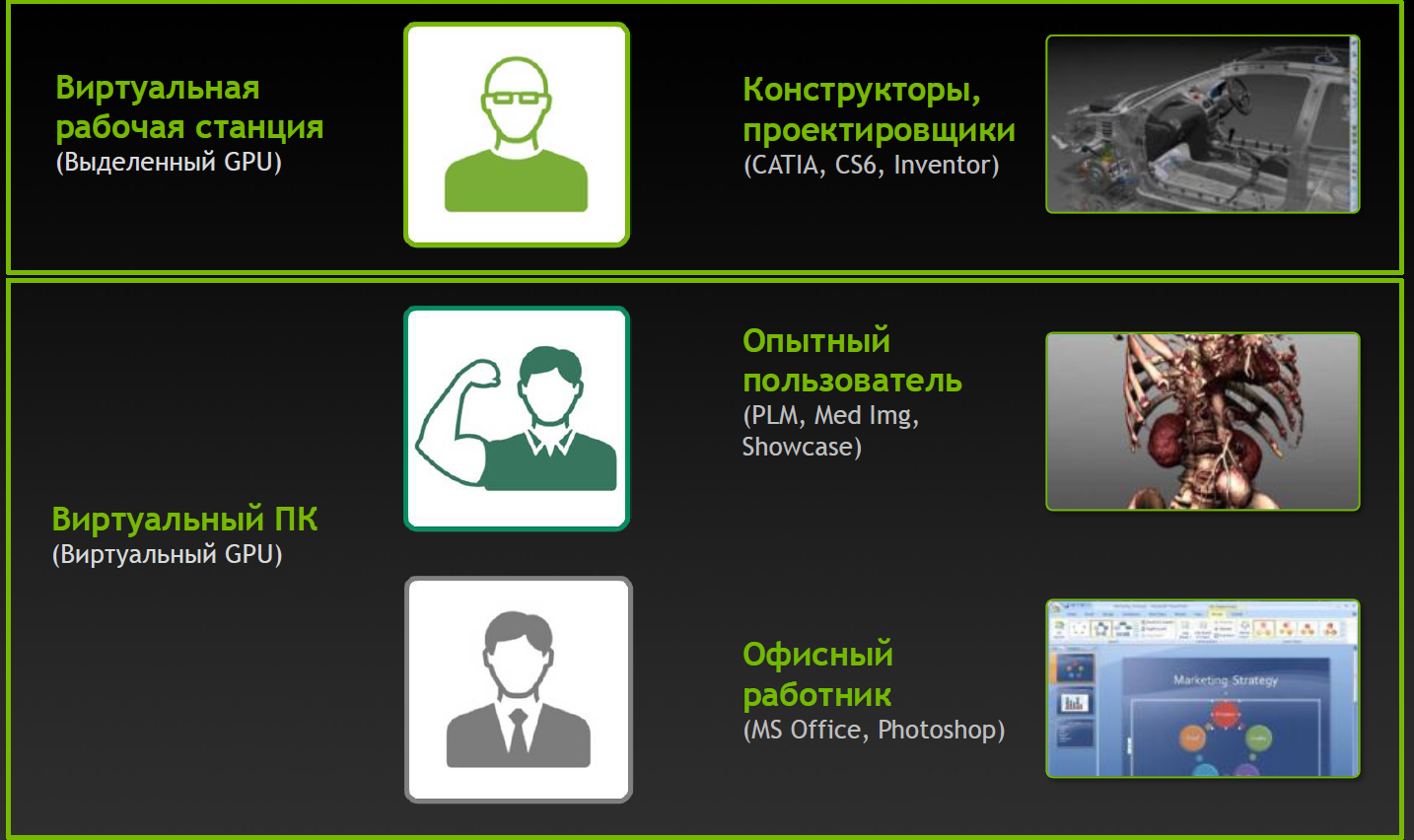

Выделенный GPU

Наиболее производительный режим работы, поддерживается в продуктах Citrix XenDesktop 7 VDI delivery и VMware Horizon View (5.3 or higher) with vDGA. Полностью работают NVIDIA CUDA, DirectX 9,10,11, OpenGL 4.4. Все остальные компоненты (процессоры, память, накопители, сетевые адаптеры) виртуализованы и разделены между инстансами гипервизора, однако один GPU остается одним GPU. Каждая виртуальная машина получает свой GPU практически без пенальти по производительности.

Очевидное ограничение — количество таких виртуальных машин ограничено количеством доступных графических адаптеров в системе.

Shared GPU

Работает в Microsoft RemoteFX, VMware vSGA. Этот вариант полагается на возможности ПО для VDI, виртуальная машина работает как будто с выделенным адаптером и и серверный GPU также полагает, что работает с одним хостом, хотя на самом деле это уровень абстракции. Гипервизор перехватывает вызовы API и транслирует все команды, запросы отрисовки и прочее до передачи графическому драйверу, а хост машина работает с драйвером виртуальной карты.

Shared GPU вполне разумное решение для многих случаев. Если приложения не слишком сложные, то одновременно может работать значительное число пользователей. С другой стороны, на трансляцию API тратится достаточно много ресурсов и при этом невозможно гарантировать совместимость с приложениями. Особенно с теми приложениями, которые используют более новые версии API, чем существовавшие на момент разработки VDI продукта.

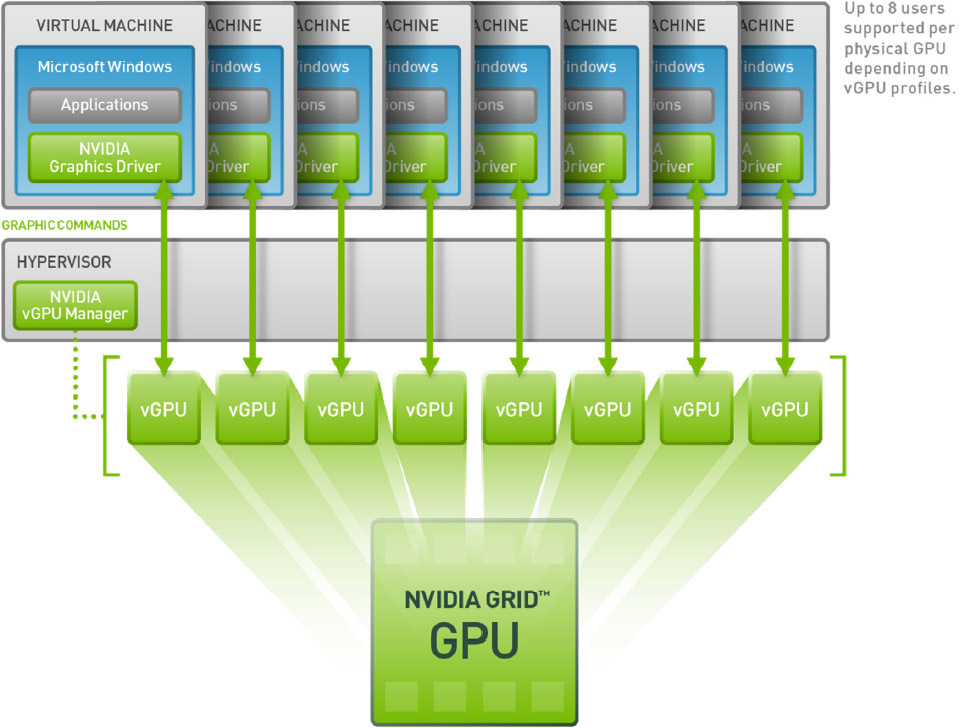

Virtual GPU

Наиболее продвинутый вариант разделения GPU между пользователями, поддерживается на данный момент только в продуктах Citrix.

Как это работает? В VDI среде с vGPU каждая виртуальная машина работает через гипервизор с выделенным драйвером vGPU, который есть в каждой виртуальной машине. Каждый драйвер vGPU посылает команды и управляет одним физическим GPU, используя выделенный канал.

Обработанные кадры возвращаются драйвером в виртуальную машину для отправки пользователю.

Такой режим работы стал возможен в последнем поколении GPU производства NVIDIA — Kepler. В Kepler есть Memory Management Unit (MMU) который транслирует виртуальные адреса хоста в физические адреса системы. Каждый процесс работает в собственном виртуальном адресном пространстве, а MMU разделяет их физические адреса, чтобы не было пересечения и борьбы за ресурсы.

Воплощение в карточках

Модельный ряд

| GRID K1 | GRID K2 | |

| Number of GPUs | 4 x entry Kepler GPUs | 2 x high-end Kepler GPUs |

| Total NVIDIA CUDA cores | 768 | 3072 |

| Total memory size | 16 GB DDR3 | 8 GB GDDR5 |

Разновидности для VDI

Но простого деления по характеристикам мало, для GRID доступно деление на виртуальные профили vGPU.

Видение типов пользователей

| Карта | Количество GPU | Виртуальный GPU | Тип пользователя | Объем памяти (МБ) | Количество виртуальных экранов | Максимальное разрешение | Max количество vGPU на GPU/карту |

| GRID K2 | 2 | GRID K260Q | Дизайнер/проектировщик | 2048 | 4 | 2560x1600 | 2/4 |

| GRID K2 | 2 | GRID K240Q | Дизайнер/проектировщик среднего уровня | 1024 | 2 | 2560x1600 | 4/8 |

| GRID K2 | 2 | GRID K200 | Офисный сотрудник | 256 | 2 | 1920x1200 | 8/16 |

| GRID K1 | 4 | GRID K140Q | Дизайнер/проектировщик начального уровня | 1024 | 2 | 2560x1600 | 4/16 |

| GRID K1 | 4 | GRID K100 | Офисный сотрудник | 256 | 2 | 1920x1200 | 8/32 |

Профили и применения

Профили с индексом Q сертифицированы под ряд профессиональных приложений (например, Autodesk Inventor 2014 и PTC Creo) так же, как и карты серии Quadro.

Полное виртуальное счастье!

NVIDIA не была бы верна себе, если бы не подумала о дополнительных разновидностях. Определенную популярность набирают сервисы игр по запросу (Gaming-as-a-Service, GaaS), где тоже можно получить неплохой бонус от виртуализации и возможности разделить GPU между пользователями.

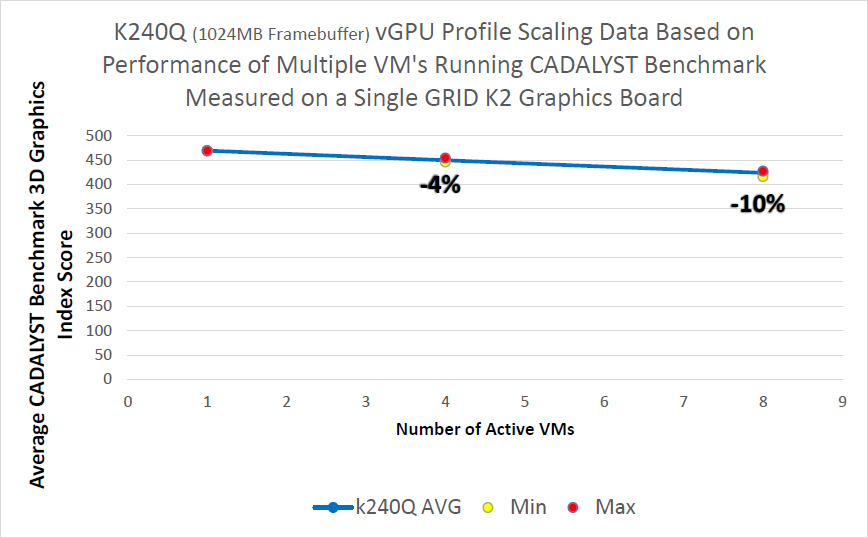

Влияние виртуализации на производительность

Конфигурация сервера:

Intel Xeon CPU E5-2670 2.6GHz, Dual Socket (16 Physical CPU, 32 vCPU with HT)

Memory 384GB

XenServer 6.2 Tech Preview Build 74074c

Конфигурация виртуальных машин:

VM Vcpu: 4 Virtual CPU

Memory: 11GB

XenDesktop 7.1 RTM HDX 3D Pro

AutoCAD 2014

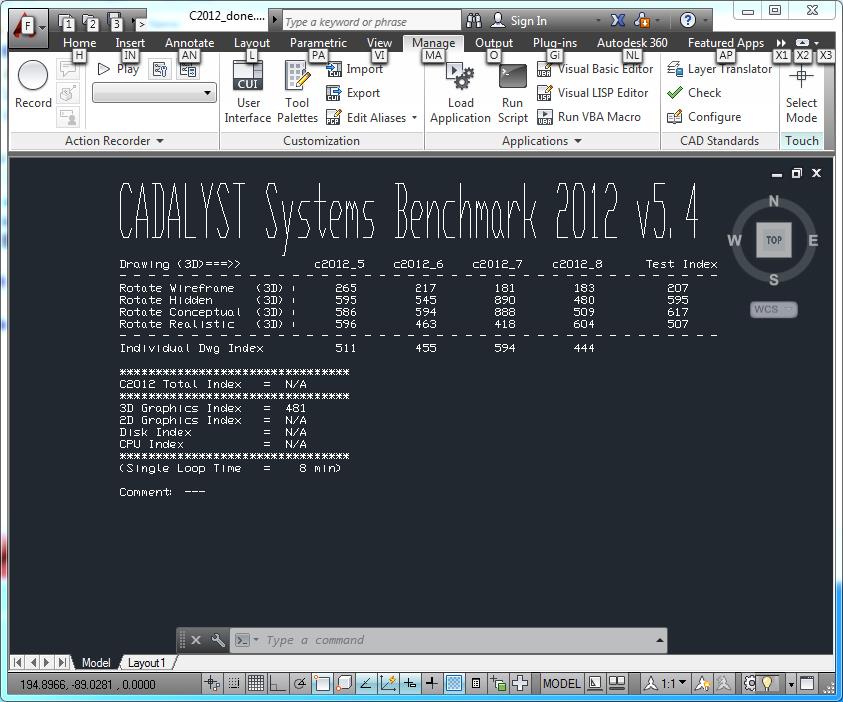

Бенчмарк CADALYST C2012

NVIDIA Driver: vGPU Manager: 331.24

Guest driver: 331.82

Методика измерений простая — в виртуальных машинах запускался тест CADALYST и сравнивалась производительность при добавлении новых виртуалок.

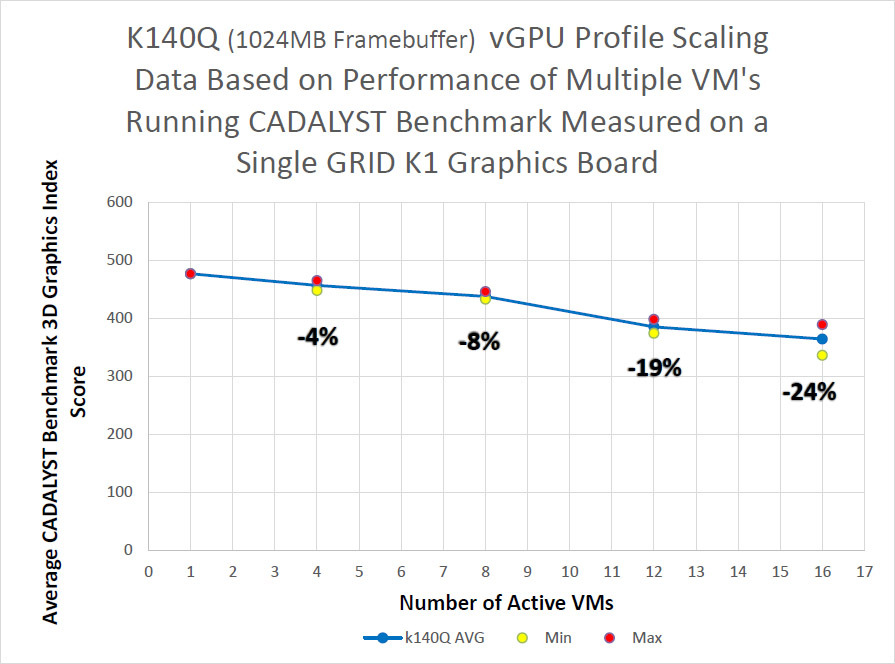

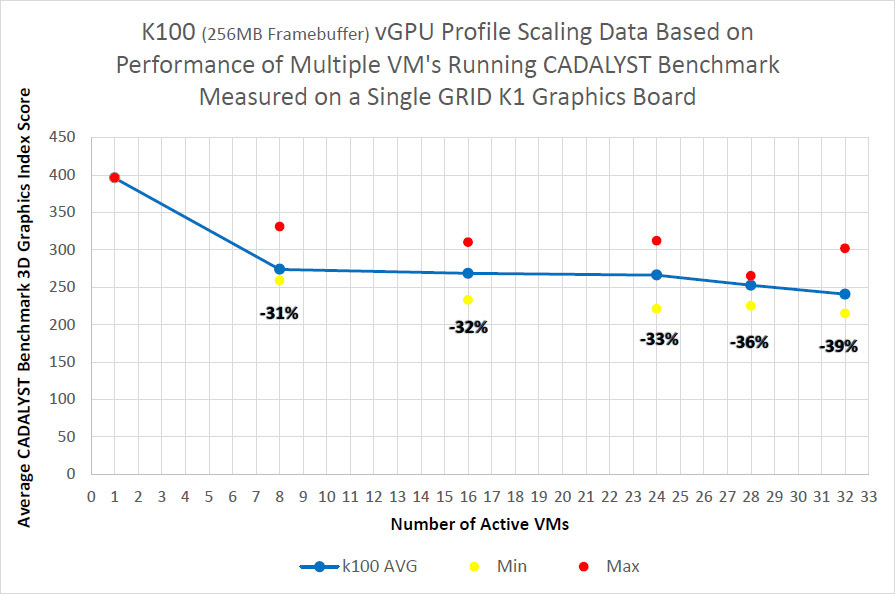

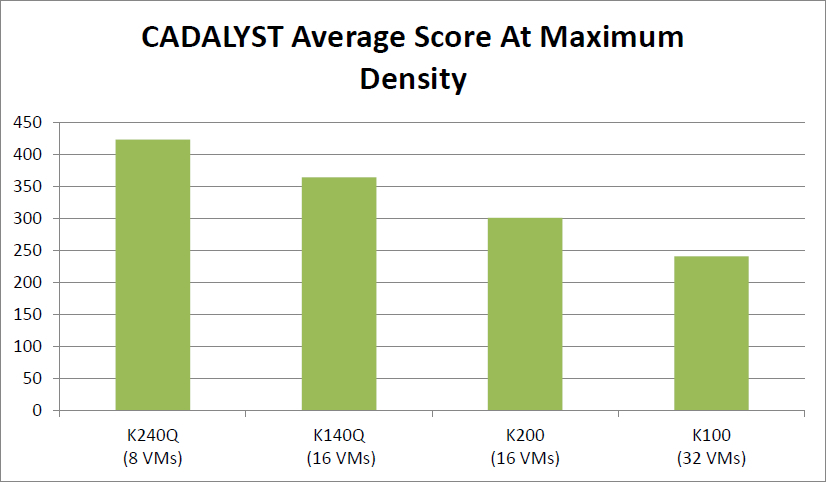

Как видно из результатов, для старшей модели K2 и сертифицированного профиля падение составляет порядка 10% при запуске 8 виртуальных машин, для модели K1 падение сильнее, но и виртуальных машин в два раза больше.

Абсолютный результат карт при максимальном числе виртуальных машин:

Куда ставить карты?

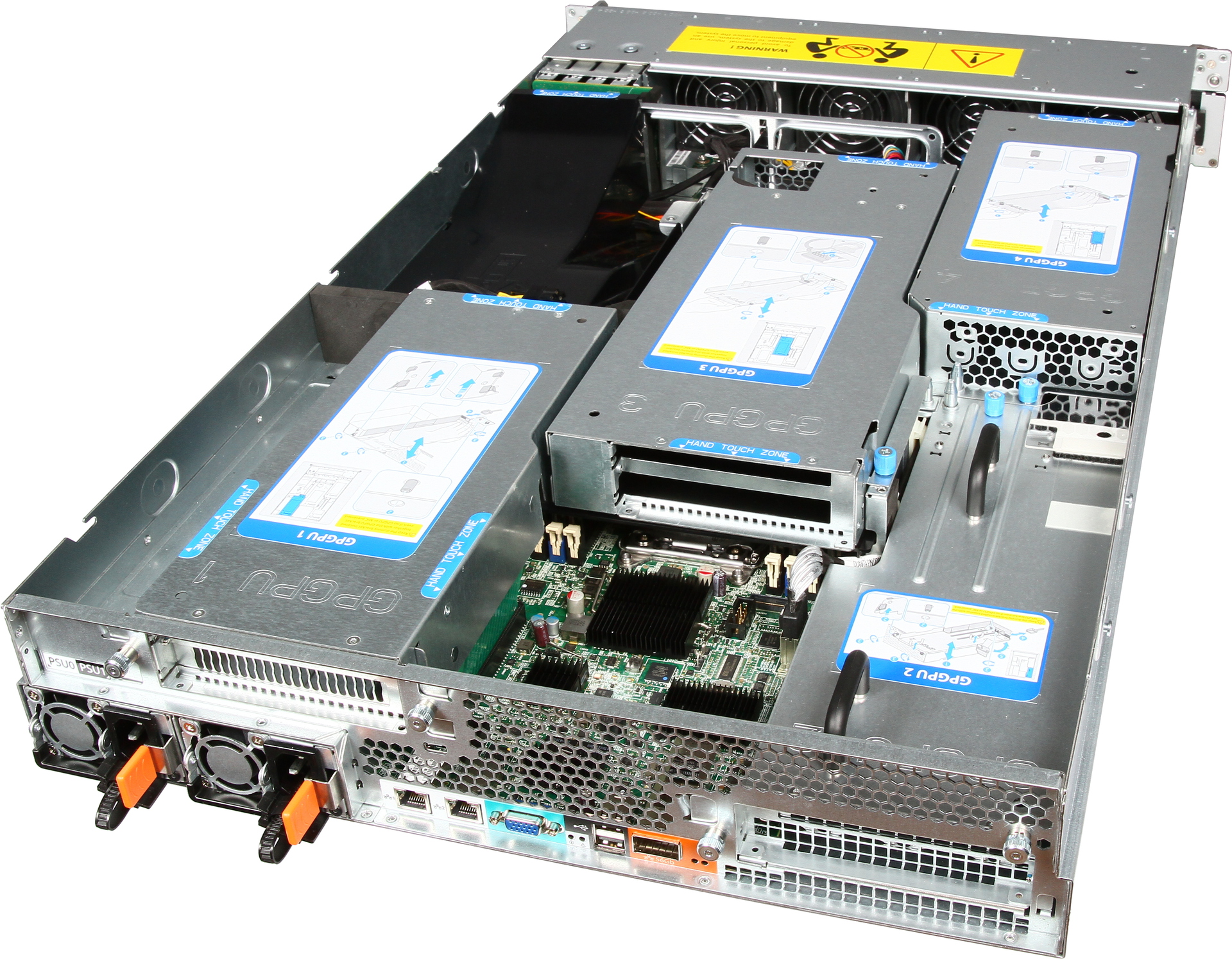

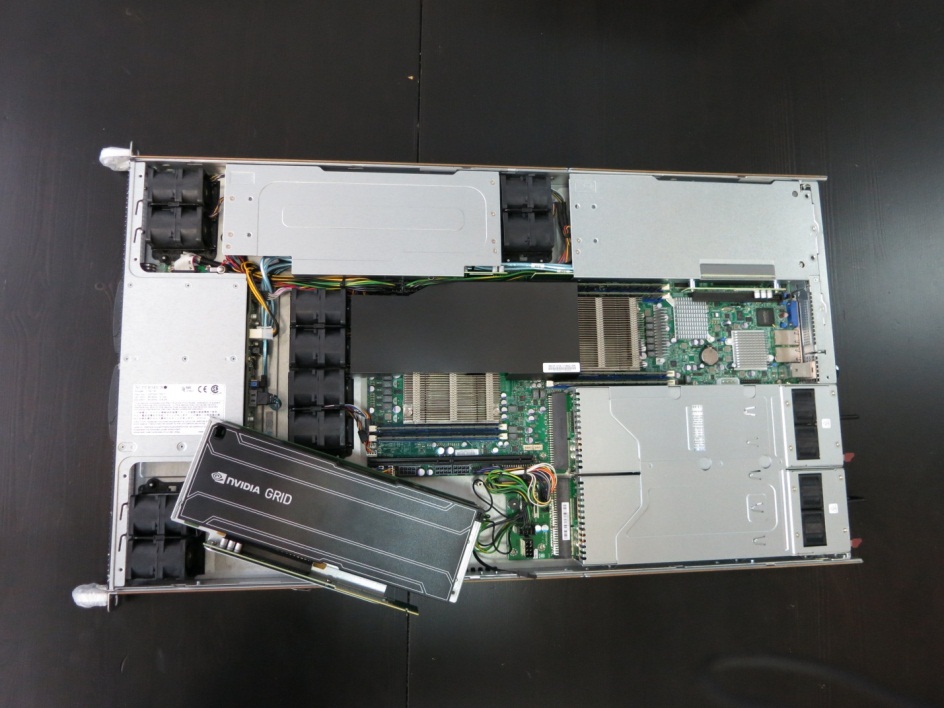

У нас представлена модель Hyperion RS225 G4, предназначенная для установки 4 Intel Xeon Phi или GPGPU карт.

Два процессора Xeon E5-2600 v2, до 1 терабайта оперативной памяти, 4 посадочных места под жесткие диски, InfiniBand FDR или 40G Ethernet для подключения к высокоскоростной сети и пара стандартных гигабитных сетевых разъемов.

Терминальный сервер для CAD систем интересовал меня давно и данная статья является результатом изысканий в сети Интернет. В этой статье поговорим конкретно о терминальном сервере для Автокада.

Автокад довольно ресурсоёмкое приложение требующее все ресурсы железа: и оперативную память, и видеокарту, и мощный процессор и быстрые диски. И сразу напрашивается мысль, что отдельностоящие мощные ПК – это самый хороший вариант. Но мы постарались развернуть терминальный сервер для этого приложения и применить его на практике.

- платформа Supermicro (уже некруто, но все же довольно шустро);

- 2 процессора E5-2260 v4 с 28 физическими ядрами, а с включенной функцией hyperthreading 56 ядер;

- гипервизор – хостовая операционная система Citrix Xenserver 7.0;

- гостевая операционная система Server 2016 Standart;

- Raid массив 10 — 4 диска HDD по 1 TB со скоростью вращения 10000 оборотов в минуту;

- Ethernet 1 Gb/sek;

- самый важный компонент – 2 видеоускорителя Tesla m60 16 Gb.

Искал как сделать терминальный сервер с доставкой его через citrix receiver — не нашел агента VDAforHDX 3dPro для серверной ОС, если кто знает как и что, просьба, киньте ссылку в комментарии, поэтому создал сервер с доставкой его через RDP.

Начнем по порядку:

- создание виртуальной машины в Citrix Xendesctop;

- установка операционной системы для виртуальной машины Server 2016 Standart;

- установка обновлений для ОС виртуальной машины;

- установка гостевых служб Citrix на виртуальную машину – после этого в контекстном меню виртуальном машины появятся пункты shutdownи restart — что позволить выключать и перезагружать виртуальную машину из Xenserver корректно (до этого были только force shutdown и force reboot);

- пробрасываем в виртуальную машину видеокарту Teslam60 методом passthrough.

Далее согласно статье устанавливаем оба драйвера, но, полагаю, для виртуальной машины можно было установить только grid driver. Дальше драйверов больше ничего не делаем из этой статьи.

Потом необходимо зайти в панель управления nvidia и в параметрах 3d выбрать видеокарту по умолчанию Tesla m60, кстати, после этого у меня исчезла возможность выбора видеокарты по умолчанию и отображается теперь всегда вот так:

Далее необходимо установить роль терминального сервера и включить следующую групповую политику: Конфигурация компьютера – Административные шаблоны – Компоненты Windows – Службы удаленных рабочих столов – Узел сеансов удаленных рабочих столов – Среда удаленных сеансов – Для всех сеансов службы удаленных рабочих столов используйте аппаратный графический адаптер по умолчанию

Так как мы создаем терминальный сервер, то в результате работы пользователей в каком-либо из приложений будут создаваться временные файлы, поэтому для того, чтобы минимизировать нагрузку на файловую подсистему можно установить Ram-диск и перенести на него временные файлы – В параметрах системы – Дополнительные параметры системы – вкладка Дополнительно – кнопка Переменные среды:

Измените следующие переменные как для пользователя так и для системы:

TMP

TEMP

Чтобы сменить обычному пользователю данные переменные – сделайте его администратором – измените переменные, а потом заберите права администратора. В переменных не указывайте корень Ram-диска – некоторые программы не будут из-за этого работать, создайте папку в Ram-диске – как у меня T:\temp. Также на эту папку дайте полные права для пользователей.

После перезагрузки сервер готов к работе и если мы запустим Автокад, то увидим что аппаратное ускорение включено.

Все тесты проводились c использованием лицензии GridVirtualAPP — в панели управления Nvidia — в разделе Лицензирование. Для использования QuadroDataCenterWorkstation необходимо установить сервер лицензирования и купить соответствующие лицензии. Они у нас куплены – но все же тестирование проводилось под лицензиями GridVirtualaPP.

Запустили на одном клиенте и увидели радостные 50-70 fps – видеокарта работает.

Запустили на трех и fps начал скакать от 25 до 60 – в среднем 35-40 — качество заметно просело начали появляться небольшие лаги.

После включения еще 3 все стало еще хуже fps начали просидать до 10 а процессор видеокарты нагрузился до 100%

В результате полученных результатов поняли, что на терминальном сервере лучше не запускать webgl технологии – и, вообще, если есть возможность предоставить доступ к сети интернет из под локального браузера. Во первых пользователь может открыть в 10 браузерах по 100 вкладок и тут уж точно никакой сервер не выдержит. И, во-вторых, без интернета терминальный сервер будет целее.

Теперь приступим к обзору тестирования автокада на нашем сервере.

Сначала мы зашли на терминальный сервер с 16 тонких клиентов и запустили автокад, в автокаде запустили стандартные чертежи, черчением не занимались.

Здесь нет графика использования оперативной памяти, но скажу что у сервера сначала было 20 Гб, но после подключения 13 клиентов ее потреблялось 18,2 и AutoCAD начал выводить ошибки о нехватке памяти. После этого мы добавили еще 10 Гб оперативки и ошибки ушли, а потребление оперативной памяти не поднималось выше 22 Гб. Из полученных графиков видно что использование процессора сервера идет на 50%, дисковая подсистема особо не задействована, сетевая активность максимум 20 Мбит\сек выдавало и то скачками, средний показатель до 1 Мбит, как ни странно, но вот использование видеопамяти значительное 7,2 Гб из 8. Отсюда можно сделать вывод что максимальное количество пользователей 16, и то это практически без запаса, и в тот момент когда в Автокаде не чертят, а просто открыли чертеж.

Далее Мы посадили за тонкие клиенты студентов 3 курса и попросили начертить небольшие детали в 3d и 2d. Сначала запустили автокад со всех тонких клиентов:

Видеопамять просто запущенный автокад без открытия чертежа потребил 2,9 Гб.

Далее студни начали чертить, кто 2d, кто 3d, примерно 50 на 50. Жалоб особых не было, полагивало в момент открытия чертежа, и совсем небольшие задержки, которые очень редки и впечатление от черчения как на локальном ПК.

Сразу можно сделать вывод, что в данной конфигурации не хватает 8 ядер CPU, лучше сделать 10 или 12, оперативной памяти вполне хватает, но лучше выделить порядка 2-3 Гб на пользователя.

Потом на одной станций попытались отрендерить чертеж – рендерили 3d-модель 4 стен и сразу получили лаги в работе автокада – некоторые студенты начали жаловаться, что иногда работать стало рывками. Мы попросили выйти 5 студентов и лаги прекратились, хотя, на одной станции все еще рендерился чертеж. Ниже графики, когда 16 студентов работают и рендеринг запущен – как раз можно увидеть момент запуска рендеринга.

В принципе, нам этого хватило, но мы решили пойти дальше и запустили рендеринг еще на 3 местах и автокад начал тормозить везде так, что работать было явно не приятно, но все же надо отметить одного студента, у него все работало… но и чертеж у него был из линий 10…

Из этого можем сделать вывод, что Терминальный сервер на виртуальной машине с проброшенной методом passthrough 1ой TeslaM60 можно использовать для работы в автокаде по rdp-протоколу с количеством пользователей до 15, лучше примерно 12-13 на сервер, чертить можно и в 2d и в 3d (небольшом), но без рендеринга.

Где использовать: при обучении работе в автокаде – в тех дисциплинах, где НЕ нужен рендеринг (или еще какие-либо высокотребовательные технологии), например, для автоматизаторов или технологов, которые чертят только в 2д. Строители, механики и другие высокотребовательные автокадные личности будут сильно жаловаться и плеваться. Но если у вас есть такой сервер, а у требовательных личностей сильно устарели компьютеры, то они с радостью почертят и на таком сервере без использования рендеринга, так как рендеринг чертежа это заключительный этап непосредственно перед сдачей зачета по дисциплине и этот момент можно распределить во времени, например, запускать по очереди. Но для этого необходим адекватный преподаватель или же лаборант, который смотрит за компьютерным классом процессом черчения.

Что облегчает терминальный сервер: Во первых, время установки – это, от силы, день установки и настройки, нежели переустановить 15 компьютеров, скачать обновления и поставить на каждом автокад. Во вторых, администрирование одного сервера, а не 15 компьютеров.

Минусы: Во-первых, один сервер – это одна точка отказа, умер сервер, умер Ваш учебный процесс. Поэтому необходим второй такой сервер, но так как это виртуальный сервер, то лучше чтобы хостовых серверов было два и делались бекапы виртуальных машин, и, если один выйдет из строя, то Вы быстро запустите виртуальную машину из бекапа на втором.

Во-вторых, ресурсы сервера используют сразу много пользователей, и, если найдется один слишком умный пользователь, который назапускает много всего, то ресурсов останется мало и может залагать у всех. Но за этим как раз и должен следить как администратор сервера, так и преподаватель группы студентов.

В-третьих rdp он и в Африке rdp. Будет сбоить сеть, будет невозможно работать и оптимизация rdp-протокола конечно значительно повышает качество использования, но все же есть некоторые нарекания в работе данной технологии и не все приложения нормально с ней работают.

Почему выбрали rdp – потому, что прочитали здесь, что автокад поддерживает работу через этот протокол. Но лучше использовать Citrix Receiver, но к сожалению я не нашел мануал как использовать Citrix XenDesktop для терминального сервера, в котором есть CAD-приложения – все найдные мануалы только для отдельных виртуальных машин с desktop os – win7, 8 или 10, в которых при установке указывается тип VDA агента – forHDX 3dpro, а вот для серверной ОС нет такого агента, есть только просто VDA. Агент VDAforHDX 3dPro для виртуальных машин у которых есть видеокарта. Если кто знает, как сделать такой же терминальный сервер с помощью Citrix XenDesktop и если знаете где найти VDAforHDX 3dPro для серверной ОС напишите, пожалуйста в комментариях.

Теперь давайте посчитаем сколько это все стоит.

Железный сервер с 2мя Tesla M60 нам обошелся 1 500 000р

Гипервизор XenServer7.0 – 125 000р

WindowsServerобойдется примерно 60 000

Терминальная лицензия – 1 700 р (одна штука)

Максимум мы можем создать 4 таких терминальных сервера, потому что в гипервизоре 2 видеокарты Tesla M60 отображаются как 4. 4 терминальных сервера потянут максиму 50-60 клиентов.

При использовании XenServer в качестве гипервизора:

Если 60 пользователй на сервер

1500 000+ 125 000 + 60 000 * 4 + 1700 *60 = 1967000

В пересчете на рабочее место 32783 р

Если 50 пользователей на сервер:

1500 000 + 125 000 + 60 000 * 4 + 1700 *50 = 1950000

В перерасчете на рабочее место 39000

Если взять в качестве гипервизора WindowsServer 2016 DataCenter то за ОС виртуальных машин платить не надо, а сам Server 2016 стоит в редакции DataCenter на 28 ядер примерно 250000

1500 000 + 250000+ 1700*60=1852000

30886 руб за рабочее место в перерасчете на 60 пользователей

Подключение можно производить например с помощью тонких клиентов стоимостью до 20000 рублей, например hp T620, или неттопов, например, Lenovo m600, но самый лучший вариант использовать самосборы. Вот пример такого самосбора с никса

- Desktop SilverStone Milo ML05 <SST-ML05B> Black Mini-iTX Без БП 1 шт. 3 690

- Блок питания NAVAN <SFX-400W> 400W SFX (24+4пин) 1 шт. 1 378

- ASRock H110M-ITX (RTL) LGA1151 PCI-E DVI+HDMI GbLAN SATA Mini-ITX 2DDR4 1 шт. 4 305

CPU Intel Core i3-7320 4.1 GHz/2core/SVGA HD Graphics 630/ 4Mb/ LGA1151 1 шт. 10 331

SSD 120 Gb SATA 6Gb/s ADATA Ultimate SU700 <ASU700SS-120GT-C> 2.5" 3D TLC 1 шт. 3 813

Crucial DDR4 RDIMM 4Gb <PC4-17000> CL15 ECC Registered 1 шт. 4 428

21.5" ЖК монитор Acer <UM.WV6EE.A09> V226HQL Abmd (LCD,Wide, 1920x1080, D-Sub, DVI) 1 шт. 6 703

2Gb <PCI-E> DDR3 MSI GT710 2GD3H LP (RTL) D-Sub+DVI+HDMI 1 шт.

3 321

Итого: 37 969 руб. (617.48 у.е.)

Купив тонкий клиент Вы затратите 30 000 рублей вместе с монитором клавиатурой и мышью, у него будет предустановленная операционная система, предназначенная только для удаленного подключения куда-либо и не совсем корректно работающий браузер. Но затратив чуть больше и купив самосбор за 40 тыс. рублей Вы получете полноценный пк еще и с хрошим процессором и видеокартой. Установив на него бесплатный линукс, например Ubuntu либо Linux Mint — Вы получите полноценную ОС с возможностью установки дополнительго программного обеспечения — таковым могут быть разнообразные приложения — от текстовых редакторов до CAD-приложений. На них даже можно будет установить аналоги AutoCAD, например, BricksCad, но все же если в вашем образовательном учреждении обучают работе в приложениях под Windows, то придется либо ставить на каждую рабочую станцию Windows, либо развернуть терминальный сервер.

Я за терминальные сервера, если приложение позволяет использовать режим запуска его многими пользователями с одного сервера. При этом увеличив количество пользователей на сервере вы удешевите цену лицензии ОС в расчете на одного пользователя. Особенно это актуально, в настоящее время, когда Dream Spark от мелкософтных закрыт для России, а постановление правительство запрещает закупку без обоснования иностранного ПО для образовательных учреждений. Кроме того в новых майских указах планируют перевести весь госсектор на отечественное ПО к 24 году, каким образом непонятно, и поэтому запасаться ПО необходимо сейчас.

Давайте рассчитаем цену за рабочую станцию в нескольких вариантах.

Итого в минимальной конфигурации одно рабочее место будет стоить:

тонкий клиент — 20000 р

монитор — 7000 р

мышь клавиатура — 2000 р

рабочее место на терминальном сервере — 30000 р

Итого 59 000

Если же Покупать самосбор и Windows:

самосбор с монитором 38000 р

клавиатура мышь — 2000 р

Windows 10 pro — 9000 р

Итого 49000

10000 р небольшая переплата, но выбрав второй вариант увеличиваются затраты на администрирование: установка windows и драйверов занимает больше времени, нежели просто включить тонкий клиент, либо установить линукс минт. Кроме того необходимо позаботиться об антивирусном обеспечении, и, по опыту могу сказать что 95 процентов всех вирусов для Windows.

Если же выбрать третий вариант — терминальный сервер и самосбор с линуксом, то получим:

рабочее место на терминальном сервере — 30000 р

самосбор с монитором 38000

клавиатура мышь 2000 р

итого: 70000 р

Цена довольно большая и за эти деньги можно купить неплохой самосбор, как раз для Cad приложений, но опять, же администрирование отдельностоящих пк тяжелее, чем администрирование сервера, тем более когда речь идет о 60 машинах. Но производительность будеть лучше чем на терминальном сервере, особенно, в рендеринге. Также хочу отметить еще то, что сервер без нагрузки — когда им пользуется один пользователь неплохая графическая станция, которую можно отдать в пользование научным работникам кафедры для тяжелого рендеринга в то время, когда нет пар.

Кроме того сервер можно использовать, деля его ресурсы во времени, например, есть два компьютерных класса со старой техникой, но обоим необходим автокад. Пусть одни используют его на первой паре, а вторые на второй. Таким образом можно увеличить количество рабочих станций в двое и цена одного рабочего места упадет ниже 30000.

Можно разрешать подключение студентам к серверу из дома или вузовской библиотеки, предоставив тем самым все программное обеспечение необходимое для курсовых, практических или дипломных работ.

Использовать ли такие сервера в учебном процессе, вопрос спорный. Но время движется вперед и виртуализация становится все дешевле, доступней и стабильней. Кроме того такой сервер позволяет увеличить скорость создания компьютерного класса в разы.

Еще один момент — если купить сервер не с 2 видеокартами а с 4, то цена за рабочее место упадет еще.

Вопрос сложный и необходимо взвешивать все за и против и отталкиваться от конкретно поставленной задачи для чего и почему.

Отсутствие аппаратного ускорения графики является существенным препятствием при внедрении технологий виртуализации в компаниях, работающих в сфере дизайна, проектирования, конструкторских разработок и пр. Рассмотрим, какие новые возможности появились с выходом NVIDIA GRID.

Виртуализация рабочих мест (VDI) уже прочно вошла в нашу жизнь, в первую очередь в корпоративном сегменте рынка, и уверенно пробивает путь в остальные сегменты, в том числе и в виде публичных облачных сервисов (Desktop as a Service). Отсутствие же аппаратного ускорения графики сдерживает использование данной технологии в тех отраслях, которые могли бы оценить такие преимущества использования VDI как удаленную доступность, безопасность данных и упрощение аутсорсинга персонала.

Первые шаги к использованию 3D ускорения в VDI были сделаны достаточно давно и заключались в пробросе PCI устройств в виртуальные машины, что позволяло выдавать для VDI видеокарты, установленные в сервер или подключенные к серверу с помощью внешних PCIe корзин, например, таких как Dell PowerEdge C410x. Недостатки такого решения очевидны — повышенное использование электроэнергии, места в стойках и высокая стоимость.

Коротко о технологии NVIDIA GRID

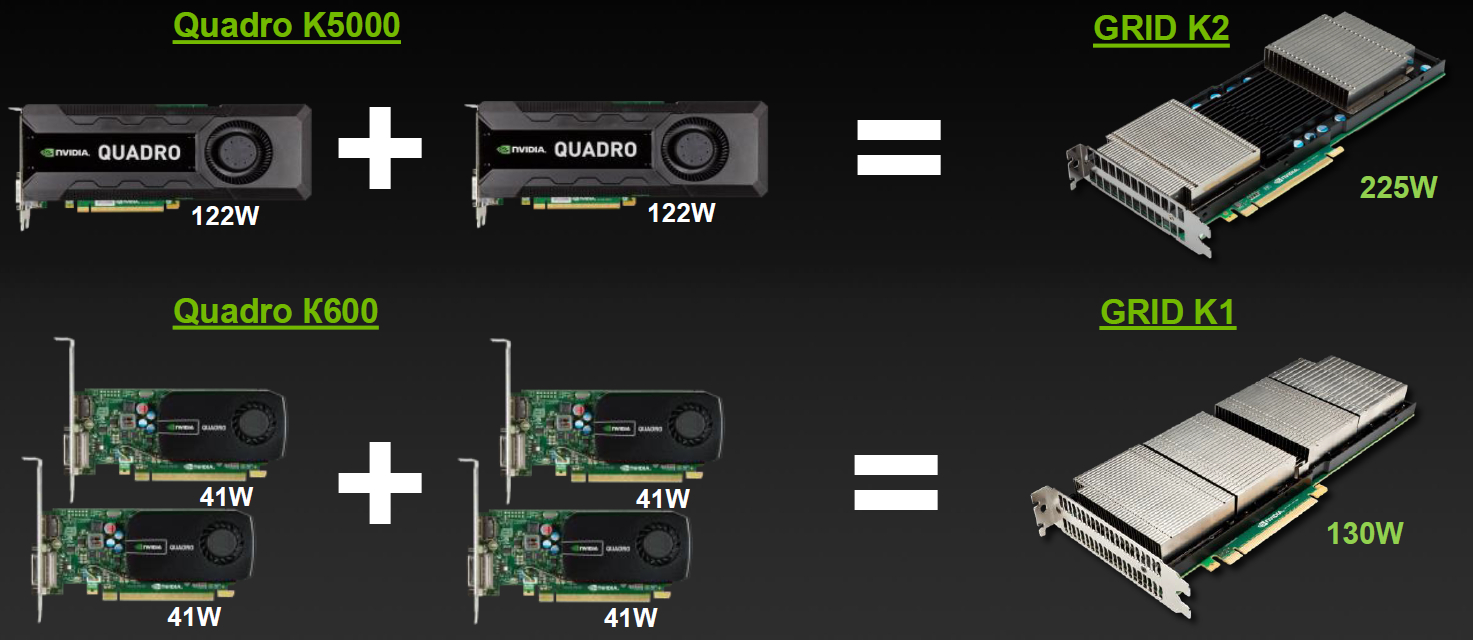

С анонсом технологии NVIDIA GRID (NVIDIA VGX на момент анонса) в прошлом году интерес к использованию 3D ускоренных VDI значительно возрос. Суть технологии GRID, которая исходно предназначена именно для 3D ускорения в виртуальных средах, достаточно проста и включает в себя следующие принципы:

- Агрегация на базе одной PCIe карты нескольких графических ускорителей;

- Возможность виртуализации графических ускорителей на уровне гипервизора;

- Возможность виртуализации графических ускорителей средствами технологии GRID Virtual GPU.

Включение в платформу GRID серверов различных вендоров, обеспечивающих установку до 4 карт GRID в один сервер избавляет от необходимости применять внешние PCIe корзины.

ПО, поддерживающее технологию GRID — это гипервизоры VMware, Citrix и Microsoft, а также системы виртуализации рабочих станций VMware и Citrix (и Microsoft, если рассматривать варианты общего доступа к серверу).

Описание нашего тестового стенда

- Dual socket R (LGA 2011) supports Intel® Xeon® processor E5-2600 and E5-2600 v2 family

- Up to 512GB ECC DDR3, up to 1866MHz; 8x DIMM sockets

- 3x PCI-E 3.0 x16 slots (support GPU/Xeon Phi cards), 1x PCI-E 3.0 x8 (in x16) low-profile slot

- Intel® X540 10GBase-T Controller

- 4x Hot-swap 2.5" SATA3 Drive Bays

- 1800W Redundant Power Supplies Platinum Level (94%+)

SATA корзина позволяет использовать недорогие SSD диски для Host Based кэширования доступа к данных, столь полезного при VDI нагрузках, с характерными пиками дисковой активности в начале и окончании рабочего дня.

При современных же ценах на модули памяти восьми DIMM-слотов оказывается вполне достаточно в ситуации, когда плотность VM на сервер ограничивается CPU и GPU ресурсами.

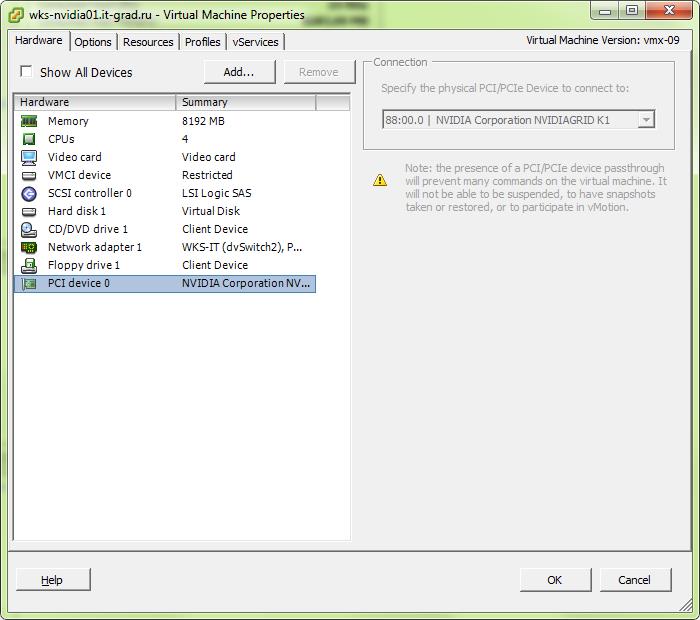

В данный сервер мы установили карту NVIDIA GRID K1. Приводим фото сервера с готовой к установке видеокартой:

В качестве платформы виртуализации была выбрана привычная нам VMware vSphere. Забегая вперед, отмечу, что во второй части данной статьи нам придется использовать Citrix XenServer, поскольку на данный момент только он и только в статусе Tech Preview поддерживает технологию GRID Virtual GPU.

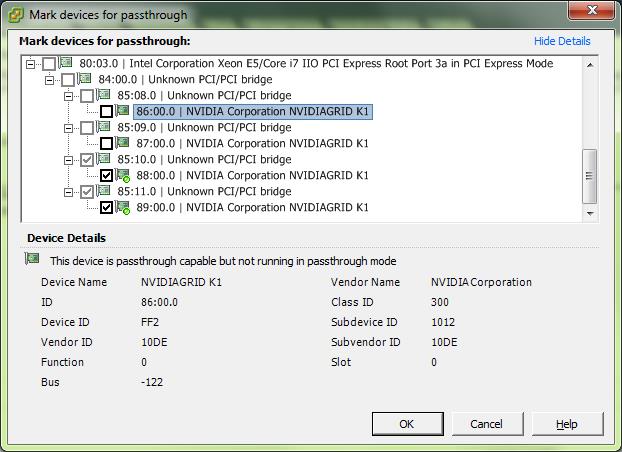

Гипервизор ESXi определяет видеокарту как 4 устройства NVIDIAGRID K1, подключённые через PCI/PCI bridge, что делает ускорители доступными для раздельного использования как passthrough устройства, подключаемые к ВМ, или как основу для виртуализации на уровне гипервизора.

В гипервизор инсталлируется драйвер от NVIDIA:

Все устройства, которые не переведены в режим passthrough, при загрузке инициализируются и используются драйвером от NVIDIA:

2013-10-28T06:12:42.521Z cpu7:9838)Loading module nvidia .

2013-10-28T06:12:42.535Z cpu7:9838)Elf: 1852: module nvidia has license NVIDIA

2013-10-28T06:12:42.692Z cpu7:9838)module heap: Initial heap size: 8388608, max heap size: 68476928

2013-10-28T06:12:42.692Z cpu7:9838)vmklnx_module_mempool_init: Mempool max 68476928 being used for module: 77

2013-10-28T06:12:42.693Z cpu7:9838)vmk_MemPoolCreate passed for 2048 pages

2013-10-28T06:12:42.693Z cpu7:9838)module heap: using memType 2

2013-10-28T06:12:42.693Z cpu7:9838)module heap vmklnx_nvidia: creation succeeded. >

2013-10-28T06:12:42.943Z cpu7:9838)PCI: driver nvidia is looking for devices

2013-10-28T06:12:42.943Z cpu7:9838)PCI: driver nvidia claimed device 0000:86:00.0

2013-10-28T06:12:42.943Z cpu7:9838)PCI: driver nvidia claimed device 0000:87:00.0

2013-10-28T06:12:42.943Z cpu7:9838)PCI: driver nvidia claimed 2 devices

NVRM: loading NVIDIA UNIX x86_64 Kernel Module 304.76 Sun Jan 13 20:13:01 PST 2013

2013-10-28T06:12:42.944Z cpu7:9838)Mod: 4485: Initialization of nvidia succeeded with module ID 77.

2013-10-28T06:12:42.944Z cpu7:9838)nvidia loaded successfully.

После загрузки гипервизора

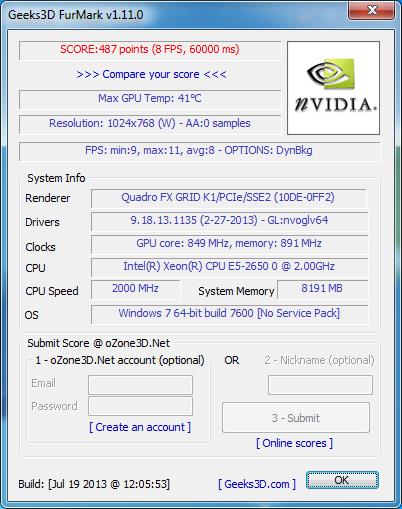

В качестве платформы для создания инфраструктуры VDI используется продукт Citrix XenDesktop 7, который в настоящий момент используется и в нашей production инфраструктуре, предоставляющей сервисы VDI для наших заказчиков. На тестовых машинах используется технология HXD 3D Pro, осуществляющая эффективную упаковку и проброс на клиента отрендеренного GPU изображения. Тестовый виртуальный сервер имеет следующую конфигурацию: 4vCPU 2GHz, 8GB RAM, 60GB HDD.

Тестирование vSGA

vSGA — это технология VMware, обеспечивающая виртуализацию ресурсов GPU, установленных в сервера под управлением гипервизора VMware ESXi, и последующее использование данных GPU для обеспечения 3D ускорения для виртуальных видеокарты, выданных для виртуального сервера.

Технология обладает множеством ограничений по производительности и функционалу виртуальных видеокарт, однако позволяет максимизировать плотность виртуальных машин на один GPU.

Фактически, нам удалось запустить машины с близким к двухкратному превышением количества виртуальной видеопамяти в сравнении с количеством физической видеопамяти на используемых GPU.

- поддерживаемые API: DirectX 9, OpenGL 2.1

- максимальный объем видеопамяти: 512MB

- производительность графического ядра: динамическая, не управляется.

- включить поддержку 3D,

- установить размер видеопамяти в свойствах видеокарты в редактировании машины:

В гостевой ОС такая виртуальная видеокарта определяется как «VMware SVGA 3D». Она отличается от обычной виртуальной видеокарты только объемом памяти и поддержкой аппаратного ускорения вышеперечисленных API.

Результаты выполнения теста FurMark на такой VDI машине однозначно говорят, что играть на ней не придется (при этом необходимо отметить, что во время тестирования физической видеокартой пользовалась одна виртуальная машина, то есть все вычислительные ресурсы видеокарты, с учетом накладных расходов виртуализации, были доступны тесту):

С точки зрения AutoCad 2014 возможности видеокарты выглядят следующим образом:

Enhanced 3D Performance: Available and on

Smooth display: Available and off

Gooch shader: Available and using hardware

Per-pixel lighting: Available and on

Full-shadow display: Available and on

Texture compression: Available and off

Advanced material effects: Available and on

Autodesk driver: Not Certified

Effect support:

Enhanced 3D Performance: Available

Smooth display: Available

Gooch shader: Available

Per-pixel lighting: Available

Full-shadow display: Available

Texture compression: Available

Advanced material effects: Available

Как видно, формально все параметры аппаратного ускорения поддерживаются драйвером. Предполагается, что проблемы с поддержкой мы можем увидеть только при использовании более тяжелых продуктов, использующих, например, архитектуру CUDA.

Результаты выполнения теста Cadalyst Benchmark:

Результаты не впечатляю, однако использовать данное ПО можно, а если большой производительности и работы со сложными моделями не требуется — например, в учебном классе, то высокая плотность и низкая стоимость таких машин может оказаться полезной.

Тестирование vDGA

vDGA — это название, используемое VMware для обозначения проброса физической видеокарты в виртуальную машину.

Фактически, для данной технологии NVIDIA GRID дала одно единственное преимущество — высокую плотность GPU, которая позволяет отказаться от использования внешних PCIe корзин.

Например, в используемый на тестовом стенде сервер возможно установить три видеокарты NVIDIA GRID K1, что даст нам 12 независимых ускорителей класса QUADRO K600. Это позволяет запустить на сервере 12 виртуальных серверов, что позволяет загрузить мощности сервера, а в зависимости от профиля нагрузки — и дает запас по GPU ресурсам по сравнению с CPU ресурсами.

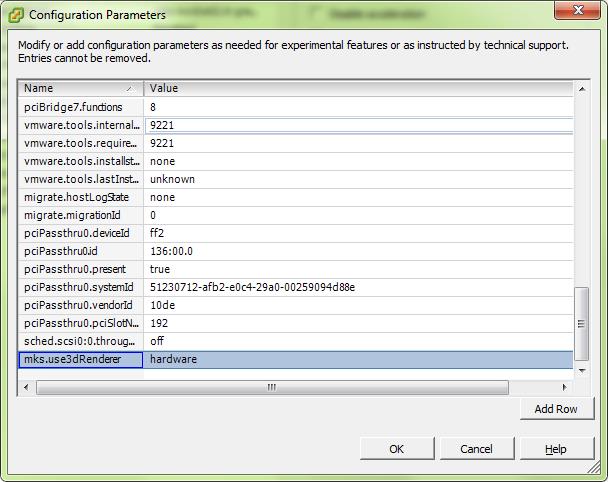

Для проброса видеокарты в виртуальный сервер необходимо включить режим passthrough для данного PCIe устройства в конфигурации хоста и добавить PCI устройство в конфигурацию виртуальной машины:

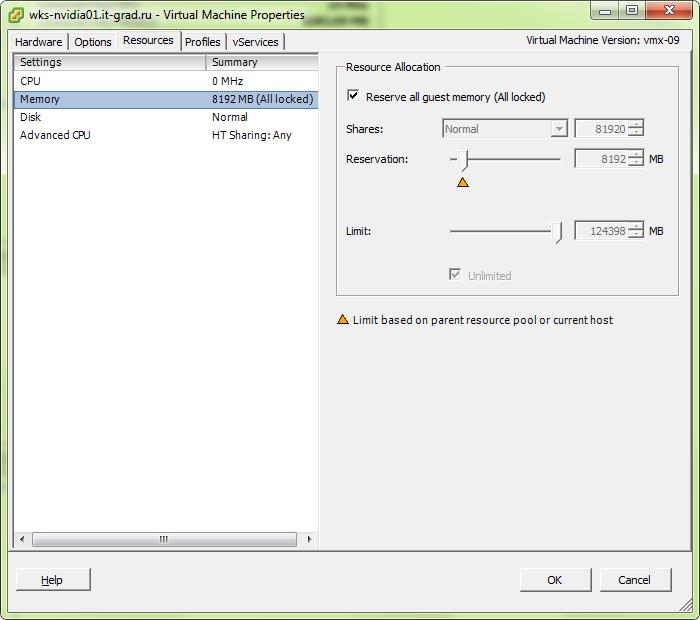

Также, требуется установить полное резервирование памяти для данной виртуальной машины

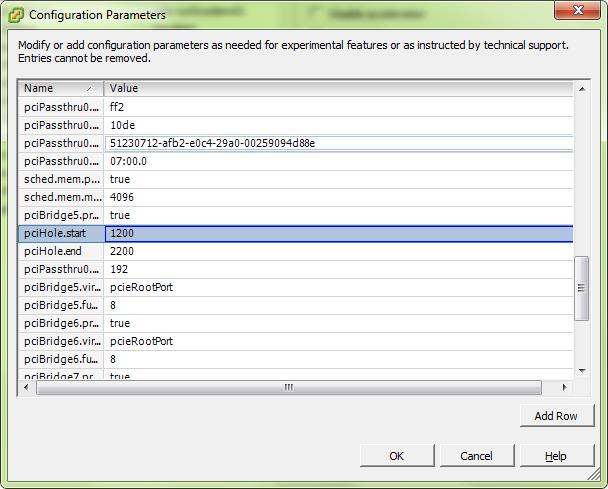

и провести настройку pci hole. На этот счет существуют различные мнения, мы выбрали значения от 1200 до 2200:

В гостевой ОС в таком случае видеокарта видится полноценным устройство от NVIDIA и требует установки драйверов для семейства видеокарт GRID.

Результаты FurMark близки к результатам, полученным в тесте vSGA, что говорит об относительной эффективности уровня виртуализации для этого теста:

При использовании AutoCad 2014 картина следующая:

Current Effect Status:

Enhanced 3D Performance: Available and on Smooth display: Available and off

Gooch shader: Available and using hardware

Per-pixel lighting: Available and on

Full-shadow display: Available and on

Texture compression: Available and off

Advanced material effects: Available and on

Autodesk driver: Not Certified

Effect support:

Enhanced 3D Performance: Available

Smooth display: Available

Gooch shader: Available

Per-pixel lighting: Available

Full-shadow display: Available

Texture compression: Available

Advanced material effects: Available

Все возможности также ожидаемо поддерживаются, однако карточка не является сертифицированной. Из серии GRID для AutoCad сертифицирована только K2.

Результаты выполнения бенчмарка Cadalyst 2012:

Как мы видим, проброшенная видеокарта показывает фактически результаты в 4 раза большие, чем виртуализированная. В данном случае, использовать для работы проектировщика такую машину уже возможно.

Если же производительности карты K1 не достаточно, можно установить K2 и получить top range видеокарту внутри виртуального сервера.

Во второй части статьи

Мы подробно расскажем о возможности виртуализации GPU посредством технологий NVIDIA, которые обещают нам поддержку всех доступных физической карте API и производительность, достаточную для уверенной работы с CAD, покажем тестовый стенд, замеры производительности таких видеокарт и подведем итоги. Продолжение следует.

Читайте также: