Почему видеопамять используется на максимум

Обновлено: 28.06.2024

Здравствуйте, что бы убрать весь лишний флуд сразу скажу - сперва гуглила проблему, потом проверяла на вирусы, перетыкала видеокарту, переустанавливала драйвера, смотрела температуру (выше 70не поднимается) и ещё раз гуглила и ещё раз смотрела, перезагружалась и ещё раз гуглила. Спустя двое суток безрезультатных скитаний все же решилась спросить тут ибо друзей нет знакомых тоже нет, а в контору нести видеокарту не готова пока что.

Теперь о проблеме: видеокарта 1060 6гигов. Всё было хорошо, никогда не было большой нагрузки, играю в основном с вертикальной синхронизации в 60фпс, мониторы при этом 1080 шестидесятигерцовые (два). Иногда просматривала нагрузку, никогда она 60% в общей сложности не превышала, а в большенстве игр и 20% (Wow к примеру). Баловалась стримами в OBS и все было ок. На днях вечером (не происходило никаких обновлений ничего и никаких новых загрузок или изменений в винде, ни миганий света ни разрывов интернета) играя в вов так же решила стартануть стримчик и заметила что OBS ругается на нагрузку и теряет кадры при кодировании, жирно так теряет от 40% и больше. В общем захлебывается и требует сменить качество. Полезла посмотреть что происходит (проц i7 последнего сокета, оперы 32гига, блок питания 700) и сразу увидела что GPU 3D 99-100% нагрузки. Для теста я выключила трансляцию с игрой, нагрузка сразу упала до 1%, включила ещё несколько игр смотря нагрузку и везде сразу после загрузки 3D GPU подскакивало до 99-100% и держалось в этом положении. Элекс, пиларс оф етернити, лайф ис стрендж2, вов и гта5 - все игры стали загружать видеокарту на 99-100%

OBS переустанавливала, сбрасывала все настройки, откатывала версии и писала в дискорд разработчикам. Ответом было, что проблема в видеокарте и да, я сразу после этого стала смотреть без включённого Обс все ровно нагрузка в потолок.

Все? Кирдык видеокарте? Или может кто сталкивался с такой же проблемой? Если есть какой дельный совет по спасению, пожалуйста напишите что можно сделать (по мимо покупки новой). Я и так в депресухе на фоне нынешних проблем с вирусней всякой в мире, сгоревшей квартире, сломанном зубе. так ещё и дома теперь не почилить в игрули во время этого дуратского карантина :( извините

Руководство покупателя игровой видеокарты

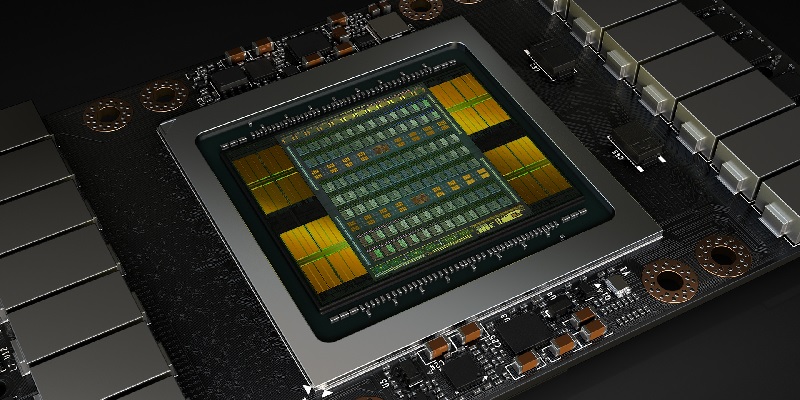

Производительность видеокарты определяется не только мощностью самого GPU. Любому чипу нужен большой объём выделенной памяти с высокой пропускной способностью при записи и чтении различных данных: текстур, вершин, содержимого буферов и т. п. Даже самый мощный видеочип можно «придушить» слишком малым объёмом видеопамяти, да ещё с медленным доступом, поэтому характеристики устанавливаемых микросхем памяти также являются одними из важнейших параметров современных видеокарт.

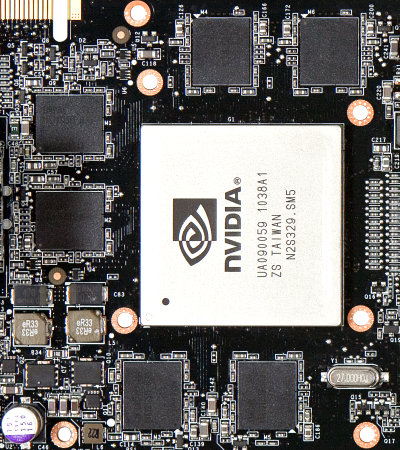

Микросхемы памяти, количество которых на некоторых моделях видеокарт достигает 24 штук, обычно располагаются на печатной плате вокруг видеочипа, на одной или обеих сторонах. В некоторых случаях для них не используется даже пассивное охлаждение, но часто применяется общий кулер, охлаждающий и GPU и память, а иногда и отдельные радиаторы. Вот так микросхемы памяти выглядят на GeForce GTX 590 со снятым устройством охлаждения:

Современные видеокарты оснащаются различным объемом локальной видеопамяти, но обычно он начинается от 512 МБ и может достигать 3 ГБ на один GPU (с удвоением объёма на двухчиповых видеокартах). Чаще всего на видеокарты low-end и mid-end сейчас ставят 1 ГБ памяти, а на high-end — 1,5-3 гигабайта на чип, но есть и исключения. Так, карты самого низкого уровня могут иметь и 512 МБ более быстрой памяти GDDR5, и 1-2 ГБ медленной DDR3.

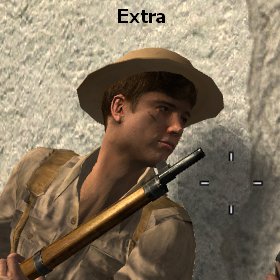

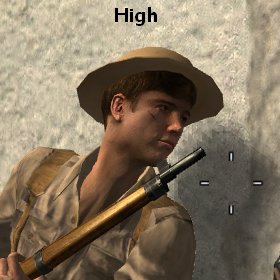

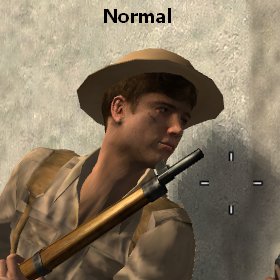

Чем больше выделенной памяти установлено на видеокарте, тем больше данных (тех же текстур, вершин и буферов) можно хранить в ней, не используя медленный доступ к ОЗУ компьютера. Причем, больше всего места занимают текстуры и различные буферы, а вот собственно геометрические данные обычно не слишком объёмны. Рассмотрим скриншоты из довольно старой игры Call of Duty 2 с разными установками качества текстур:

В этой игре, как и во многих других, автоматически настраивается качество текстур под имеющийся объём текстурной памяти. В данном случае режим Extra автоматически выставляется на видеокартах с 320-1024 МБ памяти, High или Normal — на 256 МБ, в зависимости от настроек разрешения и уровня антиалиасинга, а Low — на самых слабых GPU с 128 МБ. И даже если вы выставите максимальные настройки вручную, то на видеокарте с недостаточным объёмом видеопамяти для хранения ресурсов будет использоваться часть системной памяти, что приведет к серьёзным "тормозам" и отсутствию комфорта и плавности в игре.

В последнее время рост требований к объёму видеопамяти сильно замедлился, и виновато в этом засилие мультиплатформенных игр. Современные игровые консоли имеют лишь по 512 МБ памяти и поэтому разработчики игр ориентируются именно на этот уровень. Конечно, в ПК-версиях игр зачастую предусмотрены как текстуры большего разрешения, так и высокое разрешение рендеринга, что требует куда большего объёма видеопамяти. Но всё равно, объём памяти в 1 ГБ до сих пор вполне приемлем в подавляющем большинстве случаев. Кроме экстремальных настроек сглаживания и разрешения, вроде MSAA 8x и 2560×1600, соответственно.

Но даже уже устаревшим мультиплатформенным играм не хватает 512 МБ, они довольно требовательны к объёму видеопамяти, занимая до 600-700 МБ. И всё же, на данный момент минимальным необходимым объёмом локальной памяти для игровых видеокарт мы считаем 1 ГБ. Он же является и оптимальным для большинства моделей. Кроме видеокарт NVIDIA, имеющих 320- и 384-битную шины памяти — у них объём видеопамяти ещё более подходящий — 1280-1536 МБ. Но для топовых моделей уже востребован и больший объём, порядка 2 ГБ, что предлагают видеокарты серии Radeon HD 6900, и 3 ГБ, ставящиеся на некоторые модификации GeForce GTX 580. Тем более, что видеокарту всегда лучше подбирать с небольшим запасом.

К слову, в случае интегрированных видеоядер и устаревших дискретных видеокарт бывает так, что указанное на коробке количество видеопамяти не равно объему установленных на плату микросхем. Такое было ранее в случае видеоплат low-end, работающих с частью системной памяти при помощи технологий TurboCache (NVIDIA) и HyperMemory (ATI):

В характеристиках видеокарт с поддержкой этих технологий в маркетинговых целях указывался объём памяти (в т. ч. и часть ОЗУ), который может использоваться видеочипом, равный 128 МБ, в то время как в реальности на них установлен меньший объем — 16-32 МБ. Поэтому всегда нужно внимательно читать материалы нашего сайта, чтобы не попадаться на подобные ухищрения в будущем. Но пока что можно жить спокойно, ведь сейчас в таких видеокартах уже нет никакого смысла, их нишу прочно заняли интегрированные чипсеты.

С имеющимися разновидностями видеокарт по объёму локальной памяти мы разобрались, но ведь объём памяти для видеокарт — это еще не всё, и даже зачастую не главное! Очень часто бывает так, что на дешёвые видеокарты ставят очень большое количество памяти, чтобы нарисовать красивые цифры на их коробках и в описаниях готовых систем (поэтому их так любят сборщики — вспомните слоганы вроде «4 ядра, 4 гига»), с расчетом на то, чтобы они лучше продавались. Но для слабых видеокарт в повышенном объёме памяти никакого смысла нет, они ведь всё равно не смогут выдавать приемлемую частоту кадров на высоких настройках, в которых и используется большие объёмы текстур и геометрии.

Продавцы часто используют объём видеопамяти в качестве основной характеристики видеокарт, и это вводит в заблуждение простых покупателей, плохо знакомых с реальным положением дел. Сравним производительность решений с разным количеством видеопамяти на примере двух одинаковых видеокарт Radeon HD 6950, имеющих единственное отличие — на первой из них установлено 1 ГБ видеопамяти, а на второй — 2 ГБ. Любой менеджер по продажам скажет вам, что вторая видеокарта значительно лучше первой, кроме случаев, когда в магазине есть модели только с 1 ГБ памяти и редчайших случаев честных и компетентных продавцов. А что получается на самом деле? Есть ли великая разница? Посмотрим на цифры, полученные в игре Metro 2033, являющейся одной из наиболее требовательных:

Как видите, в большинстве игровых режимов объём видеопамяти влияет на производительность не слишком значительно — разница не превышает 5-6%. То же самое получается и в других играх, даже современных и ПК-эксклюзивных (что сейчас большая редкость). Лишь в сверхвысоком разрешении и с максимальными настройками качества появляется значимая разница, когда модель с 1 ГБ заметно отстаёт от более дорогой карты с 2 ГБ памяти — на 27%.

Казалось бы — вот оно, ради чего нужно платить деньги! Но посмотрите на цифры кадров в секунду при разрешении 2560×1600 — разве 18,9 FPS можно назвать комфортной скоростью? Нет. Что 14,9 FPS, что 18,9 FPS — эти цифры одинаково не имеют практического смысла, никто не будет играть с настолько дёрганой частотой смены кадров. Поэтому, с некоторым допущением, можно считать, что разница в объёме видеопамяти между 1 ГБ и 2 ГБ сейчас незначительно сказывается на скорости рендеринга, и сравнивать даже топовые видеокарты по количеству памяти не нужно.

Но речь шла только об объёмах памяти выше 1 ГБ. Да и 512 МБ для плат нижнего ценового диапазона сейчас вполне достаточны. В этих случаях, примеры, когда объём памяти начинает сказываться на производительности, весьма редки. Разработчики игровых приложений рассчитывают используемые в играх ресурсы и графические настройки так, чтобы все данные входили в локальную видеопамять наиболее распространённых на рынке видеокарт. То есть, сейчас это уровни 512 МБ (для low-end) и от 1 ГБ для всех остальных видеокарт, включая и высокие разрешения и максимальные настройки качества. А если видеопамяти меньше, то современные игры или будут тормозить или даже не дадут выставить максимальные настройки.

Но этот расчётный объем видеопамяти у игровых разработчиков растет, даже несмотря на засилие консолей и мультиплатформы. Ещё пару лет назад было вполне достаточно 512-640 МБ, а теперь появились проекты, в которых этот объёма недостаточно. Но даже среди самых последних игр таких проектов пока мало, но они уже появляются. Поэтому, в случае не слишком большой разницы в цене между видеокартами с разными объёмами памяти при прочих равных условиях (частота и ширина шины), следует покупать модель с большим объёмом. Но без погони за цифрами — никакой low-end карте не поможет пара гигабайт медленной DDR3-памяти. Такой объём ей на данный момент просто не нужен. Зато важен другой параметр, о котором мы поговорим далее.

Подробнее о пропускной способности памяти

Ещё одна важная характеристика, о которой мы уже писали — это пропускная способность памяти (ПСП), которая зависит как от частоты работы памяти, так и от ширины шины. Этот параметр определяет количество данных, которые теоретически можно передать в память или из памяти за единицу времени. Другими словами, это скорость, с которой графическое ядро может записывать и считывать различные данные в локальную видеопамять. Соответственно, чем быстрее считываются текстурные, геометрические и прочие данные, и чем быстрее записываются в буфер рассчитанные пиксели, тем выше будет общая производительность.

Пиковая пропускная способность памяти рассчитывается довольно просто — это произведение «эффективной» частоты памяти на количество данных, передаваемых за такт (ширина шины памяти). Например, для GeForce GTX 580 с шиной 384 бит и частотой видеопамяти 1002(4008) МГц, ПСП будет равна:

1002 МГц × 4 (передача данных с учетверённым темпом) × 48 (384/8 байт за такт) ≈ 192,4 ГБ/с

Естественно, что последнее нигде широко не афишируется. Для производителя узкая шина и дешевле в производстве, и позволяет удобнее масштабировать производительность решений линейки. И две одинаковые видеокарты с одинаковыми частотами, но с разной шириной шины памяти, будут сильно отличаться по производительности. Та, у которой ПСП больше, может обрабатывать большее количество данных, по сравнению с картой с меньшей разрядностью шины, хотя сами GPU у них совершенно одинаковые.

Рассмотрим очень жизненный пример — модель GeForce GTS 450 с двумя разными типами памяти, GDDR5 на более дорогой модели и DDR3 на дешёвой. Во время выхода на эту видеокарту ставили исключительно быструю GDDR5-память с приличной пропускной способностью. Но когда её время прошло и она спустилась в нижний ценовой диапазон, производители начали экономить, выпуская варианты с DDR3-памятью, которая гораздо дешевле. Результат подобной экономии можно пронаблюдать на следующей диаграмме:

Как видите, всё очень печально для DDR3-варианта — даже в далеко не самой новой игре разница в различных разрешениях экрана составляет от 50 до 70%! То есть, мощность GPU во всех протестированных условиях ограничена медленной видеопамятью. Модель с DDR3 просто не может считывать и записывать данные с теоретически возможной скоростью. Таким образом производители вместе с компанией NVIDIA снизили себестоимость модели, спустив её ещё ниже в бюджетный сегмент.

В этом гайде мы расскажем о загрузке видеокарты. Многих волнует вопрос, какая же нагрузка должна быть у видеокарты в играх. Нормально ли, что видеокарта загружена на 100% или, например, всего на 60%?

Как проверить, на сколько загружена видеокарта и процессор

Чтобы вообще понять суть проблемы, нужно сначала узнать, какая загрузка у вашей видеокарты в конкретной игре. Для этого воспользуйтесь бесплатной программой MSI Afterburner. Мы уже подробно рассказывали о ней в гайде «Как настроить мониторинг MSI Afterburner в играх», поэтому здесь повторяться не будем.

Видеокарта загружена на 100%

Если в играх ваша видеокарта загружена на 100%, то это абсолютно нормально. Она работает на полную мощность и каких-либо проблем с железом нет. Но если FPS при этом низкий, значит ваша карточка просто не справляется с игрой.

Если же видеокарта остается под нагрузкой даже в простое (когда вы ничего не запускали) или при выполнении несложных задач, то это плохой признак. Вероятно, в системе засел вирус-майнер. При помощи диспетчера задач выявите процесс, который грузит видеокарту и завершите его. Далее, нужно будет почистить систему. Подробнее можно прочитать в нашем гайде о перегревах видеокарты.

Видеокарта загружена не на 100% (недогружена). Нормально ли это?

Если видеокарта недогружена, то все гораздо сложнее. Само по себе это еще ни о чем не говорит, но нужно разбираться. Происходит это потому, что на видеокарту нет нагрузки. Такое часто происходит в нетребовательных играх или при низких настройках графики, когда приложение не может создать серьезной нагрузки на железо. Но если игра требовательная и современная, то могут быть несколько причин.

Первое, на что нужно смотреть — частота кадров. Если у вас стоит ограничение, например, на 60 кадров и видеокарта их выдает, то беспокоиться не о чем. Попробуйте поднять качество графики или убрать ограничение, чтобы повысить загрузку. Если же видеокарта недогружена и FPS при этом низкий, игра тормозит, то это непорядок.

Как заставить видеокарту работать на 100%

Если видеокарта недогружена и это проблемный случай, то нужно выяснять, почему так происходит. Самые распространенные причины: слабый процессор или плохая оптимизация игры. О них мы поговорим подробнее.

Слабый процессор. Есть такое понятие «раскрытие видеокарты процессором». Кто-то считает, что это миф, а кто-то принимает за чистую монету. На самом деле проблема несоответствия процессора и видеокарты имеет место, но она гораздо сложнее. Дело в том, что один и тот же процессор может как «раскрыть», так и не «раскрыть» видеокарту. К примеру, в разрешении 1080p видеокарта недогружена, но стоит перейти в 4К и загрузка увеличивается. Вот и все раскрытие.

Но важно вот что: если процессор не может обеспечить комфортный FPS, то и видеокарта будет простаивать. Она хоть и может выдать больше кадров, но процессор нет. Поэтому вместо плавного геймплея получите слайд-шоу. В таком случае нужно обновить процессор или разогнать его. В последнем случае чудес ждать не стоит. Если процессор совсем устарел, разгон не поможет.

Кроме того, не лишним будет проверить и температуру процессора. Как это сделать, мы рассказывали в подробном гайде. Вполне возможно, что CPU перегревается и начинает троттлить (пропускать такты и снижать производительность) поэтому и не вывозит игры. Позаботьтесь о достойном охлаждении.

Плохая оптимизация. Если игра плохо оптимизирована, то она будет тормозить, независимо от вашего железа. Типичная картина плохой оптимизации была на запуске Mafia 3. Разработчики установили лок на 30 FPS, что в итоге привело к недогрузу видеокарты и консольному фреймрейту.

Если у вас проблемы такого рода, то попробуйте обновить или переустановить драйвера, систему Windows или саму игру (если на нее есть патчи). Однако когда причина в кривом коде, никакие переустановки драйверов не помогут, пока проблему не исправят.

Прочие проблемы. Могут быть и другие причины. Так, сама видеокарта может быть неисправна. В этом случае стоит проверить ее с другим железом или протестировать в стресс-тестах типа Furmark. Кроме того, узким местом в системе могут быть и другие комплектующие. Производительность может зависеть от оперативной памяти. К примеру, в ноутбуках часто ставят только одну планку памяти и работает она в одноканальном режиме.

Также стоит проверить режимы энергосбережения и другие настройки видеокарты и Windows для игр. Подробнее об этом читайте в гайдах «Как настроить Windows 10 для игр» и «Как настроить видеокарту NVIDIA для игр».

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Читайте также: