Raid контроллер marvell настройка

Обновлено: 03.07.2024

RAID можно настроить в режиме Legacy или UEFI. Для настройки в UEFI может понадобиться свежая прошивка BIOS.

Настройка RAID в режиме Legacy

Загружаемся в BIOS. Для входа в BIOS нужно нажать DEL или F2.

Переходим в Advanced > Boot Option.

Переключаем Boot Mode в Legacy only.

F4 - сохраняем настройки и перезагружаем сервер.

Ожидем надписи "Press <Ctrl>+<M> to enter BIOS Setup or <Space> to continue".

Нажимаем Ctrl+M и попадаем в Marvell BIOS Setup.

Здесь можно настроить RAID. Нажимаем Enter.

Есть один пункт: Configuration Wizard. Кликаем Enter. Нас просят выбрать диски, которые требуется сконфигурировать.

Пробелом выделяем нужные диски.

Производим операцию над дисками — кликаем Enter. Нас просят выбрать RAID, т.е. виртуальный диск.

- RAID 0

- RAID 10 (недоступно для двух дисков)

- RAID 1 (то что мне нужно)

- Safe (Safe mode creates a virtual disk that is optimized for best fault tolerance. It is safe to use

with hard drives that contain existing data. Virtual disks created in safe mode can also be

partially rebuilt if the SSD fails, but not if the HDD fails) - Capacity (Capacity mode creates a virtual disk that is optimized for maximum utilization of the

SSD. Virtual disks created in capacity mode have better read and write performance than

those created in safe mode. However, they cannot be rebuilt.)

Выбираем RAID 1 (У меня только два диска). Enter.

Strip Size, возможно выбрать 32K или 64K. Выбираем 64K.

Указываем название массива.

Enter. Спрашивают, хочу ли я создать диск? Y.

Здесь же можно посмотреть статус массива и информацию о нём.

Статус дисков сменился на Configured.

Перезагружаем сервер и входим в BIOS. В SATA Configuration теперь вместо дискав отображается MARVELL Raid VD.

В Boot > Boot Option Priorities тоже вместо дисков теперь фигурирует RAID массив.

При загрузке сервера отображается информация и о дисках и о RAID массиве:

Настройка RAID в режиме UEFI

В старой версии BIOS нет возможности настроить RAID из UEFI. Есть два варианта решения проблемы. Первый вариант - воспользоваться утилитой Marvell BIOS Utility (UEFI):

- Скачиваем утилиту по ссылке выше.

- Копируем ui64.efi на флешку (FAT32).

- Вставляем флешку в сервер, загружаемся.

- Нажимаем F11 для выбора вариантов загрузки.

- Выбираем UEFI: Built-in EFI Shell.

- Смотрим подключённые устройства командой map -r. Флешка с ui64.efi оказалась под именем blk0, хотя может быть и fs0 (алиас)

- Монтируем флешку mount blk0.

- Переходим на неё - вводим blk0:

- Запускаем утилиту ui64.efi, Смотрим список содержимого с помощью ls или dir.

Второй вариант - обновить прошивку BIOS. А потом штатными средствами UEFI настроить RAID.

Понять, что у вас нужная прошивка можно из окна загрузки, там белым по чёрному написано "To configure RAID. бла-бла-бла":

Или под пунктом в BIOS: Advanced > SATA Configuration. Здесь уже подробно написано что делать: "For System RAID setting, you could type command RAID on UEFI shell".

Если таких строк нет - нужно обновлять BIOS. Обновляем BIOS: HPE ProLiant MicroServer Gen10 - обновляем BIOS через UEFI . После обновления прошивки загружаемся в BIOS. Для входа в BIOS нужно нажать DEL или F2.

Организация единого дискового пространства — задача, легко решаемая с помощью аппаратного RAID-контроллера. Однако следует вначале ознакомиться с особенностями использования и управления таким контроллером. Об этом сегодня расскажем в нашей статье.

Надежность и скорость работы дисковых накопителей — вопрос, волнующий каждого системного администратора. Несмотря на заверения производителей о качестве собственных устройств — HDD и SSD продолжают выходить из строя в самое неподходящее время, теряя драгоценные данные. Технология S.M.A.R.T. в большинстве случаев дает возможность оценить «здоровье» накопителя, но это не гарантирует того, что диск будет продолжать беспроблемно работать.

Предсказать выход диска из строя со 100%-ой точностью невозможно, поэтому следует предусмотреть вариант, при котором это не станет проблемой или причиной остановки сервисов. Использование RAID-массивов решает эту задачу. Рассмотрим три основных подхода, применяющихся для этой задачи:

- Программный RAID — наименее затратный вариант, но и наименее производительный. Массив создается средствами операционной системы, вся нагрузка по обработке данных «ложится на плечи» центрального процессора.

- Интегрированный аппаратный RAID (еще его часто называют Fake-RAID) — микрочип, установленный на материнскую плату, который берет на себя часть функционала аппаратного RAID-контроллера, работая в паре с центральным процессором. Этот подход работает чуть быстрее, чем программный RAID, но надежность у такого массива оставляет желать лучшего.

- Аппаратный RAID — это отдельный контроллер с собственным процессором и кэширующей памятью, полностью забирающий на себя выполнение всех дисковых операций. Наиболее затратный, однако, самый производительный и надежный вариант для использования.

Давайте рассмотрим аппаратный RAID детально.

Внешний вид

Мы выбрали решения Adaptec от компании Microsemi. Это RAID-контроллеры, зарекомендовавшие себя удобством использования и высокой производительностью. Их мы устанавливаем, если наш клиент решил заказать сервер произвольной или фиксированной конфигурации.

RAID-контроллеры форм-фактора PCI-E

Для подключения дисков используются специальные интерфейсные кабели. Со стороны контроллера используются разъемы SFF8643. Каждый кабель позволяет подключить до 4-х дисков SAS или SATA (в зависимости от модели). Помимо этого интерфейсный кабель еще имеет восьмипиновый разъем SFF-8485 для шины SGPIO, о назначении которой поговорим чуть позже.

Помимо самого RAID-контроллера существует еще два дополнительных устройства, позволяющих увеличить надежность:

- BBU (Battery Backup Unit) — модуль расширения с литий-ионной батареей, позволяющий поддерживать напряжение на энергозависимой микросхеме кэша. В случае внезапного обесточивания сервера его использование позволяет временно сохранить содержимое кэша, которое еще не было записано на диски. Как только электропитание сервера будет восстановлено — содержимое кэша будет записано на диски в штатном режиме. По заявлениям производителя полностью заряженная батарея способна хранить данные кэша в течение 72 часов.

- ZMCP (Zero-Maintenance Cache Protection) — специальный модуль расширения для RAID-контроллера, имеющий собственную энергонезависимую память и суперконденсатор. В случае возникновения сбоя сервера по электропитанию, суперконденсатор обеспечивает микросхемы электроэнергией, которой достаточно для записи содержимого энергозависимой памяти кэша в NAND-память ZMCP. После того, как электропитание сервера восстановлено, содержимое кэша автоматически будет записано на диски. Именно такие модули устанавливаются в наши серверы с аппаратным RAID-контроллером и Cache Protection.

Это особенно важно, когда включен режим отложенной записи кэша (Writeback). При пропадании электропитания содержимое кэша не будет сброшено на диски, что приведет к потере данных и, как следствие, штатная работа дискового массива будет нарушена.

Технические характеристики

Температура

Вначале хотелось бы затронуть такую важную вещь, как температурный режим аппаратных RAID-контроллеров Adaptec. Все они оснащены небольшими пассивными радиаторами, что может вызвать ложное представление о небольшом тепловыделении.

Производитель контроллера приводит в качестве рекомендуемого значения воздушного потока — 200 LFM (linear feet per minute), что соответствует показателю 8,24 литра в секунду (или 1,02 метра в секунду). Рассчитаны такие контроллеры исключительно на установку в rackmount-корпусы, где такой воздушный поток создается скоростными штатными кулерами.

От 0°C до 40-55°C — рабочая температура большинства RAID-контроллеров Adaptec (в зависимости от наличия установленных модулей), рекомендованная производителем. Максимальная рабочая температура чипа составляет 100°C. Функционирование контроллера при повышенной температуре (более 85°C) может вывести его из строя. Удобства ради приводим под спойлером табличку рекомендуемых температур для разных серий контроллеров Adaptec.

Рекомендуемые температуры

| Серия контроллера Adaptec | Рабочая температура |

|---|---|

| Series 2 (2405, 2045, 2805) and 2405Q | 55°C без модулей |

| Series 5 (5405, 5445, 5085, 5805, 51245, 51645, 52445) | 55°C без батарейного модуля, 40°C с батарейным модулем ABM-800 |

| Series 5Z (5405Z, 5445Z, 5805Z, 5805ZQ) | 50°C с модулем ZMCP |

| Series 5Q (5805Q) | 55°C без батарейного модуля, 40°C с батарейным модулем ABM-800 |

| Series 6E (6405E, 6805E) | 55°C без модулей |

| Series 6/6T (6405, 6445, 6805, 6405T, 6805T) | 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-600 |

| Series 6Q (6805Q, 6805TQ) | 50°C с ZMCP модулем AFM-600 |

| Series 7E (71605E) | 55°C без модулей |

| Series 7 (7805, 71605, 71685, 78165, 72405) | 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-700 |

| Series 7Q (7805Q, 71605Q) | 50°C с ZMCP модулем AFM-700 |

| Series 8E (8405E, 8805E) | 55°C без модулей |

| Series 8 (8405, 8805, 8885) | 55°C без ZMCP модуля, 50°C с ZMCP модулем AFM-700 |

| Series 8Q (8885Q, 81605Z, 81605ZQ) | 50°C с ZMCP модулем AFM-700 |

Нашим клиентам не приходится беспокоиться о перегреве контроллеров, поскольку в наших дата-центрах поддерживается постоянный температурный режим, а сборка серверов произвольной конфигурации происходит с учетом особенностей таких комплектующих (о чем мы упоминали в нашей предыдущей статье).

Скорость работы

Для того чтобы продемонстрировать, как наличие аппаратного RAID-контроллера способствует увеличению скорости работы сервера, мы решили собрать тестовый стенд со следующей конфигурацией:

- CPU Intel Xeon E3-1230v5;

- RAM 16 Gb DDR4 2133 ECC;

- 4 HDD емкостью по 1 ТБ.

В качестве операционной системы будет установлена CentOS 7. Роль серверного приложения возьмет на себя 1C Bitrix24. Вначале мы соберем программный RAID-массив с помощью mdadm и измерим производительность с помощью встроенного в Bitrix24 теста. Каких-либо изменений или дополнительных настроек в систему специально не вносим — устанавливается демо-конфигурация с настройками по-умолчанию.

Затем в этот же стенд поставим RAID-контроллер Adaptec ASR 7805 с модулем защиты кэша AFM-700, подключим к нему эти же жесткие диски и выполним точно такое же тестирование.

С программным RAID

Несомненное преимущество программного RAID — простота использования. Массив в ОС Linux создается с помощью штатной утилиты mdadm. При установке операционной системы чаще всего создание массива предусмотрено непосредственно из установщика. В случае, когда такой возможности установщик не предоставляет, достаточно всего лишь перейти в соседнюю консоль с помощью сочетания клавиш Ctrl+Alt+F2 (где номер функциональной клавиши — это номер вызываемой tty).

Создать массив очень просто. Командой fdisk -l смотрим, какие диски присутствуют в системе. В нашем случае это 4 диска:

Проверяем, чтобы на дисках не было метаданных, например, от предыдущего массива:

В случае, если на одном или нескольких дисках будут метаданные, удалить их можно следующим образом (где sdX — требуемый диск):

Создадим на каждом диске разделы для будущего массива c помощью fdisk. В качестве типа раздела следует указать fd (Linux RAID autodetect).

Собираем массив RAID 10 из созданных разделов с помощью команды:

Сразу после этого будет создан массив /dev/md0 и будет запущен процесс перестроения данных на дисках. Для отслеживания текущего статуса процесса введите:

Пока процесс перестроения данных не будет завершен, скорость работы дискового массива будет снижена.

После установки операционной системы и Bitrix24 на созданный массив мы запустили стандартный тест и получили следующие результаты:

С аппаратным RAID

Прежде чем сервер сможет использовать единое дисковое пространство RAID-массива, необходимо выполнить базовую настройку контроллера и логических дисков. Сделать это можно двумя способами:

- при помощи внутренней утилиты контроллера,

- утилитой из операционной системы.

Внешний вид утилиты

Утилита позволяет не только управлять настройками контроллера, но и логическими устройствами. Инициализируем физические диски (вся информация на дисках при инициализации будет уничтожена) и создадим массив RAID-10 с помощью раздела Create Array. При создании система запросит желаемый размер страйпа, то есть размер блока данных за одну I/O-операцию:

- больший размер страйпа идеален для работы с файлами большого размера;

- меньший размер страйпа подойдет для обработки большого количества файлов небольшого размера.

Сразу после того, как контроллеру отдана команда создания массива, также, как и с программным RAID, начинается процесс перестроения данных на дисках. Этот процесс работает в фоновом режиме, при этом логический диск становится сразу доступен для BIOS. Производительность дисковой подсистемы будет также снижена до завершения процесса. В случае, если было создано несколько массивов, то необходимо определить загрузочный массив с помощью сочетания клавиш Ctrl + B.

После того как статус массива изменился на Optimal, мы установили Bitrix24 и провели точно такой же тест. Результат теста:

Сразу становится понятно, что аппаратный RAID-контроллер ускоряет операции чтения и записи на дисковый носитель за счет использования кэша, что позволяет быстрее обрабатывать массовые обращения пользователей.

Управление контроллером

Непосредственно из операционной системы управление контроллером производится с помощью программного обеспечения, доступного для скачивания с сайта производителя. Доступны варианты для большинства операционных систем и гипервизоров:

- Debian,

- Ubuntu,

- Red Hat Linux,

- Fedora,

- SuSE Linux,

- FreeBSD,

- Solaris,

- Microsoft Windows,

- Citrix XenServer,

- VMware ESXi.

Пользователям других дистрибутивов Linux также доступны исходные коды драйверов. Помимо драйверов и консольной утилиты ARCCONF производитель также предлагает программу с графическим интерфейсом для удобного управления контроллером — maxView Storage Manager.

С помощью указанных утилит можно, не прерывая работу сервера, легко управлять логическими и физическими дисками. Также можно задействовать такой полезный функционал, как «подсветка диска». Мы уже упоминали про пятый кабель для подключения SGPIO — этот кабель подключается напрямую в бэкплейн (от англ. backplane — соединительная плата для накопителей сервера) и позволяет RAID-контроллеру полностью управлять световой индикацей каждого диска.

Следует помнить, что бэкплэйны поддерживают не только SGPIO, но и I2C. Переключение между этими режимами осуществляется чаще всего с помощью джамперов на самом бэкплэйне.

Каждому устройству, подключенному к аппаратному RAID-контроллеру Adaptec, присваивается идентификатор, состоящий из номера канала и номера физического диска. Номера каналов соответствуют номерам портов на контроллере.

Замена диска — штатная операция, впрочем, требующая однозначной идентификации. Если допустить ошибку при этой операции, можно потерять данные и прервать работу сервера. С аппаратным RAID-контроллером такая ошибка является редкостью.

Делается это очень просто:

-

Запрашивается список подключенных дисков к контроллеру:

Контроллер даст соответствующую команду на бэкплэйн, и светодиод нужного диска начнет равномерно моргать цветом, отличающимся от стандартного рабочего.

Например, на платформах Supermicro штатная работа диска — зеленый или синий цвет, а «подсвеченный» диск будет моргать красным. Перепутать диски в этом случае невозможно, что позволит избежать ошибки из-за человеческого фактора.

«Подсвеченный» диск

Настройка кэширования

Теперь пару слов о вариантах работы кэша на запись. Вариант Write Through означает, что контроллер сообщает операционной системе об успешном выполнении операции записи только после того, как данные будут фактически записаны на диски. Это повышает надежность сохранности данных, но никак не увеличивает производительность.

Чтобы достичь максимальной скорости работы, необходимо использовать вариант Write Back. При такой схеме работы контроллер будет сообщать операционной системе об успешной IO-операции сразу после того, как данные поступят в кэш.

Важно — при использовании Write Back настоятельно рекомендуется использовать BBU или ZMCP-модуль, поскольку без него при внезапном отключении электричества часть данных может быть утеряна.

Настройка мониторинга

Вопрос мониторинга статуса работы оборудования и возможности оповещения стоит достаточно остро для любого системного администратора. Для того чтобы настроить «связку» из Zabbix и RAID-контроллера Adaptec рекомендуем воспользоваться перечисленными решениями.

Зачастую требуется отслеживать состояние контроллера напрямую из гипервизора, например, VMware ESXi™. Задача решается с помощью установки CIM-провайдера с помощью инструкции Microsemi.

Прошивка

Необходимость прошивки RAID-контроллера возникает чаще всего для исправления выявленных производителем проблем с работой устройства. Несмотря на то, что прошивки доступны для самостоятельного обновления, к этой операции следует подойти очень ответственно, особенно если процедура выполняется на «боевой» системе.

Если нашему клиенту требуется сменить версию прошивки контроллера, то ему достаточно создать тикет в нашей панели управления. Системные инженеры выполнят перепрошивку RAID-контроллера до требуемой версии в указанное время и сделают это максимально корректно.

Важно — не следует выполнять перепрошивку самостоятельно, поскольку любая ошибка может привести к потере данных!

Заключение

Использование аппаратного RAID-контроллера оправдано в большинстве случаев, когда требуется высокая скорость и надежность работы дисковой подсистемы.

Системные инженеры Selectel бесплатно выполнят базовую настройку дискового массива на аппаратном RAID-контроллере при заказе сервера произвольной конфигурации. В случае, если потребуется дополнительная помощь с настройкой, мы будем рады помочь в рамках нашей услуги администрирования. Также мы подготовили для наших читателей небольшую памятку по командам утилиты arcconf.

Ты хорошо подумал насчёт RAID0 aka страйп? Тебе данные на этом страйпе вовсе не нужны и не интересны, да. :D

Там кроме игр ничего не будет стоять - вся система на SSD. Все картинки, документы и т.д. уже есть на внешнем диске :)

вся система на SSD А тогда зачем ты решил систему всю переставить Какое дело ОСи до дисков с данными. Это нее связано с этим - просто думал что будет лишний повод поставить все заново. Resonickесли не трудно дайте скрин производительности двух velociraptor в страйпе

Resonick

если не трудно дайте скрин производительности двух velociraptor в страйпе

Ок - буду ночью делать - потом выложу.

Фишка в том что велоцираптор рассчитан на САТА3 - у меня же рейд держит только САТА2 контроллер - поэтому буду цеплять к нему.

Вопрос - если есть медленные блоки (в виктории показывает - красные и желтые (бэдов нет) их можно починить при форматировании или ремэппинге?

Вот только сейчас появилось время вживлять вторую ящерицу в системник - сходу вопрос к знающим - у меня материнка Asus Rampage III Extreme - Raid подерживает только контроллер южника Sata 2. Вопрос такой - если я переведу его в режим Raid то соответственно все 6 портов будут шпарить в этом режиме. К этому же контроллеру подключен Интеловский ССД под систему. Будет ли этом ССД нормально функционировать, или его Бивис просто не увидит и надо цеплять к другому контроллеру? Jmicron задействовать неохота с его одним портом (он к eSata у разъему у меня включен). Можно ли будет подключить SSD Sata2 к контроллеру Marvell Sata 3?Resonick

если не трудно дайте скрин производительности двух velociraptor в страйпе

Все настроил и подключил.

Intel SSD 120 Gb подключил к контроллеру Marvell

2 VelociRaptora подключил к контроллеру Intel Sata 2

Resonick

ты жестокий человек )))

ну хоть бы под ссылкой спрятал эту картинку )

Можно ли будет подключить SSD Sata2 к контроллеру Marvell Sata 3?

можно, почему ж нельзя :)

Resonick

ты жестокий человек )))

ну хоть бы под ссылкой спрятал эту картинку )

можно, почему ж нельзя :)

Если картинка уменьшается - то там ни хрена не видно :D

думал будет побыстрее.

вот для сравнения 2 st3500418As

зато время доступа тама веселее ) хотя до ссды как до неба раком )))

cwhs

зато время доступа тама веселее ) хотя до ссды как до неба раком )))

Гонял тоже свою ССДшку - там график в общих чертах линейный получается а не ниспадающий.

Resonickя про время доступа, а не график скоростей чтения.

Resonick

я про время доступа, а не график скоростей чтения.

Ну это да - 10000об/мин дают все таки прирост

Я вот как раз к тому, что не стоит заморачиваться с VR. Разница в производительности минимальна. Я вот как раз к тому, что не стоит заморачиваться с VR. Разница в производительности минимальна.Время и прогресс берут своё.Intel SSD 120 Gb подключил к контроллеру Marvell Да верни уже его на интелёвый хаб, нормально он там будет работать.

Добавлено через 1 минуту

свою ССДшку - там график в общих чертах линейный получается А какой он ещё может быть, у SSD-то. ;)

А какой он ещё может быть, у SSD-то. ;)

Да я откуда знаю - я же новичек в этих делах :D Вот методом тыка и изучаю :смеюсь:

Добавлено через 2 минуты

Да верни уже его на интелёвый хаб, нормально он там будет работать.

Че то система нихрена его не видела когда он туда был включен :confused: Точнее видела в Бивисе но грузиться с него наотрез не хотела :confused:

Верну обратно попозже - хочу взять Интеловскую ССД Сата3 и подоткну ее к Марвелу, а Сата2 верну на Интеловский контроллер :)

система нихрена его не видела когда он туда был включен Но теперь-то ты же уже поставил дрова для режима RAID? Уже должно грузиться и с него.Но теперь-то ты же уже поставил дрова для режима RAID? Уже должно грузиться и с него.

Да я пока ничего не ставил :shuffle: Настроил RAID через Биос :rolleyes:

Но теперь-то ты же уже поставил дрова для режима RAID? Уже должно грузиться и с него.

Кстати так наверное не получится - в мануале к материнке написано что в лучае перевода одного из портов Сата2 на контроллере Интел в режим RAID все шесть портов Сата этого контроллера начинают работать в режиме RAID, по видимому именно из за этого мне сперва не удалось заставить систему грузиться с ССДшки подключенной к этому же контроллеру - поэтому я и переключил ее на Марвелл.

все шесть портов Сата этого контроллера начинают работать в режиме RAID И что с того? Все RAID-контроллеры поддерживают и работу одиночных дисков.Вот ещё один такой-же добавь - и в RAID10 их; а на сервере поднимай терминальный сервер - и всех в RDP, вот и наступит вам щастье с быстродействием. :)

Выражаю благодарность Smirnoff:up: поднял терминальный сервер и пользователей подцепил. Щастье наступило:смеюсь: до Raid10 немного осталось.

Добавлено через 12 минут

Сильно не бить, я только учусь ;)Ещё вопрос есть сервак (домен cert.local). на нем AD соответственно, + файловый сервер. Так вот можно ли подключить сетевой диск чтобы он был виден вне домена(Т.е. компьютеры не входили в домен , были в разных рабочих группах, но при этом могли подключить этот сетевой диск). Все компы принадлежат одной сети. По ip сервер не пингуется, но через RDP без проблем. Может быть дело в брэндмауэре? Если да то как его настроить в AD?

есть сервак (домен cert.local). на нем AD соответственно, + файловый сервер. Так вот можно ли подключить сетевой диск чтобы он был виден вне домена Можно, но это очень пОшло - расшаривать вообще что-то на контроллере домена и уж тем более - для нечленов домена; расказывать "как" я не буду. ребят,нет времени читать,сразу вопрос по существу: можно ли перенести систему забэкапленную с обычного веника на рэйд? Я работаю с графикой и 500 гиговый диск весь забит уже, хочу сейчас купить два по 500 гиг и в рейд их слить, сделать бэкап диска,который есть сейчас и переместить всё это на рейд. Это возможно, дл этого нужно делать какие-нибудь особые операции с новыми винтами перед перемещением?Люди добрые, подскажите и мне! Ну пожалуйста.

Проблема:

BSOD (stop:0x0000007b (0xfffffadfca323c0, 0xfffffffffc0000034, 0x000..00, 0x00..00)) при время установки windows 2k3 x64 во время инициализации установки (вроде перед лицензионным соглашением).

Куда ставлю:

Intel server Board s5500bc, корзина стандартная (axx6drv3gr). четыре жестких, по 1тб, собрал через стандарную прошивку intel-oв в raid-10, инициализировал. Во время установки подсовываю дрова на usb-флопаре, дрова с сайта intel. Установщик продолжает грузить драйвера системы, в конце вываливается в BSOD.

Как же мне все это дело спасти?

С драйверами от x86 установка отказывается работать, что-то вроде "выбранные драйвера х86, а нужно х64, давай другие, с этими работать не буду". С nLite уже пытался, но слава богу нашел дискету с флопарем, а то бы болванок уже угробил штук 30. а то бы болванок уже угробил штук 30. Забавно. У меня почему-то прямо с первого раза всё получается.nLite нужно сказать, что требуется интегрировать дрова, что нужна вся папка и что эти дрова - текстового режима; потом велеть создать .ISO и нарезать его (я предпочитаю Nero, но nLite и сам может нарезать). Вчера привезли RevoDrive3, подключил его и обнаружил что с рейдом на ich10r он не дружит( Ну точнее 128кб памяти биосам их контроллеров не хватает( Сейчас лазил на бугровских сайтах, искал решение - чтото не совсем понял, я так понял на каких то матерях эту парочку можно сдружить? Скачал для своей мамки свежие прошивки, вечером попробую. Оч не хочется остаться без raid 10 =( Может кто сталкивался с подобным, как устранить проблемму? RAID manager в BIOS поменять на тот, где нужная опция есть. RAID manager в BIOS поменять на тот, где нужная опция есть.

Это где такое найти?

Поставил свежую прошивку - не помогло, единственное что пока смог сделать, создать рейд1 на марвеле. Норм работает вместе с revo, он видимо меньше места занимает чем ich10r bios. Кидай ссылку на свою прошивку и мамку, где тоже ICH10R, но есть 128К.

Обновил firmware RevoDrive 3 с версии 2.08 до 2.11 (новейшая) - биосы по прежнему не умещаются, но зато ssd теперь работает гораздо быстрее) примерно на 30%, к примеру лин. чтение с 430Мб выросло до 580 :super:

Добавлено через 5 минут

Кстати, прошиваться на Revo 3 теперь стало горАздо! удобнее, к примеру на первой серии этих ссд нужно было чрз биос размонтировать массив, только после этого можно было их шить. Само-собой данные терялись безвозвратно, а тут после прошивки даже окна не пришлось переставлять, я в шоке! :)

вопрос не в тему , можно ли hdd с системой пириткнуть в другой сата порт ? dope77 На твоей профильной м/б тыкай в любой красный SATA, система даже не заметит подвоха(естественно в BIOS расставить приоритеты). Белый и оранжевый SATA работают только в BIOS! C подпрограммой ASUS Drive Xpert.dope77 На твоей профильной м/б тыкай в любой красный SATA, система даже не заметит подвоха(естественно в BIOS расставить приоритеты). Белый и оранжевый SATA работают только в BIOS! C подпрограммой ASUS Drive Xpert.

Белый и оранжевый SATA работают только в BIOS! C подпрограммой ASUS Drive Xpert. Да ОЙ. :DЕсли прочитать мануал - нечаянно выяснится, что и к Марвелу можно спокойно подключать одиночные HDD (и даже - в режиме Hot Plug). Если прочитать мануал

Вот и почитай Олег Батькович! Там JMB361 только одним UltraDMA каналом на два PATA девайса рулит + eSATA в тылу. А вот оранжевый и белый на SATA Sil5723 контроллере у меня в Win7 не видны :dont:.

Добавлено через 1 час 0 минут

оранжевый и белый на SATA Sil5723 контроллере у меня в Win7 не видны Кстати "о птичках": полез сейчас на свою P5Q - там тоже типа написано, что мол "Marvell® 88SE6111 - 1 x UltraDMA 133/100/66 for up to 2 PATA devices" и "Silicon Image® Sil5723 (Drive Xpert technology) - 2 x SATA 3Gb/s

- Supports EZ Backup and Super Speed functions"

При этом, если я в BIOS выключаю Marvell - так у меня и диски на этих двух SATA-разъёмах (белом и оранжевом) нифига не видны, а если включаю - всё прекрасно видно.

Казалось бы - ну при чем тут Marvell, когда их обязан обслуживать Sil5723 .

А вот, оказывается, есть некая связь: чё-то там накосячил "сумрачный ассусьный гений". :cool:

Всем привет.

Думал рейд создать просто, но помучавшись у меня не удалось.

материнка: P8Z77-V LE.

накопители: ssd - система (6G_1), dvd-rom (6G_2), HDD 3Tb (3G_1), HDD 3Tb - пуст, отформатирован в винде (3G_2).

Думал все просто, зайду в биос, переключу с AHCI на RAID и дальше следовать указателям, но нет, после переключения ничего не произошло и просто винда не грузилась.

В мануале к материнке пишут про usb floppy на который нужно скопировать драйвера (пытался скопировать на флешку, но в досе ее не видит и пытается читать с A:\

Как создать raid1 на 2 не системных винта в моем случае? -_-

Как создать raid1 на 2 не системных винта в моем случае? Начать с заполнения конфигурации компьютера в своём профиле.

Далее - желательно сделать куда-то бэкап информации с HDD: бывает, что создание RAID1 из одиночного HDD с добавлением пустого проходит нормально, но возможен и вариант с потерей данных.

после переключения ничего не произошло и просто винда не грузилась Что делать - зависи от ОСи, про которую мы пока ничего не знаем.

Что делать - зависи от ОСи, про которую мы пока ничего не знаем.

Профиль заполнил. Но я не спец и по поводу оси не очень понял +_+ после перечитывания инструкции к материнке понял, что при переключения с ahci на рейд - все диски переключаются в рейд. Тоесть видимо на моей материнке нельзя одновременно использовать обычный ссд + рейд1 из 2 хдд.

Насколько я понял либо рейд контроллер докупать, но эта идея немног не нравится. Либо же. что если в виндовсе создам зеркальный том (с потерей данных он создается вроде как)?

Всем привет, рад, что вы решили посмотреть вторую часть статьи по настройке и созданию raid массивов на контроллере adaptec raid 8885. Сегодня мы будем рассматривать, самые распространенные виды RAID, со всеми нюансами и рекомендациями, которые предписывают производители железа, но в любом случая, я вас призываю не верить на слово и производить свое тестирование со всеми настройками.

И так общие настройки для контроллера посмотрите в первой части настройки adaptec raid 8885.

Инициализация дисков

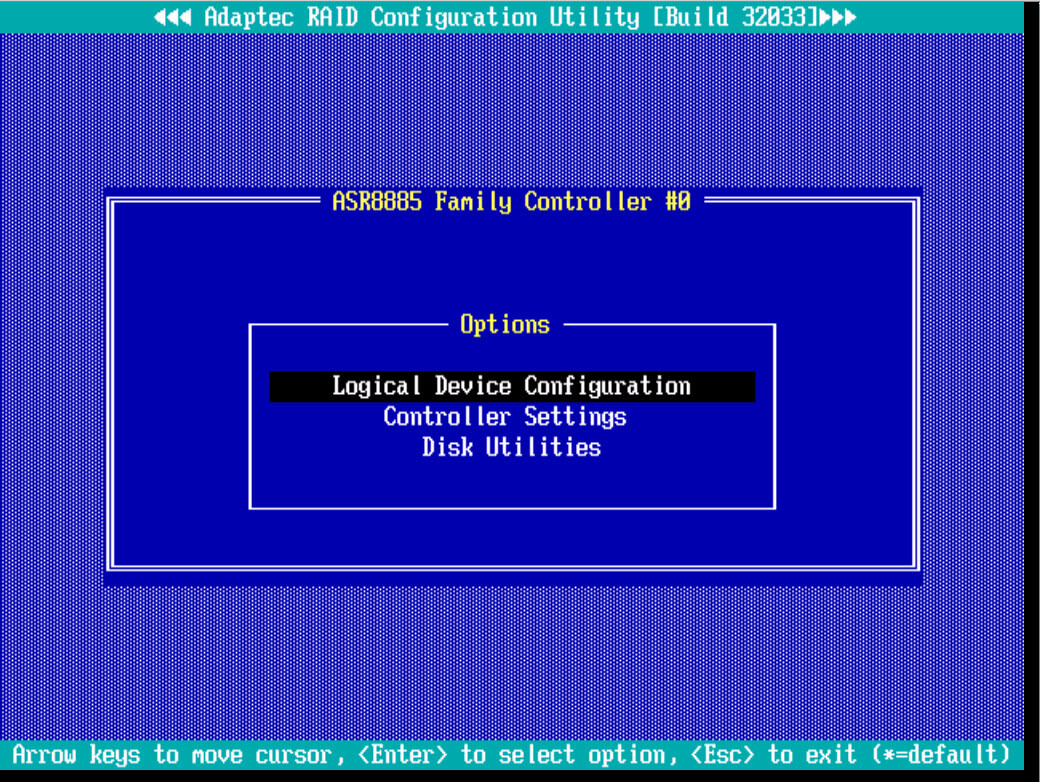

Выбираем в главном меню пункт Logical Device Configuration

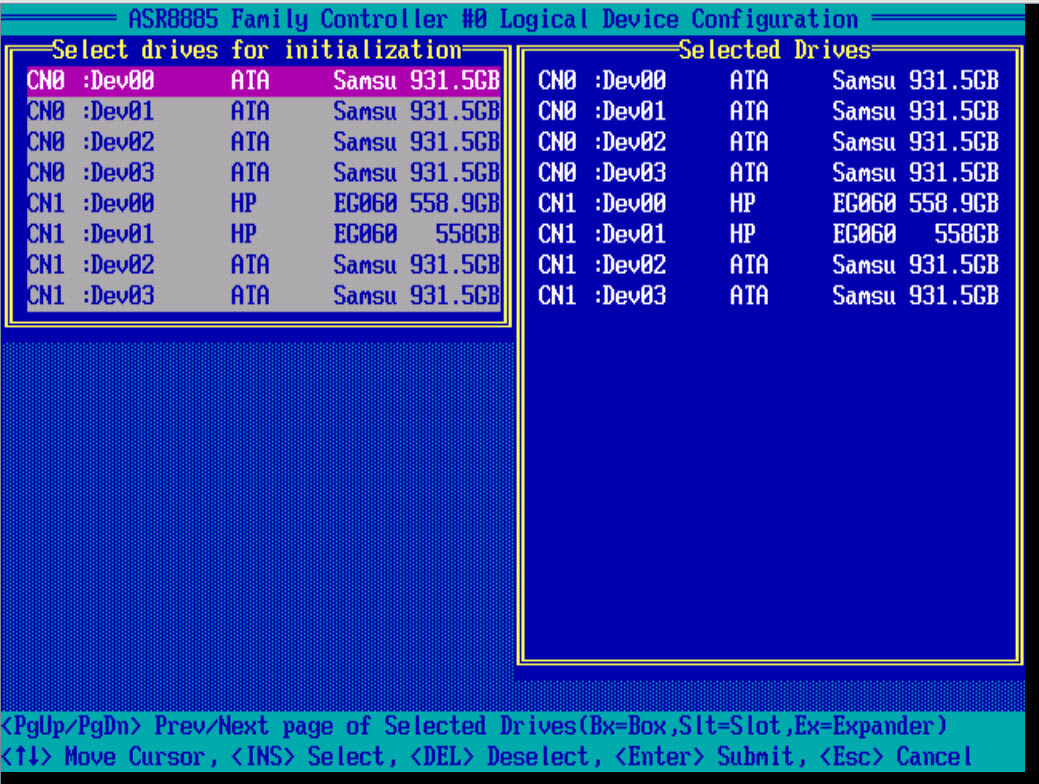

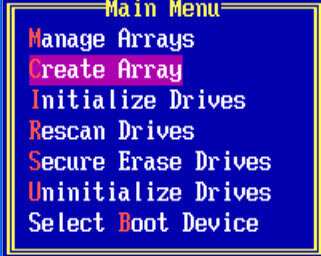

Первым делом, что бы вы могли создать создать raid массив, вам нужно проинициализировать ваши диски, для этого выбираем initialize Drives.

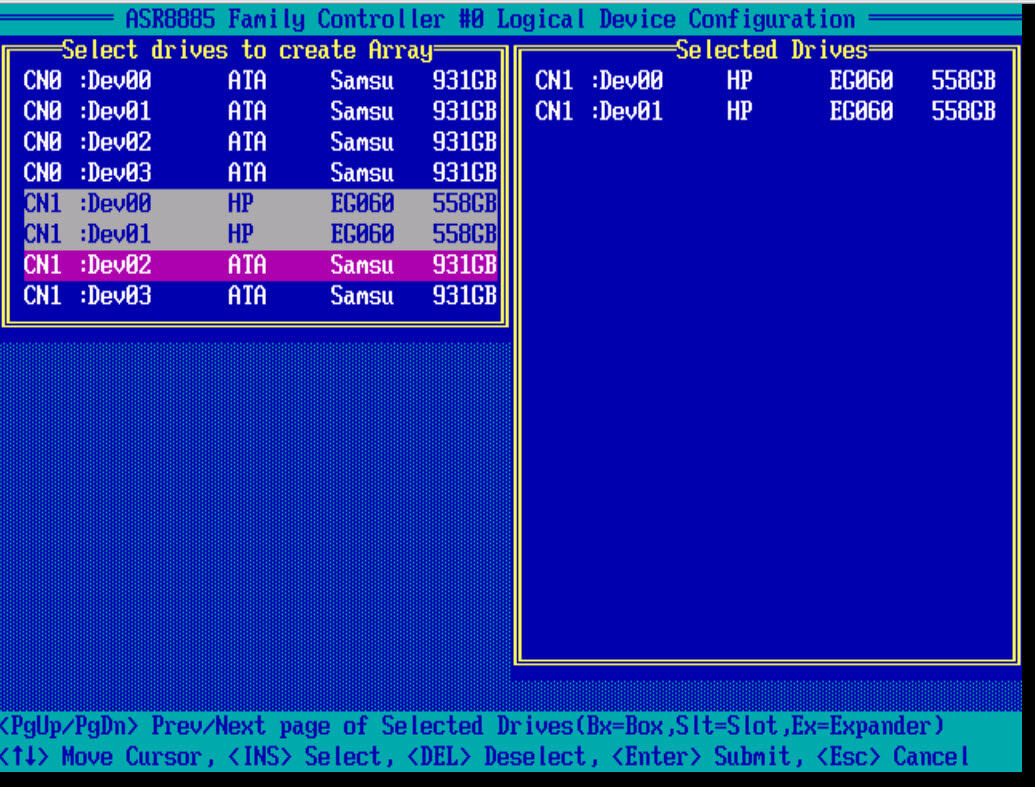

Пробелом выбираем нужный диск, он сразу будет у вас отображаться в правой части окна. Для подтверждения выбора жмем Enter.

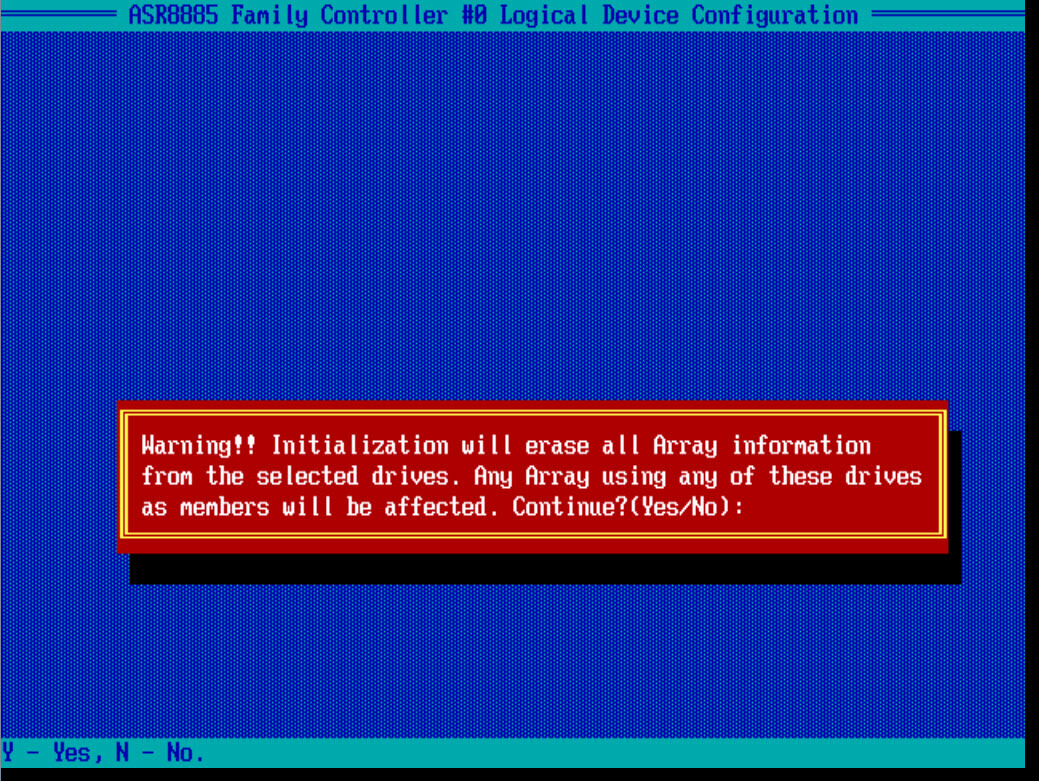

Вас предупредят, что вся информация с дисков будет удалена, жмем Y и соглашаемся

Как создать raid

И так давайте рассмотрим как создать raid на данном контроллере adaptec. После инициализации рассмотрим создание RAID 0 и RAID 1 под систему, почитать по виды RAID можно по ссылке слева. Выбираем Create Array.

Создаем RAID 0

Создать raid массив 0, можно из любого количества дисков или твердотельных SSD. Я выбираю пробелом два HP SAS диска по 600 гб.

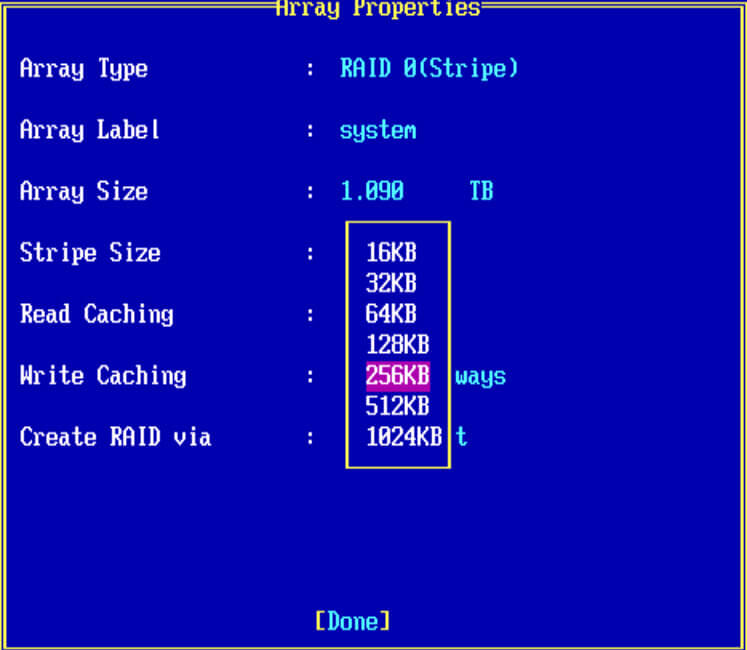

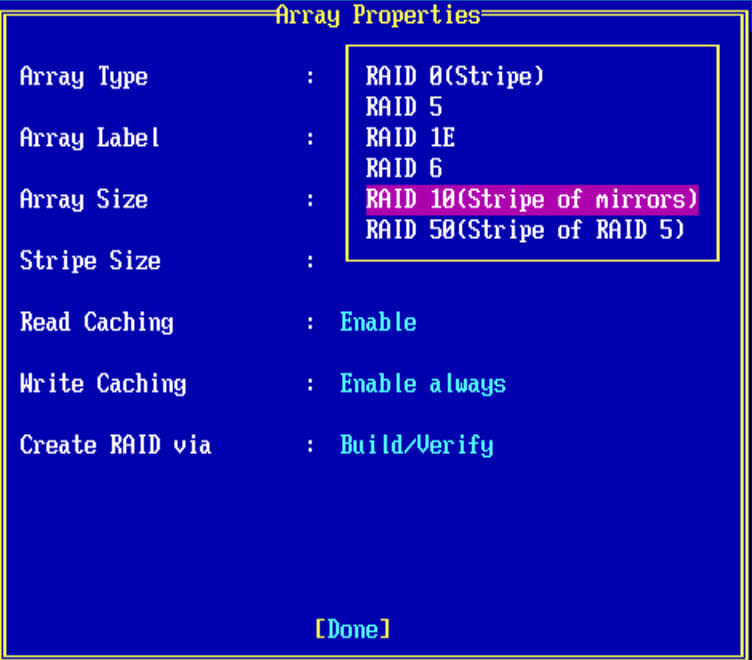

- Выбираем RAID 0

- в Array Label можно написать предназначение массива

- Array Size > указываете нужный вам размер

- Stripe Size > размер блока, может принимать разные значения от 16-1024 кб, все зависит от задачи

- Read Cachin > кэш на чтение

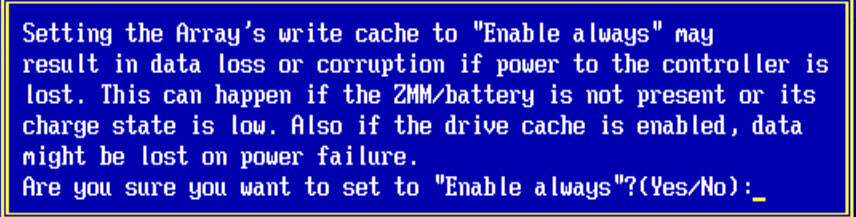

- Write Caching > кэш на запись, про оба кэша в конце статьи.

- Criate RAID via > инициализация массива.

Жмем enter, вас предупредят, что все данные у вас будут уничтожены.

Я настоятельно рекомендую использовать данный вид рейд, только в тестовых целях, так как отказоустойчивость у него нулевая, выше я дал ссылку на виды рейд, почитайте их принципы

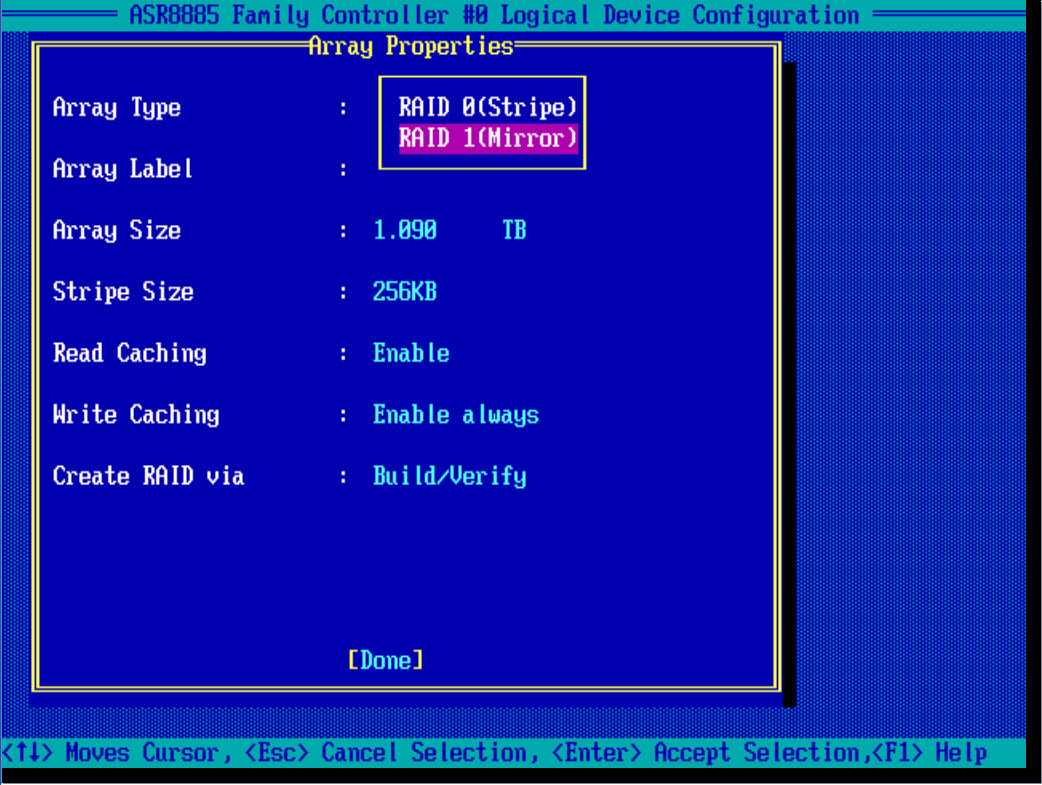

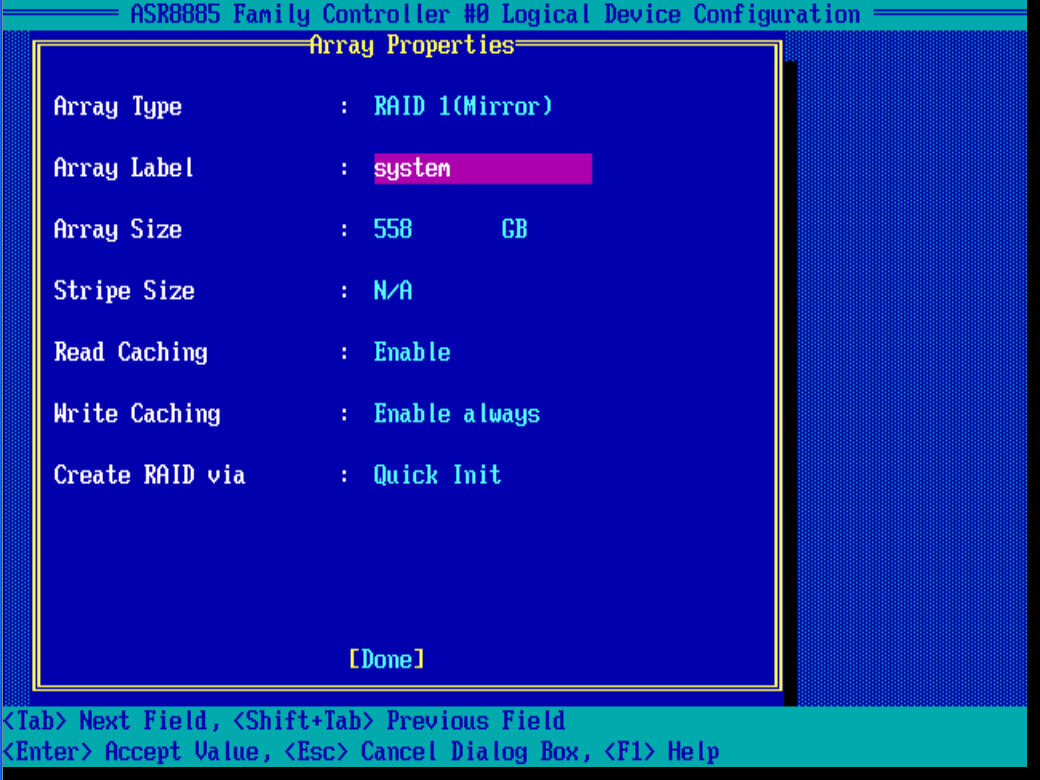

Создаем RAID 1

И так, так же как и с 0 рейдом, создадим на контроллере adaptec, зеркальный массив под установку системы. В Array Type выбираем RAID 1 (Mirror), для его создания нужно четное число дисков.

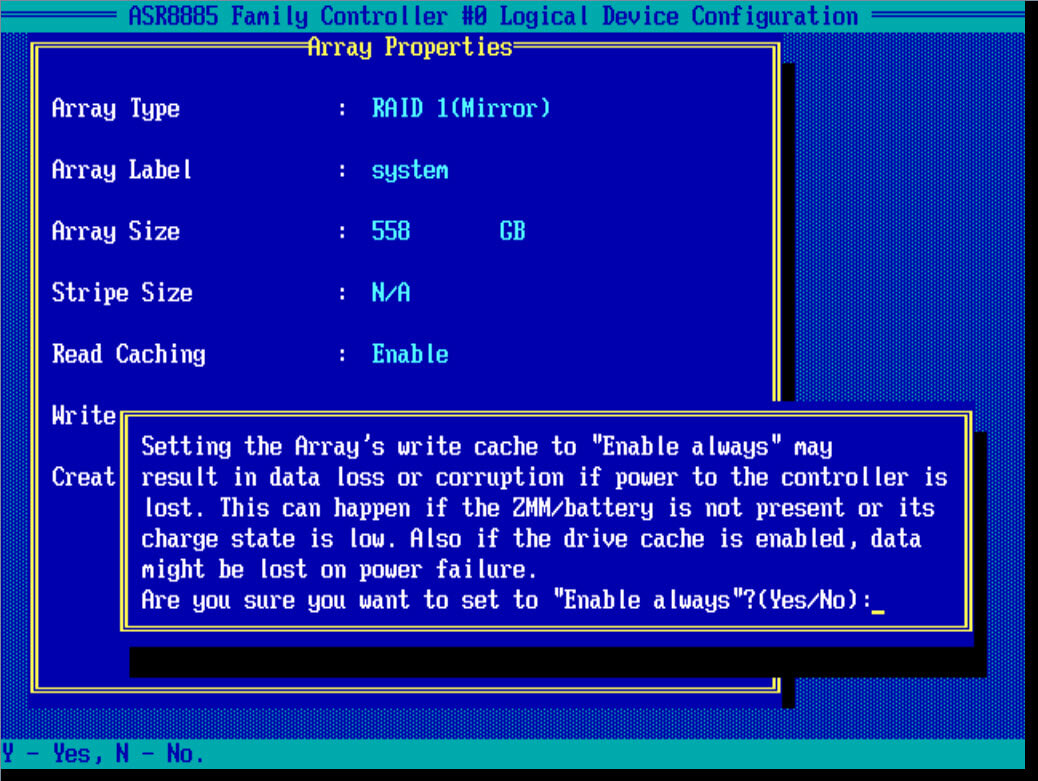

Также задаем описание, у меня это system. Stripe к сожалению задать не удается, режимы кэширования оставим по умолчанию

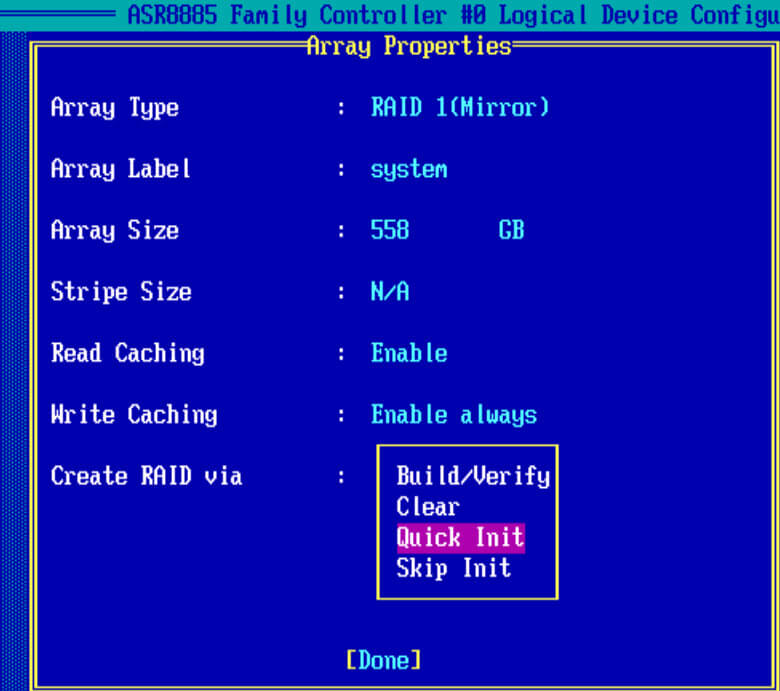

В пункте Create RAID via выбираем Quick init, быстрое формтирование массива.

Подтверждаем инициализацию рейд дисков

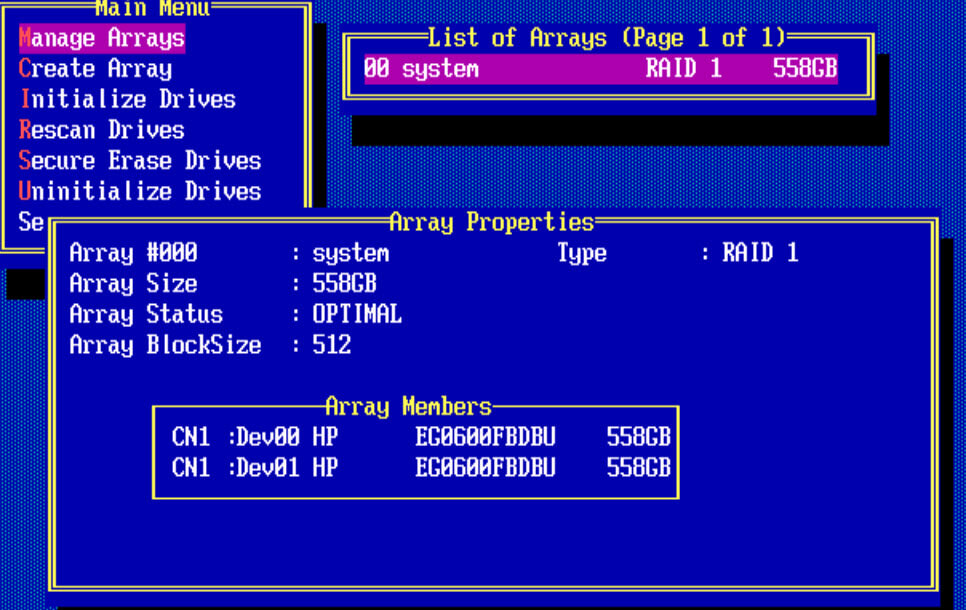

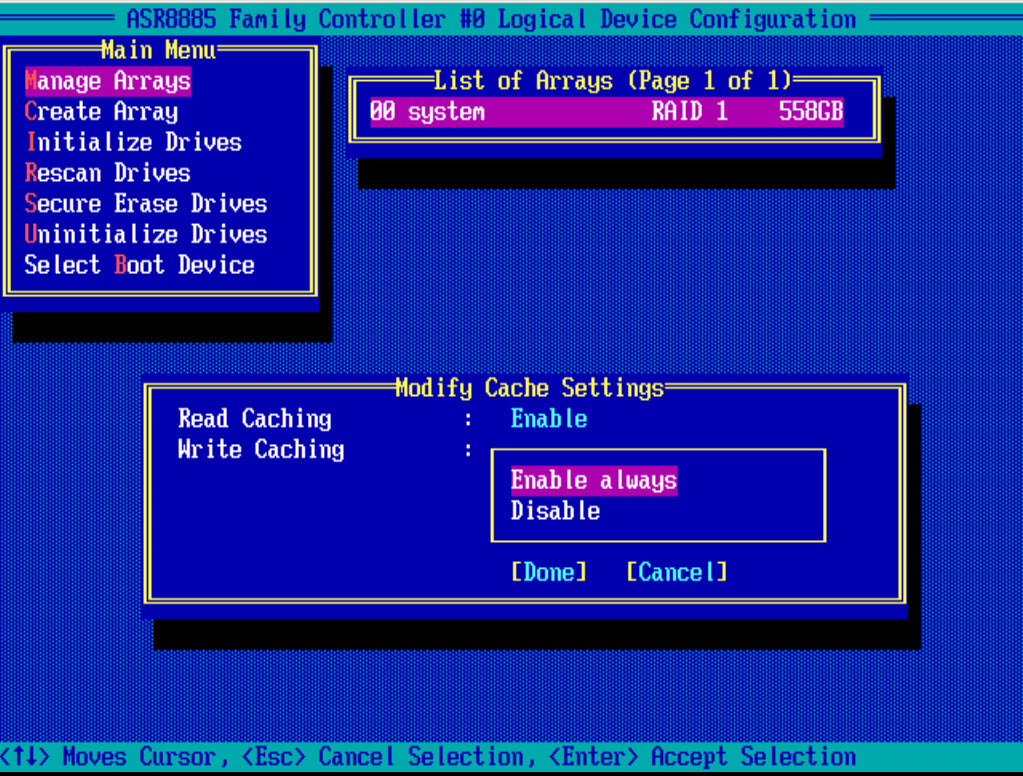

Для того чтобы, потом изменить настройки созданного рейд массива, следует выйти в меню Main Menu и выбрать пункт manage Arrays. У вас будет отображен список lun в List of Arrays. Как видите у меня есть RAID 1 и он состоит из двух дисков.

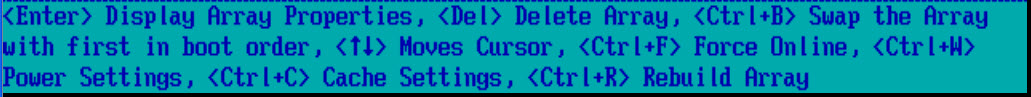

Снизу есть комбинации клавиш с помощью которых можно выполнять редактирование у созданных lunов.

Нажимаем CTRL+R и попадаем в пункт редактирования настроек кэширования. Выбираем значения Tab.

Создаем RAID 5

Самый противоречивый вид, с одной стороны может долго восстанавливаться, а с другой экономит место. Если у вас как и у меня будут ssd твердотельные диски, для тестирования, то советую попробовать пятерку. Для создания рейд 5 требуется минимум 3 диска, формула n-1, где n общее число дисков. В моем случае из 4 ssd и в системе увижу объем трех, четвертый будет скрыт под контрольные суммы.

Выбираем из списка RAID-5

Вот какие настройки у меня получились.

Жмем done. Так как у меня 4 ssd диска, то контроллер предложил, для увеличения производительности отключить на ssd дисках кэш на чтение и на запись.

При желании потом можно включить cache.

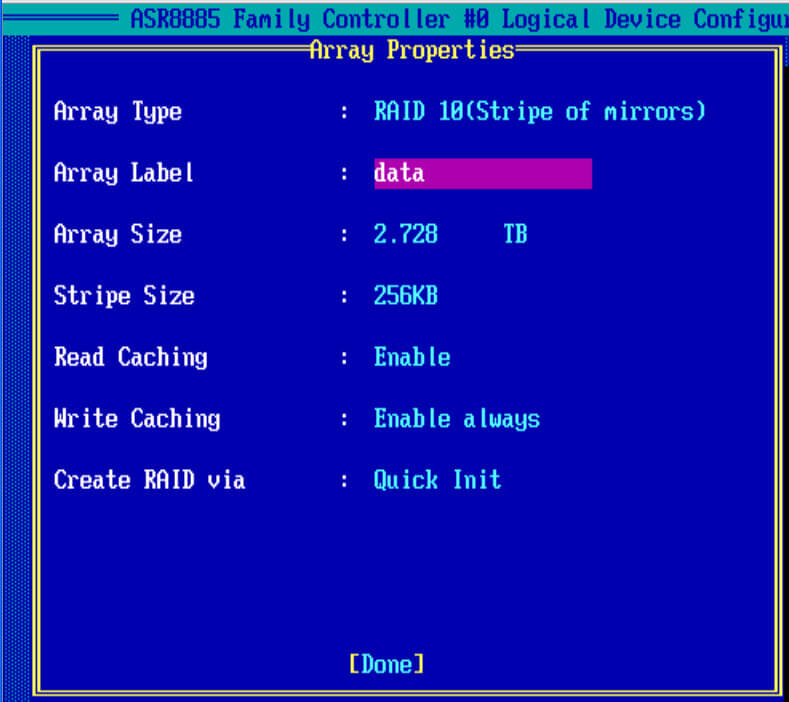

Создаем RAID 10

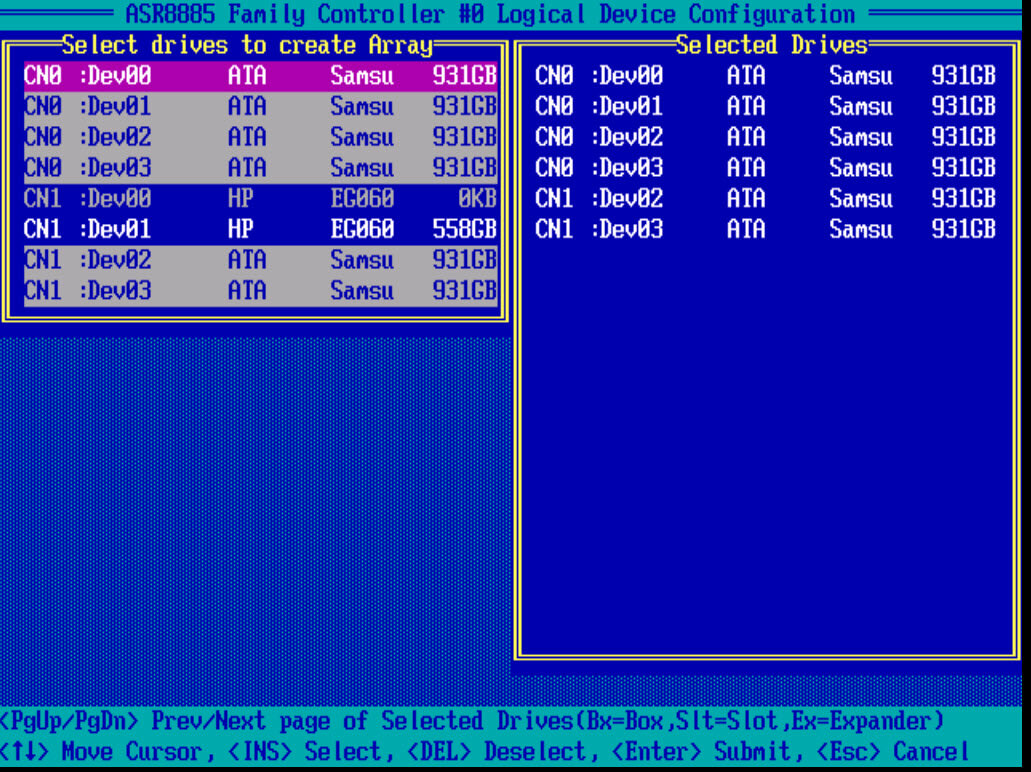

И так, чтобы настроить raid массив 10, нам потребуется четное количество дисков. В моем случае это 6 ssd samsung evo 850. Выбираем диски пробелом и жмем Enter.

В Array Type выбираем нужное значение.

заполняем остальные значения, у меня вышло вот так и жмем done, так же контроллер вам порекомендует отключить для ssd кэширование, советую подтвердить на данном этапе, а потом сравнить во время тестирования с ним и без него.

Описание кэширования LUN

- Read Caching > Данная настройка, по дефолту включена, это позволяет adaptec 8885 контроллеру сохранять данные в кэш на диске. Со включенным кэшом контроллер мониторит процесс чтений данных с пула дисков. Опция Enable MaxCache, аналогична Cache Cade у LSI, и смысл технологии в том, что если у вас есть обычные hdd и есть один или более ssd дисков, то их можно использовать для кэширования hdd массивов, что в десятки раз увеличивает количество операций ввода/вывода (iops)

- Write Caching > так же настройка включена по дефолту. Данный параметр означает. что включен режим write-back, в котором рейд контроллер отсылает ОС подтверждение о том что данные записались, только тогда когда они появились на дисках. При его работе производительность лучше, но данные могут потеряться если у вас будут проблемы с питанием, но если у вас подключена батарейка или флэш-модуль, то кэш сохранится еще на 72 часа, в течении которых вы должны устранить проблему с питанием. Если вы не восстановите электропитание, то контроллер не сможет перенести данные из кэша DRAM, на диски.

Далее можно приступать к установке операционной системы на созданные lun, в моем случае я буду ставить VMware ESXi 5.5.

Читайте также: