Raid tp что это

Обновлено: 03.07.2024

Примечательно в новой модели Dorado 3000 v3 именно то, что она изначально умеет работать только с твердотельными накопителями. Это важно не с технической точки зрения, а с маркетинговой или даже психологической. Новинка «атакует» гибридные и классические СХД с жёсткими дисками — за аналогичную стоимость она может предложить большую производительность и удовлетворительную ёмкость. И, что самое важное, достаточную надёжность.

Собственно говоря, именно опасения в надёжности SSD до сих пор являются одним из важных факторов, которые замедляют массовое внедрение таких накопителей во всех областях. И зря! Переживания насчёт сохранности данных на SSD при длительном отсутствии питания к обычным СХД не очень применимы. Что касается высокопроизводительных хранилищ, то там победа твердотельных накопителей уже безоговорочна. Seagate выпустила последнее поколение 15k-дисков ещё в 2016 году , а WD/HGST заявила об отказе разработки новых HDD 10k и 15k в 2017-ом . Да, такие накопители всё ещё поставляются, но новых моделей ждать больше нет смысла.

В течение следующего цикла обновления оборудования они в любом случае будут вынуждены обратиться к SSD. А новые, более ёмкие HDD скорее займут нишу хранения «холодных» данных. Впрочем, технологиям SMR , HAMR и MAMR тоже предстоит доказать свою надёжность в долгосрочной перспективе. Для SSD же первые исследования на больших объёмах провела Google ещё в 2016 году . И они показали, что в плане надёжности SSD, вообще говоря, ничуть не хуже HDD, хотя и требуют для детальной оценки несколько иных метрик в силу различия физического устройства накопителей.

Внутренняя статистика Huawei говорит о том, что на практике частота возврата накопителя по гарантии — износ ей покрывается — до 5 раз меньше для SSD, чем для HDD. Кроме того, надёжность SSD нынче такова, что даже для моделей с относительно небольшим значением DWPD, высока вероятность того, что они успеют морально устареть и будут заменены до того, как износятся.

Huawei OceanStor Dorado 3000 v3

Формально есть ещё одно ограничение — на выбор доступен только один объём кеша в оперативной памяти, от которого напрямую зависит производительность СХД. Однако в данном случае даётся 96 Гбайт на каждый контроллер, которых, строго говоря, более чем достаточно при лимите в 100 дисков на контроллер и используемом CPU Intel Xeon 4109T (8C/16T, 2.0/3.0 ГГц). К слову, ровно тот же процессор используется в гибридной СХД среднего уровня OceanStor 5500 V5 из прошлой линейки.

Во всём, что касается реальной производительности, Huawei не устаёт напоминать, что не все all-flash СХД одинаково полезны, даже несмотря на официальные рекорды с миллионами IOPS. Идея проста — все тесты надо проводить в условиях, приближенных к реальным нагрузкам. Это, например, тесты при 80% заполнении хранилища, которое при таком уровне неизбежно начнёт страдать от сборки мусора в накопителях. Штраф накладывает и использование RAID-массивов уровней 5 и 6, а также массивов тройной чётности (TP). По умолчанию SSD ёмкостью менее 8 Тбайт собираются в RAID-6, а более ёмкие в RAID-TP.

Массивы RAID-10 и 0 в Dorado принципиально не поддерживаются, так как они либо отъедают ёмкость, либо сказываются на надёжности. Собственно реализация RAID-TP позволяет добиться устойчивости к сбоям (из строя могут выйти три накопителя сразу) и ускорения восстановления после них, сохраняя ёмкость. Фактически в случае RAID-TP массив образуют не сами диски. Последние разбиваются на блоки по 64 Гбайт, которые и собираются в RAID-группы.

Кроме того, для экономии места по умолчанию всегда включены сжатие и дедупликация. А надёжность дополнительно обеспечивается механизмом anti-wear-leveling — когда износ накопителей, внутри которых как раз работает выравнивание (wear-leveling), достигает 80%, случайным образом выбирается «жертва», которая получает чуть большую нагрузку. В итоге диски выходят из строя и могут быть заменены по одному, а все разом.

Другой стандартный механизм защиты данных — это снапшоты, которые можно делать хоть каждые десять секунд. Используемый для них механизм redirect-on-the-write также положительно влияет на скорость работы. В целом, каждая из вышеперечисленных технологий не более чем на 10% снижает суммарную производительность СХД.

Ещё один пункт, связанный с надёжностью, но в несколько более широком контексте, связан с производством накопителей и СХД в целом. Политика максимальной локализации неожиданно стала особенно актуальной в свете политических событий последних месяцев. Хотя Huawei и прежде старалась использовать по возможности свои наработки. Для СХД доля собственных компонентов в количественном выражении превышает 90%, а в денежном — выше 80%. Из сторонних решений есть только CPU Intel и несколько чипов Broadcom. До недавнего времени RAM закупалась на стороне, но теперь в Китае осваивают и её.

Для SSD ситуация похожая. Чипы NAND действительно приобретаются у крупных зарубежных поставщиков вроде той же Samsung. Однако вся остальная технологическая цепочка производства — упаковка, тестирование, сборка, корпусировка — делается на месте. Контроллер и прошивка для него тоже создаётся своими силами. Более того, для накопителей корпоративного класса проводятся дополнительные тесты надёжности вроде облучения нейтронами, которые могут изменить состояние транзистора в ячейке. Контроллер должен уметь корректировать и такие ошибки. В сумме это позволяет заявлять Huawei, что для её SSD показатель MTBF составляет 3 млн часов.

Как уже было отмечено в самом начале, Dorado 3000 v3 будет предлагаться по цене, сходной с ценами 10k/15k HDD (в первую очередь), гибридными и all-flash СХД других вендоров. Более того, Huawei готова идти на риск и предлагать замену более старших HDD-моделей прошлого поколения на «трёхтысячную». Под этим подразумевается, что цена Dorado 5500 прошлого поколения с SAS-дисками 10k ёмкостью 2,4 Тбайт будет сопоставима с ценой Dorado 3000 v3 с примерно следующими характеристиками: SAS SSD ёмкостью 4 или 8 Тбайт, интерфейсные блоки 32GFC и 10GbE, производительность порядка 150 000 IOPS.

Бонусом «трёхтысячная» получит полный набор ПО для расширения функциональности, которое в случае старших моделей Dorado придётся докупать отдельно: HyperMetro, репликация, клонирование, сервисное облако и так далее. Помимо прочего, Dorado 3000 v3 останется начальной моделью и для серии СХД грядущего поколения, то есть просуществует на рынке достаточно долго.

Ну а все последующие СХД Huawei OceanStor Dorado v6 будут только all-flash, причём как с SAS, так и с NVMe. Вообще они будут значительно отличаться от текущих решений во многих аспектах. В частности, для них будет полностью переработана внутренняя архитектура: основной шиной станет 100GbE, они получат ИИ-чип и SCM-память, часть функций станет программно-определяемыми и так далее. Но самое главное, Huawei обещает, что эти СХД не будут содержать ни одного американского компонента. Даже процессор будет свой. А уж какой, догадайтесь сами.

За последние двадцать лет мощность процессоров выросла почти в 580 раз, пропускная способность каналов — в 1000 раз, а вот производительность СХД — только в 20 раз. Хранение данных стало «слабым местом», которое тормозит развитие всех IT-систем. Положение дел заметно улучшилось благодаря распространению СХД на SSD-накопителях. К таким системам относится Huawei OceanStor Dorado V3 — СХД высокой доступности (99,9999%). В этом посте мы без громких эпитетов расскажем о технологиях, на которые стоит обратить внимание, оценивая нашу новинку.

All-flash СХД Huawei OceanStor Dorado V3 рассчитана для использования в ИТ-системах, где скорость и надёжность систем хранения становятся критически важны. Это, к примеру, обработка транзакций в реальном времени (OLTP), оперативная аналитическая обработка (OLAP) крупных баз данных, высокопроизводительные вычисления (HPC), инфраструктура виртуального рабочего стола (VDI). В них потенциал нашей СХД основан на разработках в трех областях — это оригинальные SSD, функциональная ОС и широкие возможности интеграции.

Основа Dorado V3 — собственные накопители Huawei SSD, работа с которыми оптимизирована на уровне операционной системы. В зависимости от модели СХД, в нее можно установить до 200, 800 или 2400 накопителей.

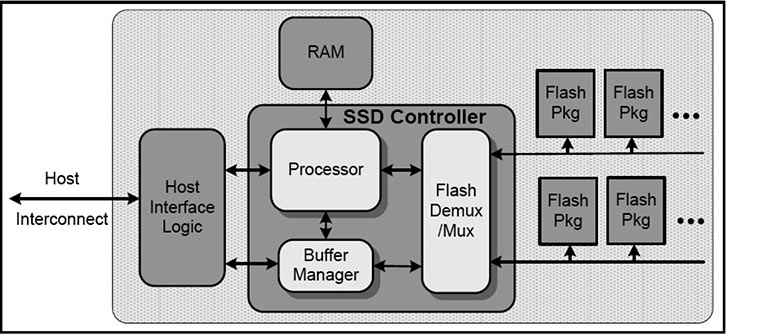

Контроллер накопителя основан на SoC Cortex-A9, поддерживает DDR4, 18 каналов NAND-флэш, 12 Гбит/с SAS и 8 GT/s PCIe. Непосредственно на SSD реализовано несколько функций, обеспечивающих необходимые для систем высокой доступности пропускную способность и надёжность.

Чтобы снизить количество ошибок, данные проверяются на каждом этапе. Многоступенчатая проверка процесса позволяет получить частоту битовых ошибок (BER) равную 10 -17 . На уровне DDR для предотвращения ошибок данных используются ECC (error correction code) и CRC (cyclic redundancy check). На уровне NAND-флеш используются LDPC (low density parity check code) и CRC. И непосредственно на уровне DIE алгоритм XOR.

Read Retry попробует прочитать данные, изменяя напряжение flash-накопителя. В разумных пределах, разумеется. Чтобы устранить задержку при последовательном переборе нескольких уровней напряжения, Read Retry учитывает частоту использования блока, продолжительности хранения данных.

Read Retry использует только предустановленные уровни напряжения, поэтому дополнительно применяется технология Read Offset. На SSD компании Huawei сохраняются таблицы калибровки напряжения. При возникновении ошибки Huawei Enterprise SSD запрашивает таблицу на основе состояния блока и выбирает наиболее подходящее напряжение.

Из-за ограниченного срока службы SSD считают слабым местом all-flash СХД. Мы постарались сбалансировать нагрузку так, чтобы износ не стал проблемой. Наш основной инструмент здесь — регулирование износа SSD.

Распределение циклов программирования/стирания при регулировании износа SSD в СХД Dorado V3

C помощью алгоритмов распределения P/E-циклов ресурс дисков сокращается равномерно.

Распределение нагрузки при наличии диска со сравнительно большим износом

Но при достижении высокого показателя выработки (>80%) такой подход может привести к одновременному выходу из строя всех дисков. А наш RAID готов только к трём одновременным отказам. Поэтому, когда жизненный цикл SSD близится к концу, включается обратная функция — Anti-Wear Leveling. Система выбирает SSD с самым большим износом и начинает писать данные на него, а пользователю тем временем советует его заменить.

Особенность работы NAND-флэш такова, что для записи новых данных на страницу — минимальную единицу в местной терминологии — нужно очистить весь блок в который она входит. Поэтому если в блоке есть полезные данные, их нужно перенести, что требует дополнительных операций.

Чтобы локализовать данные, к которым обращаются чаще всего, их на уровне SSD разделяют на «горячие» и «холодные». Данным с разной частотой использования добавляются соответствующие метки. SSD сохраняют данные с теми же ярлыками в один и тот же блок. Таким образом, «горячие» и «холодные» данные хранятся в разных блоках, уменьшая объем данных, с которым приходится работать системе.

Программная архитектура OceanStor Dorado V3 (BDM — управление блоками данных, DSW — сетевой коммутатор)

СХД семейства OceanStore работают под управлением одноименной ОС. Самое интересное в этой операционке — это набор утилит FlashLink для управления и оптимизации записи на SSD. FlashLink охватывает I/O-модули ПО контроллера с драйверами SSD дисков. Симбиоз на двух уровнях СХД позволяет увеличить IOPS и обеспечить задержку не более 0,5 мс. Функции FlashLink можно разложить по трем слоям.

Базовый уровень — виртуализация дисков. RAID 2.0 со знаком «плюс» стирает границы между RAID-массивами. Это позволяет одновременно и лучше распределять нагрузку, и ускорять работу. А при необходимости и восстановление информации. RAID-TP застрахует от проблем с данными даже если из строя выйдут сразу три диска.

На уровень распределения данных идет взаимодействие с накопителями. Разделение на горячие и холодные данные, выравнивание износа, цельнострайповая последовательная запись (full-stripe sequential write) — FlashLink управляет этими функциями, благодаря которым SSD живут долго, счастливо и не умирают неожиданно.

Уровень обслуживания данных: здесь происходит объединение все записей в один страйп, распределение по дискам раздаются приоритеты по распределению ресурсов.

Остановимся подробнее технологиях ОС OceanStore, которые мы не рассмотрели ранее.

Чтобы эффективно распределять нагрузку на дисковые массивы, нужно обеспечивать быструю запись на несколько дисков сразу. Чтобы сократить задержки используется цельнострайповая последовательная запись: новые и измененные данные объединяются в полный страйп и пишутся в свободное место на SSD. Благодаря тому, что здесь произвольная запись становится последовательной, мы избегаем задержек на чтение/очистку/запись, характерных для NAND:

При записи новых данных система объединяет данные LUN 1 и LUN 2 в страйп, а затем записывает данные на диски, как показано в левой части рисунка.

При изменении данных, пользователь изменяет 1B на 1b в LUN 1, записывает новые данные 3A и 3B в LUN 3, а новые данные 4A — LUN 4. Система объединяет 1b, 2B, 2C, 3A, 3B и 4A в качестве нового страйпа, а затем записывает данные на SSD. Блок 1B отмечается на удаление.

Глобальная очистка проводится после того, как все нужные данные были скопированы и сохранены в новом месте

При накоплении большого числа мусорных данных используется глобальная очистка. Таким образом освобождается пространство для записи целых страйпов.

Приведем аналогию. Вы поехали с большой компанией друзей на рыбалку. Поехали недалеко, потому что собрать столько народу надолго не получилось. Закинули удочки, сидите. Вдруг у вас в камышах запутывается леска. Капитально запуталась — нужно лезть в заросли, и неизвестно, распутаете ли вообще. У вашего друга рядом такая же история. Вместо того, чтобы долго распутывать снасти (перезаписывать данные) вы просто обрезаете леску и быстро натягиваете все заново — крючок, поплавок, грузило (записываете данные на пустое пространство). Когда рыбалка подойдет к концу, самый молодой и ловкий залезет в заросли и вытащит все сразу, с листьями и узлами, которые можно распутать по пути домой (в контексте СХД — проведет глобальную очистку).

RAID TP — схема создания страйпов с тройным резервным копированием

Для лучшей сохранности данных диски объединяются в массивы Raid TP. Благодаря цельнострайповой последовательной записи в Raid-массив добавляется дополнительный диск с информацией для исправления ошибок. Благодаря этому сохранность данных обеспечивается даже при выходе из строя трех дисков, и не происходит потери производительности. Таким образом, Dorado V3 поддерживает 23+3 (23 основных диска и 3 с кодами коррекции ошибок) RAID-конфигурацию, более надежную по сравнению с 23+2.

Расстановка приоритетов для операций ввода/вывода. Голубым выделены запросы, поступающие не с хоста — глобальная очистка, сброс кэша, репликация. Красным — группы с наиболее важным приоритетом — запросы с хоста и некоторые другие.

Чтобы уменьшить задержки, контроллеры Dorado V3 задают приоритеты для операций ввода-вывода. Например, приоритет запроса на чтение с хоста выше, чем запрос на очистку кеша, который в свою очередь ставится перед копированием в рамках асинхронной репликации. Приоритеты чтения/записи отправляются на SSD вместе с запросами на эти операции. Далее приоритеты обрабатывает контроллер SSD.

В Dorado V3 встроены функции дедупликации и сжатия. Вот как они работают. Сначала блок данных записывается в постоянный кэш. Затем вычисляется fingerprint блока с использованием слабой хэш-функции (экономим время и ресурсы), производится выбор контроллера для записи и побитовое сравнение со всеми хранящимися fingerprint'ами.

Если результат положительный, то производится удаление блока и подмена его ссылкой на найденный. Если совпадений нет, то производится сжатие блока с использованием алгоритма LZ4.

После этого производится запись блока на SSD, а его fingerprint добавляется в каталог. Эффективность сжатия зависит от типа данных, и обычно составляет от 2 до 3,5 раз. Принцип сжатия показан на картинке ниже:

Стоит оговориться, что такой подход к сжатию влияет на скорость записи. В сценариях, где требуется более получить более высокую скорость записи, эту функцию можно отключить на уровне LUN.

С технологией FlashLink мы смогли повысить производительность и надежность СХД. Это позволило нам реализовать на базе Dorado V3 несколько важных функций, которые необходимы, например, для крупномасштабного развертывания VDI или хранения данных критически важных услуг.

Схема инфраструктуры HyperMetro. Оранжевые линии — связь между хостами и сетевыми коммутаторами. Красные — сеть между дата-центрами в одном городе. Зеленые — репликация HyperMetro. Голубые — кворумная сеть с отдельным следящим сервером.

Объединение двух СХД OceanStor V3 открывает режим Huawei Active-Active HyperMetro, позволяет повысить аптайм системы хранения до 99,9999%.

Особенности этого решения:

- Согласованность двух СХД — параллельное чтение и запись. Когда одно хранилище недоступно, происходит переключение на другое хранилище с RPO=0 и RTO=0.

- Связь между копиями может осуществляться по протоколу FCoE на скорости 10Gbps, с возможностью комбинирования IP- и FC-интерфейсов.

- Между активными центрами обработки данных поддерживается сеть FC, которая позволяет разносить ЦОДы на большие расстояния, чем в случае с IP-сетями — до 300 км.

- Поддержка двух режимов арбитража доступа (внутренний и внешний) с возможностью задания приоритета. Внешний арбитраж может быть осуществлён с физического или виртуального сервера (Quorum Server), доступного по IP-сети.

- Каждая Dorado V3 управляется как минимум парой контроллеров. Система из двух СХД остается рабочей при доступности хотя бы одного из четырех (или более) контроллеров.

При расширении парка СХД имеющееся оборудование часто не списывается, а обновляется или переводится на другие сценарии — все для минимизации TCO (общей стоимости владения). Так со временем в одной и той же ИТ-инфраструктуре могут появляться хранилища разных производителей. Встает вопрос совместимости оборудования от разных поставщиков: нужно обеспечить безопасный и надёжный перенос данных при непрерывной работе.

SmartVirtualization умеет превращать LUN'ы сторонних массивов хранения в логические диски, ресурсы которых доступны для СХД Dorado. А также самостоятельно создавать LUN'ы на внешних массивах и привязывать их к логическим дискам. Метаданные DevLUN хранятся в локальном хранилище, а рабочие данные - во внешнем. В процессе работы SmartVirtualization отслеживает и исправляет ошибки маршрутизации LUN, связанные с использованием различных версий SCSI. Кроме того, она создает резервные каналы связи между разнородными массивами хранения.

Функция SmartMigration защищает данные при миграции между гетерогенными средами без прерывания хост-сервисов. Если во время процесса переноса данных с целевым LUN возникают неполадки, SmartVirtualization регистрирует различия ввода-вывода и выполняет инкрементную синхронизацию после исправления ошибки.

SmartVirtualization умеет выполнять синхронную и асинхронную репликацию между гетерогенными массивами. Причем при синхронной репликации показатель RPO будет равен нулю, а при асинхронной — не превышать считанных секунд. Наконец, SmartVirtualization способна создавать снэпшоты LUN в гетерогенных массивах хранения.

Обозреватель “Ъ FM” Александр Леви рассказывает, как система хранения данных OceanStor Dorado может снизить риски для компаний.

Представители Huawei скромничают лишний раз упоминать, но между тем по количеству патентов в области IT китайский вендор оставил позади таких гигантов, как Intel, Google и Microsoft. Как минимум этот факт отражает эффективность труда исследователей и разработчиков, которым компания ежегодно выделяет около 15% от глобальной выручки. Это более $20 млрд только за прошлый год.

Соревновательный элемент и имиджевая составляющая тут скорее вторичны, как мне кажется. В первую очередь ценность собственных разработок в возможности сэкономить и создать более эффективный и надежный продукт. Особенно в случаях, когда речь заходит о системах хранения данных, таких, как новое поколение OceanStor Dorado 18000. Допустим, если условный банк внезапно останется без доступа к сети, то это, безусловно, вызовет неприятности. Но проблемы сети можно устранить. Если же во время работы банка будут утеряны или повреждены данные, то масштаб инцидента легко может достичь статуса «катастрофа». Поэтому при создании систем хранения данных линейки Huawei OceanStor Dorado компоненты собственной разработки являются преимуществом, дополнительной гарантией контроля, предсказуемости, совместимости устройства с другими его элементами и программным обеспечением, что в целом легко конвертировать в надежность.

Кроме передовой аппаратной платформы Huawei, в основе OceanStor Dorado 18000 V6 лежит полностью взаимосвязанная архитектура SmartMatrix. Она предоставляет симметричные сервисы в так называемом режиме «активный-активный». Система хранения данных готова к выходу из строя одного из двух блоков контроллеров и семи из восьми контроллеров. Достичь обоих подобных сценариев одновременно можно разве что специально. Тем не менее, СХД от Huawei готовы и к этому. В запасе есть технология RAID-TP. Она готова к одновременному выходу из строя трех дисков. А для восстановления 1 Тб данных вместо средних показателей в 10 часов потребуется всего 15 минут, благодаря технологии интеллектуальных дисковых полок.

В системах хранения данных критически важны сохранность и время восстановления в случае сбоя. Свою ценность, а в некоторых задачах и более высокую, имеет скорость работы накопителей. Использование RAID-массивов в различных конфигурациях — это поиск компромисса между перечисленными параметрами.

RAID — это технология объединения двух и более накопителей в единый логический элемент с целью повышения производительности и (или) отказоустойчивости отдельно взятого элемента массива.

RAID-массивы классифицируются по следующим параметрам:

- по исполнению RAID контроллера;

- по типам поддерживаемых интерфейсов накопителей;

- по поддерживаемым уровням RAID.

RAID-контроллеры: аппаратные и не очень

По исполнению контроллеры делятся на программные и аппаратные. Программные реализуются непосредственно средствами операционной системы или на уровне материнской платы. Последние также известны как интегрированные, а также Fake-RAID. Они работают быстрее чисто софтверных решений за счет специального чипа для управления массивом. Недавно публиковался текст о развертывании таких технологий. Дополнительной железки при этом никакой нет и в любом случае будут использоваться ресурсы вычислительной машины.

Аппаратные RAID-контроллеры выполняются в форм-факторе платы PCIe либо в составе внешнего автономного устройства — дискового массива.

Они имеют на борту собственные процессор, память, BIOS и специальный интерфейс для конфигурации. Платы PCIe также комплектуются дополнительными модулями, сохраняющими данные, если произойдет сбой в электропитании: BBU с Li-Ion аккумулятором и ZMCP на базе суперконденсатора.

Оба модуля позволяют сделать сэйв содержимого кэша. После восстановления работы эти данные будут немедленно записаны на диск. Дисковый массив, будучи автономным, располагает собственными блоком питания и системой охлаждения.

Накопители подключаются к плате либо кабелями напрямую, либо через платы расширения. Автономные дисковые массивы содержат все накопители внутри себя, а наружу смотрит все тот же интерфейс PCIe (есть и другие варианты, например, USB 3.2 и Thunderbolt 3). Кстати, известный вид дисковых массивов — сетевое хранилище данных (NAS).

Что можно подключать к RAID-контроллеру

Следующий важный параметр, по которому различаются RAID-массивы, это поддержка интерфейсов накопителей. Не будем тревожить склеп с IDE-дисками, а констатируем, что по большому счету применяются три типа: SATA, SAS и NVMe. SAS — удел серверов, а вот остальные применяются повсеместно.

Есть программные и аппаратные RAID-контроллеры, которые умеют управлять массивом дисков с одним из интерфейсов. В формате PCIe есть и такие платы, которые реализуют режим Tri-Mode, позволяющий работать со смешанным составом накопителей.

Уровни RAID

Разобравшись с основными конструктивными особенностями RAID-контроллеров, перейдем к главной характеристике — поддержке уровней RAID. В подавляющим большинстве контроллеры работают с уровнями 0, 1, 1E, 10, 5, 5EE, 50, 6, 60. Другие занесены в красную книгу и на практике встречаются редко. Простейшие программные контроллеры позволяют создать RAID 0 и 1. Более продвинутые добавляют RAID 10 и 5. В аппаратных, как правило, такой перечень минимален, и многие платы поддерживают весь спектр уровней. Рассмотрим подробнее каждый из них.

Несколько важных нюансов для понимания эффективных объема и быстродействия, получаемых в результате объединения в массив:

- при использовании накопителей разного объема контроллер «обрезает» объем каждого из них до наименьшего из используемых. Если у вас есть много дисков 4 ТБ и один 2 ТБ, то в массиве все диски будут восприниматься как 2 ТБ;

- при использовании накопителей с разными скоростями ввода/вывода и задержками, то операции доступа будут осуществляться с наихудшими из всех параметров. Другими словами, самым быстрым дискам придется ждать, пока отработает самый медленный.

RAID 0

Единственный массив, который не совсем оправдывает название, поскольку не обладает избыточностью. При этом скорость и эффективный объем максимальны. Данные разбиваются на одинаковые блоки, равномерно записываемые на все диски по очереди. Эти блоки называются страйпами, отсюда и сам RAID 0 часто именуют страйпом. Считывание данных также происходит параллельно. Здесь конечно же есть свое но.

Дело в том, что прирост производительности не прямо пропорционален количеству дисков (как хотелось бы). В силу специфики накопителей, особенно механических, выигрыш в конфигурации RAID 0 хорошо заметен только на операциях последовательного чтения. Другими словами, при работе с большими файлами. Типичная область применения — игры, видеомонтаж и рендеринг. При условии, что регулярно производится резервирование на сторонние накопители. Наряду с этим при случайном доступе к файлам разница с отдельно взятым диском уже не так ощутима. Более позитивная картина наблюдается в случае твердотельных накопителей, но они и так удовлетворяют большинству запросов по быстродействию.

В общем, в современных реалиях RAID 0 далеко не всегда оправдает свое применение, а основная задача RAID-массива все же в повышении надежности хранения данных.

Обратная сторона медали за скорость как раз в отсутствии избыточности, что означает нулевую отказоустойчивость. В случае сбоя хотя бы одного из элементов массива, восстановление всего содержимого практически невозможно.

RAID 1

RAID 1, известный как «зеркало», представляет собой другую крайность. Он максимально избыточен — в нем производится 100 % дублирование данных. Этот процесс «съедает» ровно половину объема массива. Число дисков в нем, соответственно, четное. Позволяет увеличить скорость чтения, но синхронная скорость записи в некоторых случаях падает. При отказе одного из дисков работа автоматически продолжается с дублером. Если доступна функция горячей замены дисков, то восстановление штатного режима происходит без остановки. RAID 1 идеален для чувствительных данных.

RAID 5

Состоит минимум из трех накопителей, при этом доступный объем уменьшается на один. Данные записываются в страйпы на все диски кроме одного, на котором размещается контрольная сумма этой части данных. Запись этого блока также чередуется между всеми накопителями, распределяя равномерную нагрузку. Если их больше четырех, то скорость чтения будет выше чем в RAID 1, но запись будет осуществляться медленнее. Контрольные суммы позволяют достать информацию в случае выхода из строя одного из элементов. Сама операция восстановления вызывает повышенную нагрузку на оставшиеся диски. Значительно падает производительность и риск утери всех данных в случае отказа еще одного диска. Желательно иметь опцию горячей замены для оперативного возвращения в нормальный режим работы.

Со всеми плюсами и минусами эти три уровня наиболее распространены и просты в развертывании.

RAID 6

Развитие RAID 5 по части надежности, позволяющее пережить потерю двух дисков. В данной конфигурации в каждом проходе пишется две независимые контрольные суммы на два накопителя. Требуется минимум четыре диска, из которых два уйдет на описанный алгоритм повышения отказоустойчивости. При этом скорость записи будет еще ниже, чем у RAID 5.

Следующие уровни — производные и комбинации перечисленных.

RAID 10

Неплохо было бы объединить достоинства RAID 0 (производительность) и RAID 1 (отказоустойчивость)? Встречайте RAID 10: страйп и зеркало, два в одном. Но и недостатки не забудьте — по-прежнему половина объема уходит на резерв. А что делать, за надежность приходится платить. В этом плане менее экономичен, чем RAID 5 И RAID 6, но более прост в восстановлении после сбоя.

RAID 50

По похожей схеме получаем RAID 50. Здесь уже страйпы не зеркалируются, а распределяются по двум и более массивам RAID 5. Требуется от шести дисков, скорость чтения значительно увеличивается. Кроме того, нивелируется и слабое место RAID 5 и RAID 6 — низкая скорость записи. Отрицательная сторона опять лежит в плоскости экономики. Из эффективного объема выпадают два диска, как и RAID 6, при этом массив выдержит потерю только одного.

RAID 60

Данный гибрид RAID 0 и RAID 6 призван решить проблему производительности последнего. Отказоустойчивость остается на том же уровне, как и часть объема накопителей, отводимая на реализацию алгоритмов контроля целостности данных. Дисков для такого удовольствия понадобится как минимум восемь.

RAID 1E

Еще одна вариация совмещения алгоритмов зеркалирования и чередования данных. Записанные на одной итерации страйпы повторно записываются на следующей, но в обратном порядке. Таким образом в RAID 1E можно использовать три диска. Массив останется тем же зеркалом с эффективным объемом, равным половине от исходного.

RAID 5EE

Один из вариантов использования RAID 5 с резервным диском. Отличается тем, что этот диск не простаивает до выхода из строя одного из элементов массива, а используется наряду с другими. На каждой итерации помимо страйпов данными и контрольной суммой записывается резервный блок. Сделано это для ускорения процесса сборки массива в случае нештатной ситуации. Платой за такую опцию становится второй диск, исключаемый из эффективного объема RAID 5EE.

В таблице ниже приведены сравнительные характеристики рассмотренных уровней RAID.

Не забудем и про массив с незатейливым названием JBOD (дословно переводится как «просто связка дисков»). Строго говоря, он не является RAID-массивом. Это объединенные в один несколько дисков без дополнительной функциональности. Позволяет развернуть логический диск с объемом, который недоступен в рамках одного накопителя. Такой диск полезен для перемещения файлов больших размеров в несколько терабайт.

Вместо заключения напомним самое главное правило для всех, кто хранит данные в RAID-массиве: RAID-массив ≠ бэкап! Регулярно делайте резервные копии данных на независимые носители и да пребудет с вами сила.

RAID (Redundant Array of Independent Disks или «избыточный массив независимых дисков») — метод виртуализации, позволяющий объединять несколько дисков в единый логический том, имеющий лучшие характеристики. Чтобы описать, чем RAID может быть полезен на практике, рассмотрим теоретические основы, классификацию и особенности использования данной технологии.

Для чего применяется RAID

RAID позволяет превратить несколько дисковых накопителей в один большой и быстрый диск. Его можно использовать в качестве хранилища данных с функцией автоматического резервного копирования или настроить как системный диск повышенной отказоустойчивости.

У технологии RAID-массивов существуют и минусы. Платой за быстродействие и надежность становится усложнение системы, а также необходимость закупать дополнительное оборудование. Однако эта цена невелика по сравнению с потенциальными убытками, которые может понести пользователь при потере информации или внезапной поломке накопителя.

Преимущества технологии

- Увеличенный объем. Первоначальное назначение RAID — получение диска большей емкости.

- Повышение быстродействия системы через параллельное подключение в массив нескольких физических дисков.

- Отказоустойчивость и надежность хранения данных обеспечиваются выделением на цели резервирования отдельного устройства. При повреждении одного из дисков RAID-массива информация не будет утеряна.

Условие применения

Технологию можно использовать не во всех случаях. Для этого требуется ее аппаратная и программная поддержка. BIOS должен содержать настройку вида «SATA Configuration: RAID». Если же ее по каким-либо причинам нет, то необходимо «перепрошить» базовую систему ввода-вывода.

В случае, когда поддержка RAID программным методом невозможна, нужно подключить дополнительное устройство — RAID-контроллер и установить соответствующий драйвер. В последних версиях ОС Linux (Ubuntu 20.04, POP-OS 20.04 и т. д.) драйвер для включения режима RAID инсталлируется автоматически.

Основные понятия

В основе функционирования RAID-массивов лежит несколько базовых терминов, без которых нельзя понять принципы работы этой технологии.

- Массив — объединение нескольких физических или виртуальных накопителей в один большой диск с возможностью единой настройки, форматирования и управления.

- Метод зеркалирования — способ повысить надежность хранения информации через создание копии исходного диска на другом носителе, входящем в массив.

- Дуплекс — один из методов зеркалирования, в котором используется вдвое большее количество накопителей для создания копий.

- Чередование — увеличение производительности диска, благодаря блочной разбивке данных при записи.

- Четность — технология, сочетающая в себе чередование и зеркалирование.

Типы RAID-массивов

- Программный (software RAID) — самый бюджетный и распространенный вариант. Дисковые массивы создаются в самой операционной системе посредством специальных утилит. Обработкой данных занимается центральный процессор. Основной недостаток — зависимость от предустановленной системы, которая приводит к существенному понижению быстродействия и безопасности хранения информации.

- Аппаратный (hardware RAID) — создается на основе отдельного устройства (RAID-контроллера), которое имеет собственные специализированный микропроцессор и кеш-память. При этом нагрузка на микропроцессор практически отсутствует. Это наиболее затратный метод реализации, характеризующийся надежностью, высокой скоростью записи и чтения.

- Интегрированный аппаратный (fake RAID, RAID-on-Chip) — комбинация программного и аппаратного способов. Реализована в виде дополнительного микрочипа, который встраивается в материнскую плату и работает совместно с центральным процессором. Эта технология быстрее программной, но не отличается надежностью хранения информации.

Классификация RAID по уровням

Основные отличия между конфигурациями или уровнями RAID заключаются в методах формирования и размещения данных, а также в алгоритмах распределения информации на носителях. Базовые типы RAID-массивов — RAID 0 и RAID 1. Остальные уровни считаются их производными, сочетающими в себе достоинства той или иной базовой модели.

RAID 0

Технология виртуализации RAID 0 называется striping («чередование»). Для ее реализации применяется от 2 до 4 накопителей, которые совместно выполняют процедуру «чтения/записи».

При записи информация разделяется на блоки, которые одновременно сохраняются на накопители. Первый блок — на один, второй — на другой жесткий диск и так далее. Производительность массива возрастает прямо пропорционально количеству накопителей в системе. То есть, 4 диска будут работать в 2 раза быстрее, чем два.

Однако, такая конфигурация RAID-массива чревата потерей данных, что уменьшает безопасность хранения информации. Это объясняется структурой каждого файла. Последний состоит из определенной последовательности блоков (байт), поскольку каждый из них записывается на разные диски и происходит «нарушение» его целостности. Если один накопитель выходит из строя, то блок «теряется». При этом получается «битый» файл, который практически невозможно восстановить.

Достоинства

- Дисковый RAID-массив уровня 0 обеспечивает ощутимый прирост скорости, который прямо пропорционально зависит от кратности количества накопителей.

- Использование всего дискового объема, т. е. при установке четырех дисков по 2 ТБ общий объем RAID-массива будет равен 2*4=8 ТБ.

Недостатки

- Нарушение отказоустойчивости. Иногда возможен отказ в операциях чтения или записи.

- При выходе из строя одного накопителя информация полностью теряется.

Использование

Применяется в приложениях для скоростного обмена информацией, в хранилищах временных файлов. Также RAID 0 нужен для систем, использующих некритичные по важности массивы данных.

RAID 1

Технология RAID 1 называется мirroring («зеркалирование»). Она подразумевает использование от 2 до 4 накопителей. Однако при этом теряется половина объема дисков, поскольку это пространство используется резервированием данных.

Простыми словами, если RAID-система состоит из 2 жестких дисков, то при выходе одного из них информация не потеряется полностью, поскольку один накопитель является точной копией другого.

Достоинства

- Надежность хранения информации.

- Простота реализации.

- Высокая производительность при выполнении операции чтения.

- Минимальная комплектация составляет всего 2 жестких диска.

Недостатки

- Низкая производительность.

- Емкость RAID-массива делится на 2, что обусловлено резервированием информации.

- Замена неисправного накопителя требует полное отключение системы.

Использование

Уровень RAID 1 необходимо применять для увеличения надежности хранения информации на серверах.

RAID 5

Технология RAID 5 («чередование с чётностью») считается наиболее распространенной и безопасной. Для подобной конфигурации необходимо минимум 3 диска, а максимальное допустимое количество — 16.

При записи информации происходит разделение на блоки данных, но с одним условием — на один из дисков, называемый блок «чётность данных» (Parity Drive, PD), происходит запись информации для восстановления. Этот подход позволяет спасти данные при повреждении одного из накопителей.

RAID 5 может реализовываться программным методом при помощи специальных утилит, но IT-специалисты рекомендуют все же отдать предпочтение аппаратному способу.

Достоинства

- Увеличена скорость чтения за счет одновременной обработки данных с нескольких независимых потоков от дисков массива.

- Информация не «потеряется» при повреждении одного накопителя.

- При замене неисправного диска происходит автоматическое восстановление информации.

Недостатки

- Иногда происходят отказы дисков.

- Если объем поврежденного накопителя 4 ТБ и более, при замене его на идентичный диск, восстановление может занять более одного дня.

- Если диск «чётности» вышел из строя при выполнении процедуры восстановления, то информация будет окончательно утеряна.

- Минимальное количество накопителей — 3.

Использование

Технология виртуализации 5 уровня (RAID 5) прекрасно подойдет для безопасного хранения данных, но при этом не будет утрачена производительность. Очень часто ее используют файловые серверы.

RAID 6

Технология виртуализации 6 уровня («чередование с двойной чётностью») похожа на RAID 5. Отличие состоит в записи информации для восстановления на два диска. Первый — блок «чётность данных» (PD) используются в архитектуре RAID 5 для резервного хранения данных. Второй диск «чётности» дублирует работу первого. Его работа основана на коде Рида-Соломона (Reed-Solomon), поэтому диск часто имеет краткое обозначение — RS или Q.

Благодаря использованию принципа двойной чётности, система может перенести без потерь информации отказ сразу двух жестких дисков. Однако для создания RAID 6 потребуется минимум четыре накопителя.

Достоинства

- Высокая скорость считывания и записи данных.

- Поддержка двух, одновременно вышедших из строя накопителей.

Недостатки

- Время на операцию записи на 20% больше, чем для RAID 5.

- Минимальная вероятность отказа дисков.

- Восстановление после сбоя занимает много времени.

- Для реализации необходимо 4 накопителя.

Использование

RAID 6 является более надежной конфигурацией, чем RAID пятого уровня. Она часто применяется на файловых серверах, где используются большие объемы данных.

RAID 10

Технология виртуализации 10 — «гибрид» RAID нулевого и первого уровней, сочетающая в себе все их преимущества.

Достоинства

- Высокая скорость восстановления данных.

- Высокая надежность.

- Быстродействие.

Недостатки

- Дороговизна реализации.

- Емкость, уходящая на зеркалирование, эквивалентна 50 % от всего объема дисков.

Использование

Гибридная технология RAID 10 используется в тех же случаях, что и RAID 0 и RAID 1.

Утилиты для создания

В операционной системе Windows есть встроенная утилита для создания RAID. Однако она поддерживает только RAID-массивы первого. Поэтому для более сложных операций, а также для платформ на базе Unix/Linux требуется установка стороннего ПО.

Перед выбором соответствующей конфигурации RAID-массива, специалисты рекомендуют сохранить информацию на отдельный носитель. При создании или удалении RAID-системы данные на дисках уничтожаются.

Mdadm

Для операционных систем на основе Linux рекомендуется использовать штатную утилиту «mdadm», которую необходимо предварительно установить через терминал.

Основные возможности

- Создание и сброс RAID-массивов.

- Монтирование файловых систем.

- Сохранение топологии массива.

- Удаление отдельных элементов из RAID.

Установка

Для инсталляции утилиты требуется ввести в терминале следующие команды:

При этом в систему будет инсталлирована утилита, а также необходимый набор библиотек.

MegaRAID Storage Manager (MSM)

Бесплатное приложение от Microsoft, разработанное с целью обеспечения гибкого управления RAID-системами в ОС Windows.

Основные возможности

- Просмотр состояния RAID-контроллера.

- Создание RAID-массивов различных уровней.

- Удаление элементов из массива.

- Графический интерфейс.

- Монтирование файловых систем.

Установка

Заключение

Использование RAID-массивов позволяет реализовать повышенние потенциала нескольких дисковых накопителей за счет их объединения. В частности, растет производительность и надежность хранения информации. Однако эффективность работы массива будет сильно зависеть от того, каким способом он создан. Оптимальным является аппаратный метод на базе отдельного RAID-контроллера, но его организация потребует больших финансовых вложений.

Помимо способа реализации для работы RAID важна конфигурация массивов, которая делится на несколько базовых уровней. Оптимальным уровнем считается RAID-10, поскольку он обеспечивает не только высокую скорость обработки данных, но и их сохранность.

Виртуальный сервер от Eternalhost — надежная площадка для современного веб-ресурса! Быстрые NVMe диски, реальная защита от DDoS, техподдержка 24/7.

Читайте также: