Spark не передает файлы

Обновлено: 06.07.2024

Spark

версия: 2.11.1

Последнее обновление программы в шапке: 04.11.2021

Краткое описание:

Spark – это больше, чем просто почтовый клиент. В нем умело совмещены интуитивный дизайн и механизм, продуманный до мелочей.

"Spark помогает разобрать загруженный письмами ящик за несколько секунд." – The Verge

Контроль над собственным ящиком

Умная сортировка писем и умные уведомления – лучшие инструменты для работы с персональной почтой. С таким помощником достичь Inbox Zero будет несложно!

Умные уведомления

Включите Умные уведомления, и почта будет отвлекать вас только по действительно важным вопросам от реальных людей.

Email Суперсила

Незаменимые инструменты в Spark подарят вам Email Суперсилу, с которой вы сможете разгрести завалы из писем за считанные секунды:

Свайп вправо, свайп влево

Все ваши подписи запоминаются программой автоматически. А для быстрого выбора нужной подписи вам достаточно свайпнуть влево или вправо.

Стильный дизайн

Мы много работали над тем, чтобы Spark одинаково классно выглядел на всех ваших устройствах. И чтобы фокус всегда был на тексте письма. И чтобы пользоваться приложением было не только удобно, но и приятно. Попробуйте!

КОМАНДНАЯ РАБОТА С ПОЧТОЙ

Комментируйте письма

Приглашайте сотрудников к обсуждению отдельных писем в виде приватного чата-переписки. Обменивайтесь комментариями для эффективного взаимодействия друг с другом.

Пишите письма вместе

В режиме реального времени редактируйте и создавайте письма вместе с друзьями и коллегами.

Обменивайтесь ссылками на письма

Создавайте защищенные ссылки на отдельные письма и целые переписки. Обменивайтесь ими в Slack, Skype, CRM и других корпоративных сервисах для удобного сотрудничества с коллегами и партнерами.

Требуется Android: 7.0+

Для ранних версий 6.0+

Русский интерфейс: Да

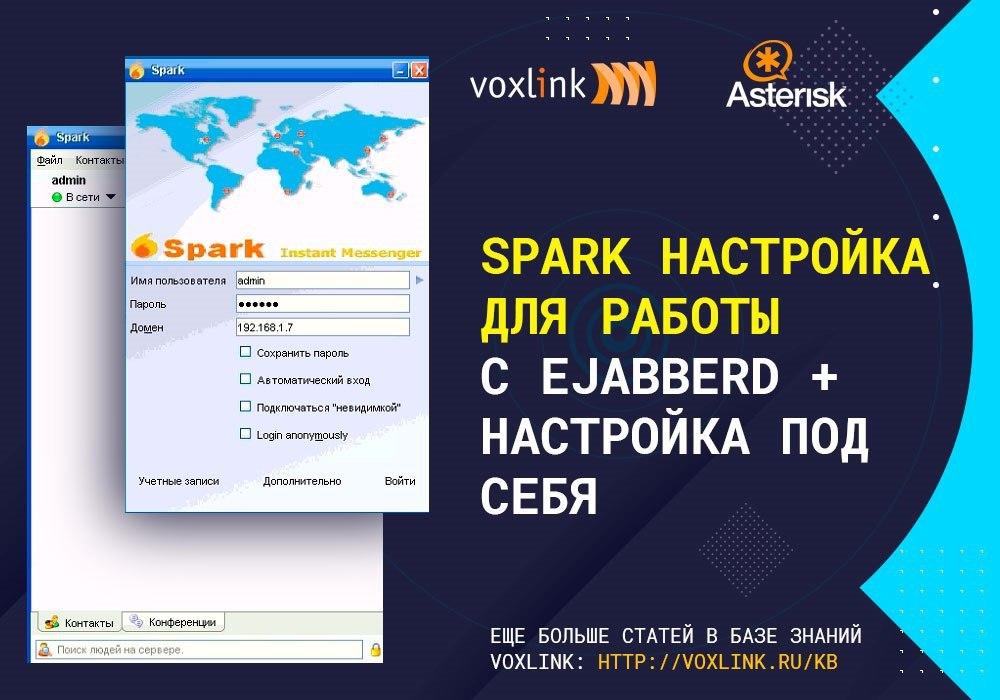

В данной статье мы рассмотрим настройку jabber клиента Spark Spark данный мессенджер был известен под названием Jive Communicator, он был разработан Jive Software. Позже, разработчики открыли код Spark и передали сообществу Ignite Realtime, наряду с Openfire, для дальнейшего совершенствования и развития. Данный мессенджер отличается следующими особенностями: Легкий графический интерфейс; Распространяется как СПО (Свободное Программное Обеспечение); […]

В данной статье мы рассмотрим настройку jabber клиента Spark

Spark данный мессенджер был известен под названием Jive Communicator, он был разработан Jive Software. Позже, разработчики открыли код Spark и передали сообществу Ignite Realtime, наряду с Openfire, для дальнейшего совершенствования и развития. Данный мессенджер отличается следующими особенностями:

Перед тем как приступить к настройке:

Как можете видеть, мессенджер поддерживает кроме windows еще и GNU/Linux и MacOS. Однако, настройка в данной статье будет проводиться на ОС Windows 7, версия Spark 2.8.3. Выбираем подходящую нам платформу, разрядность, устанавливаем и запускаем. Установка этого приложения не должно вызвать каких-то проблем

Разве что стоит обратить внимание на наличие требования у программы к установленной Java. К счастью разработчики настроили установочный пакет, который включает в себя все, что необходимо и советуем выбрать в качестве установщика bundledJRE

Если вы все сделали правильно, то сейчас jabber-клиент должен был подтянуть группу «Support» с пользователями и вы можете начать общение с кем-то из них

Настройка под «себя»:

Spark это открытое ПО и никто нам не помешает его немного донастроить под свои нужды.

Для начала найдите в каталоге, в которой вы установили программу файл sprk.jar (По умолчанию C:/Program Files/Spark/lib/spark.jar ). Открыть можно любым архиватором (7zip, winrar и.т.д), далее любым текстовым редактором открываем «spark.jar/org/jivesoftware/resource/default.properties»

Учитывайте, что файл «spark.jar» перезаписывается после каждой переустановки или обновления SparkДалее по пунктам:

Окно входа:

- MAIN_IMAGE = Опция отвечающая за стартовое изображение. Размер изображения фиксирован и должен составлять 244 на 188 пикселя

- APPLICATION_NAME = Стартовое название приложение

- HOST_NAME = Voxlink Здесь можно задать имя сервера по умолчанию

- HOST_NAME_CHANGE_DISABLED = Если в этой опции установить значение «true» то пользователи потеряют возможность изменить имя сервера

Прокси:

Работа с файлами:

Контакты:

- ADD_CONTACT_DISABLED = Значение «true» отключает возможностьдобавление контактов

- ADD_CONTACT_GROUP_DISABLED = Значение «true» отключает возможность добавление групп

Пароль:

Руководство и помощь:

Доступные плагины:

- NSTALL_PLUGINS_DISABLED = Значение «true» отключает возможность установки плагинов

- DEINSTALL_PLUGINS_DISABLED = Значение «true» отключает возможность удаления плагинов

- PLUGIN_BLACKLIST = Черный список плагинов. Если вы хотите запретить использование каких-то определенных плагинов, то укажите их тут через запятую, к примеру Plagin,Plagin 2,Plagin 3

- PLUGIN_BLACKLIST_CLASS = Аналогичен предыдущему пункту, но делает плагины недоступными с помощью классов. К примеру org.jivesoftware.fastpath.FastpathPlugin

Цвета и Внешний вид:

DEFAULT_LOOK_AND_FEEL = изменение внешнего вида, по-умолчанию имеет значение SubstanceBusinessBlueSteelLookAndFeel

Еще материалы по теме

PXF, Greenplum и оптимизация SQL-запросов к разным источникам данных

AVRO и JSON В Apache Kafka: краткий ликбез по реестру…

На заметку разработчику Spark-приложений: 3 ошибки PySpark и тонкости Outer…

Новое на сайте

Отзывы на Google

Курсы от инженеров и для инженеров. Всё чётко, по делу. Тренеры глубоко знают продукты, о которых читают лекции. read more

Принимал участие в обучении по курсу "KAFKA: Администрирование кластера Kafka". В целом понравилось, но хотелось бы более качественной организации работы с лабгайдами. Когда лектор выполняет лабораторную работу, не совсем удобно выполнять её параллельно - где-то отстаешь, где-то убегаешь вперед. Может будет лучше разделить на более мелкие модули. read more

Прошел Курс Администрирование кластера Hadoop. Подача материала хорошая, размеренная. Преподаватель отвечает на все вопросы, и пытается как можно прозрачней приподнести материал. read more

Обучался на программе HADM. Подача материала доступная. Порадовало соотношение теории и практики 50/50. Отзывчивый преподаватель. Однозначно рекомендую. read more

Заканчиваю прохождения курса "ADH: Администрирование кластера Arenadata Hadoop". Хочу сказать, что выстроен грамотный план обучения, где отслеживается отличное соотношение практики и теории. Преподаватель, Комисаренко Николай, обладает отличным чувством юмора, что позволило не скучать на серьезных темах, и обладает отличным навыком объяснять сложные вещи простыми словами. На курс приходил с большим числом вопросов, на все из которых получил грамотные ответы, после чего все разложилось по полочкам. read more

В декабре 2020 прошел курс "Администрирование кластера Kafka". Курс проводился удаленно. В части организации обучения придраться не к чему. Необходимую информацию прислали заранее, лабораторный стенд и портал обучения работали стабильно. Немного разочаровали лабораторные работы. На месте BigDataSchool я бы их переделал. В документах с лабами нужно сделать нормальное форматирование и нумерацию пунктов. Все пункты, необходимые для выполнения, нужно сделать в виде текста. В лабах много работ по созданию «обвязки» kafka (создание самоподписных сертификатов, развертывание MIT и т.п), которые можно сделать заранее. Это позволит студентам уделять больше времени изучению самой kafka. BigDataSchool идет навстречу и позволяет пользоваться лабораторным стендом гораздо дольше установленных часов обучения. Это очень к стати, если в течении дня Вы вынуждены отвлекаться от обучения. В целом, курс дает хорошую базу по kafka. Преподаватель хорошо подает материал, делает акценты в нужных местах, подробно отвечает на вопросы. read more

С 30 ноября по 4 декабря прошел курс "Администрирование кластера Hadoop". Учитывая, что я обладал довольно поверхностной информацией в данной теме (я CIO) - ушел с курсов просветленным. Многое стало понятным, в процессе обучения наложил знания на существующую инфраструктуру компании, в которой работаю. Рекомендую коллегам руководителям в ИТ - прокачаться на данном курсе, вы поймете куда двигаться в ближайшие 2-3 года. Админам, работающим или стремящимся в BigData- обязательно! Рекомендация - настойчиво, для тех кто "думает, что знает": перед курсом уделите время работе с командной строкой Linux! Total recall - обязательное условие. Много практической работы, и если есть затык в Linux - будете безнадежно отставать при выполнении лабораторных работ. read more

В октябре прошел курс Анализ данных с Apache Spark, это был второй раз, когда я обучался в этом месте. В целом, все хорошо, думаю что не последний. Не могу не подчеркнуть профессионализм преподавателя Королева Михаила, отвечал на поставленные вопросы, делился своим опытом. В общем, рекомендую! read more

Прошел тут курс "NIFI: Кластер Apache NiFi", вёл Комисаренко Николай. Живое и понятное обучение. Преподаватель отвечал на все вопросы от самых глупых, до самых умных и это было приятно. Так же порадовало, что преподаватель не идёт по заранее проложенным рельсам, а проходит весь путь вместе с вами, стараясь привнести, что-то новое. read more

Спасибо за обучение!

Очень крутое место, много практики, понятное объяснение заданной темы. Еще вернусь :) read more

Обучался на курсе HADM администрирование кластера Arenadata Hadoop. Интересный курс, хорошая подача. read more

Обучался на курсе по администрированию Apache Kafka. Хорошая подача материала, интересные практические задачи. Возникающие вопросы доходчиво и ясно объясняют. Остался очень доволен. read more

Был на курсе "Администрирование кластера Hadoop". Отличная подача материала. Очень много практики и технических подробностей. Подробный обзор стека технологий, платформы и инструментов. Рекомендую! read more

Учился на курсе Администрирование Hadoop. Курс вёл Николай Комиссаренко. Отлично подготовленная, продуманная, системная программа курса. Практические занятия организованы так, что у студентов есть возможность познакомиться с реальными особенностями изучаемого продукта. Отключил голову и прощёлкал лабы по книжке - здесь не работает. Преподаватель легко и развёрнуто отвечает на возникающие вопросы не только по теме предмета, но и по смежным. read more

Прошёл курс по администрированию Apache Kafka. Очень понравилась как подача материала, так и структура курса. Только вот времени маловато оказалось. не всё успел доделать, но это уже не к курсу претензии :). Практики было довольно много, и это хорошо read more

Прошёл курс "Hadoop для инженеров данных" у Николая Комиссаренко. Информация очень актуальна и полезна, заставляет задуматься о текущих методах работы с большими данными в нашей компании и, возможно, что-то поменять. Занятия с большим количеством практики, поэтому материал хорошо усваивается. Отдельное спасибо Николаю за то, что некоторые вещи объяснял простым языком, понятным даже для "чайников" в области Hadoop. read more

I did not find any disadvantages in the course. Pluses: + A lot of practice (50% of the time). + The teacher can explain difficult topics easy way. + Announced topics were considered. Besides additional materials were studied. read more

Посетил курс администрирование Hadoop. На курсе устанавливали кластер с нуля на виртуалках в облаке Amazon. Настраивали Kerberos, тестировали выполнение задач на кластере, управление ресурсами кластера. Т.к. кластер развернут в облаке, после завершения занятий можно самостоятельно работать с кластером из дома. Лекции вел Николай Комиссаренко, после обучения предоставил все материалы. На занятиях отвечал на дополнительные вопросы, рассмотрели как решить пару живых задач от студентов. Хороший курс для начала изучения BigData. Update Дополнительно прошел обучения по Airflow и NiFi. Курсы двух дневные упор на занятиях делался на использовании продуктов, администрированию уделялось меньше времени. Т.к. курсы короткие, то перед занятиями желательно почитать обзорные статьи по продуктам, чтобы не терять время на базовое погружение и задавать более предметные вопросы. Перед началом занятий желательно связаться с школой и запросить что больше интересуется на обучении. Может быть предложить свои кейсы, чтобы на лабораторных отработать не только общий функционал. read more

Был на основах хадупа, все материалы описаны доступным языком. В частности хочу отметить преподавателя Николая Комисаренко, как очень квалифицированного преподавателя и специалиста. read more

Отличные курсы по "Администрированию Hadoop" и отличная организация проведения занятий, все по делу и понятно. Очень понравилось, знания получены основательные. Материал подаётся основательно. Постараюсь ещё попасть на другие курсы. read more

Курс по Isilon у Николая Комиссаренко мне тоже понравился. Грамотный и отзывчивый. Возникали вопросы по курсу он отвечал на все вопросы. Спасибо. Успехов ему read more

Посетил курс администрирование Hadoop. На курсе устанавливали кластер с нуля на виртуалках в облаке Amazon. Настраивали Kerberos, тестировали выполнение задач на кластере, управление ресурсами кластера. Т.к. кластер развернут в облаке, после завершения занятий можно самостоятельно работать с кластером из дома. Лекции вел Николай Комиссаренко, после обучения предоставил все материалы. На занятиях отвечал на дополнительные вопросы, рассмотрели как решить пару живых задач от студентов. Хороший курс для начала изучения BigData. read more

Эффективный практический курс. Прошел курс Администрирование Hadoop в октябре 2018. Хорошо наполненный материал, оптимальная длительность курса и все делалось своими руками. Местами было непросто, но преодолимо. Оправдал все ожидания, после курса появилось целостное понимание создания и работы кластера. Николай, большое спасибо read more

Прошёл курс по администрированию Hadoop Cloudera. Отличная "живая" подача материала на "простом" языке. Как плюс работа с кластером построена на платформе AWS. На курсах не скучно, рекомендую! read more

Я узнал много нового посетив курс уважаемого Николая Комиссаренко по айзелону. Очень грамотный специалист обучение было очень полезным и грамотным. Спасибо вам большое read more

Чтение и сохранение данных Spark можно отличить от двух измерений: формат файла и файловая система.

Формат файла делится на: текстовый файл, файл Json, файл CSV, файл последовательности и объектный файл;

Файловая система разделена на: локальную файловую систему, HDFS, HBASE и базу данных.

Spark легко читает и сохраняет многие форматы файлов.

Spark может его поддерживать, от неструктурированных файлов, таких как текстовые файлы, до полуструктурированных файлов, таких как формат JSON, до структурированных файлов, таких как SequenceFile.

Если каждая строка в файле JSON является записью JSON, вы можете использовать файл JSON в качестве текста

Файл для чтения, а затем используйте связанную библиотеку JSON для анализа каждой части данных JSON.

Примечание. Использование RDD для чтения файлов JSON очень сложно, а SparkSQL обеспечивает хорошую обработку

Файл JSON, поэтому большинство приложений используют SparkSQL для обработки файлов JSON.

SparkSQL обрабатывает файлы json:

Файл SequenceFile представляет собой плоскость, разработанную Hadoop для хранения двоичных пар ключ-значение

Файл (плоский файл). У Spark есть специальный интерфейс для чтения SequenceFile. В SparkContext вы можете

call sequenceFile keyClass, valueClass。

Примечание. Файл SequenceFile предназначен только для PairRDD

Файл объекта - это файл, сохраненный после сериализации объекта с использованием механизма сериализации Java. способен пройти

objectFilek,v Функция получает путь, читает объектный файл и возвращает соответствующий RDD, который также может быть вызван

Используйте saveAsObjectFile (), чтобы реализовать выходные данные объектного файла. Поскольку это сериализация, тип должен быть указан.

- Читать CSV

- Чтение данных CSV / TSV аналогично чтению данных JSON. Перед обработкой данных необходимо прочитать данные как обычный текстовый файл. Из-за отсутствия стандартов формата разные версии одной и той же библиотеки иногда обрабатывают входные данные по-разному.

- Если все поля данных вашего CSV не содержат символов новой строки, вы также можете использовать textFile () для чтения и анализа данных

- Сохранить CSV

Запись данных CSV / TSV проста и может быть ускорена путем повторного использования выходного кодера

Приведенный выше пример может быть использован только тогда, когда мы знаем все поля, которые должны быть выведены. Однако, если некоторые имена полей определяются пользовательским вводом во время выполнения, должны использоваться другие методы. Самый простой способ - обойти все данные. Извлеките разные ключи и выведите их отдельно.

Читайте также: