Сравнение фреймворков машинного обучения

Обновлено: 07.07.2024

Прежде, чем мы с вами перейдём к инструментам машинного обучения, стоит проговорить одну простую, но важную вещь. Начинающие часто воспринимают машинное обучение как огромный цельный процесс. Нередко пугаются и впадают в ступор из-за обширности темы. Поэтому начнём с разделения процесса машинного обучения на три основных этапа:

- Сбор и обработка данных.

- Обучение и оценка модели.

- Использование обученной модели.

В таком же порядке рассмотрим и инструменты, которые помогут всё это реализовать.

Языки программирования для машинного обучения

Нам понадобятся готовые библиотеки и фреймворки для машинного обучения. Мы ведь хотим научиться ездить на машине, а не конструировать её. Если вы пытаетесь подобрать «тот, самый подходящий» язык, то не переживайте: в любом современном языке программирования уже написаны такие инструменты, поэтому берите любой, который нравится (или знаете).

Но если мы начнём рассказывать обо всех языках в одной статье, то она будет очень длинной. Поэтому дальше будем рассматривать всё, что связано именно с Python, популярность которого стабильно растёт на протяжении вот уже нескольких лет благодаря своей гибкости, хорошей читаемости и простоте в обучении. Написанные под него библиотеки машинного обучения — самые популярные на момент выпуска статьи.

Инструменты для сбора, обработки и визуализации данных

Здесь мы собираем данные с различных сайтов и создаём датасет, который потом используем для обучения алгоритма. Сбор данных с сайтов ещё называют веб-скрейпингом (ранее мы подробно рассказывали об инструментах для веб-скрейпинга).

После того, как собрали данные, их нужно обработать, чтобы избавиться от ошибок, шума и несогласованностей, которые приведут к ситуации «мусор на входе — мусор на выходе». Это очень важно, так как от корректности данных будет зависеть точность результатов алгоритма.

ABBYY , Москва, можно удалённо , От 220 000 ₽

Визуализация поможет определить линейность структуры данных, существенные признаки и аномалии. Для этих задач можно воспользоваться готовыми веб-сервисами, либо написать собственный код.

После того как мы почистили наш датасет, нужно поделить его на 80% — для обучения модели, — и 20% — для её проверки и тестирования.

pandas: библиотека для обработки и анализа данных

Она построена поверх NumPy, о котором поговорим чуть дальше. Это наши группировки, сортировки, извлечения и трансформации. Для работы с файлами CSV, JSON и TSV pandas превращает их в структуру данных DataFrame со строками и столбцами. Выглядит, как обычная таблица в Excel, и работать с ней легче, чем с for-циклами для прохода по элементам списков и словарей.

Tableau, Power BI, Google Data Studio: простая онлайн-визуализация без кода

Инструменты для бизнес-аналитики и людей без особых навыков программирования. Ключевое слово здесь — визуализация. Загружаем датасет и пользуемся встроенными функциями, фильтрами и аналитикой в реальном времени. Эти сервисы быстро собирают инсайты и представляют их в наглядной форме. И Tableau, и Power BI, и Google Data Studio имеют как платные подписки, так и бесплатные версии (само собой, с ограничениями).

Matplotlib: библиотека для построения 2D-графиков

Matplotlib в связке с библиотеками seaborn, ggplot и HoloViews позволяет строить разнообразные графики: гистограммы, диаграммы рассеяния, круговые и полярные диаграммы, и много других. Для большинства из них достаточно написать всего пару строк.

Интерактивные среды разработки

Эти инструменты часто используются для Data Science и машинного обучения. Веб-среда (её также называют «notebook») позволяет разработчикам на лету тестировать небольшие части кода, проверять функциональность и разные гипотезы. Тем не менее, при желании в ней можно поместить и целый проект.

Jupyter Notebook: интерактивное моделирование

Простая в использовании бесплатная интерактивная веб-оболочка. Помимо Python, Jupyter Notebook поддерживает более чем 40 языков программирования. В нём удобно экспериментировать с новыми идеями в режиме «зашёл-сделал-вышел», писать документацию и создавать аналитические отчёты. Напоминает IDE, но по функциональности, хоть и достаточно широкому, до неё не дотягивает.

Среди инструментов для машинного обучения, и в целом Data Science, Jupyter хорош благодаря быстрому анализу, моделированию и визуализации данных. Результаты можно экспортировать во множество форматов, в числе которых — широко распространённые PDF и HTML.

Kaggle: сообщество Data Science

Kaggle также предоставляет интерактивную среду разработки. Разница в том, что всего один клик отделяет вас от целого сообщества Data Science и машинного обучения. Здесь можно найти готовые датасеты, модели и даже программный код для решения разных задач.

Также крупные коммерческие компании часто проводят здесь конкурсы и разыгрывают призовой фонд в обмен на бесплатную лицензию на использование интеллектуальной собственности (алгоритма и программного обеспечения) победившего участника.

Фреймворки и библиотеки для общего машинного обучения

Обучение модели делится на две большие категории: с учителем и без. В первом случае мы маркируем датасет, объясняя алгоритму машинного обучения, где правильный ответ, а где — нет. Так данные можно представить таблицей соответствий «элемент-категория».

Во втором случае алгоритм сам вынужден искать признаки и закономерности, так как в датасете мы даём данные без уточняющей информации. Датасет представлен сплошным потоком данных нужного типа: текста, картинок и др.

Для каждой категории используются свои алгоритмы машинного обучения (кластеризация, классификация, регрессия, ассоциация). Оптимальный выбор зависит от задачи, сложности модели, размера и типа данных.

Имейте в виду, что обучение и отладка собственной модели — долгий и затратный процесс. Очень вероятно, что кто-то уже решал похожую задачу и подготовил модель. Поэтому стоит поискать, воспользоваться реализованной архитектурой и переучить алгоритм под ваши данные. Но чем больше ваша задача отличается от той, что решает готовая модель, тем больше нужно её переучивать и менять параметры.

NumPy: готовые вычислительные алгоритмы и линейная алгебра для машинного обучения

Данные в машинном обучении представлены числовыми массивами. Даже если мы работаем с картинками или естественной речью, они должны быть преобразованы в числовые массивы. В NumPy уже реализовано всё необходимое для этого: преобразование Фурье, генерация случайных чисел, перемножение матриц и другие сложные операции. Вам остаётся только пользоваться.

NLTK: разбираем естественный язык на части

Один из ведущих инструментов для обработки естественного языка. По аналогии с тем, как NumPy упрощает линейную алгебру, NLTK упрощает парсинг текста, анализ тональности, структуры предложений и всё, что с этим связано.

scikit-learn: всё гениальное просто

Позиционируется как простая библиотека с кучей примеров на официальном сайте, из-за чего хорошо подходит новичкам. Но это не значит, что для серьёзных проектов он не годится.

Spotify, например, сделали свою рекомендательную систему как раз с помощью scikit-learn. Работает в связке с SciPy, NumPy и Matplotlib. Все базовые функции типа кластеризации, классификации и регрессии, разумеется, на месте.

Фреймворки глубокого обучения и моделирования нейросетей

Упомянутые инструменты машинного обучения позволяют нам получить модель, способную выполнять сравнительно простые задачи. Однако дальше речь пойдёт о глубоком машинном обучении нейронных сетей. Здесь для принятия более сложного решения алгоритм учитывает различные факторы, пропуская входящие данные через множество слоёв нейронов.

Само собой, для этого нужно больше вычислительной мощности и данных для обучения. Например для GPT-3 OpenAI насобирали датасет из 45 ТБ текстовых данных и отфильтровали его до 570 ГБ. Обучение модели стоило им миллионы долларов. При этом использовали они даже не весь текст. Поэтому в проектах поменьше обучение часто делегируют облачным сервисам типа Google Cloud или Amazon AWS.

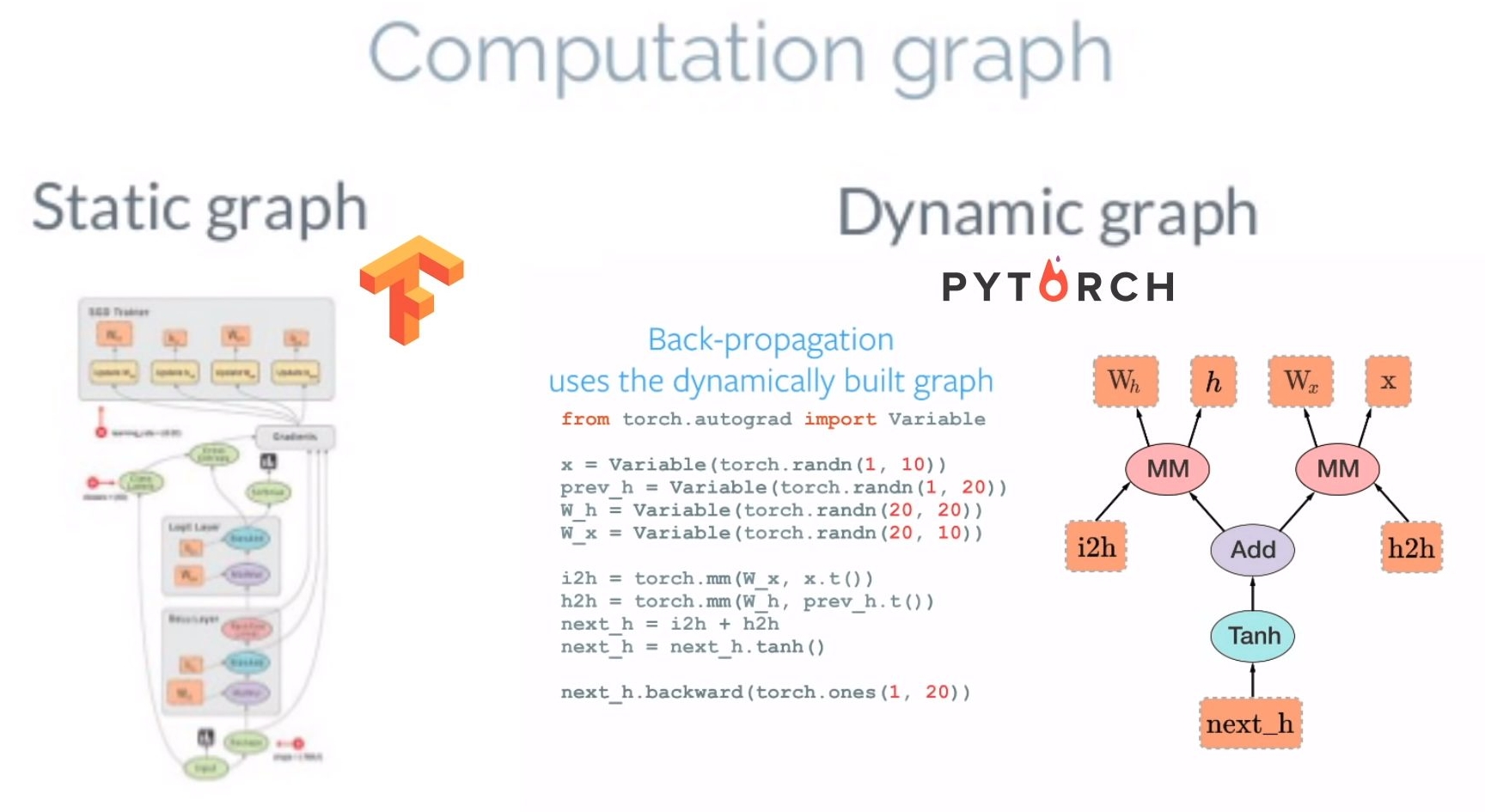

На рынке инструментов глубокого машинного обучения классическая ситуация: бодаются два мастодонта — фреймворки PyTorch и TensorFlow. Раньше в них были существенные отличия. Но разграничения постепенно стираются с тем, как они перенимают друг у друга лучшие особенности.

PyTorch: король исследований

Прост в изучении и понимании, хорошо дружит с остальной питоновской экосистемой. Поэтому к новичкам PyTorch относится мягко. Отладка проходит на интуитивном уровне: ставим брейкпоинт куда угодно в коде и смотрим значения переменных. Ещё исследователям нравятся динамические графы, благодаря которым можно менять поведение модели на ходу. Всё это позволяет проверять различные теории и подходы на небольших датасетах без долгих задержек.

TensorFlow: король продакшена

Главное отличие — в подходе. Если PyTorch правит в академической среде, то TensorFlow изначально ориентирован на рынок. Да, графы у него статические; для отладки нужно учиться работать с отдельным дебагером tfdbg; а его API меняли кучу раз, ломая при этом обратную совместимость. Но он заточен для решения задач именно бизнеса: пропускать через себя огромные массивы данных при хорошей производительности и с возможностью использовать модели на мобильных устройствах без костылей и бубнов. Хотя и PyTorch уже двигается в этом направлении.

Keras: «С++ машинного обучения»

Первое, что новичок замечает в TensorFlow — это сложность. Ведь буквально всё находится и происходит внутри графа — и операции, и числа. А значит, не так, как обычно.

Keras — более высокоуровневый интерфейс для TensorFlow, CNTK, Theano, MXNet и PlaidML. Простыми словами, он создан, чтобы стать языком «С++ машинного обучения» для низкоуровневых фреймворков. Новичок может не думать, как реализовать тензорную алгебру, построить модель и прочее. Он просто воспользуется готовыми строительными блоками. Мыслительный ресурс освобождается, из-за чего начинающие специалисты быстрее учатся, а более опытные разработчики больше концентрируются на стратегических задачах.

TensorBoard: козырь в рукаве TensorFlow

Человеку непросто держать и анализировать в голове все данные. Нативная визуализация графов в браузере с разными метриками и возможностью отслеживать работу моделей — то, чего нет у PyTorch. Конечно, можно сказать про Visdom, но по возможностям он сильно уступает TensorBoard. Поэтому в PyTorch приходится часто использовать Matplotlib для визуализации и писать графики самому.

В этом аспекте TensorFlow выигрывает. Помимо метрик, разные структуры можно окрашивать в зависимости от используемого для вычислений устройства (CPU или GPU), подсвечивать узлы для отслеживания входящих данных, отображать несколько графов одновременно. Словом, всё, чтобы мониторить работу было легко и удобно.

Какие ещё инструменты машинного обучения вы бы посоветовали? Расскажите в комментариях!

Как выбрать фреймворк глубокого обучения? Сравниваем 10 популярных сред тренировки нейросетей. Преимущества, недостатки, подводные камни.

Начнем с очевидного. TensorFlow, без сомнения, – популярнейший инструмент для обучения нейросетей. Google активно использует собственный фреймворк глубокого обучения для таких крупномасштабных сервисов как Gmail и Google Translate. TensorFlow уже применили к своим сервисам и такие значительные бренды как Uber, Airbnb, Dropbox и многие другие. Он оказал огромное влияние на разработку.

Следствием популярности фреймворка стала подробная документация, включающая не только версию на официальном сайте, но и сторонние источники. Документация описывает как структуру фреймворка TensorFlow, так и инструменты, позволяющие отследить сам процесс обучения нейросети, например, визуализация с TensorBoard.

Важно, что проект учитывает не только мощные вычислительные кластеры, но и возможность запуска моделей на мобильных платформах, как iOS и Android.

Тем не менее, TensorFlow – это низкоуровневый инструмент. Вам нужно тщательно продумывать архитектуру нейросети, правильно оценивать размерность и объемы входных и выходных данных. Таким образом, работа с TensorFlow требует написания значительного количества программного кода.

TensorFlow оперирует статическим вычислительным графом. То есть вначале мы определяем граф, далее запускаем вычисления и, если необходимо внести изменения в архитектуру, заново обучаем модель. Такой подход выбран ради эффективности, но многие современные нейросетевые инструменты умеют учитывать уточнения в процессе обучения без существенной потери скорости обучения. В этом плане основным конкурентом TensorFlow является фреймворк глубокого обучения PyTorch.

В отличие от TensorFlow, библиотека PyTorch оперирует динамически обновляемым графом. То есть позволяет вносить изменения в архитектуру в процессе работы.

Фреймворк PyTorch был разработан для сервисов Facebook, но уже используется для собственных задач такими компаниями как Twitter и Salesforce. В PyTorch можно использовать стандартные дебаггеры, например, pdb или PyCharm. Процесс тренировки нейросети прост и ясен. При этом PyTorch поддерживает модель параллелизма данных и распределенного обучения, а также содержит множество предобученных моделей.

Но в отличие от TensorFlow, описываемый фреймворк глубокого обучения гораздо менее гибок в поддержке различных платформ. Также в PyTorch нет родных инструментов для визуализации данных. Однако есть сторонний аналог, называемый tensorboardX.

В материалах конференций по искусственному интеллекту и в конкурсах Kaggle исследователи нередко отдают предпочтение PyTorch, а не TensorFlow. Связано это с тем, что PyTorch гораздо лучше подходит для небольших проектов и прототипирования. Когда же речь заходит о кросплатформенных решениях, TensorFlow выглядит более подходящим выбором. Однако стоит отметить, что для тех же задач можно использовать представленный в 2017 году мобильный фреймворк Caffe2. Ведь он умеет работать в связке с PyTorch.

Надстроенный над TensorFlow фреймворк глубокого обучения Sonnet разработан для создания нейросетей со сложной архитектурой всемирно известной компанией DeepMind.

Идея Sonnet состоит в первичном конструировании объектов Python, соответствующих определенной части нейросети. Далее эти объекты независимо подключаются к вычислительному графу TensorFlow. Разделение процессов создания объектов и связывания их с графом упрощает конструирование высокоуровневых архитектур. Подробнее об этих принципах можно прочитать в документации фреймворка.

Наиболее минималистичный подход к использованию TensorFlow, Theano или CNTK дает высокоуровневая оболочка Keras. Прототипирование здесь облегчено до предела. Создание массивных моделей глубокого обучения в Keras сведены до одностроковых функций. Но такая стратегия делает Keras менее конфигурируемой средой, чем низкоуровневые фреймворки.

Таким образом, Keras – лучший Deep Learning фреймворк для тех, кто только начинает. Идеально подходит для обучения и прототипирования простых концептов, чтобы понять самую суть различных моделей и процессов их обучения.

MXNet представляет собой фреймворк глубокого обучения, разрабатываемый компанией Amazon. Фреймворк исходно поддерживает большое количество языков (C++, Python, R, Julia, JavaScript, Scala, Go и даже Perl). Основной акцент сделан на том, что фреймворк очень эффективно параллелится на множестве GPU и многих машинах. Это, в частности, продемонстрировано и его работой на Amazon Web Services.

Специфика проекта Gluon – гибкий интерфейс, упрощающий создание прототипов, построение и обучение моделей глубокого обучения без ущерба для скорости обучения. Gluon базируется на MXNet и предлагает простое API, упрощающее создание моделей глубокого обучения. Аналогично PyTorch, фреймворк Gluon поддерживает работу с динамическим графом, сочетая это с высокой производительностью MXNet. В этом ракурсе Gluon выглядит крайне интересной альтернативой Keras для распределенных вычислений.

Как вы могли заметить, все мировые гиганты IT находятся в гонке за глубокое обучение. Исключением не стала и компания Microsoft.

Chainer – фреймворк глубокого обучения, созданный японским стартапом и поддерживаемый IBM, Intel, Microsoft и Nvidia. Код написан на чистом Python поверх библиотек Numpy и CuPy. Chainer – первый фреймворк, который стал оперировать динамической моделью архитектуры (как в PyTorch). Кроме того, Chainer несколько раз бил рекорды по эффективности масштабирования при моделировании задач, решаемых нейронными сетями.

Тем, кто на короткой ноге с Java или Scala, стоит обратить внимание на DL4J (сокращение от Deep Learning for Java). Обучение нейросетей в DL4J осуществляется параллельно по итерациям через кластеры. Процесс поддерживается архитектурами Hadoop и Spark. Использование Java позволяет применять библиотеку в цикле разработке программ для Android-устройств. Заметим, что разработчикам под iOS стоит обратить внимание на фреймворк Core ML.

Проект ONNX родился в результате сотрудничества Microsoft и Facebook как поиск открытого формата для представления моделей глубокого обучения. ONNX упрощает процесс переноса моделей между различными средствами работы с искусственным интеллектом. Таким образом, ONNX позволяет сочтать преимущества различных Deep Learning фреймворков.

Подведем итог. При выборе фреймворка обратите внимание на таблицу сравнения различных фреймворков и библиотек. Если вы только начинаете и хотите разобраться, что к чему, лучший выбор – Keras. В исследовательских целях наиболее востребован PyTorch. Для продакшена нужно ориентироваться на среду. Так, для Google Cloud лучший выбор – это TensorFlow, для AWS – MXNet и Gluon, для Microsoft Azure – CNTK. Разработчикам под Android стоит обратить внимание на D4LJ, для iOS подобный круг задач решает Core ML. Наконец, в вопросах взаимодействия между различными фреймворками поможет ONNX.

Материал подготовили эксперты компании Hey Machine Learning.

Машинное обучение и искусственный интеллект определённо являются технологическим прорывом. Приложения для подстановки лиц и их состаривания. Голосовые помощники, способные забронировать столик или заказать билет.

Решения, распознающие мерцательную аритмию и сердечный приступ. И это лишь то, что произошло буквально недавно. Популярность ИИ-технологий растёт, а значит, растёт и спрос на них. Это приводит к увеличению всего сообщества разработчиков и к появлению фреймворков ИИ, упрощающих обучение и работу.

Давайте разберёмся, что такое фреймворк. Фреймворк — это набор инструментов и стандартных реализаций для обеспечения более быстрой разработки какого-либо программного продукта. Его часто путают с библиотекой, которая же, в свою очередь, является набором стандартных реализаций, функций и структур данных, облегчающих решение какой-либо задачи.

Если перейти во вселенную метафор, то фреймворк — это как мастерская, в которой вы можете сесть и, например, собрать автомобиль или стул. Тогда с этой точки зрения библиотека — молоток.

Мы в Hey Machine Learning работаем с ИИ-фреймворками ежедневно, поэтому решили написать для вас статью о десяти самых известных из них. На основе собственного использования выделили их положительные и отрицательные стороны, а также добавили информацию о самом эффективном их применении. В первую часть обзора вошли Tensorflow, PyTorch, Keras, Darknet и XGBoost.

Статистика по фреймворкам с официальных аккаунтов на GitHubTensorFlow — это комплексная платформа для машинного обучения с открытым исходным кодом. Она была разработана командой Google Brain как продолжение закрытой системы машинного обучения DistBelief, однако в ноябре 2015 года компания передумала и открыла фреймворк для свободного доступа.

Как и большинство фреймворков глубокого обучения, TensorFlow имеет API на Python поверх механизма C и C ++, что ускоряет его работу.

TensorFlow имеет гибкую экосистему инструментов, библиотек и ресурсов сообщества. Это позволяет исследователям использовать самые современные МО-технологии, а разработчикам — создавать и развёртывать приложения на базе машинного обучения.

Платформа предоставляет интуитивно понятные высокоуровневые API-интерфейсы, например Keras, с быстрым выполнением, что обеспечивает немедленную итерацию модели и простую отладку. За счёт мультиплатформенности решение позволяет обучать и разворачивать модели в облаке и локально, независимо от используемого пользователем языка.

Если вам необходимо запустить модель машинного обучения на смартфоне или IoT-устройстве, то вам пригодится среда глубокого обучения с открытым исходным кодом TensorFlow Lite. Когда нужно создать и обучить МО-модель на JavaScript, а после развернуть её в браузере или на Node.js, то можно воспользоваться библиотекой TensorFlow.js.

Стоит отметить, что фреймворк постоянно развивается за счёт открытого исходного кода и огромного сообщества энтузиастов. Также за счёт его популярности есть множество уже решённых задач, что существенно упрощает жизнь новоиспечённым разработчикам.

Однако фреймворк не лишён недостатков. Компания Google известна своей любовью к созданию собственных стандартов, что коснулось и фреймворка. Например, если во время работы с TensorFlow в коде вылетает ошибка, то фреймворк не покажет пользователю конкретную строчку, спровоцировавшую её.

Почему так? Это связано с особенностью API TensorFlow, где все операции выполняются через класс tf.Session. В программировании есть две основные парадигмы — императивная и декларативная. В TensorFlow используется второй подход.

Рассмотрим очень грубый пример:

Если думаете, что c = 6, то спешу вас огорчить. На самом деле оно равно:

Это значит, что из-за декларативного подхода, вы не умножаете 2 * 3, а объявляете операцию, которая умножает 2 * 3.

Чтоб получить 6, необходимо выполнить операцию умножения чисел через сессию:

Теперь рассмотрим пример посложнее: сделаем вход не константным и будем использовать поэлементное умножение матриц.

Возьмём матрицы разных размеров, что должно привести к ошибке, потому что нельзя поэлементно умножить две матрицы разной формы.

Теперь даём на вход вектор из двух элементов и из трёх.

validArgumentError (see above for traceback): Incompatible shapes: [2] vs. [3] [[node mul_3 (defined at <ipython-input-66-0b219961c4c2>:4) = Mul[T=DT_FLOAT, _device="/job:localhost/replica:0/task:0/device:GPU:0"](_arg_Placeholder_3_0_0/_7, _arg_Placeholder_4_0_1/_9)]] [[<Всё потому, что ошибка — внутри сессии.

Конечно, есть способы обезопасить себя от подобного, однако, например, в PyTorch такое вообще не возможно.

Ещё одна проблема TensorFlow, которую следует выделить, — фреймворк всегда забирает всю видеопамять. Если вы хотите его ограничить, то необходимо создавать файл конфигурации и явно указывать, что можно брать. Также фреймворк можно ограничить напрямую, например, позволить взять не больше 50% видеопамяти.

Из-за подобного поведения с памятью могут возникнуть проблемы в работе. Предположим, что в одном проекте множество различных моделей, одни из которых написаны на PyTorch, а другие — на TensorFlow. Если изначально мы создадим TensorFlow-модель и не ограничим её, то она использует всю видеопамять при том, что ей необходимо всего 0,5 ГБ, и в итоге на PyTorch-модели попросту не хватит места.

- Отличный фреймворк для создания нейронных сетей, которые будут работать в продакшене.

- Берёт на себя оптимизацию ресурсов для вычислений.

- Огромное комьюнити.

- За счёт популярности выше вероятность, что проблему, подобную вашей, уже решили.

- Сложен в использовании и освоении.

- Недружелюбный.

- Необходимо постоянно контролировать используемую видеопамять.

- Имеет свои стандарты.

- Плохая документация.

- У вас всегда есть пять способов решить задачу, но три из них deprecated, один не работает, а тот, который работает, — не задокументирован.

Проекты, которые используют фреймворк TensorFlow:

-

— система распознавания речи. — модель, которая генерирует ограничительные рамки и маски сегментации для каждого объекта на изображении. — предобученная нейронная сеть, используемая для решения задач обработки естественного языка.

PyTorch — это среда машинного обучения на языке Python с открытым исходным кодом, обеспечивающая тензорные вычисления с GPU-ускорением. Она была разработана компанией Facebook и представлена в октябре 2016 года, а открыта для сторонних разработчиков — в январе 2017 года. Фреймворк подходит для быстрого прототипирования в исследованиях, а также для любителей и небольших проектов.

Фреймворк предлагает динамические графы вычислений, которые позволяют обрабатывать ввод и вывод переменной длины, что полезно, например, при работе с рекуррентными нейронными сетями. Если коротко, то за счёт этого инженеры и исследователи могут менять поведение сети «налету».

За счёт глубокой интеграции фреймворка с кодом C++ разработчики могут программировать на C и C++ с помощью API-расширения на основе FFI для Python.

В отличие от TensorFlow, PyTorch менее гибок в поддержке различных платформ. Также в нём нет родных инструментов для визуализации данных, но есть сторонний аналог, называемый tensorboardX.

Однако, снова же, в отличие от TensorFlow, если при работе с PyTorch вылетает ошибка, то это конкретная недоработка в коде и система выделит вам именно ту строчку, которая её спровоцировала.

Также при развёртке сетей на GPU PyTorch самостоятельно займёт только необходимую видеопамять.

- Имеет множество модульных элементов, которые легко комбинировать.

- Легко писать собственные типы слоев и работать на GPU.

- Имеет широкий выбор предварительно обученных моделей.

- Вам придётся самостоятельно писать тренировочный код.

- Плохая документация, то и дело будут попадаться функции и методы, документация которых существует исключительно на форумах сообщества и получена эмпирическим путём.

Проекты, которые используют фреймворк PyTorch:

-

— библиотека для обработки устной и письменной речи. — генеративная нейросеть для подмены деталей и свойств видеопотока. — алгоритм, который превращает пользовательские наброски в фотографии.

Keras — открытая среда глубокого обучения, написанная на Python. Она была разработана инженером из Google Франсуа Шолле и представлена в марте 2015 года.

Фреймворк нацелен на оперативную работу с нейросетями и является компактным, модульным и расширяемым. Подходит для небольших проектов, так как создать что-то масштабное на нём сложно и он явно будет проигрывать в производительности нейросетей тому же TensorFlow.

Keras работает поверх TensorFlow, CNTK и Theano и предоставляет интуитивно понятный API, который, по мнению наших инженеров, пока что является лучшим в своём роде.

Фреймворк содержит многочисленные реализации широко применяемых строительных блоков нейронных сетей, таких как слои, целевые и передаточные функции, оптимизаторы, а также множество инструментов для упрощения работы с изображениями и текстом.

Deeplearning4j использует Keras в качестве своего Python API и позволяет импортировать модели из Keras, а также через Keras из Theano и TensorFlow.

- Удобен в использовании.

- Лёгок в освоении.

- Быстроразвивающийся фреймворк.

- Хорошая документация.

- Встроен в TF.

Проекты, которые используют фреймворк Keras:

-

— модель, которая генерирует ограничительные рамки и маски сегментации для каждого объекта на изображении — алгоритм для распознавания лиц в режиме реального времени и классификации эмоций и пола. — нейронная сеть для обнаружения объектов в режиме реального времени.

Darknet — это фреймворк с открытым исходным кодом, написанный на языке C с использованием программно-аппаратной архитектуры параллельных вычислений CUDA. Он быстрый, лёгкий и удобный в использовании. Также Darknet поддерживает вычисления на базе CPU и GPU.

Обученные веса Darknet хранит в формате, который может быть распознан с помощью разных методов на различных платформах. Однако это может стать проблемой, если вы решите натренировать модель на одном сверхмощном оборудовании, а затем использовать её на другом.

Так как фреймворк написан на C и не имеет другого API, то в случае, когда требования платформы или собственные предпочтения заставят обратиться к другому языку программирования, вам придётся дополнительно заморочиться над его интеграцией. К тому же он распространяется только в формате исходного кода, и процесс компиляции на некоторых платформах может быть несколько проблематичным.

Фреймворк не рекомендуется использовать для сложных проектов, разве что вам необходимо создать сверхбыстрый детектор объектов.

- Кроме задач с обнаружением больше нигде не используется.

- Не рекомендуется для больших проектов.

- Плохая документация.

Проекты, которые используют фреймворк Darknet:

-

— нейронная сеть для обнаружения объектов в режиме реального времени. — компактная нейронная сеть для обнаружения объектов.

XGBoost — это фреймворк с открытым исходным кодом, который предлагает систему градиентного бустинга для C++, Java, Python, R, Julia. Он разработан для обеспечения высокой эффективности, гибкости и портативности.

Этот фреймворк относится не к глубокому обучению, как все вышепредставленные, а к классическому.

Изначально это был исследовательский проект Тяньцзи Чена и Карлоса Гестрина в составе Distributed [Deep] Machine Learning Community, но позже он был расширен и представлен публике на конференции SIGKDD в 2016 году, где произвёл фурор.

После своей презентации фреймворк лидировал в соревнованиях Kaggle и до сих пор остаётся фаворитом для решения большинства задач на платформе.

XGBoost фокусируется на скорости вычислений и производительности модели и подходит для решения задач регрессии, классификации и упорядочивания. Если данные можно представить в виде таблицы, то точность и производительность будут существенно выше, чем у DeepLearning-решений. Любимый инструмент Data Scientist-ов.

Фреймворк совместим с операционными системами Windows, Linux и OS X, а также поддерживает кластеры AWS, Azure и Yarn, хорошо работает с Flink, Spark.

- Очень быстрый и удобный инструмент для тренировки моделей типа «дерево решений».

- Точный.

- Отлично подходит для проверки гипотез.

Так всё же, какой фреймворк к какой задаче лучше всего применить?

TensorFlow хорош для продвинутых проектов, таких как создание многослойных нейронных сетей. Может использоваться для распознавания речи, лиц, объектов и изображений, а также для работы с текстом.

PyTorch подойдёт в случае, когда вам необходимо обучить модели быстро и эффективно. Удобный для быстрого прототипирования в исследованиях, а также для любителей и небольших проектов.

Keras подходит для быстрого прототипирования. Хорош в кейсах, связанных с переводом, распознаванием изображений и речи.

Darknet подходит для небольших проектов. Хорошо работает в задачах обнаружения.

XGBoost может использоваться для решения задач регрессии, классификации, упорядочивания и пользовательских задач на предсказание.

Мы надеемся, что наша статья о топ-10 фреймворках для искусственного интеллекта расскажет вам что-то новое и полезное, а также поможет подобрать наиболее подходящее решение для вашего проекта.

Поверхностно, keras это надстройка над tf. А не отдельный фреймворк. Это как jquery для js.

только js это не фреймворк

Полностью согласен. Тока хотел тоже самое написать:)

Теоретически вы правы, однако на практике дела обстоят немного иначе.

Термин «фреймворк» является достаточно расплывчатым и может означать много разных вещей в зависимости от контекста. Фреймворком может называться всё, что используется при разработке приложений: библиотека, набор из множества библиотек, набор сценариев или любое программное обеспечение, необходимое для создания приложения.

Например, в Mac OS X фреймворк - это просто библиотеки, упакованные в пакет.

Keras действительно является надстройкой и, кстати, не толькоTensorFlow, но и CNTK и Theano. Он может считаться фреймворком, так как используется для создания полноценных решений типа Mask R-CNN и face_classification.

Также, когда дело касается решения задач распознавания изображений и машинного перевода, Keras всегда рассматривают как альтернативу TensorFlow и PyTorch, так как он удобен в использовании, лёгок в освоении и имеет хорошую документацию.

Всем привет! Меня зовут Дмитрий, я занимаюсь разработкой в области компьютерного зрения в команде MTS AI. Так исторически сложилось, что в своей работе я использую, как правило, связку устаревшей версии TensorFlow 1 и Keras. Пришло время двигаться дальше, но прежде чем полностью перейти на TensorFlow 2, я решил сравнить наиболее популярные на сегодня фреймворки глубокого обучения: TensorFlow и PyTorch. Эта статья будет полезна всем Data Scientist'ам, кто желает узнать чуть больше про особенности и производительность TensorFlow и PyTorch.

TensorFlow и Keras

TensorFlow был впервые представлен компанией Google в ноябре 2015 года. Он появился на основе собственного решения Google для задач машинного обучения. Название фреймворка отражает суть его работы: данные представляются в виде тензоров, а при выполнении операций с ними формируется граф потока данных (граф вычислений), в котором отслеживается изменение данных и поддерживается автоматическое дифференцирование. В первой версии TensorFlow граф вычислений был статическим.

Версия TensorFlow 2.x была представлена в сентябре 2019, её главным отличием от первой версии был переход от статического к динамическому графу вычислений. При этом сохранилась поддержка статического графа вычислений:

Keras первоначально представлял собой высокоуровневый фреймворк глубокого обучения, основанный на базе TensorFlow, Theano и CNTK. Keras был создан одним из разработчиков Google,а название является отсылкой к Одиссее. Keras был интегрирован в TensorFlow, начиная с версии 1.4.0, а в TensorFlow 2.х уже полностью интегрирован: рекомендуется использовать только tf.keras . Самостоятельная версия Keras с поддержкой нескольких фреймворков прекратила своё развитие, так как Theano и CNTK на данный момент также не развиваются.

TensorFlow предоставляет несколько полезных для разработки API: TensorFlow Lite позволяет легко оптимизировать и подготовить обученные модели для запуска на различных мобильных устройствахи устройствах IoT; TensorFlow.js позволяет использовать JavaScript для обучения моделей и запуска обученных моделей; TensorFlow Extended предоставляет множество компонентов, в том числе REST API, для реализации пайплайнов машинного обучения в готовых продуктах.

PyTorch

PyTorch был впервые представлен компанией Facebook в октябре 2016 года. PyTorch основан на Torch – Matlab-подобной библиотеки для Lua, поддержка которой практически прекратилась в 2017 году. PyTorch также поддерживает автоматическое дифференцирование и использует динамический граф вычислений.

PyTorch достаточно удобен и прост: работа с тензорами очень похожа на работу с numpy arrays, что в совокупности с динамическим графом вычислений облегчает разработку и дебагинг.

Статический и динамический графы вычислений

При использовании статического графа вычислений программа работает следующим образом. Код, описывающий различные операции с тензорами, выполняется только один раз, в результате чего формируется статический граф вычислений (объект tf.Graph() в TensorFlow 1.x). Чтобы получить результаты вычисления графа, необходимо подать данные в граф и запустить вычисления для необходимых тензоров:

При использовании динамического графа вычисления происходят сразу при определении операций:

Таким образом, динамический граф вычислений является более удобным:

вычисления выполняются сразу при определении операций;

результаты вычислений доступны на любом шаге;

более лёгкая и гибкая разработка, упрощённый дебагинг.

Сравнение производительности TensorFlow и PyTorch

При использовании различных версий TensorFlow и PyTorch я неоднократно замечал различия в производительности, однако в гугле я практическине нашел подробной информации с числами. Из наиболее интересных данных, здесь автор вопроса сравнивал скорость обучения при использовании TensorFlow 1.х и TensorFlow 2.х., а в этой статье 2017 года представлено сравнение производительности нескольких фреймворков глубокого обучения, однако на сегодня она уже является устаревшей.

Мне, как активному пользователю этих фреймворков, наиболее интересно сравнить скорость обучения (на GPU), скорость инференса (на GPU и на CPU), а также количество выделяемой видеопамяти при обучении и инференсе.

Обучение и инференс:

В каждом шаге обучения выполняется forward propagation – прямое распространение сигнала вдоль нейронной сети и получение предсказаний, вычисление функции потерь и backward propagation – алгоритм обратного распространения ошибки и обновление обучаемых параметров. Инференс же представляет собой только forward propagation, за счёт чего расчёты выполняются быстрее с меньшим потреблением памяти.

Для сравнения я выбрал несколько классических архитектур свёрточных нейронных сетей, которые отличаются размером, количеством и типом свёрточных слоёв и функций активации. Помимо этого, я варьировал наиболее часто изменяемые параметры: размер батча (количество одновременно обрабатываемых нейронной сетью изображений) и размер входных изображений.

GPU: Nvidia GeForce RTX 2060;

CPU: Intel(R) Core(TM) i7-9750H.

Поскольку конечной целью является измерение среднего времени шага обучения/инференса, данные могут быть использованы любые. Например, случайным образом сгенерированные:

1. Скорость обучения (на GPU)

Для каждой комбинации нейронной сети, размера входных изображений и размера батча было выполнено 100 шагов обучения и измерено среднее время шага обучения. Полные результаты измерений представлены в таблице 1. Прочерки в таблицах соответствуют такой комбинации параметров, при которой для процесса не хватило видеопамяти. На рисунке 1 представлены кривые, соответствующие относительному времени шага обучения фреймворков для каждой выбранной комбинации входных параметров (за единицу принято наименьшее время шага в данной комбинации).

Таблица 1. Среднее время шага обучения (в секундах).

В большинстве случаев PyTorch показывает лучшую производительность по сравнению с TensorFlow. Грубая оценка такая: скорость обучения в PyTorch 1.9.0 на 30% быстрее, чем в TensorFlow 2.5.0, и на 45% быстрее, чем в TensorFlow 1.15.0. Однако заметно, что при обучении vgg16 и efficientnet в TensorFlow 2.5.0 показывает лучшую производительность, хотя и в целом близкую к производительности в PyTorch 1.9.0. Оптимизация видеопамяти в TensorFlow 2.5.0 улучшилась по сравнению с TensorFlow 1.15.0, благодаря чему удалось запустить обучение для большего числа нейронных сетей. Оптимизация видеопамяти в PyTorch 1.9.0 выглядит чуть более превосходящей, чем в TensorFlow 2.5.0.

2. Скорость инференса (на GPU)

Среднее время шага инференса измерялось аналогичным образом, полные результаты измерений представлены в таблице 2, кривые, соответствующие относительному времени шага инференса фреймворков, представлены на рисунке 2.

Таблица 2. Среднее время шага инференса на GPU (в секундах).

При инференсе на GPU TensorFlow 1.15.0 и PyTorch 1.9.0 показывают примерно одинаковую производительность: при грубой оценке, PyTorch 1.9.0 оказывается в среднем на 5% быстрее при использовании архитектур ResNet и VGG, а TensorFlow 1.15.0 в среднем на 5% быстрее при использовании архитектур MobileNet и EfficientNet. При этом TensorFlow 2.5.0 во всех случаях в среднем на 30% медленнее. Основная причина в этом, на мой взгляд, использование динамического графа вычислений: при переходе к статическому, скорость инференса в TensorFlow 2.5.0 становится практически такой же, как и в TensorFlow 1.15.0.

3. Скорость инференса (на CPU)

В таблице 3 представлены полные результаты измерений скорости инференса на CPU. На рисунке 3 представлены кривые, соответствующие относительному времени шагу инференса фреймворков на CPU.

Таблица 3. Среднее время шага инференса на CPU (в секундах).

Здесь результаты получились довольно неожиданные: в большинстве случаев PyTorch 1.9.0 показывает низкую производительность, причём чем сложнее нейронная сеть, тем ниже производительность. Грубая оценка скорости инференса на CPU: TensorFlow 2.5.0 в среднем на 5% быстрее, чем TensorFlow 1.15.0 и в среднем на 40% быстрее, чем PyTorch 1.9.0.

Интересно, что при инференсе на CPU переход от динамического графа к статическому в TensorFlow 2.5.0 не влияет на скорость.

4. Количество выделяемой видеопамяти

Для измерения выделяемой видеопамяти я использовал python-оболочку для nvidia-smi. Благодаря этой библиотеке, в конце процесса обучения/инференса я получал информацию о количестве выделенной видеопамяти под текущий процесс. К сожалению, видеопамять в TensorFlow выделяется не совсем понятным образом: как правило, значительная часть доступной видеопамяти выделяется независимо от параметров обучаемой нейронной сети. При этом я несколько раз замечал, что там, где ожидается большее потребление видеопамяти, TensorFlow выделяет её меньше. Например, для обучения ResNet18 с входным размером изображения (128, 128, 3) и размером батча 1 выделяется 4679 Мб видеопамяти, а для обучения той же ResNet18 с входным размером изображения (320, 320, 3) и размером батча 1 выделяется 3911 Мб видеопамяти. В PyTorch выделение видеопамяти более понятно: для описанных конфигураций выделяется 1329 Мб и 1355 Мб видеопамяти соответственно.

В таблице 4 и на рисунке 4 представлены результаты измерения выделяемой видеопамяти в PyTorch при обучении и инференсе, полученные для каждой комбинации нейронной сети, размера входных изображений и размера батча.

Таблица 4. Количество выделяемой видеопамяти при обучении и инференсе в PyTorch 1.9.0 (в Мб).

Заключение

Проанализировав результаты измерений, я сделал для себя несколько выводов:

помимо того, что TensorFlow 1 уже морально устарел, TensorFlow 2 является в целом более производительным при обучении свёрточных нейронных сетей и инференсе без использования GPU;

использовать tf.keras для инференса на GPU в TensorFlow 2 можно на этапе разработки и тестирования моделей, а для встраивания обученных моделей желательно использовать другие средства TensorFlow, обеспечивающие бóльшую производительность, например, в TensorFlow 2 осталось доступна заморозка графа;

PyTorch радует своей производительностью при использовании GPU, но если планируется запускать обученные модели на CPU, то необходимо использовать другие средства, например, onnxruntime. На мой взгляд, onnxruntime обеспечивает наилучшую производительность при запуске нейронных сетей на CPU.

Несколько ссылок, где можно подробнее почитать про сравнение различных фреймворков глубокого обучения:

1 – небольшое описание и сравнение TensorFlow и PyTorch;

2 – сравнение TensorFlow и PyTorch с примерами кода;

3 – краткое описание 8 различных фреймворков глубокого обучения.

Весь код, использованный мной для выполнения этих измерений, а также результаты измерений опубликованы в моём репозитории.

Читайте также: