Supermicro не видит raid контроллер

Обновлено: 06.07.2024

Создадим зеркальный массив из задних двух слотов на сервере Supermicro SYS-2029U-TN24R4T.

Всем привет. Ранее я уже писал похожую статью про создание массива из REAR слотов:

На этот раз у нас другая модель сервера и процесс настройки будет немного отличаться. Итак, имеем Сервер Supermicro SYS-2029U-TN24R4T. Сервер забит NVMe дисками.

Причины не использовать NVMe диски под операционную систему:

- Жаба душит использовать NVMe диски под операционную систему.

- В сервере нет RAID контроллера для NVMe дисков, не получится собрать RAID массив, а он необходим для отказоустойчивости ОС.

- Не хотелось бы использовать одни и те же диски для ОС и для данных.

К счастью, сзади есть два дополнительных слота для дисков.

Вот их-то мы и будем использовать для создания RAID 1 массива, на который зальём операционную систему.

Купили парочку недорогих дисков, вот таких:

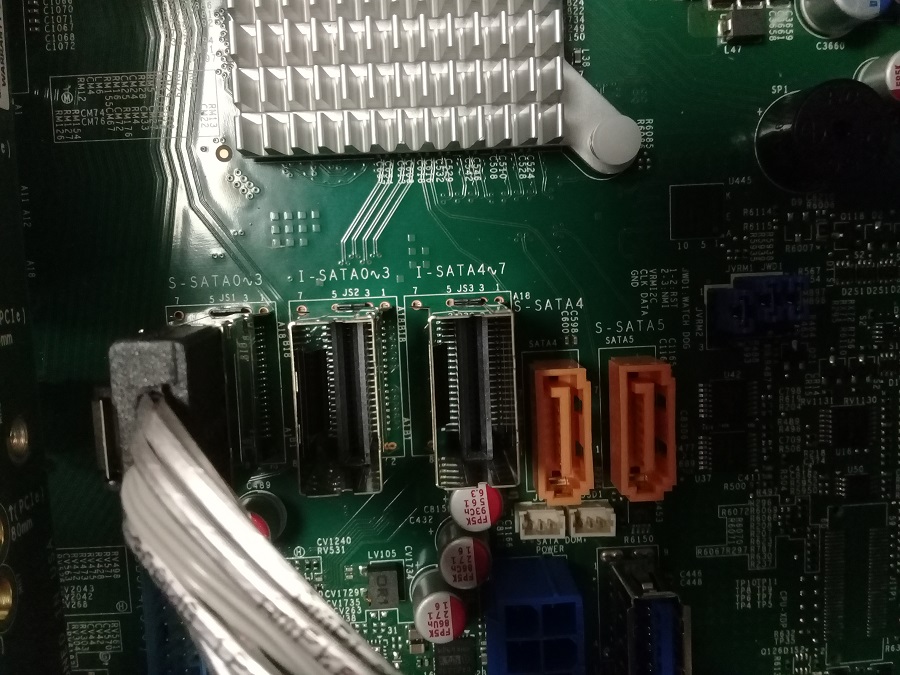

Примечательно, что отсек с REAR слотами был подключен ко второму SATA контроллеру:

Переключаем кабель из S-SATA

Теперь диски подключены к нужному встроенному SATA контроллеру.

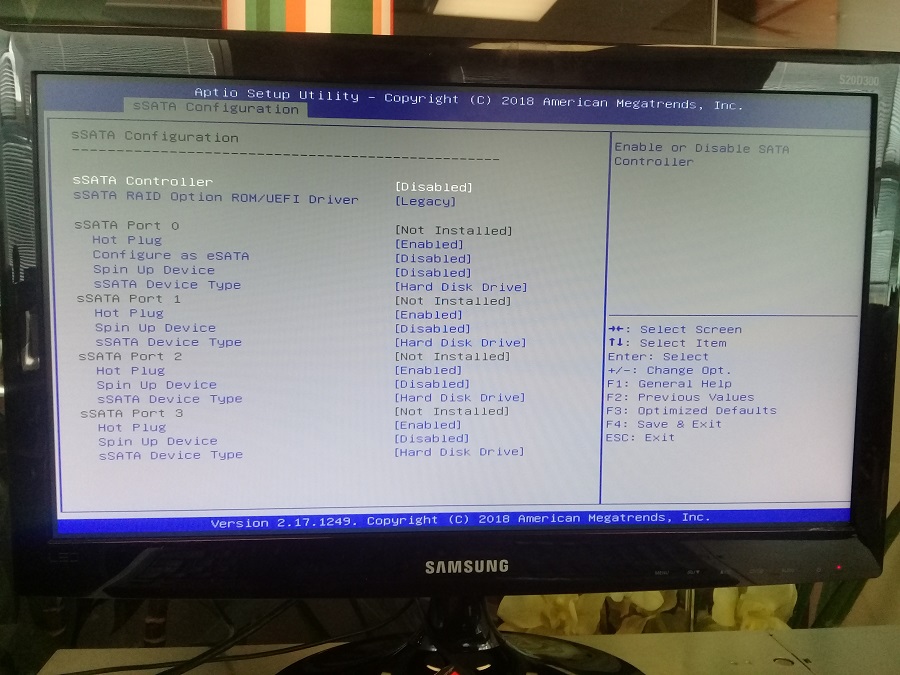

Второй SATA контроллер можно отключить.

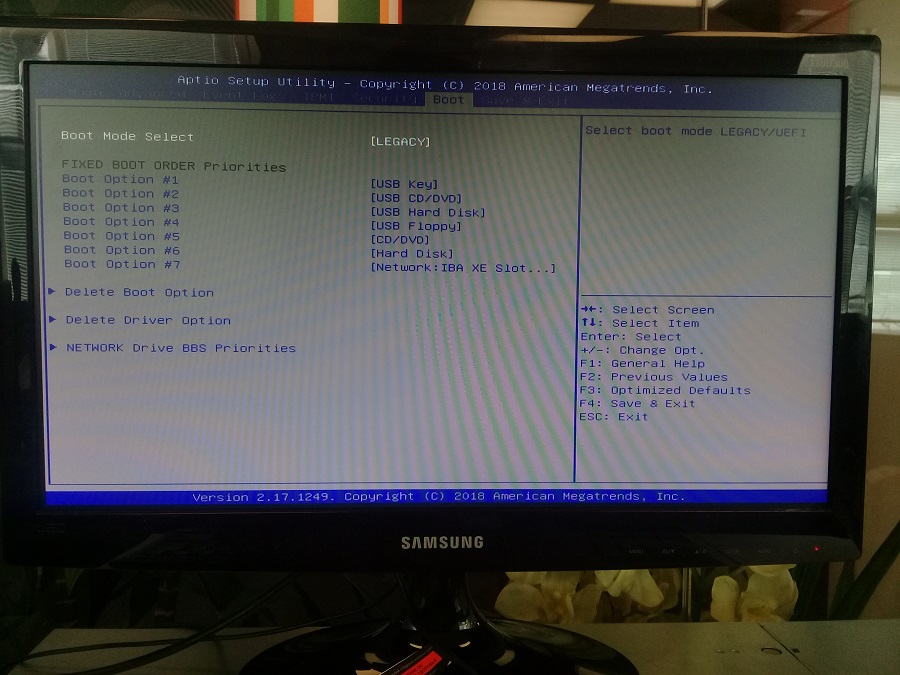

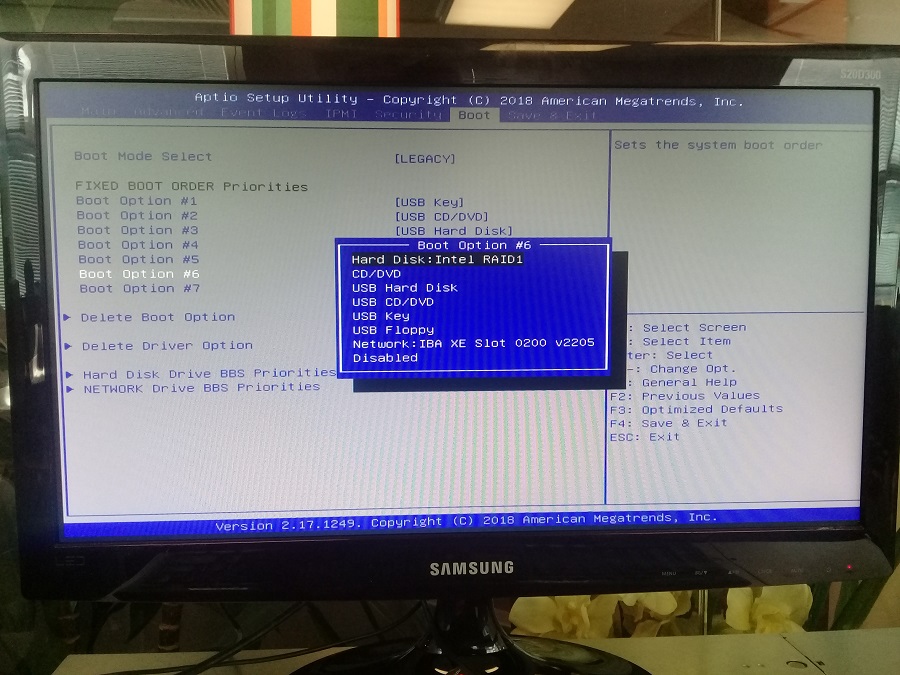

Диски определились, теперь нужно настроить RAID 1 массив. Заходим в раздел BOOT, переключаем Boot mode select на LEGACY.

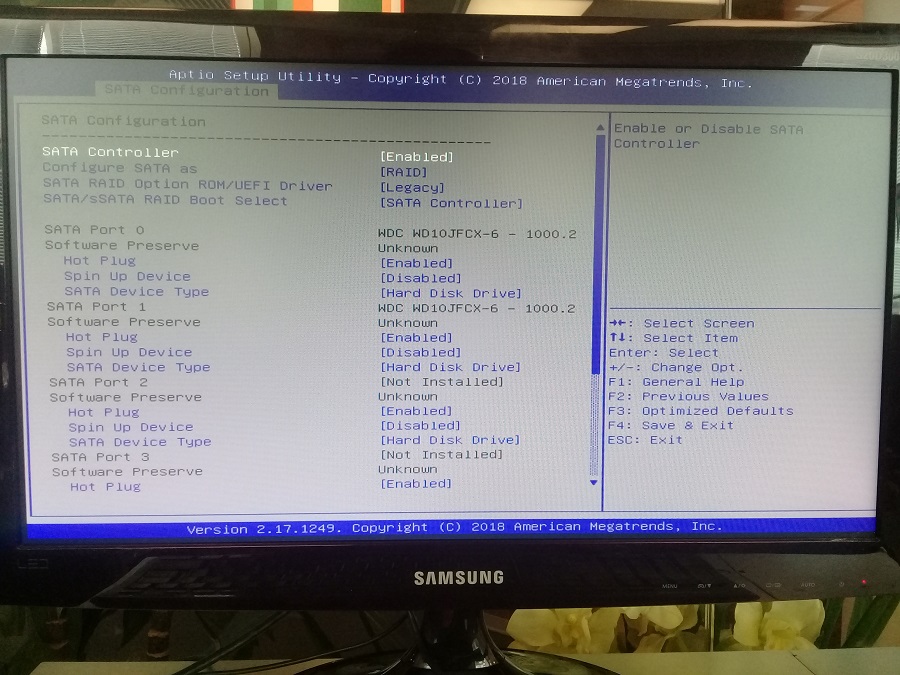

В настройках SATA контроллера переключаем режим. Меняем Configure SATA as AHCI на RAID.

SATA RAID Option ROM/UEFI Driver устанавливаем в Legacy.

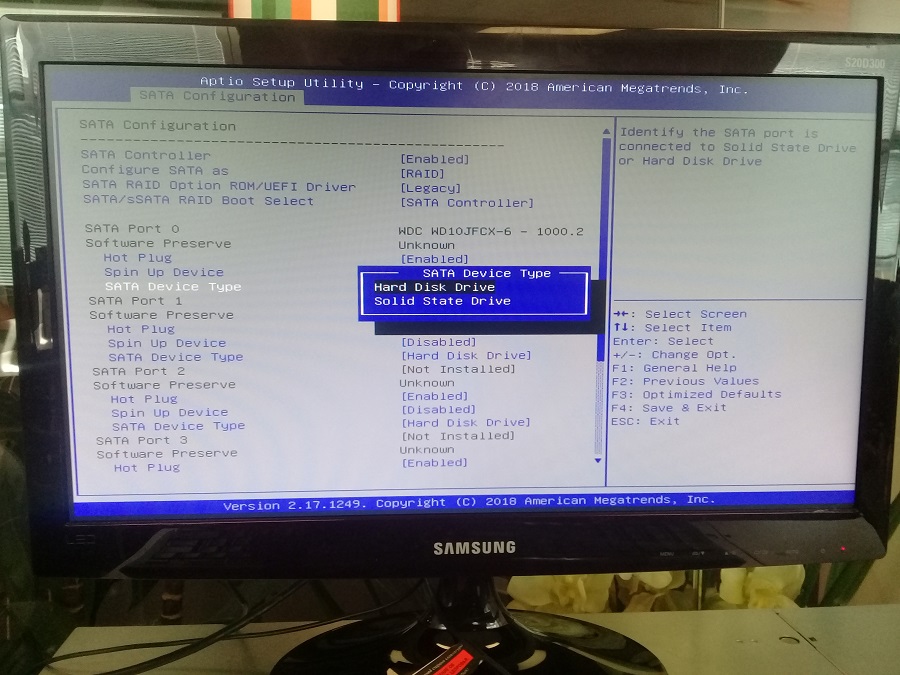

Поскольку мы приобрели HDD диски, то опции SATA Device Type на каждом диске оставляем Hard Disk Drive. Если у вас SSD, то нужно установить Solid State Drive.

Сохраняем конфигурацию BIOS и перезагружаем сервер.

При загрузке жмём Ctrl+I.

Попадаем в утилиту конфигурирования RAID массивов Intel Virtual RAID on CPU - SATA Option ROM.

Выбираем Create RAID Volume.

Указываем название массива, например, RAID1.

RAID Level указываем RAID1(Mirror), нам же нужна отказоустойчивость.

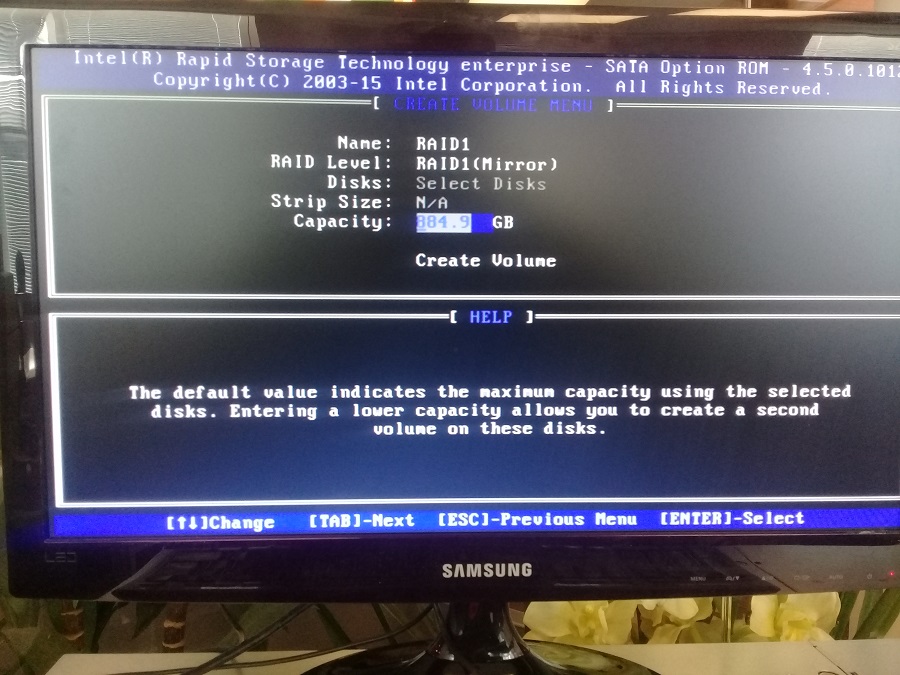

Capacity — используем всё место.

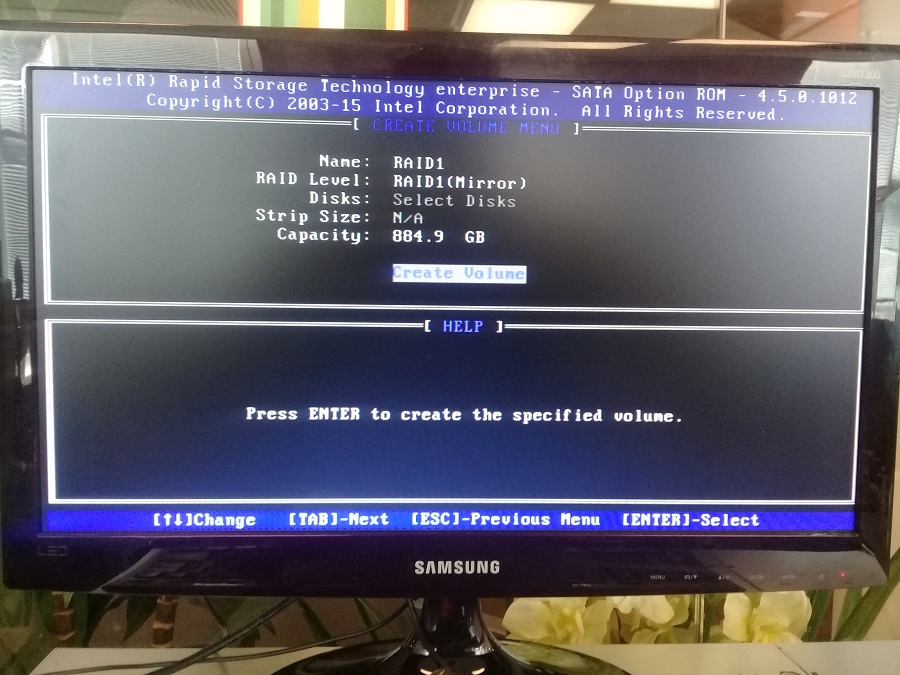

Create Volume — создаём массив.

Подтверждаем создание массива — Y.

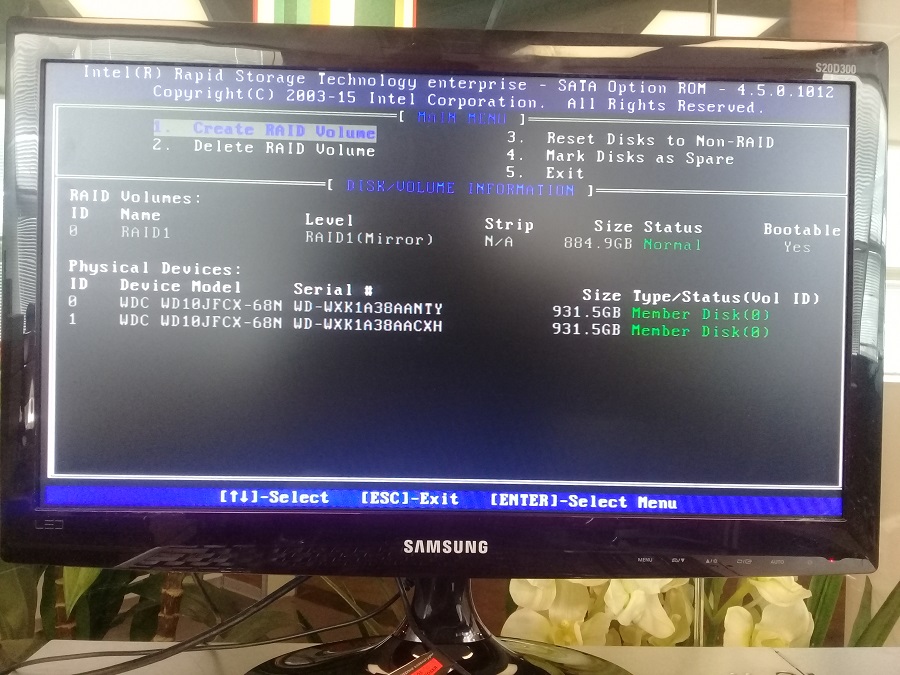

RAID 1 массив создан.

Теперь тонкий момент, я собираюсь устанавливать операционную систему в режиме UEFI. Заходим в BIOS и в разделе Boot устанавливаем Boot mode select на DUAL.

В Advanced конфигурируем SATA контроллер. SATA RAID Option ROM/UEFI Driver меняем на EFI.

Сохраняем настройки BIOS. Монтируем образ с операционной системой.

При загрузке жмём F11 для выбора загрузчика.

Выбираем UEFI: ATEN Virtual CDROM YSOJ, грузимся с примонтированного ISO образа.

Запускается инсталлятор, в моём случае это Oracle Linux.

Инсталлятор видит созданный нами BIOS RAID set (mirror), туда и ставим ОС.

Готово, мы убедились в том, что RAID 1 зеркало отлично создается на REAR слотах и доступно для установки ОС.

Имеется сервер Supermicro 4U в составе CSE-846BE16-R920B / MBD-X10DRi / 2xIntel Xeon E5-2660 V.4 / 4x32 GB DDR4 ECC REG / 24x6TB 7200 RPM / SAS 9300-8i Host Bus Adapter / LSI CBL-SFF8643-8087-10M (LSI00402) / MCP-220-82609-0N / Rear 2.5 x 2 Hot swap HDD / Intel X520-DA2.

И серверная полка в составе CSE-846BE1C-R1K03JBOD / 2282600-RACK-E-HDmSAS-HDmSAS-2M / 24x6TB 7200 RPM.

Простым языком конфигурация следующая:

Сервер размером 4 юнита, в него воткнуты:

- спереди 24 жёстких диска HDD 3.5' объёмом 6 Тб каждый,

- внутри материнка X10DRi,

- два процессора,

- четыре плашки памяти по 32 Гб,

- Host Bus Adapter SAS 9300-8i - кабелем LSI соединяется с полкой, её описание ниже,

- сзади два слота под 2.5' жёсткие диски.

Полка размером 4 юнита, в ней:

- спереди 24 жёстких диска HDD 3.5' объёмом 6 Тб каждый,

- полка подключена LSI кабелем к серверу.

Вот как оно выглядит вместе:

Идея в следующем: 2 слота сзади сервера использовать под систему, объединив для отказоустойчивости в зеркало - RAID1. Слоты:

- объединить два Rear винта в зеркало,

- сделать их загрузочными,

- установить ОС, загрузиться.

- Убедиться, что большие диски по 6 Тб видны в ОС.

Первые грабли - Legacy

Я уже имел дело с серверами Supermicro, поэтому сразу предупреждаю, встроенный софтварный RAID контроллер на материнке управляется только в режиме Legacy. Это свойственно не только серверам Supermicro. Как минимум, у нового микросервера HPE Proliant Microserver Gen10 тот же недостаток. Итак, нужно в BIOS переключить Boot Mode в режим Legacy.

Вытаскиваю все винты, чтобы не мешали.

Сервер загружается, видим заставку, ждём надписи "Press <DEL> to run Setup":

Жмём DEL, должна появиться надпись "Entering Setup. ":

Отдыхаем и ждём окна BIOS.

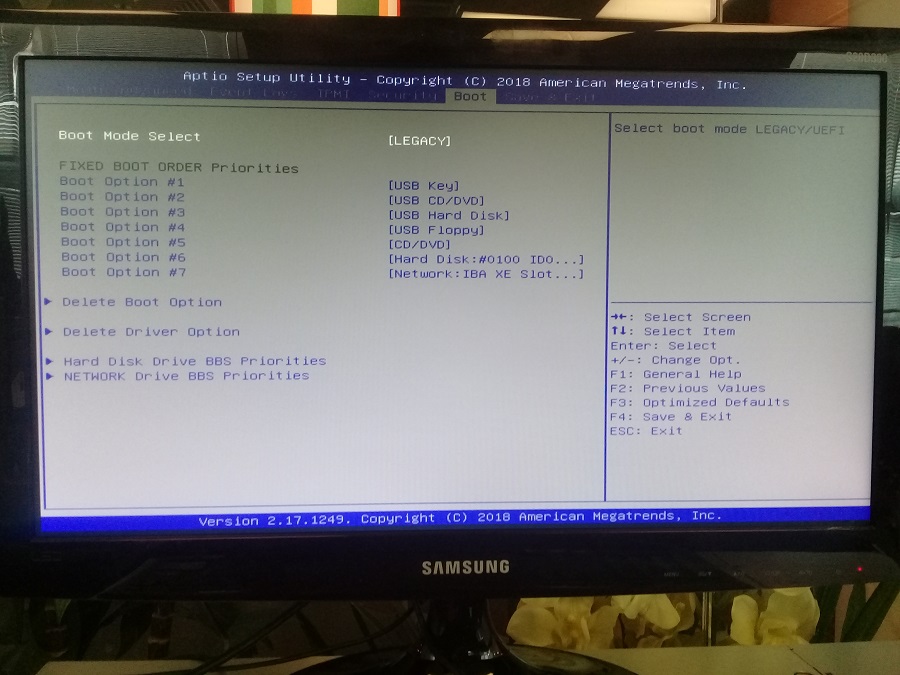

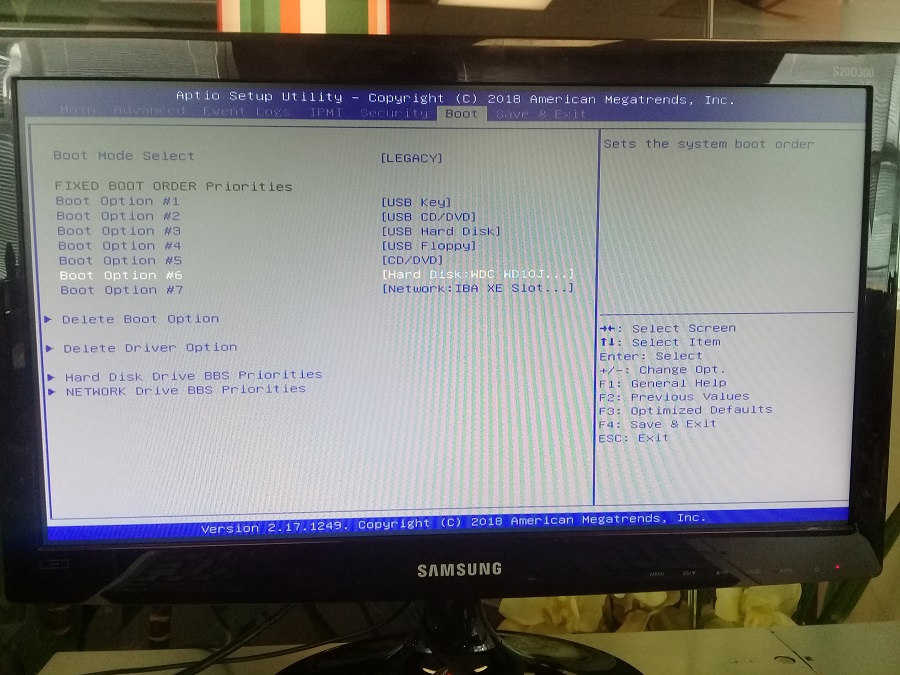

Переходим во вкладку Boot, переключаем режим Boot Mode Select на LEGACY. Сохраняем изменения, перезагружаем сервер.

Разбираемся с жёсткими дисками

Из описания следует, что мать имеет на борту два SATA-контроллера. Визуально было обнаружено, что Rear слоты подключены к первому, но это можно и в BIOS посмотреть. Переключить на второй SATA-контроллер вполне реально, но мне не нужно.

SAS винты контроллерами SATA не поддерживаются. Пробуем SATA винты. В качестве теста использовались две модели жёстких дисков:

- Intel SSD DC S3510 Series 480 Gb (HPE)

- Western Digital HDD WD10JFCX

Сразу скажу - оба вида жёстких дисков заработали. Далее в статье работа ведётся только с HDD WD10JFCX от Western Digital, которые мы и будем объёдинять в зеркало.

Rear слоты уже имеют салазки, прикручиваем их к винтам:

Втыкаем для начала один винт:

Мне пока просто интересно, увидит ли сервер винт?

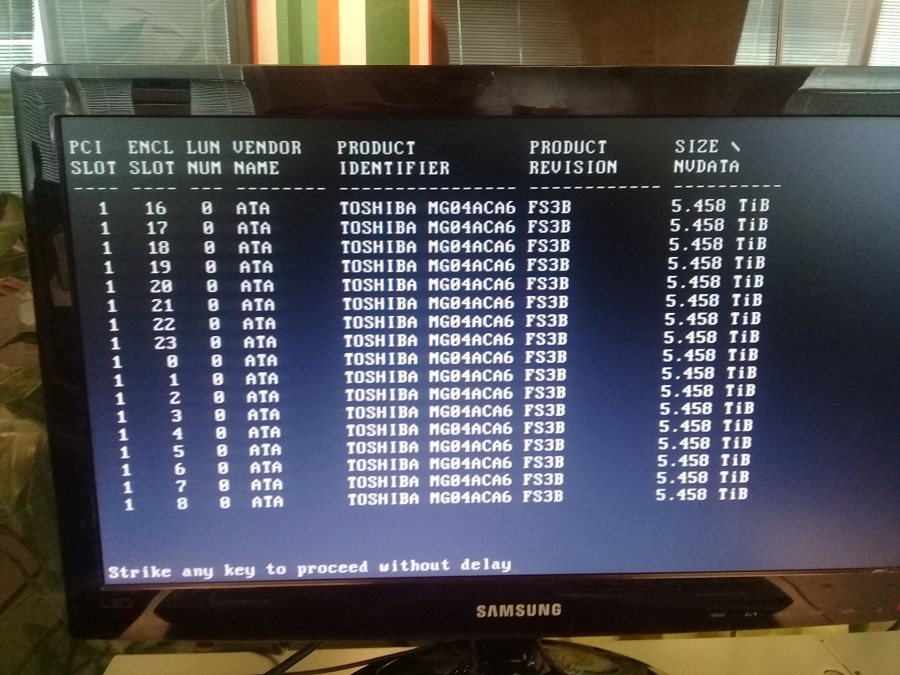

Также подключаем все 48 винтов по 6 Тб.

Вторые грабли - слишком много винтов в BIOS

После включения сервера с одним Rear винтом нам снова нужно попасть в BIOS.

В процессе загрузки мы видим много винтов TOSHIBA:

Это нормально, это всё большие 6 Тб винты.

В процессе загрузки жмём DEL и входим в BIOS, переходим во вкладку Boot:

Видим два изменения:

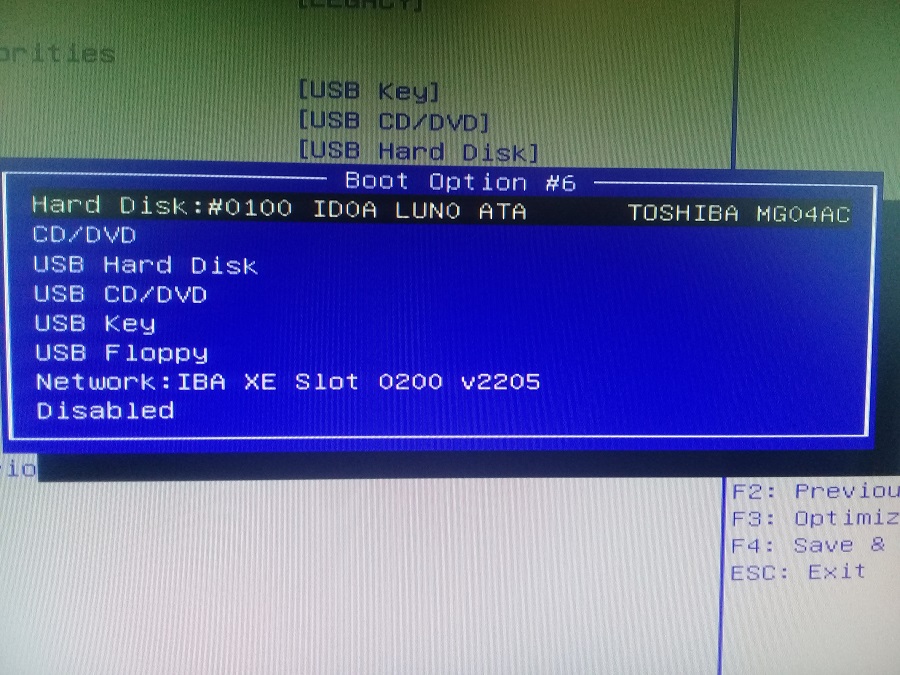

Смотрим на наш "Hard Disk. ":

Toshiba - это не Rear, нам нужно грузиться с других винтов.

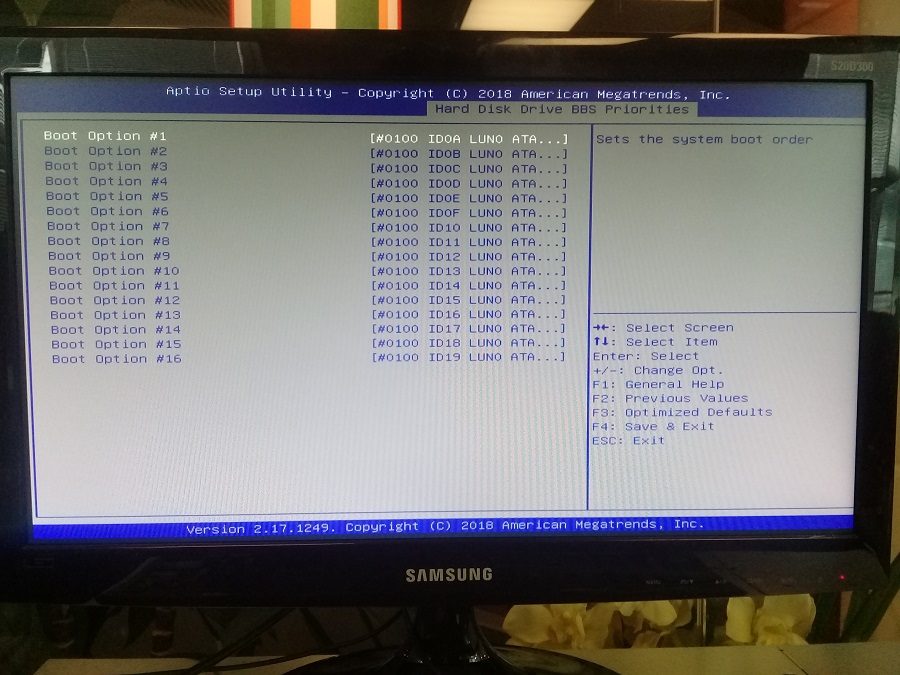

Кликаем на "Hard Disk Drive BBS Priorities":

И вот они - грабли. BIOS видит первые 16 жёстких дисков, остальные просто отсутствуют. Rear даже близко нет.

Настройка контроллера SAS 9300-8i

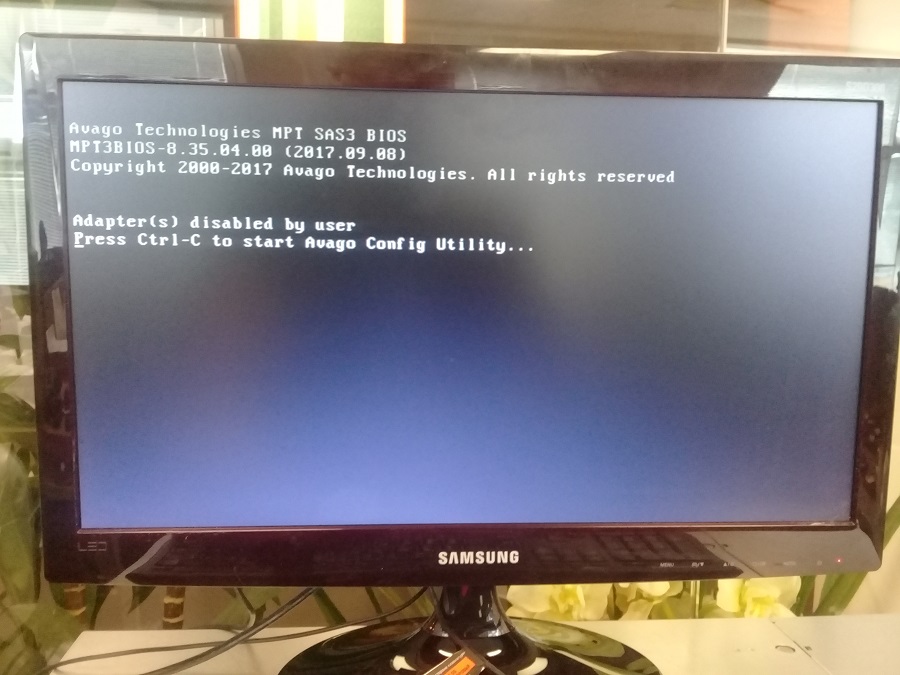

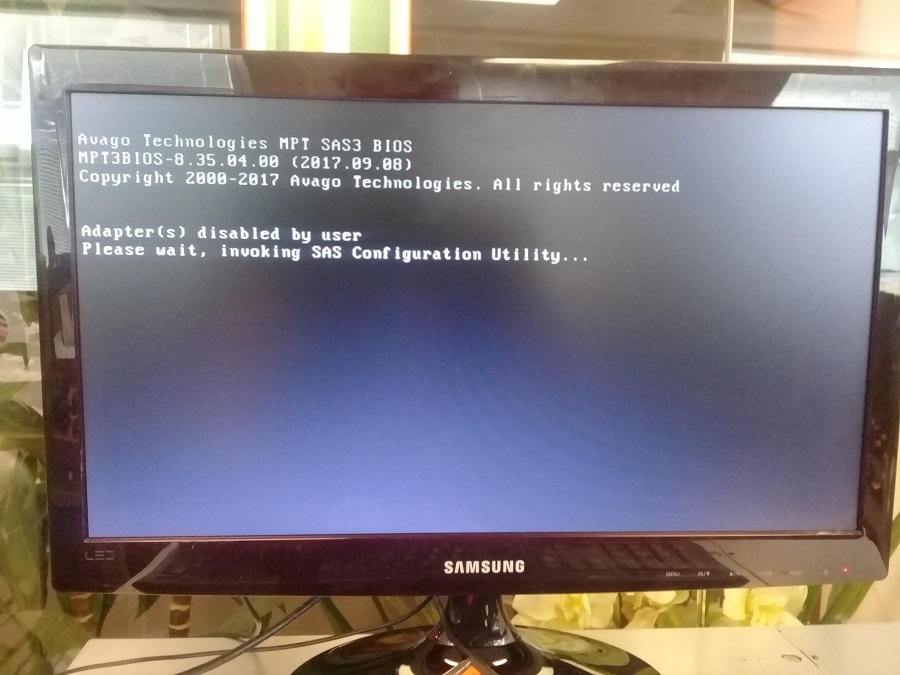

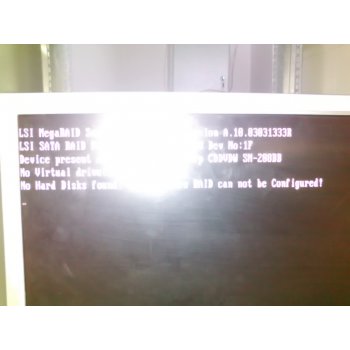

Для доступа к настройкам SAS-контроллера ждём появления экрана:

Утилита управления SAS-контроллером называется Avago Config Utility. Для входа нажимаем Ctrl+C:

Please wait, invoking SAS Configuration Utility.

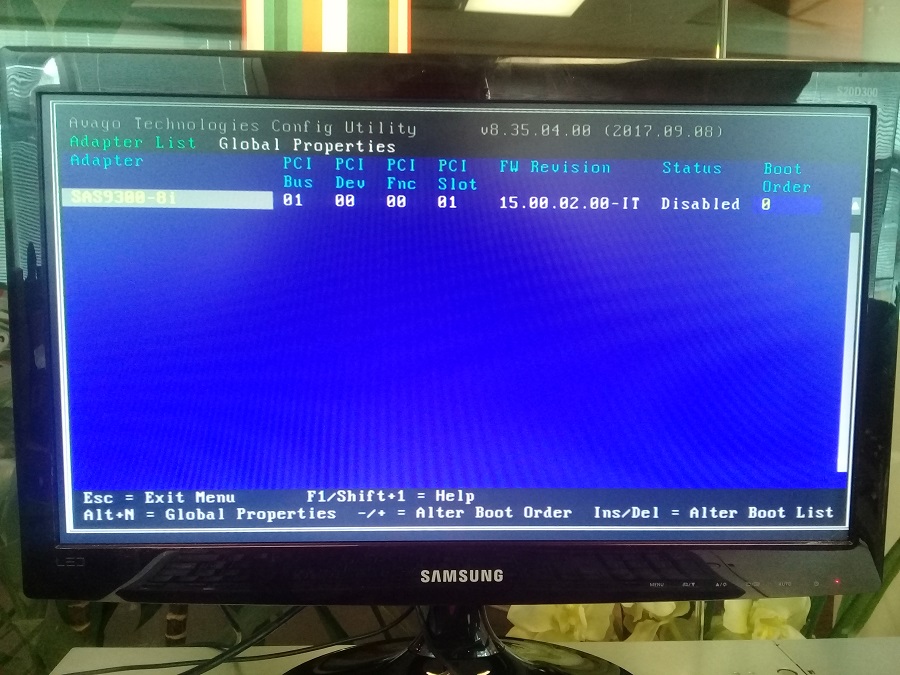

Открывается синий экран, курсор на контроллере SAS9300-81. Кликаем Enter:

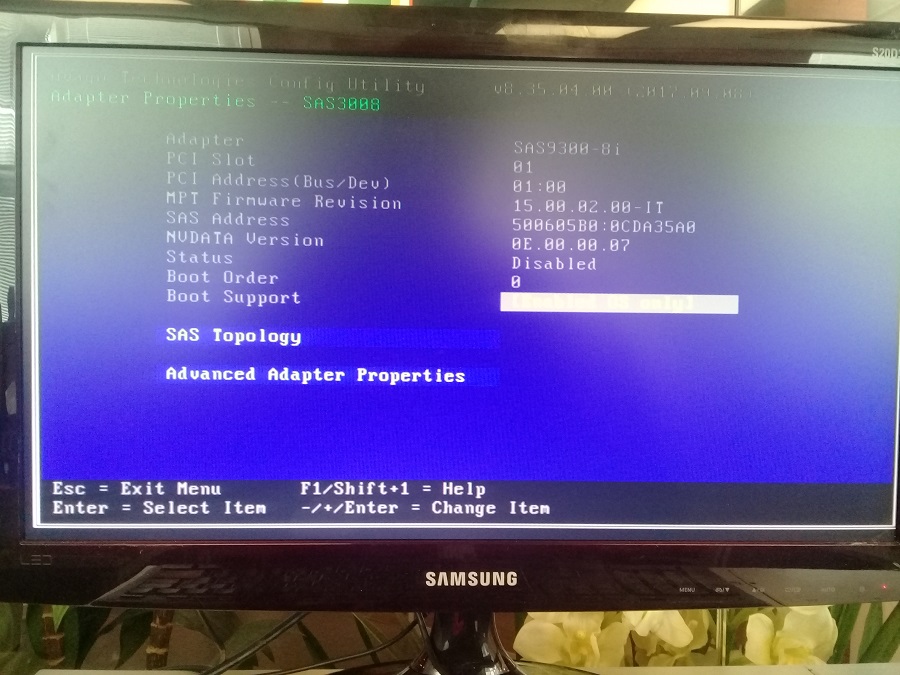

Ждём, открывается окно конфигурации контроллера:

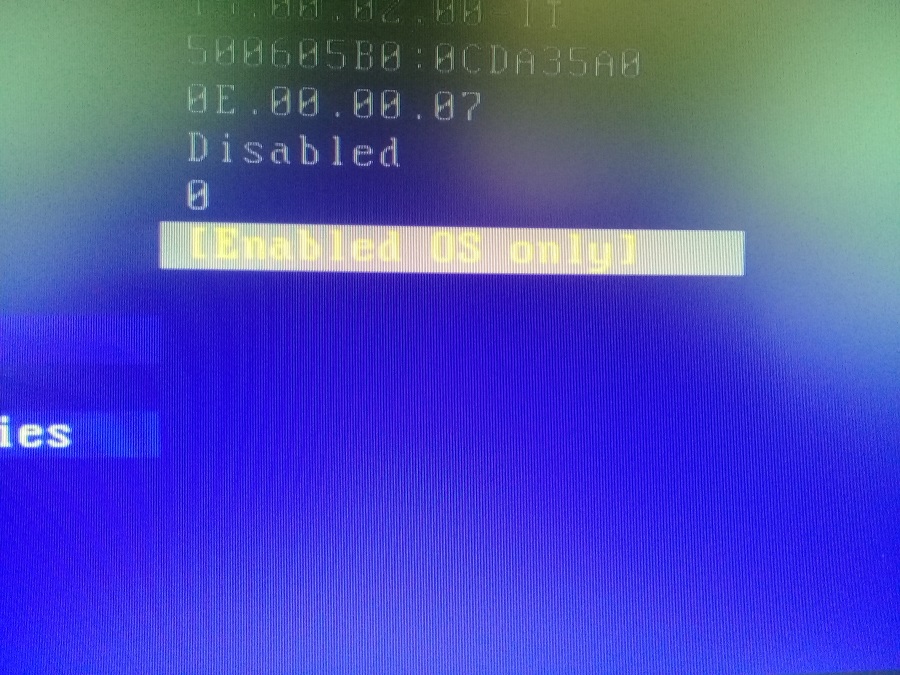

На фото плохо видно, но нас интересует пункт Boot Support, приближу:

По умолчанию стоит значение "Enabled BIOS & OS", кнопками плюс и минус меняем его на "Enabled OS only":

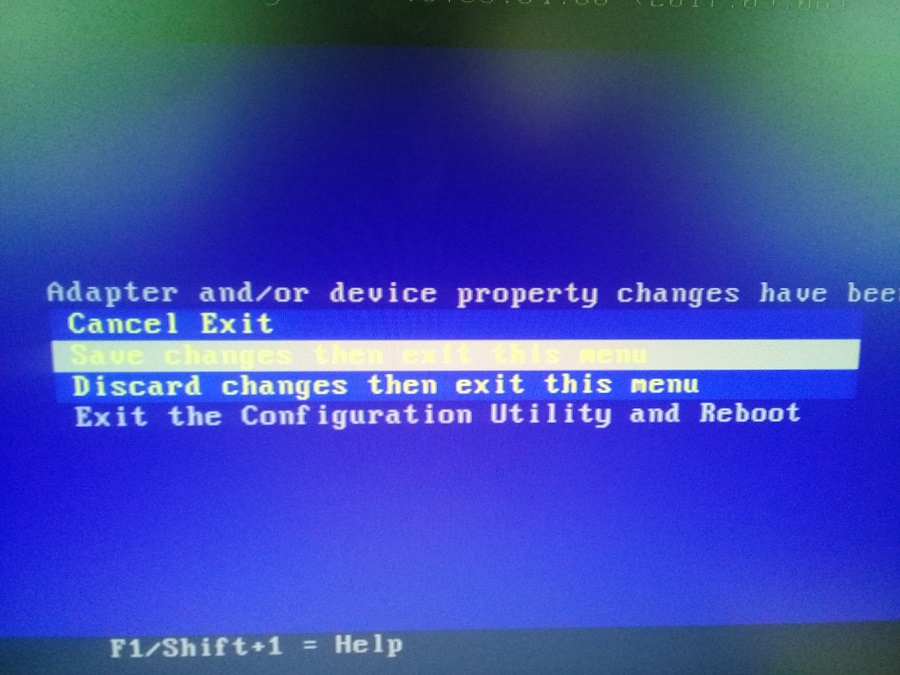

Нажимаем ESC, выбираем "Save changes then exit this menu":

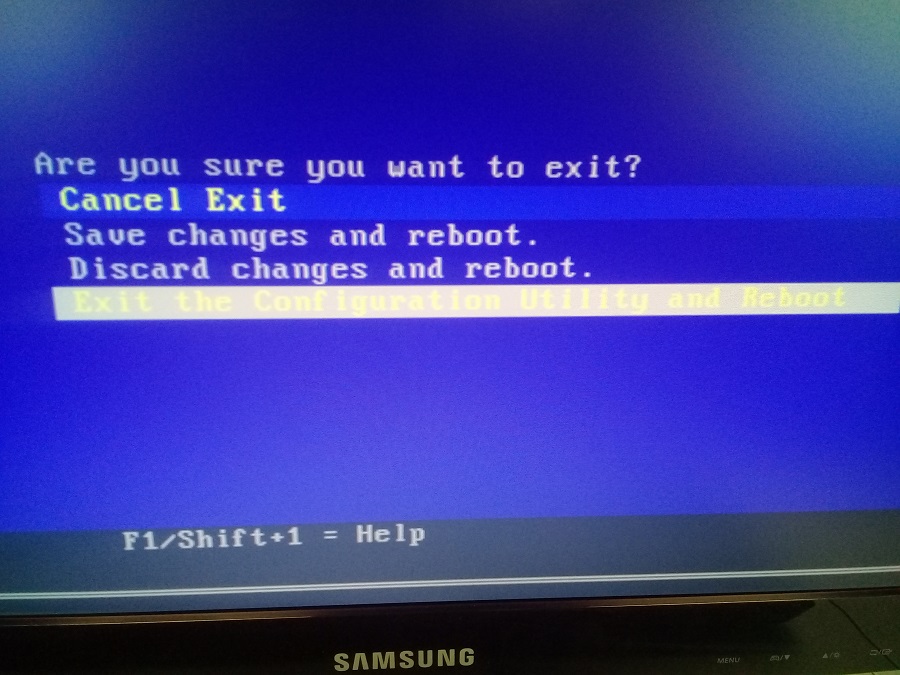

Потом "Exit the Configuration Utility and Reboot":

Перезагружаем сервер. На самом дела в этой утилите можно ещё много чего сделать, назначить, например, диск загрузочным, но мне это не требуется.

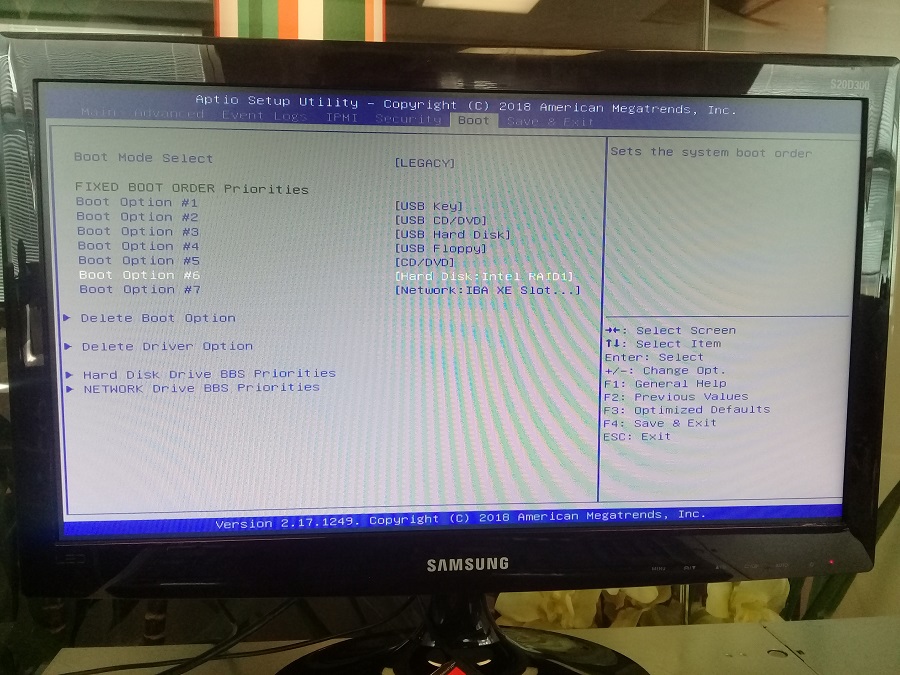

Снова жмём DEL и входим в BIOS во вкладку Boot:

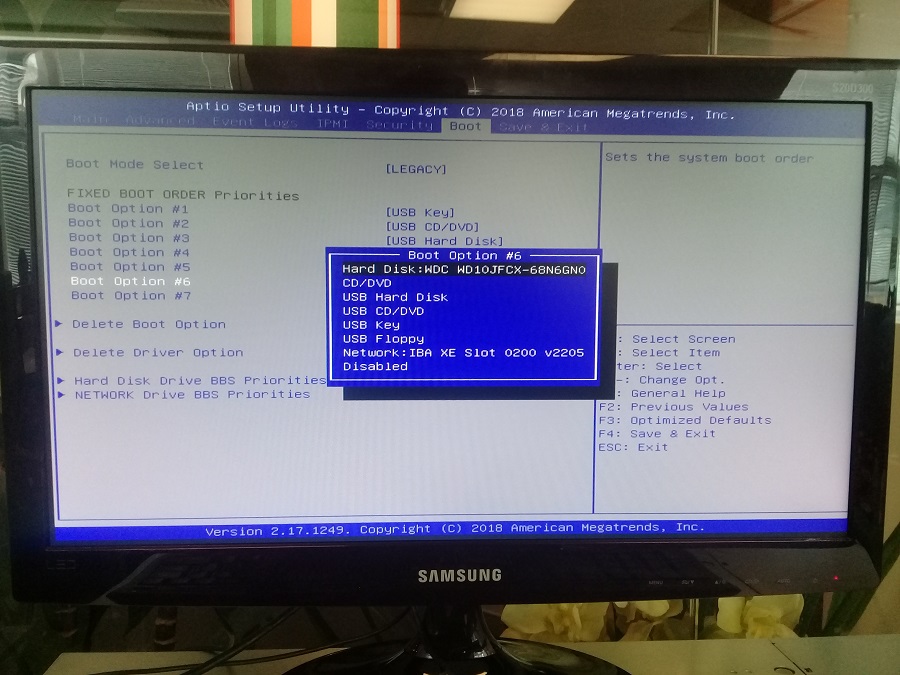

Да, судя по серийнику, это именно тот 2.5' Rear диск, который мы воткнули в сервер. Теперь мы убедились. что винт подходит и читается сервером. Следующая наша задача, сделать из двух Rear дисков RAID.

RAID1

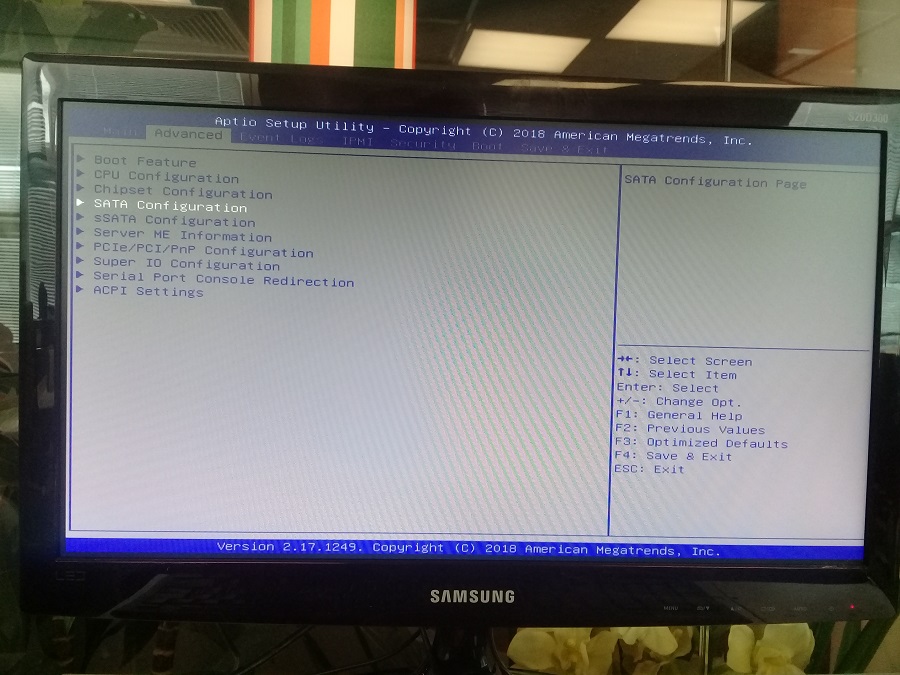

Переходим во вкладку Advanced:

Нас интересует пункт SATA Configuration. Это раздел конфигурирования встроенного в материнку SATA контроллера.

Чуть ниже есть ещё один пункт sSATA Configuration. sSATA расшифровывается просто - Second SATA Controller. Меня он не интересует, поскольку Rear диски подключены к первому SATA контроллеру.

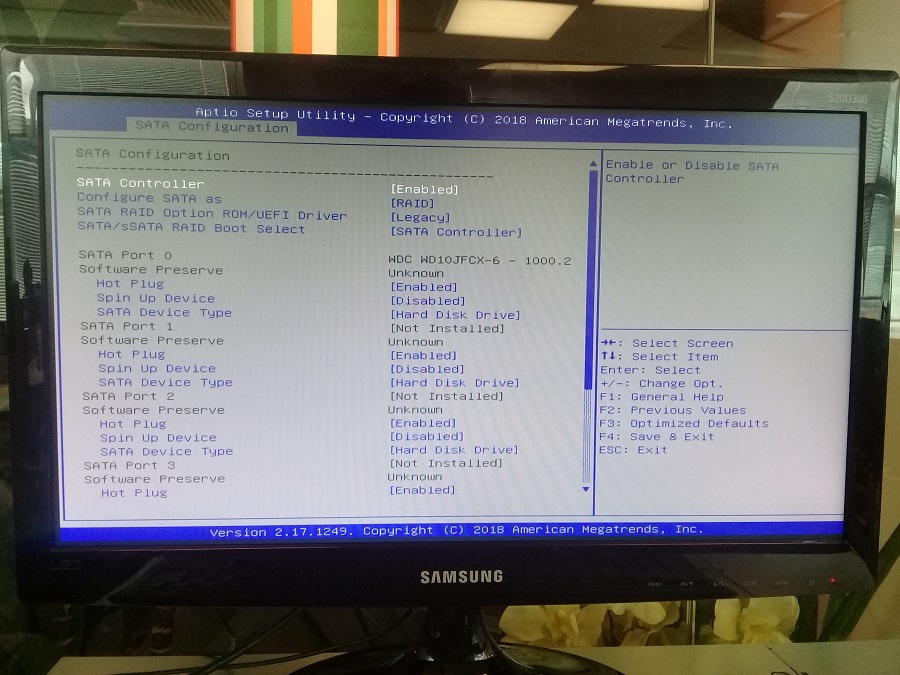

Переходим в SATA Configuration. Конфигурируем.

- SATA Controller - Enabled

- Configure SATA as - RAID

- SATA/sSata RAID Boot Select - SATA Controller

В SATA Port 0 видим наш диск Western Digital. Выше я рассказывал, что пробовал SSD диски. Для них можно сменить SATA Device Type с "Hard Disk Drive" на "Solid State Drive" (Для HDD не меняйте!):

Не знаю, что это даст, но хуже не будет точно. Поскольку я остановил выбор на WD HDD дисках, то оставляю "Hard Disk Drive" как было по умолчанию.

Сохраняем все изменения в BIOS и выключаем сервер. Вставляем в него второй Rear винт:

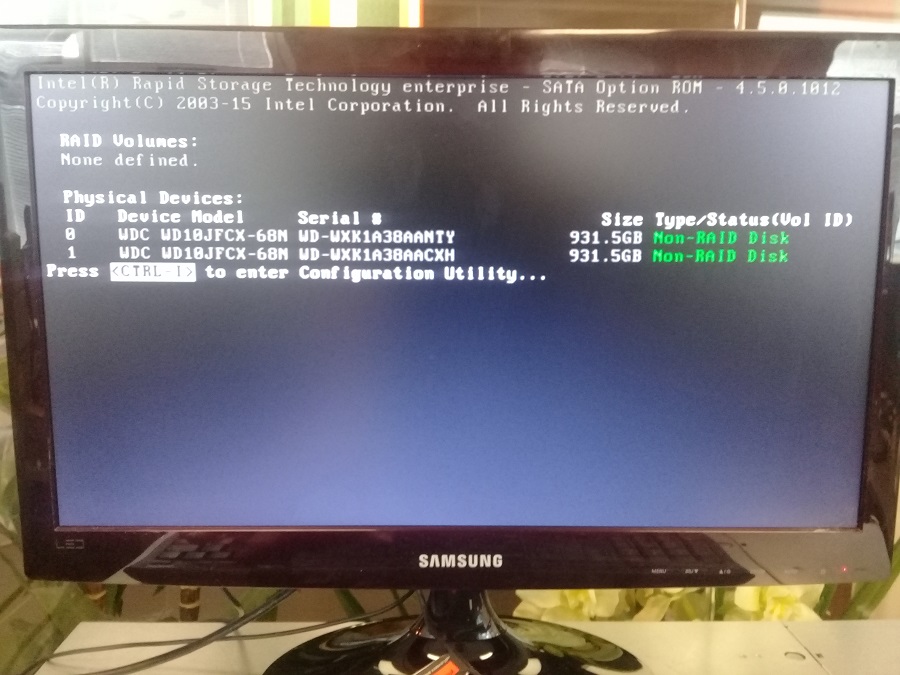

Включаем сервер. В процессе загрузки мелькает новое окно, ловим его:

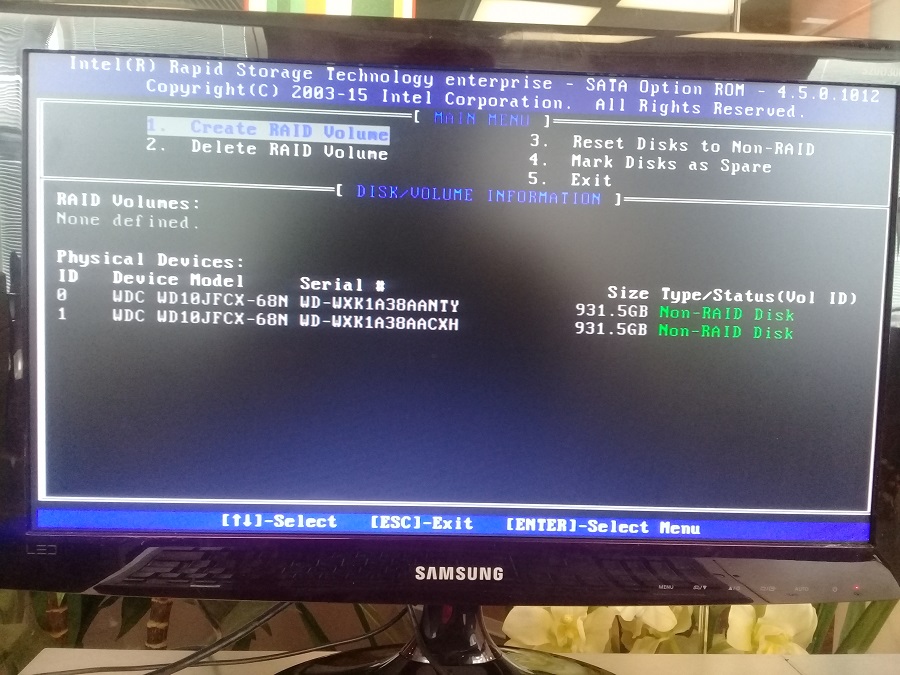

Для входа в раздел конфигурирования RAID нажимаем Ctrl+I (ай, i). Открывается окно Intel(R) Rapid Storage Technology enterprise - SATA Option ROM:

Далее настраиваем зеркало из двух винтов. Нажимаем единицу - Create RAID Volume:

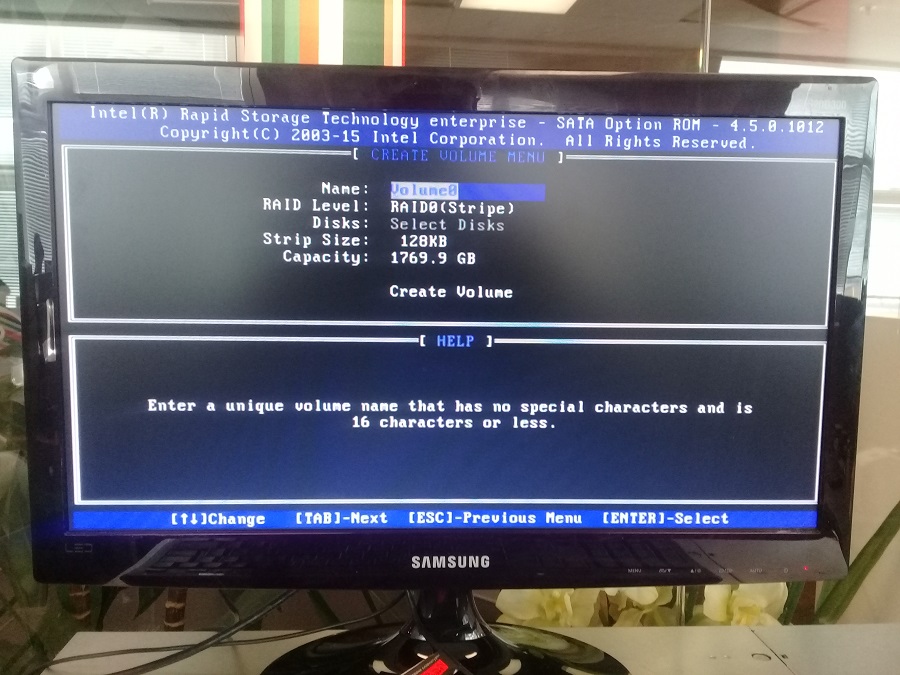

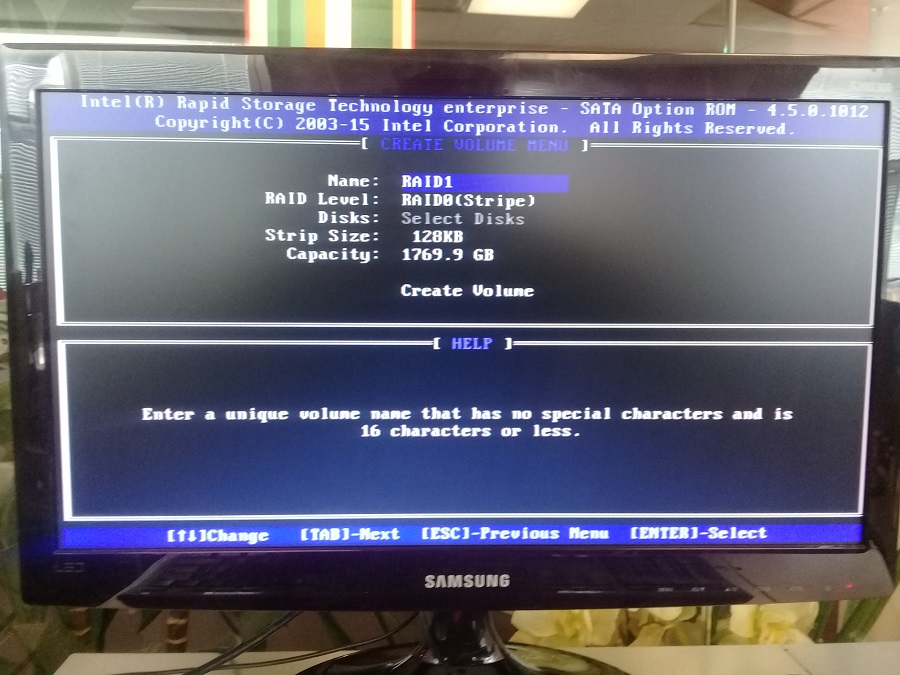

Указываем Name, я указал RAID1:

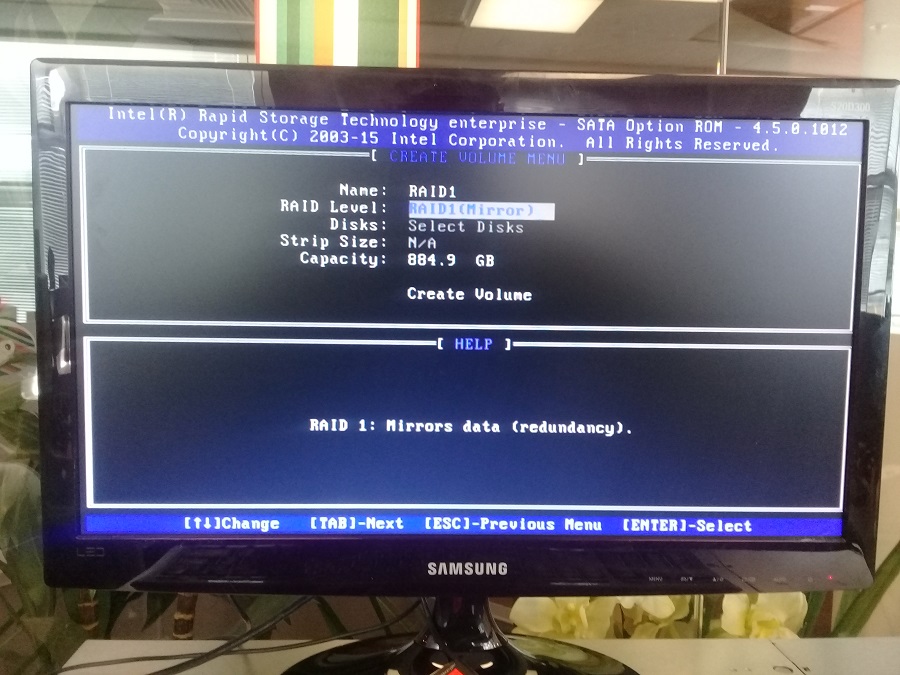

Выбираем RAID Level - RAID1(Mirror):

Capacity оставляю максимум, в зеркале размер RAID массива чуть меньше размера одного винта:

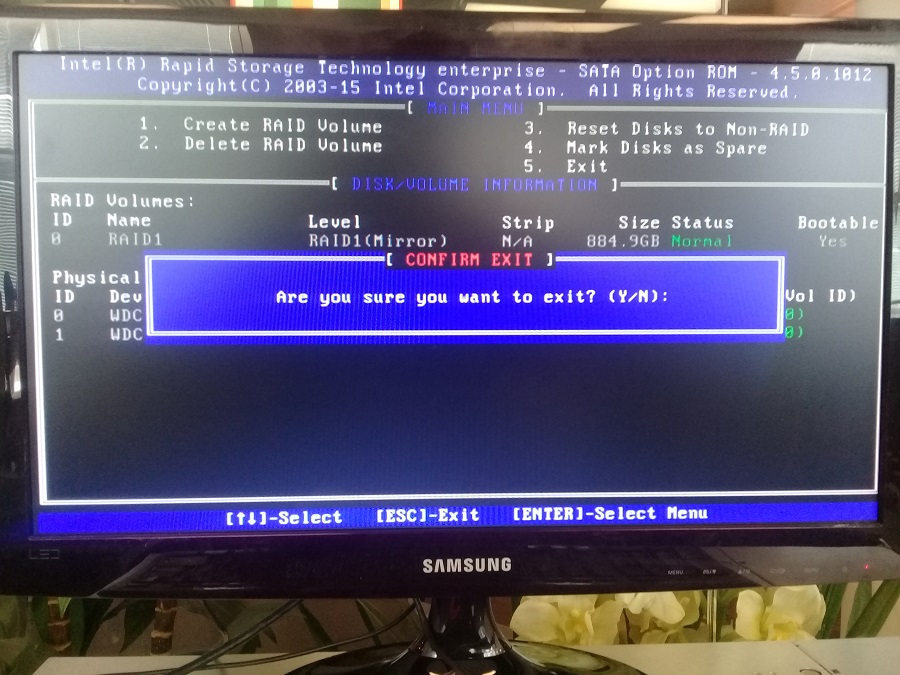

Статус массива Normal, инициализация зеркала проходит быстро. Bootable Yes. Выходим - 4:

Перезагружаем сервер, теперь нужно сделать RAID1 загрузочным.

RAID1 bootable

Отдельные винты в опциях загрузки пропали, но их можно увидеть в Advanced > SATA Configuration:

Если второй SATA контроллер не нужен, можно ему сделать Disabled:

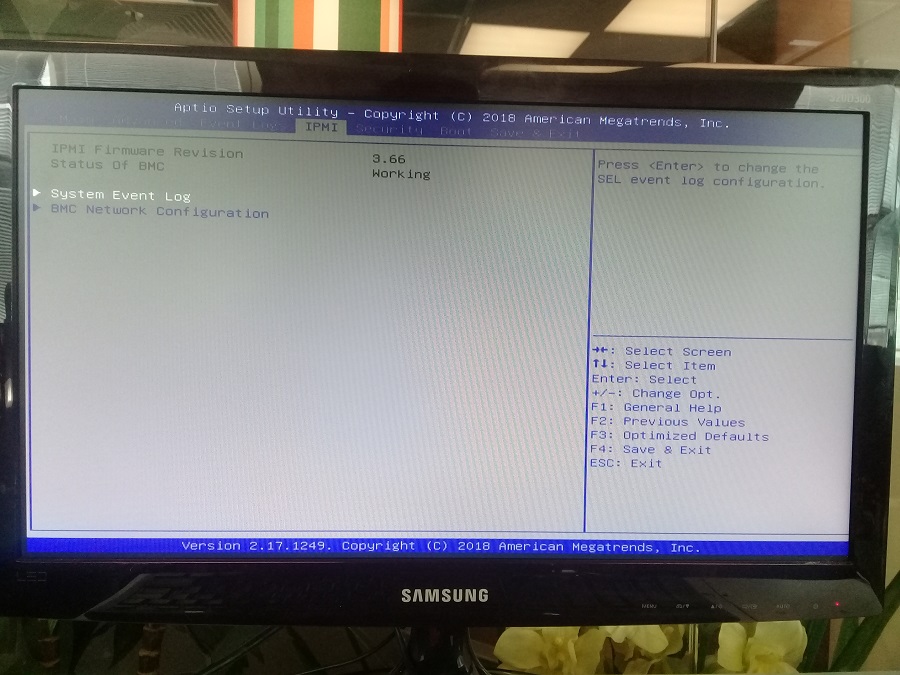

Для дальнейшей работы нам понадобится настроить IPMI (Redfish, BMC).

Настройка IPMI (Redfish, BMC) в BIOS

Для настройки IPMI на сервере достаточно вписать IP адрес и конфигурацию сети в BIOS. Переходим во вкладку IPMI:

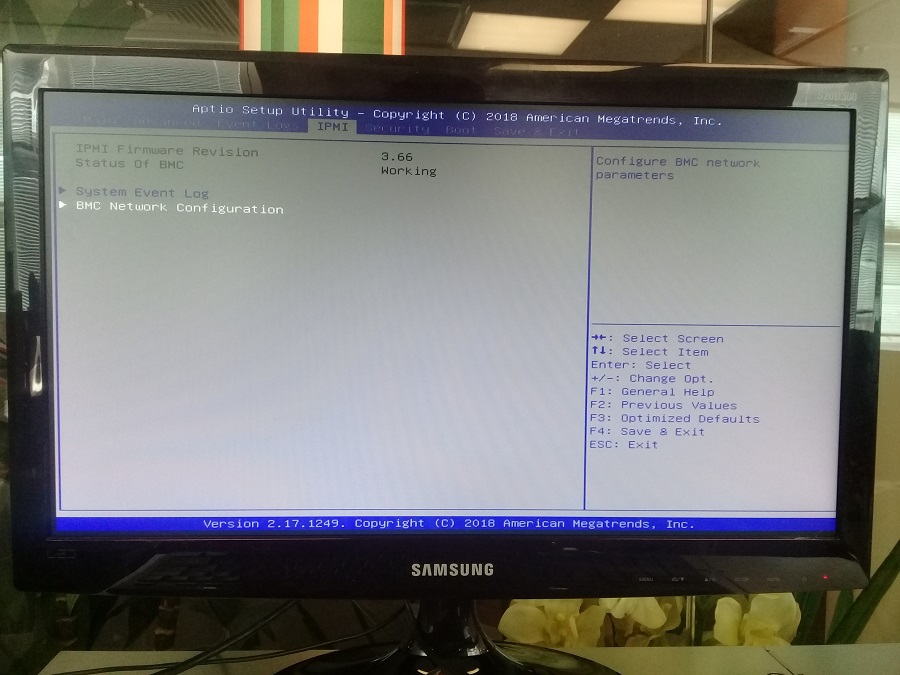

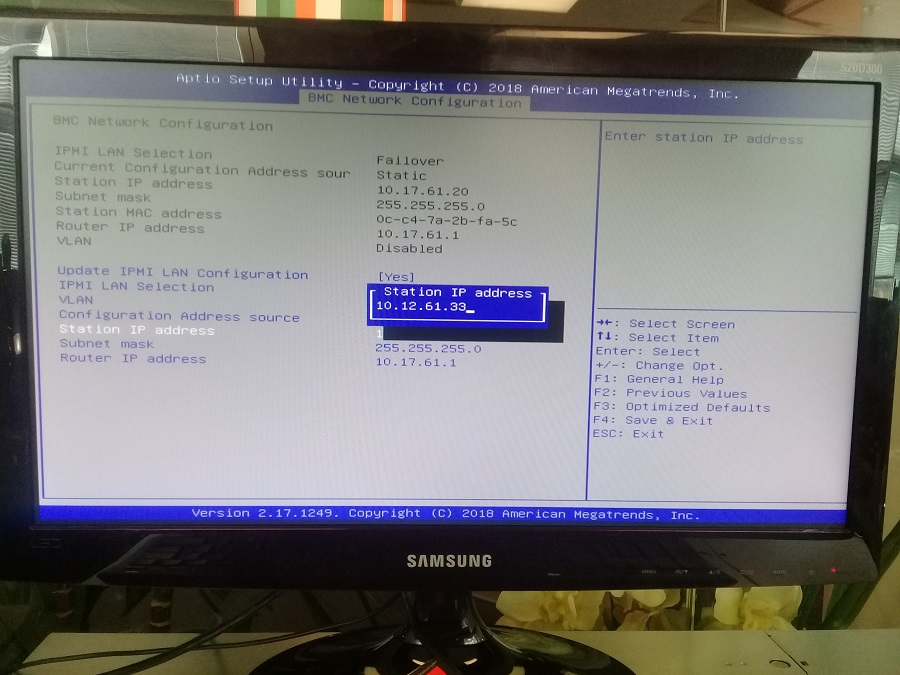

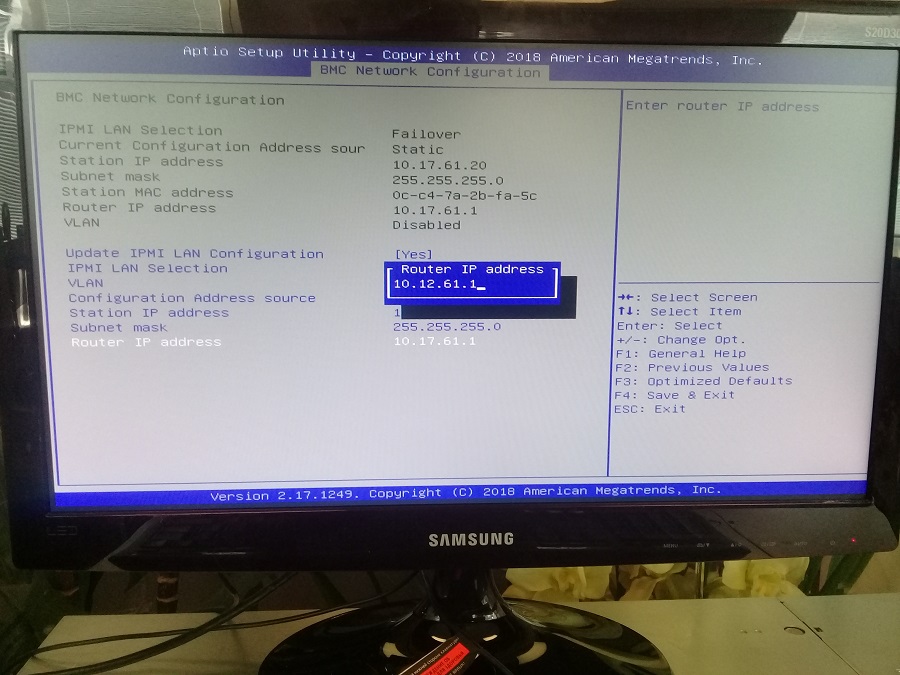

Переходим в BMC Network Configuration:

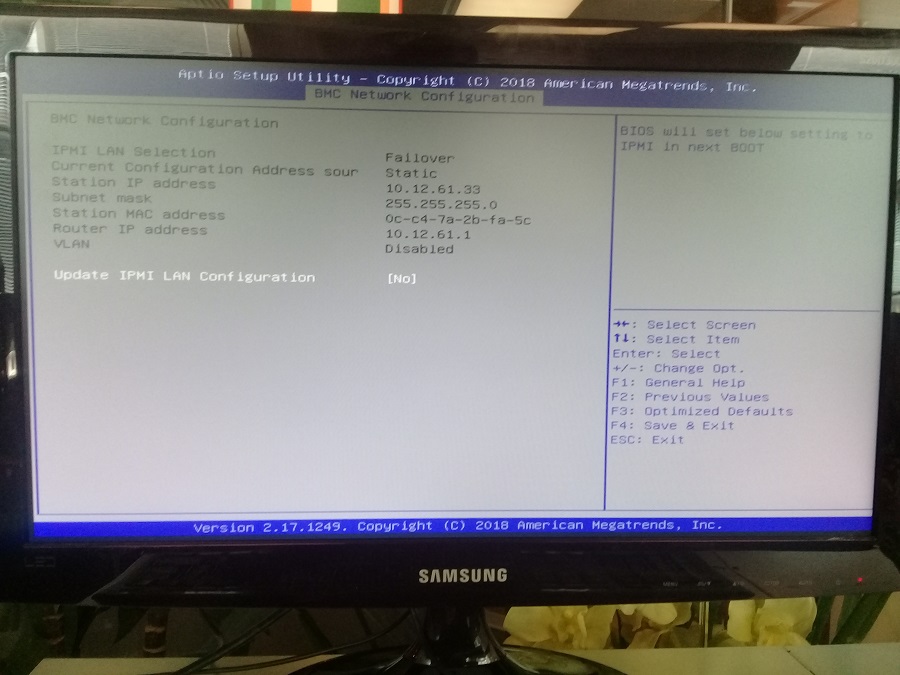

Выбираем Update IPMI LAN Configuration:

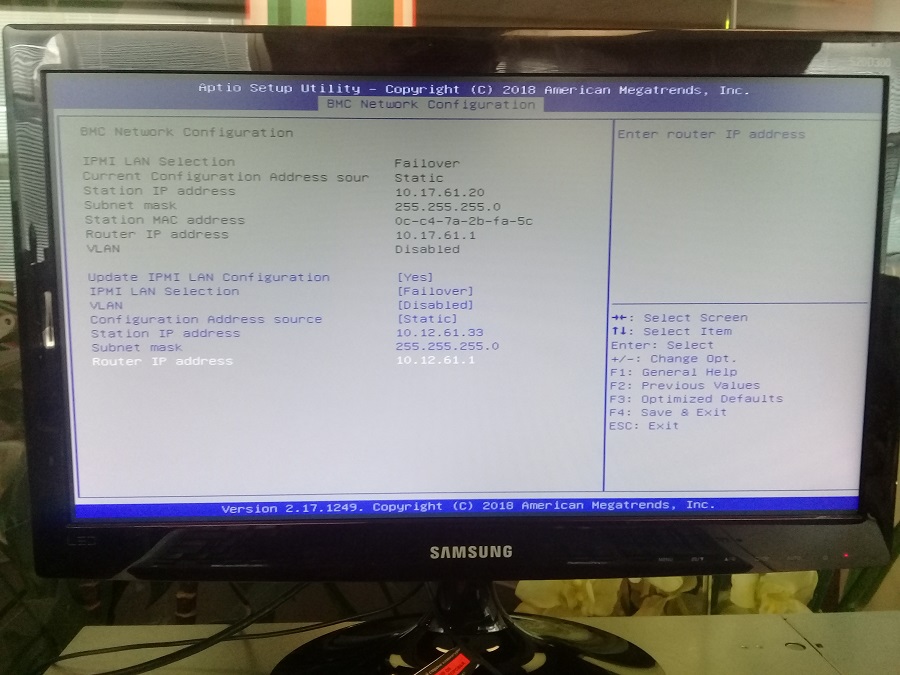

Дальше настраиваем конфигурацию сети:

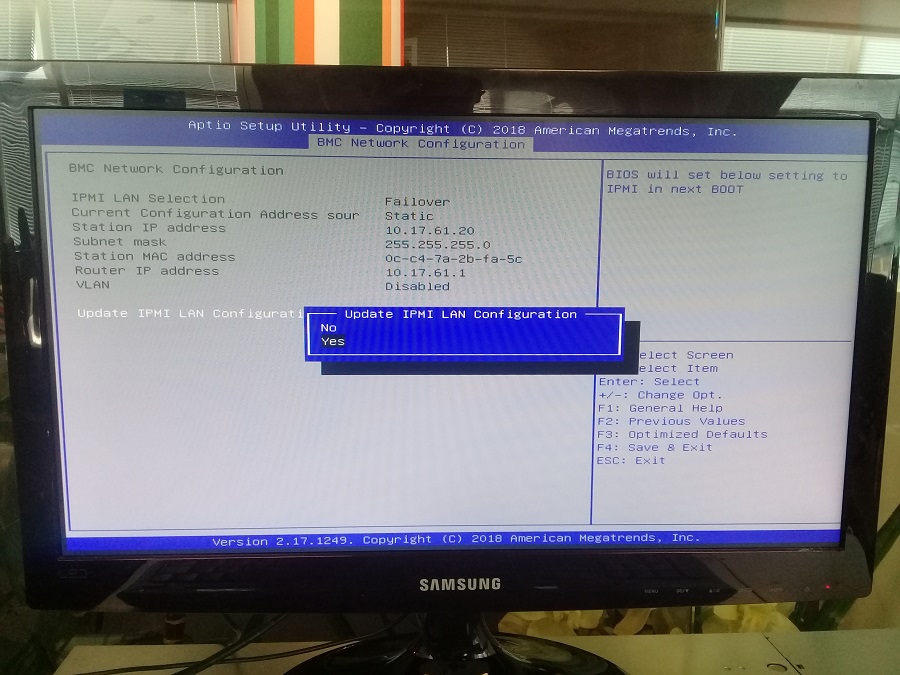

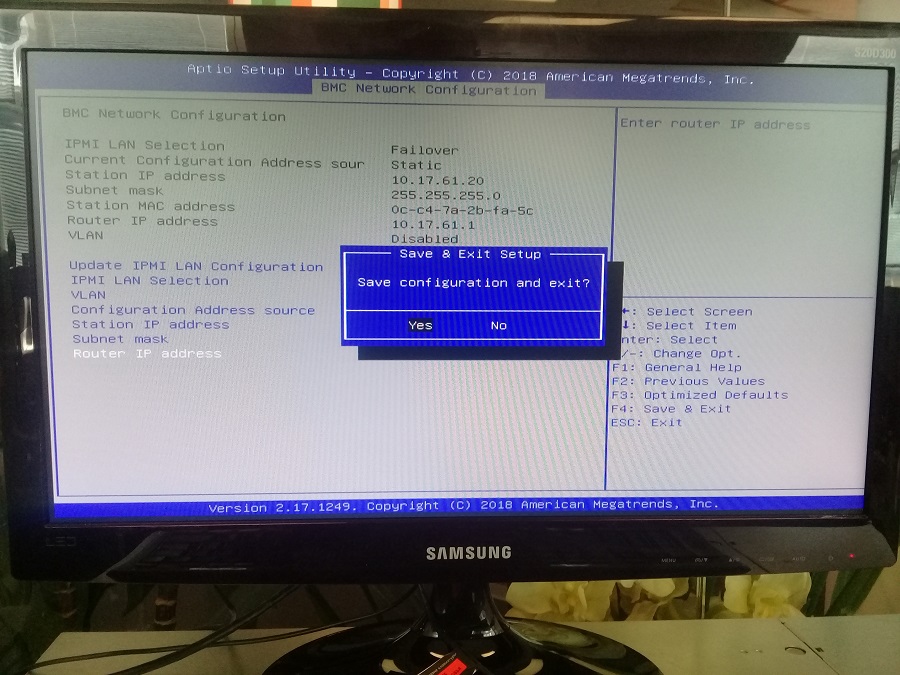

Сохраняем и перезагружаемся:

Вот тут примечание - после первой перезагрузки IP адрес не меняется. Пришлось чуть позже перезагрузиться второй раз:

Вот теперь IP адрес нужный. Теперь можно через IPMI подключиться к консоли сервера, примонтировать ISO образ и установить ОС.

А вот для настройки IPMI на полке понадобятся дополнительные действия. По умолчанию там настроен DHCP - нужно подключить IPMI в сеть с DHCP сервером, поймать выданный IP адрес, зайти по нему на web-интерфейс IPMI и сменить IP адрес и сетевые настройки там. На полке расширения есть кнопка reset, если вы что-то напортачите, мне не пригодилась.

Итак, IP адрес у IPMI есть. Подключаем патчкордом сервер к сетевой карте своего компьютера. Настраиваем на своём компьютере IP адрес из той же подсети, что и IPMI:

Заходим на сервер в IPMI через web-интерфейс:

- Логин Supermicri IPMI по умолчанию ADMIN.

- Пароль для Supermicri IPMI по умолчанию ADMIN.

Регистр имеет значение.

Установка ОС

Запускаем консоль. Remote Control > Console Redirection > Launch Console:

Видим экран сервера:

Монтируем ISO образ.

Virtual Media > Virtual Storage:

Выбираем тип - ISO File:

Затем Open Image:

Кликаем Plug In:

Ok. Ключи можно посмотреть в Hotkey Settings:

Перезагружаем сервер F6 (передаёт Ctrl+Alt+Del):

Загружаемся в ISO образа:

Устанавливаем ОС, это уже вы сами. Как пример: Установка Oracle Linux 7.5

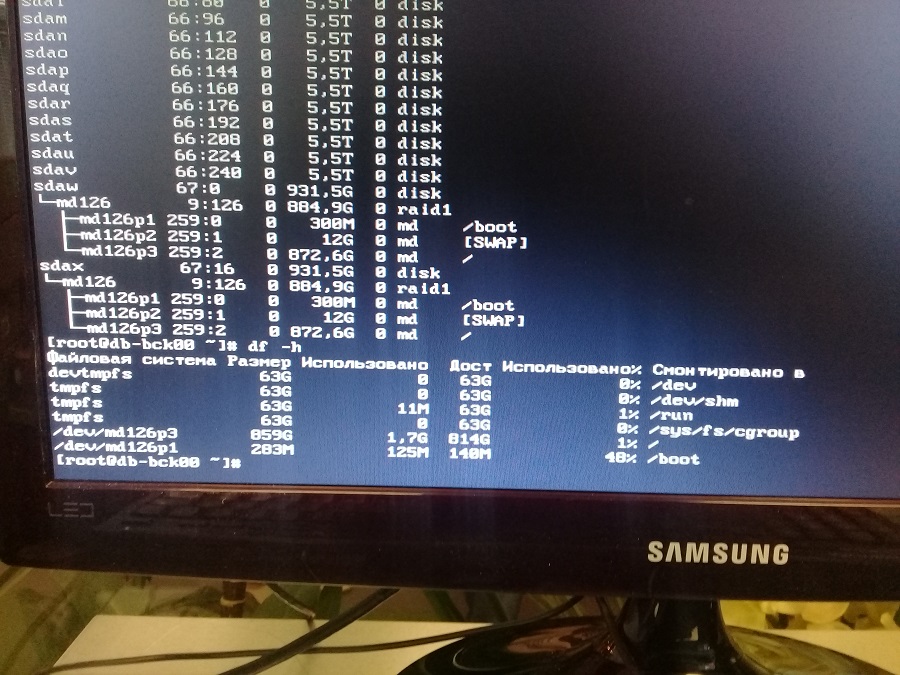

После установки ОС можно загрузиться и увидеть наше зеркало уже в Linux:

ОС успешно установилась на зеркало. Система готова к эксплуатации.

Данная статья писалась два дня. Некоторые её части были выделены в отдельные статьи, могут пригодиться:

В распакованном каталоге присутствует инструкция, как добавить драйвер в образ посредством которого когда снова установим ESXi на флешку, гипервизор посредством имеющихся драйверов на установленный в систему RAID контроллер сможет работать с дисками:

- RAID 1 = 2 по 500Gb

- RAID 1 = 2 по 2Tb

Теперь загружаю виртуальную машину Virtualbox с осью Windows 7 на борту и подготавливаю рабочее окружение для сборки с учетом скачанных драйверов на RAID контроллер:

Для сборки своего образа ESXi потребуется:

Разрешаю запуск PowerShell скриптов:

Пуск — Все программы — Стандартные — Командная строка и через правый клик на ней запускаем «Запуск от имени администратора»

C:\Windows\system32>cd /d C:\Windows\System32\WindowsPowerShell\v1.0

C:\Windows\system32>powershell

PS C:\Windows\System32\WindowsPowerShell\v1.0>set-executionpolicy remotesigned

Устанавливаю в систему пакет: PowerShell 3.0 (Windows6.1-KB2506143-x86), без предыдущего не будет и этого.

Устанавливаю в систему пакет: VMware-PowerCLI-6.0.0-3056836.exe

Устанавливаю в систему пакет: 7zip

На данной рабочей станции потребуется доступ в интернет

- Через общие папки передаю с основной системы на гостевую скачанный файл драйвера и найденный на просторах интернета скрипт: ESXi-Customizer-PS-v2.4.ps1

- md5sum ESXi-Customizer-PS-v2.4.ps1 5af8f83ec08faaed500294b69b920d0a ESXi-Customizer-PS-v2.4.ps1

Пуск — Все программы — Vmware — Vmware vSphere PowerCLI и через правый клик «Запуск от имени администратора»

Создаю папку Driver и помещаю в нее vib файл

PowerCLI C:\> mkdir C:\Drivers

В данную папку помещаю файл драйвера для моего RAID контроллера :

vmware-esxi-drivers-scsi-aacraid-550.5.2.1.40301.-1.5.5.1331820.x86_64.vib

PowerCLI C:\> .\ESXi-Customizer-PS-v2.4.ps1 -obDir .\Drivers -sip -v55

Parameter name: value.Width

+ CategoryInfo : NotSpecified: (:) [], SetValueInvocationException

Script to build a customized ESXi installation ISO or Offline bundle using the VMware PowerCLI ImageBuilder snapin

(Call with -help for instructions)

Running with PowerShell version 3.0 and VMware vSphere PowerCLI 6.0 Release 2 build 3056836

Select Base Imageprofile:

Enter selection: 1

(dated 11/18/2015 20:26:01, AcceptanceLevel: PartnerSupported,

После того, как создастся образ (в моем случае он именуется , как: ESXi-5.5.0-20151204001-standard.iso) копирую его также через «Общие папки» в основную систему Ubuntu 12.04.5 Desktop amd64 и по аналогии как делал по заметке делаю загрузочную флешку.

$ sudo parted /dev/sdb

(parted) mklabel gpt

Предупреждение: Существующая метка диска на /dev/sdb будет уничтожена и все

данные на этом диске будут утеряны. Вы хотите продолжить?

Да/Yes/Нет/No? Yes

(parted) unit GB

(parted) mkpart primary 0.00Gb 4.00Gb

(parted) print

Модель: JetFlash Transcend 4GB (scsi)

Диск /dev/sdb: 3911MB

Размер сектора (логич./физич.): 512B/512B

Таблица разделов: gpt

Номер Начало Конец Размер Файловая система Имя Флаги

1 1049kB 3910MB 3909MB fat16 primary

(parted) quit

Информация: Не забудьте обновить /etc/fstab.

$ sudo mkfs.msdos /dev/sdb1

mkfs.msdos 3.0.12 (29 Oct 2011)

$ sudo mkdir /media/cdrom

$ sudo mount /dev/sdb1 /media/cdrom

$ /usr/bin/unetbootin method=diskimage isofile="/home/aollo/ISO/ESXi-5.5.0-20151204001-standard_Adaptec_6805E.iso" installtype=USB targetdrive=/dev/sdb1 autoinstall=yes

$ sudo umount /dev/sdb1

или же просто без какой либо автоматизации:

Теперь подключаю данную флешку в сервер SuperMicro и произвожу установку гипервизора ESXi на неё же, но вот беда — не идет установка, только появляется надпись:

Mission operation system

Диск /dev/sdb: 3911 МБ, 3911188480 байт

39 головок, 38 секторов/треков, 5154 цилиндров, всего 7639040 секторов

Units = секторы of 1 * 512 = 512 bytes

Размер сектора (логического/физического): 512 байт / 512 байт

I/O size (minimum/optimal): 512 bytes / 512 bytes

Идентификатор диска: 0xf77e43f8

Устр-во Загр Начало Конец Блоки Id Система

/dev/sdb1 1432 7639039 3818804 b W95 FAT32

$ sudo mount /dev/sdb1 /media/cdrom

образ успешно записался и подключив флешку к серверу произвожу установку, но опять результат тот же гипервизор не обнаруживает драйверов на RAID контроллер.

/adaptec/vsphere_esxi_5.5$ mv vmware-esxi-drivers-scsi-aacraid-550.5.2.1.40301.-1.5.5.1331820.x86_64.vib adaptec.vib

/adaptec/vsphere_esxi_5.5$ scp adaptec.vib root@10.7.8.153:/

adaptec.vdi 100% 61KB 60.6KB/s 00:00

Подключаюсь к серверу ESXi с помощью клиента SSH и устанавливаю драйвер, а затем для принятия изменений перезагружаю сервер

$ ssh -l root 10.7.8.153

The time and date of this login have been sent to the system logs.

VMware offers supported, powerful system administration tools. Please

The ESXi Shell can be disabled by an administrative user. See the

vSphere Security documentation for more information.

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: Adaptec_Inc_bootbank_scsi-aacraid_5.5.5.2.1.40301-1OEM.550.0.0.1331820

VIBs Removed: VMware_bootbank_scsi-aacraid_1.1.5.1-9vmw.550.0.0.1331820

Connection to 10.7.8.153 closed.

После того, как сервер перезагрузится подключаюсь к нему с рабочей станции под управлением Windows 7 посредством клиент vSphere Client, проверяю наличие RAID контроллера и он присутствует:

ESXi (10.7.8.153) — Configure — Storage Adapters

Отлично гипервизор видит RAID контроллер, но вот теперь моя задача сводится к форматированию устройств, т. е. Я хочу переделать текущее (уже больше не нужно).

Configuration — Storage — выделяю хранилище, в моем случае оно именуется, как Data и нажимаю в правом углу на Delete, затем подтверждаю свое намерение

Но меня поджидает облом — видители гипервизор использует данные хранилища и удалить не дает:

*** The fdisk command is deprecated: fdisk does not handle GPT partitions. Please use partedUtil

Disk /dev/disks/mpx.vmhba32:C0:T0:L0: 7639040 sectors, 7460K

Disk /dev/disks/mpx.vmhba2:C0:T1:L0: 3900682240 sectors, 3719M

Disk /dev/disks/mpx.vmhba2:C0:T0:L0: 975155200 sectors, 929M

mpx.vmhba2:C0:T0:L0:1 /vmfs/devices/disks/mpx.vmhba2:C0:T0:L0:1 51fa6d03-0a61ea94-5b19-6805ca0a091f 0 System

Хранилище System я отключил

А вот отключить хранилище Data почему-то не могу:

watchdog-storageRM: Terminating watchdog process with PID 34001

ESXi-хост (10.7.8.153) — Configuration — Storage — нажимаю Rescan All

Не помогло, а вот еще проверяя расширенные параметры ESXi хоста наткнулся на вот такой вот параметр и

По найденному описанию на официальном сайте данное значение нужно изменить на /tmp сохранить внесенные изменения и перезагрузить хост

Connection to 10.7.8.153 closed.

После проверяю значение измененного параметра:

ничего не поменялось.

Пробую поменять через консоль:

Затем перевожу хост в режим обслуживания:

vSphere Client — ESXi-(хост) — через правый клик по хосту нахожу параметр Enter Maintenance Mode, подтверждаю свое намерение нажатием кнопки Yes

Connection to 10.7.8.153 closed.

После уже снова подключаюсь через vSphere Client и что самое главное успешно на всех хранилищах, таких как Data & System делаю umount и удаляю.

И только потом можно будет через vSphere Client удалить хранилища имеющее место быть в ранее созданном и используемое на предыдущей версии гипервизора ESXi текущего сервера.. Почему переделываю, дело в том, что той флешки на которой был установлен гипервизор уже много и много лет, да и сервак стал больше не нужным, а разобрать все в шагах по установке надо на всякий случай будет полезно.

Теперь заново создаю хранилища:

На этом моя заметка завершена. Я разобрал как создать свой образ, если не получилось как импортировать модуль в существующий гипервизор и как пересоздать локальные хранилища в основе которых лежат диски на Raid контроллере. До новых встреч, с уважением автор блога — ekzorchik.

ЗЫ За конкретную помощь в долгу не останусь;)

Т.к. тема является архивной.

Т.к. тема является архивной.

есть возможность подоткнуть другой диск ради тестов?Т.к. тема является архивной.

Другой сас диск? нет таких(( может даст кто старенький?)Т.к. тема является архивной.

у меня есть пара штук, которые рэйд выплюнул, fujitsu mbe2147rc. с момента отторжения рэйдом я их не ковырял, могу отдать, всё равно валяются.

Т.к. тема является архивной.

Список дисков можно (всё же) в приват увидеть? Забрал бы за ништяки.Т.к. тема является архивной.

Офф. Яков, а нужны SATA парочка посыпавшихся - какие-то терабайтники - под доноров?Т.к. тема является архивной.

fujitsu mbe2147rc 3шт

сегейты: sv35 st2000vx002 3шт, баракуда st3250310as 1шт

вестены грин wd5000aads 2шт

тошиба mk1665gsx 2шт

макстор stm31000340as 1шт

это что под рукой сейчас, завтра если не забуду ещё подобный список будет

Т.к. тема является архивной.

все по одной штуке

сегейты:

cheetah 15K.5 st373455ss

constellation es st32999644ns

барракуда st2000dm001

барракуда st3500320ns

барракуда st500dm002

макстор YAR41BW0 (это который diamondmax plus 9 80gb ata/133 hdd)

есть ещё вестерн caviar 21200 (mdl: wdac21200), но я из него выковырял магнитики и блины, плата управления на месте, её не трогал. хотя он и целый вероятно не нужен.

наверное больше ни чего пока не предложу.

Т.к. тема является архивной.

Не вижу этих винтов в списке совместимости контроллера. Попробуй другой диск.Т.к. тема является архивной.

А где можно список посмотреть этот?Заявлено что контроллер поддерживает диски 3ТБ

Т.к. тема является архивной.

Т.к. тема является архивной.

Т.к. тема является архивной.

Не обязательно.В список вносят те диски, которые они сами тестировали и гарантируют работу.

Т.к. тема является архивной.

Т.к. тема является архивной.

Т.к. тема является архивной.

Читайте также: