Xeon контроллер памяти где

Обновлено: 04.07.2024

Основные вопросы, на которые нужно ответить при выборе конфигурации памяти DDR3:

1. Нужно получить максимальный объём или максимальную производительность памяти?

2. Какие процессоры будут использоваться?

3. Какое соотношение цена/производительность для нас оптимальна?

Отличия в использовании DDR2 и DDR3

DDR2 и процессоры Intel Xeon 5400

- До 4 DIMM на канал

- Память Fully-buffered DDR2 533/667/800

- Максимальный объем 128Гб

DDR3 и процессоры Intel Xeon 5500

- До 3 DIMM на канал

- Память DDR3 800/1066/1333

- Максимальный объем 144Гб

Варианты конфигурирования

Для оптимального выбора конфигурации DDR3 необходимо четко понимать, что нам важнее производительность или объем. Ниже представлены конфигурации для этих обоих вариантов и сбалансированный вариант.

Максимальная производительность

Для обеспечения максимальной производительности необходимо использовать память DDR3 с частотой 1333MHz и процессоры серии X5550, т.к. только они способны обеспечить необходимую пропускную способность шины QPI (10,6 GB/s). Такая конфигурация накладывает ограничение на максимальный объем памяти в 48GB, т.к. возможно установить только 1 модуль памяти на 1 канал процессора.

Максимальная производительность

Максимальный объем

В этом случае необходима память с частотой 800MHz и любые процессоры серии X5500. Пропускная способность шины QPI при этом будет 6,4GB/s. При этом можно будет установить до 18 модулей памяти, то есть по 3 модуля на канал, и получить объем в 144GB.

Максимальный объем

Сбалансированный

Оптимальный вариант, межу производительностью и объемом. Необходимо использовать память DDR3 с частотой 1066 MHz, процессоры серии E5520 или старше. В такой конфигурации возможна установка по 2 модуля памяти на канал (всего 12 модулей) и получить общий объем памяти 96GB.

Сбалансированный вариант

Типы памяти

Но это не все. Кроме ранжирования по скорости MHz, есть 3 вида памяти DDR3: Registered DIMMs (RDIMM), Unbuffered ECC DIMMs (UDIMM ECC) и Unbuffered DIMMs (UDIMM). Сразу отмечу что Unbuffered DIMMs (UDIMM) не рекомендуется использовать в серверах. Так же модули памяти бывают разных рангов.

Сравнение UDIMM и RDIMM:

Регистр/Буфер

800, 1066, 1333 МГц

800, 1066, 1333 МГц

Количество рангов

Максимальное кол-во модулей на канал

Объем модулей

Четность адреса

Энергопотребление

RDIMMs:: Хотя они на несколько процентов медленнее чем UDIMM, они позволяют получить больший общий объем памяти. Поддерживают до 3 DIMMs/канал.

UDIMM ECC: поддерживает все RAS функции RDIMM кроме x4 Single Device Data Correction (SDDC).

Для систем начального уровня с объемом ОЗУ 12Гб или меньше, целесообразно использовать UDIMM ECC, т.к. у них меньше стоимость. Регистровую память имеет смысл использовать в материнских платах, где по 3 слота на канал (на будущее расширение без выбрасывания старой памяти) или модули по 4ГБ.

Относительная стоимость модулей

Ранги (Single, Dual, Quad)

Не будем детально разбирать вопрос рангов. Остановимся на наиболее важных моментах. Итак, на рисунках наглядно показано основные отличия разноранговой памяти. Технологически, при производстве, дешевле размещать большее чипов на одном модуле, то есть изготавливать память типа quad rank.

Физическое устройство разноранговой памяти

Латентность QR модулей меньше, т.к. в них одновременно может быть открыто несколько страниц. Так же есть ограничение в 8 рангов на канал, т.е в один канал можно поставить только 2 QR модуля (у разных производителей, кол-во поддерживаемых рангов может отличаться в зависимости от модели материнской платы). На данный момент Quad Rank бывают только модули RDIMM.

Еще отмечу момент, что при установки памяти с разным количеством рангов, первыми устанавливаются QR модули, потом DR и SR.

Выбор модулей оптимального объема.

Сейчас рассмотрим, какого объема лучше использовать модули, для получения необходимого объема памяти на ядро. Т.к. это позволит сэкономить деньги, и получить оптимальную производительность.

При использовании RDIMM-ов, возможны следующие конфигурации (при использовании 2х 4х ядерных процессоров Nehalem-EP)

В таблице представлены основные конфигурации памяти. Сначала в первой строке выбираем желаемый объем памяти на 1 ядро.

Во второй строчке указа общий объем памяти, который мы получим.

Далее ниже рассмотрены варианты с разным объемом каждого модуля. Красным выделены оптимальные конфигурации.

При использовании UDIMM-ов ECC (при использовании 2х 4х ядерных процессоров Nehalem-EP)

DDR3 UDIMMs ограничены 2 DIMMs на канал, или в общей сложности 12 DIMMs.

Принцип выбора тот же что и при RDIMM.

Баланс памяти по каналам в конфигурации

В таблицах есть не сбалансированные конфигурации. Не сбалансированной конфигурация считается, если не используются все 3 канала памяти на процессор или число модулей не кратно 3 модулям на процессор. Конфигурация, когда используется два канала из трех, можно считать сбалансированной, т.к. interleave работает, но только на 2 канала.

Так же возможна конфигурация, когда вся память находиться у одного процессора. Она возможна при использовании Non-Uniform Memory Access (NUMA).

Сбалансированная конфигурация: задействовано больше каналов, выше пропускная способность памяти.

Несбалансированная конфигурация: уменьшенная пропускная способность (до 17%)

Пропускная способность памяти. Сравнение сбалансированной и не сбалансированной конфигурации (DDR3 1066).

Разница в скорости на разных конфигурациях

Очень хорошо видна разница в пропускной способности памяти в разных режимах:

C момента появления процессоров на ядре Nehalem, одним из их преимуществ все считали интегрированный трехканальный контроллер памяти. Не просто интегрированный контроллер памяти (ИКП сокращенно), а именно трехканальный. Понятно, чем это «круто» — все-таки одноканальные и двухканальные контроллеры памяти у AMD были еще за пять лет до этого, так что дополнительный канал, да еще и наиболее скоростной на данный момент памяти типа DDR3, выглядел весьма серьезным преимуществом. По мнению многих пользователей, также и одним основных факторов, которым процессоры линейки Core i7 обязаны своей высокой производительностью. Стоит заметить, что сама компания Intel это мнение никак не опровергала, за что и немного поплатилась — по-настоящему массовые процессоры архитектуры Nehalem, которые будут выпущены в начале осени, рассчитаны на конструктив LGA1156, предполагающий использование лишь двух каналов памяти. Казалось бы, серьезный недостаток новых моделей, который неспособен будет позволить им конкурировать со старшими братьями. Но так ли это?

В обзорах материнских плат мы уже пробовали оценить полезность многоканального режима памяти в процессорах под LGA1366, и результаты оказались, мягко говоря, неутешительными. Для режимов, разумеется, а не для пользователей. Однако проверки проводились на весьма ограниченном количестве приложений, так что окончательного ответа на вопрос, нужен ли трехканальный режим на практике, они не давали. Сейчас мы решили восполнить этот пробел. Точнее, сначала просто возникло желание опробовать не трех-, а двухканальный режим, для последующего более корректного сравнения производительности Core i7 900-й и 800-й серий: чтобы потом не строить гипотез о том, что сильнее всего повлияло на результаты (если они, действительно, окажутся существенно различными). Однако просто «прогнать» тесты из последней версии нашей методики в еще одной конфигурации - слишком скучно, да и из такого противостояния всего двух вариантов хорошей статьи получиться не может, поэтому мы немного усложнили задачу.

Конфигурация тестовых стендов

Получилось четырех конфигурации, представленные в таблице:

Подробные результаты всех подтестов, как обычно, представлены в таблице, в формате Excel. Заметим, что в сегодняшнем тестировании они будут иногда даже более интересными, чем общие усредненные показатели по группам, так что тем, кому интересна детальная информация, не стоит отказывать себе в удовольствии с ними познакомиться.

Пристрелка

Но для начала мы решили проверить производительность каждого из вариантов в синтетическом приложении, в роли которого сегодня выступал Everest 4.6 (да, это далеко не последняя версия популярного тестового пакета, однако и «реальный» софт обновляется далеко не мгновенно, так что эти результаты нам весьма интересны даже если предположить слабую оптимизированность 4.6 под Nehalem).

И первые же результаты несколько обескураживают — как мы видим, никакого видимого прироста от задействования третьего канала ИКП нет. Более того — три модуля от Apacer справляются с этой задачей медленнее, чем два от Kingston. В то же время одноканальный режим — явный аутсайдер. Теоретическая ПСП DDR3 1066 составляет 8528 МБ/с, во что мы и уперлись — это понятно. Но добавление еще одного канала увеличивает скорость чтения далеко не в два, а менее чем в полтора раза, а третий вообще ничего не дает.

Со скоростью записи все еще веселее — одноканальный режим честно уперся в теоретическую ПСП, а увеличение количества каналов дало лишь менее 20% во всех случаях.

И, наконец, задержки доступа. Очевидный лидер здесь — двухканальный режим (напомним, что на этой диаграмме чем меньше цифры, тем лучше), хотя и одноканальный доступ дело не сильно ухудшает, но в трехканальном режиме задержки сравнительно сильно возрастают: на четверть.

Уже можно делать определенные выводы. Как мы помним из поведения других архитектур с ИКП (AMD K8/K10), они наиболее восприимчивы именно к задержкам при доступе к памяти, что очень заметно в реальных приложениях. Вряд ли Nehalem будет вести себя строго наоборот. Причем все это на фоне одинаковых скоростей чтения и записи, то есть двухканальный режим должен стать лидером. Одноканальный — уже не факт, что будет слишком быстрым: задержки меньше, но и ПСП гораздо ниже, а это не может не сказаться. Насколько сильно — мы и проверим. И попутно посмотрим, как разные приложения относятся к разному полному объему памяти: синтетические бенчмарки никакой информации по этому поводу дать не могут.

3D-визуализация

В аутсайдерах оказались обе трехканальных конфигурации, из чего можно сделать вывод, что главное для этой группы приложений — задержки доступа. Но эти два варианта ведут себя по-разному, а изучение подробных результатов тестов показывает достаточно пеструю картину, из чего можно сделать вывод, что некоторым приложениям уже недостаточно не только трех, но и четырех гигабайт памяти.

Рендеринг трёхмерных сцен

Рендеринг вообще мало восприимчив к характеристикам системы памяти, что можно было предполагать и изначально — здесь главное именно «числодробительные» способности вычислительных ядер и их количество (да и «виртуальные» потоки вычисления тоже воспринимаются положительно). Причем и к объему памяти требований особых нет — лишь бы ее хватало для просчитываемой сцены и накладных расходов. Для наших тестов вполне достаточно 3 ГБ, что и демонстрирует нам диаграмма выше.

Научные и инженерные расчёты

А в этой группе появляется еще один класс приложений, в дополнение к тем, кому нужно как можно больше памяти и кому объем не важен — те, кто начинает в зависимости от увеличения ОЗУ работать медленнее. На первый взгляд, ситуация необъяснимая — если скорость падает от нехватки памяти, это понять легко, но избыток просто никто не должен «заметить». С другой стороны — а почему не должен? Эффективность кэширования вполне может зависеть от объема ОЗУ и даже должна от него зависеть. Если конкретное приложение использует лишь небольшой объем памяти, причем постоянный, ему будет «доставаться» разный объем кэш-памяти процессора. Например, при шести установленных гигабайтах лишь половина из 8 МБ кэша L3 будет отведена для данных программы «переднего плана» (не забываем, что в оставшейся памяти тоже может кто-то «жить», пусть и не очень активно, но на кэш при этом претендовать), а при трех их обслуживанием будут заниматься уже 2/3 от 8 МБ. Любопытный эффект, конечно, жаль только несколько в стороне от основной темы нашего исследования лежащий. С ней все, как обычно — в среднем, самым быстрым оказывается двухканальный режим, а из двух вариантов трехканального, несмотря на наличие упомянутых выше приложений-ренегатов, производительнее тот, где суммарный объем памяти выше.

Растровая графика

В основном, все понятно, поскольку среди растровых редакторов нам встречаются все три уже определенных «группы» приложений. Хотя и с некоторыми вариациями — так, например, обоим продуктам Corel все равно, сколько памяти и какой — 3 или 4 ГБ неважно, но лишь бы не 6. Но обнаружилось просто очень «памятелюбивое» приложение - Adobe Photoshop. Причем тут очень интересен не общий результат подтестов, а некоторые из них в отдельности. Точнее, один — Convert. И настолько интересен, что продублируем в статье соответствующий кусок таблицы с «сырыми» данными.

Вывод? Несмотря на то, что большинство обзоров в сети, где сравниваются процессоры разных архитектур в этом приложении (в меньшинстве обзоров теста по Photoshop просто нет, так что можно даже сказать, что во всех статьях такого рода), утверждается, что Core i7 просто идеальный процессор для Photoshop, как мы видим, ничего особо выдающегося в нем нет. Идеальным тут является не архитектура ядра, а количество памяти. При 6 ГБ Core i7 920 вдвое обгоняет Core 2 Quad Q9300, обеспеченный всего 4 ГБ. Именно такие сравнения в большинстве статей и встречаются (в том числе и на нашем сайте, но и прочие ресурсы ведут себя аналогично): 3х2 для процессоров под LGA1366 и 2х2 для Core2, AMD Phenom и т.п. Но если мы ограничим первый из процессоров теми же 4 ГБ (причем неважно, каким образом набранными), то выясняется… что отличие от Core 2 Quad вполне укладывается в допустимое, с точки зрения разницы в тактовой частоте. А если мы «отберем» у Core i7 еще всего один гигабайт памяти (казалось бы — 3 или 4: невелика разница), то результат ухудшится еще вдвое! Это наиболее показательный пример, однако и другие подтесты ведут себя сходным образом, хоть микроскопическую, но разницу находят всегда. И ничего не поделаешь — Photoshop действительно память «любит», причем чем больше «весят» обрабатываемые в нем файлы, тем больше «любит», а все утилиты тестирования производительности в данном приложении (а не только наши самописные тесты), естественно, оперируют именно большими файлами.

Впрочем, нельзя сказать, что в высоких результатах совсем нет заслуги самого Core i7, а только преференции от большого количества памяти. Трехканальный ИКП как раз и позволяет установить больше памяти при прочих равных условиях. Но об этом подробно мы поговорим чуть позже.

Сжатие данных

Программы-архиваторы не умеют использовать слишком большой объем памяти, поэтому им он просто вредит — к доступной емкости кэш-памяти они очень восприимчивы. К задержкам основного ОЗУ еще более восприимчивы, поэтому и имеем такую картину — самой медленной конфигурацией является 3х2, а выйти на первое место 3х1 мешает латентность.

Компиляция (VC++)

Компилируемый нами проект большого количества памяти не требует, так что важны задержки, а также немного скорости чтения и записи. Поэтому двухканальный режим доступа к памяти здесь оказался лучшим, но одноканальный лишь чуть-чуть выиграл у трехканальных — латентность ниже, но и прочие параметры тоже.

Тест Java-машины оказался очень восприимчив к скорости чтения из памяти, но и ее общий объем ему достаточно важен. Именно такую картину можно было бы ожидать везде, если бы верны были наивные предположения о том, что трехканальный доступ к памяти является залогом высокой производительности, но памяти при этом много не бывает. Жаль только, что среди протестированных приложений эти мечты подтверждены буквально пару-тройку раз. Но, как раз, пример, когда подтверждены.

Кодирование аудио

Прекрасная задача — требования к системе памяти, можно сказать, отсутствуют. При рендеринге они тоже почти отсутствовали, а здесь — совсем отсутствуют. Идеальный бенчмарк процессоров, правда, отвратительный для тестирования системы в целом.

Кодирование видео

А вот тут все почти так, как должно быть в «наивной теории». Портит картинку только недостаточно заметный проигрыш двухканального режима. Точнее, будет сказать, почти незаметный. Да и тому, что он вообще есть, мы обязаны ровно одному приложению — DivX. Пример хорошей оптимизации под все особенности сегодняшние Core i7. Как он поведет себя на «завтрашних» будем проверять уже менее чем через месяц.

Игровое 3D

Очень, очень спокойная немного непонятная общая картина. Однако под внешним спокойствием в детальных результатах таится настоящая буря. Пристрастия игр сильно разделились, а у каких как — оставим в качестве задачи для самостоятельного изучения. Главный вывод — для игр (именно как множества, а не для одной конкретной игры) вопрос конфигурации памяти не является каким-то важным. В общем-то, решать его даже менее необходимо, чем вопрос выбора центрального процессора (разумеется, если речь не идет о совсем уж бюджетном секторе, типа Core 2 Duo или вообще Pentium/Celeron). Главным же вопросом, стоящим перед «хардкорным» геймером сегодня, будет: «Потяну на multi-GPU или придется свои желания как-то ограничивать?»

А зачем вообще нужен трехканальный ИКП?

Как мы видим, большой пользы от задействования третьего канала контроллера памяти в Core i7 LGA1366 нет. Канал — есть, использовать — можно, но результаты далеко не всегда улучшаются. Чаще даже, наоборот, ухудшаются. Так зачем компания Intel делала ИКП именно трехканальным? Из желания поиграть мускулами (у конкурента два, а мы все три сделаем)? Возможно, такой соблазн тоже был, но вряд ли — все-таки три канала даются достаточно высокой ценой. Причем в прямо смысле: разводка плат становится очень сложной, а сложно — значит дорого. Процессоры можно делать и недорогими (и использованный нами сегодня Core i7 920 тому яркий пример — его розничная цена как Core 2 Quad Q9650), но сама платформа оказывается дороговатой. Причем без особой пользы — для большинства «типично пользовательских» приложений сейчас легко можно ограничиться двумя модулями по 2 ГБ и не волноваться (особенно если учесть процент до сих пор использующих 32-х разрядные операционные системы, где больший объем ОЗУ просто не будет использоваться). Как было сказано в хорошем анекдоте про верблюжонка и его маму: «А зачем нам эти навороты, если мы все равно живем в зоопарке?»

В том-то и дело, что нынешние Core i7, по сути, в зоопарке и живут. Наилучшим образом под него будут приспособлены «настоящие» настольные модели, рассчитанные под исполнение LGA1156, главным (да и вообще — единственным) отличием которого от LGA1366 является поддержка «всего-навсего» двухканального режима памяти. А LGA1366 — платформа изначально серверная. В серверах нужно много памяти. Ни 4, ни 8 и даже ни 12 ГБ, а действительно много. Там и полсотни гигабайт легко могут оказаться востребованными, а то и недостаточными. Как же можно установить больше памяти в одну систему? Общий объем равен произведению количества модулей на их объем. Стало быть, нужно увеличивать либо количество, либо емкость каждого модуля. Второе — сложно и от производителей процессоров/чипсетов, вообще говоря, не зависит. Более того — освоение индустрией более «плотных» микросхем памяти благотворно сказывается на всех производителях серверных платформ одновременно, так что не может стать конкурентным преимуществом.

Значит, надо увеличивать количество поддерживаемых модулей. А оно равно (в общем случае) количеству контроллеров памяти, умноженных на количество поддерживаемых каждым модулей. Последнее — произведение числа поддерживаемых каналов на число одновременно работающих на каждом канале модулей. Увеличивать последнее — очень сложная задача, поскольку одновременно нужно и скоростные характеристики не ухудшать, как минимум. Эта проблема даже в настольных системах проявляется, где больше двух-трех модулей на канал не используется. Например, может быть так: один модуль — DDR3 1333, два — DDR3 1066, три — DDR3 800. Очень много медленной памяти, конечно, иногда лучше, чем мало быстрой, но идти на такие издержки все равно нежелательно. А иногда и невозможно.

Над проблемой увеличения количества поддерживаемых одним каналом контроллера модулей памяти в Intel работали долго и небезуспешно. Однако оказалось, что конечный результат (FB-DIMM) изначально поставленным требованиям удовлетворяет, но его использование вызывает массу нежелательных побочных эффектов.

Остается только один путь — во-первых, перенести контроллер памяти в процессор, что в многопроцессорной системе автоматически обеспечивает нам поддержку и нескольких контроллеров памяти. Во-вторых, увеличивать количество каналов памяти. И то, и другое было сделано. Результат? В системе на двух Xeon, равно как и в системе на двух Opteron, есть два контроллера памяти. Только в первой оба трехканальные, а во второй — двухканальные, что дает нам шесть и четыре канала памяти, соответственно. При установке двух модулей памяти на канал (очень даже щадящий режим) в первой системе их окажется 12, а во второй — 8. Допустим, каждый модуль имеет емкость 4 ГБ, тогда в первой системе окажется 48 ГБ, а во второй — 32 ГБ. В ряде задач это сразу обеспечит первой системе весомое преимущество. А как в сервере на Оптеронах теми же модулями «добить» память до 48 ГБ? Легко — устанавливаем три модуля на канал и… вся система памяти начинает работать медленнее, поскольку, например, задержки придется сильно увеличить. И получается: при одинаковой скорости работы памяти система «и» имеет в полтора раза больший ее объем, чем система «а», а при равном объеме система «и» работает с памятью быстрее, чем система «а».

Именно поэтому в Xeon трехканальный контроллер памяти нужен. Он и в Opteron нужен, но не удалось в свое время сделать. Точно так же, как сейчас Intel не удалось четыре канала реализовать. Все равно по этому пути идти обоим производителям, поскольку альтернативным (а именно FB-DIMM и количество модулей на канале увеличивать) один из них уже идти пробовал и остался не очень довольным.

А зачем все это в зоопарке, на рабочем столе обычного пользователя? Правильно — незачем. Кому нужно — те многопроцессорную рабочую станцию купят и сведут задачу к предыдущей. Основная масса как-то желанием не горела и по 8 ГБ в компьютеры устанавливать (хотя это-то давно доступно), так что ей нет разницы — можно поставить 12 или как. Тем более что сейчас уже при двух модулях на канал двухканального контроллера памяти можно получить и 16 ГБ, а вопрос — насколько это хуже/лучше, чем 24 ГБ, для нормального пользователя компьютера сродни вопросу, сколько ангелов поместятся на кончике иглы.

Итого

При взгляде на итоговую диаграмму, возникает закономерный вопрос — а зачем мы всем этим занимались? Ведь видно, что к финишу практически все пришли одновременно. Гипотетический одноканальный режим свою относительную бессмысленность показал, двухканальный — как и можно было предположить из тестов в синтетике, оказался самым быстрым. Разброс в 2% между лучшим и худшим случаями на таком представительном количестве приложений — очень хороший результат. Показывает, что, как бы то ни было, но в основном наша текущая методика тестирования продолжает оставаться методикой тестирования процессоров, и на общий итоговый балл прочие характеристики системы влияют весьма слабо.

Но! Успокаиваться на этом рано — как мы видим, в общем зачете получилась идиллия именно из-за того, что разные приложения друг друга уравновешивают, однако ведут себя они совершенно по-разному. Кому-то нужно много памяти, кому-то ее увеличение наоборот — мешает, кому-то не важен объем, но жизненно важны низкие задержки, но DivX, по сути, «презрел» все объективно существующие параметры памяти и отдал предпочтение трехканальному режиму в любом виде. Поэтому, при сравнении систем с разными конфигурациями памяти в рамках одной статьи (или самостоятельно), в конкретных тестах не стоит забывать поинтересоваться — как именно получен тот или иной результат. Впрочем, не так уж долго осталось нам возиться именно с разными конфигурациями — LGA1156, напомним, поддерживает только два канала памяти, так что с этими процессорами все будет просто и логично. Устройства в конструктиве LGA1366 мы продолжим тестировать в конфигурации 3х2, однако иногда будем извлекать из запасников и 2х2 (когда нежелательно будет делать поправки в уме на особенности системы памяти). Можно было бы даже полностью перейти на последние, но нет смысла — в среднем, они, конечно, несколько быстрее, но поддержка трех каналов памяти эксклюзивная особенность LGA1366, так что пусть за нее отдувается. Нам просто достаточно помнить, что трехканальный доступ к памяти на этой платформе производительность совсем не увеличивает, а даже наоборот.

Привет, GT! В 2017 году на рынке процессоров для серверов произошло много интересного. Пожалуй, самым знаменательным событием стала презентация новых серверных процессоров Intel Xeon Scalable, а также связанной с ними платформы Purley. И сегодня мы расскажем о том, как эти новинки работают с памятью, чем отличаются от своих предшественников и какие модули лучше с ними использовать.

По данным IDC, Intel принадлежит более 90% рынка серверных процессоров, но в текущем году AMD представила новые мощные процессоры EPYC. Лидеры не остались в долгу и летом показали всему миру платформу Purley, которая отличается от предыдущих решений, а также от продуктов конкурентов новой схемой работы с памятью.

Пожалуй, самой важной особенностью Purley является именно архитектура. Производитель представил одновременно процессоры Intel Xeon Scalable со встроенными контроллерами и специальными оптимизаторами, а также SSD-компоненты Intel Optane и чипсеты Intel Xeon Phi. При условии установки высокопроизводительной памяти DRAM, все это будет работать с максимальной скоростью, открывая новые возможности для «облачных вычислений, виртуализации, телекоммуникационных сетей нового поколения (5G), машинного обучения и искусственного интеллекта».

Сами процессоры Intel Xeon Scalable отличаются намного более высокой производительностью, чем предыдущее поколение. По данным Intel, рост составляет порядка 65%. Это касается топовых процессоров Intel Xeon Scalable Platinum, которые могут содержать до 28 ядер на кристалле (бывают версии с меньшим количеством), работающих на частоте до 2,4 ГГц. За счет новых технологий передачи данных между процессорами и вычислительными ядрами новинки позволяют выполнять плохо распараллеливаемые задачи, когда вы не можете заранее предсказать, какая информация потребуется в следующий момент. Давайте разберемся с тем, как новая платформа работает с данными.

Новая иерархия памяти

Помимо наличия 6-канального контроллера памяти DDR4, процессоры Intel Xeon Scalable могут работать и напрямую с SSD-накопителями Intel Optane. Благодаря специальным оптимизациям, подключаясь через интерфейс PCIe 3.0 они фактически создают новый уровень оперативного хранения данных, обеспечивая процессорам доступ к обширному полю памяти. Процессоры поддерживают до 48 интерфейсов PCIe на плате, что позволяет устанавливать дополнительные накопители Intel Optane в достаточно большом количестве. Скорость передачи данных по шине PCIe составляет 8 гигатранзакций в секунду (что эквивалентно 32 Гбит/с), и Optane могут работать со скоростью порядка 2 Гбит/с на каждый накопитель.

По данным Intel, при установке 6 накопителей Intel Optane и использовании Intel SPDK можно добиться снижения времени отклика до 40 раз, а также увеличения IOPS (количества операций ввода-вывода) до 5,2 раз и снижения задержек до 3,3 раз по сравнению с работой на традиционных накопителях. Это происходит за счет ускорения доступа к информации и Tier-инга размещения данных на различных накопителях.

Сколько при этом система получает памяти? Давайте посчитаем: каждый процессор Intel Xeon Scalable поддерживает 6 каналов памяти по 2 модуля в каждом. Таким образом, можно установить 12*128 ГБ=1,5 ТБ ОЗУ. Дополнив их 6 SSD емкостью 512 ГБ, можно получить 1,5+3=4,5 ТБ высокоскоростной памяти для КАЖДОГО процессора. Более того, использование технологии Intel Memory Drive Technology (MDT) позволяет создать программно-определяемое хранилище памяти для каждого конкретного сервера. Специальный драйвер загружается до ОС и объединяет в единое двухуровневое хранилище всю оперативную память и накопители. В результате операционная система получает готовое хранилище памяти с автоматизированным распределением данных по «быстрым» и «медленным» сегментам.

Это действительно невероятный результат, учитывая, что в каждый сервер можно установить достаточно много емких, но более медленных дисков для статического хранения дата-сетов. Например, 10 дисков SATA емкостью 2 ТБ каждый могут добавить 20 ТБ «медленного» хранилища, для достижения более высокой скорости выбор можно сделать в пользу SSD-накопителей. Процессоры Intel Xeon Scalable обладают встроенным модулем VMD (Virtual Management Device), который самостоятельно создает RAID-массивы из подключенных через PCIe и SATA дисков, поддерживая «горячую замену» выходящих из строя компонентов, а также напрямую взаимодействует с сетевым контроллером для ускорения работы с данными во всем вычислительном кластере.

Кеш и специальный доступ к памяти

Теперь давайте вернемся к самому процессору. Архитектура SkyLake меняет структуру самой кэш-памяти. Кэш L1 находится внутри ядра, рядом с каждым ядром размещается «добавка» к кэшу L2 в 768 КБ, которая позволяет ему достичь 1 МБ. А кэш L3, из которого каждое ядро может получать данные напрямую, расположен в отдельном слое кристалла и составляет 39 Мбайт – то есть 1,375 Мбайт на ядро. Этот кэш неинклюзивный – данные поступают из памяти непосредственно в L2, а уже ненужные или общие для нескольких ядер строки данных вытесняются в кэш L3.

Как вы можете видеть на представленной выше схеме, межъядерное взаимодействие происходит не по кольцевой шине, как это было в предыдущем поколении процессоров, а согласно архитектуре Mesh. Она ускоряет обмен информацией и качественно улучшает работу новых чипов при высоких нагрузках, характерных для задач виртуализации и сложных аналитических систем, особенно когда запросы ядер к памяти практически невозможно предсказать.

Кстати, такая же архитектура используется для обмена данными между процессорами в многопроцессорном сервере. Благодаря шине OmniPath «общение» чипов между собой происходит намного быстрее, а архитектура Remote Direct Memory Access позволяет получить доступ напрямую к «чужим» ячейкам памяти, минуя уровень ОС. Таким образом, вычислительные ядра могут работать с данными, находящимися в поле памяти другого процессора или даже другого узла вычислительного кластера.

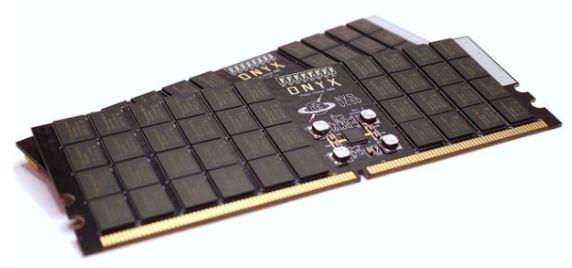

И снова все дело в памяти!

Иерархия кэша, а также технологии доступа к данным, хранящимся в ОЗУ других процессоров, в том числе по сети, делают большое и доступное поле оперативной памяти одним из основных преимуществ новой платформы Intel. И если традиционные накопители, подключенные через интерфейс SATA, можно заменять в режиме hot swap, то оперативную память необходимо изначально выбирать максимально надежную и стабильную. В облачных ЦОД и в тяжелых аналитических системах, оперативная память играет ключевую роль, и у Kingston уже есть предложение, созданное специально для новых процессоров.

Платформа Purley позволяет устанавливать регистровые модули памяти RDIMM или модули со сниженной нагрузкой LRDIMM, либо 3DS LRDIMM для достижения энергоэффективности. С появлением новых платформ Intel и AMD, Kingston сертифицировала свои модули памяти для инновационных серверных платформ.

Кстати, обратите внимание, что для линейки серверной памяти Kingston теперь используется маркировка KSM (Kingston Server Memory), а не KVR, KCP, KTH, KTD, KTL, KCS – или как-то еще. Пока это касается модулей со скоростью 2666 МГц, но все новые брендовые модули серверной памяти Kingston будут иметь маркировку KSM, в том числе работающие на более высоких частотах, выпуск которых запланирован уже в 2018 году. Однако в случае с Xeon Scalable это пока не имеет значения, так как встроенный контроллер памяти у топовых Intel Xeon Scalable работает на частоте 2666 МГц и более быстрая память в Purley попросту не нужна. А для реальных задач и вовсе не всегда нужны именно самые дорогие чипы. В большинстве случаев вполне можно обойтись процессорами Gold 51xx, Silver 41хх и Bronze 31хх на той же архитектуре, которые поддерживают частоты памяти 2400 МГц и 2133 МГц.

Как вы можете видеть, при разумном подходе можно сэкономить и на памяти, благо Kingston, разумеется, предлагает продукты с любыми частотами из вышеприведенной схемы. Достаточно определить спектр задач, которые будет выполнять сервер, и установить в него память, соответствующую возможностям процессора. Например, в серию Bronze 31xx нет смысла покупать даже DDR4-2400 МГц, так как процессор не будет использовать ее возможности.

Заказ памяти нового поколения – модулей KSM – стал заметно проще. Нет больше никаких различий маркировок. Если вы покупали память Kingston для серверов, то прекрасно знаете, что раньше у нас было два вида серверной памяти – Server Premier и Value RAM. Вся память KSM обладает свойствами Server Premier, при том, что цена модулей была снижена по отношению к премиальной серии. К тому же, если раньше нужно было проверять, есть ли в маркировке памяти суффикс «i» (говорящий о сертификации Intel), теперь о нем можно забыть – вся серия KSM изначально проходит сертификацию. Поэтому новинки будет проще выбирать как сборщикам, так и пользователям серверных систем.

Все модули KSM используют фиксированный BOM (Bill of Materials). Это значит, что специалисты Kingston тщательно выбирают производителей самих микросхем и допускают в серию только самые качественные продукты. Инженеры проводят тестирование каждой ячейки памяти на этапе производственного контроля, а также проверяют сами печатные платы. Мы контролируем все, вплоть до ревизии чипов и производителя регистрового чипа. Таким образом, модули серии KSM представляют собой самую тщательно контролируемую серию памяти Kingston для профессиональных задач.

Вся информация о памяти теперь легко читается в ее парт-номере. Например, если вы прочитаете следующий номер на модуле:

То это будет значить, что производитель чипа H – Hynix, ревизия чипа – А, а производитель регистрового чипа – IDT. Кстати, производителями регистровых чипов могут быть разные компании. Кроме IDT (I) также используются компоненты от Rambus, известная ранее как Inphi ® и Montage (M).

Вообще более прозрачная маркировка не только отражает более целостный подход Kingston к Выпуску серверной памяти, но также поможет производить апгрейды модулей, контролируя все параметры, вплоть до производителя чипов. Это позволит избежать возможных конфликтов или снижения производительности оборудования из-за неполной совместимости, а также закупать однотипные модули для нескольких видов серверов, упрощая логистику и обслуживание систем.

Заключение

Подведем небольшой итог. Чтобы получить полную отдачу от новой платформы, необходимо тщательно подобрать все компоненты и использовать все средства оптимизации Intel, которые помогают использовать преимущества новых процессоров и платформы Purley в целом. Преимуществами памяти Kingston для серверов уже сегодня пользуются ведущие хостинговые компании, и если вы установите максимально производительные и надежные модули, переход на Intel Xeon Scalable даст максимально возможный эффект для решения тяжелых задач – от виртуализации до аналитики и моделирования.

Подписывайтесь и оставайтесь с нами — будет интересно!

Для получения дополнительной информации о продукции Kingston и HyperX обращайтесь на официальный сайт компании.

Широка страна наша родная, поэтому подготовили акции сразу в нескольких сетевых магазинах-партнеров – у каждого должна быть возможность получить аксессуары HyperX как можно ближе к дому и как можно быстрее. До 12 января можно приобрести периферию с максимальными скидками.

• скидка 1000 рублей — на гарнитуру HyperX Cloud Stinger

• скидка 2000 рублей — на клавиатуру HyperX Alloy FPS с переключателями Cherry MX (на выбор Brown/Blue/Red)

• скидка 1000 рублей — на гарнитуру HyperX Cloud Silver

• скидка 700 рублей — на мышь HyperX Pulsefire FPS

Intel® Xeon® Processor X5270 x2 (6M Cache, 3.50 GHz, 1333 MHz FSB) Launched Q3'08 80 W

Intel® Xeon® Processor L5430 x4 (12M Cache, 2.66 GHz, 1333 MHz FSB) End of Life Q3'08 50 W

Intel® Xeon® Processor X5470 x4 (12M Cache, 3.33 GHz, 1333 MHz FSB) End of Life Q3'08 120 W

Intel® Xeon® Processor X5492 (12M Cache, 3.40 GHz, 1600 MHz FSB) End of Life Q3'08 150 W

Intel® Xeon® Processor L5240 (6M Cache, 3.00 GHz, 1333 MHz FSB) Launched Q2'08 40 W

Intel® Xeon® Processor L5408 x4 (12M Cache, 2.13 GHz, 1066 MHz FSB) Launched Q1'08 40 W

Intel® Xeon® Processor E5240 x2 (6M Cache, 3.00 GHz, 1333 MHz FSB) Launched Q1'08 65 W

Intel® Xeon® Processor E5220 x2 (6M Cache, 2.33 GHz, 1333 MHz FSB) Launched Q1'08 65 W

Intel® Xeon® Processor L5410 x4 (12M Cache, 2.33 GHz, 1333 MHz FSB) Launched Q1'08 50 W

Intel® Xeon® Processor L5420 x4 (12M Cache, 2.50 GHz, 1333 MHz FSB) End of Life Q1'08 50 W

Intel® Xeon® Processor E5405 x4 (12M Cache, 2.00 GHz, 1333 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor E5410 x4 (12M Cache, 2.33 GHz, 1333 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor E5430 x4 (12M Cache, 2.66 GHz, 1333 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor E5440 x4 (12M Cache, 2.83 GHz, 1333 MHz FSB) Launched Q1'08 80 W

Intel® Xeon® Processor E5450 x4 (12M Cache, 3.00 GHz, 1333 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor E5462 x4 (12M Cache, 2.80 GHz, 1600 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor E5472 x4 (12M Cache, 3.00 GHz, 1600 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor X5460 x4 (12M Cache, 3.16 GHz, 1333 MHz FSB) End of Life Q4'07 120 W

Intel® Xeon® Processor X5482 x4 (12M Cache, 3.20 GHz, 1600 MHz FSB) End of Life Q4'07 150 W

Intel® Xeon® Processor E5205 x2 (6M Cache, 1.86 GHz, 1066 MHz FSB) End of Life Q4'07 65 W

Intel® Xeon® Processor X5260 x2 (6M Cache, 3.33 GHz, 1333 MHz FSB) Launched Q4'07 80 W

Intel® Xeon® Processor X5272 x2 (6M Cache, 3.40 GHz, 1600 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor E5420 x4 (12M Cache, 2.50 GHz, 1333 MHz FSB) End of Life Q4'07 80 W

Intel® Xeon® Processor X5450 x4 (12M Cache, 3.00 GHz, 1333 MHz FSB) End of Life Q4'07 120 W

Intel® Xeon® Processor X5472 x4 (12M Cache, 3.00 GHz, 1600 MHz FSB) End of Life Q4'07 120 W

Intel® Xeon® Processor LV 5128x2(4M Cache, 1.86 GHz, 1066 MHz FSB) Launched Q2'06 40 W

Intel® Xeon® Processor LV 5138x2(4M Cache, 2.13 GHz, 1066 MHz FSB) Launched Q2'06 35 W

Intel® Xeon® Processor 5140 (4M Cache, 2.33 GHz, 1333 MHz FSB) Launched Q2'06 65 W

Intel® Xeon® Processor LV 5148 (4M Cache, 2.33 GHz, 1333 MHz FSB) Launched Q2'06 40 W

Intel® Xeon® Processor 5110 (4M Cache, 1.60 GHz, 1066 MHz FSB) End of Life 65 W

Intel® Xeon® Processor 5120 (4M Cache, 1.86 GHz, 1066 MHz FSB) End of Life 65 W

Intel® Xeon® Processor 5150 (4M Cache, 2.66 GHz, 1333 MHz FSB) End of Life 65 W

Intel® Xeon® Processor 5160 (4M Cache, 3.00 GHz, 1333 MHz FSB) End of Life 80 W

Intel® Xeon® Processor LV 5133 (4M Cache, 2.20 GHz, 800 MHz FSB) Launched 40 W

Intel® Xeon® Processor L5238 (6M Cache, 2.66 GHz, 1333 MHz FSB) Launched Q1'08 35 W

Intel® Xeon® Processor L5248 (6M Cache, 3.00 GHz, 1333 MHz FSB) Launched 55 W

В наличии у меня материнская плата ASUS P5K-E:

Установлен в неё процессор Intel Pentium 4 3ГГц 1 ядро с 2-мя потоками (технология Hyper-threading). Вот что показывает стандартная оценка Win7 и CINEBENCH:

Принимая во внимание первую таблицу, я заказал далеко не самый топовый процессор, а такой, который тестировался с моей материнской платой, а именно Intel® Xeon® Processor E5440.

Посылка пришла в виде достаточно большой коробки:

Внутри куча «пупырки»:

Внутри «пупырки» антистатический пакет с процессором:

Внутри пакета процессор и переходник:

Сравним полученный процессор с имеющимся:

Переходник уже был наклеен, продавец также положил запасной. Переходник крупным планом:

Приступаем к «допиливанию» сокета. Нужно аккуратно срезать скальпелем выступы обозначенные стрелками и установить правильно процессор:

Собираем и включаем:

Как и ожидалось, BIOS материнской платы процессор не опознал. Однако в соответствующем разделе BIOS-а вся информация о процессоре указана верно:

Неправильно читается ещё и температура процессора:

Ну что же, необходимо зашить модифицированную прошивку. Для этого идём по ссылке для материнских плат ASUS. Ссылки на другие платы (Gigabyte и MSI) указаны в соответствующей ветке форума в начале обзора.

Качаем прошивку, а также утилиту afudos для обновления BIOS-ов материнских плат ASUS. Другие материнские платы прошиваются другими утилитами. Также необходим DOS, для чего форматируем флешку с загрузочными файлами DOS, например, как описано тут. Переписываем на нее файл прошивки и утилиту afudos. Грузимся с флешки и с командной строки запускаем прошивку BIOS:Да, необходимо предупредить, что если прошивка выбрана неправильная, или «кривая», например скачалась с ошибками, то можно получить «кирпич». Такой же «кирпич» можно получить и если в процессе прошивки пропадёт питание, тут посоветую запитать компьютер через UPS. В общем к прошивке BIOS необходимо подходить очень ответственно.

Итак, всё прошилось успешно, включаем и проверяем:Да, действительно, всё хорошо.

Переходим к испытаниям:

По оценке Win7 производительность выросла с 3,4 до 7,3, больше чем в 2 раза, но тут шкала скорее всего нелинейная. По оценке же CINEBENCH производительность процессора аж в 7 раз больше. А я напомню, это далеко не самый топовый процессор. Но даже он по таблице рейтинга процессоров NIX на уровне CPU Intel Core i3-4150T 3.0 GHz/2core/SVGA HD Graphics 4400/0.5+3Mb/35W/5 GT/s LGA1150 цена которому у них же около 9000 рублей. Плюс ещё необходима замена материнской платы, а это ещё несколько тысяч. Так что экономия значительна :)

Надеюсь мой опыт будет полезен. Желаю удачи.

Во многих процессорах, особенно некоторых поколений назад от Intel, мы могли видеть аббревиатуру IMC, выгравированную на IHS. В настоящее время они больше не делают, но это не значит, что они перестали использовать его, и на самом деле, сегодня это является одним из компонентов процессоров, который имеет большее значение , В связи с этим, вы знаете, что такое ИМТ процессора? В этой статье мы расскажем вам, и мы объясним, как это работает и какие типы есть.

IMC на самом деле является одной из тех частей процессора, которые обычно не принимаются во внимание, и это то, что мы склонны смотреть только на ядра, скорость и, самое большее, на кеш-память, которую они имеют. Но это внутренний компонент процессоров, который чрезвычайно важен, и тогда вы поймете, почему.

Что такое ИМТ процессора

IMC означает «интегрированный контроллер памяти» или встроенный контроллер памяти. Контроллер памяти может быть отделен или интегрирован в другую микросхему, так что интегрированные - это те, которые, как вы предположите, интегрированы в кристалл процессора. Раньше контроллер памяти находился на материнская плата, но уже довольно давно используется только IMC, поскольку он позволяет процессору управлять памятью более быстрым и прямым образом.

Таким образом, IMC - это цифровая схема, которая контролирует поток данных, которые приходят и уходят между самим процессором и Оперативная память. То, что он интегрирован в процессор, позволяет управлять ОЗУ напрямую и быстрее, чем когда контроллеры памяти были на материнской плате.

Перед AMD K8s (выпущен в 2003 году), процессоры AMD имели контроллер памяти в своем северном мосту, но в следующих поколениях AMD впервые интегрировала его в сам процессор . Intel впервые сделала то же самое для процессоров Nehalem в 2008 году, и после этого оба производителя используют только IMC. Кстати, ARM Процессоры с архитектурой также во всех случаях используют контроллер памяти, встроенный в процессор.

Как работает контроллер памяти?

Контроллеры памяти содержат логику, необходимую для чтения и записи в ОЗУ и «обновления» DRAM. Без этих постоянных «обновлений» DRAM потерял бы содержащиеся в нем данные, так как содержащиеся в них конденсаторы теряют заряд за доли секунды (не более 64 миллисекунды в соответствии со спецификацией JEDEC ).

Чтение и запись в ОЗУ осуществляется путем выбора адресов данных строки и столбца DRAM в качестве входов для схемы мультиплексора, где демультиплексор в DRAM использует преобразованные входы для выбора правильного расположения в памяти и возврата данных, которые возвращаются обратно через мультиплексор для консолидации с целью уменьшения ширины шины, необходимой для работы.

Некоторые контроллеры памяти также имеют свою собственную систему исправления ошибок, которая может быть дополнена той, которая включает в себя множество модулей памяти ОЗУ (что хорошо, потому что в некоторых случаях она освобождает их, а в других удваивает коррекцию ошибок размера).

Варианты существующего ИМТ

Конечно, вы заметили, что спецификации процессоров почти всегда включают определение типа и скорости ОЗУ, с которым они совместимы, точно в зависимости от ИМТ, который они включают. Поэтому существуют разные варианты контроллера памяти, и некоторые из них вы обязательно узнаете сразу.

С одной стороны, есть Контроллеры DDR что может быть (обычно) двойной канал и четырехъядерный канал , Разница заключается в том, что в них память RAM разделена на 2 или 4 отдельных канала, каждый с прямой шиной к контроллеру памяти. Это наиболее используемые на ПК, и те, которые мы все знаем.

С другой стороны, у нас есть контроллеры с именем FBM ( Полностью буферизованная память ) поведение которого отличается от предыдущего тем, что в каждом модуле памяти находится буферное устройство (называемое FB-DIMM ), который использует последовательный канал передачи данных к контроллеру (вместо параллельного), уменьшая количество рельсов, необходимых для связи, за счет увеличения задержки.

Наконец, мы имеем Флэш-память контроллеры, используемые такими устройствами, как флеш-накопители или твердотельные накопители. Флэш-память по своей природе медленнее, чем DRAM, и, как правило, становится непригодной для использования после ряда циклов записи, но ей все равно нужен собственный контроллер памяти для связи с остальной системой.

Читайте также: