Как подключить схд к компьютеру

Обновлено: 04.07.2024

Как настроить подключение к блочному устройству на системе хранения по протоколу iSCSI?

Решение:

Для работы с блочным устройством через протокол iSCSI необходимо выполнить следующие условия:

Установить два отдельный сетевых адаптера (минимум - один выделенный адаптер) для подключения в сеть хранения. Настроить сетевое оборудование провайдера для доступа сервера в сеть хранения Настроить iSCSI инициатор и параметры аутентификации, сообщить эти параметры провайдеру Установить и настроить многопутевой доступ UltraPathТерминология iSCSI

iSCSI (Internet Small Computer System Interface) — протокол, который базируется на TCP/IP и разработан для подключения к устройствам хранения данных в режиме блочного устройства. Протокол обеспечивает передачу по сети команд SCSI и эмулирует локальный жесткий диск из набора данных находящихся на СХД. IQN (iSCSI Qualified Name) - имя длиной до 255 символов в соответствии с RFC 3720. Примеры: Internet Small Computer Systems Interface (iSCSI) Naming and Discovery Таргет — iSCSI-сервер; предоставляет доступ к своим устройствам по iSCSI. iSCSI Портал — группа таргетов, которые анонсируются вместе. Обычно один узел хранения — один портал. LUN (Logical Unit Number) — уникальный номер объекта внутри таргета содержащий набор данных. Ближайшим аналогом LUN является жесткий диск, раздел диска или отдельный том. Обнаружение (discovery) — процесс, в ходе которого инициатору становятся известны доступные ему таргеты.Установка и подключение сетевой карты

В ходе заказа услуги следует сообщить параметры сетевых адаптеров которые вы предполагаете выделить для работы с СХД. Или заказать установку дополнительных адаптеров.

После установки адаптеров и настройки сетевого оборудования сетевой инженер сообщит вам адреса которые вам нужно будет настроить на ваших адаптерах.

Проверка доступности

Сервера клиента двумя отдельными сетевыми интерфейсами (минимум - один отдельный сетевой порт) должен быть подключен в сеть хранения:

Наличие второго интерфейса позволит агрегировать (объединить) производительность обоих портов и обеспечит живучесть при обрыве связи по одному из каналов.

Для подключения к таргету вам следует убедиться, что сеть хранения доступна для вашего сервера.

iSCSI - портал системы хранения должен быть доступен на следующих адресах:

Если у вас один сетевой порт, то вы должны видеть или первую или вторую пару адресов.

Проверьте доступность командой

Настройка Инициатора

Найдите в контрольной панели iSCSI Initiator

Control Panel>System and Security>Administrative Tools>iSCSI Initiator

Имя IQN текущего инициатора можно посмотреть на закладке:

Имя инициатора

IQN (iSCSI qualified name) – имя длиной до 255 символов в следующем формате: iqn.<year-mo>.<reversed_domain_name>:<unique_name>

reversed_domain_name - официальное имя домена, записанное в обратном порядке; unique_name - это произвольное имя, например, имя сервера (ad321).Во избежание лишних недоразумений рекомендуем использовать имя сервера которое мы назначили вашему серверу, например, вы можете найти это имя в списке ваших услуг:

При этом имя хоста в параметрах операционной системы может быть каким угодно.

И имя IQN может быть любым, просто нам удобнее вести учет выдачи ресурсов по нашим внутренним спискам.

Аутентификация

Вам потребуется настроить аутенификацию для discovery и аутенификацию для подключения.

Придумайте или сгенерируйте криптостойкий пароль 14-16 символов

Для создания учетной записи вашего сервера на системе хранения передайте следующую информацию:

После получения этой информации администратор системы хранения создаст учетную запись для вашего сервера с соответствующими вашему заказу LUN и параметрами отображения.

В панели iSCSI Initiator Properties перейдите на закладку Discovery, нажмите Discover Portal, укажите IP-адрес, нажмите Advanced, поставьте птицу на чекбоксе Enable CHAP log on. В качестве имени используйте имя инициатора, пароль 14-16 символов.

Повторите эти действия для каждого из адресов iSCSI портала.

После этих действий на закладке Targets должны отображаться 4 тергета в окне Discovered targets. Если у вас только одна карта, то там должен быть список из двух таргетов.

Последовательно укажите на каждый из таргетов и нажмите кнопку Connect. Затем Advanced, поставьте птицу на чекбоксе Enable CHAP log on. В качестве имени используйте то же самое имя инициатора и пароль 14-16 символов.

В менеджере дисков вы должны увидеть новый диск или диски с размерами соответствующими заказанным. Если этого нет, обновите список устройств через менеджер дисков или менеджер устройств.

Так как ваш сервер видит СХД по нескольким путям, то вместо одного диска вы будете видеть 4.

Но не торопитесь ставить чекбокс для Enable multi-path в параметрах инициатора. Есть лучшее решение. .

UltraPath

Разумеется, вы можете использовать стандартный multipath из вашей операционной системы. Однако Huawei UltraPath скорее всего окажется надежнее.

Скачайте и установите пакет UltraPath for Windows. Ссылку для скачивания последней версии пакета вам передаст служба технической поддержки. Или вы найдете ссылку под этой статьей.

Преимущества Huawei UltraPath

После установки перезагрузите сервер.

Убедитесь, что драйвер UltraPath установлен и работает:

Теперь нужно запустить консоль Ultra-Path, зайти в меню System > Global Settings и установить параметры как на этом снимке:

Зайдите в менеджер дисков, активируйте диск, создайте раздел с файловой системой.

В консоли Ultra-Path выберите все пути (1), запустите Performance Monitor (2), выберите тип измерений / measurement (3), запустите мониторинг (4), дайте нагрузку на диск и убедитесь что данные передаются по всем путям.

Тестирование производительности

Для теста производительности рекомендуем использовать утилиту diskspd

Для tier-2 и tier-3 это может длится довольно долго несмотря на то, что вы выбрали быстрое форматирование

В консоли Power Shell перейдите на созданный вами диск Создайте на диске каталог для тестирования, например - mkdir D:\test Скачайте и распакуйте утилиту diskspd в отдельный каталогTest-1

Это нагрузочный тест с имитацией работы OLTP позволяющий оценить нагрузочные характеристики диска.

Значение опций:

-r -w30 - Тестирует произвольные операции ввода-вывода (-r) с соотношением операций записи (-w30) и чтения 30/70 для эмуляции типичного режима рабочей нагрузки OLTP. -d600 -W300 - Задает 10-минутную продолжительность теста (сбора данных) (-d600), выполняемого после 5-минутного прогрева (-W300). При тестировании прогрев необходим для того, чтобы до начала сбора данных управление внутренними устройствами достигло состояния, близкого к устойчивому. Это важно при тестировании как операций чтения, так и операций записи. -b8K - Задает размер блока в 8 КБ (-b8k) — размер страницы, типичный для виртуальных машин Microsoft SQL Server и Hyper-V. -t4 -o15 - Создает 4 потока на файл (-t4). Каждый поток включает 15 ожидающих операций ввода-вывода (-o15). -h - Отключает программное кэширование и аппаратное кэширование записи — эквивалентно открытию файла с флагами FILE_FLAG_NO_BUFFERING и FILE_FLAG_WRITE_THROUGH. -Z1M Поддерживает исходные буферы произвольной записи размером 1 МБ (-Z), которые обеспечивают обычно несжимаемый поток данных на твердотельные накопители. Это важно для управления работой определенных классов устройств флэш-памяти и твердотельных накопителей. -c100G test.bin > test-1.txt Создает указанный файл данных test.bin размером 100 ГБ (-c100G) и сохраняет результат теста в файле test-1.txtTest-2, Test-3

Эти тесты служат для оценки ширины канала связи с СХД

test-2: последовательное чтение блоками по 512K

test-3: последовательная запись блоками по 512K

Пример результатов тестирования

Тестирование производилось ночное время при небольших конкурирующих нагрузках и без лимитирования SmartQoS

Использовался один порт 10GbE Intel X520 (MTU=9000) на стороне хоста и два порта на стороне СХД с Huawei UltraPath-8.06.063.

В некоторых тестах вы можете заметить малую разницу между различными Tier. Этот эффект объясняется особенностями работы кэша и контроллера СХД. При значительных конкурирующих нагрузках этот эффект делится между клиентами в соответствии с уровнем приоритета tier.

Если вы уже не первый год в бизнесе, то наверняка заинтересованы переходом на системы хранения данных. Об их функциях мы подробно рассказывали в другом материале, с которым также рекомендуем ознакомиться.

Здесь же остановимся на технической части. А точнее — на процессе подключения СХД к серверу предприятия. Чтобы все правильно работало, отвечало критериям безопасности, не вызывало проблем на дистанции. Тема объемная, затрагивает массу смежных протоколов и сервисов. Но если разобраться — ничего сложного.

Общие сведения и определения

Для начала давайте пройдемся по терминологии. Системы хранения данных (или сети хранения данных) в кругу специалистов принято именовать SAN (Storage Area Network). Основные компоненты SAN — накопители и контроллеры. Чтобы равномерно распределять нагрузку между дисками и серверами, не потеряв при этом в скорости и надежности, используют несколько путей ввода-вывода, не менее двух интерфейсов подключения и HBA (Host Bus Adapter) — выделенную плату-контроллер, которая связывает диски.

Связь между блоками обеспечивают коммутаторы. Они же отвечают за принадлежность к определенным ресурсам. Для этих целей у каждого SAN собственный WWN-адрес (World Wide Name), некий сетевой аналог MAC-адреса.

Подключение производят посредством LUN-интерфейса (Logical UNit). Это отчасти аналог раздела на жестком диске, но используемый для контроллеров. Благодаря такому подходу сервер видит LUN-диски как физические копии. Полезный подход, поскольку в дальнейшем через LUN можно подключить неограниченное количество физических и облачных мощностей в единую систему, формируя один полноценный диск. С него и будет раздаваться информация по серверам.

Распределение происходит через Disk Manager, или посредством утилит уровня LAN/SAN Mapping. Сам же хост LUN-интерфейс не видит.

Специалисты отмечают, что цеплять все имеющиеся LUN-ы на единый контроллер не стоит — быстро перегрузите систему. Всегда разделяйте мощности.

При создании СХД можно использовать как SATA, так и SAS-диски. Зависит от бюджета и потребностей.

Само же подключение SAN к хосту выполняется по следующему принципу:

- физическая компоновка;

- программная настройка.

И будь вы хоть трижды заслуженный админ с самым красивым бубном и хронически красными глазами (борода, само собой, должна быть длинной и окладистой), не забывайте действовать по инструкции. Производитель всегда кладет ее в комплект, чтобы минимизировать риски и снизить количество классических обращений в сервисный центр.

Схема подключения СХД к серверу по SCSI, SAS, FC

Опустим различия между производителями и сосредоточимся на сути. Основной процесс создания системы выглядит следующим образом:

- Установите контроллер HBA в свободный PCI-слот сервера.

- Подключите SAN к соответствующим интерфейсам, которые подразумеваются дисковым вместилищем (SCSI, SAS, FC).

- Настройте сетевое подключение, определите порты, используемые для оптической сети.

- Скачайте официальное ПО, если оно не предусмотрено в комплекте (зачастую это необходимо, потому как CD-привода в большинстве серверов давно нет).

- Инсталлируйте софт с дальнейшей регистрацией, если необходимо.

- Подключите HBA хоста и полку с дисками (стойку с накопителями) в одну подсеть на физическом свитче.

- Временно отключите файрволл во избежание ненужных ошибок и возмущений системы.

- Запустите программу сканирования СХД, которая определит топологию сети, а заодно покажет количество и номера устройств.

- Проведите регистрацию хоста на полке. Задачу можно произвести автоматически (рекомендуется), или руками через веб-морду.

- Введите IP хоста, привязав его к дисковой полке. Также не забудьте задать пароль администратора при первом старте.

- Зайдите в СХД и убедитесь, что все накопители нормально работают в режиме стандартных SCSI-устройств.

- Перейдите с помощью браузера к СХД по IP-адресу, а заодно убедитесь в наличии серверов, которые прошли регистрацию в массиве.

- Откройте вкладку с инициаторами, которые связывают блоки СХД с хостами. Дополнительно проверьте IP-адреса и, по необходимости, пропишите их вручную.

- Свяжите воедино хосты и LUN-ы, только последовательно.

Если все сделано правильно, то возле раздела с HBA появится соответствующая пиктограмма.

Как только разобрались с полкой, самое время перейти в программную часть и заняться настройками. Делается это не так, как на классических домашних ПК. Как говорится, есть нюансы.

Первым делом, необходимо разрезать диски на LUN-ы и оставить 1-2 ГБ свободного места на всякий случай. Далее переведите все накопители в статус «онлайн», но буквы никому не присваивайте — особенности работы. А вот форматировать стоит (NTFS. ExFAT или другой алгоритм на усмотрение администратора).

Завершаем настройку установкой HBA-драйверов под FC, SAS или SCSI.

На этом можно считать, что работы завершены. Системой можно управлять специализированным ПО от производителя, или благодаря веб-морде. Это не принципиально.

Полезные советы

Если вы создаете СХД с нуля, настоятельно рекомендуем закупить железо единого производителя. В идеале — одной серии. Так вы избежите 90% ошибок, нестыковок, проблем совместимости.

Дисковая полка нуждается в дополнительном источнике бесперебойного питания. Встроенный блок отвечает не за питание системы, а за корректную остановку действий в случае форс-мажоров. Не забывайте об этом.

Не стоит подключать к одному LUN-у несколько хостов, если не создаете кластер. Может возникнуть несогласованность записи, а это чревато повреждением целостности информации, чего мы всячески стараемся избежать.

И самое главное. При отсутствии опыта у штатных техников и администраторов, обращайтесь к аккредитированным специалистам. Это не та сфера, где можно по щелчку пальцев настроить все самостоятельно — большое количество смежного оборудования, коннекторов, плат управления и контроллеров. Специалисты Маркет.Марвел, имея большой опыт работы в этом направлении, помогут вам подобрать грамотную конфигурацию и оборудование для неё.

Также вы получите квалифицированную поддержку в момент запуска, и после истечения гарантийного срока. Поверьте: сохранность данных того стоит. Это как раз тот случай, когда эксперименты обходятся дорого.

Если у вас еще остались вопросы по эксплуатации СХД, вы всегда можете задать их нашим специалистам. Закажите консультацию, и мы предоставим вам всю требуемую информацию.

Алгоритм подключения системы хранения данных к хосту достаточно универсален. Безусловно, существуют нюансы настройки, которые зависят от конкретного оборудования и топологии вашей сети.

Создание SAN является сложной задачей. Если это ваш первый опыт, обратитесь к специалистам ВИСТЛАН за консультацией, помощью в проектировании системы и подборе оборудования

Подключение СХД к хосту делится на два этапа:

Физическое соединение.

Настройка.

Перед началом внимательно ознакомьтесь с документацией производителя на полку. Она подробно описывает все действия. Пример документации от Oracle .

Техническая информация

SAN состоит из нескольких HDD и контроллеров. Для равномерного распределения нагрузки и обеспечения надёжности стараются использовать два HBA (Host Bus Adapter), несколько путей ввода-вывода, как минимум два интерфейса.

Главным правилом подключения СХД к хосту является использование как минимум двух связей и путей для каждого устройства.

Свичи обеспечивают для серверов доступ только к предназначенным им ресурсам. Для этого в SAN каждому интерфейсу и каждому LUN-у присваивается World Wide Name (WWN) — подобие MAC-адреса.

LUN — Logical UNit — с точки зрения контроллера — это аналог раздела на жёстком диске. Сервер видит их как физические диски. Можно подключить все хосты к одному диску или раздать LUN-ы по серверам.

Распределение выполняется в Disk Manager конкретного сервера или с помощью утилит (LAN Mapping, SAN Mapping и т.п) хосту принудительно запрещается видеть LUN.

Не вешайте все LUN-ы на один контроллер. Разделите особо нагруженные LUN-ы по разным.

При создании SAN можно использовать разные типы HDD. Помедленнее и подешевле, типа SAS или SATA, — для ОС сервера и файловых ресурсов; FC — для скоростных приложений и баз данных.

Алгоритм подключения

В сервер установите HBA-контроллер.

Подключите СХД с помощью кабелей соответствующих интерфейсам, установленным на дисковой хранилище (FC, SAS, SCSI) по вашей схеме.

Проведите настройку сети, правильно установите типы используемых портов для оптической сети.

Скачайте с сайта производителя ПО. Однако, оно может идти в комплекте, но это не обязательно.

Установите ПО. Пройдите регистрацию, если требуется.

Включите HBA хоста и дисковую полку в одну подсеть на одном физическом коммутаторе.

Запустите утилиту сканирования SAN для определения топологии. Она покажет все устройства и их номера.

Зарегистрируйте хост на полке. Это можно сделать с помощью утилиты или вручную через веб-интерфейс полки. Автоматически — корректней.

Введите в браузере IP-адрес хоста и сделайте привязку полки. При первом подключении может понадобиться создать пароль админа.

Зайдите в систему управления дисками на хосте, убедитесь, что подключенные диски видны. Они выглядят там как обычные SCSI.

Перейдите по IP-адресу СХД в браузере. Проверьте наличие серверов, регистрация которых уже выполнена.

Найдите вкладку с инициаторами, связывающими хосты с блоками СХД. Проверьте IP-адреса. Если нужно, перенастройте их вручную.

Свяжите LUN-ы и хосты. Действия типа: Create -> Connect LUNs -> Connect Hosts.

Посмотрите наличие отметки около HBA, сигнализирующей о корректности подключения.

На этом настройка полки закончена.

Нарежьте диски на LUN-ы. Их можно сделать много. Оставьте около 1 Гб свободного места

Переведите диски в режим онлайн. Буквы не присваивайте.

Отформатируйте диски в нужный формат, например, NTFS.

Установите драйверы HBA (FC, SAS или SCSI).

Подключение завершено. Можно управлять системой с помощью специального софта или через веб-интерфейс.

Рекомендации

Если СХД только создаётся, имеет смысл использовать оборудование одного производителя, чтобы избежать проблем с совместимостью устройств.

Во избежание всяких неприятных ситуаций лучше сразу обратиться к системному интегратору, например, к нам.

Это можно не делать, если у вас в штате есть несколько опытных и толковых администраторов, у которых много свободного времени. Хотя, по деньгам вы здесь вряд ли выиграете, так как их работа оплачивается, а также нужно будет приобретать нужные комплектующие и пытаться их «подружить».

Дисковая полка конструктивно состоит из жёстких дисков и источника бесперебойного питания. Его основная функция — не питать систему в случае отключения электричества, а предоставление возможности СХД корректно завершить все операции ввода-вывода при выключении полки. Поэтому, для защиты сторейджа по питанию устанавливайте ИБП.

По FC можно подключиться к коммутатору и тем самым расширить количество используемых устройств. На SAS нельзя повесить серверов больше, чем есть портов на массиве.

Покупайте полку сразу с дисками.

Не подключайте несколько хостов к одному LUN-у, если у вас не кластер. Такое соединение создает несогласованность записи, что приведёт к повреждению данных.

Сервис — очень важная вещь в СХД. Так как стоимость и масштаб потерь велики, не скупитесь, заключите договор с интегратором на обслуживание. В результате вы сэкономите время, нервы и, как ни странно, деньги.

Всем привет, сегодня у нас маленький эксперимент по подключению SAS дисков к обычному персональному компьютеру. Обычно в компьютер можно установить только SATA диски, так как на материнской плате есть встроенный SATA контроллер. А SAS диски в обычный ПК не вставишь.

Дело в том, что SATA контроллер поддерживает только SATA диски. А SAS контроллер может поддерживать и SAS диски и SATA диски. SAS обратно совместим с интерфейсом SATA: устройства 3 Гбит/с и 6 Гбит/с SATA могут быть подключены к контроллеру SAS, но не наоборот.

SATA (Serial ATA) — последовательный компьютерный интерфейс обмена данными с накопителями информации. Предназначен для настольных ПК.

- SATA Revision 1.0 — до 1,5 Гбит/с

- SATA Revision 2.0 — до 3 Гбит/с

- SATA Revision 3.0 — до 6 Гбит/с

SAS (Serial Attached SCSI) — последовательный компьютерный интерфейс, разработанный для подключения различных устройств хранения данных, например, жёстких дисков и ленточных накопителей. Последняя реализация SAS обеспечивает передачу данных со скоростью до 12 Гбит/с на одну линию. Предназначен для серверов.

SAS не предназначен для настольных ПК, но иногда очень надо. Мне, например, по работе требуется иногда работать с SAS дисками. Подключаем SAS диск к ПК.

Что нужно для подключения SAS диска к ПК

Потребуется обычный ПК. Поскольку SAS контроллера на обычном ПК нет, то нам потребуется такой контроллер. Я попробую два варианта:

-

— это полноценный RAID контроллер, позволяющий объединять диски в RAID массивы. — это простой адаптер HBA, он не умеет объединять диски в RAID массивы. Вернее умеет, но со специальной прошивкой и не так хорошо как нормальный RAID контроллер.

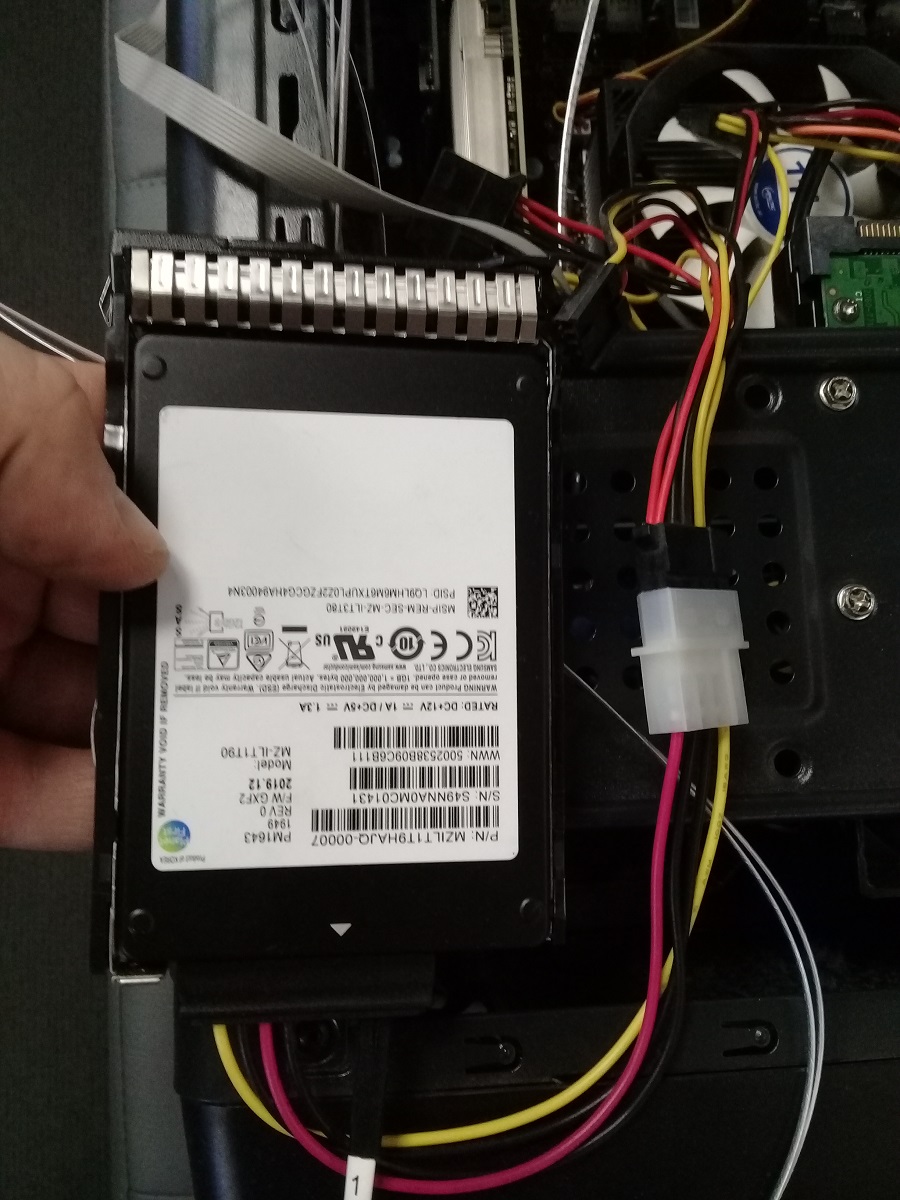

Для подключения дисков к контроллеру без использования корзины потребуется кабель переходник. Купил такой:

Переходник позволяет подключить 4 HDD с интерфейсом SAS или SATA к контроллеру с разъемом SFF-8643. Питание подаётся на каждый диск через 4-pin Molex.

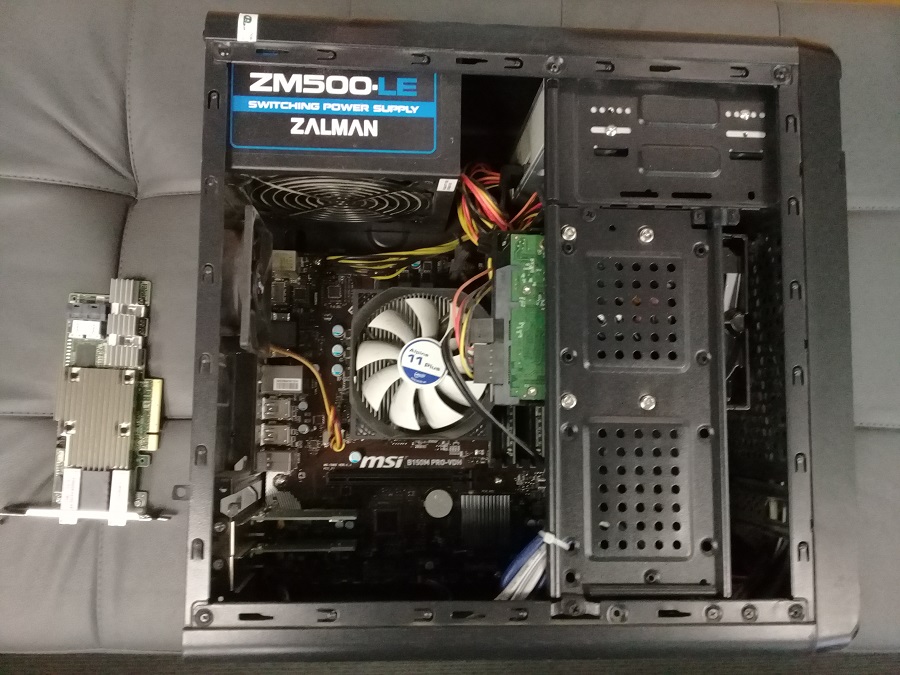

Подключение SAS диска через RAID контроллер Avago MegaRAID SAS 9380-8i8e

Готовим корпус ПК.

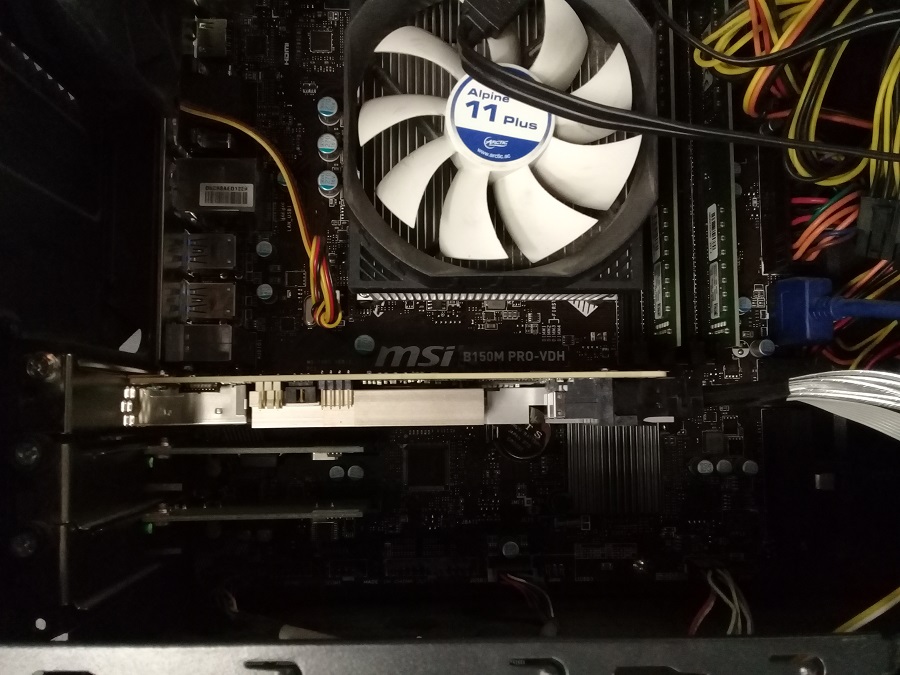

Устанавливаем контроллер в PCIe слот.

Подключаем диск через переходник.

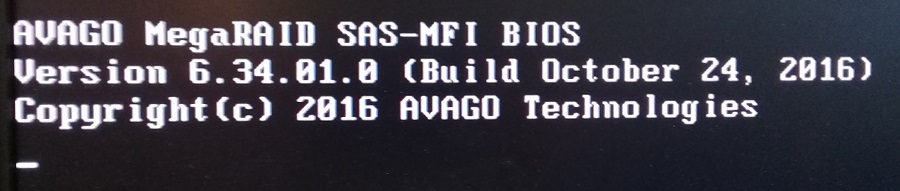

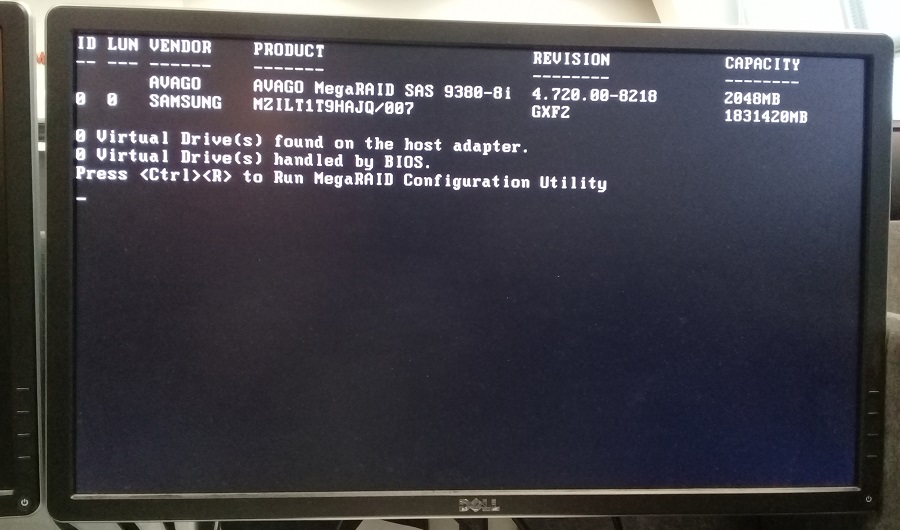

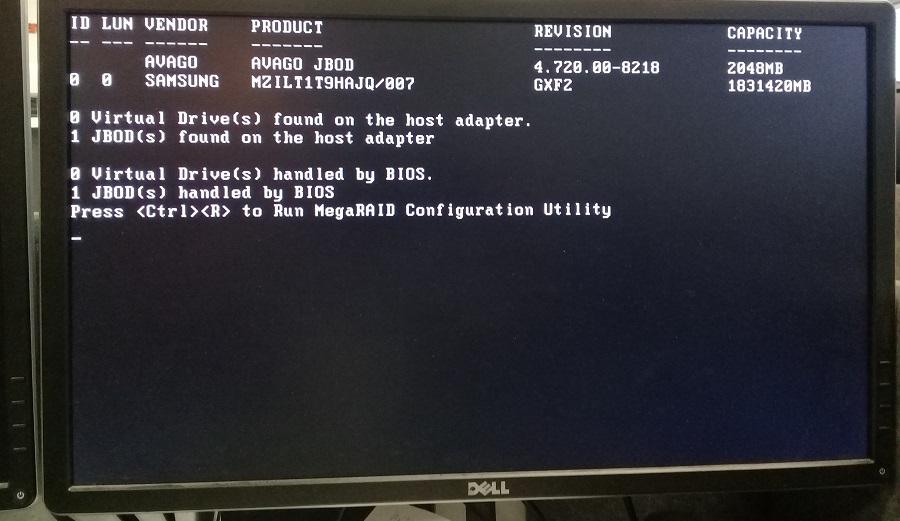

RAID контроллер определился. Видим, что диск SAMSUNG тоже определился.

Для доступа в конфигурационную утилиту MegaRAID Configuration Utility нажимаем Ctrl+R.

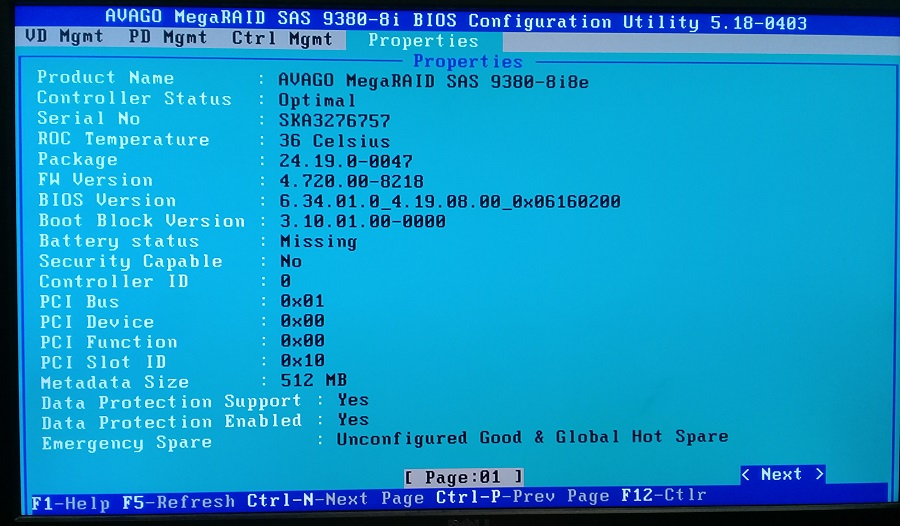

Можем посмотреть настройки контроллера.

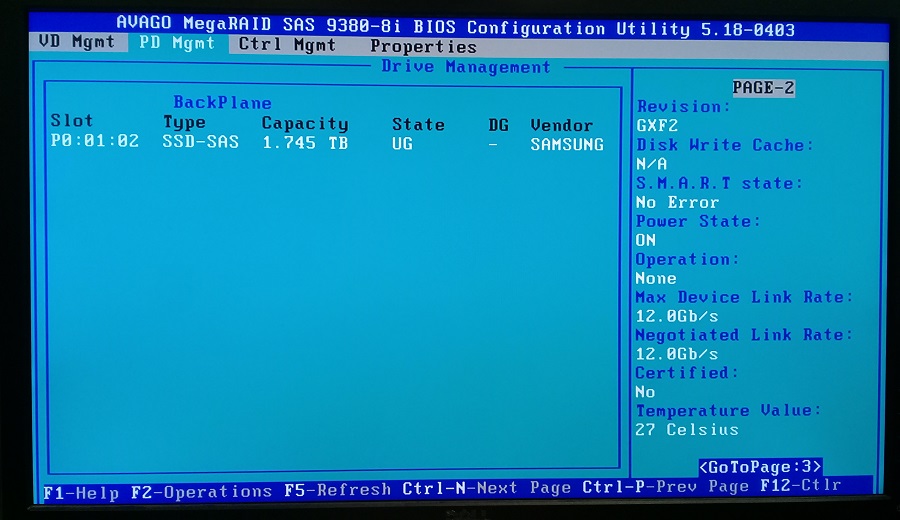

Можем посмотреть физические диски. Я подключал только один диск, он определился. Обратите внимание, что состояние диска UG — Unconfigured Good.

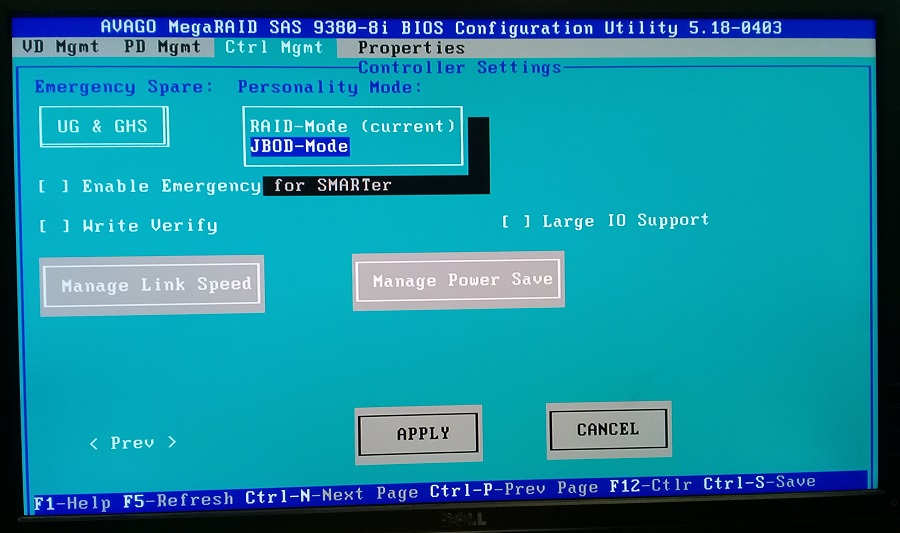

RAID контроллер по умолчанию показывает операционной системе не физические диски а RAID массивы. Я же хочу просто пробросить диск. Для этого необходимо RAID контроллер переключить в режим HBA.

В настройках контроллера меняем режим на JBOD-Mode. Применяем изменения и перезагружаем компьютер.

При загрузке уже 1 JBOD найден и handled by BIOS, это уже хорошо. Для проверки снова зайдем в настройки контроллера.

Читайте также: