Сравнения sas fc scsi iscsi

Обновлено: 04.07.2024

Протокол iSCSI впервые был предложен компанией Cisco в 2001 г. В 2004 году протокол был стандартизован IETF в RFC 3720.

iSCSI создан для переноса протокола SCSI (Small Computer Systems Interface), который работал на сети Fibre Channel (FC), в сеть TCP/IP. То есть, iSCSI – это транспортный протокол SCSI для отображения блочного хранилища через сеть TCP/IP.

Методы организации сетевых распределенных хранилищ

Существует три основных метода организации сетевых распределенных хранилищ:

FC SAN очень популярен из-за своей высокой производительности, высокой дальности передачи, возможности работать с данными на уровне блоков, широкого диапазона масштабирования. Недостатки FC SCSI SAN: сложность, высокая стоимость оборудования и обслуживания.

NAS позволяет подключать накопители непосредственно к существующей сети Ethernet. NAS проще и дешевле, но медленнее FC SAN. Транспорт данных в NAS работает на файловом уровне, а не блочном, как в SAN, что существенно замедляет работу таких приложений, как серверы баз данных. По мере увеличения устройств хранения в NAS начинают возникать проблемы масштабирования и управления.

Сравнение методов организации распределенного хранения: FC SAN, NAS и iSCSI SAN (источник: SNIA)

iSCSI дает возможность получать универсальный доступ к накопителям и сетям SAN через Ethernet-сеть с протоколом TCP/IP. Эта сеть может быть как выделенной, так и с работающими на ней другими приложениями. Кроме того, могут быть также добавлены маршрутизаторы и/или коммутаторы сети WAN (wide-area LAN network, не путать с WLAN), чтобы расширить IP-сеть хранения данных для глобальной сети (wide area network) для таких приложений, как удаленное резервирование данных (синхронное или асинхронное) или архивирование на ленточные библиотеки.

Для переноса файлов по IP-сети используется файловая система NFS для распределенных систем хранения. Это дает возможность общего доступа к файлам по многим системам.

В сетях WAN протокол TCP обеспечивает надежность хранения данных, позволяет регулировать перегрузку каналов сети, а также использовать возможности TCP по повторной передачи пакетов, в случае потери пакетов или их задержке на больших дальностях передачи по сети WAN.

Преимущества iSCSI

- IP-протокол и промежуточное ПО (middleware) для управления, безопасности и качества сервиса QoS (quality of service) могут быть использованы в сетях SAN.

- Компетенции и опыт пользователя в IP-сетях LAN (local-area network) могут быть применены к сетям SAN на базе IP.

- За счет использования стандартной IP-инфраструктуры, продуктов и сервисов может быть получена значительная экономия при создании сетей хранения SAN, основным недостатком которых являлась сложность проектирования, недостаточная совместимость и дороговизна развертывания, в то время как iSCSI может существенно сократить эти затраты.

- Гигабитные Ethernet коммутаторы могут повысить быстродействие SAN, уменьшить число ошибок, могут контролировать параметры потоков. Таким образом, можно обеспечить оптимальные скорости передачи через локальные сети LAN, глобальные WAN, и городские MAN (metropolitan-area networks).

- iSCSI совместим с существующей инфраструктурой Ethernet и IP WAN, а также с множеством других существующих и будущих IP-протоколов.

- Единая транспортная технология для сетей хранения, серверов и клиентов в сетях LAN, WAN, SAN.

- Возможность географического распределения систем хранения

- Возможность использовать средства управления TCP/IP сетями.

iSCSI может обеспечить хорошие параметры работы блочного хранилища при низких затратах. Этот протокол поддерживается большинством операционных систем и гипервизоров и может работать через стандартные сетевые адаптеры или через специализированные адаптеры HBA (Host Bus Adapters). Кроме того, iSCSI поддерживается большинством корпоративных СХД, где работают приложения второго уровня (Tier 2), которые требуют хорошего, но не превосходного качества работы блочных СХД, а также в СХД, которые используют много хостов одновременно.

iSCSI также популярен среди крупных облачных провайдеров, там часто используются блочные хранилища, которые работают поверх Ethernet.

Стек протоколов iSCSI

Соединения в iSCSI

Для традиционного SCSI, работающего по сети Fibre Channel, существует сервис простых доменных имен (Simple Name Server), работающий с сотнями и тысячами устройств. Однако в сетях IP, устройств может быть гораздо больше.

В IP используется два механизма обнаружения устройств iSCSI.

- SLP (service locator protocol), позволяющий осуществлять автоматическую настройку ресурсов.

- Internet Simple Name Server, где принципы Simple Name Server для Fibre Channel были расширены для IP сетей.

Сессия iSCSI

iSCSI сессия состоит из фаз:

- аутентификации (Login Phase)

- обмена (Full Feature Phase).

Фаза аутентификации используется для подтверждения права доступа и согласования параметров между iSCSI-инициатором и iSCSI- получателем. Если фаза аутентификации iSCSI завершается успешно, получатель (target) подтверждает доступ инициатору, в противном случае, TCP-соединение прерывается.

После подтверждения доступа iSCSI сессия переходит к фазе обмена. Если было установлено несколько TCP-линков, протокол iSCSI требует, чтобы каждая пара «команда/ответ» проходила через одно и то же TCP-соединение, а не так, чтобы команда проходит через одно ТСР, а ответ – через другое. Такая процедура гарантирует, что каждая отдельная команда считывания или записи будет осуществляться без необходимости дополнительно отслеживать каждый запрос на предмет его прохождения по разным потокам. Однако, в рамках одной сессии несколько транзакций могут одновременно передаваться через несколько ТСР-линков.

Сессии и соединения в iSCSI (источник: SNIA)

Когда транзакция завершается, происходит последний обмен между инициатором и получателем, который подтверждает успешность передачи. Сессия закрывается командой iSCSI logout, передаваемой в конце фазы обмена. Эта команда также передает информацию о причинах завершения сессии. Она также может содержать информацию о том, какой ТСР-линк следует закрыть в случае возникновения ошибки.

Обработка ошибок

Поскольку при передаче по IP-сети (в особенности, WAN) возможны ошибки при передаче, протокол iSCSI содержит много средств по обработке ошибок.

Как инициатор, так и получатель (target) iSCSI должны иметь буфер команд, чтобы получать подтверждения их выполнения, а также они должны иметь возможность восстановления утраченного или испорченного блока данных IP-пакета (PDU) для восстановления сеанса передачи данных.

Средства обработки ошибок и восстановление в iSCSI включают:

- На низком уровне — определение ошибки и восстановление данных на уровне сеанса связи, например, повторение передачи утраченного или поврежденного PDU.

- На среднем уровне — при повреждении TCP-линка оба узла iSCSI пытаются восстановить соединение.

- На высоком уровне – при повреждении сессии iSCSI. Если восстановление корректно отрабатывается на других уровнях, то прерывания сессии, как правило, не требуется. Но если сессию восстановить не удается, то требуется закрытие всех TCP-линков, прерывание всех задач, отмена невыполненных SCSI команд и перезапуска сессии через повторный login.

Особенности iSCSI

При создании iSCSI SAN в той же сети TCP/IP, по которой передаются данные между серверами и рабочими станциями пользователей, могут возникнуть задержки и зависания приложений. Поэтому сети СХД, в общем, должны быть логически изолированы от других систем в рамках LAN или WAN, или даже созданы в виде отдельной коммутируемой сети. Но если пользователей в сети iSCSI немного (небольшая рабочая группа, например), то этим правилом можно пренебречь.

Следует также учесть, что, в случае использования обычных сетевых адаптеров, iSCSI создает нагрузку на процессор сервера, поскольку предусматривает упаковку команд и данных SCSI в пакеты TCP/IP, а также распаковку этих пакетов. Чтобы снизить нагрузку на сервер, можно использовать плату TCP Off-load Engine (TOE) или хост-адаптер iSCSI. В отличие от обычных сетевых плат, эти устройства сами обрабатывают протокол TCP/IP-вычисления на своем процессоре.

Так Fibre Channel или iSCSI?

Подводя итог, можно провести сравнение двух наиболее популярных технологий для сетей хранения: FC или iSCSI.

Fibre Channel, благодаря высокой производительности и надежности, долгое время рассматривался как стандартная технология для корпоративных SAN. Но FC SAN довольно дороги и сложны в развертывании и управлении.

iSCSI SAN стали набирать популярность, поскольку производительность IP-сетей выросла, и стала достаточной для компаний с ограниченным бюджетом. Более того, iSCSI SAN позволяет переиспользовать традиционные сетевые компоненты Ethernet для коннективности между хостами и устройствами хранения, что значительно снижает стоимость развертывания.

Поэтому выбор между двумя этих технологиями зависит от требований компании. FC SAN дают выигрыш в производительности, задержках и IOPS, а iSCSI SAN – проще и дешевле.

В этой статье мы проведем небольшой обзор наиболее популярных протоколов, которые используются для построения сетей хранения данных (SAN). Также рассмотрим перспективы развития и использования отдельных протоколов, опираясь на общедоступные роудмапы производителей.

Не секрет, что на сегодняшний день проблемы производительности перемещаются из сферы СХД в область SAN сетей, так как СХД уже достигли огромных показателей производительности в ГБ/с и миллионах IOps, а текущие SAN сети не позволяют прокачивать через себя такие объёмы данных.

Общие тенденции

Существующие сети FC 8Гб/с и Ethernet 10Гб/с уже не справляются c современными СХД, даже Ethernet 25/50 Гб/с не может обеспечить приемлемые задержки при работе с последними моделями СХД, использующими NVMe диски.

Многие ИТ-специалисты, занимающимся настройкой и администрированием инфраструктуры хранения, задаются вопросом о модернизации SAN-сетей. Почему же это так важно и необходимо на сегодняшний день? Сформулируем несколько основных причин:

- Во-первых, плотность хранения данных постоянно растёт, увеличиваются объёмы как HDD дисков, так и флэш-накопителей. Уже сейчас на рынке доступны HDD объёмом 10ТБ и SSD до 3.2ТБ.

- Во-вторых, скорость флэша и гибридных СХД растёт в двух аспектах: увеличивается пропускная способность и уменьшаются задержки. Например, последние модели NVMe-накопителей имеют производительность порядка 3ГБ/с и задержки в 20 мкс.

- В-третьих, потребность в обработке миллионов IOps. Уже сейчас один NVMe-диск способен выдавать до 700+ тысч IOps.

- В-четвёртых, потребность увеличивать производительность на один порт подключения. Если раньше с одного порта QSFP+ на протоколе InfiniBand получали максимум 56Гб/с, то уже в этом году есть решения с производительностью 200Гб/с на порт.

По существующим прогнозам, в перспективе двух лет (по данным Gartner, в течение 18 месяцев) all-flash массивы будут комплектоваться более производительными SSD-дисками, а в сочетании с быстрым интерконнектом (например, NVMe) и новыми протоколами (например, iWARP) производительность all-flash массивов повысится ещё на два порядка, что приведёт к необходимости модернизировать SAN.

Сравнение протоколов

Все SAN сети, будь то Ethernet, PCI Express, SAS, NVMeoF, FC, FCoE или InfiniBand, должны поддерживать одинаковый функционал, а именно:

- идентифицировать хост и СХД;

- иметь возможность маршрутизировать траффик;

- разделять сеть на подсети и изолировать в них траффик;

- обеспечивать возможность использования нескольких путей к СХД;

- управлять подключением устройств к сети;

- приоритизировать траффик.

На сегодняшний день протоколы хранения данных можно разделить на две условные группы:

- используемые для подключения серверов приложений (FC, FCoE, iSCSI, NFS, SMB);

- используемые для подключения в рамках кластера или в качестве интерконнекта внутри СХД (InfiniBand, NVMe, PCIe).

Fibre Channel (FC)

Fibre Channel — популярный протокол хранения, обеспечивающий низкие задержки и высокую пропускную способность за счёт своих архитектурных особенностей. Fibre Channel не требователен к ресурсам и отлично подходит для передачи большого объёма данных, так как все операции FC выполняются на стороне HBA, разгружая центральный процессор.

Новые версии протокола Fibre Channel обратно совместимы с прошлыми редакциями, что открывает хорошие перспективы для модернизации и масштабирования. Например, если внедрять FC 32Гб/с, то всё ещё можно будет использовать FC 8Гб/с и 16Гб/с, т.е. можно поэтапно менять FC-коммутаторы и FC адаптеры.

В ближайшее время FC будет обновлён до 64Гб/с и 128Гб/с (уже сейчас есть коммутаторы, поддерживающие агрегацию 4-х портов 32Гб/с в один канал 128Гб/с для соединения коммутаторов).

Простота настройки и удобство в администрировании позволили FC стать одним из наиболее распространенных протоколов хранения. Большинство администраторов SAN-сетей во всем мире знает, как он устроен и какие преимущества обеспечивает при решении различных задач. При этом FC всё ещё сложнее, чем Ethernet, хотя и обладает большим количеством средств управления и мониторинга.

FCoE (Fibre Channel over Ethernet)

Идея создания FCoE заключалась том, чтоб консолидировать операции ввода-вывода и, как следствие, обеспечить безопасное размещение в одном «проводе» различных типов траффика. Такая задумка подразумевала снижение совокупной стоимости владения системой (TCO) за счет уменьшения числа кабелей и адаптеров, а также снижения показателей по энергопотреблению. При этом показатели доступности и производительности FCoE не сопоставимы с показателями FC, так как передача данных требует дополнительных накладных расходов на инкапсуляцию в Ethernet.

К тому же, FCoE добавляет сложность в развёртывании и администрировании всей системы, повышая уровень требований к обслуживающему персоналу и поддержке решения. Несмотря на надежды производителей FCoE на повсеместное внедрение, до сих пор данный протокол не смог вытеснить FC и развивается очень медленными темпами. Распространение FCoE на рынке SAN в настоящий момент минимально.

По данным Fibre Channel Industry Association (FCIA) в прогнозных показателях FCoE скорость протокола зависит от реализаций Ethernet.

iSCSI (Internet Small Computer System Interface)

iSCSI строится на двух наиболее часто используемых протоколах:

- SCSI — протоколе обмена блоками данных между компьютером и хранилищем

- IP — сетевом транспортном протоколе, широко применяемом в корпоративных сетях Ethernet.

Считается, что iSCSI 10Гбит обеспечивает такое же количество IOps и пропускную способность, как и сопоставимый ему FC 8Гбит, но это не совсем так. Хотя пропускная способность iSCSI и выше, но его эффективность ниже, чем у FC за счёт дополнительных накладных расходов.

Производительность iSCSI зависит от существующий инфраструктуры Ethernet (на сегодняшний день минимально рекомендованная сеть для iSCSI – 10Гбит). В ближайшем будущем (по данным Gartner, 10–12 месяцев) стоит планировать переход на 25/40/50GbE, если будет необходимость использовать высокопроизводительные all-flash СХД.

SAN-сети на основе сетей Ethernet

Протоколы iSCSI, NFS, SMB, FCoE используют Ethernet-сети для передачи данных, поэтому использовать данные протоколы в общих сетях не целесообразно. Это приводит нас к необходимости развёртывания выделенных сетей для использования их в качестве SAN.

Такие сети должны работать параллельно с другими основными сетями и отделять пользовательский траффик от траффика данных серверов. Однако из-за разделения сетей увеличивается сложность администрирования и общая стоимость владения.

Единственное исключение — это использование общих сетей для объектного хранения, т.к. в данном случае обеспечение минимальных задержек и максимальной производительности не так критично.

NFS (Network File System)

Network File System (NFS) — протокол сетевого доступа к файловым системам, первоначально разработанный Sun Microsystems в 1984 году. NFS предоставляет клиентам прозрачный доступ к файлам и файловой системе сервера.

NFS просто конфигурируется и администрируется, т.к. используется поверх сетей Ethernet. Как и в других протоколах, использующих Ethernet, скорость и задержки целиком зависят от реализации сети на нижнем уровне и чаще всего «упираются» в ограничения стандарта 10GbE.

NFS часто используется как протокол начального уровня для построения SAN-сети для виртуализации. По прогнозам Gartner, такой тренд сохранится в течение последующих 10 лет.

SMB (Server Message Block)

SMB — это сетевой протокол для общего доступа к файлам, который позволяет приложениям компьютера читать и записывать файлы, а также запрашивать службы серверных программ в компьютерной сети. Разработан компанией Microsoft для реализации «Сети Microsoft Windows» и «Совместного использования файлов и принтеров». С увеличением пропускной способности сетей передачи данных SMB стал одним основных протоколов файлового доступа, применяемых в СХД. В системах хранения SMB чаще всего используется в сетях 10GbE, из-за этого его производительность сильно зависит от реализации, настроек и используемых компонентов сети.

До версии SMB 3.0 протокол в основном использовался для передачи файлов в локальных сетях. С новой версией, поддерживающей технологию SMB-Direct (использование RDMA), стал активно применяться в кластерах виртуализации на базе MS Hyper-V как протокол доступа к общему пулу хранения.

Как и NFS, SMB часто используется в качестве протокола начального уровня при построении SAN-сети для виртуализации. Эта тенденция также должна сохраниться в ближайшее десятилетие.

InfiniBand (IB)

InfinBand — высокоскоростной протокол, обеспечивающий очень большую пропускную способность и низкие задержки. Используется, преимущественно, в отрасли высокопроизводительных вычислений (HPC) и в качестве интерконнекта при создании высокопроизводительных СХД.

Наиболее явным недостатком этой технологии является сложность в настройке и администрировании. Как следствие, работа с IB требует квалифицированного персонала.

Среди трудностей повсеместного распространения InfinBand можно отметить ограниченные средства для мониторинга производительности и диагностики проблем, а также не самую лучшую совместимость с разными операционными системами.

В сравнении с FC и Ethernet протокол InfiniBand более «дорог» для внедрения и обслуживания. К тому же, существует лишь несколько считанных компаний, которые производят оборудование и программное обеспечение для работы с IB.

NVMe (NVM Express)

NVMe — это достаточно новый высокопроизводительный протокол доступа к твердотельным накопителям, подключенным по шине PCI Express. Аббревиатура «NVM» в названии обозначает энергонезависимую память (Non-Volatile Memory), в качестве которой в SSD повсеместно используется флеш-память типа NAND.

Протокол был разработан с нуля. Основные цели его разработки – низкие задержки и эффективное использование высокого параллелизма твердотельных накопителей. Последняя задача решается за счёт применения нового набора команд и механизма обработки очередей ввода-вывода, оптимизированного для работы с современными процессорами.

На данный момент технология NVMe еще не получила широкого распространения. В основном протокол используется для внутреннего соединения в серверах и СХД. Спецификация NVMe также позволяет инкапсулировать его в другие протоколы, такие как Ethernet, FC и InfiniBand, и масштабировать протокол в более крупных сетях. Впрочем, поскольку NVMe использует прямой доступ к памяти (RDMA), латентность протокола несущей должна быть очень низкой для нормальной работы протокола.

В 2017 году ожидается активное внедрение NVMe, так как многие производители серверных платформ представляют новые модели с поддержкой двухпортовых NVMe-устройств, что позволит проектировать отказоустойчивые решения для хранения.

Ожидается, что в ближайшие несколько лет NVMe будет использоваться в качестве внешнего межсетевого интерфейса, аналогичного PCIe и InfiniBand. Например, он может использоваться в небольших специализированных сетях хранения из десятков узлов или устройств в однородной среде хранения. Гораздо шире NVMe будет использоваться в качестве внутреннего интерконнекта.

PCIe имеет очень низкие задержки и используется преимущественно в серверах для подключения плат расширения, в том числе и высокопроизводительных NVMe дисков. Некоторые новые продукты от известных производителей используют PCIe в качестве протокола подключения серверов через небольшие PCIe коммутаторы, т.е. PCIe получается использовать только в небольших SAN-сетях.

Только несколько производителей СХД в мире используют PCIe для внешних подключений, что и определяет узкоспециализированное применение данного протокола.

Так как PCIe не использует SCSI и требует собственного протокола для передачи данных, он может увеличить пропускную способность за счёт уменьшения задержек, по сути, работая на скорости чистой PCIe-линии. Такие решения требуют применения проприетарных драйверов, что делает их сложно администрируемыми и приводит к невозможности создавать гетерогенные инфраструктуры, а также встраивать такие решения в существующие SAN сети.

На сегодняшний день основная используемая реализация технологии — это PCIe 3.x, в которой производительность увеличена на 40% по сравнению PCIe 2.x.

По количеству линий PCIe масштабируется от 1ГБ/с до 16ГБ/с. В 2017 году выходит новый стандарт PCIe 4.x, который увеличит производительность в 2 раза, т.е. максимальная производительность достигнет 32ГБ/с.

Протоколы объектного хранения

Производительность этих протоколов сильно зависит от нижнего уровня, чаще всего это Ethernet. Основное функциональное применение протоколов объектного хранения — работа с неструктурированными данными. Ввиду этого они используются в рамках ЦОДов, а также широко применяются для доступа к данным и записи в облачные пулы хранения.

Протоколы объектного доступа требуют передачи и хранения большого объёма метаданных, что всегда добавляет накладные расходы, особенно в сравнении протоколами блочного доступа.

За последние несколько лет было разработано множество протоколов объектного доступа. Наиболее популярные из них – SOAP, S3, OpenStack Swift. В ближайшем будущем (по данным Gartner, в течение 5 лет) данные технологии будут вызывать особый интерес.

Вывод

Развитие SAN-протоколов напрямую зависит от развития приложений и профилей нагрузки.

Такие приложения и типы нагрузок, как в HPC, аналитике Big Data и активных архивах, будут двигать SAN в сторону создания СХД c очень низкими задержками и высочайшей пропускной способностью, а также с поддержкой разделяемого доступа с использованием NVMe.

Протоколы, которые будут внедряться в ближайшем будущем (такие как 40/100GbE ), файловые протоколы (такие как NFS over RDMA и SMB-Direct) и текущие блочные протоколы (такие как FC 16Gb/s), уже сейчас слишком медленные для следующего поколения Flash и гибридных СХД.

Основным протоколом на ближайшее десятилетие останется FC, так как под него создана вся необходимая инфраструктура. Многие будут переходить на FC 16Гб/c, затем на FC 32Гб/с и более новые версии.

InfiniBand, PCIe и NVMe останутся протоколами для подключения конечных устройств, межузловых подключений в кластерах или интерконнекта с малыми задержками. При этом будут и небольшие узкоспециализированные решения для SAN-сетей, в которых необходимы минимальные задержки и максимальная пропускная способность. FCoE, iSCSI, NFS, SMB или объектные протоколы будут использоваться преимущественно в качестве внешних протоколов.

C каждым годом растёт интерес к объектным системам хранения. Это происходит за счёт увеличения количества неструктурируемых данных, появления новых задач по их обработке и новых требований к хранению информации.

Использованные источники:

• The Fibre Channel Roadmap, FCIA 2016.

• Dennis Martin. Demartek Storage Networking Interface Comparison, Demartek 2016.

• Valdis Filks, Stanley Zaffos. The Future of Storage Protocols, Gartner 2017.

SCSI - это недостаток интерфейса малого компьютерной системы (интерфейс маленького компьютерного системного интерфейса), в 1979 году, первое предложение представляет собой интерфейсную технологию, разработанную для небольших машин. Теперь он полностью полностью популярен с небольшими машинами, высокими и низкими и нижнедельными серверами и обычными ПК. Отказ

SCSI можно разделить на SCSI-1, SCSI-2, SCSI-3, последний SCSI-3, также является наиболее широко используемой версией SCSI.

Во-вторых, ФК (Fibre Channel)

FC Fibre Channel: передача данных между компьютерными устройствами, скорость передачи достигает 2G (4G достигнет 4G). Волоконные каналы используются для подключения общего хранения сервера, внутреннее соединение между контроллером хранения и приводом.

Основная архитектура протокола:

FC-4 Upper Layer Protocol:SCSI,HIPPI,SBCCS,802.2,ATM,VI,IP

FC-3 common service

FC-2 Framing Protocol /Flow Control

FC-1 Encode/Decode

FC-0 Media:Optical or copper,100MB/sec to 1.062GB/sec

Описание соглашения:

FC-0: физический уровень, настраиваемые различные носители, расстояние передачи, стандарт механизма сигналов, также определенный оптоволоконный и медный интерфейс

И кабельные индикаторы

FC-1: определяет стандарты кодирования и декодирования

FC-2: определить кадр, управление поток и качество обслуживания и т. Д.

FC-3: определить общие услуги, такие как шифрование и сжатие данных

FC-4: слой сопоставления протокола определяет интерфейсы между волокнами каналами и верхними приложениями, такими как последовательные протоколы SCSI, драйверы HBA предоставляют функции интерфейса FC-4, Multi-протокол поддержки FC-4, такие как: FCP-SCSI, FC-IP , ФК-VI

Протокольный профиль:

FCP-SCSI: протокол, который преобразует параллельный интерфейс SCSI в режим последовательного интерфейса, применяется к передаче данных между системами хранения и серверами. Новый стандарт ANSI T10 поддерживает прямые данные напрямую между системами хранения на SANS. FCP-SCSI обеспечивает скорость передачи 200 МБ / с (полную дуплексную эксклюзивную пропускную способность), до 10 км на соединение, до 1600 000 узлов. FCP-SCSI использует блоки замены передачи кадров. Передача кадров передается короткие данные транзакции в больших потоковых данных.

В-третьих, ISCSI.

ISCSI (интернет-интерфейс компьютерной компьютерной системы) является стандартом передачи блока данных по TCP / IP. Он был инициирован двумя Cisco и IBM и поддержал основные продавцы хранения. ISCSI может реализовывать протокол SCSI в IP-сети для включения быстрых операций резервного копирования доступа к данным, таких как высокая скорость Gigabit Ethernet.

Стандарты IETFSI были переданы IETF (Group Internet Engineering Group) 11 февраля 2003 года. ISCSI наследует две самые традиционные технологии: SCSI и TCP / IP протоколы. Это заложил прочную основу для развития ISCSI. Системы хранения на основе ISCSI требуют только многих инвестиций для реализации хранилища SAN и даже непосредственно используют существующие сети TCP / IP. По сравнению с предыдущими технологиями хранения сетевых хранилищ, он решает открытость, мощность, скорость передачи, совместимость, безопасность и т. Д., И превосходная производительность заставляет его допустить и любимым.

рабочий процесс:

Система ISCSI отправляет команду SCSI адаптером SCSI.

Команда инкапсуется в пакет TCP / IP и отправляется в сеть Ethernet.

Получатель извлекает команду SCSI из пакета TCP / IP и выполняет соответствующую операцию.

Упакуйте возвращенную команду SCSI и данные в пакет TCP / IP, отправьте их обратно в отправителя.

Система извлекает данные или команды и передает их обратно в подсистему SCSI.

Преимущества ISCSI:

(1) широко распространенный Ethernet обеспечивает основу для развертывания ISCSI.

(2) Популярность Gigabit / 10 Gigabit Ethernet обеспечивает большую пропускную способность пропускания для ISCSI.

(3) Популярность знаний Ethernet обеспечивает большое количество талантов управления для технологии хранения на основе технологий ISCSI.

(4) Из-за сети TCP / IP полностью разрешают проблему удаленной репликации данных (Dester Recover) и других транспортных расстояний.

(5) Воспользуйтесь преимуществом цен на преимущество оборудования Ethernet и открытость сети TCP / IP и удобного управления, расширения и коррективов приложений оборудования.

В-четвертых, сравнение ISCSI и FC

Из транспортного слоя передача волоконного канала использует свой протокол FC, а ISCSI использует протокол TCP / IP.

Протокол FC полностью гетерогенный с существующим Ethernet, оба из которых не могут быть подключены друг к другу. Следовательно, волокнистый канал закрыт, но не только с доступом в существующей внутренней сети предприятия (Ethernet), но и с другими различными продуктами производственного волокна. Огромная проблема). Поэтому он стал проблемой для расширения сети хранения из-за совместимости. Кроме того, протокол FC добавлен в новую подсеть хранения после завершения сети. Когда добавлена новая подсеть хранения, вся сеть должна быть перенастройкой, которая также является препятствием для расширения сети FC.

Протокол TCP / IP на основе ISCSI, он сам работает на Ethernet, поэтому вы можете легко привязать к существующим предприятиям. Совместимость между сетевыми устройствами TCP / IP не надо обсуждать, а также быстрое развитие интернет-оборудования, которое запускает бесчисленные производители бесчисленного сетевого устройства в мире, является наилучшим доказательством.

С точки зрения управления сетью оптическая сеть, выполняющая протокол FC, довольно большой. Его управление использует проприетарное программное обеспечение, поэтому требуются специальные менеджеры, а их расходы на обучение высоки. Знание сети TCP / IP прошло большое количество талантов управления сетью через эти годы, и из-за поддержки устройств TCP / IP для поддержки протокола, даже различных производителей оборудования, его методы управления сетью также являются основными последовательными.

FC работает над оптической сетью, а его скорость очень быстро, и теперь достигла пропускной способности 2G, которая также является его основным преимуществом. Следующее поколение стандарта Fc работает, и его скорость может достигать 4G. Сегодняшний гигабитный Ethernet уже в популярности, который также основан на протоколе TCP / IP IPSI входит в практическую гарантию.

Благодаря отличному дизайну, Ethernet рожден сейчас, повсюду, где есть сеть, и теперь существует необычайная жизнеспособность. При общих усилиях бесчисленных производителей сети Ethernet неуклонно улучшается, Gigabit в сети фактически применял сеть , 10 Gigabit Network хочет выйти, а основные компонентные коммутаторы маршрутизаторов Ethernet имеют 10 гигабитных продуктов. С той фактом, что продукт постоянно богат, стоимость строительства постоянно уменьшается, а популярность 10 гигабитных сетей все более приближается.

Когда ISCSI передает данные при 10 ГБ высокоскоростных данных, технология хранения на основе протокола ISCSI будет неактивным, чтобы стать королем сетевого хранения.

Последовательный протокол SAS (Serial Attached SCSI) появился меньше десяти лет назад — поначалу как универсальная технология подключения внутренних дисков SAS и SATA в серверах. Сейчас SAS является доминирующим интерфейсом систем хранения данных и посягает на территорию Fibre Channel в роли среды взаимодействия серверов и дисковых массивов общего доступа. Берет высокой производительностью, простой расширяемостью, доступной ценой реализации.

Как закалялся SAS

SAS — протокол последовательной передачи данных «точка-точка», где для выполнения транзакции устанавливается полное соединение между инциатором (хостом) и таргетом (устройством хранения). Трансформация параллельного интерфейса и команд SCSI в последовательный SAS помогла ускоренному восхождению технологии на уровень коммутируемых сетевых подключений множества устройств.

На начальном этапе SAS 1.0 c пропускной способностью 3 Gb/s использовался для организации небольших RAID-массивов серверов: внутренних и JBOD. Массивы прямого подключения SAS DAS обеспечивали высокую производительностью, но были разрозненными. «Островки хранения» DAS нельзя собрать в общий ресурсный пул, они требуют отдельных операций для каждого массива, ими сложно управлять, потери от простоя оборудования при отказах или регламентных работах велики.

Для обеспечения целостности информации корпоративного уровня по всей цепочке передачи данных от хоста до диска запоминающей системы была принята модель защиты информации Т10. Соответствующая характеристика Data Integrity Field появилась в SAS 1.1.

В SAS 2.0 пропускную способность удвоили с 3 до 6 Gb/s, а сам стандарт переименовали в 6G SAS. Составной частью RAID-контроллеров и плат коммутации дисковых корзин стали самоконфигурируемые расширители портов (экспандеры). По сути, те же экспандеры, но во внешнем исполнении, породили SAS-коммутаторы — автономные устройства, которые транслируют преимущества высокой производительности SAS и решают проблему маршрутизации между серверами и несколькими устройствами хранения. С помощью SAS-коммутаторов массивы объединяют в пулы, делают устройства хранения общими, реализуют многоуровневое хранение (расслоение данных по разноскоростным устройствам), обеспечивают зонирование (разграничение потоков ввода/вывода по физическим устройствам и логическим томам).

Следующий шаг к росту пропускной способности соединений SAS уже сделан — на рынке появились промышленные образцы устройств 12G SAS. Будущее стандарта связано с увеличением дальности соединений с использованием оптоволоконного кабеля (для 6G SAS она ограничена 10 метрами по пассивному кабелю и 25 метрами по активному, с усилением сигнала).

Бережливая SAN

Когда серверов у предприятия немного, а запросы к производительности и емкости хранения невелики, повода для развертывания сложной инфраструктуры нет — хватит одной системы хранения данных (СХД) с 4 портами прямого подключения: FC, SAS или Ethernet. Производительность и управляемость такого решения зависит от уровня СХД и программной модели взаимодействия с хостами. Непрерывность сервиса обеспечивается дублированием узлов системы хранения и динамической миграцией виртуальных машин между серверами-хостами. Если приоритетом бизнес-модели является доступность данных и приложений, а производительности СХД достаточно, на такой структуре без коммутаторов можно и остановиться.

С ростом объемов информации и разнообразия приложений приходит потребность в новых серверах и слоях хранения. Производительность и непрерывность работы с данными дается ценой усложнения сетевой инфраструктуры. Простое наращивание базовой СХД дисковыми полками не всегда помогает — возможности головных устройств по обслуживанию интенсивного ввода/вывода ограничены (у систем начального уровня они весьма скромные). К тому же, привязка к проприетарным системам хранения ограничивает свободу маневра. Так приходят к построению коммутируемых сетей SAN взаимодействия серверов и разнообразных систем хранения. Раньше на эту роль было два кандидата: FC SAN на технологии Fibre Channel и/или IP SAN на iSCSI.

Сегодня производительную расширяемую SAN можно построить на одних только SAS-устройствах. Если быть точнее в формулировках — масштабируемую сеть серверов и устройств хранения SAS c разделяемым доступом. В большинстве дисковых массивов и так используются накопители SAS (или совместимые с ними SATA). Если внешние системы хранения c интерфейсом SAS, RAID-контроллеры и хост-адаптеры объединить SAS-коммутаторами, получится компактное продуктивное ядро вычислительной сети предприятия или его подразделения.

У разделяемого SAS есть три конька: высокая производительность, простая расширяемость, относительно низкие затраты на реализацию. Прямое подключение, низкие задержки и большая полоса пропускания делают коммутируемую сеть SAS состоятельным инфраструктурным решением — см. Коммутируемый SAS. Разделяемая, масштабируемая инфраструктура SAS.

Ограничения SAS — сравнительно малое расстояние между устройствами и отсутствие встроенной репликации. В остальном, преимущества на его стороне. Протокол проще, чем iSCSI и FC. Пропускная способность выше. Задержки (latency) у SAS 6Gb в разы ниже, чем у 10 GbE iSCSI и сопоставимы с 8 Gb FC. SAS HBA вдвое дешевле, чем карты 10GbE и впятеро, чем FC HBA, дешевле коммутаторы. У сетей передачи данных поверх Ethernet сети SAS SAN выигрывают в производительности — накладные расходы протокола TCP/IP нивелируют быстрый отклик СХД и затрудняют прокачку потоковых данных с высокой скоростью. FC SAN требуют больших капитальных затрат, территориально-распределенные решения нужны немногим. В задачах, где производительность дисковых операций является основным приоритетом, любые посредники между серверами и системами хранения становятся потенциальными источниками потерь. Коммутируемый SAS обходится одним протоколом с короткими цепочками связи инициаторов с таргетами.

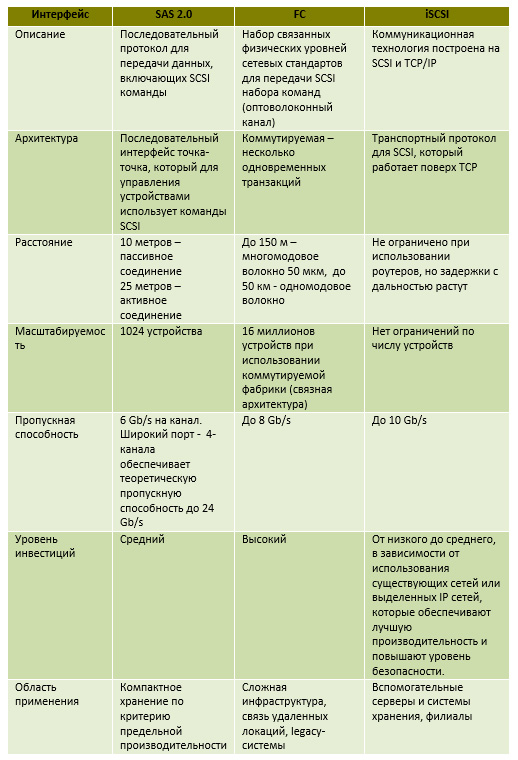

Сравнение сетей SAS / FC / iSCSI

Таблица 1

Совмещение различных типов сетей в серверной инфраструктуре предприятия – дело обычное, хотя и затратное. Какие из них уместны с точки зрения обслуживаемых приложений - зависит от сообразности целей и средств, с учетом затрат на развертывание (Capital Expences или СapEx) и сопровождение (Operational Expences, OpEx). Анализ CapEx/OpEX должен предшествовать любому проекту, при этом очевидно, что отказ от наслоений SAN упрощает обмен данными и управление сетями.

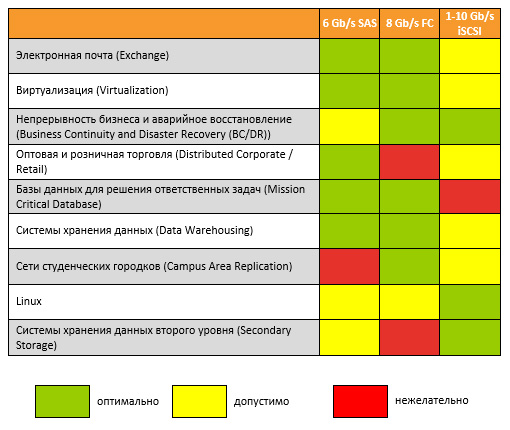

Таблица 2

Из последней таблицы видно, что для большинства типовых бизнес-задач достаточно одной только SAS SAN. Стандартные программные средства (например, Microsoft Windows Server 2012) позволяют создавать на основе разделяемого SAS масштабируемые сети хранения самого разного уровня: от небольшого хранилища для базы данных/видеоматериалов малого предприятия — до нескольких шкафов оборудования провайдера IT-услуг.

В корпоративном сегменте для подключения СХД применяются четыре основных интерфейса, предоставляющих блочный доступ: SAS, iSCSI, FC и FCoE. Каждый их них обладает своими преимуществами и недостатками, и рекомендуется к использованию в определенных сценариях.

SAS (Serial Attached SCSI)

Текущая реализация в СХД: 4 канала по 12Gbps, разъем SFF-8644.

Плюсы:

- Цена. Совокупная стоимость решения на базе СХД с интерфейсом SAS, включая контроллеры для серверов и SAS кабели, является невысокой, а в случае высоконагруженных инсталляций — самой дешевой среди всех интерфейсов.

- Высокая скорость. В каждом кабеле проходят четыре независимых линии по 12Gbps, что дает общую пропускную способность в 48Gbps при четырех и более одновременных потоках.

- Низкая латентность. Среди всех интерфейсов именно SAS демонстрирует наименьшие задержки.

Минусы:

- Ограничение по количеству хостов. Современные СХД с интерфейсом SAS позволяют подключить не более 8 серверов (не более 4 с дублированием путей доступа).

- Ограничение по расстоянию. Типовые SAS кабели имеют длину 2-5 м (в исключительных случаях можно найти дорогостоящие кабели длиной максимум до 10-15 м), что заставляет размещать серверы и СХД в пределах одной или соседних стоек.

- Отсутствие коммутаторов. Направление SAS коммутации не развивается уже несколько лет, существующие на рынке коммутаторы не совместимы с современным оборудованием и ПО, и мы крайне не рекомендуем их рассматривать для новых инсталляций.

В качестве первой СХД с интерфейсом SAS идеальны для компаний, в которых планируется подключать 2-3 сервера и можно спрогнозировать расширяемость на ближайшие 3-5 лет (рекомендуемый срок жизни СХД) до суммарно не более 8 серверов. В случае значительного расширения ИТ-инфраструктуры можно будет приобрести еще одну СХД или провести апгрейд с заменой интерфейсных контроллеров.

СХД c SAS подключением рекомендуются в качестве быстрых систем с минимальными задержками для скоростных баз данных, биллинга и других высоконагруженных приложений.

SAS также востребован в небольших кластерах отказоустойчивости.

iSCSI (Internet Small Computer System Interface)

Текущая реализация в СХД: 1/10GBase-T (в медной среде) и 10GbE SFP+ (в оптической среде).

Плюсы медного 1/10GBase-T:

- Цена. Самая низкая стоимость базового решения — в любом сервере есть гигабитный Ethernet, не нужно никаких особых адаптеров и кабелей; простейшие коммутаторы обычно уже есть в компании.

- Простота внедрения. Знакомая для любого администратора архитектура, не требующая специфических знаний и навыков, зачастую является решающим фактором при выборе первой СХД.

Минусы медного iSCSI 1/10GBase-T:

- Высокая латентность. Медленный интерфейс с самыми большими задержками.

- Низкая скорость интерфейса 1GBase-T. Скорость интерфейса в 1Gbps не удовлетворяет требованиям большинства сегодняшних нагрузок.

Медный iSCSI рекомендуется использовать только в случае очень жесткого ограничения бюджета, или в сценариях, при которых не важна латентность — например, для систем видеонаблюдения.

Плюсы оптического iSCSI:

- Простота внедрения. Во многих компаниях уже существует инфраструктура под оптический Ethernet. Техническим специалистам не требуется дополнительно вникать в эту среду, высокая степень совместимости с уже имеющимся оборудованием делает данный вариант очень популярным.

- Удобство подключения. СХД с 10-гигабитной оптикой также хорошо себя показывает при прямом подключении. В этом случае получаем приемлемую латентность, достаточную производительность.

- Большие расстояния. Оптические интерфейсы позволяют строить территориально распределенные решения на расстоянии до нескольких километров.

Минусы оптического iSCSI:

СХД с оптическим 10GbE является удобным решением для большинства задач. Однако, следует закладывать достаточный бюджет на сопутствующую инфраструктуру.

FC (Fibre Channel)

Текущая реализация в СХД: 16Gbps, разъем SFP+.

Плюсы:

Минусы:

- Незнакомая архитектура. Fibre Channel может отпугивать тех, кто ранее не сталкивался с данным протоколом.

- Порог вхождения. Цена начального приобретения решения на базе протокола FC несколько выше, чем на iSCSI.

Прокол Fibre Channel был специально разработан для сетей хранения данных, является оптимальным по совокупности параметров цена/удобство/скорость и рекомендуется для подключения блочных СХД для любых задач, особенно требующих высоких скоростей (биллинг, базы данных и пр.)

При стремительном росте ИТ-инфраструктуры является оптимальным выбором, т.к. позволяет разделить сеть хранения и локальную сеть для лучшего управления настройками безопасности.

FC является самым надежным, наименее проблемным и хорошо зарекомендовавшим себя протоколом, поэтому является рекомендуемым в корпоративном и банковском секторе.

FCoE (Fibre Channel over Ethernet)

Текущая реализация в СХД: 10Gbps, разъем SFP+.

Плюсы:

- Удобство управления и надежность. FCoE, являясь конвергентным протоколом, сочетает в себе все преимущества удобства управления от протокола iSCSI и при правильной сетевой инфраструктуре надежность протокола FC.

- Универсальность. Позволяет через единый порт одновременно передавать пакеты FC и Ethernet, что позволяет универсализировать доступ к сетевым устройствам.

Минусы:

- Цена. Коммутаторы, интерфейсные карты и в целом решения на базе FCoE являются самыми дорогими.

- Сложность внедрения. Для того, чтобы воспользоваться преимуществами данного протокола, необходимо правильно настроить сетевые параметры, что немного сложнее, чем в стандартных Ethernet сетях с IP роутингом.

Интерфейс FCoE может быть интересен только для больших инсталляций (например, с блейд-серверами) и, несмотря на множество положительных отзывов, мало распространен.

Большинство вендоров поддерживают мультипротокольное подключение к дисковым массивам, позволяя одновременно подключаться по нескольким интерфейсам сразу. Приобретение такой системы обходится немного дороже, зато избавляет от дальнейших расходов в случае изменения требований, решаемых задач или архитектуры доступа к данным.

В 2017 году ожидаются поставки СХД со следующими поколениями интерфейсов: FC 32Gbps SFP+, iSCSI/FCoE 25Gbps SFP+/40Gbps QSFP+. Использование обновленных версий протоколов сохранит баланс текущих плюсов и минусов.

Читайте также: