Не плавное изображение на мониторе 144гц

Обновлено: 09.05.2024

Чтобы получить игровое преимущество, нужен правильный монитор. Перед ним стоит несколько задач: выводить картинку правильно, то есть четко, с достаточной детализацией, а также делать это максимально быстро. Чем выше количество кадров в секунду меняется, тем раньше удастся обнаружить противника, да и в целом изображение будет более плавным. Это также полезно в кино, при видеомонтаже. Только вот бывает проблема, что не удается выставить подходящую частоту работы монитора. К примеру, в технических характеристиках заявлено 144 Гц, но система не разрешает выбрать более 60 или 75 Гц. Почему так происходит и как выйти из сложившейся ситуации? Сейчас разберемся.

Почему нельзя выставить нужную частоту обновления экрана?

Практически всегда современные компьютеры ограничивают рабочую частоту монитора из-за нескольких причин:

- Недостаточная пропускная способность кабеля. Каждый способ подключения имеет свой максимум, который можно выразить в предельном разрешении и частоте обновления. При чем, чем меньше разрешение, тем большее количество кадров сможет обработать видеокарта, передать и воспроизвести на мониторе.

- Компьютер не поддерживает современную версию стандарта подключения.

- Монитор просто не работает на той частоте с выбранным разрешением.

- Проблемы с драйверами. Они либо очень устарели, либо были неправильно установлены (инсталляция завершилась ошибкой), либо просто не подходят под данную операционную систему.

Нужно понимать, что все виды цифрового подключения имеют функцию автоматического определения возможностей оборудования. На это влияет тип кабеля и характеристики монитора. Информация EDID поступает на компьютер, и он понимает, что данный комплект оборудования не способен работать на более, чем 60 Гц. Отсюда и ограничение, отсутствие подходящего пункта.

Что можно предпринять?

Как мы уже разобрались, нам нужно дать понять компьютеру, что он может работать на большей частоте. Для этого нужно убрать слабое звено в данной цепочке, ведь именно оно и препятствует выбору правильного варианта. Конечно же, мы подразумеваем, что вам монитор действительно способен работать на большей частоте. Первым нашим подозреваемым становится кабель.

Заменить кабель

Для удобного восприятия опишем разные стандарты подключения и их максимальные характеристики в виде таблицы.

1440p при 144 Гц

1440p максимум на 165 Гц

1440p на частоте 240 Гц

4K уже со 120 Гц, если поддерживается сжатие – 144 Гц

1440p при 240 Гц

В 95% случаев данная таблица и будет ответом на вопрос, почему нельзя переключить монитор на большую частоту: 75, 120, 144, 240 Гц. наверное, вы подключили его по VGA или HDMI 1.4. Еще один вариант – компьютер поддерживает максимум HDMI 2.0, поэтому кабель 2.1 не работает в полную мощность. В силу обратной совместимости его пропускная способность падает до уровня самого слабого звена. При этом HDMI 2.0 не позволит выставить 75 Гц, а тем более 120 Гц для 4К. Он является самым популярным и распространенным стандартом подключения. HDMI 2.1 чаще встречается в геймерском оборудовании.

Проблема с драйверами

В старых компьютерах может иметь место неполадка с драйверами видеокарты. В новых ПК это встречается куда реже. Самое простое решение – удалить драйвер видеоадаптера полностью и установить его заново. Важно не использовать при этом программы автоматической инсталляции подобного ПО, а сделать все вручную. Удаление выполняется в «Диспетчере устройств» Windows, а нужный файл доступен на сайте Nvidia и AMD .

При условии, что компьютер работает с выбранной версией стандарта подключения, монитор его воспринимает, а кабель – передает, проблема уйдет. Компьютер получит по EDID одобрение на большую частоту работы и все будет ок. Однако нужно учитывать, что важна не только частота, но и разрешение. Возможно, монитор поддерживает 4k и написано, что работает на 144 Гц, но не одновременно. Нужно в технических характеристиках прочитать, возможно, в FHD 144 Гц, а в 4k – только 60 Гц.

Про то, что можно разогнать процессор, видеокарту или ОЗУ, слышали, я думаю, большинство пользователей ПК. Однако про то, что можно разогнать еще и монитор, знают немногие, причем зачастую разница от его разгона существеннее и заметнее, чем от разгона другого железа. Также она еще и безопаснее, но об этом ниже.

Теория

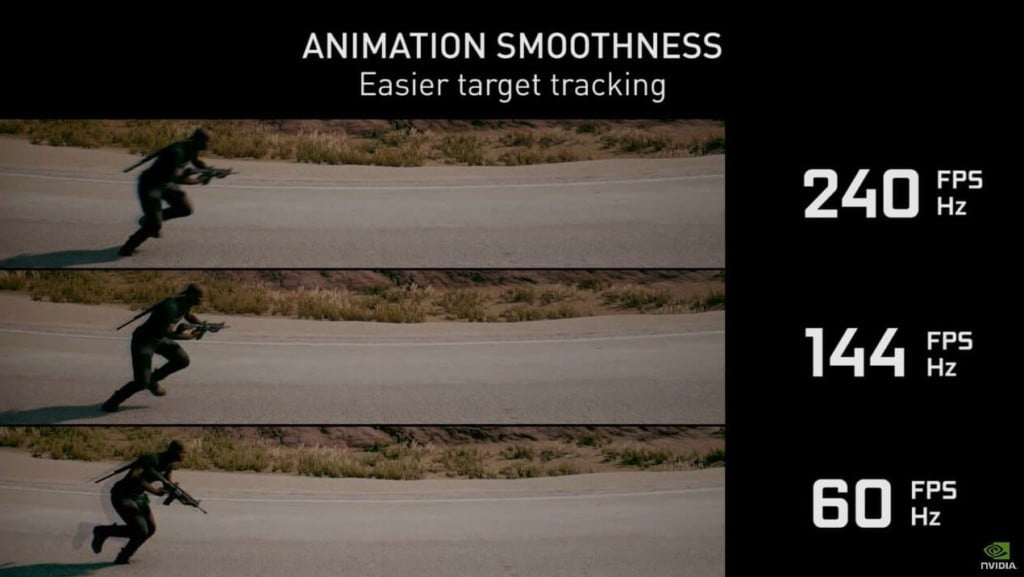

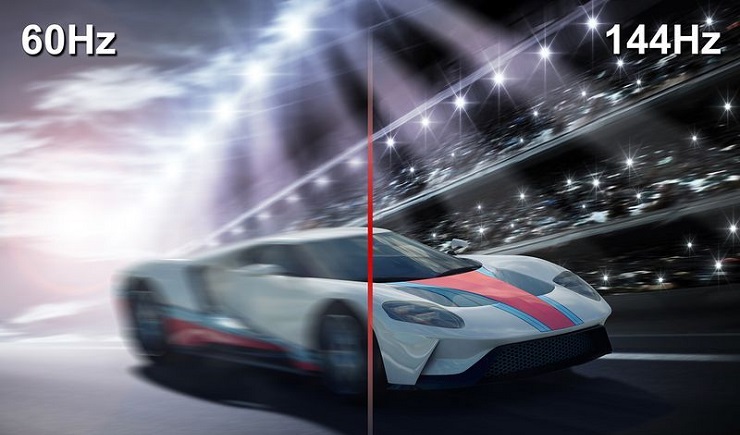

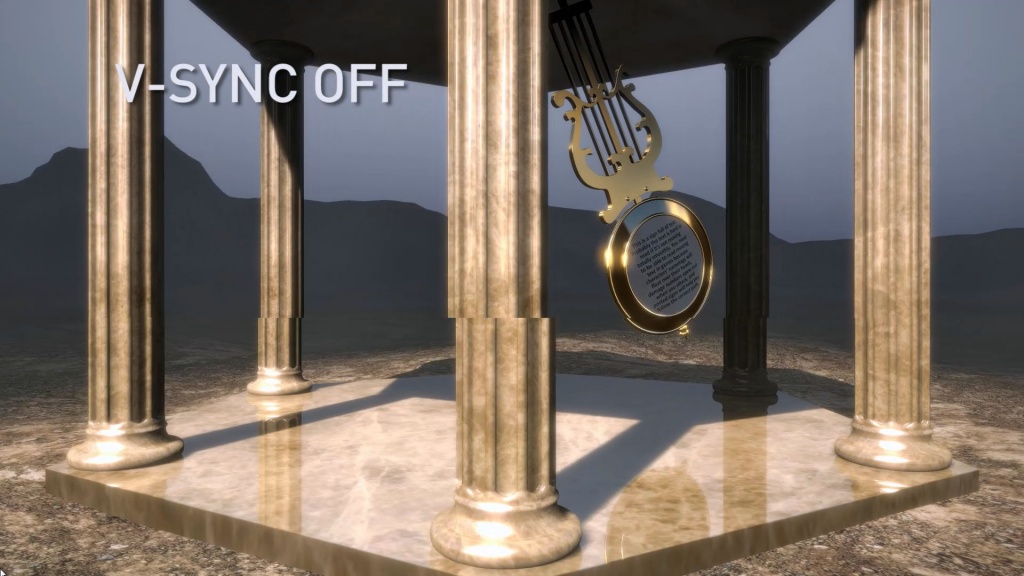

Для начала — что же подразумевается под разгоном матрицы монитора? Подразумевается увеличение частоты обновления монитора со стандартных 60 Гц и на сколько получится — 70-75, бывает и 120, и даже 150 Гц (!). Зачем это нужно? Чтобы повысить плавность картинки. Что означает, что частота обновления монитора — 60 Гц? Это означает, что картинка на экране меняется ровно 60 раз в секунду. При этом видеокарта может выдавать как меньшее количество fps, так и большее. Если количество кадров, выдаваемых видеокартой, меньше частоты обновления, то, значит, какой-то кадр будет дважды (а то и трижды) выведен на экран, что может привести к ощутимым задержкам. Если же количество кадров, выдаваемых видеокартой, больше частоты обновления монитора, то получится так, что на экран будет выдаваться сразу два-три кадра, что приведет к артефактам:

Компромиссом является установка вертикальной синхронизации. В чем ее суть? Она жестко привязывает один кадр, подготовленный видеокартой, к одному обновлению картинки на мониторе. И тут, если ваша видеокарта выдает стабильно больше кадров, чем частота обновления монитора, то вы получите идеальную плавную картинку, ну а ваша видеокарта при этом временами не будет загружена на 100% и будет отдыхать. И именно такой режим работы зачастую используется в системе — к примеру, когда вы скроллите в браузере, артефактов вы не видите, и при этом скроллинг плавный.

Поднятие частоты обновления монитора убивает сразу двух зайцев: во-первых, теперь вертикальная синхронизация будет идти на более высокой частоте, а значит плавность еще повысится (думаю, все видели разницу в роликах на YouTube с 30 и 60 кадрами? Вот тут также). Во-вторых, если ваша видеокарта в играх выдавала больше 60 кадров в секунду, то теперь порог появления артефактов отодвигается до новой частоты обновления, при этом информация на экране будет обновляться чаще, что достаточно важно для динамических игр.

Разумеется, возникает вопрос — насколько это безопасно? Гораздо безопаснее разгона железа: если монитор не может работать на заданной частоте, он просто не включится. Если на заданной частоте он заработал — значит, никаких проблем у вас не будет. Перегрев ему, как в случае с разгоном процессора или видеокарты, точно не грозит.

Практика

Теперь, когда немного разобрались с теорией, можно перейти к практике. Первое, что нужно знать — гонится любой монитор и даже матрицы ноутбуков, но тут есть сразу несколько сдерживающих факторов. Первый — это способ подключения: через DVI при разрешении 1920x1080 вы вряд ли получите свыше 65 Гц — сказывается достаточно низкая пропускная способность интерфейса. Через старые HDMI (до 1.4) при том же разрешении вы скорее всего сможете получить частоту около 75-85 Гц. Ну а через новые HDMI (1.4-2.0), Thunderbolt или DisplayPort ограничений практически нет — можно и 120-165 Гц получить. Аналогично зачастую нет ограничения у матриц ноутбуков, подключенных напрямую к плате. Второй сдерживающий фактор — сама матрица, вернее ее контроллер. Бывает, что даже с быстрым подключением при повышении частоты появляются некоторые артефакты изображения — увы, тут уже ничего не сделаешь, кроме как снижать частоту до последней стабильной.

Теперь поговорим о том, как разгонять. Владельцам видеокарт от Nvidia тут везет — для них алгоритм прост: нужно зайти в панель управления Nvidia, перейти на вкладку «Изменение разрешения», нажать на кнопку «Настройка», в открывшемся окне поставить галку на включении режимов, не поддерживаемых дисплеем, после чего нажать на кнопку «Создать собственное разрешение», и в открывшемся окне мы наконец-то получаем доступ к изменению частоты обновления:

Частоту стоит поднимать на 3-5 Гц, после чего нажимать на кнопку «Тест». Если никаких артефактов не появилось и изображение есть — поднимаете частоту еще выше. Как только появились артефакты или исчезло изображение — снижаете до предыдущей рабочей частоты, и дальше поднимаете уже по 1 Гц — в общем, тут все ровно как при обычном разгоне видеокарты. После того, как нашли нужную частоту обновления, просто сохраняете полученную конфигурацию, и она появится в пользовательских разрешениях.

Как видите, тут риска никакого — если монитор «не завелся» на указанной вами частоте, через 20 секунд система откатит значение частоты на дефолтное. Увы — все так хорошо только с видеокартами от Nvidia, с видеокартами от AMD или Intel все хуже — там в настройках драйвера частоту увеличить нельзя, однако есть универсальное приложение, которое поможет это сделать — называется оно Custom Resolution Utility (CRU), скачать его последнюю версию можно тут.

Сразу предупрежу — проблема программы в том, что у нее нет кнопки Тест, как в случае с Nvidia, поэтому частоты применяются сразу и бесповоротно. Так что если после выставления частоты вы видите черный экран — вам поможет или подключение второго монитора и возврат настроек на дефолтные, или же заход через безопасный режим и проделывание того же самого.

Работать с программой достаточно просто — вы ее запускаете, удаляете все разрешения из стандартных и снимаем все галочки слева (у себя я этого проделывать не буду, ибо уже разогнал матрицу через настройки Nvidia):

Теперь под окном с Detailed resolutions нажимаем на кнопку Add, выставляем Automatic - LCD Reduced и ниже меняем частоту обновления:

Тут принцип тот же — увеличиваем частоту на 3-5 Гц, нажимаем ОК, все сохраняем и перезагружаемся. Теперь заходим в панель AMD (или Intel) и выставляем новую частоту:

Вот, в общем-то, и все — как видите, ничего трудного или опасного нет.

Ну и остается последний вопрос — раз разгоняются почти все матрицы, то почему этого не делают производители с завода? Тут все просто: есть такое понятие, как стандарт, и для частоты обновления мониторов он уже достаточно давно составляет 60 Гц. Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц. Во-вторых — зачастую все упирается уже в способ подключения. К примеру, передать 1080р60 можно по любому интерфейсу, хоть DVI, хоть Thunderbolt 3. А вот для 1080р80 уже нужен специальный кабель — DVI и старые HDMI уже не подходят. И чтобы не создавать путаницу, производители опять же ограничились 60 герцами.

Что касается вопроса, разгонять или не разгонять — решать вам и только вам. Если у вас получилось увеличить частоту с 60 до 65 Гц — то смысла в таком разгоне нет, разницу вы не увидите. А вот при разгоне уже до 75 и выше Гц разница становится явно видной, так что игра тут стоит свеч. Также следует учитывать, что после разгона повысится нагрузка на видеокарту при обычной работе — ведь ей теперь придется выдавать больше кадров в секунду, так что если вы разгоняете матрицу на ноутбуке — следует учитывать, что у вас несколько снизится время автономной работы.

Добрый день, купил монитор Dell S2721HGF ситуация такая, с гсинком сама по себе картинка плавная, но при просадках фпс, время кадра повышается, из-за чего фпса становится меньше чем его есть на самом деле (на экране 80, но ощущениям 40 и дико фризит), по ощущениям картинка с остаточным изображением и немного моргает на экранах загрузки, ток не прям черным, а светлым. Без гсинка все проблемы уходят кроме одной, картинка становится дерганой, чего быть не должно. Допустим на моем телике и старом монике с всинком картинка была такая же плавная как на новом монике с гсинком, а без гсинка на новом монике по плавности картинка хуже чем на старом мониторе и телевизоре. Еще вот что пробовал, ограничивал частоту до 60 в панели управления, но картинка становится не чисто 60 фпс, а супер дерганая, такое чувство как будто там 30гц. Все делал, дрова ставил, менял, подрубаю через DP. Я думаю это особенность 144гц моников, хочешь что бы работало, нужно что бы фпс был 144 и не ниже, но он то зараза просаживается, тем более в одиночках. Помогите пожалуйста разобраться.

Странно, у меня тоже 144, естественно просадки в играх будут, но чтобы очень заметно не ощущал. А какой у тебя пк? Может у тебя резкие просадки из-за самого пк?

Gtx 1080, 8700k разогнанный до 4.9, 16 озу 3100 ,ссд

Тогда очень странно. Но то, что "Я думаю это особенность 144гц моников, хочешь что бы работало, нужно что бы фпс был 144 и не ниже"

Это точно не так. На практике должно быть все плавно, даже, если фпс скачет с 144 до 80 и ниже. Прям дерганий не должно быть, тогда такие моники как кирпичи были. К тому же как я понял, у тебя моник фул хд, то есть твоему пк вообще без напряга должно быть. У меня тоже фул хд и 144, вот нет ничего такого, правда у меня AOC. Пока даже без понятия, драйвера точно встали не криво? Там бывает еще софт на мониторы от производителя, в них можно все настроить, попробуй найти, потому что свой я через такую прогу настраивал, без нее у меня он не видел 144 герца.

Драва менял пару раз, а софт абы какой ,там те же настройки которые я могу накрутить кнопками монитора.

Ну ты попробуй на всякий. Тк. у меня нвидия вообще не видела до этого софта 144 и ставила то 75, то 100, то 120. А как они применились, так все применилось и в панели теперь.

Ну вот а ты можешь сейчас выставить в панели нвидиа макс частоту 60гц и зайти в колду, овер или ченить онлайновое, посмотреть, у тебя будут нормальные плавные 60гц, или дико дерганные?

Будут они такие, как если бы у меня был моник 60 гц, это я проверял. Думаю у тебя какие то проблемы с настройками.

Ну попробую завтра к ноуту подрубить, отпишусь. Кста, когда в настройках винды ставлю 60 герц, у меня так же подтормаживает стол и матрица становится высветленной.

Может реально брак? Вот это точно не должно.

Тоже думаю о покупке 144 моника, и интересно как будет вести себя картинка при дропах

Выше 60 заметна плавность и если бывают дропы с 100 до 70, то незаметно. Ниже 60 по ощущениям слайдшоу. Говорю на своём примере и игры Warhammer: Vermintide 2.

Заметно, разница теряется между 140-165, скачки 70-100 заметны и лучше ставить лок.

Вообще, это минус таких моников, нужно каждую игру настраивать перед тем как начать играть.

Ну когда играешь в экшен то не заметно. Особенно если нагрузка в бою неравномерная по замесу.

Комментарий удален по просьбе пользователя

Да понятно, вот ток хз как 2к 144 на 3070 будет вести себя, с учетом того что новинки люблю побегать

Комментарий удален по просьбе пользователя

Очень заметна разница конечно. Если фпс долгое время держится в рамках 144, а потом падает до 110 и ниже то ощущается это неприятно. Будто тормозит :D

Попробуй ограничитель выставить на 72фпс,через приложуху зелёных. Лучше все таки ограничения делать кратными гц. Но проблема у тебя явно странная.

Я ставил только 60, там кромешный ад, я попробую ,но уверен, 72 не решит

А смысл ставить на 144ом 60? Это же такая кастрация. Весь смысл моника убиваешь.

Я ставил в качестве эксперемента, после того как у меня на меньше 80 начинает фризить.

Я же говорю это не кратное значение. 144гц это значение количества обновлений монитора в секунду. 144 /60=2.4, тоесть каждый 5 кадр может не отрисоваться с задержкой, г синк его придерживает и только 5 попадает в тайминг из-за этого может быть визуально фигня. 72 кратно развёртке монитора, по этому каждое второе обновление у тебя новый кадр.

Понял, чисто ради интереса попробую) спасибо

сори, но кратность значения - глупость. Если это всинк, то он и будет кратным (хотя и не обязательно, но тогда фпс не будет константным априори), если просто огранчитель фпс -то хоть точное значение с герцовкой поставь, синхронизации подачи кадра в буфер с развёрткой (отображением на мониторе) не будет.

Не совсем так работает, г синк точно сообщает монитору когда и какой кадр рисовать и когда нового кадра нет. По этому если кадр не успел к обновлению отрисоваться, то монитор задержит прошлый кадр. Соответственно между кадрами создаётся дополнительная задержка, при кратном каждый второй кадр рисуется мониторов с буфера видеокарты равномерно. По этому если кратность не совпадает, где-то будут задерживается кадры на дольше из-за этого будет ощущение неравномерности. Это как раз про г синк, если он не включён задержки не будет, просто кадры будут вообще из разных отрисованы кадров и начнётся тиринг.

я думал речь про ограничение с отключенным gsync'ом. Тогда смысл какой-то есть, правда по логике как раз это (любое ограничение с синхронизацией) и будет делать картинку дёрганей.

В том то и суть, что если кратно то не будет. А если не кратно, то из-за каждой задержки не кратного кадра происходит увеличение времени кадра. А при кратном, все должно быть идеально, само собой если фпс не будет падать ниже заданого лимита.

(на экране 80, но ощущениям 40 и дико фризит)

Тут виновато явно что-то большее, чем gsync. Не сталкивался с подобным.

по ощущениям картинка с остаточным изображением и немного моргает на экранах загрузки

А это - извастная херня с gsync'ом. Не знаю, на всех ли мониторах, но на большинстве - точно. Как только частота кадров просаживается ниже минимальной поддерживаемой gsync'om, он отрубается, и это сопровождается небольшим изменением яркости картинки. Отдельные случаи - не заметны, но если просадки частые и фреймрейт скачет туда-сюда (что и случается на экранах загрузки), это очень заметно и может бесить.

Без гсинка все проблемы уходят кроме одной, картинка становится дерганой, чего быть не должно.

Если vsync не включен - вполне нормальная картина. "Разрывы" кадра вполне себе могут создавать ощущение "дерганной" картинки.

Допустим на моем телике и старом монике с всинком картинка была такая же плавная как на новом монике с гсинком, а без гсинка на новом монике по плавности картинка хуже чем на старом мониторе и телевизоре.

А ты уверен, что это так? Просто, я по собственному опыту знаю, что очень легко привыкнуть к новой плавности, и потом кажется, что всегда так было. После 144Hz, например, 60 больше не кажутся плавными. Но потом привыкаешь, и все опять ОК.

Даже не выходя за диапазон гсинка картинка мазанная, в HS на 144гц картинка моргает. Без гсинка я включаю всинк само собой и картинка как я и сказал дерганная. И нет я не привык к 144, я четко вижу как на телике в 60гц картинка приятнее чем на 144 монике.

Что за игра?

Много лет на 144гц монике, и ни разу этих симптомов не наблюдал. Более того, что такое разрыв кадра и зачем gsync вообще не ведаю, хотя играю на фпс ниже герцовки в синглплеерные игры, само-собой.

Я думаю это особенность 144гц моников, хочешь что бы работало, нужно что бы фпс был 144

Купил 144 хз-монитор, а компьютер, стабильно выдающий эти 144 хз, прикупить забыл. Пурум-пурум-пум.

Я играю в варик, а там игра старая и использует всего полтора ядра, в основном там 200+ фпс, но чем больше персонажей в кадре, тем больше нагрузка на проц, вот и фпс просаживается с 200 до 75

Тогда вопрос снят.

Так, а разве гсинк не нужен для того чтобы при дропах скидывать Гц до оптимальных? Заказал себе моник 144 гц из расчета, что это так, теперь очкую ))

П.С. по характеристикам в этом монике freesync,. может из-за этого. Они работают с зелеными начиная с 1000 серии, вроде ред.

Когда покупаешь моник в 144 герца, да и еще и в 2к, позаботься о том, чтобы увидеть все прелести картинки и о железе пк. На 1050ti например, будет наивным ждать что-то. Моник сам фпсы не рисует.

В курсе, моник fhd, карта 1070

Ну с фрисинком-гсинком себя так моник ведет

В планах у двух знакомых узнать как ведет себя монитор при таких прасадках, еще возьму у брата ноут, там 144гц, его чекну и подрублю свой моник ,посмотрим что будет. Если все пичально, то лучше я возьму 60гц 2к, надеюсь если я выставлю в некоторых играх FullHD на 2К монике, то ни каких проблем это не вызовет, как с герцовкой.

Привет, лично у меня на 2к мониторе, при выставлении 1080p получается мыльная картинка. Напиши, пожалуйста, потом ,что получилось по итогу. Может у меня у самого монитор УГ.

Жизнь - боль, надежды нет

У всех ЖК мониторов картинка четкая только в родном разрешении - это принцип их работы. Так что несли берешь фуллхд, то и играй в фуллхд. Если берешь 2к, то и играй в 2к.

Возможно, не совсем в тему.

Имею fullHD монитор на 144гц с фрисинком.

Старая видеокарта от зелёных, соответственно сам монитор подключен обычным кабелем дисплей порт, который был в комплекте.

В системе стоит настройка 144гц, стороннего софта нет.

Комп уже очень старый, но в том же Овервотче бывают просадки, и глазу не приятно, абсолютно так же как и при старом мониторе 60гц. Постоянное дёрганье и просадки, как ты описываешь, не испытывал.

И ещё важный момент, мой монитор работает только 144гц + DisplayPort. Если хдми кабель, то только 60гц.

Скажу разница между 60гц и 144гц чувствуется только обратная. Когда после долгого использования возвращаешься на 60гц.

Ну всем кому показывал 144 прям в восторге, разница на голову :)

Комментарий удален по просьбе пользователя

Единственное что я могу предположить - в некоторых приложениях Gsync вступает в "конфликт" с v-sync который выставляется в самом приложении. Можно попробовать его там отключить в настройках.

Какой процессор? Фпс дропается в конкретных играх или вне их тоже?

8700К, картинка дропается естественно, из-за нагрузки и старого движка, но если я ограничиваю частоту до 60 гц, то во всех играх так фризит на 60 ред.

То что ты описываешь похоже на статтеры. Что-то кроме видеокарты является бутылочным горлышком в системе.

Часто виной бывает слабый процессор в таких случаях. Нужно глянуть на график загруженности

Еще может быть разгон избыточный, попробуй все на дефолт сбросить если разгонял. профиль оперативы в биосе например

Гнал по полной, над проверить

А подключение через Display Port ?

Видяхи поколения 10x0 имеют проблемы при работе g-sync через DP есть даже официальный патч для биоса видяхи

Хм, у меня стоит последнее обновление или это другое?

немного моргает на экранах загрузки,

это норма

Если во время игры падения сильные будут то и там мерцать изображение будет.

Да, читал про такое, но это не самая большая проблема.

А так при 60 фпс нормально играю на 144 мониторе. Никаких статеров-подергиваний или еще чего-то подобного. Гсинк и всинк не отключаю.

Попробуй залочить не на 60, а на 59.983. На 60 вроде как и неправильно лок ставить.

ну то что с gsync'ом хуже это то понятно. А вот что не так без синхронизации я и не понял. Что значит картинка становится дёрганней? Может дело в самих просадках? Падение фпс с 140 до 100 ощутимы на глаз. Запусти какой-нибудь тест с стабильными 80-100 гц (выбери конкретное значение) и зацени, будет ли такой эффект. Ограничение кадров это не одно и то же, что я предложил.

Ну тип персонаж двигается плавно, а мир вокруг вроде и 144, но когда вот летишь, он рывками показывается, я мб сегодня видео запишу.

У меня AOC g2590px, 9700k, 2060 Asus Strix, подключен через DP, в играх дерганий не замечал, даже при просадках до 60 фпс, вертикальную синхронизацию всегда в играх отключаю.

Но, однажды, у меня после обновления стали непонятно дергаться игры, причем фпс было около 144, методом тыка обнаружил, что у меня включился g-sync (нативно моник идет с адмсинк или как его там, но нвидия в дровах добавили поддержку гсинк), после отключения все снова стало качественно.

Может стоит и вам попробовать отключить g-sync и вертикальную синхронизацию и проблема решится? На 144гц мониторах разрывы кадров не так видны как на 60гц.

Как раз таки без гсинка у меня даже 144 дергается, а с гсинком дико фризит при фпсе ниже 80.

Как оказалось, последние видеокарты NVIDIA работают совсем неправильно, при подключении через…Спасибо, завтра попробую. Хотя там про DP 1.3-1.4 пишется, у меня наверно 1.2. Я вот подумал, мб воткнуть моник еще в мать, а не в видеокарту.

Пишет, что прошивка не совместима с видеокартой

rtx 2060, подключена через display port 1.4

Обновил, лучше не стало, мб когда подключу через 1.4 что-то поменяется.

Ну по видео сложно определить, заметил только на кустах фризы, да, что то типа того.

Ну судя по тому, что вы описали, у меня точно такая же проблема

Что забавно, пробовал ставить старый моник, все так же дергается на 60 фпс, хотя до покупки нового монитора 144гц все было хорошо

Ну у меня на старом не дергается, все отлично

А вы проверяли старый монитор, после того как начались проблемы с новым? Если нет, то можете попробовать ради интереса

Проверял, все отлично, что моник, что телик, правда на монике старом даже с выключенным из ризетки новым монитором, картинка тип не закругленная как как экран нового монитора, а наоборот пузатая)))) Забавно выглядит, но я его продал и на др пк все хорошо

У меня монитор 240 Гц. С G-Sync играю RDR2 в 70 фпс без проблем. Монитор подстраивается.До этого был AliеnWare, поменял на ASUS тоже 240. Все работает четко. карат 2060S. Если фпс падает ниже 60, монитор ставит герцовку в 2 раза больше. Например при 50 фпс, 100Гц. На обоих мониторах. Попробуй вкл. счетчик фпс на мониторе если есть. как у меня на первом фото. Посмотри как себя ведет. И галка в нвидиа панели должна стоять, чтобы все работало. Еще вопрос DP кабель не думал поменять?Он в комплекте был? Ну и по хорошему видео записать бы через оверлей нвидиа.

А вообще много людей жалуется на высокочастотные мониторы. что G-SYNC хреново работает в бюджетных моделях типа AOC, Samsung и прочего. А Dell за 18к - бюджетная модель, как ни крути. Тем более 27 дюймов.

Крч более-менее разобрался, я в основном играю в игры Blizzard, там есть описанные косяки, а вот в остальных играх все отлично, ведьмак, вотч догс 2, дивижка, крч везде показывает нормальный фпс, если в игре выдает 60, то так оно и выглядит. Вот только без гсинка во всех играх картинка дерганая все равно, а с ним все супер плавно.

Кстати в овервотче уже дней пять проблемы, со статерами из за потери пакетов,кажется будто кадры пропускает.

У кого то почти незаметно,а у некоторых оч сильно раздражает

Заходил пару дней назад, вроде норм было

Я думаю это особенность 144гц моников, хочешь что бы работало, нужно что бы фпс был 144 и не ниже, но он то зараза просаживается, тем более в одиночках. Помогите пожалуйста разобраться.

Не думай. Чтобы работала адаптивная синхра, надо, чтобы не падало ниже 48. Во всех остальных случаях картинка идеально гладкая. Хоть как фпс гуляет - похрен вообще. У меня так везде, во всех играх.

У меня правда 240гц. ред.

Ну в современных играх вроде как 60 выглядят на 60, а вот в варике все печально.

Решил собрать новый ПК, т.к. на старом (gtx970, i5 4690k) фпс в новых играх не вытягивал, и собрал такой:

MSI RTX 2070 super

16GB RAM (2x8) 3200Mhz

Материнка MSI Z390-A PRO

Монитор AOC G2460PF

И, стал свидетелем ужасного разрыва кадров в динамических сценах (этот самый тиринг)

Нагуглил все возможное на эту тему, но решения так и не нашел. Перепробовал следующее:

Переустанавливал ОС (с 10-ки, на другую 10-ку), менял 3 раза

Переустанавливал драйвера Nvidia

Менял все настройки в панели управления nvidia

Менял кабели питания, дисплей порта, розетку

Менял порты на дисплей порта на видеокарте

Менял кабеля с пинами на видеокарте, переставлял ее в другой PCIe слот на материнской плате

Менял все настройки монитора, и т.д. (может еще что забыл упомянуть)

Далее, я сделал следующее:

Свой старый BENQ 144гц монитор я менял на новый 144гц AOC, по той причине, что на RTX2070 нет VGA порта, только DP и HDMI, а т.к. 144гц HDMI не передает, я брал AOC.

В общем, я подключил старый BENQ через HDMI, чтобы проверить наличие тиринга. Поддерживал он только 1440х900 120гц. И, тиринга я не обнаружил, ну или он был, но не так сильно заметно. Когда я играл с ограничением фпс (ставил например 120фпс лок) - тиринг был, но опять же, незначительный.

На старом пк, я вообще не знал что такое тиринг, и не видел его не при каких локах и настройках. А тут другая история.

В общем, я начал грешить на монитор AOC, продал его, и заказал другой BENQ с DP.

Тиринга стало меньше, да, но он все еще остался. Особенно он заметен в динамичных играл по типу Apex.

Интересные особенности: в Apexe, когда играю fullscreen тиринг есть ужасный, меняю на оконный без рамки - тиринг исчезает, НО, 50% времени у меня хорошая картинка (какая и должна быть), а остальные 50% - жуткие дропы (по ощущениям как будто герцовка монитора или фпс сильно дропаются), но с ФПС-ом естественно все окей.

Еще, когда я переставлять видеокарту в другой слот на материнке - я слышал характерное жужание в наушниках во время игр. Тон жужания менялся, если я менял лок фпс-а, ставил вертикалку и т.д. В итоге я вернул обратно в другой слот, и жужание пропало. Возможно по этой инфе можно сделать какой-то вывод.

Еще, жутко лагает в Биосе (такое чувство, что у меня там 10-15фпс), не знаю, может это еще о чем-то должно говорить.

Вертикалка не решение. Да, возможно она убирает частично тиринг, но так-же добавляет инпут-лаг и картинка становится "масляной". Но и с ней с картинкой "что-то не так". На старом ПК, опять же, я не знал вообще о существовании Тиринга и картинка была идеально плавной в рамках моих герц, и кадры не рвались.

На видео тиринг не захватывается.

Его так-же видно на твиче и вообще везде, где сцены динамичные. Почти всегда это нижняя или верхняя часть экрана, но бывает и в центре.

В общем, я не знаю на что грешить (что пробовать менять), или что вообще делать. Перепробовал все, что вычитал и пришло на ум.

Если у вас есть идеи решения - пожалуйста поделитесь. Ибо, то что происходит у меня на мониторе - это рак для глаз. Если нужна какая-то дополнительная информация/тесты/скрины чего-либо, пишите, всю инфу дам.

Илья, блин. Наверное все же субъективщина, нужно как-то опробовать может в магазе что-ли. А нет каких-нибудь видео на эту тему?

Роман, ты хочешь на 144 перейти? Сначала будет сильный эффект, потом привыкнешь

Илья, нет, мне не позволят деньги покупать какие-нибудь 3070 и выше, + i7. А страдать потом при понижении фпс, ипаться с разгоном процессора и видюхи. Охлад топ ставить, ну не хочется совсем, я чисто из спортивного интереса

Илья, согласен. Меня просто обсирали там в недавнем посте, что я постоянно про 144 Гц парюсь, что нищеброд и прочее. Хотелось объективного мнения, без оскорблений

Может есть хоть видео на эту тему? Сравнение какое-нибудь

Роман, как ты на видео это увидишь?) Если у тебя 60hz монитор, у меня в таких случаях фрисинк выручает)

не знаю, может будет заметно. Мне больше никак не посмотреть, нет возможности

Роман, во первых видео на тот же ютуб свыше 60 кадров не выложить) во вторых это не комп фризит, а визуально матрица и на видео будет все плавно

Роман, короче не еби голову, бери 144гц монитор, те игры которые не вывозит твой комп ограничивай фпс на максимальном фпс в этой игре и все будет плавно, у меня ассасин на сред-высоких идёт 70-80 кадров и нормально дерганий не замечаю

чем режете фпс? Риватюнер плохо режет, нет плавности

У меня в кс если ниже 300 падает то уже супер не комфортно.

Maxim, нифига себе. Я слышал что чем больше кадров тем лучше, тип игроки видят разницу, но сам не играю в КС, сюжетки и ММОРПГ наподобие Dragon Nest

Роман, в кс просто очень высокая привязка к инпут лагу, там меньше 200 уже не комфортно становится

Maxim, чел понимаю у меня если меньше 400 падает в танках тож не очень

подтверждаю, если нет стабильных 144 фпс играть то падения до 120 кадров заметны, но если оставить лок на 120 то норм, ниже 100 фпс играть очень не приятно

Если я играю в игру которая не может дать стабильно 144 кадра, я режу фпс до 120 или 100, так как прыжки FPS - могут влиять на гемплей.

----------------------

Если проще - ты не привыкаешь к динамике, которая не стабильна.

MSI AF не использую с 2012 года - лаганная параша. Режу через панель Nvidia, там есть такая возможность.

а если Амуде, то я сочувствую =) и желаю удачи, были rx 570 + 5700 = впечатления такие, что реально плакать хочется.

после 10 лет зелени, я реально чуть не заплакала когда вставил 570 и аху. а потом переставил на 5700 и тоже самое говно. Все по другому. Много чего нет вообще.

Стрим через них = мука, куды нет вообще, настройки драйвера - просто ужас + половины нужных настроек не нашел, такой фишки как Nvidia Profile нет = минус улучшения графики в любой игре. Версия драйвера может кардинально менять производительность карты в какой либо игре. То есть жеоезо очень софтозависимое, а софт говно = железо говно

Олег, улучшение графики. Ну не знаю, да там меньше всего в Амуде, но пока робит, норм. Мне чисто не хватает проиводительности, нужно хотя 2060S. А 6700 и 6800 там пока допилят дровами и софтом, пройдет год)) Ну как обычно, RX хоть более менее вылизанные и давно Паскали типа 1060 эбут. А на выкате та же RX 580 была менее производительной) Еще один камень в пользу занижения дровами от Нвидии.

У AMD только одно норм - Цена/производительность. Но функционал и стабильность той самой производительности в цену не входят

Читайте также: