На компьютерах которые оперируют

Обновлено: 02.07.2024

Специалисты Университета Дьюка смогли решить фундаментальные проблемы, связанные с ошибками квантовых компьютеров. Авторы объединили несколько кубитов, с помощью которых работают машины будущего, так, чтобы они функционировали как единое целое, то есть образовали логический кубит. В данной конструкции один кубит содержит нужную информацию, а другие позволяют исправлять ошибки. Таким образом, вероятность квантовых ошибок может быть сведена к минимуму.

Машины будущего настолько сложны, что для работы с ними нужны особые языки и квалифицированные специалисты.

До изобретения квантовых компьютеров ученые полагались на суперкомпьютеры — устройства, отличающиеся от обычных ПК габаритами и наличием сотен, если не тысяч ядер центрального процессора. Однако для работы с определенными массивами данных обычные компьютеры даже с тысячами ядер не очень подходят. Компания IBM, которая создала около 20 квантовых компьютеров, объясняет недостатки классических машин особенностью строения.

В качестве примера приводится задача, когда нужно разместить несколько привередливых гостей за столами, и при этом есть только один оптимальный план рассадки. В случае, когда гостей пять, таких комбинаций 120. Если количество гостей увеличить до 10, то будет более трех миллионов комбинаций. Обычный компьютер начал бы решать задачу постепенно, обрабатывая каждую комбинацию, — на ответ ушло бы очень много времени. Квантовый компьютер создаст огромное многомерное пространство, в котором сможет вместить все варианты ответа и найти верный.

В Google, где также работают над квантовым компьютером, считают, что вычисления, на которые современные ПК потратят 10 тысяч лет, машина закончит за три с половиной минуты. Например, существует определенный список из одного триллиона значений, и нужно найти лишь один подходящий элемент. При условии, что на проверку каждого элемента дается миллисекунда, обычный ПК справится за неделю, квантовый — менее чем за одну секунду.

Классические устройства — даже если обеспечить их тысячами процессоров с десятком тысяч ядер — оперируют битами, то есть воспринимают информацию в двоичной системе. В этом случае данные принимают значения только в виде единицы или нуля. Квантовые машины производят вычисления с помощью кубитов, где информация может иметь значение одновременно и в виде единицы, и в виде нуля. Это означает, что кубиты, в отличие от битов, могут принимать различные значения одновременно и выполнять вычисления, которые обычный компьютер не способен совершить по своей природе.

В первую очередь эти продвинутые устройства можно использовать для проведения научных экспериментов. Например, можно моделировать поведение атомов и частиц, которое сейчас реально воссоздать лишь на очень сложном уровне, например, в Большом адронном коллайдере. Также квантовые компьютеры могут оперировать с гигантскими массивами данных, состоящими из миллионов элементов. По оценке ученого Лова Гровера, базу с миллионом единиц обычное устройство проанализирует за миллион шагов, квантовый компьютер потратит всего тысячу.

Уже упоминалось, что квантовые компьютеры оперируют кубитами, а значит, могут работать с огромным количеством данных одновременно. Например, такое устройство могло бы обычным подбором быстро взломать любое шифрование. Если посмотреть на ситуацию с другой стороны, то передовые компьютеры можно будет использовать для предотвращения взлома различных систем. Безусловно, квантовые компьютеры пригодятся при работе с искусственным интеллектом, который часто полагается на комбинаторную обработку очень больших объемов данных для более точного прогнозирования и принятия решений.

Вероятно, на ранних этапах применения квантовых компьютеров машины будут задействованы в финансовой сфере. Она отличается от многих тем, что охватывает огромные данные. Устройства могли бы выполнять сложные финансовые расчеты и моделировать движение рынка.

В последние несколько лет большую популярность обретают системы, в основе которых лежит так называемый блокчейн, привлекающий пользователей рядом своих преимуществ: децентрализацией, неизменяемостью данных, прозрачностью, а также отсутствием доверенного центра, то есть посредника. Предоставление таких преимуществ возможно благодаря двум “китам” блокчейна: асимметричному шифрованию и использованию хэш-функций. Однако в связи с развитием квантовых вычислений безопасность этих примитивов стала под угрозой, поэтому возникает необходимость нахождения новых подходов к построению блокчейна, который будет устойчив к атакам с помощью квантового компьютера — так называемого постквантового блокчейна. В данной статье освещается, какие части блокчейна являются наиболее уязвимыми для атак с помощью квантового компьютера, насколько реальны эти угрозы, какие существуют подходы к построению постквантового блокчейна, устойчивого к ним, и насколько применимыми оказываются эти подходы.

Для начала вспомним, что из себя представляет блокчейн, чтобы затем понять, почему он уязвим к атакам с помощью квантового компьютера. По сути, блокчейн — это база данных, состоящая из цепочки блоков, в которой каждый блок хранит в себе хэш от предыдущего блока, в результате чего для изменения или удаления блока из середины цепочки необходимо перестраивать все последующие блоки. Подсчет каждого блока является вычислительно сложной задачей, поэтому перерасчет блоков оказывается практически невозможным и поэтому блокчейн обладает свойством неизменяемостью данных.

Такой вычислительно сложной задачей может быть, например, поиск коллизий хэша: нахождение некоего числа, proof-of-work (англ.: доказательство работы), при добавлении которого хэш от блока начинается с нескольких нулей. Данная задача с помощью классического компьютера может решаться лишь перебором, из-за чего среднее время нахождения такого числа экспоненциально растет с ростом требуемого количества нулей. Более подробно об этом можно прочитать в оригинальной статье С. Накамото, предложившего данную идею.

Блоки состоят из сформированных пользователями транзакций, которые подписываются ими с использованием асимметричной криптографии. Каждый пользователь имеет два ключа: приватный, известный только этому пользователю, с помощью которого он подписывает транзакции, и публичный, известный всем пользователям, с помощью которого кто угодно может проверить подпись. Например, биткоин использует для подписи транзакций алгоритм ECDSA (англ.: Elliptic Curve Digital Signature Algorithm), схожий с алгоритмом DSA (англ.: Digital Signature Algorithm), но определенный в группе точек эллиптической кривой. Криптографическая стойкость данного алгоритма основывается на сложности задачи дискретного логарифмирования, которая на классическом компьютере решается за экспоненциальное время относительно размера ключа. Другой вычислительно сложной задачей является задача факторизации больших чисел, на которой, например, основан алгоритм RSA (англ.: Rivest Shamir Adleman), также обеспечивающий криптографическую стойкость цифровой подписи, поскольку лежащая в основе него задача решается за время, которое экспоненциально зависит от размера ключа. Таким образом, пока эта криптографическая стойкость существует, пользователям гарантируется, что никто другой не сможет сгенерировать транзакции от их имени.

Как было сказано выше, блокчейн опирается на две вычислительно сложные задачи: поиск коллизий хэша и взятие дискретного логарифма или факторизацию больших чисел. Обе задачи решаются на классическом компьютере за экспоненциальное время, благодаря чему при выборе достаточно сложной хэш-функции или достаточно длинного ключа могут считаться нерешаемыми. Однако настоящим потрясением оказалось то, что существуют алгоритмы, благодаря которым квантовые компьютеры способны решать эти задачи на порядки быстрее.

В то время как классический компьютер оперирует с битами, которые представляются в виде нуля или единицы, квантовый компьютер оперирует с кубитами, которые могут пребывать в суперпозиции различных состояний. Говоря упрощенно, каждое такое состояние может обрабатываться одновременно, в результате чего возможно получить существенное ускорение по сравнению с классическим аналогом. Далее рассматриваются два основных квантовых алгоритма, способных поставить под угрозу безопасность привычного блокчейна.

Алгоритм Гровера

Алгоритм Гровера позволяет получать квадратичное ускорение в решении задачи перебора, поэтому может быть использован для ускорения генерации хэшей. Благодаря этому злоумышленник сможет генерировать ложные блоки на порядки быстрее генерации настоящих блоков, тем самым создавая более длинную цепочку блоков, которая будет принята всеми пользователями. Также этот алгоритм может быть использован для замены уже существующих блоков в блокчейне, при этом сохраняя их целостность.

Суть алгоритма Гровера заключается в следующем. Допустим, мы имеем некую функцию , корень которой мы собираемся найти. Пусть эта функция реализуема на классическом компьютере, тогда в теории представляется возможным реализовать обратимую функцию , которая равняется , если является корнем функции , и — в противном случае. Такая функция называется оракулом, а её обратимость обеспечивает то, что её можно реализовать на квантовом компьютере, например, при помощи вентилей Тоффоли. В таком случае на вход этой функции можно подавать не одно значение , как в классическом переборе, а суперпозицию всех возможных значений , а значит, получать на выходе суперпозицию всех возможных выходных значений оракула. Далее с помощью элементарных квантовых вентилей можно усилить амплитуду вероятности состояния, соответствующего корню оракула. После определенного количества таких итераций в результате измерения будет получен корень исходной функции с вероятностью, практически равной . Ситуация несколько осложняется в случае, когда у функции имеется несколько корней, что соответствует задаче поиска коллизий хэша, однако и в таком случае алгоритм Гровера показывает значительное ускорение по сравнению с простым перебором.

Атака на proof-of-work

Несмотря на то, что алгоритм Гровера способен обеспечить квадратичное ускорение при подсчете блоков, атака с его помощью не является для блокчейна критической, что утверждается в недавнем отчете группы канадских и австралийских ученых. Дело в том, вычислительная мощность интегральных схем специального назначения (англ.: ASIC), находящаяся в настоящий момент в руках майнеров, способна свести на нет практически любые попытки получить ускорение майнинга при помощи квантового компьютера. Допускается, однако, что дальнейшее развитие квантовых технологий может способствовать тому, что квантовые компьютеры получат серьезное преимущество над существующими вычислительными мощностями, но это, по оценкам авторов работы, наступит лишь после повсеместного распространения квантовых компьютеров. Когда же это настанет, майнеры также получат возможность использовать их, тем самым возможность доминирования с помощью квантового компьютера снизойдет на нет.

Кроме того, существуют и другие подходы к генерации блоков, в основе которых не лежат вычислительно сложные задачи, а значит, блокчейны на их основе могут рассматриваться как устойчивые к атакам на proof-of-work. Наиболее популярным таким подходом, который в настоящий момент уже используется, например, в BlackCoin, является proof-of-stake (англ.: доказательство доли владения), заключающийся в том, что блоки с большей вероятностью генерируются теми пользователями, которые владеют большей частью средств в блокчейне. Proof-of-stake не требует поиска коллизий хэша, поэтому с этой точки зрения является устойчивой к атакам с помощью квантового компьютера.

Однако proof-of-stake по-прежнему уязвим к атакам с помощью квантового компьютера, если он способен подделывать цифровые подписи, например, используя алгоритм Шора, рассматриваемый далее. В таком случае злоумышленник сможет очень быстро сосредоточить все средства блокчейна на подконтрольных счетах и получить полный контроль над ним. Стоит отметить, что цифровые подписи широко распространены и в других областях, которые теперь могут стать уязвимыми для квантового компьютера, из-за чего ведутся активные исследования по разработке новых подходов к созданию цифровых подписей, ряд которых будет рассмотрен в данной статье в дальнейшем.

Алгоритм Шора

Теперь перейдем к краткому рассмотрению Алгоритма Шора, который способен разлагать большие числа на простые множители и производить дискретное логарифмирование, причем делать всё это за полиномиальное время, сводя обе эти задачи к поиску периода функции. Из-за этого вычислительно сложные задачи, лежащие в основе криптографической стойкости алгоритмов создания цифровой подписи, таких как RSA, ECDSA, ECDH, DSA, оказываются решаемыми за вменяемое время с помощью квантового компьютера, обладающего достаточной мощностью. Наличие такого квантового компьютера позволит злоумышленнику создавать ложные транзакции, тем самым получая доступ ко всем средствам, хранящимся в блокчейне, поэтому в настоящее время именно атаки с помощью алгоритма Шора считаются наиболее опасными для безопасного функционирования блокчейна.

Требования, предъявляемые к постквантовому блокчейну

Прежде чем перейти к обзору различных подходов к созданию цифровой подписи, устойчивой к квантовым атакам, рассмотрим, какие требования предъявляются к постквантовому блокчейну в целом, чтобы в дальнейшем иметь представление, какие методы могут быть использованы, а какие — нет. С одной стороны, кажется, что можно лишь увеличивать размеры ключей и хэша, чтобы отсрочить момент когда квантовые компьютеры смогут окончательно взломать блокчейн, однако такой подход имеет ряд недостатков. Во-первых, это будет требовать от устройств большого количества памяти и вычислительных ресурсов, что неприемлемо в случаях, когда с блокчейном необходимо взаимодействовать устройствам Интернета вещей, поскольку зачастую они не обладают большой памятью и мощностью, а наоборот, должны работать несколько лет от одной батарейки. Во-вторых, увеличение размера хэшей и подписей влечет за собой увеличение размера блокчейна, который необходимо хранить всем пользователям, что может занимать довольно много памяти. Такая проблема уже сейчас возникла в Bitcoin’е, размер блокчейна которого увеличился на целых 60Гб за один год и на момент написания статьи составил 310Гб, причем его рост лишь продолжает увеличиваться и, можно предположить, примерно к 2030 году он превысит 1Тб. Конечно, существует вариант использовать так называемые “легкие” кошельки, позволяющие не хранить весь блокчейн, но это уменьшает надежность системы. Таким образом, основные требования к постквантовому блокчейну касаются размеров подписей, ключей и хэшей: они не должны быть слишком большими. Кроме того, постквантовый блокчейн должен иметь достаточно большую скорость исполнения операций, чтобы обеспечивать стабильное функционирование системы с огромным количеством транзакций в секунду.

Постквантовые алгоритмы цифровой подписи

В настоящее время ведутся активные работы по разработке алгоритмов шифрования, в том числе и алгоритмов создания цифровой подписи, которые будут устойчивы к атакам с помощью квантового компьютера. Интерес исследователей подогревается тем, что в 2016 году NIST (англ.: Национальный институт стандартов и технологий) запустил конкурс таких алгоритмов, результаты которого будут объявлены к 2022 году. Приведем далее наиболее известные из предложенных алгоритмов, устойчивых к квантовым атакам.

Начнем рассмотрение с механизмов цифровой подписи на основе кода (англ.: code based), примером которой является система McEliece, предложенная примерно в то же время, что и повсеместно используемый алгоритм RSA, однако не получившая тогда широкого распространения. В настоящее время данная система, а также ряд её улучшений, таких как система Niederreiter’а, обретают всё большую популярность, поскольку они являются устойчивыми к атакам с помощью алгоритма Шора. В их основе лежит задача декодирования линейных кодов, что является NP-полной задачей, при этом пока что нерешаемой на квантовом компьютере. Несмотря на то, что подписи, сгенерированные по данным методам, обладают относительно маленьким размером и могут быть проверены достаточно быстро, они требуют хранения огромных матриц, которые выступают в роли ключей, что в свою очередь также увеличивает время генерации подписи, затрудняя её использование в блокчейне. В связи с этим исследуются различные методы сжатия матриц или использования других кодов, например, LDPC кодов (англ.: Low Density Parity Check), особенностью которых является малая плотность проверочной матрицы.

Другим механизмом создания цифровой подписи является так называемый механизм на основе решеток (англ.: lattice based), который был отдельно выделен в недавнем отчете NIST как наиболее перспективный. Так называемую решетку можно представить себе как набор точек в n-мерном пространстве с периодической структурой. В данном случае математической задачей, на которой основана криптографическая стойкость, является, например, задача нахождения в этой решетке кратчайшего вектора (Shortest Vector Problem) или же схожая с ней задача нахождения ближайшего вектора (Closest Vector Problem), причём обе эти задачи обладают огромной вычислительной сложностью. Однако недостатком таких систем является тот факт, что необходимо хранить ключи большого размера, что приводит к значительным накладным расходам шифротекста и делает практически невозможным использование подобных систем в блокчейне. Существуют, однако, системы на основе решеток, основанные на задаче краткого целочисленного решения (англ.: Short Integer Solution), благодаря чему удается уменьшить размер ключа, позволяя тем самым использовать такие системы в блокчейне.

Последним механизмом создания цифровой подписи, рассматриваемым в данной статье, является механизм на основе хэша (англ.: hash based), безопасность которого основывается не на сложности некоей математической задачи, а на лежащей в его основе криптографической хэш-функции. Подобный подход был предложен ещё в 70-х годах прошлого века как альтернатива алгоритмам RSA и DSA, однако он не пользовался большим интересом, поскольку накладывает ограничение на количество повторных использований подписей. Однако сейчас этот подход обретает всё большую популярность, поскольку он является устойчивым к квантовым атакам. Недостатком же такого подхода является тот факт, что генерация ключа занимает достаточно длительное время, что делает его неприменимым для использования в блокчейне.

В рамках данной статьи были рассмотрены атаки с помощью квантового компьютера, к которым блокчейн оказывается уязвимым. Было выяснено, что хоть алгоритм Гровера и показывает квадратичное ускорение по сравнению с классическими подходами, атака с его помощью не несет практически никакой угрозы для существующих систем на основе proof-of-work, не говоря уже о других методах генерации блоков, таких как proof-of-stack. В то же время главной угрозой, способной свести на нет безопасное функционирование не только блокчейна, но и практически всех цифровых финансовых операций, является атака с помощью алгоритма Шора, методы борьбы с которой были также освещены в данной статье. Кроме того, были рассмотрены требования, предъявляемые к квантовому блокчейну, которые определяют, какие методы борьбы с данной атакой являются приемлемыми, а какие — нет.

• как возникла идея квантового компьютера;

• из чего строят квантовые машины, что такое кубит;

• почему квантовые компьютеры могут превзойти обычные;

какие существуют квантовые алгоритмы.

Оглавление

Модуль 3. Основные принципы квантового вычисления

Проверочный тест

Традиционные компьютеры, основанные на использовании полупроводниковых логических элементов, уже приблизились к пределу своего развития — дальнейшая миниатюризация транзисторов и «упаковка» еще большего числа вычислительных компонентов в тот же объем скоро станет невозможной. Поэтому инженеры и ученые пытаются создать вычислительные устройства иного типа. В их числе — квантовые вычислительные машины, основанные на использовании ряда квантовых эффектов, таких как квантовая запутанность и квантовая суперпозиция. Благодаря этому они способны решать задачи, на которые «обычные» компьютеры потратили бы миллиарды лет (это, например, расчет поведения сложных молекул, моделирование нейронных связей в мозге или решение сложных логистических задач). Квантовые компьютеры обещают решить эту проблему, однако пока созданы только экспериментальные квантовые установки, еще не показавшие «квантового превосходства» — значимой прибавки в скорости вычислений по сравнению с обычными компьютерами.

История идеи

Идею квантовых вычислительных устройств впервые высказал в 1980 году советский математик Юрий Манин. В книге «Вычислимое и невычислимое», рассуждая о сложности процесса считывания и записи биологической информации с молекул ДНК, он заметил, что для моделирования этого процесса могли бы подойти квантовые устройства. Здесь же Манин указал указал на главное их преимущество — рост числа состояний таких устройств идет по степенному закону:

Годом позже, в мае 1981 года, идею квантового компьютера сформулировал физик и нобелевский лауреат Ричард Фейнман в докладе, посвященном возможности моделирования физических процессов.

Ученый подчеркнул, что все явления подчиняются квантовым законам (а классическая физика — только приближение). Если поведение одиночного квантового объекта достаточно легко поддается моделированию с помощью компьютера, то нарастание количества элементов ведет к экспоненциальному росту сложности вычислений.

Из этого следовало два выхода, говорил Фейнман: первый — признать, что квантовые системы не поддаются моделированию с помощью компьютеров, и второй — построить вычислительную машину из квантовых элементов, подчиняющихся тем же квантовым законам, что и моделируемая система.

В своем докладе Фейнман впервые сформулировал понятие квантового симулятора — квантовой системы, воспроизводящей поведение какой-то другой квантовой системы, а также универсального квантового компьютера — такой квантовой системы, которую можно перенастроить (перепрограммировать) так, чтобы она была способна моделировать поведение многих других систем.

Наконец, Фейнман также впервые описал пример работы системы из кубитов, созданных из фотонов с определенной поляризацией.

Работа одного из элементов квантового компьютера в представлении Фейнмана

В 1985 году Дэвид Дойч из Оксфордского университета разработал теорию универсального квантового компьютера как квантовой машины Тьюринга.

Однако первый в мире квантовый компьютер мог появиться намного раньше, еще до статей Манина и Фейнмана, в 1950-е годы. Тогда японский ученый Гото Эйичи экспериментировал с низкотемпературной электроникой для разработки миниатюрного магнитно-управляемого бита, то есть системы, способной находиться в двух состояниях и служить, как и обычный полупроводниковый транзистор, основным элементом компьютера.

Эйичи назвал свой бит параметроном, и его первый прототип был создан в 1958 году в Токийском университете. Ниже представлен схематический чертеж оригинального устройства Гото.

Гото Эйичи и его команда повысить энергетический барьер между двумя состояниями битов, чтобы их гарантированно можно было различить. Иначе говоря, японские ученые хотели, чтобы устройство ни в коем случае не оказывалось в бистабильном состоянии, то есть в состоянии квантовой суперпозиции.

Такое состояние рассматривалось ими как нечто, вызывающее неуправляемый и нежелательный шум, в то время как квантовые эффекты могли дать им принципиально новый метод вычислений. Если бы не стремление японских специалистов к избавлению от ошибок, квантовые симуляторы, возможно, появились бы на полвека раньше.

Пределы роста классических компьютеров

Современные компьютеры, включая самые мощные, основаны на использовании множества полупроводниковых «переключателей» — транзисторов. Вычислительная мощность любого компьютера, в конечном счете, зависит от количества этих транзисторов и скорости их срабатывания.

С 1960-х годов, когда началось интенсивное развитие электроники, в мире компьютеров действует закон Мура — замеченная основателем Intel Гордоном Муром закономерность, согласно которой число транзисторов на чипе удваивается каждые два года, а производительность процессоров (как и мощность, доступная за 1 доллар) — каждые 18 месяцев.

Конечно, существуют абсолютные пределы для скорости обработки вычислений, связанные с фундаментальными физическими константами — скоростью света, гравитационной постоянной и постоянной Планка.

Согласно расчетам Сета Ллойда из Массачусетского технологического института, умозрительный «окончательный ноутбук», в котором предельная вычислительная мощность «упакована» в объем 1 литр и массу 1 килограмм, мог бы выполнять 10 51 операций в секунду на 10 31 битов, что примерно на 40 порядков выше возможностей современных вычислительных машин. Это означает, что закон Мура должен действовать еще примерно 250 лет, чтобы добраться до этого окончательного предела.

Однако большинство экспертов считают, что рост возможностей современной электроники упрется в потолок намного раньше и закон Мура перестанет работать. Пределы роста связывают с ограничениями на миниатюризацию самих транзисторов — уже сейчас слои диэлектрика в них могут иметь всего несколько атомов в толщину, так что на их работе начинают сказываться квантовые эффекты, например, туннелирование.

Сложности создает и пропускная способность соединений между транзисторами. Еще в 2013 году некоторые ученые объявили о конце закона Мура (пока лишь в области твердотельных накопителей).

Поэтому большинство крупных IT-компаний ищет варианты, позволяющие продолжить рост вычислительных мощностей. В качестве перспективных идей рассматривается создание оптических компьютеров (информация кодируется и обрабатывается в световых импульсах) и спинтронных компьютеров (данные кодируются не в колебаниях электрического тока, а в спинах электронов).

Одной из альтернатив современной электронике некоторые считают квантовые вычислительные устройства, способные обеспечить резкий рост вычислительной мощности при решении некоторых типов задач. Попробуем разобраться, как устроен квантовый компьютер.

Биты и кубиты

Классические компьютеры оперируют битами — объектами, имеющими всего два возможных состояния, например 1 или 0. В качестве такого максимально простого классического объекта можно рассматривать, например, монету, у которой виден либо аверс, либо реверс, то есть орел или решка.

Все обычные компьютеры работают именно с классическими битами, то есть с наборами двоичных значений, нулей или единиц. Эквивалентом бита в квантовом мире будет кубит — квантовый бит. Фундаментальное отличие кубита заключается в том, что он, в отличие от бита, может находиться в состоянии квантовой суперпозиции.

Процессор - это главная микросхема компьютера, его "мозг". Он разрешает выполнять программный код, находящийся в памяти и руководит работой всех устройств компьютера. Скорость его работы определяет быстродействие компьютера. Конструктивно, процессор - это кристалл кремния очень маленьких размеров. Процессор имеет специальные ячейки, которые называются регистрами. Именно в регистрах помещаются команды, которые выполняются процессором, а также данные, которыми оперируют команды. Работа процессора состоит в выборе из памяти в определенной последовательности команд и данных и их выполнении. На этом и базируется выполнение программ.

В ПК обязательно должен присутствовать центральный процессор (Central Rpocessing Unit - CPU), который выполняет все основные операции. Часто ПК оснащен дополнительными сопроцесорами, ориентированными на эффективное выполнение специфических функций, такие как, математический сопроцесор для обработки числовых данных в формате с плавающей точкой, графический сопроцесор для обработки графических изображений, сопроцесор ввода/вывода для выполнения операции взаимодействия с периферийными устройствами.

Основными параметрами процессоров являются:

- тактовая частота,

- разрядность,

- рабочее напряжение,

- коэффициент внутреннего умножения тактовой частоты,

- размер кеш памяти.

- шина данных,

- адресная шина,

- командная шина.

Основные шинные интерфейсы материнских плат:

ISA (Industry Standard Architecture). Разрешает связать между собой все устройства системного блока, а также обеспечивает простое подключение новых устройств через стандартные слоты. Пропускная способность составляет до 5,5 Мбайт/с. В современных компьютерах может использоваться лишь для подсоединения внешних устройств, которые не требуют большей пропускной способности (звуковые карты, модемы и т.д.).

EISA (Extended ISA). Расширение стандарта ISA. Пропускная способность возросла до 32 Мбайт/с. Как и стандарт ISA, этот стандарт исчерпал свои возможности и в будущем выпуск плат, которые поддерживают эти интерфейсы прекратится.

VLB (VESA Local Bus). Интерфейс локальной шины стандарта VESA. Локальная шина соединяет процессор с оперативной памятью в обход основной шины. Она работает на большей частоте, чем основная шина, и позволяет увеличить скорость передачи данных. Позже, в локальную шину "врезали" интерфейс для подключения видеоадаптера, который требует повышенной пропускной способности, что и привело к появлению стандарта VLB. Пропускная способность - до 130 Мбайт/с, рабочая тактовая частота - 50 МГц, но она зависит от количества устройств, подсоединенных к шине, что является главным недостатком интерфейса VLB.

PCI (Peripherial Component Interconnect). Стандарт подключения внешних устройств, введенный в ПК на базе процессора Pentium. По своей сути, это интерфейс локальной шины с разъемами для подсоединения внешних компонентов. Данный интерфейс поддерживает частоту шины до 66 МГц и обеспечивает быстродействие до 264 Мбайт/с независимо от количества подсоединенных устройств. Важным нововведением этого стандарта является поддержка механизма plug-and-play, суть которого состоит в том, что после физического подключения внешнего устройства к разъему шины PCI происходит автоматическая конфигурация этого устройства.

FSB (Front Side Bus). Начиная с процессора Pentium Pro для связи с оперативной памятью используется специальная шина FSB. Эта шина работает на частоте 100-133 МГц и имеет пропускную способность до 800 Мбайт/с. Частота шины FSB является основным параметром, именно она указывается в спецификации материнской платы. За шиной PCI осталась лишь функция подключения новых внешних устройств.

AGP (Advanced Graphic Port). Специальный шинный интерфейс для подключения видеоадаптеров. Разработан в связи с тем, что параметры шины PCI не отвечают требованиям видеоадаптеров по быстродействию. Частота этой шины - 33 или 66 МГц, пропускная способность до 1066 Мбайт/с.

USB (Universal Serial Bus). Стандарт универсальной последовательной шины определяет новый способ взаимодействия компьютера с периферийным оборудованием. Он разрешает подключать до 256 разных устройств с последовательным интерфейсом, причем устройства могут подсоединяться цепочкой. Производительность шины USB относительно небольшая и составляет 1,55 Мбит/с. Среди преимуществ этого стандарта следует отметить возможность подключать и отключать устройства в "горячем режиме" (то есть без перезагрузки компьютера), а также возможность объединения нескольких компьютеров в простую сеть без использования специального аппаратного и программного обеспечения.

Внутренняя память

Под внутренней памятью понимают все виды запоминающих устройств, расположенные на материнской плате. К ним относятся оперативная память, постоянная память и энергонезависимая память.

Оперативная память RAM (Random Access Memory)

Память RAM - это массив кристаллических ячеек, способных сохранять данные. Она используется для оперативного обмена информацией (командами и данными) между процессором, внешней памятью и периферийными системами. Из нее процессор берет программы и данные для обработки, в нее записываются полученные результаты. Название "оперативная" происходит от того, что она работает очень быстро и процессору не нужно ждать при считывании данных из памяти или записи. Однако, данные сохраняются лишь временно при включенном компьютере, иначе они исчезают.

По физическому принципу действия различают динамическую память DRAM и статическую память SRAM.

Ячейки динамической памяти можно представить в виде микроконденсаторов, способных накапливать электрический заряд. Недостатки памяти DRAM: медленнее происходит запись и чтение данных, требует постоянной подзарядки. Преимущества: простота реализации и низкая стоимость.

Ячейки статической памяти можно представить как электронные микроэлементы - триггеры, состоящие из транзисторов. В триггере сохраняется не заряд, а состояние (включенный/выключенный). Преимущества памяти SRAM: значительно большее быстродействие. Недостатки: технологически более сложный процесс изготовления, и соответственно, большая стоимость.

Микросхемы динамической памяти используются как основная оперативная память, а микросхемы статической - для кэш-памяти.

Каждая ячейка памяти имеет свой адрес, выраженный числом. В современных ПК на базе процессоров Intel Pentuim используется 32-разрядная адресация. Это означает, что всего независимых адресов есть 232, то есть возможное адресное пространство составляет 4,3 Гбайт. Однако, это еще не означает, что именно столько оперативной памяти может быть в системе. Предельный размер объема памяти определяется чипсетом материнской платы и обычно составляет несколько сотен мегабайт.

Оперативная память в компьютере размещена на стандартных панельках, которые называются модулями. Модули оперативной памяти вставляют в соответствующие разъемы на материнской плате. Конструктивно модули памяти имеют два выполнения - однорядные (SIMM - модули) и двурядные (DIMM - модули). На компьютерах с процессорами Pentium однорядные модули можно применять лишь парами (количество разъемов для их установления на материнской плате всегда четное). DIMM - модули можно устанавливать по одному. Комбинировать на одной плате разные модули нельзя.

Основные характеристики модулей оперативной памяти:

Постоянная память ROM (Read Only Memory)

В момент включения компьютера в его оперативной памяти отсутствуют любые данные, поскольку оперативная память не может сохранять данные при отключенном компьютере. Но процессору необходимы команды, в том числе и сразу после включения. Поэтому процесор обращается по специальному стартовому адресу, который ему всегда известен, за своей первой командой. Этот адрес указывает на память, которую принято называть постоянной памятью ROM или постоянным запоминающим устройством (ПЗУ). Микросхема ПЗУ способна продолжительное время сохранять информацию, даже при отключенном компьютере. Говорят, что программы, которые находятся в ПЗУ, "зашиты" в ней - они записываются туда на этапе изготовления микросхемы. Комплект программ, находящийся в ПЗУ образовывает базовую систему ввода/вывода BIOS (Basic Input Output System).

Основное назначение этих программ состоит в том, чтобы проверить состав и трудоспособность системы и обеспечить взаимодействие с клавиатурой, монитором, жесткими и гибкими дисками.

Энергонезависимая память CMOS

Работа таких стандартных устройств, как клавиатура, может обслуживаться программами BIOS, но такими средствами невозможно обеспечить роботу со всеми возможными устройствами (в связи с их огромным разнообразием и наличием большого количества разных параметров). Но для своей работы программы BIOS требуют всю информацию о текущей конфигурации системы. По очевидной причине эту информацию нельзя сохранять ни в оперативной памяти, ни в постоянной. Специально для этих целей на материнской плате есть микросхема энергонезависимой памяти, которая называется CMOS. От оперативной памяти она отличается тем, что ее содержимое не исчезает при отключении компьютера, а от постоянной памяти она отличается тем, что данные можно заносить туда и изменять самостоятельно, в соответствии с тем, какое оборудование входит в состав системы.

Микросхема памяти CMOS постоянно питается от небольшой батарейки, расположенной на материнской плате. В этой памяти сохраняются данные про гибкие и жесткие диски, процессоры и т.д. Тот факт, что компьютер четко отслеживает дату и время, также связанн с тем, что эта информация постоянно хранится (и обновляется) в памяти CMOS. Таким образом, программы BIOS считывают данные о составе компьютерной системы из микросхемы CMOS, после чего они могут осуществлять обращение к жесткому диску и другим устройствам.

Китайские физики заявили, что запустили первые в мире программируемые квантовые компьютеры, передает Tengrinews.kz со ссылкой на Xinhua.

Компьютеры разработали профессор Китайского научно-технологического университета (КНТУ) Пань Цзяньвэй и научные сотрудники из Шанхайского института микросистем и информационных технологий Академии наук Китая и Государственного исследовательского центра параллельной вычислительной техники и технологий.

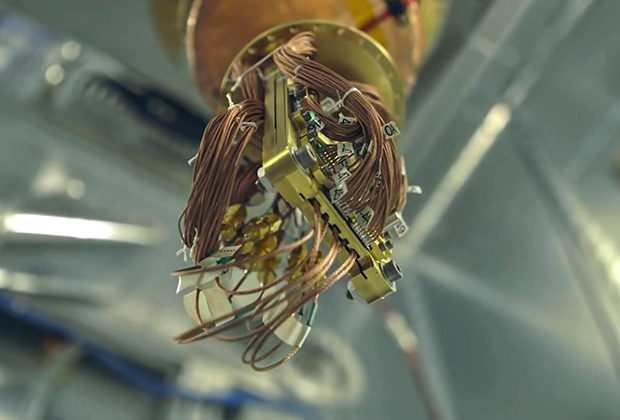

Первый из них - 66-кубитный программируемый квантовый компьютер, названный в честь математика 5-го века, Zuchongzhi 2.1. По данным исследовательской группы, он в миллион раз мощнее, чем его ближайший конкурент - 55-кубитный Google Sycamore, запущенный два года назад. Китайские ученые заявили, что этот квантовый компьютер за час справится с расчетами, на которые самый мощный электронный компьютер потратит 8 лет. Однако для этого систему Zuchongzhi 2.1 придется держать при очень низкой температуре.

Квантовый процессор "Zuchongzhi 2.1" / Xinhua

Второй компьютер Jiuzhang 2 может производить вычисления в 100 триллионов раз быстрее, чем самый быстрый из существующих суперкомпьютеров в мире.

Отмечается, что, несмотря на их скорость, эти машины не заменят обычные компьютеры в ближайшее время. На данном этапе они работают только в защищенной среде в течение коротких периодов времени над очень специфическими задачами. К примеру, квантовые компьютеры общего назначения в перспективе найдут применение в сфере дешифрования, прогноза погоды, материаловедения и разработки лекарств.

Квантовый компьютер - вычислительная машина, в которой операции выполняются в соответствии с законами квантовой механики. Традиционные компьютеры оперируют миллионами бит, каждый из которых находится в состоянии "включено" или "выключено". Это хорошо работает для бытовых нужд человечества, однако реальный мир переполнен неопределенностями, и классические вычисления для этого не годятся.

Кубиты, которыми оперирует квантовый компьютер, могут быть одновременно в двух состояниях или в промежуточном. Ученые сравнивают биты и кубиты с монеткой: если подбросить ее, мы получим орла или решку, и это будет классическое вычисление, в котором каждый бит - одна из двух сторон монетки. Однако если закрутить монетку, придется предполагать оба варианта сразу - это и есть квантовое вычисление.

Таким образом, квантовый компьютер может учитывать неопределенность для решения таких задач, которые традиционный компьютер решал бы много лет. По мнению ученых, он пригодится, в частности, для моделирования таких сложных структур, как фармацевтические препараты или новые вирусы.

Напомним, в 2020 году ученые из Китая заявили, что создали самый мощный в мире квантовый компьютер, который в 10 миллиардов раз быстрее прототипа от Google.

Читайте также: